Редирект со страниц index .html и .php

#1 Natta

Отправлено 31 Июль 2018 — 17:48

Проверила сайт одним их сервисов на просторах интернета, и он указал на следующую проблему на моем сайте с движком вордпресс.

…………………………………………

Редирект со страниц index (.html и .php) настроен не правильно

Поисковые системы рассматривают Ваши http://site.ru и http://site.ru/index.html (или http://site.ru/index.php) как разные страницы.

С различными URL-адресами более сложно получить консолидированные показатели для определенной части контента.

……………………………………….

Нужно ли это исправлять?

Сообщение отредактировал Natta: 31 Июль 2018 — 17:49

- Наверх

#2 snatch

Отправлено 31 Июль 2018 — 23:12

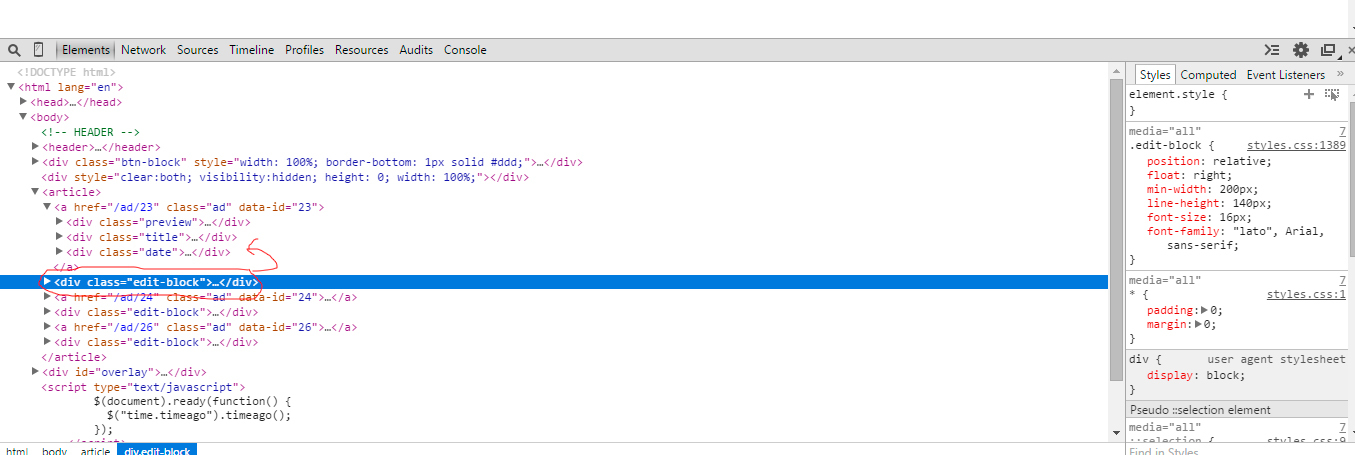

Да нужно, это дублированные страницы, болезнь бесплатных движков, для исправления ситуации: 301 редирект, robots. txt, тег canonical, вобще для вордпреса есть соответствующие плагины, ими лучше и воспользуйтесь, один плагин решит все основные проблемы.

txt, тег canonical, вобще для вордпреса есть соответствующие плагины, ими лучше и воспользуйтесь, один плагин решит все основные проблемы.

Разместить рекламу на форуме, расценки тут

- Наверх

#3 Natta

TC Отправлено 01 Август 2018 — 04:11

snatch (31 Июль 2018 — 23:12) писал:

Да нужно, это дублированные страницы, болезнь бесплатных движков, для исправления ситуации: 301 редирект, robots.txt, тег canonical, вобще для вордпреса есть соответствующие плагины, ими лучше и воспользуйтесь, один плагин решит все основные проблемы.

Плагин Yoast SEO у меня стоит.. Но я не все настроила. У меня на страницах пагинации в категориях и рубриках не прописаны канонические урлы, я начала прописывать с помощью этого плагина только сейчас.

А что в robots.txt нужно сделать, уточните, пожалуйста.

Сообщение отредактировал Natta: 01 Август 2018 — 04:16

- Наверх

#4 snatch

Отправлено 01 Август 2018 — 11:39

Natta сказал:

Плагин Yoast SEO у меня стоит.. Но я не все настроила. У меня на страницах пагинации в категориях и рубриках не прописаны канонические урлы, я начала прописывать с помощью этого плагина только сейчас

Про пагинацию уже была ваша тема, впринципе там все понятно из ответов

Natta сказал:

А что в robots.txt нужно сделать, уточните, пожалуйста.

Не обязательно с robots.txt что то делать, это один из возможных инструментов в борьбе с дубликатами, смотреть нужно по ситуации

Разместить рекламу на форуме, расценки тут

- Наверх

#5 Natta

TC Отправлено 02 Август 2018 — 21:33

А Яндекс советует так:

Если в какой-либо категории на вашем сайте находится большое количество товаров, могут появиться страницы пагинации (порядковой нумерации страниц), на которых собраны все товары данной категории.

https://yandex.ru/blog/platon/2878

А Гугл не советует то, что советует Яндекс. Андрей Липатцев (Google) подтвердил, что указывать первую страницу канонической в серии пагинации Google не рекомендует.

После серии вопросов вебмастеров Платон не отказался от своей рекомендации указывать первую страницу канонической, но написал, что «параметр можно и не устанавливать». В целом, то, что это вариант решения, а не требование Яндекса.

Интересная пагинация на сайте автора сео-плагина https://yoast.com/. Она противоречит требованиям гугла.и соответствует пожеланиям Яндекса.

Сообщение отредактировал Natta: 02 Август 2018 — 21:47

- Наверх

#6 c4e8ece0

Отправлено 02 Август 2018 — 21:48

Каноничить стоит лишь в том случае, если у товара мало характеристик и они все вываливаются и в листингах и на страницах товаров с одинаковым теговым контекстом. Ну или когда это какие-то акционные группы, которые скоро всё равно скоро уйдут под 4xx.

Ну или когда это какие-то акционные группы, которые скоро всё равно скоро уйдут под 4xx.

«Они не могут ничего, у них лапки котят»

- Наверх

Настраиваем редирект с HTTP на HTTPS

Категория: Полезное, Сайтостроение, Опубликовано: 2016-12-14

Автор: Юлия Гусарь

Приветствую вас на сайте Impuls-Web!

Сегодня мы рассмотрим последний этап перевода сайта на SSL-сертификат, в котором нам нужно настроить редирект с http на https, или, другими словами, перенаправление с нашего прежнего адреса, начинающегося с http://, на новый адрес по протоколу HTTPS.

Навигация по статье:

- Переадресация на https через htaccess

- Варианты написания серверного редиректа для HTTPS

- Проверка редиректа

В предыдущих статьях я рассматривала процесс получения у установки SSL сертификата. Если вы их не читали – вот ссылки:

Нужен ли SSL-сертификат для сайта?

Как получить бесплатно SSL-сертификат для сайта?

Как получить SSL сертификат?

Как установить SSL-сертификат на хостинг?

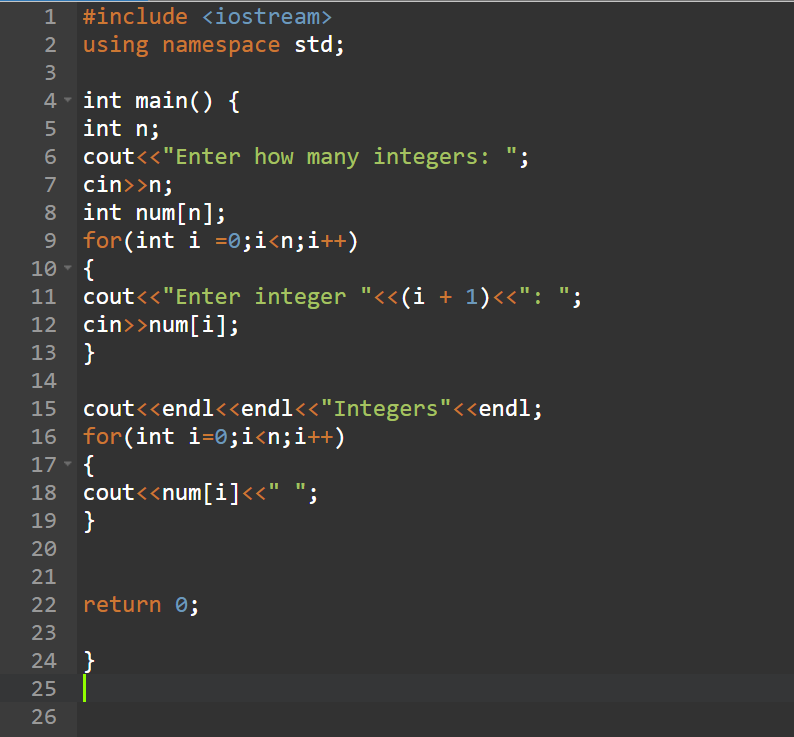

Переадресация на https через htaccess

Это поможет минимизировать потери трафика и позиций . О том как это сделать написано тут.

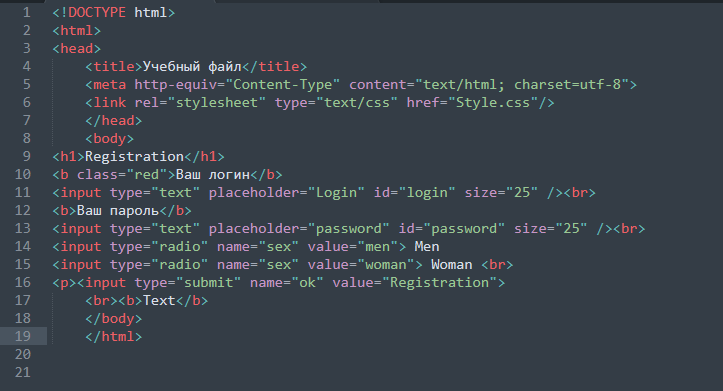

Это поможет минимизировать потери трафика и позиций . О том как это сделать написано тут.Для того, что бы настроить редирект с http на https, вам нужно, при помощи программы Notepad++, в корне вашего сайта открыть файл .htaccess, и далее, в самом начале этого файла, прописать один из нескольких вариантов перенаправления.

Как пользоваться Notepad++ и настроить для него FTP-подключение я рассказывала в одной из прошлых статей, с которой вы можете ознакомиться по этой ссылке:

Редактирование файлов сайта в Notepad++

Все дело в том, что настройки хостинга могут быть разные. Поэтому какого-то универсального синтаксиса для написание перенаправления нет и нужно будет пробовать разные варианты, что бы найти тот, который сработает на вашем хостинге.

Если вы не хотите экспериментировать с различными способами перенаправления, то лучше всего будет обратиться в техподдержку вашего хостинга и уточнить у них, как лучше всего настроить редирект с HTTP на HTTPS именно для вашего хостинга. (.*)$ https://%{HTTP_HOST}%{REQUEST_URI} [L,R=301]

(.*)$ https://%{HTTP_HOST}%{REQUEST_URI} [L,R=301]

После вставки одного из этих вариантов в файл .htaccess, сохраняете изменения.

Проверка редиректа

Затем, для того что бы проверить работает он или нет, переходим в браузер и в адресной строке вводим адрес нашего сайта с протоколом HTTP. Если перенаправление сработает, то у вас должна будет открыться страница вашего сайта с протоколом HTTPS.

Так же, вы можете воспользоваться одним из онлайн-сервисов, которые позволяют просмотреть правильность выполнения редиректа. Например, Redirect Checker. Для выполнения проверки вам нужно:

- 1.Перейти на страницу онлайн-сервиса по этой ссылке

- 2.В поле для ввода указать адрес, с которого должно осуществляться перенаправление в формате http://имя-сайта.ру .

- 3.А затем нажать на кнопку «Analyse».

В результате сервис вам выдаст отчет о правильности работы перенаправления. В моем случае редирект работает не правильно:

Перенаправление вроде бы как происходит, но это происходит несколько раз, и почему то происходит не 301 редирект, а 302. Насколько я поняла, это называется циклический редирект, и такого быть не должно. Поэтому мне нужно пробовать другие варианты.

Насколько я поняла, это называется циклический редирект, и такого быть не должно. Поэтому мне нужно пробовать другие варианты.

Так же, вы можете проверить правильность выполнения редиректа для конкретной поисковой системы. Для этого, перед нажатием на кнопку «Analyse», нужно выбрать из выпадающего списка название нужного поискового робота:

После того, как вы добавите свой сайт с протоколом HTTPS в поисковые системы, укажите основное зеркало, дождетесь переиндексации и правильно настроите 301-редирект, ваш переезд на протокол HTTPS можно будет считать завершенным. Для крупного сайта такой переезд может занять от нескольких недель, до нескольких месяцев. Все будет зависеть от того, как долго яндекс будет производить склейку зеркал.

Так же, вы можете назначить 301 редирект сразу после получения и установки с SSL-сертификата, но в этом случае вы рискуете тем, что многие страницы вашего сайта могут на время выпасть из поисковой выдачи.

Я надеюсь, что данная статья поможет вам правильно настроить редирект для HTTPS –протокола и осуществить переход на SSL-сертификат с наименьшими потерями. Если данная статья вам понравилась, делайте репост в социальные сети и подписывайтесь на мою рассылку. Желаю вам успешного переезда и до встречи в следующих статьях.

Если данная статья вам понравилась, делайте репост в социальные сети и подписывайтесь на мою рассылку. Желаю вам успешного переезда и до встречи в следующих статьях.

С уважением Юлия Гусарь

.htaccess — Неправильно настроена доступная индексная страница — Как исправить?

спросил

Изменено 6 месяцев назад

Просмотрено 5к раз

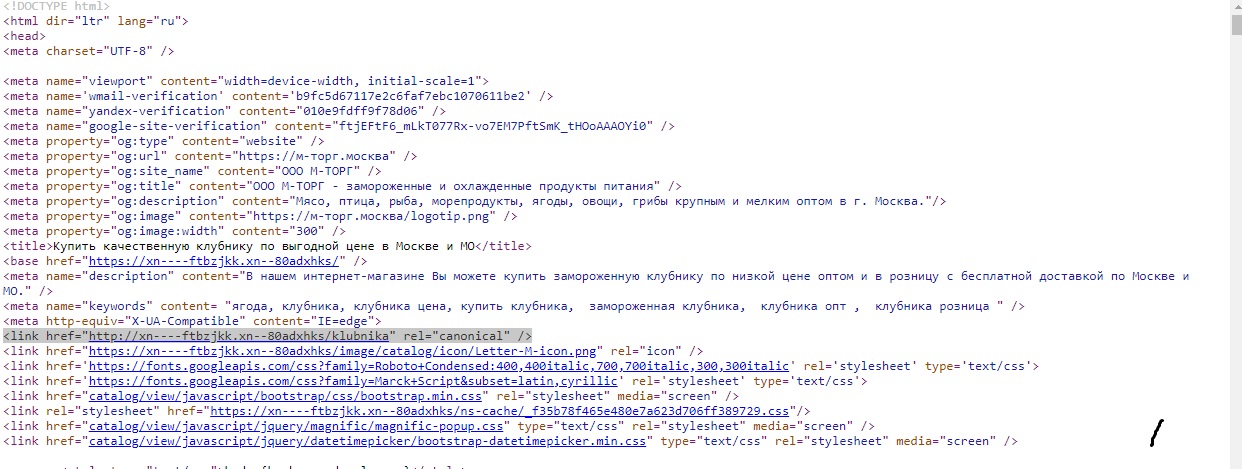

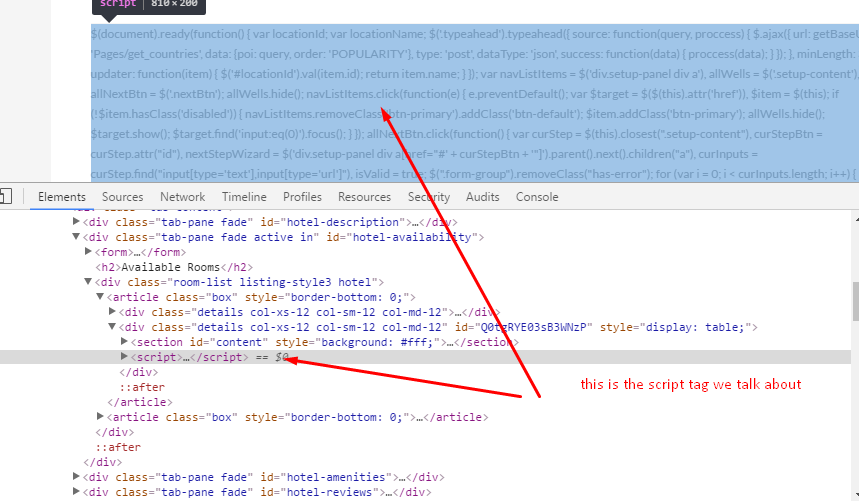

Я запустил веб-сайт, созданный с помощью SiteCheckerPro. Я вижу «критическую ошибку», но не знаю, как ее исправить. Ошибка «Уязвимость URL: неправильно настроена»

В отчете указано:

«Уязвимость URL-адреса

Поисковые системы видят ваш https://website.co.uk и https://website.co.uk/index.html (или https://website.co.

uk/index.php) как разные страницы.

Если вы явно не укажете Google, какой URL-адрес является каноническим, Google сделает выбор за вас или может считать их обоих равными веса, что может привести к нежелательному поведению.»

Я понимаю, что он мне говорит, только не могу понять, как это исправить. 9(.*)$ http://%1/$1 [R=301,L] #http > https RewriteCond %{HTTPS} выкл. RewriteRule (.*) https://%{HTTP_HOST}%{REQUEST_URI} [R,L]

Я не могу понять, что еще я могу сделать, чтобы исправить эту ошибку?

- .htaccess

- перенаправление

- url-rewriting

- url-redirection

Добавление этого в файл htaccess устранило проблему.

Перенаправление 301 /index.html https://website.co.uk/

Редирект 301 /index.php https://website.co.uk/

9index.php(/.*)?$ http://%{HTTP_HOST}$1 [R=301]

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя электронную почту и пароль

Опубликовать как гость

Электронная почта

Требуется, но никогда не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

html.

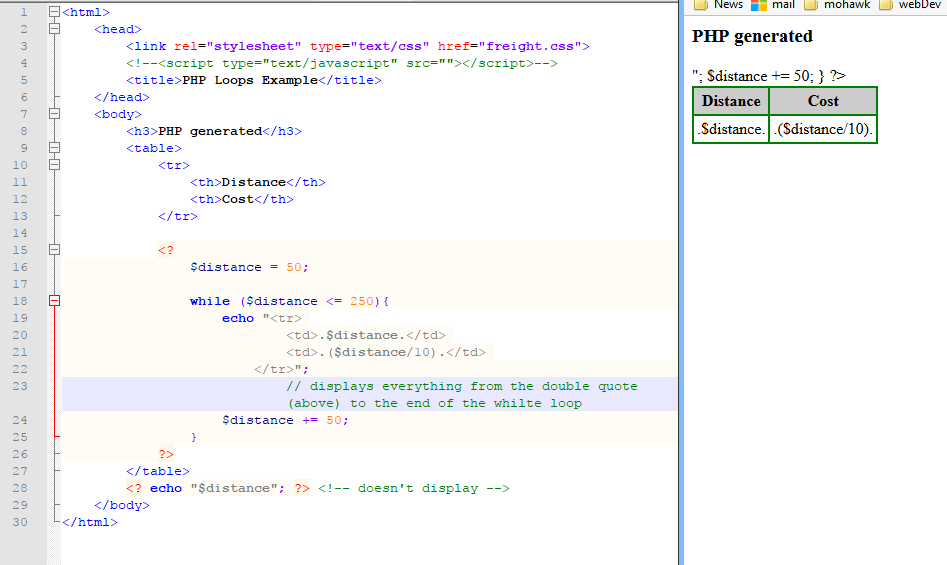

Является ли индексный файл для каждой страницы неправильным способом настройки сайта?

Является ли индексный файл для каждой страницы неправильным способом настройки сайта?Моя цель состояла в том, чтобы запретить пользователю вводить .html для доступа к странице, которую он ищет на нашем сайте. На других сайтах я оставил имя файла как /pagename.html, и пользователь мог ввести только /pagename, и страница загружалась. По какой-то причине это было невозможно с настройками нашего сервера (сервер GoDaddy Plesk Parallel), поэтому я решил создать папку для каждой нужной мне страницы, а фактическим файлом будет /index.html. Моя цель была достигнута, и теперь пользователю не нужно включать .html для загрузки страницы. Проблема сейчас в том, что отчеты Google и SEOmoz считывают тонны дублированного контента. Причина в том, что пользователь может ввести 3 разных слова, чтобы попасть на одну и ту же страницу — технически 6, если вы включите «www»:

sitename.com/services

sitename.com/services/

sitename.com/services/index.html

Поисковые системы отображают его вторым способом (http://sitename. com/services/), и если вы наберете это без «/», он перенаправляет на показ с «/». SEOmoz говорит, что у меня есть 301 редирект для каждой страницы, чтобы это произошло, но мы никогда не делали этого вручную.

com/services/), и если вы наберете это без «/», он перенаправляет на показ с «/». SEOmoz говорит, что у меня есть 301 редирект для каждой страницы, чтобы это произошло, но мы никогда не делали этого вручную.

Я попытался создать файл .htaccess с перенаправлениями с sitename.com/services/ на sitename.com/services, но страница не загружается из-за слишком большого количества перенаправлений.

Нарушил ли я какие-то важные правила, настроив его таким образом?

Обратите внимание, что «sitename.com/services/» — это всего лишь пример страницы, и весь наш сайт из 50 страниц настроен таким образом. Фактический сайт http://www.logicalposition.com.

- HTML

- SEO

1

Предпочтительный способ — настроить сервер для управления обработкой URL-адресов. Например, если вы находитесь на сервере Apache, вы можете использовать следующее предложение и создать/изменить файл .htaccess, чтобы получить желаемый эффект. (.*)\.html$ /$1 [L,R=301]

(.*)\.html$ /$1 [L,R=301]

Во-первых, похоже, что вы не выполнили базовую работу ногами, чтобы свести это к минимуму. Вам нужно решить, хотите ли вы www.samplesite.com или просто samplesite.com? Затем вы можете очень легко установить это с помощью .htaccess (см. этот удобный инструмент). Это будет означать, что у вас будет не более трех вариантов, а не 6.

Я бы принял предложение @Jassons и использовал обработку URL-адресов — 2 моих клиента в настоящее время используют GoDaddy, и оба используют этот метод, поэтому он должен полностью поддерживаться.

Еще несколько полезных ссылок для обработки URL/перезаписи htaccess (хотя примечание: настройка переадресации 301 требует времени, терпения и тщательного мониторинга ошибок сканирования в Web Master Tools, поэтому обработка URL предпочтительнее!) 9(.*)$ index.php?category=$1

Я думаю, что вы уже сделали это частично, но вы заметите, что отправлен заголовок перенаправления 301, это означает, что когда пауки посещают ваш сайт, они будут обновлять URL-адрес, чтобы иметь конечную косую черту — это не будет с ночевкой.

uk/index.php)

как разные страницы.

uk/index.php)

как разные страницы.