Как найти дубли страниц на сайте

Содержание статьи

- Что такое дубли страниц?

- Могут ли дубли плохо сказаться на продвижении сайта

- Причины возникновения дублей

- Способы поиска дублирующего контента

- XENU

- Screaming Frog

- Comparser

- Поисковая выдача

- Онлайн-сервисы

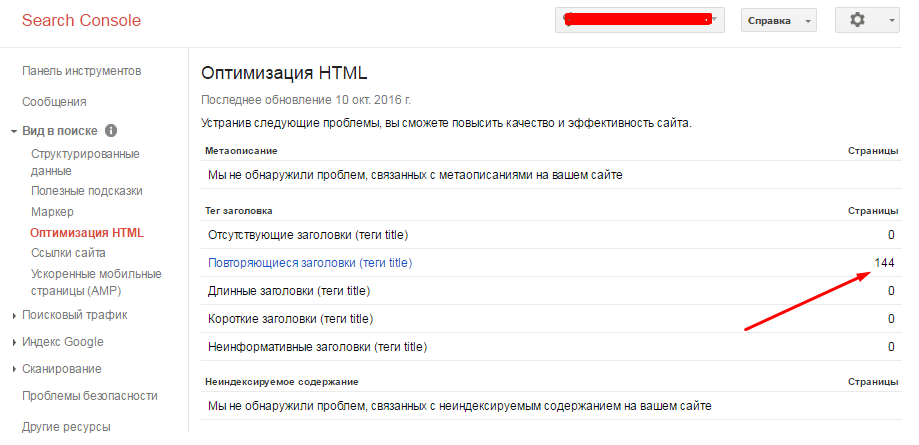

- Google Webmaster

- Sitereport

- Решение проблемы

Наличие дублей страниц в индексе — это такая страшная сказка, которой seo-конторы пугают обычно владельцев бизнеса. Мол, смотрите, сколько у вашего сайта дублей в Яндексе! Честно говоря, не могу предоставить примеры, когда из-за дублей сильно падал трафик. Но это лишь потому, что эту проблему я сразу решаю на начальном этапе продвижения. Как говорится, лучше перебдеть, поэтому приступим.

Что такое дубли страниц?

Дубли страниц – это копии каких-либо страниц. Если у вас есть страница site.ru/bratok.html с текстом про братков, и точно такая же страница site. ru/norma-pacany.html с таким же текстом про братков, то вторая страница будет дублем.

ru/norma-pacany.html с таким же текстом про братков, то вторая страница будет дублем.

Могут ли дубли плохо сказаться на продвижении сайта

Могут, если у вашего сайта проблемы с краулинговым бюджетом (если он маленький).

Краулинговый бюджет — это, если выражаться просто, то, сколько максимум страниц вашего сайта может попасть в поиск. У каждого сайта свой КБ. У кого-то это 100 страниц, у кого-то — 25000.

Если в индексе будет то одна страница, то другая, в этом случае они не будут нормально получать возраст, поведенческие и другие «подклеивающиеся» к страницам факторы ранжирования. Кроме того, пользователи могут в таком случае ставить ссылки на разные страницы, и вы упустите естественное ссылочное. Наконец, дубли страниц съедают часть вашего краулингового бюджета. А это грозит тем, что они будут занимать в индексе место других, нужных страниц, и в итоге нужные вам страницы не будут находиться в поиске.

Причины возникновения дублей

Сначала вам нужно разобраться, почему на вашем сайте появляются дубли. Это можно понять по урлу, в принципе.

- Дубли могут создавать ID-сессии. Они используются для контроля за действиями пользователя или анализа информации о вещах, которые были добавлены в корзину;

- Особенности CMS (движка). В WordPress такой херни обычно нету, а вот всякие Джумлы генерируют огромное количество дублей;

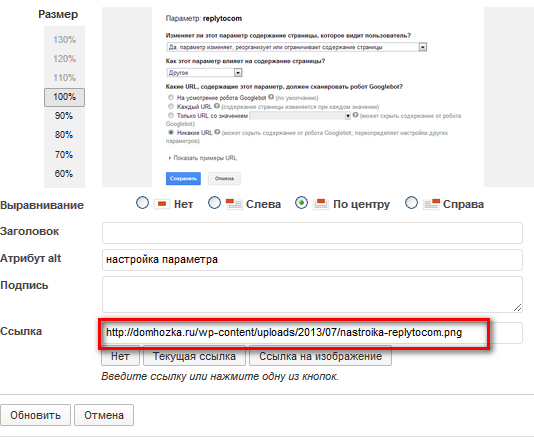

- URL с параметрами зачастую приводят к неправильной реализации структуры сайтов;

- Страницы комментариев;

- Страницы для печати;

- Разница в адресе: www – не www. Даже сейчас поисковые роботы продолжают путать домены с www, а также не www. Об этом нужно позаботиться для правильной реализации ресурса.

Способы поиска дублирующего контента

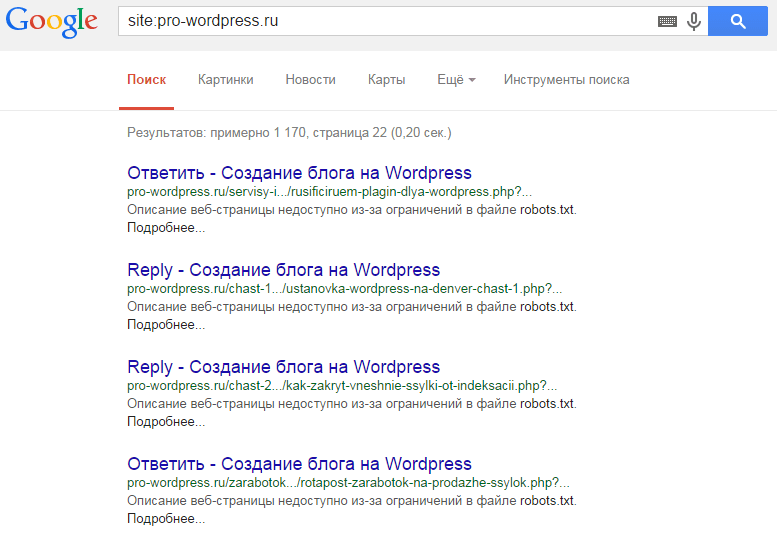

Можно искать дубли программами или онлайн-сервисами. Делается это по такому алгоритму — сначала находите все страницы сайта, а потом смотрите, где совпадают Title.

Делается это по такому алгоритму — сначала находите все страницы сайта, а потом смотрите, где совпадают Title.

XENU

XENU – это очень олдовая программа, которая издавна используется сеошниками для сканирования сайта. Лично мне её старый интерфейс не нравится, хотя задачи свои она в принципе решает. На этом видео парень ищет дубли именно при помощи XENU:

Screaming Frog

Я лично пользуюсь либо Screaming Frog SEO Spider, либо Comparser. «Лягушка» — мощный инструмент, в котором огромное количество функций для анализа сайта.

Comparser

Comparser – это все-таки мой выбор. Он позволяет проводить сканирование не только сайта, но и выдачи. То есть ни один сканер вам не покажет дубли, которые есть в выдаче, но которых уже нет на сайте. Сделать это может только Компарсер.

Поисковая выдача

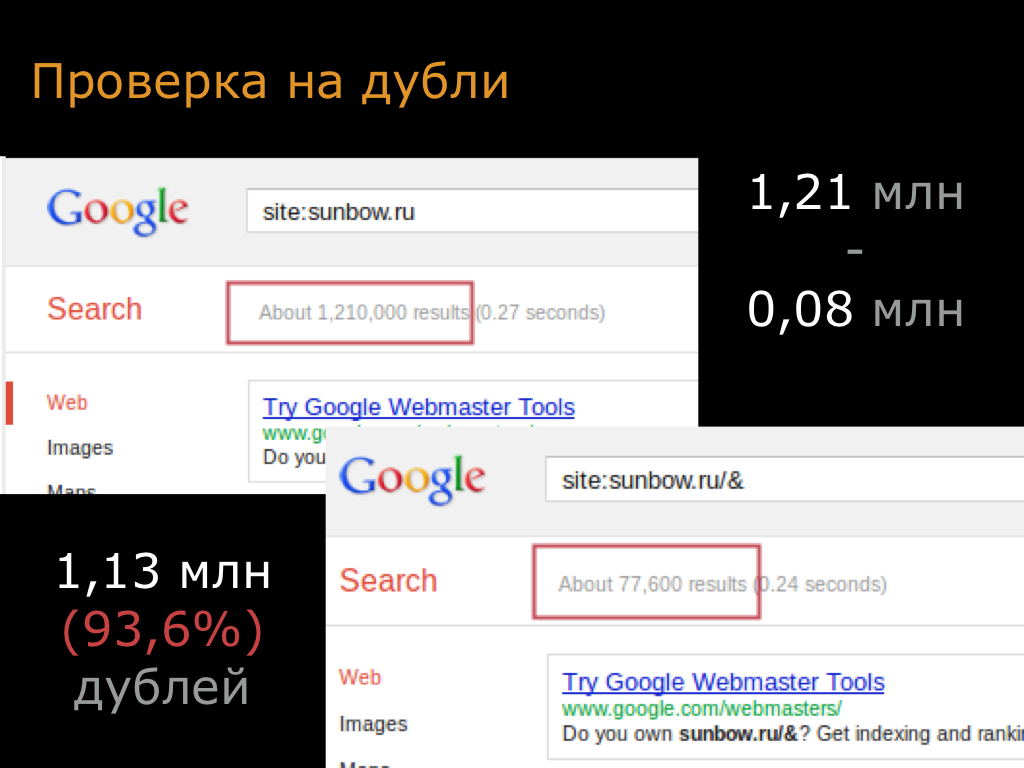

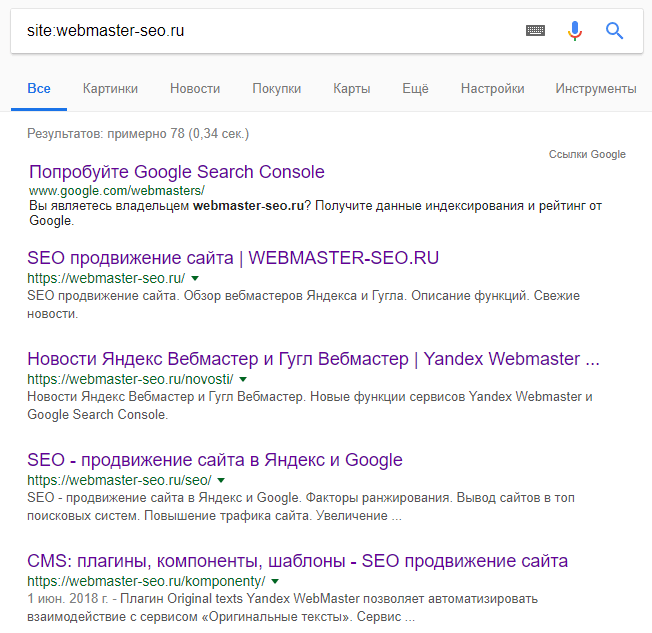

Можно также и ввести запрос вида site:vashsite. ru в выдачу поисковика и смотреть дубли по нему. Но это довольно геморройно и не дает полной информации. Не советую искать дубли таким способом.

ru в выдачу поисковика и смотреть дубли по нему. Но это довольно геморройно и не дает полной информации. Не советую искать дубли таким способом.

Онлайн-сервисы

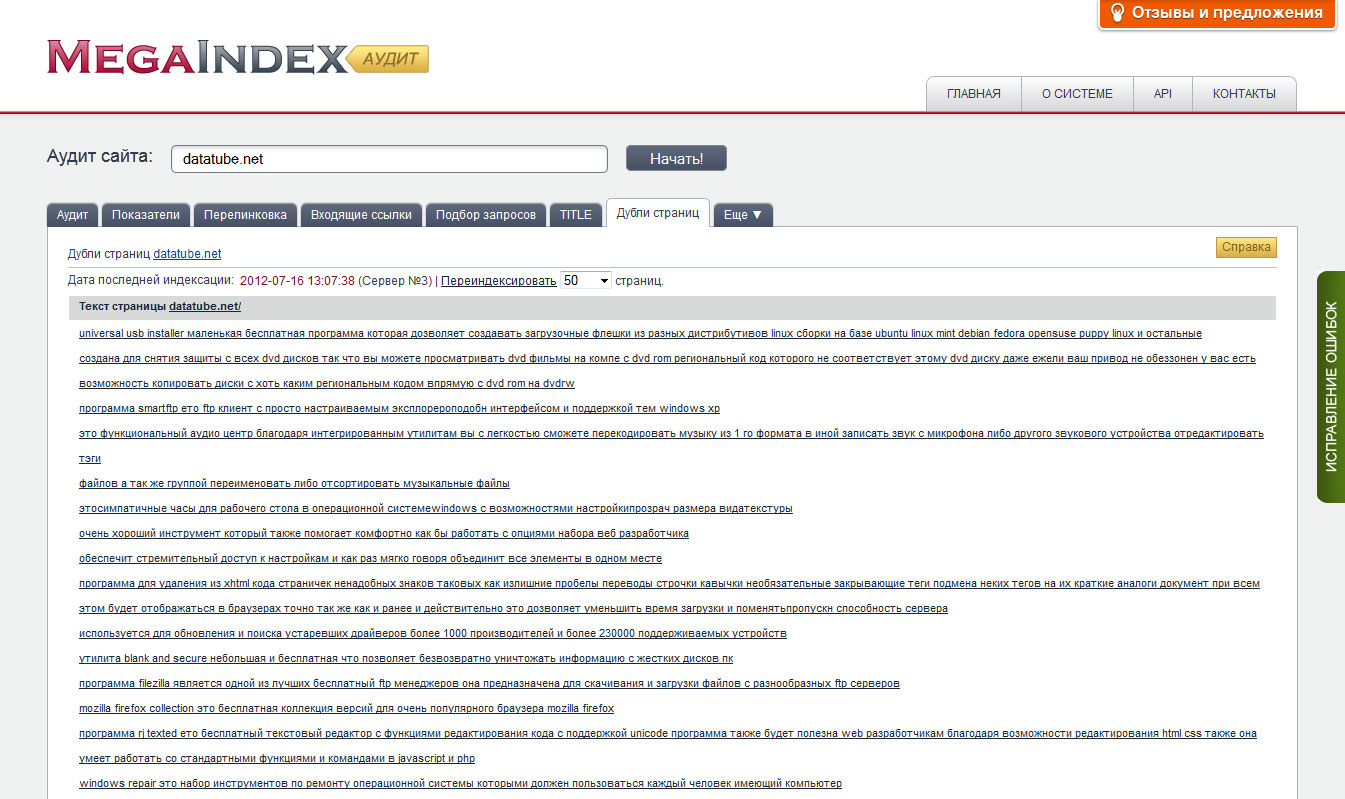

Чтобы проверить сайт на дубли, можно использовать и онлайн-сервисы.

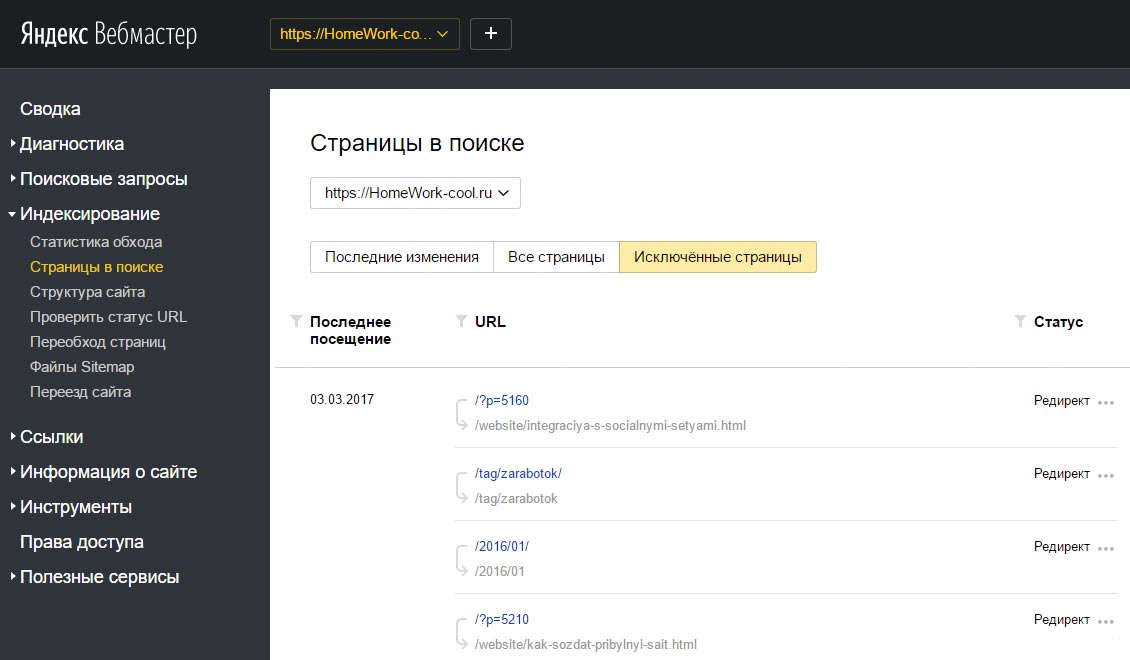

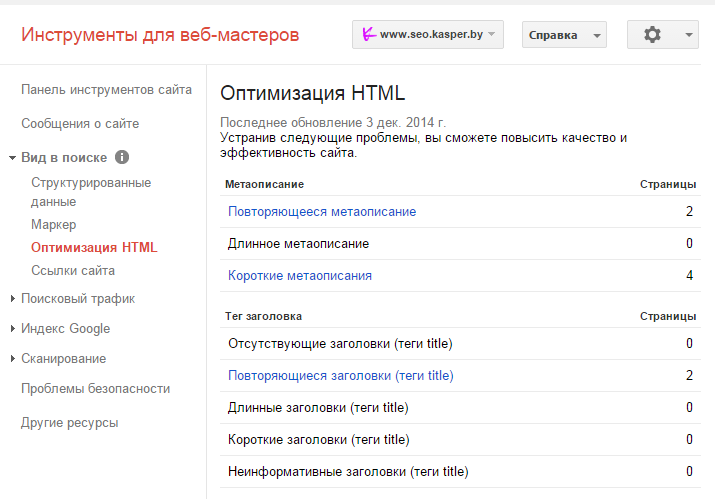

Google Webmaster

Sitereport

Аудит сайта от сервиса Sitereport также поможет найти дубли, помимо всего прочего. Хотя дублированные страницы можно найти и более простыми/менее затратными способами.

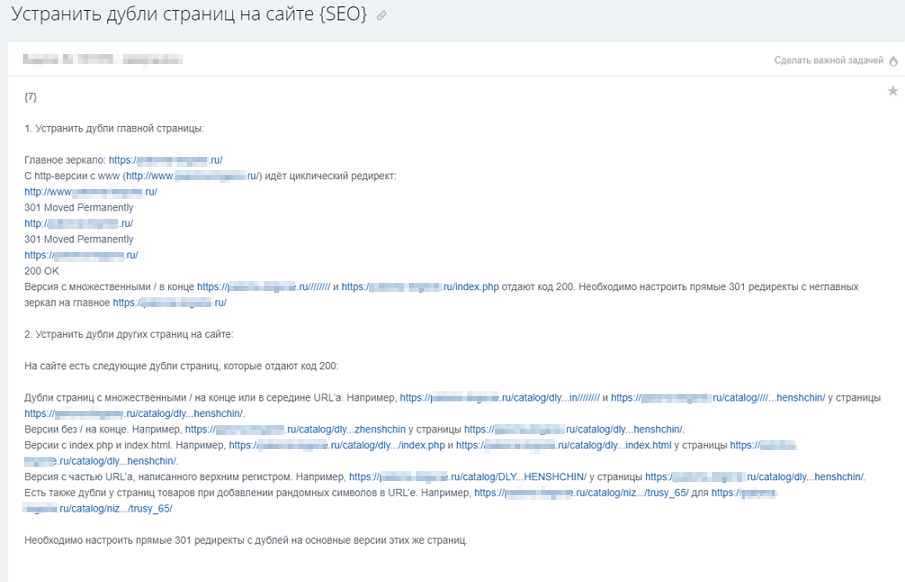

Решение проблемы

Для нового и старого сайта решения проблемы с дублями — разные. На новом нам нужно скорее предупредить проблему, провести профилактику (и это, я считаю, самое лучшее). А на старом уже нужно лечение.

На новом сайте делаем вот что:

- Сначала нужно правильно настроить ЧПУ для всего ресурса, понимая, что любые ссылки с GET-параметрами нежелательны;

- Настроить редирект сайта с www на без www или наоборот (тут уж на ваш вкус) и выбрать главное зеркало в инструментах вебмастера Яндекс и Google;

- Настраиваем другие редиректы — со страниц без слеша на страницы со слешем или наоборот;

- Завершающий этап – это обновление карты сайта.

Отдельное направление – работа с уже имеющимся, старым сайтом:

- Сканируем сайт и все его страницы в поисковых системах;

- Выявляем дубли;

- Устраняем причину возникновения дублей;

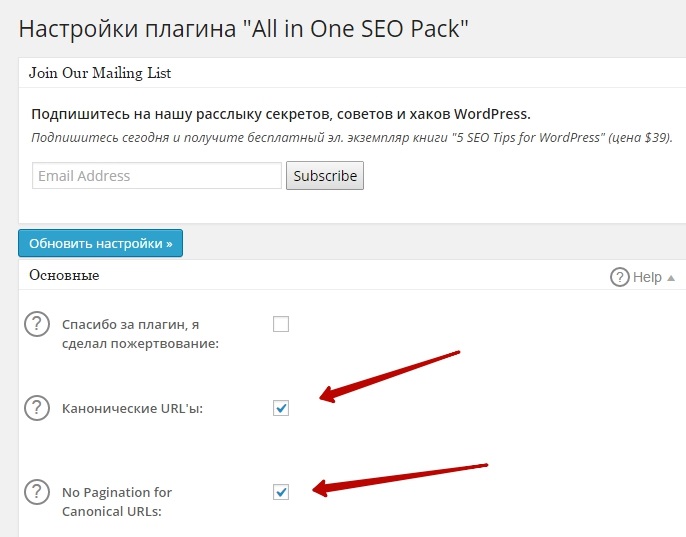

- Проставляем 301 редирект и rel=»canonical» с дублей на основные документы;

- В обязательном порядке 301 редиректы ставятся на страницы со слешем или без него. Обязательная задача – все url должны выглядеть одинаково;

- Правим роботс — закрываем дубли, указываем директиву Host для Yandex с заданием основного зеркала;

- Ждем учета изменений в поисковиках.

Как-то так.

Дубли страниц на сайте — как их найти и удалить? Онлайн поиск без помощи Яндекс Вебмастер

Январь 29, 2018

Основы SEO Инструкции к Labrika Негативные факторы

Что такое дубли страниц?

Дубли страниц на сайте — это грубая SEO-ошибка, которая характеризуется тем, что контент одной страницы полностью идентичен содержанию другой. Таким образом, они в точности копируют друг друга, но при этом доступны по разным URL-адресам. Это затрудняет индексирование страниц.

Таким образом, они в точности копируют друг друга, но при этом доступны по разным URL-адресам. Это затрудняет индексирование страниц.

Самые частые причины возникновения дублей:

Не сделан редирект flhtcjd страниц, имеющих адреса с www и без www. В этом случае каждая страница сайта будет дублироваться, так как остается доступной по двум адресам, например:

http://www.site.ru/page и http://site.ru/page - полные дублиСтраницы сайта доступны по адресу со слэшем и без слэша:

http://site.ru/page/ и http://site.ru/pageТакже URL страницы может быть с .php и .html на конце либо без расширения. Как правило, это связано с особенностями cms (административной панели сайта):

http://site.ru/page.html и http://site.ru/page; http://site.ru/page.php и http://site.ru/page- Отдельно стоит выделить неполные дубли страниц. В этом случае контент на двух разных страницах не будет идентичным на 100%.

Сходство и дублирование может появляться по причине того, что некоторые блоки на сайте являются сквозными — например, это может быть блок о доставке, который отображается на страницах всех товаров.

Сходство и дублирование может появляться по причине того, что некоторые блоки на сайте являются сквозными — например, это может быть блок о доставке, который отображается на страницах всех товаров. - Некоторые карточки интернет магазина со схожими товарами содержат идентичное описание, что также может рассматриваться как грубая ошибка.

- Постраничная пагинация каталога с товарами. В этом случае текст и МЕТА-теги на всех страницах одной категории могут быть одинаковыми.

Как дубли влияют на ранжирование?

Дубли негативно влияют на ранжирование вашего сайта в выдаче — за наличие полных дубликатов страниц интернет-ресурс может с большой степенью вероятности подвергнуться пессимизации со стороны поисковых систем.

- Яндекс и Google очень трепетно относятся к уникальности контента на web-ресурсах. В случае, если данные на страницах дублируются, они признаются неуникальными. За это на сайт могут быть наложены санкции.

- Наличие большого количества дублей страниц сильно усложняет процесс индексации сайта и запутывает поисковых роботов.

- Затрудняется продвижение посадочных страниц, так как поисковая система не может выбрать релевантную страницу из двух одинаковых.

- Теряется «вес» страниц, поскольку распределяется между двумя одинаковыми документами.

Подробно описывается негативное влияние дублей и методы борьбы с ними в статье Google «Консолидация повторяющихся URL»

Яндекс, в свою очередь, предлагает на эту тему видеоурок «Поисковая оптимизация сайта: ищем дубли страниц», где разъясняется терминология и способы решения проблемы.

Как обнаружить дубли у себя на сайте?

С поиском дублей могут возникнуть трудности не только у обладателей больших web-ресурсов, но и у владельцев совсем небольших сайтов, так как некоторые дубли, возникающие из-за особенностей и ошибок CMS, очень сложно обнаружить. Быстро и без лишних трудозатрат найти дубли страниц можно с помощью онлайн сервиса Labrika. Для этого нужно просто провести анализ вашего проекта и получить отчет с результатами проверки.

В отчете вы можете увидеть следующую информацию:

- Страница сайта, которая имеет дубль.

- Дубль этой страницы

- Процент схожести страниц. Благодаря этому проценту вы сможете определить, является ли дубль страницы полным.

Получив данные из отчета, вы сможете сэкономить время и сразу начать устранять эти ошибки.

Как устранить дубли на сайте?

Важно в первую очередь установить характер дубля и уже после этого выбирать способ его устранения.

- Если копий на сайте небольшое количество и их происхождение связано с ошибками CMS (допустим, страница доступна по адресам

http://site.ru/category/tovarиhttp://site.ru/tovar, то самым простым методом решения проблемы будет следующий. Дубль необходимо запретить для индексации поисковых систем вручную в файле robots.txt помощью директивы Disallow, или указать информацию о каноничных страницах с помощью rel canonical (также см.

- Если появление дубликатов носит системный характер и связано с такими ошибками, как, например, несклеенный домен (страница доступна по адресу с www и без www), то в таком случае необходимо выбрать главное зеркало (например, адрес сайта без www), воспользоваться командой 301 redirect (перенаправление со страниц с www на страницы без них), которая прописывается в специальном файле htaccess.

- В случае, если вы имеете дело с постраничной пагинацией товаров одной категории, Яндекс советует использовать атрибут rel=»canonical». Более подробно о применении этого атрибута на страницах с пагинацией вы можете прочитать в статье Блога Яндекс «Несколько советов интернет-магазинам по настройкам индексирования».

Читать дальше подобные статьи

- Канонические URL. Руководство по использованию атрибута rel = Canonical

- Правильно использовать атрибут rel=»canonical». Онлайн-проверка канонических ссылок на страницу

- Настроить редирект

- Как настроить страницу с ошибкой 404?

- Релевантность. Карта релевантных страниц

Online SEO-инструменты для продвижения сайтов

Проверьте свой сайт и сайты конкурентов на 205 факторов поисковых систем.

Лучшее средство проверки дубликатов контента онлайн

Все ваши проблемы с дублированием контента решены сегодня с помощью нашей быстрой и точной проверки контента веб-сайта на плагиат.

Просто вставьте свой контент в поле ниже, чтобы начать!

Просто вставьте свой контент в поле ниже, чтобы начать! Для владельцев онлайн-сайтов нет ничего более захватывающего, чем ранжирование на первых страницах страниц результатов поисковой системы Google (SERP). И точно так же нет ничего более обескураживающего, чем уведомление от Google о том, что на вашем сайте есть дублированный контент. Это одно из самых жестких наказаний, с которым приходится сталкиваться любому веб-мастеру, так зачем ждать штрафного молотка, если вы можете предотвратить его с самого начала?

Мы помогаем вам предотвратить плагиат веб-контента, чтобы вы:

- Не подвергайтесь наказанию Google

- Не публиковать плагиат в блогах

- Проблема с дублированием контента

- Не нарушайте авторские права на материалы

Вот как мы помогаем вам предотвратить плагиат на вашем веб-сайте, используя наши точные и

бесплатная проверка контента сайта на плагиат.

Использование средства проверки на плагиат как части веб-контента СОП

Общепризнано, что контент является королем, когда дело касается онлайн-сайтов, но это не означает, что контент любого типа. Когда вы имеете дело с веб-контентом, убедитесь, что вы создали для него СОП, чтобы не получить некачественный или плагиатный контент. Вот пример процесса:

Исследование ключевых слов > Выбор темы > Написание > Обзор > Проверка на плагиат > Опубликовать

Вы можете легко интегрировать наше средство проверки веб-контента на плагиат прямо перед публикацией. Это предотвращает дублирование вашего сайта. Просто скопируйте и вставьте свой контент в поле выше, чтобы начать.

Веб-контент какого типа следует проверять

Итак, вы убеждены, что вам нужна программа для проверки веб-контента на плагиат, но с чего начать? Вот некоторые основные типы контента, которые будут важны для сканирования ботами Google, и вы должны убедиться, что они не являются плагиатом.

Метаданные: все метаданные, включая заголовок, описание, альтернативные теги и т. д., не должны дублироваться нигде в Интернете, а также на сайте.

Целевые страницы: весь контент веб-страницы, который охватывает ваши основные услуги или продукты, должен быть проверен на плагиат и убедиться, что он не дублируется на веб-сайте или других сайтах.

Статьи в блогах: в большинстве случаев Google идентифицирует статьи в блогах как плагиат, потому что вероятность того, что авторы скопируют часть текста с другого веб-сайта, высока из-за вставки цитат, статистики, текста или другой формы контента в статьи без указания авторства. . Лучший способ справиться с этим — определить плагиат с помощью средства проверки веб-контента и перефразировать или изменить его.

Другие страницы: Другие страницы, такие как «О нас», «Часто задаваемые вопросы», «Условия» и «Политика конфиденциальности», несут ответственность за ту же проблему. С помощью средства проверки веб-контента вы можете немедленно остановить сканирование и индексацию сайта, изменив содержимое или поместив эти страницы в robots.txt.

С помощью средства проверки веб-контента вы можете немедленно остановить сканирование и индексацию сайта, изменив содержимое или поместив эти страницы в robots.txt.

Теперь вы знаете, что средство проверки веб-контента на плагиат — это необходимый инструмент, чтобы предотвратить попадание Google на ваш веб-сайт за дублирование контента или нарушение авторских прав. Проверьте весь ваш веб-контент!

ChatGPT PROMPT #7 — Как проверить сайт на наличие двойного контента?

Никола ВулевичНикола Вулевич

Конферансье @RatnikSvetlosti (Воин Света)⚔️🌞|Фермер @Vulevic Village|Соучредитель @OneFit.rs🥗🏋️|Инженер AI Prompt🤖🦾|Аналитик и руководитель CRO📈💻

Опубликовано 27 апреля 2023 г.

+ Подписаться

Способность к обучению — это дар; Способность учиться – это навык; Желание учиться – это выбор.

― Брайан Герберт, Дом Харконнен (сын автора «Хроник Дюны» Фрэнка Герберта)

ПРОБЛЕМА

Как проверить сайт на двойное содержание?

ПОДСКАЗКА

Как быстрее всего проверить сайт на двойное содержание?

Напишите быстрое решение до 800 слов.

РЕШЕНИЕ

Самый быстрый способ проверить веб-сайт на наличие дублирующегося контента — использовать онлайн-инструменты и службы, специально предназначенные для выявления таких проблем. Дублированный контент может негативно повлиять на рейтинг вашего сайта в поисковых системах, поскольку поисковые системы могут оштрафовать ваш сайт за наличие похожего контента на нескольких страницах. Вот подробное руководство о том, как быстро проверить дублированный контент на вашем сайте:

- Используйте онлайн-инструменты для обнаружения дублированного контента:

Существует несколько доступных онлайн-инструментов, которые могут помочь вам определить дублированный контент на вашем веб-сайте. Некоторые популярные и надежные инструменты включают в себя:

Некоторые популярные и надежные инструменты включают в себя:

a. Copyscape: Copyscape (www.copyscape.com) — широко используемая онлайн-система проверки на плагиат и дублирование контента. Он позволяет вам ввести URL-адрес вашего веб-сайта, а затем сканирует Интернет, чтобы найти другие веб-сайты или страницы с аналогичным содержанием. Он также предлагает премиум-версию для более глубокого анализа и функцию Copysentry, которая обеспечивает регулярный мониторинг и оповещения о любом новом дублирующемся контенте.

б. Siteliner: Siteliner (www.siteliner.com) — еще один полезный инструмент, который может помочь вам определить дублирующийся контент на вашем собственном веб-сайте. Просто введите URL-адрес вашего сайта, и Siteliner проанализирует ваши веб-страницы, предоставив подробный отчет о дублирующемся содержании, неработающих ссылках и других потенциальных проблемах, которые могут повлиять на эффективность SEO вашего сайта.

в. Plagspotter: Plagspotter (www.plagspotter.com) — это онлайн-сервис обнаружения дублированного контента, который позволяет вам проверять свой веб-сайт на наличие дублированного контента как на вашем сайте, так и в Интернете. Он создает исчерпывающий отчет, в котором выделяется дублированный контент, что упрощает решение проблем.

- Используйте консоль поиска Google:

Консоль поиска Google (ранее известная как Инструменты Google для веб-мастеров) — это бесплатная служба, предоставляемая Google, которая помогает владельцам веб-сайтов отслеживать и поддерживать присутствие своего сайта в результатах поиска Google. Он предлагает функцию, которая позволяет вам находить повторяющиеся проблемы с контентом на вашем веб-сайте. Для этого выполните следующие действия:

а. Войдите в свою учетную запись Google Search Console (или создайте ее, если у вас ее нет).

б. Добавьте и подтвердите свой сайт.

в. Перейдите к отчету «Покрытие» в разделе «Индекс» в меню слева.

д. Ищите любые ошибки или предупреждения, связанные с дублирующимся контентом, например «Повторяющийся отправленный URL-адрес, не выбранный как канонический» или «Повторяющиеся теги заголовков».

- Проведите ручную проверку:

Если ваш веб-сайт небольшой и содержит всего несколько страниц, вы можете рассмотреть возможность ручной проверки дублирующегося контента. Откройте каждую страницу в браузере и используйте функцию «Найти» (Ctrl+F или Cmd+F) для поиска конкретных фраз, которые, как вы подозреваете, могут быть дублированы. Хотя этот метод требует много времени и не подходит для крупных веб-сайтов, он может быть эффективным для небольших сайтов.

- Используйте инструменты для сканирования веб-сайтов:

Инструменты для сканирования веб-сайтов, такие как Screaming Frog SEO Spider и DeepCrawl, могут помочь вам выявить проблемы с дублированием контента на вашем сайте. Эти инструменты сканируют ваш сайт, как боты поисковых систем, и предоставляют подробные отчеты по различным аспектам, связанным с SEO, включая дублированный контент. Они также могут помочь вам найти неработающие ссылки, отсутствующие метатеги и другие проблемы, которые могут повлиять на эффективность SEO вашего сайта.

Эти инструменты сканируют ваш сайт, как боты поисковых систем, и предоставляют подробные отчеты по различным аспектам, связанным с SEO, включая дублированный контент. Они также могут помочь вам найти неработающие ссылки, отсутствующие метатеги и другие проблемы, которые могут повлиять на эффективность SEO вашего сайта.

- Проверить наличие повторяющихся URL-адресов:

Проблемы с дублированием контента также могут возникать из-за того, что несколько URL-адресов указывают на один и тот же контент. Это может произойти из-за параметров URL, идентификаторов сеанса или других вариантов URL. Чтобы проверить наличие повторяющихся URL-адресов, вы можете использовать такие инструменты, как Google Search Console, Screaming Frog SEO Spider или специализированный инструмент для проверки повторяющихся URL-адресов, такой как URLitor (www.urlitor.com).

В заключение, самый быстрый способ проверить свой веб-сайт на наличие дублирующегося контента — использовать онлайн-инструменты и сервисы, такие как Copyscape, Siteliner или Plagspotter.

Сходство и дублирование может появляться по причине того, что некоторые блоки на сайте являются сквозными — например, это может быть блок о доставке, который отображается на страницах всех товаров.

Сходство и дублирование может появляться по причине того, что некоторые блоки на сайте являются сквозными — например, это может быть блок о доставке, который отображается на страницах всех товаров.