Как закрыть сайт от индексации и что это означает — WordPressify

1 Как понимать «Попросить поисковые системы не индексировать сайт»

2 Почему иногда нужно закрыть сайт от индексации

3 Как проверить, не отпугивает ли ваш сайт поисковые системы

4 Как препятствовать индексации поисковыми системами в WordPress

4.1 Недостатки использования опции “Попросить поисковые системы не индексировать сайт”

5 Другие способы закрыть сайт от индексации

Если вы заглядывали в серверную часть WordPress, то заметили настройку: «Попросить поисковые системы не индексировать сайт», и задались вопросом, что это означает. А может быть ищете способ скрыть свой сайт от нежелательных посетителей и задаетесь вопросом, достаточно ли этого маленького флажка, чтобы контент оставался конфиденциальным.

Что означает эта опция и что именно она делает с сайтом? И почему не следует полагаться на нее, если вы пытаетесь скрыть свой контент?

Ответы на эти вопросы и несколько способов закрыть сайт от индексации и блокировки доступа к определенным страницам будут рассмотрены ниже.

Как понимать «Попросить поисковые системы не индексировать сайт»

Вы задумывались, как поисковые системы индексируют сайт и оценивают его SEO? Они делают это с помощью автоматизированной программы, называемой пауком, также известной как робот или краулер. Пауки «ползают» по сети, посещая веб-сайты и регистрируя их контент. Google использует их, чтобы ранжировать и размещать веб-сайты в результатах поиска, извлекать фрагменты текста из статей для страницы результатов поиска и вставлять изображения в Картинки Google.

Когда устанавливается флажок «Попросить поисковые системы не индексировать сайт», WordPress изменяет файл robots.txt (файл, дающий паукам инструкции о том, как сканировать сайт). А еще может добавить метатег в заголовок сайта, который сообщает Google и другим поисковым системам, что сайт или какой-либо контент закрыт от индексации.

А еще может добавить метатег в заголовок сайта, который сообщает Google и другим поисковым системам, что сайт или какой-либо контент закрыт от индексации.

Ключевое слово здесь – «попросить»: поисковые системы не обязаны выполнять этот запрос, особенно поисковые системы, не использующие стандартный синтаксис robots.txt, который использует Google.

Сканеры по-прежнему смогут найти ваш сайт. Но правильно настроенные сканеры прочитают файл robots.txt и уйдут, не индексируя контент и не показывая его в результатах поиска.

В прошлом эта опция в WordPress не мешала Google показывать веб-сайт в результатах поиска, просто индексируя его контент. Вы по-прежнему можете видеть, что ваши страницы отображаются в результатах поиска с ошибкой типа «Информация для этой страницы недоступна» или «Описание этого результата недоступно из-за файла robots.txt сайта».

Хотя Google не индексировал страницу, он также и не скрывал ее полностью. Эта аномалия привела к тому, что люди могли посещать страницы, которые им не предназначались. Благодаря WordPress 5.3 теперь он работает правильно, блокируя как индексацию, так и листинг сайта.

Благодаря WordPress 5.3 теперь он работает правильно, блокируя как индексацию, так и листинг сайта.

Представляете, как это разрушит SEO сайта, если случайно будет включен этот флажок? Критически важно использовать эту опцию только в том случае, если вы действительно не хотите, чтобы кто-либо видел контент – и даже в этом случае это не единственная мера, которую нужно предпринять.

Почему иногда нужно закрыть сайт от индексации

Веб-сайты созданы для того, чтобы их видели люди: чтобы пользователи читали статьи, покупали продукты, потребляли контент. Зачем намеренно пытаться блокировать поисковые системы?

Есть несколько причин, по которым нужно скрыть часть или весь свой сайт:

- Сайт находится в разработке и не готов к публикации.

- Используете WordPress в качестве системы управления контентом, но хотите, чтобы указанный контент оставался конфиденциальным.

- Пытаетесь скрыть конфиденциальную информацию.

- Хотите, чтобы сайт был доступен только небольшому количеству людей по ссылке или только через приглашения, а не через общедоступные страницы поиска.

- Планируете разместить некоторый контент для платного доступа (например, статьи, эксклюзивные предложения, информационные бюллетени).

- Хотите сократить трафик к старым, устаревшим статьям.

- Стараетесь предотвратить получение штрафов SEO на тестовых страницах или дублировании контента.

Для некоторых из этих пунктов есть лучшие решения – использование надлежащего автономного сервера разработки, установка приватности статей или размещение их под паролем. Но есть законные причины, по которым необходимо закрыть часть или весь свой сайт от индексации.

Как проверить, не отпугивает ли ваш сайт поисковые системы

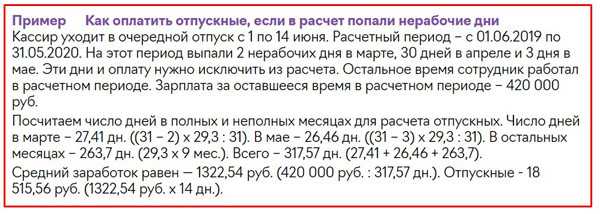

Хотя могут быть законные причины для закрытия сайта от индексации, может быть ужасным шоком понимание, что вы включили этот параметр без намерения или оставили его включенным случайно. Если трафик с сайта нулевой, то есть подозрение, что сайт не индексируется. Как подтвердить это предположение?

Один из простых способов – установить флажок «На виду» на главном экране панели администратора. Если видите сообщение «Поисковые системы не одобряют» (Search Engines Discouraged), значит, эта настройка активирована.

Если видите сообщение «Поисковые системы не одобряют» (Search Engines Discouraged), значит, эта настройка активирована.

Еще более надежный способ – проверить файл robots.txt. Это можно легко проверить в браузере, даже не заходя на сайт.

Чтобы проверить robots.txt, добавьте/robots.txtв конец URL вашего сайта. Например:https://namesite.com/robots.txt

Если видите, Disallow: /значит, весь сайт заблокирован для индексации.

Если видите, что Disallow:за ним следует URL-путь, например Disallow: /wp-admin/, это означает, что любой URL-адрес с /wp-admin/путем заблокирован. Такая структура является нормальной для некоторых страниц, но если, например, она блокирует /blog/страницы, которые необходимо проиндексировать, это может вызвать проблемы.

Теперь, когда WordPress использует метатеги, а не robots.txt для закрытия сайта от индексации, нужно проверить свой заголовок на наличие изменений.

Войдите в свой бэкэнд и выберите «Внешний вид» > « Редактор тем». Найдите заголовок темы (header.php) и следующий код:

<meta name='robots' content='noindex,nofollow' />

Еще можете проверить functions.php на наличие noindexтега, так как через этот файл можно удаленно вставить код в заголовок.

Если найдете этот код в своих файлах темы, значит сайт не индексируется Google. Но вместо того, чтобы удалять его вручную, сначала попробуем отключить исходную настройку.

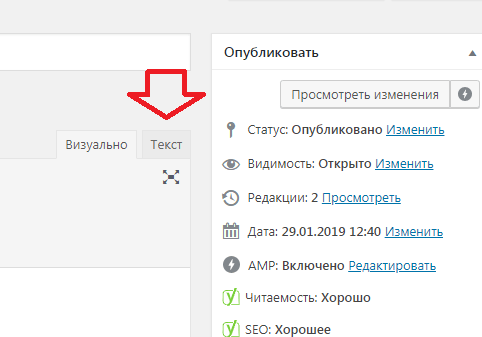

Как препятствовать индексации поисковыми системами в WordPress

Можно пропустить лишние шаги и сразу перейти к исходным настройкам, чтобы активировать или деактивировать опцию «Попросить поисковые системы не индексировать сайт» в WordPress.

Войдите в свою панель управления WordPress и перейдите в «Настройки» > «Чтение». Найдите параметр “Видимость для поисковых систем” с флажком “Попросить поисковые системы не индексировать сайт”.

Если обнаружите, что он уже включен и хотите, чтобы сайт был проиндексирован, снимите флажок. Если собираетесь запретить индексирование сайта, ставьте флажок (и запишите где-нибудь заметку, напоминающую выключить его позже!).

Теперь нажмите «Сохранить изменения», и все готово. Переиндексация сайта или его удаление из результатов поиска может занять некоторое время.

Если сайт все еще закрыт от индексации, можно удалить noindexкод из файла заголовка или вручную отредактировать robots.txt, чтобы убрать флаг «Disallow».

Это достаточно просто, но по каким причинам следует избегать этого варианта или, по крайней мере, не полностью полагаться на него?

Недостатки использования опции “Попросить поисковые системы не индексировать сайт”

Это кажется простым – поставьте галочку, и никто не сможет увидеть ваш сайт. Разве этого не достаточно?

Когда включаете этот параметр или любой другой подобный ему, он просто добавляет тег в заголовок или в файл  txt. Как показывают более старые версии WordPress, которые по-прежнему позволяют отображать ваш сайт в результатах поиска, небольшой сбой или другая ошибка может привести к тому, что люди увидят ваши предположительно скрытые страницы.

txt. Как показывают более старые версии WordPress, которые по-прежнему позволяют отображать ваш сайт в результатах поиска, небольшой сбой или другая ошибка может привести к тому, что люди увидят ваши предположительно скрытые страницы.

Кроме того, поисковые системы должны выполнить запрос на запрет индексировать указанный сайт. Основные поисковые системы, такие как Google и Bing, обычно выполняют эту опцию. Но не все поисковые системы используют один и тот же синтаксис robots.txt, и не все пауки, сканирующие Интернет, рассылаются поисковыми системами.

Можно думать, если на новом сайте нет ссылок, то он защищен от пауков, но это неправда. Существование на общем сервере, отправка электронного письма со ссылкой на веб-сайт или даже посещение сайта в браузере (особенно в Chrome) может открыть этот сайт для сканирования.

Если хотите скрыть контент, не рекомендуется просто добавлять параметр и надеяться, что он поможет. Давайте проясним: если контент, который закрыт от индексации, носит конфиденциальный или личный характер, ни в коем случае не следует полагаться на robots. txt или метатег, чтобы скрыть его.

txt или метатег, чтобы скрыть его.

И последнее, но не менее важное: эта опция полностью скроет сайт от поисковых систем, хотя во многих случаях нужно закрыть индексирование только определенные страницы.

Итак, что нужно делать вместо этого метода или вместе с ним?

Смотрите также:

Как исправить фатальную ошибку WordPress max_execution_time

Другие способы закрыть сайт от индексации

Хотя вариант, предоставляемый WordPress, обычно выполняет свою работу, в определенных ситуациях лучше использовать другие методы сокрытия контента. Даже сам Google говорит, что не используйте robots.txt для скрытия страниц.

Пока сайт имеет доменное имя и находится на общедоступном сервере, нет никакого способа гарантировать, что контент не будет виден или проиндексирован поисковыми роботами, если вы не удалите его или не скроете за паролем или требованием входа в систему.

Тем не менее, как лучше скрыть сайт или определенные страницы на нем?

Блокируйте поисковые системы с помощью .

htaccess

htaccessХотя его реализация функционально такая же, как при простом использовании опции «Попросить поисковые системы не индексировать сайт», вы можете вручную использовать .htaccess, чтобы закрыть индексирование сайта.

Используйте программу FTP / SFTP для доступа к сайту и открытия файла .htaccess, который обычно находится в корневой папке (первая папка, которую видно при открытии сайта) или в public_html. Добавьте этот код в файл и сохраните:

Header set X-Robots-Tag "noindex, nofollow"

Примечание. Этот метод работает только для серверов Apache. Серверы NGINX должны вместо этого кода добавить другой код в файл .conf, который можно найти в / etc / nginx / (можете найти здесь пример реализации метатега):

add_header X-Robots-Tag "noindex, nofollow";

Защита секретных страниц паролем

Если есть определенные статьи или страницы, которые поисковые системы не должны индексировать, лучший способ закрыть их – защитить сайт паролем. Таким образом, только вы и желаемые пользователи сможете видеть этот контент.

Таким образом, только вы и желаемые пользователи сможете видеть этот контент.

К счастью, эта функция встроена в WordPress, поэтому устанавливать какие-либо плагины не нужно. Просто перейдите на Страницы записей и нажмите на ту, которую хотите скрыть. Отредактируйте свою страницу и найдите меню справа Статус и видимость > Видимость.

Если не используете Gutenberg, процесс будет аналогичным. Найдите такое же меню в поле «Опубликовать». Измените Видимость на «Защищено паролем» и введите пароль, затем сохраните – и теперь контент скрыт от широкой публики.

Что делать, если защитить паролем весь свой сайт не нужно? А требовать пароль для каждой страницы непрактично. Можно включить защиту паролем в Сайтах > Инструменты, потребовав как имя пользователя, так и пароль.

В противном случае вы можете использовать плагин ограничения контента (например, Password Protected). Установите и активируйте его, затем перейдите в «Настройки» > «Защищено паролем» и включите «Статус защиты паролем». Это дает более тонкий контроль, позволяя занести в белый список определенные IP-адреса.

Установите и активируйте его, затем перейдите в «Настройки» > «Защищено паролем» и включите «Статус защиты паролем». Это дает более тонкий контроль, позволяя занести в белый список определенные IP-адреса.

Примечание: на момент написания статьи этот плагин не обновлялся более 11 месяцев. Он может больше не поддерживаться, что может повлечь за собой проблемы совместимости с последними версиями WordPress.

Установите плагин WordPress

Когда стандартной функциональности WordPress недостаточно, хороший плагин часто может решить ваши проблемы. Например, если вы хотите не индексировать определенные страницы, а не весь сайт, у плагина Yoast есть такая опция.

В Yoast SEO вы можете открыть страницу, которую хотите скрыть, и найти опцию на вкладке «Дополнительно»: Разрешить поисковым системам показывать эту запись в результатах поиска? Измените его на Нет, и страница будет закрыта.

Должны отметить, что оба плагина полагаются на те же методы, что и вариант WordPress по умолчанию, чтобы закрыть сайт от индексации поисковыми системами, и подвержены тем же недостаткам. Некоторые поисковые системы могут не удовлетворить ваш запрос. Поэтому нужно будет использовать другие методы, если вам действительно нужно полностью скрыть этот контент.

Другое решение – заплатить за доступ к вашему контенту или скрыть его за обязательным логином. Плагины Simple Membership или Ultimate Member помогут создать бесплатный или платный контент членства.

Используйте промежуточный сайт для тестирования

При работе над тестовыми проектами или незавершенными веб-сайтами лучше всего скрывать их, используя промежуточный или разрабатываемый сайт. Эти веб-сайты являются частными, часто размещаются на локальном компьютере, к которому никто, кроме вас и других доверенных лиц не могут получить доступ.

Многие веб-хосты предоставят простые в развертывании промежуточные сайты и позволят отправить их на собственный общедоступный сервер, когда вы будете готовы.

Если у вас нет доступа к простому способу создания промежуточного сайта, плагин WP STAGING может продублировать установку и переместить ее в папку для легкого доступа.

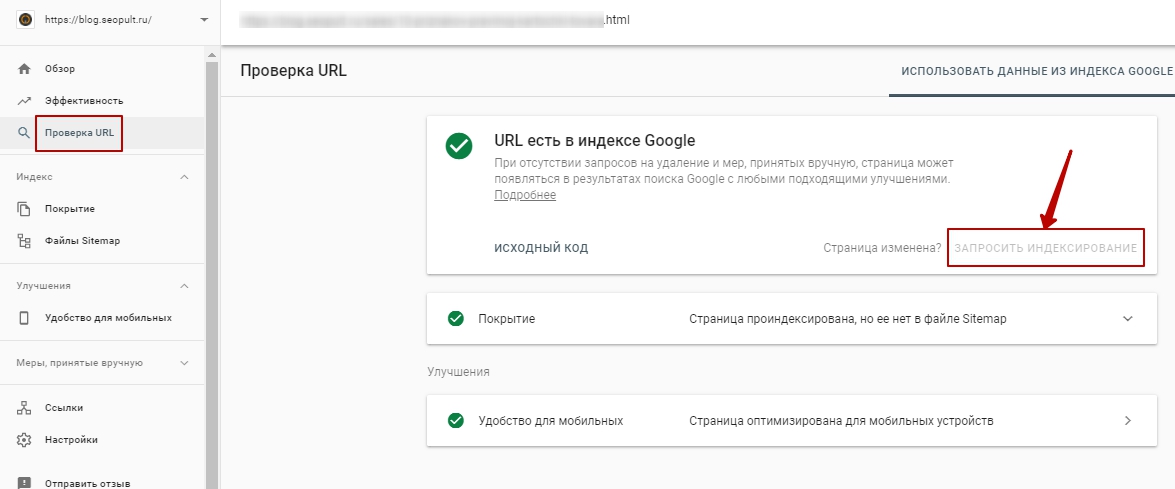

Используйте Google Search Console для временного скрытия веб-сайтов

Консоль поиска Google – это служба, которая позволяет заявить о праве собственности на веб-сайты. Что дает возможность временно заблокировать Google от индексации определенных страниц.

У этого метода есть несколько проблем: он эксклюзивен для Google (поэтому такие сайты, как Bing, не будут затронуты) и действует всего 6 месяцев.

Но если нужен быстрый и простой способ временно удалить контент из результатов поиска Google, это способ прекрасно справится. Для этого нужно добавить сайт в Google Search Console, если его тап нет. После этого откройте «Удаление» и выберите «Временное удаление» > «Новый запрос». Затем нажмите «Удалить только этот URL-адрес» и укажите ссылку на страницу, которую хотите скрыть.

Это надежный способ блокировки контента, но, опять же, он работает исключительно для Google и длится всего 6 месяцев.

Есть много причин, по которым нужно закрыть контент на своем сайте, но использование опции «Попросить поисковые системы не индексировать сайт» – не лучший способ убедиться, что такой контент не виден. Воспользуйтесь рекомендациями, подробно предоставленными в этой статье, чтобы закрыть сайт от индексации.

Источник: kinsta.com

Алексей Шевченко

редактор wpcafe

Изучает сайтостроение с 2008 года. Практикующий вебмастер, специализирующий на создание сайтов на WordPress. Задать вопрос Алексею можно на https://profiles.wordpress.org/wpthemeus/

Источник: hostenko.com/wpcafe

Понравилось это:

Нравится Загрузка…

Как закрыть сайт от индексации в robots.txt и meta-тегом

Содержание

- Когда нужно закрывать сайт от индексации

- Как проверить правильность настроек

- Как запретить индексацию

- Как закрыть весь сайт в robots.

- Как закрыть раздел сайта в robots.txt

- Закрытие с помощью Meta-тег name=»robots»

- Заключение

Поисковые системы проверяют каждую страницу в интернете, анализируют ее содержимое и заносят в индекс, чтобы в дальнейшем использовать ее в ранжировании и формировании поисковой выдачи. Этот процесс называется индексированием. Для этого у поисковых систем есть специальные боты — они сканируют страницу и только после этого она становится доступной всем пользователям интернета. Но иногда страницу или весь сайт нужно скрыть из выдачи. Разберемся, как закрыть сайт от индексации и зачем это делать.

Когда нужно закрывать сайт

В первую очередь от индексирования стоит закрыть новый сайт, который только появился и находится в процессе разработки. То же самое рекомендуется делать, когда на сайте проводятся серьезные изменения — перестройка структуры, настройка нового дизайна, замена текстов.

До окончания технических работ стоит закрыть сайт, чтобы он не индексировался неправильно. Если в выдачу попадут ненужные страницы, есть больший риск понижения значимости сайта для поисковых систем.

Если в выдачу попадут ненужные страницы, есть больший риск понижения значимости сайта для поисковых систем.

Кроме полезного для посетителей контента на сайте есть служебные страницы, которые видеть никому ненужно. Их можно закрыть на все время, чтобы не затруднять поиск и навигацию на сайте.

Как проверить правильность настроек

Такую возможность предоставляет «Пиксель Тулс», простой и бесплатный сервис. Встроенный инструмент определения возраста страницы позволяет проверять сразу несколько URL списком.

Если страница индексируется, то в результатах проверки будет указан ее возраст, дата индексирования и кэша. Если не индексируется, то в этом же столбце будет указано «Не в индексе».

Другой способ проверки — через консоли вебмастера. Search Console и Я.Вебмастер показывают элементы сайта, доступные для сканирования и закрытые.

Как запретить индексацию

Взаимодействовать с поисковыми роботами нужно с помощью файла из корневой папки сайта — robots. txt. Это специальный служебный текстовый документ, в котором указывается информация для ботов. Когда они попадают на страницу в интернете, то сначала обращаются к нему и в основном следуют написанным там инструкциям.

txt. Это специальный служебный текстовый документ, в котором указывается информация для ботов. Когда они попадают на страницу в интернете, то сначала обращаются к нему и в основном следуют написанным там инструкциям.

Если он пустой или отсутствует, то робот проиндексирует полностью все страницы. Создать файл можно самим и загрузить его на хостинг. Для этого подходит любой текстовый редактор, который сохраняет файлы в формате «.txt». В него нужно внести информацию для роботов через специальные команды. Их применение зависит от того, что именно необходимо скрыть.

Если сайт работает на платформе WordPress, можно сделать то же самое через плагин Yoast SEO.

Закрытие сайта

Доступ поисковиков к сайту можно контролировать с помощью трех команд:

- User-agent – в директории указывается имя бота, для которого установлены указания;

- Disallow – запрет;

- Allow – разрешение.

Закрыться от всех поисковых ботов:

User-agent: *

Disallow: /

Сочетанием команд можно сделать исключение для ботов какой-то одной системы, закрыв доступ остальным. В случае выделения какого-то одного поискового бота нужно писать именно его имя, а не название поисковика. Так, робот Яндекса называется Yandex, у Гугла – Googlebot. А также менее популярные поисковые системы тоже имеют своих ботов с именами:

Slurp — робот от поисковика Yahoo!;

SputnikBot — российский бот, который работает в поисковике от Ростелекома — Спутник;

MSNBot — поисковый робот Microsoft в поисковой системе Bing.

Например, такой код дает доступ к сайту только для роботов Гугла:

User-agent: *

Disallow: /

User-agent: Googlebot

Allow: /

Если нужно закрыться от некоторых ботов, а другим предоставить право индексировать, то в документе прописывается отдельная директива для каждого бота, который входит в исключения, с указанием имени каждого бота поисковой системы.

Больше никаких команд для закрытия сайта не предусмотрено, кроме указанных трех. Взаимодействие максимально простое, главное – не допускать ошибок при сочетании этих команд.

Закрытие страниц или каталогов

Если закрывать весь сайт нет необходимости, но нужно скрыть некоторые его разделы или единичные страницы, указываем их адрес с использованием тех же команд.

Для скрытия раздела:

User-agent: *

Disallow: /catalog

Закрыть индексацию карты сайта:

User-agent: *

Disallow: /sitemap.xml

Далее в примерах индексирование настроено наоборот — с закрытием всего сайта, кроме одного элемента.

Запретить доступ ко всему сайту, кроме одного каталога:

User-agent: *

Disallow: /

Allow: /catalog

Такого простого набора команд достаточно, чтобы настроить работу с поисковыми роботами так, как нужно вебмастеру и контролировать видимость сайта и его частей по необходимости.

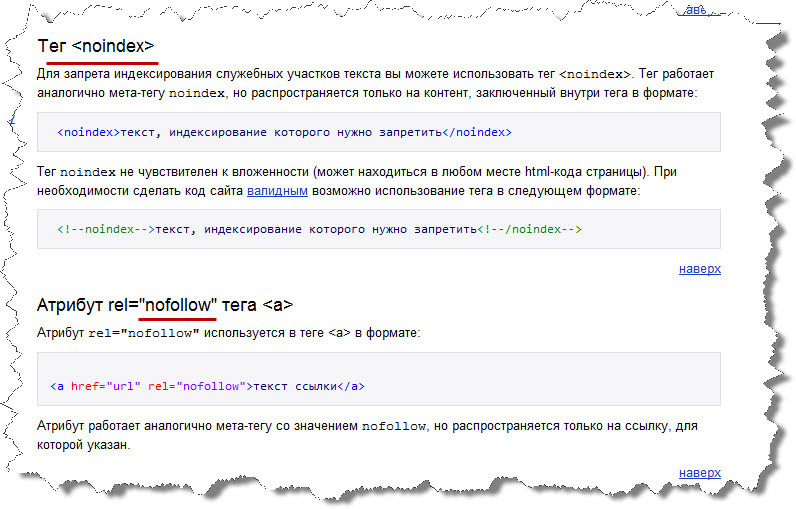

Meta-тег name=»robots»

Команды ботам можно передавать не только через отдельный файл, но и через исходный код. Для этого нужно прописать в коде страницы мета-тег name=»robots». Он считается даже более надежным и приоритетным, так как боты его чаще выполняют.

Для этого нужно прописать в коде страницы мета-тег name=»robots». Он считается даже более надежным и приоритетным, так как боты его чаще выполняют.

Внутри блока <head> устанавливается команда:

<meta name=»robots» content=»noindex, nofollow»/>

Другой способ написания:

<meta name=»robots» content=»none»/>

По такому же принципу, как в файле роботс.тхт, здесь можно указывать конкретного бота, которому запрещена индексация. Для этого вместо тега robots указывается имя бота, например:

<meta name=»yandex» content=»noindex, nofollow»/>

В некоторых ситуациях запрет индексирования – необходимая мера, поэтому robots.txt обязательно должен присутствовать в корневой директории. Он позволяет скрыть служебные и временные страницы, закрыть неактуальный контент, который требует замены на свежий, закрыть ссылки, баннеры и всплывающие окна. При внесении значительных изменений и проведении любых технических работ на сайте рекомендуется на время запретить индексирование страниц. Важно понимать, что поисковые роботы воспринимают команды в robots.txt больше как рекомендации. Иногда они действуют в обход указанным правилам, чаще всего так поступают роботы Гугла.

Важно понимать, что поисковые роботы воспринимают команды в robots.txt больше как рекомендации. Иногда они действуют в обход указанным правилам, чаще всего так поступают роботы Гугла.

Специалисты веб студии Moeseo грамотно выполнят любые задачи по оптимизации и технической настройке сайта. Поэтому заказать продвижение сайта у нас будет правильным и эффективным решением.

Автор: Начальник отдела Seo продвижения Русаков Николай

S&P Cryptocurrency Top 10 Index Singapore Close

S&P Cryptocurrency Top 10 Index Singapore Close | Индексы S&P Доу-ДжонсаНе зарегистрирован?

Получите доступ к эксклюзивным данным и исследованиям, персонализируйте свой опыт и подпишитесь на получение обновлений по электронной почте.

Регистр

Не зарегистрирован?

Получите доступ к эксклюзивным данным и исследованиям, персонализируйте свой опыт и подпишитесь на получение обновлений по электронной почте.

Регистр

2 168,3 долл.

Тикер Bloomberg: SPCC10S

Документы

Информационный бюллетень

Методология

Индекс классификации

Цифровые активы Криптовалюта Заголовок

Новости и объявления

СМОТРЕТЬ ВСЕ- Индекс Новости

- – 13 июля 2021 г.

- 10:00

Индексы S&P Dow Jones запускают индекс широкого цифрового рынка S&P Cryptocurrency

Индексы S&P Dow Jones запускают индекс широкого цифрового рынка S&P Cryptocurrency

Читать

- Индекс Новости

- 4 мая 2021 г.

- 8:30

Исследования и идеи

СМОТРЕТЬ ВСЕ- Образование

Часто задаваемые вопросы: S&P Cryptocurrency Index Series

Часто задаваемые вопросы: Серия индексов криптовалюты S&P

- Образование

Обеспечение прозрачности нового класса активов: индексы криптовалюты S&P

Обеспечение прозрачности нового класса активов: индексы криптовалюты S&P

- Образование

Часто задаваемые вопросы: Возможности пользовательского индексирования криптовалюты

Часто задаваемые вопросы: Возможности пользовательского индексирования криптовалюты

Скачать информационный бюллетень

Характеристики

Топ-10 составляющих по весу индекса

Полный список участниковПолный список участниковСектор

Индекс Вес

- Образование

Часто задаваемые вопросы: S&P Cryptocurrency Index Series

Часто задаваемые вопросы: S&P Cryptocurrency Index Series

- Образование

Обеспечение прозрачности нового класса активов: индексы криптовалюты S&P

Обеспечение прозрачности нового класса активов: индексы криптовалюты S&P

- Образование

Часто задаваемые вопросы: Возможности пользовательского индексирования криптовалюты

Часто задаваемые вопросы: Возможности пользовательского индексирования криптовалюты

Нет результатов, соответствующих вашим критериям.

Загрузи больше

Обработка…

Elasticsearch Close Index

Elastic Search4 месяца назад

от John Otieno

В этом руководстве мы узнаем, как закрыть индекс с помощью API закрытия индексов Elasticsearch.

Начинаем!

Что такое закрытый индекс в Elasticsearch?

Закрытый индекс относится к обычному индексу, находящемуся в закрытом состоянии. Elasticsearch блокирует операции чтения и записи в закрытом индексе. Это также предотвращает другие операции, которые допускает открытый индекс. Например, нельзя создавать псевдонимы, поиск и т. д.

Закрытие индекса — отличный способ уменьшить нагрузку на кластер, поскольку закрытые индексы не являются основными внутренними структурами данных.

Однако закрытые индексы занимают место на диске. Поэтому, если вы хотите уменьшить использование диска, рассмотрите другие методы, такие как перемещение индекса и т. д. действия во время операции закрытия.

д. действия во время операции закрытия.

Синтаксис запроса

Следующая команда показывает синтаксис для использования API закрытия индекса:

POST /

Запрос принимает следующие параметры пути:

Пример

В следующем примере показано, как использовать Elasticsearch close API для закрытия индекса с именем «Netflix».

curl -XPOST «http://localhost:9200/netflix/_close» -H «kbn-xsrf: reporting»

Предыдущий запрос должен вернуть следующий вывод:

{

«подтверждено»: true,

«shards_acknowledged»: true,

«indices»: {

«netflix»: {

«closed»: true

}

}

}

Вы можете проверить, закрыт ли индекс, выполнив следующий запрос:

—curl XGET «http://localhost:9200/netflix/_stats» -H «kbn-xsrf: отчетность»

Поскольку индекс закрыт, Elasticsearch блокирует запрос на чтение, но указывает причину, как показано ниже: «причина»: «закрыто»,

«index_uuid»: «zSe-VsUYTfeEc8NVmqkLcw»,

«index»: «netflix»

}

],

«index_uuid»: «zSe-VsUYTfeEc8NVmqkLcw»,

«index»: «netflix»

},

«status»: 400

}

Заключение

закрытое состояние.