Раздел «Индексирование» Яндекс Вебмастера для работы с сайтом

Четвёртым в Меню для работы с сайтом Яндекс Вебмастера расположен раздел «Индексирование». Он состоит из девяти пунктов: «Статистика обхода», «Страницы в поиске», «Структура сайта», «Проверить статус URL», «Важные страницы», «Переобход страниц», «Файлы Sitemap», «Переезд сайта» и «Скорость обхода». Именно этот раздел и его пункты рассмотрим в кратце ниже в этой статье.

Как раскрыть содержимое Раздела «Индексирование» Яндекс Вебмастера

Для того, чтобы открыть пункты Раздела «Индексирование» Яндекс Вебмастера для работы с сайтом, нужно кликнуть левой кнопкой мышки по его названию. Это откроет доступ к ссылкам на содержащиеся в нём раздела. Повторный клик по названию раздела свернёт его содержимое обратно в одну строчку:

Краткое содержание пунктов Раздела «Индексирование» Яндекс Вебмастера

Рассмотрим кратко, что за пункты содержатся в Раздела «Индексирование» Яндекс Вебмастера и как они могут помочь в работе над сайтом в плане его поисковой оптимизации.

- Раздел «Индексирование»

- Пункт «Статистика обхода» — статистика обхода представлена в виде графика обхода по дням с количеством новых страниц, найденных поисковым роботом и количеством изменившихся страниц. Информация позволяет узнать, какие страницы вашего сайта обходит робот. Вы можете выявить адреса страниц, которые робот не смог загрузить из-за недоступности сервера, на котором находится сайт, или из-за ошибок в содержимом самих страниц.

- Пункт «Страницы в поиске» — информация отображает страницы сайта, которые участвуют в поиске Яндекса и показана тенденция добавление новых страниц в поисковую базу Яндекса и удаление страниц из неё. Страница сайта может не попасть в результаты поиска, если она дублирует контент другой страницы, содержит спам или вирусы, перенаправляет на другой URL, при ее скачивании произошла ошибка.

- Пункт «Структура сайта» — информация отображает разделы сайта, которые содержат не меньше 10 страниц и составляют больше 1% от общего числа страниц, загруженных в базу поиска.

При удалении пользовательского раздела из структуры сайта информация о нем в базе поиска сохраняется.

При удалении пользовательского раздела из структуры сайта информация о нем в базе поиска сохраняется. - Пункт «Проверить статус URL» — тут можно проверить, знает ли робот об определенной странице сайта, права на который вы подтвердили. В поле URL можно ввести полный URL страницы или путь от корня сайта, начинающийся с «/». Как правило, сбор и обработка информации занимают до 2 минут. Иногда это может занять несколько часов. Как только обработка данных завершится, статус отчета изменится на «готово».

- Пункт «Важные страницы » — информация по отслеживанию изменений на важных страницах. Вы можете отслеживать индексирование наиболее важных страниц сайта и наиболее популярных — рекомендованных Яндекс.Вебмастером и подписаться на получение информации на почту.

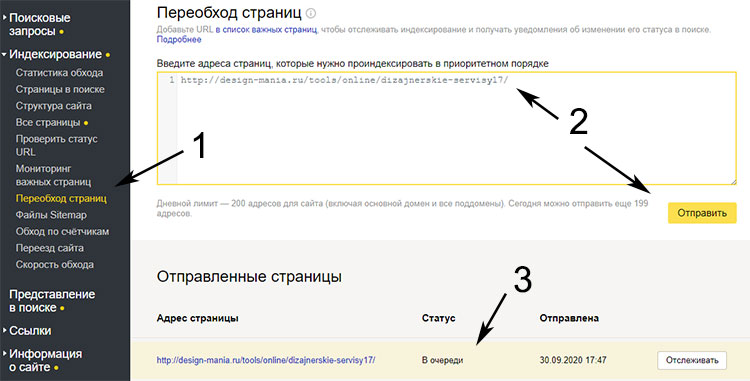

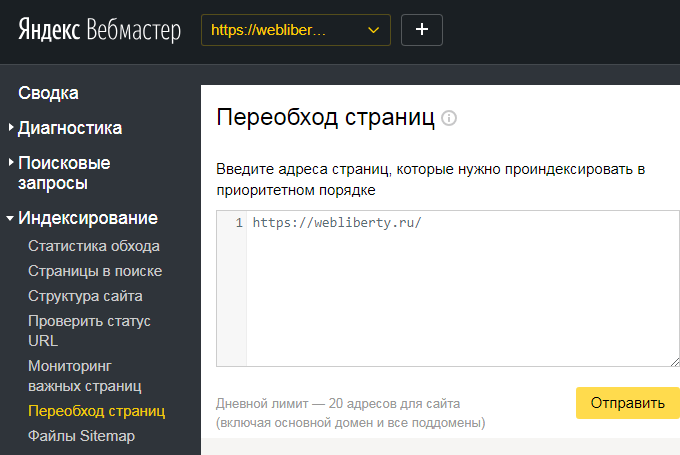

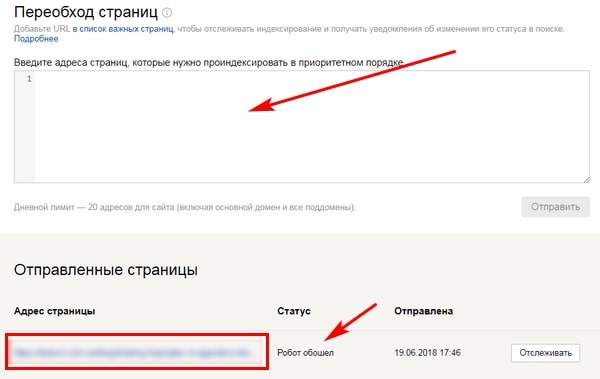

- Пункт «Переобход страниц» — этот пункт помогает сообщить Яндексу о новых и обновленных страницах. Когда вы отправите адреса страниц, они примут один из статусов: «В очереди» — страница передана роботу для обхода.

В течение 3 суток заявка будет обработана; «Робот обошёл» — страница посещена роботом. Данные о странице обновятся в поиске в течение 2 недель и «Ошибка» — робот не смог посетить страницу.

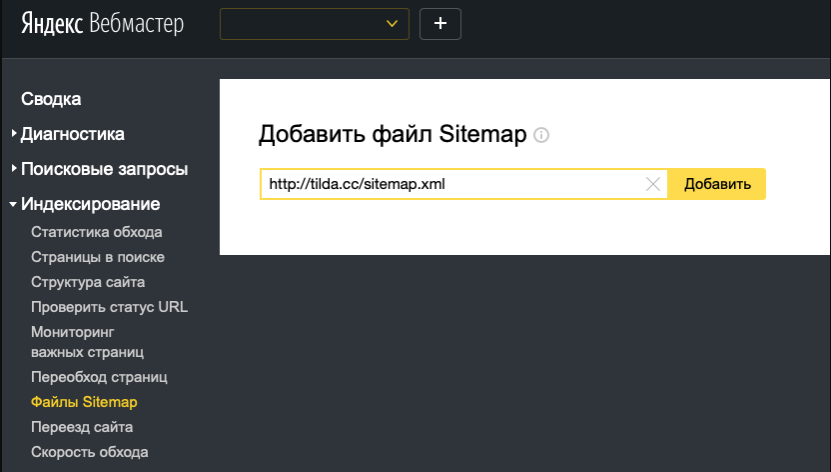

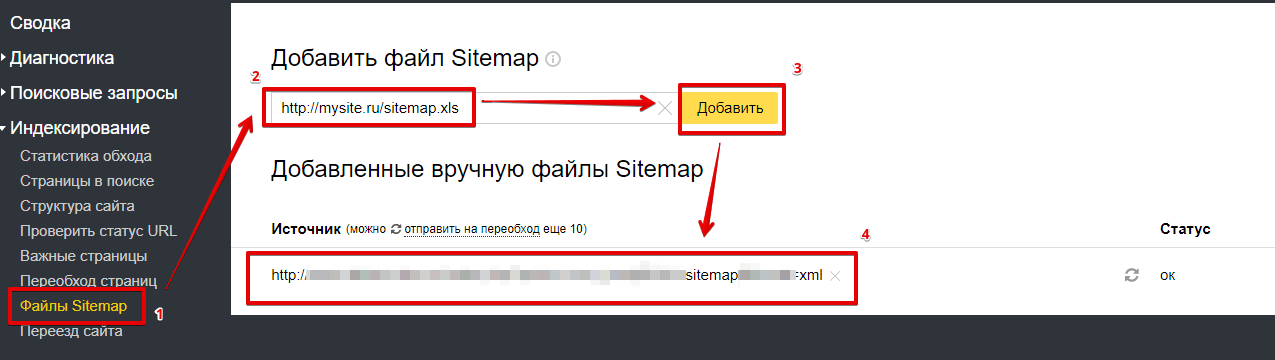

В течение 3 суток заявка будет обработана; «Робот обошёл» — страница посещена роботом. Данные о странице обновятся в поиске в течение 2 недель и «Ошибка» — робот не смог посетить страницу. - Пункт «Файлы Sitemap» — пункт позволяет добавить файл Sitemap в Яндекс.Вебмастер, чтобы ускорить индексирование сайта.

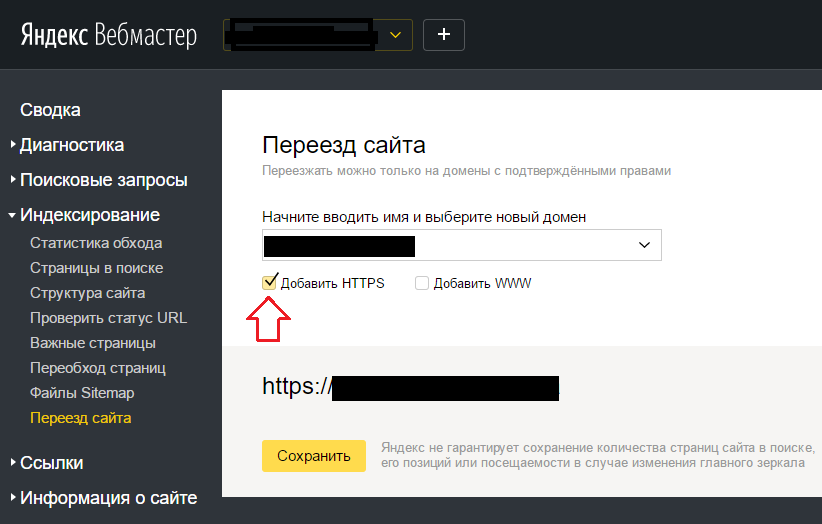

- Пункт «Переезд сайта» — в этом пункте можно сообщить Яндексу о смене адреса сайта. Указанный в поле адрес будет являться главным зеркалом.

- Пункт «Скорость обхода» — тут можно настроить скорость обхода сайта, чтобы боты Яндекса не обрушили сайт своими массированными запросами к серверу, на котором он находится. Максимальная скорость обхода сайта считается исходя из оптимальной скорости обхода, рассчитываемой Яндексом. Индивидуальную скорость обхода сайта можно регулировать.

Заберите ссылку на статью к себе, чтобы потом легко её найти!

Выберите, то, чем пользуетесь чаще всего:

Переобход страниц в Яндексе и Гугле (переиндексация сайта)

Всегда после обновления старых текстов блога я делаю повторную переиндексацию страниц сайта в ручном режиме. Это позволяет максимально быстро предоставить поисковикам актуальную исправленную версию веб-страницы, не дожидаясь появления поискового робота. Для выполнения задачи можно использовать специальные функции панелей вебмастеров Яндекс и Google. В последней недавно поменялся принцип работы и интерфейс, поэтому решил дополнить первоначальную версию статьи.

Это позволяет максимально быстро предоставить поисковикам актуальную исправленную версию веб-страницы, не дожидаясь появления поискового робота. Для выполнения задачи можно использовать специальные функции панелей вебмастеров Яндекс и Google. В последней недавно поменялся принцип работы и интерфейс, поэтому решил дополнить первоначальную версию статьи.

По идее, ручной переобход страниц сайта кроме изменений информации о них и их содержимом в выдаче также должен обновить данные в кэше поисковиков. Думаю, метод также подходит и для возвращения случайно выпавших URL’ов проекта из-за ошибок сервера и др.

В моем блоге встречались разные механизмы индексации, например, использование адурилки поисковиков или установка Яндекс Пингер и т.п. Однако это больше касается первичного добавления в индекс, как, например, создание XML Sitemap. Для нашей же задачи были разработаны специальные инструменты в панели вебмастеров.

Переобход страниц в Яндекс.Вебмастер

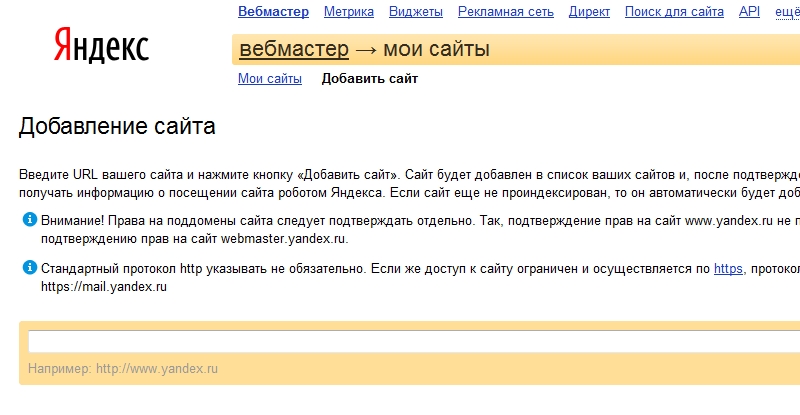

Данная функция появилась в новом Яндекс Вебмастере чуть позже после релиза. Если вы еще не зарегистрированы в этом сервисе, обязательно советую это сделать — webmaster.yandex.ru. После подтверждения прав на свой вебсайт можете зайти в раздел «Индексирование» — «Переобход страниц».

Если вы еще не зарегистрированы в этом сервисе, обязательно советую это сделать — webmaster.yandex.ru. После подтверждения прав на свой вебсайт можете зайти в раздел «Индексирование» — «Переобход страниц».

Здесь в текстовом поле указываете ссылки, на которые хотите привлечь поискового робота. Раньше дневной лимит составлял 20шт на один проект, сейчас, как я понимаю, число зависит от показателя ИКС.

После нажатия «Отправить» внизу под формой отобразятся новые страницы для переиндексации в Яндексе. Всего у них есть 3 статуса:

- В очереди — линки только добавлены.

- Робот обошел — процесс выполнен, ожидайте апдейта при следующем обновлении базы.

- Ошибка.

После этого остается лишь ждать очередного апдейта.

Переиндексация страниц в Google

Чуть ниже рассмотрена старая версия данной процедуры, но с обновлением дизайна Google Search Console все немного изменилось.

Чтобы запросить индексирование страницы требуется:

- Выбрать нужный сайт из списка.

- Дальше через пару секунд появится отчет по текущей веб-странице: нахождение ее в индексе, адаптивность для мобильных и некоторые другие общие данные. Здесь вы можете увидеть дату последнего ее посещения роботом гугла.

- Дальше у вас на выбор есть 2 варианта:

- Кликнуть «проверить страницу на сайте» — проанализирует общее ее состояние и покажет наличие ошибок здесь.

- Нажать ссылку «Запросить индексирование — направление запроса на переобход.

Насколько я понимаю, в первом случае Google проверяет страницу, но не отправляет ее на индексацию, а позже робот Googlebot в общем порядке сам туда заглянет. По второй ссылке запрос попадает в так называемую «приоритетную очередь сканирования».

Кстати, судя по времени выполнения второй заявки, перед отправкой на переобход веб-страничка автоматически проходит такую же проверку, как предполагает первый вариант.

Если честно, по сравнению с прошлым алгоритмом тут одни сплошные минусы:

- вся процедура занимает больше времени и кликов;

- нужно ждать пока пройдет проверка веб-страницы, а если у вас на очереди 50 ссылок;

- очень часто показывается каптча.

Прошлым методом можно было добавить в сутки где-то с 10-ток линков, и все это занимало не более минуты. Здесь, к сожалению, не так.

Переобход страниц в Google (старая версия)

Выполнение подобной задачи в Гугле аналогично Яндексу, хоть и включает в себя больше шагов. Ваш сайт также должен быть добавлен в панель вебмастера, но уже Google Search Console. Находите в инструментах раздел «Crawl» (Сканирование) — «Fetch as Google» (Посмотреть как Googlebot).

Здесь нужно:

- В текстовом поле вводите адрес страницы для переиндексации в Гугле (без домена, только путь).

- Кликаете по кнопке «Fetch» (Сканировать). Новый URL будет добавлен в список, и через несколько секунд после проверки у него появится статус «Complete» (Готово).

- Затем нажимаете на кнопку «Request Indexing» (Отправить в индекс), что находится рядом.

После этого отобразится всплывающее окно, где выбираете один из вариантов переобхода страницы Гуглом:

Вы можете:

- выполнить переиндексацию страницы в Google для одного URL (до 500 в месяц).

- просканировать указанную страницу и все прямые ссылки на ней (10 штук в месяц). Данная опция хорошо подходит разделам/категориям со списком записей или карте сайта.

Разумеется при всем при этом переобход страниц в Яндекс.Вебмастере или Google Search Console не гарантирует того, что новая информация с вашего URL будет добавлена в индекс. Соблюдение алгоритмов и требований к контенту никто не отменял. По времени переиндексации — эти инструменты определенно ускоряют процесс, но это не значит, что он будет выполнен моментально.

Если у вас есть что добавить по теме переиндексации страниц сайта, пишите в комментариях. Возможно, какие-то детали я пропустил.

Теги: вебмастерам, индексация, контент, настройки google, оптимизация сайта, панель вебмастера, сервисы Яндекса

Crawler List: 11 самых распространенных веб-сканеров в 2023 году

Большинству маркетологов необходимы постоянные обновления, чтобы их сайт оставался свежим и улучшался в поисковой выдаче.

Однако некоторые сайты содержат сотни или даже тысячи страниц, что усложняет задачу для команд, вручную загружающих обновления в поисковые системы. Если контент обновляется так часто, как команды могут гарантировать, что эти улучшения повлияют на их SEO-рейтинг?

Вот где в игру вступают роботы-краулеры. Робот-сканер будет очищать вашу карту сайта на наличие новых обновлений и индексировать контент в поисковых системах.

В этом посте мы опишем полный список поисковых роботов, который охватывает всех ботов веб-сканеров, которые вам нужно знать. Прежде чем мы углубимся, давайте определим ботов поисковых роботов и покажем, как они работают.

Что такое поисковый робот?

Поисковый робот — это компьютерная программа, которая автоматически сканирует и систематически читает веб-страницы для индексации страниц для поисковых систем. Поисковые роботы также известны как пауки или боты.

Чтобы поисковые системы отображали актуальные релевантные веб-страницы для пользователей, инициирующих поиск, должен выполняться поисковый робот-робот. Иногда этот процесс может происходить автоматически (в зависимости от настроек сканера и вашего сайта) или может быть инициирован напрямую.

Многие факторы влияют на SEO-рейтинг ваших страниц, включая релевантность, обратные ссылки, веб-хостинг и т. д. Однако все это не имеет значения, если ваши страницы не сканируются и не индексируются поисковыми системами. Вот почему так важно убедиться, что ваш сайт позволяет выполнять правильное сканирование и устраняет любые препятствия на его пути.

Вот почему так важно убедиться, что ваш сайт позволяет выполнять правильное сканирование и устраняет любые препятствия на его пути.

Боты должны постоянно сканировать и очищать веб-страницы, чтобы обеспечить предоставление наиболее точной информации. Google – самый посещаемый веб-сайт в США – примерно 26,9% поисковых запросов исходят от американских пользователей:

поисковых запросов в Google в основном инициируются из США ( Источник: Statista)Однако не существует ни одного поискового робота, который сканирует все поисковые системы. Каждая поисковая система обладает уникальными преимуществами, поэтому разработчики и маркетологи иногда составляют «список поисковых роботов». Этот список поисковых роботов помогает им определить различные поисковые роботы в журнале своего сайта, чтобы принять или заблокировать их.

Маркетологи должны составить список поисковых роботов, полный различных поисковых роботов, и понять, как они оценивают свой сайт (в отличие от парсеров контента, которые воруют контент), чтобы убедиться, что они правильно оптимизируют свои целевые страницы для поисковых систем.

Как работает веб-краулер?

Поисковый робот автоматически просканирует вашу веб-страницу после ее публикации и проиндексирует ваши данные.

Поисковые роботы ищут определенные ключевые слова, связанные с веб-страницей, и индексируют эту информацию для соответствующих поисковых систем, таких как Google, Bing и других.

Алгоритмы поисковых систем будут извлекать эти данные, когда пользователь отправляет запрос по релевантному ключевому слову, связанному с ним.

Сканирование начинается с известных URL-адресов. Это установленные веб-страницы с различными сигналами, которые направляют поисковые роботы на эти страницы. Этими сигналами могут быть:

- Обратные ссылки: Количество раз, когда сайт ссылается на него

- Посетители: Сколько трафика направляется на эту страницу

- Авторитет домена: Общее качество домена

Затем они сохраняют данные в индексе поисковой системы. Когда пользователь инициирует поисковый запрос, алгоритм извлечет данные из индекса, и они появятся на странице результатов поисковой системы. Этот процесс может происходить в течение нескольких миллисекунд, поэтому результаты часто появляются быстро.

Когда пользователь инициирует поисковый запрос, алгоритм извлечет данные из индекса, и они появятся на странице результатов поисковой системы. Этот процесс может происходить в течение нескольких миллисекунд, поэтому результаты часто появляются быстро.

Как веб-мастер, вы можете контролировать, какие боты будут сканировать ваш сайт. Вот почему важно иметь список поисковых роботов. это 9Протокол 0041 robots.txt , который находится на серверах каждого сайта и направляет поисковых роботов к новому контенту, который необходимо проиндексировать.

В зависимости от того, что вы вводите в свой протокол robots.txt на каждой веб-странице, вы можете приказать сканеру сканировать или избегать индексирования этой страницы в будущем.

Поняв, что поисковый робот ищет при сканировании, вы сможете понять, как лучше позиционировать свой контент для поисковых систем.

Составление списка поисковых роботов: какие существуют типы поисковых роботов?

Когда вы начнете думать о составлении списка поисковых роботов, вам придется искать три основных типа поисковых роботов.

- Собственные сканеры: Это сканеры, разработанные командой разработчиков компании для сканирования ее сайта. Обычно они используются для аудита и оптимизации сайта.

- Коммерческие сканеры: Это специализированные сканеры, такие как Screaming Frog , которые компании могут использовать для сканирования и эффективной оценки своего контента.

- Поисковые роботы с открытым исходным кодом : это бесплатные поисковые роботы, созданные различными разработчиками и хакерами по всему миру.

Важно понимать различные типы существующих поисковых роботов, чтобы знать, какой тип вам нужно использовать для достижения собственных бизнес-целей.

11 наиболее распространенных поисковых роботов, которые стоит добавить в список поисковых роботов

Не существует ни одного поискового робота, который бы выполнял всю работу для каждой поисковой системы.

Вместо этого существует множество поисковых роботов, которые оценивают ваши веб-страницы и сканируют контент для всех поисковых систем, доступных пользователям по всему миру.

Давайте рассмотрим некоторые из наиболее распространенных на сегодняшний день поисковых роботов.

1. Googlebot

Googlebot — это универсальный поисковый робот Google, который отвечает за сканирование сайтов, которые будут отображаться в поисковой системе Google.

Googlebot индексирует сайты для предоставления актуальных результатов GooglebotХотя технически существует две версии Googlebot — Googlebot для настольных ПК и Googlebot для смартфонов (мобильных), большинство экспертов считают Googlebot одним единственным поисковым роботом.

Это связано с тем, что оба следуют одному и тому же уникальному токену продукта (известному как токен пользовательского агента), записанному на каждом сайте.0041 robots.txt . Пользовательский агент Googlebot — это просто « Googlebot ».

Googlebot приступает к работе и обычно заходит на ваш сайт каждые несколько секунд (если только вы не заблокировали его в файле robots.txt вашего сайта). Резервная копия отсканированных страниц сохраняется в единой базе данных под названием Google Cache. Это позволяет просматривать старые версии вашего сайта.

Резервная копия отсканированных страниц сохраняется в единой базе данных под названием Google Cache. Это позволяет просматривать старые версии вашего сайта.

Кроме того, Google Search Console — это еще один инструмент, который веб-мастера используют, чтобы понять, как робот Googlebot сканирует их сайт, и оптимизировать свои страницы для поиска.

| Агент пользователя | Гуглбот |

| Полная строка пользовательского агента | Mozilla/5.0 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html) |

2. Bingbot

Bingbot был создан Microsoft в 2010 году для сканирования и индексации URL-адресов, чтобы Bing предлагал релевантные и актуальные результаты поиска для пользователей платформы.

Bingbot предоставляет Bing релевантные результаты поисковой системы Подобно роботу Googlebot, разработчики или маркетологи могут указать в файле robots. txt на своем сайте, разрешают ли они или нет идентификатор агента « bingbot » для сканирования своего сайта.

txt на своем сайте, разрешают ли они или нет идентификатор агента « bingbot » для сканирования своего сайта.

Кроме того, они могут различать поисковые роботы, индексирующие мобильные устройства, и поисковые роботы для настольных компьютеров, поскольку Bingbot недавно перешел на новый тип агента. Это, наряду с инструментами для веб-мастеров Bing, предоставляет веб-мастерам большую гибкость, чтобы показать, как их сайт обнаруживается и демонстрируется в результатах поиска.

| Агент пользователя | Бингбот |

| Полная строка пользовательского агента | Mozilla/5.0 (совместимый; Bingbot/2.0; +http://www.bing.com/bingbot.htm) |

3. Яндекс Бот

Яндекс Бот — краулер специально для российской поисковой системы Яндекс. Это одна из самых крупных и популярных поисковых систем в России.

Бот Яндекса индексирует российскую поисковую систему Яндекса Веб-мастера могут сделать страницы своего сайта доступными для Бота Яндекса через свои robots. txt файл.

txt файл.

Кроме того, они могли также добавить тег Яндекс.Метрики к определенным страницам, переиндексировать страницы в веб-мастере Яндекса или выдать протокол IndexNow, уникальный отчет, который указывает на новые, измененные или деактивированные страницы.

| Агент пользователя | ЯндексБот |

| Полная строка пользовательского агента | Mozilla/5.0 (совместимо; YandexBot/3.0; +http://yandex.com/bots) |

4. Apple Bot

Apple поручила Apple Bot сканировать и индексировать веб-страницы для предложений Apple Siri и Spotlight.

Apple Bot — это поисковый робот для Siri и Spotlight от Apple. Apple Bot учитывает множество факторов при принятии решения о том, какой контент повысить в предложениях Siri и Spotlight. К этим факторам относятся вовлеченность пользователей, релевантность условий поиска, количество/качество ссылок, сигналы на основе местоположения и даже дизайн веб-страницы.

| Агент пользователя | Эпплбот |

| Полная строка пользовательского агента | Mozilla/5.0 (Устройство; версия_ОС) AppleWebKit/WebKit_version (KHTML, например Gecko) Версия/Safari_version Safari/WebKit_version (Applebot/Applebot_version) |

5. DuckDuck Bot

DuckDuckBot — это поисковый робот для DuckDuckGo, который предлагает «полную защиту конфиденциальности в вашем веб-браузере».

DuckDuck Bot сканирует сайт, ориентированный на конфиденциальностьВеб-мастера могут использовать DuckDuckBot API, чтобы узнать, просканировал ли их сайт DuckDuck Bot . По мере сканирования он обновляет базу данных DuckDuckBot API последними IP-адресами и пользовательскими агентами.

Это помогает веб-мастерам идентифицировать любых самозванцев или вредоносных ботов, пытающихся ассоциироваться с DuckDuck Bot.

| Агент пользователя | УткаУткаБот |

| Полная строка пользовательского агента | УткаДакБот/1. 0; (+http://duckduckgo.com/duckduckbot.html) 0; (+http://duckduckgo.com/duckduckbot.html) |

6. Baidu Spider

Baidu — ведущая китайская поисковая система, а Baidu Spider — единственный сканер сайта.

Baidu Spider — это сканер для Baidu, китайской поисковой системы.Google запрещен в Китае, поэтому важно, чтобы Baidu Spider сканировал ваш сайт, если вы хотите выйти на китайский рынок.

Чтобы идентифицировать Baidu Spider, сканирующего ваш сайт, найдите следующие пользовательские агенты: baiduspider, baiduspider-image , baiduspider-video и другие.

Если вы не ведете бизнес в Китае, может иметь смысл заблокировать Baidu Spider в вашем скрипте robots.txt. Это предотвратит сканирование вашего сайта Baidu Spider, тем самым исключив вероятность появления ваших страниц на страницах результатов поисковой системы Baidu (SERP).

| Агент пользователя | Байдуспайдер |

| Полная строка пользовательского агента | Mozilla/5. 0 (совместимо; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) 0 (совместимо; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) |

7. Sogou Spider

Sogou — это китайская поисковая система, которая, как сообщается, является первой поисковой системой, проиндексировавшей 10 миллиардов китайских страниц.

The Sogou Spider — поисковый робот для SogouЕсли вы ведете бизнес на китайском рынке, это еще один популярный поисковый робот, о котором вам нужно знать. Sogou Spider следует тексту исключения робота и параметрам задержки сканирования.

Разверните свое приложение в Kinsta — начните с кредита

в размере 20 долларов США сейчас.Запустите свои приложения Node.js, Python, Go, PHP, Ruby, Java и Scala (или почти все, что угодно, если вы используете свои собственные файлы Docker) в три простых шага!

Разверните сейчас и получите скидку 20 долларов на

Как и в случае с Baidu Spider, если вы не хотите вести бизнес на китайском рынке, вам следует отключить этого паука, чтобы предотвратить медленную загрузку сайта.

| Агент пользователя | Sogou Pic Spider/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Головной паук Sogou/3.0(http://www.sogou.com/docs/help/webmasters.htm#07) Паутина Sogou/4.0(+http://www.sogou.com/docs/help/webmasters .htm#07) Sogou Orion Spider/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Sogou-Test-Spider/4.0 (совместимый; MSIE 5.5; Windows 98) |

8. Facebook External Hit

Facebook External Hit, также известный как Facebook Crawler, сканирует HTML-код приложения или веб-сайта, опубликованного на Facebook.

Facebook External Hit индексирует сайты для обмена ссылкамиЭто позволяет социальной платформе создавать общий предварительный просмотр каждой ссылки, размещенной на платформе. Заголовок, описание и уменьшенное изображение появляются благодаря сканеру.

Если сканирование не будет выполнено в течение нескольких секунд, Facebook не будет отображать контент в пользовательском фрагменте, созданном перед публикацией.

| Агент пользователя | фейсбот facebookexternalhit/1.0 (+http://www.facebook.com/externalhit_uatext.php) facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) |

9. Exabot

Exalead — компания-разработчик программного обеспечения, созданная в 2000 году и имеющая штаб-квартиру в Париже, Франция. Компания предоставляет поисковые платформы для частных и корпоративных клиентов.

Exabot — сканер для Exalead, компании, занимающейся поисковыми платформами.Exabot — сканер для их основной поисковой системы, созданной на их продукте CloudView.

Как и большинство поисковых систем, Exalead учитывает как обратные ссылки, так и содержание веб-страниц при ранжировании. Exabot — пользовательский агент робота Exalead. Робот создает «основной индекс», который собирает результаты, которые увидят пользователи поисковой системы.

| Агент пользователя | Mozilla/5. 0 (совместимо; Konqueror/3.5; Linux) KHTML/3.5.5 (как Gecko) (Exabot-Thumbnails) 0 (совместимо; Konqueror/3.5; Linux) KHTML/3.5.5 (как Gecko) (Exabot-Thumbnails) Mozilla/5.0 (совместимо; Exabot/3.0; +http://www.exabot.com/go /робот) |

10. Swiftbot

Swiftype — система пользовательского поиска для вашего веб-сайта. Он сочетает в себе «лучшие технологии поиска, алгоритмы, структуру приема контента, клиентов и инструменты аналитики».

Swiftype — это программное обеспечение, которое может ускорить поиск по вашему сайтуЕсли у вас сложный сайт с большим количеством страниц, Swiftype предлагает удобный интерфейс для каталогизации и индексации всех ваших страниц.

Swiftbot — поисковый робот Swiftype. Однако, в отличие от других ботов, Swiftbot сканирует только те сайты, которые запрашивают их клиенты.

| Агент пользователя | Свифтбот |

| Полная строка пользовательского агента | Mozilla/5. 0 (совместимо; Swiftbot/1.0; UID/54e1c2ebd3b687d3c8000018; +http://swiftype.com/swiftbot) 0 (совместимо; Swiftbot/1.0; UID/54e1c2ebd3b687d3c8000018; +http://swiftype.com/swiftbot) |

11. Slurp Bot

Slurp Bot — это поисковый робот Yahoo, который сканирует и индексирует страницы Yahoo.

Slurp Bot обеспечивает результаты поисковой системы YahooЭто сканирование необходимо как для Yahoo.com, так и для сайтов-партнеров, включая Yahoo News, Yahoo Finance и Yahoo Sports. Без него релевантные списки сайтов не появлялись бы.

Проиндексированный контент способствует более персонализированному использованию Интернета для пользователей с более релевантными результатами.

| Агент пользователя | Хлеб |

| Полная строка пользовательского агента | Mozilla/5.0 (совместимый; Yahoo! Slurp; http://help.yahoo.com/help/us/ysearch/slurp) |

8 коммерческих поисковых роботов, которые должны знать SEO-специалисты

Теперь, когда в вашем списке поисковых роботов есть 11 самых популярных ботов, давайте рассмотрим некоторые распространенные коммерческие поисковые роботы и инструменты SEO для профессионалов.

1. Бот Ahrefs

Бот Ahrefs — это поисковый робот, который компилирует и индексирует базу данных из 12 триллионов ссылок, которую предлагает популярное программное обеспечение для SEO Ahrefs.

Бот Ahrefs индексирует сайты для платформы SEO, AhrefsБот Ahrefs ежедневно посещает 6 миллиардов веб-сайтов и считается «вторым по активности поисковым роботом» после Googlebot.

Как и другие боты, бот Ahrefs следует функциям robots.txt , а также разрешает/запрещает правила в коде каждого сайта.

2. Бот Semrush

Бот Semrush Bot позволяет Semrush, ведущему программному обеспечению SEO, собирать и индексировать данные сайта для использования его клиентами на своей платформе.

Semrush Bot — это поисковый робот, который Semrush использует для индексации сайтов. Данные используются в общедоступной поисковой системе обратных ссылок Semrush, инструменте аудита сайта, инструменте аудита обратных ссылок, инструменте построения ссылок и помощнике по написанию.

Он сканирует ваш сайт, составляя список URL-адресов веб-страниц, посещая их и сохраняя определенные гиперссылки для будущих посещений.

3. Поисковый робот Moz’s Campaign Rogerbot

Rogerbot — поисковый робот для ведущего SEO-сайта Moz. Этот сканер специально собирает контент для аудита сайта Moz Pro Campaign.

Moz, популярное программное обеспечение для SEO, использует Rogerbot в качестве своего поискового робота.Rogerbot следует всем правилам, изложенным в файлах robots.txt , поэтому вы можете решить, хотите ли вы заблокировать или разрешить Rogerbot сканировать ваш сайт.

Веб-мастера не смогут искать статический IP-адрес, чтобы увидеть, какие страницы просканированы Rogerbot, из-за его многогранного подхода.

4. Screaming Frog

Screaming Frog – это поисковый робот, который SEO-специалисты используют для аудита своего собственного сайта и определения областей улучшения, которые повлияют на его рейтинг в поисковых системах.

После запуска сканирования вы можете просматривать данные в режиме реального времени и выявлять неработающие ссылки или улучшения, которые необходимы для заголовков ваших страниц, метаданных, роботов, дублированного контента и многого другого.

Для настройки параметров сканирования необходимо приобрести лицензию Screaming Frog.

5. Lumar (ранее Deep Crawl)

Lumar — это «централизованный командный центр для поддержания технического состояния вашего сайта». С помощью этой платформы вы можете инициировать обход вашего сайта, чтобы помочь вам спланировать архитектуру вашего сайта.

Deep Crawl был переименован в Lumar, поисковый робот для анализа сайтовLumar гордится тем, что является «самым быстрым поисковым роботом веб-сайтов на рынке» и может похвастаться тем, что он может сканировать до 450 URL-адресов в секунду.

6. Маджестик

Маджестик в первую очередь фокусируется на отслеживании и идентификации обратных ссылок в URL-адресах.

Компания гордится тем, что обладает «одним из самых полных источников данных об обратных ссылках в Интернете», что подчеркивает ее исторический индекс, который увеличился с 5 до 15 лет ссылок в 2021 году.

Поисковый робот сайта делает все эти данные доступными для клиентов компании.

7. Когнитивное SEO

Когнитивное SEO — еще одно важное программное обеспечение SEO, которое используют многие профессионалы.

congnitiveSEO предлагает мощный инструмент аудита сайтаПоисковый робот CognitiveSEO позволяет пользователям выполнять всесторонний аудит сайта, который будет информировать их архитектуру сайта и всеобъемлющую стратегию SEO.

Бот просканирует все страницы и предоставит «полностью настроенный набор данных», уникальный для конечного пользователя. Этот набор данных также будет содержать рекомендации для пользователей о том, как они могут улучшить свой сайт для других поисковых роботов — как для улучшения рейтинга, так и для блокировки ненужных сканеров.

8. Oncrawl

Oncrawl — это «ведущий в отрасли поисковый робот и анализатор журналов» для корпоративных клиентов.

Oncrawl — еще один поисковик SEO, который предоставляет уникальные данные.Пользователи могут настроить «профили сканирования», чтобы создать определенные параметры для сканирования. Вы можете сохранить эти настройки (включая начальный URL-адрес, ограничения сканирования, максимальную скорость сканирования и т. д.), чтобы легко снова запустить сканирование с теми же установленными параметрами.

Нужно ли защищать мой сайт от вредоносных поисковых роботов?

Не все сканеры хороши. Некоторые из них могут негативно повлиять на скорость вашей страницы, в то время как другие могут попытаться взломать ваш сайт или иметь злонамеренные намерения.

Вот почему важно понимать, как заблокировать доступ поисковых роботов на ваш сайт.

Составив список поисковых роботов, вы будете знать, какие из них следует искать. Затем вы можете отсеять подозрительные и добавить их в свой черный список.

Затем вы можете отсеять подозрительные и добавить их в свой черный список.

Как заблокировать вредоносных веб-краулеров

Имея под рукой список поисковых роботов, вы сможете определить, каких ботов вы хотите одобрить, а каких нужно заблокировать.

Первый шаг — просмотреть список поисковых роботов и определить пользовательский агент и полную строку агента, связанную с каждым поисковым роботом, а также его конкретный IP-адрес. Это ключевые определяющие факторы, связанные с каждым ботом.

С помощью пользовательского агента и IP-адреса вы можете сопоставить их в записях вашего сайта с помощью поиска DNS или сопоставления IP-адресов. Если они не совпадают точно, у вас может быть вредоносный бот, пытающийся выдать себя за настоящего.

Затем вы можете заблокировать самозванца, настроив разрешения, используя свои robots.txt тег сайта.

У вас еще нет списка поисковых роботов??? 🫣 Узнайте, почему важно иметь его и что в нем есть для вашего бизнеса ⬇️Нажмите, чтобы твитнутьРезюме

Поисковые роботы полезны для поисковых систем и важны для понимания маркетологами.

Обеспечение правильного сканирования вашего сайта правильными поисковыми роботами важно для успеха вашего бизнеса. Ведя список поисковых роботов, вы можете знать, каких из них следует остерегаться, когда они появляются в журнале вашего сайта.

По мере того, как вы будете следовать рекомендациям коммерческих поисковых роботов и улучшать содержание и скорость вашего сайта, вы облегчите поисковым роботам доступ к вашему сайту и индексацию нужной информации для поисковых систем и потребителей, которые ее ищут.

Получите все свои приложения, базы данных и сайты WordPress онлайн и под одной крышей. Наша многофункциональная высокопроизводительная облачная платформа включает в себя:

- Простая настройка и управление на панели инструментов MyKinsta

- Экспертная поддержка 24/7

- Лучшее оборудование и сеть Google Cloud Platform на базе Kubernetes для максимальной масштабируемости

- Интеграция Cloudflare корпоративного уровня для скорости и безопасности

- Глобальный охват аудитории до 35 центров обработки данных и более 275 точек присутствия по всему миру

Протестируйте сами со скидкой 20 долларов на первый месяц размещения приложений или баз данных. Ознакомьтесь с нашими планами или поговорите с отделом продаж, чтобы найти наиболее подходящий вариант.

Ознакомьтесь с нашими планами или поговорите с отделом продаж, чтобы найти наиболее подходящий вариант.

Как разместить свой сайт в поисковых системах: передовой опыт

Развитие веб-сайта Оптимизация

04 января 2023 г.

Astari S.

10 минут Чтение

Около 93% всего веб-трафика приходится на поисковые системы. Таким образом, размещение веб-сайта в поисковых системах является важным шагом для повышения его рейтинга на страницах результатов поисковых систем (SERP) и увеличения трафика.

Поисковые системы индексируют сайты автоматически. Тем не менее, отправка вашего сайта поможет включить полные и точные данные о вашем сайте.

Имейте в виду, что разные поисковые системы имеют разные процессы отправки. В этом руководстве рассказывается, как представить ваш веб-сайт трем основным поисковым системам: Google, Bing и Яндекс, поскольку другие известные поисковые системы, такие как Yahoo и DuckDuckGo, используют данные индексации Bing.

Кроме того, мы также поделимся советами и рекомендациями о том, как проверить статус индекса и избежать ошибок в процессе отправки веб-сайта. К концу этого урока вы сможете улучшить рейтинг своего сайта в поисковой выдаче.

Видеоруководство о том, как отправить веб-сайт в поисковые системы

Начните свой веб-сайт WordPress с помощью веб-хостинга Hostinger.

Подпишитесь на другие обучающие видео! Академия Хостингер

Подписаться

Отправка веб-сайта в Google

Google доминирует на мировом рынке поисковых систем на 92,49%. Таким образом, отправка вашего веб-сайта в Google помогает повысить узнаваемость бренда и увеличить трафик. Для бизнес-сайтов добавление их URL-адреса в Google My Business также поможет повысить рейтинг в поисковой выдаче.

Для бизнес-сайтов добавление их URL-адреса в Google My Business также поможет повысить рейтинг в поисковой выдаче.

Не забывайте, что отправка веб-сайта может относиться ко всему домену или отдельным веб-страницам.

Загрузка карты сайта в консоль поиска Google

Чтобы отправить свой веб-сайт в Google, загрузите карту сайта в консоль поиска Google. Карта сайта — это XML-файл, содержащий данные о вашем веб-сайте и взаимосвязях между его страницами.

Google использует XML-карты сайта для более быстрого индексирования вашего сайта за счет более эффективного хранения его веб-страниц. Вот некоторые из преимуществ использования XML-карты сайта для отправки вашего сайта в Google:

- Отслеживание нового контента — помогает уведомлять Google о новом контенте на вашем сайте.

- Простая навигация — показывает структуру вашего веб-сайта, предоставляя сканерам поисковых систем карту вашего сайта.

- SEO — помогает оптимизировать ваш веб-сайт за счет более частых обновлений и уведомления Google об отсутствии дублированного контента.

Чтобы загрузить карты сайта в формате XML в Google Search Console, сначала создайте карту сайта для своего веб-сайта. Выберите свой способ изготовления:

- Вручную — создать файл XML с соответствующим кодом HTML. Затем используйте валидатор карты сайта, чтобы избежать передачи недействительной карты сайта и создания помех для вашего сайта.

- Автоматически — вставьте свой URL-адрес в онлайн-генератор, и он автоматически сгенерирует URL-адрес карты сайта.

- Плагин — установите плагин YoastSEO для создания карты сайта для вашего сайта WordPress.

Любой метод будет генерировать URL-адрес карты сайта в следующем формате:

http://example.com/sitemap_index.xml

Получив XML-карту сайта, перейдите в консоль поиска Google, чтобы отправить свой веб-сайт. Вот шаги после входа в свою учетную запись:

- Выберите тип недвижимости:

- Подтвердите свой домен, добавив TXT-запись из Google Search Console на свой DNS-сервер.

С помощью Hostinger перейдите в hPanel -> Редактор зоны DNS и добавьте запись в разделе Управление записями DNS 9Коробка 0042.

С помощью Hostinger перейдите в hPanel -> Редактор зоны DNS и добавьте запись в разделе Управление записями DNS 9Коробка 0042.

- На главной странице Google Search Console выберите Sitemaps в меню левой боковой панели. Затем вставьте URL-адрес вашей карты сайта в раздел Добавить новую карту сайта . Нажмите кнопку SUBMIT , чтобы завершить процесс.

Чтобы проверить статус, перейдите на страницу Sitemaps -> Отправленные файлы Sitemap . После индексации сайта Google Search Console сообщит об оптимизации сайта и повышении его рейтинга. Google также предоставляет документацию и ресурсы для оптимизации вашего сайта.

Отправка отдельной страницы в Google

После отправки вашего сайта Google просканирует его в поисках нового содержания. Обратите внимание, что отправка отдельных URL-адресов после обновления контента ускорит индексацию Google. Для этого используйте инструмент проверки URL в Google Search Console.

Для этого используйте инструмент проверки URL в Google Search Console.

Этот инструмент предоставит данные о конкретной странице, включая ее ошибки AMP и проблемы с индексацией.

Отправьте свою страницу, выполнив следующие действия:

- После входа в свою учетную запись Google Search Console добавьте URL-адрес отдельной страницы в Проверьте любое поле URL в заголовке.

- Google проверит, был ли URL-адрес проиндексирован. Никаких дальнейших шагов не требуется, если он показывает, что URL-адрес находится в подтверждении Google . Однако, если он показывает, что URL-адрес не находится в предупреждении Google , нажмите кнопку ЗАПРОСИТЬ ИНДЕКСИРОВАНИЕ .

Обратите внимание, что Google разрешает отправлять не более 10 URL-адресов в день.

Отправка URL-адреса в Google Мой Бизнес

Отправка бизнес-сайта в Google Мой Бизнес (GMB) может привлечь больше трафика, поскольку этот бесплатный инструмент показывает сведения о компании поверх результатов поиска. Отправка URL-адреса этому инструменту имеет решающее значение для трафика, поскольку около 56% действий в списках GMB — это посещения веб-сайтов.

Отправка URL-адреса этому инструменту имеет решающее значение для трафика, поскольку около 56% действий в списках GMB — это посещения веб-сайтов.

GMB увеличивает присутствие бизнеса в Интернете в Google, включая Поиск и Карты . Когда пользователи гуглят сервис рядом с вашей компанией, поисковая система предложит вашу компанию.

Некоторые из преимуществ инструмента включают:

- Детали — от описаний до контактной информации, пользователи смогут быстрее найти все детали вашего бизнеса.

- Engagement — пользователи могут задавать вопросы и оставлять отзывы в вашем профиле, чтобы ваша компания могла ответить или ответить напрямую.

- Свяжитесь с — расширьте свое присутствие, узнав, как клиенты ищут вашу компанию.

Кроме того, этот инструмент удобен для начинающих и подходит для компаний любого размера. Выполните следующие шаги, чтобы отправить профиль вашей компании и URL-адрес в Google:

- Создайте свой профиль, вставив название вашей компании и выбрав категорию .

- Добавьте свое местоположение и выберите регион .

- Добавьте контактную информацию, включая номер телефона и URL-адрес веб-сайта .

- Другие шаги являются необязательными и могут быть изменены позже. После этого будет процесс проверки путем добавления вашего рабочего почтового адреса.

- Кроме того, есть возможность настроить свой профиль, чтобы добавить всю необходимую бизнес-информацию:

- Часы работы — укажите время, когда ваш бизнес открыт.

- Сообщения — дополнительный инструмент обмена сообщениями для прямого общения с клиентами.

- Описание бизнеса — введите описание вашего бизнеса не более 750 символов.

- Деловые фотографии – добавьте изображения вашего бизнеса или продукта.

Внутренние ссылки

Поисковый робот — это программное обеспечение, которое перемещается от ссылки к ссылке для передачи данных с веб-сайтов на серверы Google. Регулярно добавляя внутренние ссылки, Google быстрее найдет, проиндексирует и ранжирует вашу страницу.

Существует два типа внутренних ссылок: навигационные и контекстные . Оба типа помогают построить иерархию веб-сайтов и установить авторитет, который помогает поисковым роботам направлять их.

Навигационные ссылки, например строка главного меню и меню нижнего колонтитула на веб-сайте, помогают пользователям перемещаться между различными страницами в домене.

Контекстные ссылки соединяют соответствующий контент в статье, чтобы помочь читателям найти дополнительные материалы по теме. Этот тип ссылок также создает отношения между отдельными страницами сайта. Например, ссылка в сообщении блога соединяет пользователей с другой статьей, которая содержит соответствующую информацию.

Кроме того, контекстные ссылки сигнализируют Google о том, что на вашем веб-сайте есть ценная статья. Чтобы подавать сигналы поисковым системам, используйте анкорные тексты или фразы при добавлении гиперссылки к тексту.

Отправка веб-сайта в Bing

Bing — вторая по популярности поисковая система в мире. Кроме того, и Yahoo, и DuckDuckGo также используют поисковый индекс Bing для поиска новых сайтов. Чтобы отправить веб-сайт для немедленного сканирования и индексации, используйте инструменты Bing для веб-мастеров.

Отправьте свой веб-сайт в Bing, выполнив следующие действия:

- Войдите в Инструменты Bing для веб-мастеров, используя учетные записи Microsoft, Google или Facebook.

- Добавьте свой URL-адрес в разделе Добавьте свой сайт вручную . Если вы входите в систему с помощью учетной записи Google и уже подтвердили свой веб-сайт в Google Search Console, нажмите кнопку Import .

- После этого выберите Sitemaps -> Submit Sitemaps . Там добавьте URL-адрес вашей карты сайта, чтобы уведомить Bing Webmaster Tool о необходимости проиндексировать ваш сайт.

Это шаги для добавления вашего веб-сайта в Bing. Однако есть другой способ отправить отдельную страницу:

- Перейдите к URL Submit в меню левой боковой панели и нажмите кнопку Submit URLs .

- У вас есть 10 квот на отправку URL-адресов, чтобы добавить несколько URL-адресов одновременно. После добавления URL-адресов нажмите кнопку Отправить .

- После отправки URL-адреса Bing покажет дополнительную информацию о ваших URL-адресах. Если ваш веб-сайт не был просканирован или проиндексирован, нажмите кнопку 9.0041 Кнопка запроса индексации .

Если вы используете WordPress, существует также подключаемый модуль Bing URL Submission для автоматической отправки URL-адресов. Чтобы использовать этот плагин, вам необходимо сгенерировать ключ API из инструментов Bing для веб-мастеров.

Чтобы использовать этот плагин, вам необходимо сгенерировать ключ API из инструментов Bing для веб-мастеров.

Чтобы использовать подключаемый модуль, выполните следующие действия:

- Щелкните значок «Настройки» рядом со своим профилем в Инструментах для веб-мастеров Bing. В разделе «Настройки» нажмите API-доступ для управления учетными данными.

- Нажмите на API-ключ 9от 0042 до Генерация ключа . После этого скопируйте ключ API и вернитесь в WordPress.

- Перейдите на панель инструментов -> Bing Webmaster и вставьте туда ключ API. Затем нажмите кнопку Начать с помощью плагина . Оттуда вы сможете отправить URL-адрес вручную или настроить автоматическую отправку URL-адреса.

Инструменты Bing для веб-мастеров также предоставляют документацию и ресурсы для оптимизации вашего сайта.

Добавление сайта в Яндекс

Яндекс — ведущая поисковая система в России, занимающая 60% поискового рынка. Поэтому, если ваша целевая аудитория или рынок в основном находится в России или знает русский язык лучше, чем английский, отправка вашего сайта на Яндекс может быть очень выгодной.

Поэтому, если ваша целевая аудитория или рынок в основном находится в России или знает русский язык лучше, чем английский, отправка вашего сайта на Яндекс может быть очень выгодной.

Яндекс Вебмастер также имеет множество функций, которые могут помочь выявить конкретные проблемы на вашем сайте. Вот шаги для добавления вашего веб-сайта в Яндекс:

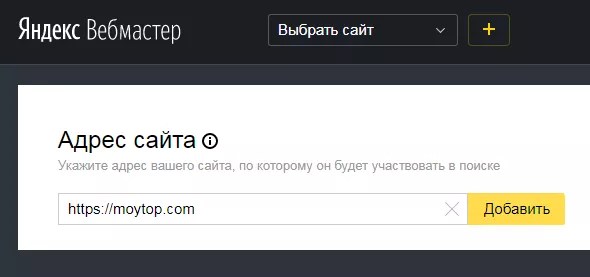

- Перейдите в Инструменты Яндекса для веб-мастеров и войдите или создайте учетную запись.

- Нажмите кнопку со знаком плюс , чтобы добавить свой веб-сайт.

- Добавьте свой URL-адрес и нажмите кнопку Добавить .

- Подтвердите свой сайт и нажмите кнопку Проверить , когда закончите. Следуйте приведенным ниже инструкциям, чтобы подтвердить свой сайт:

- Метатег. Добавьте метатег в HTML-код вашего сайта. Вам понадобится доступ к основным файлам вашего сайта через FTP.

- Корневой каталог. Добавьте HTML-файл, предоставленный Яндексом, в корневую директорию вашего сайта. Для этого параметра требуется доступ к файловому менеджеру вашего сайта.

- ДНС. Добавьте запись TXT в DNS вашего домена.

- После проверки вашего сайта перейдите на страницу Индексирование -> Файлы карты сайта . Там вставьте свой XML Sitemap в раздел Добавить файл Sitemap и нажмите кнопку Добавить .

Чтобы отправить отдельные URL в Яндекс, выполните следующие действия:

- Перейдите на Индексация -> Проверьте статус URL , чтобы добавить URL страницы из вашего домена.

- Введите URL-адрес и нажмите кнопку Проверить . Статус вашего URL будет отображаться в разделе Проверено и Страница и результаты . Существует также кнопка Track для отслеживания статуса индексации.

Яндекс отправит уведомление по электронной почте, если с вашим сайтом возникнут проблемы, которые необходимо исправить.

Проверка успешности индексации сайта

После отправки сайта проверьте, успешно ли он проиндексирован. Но не забывайте, что поисковым системам может потребоваться от нескольких дней до нескольких недель, чтобы проиндексировать ваш сайт.

Самый простой способ узнать это — проверить каждый инструмент, в котором вы представили свой сайт. У каждого инструмента есть свой способ поделиться статусом индекса для вашего сайта. Инструменты также покажут, если какие-либо ошибки требуют ваших действий.

Для Консоль поиска Google , перейдите на левую боковую панель и нажмите Покрытие . В разделе Details вы увидите, был ли ваш URL-адрес проиндексирован Google.

Если вы отправляете свой веб-сайт с помощью Инструментов для веб-мастеров Bing , нажмите Site Explorer в меню левой боковой панели. Затем вы можете просмотреть все проиндексированные страницы вашего сайта.

Затем вы можете просмотреть все проиндексированные страницы вашего сайта.

Что касается Инструменты Яндекса для веб-мастеров , перейдите к Индексация -> Проверить статус URL , чтобы узнать, проиндексировала ли поисковая система ваш URL.

Другой способ проверить это, зайдя в поисковую систему и набрав поисковый запрос:

site:yoursitename.com

На странице результатов поиска будет показан список вашего контента с вашей домашней страницей вверху. Если нет, то поисковая система не проиндексировала ваш сайт.

Предотвращение блокировки сайта с помощью «NoIndex»

Веб-сайт может блокировать поисковые системы от индексации своих страниц с помощью метатега NoIndex . Если веб-страница имеет этот тег в своем HTML, поисковые системы не будут сканировать и индексировать сайт ни вручную, ни автоматически.

Тег NoIndex находится в области страницы со следующим форматом:

Тег NoIndex может помочь избежать сканирования дубликатов контента или для тестирования страницы перед выходом в Интернет. Однако всегда не забывайте удалять тег перед отправкой своего веб-сайта.

Однако всегда не забывайте удалять тег перед отправкой своего веб-сайта.

Чтобы проверить, содержит ли ваш сайт теги NoIndex, используйте онлайн-инструменты, такие как SEO Site Checkup. Если поисковые системы не могут проиндексировать ваш сайт, удалите тег и повторно отправьте свой сайт.

Мы также рекомендуем проверить файл .htaccess , чтобы проверить, содержит ли он тег NoIndex или NoFollow.

Если вы используете WordPress, перейдите в Настройки -> Чтение и проверьте Видимость поисковой системы . Обязательно снимите флажок рядом с ним, если вы хотите, чтобы ваш сайт был проиндексирован.

Помимо тега NoIndex, проверьте другие проблемы, которые могут помешать поисковым системам индексировать ваш сайт:

- Robot.txt файл — используйте Google Robots Testing Tool, чтобы узнать, блокирует ли файл поисковые системы при сканировании вашего сайта.

- Страницы перенаправления — поисковые системы не могут индексировать страницы перенаправления.

- Дублированный контент — на страницах сайта не должно быть дублированного контента, так как поисковые системы будут индексировать только один из них.

Причины отправки вашего сайта в поисковые системы

Поисковые системы все равно будут индексировать и ранжировать ваш сайт без его отправки. Однако это поможет поисковым системам быстрее обнаружить ваш сайт. Вот некоторые из причин, по которым ваш сайт должен быть представлен поисковым системам:

- Бесплатно — добавление сайтов ничего не стоит.

- Органический трафик — увеличьте поисковый трафик, так как это один из самых распространенных способов поиска новостей и информации пользователями.

- Точность — включите самые точные и актуальные данные о вашем сайте.

- Видимость — увеличьте видимость и рейтинг вашего бизнес-сайта в результатах поиска основных поисковых систем.

Повысить осведомленность о продуктах и услугах.

Повысить осведомленность о продуктах и услугах. - Рейтинг – улучшите рейтинг, предоставив полные данные о вашем сайте.

- Обновления — поисковые системы могут быстрее индексировать вашу новую статью или видео после отправки карты сайта.

Нет необходимости размещать ваш сайт в поисковых системах. Тем не менее, очень полезно отправить свой сайт в случае:

- Новый веб-сайт – , отправив свой сайт сразу после запуска, поисковые системы смогут быстрее просканировать и проиндексировать ваш сайт.

- Обновление страницы — когда вы вносите существенные изменения на свою страницу, это гарантирует, что индекс данных поисковых систем будет наиболее релевантным.

- Неполный индекс – проверьте поисковую систему и найдите свой сайт. Если его там нет, отправьте его вручную. Может быть ошибка, которую вы упустили из виду заранее, и отправив свой веб-сайт, вы будете лучше осведомлены о проблемах.

Повышение видимости после индексации

Веб-сайты не получают автоматически более высокий трафик после того, как поисковые системы проиндексируют их. Сайт также должен включать высококачественный и SEO-оптимизированный контент, чтобы увеличить видимость в поисковой выдаче. Более высокий рейтинг может улучшить трафик, поскольку первые 3 органических результата получают 75% поискового трафика.

Помимо отправки вашего сайта в поисковые системы, вот несколько рекомендаций по использованию некоторых SEO-сервисов для оптимизации вашего сайта и повышения его видимости:

- Социальные сети — поделитесь своим контентом в Facebook, Twitter и Instagram для продвижения вашего сайта. бесплатно.

- Информационный бюллетень — отправляйте регулярные электронные письма своей аудитории, чтобы привлечь больше кликов на ваш сайт и повысить его видимость.

- Таргетинг по ключевым словам — определите ключевые слова, которые будут привлекать трафик, и добавьте их в свои заголовки, URL-адреса и заголовки.

- Обратные ссылки — помимо внутренних ссылок, создание обратных ссылок может ускорить индексацию вашего сайта поисковыми системами. Обратные ссылки — это ссылки, добавленные другими сайтами, которые направляют пользователей на ваш сайт.

- Мета-описание — оптимизируйте мета-заголовки, описания и URL-адреса , поскольку они отображаются поисковыми системами в поисковой выдаче.

- Отслеживайте конкуренцию — проверяйте основных конкурентов, чтобы узнать, отсутствуют ли в вашем контенте определенные материалы, которые помогают ранжироваться.

- Аналитика — просматривайте ежемесячные отчеты и данные, чтобы увидеть свою самую эффективную публикацию, демографические данные аудитории и степень вовлеченности. Таким образом, вы сможете создать лучшую стратегию для своего сайта.

- Удобство для мобильных устройств – Убедитесь, что ваш веб-сайт оптимизирован для мобильных устройств, поскольку поисковые системы учитывают адаптацию к мобильным устройствам при определении рейтинга.

- Обновления контента – Продолжайте обновлять, вносить изменения и повторно публиковать статьи, чтобы они оставались актуальными и оптимизированными.

- Визуальный контент – добавление изображений, графиков и видео на веб-сайты для привлечения большей аудитории. Обязательно оптимизируйте изображения, чтобы ваш сайт не тормозил.

Заключение

Размещение вашего веб-сайта в поисковых системах — один из способов увеличить посещаемость веб-сайта. Поисковые системы автоматически сканируют веб-сайты, чтобы проиндексировать их. Однако вы можете заметить ошибки и лучше оптимизировать свой веб-сайт, отправив его в поисковые системы вручную.

В этой статье показано, как добавить веб-сайт в поисковые системы: Google, Bing и Yandex, а также Yahoo и DuckDuckGo, которые используют данные индексации Bing. Мы также рассказали, как отправлять карты сайта и URL-адреса для отдельных страниц.

В случае ошибки при отправке веб-сайта мы показали, как проверить, удалось ли вам исправить ошибку.

Имейте в виду, что представления вашего веб-сайта в поисковых системах недостаточно для привлечения трафика, поэтому в этом руководстве также содержатся советы и рекомендации по оптимизации содержимого веб-сайта для повышения его рейтинга в поисковой выдаче.

Теперь, когда вы знаете, как разместить свой веб-сайт в основных поисковых системах, поделитесь своим опытом в разделе комментариев ниже.

Узнать больше об оптимизации сайта

Core Web Vitals

Лучшие SEO-форумы

Как выполнить тест скорости веб-сайта

Как найти ключевые слова с длинным хвостом

Астари — эксперт по цифровому маркетингу, специализирующийся на SEO и WordPress. Она любит делиться своим богатством знаний в своих письмах и любит бродить по Интернету в поисках новой информации, когда она не плывет по волнам или не ходит в горы. Ее миссия — узнавать что-то новое каждый день, и она твердо верит, что знаний много не бывает.

При удалении пользовательского раздела из структуры сайта информация о нем в базе поиска сохраняется.

При удалении пользовательского раздела из структуры сайта информация о нем в базе поиска сохраняется. В течение 3 суток заявка будет обработана; «Робот обошёл» — страница посещена роботом. Данные о странице обновятся в поиске в течение 2 недель и «Ошибка» — робот не смог посетить страницу.

В течение 3 суток заявка будет обработана; «Робот обошёл» — страница посещена роботом. Данные о странице обновятся в поиске в течение 2 недель и «Ошибка» — робот не смог посетить страницу.