Как найти и удалить дубли страниц на сайте

- SEO

- РАЗРАБОТКА

Дубль – страница, которая полностью или частично дублирует контент другой страницы. Одна из причин потери трафика из поисковых систем – наличие дублей страниц на сайте.

Подписаться

Дубль – страница, которая полностью или частично дублирует контент другой страницы. Одна из причин потери трафика из поисковых систем – наличие дублей страниц на сайте.

Одна из причин потери трафика из поисковых систем – наличие дублей страниц на сайте.

Принципы определения дублей поисковыми системами

Поисковые системы (далее «ПС») имеют свои алгоритмы проверки и определения дублей страниц.

Основные параметры, которые учитывают ПС при определении дублей:

- Мета-теги;

- Заголовки h2-H6;

- Текст страницы.

Способы определения дублей страниц на сайте

Статус «Дубль» присваивается поисковым роботом соответствующей поисковой системы при сканировании страниц сайта. Воспользуйтесь Вебмастерами поисковых систем, чтобы определить наличие дублей. Или воспользуйтесь специализированными программами для ручного поиска дублей.

Способ 1: Дубли страниц в Яндекс.Вебмастер

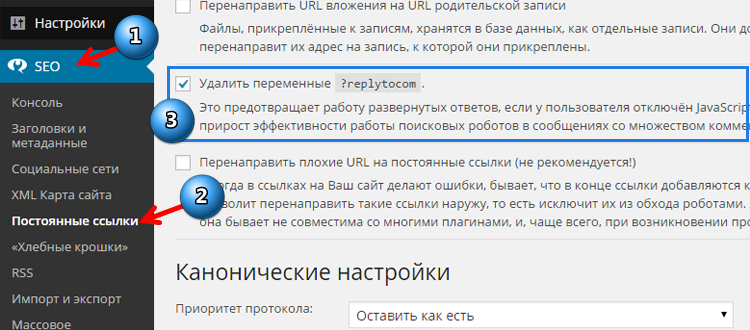

В поисковой системе Яндекс увидеть дубли страниц можно в Яндекс.Вебмастер, в разделе Индексирование → Страницы в поиске → Исключенные страницы → Статус «Дубль».

Способ 2: Дубли страниц в Google Search Console

В поисковой системе Google увидеть дубли страниц можно в Google Search Console, в разделе «Покрытие» → «Исключено».

Дубли страниц в Google Search ConsoleСпособ 3: Через программы для комплексного анализа сайтов

Поисковые системы не всегда корректно распознают дубли. Используя различные программы сканирования сайтов можно определить наличие дублей на сайте. Например, программа Screaming Frog позволяет это сделать.

Чтобы найти дубли с помощью Screaming Frog используйте те же самые основные параметры поиска:

-

Поиск одинаковых Title. Вкладка «Page Titles» → Filter «Duplicate»

-

Одинаковые заголовки h2, h3. Вкладка «h2» или «h3» → Filter «Duplicate»

Список страниц с одинаковыми h2 в программе Screaming Frog

Подобным образом можно найти дубли во вкладке Description, h3.

Способ 4: Ручной поиск – проверка типичных ошибок

Дубли сайта формируются на основании технических особенностей систем, на которых пишутся сайты.

Основные ручные проверки, которые необходимо провести:

- Доступность страницы с добавлением index.php / index.html / index.htm для каждой страницы после слеша. Например, есть страница https://site.ru, нужно проверить доступность страницы по адресам:

- https://site.ru/index.php

- https://site.ru/index.html

- https://site.ru/index.htm

- Доступность страницы по HTTP и HTTPS страницы: https://site.ru и http://site.ru. Если страница доступна по разным протоколам, то необходимо настроить 301 редирект с HTTP на HTTPS

- Доступность страницы по разным зеркалам. Адреса с «www» и без «www»:

- http://site.ru

- http://www.site.ru

- Доступность страницы с разным регистром в URL:

- http://site.

ru/example/

ru/example/ - http://site.ru/EXAMPLE/

- http://site.

- Доступность одной и той же страницы по разным URL:

- http://site.ru/catalog/tovar1/

- http://site.ru/tovar1/

- Доступность страницы со слешами («/», «//», «///») и без них в конце:

- http://site.ru/example

- http://site.ru/example//

- http://site.ru///example/

- Доступность страницы-дубля через пагинацию:

- http://site.ru/catalog/

- http://site.ru/catalog/page1

Как избавиться от дублей страниц

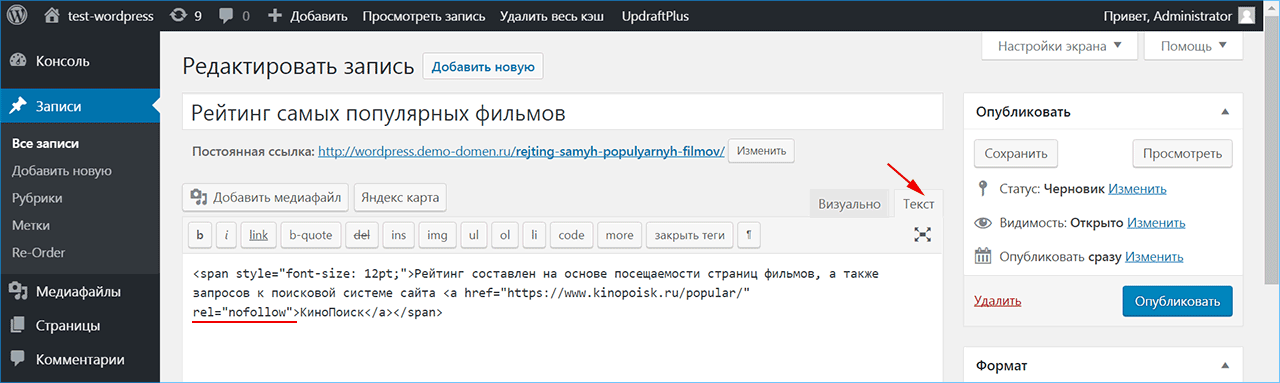

- Установить тег canonical. Установить тег в head: link rel=»canonical» href=»ссылка на каноничную страницу»;

- Изменить контент страницы. Изменить мета-теги, заголовки h2-h6, текст, учитывая особенности контента, расположенного на странице. Используйте в случае необходимости индексирования страницы-дубля;

- Удалить страницу;

- Установить 301 редирект с дубля на оригинальную страницу.

Попадая на страницу дубль, пользователь будет переадресован на нужную страницу;

Попадая на страницу дубль, пользователь будет переадресован на нужную страницу; - Запретить индексирование в robots.txt. Указать поисковому роботу, что добавлять в индекс такие страницы не нужно;

- Установить мета-тег noindex. Добавить в head: meta name=»robots» content=»noindex».

Влияние дублей страниц на поисковое продвижение

- Любой поисковая система имеет лимит на сканирование страниц для одного сайта. При появлении дублей, увеличивается общее количество страниц на сайте. При большом количестве страниц-дублей, поисковой робот может вовсе пропустить важные страницы;

- Изменение релевантности страницы. Поисковой робот может решить, что страница-дубль отвечает на запрос лучше, чем оригинальная страница и в поисковой выдаче будет показывать страницу-дубль;

- Потеря ссылочной массы оригинальной страницы и посетители станут попадать на страницы-дубли.

-

-

НОВОСТИ

Цифровой Элемент на Ecom Eхpo’22 -

РАЗРАБОТКА

Что такое 1С-Bitrix?

Все статьи

-

РАЗРАБОТКА

Как проверить и увеличить скорость загрузки сайта -

ИНТЕРНЕТ-РЕКЛАМА

Что такое контекстно-медийная реклама

Все статьи

-

РАЗРАБОТКА

Flutter или нативная разработка? -

ИНТЕРНЕТ-РЕКЛАМА

Что такое CTR в рекламе

Все статьи

#SEO

Микроразметка schema.org

Schema.org – микроразметка, позволяющая структурировать данные на сайте для поисковых систем. С ее помощью поисковые системы понимают, какие данные…

#ИНТЕРНЕТ-МАРКЕТИНГ

Как попасть на Яндекс.Карты, Google.Карты, 2GIS

Если ваша компания ведет бизнес офлайн, размещение на Яндекс.Картах и Google и 2GIS поможет рассказать об этом потенциальным клиентам. Присутствие…

#ДИЗАЙН

TОП-40 плагинов Figma

Для создания дизайнов и прототипов большинство современных дизайнеров использует Figma. Его основное преимущество перед другими графическими прогр…

Его основное преимущество перед другими графическими прогр…

#SEO

404 ошибка – страница не найдена

404 ошибка (страница не найдена) – это ответ сервера, который возникает, когда сервер не может отобразить запрашиваемую страницу по указанному адре…

#SEO

Семантика сайта

Семантическое ядро – это набор фраз, соответствующих поисковым запросам пользователей в поисковых системах, которые характеризуют определенную тема…

#ИНТЕРНЕТ-РЕКЛАМА

Как предоставить гостевой доступ к Яндекс Директ и Google Adwords

Контекстная реклама — один из самых простых и быстрых способов увеличения посещений веб-сайта. Особенностью этого инструмента является понятность р…

#РАЗРАБОТКА

Как составить ТЗ на разработку сайта

ТЗ (техническое задание) – очень полезный документ, в котором описаны все разделы сайта, все элементы страницы и функциональность всех модулей. Пол…

Пол…

#SEO

Микроразметка Open Graph

Open Graph – стандарт микроразметки, который позволяет формировать превью сайта при публикации в социальных сетях. Стандарт Open Graph был р…

#ТЕХПОДДЕРЖКА

Сброс кеша DNS в Google Chrome

Для сброса кеша DNS в Google Chrome: Введите в адресной строке браузера chrome://net-internals/#dns и нажмите кнопку Clear host cache; Зат…

#ИНТЕРНЕТ-МАРКЕТИНГ

Анализ сайта с помощью Яндекс.Метрики

Яндекс.Метрика – инструмент анализа аудитории сайта. Метрика позволяет сегментировать данные, определять целевую аудиторию сайта, достигать целей и…

Заявка!

Для консультации или подготовки предложения.

Будьте всегда в курсе!

Подпишитесь на нашу рассылку

Ваш email

Ваш email

Я согласен(а) на получение сообщений по e-mail. Я уведомлен(а), что могу в любое время отказаться от их получения.

Ваш e-mail

Ваше имя

Контактный телефон

Эл. почта

Согласен на обработку персональных данных

Золотой партнер

1С-Битрикс

Сертифицированное агентство

Яндекс. Директ

Директ

Сертифицированное агентство

Google.AdWords

Региональный партнер

Ru-center

Золотой партнер

Битрикс24

Инструкция для новичков по удалению дублей страниц на сайте

140351 2432 2

| SEO | – Читать 14 минут |

Прочитать позже

Сергей Романов

Специалист по продвижению веб-проектов в Promodo

Дубли страниц очень опасны с точки зрения SEO. Они критично воспринимаются поисковыми системами и могут привести к серьезным потерям в ранжировании и даже к наложению фильтра. Чтобы этого избежать, важно вовремя находить и удалять такие дубли.

Содержание

- Дубликаты: в чем опасность?

- Какими бывают дубли?

- Полные дубликаты — откуда они берутся?

- Частичные дубликаты — что представляют из себя?

- C помощью каких инструментов искать дубли?

- Как побороть и чем?

- Как быстро найти дубли страниц на сайте с помощью Serpstat

Заключение

Дубликаты: в чем опасность?

Опасность возникновения дублей можно показать на простом отвлеченном примере: посмотрите на картинку справа и скажите, какой из 2-х изображенных плодов наиболее релевантен запросу «красное яблоко».

Сложно, не правда ли? Ведь оба плода на картинке — это яблоки, и оба они красные. То есть, они одинаково релевантны запросу, а выбрать нас просят один, максимально точно соответствующий.

Возвращаясь к сайтам: в той же ситуации оказывается и поисковая система, когда ей нужно выбрать из двух одинаковых страниц одну и показать ее в результатах выдачи.

Конечно, поисковик учитывает и другие параметры при ранжировании, такие как внешние и внутренние ссылки, поведение пользователей, но факт остается фактом: из 2-х одинаково красных яблок, Google или Yandex должны выбрать одно. В этом-то и состоит вся трудность.

Возникновение такой дилеммы может привести к различным негативным последствиям:

Снижению релевантности основной посадочной страницы, а, значит, и снижению позиций ключевых слов.

«Скачкам» позиций ключевых слов за счет постоянной смены релевантной привязки с одной страницы на другую.

Общему понижению в ранжировании, когда проблема приобретает масштабы не отдельных URL, а всего сайта.

Именно подобная опасность вынуждает SEO-оптимизаторов обращать особое внимание на поиск и устранение дублей на этапе внутренней оптимизации.

Какими бывают дубли?

Перед тем, как начать процесс поиска дублей, нужно определиться с тем, что они бывают 2-х типов, а значит, процесс поиска и борьбы с ними будет несколько отличным. Так, в частности, выделяют:

Полные дубли

Когда одна и та же страница размещена по 2-м и более адресам.

Частичные дубли

Когда определенная часть контента дублируется на ряде страниц, но они уже не являются полными копиями.

Как удалить пустые страницы на сайте

| Читать! |

Полные дубликаты — откуда они берутся?

Дубли главной страницы по адресам:

http://mysite. com/index,

com/index,

http://mysite.com/index/,

http://mysite.com/index.php,

http://mysite.com/index.php/,

http://mysite.com/index.html,

http://mysite.com/index.html/.

Один из этих URL может быть адресом главной страницы по умолчанию.

Дубли, сгенерированные реферальной ссылкой.

Когда пользователь приходит по URL адресу с параметром «?ref=…», должно происходить автоматическое перенаправление на URL без параметра, что, к сожалению, часто забывают реализовать разработчики.

Ошибки, связанные с иерархией URL, приводящие к возникновению дублей.

Так, например, один и тот же товар может быть доступен по четырем разным URL-адресам:

https://mysite.com/catalog/dir/tovar.php,

https://mysite.com/catalog/tovar.php,

https://mysite.com/tovar.php,

https://mysite.com/dir/tovar.php.

Некорректная настройка страницы 404 ошибки, приводящая к возникновению «бесконечных дублей» страниц вида:

http://mysite. com/olololo-test-olololo

com/olololo-test-olololo

где текст, выделенным красным — это любой набор латинских символов и цифр.

Страницы с utm-метками и параметрами «gclid».

Данные метки нужны для того, чтобы передавать некоторые дополнительные данные в системы контекстной рекламы и статистики. Несмотря на то, что, по идее, они не должны индексироваться поисковыми системами, частенько можно встретить полный дубль страницы с utm-меткой в выдаче.

Полные дубли представляют серьезную опасность с точки зрения SEO, так как критично воспринимаются поисковыми системами и могут привести к серьезным потерям в ранжировании и даже к наложению фильтра, пессимизирующего весь сайт.

Хотите узнать, как с помощью Serpstat найти дубли страниц?

Заказывайте бесплатную персональную демонстрацию сервиса, и наши специалисты вам все расскажут! 😉

| Оставить заявку! |

Частичные дубликаты — что

представляют из себя?

Как и в случае с полными дублями, частичные возникают, в первую очередь, из-за особенностей CMS сайта, но значительно труднее обнаруживаются. Кроме того, от них сложнее избавиться, но об этом чуть ниже, а пока наиболее распространенные варианты:

Кроме того, от них сложнее избавиться, но об этом чуть ниже, а пока наиболее распространенные варианты:

Страницы пагинации, сортировок, фильтров

Как правило, каким-то образом меняя выводимый товарный ассортимент на странице категории магазина, страница изменяет свой URL (фактически все случаи, когда вывод не организован посредством скриптов). При этом SEO-текст, заголовки, часто и мета-данные — не меняются. Например:

http://mysite.com/catalog/category/ — стартовая страница категории товаров

http://mysite.com/catalog/category/?page=2 — страница пагинации

При том, что URL адрес изменился и поисковая система будет индексировать его как отдельную страницу, основной SEO-контент будет продублирован.

Страницы отзывов, комментариев, характеристик

Достаточно часто можно встретить ситуацию, когда при выборе соответствующей вкладки на странице товара, происходит добавление параметра в URL-адрес, но сам контент фактически не меняется, а просто открывается новый таб.

Версии для печати, PDF для скачивания

Данные страницы полностью дублируют ценный SEO-контент основных страниц сайта, но имеют упрощенную версию по причине отсутствия большого количества строк кода, обеспечивающего работу функционала. Например:

http://mysite.com/main/hotel/al12188 — страница отеля

http://mysite.com/main/hotel/al12188/print — ЧБ версия для печати

http://mysite.com/main/hotel/al12188/print?color=1 — Цветная версия для печати.

Выдача Google:

Выдача Yandex:

Html слепки страниц сайта, организованных посредством технологии AJAX

Найти их можно заменив в оригинальном URL-адресе страницы «!#» на «?_escaped_fragment_=». Как правило, в индекс такие страницы попадают только тогда, когда были допущены ошибки в имплементации метода индексации AJAX страниц посредством перенаправления бота на страницу-слепок и робот обрабатывает два URL-адреса: основной и его Html-версию.

Основная опасность частичных дублей в том, что они не приводят к резким потерям в ранжировании, а делают это постепенно и незаметно для владельца сайта. То есть найти их влияние сложнее и они могут систематически, на протяжении долгого времени «отравлять жизнь» оптимизатору.

C помощью каких инструментов искать дубли?

Существует несколько инструментов для поиска дублей:

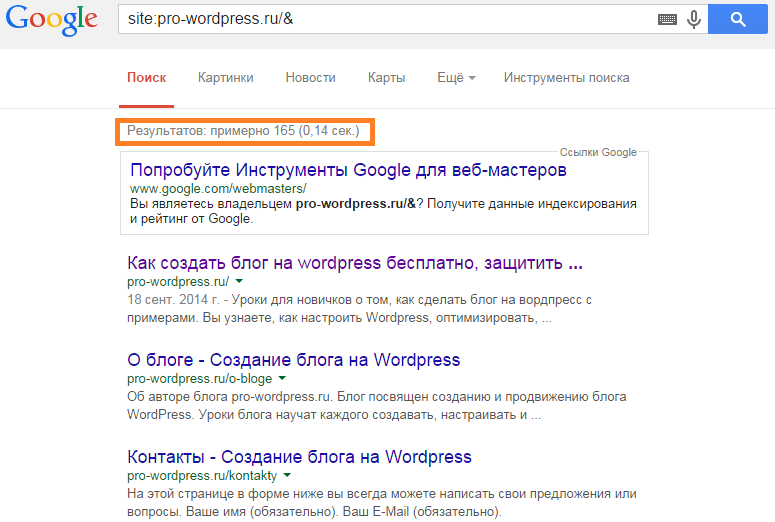

Мониторинг выдачи посредством оператора «site:»

Отобразив на странице SERP все проиндексированные URL участвующие в поиске, можно визуально детектировать повторы и разного рода «мусор».

Десктопные программы-парсеры и сервисы

Могу порекомендовать три удобные и информативные программы: Screaming Frog Seo Spider, Netpeak Spider, Xenu. Запуская собственных ботов к вам на сайт, программы выгружают полный список URL-адресов, который можно отсортировать по совпадению тега «Title» или «Description», и таким образом, выявить возможные дубли.

В Serpstat также можно найти потенциальные дубли. Он находит страницы с дублирующимися Title и Description.

SEO-аудит сайта с помощью Serpstat: обзор инструмента

| Читать! |

Поисковая консоль Google

В Google Search Console во вкладке «Оптимизация Html» можно посмотреть список страниц с повторяющимися мета-описаниями, т.е. список потенциальных дублей.

Ручной поиск непосредственно на сайте

Опытные веб-мастера способны вручную выявить большинство дублей в течение пары минут, просто попробовав различные вариации URL-адресов в обозначенных выше проблемных местах.

Как побороть и чем?

Способов борьбы с дубликатами не так уж и много, но все они потребуют от вас привлечения специалистов-разработчиков, либо наличия соответствующих знаний. По факту же арсенал для «выкорчевывания» дублей сводится к:

По факту же арсенал для «выкорчевывания» дублей сводится к:

Их физическому удалению — хорошее решение для статических дублей.

Запрещению индексации дублей в файле «robots.txt» — подходит для борьбы со служебными страницами, частично дублирующими контент основных посадочных.

Настройке 301 редиректов в файле-конфигураторе «.htacces» — хорошее решение для случая с рефф-метками и ошибками в иерархии URL.

Установке тега «rel=canonical» — лучший вариант для страниц пагинации, фильтров и сортировок, utm-страниц.

Пример установки тега на странице пагинации:

Установке тега «meta name=»robots» content=»noindex, nofollow»» — решение для печатных версий, табов с отзывами на товарах.

Быстро проанализировать robots.txt, состояние тега canonical поможет:

Расширение для браузеров Serpstat Website SEO Checker

| Читать! |

Как быстро найти дубли страниц на сайте с помощью Serpstat

Чтобы быстро найти дубли страниц на сайте, можно воспользоваться «Аудитом сайта» от Serpstat. Это инструмент, который позволяет проанализировать сайт на наличие технических ошибок.

Это инструмент, который позволяет проанализировать сайт на наличие технических ошибок.

Аудит сайта Serpstat работает по тому же принципу, что и поисковый робот. Проверка укажет на слабые места вашего сайта, в которых он не соответствует требованиям поисковых систем, и предложит способы исправления этих ошибок. Также можно провести аудит одной страницы.

Для того, чтобы провести проверку сайта на ошибки, необходимо сначала создать проект и сделать соответствующие настройки. Подробнее об этом читайте в статье.

SEO-аудит сайта с помощью Serpstat: обзор инструмента

| Читать! |

После того как проверка будет произведена, вы получите подборную сводку по ошибкам. В ней все SEO-уязвимости будут распределены по приоритетам: от высокого — ошибок, которые угрожают позициям, до низкого — ошибок, которые опасны в меньшей мере, но требуют исправления и советов по улучшению, которые стоит внедрить, чтобы сайт выглядел привлекательнее в глазах поисковых роботов.

Чтобы найти дубли страниц, в сводке по ошибкам необходимо перейти в раздел «Метатеги» и найти пункт «Дублирующийся Title». Если возле него чек-бокс будет окрашен в серый цвет, значит на вашем сайте найдены такие неполадки.

Как видим, данная ошибка имеет высокий приоритет, так как метатег Title — это один из важнейших элементов, которые напрямую влияют на ранжирование. Кликните на название ошибки, чтобы увидеть ее описание, рекомендации к устранению и список URL, где она встречается.

Также косвенно можно найти дубли с помощью пункта «Дублирующийся Description» Следуйте рекомендациям и постарайтесь устранить ошибку как можно скорее.

Хотите узнать, как с помощью Serpstat сделать проверку сайта на дубли?

Заказывайте бесплатную персональную демонстрацию сервиса, и наши специалисты вам все расскажут! 😉

| Оставить заявку! |

| Узнать подробнее! |

Заключение

Часто решение проблемы кроется в настройке самого движка, а потому основной задачей оптимизатора является не столько устранение, сколько выявление полного списка частичных и полных дублей и постановке грамотного ТЗ исполнителю.

Запомните следующее:

Полные и частичные дубли могут понизить позиции сайта в выдаче не только в масштабах URL, а и всего домена.

Полные дубли — это когда одна и та же страница размещена по 2-м и более адресам.Частичные дубли — это когда определенная часть контента дублируется на ряде страниц, но они уже не являются полными копиями.

Полные дубликаты нетрудно найти и устранить. Чаще всего причина их появления зависит от особенностей CMS сайта и навыков SEO разработчика сайта.

Частичные дубликаты найти сложнее и они не приводят к резким потерям в ранжировании, однако делают это постепенно и незаметно для владельца сайта.

Чтобы найти частичные и полные дубли страниц, можно использовать мониторинг выдачи с помощью поисковых операторов, специальные программы-парсеры, поисковую консоль Google и ручной поиск на сайте.

Избавление сайта от дублей сводится к их физическому удалению, запрещению индексации дублей в файле «robots. txt», настройке 301 редиректов, установке тегов «rel=canonical» и «meta name=»robots» content=»noindex, nofollow»».

txt», настройке 301 редиректов, установке тегов «rel=canonical» и «meta name=»robots» content=»noindex, nofollow»».

Персональная демонстрация

Оставьте заявку и мы проведем для вас персональную демонстрацию сервиса, предоставим пробный период и предложим комфортные условия для старта использования инструмента.

Сэкономьте время на изучении Serpstat

Хотите получить персональную демонстрацию сервиса, тестовый период или эффективные кейсы использования Serpstat?

Оставьте заявку и мы свяжемся с вами 😉

Оцените статью по 5-бальной шкале

4.35 из 5 на основе 158 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Петр Савинов

Как продвинуться в 2GIS: основные рекомендации

SEO +1

Daniel Ricardo

Как делать SEO-отчеты, которые впечатлят ваших клиентов: опыт Strategy Plus

SEO

Виталий Михейкин

Крауд-маркетинг своими руками: рекомендации для линкбилдинга

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

Как найти и удалить дубли страниц на сайте — Офтоп на vc.ru

{«id»:13623,»url»:»\/distributions\/13623\/click?bit=1&hash=626bd36534dece213f1f26a8750e63de3e475c69d0d206ab93e2c56faa7fda23″,»title»:»\u0418\u0449\u0435\u043c \u043a\u043e\u043c\u043c\u0435\u0440\u0447\u0435\u0441\u043a\u043e\u0433\u043e \u0440\u0435\u0434\u0430\u043a\u0442\u043e\u0440\u0430 \u0432 \u00ab\u041a\u043e\u043c\u0438\u0442\u0435\u0442\u00bb. \u042d\u0442\u043e \u043d\u0435 \u0432\u044b?»,»buttonText»:»\u042f!»,»imageUuid»:»1be73235-8504-513d-b994-f0b41ec0f080″,»isPaidAndBannersEnabled»:false}

Дубли страниц — документы, имеющие одинаковый контент, но доступные по разным адресам. Наличие таких страниц в индексе негативно сказывается на ранжировании сайта поисковыми системами.

Наличие таких страниц в индексе негативно сказывается на ранжировании сайта поисковыми системами.

2401 просмотров

Какой вред они могут нанести

- Снижение общей уникальности сайта.

- Затрудненное определение релевантности и веса страниц (поисковая система не может определить, какую страницу из дубликатов необходимо показывать по запросу).

- Зачастую дубли страниц имеют одинаковые мета-теги, что также негативно сказывается на ранжировании.

Как появляются дубликаты

Технические ошибки

К ним относят доступность страниц сайта:

- по www и без www;

- со слэшем на конце и без;

- с index.php и без него;

- доступность страницы при добавлении различных GET-параметров.

Особенности CMS

- страницы пагинации сайта;

- страницы сортировки, фильтрации и поиска товаров;

- передача лишних параметров в адресе страницы.

Важно! Также дубли страниц могут появляться за счет доступности первой страницы пагинации по двум адресам: http://site.ru/catalog/name/?PAGEN_1=1 и http://site.ru/catalog/name/.

Дубликаты, созданные вручную

Один из наиболее частых примеров дублирования страниц — привязка товаров к различным категориям и их доступность по двум адресам. Например: http://site.ru/catalog/velosiped/gorniy/stern-bike/ и http://site.ru/catalog/velosiped/stern-bike/.

Также страницы могут повторяться, если структура сайта изменилась, но старые страницы остались.

Поиск дублей страниц сайта

Существует большое количество методов нахождения дубликатов страниц на сайте. Ниже описаны наиболее популярные способы:

- программа Screaming Frog;

- программа Xenu;

- Google Webmaster: «Вид в поиске» -> «Оптимизация HTML»;

- Google Webmaster: «Сканирование» -> «Оптимизация HTML».

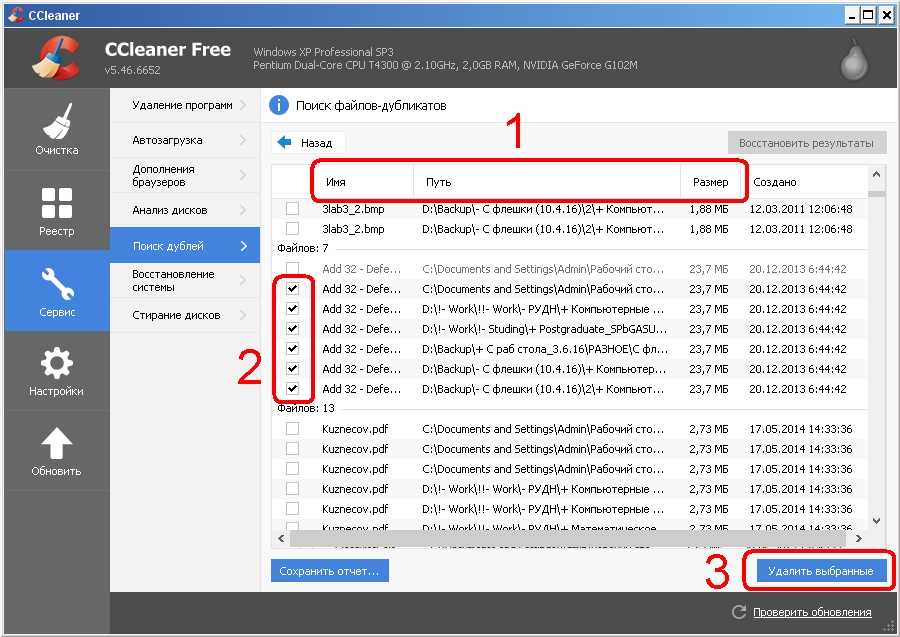

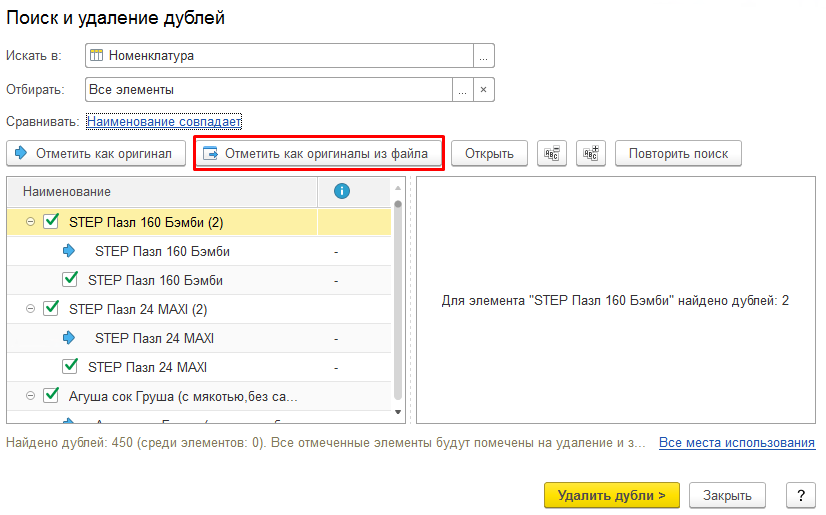

Для программы Screaming Frog и Xenu указывается адрес сайта, и после этого робот собирает информацию о нем. После того, как робот просканирует сайт, выбираем вкладку Page Title — Duplicate, и анализируем вручную список полученных страниц.

С помощью инструмента «Оптимизация HTML» можно выявить страницы с одинаковыми description и title. Для этого в панели Google Webmaster надо выбрать необходимый сайт, открыть раздел «Вид в поиске» и выбрать «Оптимизация HTML».

C помощью инструмента «Параметры URL» можно задать параметры, которые необходимо индексировать в адресах страниц.

Для этого надо выбрать параметр, кликнуть на ссылку «Изменить» и выбрать, какие URL, содержащие данный параметр, необходимо сканировать.

Также, найти все индексируемые дубли одной страницы можно с помощью запроса к поиску Яндекса. Для этого в поиске Яндекса необходимо ввести запрос вида site:domen.ru «фраза с анализируемой страницы», после чего проанализировать вручную все полученные результаты.

Как правильно удалить дубли

Чтобы сайт открывался лишь по одному адресу, например «http://www.site.ru/catalog/catalog-name/», а не по «http://site.ru/catalog/catalog-name/index.php», необходимо корректно настроить 301 редиректы в файле htaccess:

- со страниц без www, на www;

- со страниц без слэша на конце, на «/»;

- со страниц с index.php на страницы со слэшем.

Если вам необходимо удалить дубликаты, созданные из-за особенностей системы управления сайтом, надо правильно настроить файл robots.txt, скрыв от индексации страницы с различными GET-параметрами.

Для того чтобы удалить дублирующие страницы, созданные вручную, нужно проанализировать следующую информацию:

- их наличие в индексе;

- поисковый трафик;

- наличие внешних ссылок;

- наличие внутренних ссылок.

Если неприоритетный документ не находится в индексе, то его можно удалять с сайта.

Если же страницы находятся в поисковой базе, то необходимо оценить, сколько поискового трафика они дают, сколько внешних и внутренних ссылок на них проставлено. После этого остается выбрать наиболее полезную.

После этого необходимо настроить 301-редирект со старой страницы на актуальную и поправить внутренние ссылки на релевантные.

Ждите новые заметки в блоге или ищите на нашем сайте.

Дубли страниц на сайте, способовы поиска и методы устранения

К рамкам технической оптимизации относится поиск, выявление и удаление копий. Дубли — это страницы, которые обладают идентичным или частично совпадающим контентом, но доступ к ним можно получить по разным целевым.

Если такие разделы существуют на сайте, то системы поиска будут неправильно их ранжировать, а значит такой материал нужно как можно раньше выявить, а после удалить.

Как появляются

Бывают «полные» и «частичные» дубликаты или иногда их называют «явные» и «неявные». Первые полностью совпадают по всем показателям, а вторые совпадают лишь частично. Зачастую дубли страниц возникают на сайте из-за особенности работы CMS, некорректной настройки 301-редирект или ошибок в файле «robots.txt». Также копии могут появиться по следующим причинам:

Зачастую дубли страниц возникают на сайте из-за особенности работы CMS, некорректной настройки 301-редирект или ошибок в файле «robots.txt». Также копии могут появиться по следующим причинам:

- Доступ к сервису через префикс «www» или без него. Если не указать главную версию проекта, то произойдет конфликт с выбором главного зеркала сайта. А значит, что машины будут воспринимать ресурс с «www» и без него в качестве двух разных площадок. Зачастую такие случаи решают при помощи Google Search Console или Яндекс.Вебмастер.

- С протоколами http и https. Здесь происходит примерно такая же ситуация, как с «www». Если вовремя не настроить какая целевая будет главной, то произойдет появление зеркал. Это снижает уникальность контента, а также снижает позиции площадки в выдаче.

- Целевая может оканчиваться на слэш, а может быть без него. В таких ситуация создается полный дубликат. Поисковики индексируют оба раздела, которые наполнены идентичным контентом. По итогу вносят сайт в бан или понижают его вы выдаче по запросам.

Какой вариант предпочтительнее (со слэшом или без него) решает веб-мастер: если больше проиндексировано материала без слэша, то лучше все страницы подвести под единое правило.

Какой вариант предпочтительнее (со слэшом или без него) решает веб-мастер: если больше проиндексировано материала без слэша, то лучше все страницы подвести под единое правило. - Копии по ссылкам: http://site.com/index, http://site.com/index/, http://site.com/index.php, http://site.com/index.php/, а также другие похожие варианты. Одна из этих ссылок должна быть главной по умолчанию.

- Структура сайта изменилась, но сохранились старые страницы. Здесь ссылки могут не совпадать совершенно, но контент, мета-данные, товар остались таким же, как на новых. Это приводит к полному дубляжу материала.

- Ошибки, которые возникают при нарушении иерархии адреса. По примеру https://site.com/category/tovar/ и https://site.com/tover/category/. Дублируется часто полностью мета, контент, параметры.

- Страницы с utm-метками и параметрами «gclid». Метки нужны для передачи дополнительной информации в системы контекстной рекламы или статистики. Обычно они не должны индексироваться поисковиками, но бывают ситуации, когда удается встретить полный дубликат с utm-метками.

- Пагинация сайта, а также дубликаты, которые создаются фильтрами. В таких ситуациях выводится товарный ассортимент на странице «категория». При этом сам раздел меняет свой урл-адрес, но SEO-тексты, заголовки, мета-информация, весь прочий контент сохраняется. То есть происходит частичное копирование данных.

- Создание отдельных страниц для взаимодействия с блоками под комментарии, характеристики или отзывы. При выборе «оставить комментарий» или какого-либо тега с характеристиками происходит добавление параметра в адресную строку, но контент не меняется, то есть происходит частичное копирование.

- Версии для PDF-печати. Страницы для печатей копируют SEO-данные. Это приводит к снижению уникальности или даже бану. Также относятся к категории частичных дублей.

Какой вред наносят

Когда на платформе существует два идентичных макета, то системы не понимают что именно нужно выдавать по запросу, поэтому система ранжирования часто работает неправильно, а значит проект начнет со временем терять свои позиции в выдаче. Важно находить и удалять копии, а иначе можно столкнуться с рядом проблем:

Важно находить и удалять копии, а иначе можно столкнуться с рядом проблем:

- Понижение рейтинга площадки в целом, а не только его некоторых разделы.

Например, на проекте «site.com/catalog/phone» расположено большое количество товаров, вся необходимая информация, контент о них, включая мета-данные. В эту же страницу вкладывают деньги для продвижения и рекламы. По итогу она попадает в топ выдачи, а значит системы индексируют ее хорошо. Однако в какой-то момент ЦМС создает аналог «site.com/phone». Данная страница ранжируется плохо, привлекает мало пользователей, никаких действий для ее продвижения не ведется. После роботы для поиска по запросам видят, что происходит ухудшение просмотров, и значит начинают исключать из выдачи дубликат и оригинал. Роботы внимательнее относятся к остальному материалу и, если ситуация повторяется, то понижают рейтинг сервиса.

- Скачки в выдаче, так как поисковики все время меняют релевантность между одинаковыми материалами.

Это достаточно плохо для целевой. Во-первых, по ней начнут меньше переходить посетителей. Во-вторых, если вторая целевая частично дублирует материал, то на ее обнаружение уйдет больше времени, но когда ее найдут, то выяснить, какая из двух приносит больше трафика и что будет с посетителями с другой похожей страницей неясно, а значит выбрать что лучше и что нужно удалить будет сложнее. В-третьих, даже после удаления дубля, может быть так, что вернуть прежние показатели будет невозможно или очень трудно.

Во-первых, по ней начнут меньше переходить посетителей. Во-вторых, если вторая целевая частично дублирует материал, то на ее обнаружение уйдет больше времени, но когда ее найдут, то выяснить, какая из двух приносит больше трафика и что будет с посетителями с другой похожей страницей неясно, а значит выбрать что лучше и что нужно удалить будет сложнее. В-третьих, даже после удаления дубля, может быть так, что вернуть прежние показатели будет невозможно или очень трудно.

- Снижение уникальности работ на площадке.

Большинство маркетологов, контентщиков, аналитиков знает, что чем ниже уникальность работ, тем неохотнее системы выдают платформу в выдаче по запросам. При этом те ресурсы, которые предоставляют уникальную информацию и контент по ключевым словам почти всегда попадают в первые строки выдачи.

- Снижение позиций ключевых слов или фраз.

Похожая система со снижением уникальности. Ключевые слова и фразы просто перестают восприниматься поисковыми системами, так как материал с одинаковыми ключевиками встречаются на большом количестве страниц и внедрены они в неуникальный текст.

- Увеличение времени на индексацию.

На сканирование каждого ресурса у поисковых роботов есть краулинговый бюджет. Если дубликатов много, то робот может просто не добраться до нужной страницы. Такая проблема очень велика для крупных интернет-магазинов и холдингов, у которых тысячи или десятки тысяч разделов с похожим материалов, товарами или разделами.

- Бан от поисковых систем.

Здесь стоит отметить, что копии — это не повод наложения санкций со стороны поисковиков, но вот их большое количество воспринимается последними как намеренное решение, чтобы увеличить количество позиций в выдаче.

- Проблемы для веб-мастера.

Чем дольше откладывается работа по нахождению и устранению дублей, тем больше их накопится, а риск негативных последствий для ресурса также растет.

Стоит отметить, что полные копии с точки зрения SEO несут критическую и резкую опасность. Роботы воспринимают их враждебно, при этом не имеет значения, какой запрос был задан. Они вызывают потерю по ранжированию или даже наложению фильтра пессимизирующего всю площадку.

Они вызывают потерю по ранжированию или даже наложению фильтра пессимизирующего всю площадку.

Частичные дубликаты не приводят к полной потери ранжирования резко или заметно для менеджеров, но делают это поступательно медленно, так, что владелец ресурса может этого до определенного момента даже не замечать. Это говорит о том, что найти их сложнее, а вред от них даже куда выше, чем от полных дублей.

Как найти дубли

Существует несколько способов обнаружения дублей. Чаще всего для этих целей используют:

- Мониторинг сайта через оператора «site». Часто используют для анализа проектов конкурентов. Чтобы проверить дубли страниц на сайте и провести анализа своей платформы онлайн в поисковой строке нужно ввести команду «site:site.com/catalog». Здесь можно увидеть перечень адресов всего проекта, включая те, которые дублируются. Также, если нужно проверить дубляж определенных страниц, для этого стоит в поисковой строке в ссылке добавить нужный запрос и проверить нет ли одинакового материала.

Например, «site:site.com/catalog/белый телефон».

Например, «site:site.com/catalog/белый телефон». - Программы-парсеры: Screaming Frog, Xenu, PromoPult. Например, для работы с программой Screaming Frog вбивают ссылку, которая ведет на сайт, после запускают сканирование, где приложение собирает информацию о площадке. После запускают вкладку «Page Title→Duplicate» и происходит вывод страниц, которые нужно проанализировать вручную.

- Онлайн-платформы. Чтобы провести поиск дублей страниц сайта онлайн, можно использовать ApollonGuru. Работа с этим сервисом крайне простая, даже интуитивно понятная. В поле «Поиск дублей» вносят ссылки тех разделов, которые надо проверить. Сервис проводит анализ и выдает результат. Если напротив ссылки появляется значение «200», то их нужно брать в работу, так как они имеют полный или частичный скопированный материал.

- Google Webmaster: «Вид в поиске» → «Оптимизация HTML» или Google Webmaster: «Сканирование» → «Оптимизация HTML». Здесь инструменты помогают найти целевые с одинаковым Title и Description.

Для работы с Вебмастером нужно указать ссылку сайта, открыть раздел «Вид в поиске» и выбрать «Оптимизация HTML». Инструмент «Параметры URL» позволяет задать параметры, которые нужно индексировать, сканировать. После анализа платформы, нужно выявить копии, а после заняться удалением.

Для работы с Вебмастером нужно указать ссылку сайта, открыть раздел «Вид в поиске» и выбрать «Оптимизация HTML». Инструмент «Параметры URL» позволяет задать параметры, которые нужно индексировать, сканировать. После анализа платформы, нужно выявить копии, а после заняться удалением. - Яндекс.Вебмастер: «Индексирование» → «Страницы в поиске». Вебмастер от Яндекса работает похожим образом. Программа предоставляет также функции индексирования, сканирования проекта или отдельных макетов.

- Ручной поиск. Опытные веб-мастера способны уже предположить, где могут быть дубли, а также выявить большинство из них вручную. При этом они могут использовать дополнительные приложения, самописные программы и многое другое.

Как убрать дубли

Можно бороться с дублирующим материалом разными способами. Самыми популярными остаются те, которые вызывают большинство дубликатов: настройка 301 редирект, создание канонической страницы, директива Disallow в robots.txt.

301 редирект

Неплохое решение для случаев с рефф-метками и ошибками в иерархии адресов.

Если же CMS позволяет, то редиректы можно настраивать вручную даже без помощи программиста, например, UMI предоставляет такую возможность. Однако большинство площадок требуют вмешательства программиста с опытом работы в этой сфере.

Настраивают 301 редирект в файле htaccess. Например, для отдельной страницы используют: Redirect 301 %old_url% %new_url%

%old_url% — это старая ссылка страницы без домена

%new_url% — это новый адрес, где указывают домен.

При этом нужно запомнить, что поисковые системы не удаляют из индексации страницу, с которой происходит редирект, но и не добавляют в индекс страницу, которая получила редирект.

Каноническая страница

Использовать тег «rel-canonical» стоит. Он дает поисковикам понять, что перед ней именно та каноническая страница, которую нужно обрабатывать и выдавать.

Чтобы дать понять, что перед поисковиком такая страница, нужно на все копии добавить тег с ссылкой оригинальной страницы:

<link rel= “canonical” href= “http://www. site.com/original-page.html”>

site.com/original-page.html”>

Этот тег хорошо понимают машины. Кроме того, важно помнить, что добавлять такие теги можно и на посадочные страницы, которые являются основными для сайта с точки зрения SEO.

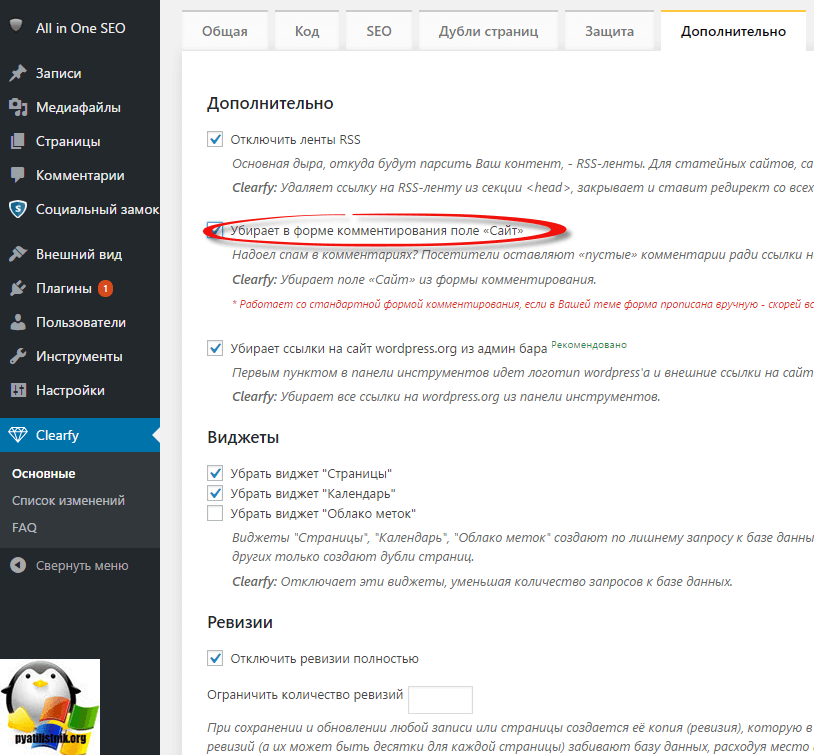

Чтобы на всех страницах прописать каноничность, то стоит использовать плагины. Например, для WordPress используют YoastSEO или AllinOneSEOPack.

С Bitrix ситуация сложнее. Для этой CMS нужно использовать язык программирования PHP в соответствующих файлах.

Директива Disallow в robots.txt.

Используют для борьбы со служебными страницами, которые частично или полностью дублируют контент посадочных. Часто сюда попадают адреса со слэшами и другими частями URL-адресов, которые создают копии.

Работает это следующим образом: Если на сайте есть копии, можно запретить их индексировать с помощью условия Disallow, который вписывают в файл «robots.txt». Например, в robots.txt прописать «Disallow:/tovar/whitephone/», после этого роботы поисковых систем не будут индексировать раздел с таким адресом.

Советы вместо заключения

- Старайтесь всегда создавать уникальный URL-адрес для каждой целевой.

- Указывайте, какая из страниц пагинации, фильтрации является целевой и рекламируйте ее.

- Выявляйте, какая из целевых приносит больше трафика, делайте ее главной, а копию или копии удаляйте.

- Если нет опыта поиска дубликатов и разбираться в том, как убрать дубли страниц на сайте нет времени, то можно нанять на работу сотрудников, которые разбираются в сфере, а значит смогут сделают работу за вас.

Хотите тоже написать статью для читателей Yagla? Если вам есть что рассказать про маркетинг, аналитику, бизнес, управление, карьеру для новичков, маркетологов и предпринимателей. Тогда заведите себе блог на Yagla прямо сейчас и пишите статьи. Это бесплатно и просто

Как найти и удалить дубли страниц на сайте

Здравствуйте!

Если Ваш сайт очень медленно растёт в поисковых системах, делает один шаг вперёд, а затем два назад, при постоянном изменении позиций, то одной из причин такой нестабильности могут быть дубли страниц на сайте. Это когда, страницы имеют разные адреса (url), но при этом содержат один и тот же контент, полностью или частично.

Это когда, страницы имеют разные адреса (url), но при этом содержат один и тот же контент, полностью или частично.

Чтобы вернуть сайту стабильность и поднять в ТОП, необходимо найти и удалить дубли страниц. О том, как это сделать, мы расскажем в сегодняшней публикации.

Чем опасны дубли страниц на сайте?

Но для лучшего понимания, зачем находить и удалять дубли страниц, мы расскажем о том, как вред может нанести сайту дублированный контент из-за которого и так снижается доверие поисковых систем к сайту:

- Некорректная индексации. Допустим, у Вас большой новостной портал, на котором ежедневно публикуются по 10 новостей и статей. Если для каждой страницы будет существовать хотя бы один дубль, то объём сайта вырасти вдвое, а значит и поисковикам придётся больше времени тратить на обход ресурса. А если таких дублей 4-5? Поисковая система будет удалять дубли страниц из поиска и занижать позиции сайта.

- Неправильное определение веса страниц.

С помощью внутренней оптимизации сайта, без применения внешней, можно добиться значительных результатов, в том числе за счёт правильно поставленных внутренних ссылок, которые передают вес нужной странице, с товаром или услугой, или продвигаемой по ВЧ-запросам. Соответственно при наличии дублей страниц, передаваемый рейтинг будет распыляться, а значимость страницы для ПС будет падать.

С помощью внутренней оптимизации сайта, без применения внешней, можно добиться значительных результатов, в том числе за счёт правильно поставленных внутренних ссылок, которые передают вес нужной странице, с товаром или услугой, или продвигаемой по ВЧ-запросам. Соответственно при наличии дублей страниц, передаваемый рейтинг будет распыляться, а значимость страницы для ПС будет падать. - Показ в результатах поиска нерелевантной страницы. Так же одной из проблем, которой грозят дубли страниц является показ в результатах поиска нерелевантной страницы (например, вместо страницы услуги, показывается прайс, где эта услуга упоминается).

Таким образом, все усилия приложенные на продвижение определённой страницы (сюда относятся, как внешние, так и внутренние ссылки), пойдут к коту под хвост. Кроме того, в последствии поисковая система может ещё больше занизить рейтинг страницы, так как она нерелевантна запросу. - Потеря естественных ссылок. Пользователь, который был на Вашем сайте и захотел поделиться ссылкой на его страницу, может как раз поделиться ссылкой на дубль, а не на ту, которую нужно.

В итоге, такие ценные для SEO-продвижения естественные ссылки будут вести на дубликаты, которые не индексируются.

В итоге, такие ценные для SEO-продвижения естественные ссылки будут вести на дубликаты, которые не индексируются.

Дубли могут быть полными (одна и та же страница, доступ по разным адресам) и частичными (фрагмент контента одной страницы дублируется на других).

Проверка сайта на дубли страниц

Ну, что? Убедились во вредности дубликатов страниц? Значит пора проверить свой сайт на дубли страниц! Есть несколько стандартных процедур, которые помогут выявить дубли страниц.

1. Search Console.

Или Google Webmaster. Это один из самых лёгких способов, для поиска дублей страниц. Заходим в сервис, далее идём в раздел «Вид в поиске» и выбираем вкладку «Оптимизация HTML».

Здесь нам необходимо обратить внимание на следующие строчки:

- «Повторяющееся метаописание» — страницы с одинаковыми описаниями Description;

- «Повторяющиеся заголовки (теги title)» — список страниц с одинаковыми Title.

Данный подход выявления дублей основывается на том, что страницах может совпадать не только содержание, но и мета-данные. Просмотрев страницы, которые показываются в данном отчёте, мы довольно-таки просто обнаружим страницы, которые являются дубликатами.

2. Яндекс Вебмастер.

Периодически Яндекс индексирует новые страницы сайта или какие-то удаляет. Эта информация отражается, как на главной странице сервиса, так и в разделе «Индексирование» — «Страницы в поиске». Зайдите туда прямо сейчас.

Рядом с удалёнными из поисковой выдачи страницами (они выделены синим), есть комментарий, говорящий о причине исключения. Одним из возможных вариантов является «Дубль».

В данном случае это страница категории, которая содержит часть контента из постов в виде анонсов. Поэтому поисковая система считает её дублем.

3. Просмотр поисковой выдачи.

Промониторьте выдачу, используя специальный оператор «site:».

Довольно часто причиной возникновения дублей страниц становятся несовершенства систем управлений сайтом (CMS). Например, WordPress грешен тем, что может автоматически генерировать дубли страниц или в рубриках публиковать анонсы с частичным содержанием текста из самой статьи.

Например, WordPress грешен тем, что может автоматически генерировать дубли страниц или в рубриках публиковать анонсы с частичным содержанием текста из самой статьи.

Также причины дубликатов могут быть в присутствующих на сайте версиях для печати или ускоренных страниц (AMP), пагинация, страницы с utm-метками, динамические урлы, страницы тегов, не добавленные описания товаров в интернет-магазине, не прописанные мета-теги.

Как удалить дубли страниц на сайте?

- Если на сайте, есть две страницы, у которых совпадают мета-теги, но при этом разное содержание — нужно просто изменить мета-описание.

- Закрыть от индексации рубрики, категории и страницы тегов, с помощью параметра Disallow в robots.txt. Либо, если не хотите терять возможный трафик, который могут принести эти разделы сайта, придумайте способ их уникализировать. Например, сделать так, чтобы вместо анонса отображался только заголовок, который является ссылкой на статью.

- Для ускоренных страниц, страниц с utm-метками и версий для печати задайте в настройках канонический URL.

- Действительно есть две одинаковые страницы — удалите одну из них (ту, что не ранжируется поисковыми системами например).

- Настройте 301-редирект для удалённых страниц, чтобы заходя по старому адресу на сайт, пользователь не попал на 404-ую страницу.

что это, как влияет на SEO и как удалить из поисковой выдачи

Дублями называются веб-страницы, содержимое которых частично либо полностью совпадает. Дублирование приводит к тому, что сайт начинает терять трафик. Сегодня расскажем о том, как с этим бороться.

Как и почему дубли веб-страниц затрудняют SEO

Из-за дублирования поисковые системы не могут определить, какую именно из страниц, которые соответствуют релевантным запросам, необходимо показывать в выдаче. В результате поисковики снижают позиции сайта в ранжировании либо вообще банят его. По этой причине SEO-специалисты рекомендуют проверять продвигаемые ресурсы на наличие дубликатов.

Вопрос о том, почему дубли осложняют продвижение, можно рассмотреть на простом примере. На картинке ниже изображены три яблока.

На картинке ниже изображены три яблока.

Яблоки на картинке ничем не отличаются. Все они соответствуют запросу «красное яблоко», и выбрать фрукт, который больше других подходит под это определение, очень сложно.

С такими же затруднениями сталкиваются поисковые системы, если на сайте есть несколько частично похожих или полностью идентичных страниц.

Из-за наличия страниц-дубликатов возникают следующие проблемы:

- Снижение релевантности основной продвигаемой страницы и ее позиций по ключевым словам.

- Изменение страницы поисковыми системами для показа в выдаче, что также приводит к нестабильности позиций по ключевым словам.

- При наличии большого количества дублей — попадание под фильтры «Яндекса» и Google.

Виды дублей

Дубли бывают полные и частичные.

Полный дубль — страница, которую поисковые системы находят по разным адресам.

Причины появления полностью идентичных страниц:

- Отсутствие главного зеркала. Это одна из наиболее распространенных причин. Если разработчики забывают указать главное зеркало, то сайт может выходить в поиске в нескольких вариантах — с www и без него, с http и c https.

- Особенности CMS или действия разработчика. Например, главная страница может быть доступна со слешем в конце и без него, с добавлением слов start, php и т.д.

- Попадание в индекс страниц с динамичными адресами. Как правило, это происходит, если используются фильтры для сортировки и сравнения различных товаров.

-

Самогенерация дублей некоторыми движками — WordPress, Joomla, OpenCart, MODX. Например, в Joomla часть страниц автоматически отображается с разными URL —mysite.ru/catalog/25 и mysite.

ru/catalog/25-article.html и т.п.

ru/catalog/25-article.html и т.п. - Отслеживание сессий с помощью специальных идентификаторов, которые также могут индексироваться и создавать дубли.

- Добавление к адресам страниц UTM-меток. Они используются, чтобы отслеживать, насколько эффективно проходят рекламные кампании. Теоретически страницы с UTM-метками не должны индексироваться, но на практике они часто встречаются в выдаче.

Полные дубли легко обнаружить и удалить, в отличие от частичных.

Подпишитесь на нас в Telegram

Получайте свежие статьи об интернет-маркетинге и актуальные новости о наших готовых решениях

Рассмотрим причины, по которым появляются частичные дубли.

Пагинация страниц

С помощью пагинации можно упростить навигацию по сайту и одновременно осложнить продвижение.

Каждая страница пагинации представляет собой дубликат, часто — с такими же метаданными и SEO-текстом.

Например, адрес главной страницы — https://mysite.ru/women/clothes. При этом страница пагинации выглядит так: https://mysite.ru/women/clothes/?page=2. В результате появляются две страницы с разными адресами и практически одинаковым содержимым.

Блоки новостей, топовых статей и комментариев

Чтобы посетители как можно дольше оставался на сайте, ему предлагаются последние новости, популярные статьи и интересные комментарии. Их заголовки с частью содержимого обычно размещаются справа, слева или снизу от основного материала. Эти фрагменты не должны индексироваться, иначе поисковик обнаружит разные страницы с одинаковым контентом.

Как видно на картинке, внизу главной страницы находится три блока с новостями, последними статьями и новыми отзывами. Их текстовое содержимое можно найти в соответствующих разделах. При этом контент повторяется на главной странице, из-за чего создаются частичные дубли.

Наличие версий страниц для печати

Часть страниц сайта доступна в двух вариантах — обычном и для печати. Вторая версия отличается от основной адресом. Кроме того, в ее коде отсутствуют многие строки, поскольку странице для печати не требуется значительная часть функционала.

Чтобы понять разницу, можно сравнить адреса обычной страницы и версии для печати: https://my-site.ru/page и https://my-site.ru/page?print.

Применение технологии AJAX

Иногда на сайтах, при создании которых использовалась технология AJAX, появляются HTML-слепки. Они не представляют опасности для продвижения, если AJAX-страницы индексируются правильно. В противном случае поисковые боты выходят не на основную страницу, а на слепок. В результате одна страница индексируется по двум адресам — главному и HTML-слепка.

Чтобы найти слепок, нужно в основном адресе заменить «!#» на код «?_escaped_fragment_=».

Опасность частичных дублей заключается в том, что они не приводят к одномоментной значительной потере позиций, а незаметно ухудшают продвижение сайта.

Как искать дубликаты веб-страниц

Выявлять дубли можно вручную или с помощью специализированных программ или онлайн-сервисов.

Ручной способ

Найти дубликаты можно с помощью команды site. Ее нужно вставить в адресную строку и после нее ввести домен и часть текстового содержимого, чтобы Google выдал все существующие варианты.

Как видно на картинке, после команды site в адресную строку было введено первое предложение статьи. Поисковая система обнаружила, что основная страница с текстовым содержимым частично дублируется на главной.

Применение специализированных программ

Искать дубликаты можно с помощью различных программ, например, Xenu. Это бесплатный сервис. Еще одна программа — Screaming Frog. Ее стоимость составляет 149 фунтов в год. Также разработчики предлагают ограниченную бесплатную версию, функционала которой достаточно для решения большинства задач.

Это бесплатный сервис. Еще одна программа — Screaming Frog. Ее стоимость составляет 149 фунтов в год. Также разработчики предлагают ограниченную бесплатную версию, функционала которой достаточно для решения большинства задач.

Применение Google Search Console и «Яндекс.Вебмастер»

Чтобы найти дубли с помощью Google Search Console, нужно проверить «Предупреждения» и «Покрытие». Там содержится информация о страницах, которые Google считает проблемными.

В «Яндекс.Вебмастере» данные о дублях находятся в разделе «Индексирование», где нужно зайти в «Страницы в поиске» и спуститься вниз. Далее следует выбрать справа формат файла — CSV либо XLS, скачать его и открыть документ. Все дубли в строке «Статус» должны быть помечены как DUPLICATE.

Как удалить дубли страниц

Рассмотрим способы удаления дубликатов.

С помощью noindex и nofollow

Проще всего закрыть страницу от индексации. Для этого метатег <meta name=”robots” content=”noindex,nofollow”/> нужно поставить в шапку между открывающим тегом <head> и закрывающим </head>. После этого поисковые системы перестанут индексировать страницу и учитывать те ссылки, которые на ней находятся.

Для этого метатег <meta name=”robots” content=”noindex,nofollow”/> нужно поставить в шапку между открывающим тегом <head> и закрывающим </head>. После этого поисковые системы перестанут индексировать страницу и учитывать те ссылки, которые на ней находятся.

Важно: при использовании метатега нельзя запрещать индексацию через robots.txt.

С помощью robots.txt

Индексацию дубликатов можно запретить в robots.txt через директиву Disallow. Для этого в файл нужно добавить такой код:

User-agent: *

Disallow: /dublictate.html

Host: mysite.ru

Запрет индексации через robots.txt часто используется для служебных страниц.

Такой способ становится альтернативным решением, если запрет через Disallow не работает.

С помощью canonical

Этот метатег сообщает поисковым роботам, что перед ними находится дубликат, а также указывает им на основную страницу. Сanonical нужно поместить между тегами <head> и </head>: <link rel=”canonical” href=”адрес основной страницы” />.

Сanonical нужно поместить между тегами <head> и </head>: <link rel=”canonical” href=”адрес основной страницы” />.

Как удалить дубли со страниц с пагинацией

Для сайтов с многостраничными каталогами типична ситуация, когда на второй и следующих за ней страницах появляются дубли.

Так выглядит первая страница каталога.

На второй и следующих за ней страницах дублируется текст и теги <title> и <description>.

SEO-специалист должен сделать так, чтобы текст отображался только на первой странице. Кроме того, нужно убрать дубли <title> и <description>. У каждой страницы должны быть уникальные теги. Также необходимо убедиться, что в адресах страниц пагинации отсутствуют динамические параметры.

Понимание того, что такое дубли страниц и как их устранить, поможет избежать попадания в индекс копий, которые осложняют продвижение сайта.

Поиск и удаление дубликатов и почти дубликатов страниц PDF

Поиск и удаление дубликатов страниц PDF

- Введение

- В этом руководстве показано, как найти и при необходимости удалить похожие или повторяющиеся страницы в одном документе PDF с помощью подключаемый модуль AutoSplit™ для Adobe® Acrobat®. Эта операция обнаруживает похожие страницы и представляет их пользователю для просмотра. Пользователь может просмотреть результаты и выбрать/отменить выбор отдельных страниц из списка дубликатов для возможного удаление или извлечение. Вы можете выполнять следующие операции:

- Поиск дубликатов и почти дубликатов

- Добавление дубликатов страниц в закладки

- Извлечь дубликаты страниц в отдельный документ PDF

- Удалить дубликаты страниц из документа

- Сохранить отчет о сходстве страниц

- Подключаемый модуль предоставляет два разных метода обнаружения дубликатов или почти дубликатов страниц:

- Сравнить только текст страницы

- Используйте этот метод для сравнения текста страницы независимо от его внешнего вида.

Он вычисляет сходство страниц

на основе текстового содержимого только и полностью игнорирует внешний вид текста, макет, изображения и графику

которые могут присутствовать на странице. Это лучший метод обнаружения дубликатов в большинстве типов документов.

Он вычисляет сходство страниц

на основе текстового содержимого только и полностью игнорирует внешний вид текста, макет, изображения и графику

которые могут присутствовать на странице. Это лучший метод обнаружения дубликатов в большинстве типов документов. - Сравните внешний вид страниц

- Этот метод сравнивает страницы «как изображения» и обнаруживает страницы, которые выглядят совершенно одинаково. Этот метод не сравнивает невидимый текст, который может присутствовать на странице. Не рекомендуется использовать этот метод для отсканированных бумажных документов.

- Использование отсканированных бумажных документов

- Довольно часто эта операция используется для поиска дубликатов страниц в отсканированных бумажных документах.

Отсканированные документы необходимо подвергнуть распознаванию, прежде чем использовать их для какой-либо текстовой обработки.

OCR — это процесс распознавания текста в отсканированных документах и обеспечения возможности поиска по ним.

Важно понимать, что распознавание текста в отсканированных документах подвержено ошибкам и

это редко бывает на 100% точным. Количество ошибок зависит от разрешения сканирования и качества исходного документа.

В большинстве случаев отсканированная страница может содержать от 1 до 10 ошибок распознавания, где некоторые буквы

неправильно идентифицирован. Например, в зависимости от шрифта строчная буква l может выглядеть точно так же, как цифра 1.

. Заглавная буква O часто ошибочно принимается за цифру 0, заглавная буква S — за цифру 5 и т. д.

Поскольку многие буквенно-цифровые символы имеют схожие или идентичные физические характеристики, часто возникает необходимость их различения.

Отсканированные документы необходимо подвергнуть распознаванию, прежде чем использовать их для какой-либо текстовой обработки.

OCR — это процесс распознавания текста в отсканированных документах и обеспечения возможности поиска по ним.

Важно понимать, что распознавание текста в отсканированных документах подвержено ошибкам и

это редко бывает на 100% точным. Количество ошибок зависит от разрешения сканирования и качества исходного документа.

В большинстве случаев отсканированная страница может содержать от 1 до 10 ошибок распознавания, где некоторые буквы

неправильно идентифицирован. Например, в зависимости от шрифта строчная буква l может выглядеть точно так же, как цифра 1.

. Заглавная буква O часто ошибочно принимается за цифру 0, заглавная буква S — за цифру 5 и т. д.

Поскольку многие буквенно-цифровые символы имеют схожие или идентичные физические характеристики, часто возникает необходимость их различения. вызов. Вот почему сравнение на основе подобия полезно для обнаружения небольших различий между страницами, которые

производится в процессе распознавания текста. Отсканированные документы низкого качества могут содержать большое количество ошибок, делающих их

непригоден для любого надежного текстового сравнения. См. следующий учебник о том, как распознавать отсканированные документы.

и оценивает их пригодность для текстовой обработки. .

вызов. Вот почему сравнение на основе подобия полезно для обнаружения небольших различий между страницами, которые

производится в процессе распознавания текста. Отсканированные документы низкого качества могут содержать большое количество ошибок, делающих их

непригоден для любого надежного текстового сравнения. См. следующий учебник о том, как распознавать отсканированные документы.

и оценивает их пригодность для текстовой обработки. . - Предпосылки

- Для использования этого руководства вам потребуется копия Adobe® Acrobat® вместе с подключаемым модулем AutoSplit™, установленным на вашем компьютере. Вы можете загрузить пробные версии как Adobe® Acrobat®, так и подключаемого модуля AutoSplit™.

- Содержимое

- Сравнение только текста страницы

- Сравнить только внешний вид

- Сравнение нескольких документов

- Метод 1 — сравнение только текста страницы ↑обзор

- Этот метод сравнивает сходство страниц только на основе содержимого их страниц.

Внешний вид, положение и порядок текста не имеют значения. Этот метод также игнорирует любые изображения и графику, присутствующие на страницах.

Метрика подобия модифицированного косинуса используется для расчета того, как

похожи две страницы на основе их текстового содержания.

Внешний вид, положение и порядок текста не имеют значения. Этот метод также игнорирует любые изображения и графику, присутствующие на страницах.

Метрика подобия модифицированного косинуса используется для расчета того, как

похожи две страницы на основе их текстового содержания. - Шаг 1. Откройте файл PDF

- Запустите приложение Adobe® Acrobat® и откройте файл PDF с помощью меню «Файл > Открыть…».

- Шаг 2. Откройте диалоговое окно «Поиск повторяющихся страниц»

- Выберите «Подключаемые модули > Разделить документы > Найти и удалить повторяющиеся страницы…», чтобы открыть диалоговое окно «Найти повторяющиеся страницы».

- Шаг 3. Укажите параметры

- Установите флажок «Сравнять только текст страницы (игнорировать внешний вид страниц)».

- Использование предопределенных настроек

- Текстовый метод предоставляет ряд предопределенных наборов параметров, которые подходят для сравнения разных типов документов с разным количеством ошибок распознавания.

Каждый предопределенный набор параметров обеспечивает различные условия для расчета подобия:

Каждый предопределенный набор параметров обеспечивает различные условия для расчета подобия: - Пользовательские настройки — все настройки задаются пользователем

- Отсканированный бумажный документ: высокое качество

- Отсканированный бумажный документ: среднее качество

- Факс: низкое качество

- Несканированный PDF: точное совпадение

- Неотсканированный PDF: нечеткое совпадение

- Точное совпадение (с порядком текста) — этот метод не использует косинусное сходство

- Настройки появляются под меню после выбора предопределенного набора параметров.

- Вот настройки, используемые предопределенными наборами:

- Нажмите «Изменить…», чтобы настроить параметры сходства страниц:

- Метод сравнения текста использует 3 параметра, чтобы ограничить, насколько разными могут быть две «похожие» страницы. Варьируя эти параметры, можно обнаружить страницы, имеющие разную степень сходства.

- Минимально допустимое сходство текста страницы (в процентах) — это значение метрики косинусного сходства, выраженное в процентах. Укажите минимально допустимое сходство текста страницы от 70 до 100 (в процентах).

- Максимально допустимая разница в длине страницы (в символах).

- Максимально допустимая разница текста страницы (в словах).

- Используйте эти настройки для экспериментов с настройками обработки, когда необходимо настроить алгоритм обработки для конкретного документа.

- Использовать образцы страниц

- При необходимости нажмите «Установить из образца страницы…», чтобы указать параметры схожести страниц на основе двух образцов страниц:

- Выберите две страницы, которые можно считать идентичными. Программное обеспечение автоматически рассчитает схожесть страниц, и статистика появится в левом нижнем углу диалогового окна.

- Нажмите «ОК», чтобы сохранить текущие настройки сходства.

- Укажите параметры фильтрации текста

- Существует несколько параметров, управляющих содержимым страницы, которое анализируется алгоритмом сравнения текста. Используйте эти параметры при сравнении отсканированных бумажных документов, которые могут содержать различные ошибки распознавания текста. Эти параметры исключают определенные виды символов из обработки. Во многих случаях это может помочь вычислить более точную метрику сходства.

- Игнорировать регистр — эта опция игнорирует регистр при сравнении текста.

- Игнорировать знаки препинания (,.!?-) — эта опция исключает из сравнения все знаки препинания.

- Игнорировать небуквенно-цифровые символы — этот параметр игнорирует все символы, кроме букв и цифр.

- Нажмите «ОК», чтобы сохранить настройки сходства страниц.

- Нажмите «ОК», чтобы начать поиск дубликатов страниц в текущем PDF-документе:

- Шаг 4.

Проверка дубликатов страниц

Проверка дубликатов страниц - В диалоговом окне «Удалить повторяющиеся страницы» отображается список повторяющихся или почти повторяющихся страниц. Щелкните запись страницы, чтобы отобразить соответствующую страницу в средстве просмотра. Просмотрите страницы и выберите/отмените выбор страниц для удаления.

- При необходимости нажмите «Сохранить отчет…», чтобы создать отчет о схожести страниц в формате HTML. Или нажмите «Страницы закладок», чтобы создать закладки в PDF для выбранных дубликатов страниц.

- Плагин позволяет просматривать/сравнивать найденные дубликаты или почти дубликаты страниц. Сходство страниц (в %) и количество несовпадающие слова отображаются для каждой пары страниц. Вот примеры, рассчитанные для пары отсканированных бумажных документов:

- Обратите внимание, что внешний вид и расположение текста не влияют на результаты.

- Эти две страницы считаются идентичными, несмотря на разницу в цвете текста:

- Эти две страницы считаются идентичными, несмотря на разницу в расположении контента:

- Эти две страницы считаются на 94% похожими, несмотря на разницу в порядке текста, макете и отсутствии изображения:

- Шаг 5.

Извлечение дубликатов страниц или добавление их в закладки

Извлечение дубликатов страниц или добавление их в закладки - При необходимости используйте кнопку «Закладка страниц», чтобы добавить в закладки все отмеченные страницы. Это полезно, если вы не планируете удалять найденные дубликаты страниц из документа. Используйте флажки перед страницами, чтобы выбрать или отменить их выбор в наборе обработки.

- Используйте кнопку «Извлечь страницы…», чтобы извлечь все отмеченные страницы в отдельный документ PDF. Эта операция не удалит страницы из текущего документа.

- Используйте кнопку «Сохранить отчет…», чтобы сохранить отчет о вычислении схожести страниц в файл HTML. Он содержит сведения о сходстве страниц, показывает различия между страницами и перечисляет пропущенные слова. Это может быть очень полезно для глубокого анализа.

- Шаг 6. Удаление повторяющихся страниц

- Используйте флажки перед страницами, чтобы выбрать/отменить выбор страниц для удаления.

Нажмите кнопку «Удалить страницы» в диалоговом окне «Удалить дубликаты страниц», чтобы удалить все отмеченные страницы из текущего документа PDF:

Нажмите кнопку «Удалить страницы» в диалоговом окне «Удалить дубликаты страниц», чтобы удалить все отмеченные страницы из текущего документа PDF: - Нажмите кнопку «ОК» для подтверждения. Страницы будут удалены навсегда.

- Метод 2 — сравнение только внешнего вида ↑обзор

- Этот метод сравнивает страницы «как изображения» и обнаруживает страницы, которые выглядят совершенно одинаково. Этот метод не сравнивает невидимый текст, который может присутствовать на странице. Не рекомендуется использовать этот метод для отсканированных бумажных документов.

- Шаг 1. Откройте файл PDF

- Запустите приложение Adobe® Acrobat® и откройте файл PDF с помощью меню «Файл > Открыть…».

- Шаг 2. Откройте диалоговое окно «Поиск повторяющихся страниц»

- Выберите «Подключаемые модули > Разделить документы > Найти и удалить повторяющиеся страницы.

..», чтобы открыть диалоговое окно «Найти повторяющиеся страницы».

..», чтобы открыть диалоговое окно «Найти повторяющиеся страницы». - Шаг 3. Укажите параметры

- Установите флажок «Сравнить внешний вид для точного соответствия (можно использовать для сравнения изображений)».

- Нажмите «ОК», чтобы начать поиск дубликатов страниц.

- Шаг 4. Проверка дубликатов страниц

- В диалоговом окне «Удалить повторяющиеся страницы» отображается список повторяющихся или почти повторяющихся страниц. Щелкните запись страницы, чтобы отобразить соответствующую страницу в параллельном представлении. Просмотрите страницы и выберите/отмените выбор страниц для возможного удаления.

- При необходимости нажмите «Сохранить отчет…», чтобы создать отчет о схожести страниц в формате HTML. Или нажмите «Страницы закладок», чтобы создать закладки в PDF для выбранных дубликатов страниц.

- Этот метод основан на создании уменьшенных (пробных) копий страниц и сравнении их «как изображения».

В следующем примере показаны две идентичные страницы, которые содержат только графику и не содержат текст для поиска: .

В следующем примере показаны две идентичные страницы, которые содержат только графику и не содержат текст для поиска: . - Если страницы визуально идентичны, то программа определяет их как дубликаты:

- Эти две страницы считаются разными из-за штампа «Утверждено» на одной из страниц:

- Эти две страницы считаются идентичными по этому методу:

- В отличие от текстового метода сравнения, если цвет или стиль текста отличаются, страницы не считаются идентичными:

- Шаг 5. Удаление повторяющихся страниц

- Нажмите «Удалить страницы» в диалоговом окне «Удалить повторяющиеся страницы», чтобы продолжить.

- Нажмите кнопку «ОК», чтобы удалить страницы из текущих документов PDF. Страницы будут удалены навсегда.

- Сравнение нескольких документов PDF

- Эту операцию можно использовать для поиска и удаления дубликатов страниц из нескольких документов PDF.

Подход состоит в том, чтобы объединить один или несколько документов в один файл PDF и запустить «Найти и удалить дубликаты страниц».

операцию над результирующим файлом. По сути, это создаст один документ без каких-либо дубликатов. При желании можно извлечь все обнаруженные дубликаты страниц в отдельный PDF-документ.

Подход состоит в том, чтобы объединить один или несколько документов в один файл PDF и запустить «Найти и удалить дубликаты страниц».

операцию над результирующим файлом. По сути, это создаст один документ без каких-либо дубликатов. При желании можно извлечь все обнаруженные дубликаты страниц в отдельный PDF-документ. - Шаг 1. Объединение нескольких PDF-документов ↑обзор

- Запустите приложение Adobe® Acrobat® и выберите «Инструменты» в меню. Выберите значок «Объединить файлы» в списке инструментов.

- Нажмите «Добавить файлы…» в меню «Объединить файлы» и выберите PDF-файлы для объединения для сравнения.

- Нажмите кнопку «Объединить» в меню, чтобы объединить выбранные файлы PDF.

- Шаг 2. Найдите дубликаты страниц

- На экране появится объединенный выходной PDF-файл. Если нет, откройте объединенный файл PDF.

- Выберите «Подключаемые модули > Разделить документы > Найти и удалить повторяющиеся страницы.

..», чтобы открыть диалоговое окно «Найти повторяющиеся страницы».

..», чтобы открыть диалоговое окно «Найти повторяющиеся страницы». - Установите флажок «Сравнить внешний вид для точного соответствия (можно использовать для сравнения изображений)». Нажмите «ОК», чтобы начать поиск дубликатов страниц.

- Шаг 3. Извлечение дубликатов страниц

- В диалоговом окне «Удалить дубликаты страниц» будет показан список дубликатов или почти дубликатов страниц. Щелкните запись страницы, чтобы отобразить соответствующую страницу в средстве просмотра. Просмотрите страницы и выберите/отмените выбор страниц.

- Нажмите «Извлечь страницы…», чтобы извлечь выбранные дубликаты страниц в новый документ PDF.

- Укажите выходную папку и имя файла. Нажмите «Сохранить».

- Появится диалоговое окно, показывающее количество страниц, которые были извлечены в отдельный документ. Теперь вы сохранили все повторяющиеся страницы в отдельный файл PDF перед их удалением. Вы можете изучить эти страницы и использовать их позже, если это необходимо.

- Нажмите «ОК», чтобы закрыть диалоговое окно.

- Шаг 4. Удаление повторяющихся страниц

- Нажмите «Удалить страницы» в диалоговом окне «Удалить повторяющиеся страницы», чтобы продолжить.

- Нажмите «ОК» в диалоговом окне, чтобы удалить выбранные дубликаты страниц из текущего документа PDF.

- Выбранные повторяющиеся страницы будут навсегда удалены из документа PDF. Вам нужно будет использовать меню «Файл > Сохранить», чтобы сохранить измененный документ на диск.

- Щелкните здесь, чтобы просмотреть список всех доступных пошаговых руководств.

Удалить дубликаты страниц в PDF Online

«; ломать; case «limitationLimited»: e.innerHTML = «

Достигнуто ежедневное бесплатное использование. Go Pro или подождите 00:00:00, чтобы начать работу над другим файлом. Go Pro Now

Go Pro Now

«; ломать; случай «переподписаться»: е.innerHTML = «»; ломать; кейс «бесплатная пробная версия»: e.innerHTML = »

Начните бесплатную пробную версию

Разблокируйте функции Pro и выполняйте свою работу быстрее.

«; ломать; case «emailVerification»: e.innerHTML = «

Подтвердите свой адрес электронной почты

Возможности Smallpdf ограничены без подтвержденного адреса электронной почты

«; ломать; случай «ie11Offboard»: e.innerHTML = »

Прекращение поддержки IE11

Мы прекратили поддержку Internet Explorer. Используйте другой браузер.

«;

ломать;

случай «alipayNotSupported»:

e. innerHTML = »

innerHTML = »

Alipay больше не поддерживает

Обновите способ оплаты, чтобы продолжить использование Smallpdf Pro

«; ломать; } } }

HomeConvert & Compress

Compress PDF

PDF Converter

PDF Scanner

Split & Merge

Split PDF

Merge PDF

View & Edit

Edit PDF

PDF Reader

Number Pages

Delete PDF Pages

Rotate PDF

Convert from PDF

PDF в Word

PDF в Excel

PDF в PPT

PDF в JPG

0 Конвертировать в PDF10

Word to PDF

Excel to PDF

PPT to PDF

JPG to PDF

Sign & Security

eSign PDF

Unlock PDF

Защита PDF

Преобразование и сжатие

Сжатие PDF

Конвертер PDF3

12

PDF Scanner

Split & Merge

Split PDF

Merge PDF

View & Edit

Edit PDF

PDF Reader

Нумерация страниц

Удалить страницы PDF

Повернуть PDF

Преобразовать из PDF

1PDF для Excel

PDF до PPT

PDF в JPG

.

PDF

PDFJPG до PDF

1

PDF0003

Sign & Security

ESIGN PDF

Unlock PDF

- 111

PDF

- 1111110003

- Compress

- Преобразование

- Merge

- РЕДАКТИРОВАТЬ

- Знак

ПРЕИМУЩЕСТВА

«; ломать; } } }

Как удалить страницы PDF

by Hung Nguyen

Вы также можете прочитать эту статью на немецком, испанском, французском, индонезийском, итальянском и португальском языках.

Удалить дубликаты страниц из файла PDF онлайн бесплатно. Без водяных знаков и без регистрации!

Вы случайно объединили файлы PDF с одинаковыми страницами? Если это так, вы можете использовать инструмент Удалить страницы Smallpdf, чтобы удалить эти дубликаты страниц в одно мгновение. Этот инструмент можно использовать совершенно бесплатно — регистрация не требуется.

Этот инструмент можно использовать совершенно бесплатно — регистрация не требуется.

Как удалить дубликаты страниц в PDF онлайн бесплатно

Откройте инструмент «Удалить страницы» на нашем сайте.

Перетащите документ PDF в панель инструментов.

Наведите указатель мыши на повторяющиеся страницы и щелкните значок корзины, чтобы удалить их.

Нажмите «Применить изменения» и загрузите сохраненный файл.

Удалите дубликаты страниц из PDF-файла за один раз.

Удаление повторяющихся страниц

Масштабирование или поворот перед удалением