10 основных причин, по которым страница сайта может не находиться в индексе поисковых систем Яндекс или Google

Причина номер 1. Новая страница или новый сайт

Первая причина, это то, что поисковые роботы еще просто не нашли новую страницу вашего сайта. В зависимости от того, какой ваш сайт, переобход страниц может занимать от нескольких минут до нескольких недель.

Чтобы узнать, находится ли в индексе страница Вам необходимо воспользоваться сервисами вебмастера Яндекс или Google Search Console.

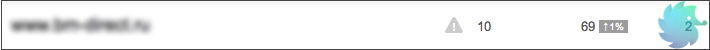

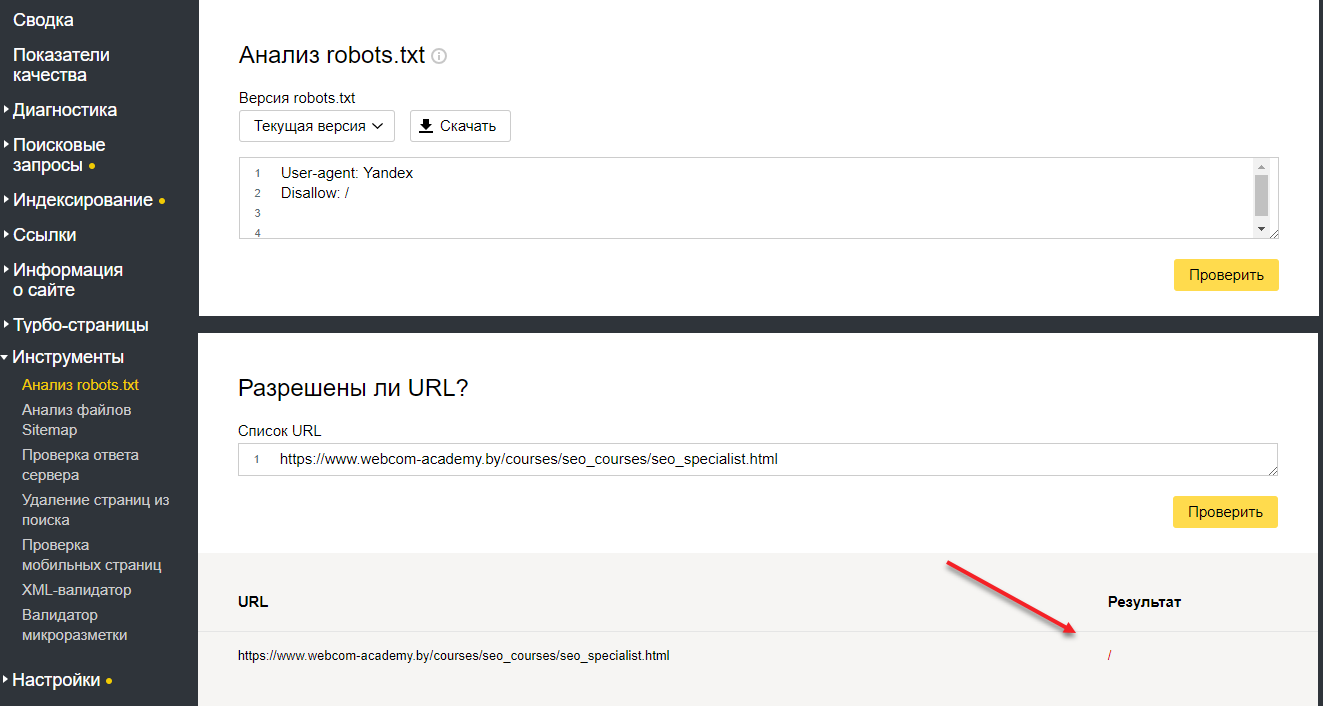

В Яндекс.Вебмастере это раздел «Индексирование» — «Проверить статус URL». Если робот обошел и проиндексировал страницу, вы увидите уведомление «Страница обходится роботом и находится в поиске».

Если робот о странице еще не знает, вы увидите сообщение «Страница неизвестна роботу».

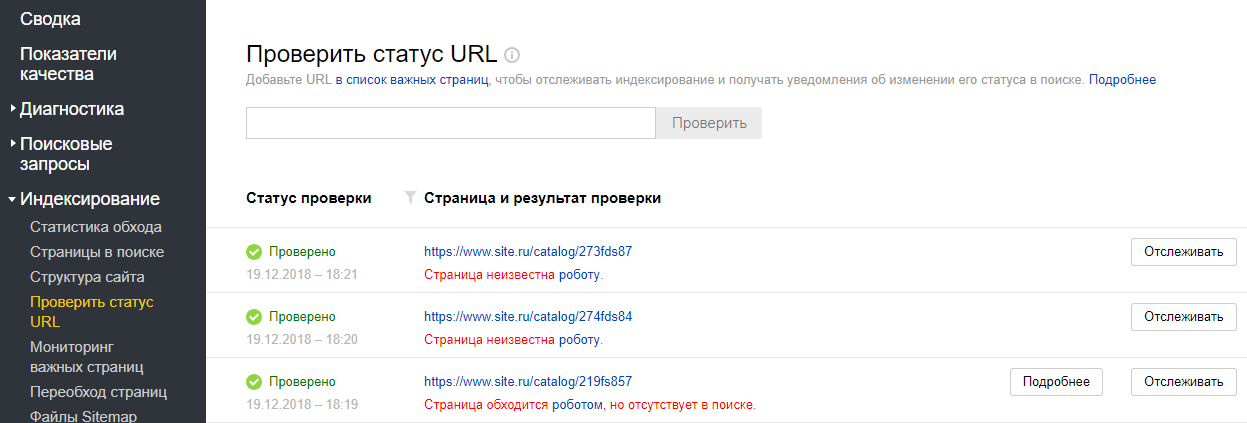

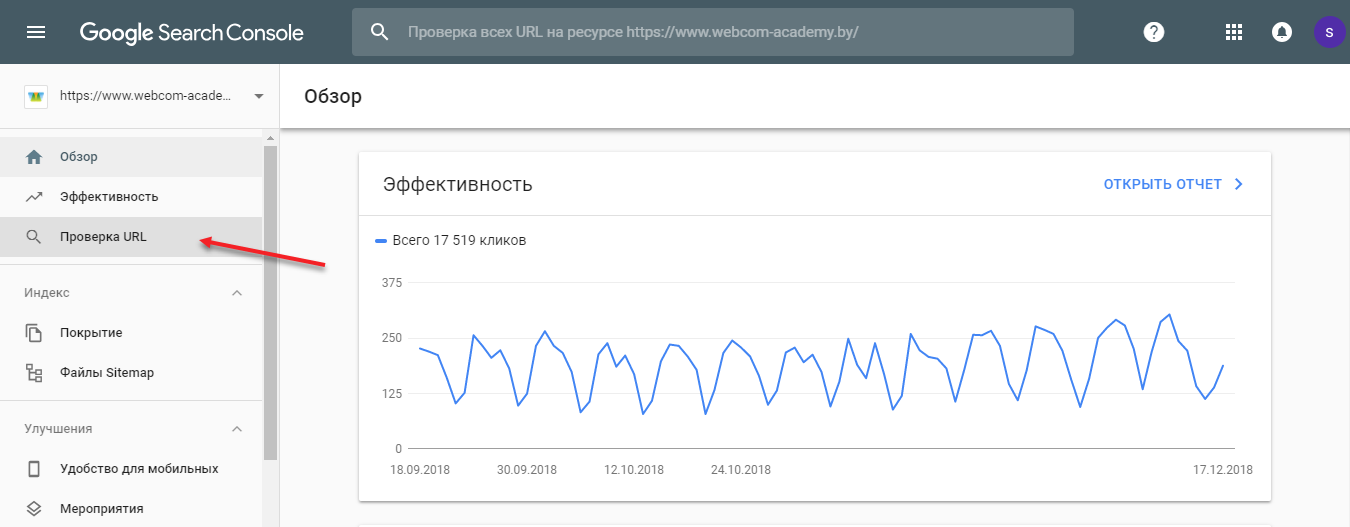

В новой версии Google Search Console вам нужен инструмент «Проверка URL». Если робот обошел и проиндексировал страницу, вы увидите уведомление «URL есть в индексе Google».

Если робот на странице еще не был, вы увидите сообщение «URL нет в индексе Google».

Причина номер 2. Страница или сайт закрыты от индексации в файле robots.txt

Существует специальный файл robots.txt, который позволяет указать роботам на то, какие страницы сайта должны быть в индексе поисковых систем, а какие страницы не должны быть включены.

Соответственно, если в файле прописаны запрещающие правила, в индексе поисковых систем данную страницу вы не найдете.

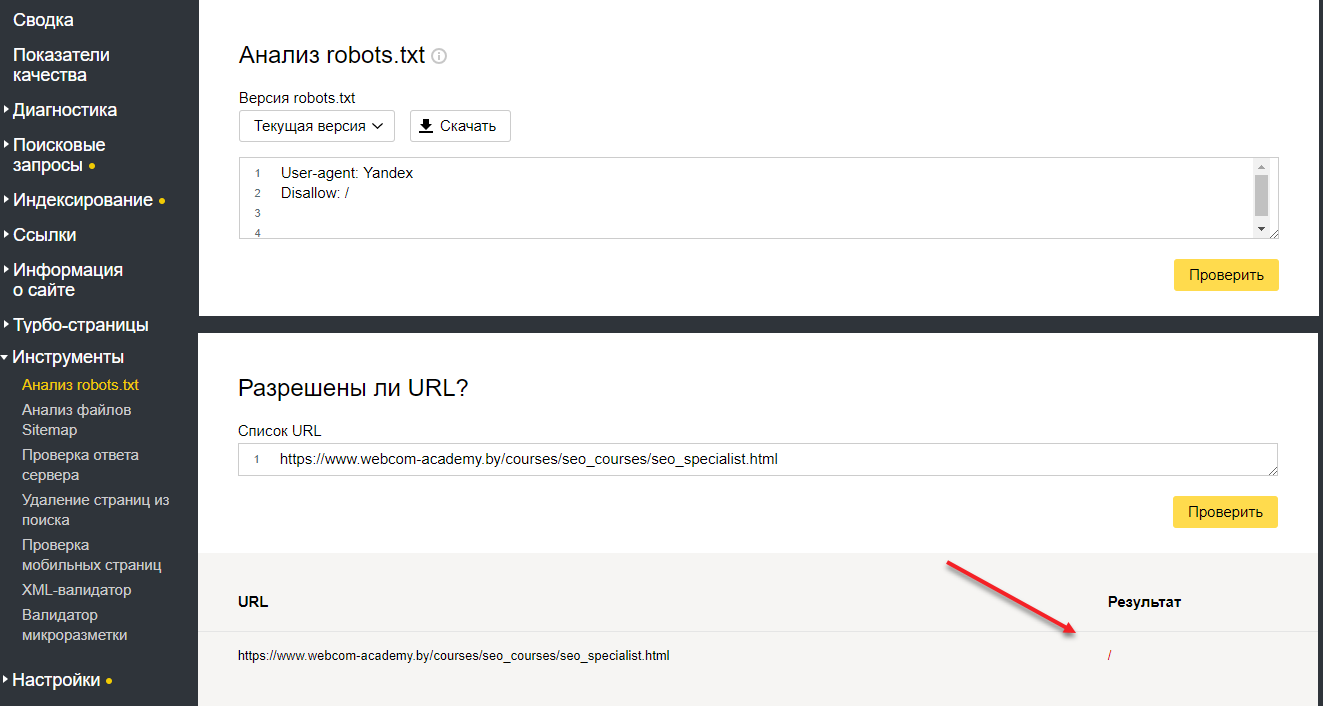

Как проверить, закрыта ли страница в robots.txt?

В Яндекс.Вебмастере: заходим в «Инструменты — Анализ файла robots.txt». В окно «Разрешены ли URL» вносим адреса страниц, которые мы хотим проверить. После того, как мы нажмем на кнопку «Проверить», внизу появится список введенных адресов и их статус: разрешены они для индексации или нет. Если нет, будет указано, какое из правил запрещает обход для робота.

В Google похожий инструмент находится на вкладке «Сканирование — Инструмент проверки файла robots.txt».

Важно! На данный момент эта вкладка находится в старой версии вебмастера!

Причина номер 3. Указан запрет в User-Agent

У поисковых систем есть свои требования к тому, как должен строиться файл robots.txt. И начинается он с приветствия. Приветствие может быть обращено к роботу яндекс, либо гугл, либо к обеим поисковым системам.

Часто для Яндекс и Google делают отдельные секции в файле robots.txt. А потом забывают вносить правки в эти секции. Из-за этого роботы потом некорректно начинают индексировать сайт.

Проверяем наличие проблемы также, как и в предыдущем случае. Главное — это делать в вебмастере Яндекс, и в вебмастере Google.

Причина номер 4. Запрет на индексацию страниц указан в мета-теге robots.

Суть этого мета-тега такая же, как и у файла robots.txt, только если страница закрыта в robots.txt она все равно может быть проиндексирована поисковыми системами. Но если на странице используется noindex или none, страница не будет добавлена в индекс.

1. Проверить использование данного мета-тега на странице можно в коде (сочетание клавиш Ctrl+U)

2. С помощью дополнения для браузера, например seo meta

3. С помощью вебмастеров.

Причина номер 5. Некорректно настроенный атрибут rel=canonical.

Каноникал — это еще один атрибут, помогающий управлять индексацией страниц.

Если rel каноникал настроен на другую страницу, то вы говорите поисковому роботу о том, что она схожа с другой станицей и первую страницу не нужно добавлять в индекс поисковых систем.

Проверить использование данного атрибута можно также в исходном коде, с помощью дополнения для браузера — rds бар или seo meta.

Также это можно увидеть в вебмастере Яндекс («Страницы в поиске»- «Исключенные страницы». Проверять необходимо статус «неканонические»).

Причина номер 6. Проблемы с ответом сервера

Для того, чтобы страница индексировалась, ее код ответа сервера должен быть 200 ОК. Если страница отдает ответ сервера 404 или 301, в индекс поисковых систем данная страница не попадет.

Проверять код ответа лучше всего с помощью вебмастеров, они показывают наиболее точные данные. А вот визуальной проверкой лучше не ограничиваться, так как бывают случаи, когда страницы выглядят корректно, но код ответа сервера не 200.

Причина номер 7. Проблемы с хостингом или сервером

Представьте, вы приходите в магазин, а он не работает. Потом снова приходите в магазин, но он все равно не работает. Какова вероятность того, что вы вернетесь туда? Вероятнее всего очень маленькая.

Тоже самое происходит и с поисковыми системами. Если он приходит на ваш сайт, а он не работает, то робот просто исключает страницы из индекса и не показывает их пользователям.

Правильно, зачем пользователей приводить на неработающий сайт.

Для того, чтобы отследить есть ли проблема, необходимо в вебмастерах проверять статус страниц. Если встречаются ошибки сервера 5хх (500, 503), а также если вам приходят уведомления из Яндекс.Метрики о том, что сайт не работает, необходимо решать данную проблему.

Причина номер 8. Проблемы со скоростью загрузки страниц

Скорость загрузки — важный показатель качества современного сайта. Если ваши страницы долго долго загружаются, роботы поисковых систем исключать такие страницы из индекса.

Кроме того, скорость загрузки страниц — является фактором ранжирования в поисковых системах. Поэтому, если у вас с этим есть проблемы, срочно это исправляйте!

Как проверить? Начните с инструмента PageSpeed Insights от Google. Дополнительно можете использовать сервисы Google Аналитика и Яндекс.Метрика.

Совет! Важно проверять скорость загрузки для нескольких типов страниц и не останавливаться выполнив только одну проверку, т.е. выполнять данные работы периодически.

Причина номер 9. Проблема с уникальностью и полезностью контента

Поисковики уделяют большое внимание качеству контента, поэтому, если на странице расположен не полезный контент, либо же дублирующийся с другими страницами, такие страницы не добавляются в индекс поисковых систем.

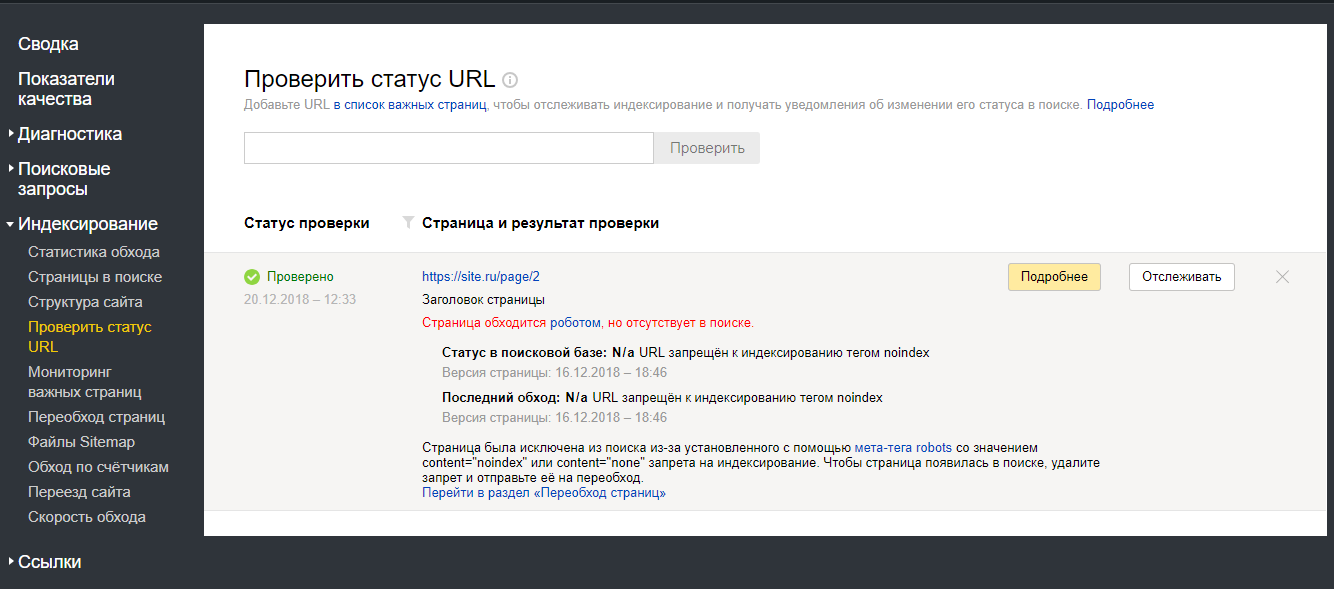

Как проверить, есть ли на сайте такие страницы — нужно зайти в вебмастер.

В Яндексе — это отчет «Страницы в поиске» — «Исключенные страницы». Проверять нужно статусы «Дубль» и «Недостаточно качественная».

В Google Search Console — это отчет «Покрытие» — «Страница является копией. Канонический вариант не выбран пользователем».

Причина номер 10. Проблемы с AJAX

Если ваш сайт выполнен на технологии AJAX очень важно правильно выполнить требования поисковых систем, для того чтобы поисковые роботы смогли проиндексировать страницы вашего сайта.

Таким образом для каждой отдельной страницы должна быть своя HTML-версия.

И напоследок, дадим вам несколько советов, как ускорить индексацию:

- отправляйте страницы на переобход с помощью вебмастеров

- используйте файл sitemap.xml

- используйте новейшие возможности, которые предоставляют вам поисковики. Например, Яндекс Метрике появилась возможность связать Яндекс Вебмастер и Яндекс Метрику, для того чтобы отправлять страницы на переиндексацию.

Также смотрите наш видеоролик https://youtu.be/HF-2dd4luQY с помощью которого вы сможете найти ошибки у себя на сайте и запланировать работы по их исправлению.

Если вы хотите продвинуть свой сайт в ТОП поисковой выдачи, тогда записывайтесь на курс по SEO-продвижению http://m.webcom.by/5tsCcgVO

«Профессиональный курс по SEO»

Начало:

Свободных

мест: 3

www.webcom-academy.by

Решение проблем индексации. Блог LeSEO.RU

Автор: Lee. 2014 год. 7 895 посещение

Всем приветик. Неожиданно для себя столкнулся с проблемой индексации страниц моего блога. Долго не заходил в ГоГетЛинкс, а когда зашел оказалось, что 4 обзора до сих пор не проиндексировано и осталось всего 14 дней. Ну я как обычно взял и прогнал эти урлы по своим твиттер аккаунтам. Это всегда помогало при проблеме с индексацией. Но в этот раз этого оказалось недостаточно. Поэтому я решил рассказать читателям о том, как я боролся за добавление позабытых страничек в индекс.

Всем приветик. Неожиданно для себя столкнулся с проблемой индексации страниц моего блога. Долго не заходил в ГоГетЛинкс, а когда зашел оказалось, что 4 обзора до сих пор не проиндексировано и осталось всего 14 дней. Ну я как обычно взял и прогнал эти урлы по своим твиттер аккаунтам. Это всегда помогало при проблеме с индексацией. Но в этот раз этого оказалось недостаточно. Поэтому я решил рассказать читателям о том, как я боролся за добавление позабытых страничек в индекс.

Сразу отмечу, что если апа не случится завтра с утра, то моя 100% индексация снизится на несколько пунктов. Уже не так красиво будет выглядеть. Но как бы то ни было…

Итак, как я боролся за свой индекс. С удивлением узнал, что в webmaster.yandex.ru добавили новый сервис «Проверить URL» Там можно проверить конкретный адрес сайта который не индексируется. Ключевой момент заключается в том, что высвечивается конкретный статус странички. Всего их пять:

- В данный момент адрес страницы неизвестен роботу — то есть робот еще ни разу не заходил на сайт

- Адрес страницы уже известен роботу, но в данный момент контент страницы ещё не проиндексирован. Это значит, что скорее всего, ваша страничка появится в индексе в следующий апдейт

- Страница была проиндексирована роботом и присутствует в поиске. Ну здесь все понятно

- Страница обходится роботом, но отсутствует в поиске. Скорее всего проблема технического плана запрет в роботсе, мета роботсе и т.п.

- Страница обходится роботом, но отсутствует в поиске, поскольку дублирует уже имеющиеся на вашем сайте страницы. А этот пункт уже указывает на то, что страничка дублирует уже имеющиеся аналоги.

Как яя уже говорил, 4 пункт это технические запреты. Здесь самое важное — отсутствие запрета на индексацию сайта. Если написать в файле robots.txt «Disallow: /», поисковые системы не будут индексировать сайт, т.к. вы запретили им это делать (disallow — запретить, / — корневой каталог). Проверьте этот файл. Если запреты отсутствуют, подумайте, нужно ли вам абсолютно все в выдаче — как правило, имеются и «мусорные» (или системные) страницы. Их лучше запретить. Также нужно проверить, нет ли у вас meta-тега robots — он тоже влияет на индексацию.

Следующий пункт — поисковик должен знать URL-адрес страницы. Уведомить поисковую систему о таком адресе можно, нужно воспользоваться страницами с добавлением адреса в очередь на индексацию (вебмастера такие страницы называют «аддурилками», от английских add и url — аддурл). Впрочем, для Яндекса лучше всего купить одну-две ссылки со страниц, уже известных поисковику. Дело в том, что аддурилка этой поисковой машины работает достаточно медленно.

Почитайте связанные посты:

Опубликовано в рубрике: Поисковые системы

leseo.ru

Основы внутренней оптимизации-индексация страниц сайта

(Последнее обновление: 15.04.2019)

Привет, дамы и господа! Определенную роль во внутренней оптимизации играют факторы, никак не связанные с контентом (назовем их неконтентными факторами). Одним из таких факторов является корректная индексация страниц сайта.

Привет, дамы и господа! Определенную роль во внутренней оптимизации играют факторы, никак не связанные с контентом (назовем их неконтентными факторами). Одним из таких факторов является корректная индексация страниц сайта.

Необходимыми (но недостаточными!) условиями для попадания страницы в индекс являются следующие:

1. значение HTTP-статуса страницы, отдаваемого индексирующему роботу поисковой машины, должно иметь значение 200 ОК;

2. отсутствие запрета на индексацию данной страницы;

3. URL страницы должен быть известен поисковой машине.

Проверить HTTP-статус страницы «глазами» индексирующего робота и отсутствие запрета на ее индексацию в файле robots.txt можно в разделе «Проверка ответа сервера» Яндекс.Вебмастера, причем эта проверка производится только для тех сайтов, права на которые подтверждены в вашем аккаунте. В Инструментах для вебмастера Google для того, чтобы проверить, доступна ли конкретная страница сайта для индексации, можно воспользоваться режимом «Посмотреть как Googlebot» в разделе «Содержимое сайта». Запретить индексацию страницы можно несколькими способами:

1. с помощью файла robots.txt

2. с помощью специальных директив в HTML-тегах в коде страницы

3. изменяя настройки инструмента «Параметры URL» в разделе «Сканирование» Инструментов для вебмастера Google.

В файле robots.txt это можно сделать с помощью директив Disallow и Clean-param. Достаточно подробную справку по правилам составления файла robots.txt можно найти в разделе «Использование robots.txt» Помощи вебмастеру Яндекса и в разделе «Блокировка URL при помощи файла robots.txt» Справки Google.

Проверить корректность файла robots.txt можно в разделе «Анализ robots.txt» кабинета вебмастера Яндекса (причем, это можно сделать для любого сайта, а не только для тех, на которые подтверждены права) и в разделе «Инструмент проверки файла robots.txt» Инструментов для вебмастера Google (только для сайтов с подтвержденными правами).

К директивам, c помощью которых можно запрещать страницу к индексации, относятся мета-тег robots и атрибут rel=»canonical» тега . Справочную информацию по их использованию можно найти на страницах Помощи Яндекса и Справки Google. Справку по работе с инструментом «Параметры URL» раздела «Сканирование» Инструментов для вебмастера Google можно найти на странице https://support.google.com/webmasters/answer/1235687?hl=ru.

Инструментов для вебмастера Google

Для того, чтобы индексирующий робот нашел данную страницу, достаточно одной ссылки на неё со станицы, которая уже есть в индексе поисковика. Также о новых страницах на сайте можно сообщать поисковой машине с помощью файла Sitemap (справочную информацию по нему можно найти в Помощи Яндекса и Справке Google).

Но даже, если робот узнает о странице и посетит ее, то еще не факт, что она попадет в индекс. Проверить, знает ли индексатор Яндекса о конкретной странице, и включена ли она в поисковую базу, можно в разделе «Проверить URL» Кабинета вебмастера Яндекса. Есть несколько вариантов ответов:

1. В данный момент адрес страницы неизвестен роботу

2. Адрес страницы уже известен роботу, но в данный момент контент страницы ещё не проиндексирован.

3. Страница была проиндексирована роботом и присутствует в поиске

4. Страница обходится роботом, но отсутствует в поиске

5. Страница обходится роботом, но отсутствует в поиске, поскольку дублирует уже имеющиеся на вашем сайте страницы.

Первый вариант ответа говорит нам о том, что, во-первых, у индексатора нет информации о том, что данная страница существует. Поэтому необходимо убедиться, что поисковый робот видит данную страницу, и она отдает ему отклик 200 указанным выше способом, а также разместить ссылку на нее на какой-либо странице, уже ранее проиндексированной поисковой машиной. Также для того, чтобы сообщить о странице индексирующему роботу, SEO-специалисты используют размещение ссылок на нее в Твиттере. Более того, до недавнего времени информирование индексатора о новой странице через Твиттер считалось SEO-специалистами наиболее быстрым и надежным способом, позволяющим обеспечить попадание страницы в поисковый индекс Яндекса буквально за считанные дни. Однако в последнее время в профессиональных дискуссиях все чаще появляются сообщения, что этот способ перестает работать. Возможно, виной тому стали промышленные способы эксплуатации данного способа «загона страниц в индекс», и Яндексом были повышены требования к характеристикам аккаунтов, информацию из которых следует учитывать при поиске новых страниц. Также первый вариант ответа может возникать в случаях, когда страница запрещена к индексации в файле robots.txt.

Однако основную проблему, связанную с индексацией, составляют варианты 4 и 5, когда индексирующий робот обходит страницу, но не включает ее в поисковый индекс. Это может быть связано, как с техническими параметрами страницы, такими как запрет к индексации с помощью мета-тега noindex или атрибута rel=»canonical» тега . Но может иметь место и классификация алгоритмом данной страницы, как не имеющей достаточно ценного содержания. В таком случае говорят, что страница попадает в «скрытый индекс». Как с этим бороться?

Во-первых, страница может быть признана полным или нечетким (частичным) дубликатом уже имеющейся в индексе страницы (вариант ответа номер 5). Такое часто случается с однотипными страницами (например, номенклатурными единицами каталога продукции), которые отличаются друг от друга лишь незначительным по удельному объему текстом. В этом случае, необходимо повышать удельную долю уникального текста на страницах – расширять индивидуальное описание и по возможности закрывать от индексации текстовые элементы, общие для всех страниц данного типа (например, пункты меню, новостную ленту, фрагменты «шапки», «подвала» и т.п.)

Во-вторых, страница может иметь недостаточное количество статического веса. Например, она имеет достаточно глубокий уровень вложенности и имеет при этом сравнительное небольшое количество внутренних ссылок. Здесь можно посоветовать оптимизировать структуру сайта, уменьшая уровень вложенности информативных страниц, и плотнее их перелинковывая друг с другом. Также можно посоветовать использовать внешние ссылки с других сайтов.

В-третьих, сам сайт может иметь достаточно низкий уровень авторитетности в глазах поисковой машины. Неуникальный контент, примитивный дизайн, слабая посещаемость, малое количество внешних входящих ссылок, с таких же малоавторитетных ресурсов, злоупотребление платными ссылками и рекламой – вот типичный портрет целевой аудитории алгоритма серии АГС (подробнее смотри в моей статье https://www.searchengines.ru/articles/sergey_lyudkevich.html), который методично отправляет целые сайты в скрытый индекс.

Резюмируя, можно отметить, что проблема индексации сайта, конечно же, является не самой сложной из проблем современного SEO. Как правило, достаточно овладеть базовым справочным материалом по теме и тщательно следовать его рекомендациям. Однако с пренебрежением относиться к данному вопросу тоже не стоит, дабы неожиданно не столкнуться с неприятностями, которые могут существенно затормозить продвижение сайта.

Автор: Сергей Людкевич — ведущий аналитик проекта «Поисковая Аналитика», cупермодератор форума о поисковых системах Searchengines.ru. Сфера профессиональных интересов — исследование алгоритмов ранжирования поисковых машин, разработка методик поискового продвижения сайтов.

Автор: Сергей Людкевич — ведущий аналитик проекта «Поисковая Аналитика», cупермодератор форума о поисковых системах Searchengines.ru. Сфера профессиональных интересов — исследование алгоритмов ранжирования поисковых машин, разработка методик поискового продвижения сайтов.

Источник: searchengines.ru

wordpressmania.ru

страница обходится роботом но отсутствует в поиске

Добрый день!

Раньше постоянно сталкивался со следующей ситуацией. Пишу новый текст, все как положено, по ключевым запросам, но при добавлении в индекс Яндекса, страница не заносится в базу данных поиска(ПС). То есть фактически происходит следующее, вставляем текст на сайт, заносим в ПС через службу вебмастер яши. Через десять минут робот яндекса проходит по странице, текст сразу влетает в индекс, но в базе ПС его нет ни на следующий день, ни через месяц.

Как проверить?

Вбиваете ключевую фразу вашего текста в ПС яндекса. Страница должна появиться в ПС в топ пятьдесять приблизительно через один день. Если его там нет, значит, и в базе ПС вашего текста тоже нет. Да и не имеет никакого смысла писать текст, чтобы он появился в ПС на сто двадцатом или двести сороковом месте.

Обычно пользователи, в большинстве своем, дальше третьей или четвертой страницы ПС не просматривают.

А как проверить, что новый текст на сайте проиндексирован и проверен роботом?

Достаточно, вбить в ПС адрес вашей страницы, который вы хотите проверить. Url сайта появился, значит ваша статья проиндексирована. А то, что в базе ПС его нет, тут уже может быть масса причин.

1. Ваша статья или содержимого текста, по мнению яндекса не является чем-то уникальным, и является копипастом или рерайтом другого текста, который уже был опубликован задолго до появления вашей статьи.

2. Возможно, вы совершили элементарные ошибки и не проставили теги title, description, keywords. Хотя по заверениям многих теги description, keywords не играют никакой роли, служба вебмастера строго требует, чтобы такие теги были всегда и в обязательном порядке.

3. Статья не отвечает на главный вопрос в ключевой фразе и посетители не задерживаются долго на вашем сайте и сразу уходят. Это уже поведенческие факторы.

4. Контент вашего сайта очень долго загружается. Посетитель не станет ждать больше одной минуты. Некоторые не станут дожидаться и тридцати секунд, сразу перейдут на другой сайт.

5. Ключевая фраза повторяется в вашем тексте более двух раз. Это больная тема и в интернете приходится жестко его придерживаться. Поэтому досконально проверьте, сколько раз повторяется ваша ключевая фраза в созданном тексте. Если словосочетание встретится более трех раз, вырастает вероятность угрозы переоптимизации. Тогда господин Платон Щукин посчитает вашу новую статью второсортным спамом, и статья вылетает из ПС, или в лучшем случае отлетит на двести какое-то место и канет в неизвестность. Что в интернете является самим нежелательным итогом всей деятельности работы над сайтом.

Что делать, если статья проиндексирована, но не попала в ПС яндекса?

Проверить вашу статью по всем пунктам, которые написаны выше. Затем уже исправленную статью придется опубликовать по-новой. Но уже по другому адресу. Это обязательное условие. Иначе, господин Щукин не станет индексировать старый адрес статьи. Или пройдет месяц другой, прежде чем это произойдет. Поэтому url-адрес исправленного текста требуется обязательно поменять. Так будет гораздо быстрее. Поскольку яндекс обожает новые адреса.

Надеюсь, статья вам помогла, и вы получили ответ на свой вопрос.

Если есть другие вопросы, пишите.

Форма для ввода комментария или вопроса есть в конце каждого текста.

baseml.ru

Основы внутренней оптимизации. Индексация страниц сайта.

В своей статье «Основы контентной оптимизации: Не навреди!» я рассмотрел основные принципы оптимизации контента страниц, которая является существенной частью внутренней оптимизации сайта. Однако, определенную роль во внутренней оптимизации играют факторы, никак не связанные с контентом (назовем их неконтентными факторами). Одним из таких факторов является корректная индексация страниц сайта.

Необходимыми (но недостаточными!) условиями для попадания страницы в индекс являются следующие:

- значение HTTP-статуса страницы, отдаваемого индексирующему роботу поисковой машины, должно иметь значение 200 ОК;

- отсутствие запрета на индексацию данной страницы;

- URL страницы должен быть известен поисковой машине.

Проверить HTTP-статус страницы «глазами» индексирующего робота и отсутствие запрета на ее индексацию в файле robots.txt можно в разделе «Проверка ответа сервера» Яндекс.Вебмастера, причем эта проверка производится только для тех сайтов, права на которые подтверждены в вашем аккаунте. В Инструментах для вебмастера Google для того, чтобы проверить, доступна ли конкретная страница сайта для индексации, можно воспользоваться режимом «Посмотреть как Googlebot» в разделе «Содержимое сайта». Запретить индексацию страницы можно несколькими способами:

- с помощью файла robots.txt

- с помощью специальных директив в HTML-тегах в коде страницы

- изменяя настройки инструмента «Параметры URL» в разделе «Сканирование» Инструментов для вебмастера Google.

В файле robots.txt это можно сделать с помощью директив Disallow и Clean-param. Достаточно подробную справку по правилам составления файла robots.txt можно найти в разделе «Использование robots.txt» Помощи вебмастеру Яндекса и в разделе «Блокировка URL при помощи файла robots.txt» Справки Google.

Проверить корректность файла robots.txt можно в разделе «Анализ robots.txt» кабинета вебмастера Яндекса (причем, это можно сделать для любого сайта, а не только для тех, на которые подтверждены права) и в разделе «Инструмент проверки файла robots.txt» Инструментов для вебмастера Google (только для сайтов с подтвержденными правами).

К директивам, c помощью которых можно запрещать страницу к индексации, относятся мета-тег robots и атрибут rel=»canonical» тега . Справочную информацию по их использованию можно найти на страницах Помощи Яндекса и Справки Google. Справку по работе с инструментом «Параметры URL» раздела «Сканирование» Инструментов для вебмастера Google можно найти на странице https://support.google.com/webmasters/answer/1235687?hl=ru.

Для того, чтобы индексирующий робот нашел данную страницу, достаточно одной ссылки на неё со станицы, которая уже есть в индексе поисковика. Также о новых страницах на сайте можно сообщать поисковой машине с помощью файла Sitemap (справочную информацию по нему можно найти в Помощи Яндекса и Справке Google).

Но даже, если робот узнает о странице и посетит ее, то еще не факт, что она попадет в индекс. Проверить, знает ли индексатор Яндекса о конкретной странице, и включена ли она в поисковую базу, можно в разделе «Проверить URL» Кабинета вебмастера Яндекса. Есть несколько вариантов ответов:

- В данный момент адрес страницы неизвестен роботу

- Адрес страницы уже известен роботу, но в данный момент контент страницы ещё не проиндексирован.

- Страница была проиндексирована роботом и присутствует в поиске

- Страница обходится роботом, но отсутствует в поиске

- Страница обходится роботом, но отсутствует в поиске, поскольку дублирует уже имеющиеся на вашем сайте страницы.

Первый вариант ответа говорит нам о том, что, во-первых, у индексатора нет информации о том, что данная страница существует. Поэтому необходимо убедиться, что поисковый робот видит данную страницу, и она отдает ему отклик 200 указанным выше способом, а также разместить ссылку на нее на какой-либо странице, уже ранее проиндексированной поисковой машиной. Также для того, чтобы сообщить о странице индексирующему роботу, SEO-специалисты используют размещение ссылок на нее в Твиттере. Более того, до недавнего времени информирование индексатора о новой странице через Твиттер считалось SEO-специалистами наиболее быстрым и надежным способом, позволяющим обеспечить попадание страницы в поисковый индекс Яндекса буквально за считанные дни. Однако в последнее время в профессиональных дискуссиях все чаще появляются сообщения, что этот способ перестает работать. Возможно, виной тому стали промышленные способы эксплуатации данного способа «загона страниц в индекс», и Яндексом были повышены требования к характеристикам аккаунтов, информацию из которых следует учитывать при поиске новых страниц. Также первый вариант ответа может возникать в случаях, когда страница запрещена к индексации в файле robots.txt.

Однако основную проблему, связанную с индексацией, составляют варианты 4 и 5, когда индексирующий робот обходит страницу, но не включает ее в поисковый индекс. Это может быть связано, как с техническими параметрами страницы, такими как запрет к индексации с помощью мета-тега noindex или атрибута rel=»canonical» тега . Но может иметь место и классификация алгоритмом данной страницы, как не имеющей достаточно ценного содержания. В таком случае говорят, что страница попадает в «скрытый индекс». Как с этим бороться?

Во-первых, страница может быть признана полным или нечетким (частичным) дубликатом уже имеющейся в индексе страницы (вариант ответа номер 5). Такое часто случается с однотипными страницами (например, номенклатурными единицами каталога продукции), которые отличаются друг от друга лишь незначительным по удельному объему текстом. В этом случае, необходимо повышать удельную долю уникального текста на страницах – расширять индивидуальное описание и по возможности закрывать от индексации текстовые элементы, общие для всех страниц данного типа (например, пункты меню, новостную ленту, фрагменты «шапки», «подвала» и т.п.)

Во-вторых, страница может иметь недостаточное количество статического веса. Например, она имеет достаточно глубокий уровень вложенности и имеет при этом сравнительное небольшое количество внутренних ссылок. Здесь можно посоветовать оптимизировать структуру сайта, уменьшая уровень вложенности информативных страниц, и плотнее их перелинковывая друг с другом. Также можно посоветовать использовать внешние ссылки с других сайтов.

В-третьих, сам сайт может иметь достаточно низкий уровень авторитетности в глазах поисковой машины. Неуникальный контент, примитивный дизайн, слабая посещаемость, малое количество внешних входящих ссылок, с таких же малоавторитетных ресурсов, злоупотребление платными ссылками и рекламой – вот типичный портрет целевой аудитории алгоритма серии АГС (подробнее смотри в моей статье http://www.searchengines.ru/articles/sergey_lyudkevich.html), который методично отправляет целые сайты в скрытый индекс.

Резюмируя, можно отметить, что проблема индексации сайта, конечно же, является не самой сложной из проблем современного SEO. Как правило, достаточно овладеть базовым справочным материалом по теме и тщательно следовать его рекомендациям. Однако с пренебрежением относиться к данному вопросу тоже не стоит, дабы неожиданно не столкнуться с неприятностями, которые могут существенно затормозить продвижение сайта.

www.searchengines.ru

Диагностика сайта в Яндекс Вебмастер

Вкратце о диагностике сайта

Фатальные

Критичные

Возможные проблемы

Рекомендации

Вкратце о диагностике сайта

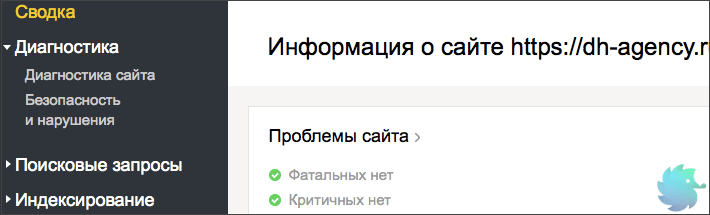

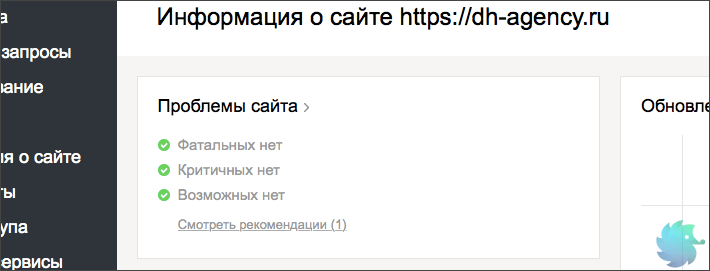

В этой статье мы подробно опишем большинство самых популярных проблем, которые выдает диагностика сайта от Яндекса. Напомним, что раздел диагностики находится в Yandex Webmaster на второй вкладке в левом меню.

Краткую информацию о наличии проблем возможно найти в левом верхнем блоке на главной странице Вебмастера.

Прежде, чем рассказывать о каждой проблеме отдельно, поясним общую информацию. Яндекс разделил все ошибки на 4 вида:

Фатальные — то есть, те, которые несовместимы с отображением сайта в поисковой выдаче. Наличие таких ошибок, скорее всего, приведет к полному исключению сайта из поиска. Среди них — запрет индексации, различного рода санкции со стороны поисковиков, серьезное нарушение безопасности или неработоспособность сайта;

Критичные — то есть, те, которые серьезно затрудняют удобство пользования сайтом, его корректную работу или индексацию. Наличие таких ошибок вряд ли приведет к исключению ресурса из поисковой выдачи, но может сильно снизить видимость;

Возможные — то есть, те, которые влияют на удобство пользователей, отображение и корректную индексацию. Подобные ошибки стоит устранить для улучшения сайта и повышения видимости в органической выдаче. В общем списке сайтов Вебмастера возможные проблемы обозначаются серым восклицательным знаком.

Рекомендации — носят исключительно рекомендательный характер. Обычно направлены на улучшение сайта или отображения.

Фатальные проблемы

Решать фатальные проблемы нужно немедленно, иначе они приведут к исключению сайта из поисковой выдачи. Подобные ошибки справедливы не только для Яндекса, но и для всех остальных поисковых систем. Ниже мы опишем каждую из них в отдельности, а так же предложим варианты решения.

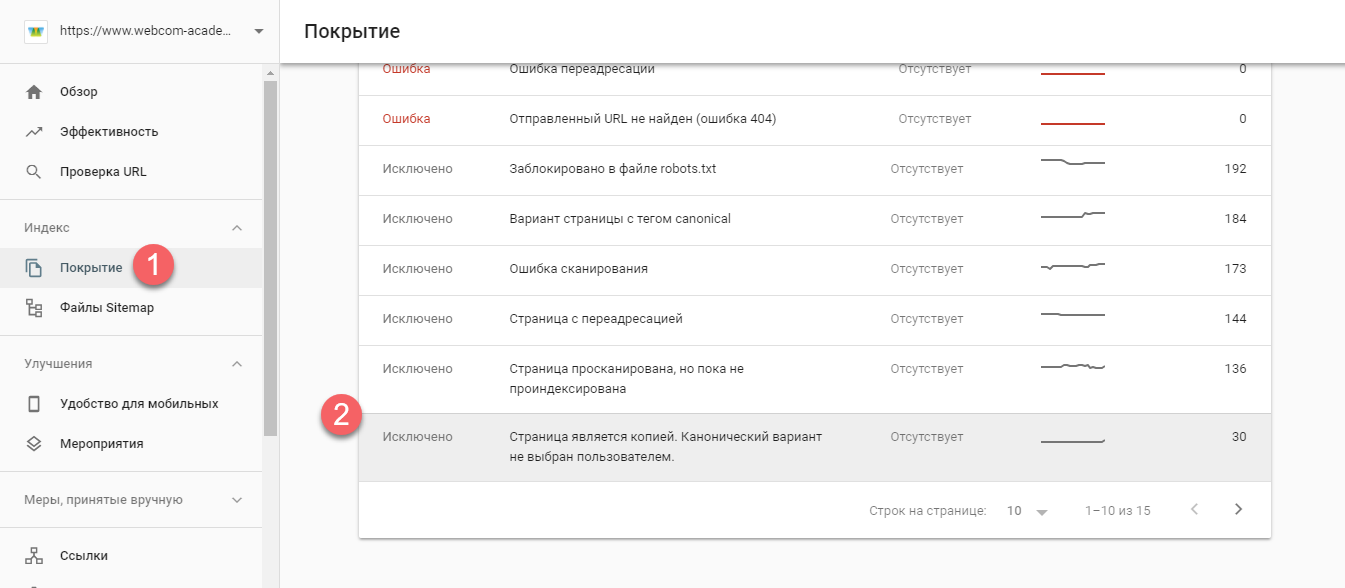

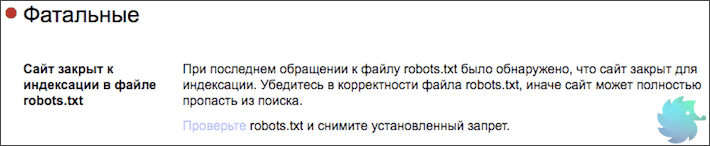

Сайт закрыт к индексации в файле robots.txt

«При последнем обращении к файлу robots.txt было обнаружено, что сайт закрыт для индексации. Убедитесь в корректности файла robots.txt, иначе сайт может полностью пропасть из поиска.» © Яндекс Вебмастер

Очень серьезная, но легко решаемая проблема. Причиной ее появления может стать банальная ошибка в синтаксисе файла robots.txt или ненамеренный запрет индексации. Зачастую такую ошибку можно увидеть у новых сайтов, так как разработчики обычно закрывают ресурс для индексации и не всега открывают обратно.

Поправить это очень просто. Открываем свой robots.txt по ссылке ваш_домен/robots.txt и проверяем содержимое. Если в нем расположен код следующего содержания:

User-agent: *

Disallow: /

или

User-agent: Yandex

Disallow: /

То, просто заменяем его на шаблонные инструкции для Вашей CMS или прописываем уникальные вручную.

Подробнее о настройке файла robots.txt

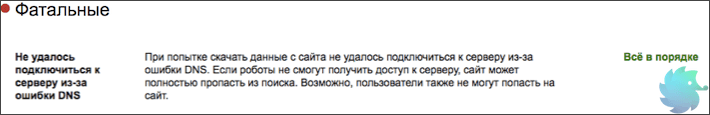

Не удалось подключиться к серверу из-за ошибки DNS

«При попытке скачать данные с сайта не удалось подключиться к серверу из-за ошибки DNS. Если роботы не смогут получить доступ к серверу, сайт может полностью пропасть из поиска. Возможно, пользователи также не могут попасть на сайт.» © Яндекс Вебмастер

Данная проблема решается уже не так быстро, как предыдущая. Суть ее проста. Индексирующий робот Яндекса попросту не смог получить доступ к сайту. То есть, корректная индексация уже невозможна. Если краулер, при повторных обращениях, будет продолжать получать ошибку, то сайт рано или поздно исключат из поиска.

В данном конкретном случае, лучше всего будет обратиться к разработчикам сайта или хост-провайдеру (регистратору доменного имени.) Если Вы не профессионал, то можете потерять много драгоценного времени в попытках разобраться в произошедшем. Помните, что фатальные ошибки нужно решать незамедлительно.

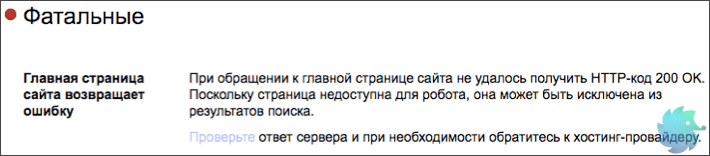

Главная страница сайта возвращает ошибку

«При обращении к главной странице сайта не удалось получить HTTP-код 200 OK. Поскольку страница недоступна для робота, она может быть исключена из результатов поиска.» © Яндекс Вебмастер

При обращении к главной странице сайта робот ожидает ответ 200 ОК. Только при его получении продолжается корректная индексация.

Если Вы столкнулись с вышеупомянутой проблемой, то вот несколько причин ее появления.

Неверно настроен ответ главной страницы. К примеру, главная может отдавать 404 Not Found или 403. Что для нее не корректно. Определить ответ можно в Яндекс Вебмастере, при помощи инструмента «проверка ответа сервера«;

Для главной страницы может быть настроен 301 редирект;

Главная страница сайта может технически отсутствовать, что редкость.

Решается проблема путем проверки наличия страницы и ее ответа. Для разработчиков сайта устранить данную ошибку не составит никакого труда.

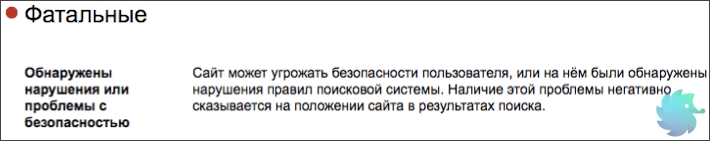

Обнаружены нарушения или проблемы с безопасностью

«Сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Наличие этой проблемы негативно сказывается на положении сайта в результатах поиска.» © Яндекс Вебмастер

Одна из самых сложно решаемых проблем. Причин ее появления может быть множество. Вот основные из них:

Сайт был взломан и на нем находится вредоносный код. Это может быть вирусный рекламный баннер, вставки iframe, различного рода трояны, а так же множество другой гадости;

Сбор, обработка или передача данных пользователей сделана насколько некорректно, что индексирующий робот заподозрил в этом мошеннические намерения;

Сайт не соответствует правилам поисковой системы. То есть, имеет запрещенный контент, обманывает или вводит в заблуждение пользователей, подменяет материал и т.д.;

Стоит сказать, что данная проблема может появляться у очень молодых сайтов из-за темного прошлого доменного имени. Обязательно проверяйте домен перед покупкой.

Однако, не стоит беспокоиться и переделывать сайт, если Вы уверены в его корректной работе. Подобное сообщение может появляться по ошибке. Если это так, то оно автоматически пропадет через несколько обновлений.

Критичные проблемы

На критичные проблемы стоит сразу обратить внимание и начать искать решение. Их появление скорее всего не приведет к исключению из поиска, однако может серьезно повлиять на видимость сайта.

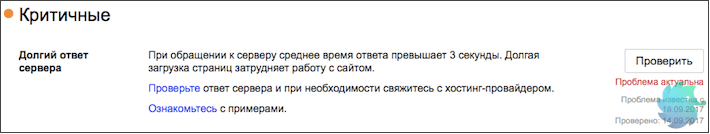

Долгий ответ сервера

«При обращении к серверу среднее время ответа превышает 3 секунды. Долгая загрузка страниц затрудняет работу с сайтом.» © Яндекс Вебмастер

Это одна из основных причин неполной (некорректной) индексации. Робот отводит на каждый сайт определенное количество секунд, после чего переходит к следующем ресурсу. Если ответ сервера слишком долгий, то времени на загрузку страниц может просто не остаться.

Что бы решить эту проблему, необходимо обратиться к администратору сервера или хост-провайдеру. Возможно, Вашему сайту просто не хватает выделенных для работы ресурсов.

Если данное сообщение появилось, а потом пропало без видимых причин, не стоит его игнорировать. Обязательно проверьте скорость ответа сервера, а так же параметры загрузки сайта. Наличие подобной проблемы влияет на индексацию вне зависимости от того, есть сообщение в Вебмастере или его нету.

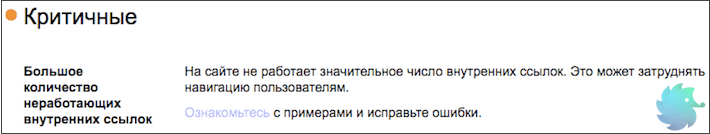

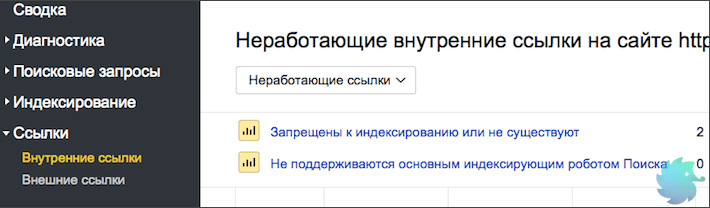

Большое количество неработающих внутренних ссылок

«На сайте не работает значительное число внутренних ссылок. Это может затруднять навигацию пользователям.» © Яндекс Вебмастер

Причиной возникновения подобной проблемы может служить некорректный перенос разделов, страниц или сайта в целом. Так же, к этому может привести сбой в работе каталога, фильтра, пагинации или другого блока связанного со ссылками.

Определить точное количество неработающих ссылок и увидеть детали можно в разделе «Внутренние ссылки» Яндекс Вебмастера.

В этом блоке подробно описываются причины, поэтому Вам останется только устранить проблемы внутри сайта.

Возможные проблемы

Несмотря на название, возможные проблемы все же являются серьезными изъянами с точки зрения SEO. Они не приведут к исключению ресурса из поиска, а так же слабо повлияют на позиции и видимость. Однако их устранение может привести к подъему поискового трафика и более лояльному отношению поисковиков.

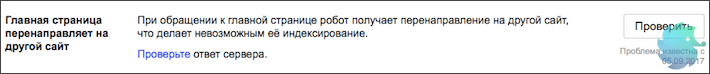

Главная страница перенаправляет на другой сайт

«При обращении к главной странице робот получает перенаправление на другой сайт, что делает невозможным её индексирование.» © Яндекс Вебмастер

Данную проблему Яндекс относит к разделу «Возможные», однако с нашей точки зрения это серьезная ошибка. Речь сейчас не идет о перенаправлении на зеркала или «склейку». Только редирект на сторонний сайт.

При корректном обращении к главной странице краулер должен получать ответ 200 ОК, что означает, что страница доступна пользователям и ее можно индексировать. В случае получения 301 Redirect, робот не только отправляется на сторонний ресурс, но и получает тревожный сигнал, что сайт мог быть взломан или вводит пользователей в заблуждение. То есть, Вы уже рискуете попасть под фильтры безопасности.

Сразу проверьте ответ сервера, если это будет не 200 ОК — ищите и устраняйте причину. В случае получения 301 Redirect рекомендуем заглянуть в файл .htaccess и проверить его на наличие редиректа.

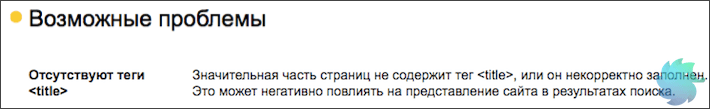

Отсутствуют теги <title>

«Значительная часть страниц не содержит тег <title>, или он некорректно заполнен. Это может негативно повлиять на представление сайта в результатах поиска.» © Яндекс Вебмастер

Очень серьезное упущение с точки зрения поискового продвижения. Заголовки <title></title> являются одним из основных факторов внутренней оптимизации, которые влияют на ранжирование страницы.

Ранее этому заголовку мы посвятили полноценную статью. В ней разложено по полочкам все, что нужно знать о данном теге с точки зрения SEO.

Безусловно, Яндекс самостоятельно выберет текст для ссылки при построении поисковой выдачи и без сниппета Вы не останетесь, однако Ваша конкурентоспособность с точки зрения SEO сильно упадет.

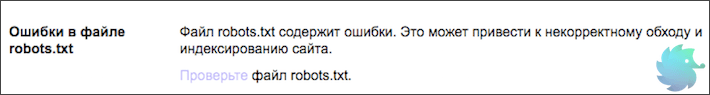

Ошибки в файле robots.txt

«Файл robots.txt содержит ошибки. Это может привести к некорректному обходу и индексированию сайта.» © Яндекс Вебмастер

Данный файл представляет из себя список инструкций для индексирующего робота. Именно в нем определяется, что нужно загружать в базу, а что игнорировать. Находится он в корневой папке сайта и доступен по адресу www.ваш_домен.ru/robots.txt.

Большинство ошибок в robots.txt, обычно, связаны с синтаксисом прописываемых в нем инструкций. Лишняя точка, слэш или пробел могут привести к некорректному распознанию команды.

Поэтому, при появлении данной проблемы сразу открывайте свой роботс и начинайте проверять синтаксис. В этом деле Вам может помочь сервис «Анализ robots.txt» находящийся во вкладке «Инструменты» Яндекс Вебмастера.

Подробнее об ошибках и настройке файла robots.txt

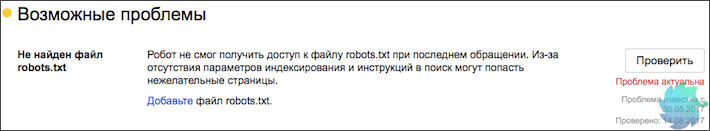

Не найден файл robots.txt

«Робот не смог получить доступ к файлу robots.txt при последнем обращении. Из-за отсутствия параметров индексирования и инструкций в поиск могут попасть нежелательные страницы.» © Яндекс Вебмастер

Суть проблемы понятна из названия. Что бы решить ее, необходимо просто добавить robots.txt в корневой каталог Вашего сайта. Сделать это можно через FTP или при помощи различного рода плагинов.

Если Вы используете популярную CMS, то мы готовы предложить шаблонные решения. Однако, обратите внимание, что шаблоны инструкций не гарантируют корректность индексации и отсутствие мусора. У каждого сайта будут свои особенности и подводные камни.

Подробнее о настройке файла robots.txt

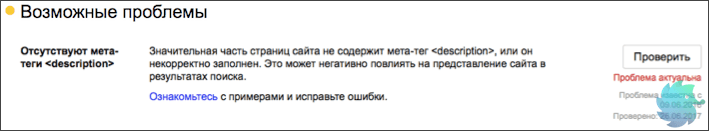

Отсутствуют мета-теги <description>

«Значительная часть страниц сайта не содержит мета-тег <description>, или он некорректно заполнен. Это может негативно повлиять на представление сайта в результатах поиска.» © Яндекс Вебмастер

Это одна из самых распространенных проблем, с которой сталкивается практически каждый SEO специалист. Для ее решения необходимо просто добавить недостающие <description>.

Узнать полный список страниц с отсутствующими тегами Вы можете перейдя по ссылке «Ознакомьтесь» в описании проблемы.

Отсутствие meta тега <description> сильно влияет на корректность отображения сниппетов. Поэтому тянуть с решением проблемы не стоит.

Если подобная ошибка появилась у Интернет-магазина, сайта-каталога или другого крупного ресурса, то для ее решения есть стандартные плагины, которые формируют meta description автоматически. Пользоваться такими плагинами мы советуем в крайнем случае, так как результат работы не всегда удовлетворителен.

Подробнее о description и правилах заполнения

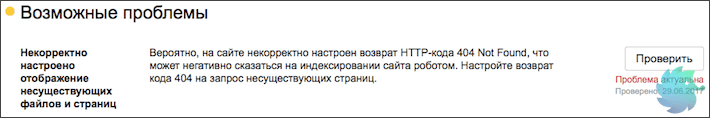

Некорректное отображение несуществующих файлов и страниц

«Вероятно, на сайте некорректно настроен возврат HTTP-кода 404 Not Found, что может негативно сказаться на индексировании сайта роботом. Настройте возврат кода 404 на запрос несуществующих страниц.» © Яндекс Вебмастер

Проще говоря, у Вас попросту отсутствует или некорректно работает страница 404. Что бы разобраться в этом, необходимо перейти на несуществующий раздел. Сделать это можно введя любой некорректный URL, к примеру «ваш_домен.ру/none12345».

Если Вы видите перед собой неизвестную ошибку, белый экран, сообщение хост-провайдера или другую информацию, которая к сайту не относится — у Вас просто нету данной страницы. Шаблон для нее необходимо сделать в CMS сайта. Это напрямую относится к разработке и дизайну сайта, поэтому работы стоит поручить верстальщику.

Если Вы видите оформленную страницу 404 своего сайта, тогда проблема в ответе сервера. Нужно понимать, что надпись «404 — страница не найдена» не означает, что сайт действительно отдает «404 Not Found», скорее всего, результатом будет 200 ОК.

Проверить ответ сервера Вы можете в разделе «Проверка ответов сервера» во вкладке «Инструменты» Яндекс Вебмастера.

Создание страницы 404 Not Found и настройка ответа сервера полностью зависят от конкретного сайта, поэтому сделать пошаговую инструкцию просто невозможно.

Подробнее о странице 404 с точки зрения SEO

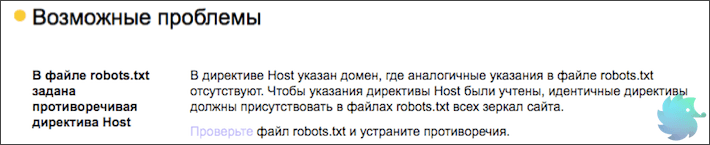

В файле robots.txt задана противоречивая директива Host

«В директиве Host указан домен, где аналогичные указания в файле robots.txt отсутствуют. Чтобы указания директивы Host были учтены, идентичные директивы должны присутствовать в файлах robots.txt всех зеркал сайта.» © Яндекс Вебмастер

Суть проблемы в следующем. Есть два зеркала. У обоих есть файл robots.txt, в котором указаны различные параметры инструкции HOST.

Решение очень простое. Необходимо указать во всех HOST одно главное зеркало. Это нужно, что бы у робота не оставалось сомнений, какое из зеркал основное.

Бывает так, что файл robots.txt один и инструкции попросту не могут различаться. В таком случае нужно подождать и сообщение пропадет.

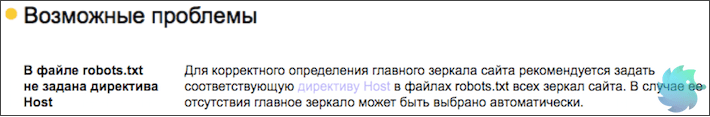

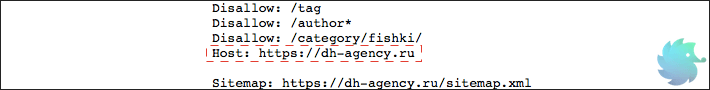

В файле robots.txt не задана директива Host

«Для корректного определения главного зеркала сайта рекомендуется задать соответствующую директиву Host в файлах robots.txt всех зеркал сайта. В случае ее отсутствия главное зеркало может быть выбрано автоматически.» © Яндекс Вебмастер

Помимо прочих инструкций в файле robots.txt для агента Яндекса необходимо указывать директиву host. Пример директивы приведен на рисунке ниже.

Синтаксис ее крайне прост. Сначала пишется служебное слово «Host:», далее через пробел вставляется главное зеркало сайта. При этом нужно учесть, что протокол http не пишется. Добавляется только https при его наличии. Убедитесь, что зеркало выставленное в Яндекс Вебмастере и других host (у сайтов-зеркал) соответствует указываемому в robots.txt. В противном случае Вы получите ошибку, о которой говорится выше.

Подробнее о директиве host

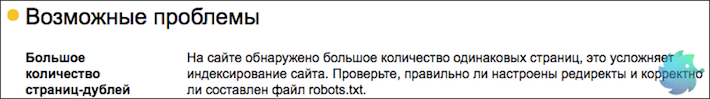

Большое количество страниц дублей

«На сайте обнаружено большое количество одинаковых страниц, это усложняет индексирование сайта. Проверьте, правильно ли настроены редиректы и корректно ли составлен файл robots.txt.» © Яндекс Вебмастер

Достаточно серьезная проблема, которая для решения, зачастую, требует квалифицированной помощи программиста. Страницы-дубли, по сути, представляют собой различные URL, которые ведут на одну и ту же страницу. (Реже, это несколько абсолютно одинаковых html файлов с разными URL)

Когда индексирующий робот попадает на сайт, он старается обойти все доступные URL адреса и загрузить по ним уникальный контент. Если робот переходит по адресу и «видит» уже загруженную ранее страницу, то он исключает ее из поиска как дубликат, при этом теряя драгоценное время обхода.

Определить наличие дублей возможно в Яндекс Вебмастере. Необходимо зайти в раздел «Индексирование» -> «Страницы в поиске» -> «Исключенные страницы». Тут будут представлены все исключенные из поиска разделы, в том числе и по причине дублирования. Для того, что бы долго не искать, можно настроить фильтр по статусу. (нажать на значок воронки рядом с заголовком)

После того, как все страницы будут отсортированы, Вы сможете увидеть имеющиеся дубликаты, о которых знает Яндекс.

Для решения данной проблемы необходимо, в первую очередь, определить причину появления дублей. Их может быть несколько.

При создании страницы, в CMS генерируется технический адрес, который обычно имеет вид «post=3333&action=edit» или любой другой не ЧПУ. Вы не хотите видеть подобный URL и создаете для страницы человекочитаемый адрес. Таким образом статья становится доступна по 2 адресам. В этом случае необходимо скрыть все технические адреса в robots.txt при помощи маски;

На сайте имеются динамические URL, которые дополняются различными префиксами в зависимости от выбранных параметров, поиска, сортировки и т.д. Их так же необходимо скрывать при помощи маски в robots или отказаться от динамических URL;

Во время настройки рекламы, для получения данных о клиенте и источнике, часто используются дублирующие ссылки с параметрами. Такие URL нужно сразу закрывать в robots.txt во избежание попадания в индекс;

Некоторые системы управления могут отображать страницу по нескольким человекочитаемым URL. К примеру, страница может быть доступна по всем 3-м адресам: «/page1/», «/page1.php», «/page1.html». Исключаются подобные дубли так же при помощи маски.

После того, как дубли будут закрыты для индексации, предупреждение пропадет автоматически. Но, не стоит думать, что это произойдет в первую неделю. Подобное сообщение может держаться месяцами.

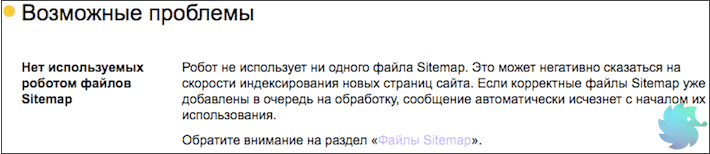

Нет используемых роботом файлов Sitemap

«Робот не использует ни одного файла Sitemap. Это может негативно сказаться на скорости индексирования новых страниц сайта. Если корректные файлы Sitemap уже добавлены в очередь на обработку, сообщение автоматически исчезнет с началом их использования.» © Яндекс Вебмастер

Это длинное сообщение описывает всего лишь отсутствие sitemap.xml. Что бы поправить ситуацию нужно просто создать данный файл и разместить его в корневом каталоге Вашего сайта. Ранее мы подробно рассказывали, как это сделать.

После создания необходимо зайти в Яндекс Вебмастер -> «Индексирование» — > «Файлы Sitemap» -> «Добавить карту». В этом же разделе возможно отследить корректность индексации и в случае необходимости обновить.

После того, как робот увидит sitemap сообщение о проблеме пропадет автоматически.

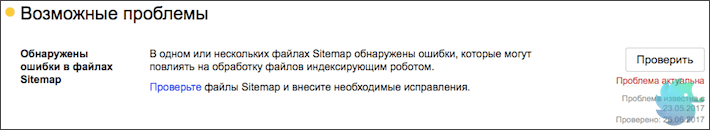

Обнаружены ошибки в файлах Sitemap

«В одном или нескольких файлах Sitemap обнаружены ошибки, которые могут повлиять на обработку файлов индексирующим роботом.» © Яндекс Вебмастер

В случае возникновения данной проблемы воспользуйтесь сервисом анализа sitemap.xml, который находится прямо в Яндекс Вебмастере. («Инструменты»-> «Анализ файлов Sitemap»).

Если ошибку не удается выявить, проще всего создать новую карту сайта. Как это сделать, подробно описывали ранее.

Если sitemap генерируется при помощи плагинов, обратите внимание на поля, которые находятся в итоговом файле. В отличии от Google, Яндекс не воспринимает инструкцию <image:image> и может сообщать об ошибке.

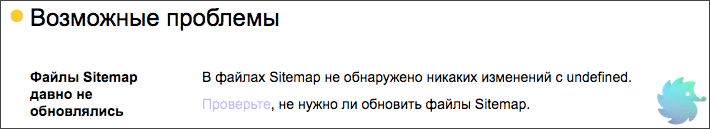

Файлы Sitemap давно не обновлялись

«В файлах Sitemap не обнаружено никаких изменений с undefined. Проверьте, не нужно ли обновить файлы Sitemap.»© Яндекс Вебмастер

Тут все просто. Необходимо обновить все имеющиеся на сайте файлы sitemap.xml. Причем сделать это нужно корректно. Вот лишь несколько ошибок, которые допускают при обновлении карты сайта.

Даты изменения страниц не соответствуют реальному обновлению страниц. Подобная ошибка происходит в тот момент, когда Вы используете online сервис. В таком случае все даты изменения могут быть одинаковыми и не соответствовать фактическим. Это заставляет поисковую систему повторно загружать один и тот же материал, что приводит к пустой трате времени;

Все страницы имеют один и тот же приоритет. В таком случае данный параметр sitemap.xml просто перестает иметь какой-либо смысл;

Вероятная частота изменения не соответствует действительной. Не стоит писать, что Ваши страницы обновляются каждый час. Обмануть поисковую систему не удастся и преимущества Вы не получите, но вот возможность корректного указания частоты обновления утратите.

Подробнее о создании sitemap.xml

Рекомендации

Этот раздел носит исключительно информационный характер, однако мы советуем соблюсти все его требования.

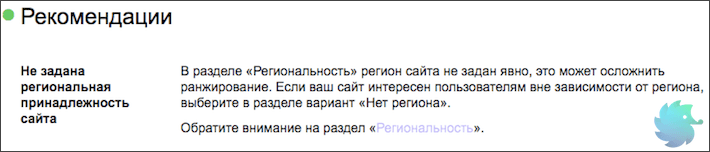

Не задана региональная принадлежность сайта

«В разделе «Региональность» регион сайта не задан явно, это может осложнить ранжирование. Если ваш сайт интересен пользователям вне зависимости от региона, выберите в разделе вариант «Нет региона».» © Яндекс Вебмастер

У данной проблемы есть две стороны медали. С одной — присвоение региона не является обязательной процедурой и Яндекс сам может определить его. С другой — если регион определен некорректно, то Вы можете получить нерелевантный трафик или же вообще лишиться его.

Поэтому мы настоятельно рекомендуем присваивать регион каждому сайту. Стоит отметить, что есть ряд ресурсов, которые не имеют региональной привязки. В таком случае необходимо сообщить Яндексу, что региона Вы не имеете.

Подробнее о том, как выбрать и присвоить регион.

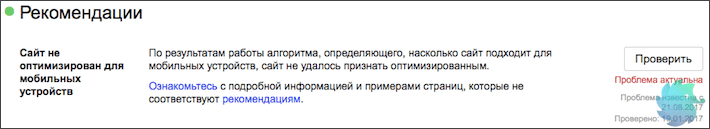

Сайт не оптимизирован для мобильных

«По результатам работы алгоритма, определяющего, насколько сайт подходит для мобильных устройств, сайт не удалось признать оптимизированным.» © Яндекс Вебмастер

Сегодня эта проблема должна находиться уже среди критичных. Поисковые системы не раз говорили о том, что будут занижать сайты не имеющие мобильной версии. С каждым годом процентное соотношение трафика с мобильных устройств растет, поэтому мобильная адаптация должна быть у всех.

Насколько корректно Ваш сайт адаптирован под мобильные телефоны и планшеты Вы можете определить с помощью официального сервиса Яндекса — «Проверка мобильных страниц» . Располагается он в разделе «Инструменты» Яндекс Вебмастера.

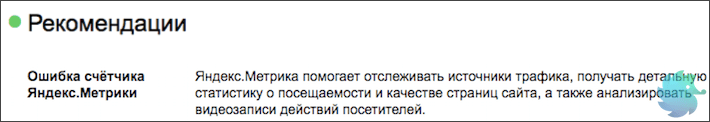

Ошибка счётчика Яндекс.Метрики

«Яндекс.Метрика помогает отслеживать источники трафика, получать детальную статистику о посещаемости и качестве страниц сайта, а также анализировать видеозаписи действий посетителей.» © Яндекс Вебмастер

Тут все просто. Скорее всего код Яндекс Метрики был установлен некорректно или не на все страницы.

Если Вы зайдете в счетчики и увидите красный значок слева от сайта — данные в Метрику не поступают. Нажмите на него.

Если он не станет зеленым, то просто переустановите счетчик. Для этого нужно:

Перейти в настройки нажав на значок шестеренки в правой части экрана;

Переходим на вкладку «Код счетчика» и копируем его;

Открываем шаблон, который формирует страницы сайта и вставляем в него код;

Переходим в метрику и нажимаем на красный кружок со стрелочкой. Он должен стать зеленым.

В случае, если Вы уверены, что код размещен правильно, но данные так и не поступают — обратитесь в службу поддержки или подробно ознакомьтесь с процессом установки счетчика.

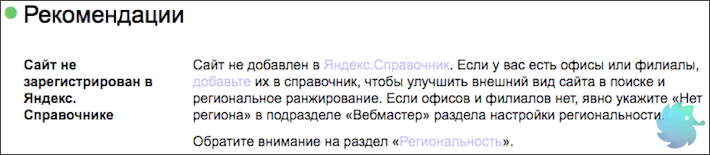

Сайт не зарегистрирован в Яндекс.Справочнике

«Сайт не добавлен в Яндекс.Справочник. Если у вас есть офисы или филиалы, добавьте их в справочник, чтобы улучшить внешний вид сайта в поиске и региональное ранжирование. Если офисов и филиалов нет, явно укажите «Нет региона» в подразделе «Вебмастер» раздела настройки региональности.» © Яндекс Вебмастер

С точки зрения SEO, регистрация сайта в Яндекс Справочнике может дополнить сниппет такой полезной информацией, как телефон, адрес и режим работы. По брендовым запросам справа от сниппета начнет появляться карта с адресом и подробной информацией о фирме. Такие сниппеты любят пользователи, поэтому стоить уделить 15 минут на регистрацию.

Зарегистрироваться проще некуда. Это совершенно бесплатно.

Заходим в Яндекс Аккаунт и переходим по ссылке: https://yandex.ru/sprav/add/;

Вводим информацию о компании и нажимаем «Добавить организацию»;

Ожидаем одобрения модераторов. (Обычно проблем с этим не возникает)

После успешной модерации информация появится в выдаче через несколько обновлений.

Отсутствует файл favicon на сайте

![]()

«Не найден файл с изображением, которое должно отображаться во вкладке браузера и может быть показано возле названия сайта в поиске.» © Яндекс Вебмастер

Файл favicon.ico это небольшая картинка, которая отображается во вкладке браузера.

![]()

Favicon имеет расширение .ico и располагается в корневой папке сайта или шаблона.

Кроме отображения во вкладке, данное изображение присутствует в поисковой выдаче рядом со ссылкой на сайт. Именно поэтому о нем сообщает Яндекс.

Сделать favicon очень просто. Для этого нужно создать рисунок квадратной формы, после чего воспользоваться одним из множество online генераторов. Примеры таких сервисов:

Скачайте получившийся файл, назовите его favicon.ico и разместите в корневой папке сайта. Несколько раз обновите браузер и Ваше изображение появится во вкладке рядом с доменом. В поисковой выдаче favicon обновится в течение 2-3 недель.

Отсутствуют быстрые ссылки

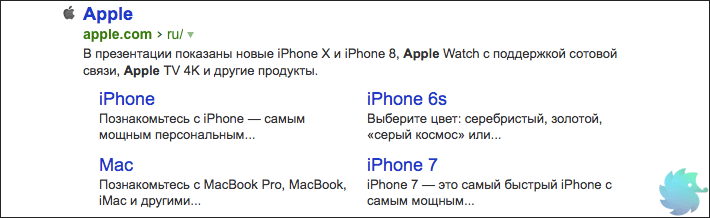

«В некоторых случаях в результатах поиска возможно отображение быстрых ссылок в сниппете сайта, что улучшает его видимость и количество переходов. Ссылки формируются полностью автоматически, роботы регулярно оценивают возможность показа быстрых ссылок.» © Яндекс Вебмастер

Это исключительно информационное сообщение, так как напрямую повлиять на вывод быстрых ссылок Вы не можете. Напомним, что последние располагаются под основным сниппетом сайта в органической выдаче. На рисунке ниже приведен пример быстрых ссылок для сайта компании Apple.

Но, несмотря на то, что напрямую влияния Вы не имеете, возможно «помочь» роботу определить быстрые ссылки. Делается это путем создания корректной древовидной структуры сайта. То есть, выделить основные разделы, сгруппировать в них подразделы и корректно связать все перелинковкой.

В этом случае Яндекс сможет с большей вероятностью определить основные разделы и сформировать блок быстрых ссылок.

dh-agency.ru

Сайт проиндексирован, но страниц нет в поиске вообще — Яндекс

Здравствуйте!

20 февраля 2016 после очередного Апа мой сайт полностью пропал из результатов поиска Яндекс. Не могу найти ни одной страницы. Не нахожу даже в ТОП-100. Вебмастер пишет, что проиндексированы и участвуют в поиске 1641 страница. Но их нет ни по одному запросу, кроме адреса сайта и названия.

До этого из 150 отслеживаемых позиций 60% были в топ-10 Яндекса и основной трафик шел из органической выдачи.

А теперь… Даже самые низкочастотные запросы, дословно повторяющие содержимое страниц — не находятся. Пример сверхнизкочастотного запроса: «поддельные колготки миф или правда» — точное совпадение с названием моей статьи, давным давно размещенной на сайте — не находится.

Ни одного товара, ни одной категории товара, ни одного информационного запроса, ни одной статьи в поиске нет!!!

Платонам писал. Получил ответ:

20 февраля я передал описание данной ситуации аналитикам поискового отдела нашей компании. Они проверят, корректно ли в данном случае работают наши алгоритмы, и при необходимости в них будут внесены соответствующие изменения. Если в течение двух недель ситуация не изменится, пожалуйста, сообщите нам об этом

Сайт у меня единственный, аффилятов нет. Ссылки уж года два не покупаю и никогда не продавал. Баннерной рекламой не занимаюсь. ПФ не накручивал. Профили из соц. сетей не воровал.

Трафик с Яндекса после 20 февраля — 0. Кормлюсь пока небогатым топом от Гугл и прямыми заходами постоянных клиентов. Нанял спеца для настройки Adwords.

Теряюсь в догадках, сушу сухари и откладываю на Доширак. Просто в шоке…. Сайт — единственный источник дохода для всей семьи.

Что это может быть??? Пациент: http://www.dlyapodruzek.ru

Заранее спасибо за ответы!

talk.pr-cy.ru