Интерфейс SAS-2 и контроллер LSI SAS 9211-8i

Знакомство с интерфейсом Serial Attached SCSI на 6 Гбит/с

В начале 2010 года в продаже появились первые жесткие диски и контроллеры с поддержкой интерфейса Serial ATA Rev. 3.0 со скоростью передачи данных 6 Гбит/с. Несмотря на вдвое возросшую скорость интерфейса и некоторые улучшения в обработке очереди команд (NCQ), новинка пока что особых дивидендов в плане производительности не принесла: будучи примененным в традиционных жестких магнитных дисках, даже имеющих огромный буфер 64 МБ (например, Seagate Barracuda XT), интерфейс SATA 6 Гбит/с явно стреноживался во много раз меньшей скоростью линейного доступа к полезной для пользователя информации на магнитных пластинах (150—160 МБ/с против 400—500 МБ/с у интерфейса SATA Rev. 3.0). Между тем, практическая «обкатка» SATA Rev. 3.0 позволила индустрии достаточно оперативно вслед за ним выпустить его «старшего братца» — интерфейс Serial Attached SCSI 2. 0 со скоростью передачи данных 6 Гбит/с. Ведь сигнальный (физический) уровень интерфейсов у них очень похож (у SAS лишь примерно вдвое выше напряжение сигналов, чем у SATA).

0 со скоростью передачи данных 6 Гбит/с. Ведь сигнальный (физический) уровень интерфейсов у них очень похож (у SAS лишь примерно вдвое выше напряжение сигналов, чем у SATA).

В этой статье мы кинем первый взгляд на интерфейс SAS-2 на примере одного контроллера и одного диска, а более детальным исследованиям его возможностей посвятим будущие статьи.

Serial attached SCSI 2.1: что новенького?

Будучи наследником старого доброго параллельного интерфейса SCSI, интерфейс Serial attached SCSI (SAS) изначально задумывался с прицелом на поэтапное удвоение пропускной способности. Первое поколение SAS со скоростью передачи данных 3 Гбит/с появилось в лабораториях еще в 2004 году и широко вышло на рынок в 2005—2006 годах. Спустя «пятилетку», то есть в 2009 году, на-гора был выдан SAS-2 (6 Гбит/с) — устройства с его поддержкой поступили в продажу уже в 2010 году. Наконец, в конце 2012 года индустрия ожидает первых инженерных воплощений SAS-3 со скоростью передачи уже 12 Гбит/с. На рынке устройства с поддержкой третьего поколения SAS следует ждать не ранее 2014 года (см. рис.). Таким образом, у новенького SAS-2 есть как минимум года четыре на окупаемость и «снятие сливок».

На рынке устройства с поддержкой третьего поколения SAS следует ждать не ранее 2014 года (см. рис.). Таким образом, у новенького SAS-2 есть как минимум года четыре на окупаемость и «снятие сливок».

План эволюции интерфейса SAS (рисунок с сайта www.scsita.org)

Разрабатывает спецификации интерфейса SAS технический комитет T10 Международного комитета по ИТ-стандартам, или INCITS (International Committee for Information Technology Standards, см. www.incits.org). Практическая разработка и поддержка протокола SAS лежит на SCSI Trade Association (SCSITA или STA, см. www.scsita.org). Разумеется, поколения SAS обратно совместимы, то есть SAS 2.0 поддерживает все функции первого поколения SAS-1.1 со скоростью 3 Гбит/с (полный дуплекс, 10-метровый внешний кабель, расширитель портов до 255 устройств (всего до 65535), поддержку TCQ, совместимость с дисками SATA с NCQ, двухпортовые диски SAS, агрегацию четырех портов с соответствующим увеличением пропускной способности до 24 Гбит/с и мн. др.).

др.).

Второе поколение стандарта SAS — это эволюционное развитие предшественника. Стандарт SAS-2.0 вскоре после выхода был усовершенствован до версии 2.1 и нынешние рыночные устройства для SAS 6 Гбит/с поддерживают именно SAS-2.1. Основные нововведения можно свести к следующему:

- Удвоение пропускной способности шины с 3 до 6 Гбит/с (кабель до 10 м).

- Стандартизованное (по SAS-2) зонирование и зонирующий экспандер (см. рисунки ниже) для улучшенной поддержки мультихостинга и функций безопасности.

- Размывание спектра частот (spread spectrum) для уменьшения электромагнитной интерференции (не требуется для соединений на скорости 3 Гбит/с и менее).

- Мультиплексирование соединений (опционально) для увеличения степени использования интерфейса при подключении устройств с SAS-1 и др.

- Разъемы Mini-SAS (SFF-8088 и SFF-8087, см. рис.) для улучшения внешних соединений.

Стандартизованное зонирование по SAS-2

Самоконфигурирующийся зонирующий экспандер SAS-2

Разъем Mini-SAS 4X

Грубо говоря, наиболее важных нововведения в SAS-2, собственно, два — это удвоение скорости передачи и новые зонирующие функции. Именно последние дают возможность создавать такие новые и уникальные пока на рынке модели как, например, первый в индустрии 16-портовый SAS-коммутатор LSI SAS6160 (см. рис.), поступивший в продажу этой осенью по весьма привлекательной для его функциональности цене.

Именно последние дают возможность создавать такие новые и уникальные пока на рынке модели как, например, первый в индустрии 16-портовый SAS-коммутатор LSI SAS6160 (см. рис.), поступивший в продажу этой осенью по весьма привлекательной для его функциональности цене.

16-портовый SAS-2 коммутатор LSI SAS6160

С его помощью многочисленные серверы можно подключить к одной или нескольким независимым внешним системам хранения данных, используя при этом высочайшую пропускную способность «счетверенного» интерфейса SAS-2. Суммарная же пропускная способность такого коммутатора достигает фантастических 384 Гбит/с. Коммутатор LSI SAS6160 поддерживает до 1000 адресов устройств SAS и SATA в SAS-сетях с зонированием, позволяя пользователям иметь больше соединений и сократить время задержки при обращении к СХД различных классов. Кроме того, поддержка специальных активных кабелей позволяет коммутаторам LSI SAS быть расположенными на расстоянии до 25 м друг от друга, что в четыре раза больше по сравнению с использованием традиционных пассивных медных SAS-кабелей. Впрочем, подробное рассмотрение данного продукта выходит за рамки этой статьи, поэтому вернемся к ее основной теме.

Впрочем, подробное рассмотрение данного продукта выходит за рамки этой статьи, поэтому вернемся к ее основной теме.

За счет нововведений второе поколение SAS может еще больше потеснить решения на базе Fibre Channel в высокопроизводительных системах хранения данных и шину Infiniband при внешних соединениях модулей СХД. В частности, благодаря более низкой стоимости на один порт и в несколько раз меньшему энергопотреблению на порт (см. слайд).

Преимущества SAS-решений по сравнению с 10 GbE и Fibre Channel

С другой стороны, у SAS-2 улучшена поддержка SATA-накопителей высшей емкости в системах хранения данных (при помощи SATA Tunneling Protocol (STP)/SATA Bridging и Serial SCSI Protocol (SSP)/SATA Bridging, см. www.serialstoragewire.net/Articles/2008_03/opinion28.html), что усиливает универсальность нового интерфейса.

С точки зрения «неискушенного ИТ-потребителя» (которому, впрочем, необязательно связываться с SAS :)) польза от SAS-2, на первый взгляд, не так уж очевидна. Действительно, для обслуживания одиночных накопителей удвоение скорости интерфейса с 280 до 500 с лишним МБ/с по пользовательским данным пока что практически бесполезно — нынешние «магнитные» винчестеры (даже дорогие SAS-диски) едва дотягивают до 200 МБ/с в скорости линейного чтения/записи и им еще как минимум 2—3 года вполне будет хватать скоростей SAS 1.1, особенно если учесть наметившееся в последнее время замедление эволюции (роста плотности) перпендикулярной магнитной записи. Исключение — применение новейших профессиональных SSD со скоростью выше 300 МБ/с (хост SAS-2 поддерживает накопители с SATA 6 Гбит/с), а также активная работа дисков в крупных RAID-массивах, где большая емкость встроенных в диски кэшей вкупе с возросшей скоростью интерфейса способна немного поднять общую производительность. И тут полезно помнить, что узким местом может уже стать шина PCI Express, на которой «сидит» используемый контроллер RAID, — ведь даже PCIe x4 первого поколения в каждом направлении пропустит не более 1 ГБ в секунду (см.

Действительно, для обслуживания одиночных накопителей удвоение скорости интерфейса с 280 до 500 с лишним МБ/с по пользовательским данным пока что практически бесполезно — нынешние «магнитные» винчестеры (даже дорогие SAS-диски) едва дотягивают до 200 МБ/с в скорости линейного чтения/записи и им еще как минимум 2—3 года вполне будет хватать скоростей SAS 1.1, особенно если учесть наметившееся в последнее время замедление эволюции (роста плотности) перпендикулярной магнитной записи. Исключение — применение новейших профессиональных SSD со скоростью выше 300 МБ/с (хост SAS-2 поддерживает накопители с SATA 6 Гбит/с), а также активная работа дисков в крупных RAID-массивах, где большая емкость встроенных в диски кэшей вкупе с возросшей скоростью интерфейса способна немного поднять общую производительность. И тут полезно помнить, что узким местом может уже стать шина PCI Express, на которой «сидит» используемый контроллер RAID, — ведь даже PCIe x4 первого поколения в каждом направлении пропустит не более 1 ГБ в секунду (см. , например, http://en.wikipedia.org/wiki/List_of_device_bandwidths#Computer_buses), что равно одновременной полной загрузке всего лишь двух линий SAS-2. Таким образом, шина PCI Express x8 фактически является минимально разумным требованием для 4-дисковых хост-контроллеров SAS-2. А для 8-дисковых RAID-хостов использование PCIe x8 поколения 2.0 является просто непременным.

, например, http://en.wikipedia.org/wiki/List_of_device_bandwidths#Computer_buses), что равно одновременной полной загрузке всего лишь двух линий SAS-2. Таким образом, шина PCI Express x8 фактически является минимально разумным требованием для 4-дисковых хост-контроллеров SAS-2. А для 8-дисковых RAID-хостов использование PCIe x8 поколения 2.0 является просто непременным.

Ну а больше пользы от применения SAS-2 можно получить, если активно использовать другие возможности SAS — в частности, расширители и агрегаторы портов. В этом случае, «посадив», скажем, на один порт SAS-2 пару быстрых SAS-винчестеров, мы можем практически не увидеть падения производительности. Аналогично — для внешних СХД при соединении с хостом по SAS-2 (кабелем длиной до 10 м)…

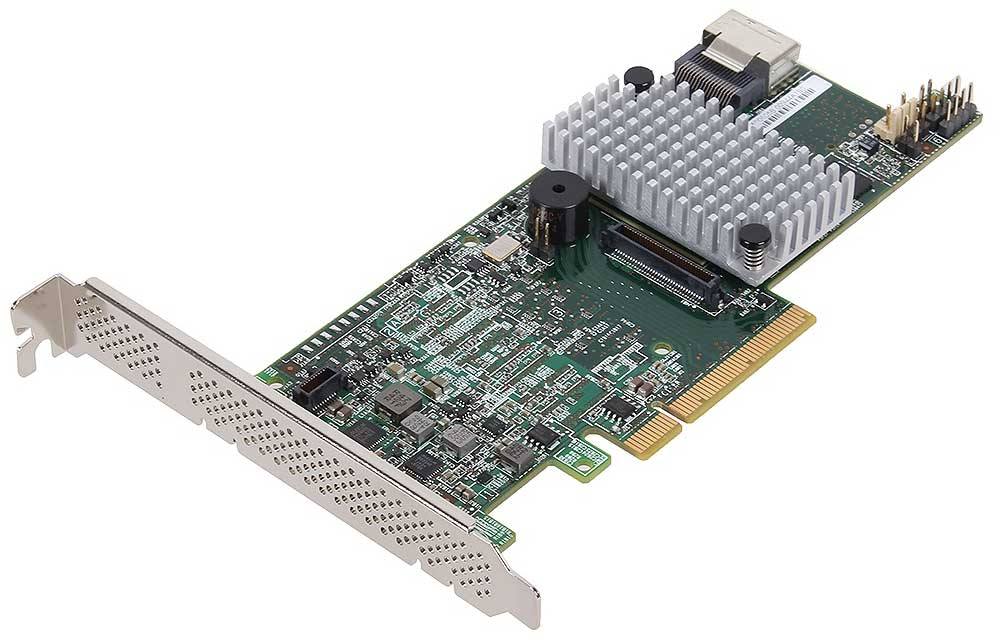

Контроллер LSI SAS 9211-8i

Первое знакомство с SAS-2 имеет смысл начать с недорогого (около 300 долл.) и достаточно простого, то есть HBA (Host Bus Adapter) 8-портового контроллера компании LSI Corporation (www.lsi.com).

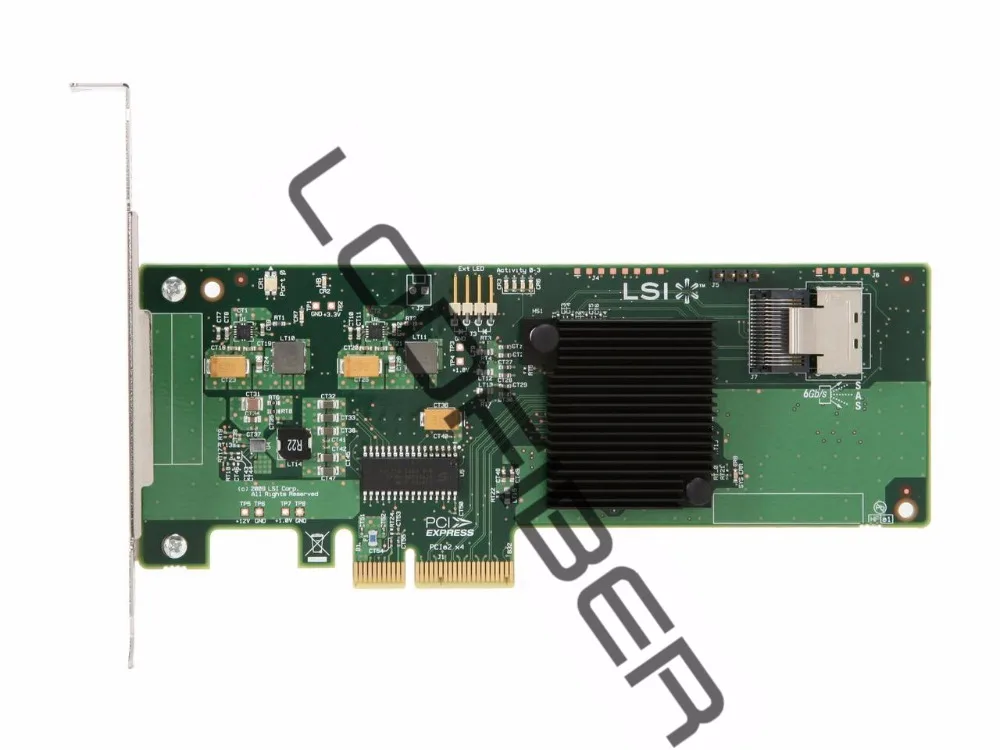

8-портовый HBA-контроллер LSI SAS 9211-8i с интерфейсом SAS 6 Гбит/с

LSI SAS 9211-8i не имеет собственной кэш-памяти (если не принимать во внимание не больно-то емкие регистры HBA-чипа) и основан на чипе LSI SAS2008 (ядро PowerPC 440 с частотой 533 МГц; производительность до 290 тыс. операций ввода/вывода в секунду).

Процессор 8-портового HBA-контроллера LSI SAS 9211-8i

Плата LSI SAS 9211-8i имеет низкий профиль (форм-фактор MD2), оснащена двумя внутренними разъемами Mini-SAS 4X (каждый из них позволяет подключать до четырех SAS-дисков), рассчитана на шину PCI Express x8 2.0 и поддерживает простейшие RAID-массивы уровней 0, 1, 1Е и 10, а также динамическую функциональность SAS, включая dual-port drive redundancy, может работать в общей сложности с 256 физическими дисками SAS и SATA (свыше восьми — через порт-мультипликаторы) и мн. др.

8-портовый HBA-контроллер LSI SAS 9211-8i с интерфейсом SAS 6 Гбит/с

Контроллер LSI SAS 9211-8i можно устанавливать как в корпуса ATX и Slim-ATX (для рабочих станций), так и в рэковые серверы формата 1U и 2U (серверы классов Mid- и High-End). Поддержка RAID производится аппаратно — встроенным процессором LSI SAS2008, что снижает общую нагрузку на ЦП рабочей станции или сервера.

Поддержка RAID производится аппаратно — встроенным процессором LSI SAS2008, что снижает общую нагрузку на ЦП рабочей станции или сервера.

Контроллер LSI SAS 9211-8i: основные технические характеристики

| Параметр | Значение |

|---|---|

| Системный интерфейс | PCI Express x8 2.0 (5 Гбит/с), Bus Master DMA |

| Дисковый интерфейс | SAS-2 6 Гбит/с (поддержка протоколов SSP, SMP, STP и SATA) |

| Число портов SAS | 8 (2 разъема x4 Mini-SAS SFF8087) |

| Поддержка RAID | уровни 0, 1, 1E и 10 |

| Процессор | LSI SAS2008 (PowerPC 440@533 МГц), до 290 тыс. IOps |

| Встроенная кэш-память | отсутствует |

| Энергопотребление, не более | 13,5 Вт (питание от +12 В шины PCIe) |

| Диапазон температур работы/хранения | 0…+70 °С / −45…+105 °С |

| Форм-фактор, габариты | MD2 low-profile, 168×64,4 мм |

| Значение MTBF | >2 млн. ч ч |

| Гарантия производителя | 3 года |

В комплекте поставки в красочной коробке содержатся: плата контроллера, брекеты для ее установки в корпуса ATX, Slim-ATX и пр., два 4-дисковых кабеля с разъемами Mini-SAS на одном конце и обычным SAS (с питанием от Molex) — на другом (для подключения до восьми дисков к контроллеру), а также CD с PDF-документацией и драйверами для Windows, Linux (SuSE и RedHat), Solaris и VMware.

Тестирование

Для первого знакомства с HBA-контроллером нового интерфейса мы решили воспользоваться одиночными дисками SAS-2 и SATA Rev. 3, поддерживающими скорость передачи данных до 6 Гбит/с. Это позволит нам сосредоточиться на анализе интерфейса в чистом виде, оставив «заморочки» с RAID различных уровней на будущее. Первым диском с поддержкой SAS-2 в нашей лаборатории оказался накопитель Toshiba MBF2600RC компактного форм-фактора 2,5 дюйма, но при этом отнюдь не маленькой емкости — 600 ГБ.

Жесткий диск Toshiba MBF2600RC емкостью 600 ГБ с интерфейсом SAS-2

При скорости вращения пластин около 10000 об/мин и восьми головках (в тонком корпусе диска размещается аж четыре магнитных пластины) данный накопитель имеет весьма малое время случайного доступа (около 7 мс, что вдвое лучше, чем у типичных десктопных SATA-накопителей) и предназначен для малогабаритных высокопроизводительных хранилищ данных (в линейке Toshiba MBF2-RC присутствуют также модели на 450 и 300 ГБ). По сравнению с непосредственными предшественниками новинки отличаются не только вдвое большей вместимостью и скоростью интерфейса — в них также заметно улучшена экономичность благодаря применению специальной технологии. В частности, в моменты бездействия вращение пластин диска замедляется и энергопотребление падает на 28%. Заявленные 4,5 Вт в режиме ожидания сравнимы с энергопотреблением экономичных 3,5-дюймовых SATA-накопителей емкостью 1—2 ТБ со скоростью вращения пластин 5-6 тыс. об/мин. Хотя по нынешним временам кэш-память этого диска не очень велика — 16 МБ, — это не является недостатком, поскольку накопители данного класса предназначены преимущественно для задач последовательного чтения и записи информации, например, в системах хранения мультимедийного контента.

По сравнению с непосредственными предшественниками новинки отличаются не только вдвое большей вместимостью и скоростью интерфейса — в них также заметно улучшена экономичность благодаря применению специальной технологии. В частности, в моменты бездействия вращение пластин диска замедляется и энергопотребление падает на 28%. Заявленные 4,5 Вт в режиме ожидания сравнимы с энергопотреблением экономичных 3,5-дюймовых SATA-накопителей емкостью 1—2 ТБ со скоростью вращения пластин 5-6 тыс. об/мин. Хотя по нынешним временам кэш-память этого диска не очень велика — 16 МБ, — это не является недостатком, поскольку накопители данного класса предназначены преимущественно для задач последовательного чтения и записи информации, например, в системах хранения мультимедийного контента.

Жесткий диск Toshiba MBF2600RC: основные технические характеристики

| Параметр | Значение |

|---|---|

| Форматированная емкость | 600 млрд. байт |

| Число пластин/головок | 4/8 |

| Скорость вращения пластин | 10 025 об/мин |

| Среднее время поиска, чтение/запись | 4 мс / 4,4 мс |

| Латентность вращения | 2,99 мс |

| Интерфейс | SAS 2. 0, 6 Гбит/с 0, 6 Гбит/с |

| Стартовый ток, не более | 1,5 А для +12 В и 1,0 А для +5 В |

| Потребление в бездействии, не более | 4,5 Вт |

| Диапазон температур работы/хранения | +5… +55 °С / -40… +70 °С |

| Емкость кэш-памяти | 16 МБ |

| Акустический шум вращения | 29 дБА |

| Ударостойкость, работа/хранение | 100 g (1 мс) / 400 g (1 мс) |

| Габариты, масса | 100×70×15 мм, 220 г |

Максимальная скорость последовательного чтения/записи полезных данных для Toshiba MBF2600RC составляет около 150 МБ/с (см. график).

График скорости последовательного чтения диска Toshiba MBF2600RC

Безусловно, это гораздо меньше предельных возможностей интерфейса SAS даже первого поколений (3 Гбит/с; около 270 МБ/с по полезным данным), уже не говоря о SAS-2. Тем не менее, благодаря более быстрому случайному доступу и профессиональным алгоритмам кэширования в буфере SAS-диска мы можем надеяться на то, что выгода от подключения этого диска к более скоростному интерфейсу будет более заметна, чем в случае с ранее исследованной нами Seagate Barracuda XT ST32000641AS — первым диском для интерфейса SATA 6 Гбит/с. Впрочем, поскольку последний также поддерживается контроллерами SAS-2 (и LSI SAS 9211-8i в частности), его мы также включили в наше тестирование.

Впрочем, поскольку последний также поддерживается контроллерами SAS-2 (и LSI SAS 9211-8i в частности), его мы также включили в наше тестирование.

Диск Toshiba MBF2600RC мы испытывали при подключении к двум контроллерам: к LSI SAS 9211-8i по интерфейсу SAS-2 (6 Гбит/с) и к HighPoint RocketRAID 2642 по SAS 1.0 (3 Гбит/с). Дело в том, что в настройках BIOS Setup контроллера LSI SAS 9211-8i не предусмотрено пункта принудительного перевода портов SAS на скорость первого поколения интерфейса — 3 Гбит/с. Поэтому для сравнения двух скоростей SAS нам и пришлось привлечь другой HBA SAS-контроллер примерно той же ценовой категории (вышеназванный HPT RR2642 на популярном чипе Marvell 88SE6445 для шины PCI Express x4). Безусловно, это не является сравнением двух скоростей SAS в чистом виде (на одном и том же контроллере), что было бы полезно с чисто теоретической точки зрения, однако практический смысл имеет немалый, поскольку сопоставляет производительность диска SAS, подключенного к HBA-контроллерам сходного класса производительности старого и нового интерфейсов.

Кроме того, поскольку с HBA-контроллером LSI SAS 9211-8i на практике могут использоваться и SATA-накопители (как одно из целевых применений), мы протестировали его с «семитысячником» Seagate Barracuda XT ST32000641AS, также поддерживающим скорость интерфейса 6 Гбит/с. Для сопоставления Barracuda XT была также протестирована на скорости интерфейса 3 Гбит/с с двумя простыми RAID-контроллерами — вышеупомянутым 4-портовым SAS HighPoint RocketRAID 2642 и 6-портовым SATA, интегрированным в южный мост Intel ICh20R. Это также позволит нам сравнить производительность одного из самых быстрых нынче «семитысячников» на разных популярных контроллерах и скоростях интерфейса.

Тестовая система была основана на процессоре Intel Xeon 3110, материнской плате с чипсетом Intel P45 и 1 ГБ памяти DDR2-800. SAS-контроллеры устанавливались в слот PCI Express x16. Испытания проводились под управлением операционных систем Windows 7 x64 Ultimate и Windows XP SP3 Professional. В качестве тестов использовались программы AIDA64, ATTO Disk Benchmark 2. 41, C’T h3BenchW 4.13, Futuremark PCMark05, Futuremark PCMark Vantage x64, Intel IOmeter 2006, Intel NAS Performance Toolkit 1.7 и др. Все тесты проводились пятикратно и результаты усреднялись. По сравнению с текущей методикой нашего сайта, предназначенной для тестирования десктопных SATA-накопителей, мы здесь добавили определенный круг задач, чтобы лучше выявить разницу между контроллерами и интерфейсами и более разносторонне представить производительность накопителей и контроллеров в приложениях — как профессиональных, так и пользовательских.

41, C’T h3BenchW 4.13, Futuremark PCMark05, Futuremark PCMark Vantage x64, Intel IOmeter 2006, Intel NAS Performance Toolkit 1.7 и др. Все тесты проводились пятикратно и результаты усреднялись. По сравнению с текущей методикой нашего сайта, предназначенной для тестирования десктопных SATA-накопителей, мы здесь добавили определенный круг задач, чтобы лучше выявить разницу между контроллерами и интерфейсами и более разносторонне представить производительность накопителей и контроллеров в приложениях — как профессиональных, так и пользовательских.

Результаты тестирования

Сперва взглянем на «физику» дисков. Оба имеют максимальную скорость чтения/записи полезных данных на пластины около 150 МБ/с, о чем наглядно говорят результаты теста ATTO Disk Benchmark на предельную скорость чтения и записи крупных (256 МБ) файлов большими блоками.

Немного разные результаты этого теста для разных контроллеров объясняются различиями в обработке и кэшировании потоковых данных. Отметим слабость SAS-контроллера HPT RR2642 при работе с SATA-диском (ниже мы убедимся в этом еще неоднократно), хотя с SAS-диском претензий к нему практически нет. Контроллер LSI SAS 9211-8i демонстрирует здесь почти эталонную работу (несколько уступив лишь интеловскому «южнику» с SATA-диском) — возможно, дело как раз в более высокой скорости интерфейса 6 Гбит/с. График скорости последовательного чтения для Toshiba MBF2600RC мы приводили чуть выше, а результаты для Seagate ST32000641AS можно найти здесь.

Отметим слабость SAS-контроллера HPT RR2642 при работе с SATA-диском (ниже мы убедимся в этом еще неоднократно), хотя с SAS-диском претензий к нему практически нет. Контроллер LSI SAS 9211-8i демонстрирует здесь почти эталонную работу (несколько уступив лишь интеловскому «южнику» с SATA-диском) — возможно, дело как раз в более высокой скорости интерфейса 6 Гбит/с. График скорости последовательного чтения для Toshiba MBF2600RC мы приводили чуть выше, а результаты для Seagate ST32000641AS можно найти здесь.

По среднему времени случайного доступа к информации на дисках закономерно более чем вдвое выигрывает SAS-десятитысячник Toshiba. Причем здесь на контроллере LSI результаты оказываются несколько хуже, чем на хосте HighPoint — возможно, «набегает» латентность от более активного кэширования данных, которое положительно сказалось на результатах потокового чтения/записи (см. выше).

Интересно, что несмотря на вчетверо меньший объем дисковой кэш-памяти у Toshiba MBF2600RC (16 против 64 МБ у Seagate ST32000641AS), эффективность работы алгоритмов отложенной записи при случайных обращениях (определяемое нами по отношению результатов этого теста при чтении и записи) у профессионального SAS-диска существенно выше, чем у десктопного SATA-накопителя — сказывается специфика оптимизации его firmware. Аналогичные результаты получены нами в программах IOmeter и AIDA64.

Аналогичные результаты получены нами в программах IOmeter и AIDA64.

Теперь о «вкусном» — о скорости самого интерфейса, коль уж мы сравниваем диски и контроллеры при работе по SAS/SATA 3 и 6 Гбит/с. Этот параметр мы измеряли в нескольких программах и здесь демонстрируем результаты для трех из них — AIDA64, HD Tach 3 RW и h3BenchW 4.13.

Как видим, разные утилиты дают порой существенно различающиеся предельные значения скорости интерфейса при чтении. Тем не менее, с уверенностью можно сказать, что 6 Гбит/с работают — и работают при этом не так уж плохо, хотя наблюдаемых в некоторых лабораториях значений в 500 и выше МБ/с мы пока и не получили. Впрочем, и текущих 340-480 МБ/с более чем достаточно для нужд одиночных дисков (как, впрочем, и 250 МБ/с у интерфейсов с 3 Гбит/с). Снова отметим некоторую «заторможенность» HPT RR2642 при работе с SATA-диском, хотя по SAS к нему претензий нет.

Теперь перейдем к тестам производительности дисков в различных пользовательских задачах, которые эмулируются при помощи бенчмарков Intel NASPT, PCMark Vantage и PCMark05, а также тестом приложений из пакета C’T h3BenchW 4. 13. Чтобы не перегружать верстку статьи многочисленными диаграммами, мы здесь приведем лишь усредненные показатели для этих четырех комплексных бенчмарков, а результаты по отдельным паттернам каждого из бенчмарков, также представляющие определенный интерес для анализа, сведем в таблицу.

13. Чтобы не перегружать верстку статьи многочисленными диаграммами, мы здесь приведем лишь усредненные показатели для этих четырех комплексных бенчмарков, а результаты по отдельным паттернам каждого из бенчмарков, также представляющие определенный интерес для анализа, сведем в таблицу.

В популярном PCMark Vantage, ориентированном на типичные применения персонального компьютера, несколько выгоднее смотрится SATA-диск Seagate (у него более эффективна работа с данными, распложенными на пластинах близко друг от друга). Выгоды от использования интерфейсов на скорости 6 Гбит/с здесь практически нет — скорее даже небольшой проигрыш, который, впрочем, легко объяснить более прозаическими причинами: особенностями работы того или иного контроллера (в данном случае HighPoint RR2642 всем дает фору). Если взглянуть на таблицу по паттернам, то видно, что с SAS-диском оба контроллера идут ноздря в ноздрю, а с SATA-винчестером контроллер LSI вырывается вперед в задаче Media Center, но немного отстает в Photo Gallery, Vista Startup, Movie Maker и Media Player.

Чуть иная картинка в стареньком PCMark05: тут LSI на диске SAS вырывается вперед, хотя на поверку «виноват» в этом лишь один паттерн (Virus Scan, который активно использует кэширование, что отлично видно из результата, явно превышающего скорость физического доступа к пластинам как для SAS, так и для SATA-дисков). То есть мы находим подтверждение более активного использования кэширования контроллером LSI SAS 9211-8i. С другой стороны, это несколько снижает его показатели в других тестовых паттернах PCMark05 по сравнению с контроллерами HPT RR2642 и Intel ICh20R.

Особо отметим высокий показатель «южника» Intel в этом тесте (хотя шина DMI, по которой он общается с системой, и не превосходит по скорости PCI Express x4/x8 у обоих SAS-контроллеров) — для персональных применений дисков «южник», видимо, оптимален.

Еще один «трековый» тест дисков — C’T h3BenchW 4.13 — использует достаточно старенькую базу приложений, хотя и оригинальных (см. табл.). Здесь на удивление SAS-диск оказался ниже всякой критики — спишем это на особенности бенчмарка, который, по-видимому, очень критичен к разнице в объеме буфера диска 16 и 64 МБ. Нас в данном случает интересует лишь то, что интерфейсы со скоростью 6 Гбит/с снова не дают дискам никакого заметного выигрыша в производительности, а разница показателей объясняется различиями алгоритмов работы самих контроллеров (снова отметим прыть ICh20R и отставание LSI при работе с SATA).

Нас в данном случает интересует лишь то, что интерфейсы со скоростью 6 Гбит/с снова не дают дискам никакого заметного выигрыша в производительности, а разница показателей объясняется различиями алгоритмов работы самих контроллеров (снова отметим прыть ICh20R и отставание LSI при работе с SATA).

В более свежем тесте Intel NAS Performance Toolkit, который использует несколько иную, более реалистичную, философию бенчмаркинга, нежели «трековые» PCMark и h3BenchW, а именно: непосредственную работу с файловой системой тестируемого диска, а не воспроизведение заранее записанных (в другой системе) команд обращения к диску внутри предварительно созданного временного файла, — ситуация еще более любопытная.

Здесь контроллер LSI (и его 6-гигабитный интерфейс) явно не в фаворитах. И если с SAS отставание в среднем в 5—6% еще не фатально (особенно страдают паттерны с записью на диск — HD Video Record, Content Creation и File/Dir Copy to NAS), то для SATA проигрыш просто фатальный, что можно списать только на недоработки firmware этого контроллера. Зато радуют показатели HPT RR2642, причем не только для SAS, но и для SATA-диска.

Зато радуют показатели HPT RR2642, причем не только для SAS, но и для SATA-диска.

Напоследок для особо пытливых в качестве бонуса (и вне общего зачета) приведем результаты старенького теста приложений WinBench 99 Disk WinMark. Интересен он прежде всего тем, что многие его паттерны в большой степени зависят от кэширования буфером самого диска.

И здесь SATA-накопитель с буфером 64 МБ демонстрирует заметное преимущество, а контроллер LSI, невзирая на вдвое более высокую скорость работы интерфейса, смотрится явным аутсайдером. В лидеры же выходит HPT RR2642 с его «более прозрачными» по отношению к диску алгоритмами работы.

Чтобы подытожить эту часть обзора, приведем усредненный показатель производительности дисков/контроллеров в приложениях (среднее геометрическое по тестам h3BenchW, PCMark05, PCMark Vantage x64 и NAS Performance Toolkit).

Как видим, непосредственной (потребительской) выгоды от применения более скоростного интерфейса 6 Гбит/с с современными одиночными магнитными винчестерами SAS и SATA нет, а разница между контроллерами объясняется скорее алгоритмами их функционирования (архитектурой, прошивкой и драйверами).

Тесты в Intel IOmeter

Отдельную часть нашего обзора посвятим тестам в пакете IOmeter, поскольку они помогут понять некоторые тонкости работы исследуемых интерфейсов, дисков и контроллеров. Для этого мы воспользуемся стандартными серверными паттернами DataBase, File Server и Web Server (более показательными в случае SAS-дисков), а также паттернами на чтение и запись крупных (0,5 МБ) и мелких файлов с очередью команд 1, 4, 16 и 64. Для начала (и в качестве альтернативы предыдущей диаграмме) приведем усредненное значение производительности дисков/контроллеров в этих семи паттернах (геометрически по всем очередям команд всех паттернов с весом 1).

Справедливость, наконец, торжествует — серверный диск Toshiba MBF2600RC более чем вдвое опережает настольный Seagate ST32000641AS с той же линейной скоростью чтения/записи. Более того, налицо положительная разница от применения контроллера LSI SAS 9211-8i с 6-гигабитным интерфейсом. Посмотрим, из чего же складывается этот успех?

В паттерне базы данных с обращениями блоками по 8 КБ для SAS-диска на обоих контроллерах наблюдается полное равенство при очередях команд 1, 4 и 16 с почти линейной зависимостью производительности от глубины очереди. И лишь при очереди 64 контроллер LSI продолжает линейный рост, тогда как для HPT RR2642 виден выход на насыщение — чип Marvell уже не справляется с обработкой такого потока запросов. Более того, для SATA-случая контроллер HPT при неединичной глубине очереди команд вообще демонстрирует заметно более низкую производительность, чем чипы LSI и Intel (последние два здесь примерно равноценны). Это похоже на ситуацию, когда RR2642 не использует NCQ при работе с SATA-диском.

И лишь при очереди 64 контроллер LSI продолжает линейный рост, тогда как для HPT RR2642 виден выход на насыщение — чип Marvell уже не справляется с обработкой такого потока запросов. Более того, для SATA-случая контроллер HPT при неединичной глубине очереди команд вообще демонстрирует заметно более низкую производительность, чем чипы LSI и Intel (последние два здесь примерно равноценны). Это похоже на ситуацию, когда RR2642 не использует NCQ при работе с SATA-диском.

В паттернах File Server и Web Server эта тенденция сохраняется: с SAS-диском контроллер HPT «затыкается» на очередях выше 16, тогда как мощный процессор LSI, как тот заяц, продолжает «работать и работать». В этих серверных паттернах более чем двухкратное преимущество диска Toshiba MBF2600RC над Seagate ST32000641AS по скорости случайного доступа напрямую выливается в 2—3-кратный выигрыш в серверной производительности. Даже несмотря на то, что накопители класса Toshiba MBF2600RC предназначены преимущественно для задач последовательного чтения и записи информации в соответствующих серверах и системах хранения данных (это все же не ультрарезвые 3,5-дюймовые 15-тысячники).

Еще более любопытная картинка — в паттернах чтения и записи крупных (полумегабайтных) файлов (или блоков) случайным образом в пределах всего объема диска.

Если при единичной глубине очереди команд диски Toshiba MBF2600RC и Seagate ST32000641AS не сильно различаются по быстродействию, то уже при глубине очереди, равной четырем, производительность SAS-модели возрастает почти вдвое, тогда как у SATA — остается на прежнем уровне. При дальнейшем увеличении глубины очереди SAS-система сохраняет достигнутый при QD=4 уровень производительности (причем, одинаково эффективно для обоих протестированных нами SAS-контроллеров), тогда как SATA-система начинает заметно тормозить! Впрочем, тут есть одно исключение — если с SATA-диском используется контроллер HPT RR2642, то скорость системы не падает с ростом глубины очереди — это своеобразная реабилитация чипа Marvell после проигрыша в серверных паттернах.

А вот при случайном чтении и записи мелких файлов в пределах всего объема диска мы видим смешанную картину. С одной стороны, при чтении она отчасти напоминает ситуацию в серверных паттернах — насыщение контроллера HPT при QD=64, его индифферентность к глубине очереди с SATA-диском (здесь хост-контроллер Intel даже обходит мощный процессор LSI). А с другой — при записи за счет эффективного кэширования производительность на мелких файлах в 1,5—2 раза опережает таковую при случайном чтении таких же файлов и динамика от глубины очереди сходна с таковой при работе этих систем c крупными файлами. За исключением того, что производительность всех трех контроллеров с SATA-диском практически не меняется от глубины очереди команд (и почти втрое ниже таковой у SAS-диска).

С одной стороны, при чтении она отчасти напоминает ситуацию в серверных паттернах — насыщение контроллера HPT при QD=64, его индифферентность к глубине очереди с SATA-диском (здесь хост-контроллер Intel даже обходит мощный процессор LSI). А с другой — при записи за счет эффективного кэширования производительность на мелких файлах в 1,5—2 раза опережает таковую при случайном чтении таких же файлов и динамика от глубины очереди сходна с таковой при работе этих систем c крупными файлами. За исключением того, что производительность всех трех контроллеров с SATA-диском практически не меняется от глубины очереди команд (и почти втрое ниже таковой у SAS-диска).

Отдельно отметим, что все эти паттерны практически не выявили никаких преимуществ между системами от применения более скоростного интерфейса 6 Гбит/с — разница либо отсутствует вовсе, либо объясняется собственно архитектурой и алгоритмами работы использованных хост-контроллеров.

Ценовая информация

8-портовый SAS-контроллер LSI SAS 9211-8i с полным комплектом предлагается по цене в районе 300 долларов, что можно считать весьма привлекательным. Четырехпортовый аналог — LSI SAS 9211-4i — стоит еще дешевле. Более точная текущая средняя розничная цена устройства в Москве, актуальная на момент чтения вами данной статьи:

Четырехпортовый аналог — LSI SAS 9211-4i — стоит еще дешевле. Более точная текущая средняя розничная цена устройства в Москве, актуальная на момент чтения вами данной статьи:

| LSI SAS 9211-8i | LSI SAS 9211-4i |

|---|---|

| $280(25) | $206(30) |

Итак, новый интерфейс SAS 2.1 со скоростью передачи данных 6 Гбит/с и новыми зонирующими функциями в этом году начал уверенно завоевывать рынок. Все новые модели SAS-дисков этого года поддерживают именно эту версию интерфейса, хотя прекрасно работают и с контроллерами SAS-1. В продажу начали поступать и контроллеры для SAS-2. И один из первых таких девайсов в лице недорогого 8-портового Host-Bus-адаптера LSI SAS 9211-8i оказался весьма неплохим продуктом, способным работать на скорости 6 Гбит/с как с SAS-, так и SATA-дисками. Некоторые недостатки нового процессора LSI SAS2008 (особенно при работе с SATA) в задачах потребительского класса с лихвой компенсируются его высокой производительностью на серверных нагрузках при большой глубине команд.

Вместе с тем, можно констатировать, что для одиночных жестких дисков даже SAS-класса применение скорости 6 Гбит/с пока что явно избыточно и не приносит никаких дивидендов по сравнению с 3 Гбит/с. Впрочем, использованный здесь нами SAS-десятитысячник Toshiba MBF2600RC — это не самый топовый диск, и применение более резвых 3,5-дюймовых SAS-накопителей со скоростью вращения шпинделя 15 тыс. об/мин, скоростью чтения/записи пластин свыше 200 МБ/с и буфером 64 МБ, возможно, поможет выявить хоть какое-то положительное влияние удвоение полосы пропускания интерфейса. И, безусловно, преимущества от новой скорости интерфейса следует искать в многодисковых конфигурациях. А новые функции зонирования в SAS-2 позволят сделать многодисковые SAS-системы еще более удобными и гибкими в использовании.

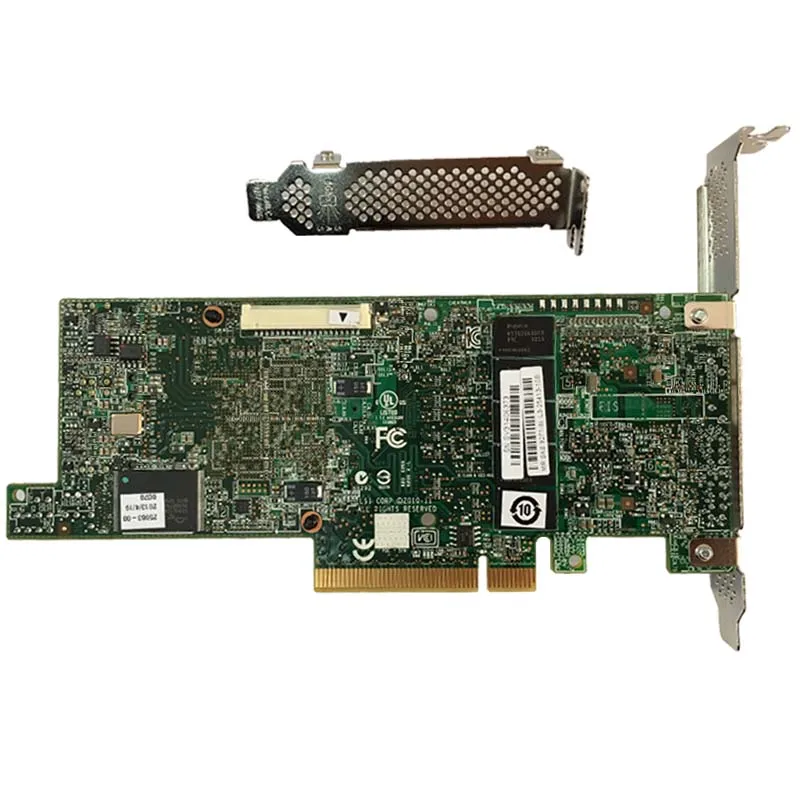

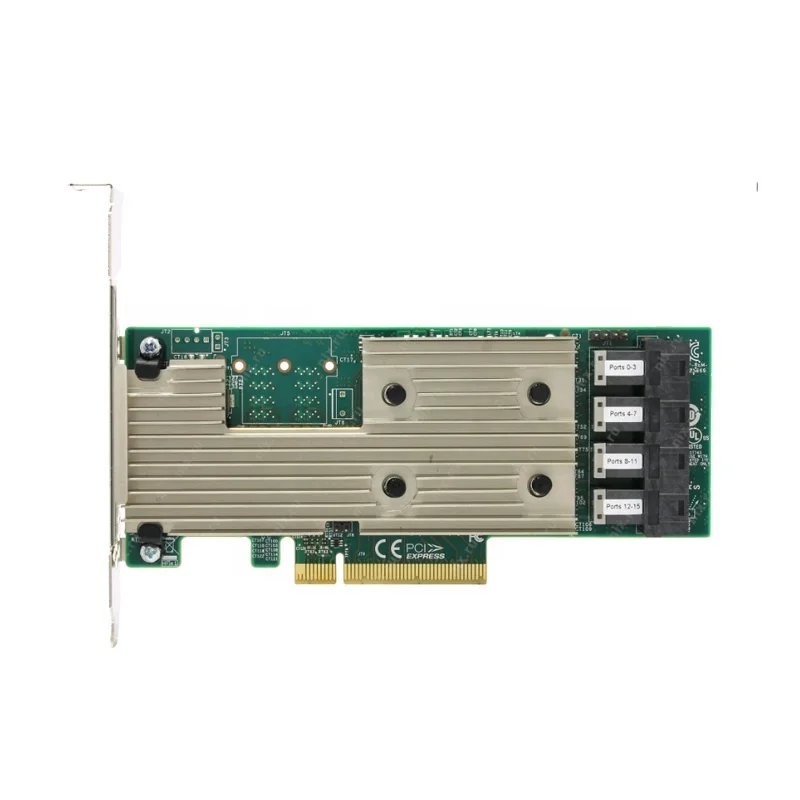

LSI MegaRAID SAS 9361-8i — 12Gb/s SAS/SATA контроллер

- 4 июня 2022

Ещё не сильно древний контроллер 2018 года для серверов и хранилищ данных. Первый с интерфейсом SAS.

Первый с интерфейсом SAS.

Стремительный рост объёма данных в ЦОД обуславливает потребность в высокоскоростных интерфейсах для передачи данных. Вот и Broadcom выпускает на рынок контроллер с поддержкой интерфейса SAS, обеспечивающий передачу данных со скоростью 12 Gb/s, увеличивая производительность вдвое. Аплодисменты.

Одна плата контроллера полностью утилизирует слот PCI Express 3.0. MegaRAID SAS 9361-8i с восемью внутренними портами оснащён двумя процессорными ядрами PowerPC с частотой 1.2 ГГц, 72-разрядным интерфейсом DDR3 с 2 ГБ кэш-памяти. Контроллер работает на базе SAS3108 RAID-on-Chip (ROC), греется как утюг, ничего нового, при сборке сервера уделите особое внимание охлаждению. Сам контроллер с пассивным охлаждением.

Поддерживаются массивы RAID0, RAID1, RAID10, RAID5, RAID6, RAID50, RAID60. Модуль защиты флэш-кэша CacheVault еще больше усиливает возможности защиты данных MegaRAID SAS 9361-8i.

В контроллере реализована новая технология диагностики дисков. Физический накопитель при сбое переводится в состояние защиты (shield), контроллер запускает диагностику диска, чтобы определить, действительно ли накопитель вышел из строя или может быть восстановлен. Это экономит диски, деньги, время и нервы.

Физический накопитель при сбое переводится в состояние защиты (shield), контроллер запускает диагностику диска, чтобы определить, действительно ли накопитель вышел из строя или может быть восстановлен. Это экономит диски, деньги, время и нервы.

Семейство контроллеров MegaRAID SAS поддерживает расширенные программные опции Broadcom, обеспечивающие повышенную производительность и защиту данных. CacheCade Pro 2.0 (опционально) и MegaRAID Fast Path (в комплекте) повышает производительность транзакционного ввода-вывода твердотельных накопителей. А SafeStore обеспечивает повышенную защиту и безопасность данных при работе с устройствами, поддерживающими шифрование.

Низкопрофильная планка в комплекте.

Ссылки

Product Brief

Quick Installation Guide

MegaRAID 93XX 12GB/S SAS storage adapter drive compatibility report selection GUID

CVM02, CVPM02, and CVPM05

Ключевые функции

- Интерфейс SAS, обеспечивающий передачу данных со скоростью 12 Gb/s.

- Поддержка до 128 дисков SAS 12 Gb/s, SATA 6 Gb/s и 3 Gb/s.

- 8 внутренних портов SAS/SATA, это два mini-SAS SFF8643 внутренних коннектора (горизонтальное расположение).

- Контроллер SAS3108: 1.2 GHz PowerPC 476 dual-core 12 Gb/s ROC.

- PCI Express 3.0.

- Опционально кэш:

- 1 GB 1866 MHz DDR3 SDRAM

- 2 GB 1866 MHz DDR3 SDRAM

- RAID 0, 1, 5, 6, 10, 50 и 60.

- Опционально CacheVault CVM02.

Характеристики

- Общие

- Модель: MegaRAID SAS 9361-8i

- Опция: CacheVault Flash Module (LSICVM02) – включает CVFM04, CVPM02, крепление и кабель

- Контроллер: SAS3108 12 Gb/s dual-core ROC

- Спецификация

- Cache Memory: 1 GB 1866 MHz DDR3 SDRAM или 2 GB 1866 MHz DDh4 SDRAM

- Cache Protection: CacheVault

- Поддерживаемые устройства: SAS/SATA 12 Gb/s, 6 Gb/s, 3 Gb/s: 128

- Размеры: MD2 low profile (6.6 in. × 2.536 in.)

- Разъёмы: два mini-SAS SFF8643 (горизонтальное расположение)

- Тип шины: x8 lane PCI Express 3.

0 compliant

0 compliant - Скорость передачи данных: до 12 Gb/s на порт

- Рабочая температура: от 0 °C до 55 °C

- Рабочее напряжение: +3.3V, +12V

- Гарантия: 3 года

- Наработка на отказ (MTBF): 1343187 часов

- ПО

- MegaRAID Storage Manager

- StorCLI (command-line interface)

- CTRL-R (BIOS configuration utility)

- HII (UEFI Human Interface Infrastructure)

- SSD оптимизация

- MegaRAID CacheCade Pro 2.0 Software leverages SSDs in front of HDD volumes to create high-capacity, high-performance controller cache pools (Optional Upgrade). Ключ LSI00290 приобретается отдельно.

- MegaRAID Fast Path Software provides high-performance I/O acceleration for SSD arrays connected to 6 Gb/s MegaRAID SATA+SAS controllers (Included)

- RAID опции

- RAID levels 0, 1, 5, and 6

- RAID spans 10, 50, and 60

- Online Capacity Expansion (OCE)

- Online RAID Level Migration (RLM)

- Auto resume after loss of system power during array rebuild or reconstruction (RLM)

- Single controller Multipathing

- Load Balancing

- Configurable stripe size up to 1 MB

- Fast initialization for quick array setup

- Check Consistency for background data integrity

- SSD Support with SSD Guard™ technology

- Patrol read for media scanning and repairing

- 64 logical drive support

- DDF compliant Configuration on Disk (COD)

- S.

M.A.R.T. support

M.A.R.T. support - Global and dedicated Hot Spare with Revertible Hot Spare support

- Automatic rebuild

- Enclosure affinity

- Emergency SATA hot spare for SAS arrays

- Enclosure management

- SES (inband)

- SGPIO (sideband)

- Databolt bandwidth optimizer technology support for compatible expander-based enclosures

- Shielded state drive diagnostic technology

- Артикулы:

- MegaRAID SAS 9361-8i (Single Pack, 1 GB Option): MPN: 05-25420-08

- MegaRAID SAS 9361-8i (Single Pack, 2 GB Option): MPN: 05-25420-17

- LSICVM02 CacheVault Kit: MPN: 05-25444-00

Поддерживаемые ОС

- Windows 10, 8.1, 8

- Windows Server 2019, 2016, 2012 R2, 2012

- Ubuntu 18.04 LTS, 16.04.5 LTS, 16.04.3 LTS, 16.04.2 LTS, 16.04.1 LTS

- CentOS 7.6, 7.5, 7.4, 6.10, 6.9

- RedHat Enterprise Linux 8.0, 7.6, 7.5, 7.

4, 7.3, 6.10, 6.9, 6.8, 6.7

4, 7.3, 6.10, 6.9, 6.8, 6.7 - SuSE Linux Enterprise Server 12 SP3, 12 SP2, 12 SP1

- Citrix XenServer 7.6, 7.5, 7.4, 7.1

- Sun Solaris 11, 10

- VMware ESXi 6.7, 6.5, 6.0

Опция LSICVM02 (CVM02)

Набор LSI CacheVault Module 02 (LSICVM02 или CVM02) Kit содержит:

- MegaRAID CacheVault Flash Module 04 (CVFM04)

- MegaRAID CacheVault Power Module 02 (CVPM02)

- крепление

- кабель

- инструкцию по установке

Дополнительно вам может потребоваться приобрести крепеж для батареи аварийного питания LSI BBU-BRACKET-05, он продаётся отдельно.

CVFM04 — это флеш модуль Open NAND Flash Interface (ONFI). Флешка, на которую сбрасываются данные контроллера, когда сервер теряет питание или падает с ошибкой.

- J1 – 9-pin Connector to the Remote CVPM02 Module

- J2 – 80-pin Board-to-Board Connector

CVPM02 — это блок суперконденсаторов, который обеспечивает энергией контроллер в процессе сброса данных из оперативной DRAM памяти на FLASH память модуля CVFM04. Когда основное питание снова подаётся на RAID контроллер, то происходит обратный процесс переноса данных из FLASH в DRAM, а затем контроллер может записать данные на диски сервера.

Когда основное питание снова подаётся на RAID контроллер, то происходит обратный процесс переноса данных из FLASH в DRAM, а затем контроллер может записать данные на диски сервера.

Принцип подключения прост. Выключаем сервер, извлекаем RAID контроллер из сервера. Работаем с заземлением, чтобы избежать статического электричества. Устанавливаем модуль CVFM04 непосредственно на контроллер, FLASH модуль фиксируется двумя винтами.

На крепеж для батареи аварийного питания LSI BBU-BRACKET-05 устанавливаем крепление батареи. Крепление фиксируется тремя винтами.

В крепление устанавливаем блок суперконденсаторов CVPM02.

Соединяем кабелем CVPM02 с CVFM04.

Устанавливаем RAID контроллер в PCIe слот сервера.

Устанавливаем крепеж для батареи аварийного питания в сервер. Под крепёж используем свободный PCIe слот.

Если в сервере нет свободных слотов PCIe под крепеж, то блок суперконденсаторов без крепления можно установить в свободный дисковый отсек внутрь дисковой заглушки. Если и диска нет, то блок суперконденсаторов можно закрепить подручными средствами в свободном месте корпуса сервера так, чтобы он не соприкасался с деталями, я умудрялся крепить два блока между фронтальными вентиляторами.

Если и диска нет, то блок суперконденсаторов можно закрепить подручными средствами в свободном месте корпуса сервера так, чтобы он не соприкасался с деталями, я умудрялся крепить два блока между фронтальными вентиляторами.

CacheVault CVPM02 для контроллера MegaRAID SAS 9380-8i8e

Перегрев контроллера

Как я уже писал ранее, контроллеры LSI очень любят греться, так что охлаждению в серверах стоит уделить большое внимание. По спецификации рабочая температура контроллера от 0 °C до 55 °C. Как добиться такой температуры в серверах Supermicro, я даже и не знаю.

У меня уже был печальный опыт использования RAID контроллеров LSI в 4-юнитовом сервере Supermicro. Там один контроллер нагрелся до 92°C, а второй — до 107°C.

Перегрев RAID контроллера LSI в сервере Supermicro

Контроллер LSI MegaRAID SAS 9361-8i я также планирую использовать в 4-юнитовом сервере Supermicro. Наученный горьким опытом я с самого начала разогнал вентиляторы на максимум.

Supermicro — управление вентиляторами

В BMC Supermicro имеется 4 режима работы вентиляторов:

- Standard

- Зона 0 — в зависимости от температуры CPU вентиляторы вращаются на 50%.

- Зона 1 — в зависимости от температуры PCH вентиляторы вращаются на 50%.

- Зона 0 — в зависимости от температуры CPU вентиляторы вращаются на 50%.

- Optimal

- Зона 0 — в зависимости от температуры CPU вентиляторы вращаются на 30%.

- Зона 1 — вентиляторы вращаются на 30%.

- Full

- Зона 0 — вентиляторы вращаются на 100%.

- Зона 1 — вентиляторы вращаются на 100%.

- Heavy IO

- Зона 0 — в зависимости от температуры CPU вентиляторы вращаются на 30%.

- Зона 1 — вентиляторы вращаются на 75%.

Я установил Full, вентиляторы вращаются на 100%. Сервер работает уже несколько недель в таком режиме, можем полюбоваться на график температур за неделю. Видно, что температура чипа в районе 68 — 74 °C.

При этом датчик CacheVault отображает нормальную температуру 26 — 29 °C.

Если учесть, что показатель наработки на отказ (MTBF) в 1343187 часов рассчитан на работу контроллера при температуре 40 °С, то реальный срок службы контроллера в серверах Supermicro со средней температурой контроллера 70 °C будет значительно меньше.

Фотографии

Теги

- Avago

- Broadcom

- LSI

- hardware

- review

True System: SAS коммутатор LSI 6160. Часть 1: обзор и сценарии использования.

Если вы не слышали про замечательный продукт компании LSI — коммутатор 6Гбит SAS LSI SAS6160, то можно начать с сайта LSI.

Вкратце: еcли вы задумывались о создании SAN (сети хранения данных) небольшого масштаба (десятки серверов и СХД) и протяженности (в пределах 20-30 метров), но стоимость инфраструктуры FC или 10Гбит iSCSI вас останавливала — то вас выручит SAS.

До недавнего времени внешний SAS рассматривался исключительно как интерфейс для прямого (DAS) подключения одного-двух серверов к дисковой СХД или подключения JBOD-полки к внутреннему RAID-контроллеру в сервере. Со временем количество портов SAS на СХД начального уровня выросло до четырех на контроллер (например, в HP P2000 G3), что позволяет подключить до восьми серверов, а в dual-path подключении — до четырех. Что делать, если нужно больше? С гигабитным iSCSI может не хватить полосы пропускания, FC и 10Гбит iSCSI дороги: двухпортовый FC HBA стоит порядка $1500, свитчи начального уровня — от $4-5k (за $2-3k можно получить лишь что-нибудь типа 8-портового Qlogic 3000-й серии). Рекомендованная цена LSI 6160 — порядка $2500.

Что делать, если нужно больше? С гигабитным iSCSI может не хватить полосы пропускания, FC и 10Гбит iSCSI дороги: двухпортовый FC HBA стоит порядка $1500, свитчи начального уровня — от $4-5k (за $2-3k можно получить лишь что-нибудь типа 8-портового Qlogic 3000-й серии). Рекомендованная цена LSI 6160 — порядка $2500.

SAS коммутаторы как средство решения данной проблемы появились достаточно давно, уже несколько лет HP и IBM предлагают соответствующие решения для своих блейд-серверов. А в 2010 году произошло важное событие: на рынке появилось большое количество SAS-устройств, поддерживающих стандарт SAS-2. Помимо не всегда критичной большой полосы пропускания (6Гбит на один линк, а в SAS, например, при соединении двух экспандров формируется 4x транк с полосой 4×6=24Гбит), в SAS-2 было стандартизировано зонирование. Т.е. существовало оно и раньше (например, в тех же 3Гбит SAS свитчах HP для блейдов), но стандартом не являлось, и список поддерживаемых устройств был весьма ограничен: тот же самый HP 3Gb SAS Bl switch был предназначен, естественно, только для установки в blade-шасси, работал в сочетании с определенным контроллером, а в качестве СХД — либо JBOD MDS600, либо MSA2000 G2.

С появлением во второй половине 2010 года SAS коммутатора LSI 6160 построение больших топологий SAS стало доступно всем.

Зонирование нам дает важный функционал для создания больших SAS топологий: устройства SAS траслируют таблицу зонирования, т.е. список разрешенных комбинаций доступа для различных SAS-адресов в топологии. Формировать таблицу зонирования можно в экспандере, поддерживающем T10-зонирование SAS-2. Осталось лишь получить возможность этим зонированием как-то управлять — что и было сделано в LSI 6160.

| схема коммутатора LSI 6160 |

То есть SAS коммутатор от LSI построен на двух давно известных чипах LSI2x36, которые применяются, например в экспандерных бэкплейнах Supermicro. Экспандеры объединены в отказоустойчивую схему с разделяемой памятью и снабжены дополнительным контроллером, отвечающим за настройку зонирования.

Физически LSI 6160 представляет собой устройство в небольшом металлическом корпусе. На передней панели: разъем RJ-45 для управления коммутатором, 16 разъемов SFF-8088 (внешний 4x SAS), два из которых поддерживают подключение активных 20-метровых кабелей. Охлаждение — два 40мм вентилятора (через утилиту управления, SAS Domain Manager, можно следить за температурными датчиками и частотой вращения вентиляторов), питание — внешний БП «ноутбучного» форм-фактора.

Два коммутатора и блоки питания можно установить в специальный поддон для монтажа в стойку. Конструктив, возможно, не самый изящный, но вполне соответствует цене устройства. Начать можно с одного коммутатора, но настоятельно рекомендую как можно скорее перейти на отказоустойчивую конфигурацию с двумя коммутаторами, тем более, что все внешние SAS HBA имеют сейчас минимум два 4x порта.

Итак, сценарии использования:

- Подключение к SAS СХД нескольких серверов: от банального решения проблемы нехватки портов на самой СХД, до построения недорогой и быстрой SAN на чистом SAS: можно построить топологию с несколькими десятками серверов и СХД.

Стоит упомянуть о том, что зонирование ограничивает доступ на уровне физических линков (phy), индивидуальный доступ к LUN’ам настраивается средствами самой СХД. Об ограничениях по масштабированию я расскажу позже.

Стоит упомянуть о том, что зонирование ограничивает доступ на уровне физических линков (phy), индивидуальный доступ к LUN’ам настраивается средствами самой СХД. Об ограничениях по масштабированию я расскажу позже. - Разделяемый JBOD, т.е. дисковая полка не имеющая собственного RAID-контроллера. Если экспандер в JBOD’е поддерживает зонирование, то возможен следующий сценарий: покупаем относительно недорогой большой JBOD с двухсторонним размещением дисков от Supermicro, например SC417E16-RJBOD1 (88 SFF дисков в 4U) или SC847E1(/2)6-RJBOD1 (45 LFF дисков в 4U), один или два SAS коммутатора, SAS-2 RAID-контроллеры с внешними портами в каждый сервер — получаем возможность управлять распределением отдельных дисков между RAID-контроллерами разных серверов. Подобная схема, конечно, совершенно не подходит для задач, требующих разделяемого LUN’а* (например, vSphere кластер с VMFS), но является намного более эффективной по сравнению с использованием локальной дисковой подсистемы в каждом сервере.

Для зонирования отдельных дисков экспандер в JBOD’е должен поддерживать зонирование (являться т.н. «зонирующим экспандером»), в противном случае все диски автоматически унаследуют зон-группу самого экспандера, т.е. получится отдать только весь JBOD одному серверу целиком.

Для зонирования отдельных дисков экспандер в JBOD’е должен поддерживать зонирование (являться т.н. «зонирующим экспандером»), в противном случае все диски автоматически унаследуют зон-группу самого экспандера, т.е. получится отдать только весь JBOD одному серверу целиком.

*Обновление от 14.10.2013. Времена меняются, и утверждение «SAS JBOD — не для кластеров» уже теряет актуальность. С появлением поддержки Parity Spaces для Failover Cluster’а в Microsoft Windows Server 2012 R2 использование Storage Spaces для кластеров Microsoft становится вполне обоснованным. Для vSphere есть VSA и с появлением vSphere 5.5 — еще и VSAN (наследие Virsto).

Плюсы, минусы, ограничения:

- Пропускная способность: 24Гбит на каждый порт, т.е. такой полосы вам хватит практически в любых сценариях, узким местом будут являться диски, HBA и шина PCI-E x8. Ждем дальнейшего удешевления SSD, появления PCI-E 3.0 и SAS-3 (а это оптика до 100м и 48Гбит в каждом 4x-wide порте).

- Латентность — в 20 раз ниже, чем у 10GbE iSCSI и 8Gb FC. В некоторых случая латентность может серьезно повлиять на производительность, в данном случае с этим проблем нет — протокол SAS проще, так же как и устройство коммутатора.

- Стоимость порта. Напрямую сравнивать с FC не имеет смысла — все зависит от масштаба сети. Пока что можно сказать, что стоимость порта при использовании SAS коммутатора сравнима с гигабитным iSCSI: хорошие гигабитные свитчи стоят недешево, цена двухпортовых GbE карточек (например, на чипе Intel 82576) ненамного меньше SAS HBA.

- Репликация. Непосредственно через SAS репликации (пока?) не существует. Так что остается использовать программные решения на стороне хоста.

- Дистанция. Только два порта на LSI 6160 поддерживают активные SAS кабели длиной 10 и 20 метров.

Масштабируемость. Тут действуют несколько простых правил:

- До 6 экспандеров в каскаде, каждый SAS коммутатор считается за один экспандер.

Если каскадируются только коммутаторы, то до 4-х.

Если каскадируются только коммутаторы, то до 4-х. - Максимум 64 экспандера в одной топологии.

- Все соединения между инициатором (таргетом) и коммутатором должны быть 4x. Для отказоустойчивых конфигураций необходимо использовать несколько коммутаторов. Пример: каждый порт 2-портового HBA и каждый порт каждого контроллера в СХД подключаются к своему коммутатору.

Вот пока что и все. В следующем посте будет практика: подключим пару серверов к LSI CTS2600 через SAS коммутатор (собственно, это всего лишь тестовая инсталляция — при таком количестве серверов использование коммутатора совершенно не нужно), посмотрим интерфейс SAS Domain Manager’а и как это все отражается на работе VMware ESXi.

SAS коммутатор LSI 6160. Часть 2: подключение.

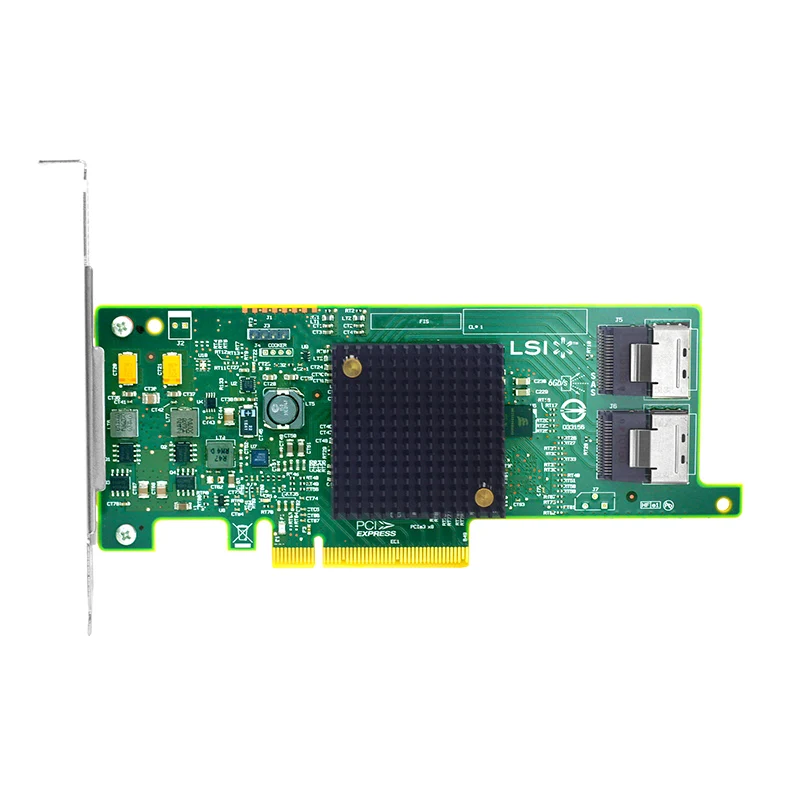

LSI SAS 2008 RAID Controller/HBA Information

Один из самых популярных серверных RAID-контроллеров и HBA-контроллеров — LSI SAS 2008. LSI SAS 2008 — это контроллер на базе SAS 2 или SATA III с пропускной порты и встроенное подключение PCIe. На форумах мы поддерживали сопоставление контроллеров LSI между контроллерами LSI и их OEM-аналогами. Этот пост будет дополнен как информацией о LSI SAS 2008, в том числе информацией о том, как переключать флэш-карты между режимами IT и IR для режимов целевого инициатора и RAID, так и различными OEM-моделями, обычно встречающимися на рынке. Часто контроллеры LSI SAS 2008 дешевле, если их найти в качестве OEM-компонентов от Intel, Dell, HP, IBM, Supermicro и других, поэтому во многих случаях имеет смысл приобрести OEM-версии карт на базе LSI SAS 2008, таких как 9.211-8и.

На форумах мы поддерживали сопоставление контроллеров LSI между контроллерами LSI и их OEM-аналогами. Этот пост будет дополнен как информацией о LSI SAS 2008, в том числе информацией о том, как переключать флэш-карты между режимами IT и IR для режимов целевого инициатора и RAID, так и различными OEM-моделями, обычно встречающимися на рынке. Часто контроллеры LSI SAS 2008 дешевле, если их найти в качестве OEM-компонентов от Intel, Dell, HP, IBM, Supermicro и других, поэтому во многих случаях имеет смысл приобрести OEM-версии карт на базе LSI SAS 2008, таких как 9.211-8и.

Краткие сведения о LSI SAS 2008

- RAID-контроллер поддерживает как SAS 2, так и SATA III на скорости 6,0 Гбит/с

- Приблизительно 9 Вт потребляемой мощности для обычных карт

- Одно ядро PowerPC на частоте 533 МГц

- Нет встроенного кэша

- Интерфейс PCIe 2.0 x8

- Поддерживает расширители SAS (с двойным подключением)

- Использует утилиту sas2flash для прошивки в режиме IT/IR (когда это возможно).

Поддерживаемые режимы HBA

- RAID 0, RAID 1, RAID 1E, RAID 10 и сквозной (не RAID)

Поддерживаемые режимы RAID

- RAID 0, RAID1, RAID 10, RAID 5, RAID 50 и JBOD

Руководства ServeTheHome

- Прошивка IBM ServeRAID M1015, часть 1 (Начало работы)

- Перепрошивка IBM ServeRAID M1015, часть 2 (производительность)

- Перепрограммирование IBM ServeRAID M1015, часть 3 (данные SMART)

- Прошивка IBM ServeRAID M1015, часть 4 (перекрестная прошивка в режиме IT/IR LSI 9211-8и)

Платы на базе LSI SAS 2008

В следующем списке представлены RAID-контроллеры и адаптеры главной шины на базе RAID-контроллера LSI SAS 2008 SAS 2 и SATA III.

LSI SAS 9211-8i

Соглашение об именах: i=внутренний порт(ы), e=внешний порт(ы)

Исходный контроллер LSI на базе SAS 2008, все платы PCIe 2.0 x8, если не указано иное.

Логические карты LSI

Серия LSI9240 использует режим iMR (встроенный MegaRaid)

- LSI9240-4i Поддерживает RAID 0, 1, 10, 5, 50 и JBOD

- LSI9240-8i Поддерживает RAID 0, 1, 10, 5, 50 и JBOD

LSI920x/921x серии представляют собой LSI HBA / Fusion MPT 2. 0, все в режиме IR поддерживают RAID 0, 1, 1e и 10, режим IT = только сквозной

0, все в режиме IR поддерживают RAID 0, 1, 1e и 10, режим IT = только сквозной

- LSI9200-8e

- LSI9201-16e SAS2116 версия

- LSI9201-16i SAS2116 версия

- LSI9202-16e Двойной контроллер SAS2008 с использованием PCIe 16x

- LSI9210-8i OEM-версия LSI9211, вертикальные порты SAS

- LSI9211-4i Горизонтальные порты SAS

- LSI9211-8i Горизонтальные порты SAS

- LSI9212-4i4e 1×4 внешних порта SAS и 4 одиночных внутренних 7-контактных разъема SAS/SATA

IBM SAS HBA

- IBM ServeRAID M1015 аналогичен LSI 9240-8i, но ServeRAID M1015 не поддерживает RAID 5, если вы не добавите «ключ расширенных функций», чтобы включить его

- IBM ServeRAID M1115 более новая версия IBM ServeRAID M1015

- Оптимизированный для производительности HBA IBM 6 Гбит (46M0912) – LSI-9240-8i (улучшенный твердотельный накопитель)

- Адаптер главной шины IBM 6 Гбит/с SAS (46M0907) — LSI 9212-4i4e — 4 внутренних разъема SAS 2/SATA III и 1 внешний разъем 4 SAS 2 SFF-8088.

Карты Dell

- Dell PERC h300 поставляется с прошивкой IT, но похож на LSI 9211-8i

- Делл Перк h410

Карты Cisco

- Cisco UCSC RAID SAS 2008M-8i

Платы Fujitsu

- Fujitsu D2607 — ребрендинг LSI 9211-8i ?

Карты Oracle (Sun)

- SUN SGX-SAS6-EXT-Z (номер по каталогу 375-3641) – LSI 9200-8e (внешние разъемы)

- SUN SGX-SAS6-INT-Z (кат. № 375-3640) – LSI 9211/10-8i (внутренние разъемы)

Карты Intel RAID

- Intel RS2WC080 внешне идентичен LSI 9240-8i и IBM M1015, но поддерживает RAID 5 и RAID 50, как и 9240-8i.

Собственные карты Intel PCIe x4

- Intel RMS2AF040 (собственные карты PCIe 4x)

- Intel RMS2AF080 (собственный PCIe 4x) То же, что и выше, но 8 портов

HBA-адаптер Hewlett Packard

- Адаптер главной шины HP h320

- Адаптер главной шины HP h321 (2 внешних разъема SFF-8088)

- Адаптер главной шины HP h322

- Адаптер главной шины HP h320i

- Адаптер главной шины HP h310i

Карты UIO собственного формата Supermicro

- SuperMicro AOC-USAS2-L8iR — спецификация 9240-8i, но с 16 МБ кэш-памяти и RAID 5, но без RAID 1E с прошивкой IR (карта UIO!)

- SuperMicro AOC-USAS2-L8E — версия HBA, поэтому она больше всего похожа на 9211-8i с IT-прошивкой (карта UIO!)

- SuperMicro AOC-USAS2-L8i — в спецификации LSI 9240-8i нет RAID 5, но есть RAID 1E с прошивкой IR (карта UIO!)

RAID-контроллеры Lenovo

- Lenovo 67Y1460 — это LSI 9240-8i с незначительным ребрендингом.

Не стесняйтесь вносить свой вклад, размещая сообщения в сообщении LSI Controller Mapping. Нам нужны отзывы сообщества, чтобы сделать это как можно более полезным для всех.

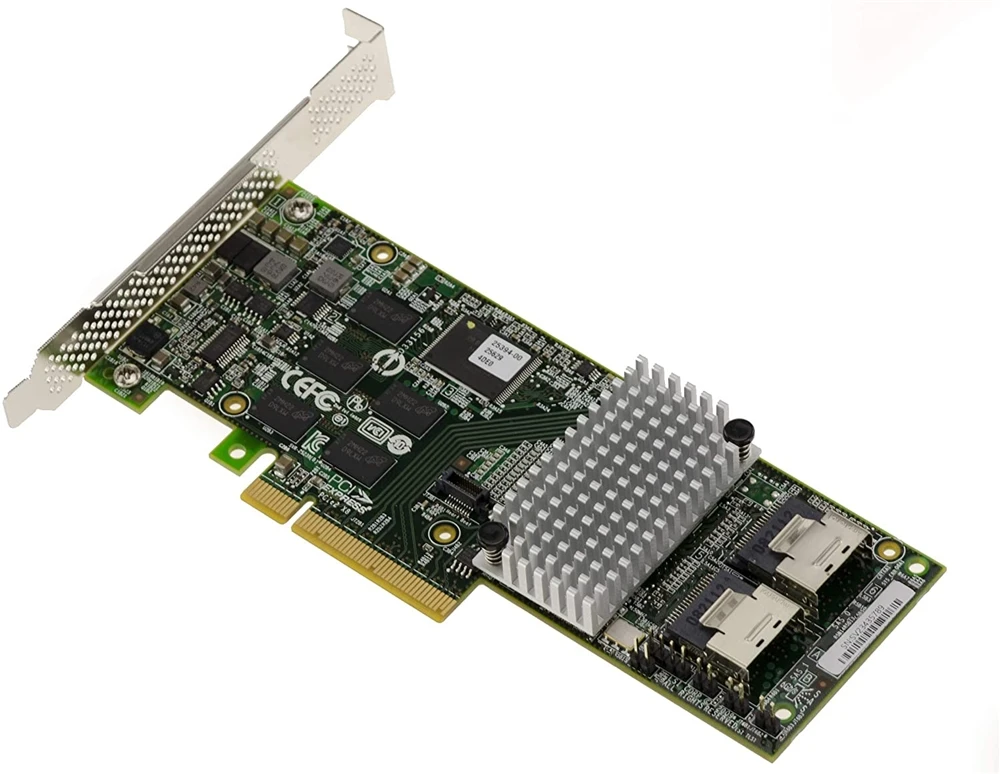

LSI Logic LSI00298 1GB 8 PORT PCIE SAS/SATA 6GBPS CONTRPERTLER

- Описание

- Спецификации

- Состояние

- 70008

LSI LOGIC LSI00298183

LSI LOGIC LSI00298183

LSI LOGIC LSI00298183

LSI LOGIC LSI00298183

LSI LSI00298183

LSI LSI00298183 Logic LSI00298 8-портовый контроллер PCI Express, SAS, Serial ATA 6,0 Гбит/с Logic LSI00298 MegaRAID — новый

Alt MPN: 9285CV-8e

MegaRAID® SAS 9285CV-8e Восьмипортовый RAID-контроллер PCI Express® 6 Гбит/с SATA+SAS с CacheVault™ Защита флэш-кэша

Высочайшая производительность серверного RAID-массива для баз данных и мультимедийных приложений. По мере расширения требований к хранилищу и роста вычислительных нагрузок администраторам становится все труднее добиваться максимальной производительности своих приложений. Новейшая линейка плат контроллеров MegaRAID® 6 Гбит/с SATA+SAS, построенных на двухъядерном контроллере LSI SAS 2208 ROC, обеспечивает непревзойденную производительность ввода-вывода для приложений баз данных и потоковых сред цифрового мультимедиа. В дополнение к производительности, масштабируемости и гибкости конфигурации, предлагаемым контроллерами MegaRAID SATA+SAS, клиенты могут воспользоваться более экологичным и недорогим решением для защиты кэш-памяти с технологией MegaRAID CacheVault. МегаRAID SAS 9Контроллер 285CV-8e с восемью внешними портами оснащен двумя процессорными ядрами PowerPC с тактовой частотой 800 МГц и 72-разрядным интерфейсом DDRIII, который управляет кэш-памятью объемом 1 ГБ. Этот контроллер идеально подходит для конфигурации внешних корпусов хранения с высокопроизводительными жесткими дисками SAS, жесткими дисками SATA большой емкости или твердотельными накопителями (SSD), ускоряющими работу приложений, или для построения более сложных конфигураций с использованием продуктов LSI 6 Гбит/с SAS Switch.

По мере расширения требований к хранилищу и роста вычислительных нагрузок администраторам становится все труднее добиваться максимальной производительности своих приложений. Новейшая линейка плат контроллеров MegaRAID® 6 Гбит/с SATA+SAS, построенных на двухъядерном контроллере LSI SAS 2208 ROC, обеспечивает непревзойденную производительность ввода-вывода для приложений баз данных и потоковых сред цифрового мультимедиа. В дополнение к производительности, масштабируемости и гибкости конфигурации, предлагаемым контроллерами MegaRAID SATA+SAS, клиенты могут воспользоваться более экологичным и недорогим решением для защиты кэш-памяти с технологией MegaRAID CacheVault. МегаRAID SAS 9Контроллер 285CV-8e с восемью внешними портами оснащен двумя процессорными ядрами PowerPC с тактовой частотой 800 МГц и 72-разрядным интерфейсом DDRIII, который управляет кэш-памятью объемом 1 ГБ. Этот контроллер идеально подходит для конфигурации внешних корпусов хранения с высокопроизводительными жесткими дисками SAS, жесткими дисками SATA большой емкости или твердотельными накопителями (SSD), ускоряющими работу приложений, или для построения более сложных конфигураций с использованием продуктов LSI 6 Гбит/с SAS Switch. Пользователи могут развернуть контроллер MegaRAID SAS 9285CV-8e в существующих серверных средах на основе жестких дисков для значительного повышения производительности. В качестве альтернативы, для пользователей, внедряющих серверные платформы на основе твердотельных хранилищ, эти контроллеры MegaRAID следующего поколения используют потенциал твердотельных накопителей для непревзойденной производительности и надежности корпоративного класса.

Пользователи могут развернуть контроллер MegaRAID SAS 9285CV-8e в существующих серверных средах на основе жестких дисков для значительного повышения производительности. В качестве альтернативы, для пользователей, внедряющих серверные платформы на основе твердотельных хранилищ, эти контроллеры MegaRAID следующего поколения используют потенциал твердотельных накопителей для непревзойденной производительности и надежности корпоративного класса.

Технология MegaRAID CacheVault™ — защита флэш-кэша MegaRAID CacheVault использует флэш-память NAND с питанием от суперконденсатора для защиты данных, хранящихся в кэше контроллера MegaRAID. Этот модуль устраняет необходимость в литий-ионном аккумуляторе, традиционно используемом для защиты кэш-памяти DRAM на контроллерах PCI RAID. Контроллер RAID автоматически записывает данные в кэш-память во флэш-память при сбое питания, в то время как суперконденсатор поддерживает ток во время процесса. Когда питание возвращается, DRAM восстанавливается из флэш-памяти, и система продолжает работать без потери данных. Преимуществами этой технологии являются устранение обслуживания оборудования, связанного с батареями LiON, более низкая совокупная стоимость владения в течение всего срока службы адаптера и более экологичная защита кэш-памяти.

Преимуществами этой технологии являются устранение обслуживания оборудования, связанного с батареями LiON, более низкая совокупная стоимость владения в течение всего срока службы адаптера и более экологичная защита кэш-памяти.

Поддержка расширенных программных опций — семейство контроллеров Avago MegaRAID 6 Гбит/с поддерживает расширенные программные опции, которые предоставляют партнерам по каналу «белого ящика» повышенную производительность и возможности защиты данных. Эти новые опции программного обеспечения позволяют конечным пользователям решать ключевые бизнес-задачи, обеспечивая при этом более высокую отдачу от своих инвестиций в ИТ. Программное обеспечение MegaRAID CacheCade® и программное обеспечение MegaRAID Fast Path повышают производительность транзакционного ввода-вывода в конфигурациях с твердотельными дисками, а программное обеспечение MegaRAID Recovery и программное обеспечение MegaRAID SafeStore™ обеспечивают улучшенную защиту и безопасность данных.

Интуитивная утилита управления RAID. Программное обеспечение MegaRAID Management Suite™ предоставляет необходимые инструменты для управления продуктами MegaRAID, независимо от того, развернуты они на предприятии или в малом бизнесе. LSI предлагает набор приложений и инструментов, включая утилиту предзагрузочной настройки и полный спектр онлайн-утилит управления RAID. Этот набор приложений позволяет администраторам настраивать представления топологии SAS или SATA от хоста системы, контроллера и дискового массива до уровня логического и физического диска. При расширении до корпоративных развертываний эти инструменты масштабируются для упрощения настройки, мониторинга и управления томами RAID и JBOD локально или по сети LAN.

Программное обеспечение MegaRAID Management Suite™ предоставляет необходимые инструменты для управления продуктами MegaRAID, независимо от того, развернуты они на предприятии или в малом бизнесе. LSI предлагает набор приложений и инструментов, включая утилиту предзагрузочной настройки и полный спектр онлайн-утилит управления RAID. Этот набор приложений позволяет администраторам настраивать представления топологии SAS или SATA от хоста системы, контроллера и дискового массива до уровня логического и физического диска. При расширении до корпоративных развертываний эти инструменты масштабируются для упрощения настройки, мониторинга и управления томами RAID и JBOD локально или по сети LAN.

Ключевые функции

- Восемь внешних 6 ГБ/с SATA+SAS PORTS

- Два внешних разъема Mini-SAS (SFF8088)

- LSI SAS 2208 Dual-Core 6GB/S ROC

- X2 800MHZ PowerPC-процессы 9001

- X2 800MHZ PowerPC-процессов

- X2 800MHZ PowerP Кэш-память DDRIII

- Уровни RAID 0, 1, 5, 6, 10, 50 и 60

- Включена защита флэш-кэша MegaRAID CacheVault

Основные преимущества

- Непревзойденная производительность RAID

- Внешнее расширение до 3 G2b4 JBOD s и 6 Гбит/с SATA и SAS жесткие диски или твердотельные накопители

- Помогает пользователям реализовать потенциал развертывания твердотельных хранилищ

- Включена технология CacheVault для более экологичной защиты кэш-памяти с меньшими общими затратами

- Совместимость с коммутатором SAS 6 Гбит/с

- Поддержка дополнительных опций программного обеспечения

3 Совместимость1: Эта карта контроллера совместима с любым сервером, имеющим разъемы PCI-E 2. Нажмите здесь, чтобы просмотреть описание предмета производителя/брошюра Альтернативный MPN: 9285CV-8E Вес: 2 LB 0.

0. ТЕХНИЧЕСКИЕ ХАРАКТЕРИСТИКИ Номер детали LSI00298 Alt Part Number 9285CV-8e Product MegaRAID SAS 9285CV-8e RAID-on-Chip-Controller LSISAS2208 Dual-Core RAID on Chip (ROC) Защита кэш-памяти Защита флэш-кэша MegaRAID CacheVault (в комплекте) Программное обеспечение для управления Raid0053 WebBIOS Physical Dimensions MD2 Low profile (6.6″ x 2.536″) Host Bus Type x8 lane PCI Express 2.0 Cache Memory 1GB 1333MHz DDR III SDRAM Внешние порты 8 Скорость передачи данных До 6 Гбит/с на порт Поддерживаемые устройства До 240 устройств SATA и/или 902 SAS5 Internal Connectors 2 Mini-SAS SFF8088 MTBF 445,584 hours Operating Temperature Maximum ambient: Controller Card: 60°C, with included CacheVault Module: 55°C Операционные системы Расширенная поддержка включает Microsoft® Windows Vista®, Windows 7®, Windows Server® 2003/2008, Red Hat Linux®, SuSE Linux®, Fedora Core Linux®, FreeBSD® и другие.

Рабочее напряжение +3,3 В Соответствие стандартам EN55022, EN55024, EN60950, EN 61000-3-2, EN 61000-3-3; FCC Класс А, Класс Б; УЛ1950; УЛ; CSA C22.2; ВККИ; РРЛ для ВПК; БСМИ; C-Tick

.0003 Абсолютно новый Описание уровней состояния Совершенно новый продукт. Гарантия DiscTech сроком на 1 год Описание гарантийных обязательств на продукт На продукт распространяется гарантия DiscTech на указанный период времени. Ознакомьтесь с нашей ограниченной гарантией LSI SAS 2008 и IBM MegaRaid MR10i (LSI SAS 1078) — что использовать

Рототип

Кадет

- #1

Привет,

Я просто собираюсь восстановить свой NAS с новой материнской платой (SuperMicro H8DG6-F), которая имеет встроенный контроллер LSI 2008 SAS, но из моей предыдущей конфигурации у меня также есть IBM MegaRaaid MR10i, который основан на чипсете LSI 1078. На борту есть 6 SATA, и у меня есть 5-сторонняя дисковая корзина с горячей заменой, а также 1 х диск для массовой загрузки (5 ТБ WD Red)) 2 х кэш-диска (256 ГБ SSD, samsung 2.5) и 2 x загрузочных диска (16 ГБ SSD тонкий маленький ) вместе с LSI Nytro WarpDrive 1,86 ТБ, который находится в слоте PCIe-X8, который, вероятно, будет использоваться для буферизации видео. 5 дисков в корзине — 6TG WD Red.

На самом деле мне не нужны все порты на обеих картах SAS (вероятно, у меня все равно будет несколько запасных портов), но мне интересно, получу ли я какое-либо преимущество от использования карты IBM по сравнению со встроенным SAS контроллер? По сути, LSI 1078 быстрее или совместимее, чем LSI 2008? Насколько я вижу, они оба имеют скорость 3 ГБ/с и (смотря на блок-схему материнской платы) оба поступают примерно из одного и того же места. Моя единственная мысль заключалась в том, что в зависимости от того, в какой разъем PCIe я его устанавливаю, я мог бы подключиться ко второму ЦП и снизить нагрузку на первый ЦП — будет ли это иметь какое-либо преимущество в производительности?

Моя единственная мысль заключалась в том, что в зависимости от того, в какой разъем PCIe я его устанавливаю, я мог бы подключиться ко второму ЦП и снизить нагрузку на первый ЦП — будет ли это иметь какое-либо преимущество в производительности?

NAS в первую очередь предназначен для использования в качестве домашней системы, поэтому абсолютная производительность не будет иметь такого критического значения, просто если одно решение лучше другого, я хотел бы выразить это сейчас, чтобы избавить себя от необходимости делать все это снова позже. Кроме того, не возникнет ли проблем с использованием обоих адаптеров в системе вместе? Другой вариант, который я мог бы использовать, — передать вывод SAS с одной или другой карты на внешний массив дисков для будущего расширения и, возможно, на резервный диск (ленточная библиотека). 932-1 для LBA, что обычно ограничивает размер диска 2,2 ТБ. Их не рекомендовали уже десять лет.

Понятия не имею, что означает «3 ГБ/с» в данном контексте. Вы говорите о скорости соединения SAS? Скорость соединения PCIe? (оба значения измеряются в бит/с, а не в байтах/с) Или скорость передачи? Потому что 2008/2308 — это контроллер SAS 6 Гбит/с.

Вы говорите о скорости соединения SAS? Скорость соединения PCIe? (оба значения измеряются в бит/с, а не в байтах/с) Или скорость передачи? Потому что 2008/2308 — это контроллер SAS 6 Гбит/с.

https://www.ixsystems.com/community/threads/confused-about-that-lsi-card-join-the-crowd.11901/

932-1 для LBA, что обычно ограничивает размер диска 2,2 ТБ. Их не рекомендовали уже десять лет.

Понятия не имею, что означает «3 ГБ/с» в данном контексте. Вы говорите о скорости соединения SAS? Скорость соединения PCIe? (оба значения измеряются в бит/с, а не в байтах/с) Или скорость передачи? Потому что 2008/2308 — это контроллер SAS 6 Гбит/с.

https://www.ixsystems.com/community/threads/confused-about-that-lsi-card-join-the-crowd.11901/

Нажмите, чтобы развернуть…

Спасибо за это, я имел в виду 3 Гбит/с (опечатка), что, как мне сказали, они оба. Похоже, я использую встроенный (2008 г.) тогда… (с ограничением в 2,2 ТБ на 1078, которое полностью исключает его, поскольку все основные диски имеют емкость 5 или 6 ТБ каждый. Знайте всех, кто хочет дешевый IBM MR10i ?)

Знайте всех, кто хочет дешевый IBM MR10i ?)

Это главная причина, по которой я задал этот вопрос здесь, где есть люди, которые разбираются в этом. Я внимательно посмотрю на эту ссылку, мне может понадобиться еще одна, если я в какой-то момент захочу выйти на внешний уровень. Возможно ли иметь 2 адаптера HBA 2008 года в одной системе? Я буду продолжать просматривать существующие сообщения, чтобы увидеть, смогу ли я ответить на это сам.

Еще раз спасибо

Рототип.

jgreco

Резидент Гринч

- #4

Возможно также пригодится:

https://www. ixsystems.com/community/resources/dont-be-afraid-to-be-sas-sy.48/

ixsystems.com/community/resources/dont-be-afraid-to-be-sas-sy.48/

Продукты

LSI 6 Гбит/с SAS, выбранные ведущими поставщиками систем хранения данных для поддержки внешних платформ хранения данных следующего поколения — Торговая ассоциация SCSI

Пресс-релизы » Релизы участников

Dot Hill, Infortrend, NEC и Xyratex выбирают внешние решения для хранения данных LSI 6 Гбит/с SAS, включая микросхемы контроллеров и расширителей, а также мостовые платы SAS-to-SATA

МИЛПИТАС, Калифорния, 22 июля 2009 г.-LSI Corporation (NYSE: LSI) сегодня объявила о том, что Dot Hill, Infortrend, NEC и Xyratex выбрали решения LSITM SAS 6 Гбит/с для реализации своих внешних платформ хранения данных следующего поколения. Являясь лидером в сегменте SAS с более чем 13 миллионами ИС SAS, поставленными по всему миру, LSI предлагает единственный в отрасли комплексный портфель продуктов SAS 6 Гбит/с для приложений внешнего хранения, включая контроллеры SAS и ИС расширителей, а также мостовые карты SAS-to-SATA. .

.

«Предлагая OEM-клиентам полное готовое к производству семейство решений для внешних хранилищ, LSI способствует развитию технологии интерфейса SAS во внешних хранилищах, — сказал Стив Фингерхат, старший директор по маркетингу Storage Components Group, LSI. «И поскольку наш портфель SAS 6 Гбит/с опирается на наши проверенные продукты SAS 3 Гбит/с, мы можем предоставить OEM-производителям меньший риск и предложить преимущество во времени выхода на рынок».

LSI предлагает 8-портовый контроллер SAS+SATA 6 Гбит/с, предназначенный для блейд-серверов, серверов начального и среднего уровня, а также внешних систем хранения; семейство расширителей SAS 6 Гбит/с (24, 28 и 36 портов), которые позволяют нескольким хостам и целевым устройствам подключаться через коммутируемое устройство для большей масштабируемости; и мостовые карты SAS-to-SATA, которые позволяют расширить существующие 2,5-дюймовые и 3,5-дюймовые диски SATA в корпоративных средах хранения данных с помощью основных функций корпоративного класса. Продукты поставляются серийно и поддерживаются полным спектром готового программного обеспечения, предназначенного для минимизации затрат на интеграцию OEM и ускорения выхода на рынок.

Продукты поставляются серийно и поддерживаются полным спектром готового программного обеспечения, предназначенного для минимизации затрат на интеграцию OEM и ускорения выхода на рынок.

Согласно отраслевым оценкам, внедрение SAS на 6 Гбит/с на рынке начнется с выпуска отдельных компонентов и устройств SAS и будет набирать обороты по мере того, как ведущие OEM-производители начнут массовое производство серверов с поддержкой SAS 6 Гбит/с и внешних систем хранения данных. Ожидается, что к концу года произойдет широкое распространение на рынке серверов с поддержкой SAS 6 Гбит/с, а в начале-середине 2010 года появятся внешние системы хранения данных.

С момента создания SAS компания LSI поставляет передовые продукты в своем портфолио микросхем контроллеров, расширителей, хост-шины и адаптеров MegaRAID®, решений RAID на материнской плате и систем хранения данных. Предлагая лучшие в своем классе технологии SAS, широкие возможности взаимодействия и поддержку от одного поставщика, LSI является предпочтительным поставщиком комплексных систем для OEM-производителей, которые хотят поставлять широкий спектр решений для хранения данных.

Более подробная информация о полном портфолио LSI SAS доступна на сайте www.lsi.com/sas.

О компании LSI