правильно настраиваем файл роботс для каталога товаров

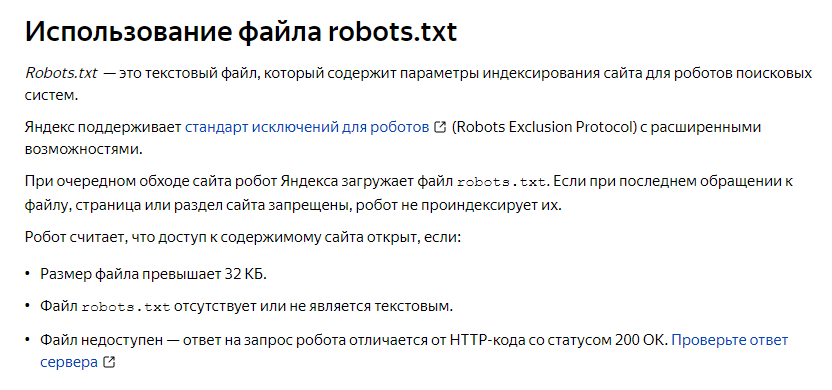

Robots txt — файл, в котором указываются инструкции поисковым роботам, посещающим сайт. Посещая веб-ресурс, они в первую очередь загружают robots.txt и индексируют те страницы, разделы и файлы, к которым разрешен доступ.

Настройка robots для лендинга несколько отличается от обычных сайтов. В статье разберем тонкости создания robots для посадочных страниц.

Правильная оптимизация файла

Сперва определите, для каких поисковых роботов вы хотите применять правила из файла. Например, если лендинг планируется продвигать и в Яндексе, и в Гугле, пропишите:

«User-agent: *»

Это сделает robots txt открытым для всех роботов. Если хотите оставить посадочную страницу под конкретный поисковик, вместо этого пропишите в параметре нужное наименование системы.

Например:

«User-agent: Google» — это откроет файл для Google.

Далее определите файлы и скрипты, которые хотите:

- открыть для индексации поисковыми роботами.

- закрыть от индексации.

Открытие robots.txt для всех роботов и Google

Страницы в robots txt для лендинга не указывают. В случае с обычным сайтом это были бы страницы, но лендинг обычно подразумевает одну веб-страницу, поэтому запрет на индексацию страниц не имеет никакого смысла.

Для лендингов чаще всего разрешают индексацию изображений, но запрещают индексирование JS-кода и CSS-стилей с помощью свойства «Disallow».

Пример кода:

User-agent: *

Allow: /images/

Disallow: /js/

Disallow: /css/

В некоторых случаях запрет снимают для роботов с Google. Тогда код примет следующий вид:

User-agent: Googlebot

Allow: /

Пример файла robots.txt для лендинга

Итоги

Правильное заполнение robots.txt позволит вашему лендингу появиться в поисковой выдаче. Если же неправильно настроить файл, например, запретить индексацию всего сайта, его может быть вообще не видно в поиске.

Примерный файл robots.txt для лендинга должен выглядеть так:

User-agent: *

Allow: /images/

Disallow: /js/

Disallow: /css/

User-agent: Googlebot

Allow: /

User-agent: Yandex

Allow: /images/

Disallow: /js/

Disallow: /css/

Мы предлагаем создание лендинга с его последующим продвижением. Более подробная информация на странице https://discript.ru/site-development/landing/.

Другие статьи

Оптимальный размер текста на странице сайта

Как формировать ТЗ на тексты

Что такое landing page?

Что такое rewriterule

Как закрыть сайт от индексации в robots.

txt — Сollaborator

txt — СollaboratorВ данной инструкции разберемся с 2 основными вопросами: зачем закрывать сайт от индексации и как это сделать с помощью файла robots.txt.

Зачем закрывать сайт или страницу от индексацииВ каких ещё ситуациях нужен запрет на индексацию:

1. Открытие сайта для пользователей, когда он еще не оптимизирован. После релиза сайта его страницы сканируются роботами при первом обходе. Однако если дизайн и контент страниц пока ещё не оптимизированы для продвижения, рекомендуется на время доработок закрыть

2. Тестирование сайта на другом домене. Если вы создали аналог основного сайта и проводите на нём тестовые работы, поисковые роботы могут воспринять страницы сайтов как дубликаты. В результате основной сайт может потерять позиции.

3. Смена дизайна, параметров, контента. На время работ по улучшению интерфейса и юзабилити закройте страницы сайта от индексации полностью или частично.

Запрет на сканирование — часто временное явление. После окончания технических работ вы сможете вернуть сайт в прежнее состояние. Такой шаг помогает сохранить позиции в выдаче.

Как закрыть сайт от индексации через robots.txtФайл robots.txt позволяет запретить индексацию страниц, разделов или всего сайта. Используйте директиву Disallow в качестве команды для поисковых роботов.

1. Если нужно закрыть весь сайт от всех роботов, пропишите в файле robots.txt:

User-agent: * Disallow: /

2. Если нужно закрыть сайт от Яндекс, пропишите в robots.txt:

User-agent: Yandex Disallow: /

Обратите внимание. Для обращения к конкретному роботу вместо «*» используйте его название.

3. Если требуется закрыть от индексации определённые разделы, укажите их после директивы Disallow. Для каждого типа контента используйте отдельную директиву.

Пример:

User-agent: * Disallow: /catalogs Disallow: /news

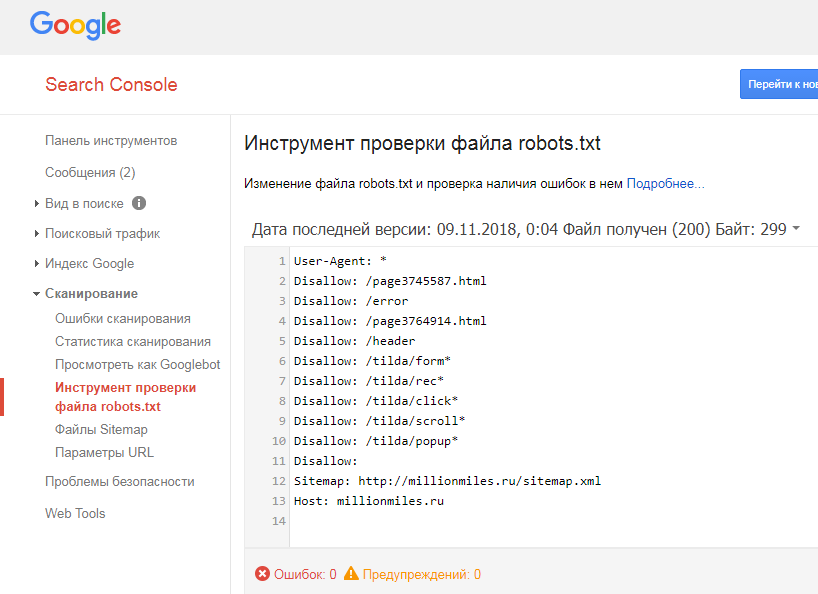

Многие SEO-оптимизаторы отмечают, что Google часто игнорирует директиву Disallow и продолжает индексировать все страницы сайта. Проверить это можно в Google Search Console.

Если страница закрыта от индекса в robots.txt, но это не указано в панели вебмастеров, скорее всего, Google-бот продолжит индексировать эту страницу.

Для проверки в Яндекс.Вебмастер перейдите в раздел «Индексирование» → Проверить статус URL.

Если директива Disallow в robots.txt не помогает закрыть страницу от индексации, то нужно использовать другие методы.

При проведении технических работ желательно временно закрыть сайт от индексации. Так вы сможете работать над дизайном и юзабилити без ущерба для поисковой оптимизации.

Похожие вопросы

- Как настроить файл robots.txt: полное руководство

Ольга Горбенко

Практикующий SEO-специалист

robots.

txt — нет индекса для всего сайта

txt — нет индекса для всего сайтаспросил

Изменено 4 года, 3 месяца назад

Просмотрено 4к раз

Я заканчиваю новый проект. Последние недели/месяцы я работаю локально. Теперь я хочу начать первые тесты на реальном сервере и базе данных sql. Я не хочу, чтобы сайт был общедоступным, и я не хочу, чтобы поисковые системы учитывали сайт, пока он не будет готов (это будет скоро, но мне понадобится неделя или две) Как мне это сделать?

Я знаю, что для одной страницы я должен поместить это в заголовок:

Для всего сайта, следует ли размещать эту строку кода на всех страницах или есть лучший способ?

- robots.txt

- noindex

Ответ Ника на добавление robots. txt может не остановить Google от индексации, он просто говорит остановить сканирование, но Google может индексировать — официальная ссылка здесь.

txt может не остановить Google от индексации, он просто говорит остановить сканирование, но Google может индексировать — официальная ссылка здесь.

Добавление мета-тега noindex слишком рискованно, если вы работаете с командой, которая не знает о последствиях тега noindex, если он будет отправлен в рабочую среду.

Я бы порекомендовал вам использовать пароль для защиты вашего веб-сайта , который, кажется, работает лучше всего и проще в управлении, с членами команды, которые не очень хорошо разбираются в SEO. И выполняет работу по прекращению доступа пользователей, а также поисковых систем.

2

Не рекомендуется использовать файл robots.txt для остановки сканирования сайта, который вы не хотите индексировать.

Если вы запретите Google сканировать ваш сайт, он никогда не сможет увидеть ваши страницы и, следовательно, никогда не увидит тег noindex или заголовок. Таким образом, когда страница находится в индексе и заблокирована файлом robots.txt, Google никогда не увидит тег, говорящий об ее удалении.

Таким образом, когда страница находится в индексе и заблокирована файлом robots.txt, Google никогда не увидит тег, говорящий об ее удалении.

Если вас беспокоит только индексирование (а не, например, случайный посетитель, который его найдет), вы можете отправить серверу заголовок noindex.

В Apache, использующем .htaccess, это будет

Заголовок, установленный X-Robots-Tag "noindex, nofollow"

См. статью о Yoast для более подробной информации. https://yoast.com/prevent-site-being-indexed/

1

Для исключения всех роботов со всего сервера:

User-agent: * Запретить: /

Этот код поможет вам получить деиндексацию всех файлов с сервера.

Для исключения всех роботов из части сервера:

User-agent: * Запретить: /cgi-bin/ Запретить: /tmp/ Запретить: /мусор/

1

Вы можете запретить определенным поисковым системам сканировать ваш сайт, добавив следующее в ваш файл robots. txt

txt

User-agent: * Запретить: /

Google не сможет сканировать ваш сайт, но ваш сайт все еще может быть проиндексирован. Однако имейте в виду, что другие поисковые системы могут вообще не учитывать ваш файл robots.txt.

Вам следует подумать о том, чтобы добавить на свой сайт ограничение пользователя/пароля. Более подробную информацию о том, как это сделать, можно найти здесь: http://www.htaccesstools.com/htaccess-authentication/

. 5

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя электронную почту и пароль

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Опубликовать как гость

Электронная почтаТребуется, но не отображается

Нажимая «Опубликовать свой ответ», вы соглашаетесь с нашими условиями обслуживания, политикой конфиденциальности и политикой использования файлов cookie

Сколько времени robots.

txt удаляет мой сайт из Google

txt удаляет мой сайт из Googleспросил

Изменено 8 лет, 5 месяцев назад

Просмотрено 1к раз

Я создал robots.txt в моем корне, но веб-сайт все еще индексируется Google. Сколько времени потребуется для robots.txt , чтобы удалить мой сайт из Google?

- robots.txt

- гугл-индекс

1

Просто используйте инструмент удаления URL, найденный в инструментах Google для веб-мастеров, чтобы ускорить работу (после блокировки с помощью robots.txt) — это не должно занять более 24 часов (просто введите / чтобы удалить весь сайт)

https:// www.google.com/webmasters/tools/url-removal

Ваш файл robots, очевидно, должен содержать одну строку, запрещающую всем роботам сканировать ваш сайт:

User-agent: * Запретить: /

Файл robots. txt может запретить сканирование , а не индексирование .

txt может запретить сканирование , а не индексирование .

В следующий раз, когда Google попытается просканировать ваши страницы, он, вероятно, проверит файл robots.txt и обнаружит, что им больше не разрешено сканировать. Это остановит Google от посещения ваших страниц, но они не обязательно удалят эти страницы из своего индекса (и это не означает, что новые страницы не будут проиндексированы; они могут найти ссылается на эти страницы где-то еще). Ваши страницы по-прежнему могут быть перечислены в их индексе (но без извлечения заголовка или фрагмента из вашей страницы).

Если вы хотите остановить индексирование, вам нужно использовать элемент meta — robots или HTTP-заголовок X-Robots-Tag . В этом случае вам придется разрешить сканирование этих страниц в robots.txt, иначе Google никогда не узнает, что вы не разрешаете индексацию.

Это зависит. Все robots.txt сообщает сканеру, какой контент вы хотите или не хотите индексировать.