Robots.txt и Sitemap.xml: зачем они нужны и как их составить

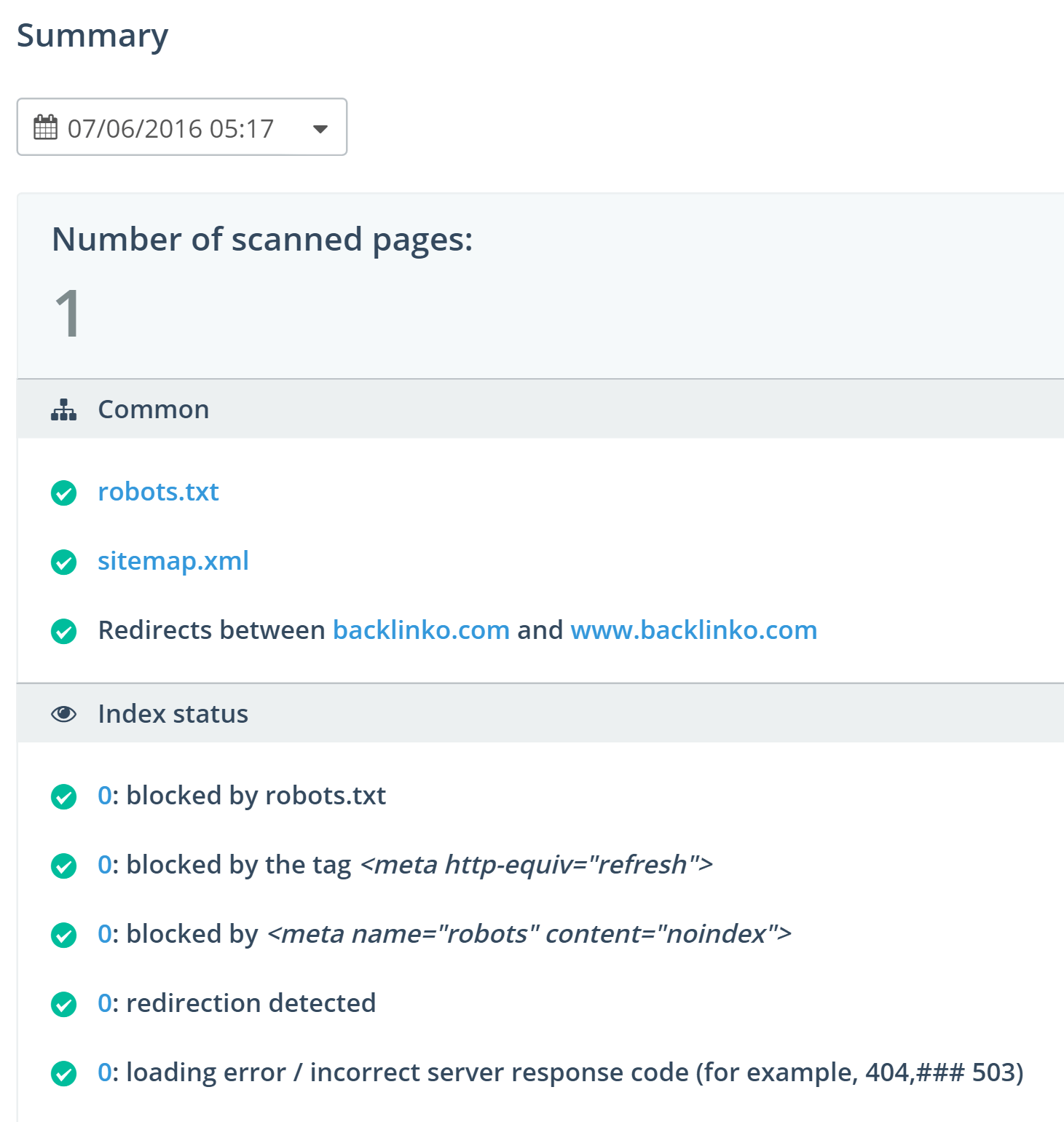

Seo продвижение веб-ресурса и его позиция в поиске напрямую зависят от того, как часто и быстро поисковики индексируют страницы сайта и вносят данные в свои базы. Чтобы дать понять поисковым роботам, какие страницы надо индексировать, а какие нельзя трогать, в корневой папке сайта должны быть два файла – Robots.txt и Sitemap.xml. Их создают после того, как выполнена внутренняя оптимизация веб-ресурса.

Зачем нужен файл Robots.txtПоисковые боты индексируют все, что находят. Однако на каждом сайте есть контент, который не подлежит индексации по разным причинам. К примеру, админпанель с приватной информацией, формы отправки данных и прочие страницы.

Robots.txt ограничивает действия поисковых ботов. В нем прописываются четкие инструкции для «веб-пауков», что им можно и что нельзя делать.

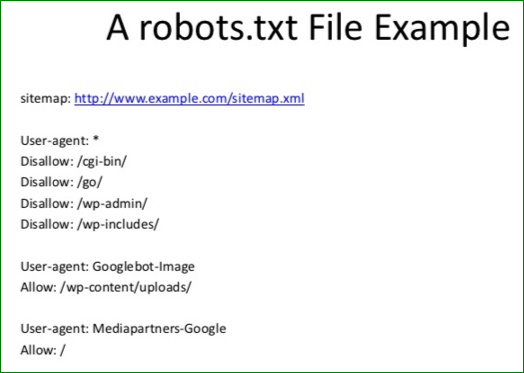

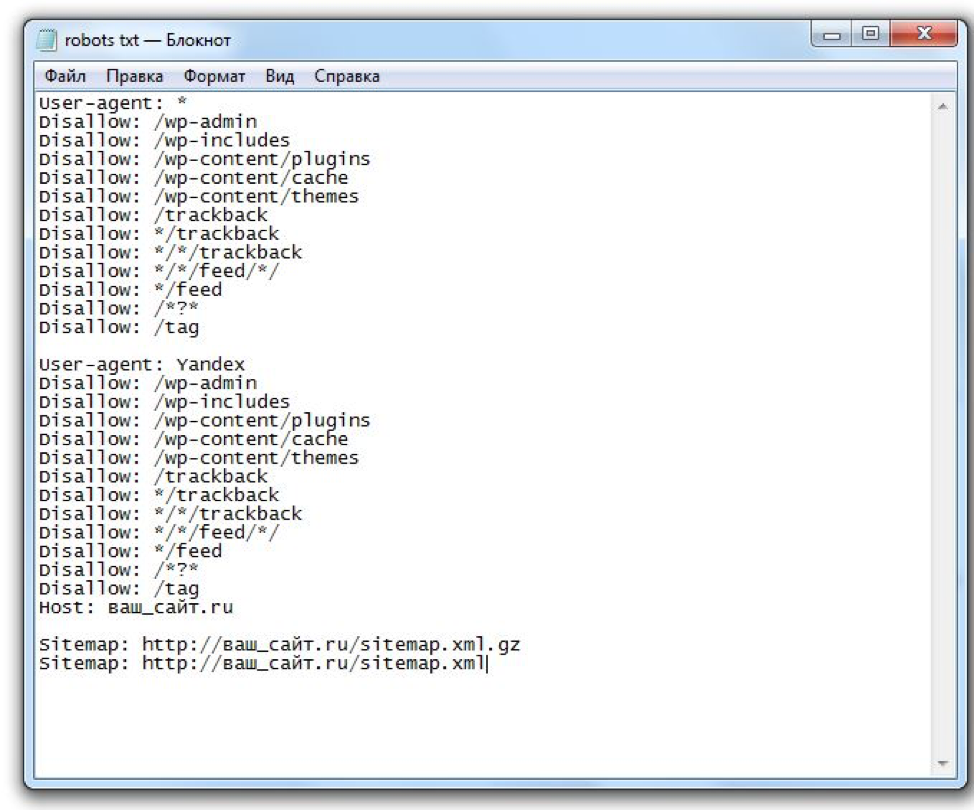

Как составлять Robots.txtRobots.txt можно составить в любом текстовом редакторе, он имеет простую структуру. В нем по определенным правилам записываются директивы для поисковых систем.

В нем по определенным правилам записываются директивы для поисковых систем.

Основные директивы Robots.txt:

- User-Agent – указывает перечень ботов, для которых прописаны инструкции;

- Disallow – запрещает сканирование отдельных страниц, папок или всего ресурса в целом;

- Allow – разрешает поисковым ботам доступ к конкретным частям сайта;

- Sitemap – указывает путь к файлу с картой сайта для индексации.

Для Яндекса важно дополнительно использовать директиву Host для указания основного зеркала.

Все команды в Robots.txt размещаются в отдельных строках.

Ошибки при составлении Robots.txt могут свести «на нет» все Seo продвижение. Поэтому важно соблюдать правила его написания:

- каждая директива пишется в отдельной строке;

- команды нельзя брать в кавычки;

- в конце директивы недопустимы знаки препинания.

Поисковики реагируют на регистр букв, поэтому имена папок и файлов должны быть прописаны точно так, как они указаны на сайте.

Создание файла Sitemap.xmlSitemap.xml, или карта сайта – это файл, который содержит сведения об индексируемых страницах. Она создается после того, как проведена внутренняя оптимизация сайта и удалены дубли.

Карту сайта лучше всего генерировать автоматически. Это можно сделать с помощью любого из многочисленных онлайн-сервисов или средствами «админки». Для каждой страницы указывается адрес, также можно заполнить ряд необязательных параметров – частоту обновления контента, приоритет, дату последнего обновления.

Если вы хотите пройти обучение, как создать sitemap.xml и robots.txt, или вообщем хотите обучиться Seo от профессионалов в сфере продвижения сайтов, пройдите по ссылке тут для более подробного ознакомления!

У вас есть вопросы?

Напишите нам в Whatsapp или позвоните по номеру +77019471903 и мы бесплатно ответим ваши вопросы, касающиеся разработки и продвижения сайта, запуска контекстной рекламы в интернет и др.

Написать в WhatsApp

Еще материалы по этой теме

WordPress Robots.txt optimization (+ XML Sitemap) – Website traffic, SEO & ranking Booster — Плагин для WordPress

Better Robots.txt создает WordPress виртуальный robots.txt, который помогает вам повысить SEO вашего сайта (возможности индексации, рейтинг в Google и т.

С помощью Better Robots.txt вы можете определить, каким поисковым системам разрешено сканировать ваш сайт (или нет), указать четкие инструкции о том, что им разрешено делать (или нет), а также определить задержку сканирования (чтобы защитить ваш хостинг-сервер от агрессивных действий). скребки). Better Robots.txt также дает вам полный контроль над содержимым WordPress robots.txt через поле пользовательских настроек.

Уменьшите экологический след вашего сайта и выбросы парниковых газов (CO2), свойственные его существованию в Интернете.

Краткий обзор:

vimeo.com/video/306589027″ frameborder=»0″ webkitallowfullscreen=»» mozallowfullscreen=»» allowfullscreen=»»>ПОДДЕРЖИВАЕТСЯ НА 7 ЯЗЫКАХ

Плагины Better Robots.txt переведены и доступны на следующих языках: китайский — 漢語 / English, английский, французский — французский, русский — русский, португальский — португальский, испанский — испанский, немецкий — немецкий

А вы знали…

- Файл robots.txt — это простой текстовый файл, размещаемый на вашем веб-сервере, который сообщает сканерам (например, Googlebot), должны ли они обращаться к файлу.

- Файл robots.txt контролирует, как пауки поисковых систем видят и взаимодействуют с вашими веб-страницами;

- Этот файл и боты, с которыми они взаимодействуют, являются фундаментальной частью работы поисковых систем;

- Первое, что искатель поисковой системы просматривает, когда он посещает страницу, — это файл robots.txt;

Robots.txt является источником SEO-сока, ожидающего разблокировки. Попробуйте лучше Robots.txt!

Попробуйте лучше Robots.txt!

О версии Pro (дополнительные функции):

1. Увеличьте свой контент в поисковых системах с помощью своей карты сайта!

Убедитесь, что ваши страницы, статьи и продукты, даже самые последние, принимаются во внимание поисковыми системами!

Плагин Better Robots.txt был создан для работы с плагином Yoast SEO (вероятно, лучший плагин SEO для веб-сайтов WordPress). Он обнаружит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, то он автоматически добавит инструкции в файл Robots.txt с просьбой ботов / сканеров прочитать вашу карту сайта и проверить, не вносили ли вы последние изменения в свой веб-сайт (чтобы поисковые системы могли сканировать новый доступный контент).

Если вы хотите добавить свою собственную карту сайта (или если вы используете другой плагин SEO), то вам просто нужно скопировать и вставить URL-адрес вашего файла Sitemap, и Better Robots.

2. Защитите свои данные и контент

Блокируйте плохих ботов со сбоев на вашем сайте и коммерциализации ваших данных.

Плагин Better Robots.txt помогает вам блокировать сканирование и удаление самых популярных вредоносных ботов.

Когда дело доходит до вещей, просматривающих ваш сайт, есть хорошие и плохие боты. Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие просматривают ваш сайт по более гнусным причинам, таким как удаление вашего контента (текст, цена и т. Д.) Для повторной публикации, загрузки целых архивов вашего сайта или извлечения ваших изображений. Сообщалось, что некоторые боты даже закрывали целые сайты из-за интенсивного использования широкополосного доступа.

Плагин Better Robots.txt защищает ваш сайт от пауков / скребков, определенных Distil Networks как плохие боты.

3. Скрыть и защитить свои обратные ссылки

Не позволяйте конкурентам определять ваши выгодные обратные ссылки.

Обратные ссылки, также называемые «входящими ссылками» или «входящими ссылками», создаются, когда один сайт ссылается на другой. Ссылка на внешний сайт называется обратной ссылкой. Обратные ссылки особенно ценны для SEO, потому что они представляют «вотум доверия» от одного сайта к другому. По сути, обратные ссылки на ваш сайт являются сигналом для поисковых систем, что другие ручаются за ваш контент.

Если многие сайты ссылаются на одну и ту же веб-страницу или веб-сайт, поисковые системы могут сделать вывод, что на контент стоит ссылаться, и, следовательно, также стоит показывать его в поисковой выдаче. Таким образом, получение этих обратных ссылок оказывает положительное влияние на рейтинг сайта или видимость поиска. В отрасли SEM специалисты часто определяют, откуда берутся эти обратные ссылки (конкуренты), чтобы выделить лучшие из них и создать высококачественные обратные ссылки для своих клиентов.

Учитывая, что создание очень выгодных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам легко идентифицировать и дублировать их, это чистая потеря эффективности.

Better Robots.txt поможет вам блокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки были необнаружимыми.

4. Избегайте обратных ссылок спама

Боты, заполняющие формы комментариев вашего сайта, которые сообщают вам «отличную статью», «любят информацию», «надеются, что вы сможете более подробно остановиться на этой теме», или даже предоставят персонализированные комментарии, в том числе имя автора легион. Спам-боты со временем становятся все более умными, и, к сожалению, спам-комментарии в комментариях действительно могут повредить вашему профилю обратных ссылок. Better Robots.txt поможет вам избежать индексации этих комментариев поисковыми системами.

5. Инструменты Seo

При улучшении нашего плагина мы добавили ссылки на ярлыки к двум очень важным инструментам (если вас интересует ваш рейтинг в поисковых системах): Google Search Console & Bing Webmaster Tool. Если вы еще не используете их, вы можете теперь управлять индексацией своего сайта, оптимизируя свой robots. txt! Также был добавлен прямой доступ к инструменту массового пинга, который позволяет пинговать ваши ссылки в более чем 70 поисковых системах.

txt! Также был добавлен прямой доступ к инструменту массового пинга, который позволяет пинговать ваши ссылки в более чем 70 поисковых системах.

Мы также создали 4 ссылки для быстрого доступа к лучшим онлайн-инструментам SEO, которые доступны непосредственно на Better Robots.txt SEO PRO. Таким образом, когда вы захотите, теперь вы сможете проверить эффективность загрузки своего сайта, проанализировать свой показатель SEO, определить свой текущий рейтинг по поисковой выдаче с ключевыми словами и трафиком и даже просканировать весь сайт на наличие неработающих ссылок (404, 503 ошибки, …), Прямо из плагина.

6. Будьте уникальным

Мы подумали, что могли бы добавить немного оригинальности в Better Robots.txt, добавив функцию, позволяющую «настроить» ваш WordPress robots.txt с вашей собственной уникальной «подписью». Большинство крупных компаний в мире персонализировали свои robots.txt добавив пословицы (https://www.yelp.com/robots.txt), слоганы (https://www.youtube. com/robots.txt) или даже рисунки ((https://store.nike.com/robots.txt — внизу). И почему не ты тоже? Вот почему мы выделили определенную область на странице настроек, где вы можете написать или нарисовать все, что хотите (действительно), не влияя на эффективность вашего robots.txt.

com/robots.txt) или даже рисунки ((https://store.nike.com/robots.txt — внизу). И почему не ты тоже? Вот почему мы выделили определенную область на странице настроек, где вы можете написать или нарисовать все, что хотите (действительно), не влияя на эффективность вашего robots.txt.

7. Запретить роботам сканировать бесполезные ссылки WooCommerce

Мы добавили уникальную функцию, позволяющую блокировать определенные ссылки («add-to-cart», «orderby», «fllter», корзина, аккаунт, оформление заказа и т. Д.) Для поисковых систем. Большинство из этих ссылок требуют много ресурсов ЦП, памяти и пропускной способности (на хост-сервере), потому что они не кэшируются и / или создают «бесконечные» циклы сканирования (пока они бесполезны). Оптимизация вашего WordPress robots.txt для WooCommerce при наличии интернет-магазина позволяет обеспечить большую вычислительную мощность для действительно важных страниц и повысить производительность загрузки.

8. Избегайте ловушек на гусеничном ходу:

«Ловушки сканеров» — это структурная проблема на веб-сайте, из-за которой сканеры находят практически бесконечное количество нерелевантных URL-адресов.

9. Инструменты для взлома роста

Сегодня самые быстрорастущие компании, такие как Amazon, Airbnb и Facebook, добились прорывного роста, объединив свои команды в высокоскоростной процесс тестирования / обучения. Мы говорим о взломе роста. Хакерство роста — это процесс быстрого экспериментирования и реализации маркетинговых и рекламных стратегий, которые ориентированы исключительно на эффективный и быстрый рост бизнеса. Better Robots.txt предоставляет список из 150+ инструментов, доступных онлайн, чтобы ускорить ваш рост.

10. Robots.txt Post Meta Box для ручных исключений

Этот почтовый мета-бокс позволяет установить «вручную», должна ли страница быть видимой (или нет) в поисковых системах, внедрив специальное правило «disallow» + «noindex» в ваш WordPress robots. txt. Почему это актив для вашего рейтинга в поисковых системах? Просто потому, что некоторые страницы не предназначены для сканирования / индексации. Страницы с благодарностью, целевые страницы, страницы, содержащие исключительно формы, полезны для посетителей, но не для сканеров, и вам не нужно, чтобы они были видны в поисковых системах. Кроме того, некоторые страницы, содержащие динамические календари (для онлайн-бронирования), НИКОГДА не должны быть доступны сканерам, поскольку они имеют тенденцию заманивать их в бесконечные циклы сканирования, что напрямую влияет на ваш бюджет сканирования (и ваш рейтинг).

txt. Почему это актив для вашего рейтинга в поисковых системах? Просто потому, что некоторые страницы не предназначены для сканирования / индексации. Страницы с благодарностью, целевые страницы, страницы, содержащие исключительно формы, полезны для посетителей, но не для сканеров, и вам не нужно, чтобы они были видны в поисковых системах. Кроме того, некоторые страницы, содержащие динамические календари (для онлайн-бронирования), НИКОГДА не должны быть доступны сканерам, поскольку они имеют тенденцию заманивать их в бесконечные циклы сканирования, что напрямую влияет на ваш бюджет сканирования (и ваш рейтинг).

11. Ads.txt & App-ads.txt crawlability

In order to ensure that ads.txt & app-ads.txt can be crawled by search engines, Better Robots.txt plugin makes sure they are by default allowed in Robots.txt file no matter your configuration. For your information, Authorized Digital Sellers for Web, or ads.txt, is an IAB initiative to improve transparency in programmatic advertising. You can create your own ads.txt files to identify who is authorized to sell your inventory. The files are publicly available and crawlable by exchanges, Supply-Side Platforms (SSP), and other buyers and third-party vendors. Authorized Sellers for Apps, or app-ads.txt, is an extension to the Authorized Digital Sellers standard. It expands compatibility to support ads shown in mobile apps.

You can create your own ads.txt files to identify who is authorized to sell your inventory. The files are publicly available and crawlable by exchanges, Supply-Side Platforms (SSP), and other buyers and third-party vendors. Authorized Sellers for Apps, or app-ads.txt, is an extension to the Authorized Digital Sellers standard. It expands compatibility to support ads shown in mobile apps.

Еще больше, как всегда…

Как добавить файлы Sitemap в robots.txt? » Rank Math

Файлы Sitemap сообщают Google, какие страницы вашего веб-сайта являются наиболее важными и должны быть проиндексированы. Хотя существует множество способов создать карту сайта, добавление ее в файл robots.txt — один из лучших способов убедиться, что Google увидит ее.

В этой статье базы знаний мы покажем вам, как добавлять карты сайта в файл robots.txt с помощью Rank Math. Мы также объясним преимущества добавления карты сайта и то, как она может помочь улучшить рейтинг вашего сайта в поисковых системах.

Начнем!

1 Преимущества добавления карты сайта

Добавление карты сайта на ваш веб-сайт помогает Google быстрее индексировать ваш сайт. Это связано с тем, что карта сайта сообщает Google, какие страницы вашего сайта являются наиболее важными и должны быть проиндексированы.

Еще одним преимуществом добавления карты сайта является то, что она может помочь улучшить рейтинг вашего сайта в поисковых системах. Это связано с тем, что карты сайта помогают Google понять структуру вашего веб-сайта и отношения между вашими страницами и типами сообщений.

2 Как добавить карту сайта в файл robots.txt с помощью Rank Math

Добавление карты сайта в файл robots.txt — отличный способ убедиться, что Google увидит его. В этом разделе мы покажем вам, как это сделать с помощью Rank Math.

2.1 Вход на ваш веб-сайт WordPress

Во-первых, вам необходимо войти на свой веб-сайт WordPress и установить плагин Rank Math. Для получения дополнительной информации о том, как это сделать, см. статью нашей базы знаний «Как установить Rank Math».

статью нашей базы знаний «Как установить Rank Math».

2.2 Перейдите к Edit Robots.txt

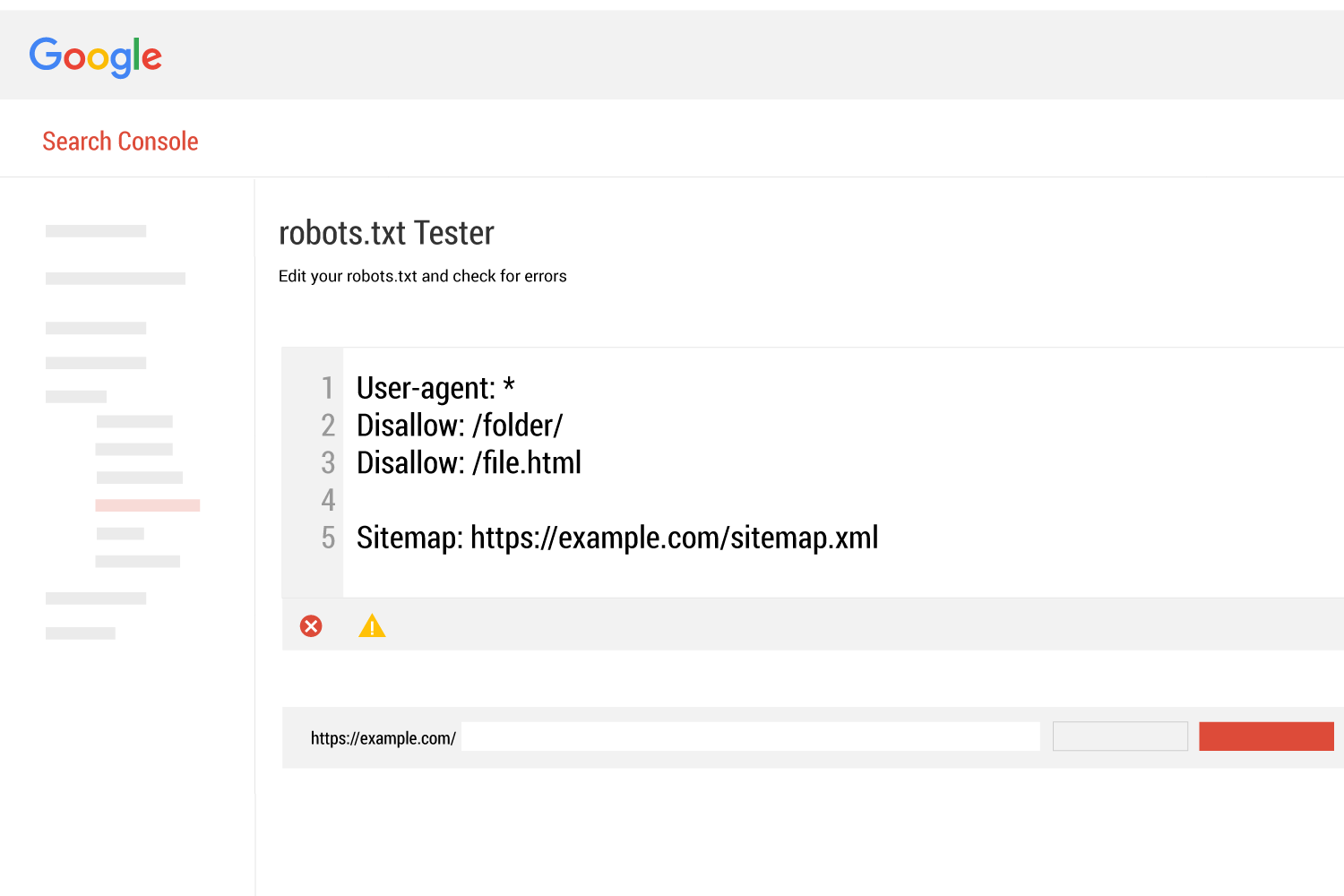

Перейдите к файлу robots.txt в Rank Math, который находится в разделе Панель управления WordPress > Rank Math > Общие настройки > Edit robots.txt , как показано ниже:

2.3 Добавьте URL-адрес карты сайта в Ваш Robots.txt

По умолчанию Rank Math автоматически добавит набор правил ( включая вашу карту сайта ) в ваш файл robots.txt. Но вы всегда можете добавить/отредактировать код по своему усмотрению из доступной текстовой области.

Теперь вам нужно ввести URL вашей карты сайта в это поле. URL-адрес будет разным для каждого веб-сайта. Например, если ваш веб-сайт — example.com, URL-адрес карты сайта будет иметь вид example.com/sitemap.xml.

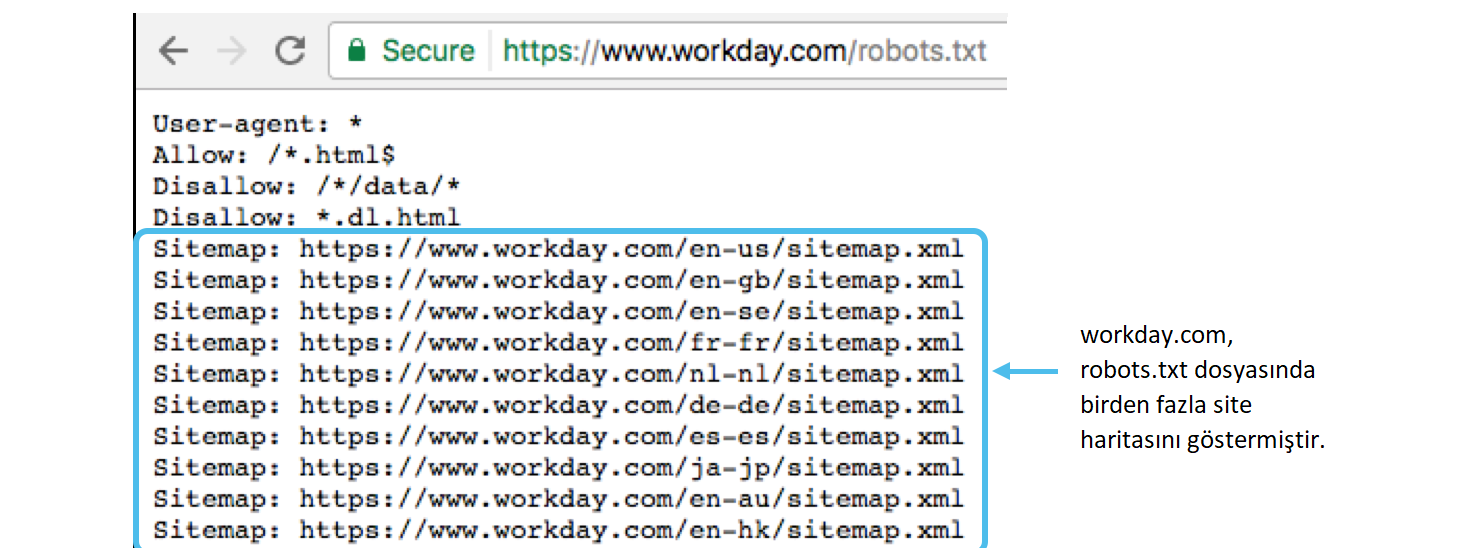

Вы также можете добавить несколько URL-адресов карты сайта, если у вас более одной карты сайта. Например, если у вас есть карта сайта для видео, вы также должны ввести URL-адрес этой карты сайта.

Вот некоторые из примеров справочных URL-адресов, которые вы можете использовать:

-

Карта сайта: https://example.com/sitemap.xml -

Карта сайта: https://example.com/post-sitemap.xml -

Карта сайта: https://example.com/page-sitemap.xml -

Карта сайта: https://example. com/category-sitemap.xml -

Карта сайта: https://example.com/video-sitemap.xml

Но вместо того, чтобы перечислять отдельные URL-адреса, вы можете просто включить индекс карты сайта, и поисковые системы смогут вытащите все отдельные карты сайта отсюда. Это также полезно — если вы в конечном итоге добавите или удалите карты сайта, вам не нужно вносить эти изменения в файл robots.txt вручную.

-

Карта сайта: https://example.com/sitemap_index.xml

Для дальнейших действий см. снимок экрана ниже:

2.4 Сохраните изменения

После добавления URL-адреса карты сайта в файл robots. t хт файл, вам необходимо сохранить изменения. Вы можете сделать это, нажав кнопку Сохранить изменения внизу страницы.

t хт файл, вам необходимо сохранить изменения. Вы можете сделать это, нажав кнопку Сохранить изменения внизу страницы.

Предупреждение: Будьте осторожны, внося существенные или незначительные изменения на свой веб-сайт с помощью файла robots.txt. Хотя эти изменения могут улучшить ваш поисковый трафик, они также могут принести больше вреда, чем пользы, если вы не будете осторожны.

Заключение:

Наконец, мы показали вам, как добавлять карты сайта в файл robots.txt с помощью Rank Math. Мы также объяснили преимущества добавления карты сайта и то, как она может помочь улучшить рейтинг вашего сайта в поисковых системах. Мы надеемся, что эта статья была вам полезна. Если у вас есть абсолютно какие-либо вопросы, пожалуйста, не стесняйтесь обращаться в нашу службу поддержки, которая доступна 24/7 и готова помочь.

Что такое карта сайта? XML-карта сайта и файл robots.txt

Любой, кто разбирается в сложности поисковой оптимизации (SEO), знает, что важная часть улучшения рейтинга веб-сайта в поисковых системах включает в себя разрешение сканирования и индексации его страниц с помощью чего-то, известного как бот или робот.

Эти боты предназначены для проверки удобства использования и релевантности определенных веб-сайтов для пользователей поисковых систем, предоставления и ранжирования результатов в соответствии с их выводами.

Чтобы убедиться, что ваш веб-сайт предоставляет ботам всю информацию, необходимую им для быстрого и эффективного чтения вашего веб-сайта, вам необходимо сосредоточиться на двух важных файлах: файле robots.txt и XML-карте сайта.

Что такое файл robots.txt?

Этот файл известен как директива сканирования. Другими словами, он указывает ботам поисковых систем сканировать веб-сайт определенным образом, следуя строгому синтаксису. Цель файла — сообщить поисковым системам, какие URL-адреса им разрешено индексировать на данном веб-сайте.

Для компаний важно размещать этот файл на своих веб-сайтах, так как это первое, что бот будет искать при входе на ваш сайт. Даже если вы хотите, чтобы бот просканировал все страницы вашего сайта, вам понадобится файл robots. txt по умолчанию, чтобы направить его так, чтобы это приносило пользу вашему SEO.

txt по умолчанию, чтобы направить его так, чтобы это приносило пользу вашему SEO.

Куда следует поместить файл robots.txt?

Файл robot.txt всегда должен находиться в корне домена веб-сайта. Другими словами, если у вас есть веб-сайт, такой как https://www.segmentseo.com, файл будет находиться по адресу https://www.segmentseo.com/robots.txt.

Каковы преимущества использования файла robots.txt?

Вообще говоря, поисковые роботы заходят на веб-сайт с заранее определенным «допуском», определяющим, сколько страниц им разрешено сканировать в зависимости от размера или репутации сайта. Это также известно как «краулинговый бюджет».

С помощью файла robot.text вы можете запретить поисковым системам вводить проблемные части вашего сайта, которые могут быть недостаточно оптимизированы для маркетинговых целей. Если вы решите оптимизировать содержимое позже, вы можете отредактировать файл и снова разрешить его.

Что такое XML-карта сайта?

Карта сайта XMP — это документ, в котором перечислены все страницы веб-сайта. Разработанный для поисковых систем, он предлагает информацию о доступном контенте и способах его доступа. Иногда он также предоставляет информацию о том, когда в последний раз обновлялись отдельные страницы и насколько важны определенные части сайта для пользователей или потенциальных клиентов.

Разработанный для поисковых систем, он предлагает информацию о доступном контенте и способах его доступа. Иногда он также предоставляет информацию о том, когда в последний раз обновлялись отдельные страницы и насколько важны определенные части сайта для пользователей или потенциальных клиентов.

Проще говоря, XML-карта сайта предлагает поисковым системам моментальный снимок всего доступного содержимого веб-сайта одновременно. Это позволяет им молниеносно находить недавно добавленный контент и упрощает понимание содержания сайта.

Важно не путать карты сайта в формате XML с картами сайта, с которыми регулярно сталкиваются обычные пользователи Интернета (известными как карты сайта в формате HTML). В то время как последний предназначен для обучения пользователей веб-сайта, первый предназначен исключительно для использования поисковыми системами.

Почему XML-карты сайта важны?

XML-карты сайта — это эффективный способ оповещения поисковых систем при создании или обновлении контента.