Robots.txt и Sitemap.xml: зачем они нужны и как их составить

Seo продвижение веб-ресурса и его позиция в поиске напрямую зависят от того, как часто и быстро поисковики индексируют страницы сайта и вносят данные в свои базы. Чтобы дать понять поисковым роботам, какие страницы надо индексировать, а какие нельзя трогать, в корневой папке сайта должны быть два файла – Robots.txt и Sitemap.xml. Их создают после того, как выполнена внутренняя оптимизация веб-ресурса.

Зачем нужен файл Robots.txtПоисковые боты индексируют все, что находят. Однако на каждом сайте есть контент, который не подлежит индексации по разным причинам. К примеру, админпанель с приватной информацией, формы отправки данных и прочие страницы.

Robots.txt ограничивает действия поисковых ботов. В нем прописываются четкие инструкции для «веб-пауков», что им можно и что нельзя делать.

Как составлять Robots.txtRobots.txt можно составить в любом текстовом редакторе, он имеет простую структуру. В нем по определенным правилам записываются директивы для поисковых систем.

В нем по определенным правилам записываются директивы для поисковых систем.

Основные директивы Robots.txt:

- User-Agent – указывает перечень ботов, для которых прописаны инструкции;

- Disallow – запрещает сканирование отдельных страниц, папок или всего ресурса в целом;

- Allow – разрешает поисковым ботам доступ к конкретным частям сайта;

- Sitemap – указывает путь к файлу с картой сайта для индексации.

Для Яндекса важно дополнительно использовать директиву Host для указания основного зеркала.

Все команды в Robots.txt размещаются в отдельных строках.

Ошибки при составлении Robots.txt могут свести «на нет» все Seo продвижение. Поэтому важно соблюдать правила его написания:

- каждая директива пишется в отдельной строке;

- команды нельзя брать в кавычки;

- в конце директивы недопустимы знаки препинания.

Поисковики реагируют на регистр букв, поэтому имена папок и файлов должны быть прописаны точно так, как они указаны на сайте.

Создание файла Sitemap.xmlSitemap.xml, или карта сайта – это файл, который содержит сведения об индексируемых страницах. Она создается после того, как проведена внутренняя оптимизация сайта и удалены дубли.

Карту сайта лучше всего генерировать автоматически. Это можно сделать с помощью любого из многочисленных онлайн-сервисов или средствами «админки». Для каждой страницы указывается адрес, также можно заполнить ряд необязательных параметров – частоту обновления контента, приоритет, дату последнего обновления.

Если вы хотите пройти обучение, как создать sitemap.xml и robots.txt, или вообщем хотите обучиться Seo от профессионалов в сфере продвижения сайтов, пройдите по ссылке тут для более подробного ознакомления!

У вас есть вопросы?

Напишите нам в Whatsapp или позвоните по номеру +77019471903 и мы бесплатно ответим ваши вопросы, касающиеся разработки и продвижения сайта, запуска контекстной рекламы в интернет и др.

Написать в WhatsApp

Еще материалы по этой теме

WordPress Robots.txt optimization (+ XML Sitemap) – Website traffic, SEO & ranking Booster — Плагин для WordPress

Better Robots.txt creates a WordPress virtual robots.txt, helps you boost your website SEO (indexing capacities, Google ranking,etc.) and your loading performance –Compatible with Yoast SEO, Google Merchant, WooCommerce and Directory based network sites (MULTISITE)

With Better Robots.txt, you can identify which search engines are allowed to crawl your website (or not), specify clear instructions aboutwhat they are allowed to do (or not) and define a crawl-delay (to protect your hosting server against aggressive scrapers). Better Robots.txt also gives you full control over your WordPress robots.txt content via the custom setting box.

Reduce your site’s ecological footprint and the greenhouse gas (CO2) production inherent to its existence on the Web.

Краткий обзор:

SUPPORTED IN 7 LANGUAGES

Better Robots.txt plugins are translated and available in: Chinese –汉语/漢語, English, French – Français, Russian –Руссɤɢɣ, Portuguese – Português, Spanish – Español, German – Deutsch

А вы знали…

- The robots.txt file is a simple text file placed on your web server which tells web crawlers (like Googlebot) whether they should access a file.

- The robots.txt file controls how search engine spiders see and interact with your web pages;

- This file and the bots they interact with are fundamental parts of how search engines work;

- Первое, что искатель поисковой системы просматривает, когда он посещает страницу, — это файл robots.txt;

Robots.txt является источником SEO-сока, ожидающего разблокировки. Попробуйте лучше Robots.txt!

Попробуйте лучше Robots.txt!

О версии Pro (дополнительные функции):

1. Увеличьте свой контент в поисковых системах с помощью своей карты сайта!

Make sure your pages, articles, and products, even the latest, are taken into consideration by search engines !

The Better Robots.txt plugin was made to work with the Yoast SEO plugin (probably the best SEO Plugin for WordPress websites). It will detect if you are currently using Yoast SEO and if the sitemap feature is activated. If it is, then it will add instructions automatically into the Robots.txt file asking bots/crawlers to read your sitemap and check if you have made recent changes in your website (so that search engines can crawl the new content that is available).

If you want to add your own sitemap (or if you are using another SEO plugin), then you just have to copy and paste your Sitemap URL, and Better Robots.txt will add it into your WordPress Robots.txt.

2. Защитите свои данные и контент

Защитите свои данные и контент

Блокируйте плохих ботов со сбоев на вашем сайте и коммерциализации ваших данных.

The Better Robots.txt plugin helps you block most popular bad bots from crawling and scraping your data.

When it comes to things crawling your site, there are good bots and bad bots. Good bots, like Google bot, crawl your site to index it for search engines. Others crawl your site for more nefarious reasons such as stripping out your content (text, price, etc.) for republishing, downloading whole archives of your site or extracting your images. Some bots were even reported to pull down entire websites as a result of heavy use of broadband.

The Better Robots.txt plugin protects your website against spiders/scrapers identified as bad bots by Distil Networks.

3. Скрыть и защитить свои обратные ссылки

Stop competitors from identifying your profitable backlinks.

Backlinks, also called “inbound links” or “incoming links” are created when one website links to another.

If many sites link to the same webpage or website, search engines can infer that the content is worth linking to, and therefore also worth showing on a SERP. So, earning these backlinks generates a positive effect on a site’s ranking position or search visibility. In the SEM industry, it is very common for specialists to identify where these backlinks come from (competitors) in order to sort out the best of them and generate high-quality backlinks for their own customers.

Учитывая, что создание очень выгодных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам легко идентифицировать и дублировать их, это чистая потеря эффективности.

Better Robots. txt поможет вам блокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки были необнаружимыми.

txt поможет вам блокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки были необнаружимыми.

4. Избегайте обратных ссылок спама

Bots populating your website’s comment forms telling you ‘great article,’ ‘love the info,’ ‘hope you can elaborate more on the topic soon’ or even providing personalized comments, including author name are legion. Spambots get more and more intelligent with time, and unfortunately, comment spam links can really hurt your backlink profile. Better Robots.txt helps you avoid these comments from being indexed by search engines.

5. Инструменты Seo

While improving our plugin, we added shortcut links to 2 very important tools (if you are concerned with your ranking on search engines): Google Search Console & Bing Webmaster Tool. In case you are not already using them, you may now manage your website indexing while optimizing your robots.txt ! Direct access to a Mass ping tool was also added, allowing you to ping your links on more than 70 search engines.

We also created 4 shortcut links related to the best Online SEO Tools, directly available on Better Robots.txt SEO PRO. So that, whenever you want, you are now able to check out your site’s loading performance, analyze your SEO score, identify your current ranking on SERPs with keywords & traffic, and even scan your entire website for dead links (404, 503 errors, …), directly from the plugin.

6. Будьте уникальным

We thought that we could add a touch of originality on Better Robots.txt by adding a feature allowing you to “customize” your WordPress robots.txt with your own unique “signature.” Most major companies in the world have personalized their robots.txt by adding proverbs (https://www.yelp.com/robots.txt), slogans (https://www.youtube.com/robots.txt) or even drawings (https://store.nike.com/robots.txt – at the bottom). And why not you too? That’s why we have dedicated a specific area on the settings page where you can write or draw whatever you want (really) without affecting your robots.

7. Prevent robots crawling useless WooCommerce links

We added a unique feature allowing to block specific links («add-to-cart», «orderby», «fllter», cart, account, checkout, …) from being crawled by search engines. Most of these links require a lot of CPU, memory & bandwidth usage (on hosting server) because they are not cacheable and/or create «infinite» crawling loops (while they are useless). Optimizing your WordPress robots.txt for WooCommerce when having an online store, allows to provide more processing power for pages that really matter and boost your loading performance.

8. Avoid crawler traps:

«Crawler traps” are a structural issue within a website that causes crawlers to find a virtually infinite number of irrelevant URLs. In theory, crawlers could get stuck in one part of a website and never finish crawling these irrelevant URLs. Better Robots.txt helps prevent crawler traps which hurt crawl budget and cause duplicate content.

9. Growth hacking tools

Today’s fastest growing companies like Amazon, Airbnb and Facebook have all driven breakout growth by aligning their teams around a high velocity testing/learning process. We are talking about Growth Hacking. Growth hacking is a process of rapidly experimenting with and implementing marketing and promotional strategies that are solely focused on efficient and rapid business growth. Better Robots.txt provide a list of 150+ tools available online to skyrocket your growth.

10. Robots.txt Post Meta Box for manual exclusions

This Post Meta Box allows to set «manually» if a page should be visible (or not) on search engines by injecting a dedicated «disallow» + «noindex» rule inside your WordPress robots.txt. Why is it an asset for your ranking on search engines ? Simply because some pages are not meant to be crawled / indexed. Thank you pages, landing pages, page containing exclusively forms are useful for visitors but not for crawlers, and you don’t need them to be visible on search engines. Also, some pages containing dynamic calendars (for online booking) should NEVER be accessible to crawlers beause they tend to trap them into infinite crawling loops which impacts directly your crawl budget (and your ranking).

Also, some pages containing dynamic calendars (for online booking) should NEVER be accessible to crawlers beause they tend to trap them into infinite crawling loops which impacts directly your crawl budget (and your ranking).

11. Ads.txt & App-ads.txt crawlability

In order to ensure that ads.txt & app-ads.txt can be crawled by search engines, Better Robots.txt plugin makes sure they are by default allowed in Robots.txt file no matter your configuration. For your information, Authorized Digital Sellers for Web, or ads.txt, is an IAB initiative to improve transparency in programmatic advertising. You can create your own ads.txt files to identify who is authorized to sell your inventory. The files are publicly available and crawlable by exchanges, Supply-Side Platforms (SSP), and other buyers and third-party vendors. Authorized Sellers for Apps, or app-ads.txt, is an extension to the Authorized Digital Sellers standard. It expands compatibility to support ads shown in mobile apps.

More to come as always …

Как добавить карту сайта в robots.txt (полное руководство)

Содержание

Прежде чем углубиться в тему карты сайта robots.txt, нам нужно вспомнить несколько элементов о файлах robots.txt. Вы можете представить себе файлы robots.txt как своего рода интеллектуальное руководство или инструкцию для роботов поисковых систем. Они указывают, какие страницы следует или не следует сканировать, а также определяют, каким роботам разрешено сканировать ваш сайт.

Другими словами, robots.txt — это текстовый файл или основной компонент веб-сайта. Он может быть в разных форматах, в зависимости от цели, которой он должен служить. Например, если вы не хотите, чтобы ваш сайт был слишком ограничительным или избирательным, области файла «User-agent» и «Disallow» можно оставить почти пустыми.

С другой стороны, если вы намерены дать определенные инструкции сканирующим роботам, вам придется заполнить эти области дополнительной информацией о том, каким «агентам пользователя» вы хотите предоставить доступ или какие URL-адреса вы «запретите». Однако следует помнить одну вещь: вы не можете контролировать ботов на 100%. Даже если они будут следовать указаниям, записанным в ваших файлах, они также сами решат, что делать, если ваши файлы запутаны или в них отсутствуют некоторые обязательные детали.

Говоря о дополнительной информации, давайте не будем забывать, что для каждого из ваших поддоменов требуются отдельные файлы robot.txt. Допустим, ваше доменное имя — inflatablemugs.com: вам понадобится файл для домена, а также для связанных с ним субдоменов (например, contact.inflatablemugs.com, about.inflatablemugs.com и т. д.).

Что делать с файлами Sitemap?

Некоторые из вас могут видеть формулы, такие как карта сайта robots.txt, и не до конца понимать, что они обозначают. Мы уже пытались освежить в памяти понятие robot.txt в первом разделе этой статьи. Теперь давайте позаботимся о части карты сайта. На самом деле, термин «протокол карты сайта» был бы более подходящим.

Мы уже пытались освежить в памяти понятие robot.txt в первом разделе этой статьи. Теперь давайте позаботимся о части карты сайта. На самом деле, термин «протокол карты сайта» был бы более подходящим.

После первых попыток Google в 2005 г. в 2006 г. было объявлено о более сложном протоколе Sitemaps под совместным контролем Google, Microsoft и Yahoo!. Грубо говоря, основная идея заключалась в том, чтобы предложить некоторую поддержку веб-мастерам, которые хотели предоставлять более точную информацию о своих сайтах поисковым системам. Карта сайта действительно сопоставима с документом, удостоверяющим личность для веб-сайтов, поскольку поисковые системы идентифицируют контент сайта благодаря ему.

Существуют разные типы карт сайта, каждый из которых отображает определенные элементы: карты сайта в формате XML, карты сайта для изображений, карты сайта для видео, карты сайта для новостей… Таким образом, поисковые системы подхватывают то, что им нужно. Они также получают информацию о наиболее важных частях сайта. На самом деле карты сайта являются аналогом файлов robots.txt: первый следует инклюзивной логике, а второй направлен на исключение ненужных элементов, когда это необходимо. Теперь мы сосредоточимся на том, как работает это партнерство или что нам следует делать, когда мы хотим добавить карту сайта в robots.txt.

На самом деле карты сайта являются аналогом файлов robots.txt: первый следует инклюзивной логике, а второй направлен на исключение ненужных элементов, когда это необходимо. Теперь мы сосредоточимся на том, как работает это партнерство или что нам следует делать, когда мы хотим добавить карту сайта в robots.txt.

Как добавить карту сайта в файлы robots.txt

Наиболее распространенный способ получить карту сайта robots.txt (то есть добавить карту сайта в robots.txt) выглядит следующим образом:

Шаг 1: Определите URL-адрес карты сайта

Прежде всего, вам нужно найти XML-карту сайта, также известную как самая важная карта сайта, чтобы выделить наиболее важные страницы. Если ваш сайт был создан кем-то другим, вам следует связаться с разработчиком, чтобы получить информацию о вашей карте сайта. Действительно, вам нужно получить доступ к вашему файловому менеджеру. Давайте еще раз возьмем наш пример с inflatablemugs.com. URL-адрес по умолчанию для этой карты сайта:

https://www. inflatablemugs.com/sitemap.xml

inflatablemugs.com/sitemap.xml

Если у вас есть несколько XML-карт сайта (в зависимости от требований вашего сайта), они будут сгруппированы в индекс карты сайта. В этом случае URL-адрес будет выглядеть так:

https://inflatablemugs.com/sitemap_index.html

Существует множество других известных решений для доступа к картам сайта. Среди них мы можем назвать генераторы XML-карт сайта, такие как доступный на xml-sitemaps.com. Эта услуга бесплатна для объемов, меньших или равных 500 страницам. Вы также можете использовать поиск Google, если ваш сайт уже проиндексирован Google. Если это так, вы можете ввести информацию об операторе, такую как:

тип файла:xml сайт:inflatablemugs.com

Шаг 2: Найдите файл robots.txt

Для начала вам понадобится текстовый файл с расширением «.txt». Это довольно легко создать. Помните области «User-agent» и «Disallow»? Ну и заполнять их надо так:

User-agent: * Disallow:

Да, в данном случае информации почти нет, потому что цель здесь не в том, чтобы ограничить доступ, а в том, чтобы быть видимым. Другими словами, то, что вы пытаетесь сделать здесь, это предоставить информацию для каталога вашего сервера. Когда вы закончите, вы можете проверить, существует ли файл, набрав что-то вроде:

Другими словами, то, что вы пытаетесь сделать здесь, это предоставить информацию для каталога вашего сервера. Когда вы закончите, вы можете проверить, существует ли файл, набрав что-то вроде:

https://www.inflatablemugs.com/robots.txt

Само собой разумеется, что центральная часть в приведенном выше примере должна быть заменена вашим собственным доменным именем.

Шаг 3. Добавьте карту сайта в файл Robots.txt

Вот и все. Это последний шаг, на котором вы можете добавить карту сайта в файл robots.txt. Последний нужно будет немного отредактировать, чтобы вы могли включить URL-адрес вашей карты сайта. Если мы используем наш предыдущий пример, то есть inflatablemugs.com, то запись будет выглядеть так: Карта сайта: https://www.inflatablemugs.com/sitemap.xml

ПОСЛЕДНИЕ ПОСТЫ

Вы, наверное, уже слышали: Необратимые ветры перемен дуют в отношении Google Analytics. Срок? 1 июля 2023 года. В этот день г…

Пришло время познакомиться с Google Analytics 4 поближе. Почему? Ну, просто потому, что это будет новый способ сбора данных…

Почему? Ну, просто потому, что это будет новый способ сбора данных…

Это означает, что файл robots.txt станет: Карта сайта: https://www.inflatablemugs.com/sitemap.xml

Пользователь -agent: * Запретить:

Если у вас большой сайт и/или несколько подразделов, вам, скорее всего, понадобится более одной карты сайта. Действительно, группировка различных элементов поможет вам лучше организовать работу. Это означает, что вы должны создать индексный файл карты сайта (концепция уже упоминалась в предыдущих абзацах). Не волнуйся; это не так сложно, как может показаться. Это просто более крупный XML-файл карты сайта.

Чтобы создать файл индекса карты сайта, у вас есть две основные возможности:

- Вы можете сообщить URL-адрес файла индекса карты сайта в файле robots.txt, который уже обсуждался выше. Результат будет выглядеть следующим образом:

Карта сайта: https://www.inflatablemugs.com/sitemap_index.xml

Пользовательский агент: * Disallow: - Или вы также можете сообщать URL каждого файла карты сайта отдельно, как показано ниже:

Карта сайта: https://www. inflatablemugs.com/sitemap_1.xml

inflatablemugs.com/sitemap_1.xml

Карта сайта: https://www.inflatablemugs.com/sitemap_2.xml

User-agent: * Disallow:

Заключение по добавлению карты сайта в robots.txt

Как видите, файлы robots.txt и карты сайта образуют эффективную комбинацию, которую можно рассматривать как основной протокол веб-сайта. Используя их, вы получаете возможность улучшить планирование своего веб-сайта, предоставить необходимую информацию поисковым системам и, следовательно, выиграть значительное количество времени. Другими словами, вы собираете ключевые ингредиенты для полноценного веб-сайта с более высокой вероятностью индексации. Если вы хотите сделать несколько шагов назад и узнать о создании robots.txt, прочтите другой наш пост.

Как добавить файлы Sitemap в robots.

txt? » Rank Math

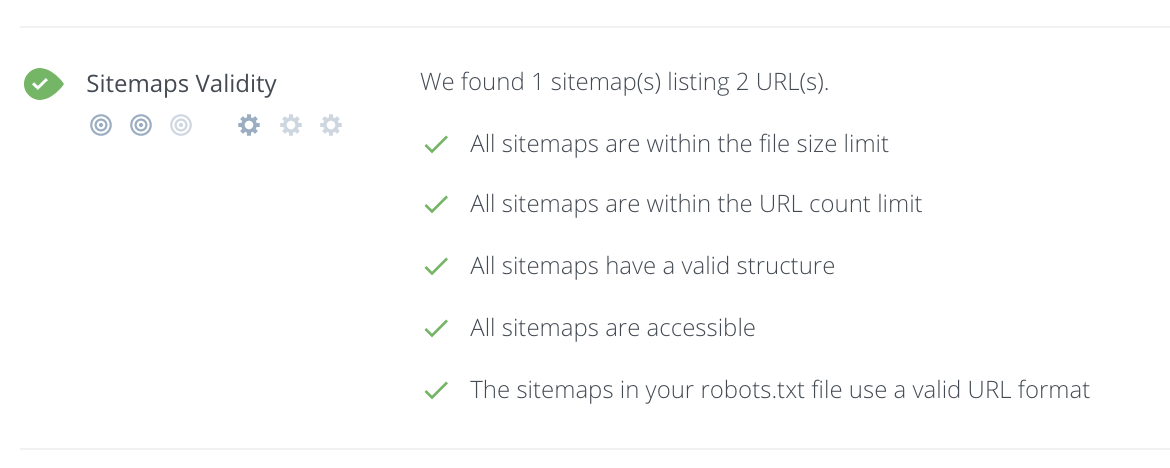

txt? » Rank MathФайлы Sitemap сообщают Google, какие страницы вашего веб-сайта являются наиболее важными и должны быть проиндексированы. Хотя существует множество способов создать карту сайта, добавление ее в файл robots.txt — один из лучших способов убедиться, что Google увидит ее.

В этой статье базы знаний мы покажем вам, как добавлять карты сайта в файл robots.txt с помощью Rank Math. Мы также объясним преимущества добавления карты сайта и то, как она может помочь улучшить рейтинг вашего сайта в поисковых системах.

Начнем!

1 Преимущества добавления карты сайта

Добавление карты сайта на ваш веб-сайт помогает Google быстрее индексировать ваш сайт. Это связано с тем, что карта сайта сообщает Google, какие страницы вашего сайта являются наиболее важными и должны быть проиндексированы.

Еще одним преимуществом добавления карты сайта является то, что она может помочь улучшить рейтинг вашего сайта в поисковых системах. Это связано с тем, что карты сайта помогают Google понять структуру вашего веб-сайта и отношения между вашими страницами и типами сообщений.

2 Как добавить карту сайта в файл robots.txt с помощью Rank Math

Добавление карты сайта в файл robots.txt — отличный способ обеспечить его видимость в Google. В этом разделе мы покажем вам, как это сделать с помощью Rank Math.

2.1 Вход на ваш веб-сайт WordPress

Во-первых, вам необходимо войти на свой веб-сайт WordPress и установить плагин Rank Math. Для получения дополнительной информации о том, как это сделать, см. статью нашей базы знаний «Как установить Rank Math».

2.2 Перейдите к Edit Robots.txt

Перейдите к файлу robots.txt в Rank Math, который находится в разделе Панель управления WordPress > Rank Math > Общие настройки > Edit robots.txt , как показано ниже:

2.3 Добавьте URL-адрес карты сайта в Ваш Robots.txt

По умолчанию Rank Math автоматически добавит набор правил ( включая ваш файл Sitemap ) в ваш файл robots.txt. Но вы всегда можете добавить/отредактировать код по своему усмотрению из доступной текстовой области.

Теперь вам нужно ввести URL вашей карты сайта в это поле. URL-адрес будет разным для каждого веб-сайта. Например, если ваш веб-сайт — example.com, URL-адрес карты сайта будет иметь вид example.com/sitemap.xml.

Вы также можете добавить несколько URL-адресов карты сайта, если у вас более одной карты сайта. Например, если у вас есть карта сайта для видео, вы также должны ввести URL-адрес этой карты сайта.

Вот несколько примеров ссылок, которые вы можете использовать:

-

Карта сайта: https://example.com/sitemap.xml -

Карта сайта: https://example.com/post-sitemap.xml -

Карта сайта: https://example.com/page-sitemap.xml -

Карта сайта: https://example. com/category-sitemap.xml -

Карта сайта: https://example.com/video-sitemap.xml

Но вместо того, чтобы перечислять отдельные URL-адреса, вы можете просто включить индекс карты сайта, и поисковые системы смогут вытащите все отдельные карты сайта отсюда.

inflatablemugs.com/sitemap_1.xml

inflatablemugs.com/sitemap_1.xml