Robots.txt Tester: используйте бесплатный онлайн-инструмент для SEO

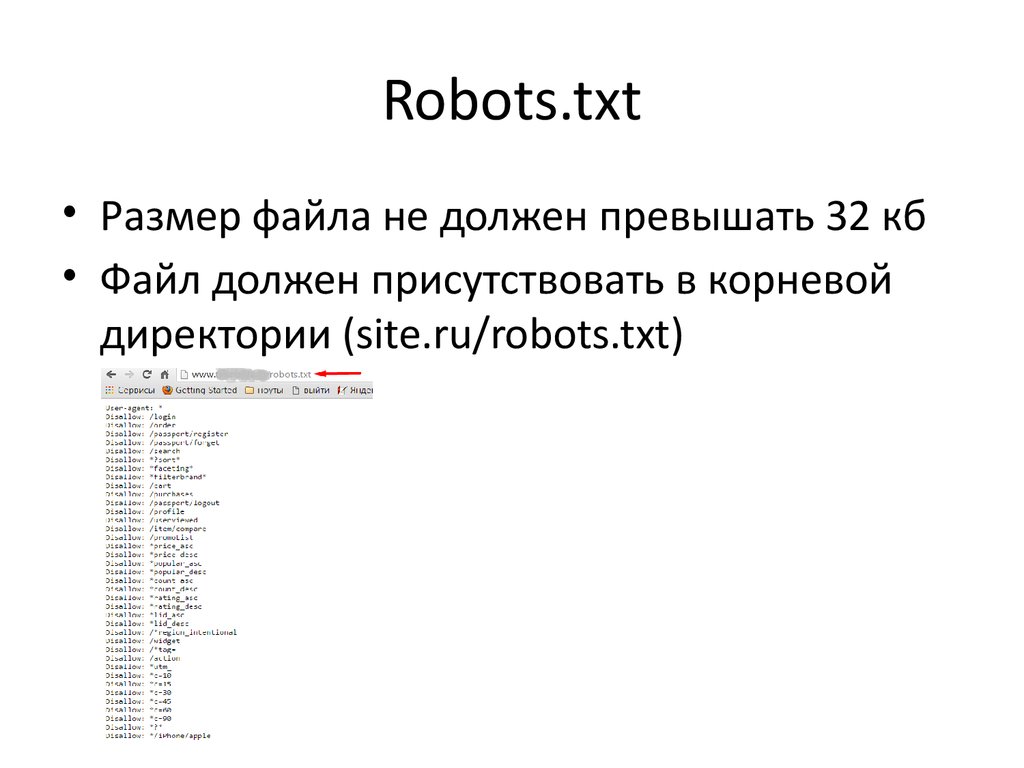

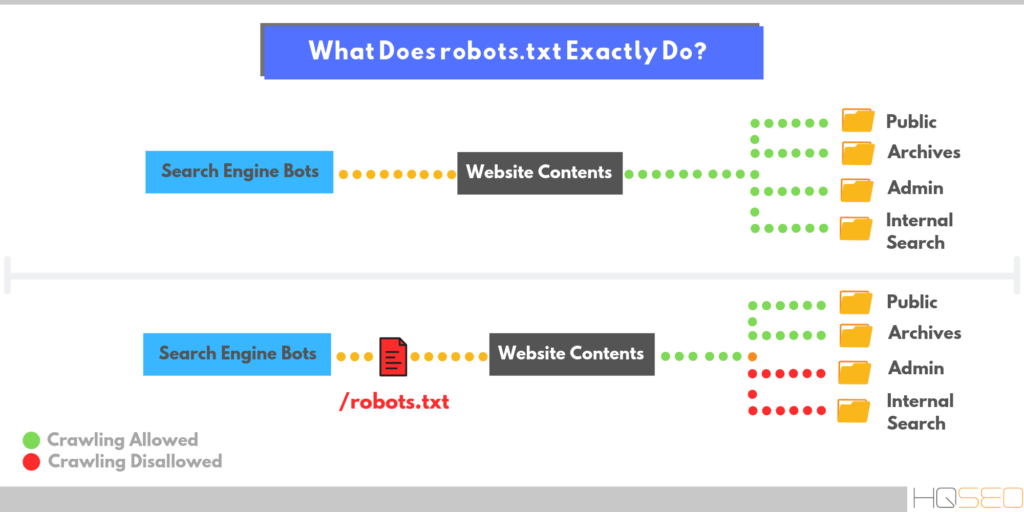

Файл robots.txt – это текстовый файл, размещаемый на веб-сайтах для информирования роботов поисковых систем (таких как Google), какие страницы в этом домене можно сканировать. . Если на вашем веб-сайте есть файл robots.txt, вы можете выполнить проверку с помощью нашего бесплатного генератора Robots.txt инструмента. Вы можете интегрировать ссылку на XML карту сайта в файл robots.txt.

Прежде чем боты поисковых систем просканируют ваш сайт, они сначала найдут файл robots.txt сайта. Таким образом, они увидят инструкции, какие страницы сайта можно индексировать, а какие не следует индексировать консолью поисковой системы.

С помощью этого простого файла вы можете настроить параметры сканирования и индексирования для роботов поисковых систем. И чтобы проверить, настроен ли на вашем сайте файл robots.txt, вы можете использовать наши бесплатные и простые инструменты для тестирования Robots. txt. В этой статье объясняется, как проверить файл с помощью этого инструмента и почему важно использовать Robots.txt Tester на своем сайте.

txt. В этой статье объясняется, как проверить файл с помощью этого инструмента и почему важно использовать Robots.txt Tester на своем сайте.

Использование средства проверки robots.txt: пошаговое руководство

Тестирование файла robots.txt поможет вам протестировать файл robots.txt в вашем домене или любом другом домене, который вы хотите проанализировать.

Средство проверки robots.txt быстро обнаружит ошибки в настройках файла robots.txt. Наш инструмент проверки очень прост в использовании и может помочь даже неопытному профессионалу или веб-мастеру проверить файл Robots.txt на своем сайте. Вы получите результаты через несколько минут.

Шаг 1. Вставьте URL-адрес

Чтобы начать сканирование, все, что вам нужно сделать, это ввести интересующий URL-адрес в пустую строку и нажать кнопку с синей стрелкой. Затем инструмент начнет сканирование и выдаст результаты. Вам не нужно регистрироваться на нашем сайте, чтобы использовать его.

В качестве примера мы решили проанализировать наш сайт https://sitechecker.pro. На приведенных ниже снимках экрана вы можете увидеть процесс сканирования в нашем инструменте веб-сайта.

Шаг 2. Интерпретация результатов тестера Robots.txt

Затем, когда сканирование завершится, вы увидите, разрешает ли файл Robots.txt сканирование и индексирование конкретной доступной страницы. Таким образом, вы можете проверить, будет ли ваша веб-страница получать трафик из поисковой системы. Здесь вы также можете получить несколько полезных советов по мониторингу.

Случаи, когда требуется проверка robots.txt

Проблемы с файлом robots.txt или его отсутствие могут негативно повлиять на ваш рейтинг в поисковых системах. Вы можете потерять рейтинговые очки в SERP. Анализ этого файла и его значения перед сканированием веб-сайта позволяет избежать проблем с сканированием. Кроме того, вы можете предотвратить добавление контента вашего веб-сайта на страницы исключения из индекса, которые вы не хотите сканировать. Используйте этот файл, чтобы ограничить доступ к определенным страницам вашего сайта. Если есть пустой файл, вы можете получить сообщение Robots.txt не найден в SEO-краулер.

Используйте этот файл, чтобы ограничить доступ к определенным страницам вашего сайта. Если есть пустой файл, вы можете получить сообщение Robots.txt не найден в SEO-краулер.

Вы можете создать файл с помощью простого текстового редактора. Во-первых, укажите пользовательский агент для выполнения инструкции и поместите директиву блокировки, например, disallow, noindex. После этого перечислите URL-адреса, для которых вы ограничиваете сканирование. Перед запуском файла убедитесь, что он правильный. Даже опечатка может привести к тому, что бот Googlebot проигнорирует ваши инструкции по проверке.

Какие инструменты проверки robots.txt могут помочьКогда вы создаете файл robots.txt, вам необходимо проверить, не содержат ли они ошибок. Есть несколько инструментов, которые помогут вам справиться с этой задачей.

Консоль поиска GoogleТеперь только в старой версии Google Search Console есть инструмент для тестирования файла robots. Войдите в учетную запись с текущим сайтом, подтвержденным на его платформе, и используйте этот путь, чтобы найти валидатор.

Войдите в учетную запись с текущим сайтом, подтвержденным на его платформе, и используйте этот путь, чтобы найти валидатор.

Старая версия Google Search Console > Сканировать > Тестер robots.txt

Этот тест robot.txt позволяет:

Войдите в аккаунт Яндекс Вебмастер с текущим сайтом и подтвержден на своей платформе и используйте этот путь, чтобы найти инструмент.

Яндекс для веб-мастеров > Инструменты > Анализ robots.txt

Этот тестер предлагает почти такие же возможности для проверки, как и описанный выше. Разница заключается в:

txt;

txt;Это решение для массовой проверки, если вам нужно просканировать веб-сайт. Наш краулер помогает проверить весь сайт и определить, какие URL-адреса запрещены в robots.txt, а какие закрыты от индексации с помощью метатега noindex.

Внимание: для обнаружения запрещенных страниц необходимо просканировать веб-сайт с настройкой игнорировать robots.txt.

Обнаружение и анализ не только файла robots.txt, но и других проблем SEO на вашем сайте!

Проведите полный аудит, чтобы выяснить и исправить проблемы с вашим сайтом, чтобы улучшить результаты поисковой выдачи.

Часто задаваемые вопросы

Зачем мне проверять файл robots.txt?

Robots.txt показывает поисковым системам, какие URL-адреса на вашем сайте они могут сканировать и индексировать, в основном, чтобы не перегружать ваш сайт запросами. Проверка этого действительного файла рекомендуется, чтобы убедиться, что он работает правильно.

Проверка этого действительного файла рекомендуется, чтобы убедиться, что он работает правильно.

Является ли нарушение файла Robots.txt незаконным?

Сегодня нет закона, требующего строго следовать инструкциям в файле. Это не обязывающий договор между поисковыми системами и веб-сайтами.

Что делает файл robots.txt?

Robots.txt показывает агентам поисковых систем, какие страницы вашего сайта можно сканировать и индексировать, а какие страницы были исключены из просмотра. Разрешение поисковым системам сканировать и индексировать некоторые страницы вашего сайта — это возможность контролировать конфиденциальность некоторых страниц. Это необходимо для поисковой оптимизации вашего сайта.

Является ли Robot.txt безопасным?

Файл robots.txt не ставит под угрозу безопасность вашего сайта, поэтому его правильное использование может быть отличным способом защитить конфиденциальные страницы вашего сайта. Тем не менее, не ожидайте, что все сканеры поисковых систем будут следовать инструкциям в этом файле. Злоумышленники смогут отключать инструкции и сканировать запрещенные страницы.

Тем не менее, не ожидайте, что все сканеры поисковых систем будут следовать инструкциям в этом файле. Злоумышленники смогут отключать инструкции и сканировать запрещенные страницы.

Что такое файл robots.txt и как его настроить

- Что такое robots.txt

- Директивы и структура robots.txt

- Как настроить robots.txt: советы

- Как проверить robots.txt онлайн

- Проверка в Яндекс.Вебмастер

- Проверка в Google Search Console

Читайте нашу статью, если хотите узнать, как сделать анализ robots txt. Мы расскажем, что это за файл и как его настроить, а также покажем, как делается проверка robots txt по правилам Яндекс и Google.

Что такое robots.txt

Файл robots.txt — это инструкция для поисковых роботов, в которой указано, какие разделы и страницы сайта они могут посещать, а какие должны пропускать.

Поисковые роботы — это программы, которые с определенной периодичностью просматривают содержимое сайтов и заносят информацию о них в базы поисковых систем (например, Яндекс и Google). Этот процесс называют индексацией сайта.

Этот процесс называют индексацией сайта.

Если не настроить robots.txt, можно столкнуться, как минимум, с двумя проблемами:

- каждый раз сайт будет индексироваться очень долго (и, возможно, редко),

- роботы увидят нежелательное содержимое (например, служебные файлы или временную информацию) и страницы сайта будут “оценены” некорректно.

Всё это негативно скажется на позициях сайта в поисковой выдаче.

Если файл присутствует на сайте и настроен корректно, роботы будут действовать строго по указанным в нём правилам. Так они поймут, на какие страницы или разделы стоит обратить внимание в первую очередь, а какие скрыты от индексации.

Как правило, файл robots.txt создают и настраивают на сайте веб-разработчики. Но при должном желании это может сделать и любой владелец сайта. Для этого нужно знать структуру файла и его основные директивы.

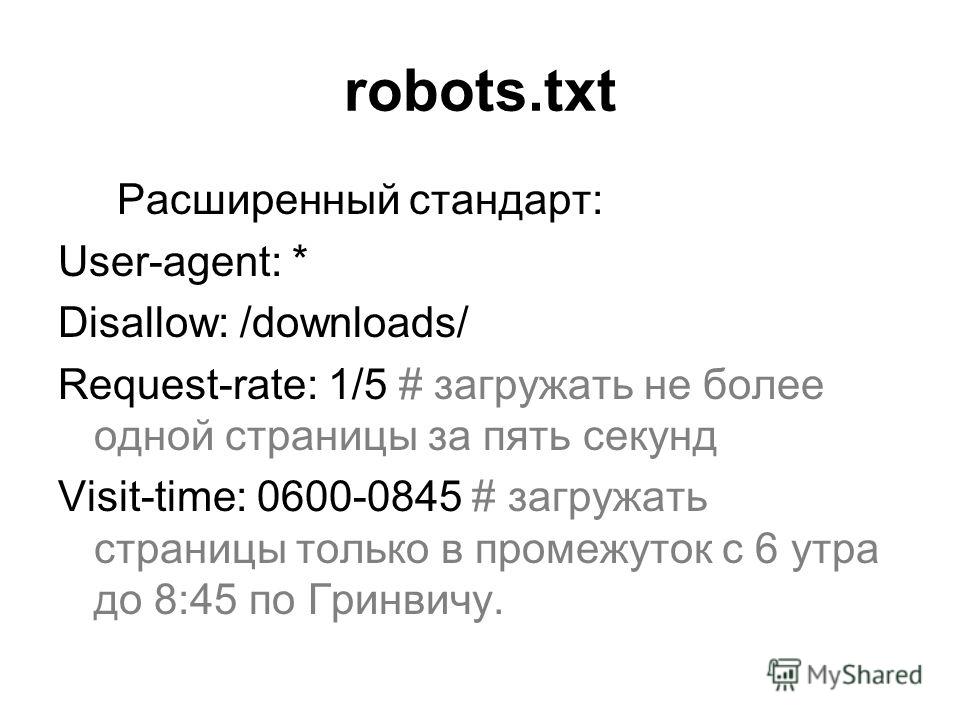

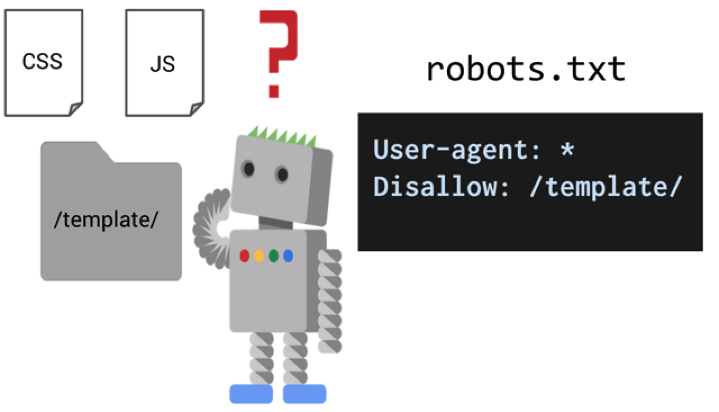

Директивы и структура robots.txt

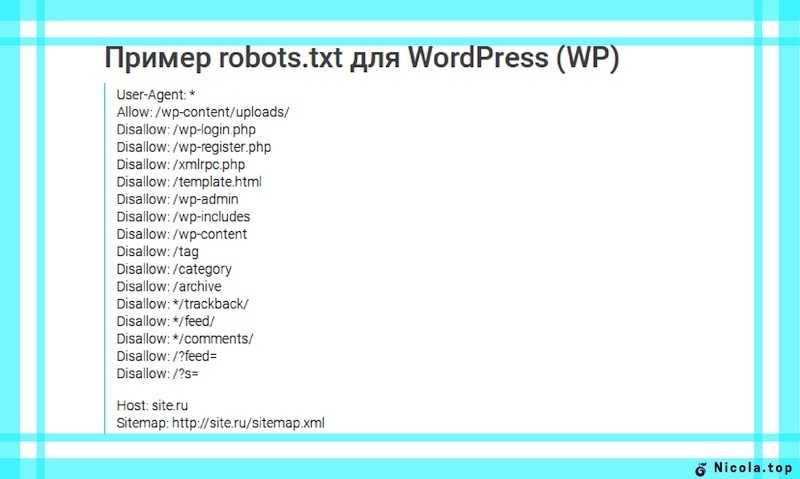

Как выглядит правильная структура файла, предлагаем рассмотреть на следующем простом примере:

User-agent: *

Disallow: /wp-admin

Disallow: /*?

Allow: /wp-admin/admin-ajax. php

Allow: /*.jpg

Sitemap: http://site.ru/sitemap.xml

php

Allow: /*.jpg

Sitemap: http://site.ru/sitemap.xml А теперь объясним, за что в структуре отвечает каждая из директив:

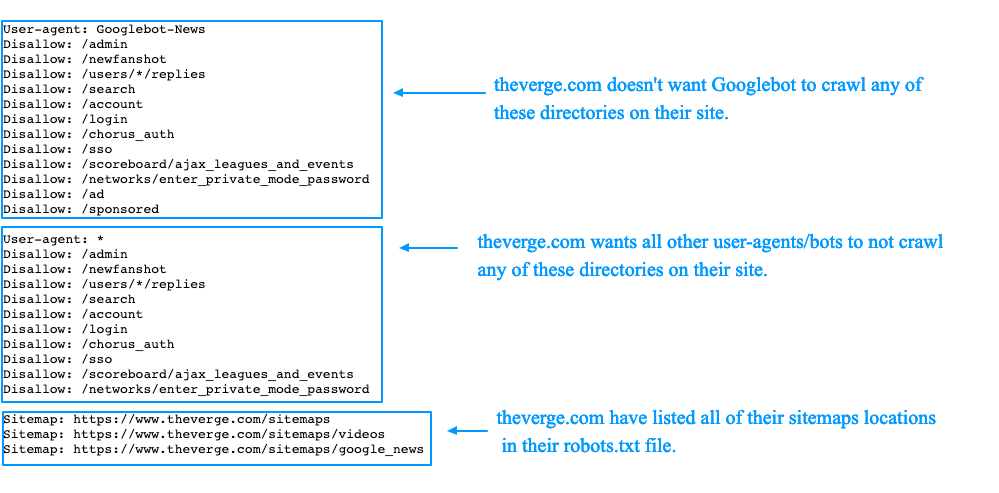

- User-agent (для кого прописаны правила): помогает указать, что правила адресованы конкретным роботам (например, Yandex, Googlebot или другим) либо отметить (с помощью символа «*»), что они относятся к роботам из всех поисковых систем сразу;

- Disallow (запрет индексации): сообщает, какие разделы не должны обходить роботы. Эту директиву нужно прописывать обязательно, даже если на сайте нет служебных файлов (просто не указывайте значение). Без неё поисковые роботы не смогут корректно прочитать robots.txt.

- Allow (разрешение): сообщает, какие разделы или файлы роботы должны просканировать обязательно. Здесь стоит указывать только исключения из правила Disallow. Не нужно прописывать все разделы сайта — роботы автоматически обойдут все, что не запрещается правилами к обходу.

- Sitemap (карта сайта): должна содержать список всех страниц, доступных для индексации (следует указывать полную ссылку на файл в формате .xml.), а также время и частоту их обновления.

Как настроить robots.txt: советы

Чтобы поисковые роботы правильно выполняли указанные в файле условия, соблюдайте следующие основные правила:

1. Группируйте директивы. Если вы хотите указать разные правила для поисковых роботов каждой системы, создайте несколько групп с правилами и разделите их пустой строкой. Пример:

User-agent: Yandex # правила только для ПС Яндекс

Disallow: # раздел, файл или формат файлов

Allow: # раздел, файл или формат файлов

# пустая строка

User-agent: Googlebot # правила только для ПС Google

Disallow: # раздел, файл или формат файлов

Allow: # раздел, файл или формат файлов

Sitemap: # адрес файлаТак роботы не будут путаться и им не придется искать нужную инструкцию во всём документе.

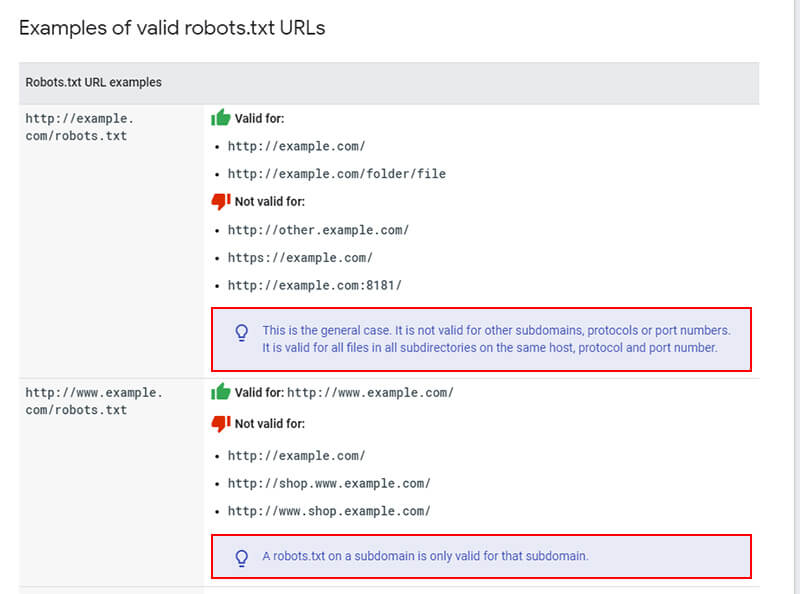

2. Учитывайте регистр. Для некоторых поисковых систем принципиально, чтобы название файла было указано только строчными или прописными. Например, Google правильно прочитает файл только в том случае, если вы укажите название файла строчными — robots.txt. Если этого не сделать, работы проиндексируют сайт некорректно.

3. Одна директива — один каталог. Для каждого раздела/файла нужно указывать отдельную директиву Disallow. Если вы напишите Disallow: /cgi-bin/ /authors/ /css/ — укажите три папки в одной строке — поисковые роботы не поймут, что им делать.

4. Удаляйте лишние директивы. После создания файла в нём будут директивы Host (зеркало сайта), Crawl-Delay (пауза между обращением поисковых роботов) и Clean-param (ограничение дублирующегося контента). Они считаются устаревшими, поэтому их лучше сразу удалить. Так роботам будет проще ориентироваться в правилах.

Как проверить robots.txt онлайн

Для этих целей существуют сервисы онлайн-проверки, например, Website Planet или PR. CY. Однако, если вы указывали правила специально для роботов Яндекс и Google, то проверять настройки нужно через их сервисы.

CY. Однако, если вы указывали правила специально для роботов Яндекс и Google, то проверять настройки нужно через их сервисы.

Обратите внимание: сервисы позволяют вносить правки в режиме онлайн — так вы сразу сможете понять, какие изменения помогут исправить ошибки. Однако эти изменения не вносятся в robots.txt автоматически. Код нужно поправить вручную (на хостинге или в административной панели CMS), а затем сохранить изменения.

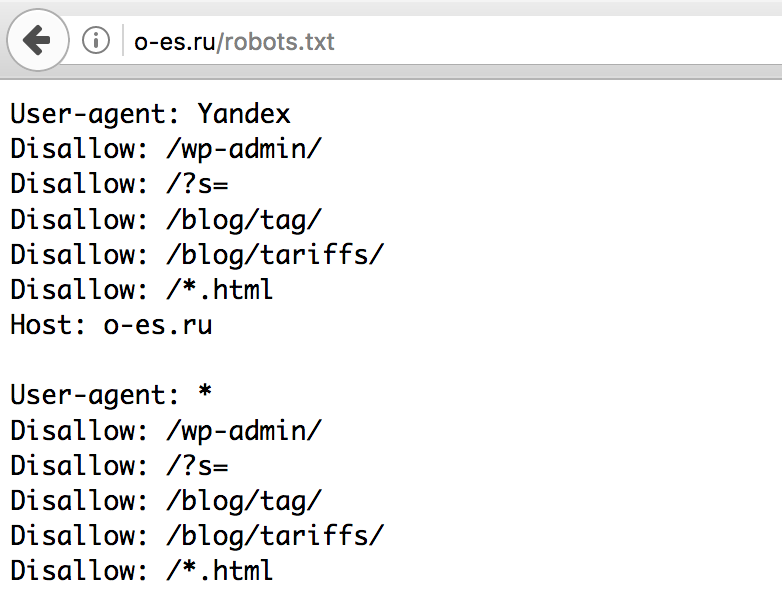

Проверка в Яндекс.Вебмастер

Если раньше вы не пользовались сервисом Яндекс.Вебмастер, перед началом работы добавьте свой сайт и подтвердите права на него. Без этого у вас не будет доступа к инструментам анализа SEO-показателей и продвижения в поисковых системах Яндекс.

Чтобы проверить robots txt:

- Авторизуйтесь в личном кабинете Яндекс.Вебмастер.

- Перейдите в раздел Инструменты — Анализ robots.txt.

- Содержимое файла должно подтянуться в форму автоматически.

Если этого не произошло, скопируйте код, вставьте его в поле и нажмите Проверить:

Если этого не произошло, скопируйте код, вставьте его в поле и нажмите Проверить:

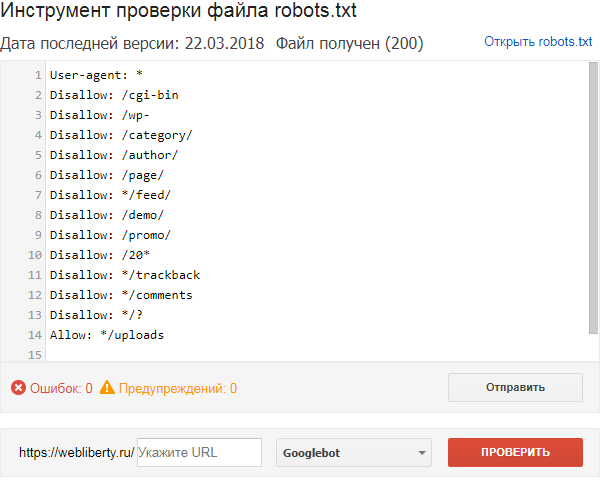

Готово, вы увидите результаты проверки. Если в директивах есть ошибки, сервис покажет, в какой строке, и опишет проблему:

Проверка в Google Search Console

- Чтобы сделать анализ robots txt:

- Перейдите в сервис проверки.

- Если на открывшейся странице отображается неактуальная версия robots.txt, нажмите кнопку Отправить и действуйте по инструкции Google:

- Подождите несколько минут. Затем обновите страницу, чтобы увидеть актуальные директивы. Если система найдет ошибки, они будут перечислены под кодом.

Готово, в нашем примере проверка показала, что ошибок нет:

Robots.txt Tester & Validator 2023: БЕСПЛАТНЫЙ онлайн-инструмент

Это поле обязательно к заполнению URL-адрес недействителен Пример: www.websiteplanet.com/robots. txt

txt

01

Простота использования:

Проверить точность файла robots.txt еще никогда не было так просто. Просто вставьте свой полный URL-адрес с /robots.txt, нажмите «Ввод», и ваш отчет будет готов быстро.

02

Точность 100%:

Наша программа проверки robots.txt не только найдет ошибки, связанные с опечатками, синтаксическими и «логическими» ошибками, но и даст вам полезные советы по оптимизации.

03

Точно:

Принимая во внимание стандарт исключения роботов и специальные расширения для поисковых роботов, наша программа проверки robots.txt создаст удобный для чтения отчет, который поможет исправить любые ошибки, которые могут быть в вашем файле robots.txt. .

Что такое средство проверки и проверки robots.txt?

Инструмент проверки Robots.txt предназначен для проверки правильности файла robots.txt и отсутствия ошибок. Robots.txt — это файл, который является частью вашего веб-сайта и содержит правила индексации для роботов поисковых систем, чтобы убедиться, что ваш веб-сайт сканируется (и индексируется) правильно, а наиболее важные данные на вашем веб-сайте индексируются в первую очередь (все без скрытых cost). Этот инструмент прост в использовании и дает вам отчет за считанные секунды — просто введите полный URL-адрес своего веб-сайта, а затем /robots.txt (например, yourwebsite.com/robots.txt) и нажмите кнопку «Проверить». Наша программа проверки robots.txt найдет любые ошибки (например, опечатки, синтаксические и «логические» ошибки) и даст вам советы по оптимизации вашего файла robots.txt.

Этот инструмент прост в использовании и дает вам отчет за считанные секунды — просто введите полный URL-адрес своего веб-сайта, а затем /robots.txt (например, yourwebsite.com/robots.txt) и нажмите кнопку «Проверить». Наша программа проверки robots.txt найдет любые ошибки (например, опечатки, синтаксические и «логические» ошибки) и даст вам советы по оптимизации вашего файла robots.txt.Зачем мне проверять файл robots.txt?

Проблемы с файлом robots.txt — или вообще отсутствие файла robots.txt — могут негативно сказаться на ваших результатах SEO, ваш сайт может упасть в рейтинге на страницах результатов поисковой системы (SERP). Это связано с риском того, что нерелевантный контент будет сканироваться раньше или вместо важного контента. Проверка файла до сканирования вашего веб-сайта означает, что вы можете избежать таких проблем, как сканирование и индексирование всего содержимого вашего веб-сайта, а не только страниц. Вы хотите индексацию. Например, если у вас есть страница, к которой вы хотите, чтобы посетители обращались только после заполнения формы подписки, или страница входа участника, но вы не исключили ее в своем файле robot.

Что означают ошибки и предупреждения?

Существует ряд ошибок, которые могут повлиять на ваш файл robots.txt, а также некоторые «рекомендуемые» предупреждения, которые вы можете увидеть при проверке файла. Это вещи, которые могут повлиять на SEO и должны быть исправлены. Предупреждения менее важны и служат советом о том, как улучшить файл robots.txt. Вы можете увидеть следующие ошибки: Неверный URL-адрес — вы увидите эту ошибку, если ваш файл robots.txt полностью отсутствует Потенциальная ошибка с подстановочными знаками — хотя технически это предупреждение, а не ошибка, если вы видите это сообщение, обычно это связано с тем, что ваш файл robots.txt содержит подстановочный знак (*) в поле Disallow (например, Disallow: /*.rss). Это проблема передовой практики — Google разрешает использовать подстановочные знаки в поле «Запретить», но это не рекомендуется. Общие и специальные пользовательские агенты в одном блоке кода — это синтаксическая ошибка в вашем файле robots. txt, которую следует исправить, чтобы избежать проблем со сканированием вашего веб-сайта. Предупреждения, которые вы можете увидеть, включают: Разрешить: / — Использование порядка разрешения не повредит вашему рейтингу и не повлияет на ваш сайт, но это не стандартная практика. Основные роботы, включая Google и Bing, примут эту директиву, но не все поисковые роботы — и, вообще говоря, лучше всего сделать файл robots.txt совместимым со всеми поисковыми роботами, а не только с большими.

txt, которую следует исправить, чтобы избежать проблем со сканированием вашего веб-сайта. Предупреждения, которые вы можете увидеть, включают: Разрешить: / — Использование порядка разрешения не повредит вашему рейтингу и не повлияет на ваш сайт, но это не стандартная практика. Основные роботы, включая Google и Bing, примут эту директиву, но не все поисковые роботы — и, вообще говоря, лучше всего сделать файл robots.txt совместимым со всеми поисковыми роботами, а не только с большими.

Как исправить ошибки в файле Robots.txt?

Исправление ошибок в файле robots.txt зависит от используемой вами платформы. Если вы используете WordPress, рекомендуется использовать плагин, такой как WordPress Robots.txt Optimization или Robots.txt Editor. Если вы подключите свой веб-сайт к Google Search Console, вы также сможете редактировать файл robots.txt там. Некоторые конструкторы веб-сайтов, такие как Wix, не позволяют вам напрямую редактировать файл robots.txt, но позволяют добавлять индексные теги для определенных страниц.49094

49094

Нравится этот инструмент? Оцените это!

4.7 (Проголосовало 986 пользователей)

Вы уже проголосовали! Отменить

Вам нужно использовать этот инструмент, чтобы оценить его

Это поле обязательно к заполнению Максимальная длина комментария равна 80000 символов Минимальная длина комментария равна 10 символам Электронная почта обязательна Электронная почта невернаRobots.

txt Tester: используйте бесплатный онлайн-инструмент для SEO

txt Tester: используйте бесплатный онлайн-инструмент для SEOФайл robots.txt — это текстовый файл, размещаемый на веб-сайтах для информирования роботов поисковых систем (таких как Google ), какие страницы в этом домене могут сканироваться . Если на вашем веб-сайте есть файл robots.txt, вы можете выполнить проверку с помощью нашего бесплатного генератора Robots.txt инструмента . Вы можете интегрировать ссылку на XML-карту сайта в файл robots.txt.

Прежде чем роботы поисковых систем просканируют ваш сайт, они сначала найдут файл robots.txt сайта. Таким образом, они увидят инструкции, какие страницы сайта можно индексировать, а какие нельзя индексировать консолью поисковой системы.

С помощью этого простого файла можно установить параметров сканирования и индексирования для поисковых роботов. А чтобы проверить, настроен ли файл Robots.txt на вашем сайте, вы можете воспользоваться нашими бесплатными и простыми инструментами для тестирования Robots. txt. В этой статье объясняется, как проверить файл с помощью инструмента и почему важно использовать Robots.txt Tester на вашем сайте.

txt. В этой статье объясняется, как проверить файл с помощью инструмента и почему важно использовать Robots.txt Tester на вашем сайте.

Использование средства проверки Robots.txt: пошаговое руководство

Проверка файла robots.txt поможет вам протестировать файл robots.txt в вашем домене или любом другом домене, который вы хотите проанализировать.

Средство проверки robots.txt быстро обнаружит ошибки в настройках файла robots.txt. Наш инструмент проверки очень прост в использовании и может помочь даже неопытному профессионалу или веб-мастеру проверить файл Robots.txt на своем сайте. Вы получите приводит к за несколько минут.

Шаг 1: введите URL-адрес и начните бесплатную пробную версию

Вы можете подписаться на бесплатную пробную версию без предоставления кредитной карты. Все, что вам нужно сделать, это подтвердить свой адрес электронной почты или использовать свою учетную запись Google. Начать работу легко и быстро.

Шаг 2: Получите результаты тестера Robots.txt

После добавления URL-адреса в наш инструмент мы быстро просканируем сайт. Через несколько секунд вы получите результаты, включающие сведения о странице и данные о директивах robots.txt для конкретной страницы. Аудит также включает в себя обзор всех проблем, присутствующих на каждой веб-странице.

Возможности Robots.txt Checker

После создания пробной учетной записи полный аудит сайта может выявить различные типы проблем и перечислить URL-адреса, по которым эти проблемы возникают. Кроме того, мы предоставляем инструкции и видеоруководства по устранению выявленных проблем. Это бесценная услуга, которая может помочь улучшить производительность и рейтинг вашего сайта.

Раздел «Сканирование и индексирование» поможет вам обнаружить любые проблемы с индексацией на вашем сайте, чтобы их можно было быстро исправить. Вы также будете получать уведомления, если эти проблемы возникнут в будущем с добавлением новых страниц!

Если вы хотите избежать возможных проблем с директивой robot. txt на определенной странице, вы можете использовать наш инструмент проверки на странице в своей учетной записи. Это поможет убедиться, что все настроено правильно, и избежать возможных проблем в будущем.

txt на определенной странице, вы можете использовать наш инструмент проверки на странице в своей учетной записи. Это поможет убедиться, что все настроено правильно, и избежать возможных проблем в будущем.

Найдите все страницы с проблемами индексации прямо сейчас!

Проведите полную проверку, чтобы найти и исправить проблемы с файлом robots.txt, чтобы улучшить техническое SEO.

Случаи, когда требуется средство проверки robots.txt

Проблемы с файлом robots.txt или его отсутствие могут негативно повлиять на ваш рейтинг в поисковых системах. Вы можете потерять рейтинговые очки в поисковой выдачи . Анализ этого файла и его значения перед сканированием вашего веб-сайта означает, что вы можете избежать проблем с сканированием . Кроме того, вы можете предотвратить добавление контента вашего веб-сайта на страницы исключения из индекса , которые вы не хотите сканировать. Используйте этот файл, чтобы ограничить доступ к определенным страницам вашего сайта. Если есть пустой файл, вы можете получить ошибку Robots.txt not Found Issue в SEO-сканере.

Если есть пустой файл, вы можете получить ошибку Robots.txt not Found Issue в SEO-сканере.

Вы можете создать файл с помощью простого текстового редактора. Во-первых, укажите пользовательский агент для выполнения инструкции и поместите директиву блокировки, например, disallow, noindex. После этого перечислите URL-адреса, которые вы ограничение сканирования . Перед запуском файла убедитесь, что он правильный. Даже опечатка может привести к тому, что Googlebot проигнорирует ваши инструкции по проверке .

Чем могут помочь средства проверки Robots.txtПри создании файла robots.txt необходимо проверить, не содержит ли он ошибок. Есть несколько инструментов, которые помогут вам справиться с этой задачей.

Google Search Console Теперь только в старой версии Google Search Console есть инструмент для тестирования файла robots. Войдите в учетную запись с текущим сайтом, подтвержденным на его платформе, и используйте этот путь, чтобы найти валидатор.

Старая версия Google Search Console > Сканирование > Robots.txt Tester

Этот тест robot.txt позволяет:

- сразу обнаружить все ваши ошибки и возможные проблемы;

- проверьте наличие ошибок и внесите необходимые исправления прямо здесь, чтобы установить новый файл на свой сайт без дополнительных проверок;

- проверьте, правильно ли вы закрыли страницы, которые не хотите сканировать, и правильно ли открыли те страницы, которые должны пройти индексацию.

Войдите в учетную запись веб-мастера Яндекса, подтвердив текущий сайт на своей платформе, и используйте этот путь, чтобы найти инструмент.

Яндекс Вебмастер > Инструменты > Анализ robots.txt

Этот тестер предоставляет практически такие же возможности для проверки, как и описанный выше. Отличие в том, что:

- здесь не нужно авторизоваться и подтверждать права на сайт, который предлагает сразу проверить файл robots.

txt;

txt; - нет необходимости вставлять постранично: весь список страниц можно проверить за один сеанс;

- вы можете убедиться, что Яндекс правильно идентифицировал ваши инструкции.

Это решение для массовой проверки, если вам нужно просканировать веб-сайт. Наш краулер помогает проверить весь сайт и определить, какие URL-адреса запрещены в robots.txt, а какие закрыты от индексации с помощью метатега noindex.

Обратите внимание: для обнаружения запрещенных страниц необходимо просканировать веб-сайт с настройкой «игнорировать robots.txt» .

Обнаружьте и проанализируйте не только файл robots.txt, но и другие проблемы SEO на вашем сайте!

Проведите полный аудит, чтобы выявить и устранить проблемы с вашим сайтом, чтобы улучшить результаты поисковой выдачи.

Часто задаваемые вопросы

Зачем мне проверять файл robots.txt?

Robots. txt показывает поисковым системам, какие URL-адреса на вашем сайте они могут сканировать и индексировать, в основном, чтобы не перегружать ваш сайт запросами. Рекомендуется проверить этот действительный файл, чтобы убедиться, что он работает правильно.

txt показывает поисковым системам, какие URL-адреса на вашем сайте они могут сканировать и индексировать, в основном, чтобы не перегружать ваш сайт запросами. Рекомендуется проверить этот действительный файл, чтобы убедиться, что он работает правильно.

Является ли нарушение файла Robot’s.txt незаконным?

На сегодняшний день нет закона о том, что нужно строго следовать инструкциям в файле. Это не обязывающий договор между поисковыми системами и веб-сайтами .

Что делает robots.txt?

Robots.txt показывает агентам поисковых систем, какие страницы вашего сайта могут быть просканированы и проиндексированы, а какие страницы были исключены из просмотр . Разрешение поисковым системам сканировать и индексировать некоторые страницы вашего сайта — это возможность контролировать конфиденциальность некоторых страниц. Это необходимо для поисковой оптимизации вашего сайта .

Безопасен ли Robot.

php

Allow: /*.jpg

Sitemap: http://site.ru/sitemap.xml

php

Allow: /*.jpg

Sitemap: http://site.ru/sitemap.xml

Если этого не произошло, скопируйте код, вставьте его в поле и нажмите Проверить:

Если этого не произошло, скопируйте код, вставьте его в поле и нажмите Проверить: txt;

txt;