Как составить файл robots.txt | SEO-notes

Как составить файл robots.txt

Подробная инструкция по составлению файла robots.txt с готовыми примерами. С помощью инструкции вы сможете создать эффективный robots.txt и улучшить индексацию вашего сайта.

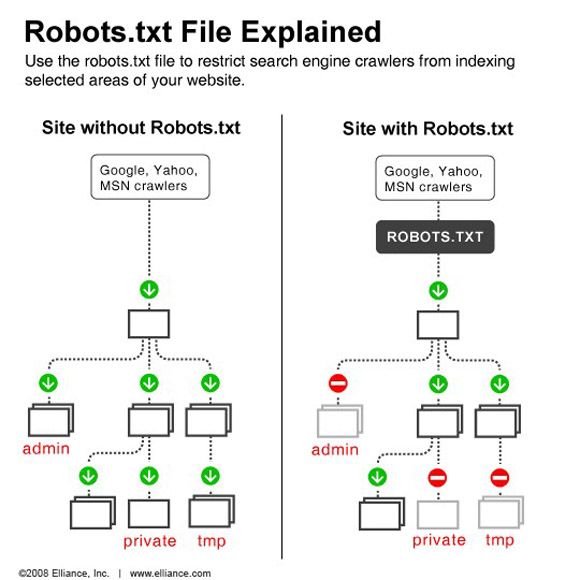

Файл robots.txt позволит улучшить индексацию вашего сайта и исключить из индекса лишние страницы, которые могут негативно сказаться на ранжировании сайта.

Подробнее о том, для чего нужен robots.txt читайте в статье Для чего нужен файл robots.txt.

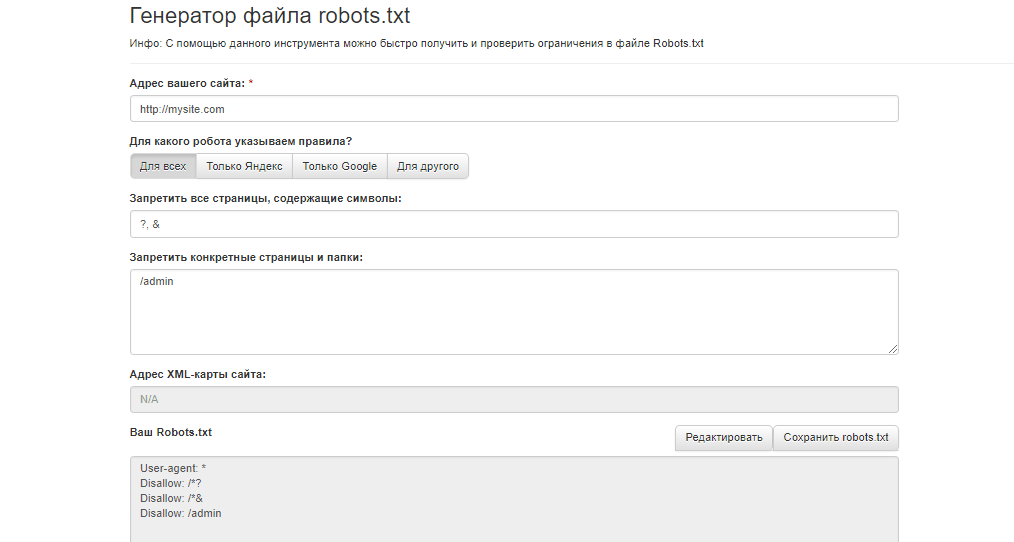

Чтобы файл robots.txt эффективно решал свою задачу необходимо придерживаться правил составления robots.txt и соблюдать синтаксис файла.

Подробнее познакомиться с правилами вы сможете в статье Синтаксис и правила составления файла robots.txt.

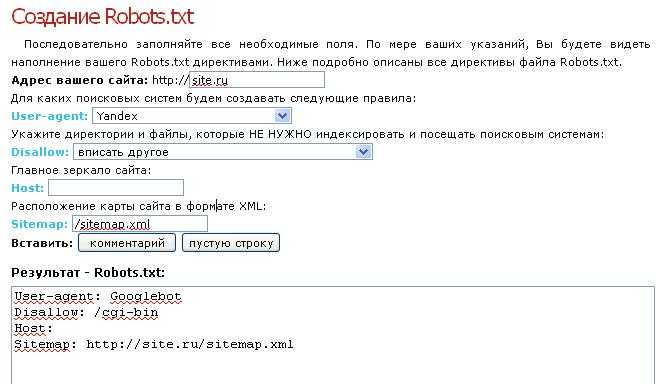

Ниже приведена пошаговая инструкция по составлению файла robots.txt.

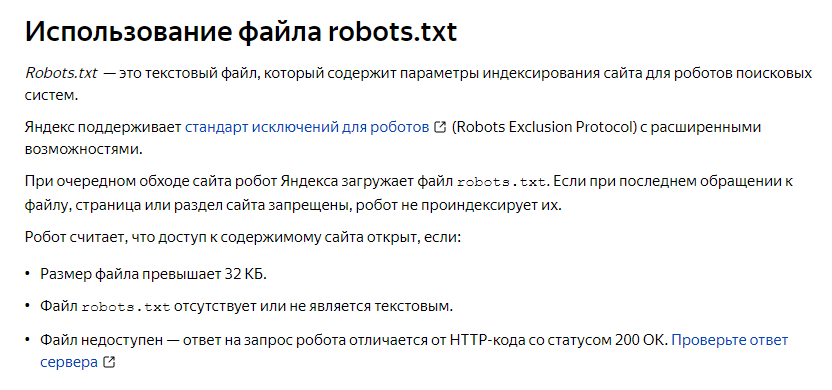

Robots.txt — это текстовый файл в кодировке UTF-8.

Для составления файла robots. txt можно использовать любой текстовый редактор.

txt можно использовать любой текстовый редактор.

Укажите User-Agent

В первой строке файла robots.txt необходимо указать User-Agent, для которого будут прописаны правила. Пропишите User-Agent: и добавьте название поискового робота.

Пример:

User-Agent: Googlebot

Если на правила в файле robots.txt необходимо реагировать всем роботам укажите всех User-Agent с помощью символа *:

User-Agent: *

Подробнее с User-Agent вы можете ознакомиться в статье User-Agent robots.txt.

Добавьте запрещающие директивы Disallow

После указания User-Agent необходимо разместить запрещающие директивы Disallow.

Закройте от индексации страницы, которые не содержат полезной информации для пользователей, например:

- Служебные файлы и папки

- Страницы результатов поиска

- Страницы сортировки

- Страницы фильтров (в некоторых случаях)

- Страницы с результатами поиска по сайту

- Личный кабинет

- Корзину

- Страницы, которые содержат данные о пользователях

- Страницы оформления заказа

Пример:

#сообщаем, что правило в robots. txt действуют для всех роботов

txt действуют для всех роботов

User-agent: *

#закрываем всю папку со служебными файлами

Disallow: /bitrix/

#закрываем сортировку на всех страницах сайта

Disallow: /*sort=

#закрываем страницы результатов поиска с любым значением после =

Disallow: /*search=

#закрываем корзину

Disallow: /basket/

#закрываем страницы оформления заказа

Disallow: /order

#закрываем личный кабинет

Disallow: /lk/

#закрываем страницы фильтров в каталоге

Disallow: /filter/

Подробнее о том, как закрыть страницы сайта для индексации читайте в статье Как запретить индексацию сайта или страницы в robots.txt.

Добавьте разрешающие директивы Allow

Если в ранее закрытых папках находятся страницы или файлы, которые необходимо проиндексировать, например изображения, PDF документы, необходимо добавить разрешающие директивы.

Также необходимо открыть для индексации скрипты и стили.

Пример:

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

Важно! Разрешающие директивы должны быть длиннее запрещающих.

User-agent: *

#разрешаем индексировать изображения и PDF документы, которые лежат в закрытой папке /bitrix/upload/

Allow: /bitrix/upload/*.png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

#далее идут ранее составленные закрывающие директивы

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

Добавьте Clean-param для Яндекса

В правилах Clean-param необходимо указать динамические параметры, которые не влияют на содержание страницы, например рекламные метки.

Пример:

Clean-param: utm_&k50id&cm_id&from&yclid&gclid&_openstat

Правило Clean-param действует только для Яндекса, в связи с этим необходимо указать User-Agent для которого предназначено данное правило:

User-agent: *

Allow: /bitrix/upload/*. png

png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

User-agent: Yandex

Allow: /bitrix/upload/*.png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

Clean-param: utm_&k50id&cm_id&from&yclid&gclid&_openstat

Подробнее о том, что такое Clean-param и как правильно прописать правило читайте в статье Директива Clean-param в файле robots.txt.

Закройте от индексации страницы с динамическими параметрами в URL для Google

Правило Clean-param действует для поисковой системы Яндекс.

Чтобы страницы с динамическими параметрами не индексировались Google, необходимо закрыть от индексации страницы с метками, указав запрещающие директивы для всех остальных User-Agen.

Пример:

User-agent: *

Allow: /bitrix/upload/*.png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

Disallow: /*utm_

Disallow: /*k50id

Disallow: /*cm_id

Disallow: /*from

Disallow: /*yclid

Disallow: /*gclid

Disallow: /*_openstat

User-agent: Yandex

Allow: /bitrix/upload/*.png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

Clean-param: utm_&k50id&cm_id&from&yclid&gclid&_openstat

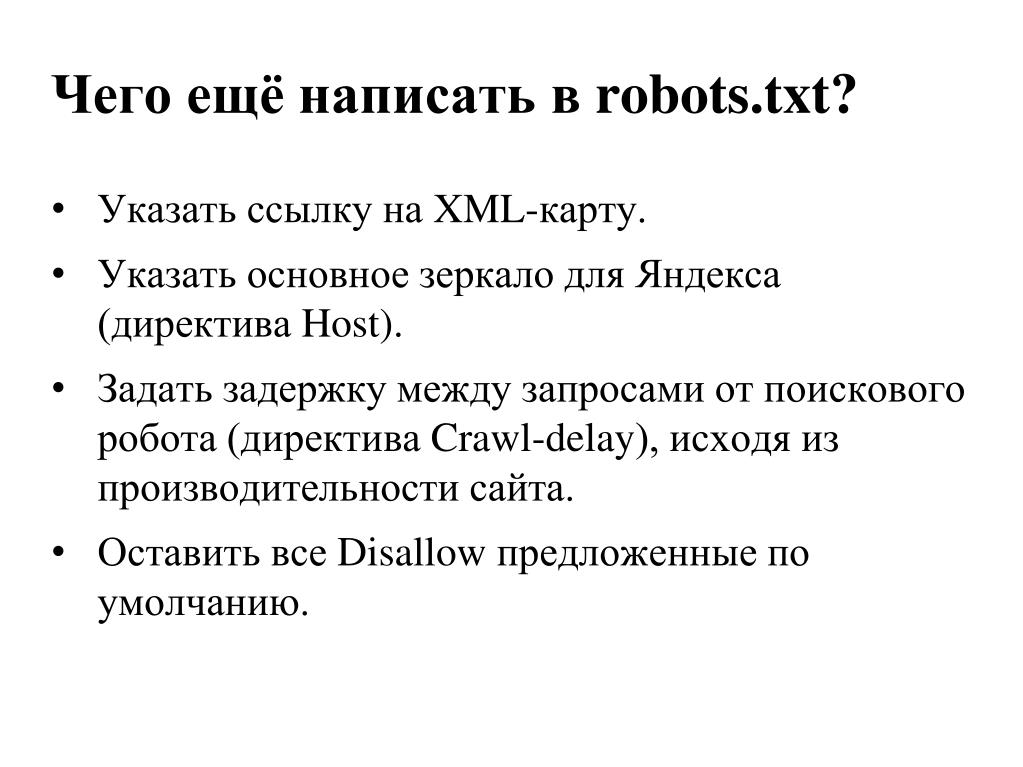

Добавьте ссылку на файл Sitemap. xml

xml

В файле robots.txt можно указать путь к xml-карте сайта. Это позволит ускорить индексацию новых страниц и страниц, на которые были внесены изменения.

User-agent: *

Allow: /bitrix/upload/*.png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*.css

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

Disallow: /*utm_

Disallow: /*k50id

Disallow: /*cm_id

Disallow: /*from

Disallow: /*yclid

Disallow: /*gclid

Disallow: /*_openstat

Sitemap: https://site.ru/sitemap.xml

User-agent: Yandex

Allow: /bitrix/upload/*.png

Allow: /bitrix/upload/*.jpg

Allow: /bitrix/upload/*.jpeg

Allow: /bitrix/upload/*.pdf

Allow: /bitrix/upload/*.js

Allow: /bitrix/upload/*. css

css

Disallow: /bitrix/

Disallow: /*sort=

Disallow: /*search=

Disallow: /basket/

Disallow: /order

Disallow: /lk/

Disallow: /filter/

Clean-param: utm_&k50id&cm_id&from&yclid&gclid&_openstat

Sitemap: https://site.ru/sitemap.xml

Пожалуйста, оцените статью

Оставьте комментарий

Нажимая на кнопку, вы даете согласие на обработку персональных данных и соглашаетесь c политикой конфиденциальности.

Читайте далее

09-09-2022

Что такое файл robots.txt

Robots.txt – это стандарт исключений для поисковых роботов. В файле robots.txt приведены инструкции, которые сообщают поисковым роботам, какие URL запрещены или разрешены для индексации.

09-09-2022

Для чего нужен файл robots.txt

Robots.txt – это важный инструмент для улучшения индексации сайта. Файл robots.txt используется для управления трафиком поисковых роботов и указывает, какие страницы запрещены для индексации.

09-09-2022

Синтаксис и правила составления файла robots.txt

Файл robots.txt имеет определенный синтаксис и правила составления. Чтобы обеспечить эффективную работу файла robots.txt, необходимо четко придерживаться правилам составления robots.txt и соблюдать синтаксис.

09-09-2022

User-Agent в файле robots.txt

User-Agent – это идентификационная строка клиентского приложения, которая используется для приложений, поисковых роботов или пауков.

09-09-2022

Как запретить индексацию сайта или страницы в robots.txt

Чтобы удалить из поисковой выдачи Яндекса и Google весь сайт или отдельные разделы и страницы, необходимо закрыть их от индексации. Тогда страницы постепенно будут исключены из индекса и не будут отображаться в поиске. Закрыть страницы от индексации можно с помощью файла robots.txt.

12-09-2022

Как проверить файл robots.txt

С помощью файла robots.txt можно улучшить индексацию сайта. При этом файл robots. txt должен соответствовать требованиям поисковых систем. Для проверки корректности robots.txt используйте нашу инструкцию.

txt должен соответствовать требованиям поисковых систем. Для проверки корректности robots.txt используйте нашу инструкцию.

02-09-2022

Директива Clean-param в файле robots.txt

Clean-param — директива robots.txt, поддерживаемая роботами Яндекса. Clean-param позволяет сообщать о динамических параметрах, которые присутствуют в URL-адресах страниц (например, рекламные метки).

13-09-2022

Ошибки при составлении файла robots.txt

При продвижении сайтов мы часто замечаем ошибки в файле robots.txt, которые негативно влияют на ранжирование сайта. Рассказываем, какие ошибки бывают в robots.txt и как их исправить.

| Показать еще |

Автор статьи

Дмитрий Лашманов

SEO-специалист

Опыт работы в SEO 4 года

60+ реализованных проектов

Дополнительные курсы:

SEO в СНГ — Rush Agency

SEO на запад — Rush Agency

UX/UI-дизайн — Skillbox

Школа экспертов Нетологии

Примеры robots.

txt WordPress для Яндекса и Google. Как правильно составить robots.txt

txt WordPress для Яндекса и Google. Как правильно составить robots.txtВ сегодняшнем видео уроке по WordPress SEO я расскажу и покажу на примерах особенности создания и использования файла robots.txt для WordPress, этот урок не планировался как исчерпывающее руководство по robots.txt, но он должен дать вам хорошее представление о том что это за файл и что туда добавлять для минимизации попадания ненужных файлов в индекс поисковых систем и как его использовать для управления тем как поисковые роботы Google и Яндекс индексируют ваш сайт. Если у вас возникнут вопросы — пишите в комметариях, ниже привожу текстовый транскрипт видео, на тот случай если у вас возникнут вопросы или будет нужен фрагмент кода в текстовом виде.

Текстовый транскрипт видео:

Оглавление

- 1 Для чего нужен файл robots.txt

- 2 Пример robots.txt для WordPress

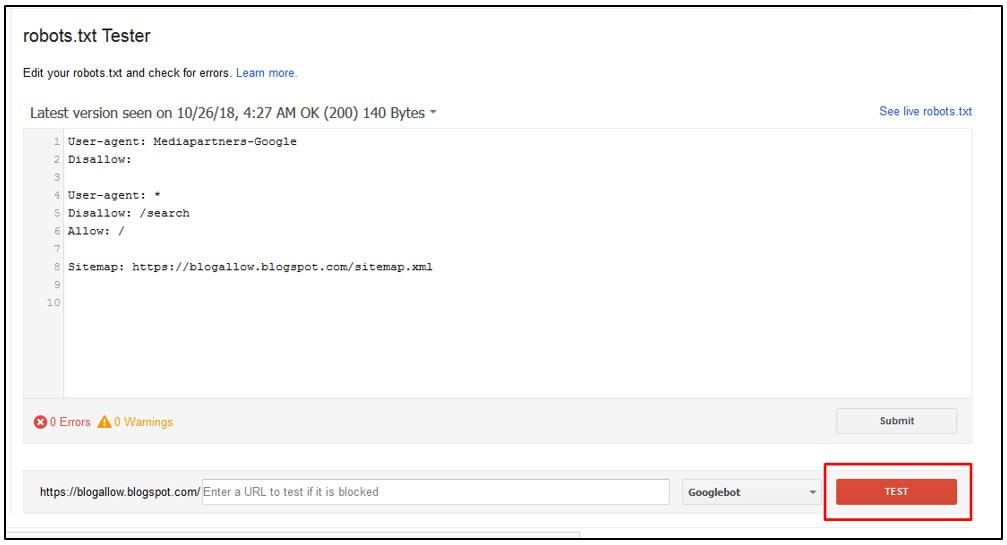

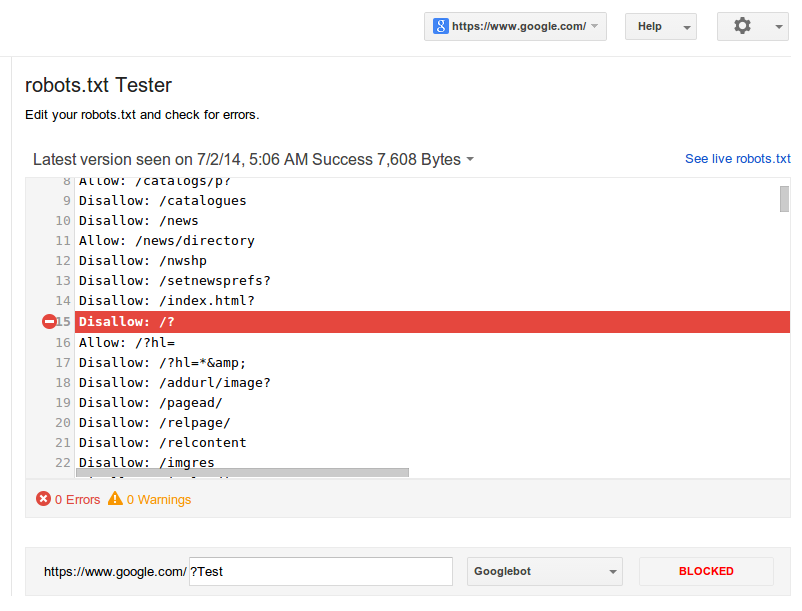

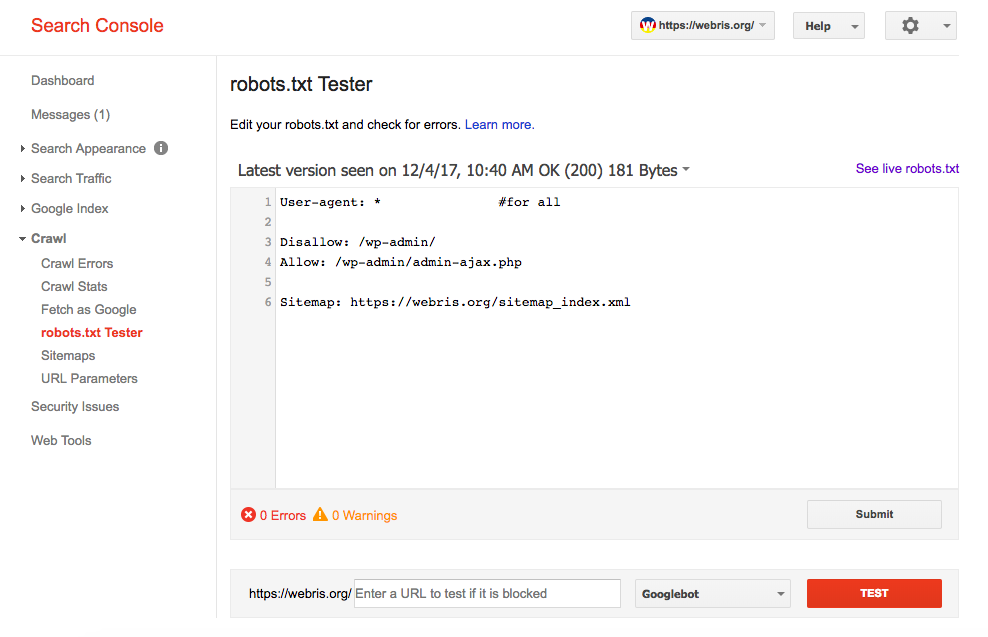

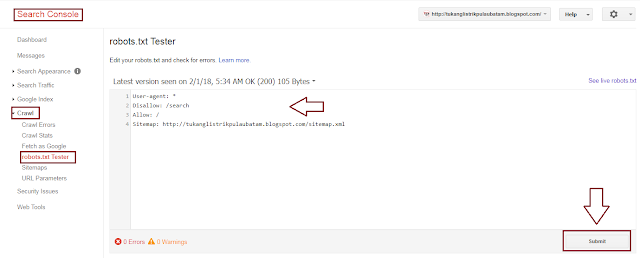

- 3 Проверка robots.txt в Google Webmaster Tools

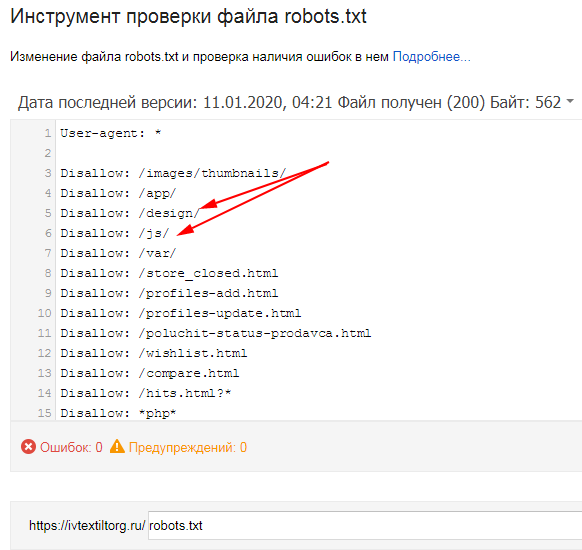

- 4 Проверка robots.txt в Яндекс Вебмастер

- 5 Заключение

Здравствуйте,

Меня зовут Дмитрий, и в этом видео вы узнаете о том, как контролировать индексирование вашего сайта поисковыми системами с помощью файла robots.txt. Плюс в качестве примера мы разберем robots.txt для WordPress, который минимизирует индексирование ненужных файлов поисковыми системами. Итак, приступим.

Для чего нужен файл robots.txt

Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции, запрещающие посещение и индексирование отдельных разделов сайта. robots.txt предназначен для использования ботами, в качестве примера ботов можно назвать поисковых роботов Яндекса и Google или ботов архиваторов, как например робот Web Archive.

Для создания robots.txt воспользуйтесь любым текстовым редактором, заполните его в соответствии с вашими пожеланиями и примерами в этом видео и сохраните как просто тест без форматирования, расширение файла должно быть .txt. После этого необходимо загрузить файл в корневой каталог вашего сайта.

Используйте файл robots.txt для ограничения поисковых роботов от индексации отдельных разделов вашего сайта. Вы можете указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы в отдельности, используя директиву User-Agent. Для списка роботов популярных поисковых систем перейдите по ссылке в описании этого видео.

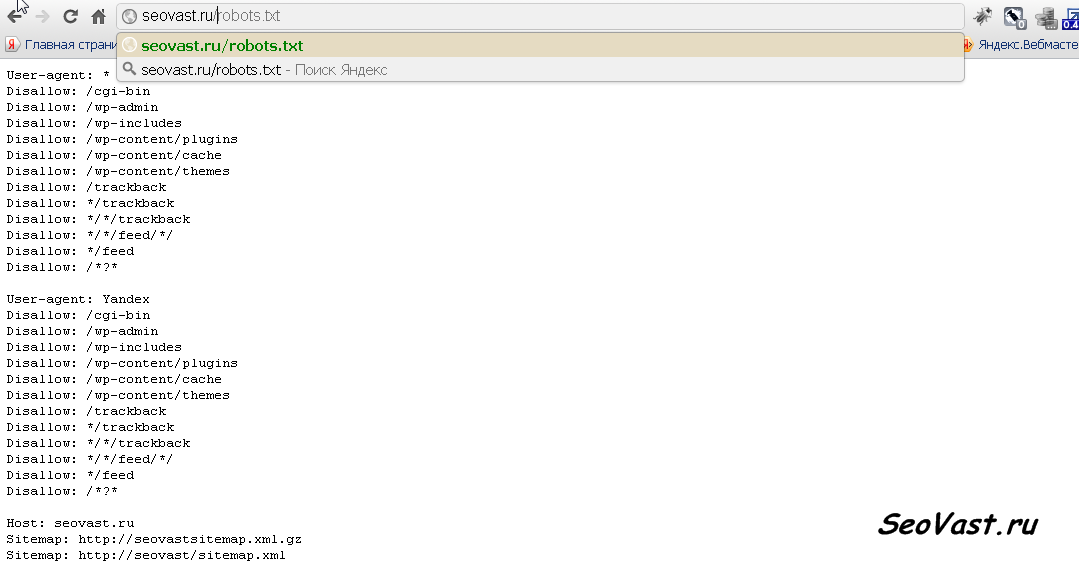

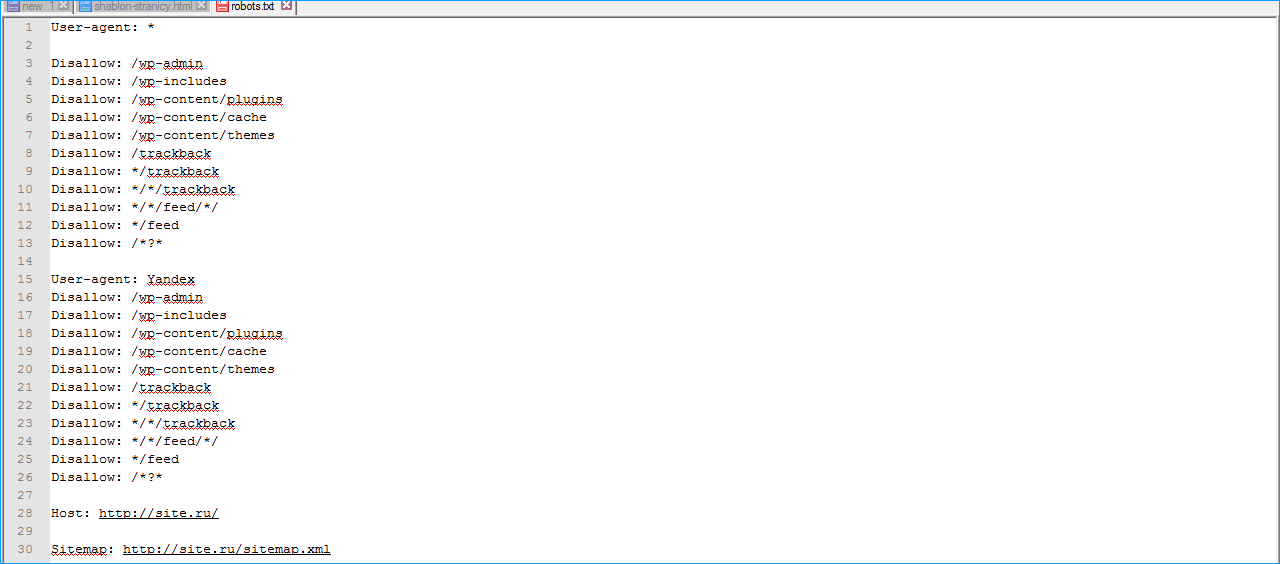

Пример robots.txt для WordPress

В качестве примера robots.txt для WordPress, который минимизирует индексирование ненужных файлов поисковыми системами, вы можете использовать следующий шаблон:

User-Agent: * Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: /wp-admin/ Disallow: /*.swf Disallow: /*.flv Disallow: /*.pdf Disallow: /*.doc Disallow: /*.exe Disallow: /*.htm Disallow: /*.html Disallow: /*.zip Allow: /

Давайте разберем по порядку, что здесь написано. Строчка User-Agent: * говорит, что это относится к любым агентам, к любым поисковым системам, к любым ботам, которые посещают сайт. Строчки, начинающиеся с Disallow: — это директивы, запрещающие индексирование какой-либо части сайта. Например, строчка Disallow: /wp-admin/ запрещает индексирование папки /wp-admin/, любых файлов, которые находятся в папке /wp-admin/. Сейчас у нас запрещены к индексированию папки – плагины, темы и wp-admin (/plugins/ /themes/ /wp-admin/). Директива Disallow: /*. и расширение файла запрещает к индексированию определенный тип файлов. В данный момент запрещены к индексированию .swf, *.flv, *.pdf, *.doc, *.exe, *.js, *.htm, *.html, *.zip. Последняя строчка Allow: / разрешает индексирование любых других частей сайта и любых других файлов.

Если вы используете плагин кеширования, который генерирует статичные версии ваших страниц или структуру постоянных ссылок, оканчивающуюся .htm/.html, уберите строчки

Disallow: /*.htm Disallow: /*.html

В общем, если в адресной строке браузера адреса ваших страниц заканчиваются на .htm или .html, то уберите эти две строчки из robots.txt, иначе вы запретите к индексированию большую часть вашего сайта. Если вы хотите открыть все разделы сайта для индексирования всем роботам, то можете использовать следующий фрагмент:

User-agent: * Disallow:

Так как помимо полезных ботов (например, роботы поисковых систем, которые соблюдают директивы указанные в robots.txt) ваш сайт посещается вредными ботами (спам боты, скрейперы контента, боты которые ищут возможности для инъекции вредоносного кода), которые не только не соблюдают правила, указанные в robots.txt, а, наоборот, посещают запрещенные папки и файлы с целью выявления уязвимостей и кражи пользовательских данных. В таком случае если вы не хотите явно указывать адрес папки или файла, запрещенного к индексированию, вы можете воспользоваться директивой частичного совпадения. Например, у вас есть папка /shop-zakaz/, которую вы хотите запретить к индексированию. Для того, чтобы явно не указывать адрес этой папки для скрейперов и ботов шпионов вы можете указать часть адреса:

В таком случае если вы не хотите явно указывать адрес папки или файла, запрещенного к индексированию, вы можете воспользоваться директивой частичного совпадения. Например, у вас есть папка /shop-zakaz/, которую вы хотите запретить к индексированию. Для того, чтобы явно не указывать адрес этой папки для скрейперов и ботов шпионов вы можете указать часть адреса:

Disallow: *op-za*

или

Disallow:*zakaz*

Символ * заменяет произвольное количество символов, тогда любые папки и файлы, содержащие в своем названии эту комбинацию, будут запрещены к индексированию. Старайтесь выбирать часть адреса, который уникален для этой папки, потому что если эта комбинация встретится в других файлах и папках, вы запретите их к индексированию.

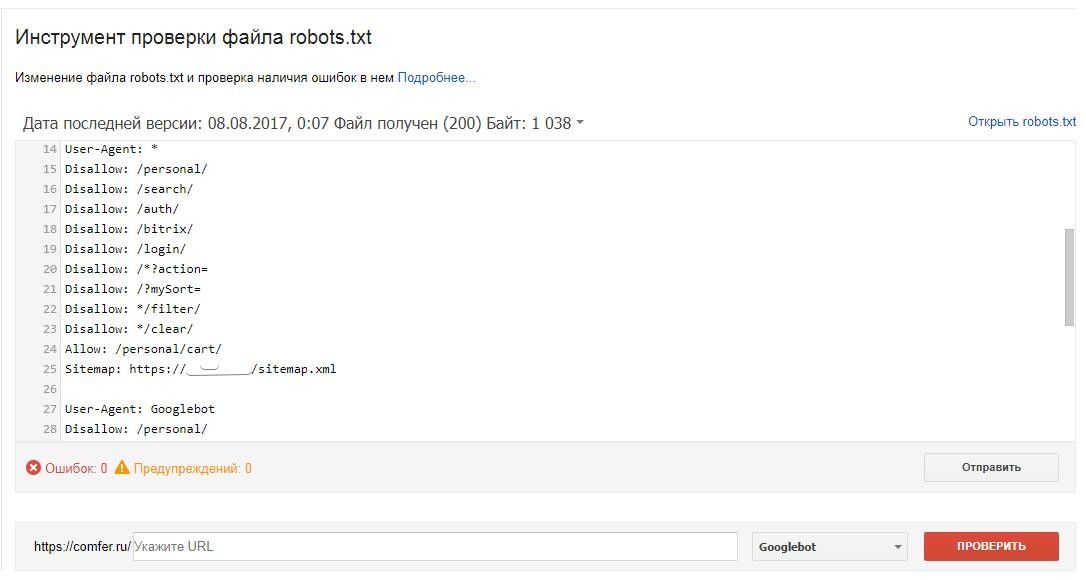

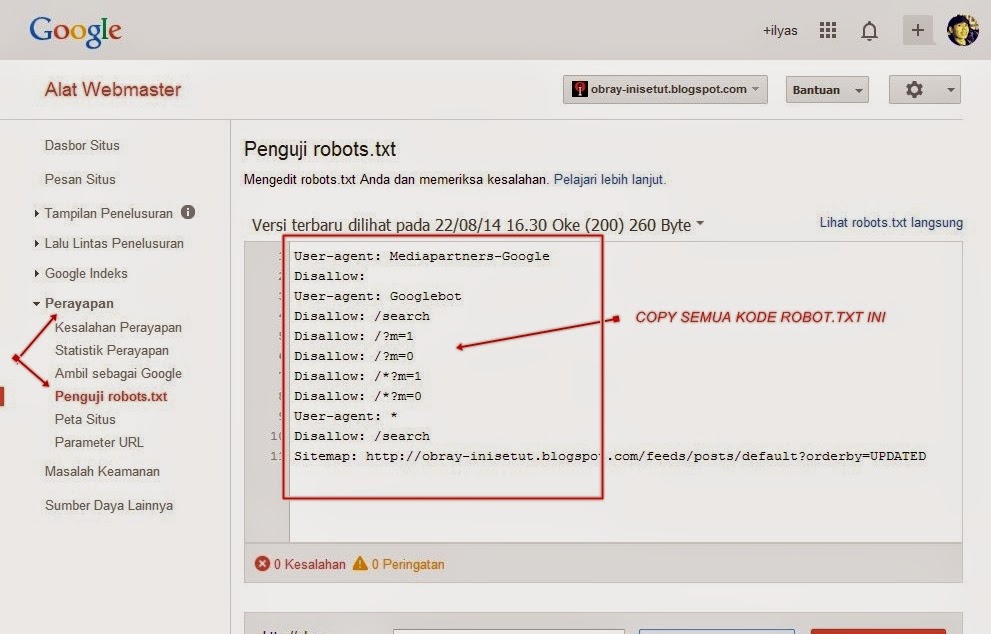

Для того, чтобы случайно не запретить к индексированию нужную часть сайта всегда имеет смысл проверить, как поисковые системы воспринимают правила, указанные в вашем robots.txt. Если вы — подтвержденный владелец сайта в инструментах вебмастера Google или Яндекс — вы можете воспользоваться встроенными инструментами для проверки правил robots.

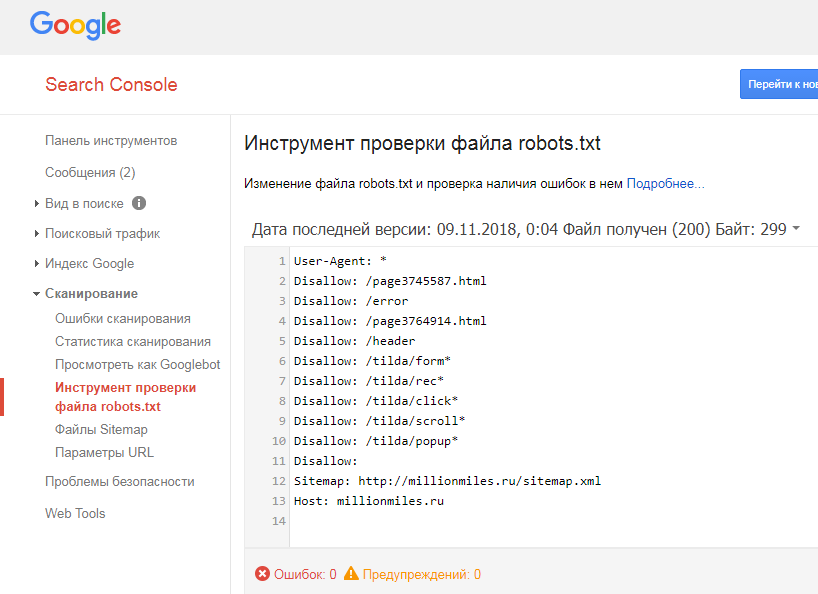

Для того, чтобы проверить robots.txt в Google Webmaster Tools перейдите в секцию «Crawl>Blocked URLs», здесь вы можете воспользоваться текущей версией robots.txt или же отредактировать ее, чтобы протестировать изменения, затем добавьте список URL, которые вы хотите протестировать и нажмите на кнопку «Проверить». Результаты теста покажут, какие из указанных URL разрешены к индексированию, а какие запрещены.

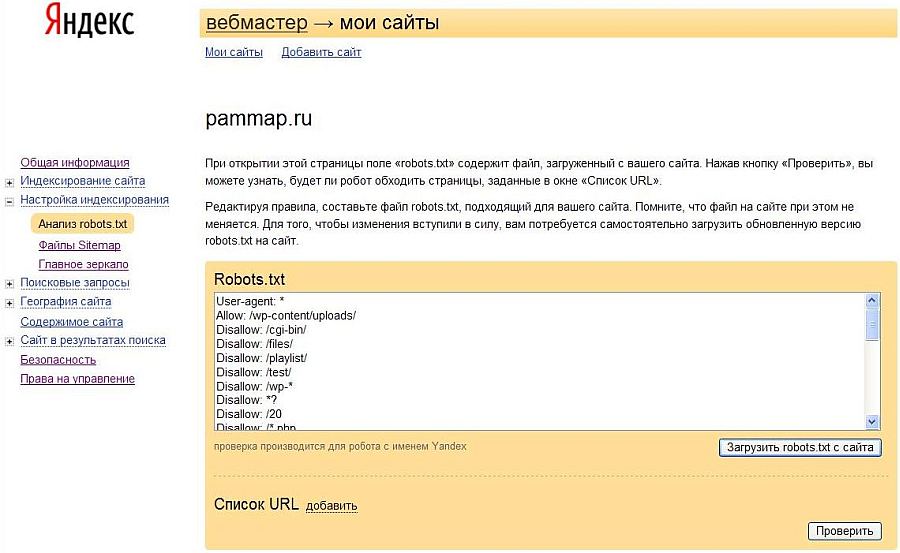

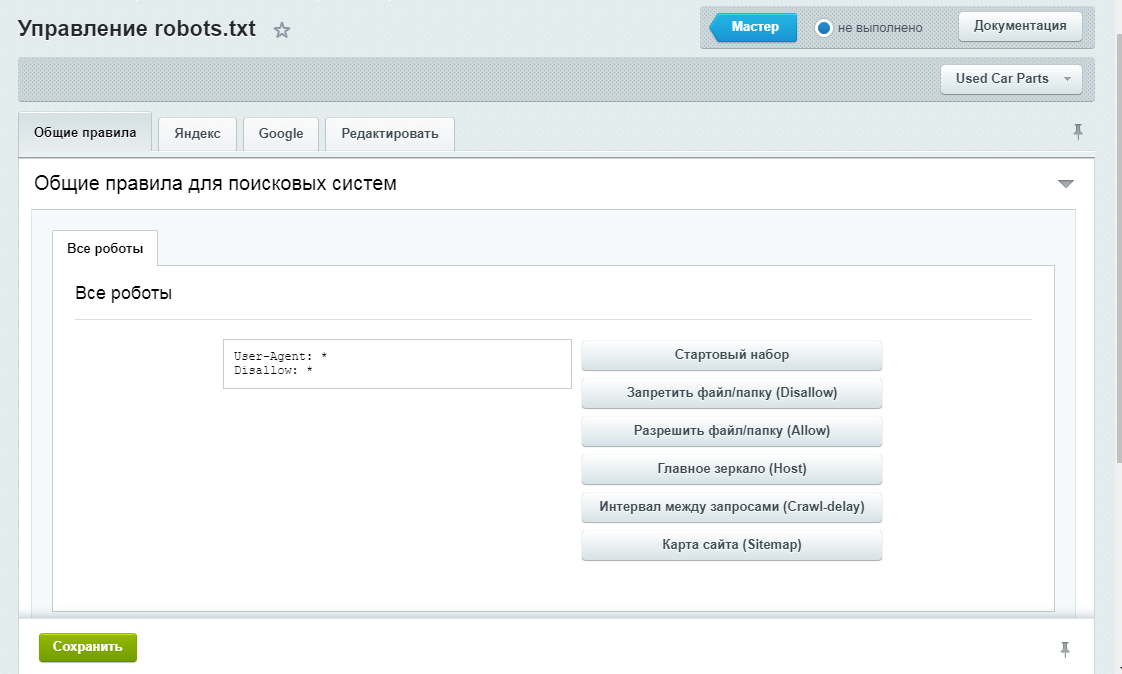

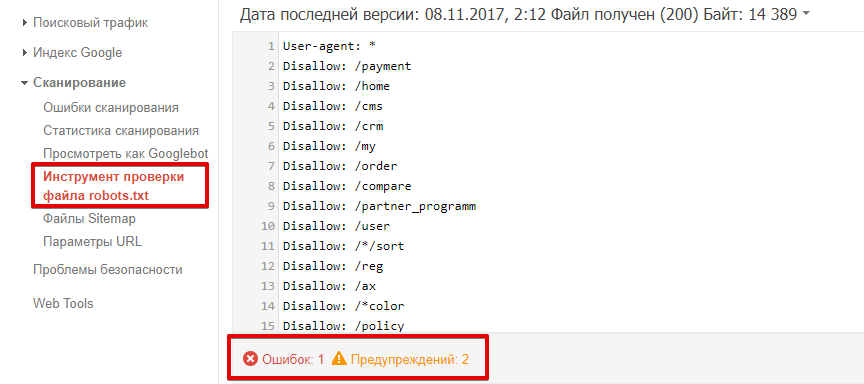

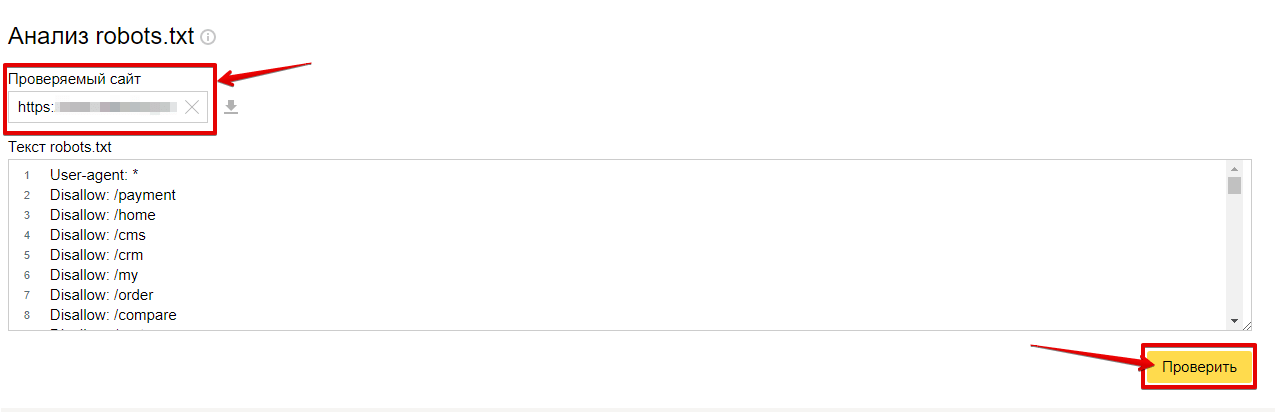

Проверка robots.txt в Яндекс ВебмастерДля того, чтобы проверить robots.txt в Яндекс Вебмастер перейдите в секцию «Настройка индексирования>Анализ robots.txt», при необходимости внесите изменения в robots.txt, добавьте список URL и нажмите кнопку «Проверить». Результаты теста покажут, какие из указанных URL разрешены к индексированию, а какие запрещены.

Редактируя правила составьте файл robots.txt, подходящий для вашего сайта. Помните, что файл на сайте при этом не меняется. Для того, чтобы изменения вступили в силу, вам потребуется самостоятельно загрузить обновленную версию robots.txt на сайт.

Для того, чтобы изменения вступили в силу, вам потребуется самостоятельно загрузить обновленную версию robots.txt на сайт.

Ну, вот мы и осветили основные моменты работы с robots.txt. Если вам нужны фрагменты и примеры файлов robots.txt, которые я использовал в этом видео, перейдите по ссылке, которая указана в описании этого видео. Спасибо за то, что посмотрели это видео, мне было приятно его для вас делать, буду вам благодарен, если вы поделитесь им в социальных сетях)) Ставьте «палец вверх» и подписывайтесь на новые видео.

Если у вас возникли проблемы с просмотром – вы можете посмотреть видео «Уроки WordPress — правильный файл robots.txt WordPress для Яндекса и Google» на YouTube.

Как составить правильный robots.txt для сайта на wordpress

Автор: Ксана

(Людмила Лунева)

Веб-дизайнер и разработчик сайтов на wordpress

Начало статьи читайте здесь »

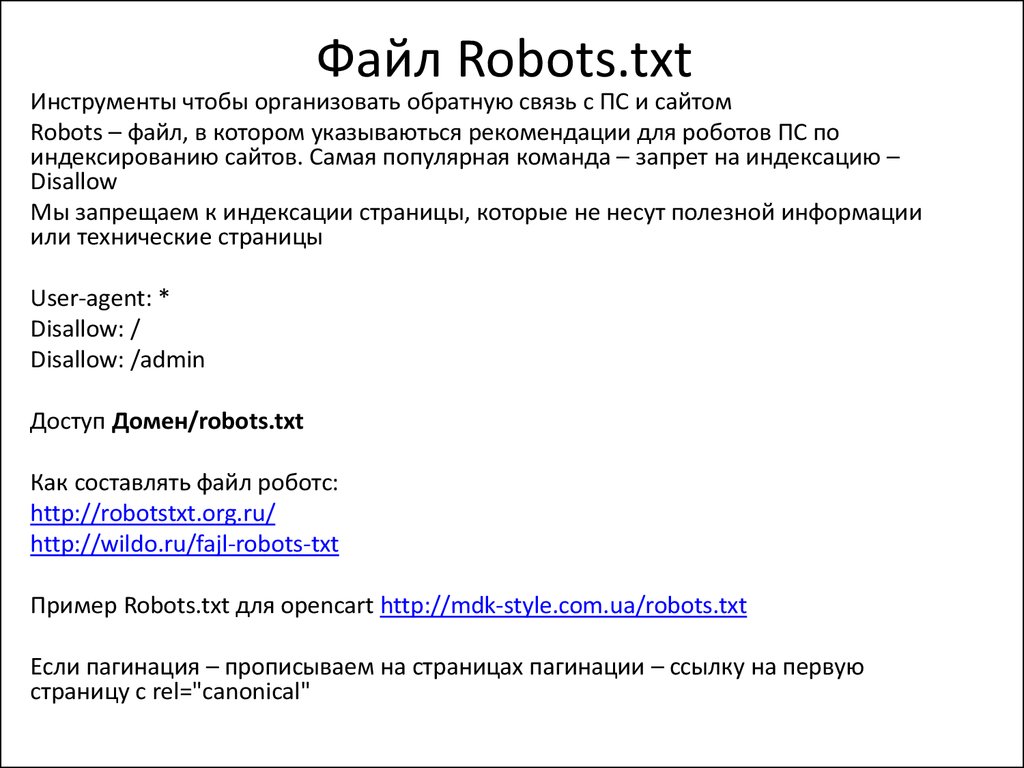

Файл robots. txt — это служебный файл, в котором можно указать роботам ПС (поисковых систем), какие разделы сайта индексировать, а какие нет. Сделать это можно с помощью специальных директив. Директивы можно написать для всех роботов одновременно или отдельно для робота каждой ПС.

txt — это служебный файл, в котором можно указать роботам ПС (поисковых систем), какие разделы сайта индексировать, а какие нет. Сделать это можно с помощью специальных директив. Директивы можно написать для всех роботов одновременно или отдельно для робота каждой ПС.

Разделы, закрытые от индексации, не попадут в индекс поисковых систем.

Что такое Индекс?

Это база данных поисковой системы, в которой она хранит набор встречающихся на интернет-страницах слов и словосочетаний. Эта информация соотнесена с адресами тех веб-страниц, на которых она встречаются, и постоянно пополняется новой информацией, собираемой роботом-пауком поисковой системы.

Вообщем, robots.txt – это очень полезный и нужный любому сайту файл.

Общая для всех сайтов часть файла:

Итак, создаем текстовый документ с названием robots.txt и пишем в него следующее:

User-agent: * Disallow: /cgi-bin/ Disallow: /wp- Disallow: /*trackback Disallow: /feed Disallow: /?s= Disallow: /xmlrpc. |

Пояснения:

User-agent: * — Директива всем роботам

Если нужно, чтобы эти правила работали только для одного, конкретного робота, то вместо * указываем его имя (User-agent: Yandex, User-agent: Googlebot и т.д.).

Disallow: /cgi-bin/

Здесь мы запрещаем индексировать папку со скриптами.

- Disallow: /wp- — Запрещает индексацию всех папок и файлов движка, начинающихся с wp- (т.е. папок /wp-admin/, /wp-includes/, /wp-content/ и всех файлов, расположенных в корневой папке).

Disallow: /*trackback Disallow: /*comment- Disallow: /feed

Запрещаем индексацию комментариев, трекбеков и фида.

Спецсимвол * означает любую (в том числе пустую) последовательность символов, т.е. все, что находится в адресе до указанной части или после нее.- Disallow: /?s= — Запрещаем индексацию результатов поиска.

Allow: /wp-content/uploads/ — Разрешение индексировать папку uploads (а значит и расположенные в ней картинки).

Правило Яндекса для robots.txt гласит:

«Директивы Allow и Disallow из соответствующего User-agent блока сортируются по длине префикса URL (от меньшего к большему) и применяются последовательно. Если для данной страницы сайта подходит несколько директив, то выбирается последняя в порядке появления в сортированном списке.»

Получается, что директиву Аllow можно указать в любом месте.

Яндекс самостоятельно сортирует список директив и располагает их по длине префикса.

Google понимает Allow и вверху и внизу секции.

Касательно директивы Allow: /wp-content/uploads/ — поскольку, далее мы разрешаем индексировать роботам-индексаторам картинок папку с картинками, я не уверена, что эта директива нужна.

Но, наверное, лишней не будет. Так что, это — на ваше усмотрение.Host: www.glavnoye-zerkalo.ru — Директива Host понимается только Яндексом и не понимается Гуглом.

В ней указывается главное зеркало сайта, в случае, если у вашего сайта есть зеркала. В поиске будет участвовать только главное зеркало.

Директиву Host лучше написать сразу после директив Disallow (для тех роботов, которые не полностью следуют стандарту при обработке robots.txt).

Для Яндекса директива Host являются межсекционной, поэтому будет найдена роботом не зависимо от того, где она указана в файле robots.txt.

Важно: Директива Host в файле robots.txt может быть только одна.

В случае указания нескольких директив, использоваться будет первая.Sitemap: http://mysite.ru/sitemaps.xml — Указываем путь к файлу sitemaps.xml

Для Яндекса и Google Sitemap — это межсекционная директива, но лучше написать ее в конце через пустую строку. Так она будет работать для всех роботов сразу.

User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: YandexImages Allow: /wp-content/uploads/

Разрешает роботам Googlebot и YandexImages индексировать наши картинки.

User-agent: ia_archiver Disallow: /

Полностью запрещаем роботу веб архива индексацию нашего сайта.

Это предупредительная мера, которая защитит сайт от массового парсинга контента через веб архив.

Итак, мы рассмотрели стандартную часть файла robots.txt, которая подойдет для любого сайта на wordpress.

Но, нам нужно спрятать от роботов-индексаторов еще некоторые разделы сайта, в частности, те, которые создают дублированный контент — разного рода архивы.

Индивидуальные настройки:

Если на вашем сайте есть система древовидных комментариев, как на моем блоге, тогда нужно запретить индексацию таких адресов:

*?replytocom=

Их создает кнопка (ссылка) «Ответить на комментарий».

- Страницы архивов на разных сайтах имеют различные адреса, в зависимости от того, как формируются URL на сайте, включены ли ЧПУ или нет.

Как определить адреса архивов вашего сайта?Для этого нужно открыть архив любого месяца и посмотреть, как выглядит адрес страницы архива.

Он может выглядеть, например, так: http://sait.ru/archives/date/post-1.

В этом случае, выделяем общую для всех архивов по дате часть адреса:

/archives/date/.

Соответственно, в файле robots.txt указываем:

Disallow: /archives/date/*

Например, архив года может иметь такой адрес: http://sait.ru/2012

Тогда закрывать нужно эту часть — /2012/

Напоминаю, что спецсимвол * означает любую последовательность символов, т.е. все, что находится в адресе далее. - Точно так же определяем адреса архивов тегов и архивов автора.

И закрываем их в robots.txt.Disallow: /archives/tag/ Disallow: /archives/author/

Рекомендую архивы тегов закрыть примерно на полгода-год, (если у вас молодой сайт) пока он стабильно пропишется в поисковой выдаче.

После этого срока архивы тегов стоит открыть для индексации, так как по наблюдениям, на страницы тегов по поисковым запросам приходит значительно больше посетителей, чем на страницы постов, к которым эти теги созданы.

Но, не добавляйте к постам много тегов, иначе вашему сайту будут грозить санкции за дублированный контент.

Один-два (редко три) тега к одному посту вполне достаточно. - Можно, также, закрыть индексацию всех главных страниц, кроме первой.

Обычно, их адреса выглядят так: http://sait.ru/page/2, http://sait.ru/page/3 и т. д., но лучше проверить.

Перейдите по ссылкам навигации внизу Главной страницы на вторую страницу и посмотрите, как выглядит ее адрес в адресной строке.

Закрываем эти страницы:

Disallow: /page/* Иногда, на сайте требуется закрыть от индексации еще какие то страницы или папки. В этом случае, действуете аналогично — открываете в браузере нужную вам страницу и смотрите ее адрес. А дальше закрываете его в robots.

txt.

txt.Учтите, что если вы закрываете, например, папку «book», то автоматически закроются и все файлы, расположенные в этой папке.

Если закрыть страницу, в URL’е которой есть, например, «news» так: */news/,

то закроются и страницы /news/post-1 и /category/news/.

robots.txt полностью ↓

Открыть ↓Справка:

Подробности составления robots.txt можно изучить на странице помощи Яндекса — http://help.yandex.ru/webmaster/?id=996567

Проверить правильность составления файла можно в webmaster.yandex — Настройка индексирования — Анализ robots.txt

В Google robots.txt можно проверить по этой ссылке:

https://www.google.com/webmasters/tools/crawl-access?hl=ru&siteUrl=http://site.ru/

Проверяемый сайт должен быть добавлен в панель веб-мастера.

P.S. Для Яндекса и Google правила составления robots.txt немного различаются.

Толкование правил составления robots.txt можно прочитать здесь — http://robotstxt.org.ru

К сожалению, проверить можно только синтаксис.

Правильно ли вы закрыли от индексации разделы сайта, покажет только время :).

Ну вот и все — файл robots.txt готов, осталось только загрузить его в корневой каталог нашего сайта.

Напоминаю, что корневой каталог это папка в которой находится файл config.php.

И последнее — все, сделанные вами изменения в robots.txt, будут заметны на сайте только спустя несколько месяцев.

В тему:

Однажды видела сайт на wordpress, на котором не было файла robots.txt.

Этот сайт некоторое время простоял пустым — т.е. с одной стандартной записью, которая по умолчанию присутствует в wordpress.

Представьте себе, какой шок испытал владелец сайта, когда обнаружил, что Яндекс проиндексировал 2 страницы с контентом и больше тысячи страниц самого движка 🙂

На этой веселой ноте заканчиваю.

1. Оптимизация кода шаблона.

2. Оптимизация контента.

3. Перелинковка.

4. Файл robots.txt.

5. Файл sitemap.xml.

6. Пинг.

- 5

- 4

- 3

- 2

- 1

(8 голосов, в среднем: 3. 3 из 5)

3 из 5)

Robots.txt для различных CMS | Jeto

В данной статье собраны примеры robots.txt, которые помогут составить корректный настройки файл для различных популярных CMS и фрэймворков: 1C-Битрикс, Joomla, Drupal, WordPress, OpenCart, NetCat, UMI CMS, HostCMS, MODX.

Файл robots.txt – это текстовый файл с технической информаций, размещаемый в корне вашего сайта, он сообщает поисковым системам орядок индексации сайта. Наборы директив (строк) сообщают поисковому роботу, какие разделы сайта запретить или разрешить к индексации. Для ряда поисковых систем, в файле robots.txt могут быть прописаны дополнительные параметры, обрабатываемые только определенной поисковой системой.

Нужно понимать, что приведенные ниже директивы являются лишь примерами и файлы не гарантируют 100% правильную работу, так как в них могуть не предусмотрены специальные разделы, типы файлов, которые должны быть закрыты или открыты на вашей сайте. В некоторых случаях может потребоваться тонкая коррекция настроек под ваш проект, поэтому рекомендуем дополнительно консультироваться по настройке robots. txt с программистом и\или администратором вашего проекта, который знаком с его спецификой и «узкими местами».

txt с программистом и\или администратором вашего проекта, который знаком с его спецификой и «узкими местами».

Обратите внимание: значение site.ru нужна заменить на ваш домен.

Как загрузить файл robots.txt на сайта через ISPmanager?

Авторируйтесь в панели хостина и в ISPmanager перейдите в Менеджер файлов — www — каталог Вашего сайта и на панели нажмите «Закачать».

Перед Вами откроется окно загрузки файла, в котором нужно выбрать robots.txt с локального компьютера и загрузить на сервер.

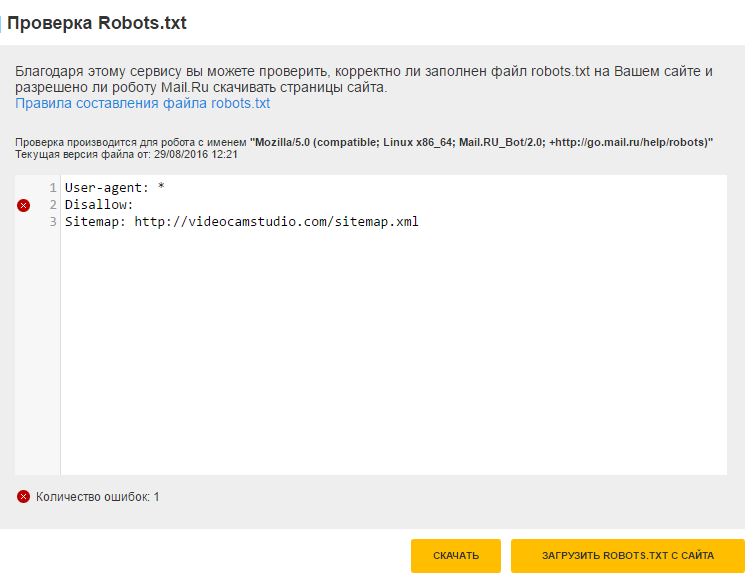

Проверка robots.txt

Проверить успешную загрузку файла на сайта можно открыв его браузере по адресу http://site.ru/ robots.txt , где site.ru — имя Вашего сайта.

После загрузки robots.txt на сайт проверяем корректность работы файла по инструкциям:

Для Яндекс – через Яндекс.Вебмастер, без регистрации.

Для Google – через Google Вебмастер, с регистрацией.

Для robots. txt рекомендуется устанавливать права 444.

txt рекомендуется устанавливать права 444.

robots.txt для 1С-Битрикс

User-agent: *

Allow: /map/

Allow: /search/map.php

Allow: /bitrix/templates/

Disallow: */index.php

Disallow: /*action=

Disallow: /*print=

Disallow: /*/gallery/*order=

Disallow: /*/search/

Disallow: /*/slide_show/

Disallow: /*?utm_source=

Disallow: /*ADD_TO_COMPARE_LIST

Disallow: /*arrFilter=

Disallow: /*auth=

Disallow: /*back_url_admin=

Disallow: /*BACK_URL=

Disallow: /*back_url=

Disallow: /*backurl=

Disallow: /*bitrix_*=

Disallow: /*bitrix_include_areas=

Disallow: /*building_directory=

Disallow: /*bxajaxid=

Disallow: /*change_password=

Disallow: /*clear_cache_session=

Disallow: /*clear_cache=

Disallow: /*count=

Disallow: /*COURSE_ID=

Disallow: /*forgot_password=

Disallow: /*ID=

Disallow: /*index.php$

Disallow: /*login=

Disallow: /*logout=

Disallow: /*modern-repair/$

Disallow: /*MUL_MODE=

Disallow: /*ORDER_BY

Disallow: /*PAGE_NAME=

Disallow: /*PAGE_NAME=detail_slide_show

Disallow: /*PAGE_NAME=search

Disallow: /*PAGE_NAME=user_post

Disallow: /*PAGEN_

Disallow: /*print_course=

Disallow: /*print=

Disallow: /*q=

Disallow: /*register=

Disallow: /*register=yes

Disallow: /*set_filter=

Disallow: /*show_all=

Disallow: /*show_include_exec_time=

Disallow: /*show_page_exec_time=

Disallow: /*show_sql_stat=

Disallow: /*SHOWALL_

Disallow: /*sort=

Disallow: /*sphrase_id=

Disallow: /*tags=

Disallow: /access. log

log

Disallow: /admin

Disallow: /api

Disallow: /auth

Disallow: /auth.php

Disallow: /auto

Disallow: /bitrix

Disallow: /bitrix/

Disallow: /cgi-bin

Disallow: /club/$

Disallow: /club/forum/search/

Disallow: /club/gallery/tags/

Disallow: /club/group/search/

Disallow: /club/log/

Disallow: /club/messages/

Disallow: /club/search/

Disallow: /communication/blog/search.php

Disallow: /communication/forum/search/

Disallow: /communication/forum/user/

Disallow: /content/board/my/

Disallow: /content/links/my/

Disallow: /error

Disallow: /e-store/affiliates/

Disallow: /e-store/paid/detail.php

Disallow: /examples/download/download_private/

Disallow: /examples/my-components/

Disallow: /include

Disallow: /personal

Disallow: /search

Disallow: /temp

Disallow: /tmp

Disallow: /upload

Disallow: /*/*ELEMENT_CODE=

Disallow: /*/*SECTION_CODE=

Disallow: /*/*IBLOCK_CODE

Disallow: /*/*ELEMENT_ID=

Disallow: /*/*SECTION_ID=

Disallow: /*/*IBLOCK_ID=

Disallow: /*/*CODE=

Disallow: /*/*ID=

Disallow: /*/*IBLOCK_EXTERNAL_ID=

Disallow: /*/*SECTION_CODE_PATH=

Disallow: /*/*EXTERNAL_ID=

Disallow: /*/*IBLOCK_TYPE_ID=

Disallow: /*/*SITE_DIR=

Disallow: /*/*SERVER_NAME=

Sitemap: http://site. ru/sitemap_index.xml

ru/sitemap_index.xml

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для WordPress

User-agent: *

Allow: /wp-content/uploads

Disallow: */comment-page-*

Disallow: */comments

Disallow: */feed

Disallow: */trackback

Disallow: /*?

Disallow: /?feed=

Disallow: /?s=

Disallow: /author

Disallow: /cgi-bin

Disallow: /comments

Disallow: /page

Disallow: /search

Disallow: /tag

Disallow: /trackback

Disallow: /webstat

Disallow: /wp-admin

Disallow: /wp-comments

Disallow: /wp-content/cache

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-feed

Disallow: /wp-includes

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /wp-trackback

Disallow: /xmlrpc.php

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для Joomla

User-agent: *

Allow: /images

Allow: /index. php?option=com_xmap&sitemap=1&view=xml

php?option=com_xmap&sitemap=1&view=xml

Disallow: /*?action=print

Disallow: /*?sl*

Disallow: /*atom.html

Disallow: /*rss.html

Disallow: /administrator

Disallow: /bin

Disallow: /cache

Disallow: /cli

Disallow: /component

Disallow: /components

Disallow: /includes

Disallow: /index*

Disallow: /index2.php?option=com_content&task=emailform

Disallow: /installation

Disallow: /language

Disallow: /layouts

Disallow: /libraries

Disallow: /logs

Disallow: /media

Disallow: /modules

Disallow: /plugins

Disallow: /templates

Disallow: /tmp

Disallow: /trackback

Disallow: /xmlrpc

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для OpenCart

User-agent: *

Disallow: /*filter_description=

Disallow: /*filter_name=

Disallow: /*filter_sub_category=

Disallow: /*keyword

Disallow: /*limit=

Disallow: /*manufacturer

Disallow: /*order=

Disallow: /*page=

Disallow: /*route=account

Disallow: /*route=account/login

Disallow: /*route=affiliate

Disallow: /*route=checkout

Disallow: /*route=checkout/cart

Disallow: /*route=product/search

Disallow: /*sort=

Disallow: /*tracking=

Disallow: /admin

Disallow: /cache

Disallow: /cart

Disallow: /catalog

Disallow: /change-password

Disallow: /checkout

Disallow: /download

Disallow: /export

Disallow: /index. php?route=account

php?route=account

Disallow: /index.php?route=account/account

Disallow: /index.php?route=account/login

Disallow: /index.php?route=checkout/cart

Disallow: /index.php?route=checkout/shipping

Disallow: /index.php?route=common/home

Disallow: /index.php?route=product/category

Disallow: /index.php?route=product/compare

Disallow: /index.php?route=product/manufacturer

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /index.php?route=product/search

Disallow: /login

Disallow: /my-account

Disallow: /order-history

Disallow: /request-return

Disallow: /search

Disallow: /search?filter_name=

Disallow: /search?tag=

Disallow: /system

Disallow: /vouchers

Disallow: /vqmod

Disallow: /wishlist

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для MODX

User-agent: *

Disallow: /*?

Disallow: /*?id=

Disallow: /assets

Disallow: /assets/cache

Disallow: /assets/components

Disallow: /assets/docs

Disallow: /assets/export

Disallow: /assets/import

Disallow: /assets/modules

Disallow: /assets/plugins

Disallow: /assets/snippets

Disallow: /connectors

Disallow: /core

Disallow: /index. php

php

Disallow: /install

Disallow: /manager

Disallow: /profile

Disallow: /search

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для Drupal

User-agent: *

Disallow: *comment*

Disallow: *login*

Disallow: *register*

Disallow: /*&sort*

Disallow: /*/delete

Disallow: /*/edit

Disallow: /*?sort*

Disallow: /*calendar

Disallow: /*index.php

Disallow: /*order

Disallow: /*section

Disallow: /*votesupdown

Disallow: /?q=admin

Disallow: /?q=admin/

Disallow: /?q=comment/reply

Disallow: /?q=contact

Disallow: /?q=filter/tips

Disallow: /?q=logout

Disallow: /?q=node/add

Disallow: /?q=search

Disallow: /?q=user/login

Disallow: /?q=user/logout

Disallow: /?q=user/password

Disallow: /?q=user/register

Disallow: /admin

Disallow: /admin/

Disallow: /archive/

Disallow: /book/export/html

Disallow: /CHANGELOG.txt

Disallow: /comment

Disallow: /comment/reply

Disallow: /comments/recent

Disallow: /contact

Disallow: /cron. php

php

Disallow: /filter/tips

Disallow: /forum

Disallow: /forum/active

Disallow: /forum/unanswered

Disallow: /includes

Disallow: /INSTALL.mysql.txt

Disallow: /INSTALL.pgsql.txt

Disallow: /install.php

Disallow: /INSTALL.sqlite.txt

Disallow: /INSTALL.txt

Disallow: /LICENSE.txt

Disallow: /logout

Disallow: /logout/

Disallow: /MAINTAINERS.txt

Disallow: /messages

Disallow: /misc

Disallow: /modules

Disallow: /node

Disallow: /node/add

Disallow: /print/node

Disallow: /profile

Disallow: /profiles

Disallow: /scripts

Disallow: /search

Disallow: /taxonomy

Disallow: /taxonomy/term*/feed

Disallow: /themes

Disallow: /update.php

Disallow: /UPGRADE.txt

Disallow: /user

Disallow: /user/

Disallow: /user/login

Disallow: /user/logout

Disallow: /user/password

Disallow: /user/register

Disallow: /xmlrpc.php

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots. txt для NetCat

txt для NetCat

User-agent: *

Disallow: /*.swf

Disallow: /*?

Disallow: /eng

Disallow: /install

Disallow: /js

Disallow: /links

Disallow: /netcat

Disallow: /netcat_cache

Disallow: /netcat_dump

Disallow: /netcat_files

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для UMI.CMS

User-agent: *

Disallow: /*?

Disallow: /?

Disallow: /admin

Disallow: /emarket/addToCompare

Disallow: /emarket/basket

Disallow: /files

Disallow: /go_out.php

Disallow: /images

Disallow: /images/lizing

Disallow: /images/ntc

Disallow: /index.php

Disallow: /install-libs

Disallow: /install-static

Disallow: /install-temp

Disallow: /search

Disallow: /users

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

robots.txt для HostCMS

User-agent: *

Disallow: /403

Disallow: /404

Disallow: /admin

Disallow: /articles/tag

Disallow: /captcha..png) php

php

Disallow: /chmod.sh

Disallow: /config.php

Disallow: /config_db.php

Disallow: /data_templates

Disallow: /documents

Disallow: /download_file.php

Disallow: /glossary/tag

Disallow: /hostcmsfiles

Disallow: /lib

Disallow: /logs

Disallow: /main_classes.php

Disallow: /modules

Disallow: /news/tag

Disallow: /search

Disallow: /structure

Disallow: /templates

Disallow: /tmp

Disallow: /upload

Disallow: /xsl

Disallow: captcha.php

Disallow: download_file.php

Sitemap: http://site.ru/sitemap.xml

Host: site.ru

Правильный пример robots txt | Как создать файл robots txt для wordpress?

Сегодня я расскажу, как создать файл robots txt для wordpress. Этот пост, будет очень важным для тех, у кого до сих пор нет файла robots txt.

Я постараюсь рассказать вам основные команды, которые используются в этом файле, чтобы вы могли составить самостоятельно robots txt а также покажу пример, каким должен быть правильный robots. txt для wordpress :smile:.

txt для wordpress :smile:.

Дублированный контент является одной из причин всех санкций поисковых систем. Это, то же самое, что пойти на другой сайт, скопипастить оттуда статью и опубликовать на своем ресурсе. Таким образом, у вас появиться неуникальная информация, которую поисковики очень сильно не любят.

Но, самое страшное то, что многие новички даже не подозревают, что у них на блоге может быть дублированный контент. После создания блога, они просто начинают писать себе статьи. Пишут, пишут, а тут раз, и страницы вылетают из индексации :smile:. Потом они думают, почему мой сайт попал под АГС? Я же писал интересные, уникальные статьи для людей. Мой блог несет пользу людям. Да, возможно это правда, и я это понимаю, но поисковый робот, к сожалению, нет :smile:.

Перед тем, как я вам покажу, как создать файл robots txt для wordpress, давайте подумаем, откуда вообще могут взяться дубли на сайте.

1. Доступность ресурса по адресу c www и без www.

Наберите сейчас в адресной строке www. (.*)$ http://vachevskiy.ru/$1 [R=301,L]

(.*)$ http://vachevskiy.ru/$1 [R=301,L]

Этот код будет перенаправлять сайт с www. vachevskiy.ru на vachevskiy.ru. Только не забудьте вместо vachevskiy.ru указать адрес своего сайта.

2. Лишние переменные.

Это когда страница открыта для индексации по такому адресу

Как легко узнать и проверить тиц сайта?

и по такому

Как легко узнать и проверить тиц сайта?

Это две разные страницы для поискового робота, и последнюю, нужно закрывать от индексации. Как правильно это сделать, я объясню немножко позже.

3. Анонс новостей.

Возможно, вы замечали на многих блогах, что идет анонс статьи, картинка, а потом, кнопка читать далее. Так вот, этот анонс будет как раз таки дублированным контентом. Я, например, вообще не делаю анонсов. У меня идет заголовок, картинка и кнопка читать далее. Если вы решили делать анонсы, но старайтесь чтобы они были небольшие, поскольку запретить их индексацию в файле robots. txt невозможно.

txt невозможно.

Ну а вообще, сейчас я вам покажу правильный robots.txt для wordpress, который стоит на моем сайте. Вот пример robots txt:

User-agent: Yandex

Disallow: /wp-register.php

Disallow: /wp-content/themes

Disallow: /*?

Disallow: /webstat/

Disallow: */comments

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: /*?*

Disallow: /comments

Disallow: /wp-content/plugins

Disallow: /wp-admin/

Disallow: /feed/

Disallow: /wp-login.php

Disallow: /category/*/*

Disallow: /wp-includes/

Host: vachevskiy.ruUser-agent: *

Disallow: /wp-login.php

Disallow: /webstat/

Disallow: /feed/

Disallow: */trackback

Disallow: /wp-register.php

Disallow: */feed

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /category/*/*

Disallow: /wp-admin/

Disallow: /trackback

Disallow: /wp-includes/

Disallow: /commentsSitemap: http://vachevskiy.

ru/sitemap.xml

Sitemap: http://vachevskiy.ru/sitemap.xml.gz

Если у вас сайт на движке wordpress, и настроены ЧПУ, то можете смело ставить этот пример robots txt и не париться. Что значит, настроены ЧПУ? Если ссылка вод такая:

Как легко узнать и проверить тиц сайта?

то этот robots.txt подойдет. А если, например, такая (вот статья о том, как сделать ссылку):

http://www.mycharm.ru/articles/text/?id=2766

то нужно просто убрать из файла robots.txt вот эту строчку

Disallow: /*?*, поскольку она заблокирует индексацию всех страниц, где встречается знак вопроса «?». Ее нужно убрать в двоих местах.

Как составить правильный robots.txt самому?

Если у вас другая система управления сайтом, то я вам сейчас кратко расскажу основные команды для того, чтобы вы могли составить robots.txt для своего сайта самостоятельно. Итак, поехали.

Директива «User-agent» отвечает за то, к какому поисковому роботу вы обращаетесь.

- User-agent: * — ко всем поисковикам;

- User-agent: Yandex – только к Яндексу;

- User-agent: Googlebot – только к Гуглу;

Директива «Disallow» закрывает страницы, категории или сайт от индексации.

Например, у меня есть на сайте вод такая страница http://vachevskiy.ru/search/ и я хочу закрыть ее от индексации всех поисковиков. В таком случаи нужно прописать следующее.

User-agent: *

Disallow: /search/

Если вы хотите закрыть весь сайт от индексации гуглом, то нужно прописать так:

User-agent: Googlebot

Disallow: /

А если, наоборот, хотите, чтобы весь сайт индексировался гуглом, то нужно прописать в файле robots.txt вод так:

User-agent: Googlebot

Disallow:

Таким образом, мы можем запретить индексировать сайт или страницу, яндексу и гулу отдельно, или всем поисковикам сразу.

Директива «Allow» разрешает индексировать сайт, категории или страницы.

Например, вы хотите запретить индексировать папку wp-includes всем поисковикам, но в этой папке хотите разрешить индексировать файл compat.php, тогда нужно прописать следующее:

User-agent: *

Disallow: /wp-includes/

Allow: /wp-includes/compat.php

Директива «Sitemap» позволяет указать карту сайта поисковым роботам:

User-agent: *

Sitemap: http://vachevskiy.ru/sitemap.xml

Есть еще несколько директив, которые понимает только Яндекс.

Директива «Host» позволяет указать основной адрес сайта. С www или без www. Я указал без www.

User-agent: Yandex

Host: vachevskiy.ru

Директива «Crawl-delay» позволяет указать задержку, с которой поисковый робот будет отправлять вам команду. Если у вас большой сайт, то поисковик постоянным его штудированием может создать большую нагрузку на сервер. И чтобы этого не случилось, вы можете воспользоваться директивой «Crawl-delay»

Вод пример:

User-agent: Yandex

Crawl-delay: 3

Это значит, что интервал между посылками команды будет 3 секунды. Но опять же, это актуально только для яндекса.

Но опять же, это актуально только для яндекса.

Для того, чтобы без проблем самому составить файл robots.txt, очень важно научиться понимать некоторые спецсимволы. Адрес начинается с третьего слеша.

- Символ * — любая, последовательность символов.

- Символ $ — конец строки.

Я сейчас объясню, что это значит, и как эти символы использовать при составлении файла robots.txt

Сначала разберем, как использовать «*». Например, у меня есть дублирована страница

http://vachevskiy.ru/page?replytocom=29#respond

Для того, чтобы убрать ее с индекса нужно прописать следующее:

User-agent: *

Disallow: /*?*

Таким образом, я говорю поисковому роботу: «Если в URL страницы встретишь знак вопроса «?» то не индексируй ее. И неважно, какие символы стоят до знака вопроса и после него».

Потому что перед знаком вопроса и после него мы поставили звездочку «*». А она, в свою очередь, означает любую последовательность символов.

Ну а теперь разберем, как использовать символ $. Например, у нас есть вод такая страница

http://vachevskiy.ru/index.php

и мы хотим запретить поисковому роботу ее индексировать.

Для этого нужно прописать следующее

User-agent: *

Disallow: /*index.php$

Я говорю поисковикам: «Если index.php конец строки и неважно какие символы до index.php – не индексируй». Пояснил, как мог, если что-то не понятно, то спрашивайте в комментариях ;-).

Таким образом, зная всего лишь эти два спецсимволы, можно запрещать от индексации любую страницу или раздел сайта.

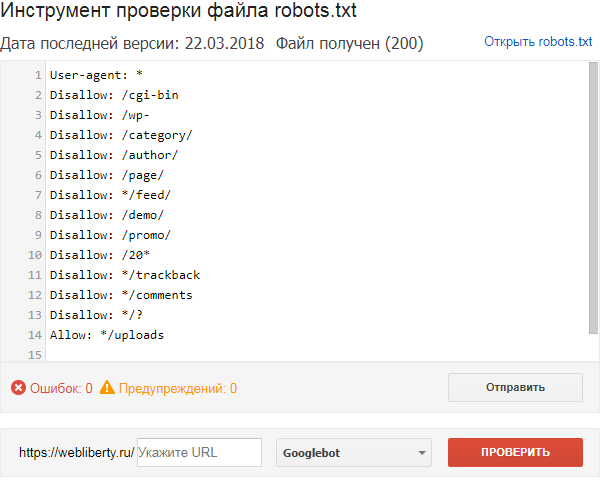

Как убедиться в том, что мы составили правильный robots.txt?

Для этого, прежде всего, нужно добавить сайт в яндекс вебмастер. Потом, нужно зайти в раздел: «Настройка индексирования» — «Анализ robots.txt».

После этого нужно загрузить файл robots.txt и нажать на кнопку проверить. Если вы увидите примерно такое сообщения, как на картинке, без ошибок, значит у вас правильный robots. txt для wordpress или другой системы управления.

txt для wordpress или другой системы управления.

Но мы еще можем проверить конкретную страницу. Например, я копирую url статьи, которая должна быть открыта для индексации, и проверяю, так ли это на самом деле.

Ну вод и все, наверное, что касается вопроса, как создать файл robots txt для wordpress. Да и не только для wordpress. Теперь вы должны уметь составить правильный robots.txt для любой системы управления :smile:.

Правильный Robots.txt для Joomla | PRIME

Перейти к содержанию

Содержание

- Что собой представляет robots.txt?

- Как правильно составить файл роботс

- Шаблон правильного robots.txt для Joomla

Сегодня мы поговорим о том, как верно написать «robots.txt», что бы боты поисковых систем быстро и верно проиндексировали Ваш интернет-ресурс.

Любой администратор интернет ресурса или web-мастер знает, что это за файл и особенности его написания. Что бы было понятнее, предположим, что сайт – это музей, а боты поисковых систем, например, яндекса и гугла – это люди пришедшие на экскурсию. В там случае файл robots – это гид, который четко знает, куда нужно вести людей, что им показывать, а куда никого пускать не стоит. Что бы все работало верно, нужно правильно написать robots с внесением нужных команд.

Что бы было понятнее, предположим, что сайт – это музей, а боты поисковых систем, например, яндекса и гугла – это люди пришедшие на экскурсию. В там случае файл robots – это гид, который четко знает, куда нужно вести людей, что им показывать, а куда никого пускать не стоит. Что бы все работало верно, нужно правильно написать robots с внесением нужных команд.

Уже по названию “robots.txt ” видно, что это текстовый файл. В нем прописывают правила по индексации для поисковых роботов, располагается в корневой папке веб-сайта- http://имясайта/robots.txt. В случае если он еще не создан, то вы можете при помощи блокнота создать его самостоятельно.

Правила содержащиеся в robots, указывают поисковикам:

- Папки, отдельные страницы, разделы вашего интернет ресурса, которые запрещены к индексированию.

- Основное зеркало сайта (к примеру, “вашсайт.ru “ или “вашсайт.

ru”).

ru”). - Время между загрузкой поисковым роботом документов и файлов с сервера (используется для снижения нагрузки на сервер, где находится ваш сайт)

Для примера возьмем Joomla 3.3. После того как устанавливается дистрибутив, файл роботс имеет такой вид:

Теперь подробно разберем, какое значение у всех этих команд, для чего они нужны и как их использовать для настройки своего сайта.

Следующие директивы лучше прописывать отдельно для каждого сайта:

<User-agent: * > — эта строка значит, что правила по индексированию веб- сайта для всех поисковиков будут одинаковыми.

Можно так же прописать отдельно правила для каждой поисковой системы.

Например:

<User-agent: Yandex> — запись будет говорит о том, что эти команды только для поискового бота Яндекса. После нее должны перечислятся основные каталоги сайта, которые будут индексироваться.

Все инструкции записанные в robots.txt для Yandex , будут являться “правилом”, а вот для других ботов, например, Google – лишь “рекомендацией”.

<User-agent: Googlebot > — для поискового бота Гугл.

<Disallow > — запрещает поисковикам проводить индексацию указанных URL или папок/разделов интернет-ресурса.

Директива <Allow > напротив “разрешает” доступ для индексирования указанных страниц, папок, файлов. К примеру:

Такая запись значит, что всем поисковым поисковикам доступ к веб-сайту, исключая те страницы, которые начинаются с ”/spitit”.

Если случится так, что одна и та же страница попадет под правила и одновременно, то поисковик Yandex учтет лишь ту директиву у которой длиннее запись «хвостика» URL. Например:

Запись значит, что страницы начинающиеся с «/razdel»-нельзя индексировать, а те что начинаются с «/razdel/statya» можно индексировать.

Директива <Crawl-delay > обычно используется, для сайтов со слабым хостингом, или очень больших сайтов. С ее помощью указывают время между закачками страниц поисковым ботом, для снижения нагрузки на сервер.

На примере выглядит так:

Для ботов яндекса можно прописывать не только целые числовые значения, например Crawl-delay: 4.5.

Для западных поисковых систем можно так же применять директиву Request-rate : 1/15, что будет означать время между загрузками 15 сек.

Команду< Clean-param > применяют если сайт содержит страницы с часто меняющейся информацией (к примеру, результаты поиска, идентификаторы пользователей и т.д.). Эти параметры складываются из меняющихся цифр, которые дописываются к адресу страницы.

Пример:

Чтобы поисковой бот яндекса не перегружал сервер индексированием подобных страниц, используют вышеупомянутую директиву.

Это пример для результатов поиска:

Директивой < Sitemap > указывается местоположение карты сайта “sitemaps.xml”. Это файл только для поисковиков, для обеспечения быстрой индексации, и для посетителей сайта полезным не является. Нужно указать все карты сайта, если их несколько, начиная с новой строки каждую.

Например:

Используя директиву < Host > мы указываем основное зеркало сайта, которое и будет индексироваться. В основном она пишется для ботов Yandex .

Примечание! Прописывать это правило нужно в поле «User-agent», чуть ниже команд «Disallow«(«Allow«). А вот директиву «Sitemap» можно прописывать, просто пропустив строку вниз.

Особые символы

«#»— значит что все что написано после него до конца данной строки- комментарий.

«*» – это цепочка символов, в т.ч. нулевая.

К примеру:

В конце каждой директивы по умолчанию автоматически дописывается «*» в конце:

Что бы убрать этот символ, используем знак “$”. Представим, что раздел «car» нужно закрыть от индексации, а статьи содержащиеся в нем разрешить индексировать.

Шаблон правильного robots.txt для Joomla

#К какому роботу обращаемся (по умолчанию ко всем)

User-agent: *

#разрешаем доступ к карте сайта

Allow: /index.php?option=com_xmap&sitemap=1&view=xml

#Запрет доступа к админ панели

Disallow: /administrator/

#Запрет доступа к кешу

Disallow: /cache/

#Запрет доступа к компонентам joomla

Disallow: /components/

#Запрещает доступ к папке includes

Disallow: /includes/

#Запрет доступа к языковым пакетам

Disallow: /language/

#Запрет доступа к библиотекам

Disallow: /libraries/

#Запрет доступа к логам

Disallow: /logs/

#Запрет доступа к папке медиа

Disallow: /media/

#Запрет доступа к модулям

Disallow: /modules/

#Запрет индексации плагинов

Disallow: /plugins/

#Папка с вашими шаблонами

Disallow: /templates/

Disallow: /tmp/

Disallow: /xmlrpc/

#Запрет на индексацию формы отправки писем

Disallow: /*com_mailto

#Запрет на индексацию всплывающих окон

Disallow: /*pop=

#Запрет на индексацию дополнительных языков сайта

Disallow: /*lang=ru

#Запрет индексации ссылки вывода на печать

Disallow: /*format=

Disallow: /*print=

#Голосования

Disallow: /*task=vote

#Водяные знаки

Disallow: /*=watermark

#Ссылки на скачивание

Disallow: /*=download

#Профили пользователей

Disallow: /*user/

#Запрет индексации 404 ошибки

Disallow: /404

#Запрет индексации ? и переменных

Disallow: /index. php?

php?

Disallow: /*?

#ссылки содержащие данный знак индексироваться не будут

Disallow: /*%

#ссылки содержащие данный знак индексироваться не будут

Disallow: /*&

#Запрет дублей

Disallow: /index2.php

#Запрет индексации облаков тегов

Disallow: /*tag

#Запрет pdf файлов (на ваше усмотрение)

Disallow: /*.pdf

#Если есть на сайте swf файлы — flash (на ваше усмотрение)

Disallow: /*.swf

#Запрет индексации ссылки на печать

Disallow: /*print=1

#Запрет параметра

Disallow: /*=atom

#Запрещаем RSS

Disallow: /*=rss

#Указываем главное зеркало вашего сайта

Host: domen.ru

# Ваш URL адрес карты сайта в формате .xml

Sitemap: http://domen.ru/sitemap.xml

Go to Top

Как редактировать файл Shopify Robots.txt (2022)

Если вы работаете с сайтом электронной коммерции, файл robots.txt является одним из важнейших элементов SEO вашего сайта. Сайты электронной коммерции, как правило, намного больше, чем большинство сайтов в Интернете, а также содержат такие функции, как фасетная навигация, которые могут экспоненциально увеличивать размер сайта. Это означает, что эти сайты должны иметь возможность более жестко контролировать, как Google сканирует их сайт. Это помогает этим сайтам управлять бюджетом сканирования и предотвращать сканирование низкокачественных страниц роботом Googlebot.

Это означает, что эти сайты должны иметь возможность более жестко контролировать, как Google сканирует их сайт. Это помогает этим сайтам управлять бюджетом сканирования и предотвращать сканирование низкокачественных страниц роботом Googlebot.

Однако, когда дело доходит до Shopify, файл robots.txt уже давно вызывает недовольство сообщества SEO. В течение многих лет одним из самых больших разочарований для Shopify SEO было отсутствие контроля над файлом robots.txt. Это усложнило работу с платформой по сравнению с другими, такими как SEO для Magento, где пользователи всегда могли легко редактировать robots.txt. Хотя файл robots.txt по умолчанию отлично справляется с блокировкой поисковых роботов, некоторые сайты требуют внесения изменений в этот файл. По мере того, как все больше сайтов начинают использовать платформу, мы видим, что сайты, использующие Shopify, становятся больше и надежнее, требуя большего вмешательства сканирования с помощью файла robots.txt.

К счастью, Shopify проделал большую работу по улучшению своей платформы. В июне 2021 года Shopify объявил, что теперь вы сможете настроить файл robots.txt для своего сайта:

В июне 2021 года Shopify объявил, что теперь вы сможете настроить файл robots.txt для своего сайта:

.User-agent: все

Разрешить: /

С сегодняшнего дня у вас есть полный контроль над тем, как роботы поисковых систем видят ваш магазин. #shopifyseohttps://t.co/Hz9Ijj5h2y— Тоби Лютке (@tobi) 18 июня 2021 г.

Это отличная новость для SEO-специалистов и владельцев магазинов Shopify, которые годами умоляли изменить файл. Это также показывает, что Shopify прислушивается к отзывам, которые им дают SEO-специалисты, и предпринимает шаги для улучшения платформы с точки зрения поиска.

Итак, теперь, когда мы знаем, что вы можете редактировать файл, давайте поговорим о том, как сделать эти настройки и о ситуациях, в которых вы можете это сделать.

Что такое Shopify Robots.txt?

Shopify robots.txt — это файл, который указывает поисковым системам, какие URL-адреса они могут сканировать на вашем сайте. Чаще всего файл robots.txt может блокировать поисковые системы от поиска страниц низкого качества, которые не следует сканировать. Shopify robots.txt создается с использованием файла robots.txt.liquid.

Чаще всего файл robots.txt может блокировать поисковые системы от поиска страниц низкого качества, которые не следует сканировать. Shopify robots.txt создается с использованием файла robots.txt.liquid.

Что блокирует файл robots.txt Shopify по умолчанию?

Глядя на готовый сайт Shopify, вы можете заметить, что файл robots.txt уже настроен. Вы можете найти этот файл, перейдя по адресу:

domain.com/robots.txt

В этом файле robots.txt вы увидите, что уже имеется большое количество предварительно настроенных правил.

Подавляющее большинство этих правил полезно для предотвращения сканирования ненужных страниц поисковыми системами. Ниже приведены некоторые из наиболее важных правил в файле Shopify robots.txt по умолчанию:

- Запретить: /search – Блокирует внутренний поиск по сайту

- Запретить: /cart – Блокирует страницу корзины

- Запретить: /checkout — Блокирует страницу оформления заказа

- Запретить: /account — Блокирует страницу учетной записи

- Запретить: /collections/*+* — Блокирует дубликаты страниц категорий, созданные фасетной навигацией

- Карта сайта: [Ссылки на карту сайта] — ссылается на ссылку sitemap.

xml

xml

В целом, правила Shopify по умолчанию довольно хорошо блокируют сканирование веб-страниц низкого качества для большинства сайтов. На самом деле, вполне вероятно, что большинству владельцев магазинов Shopify не нужно вносить какие-либо изменения в свой файл robots.txt. Конфигурации по умолчанию должно быть достаточно для обработки большинства случаев. Большинство сайтов Shopify, как правило, имеют меньший размер, и контроль сканирования не является большой проблемой для многих из них.

Конечно, поскольку все больше и больше сайтов переходят на платформу Shopify, это означает, что сайты становятся все больше и больше. Кроме того, мы видим больше сайтов с пользовательскими конфигурациями, где правил robots.txt по умолчанию недостаточно.

Хотя существующие правила Shopify в большинстве случаев хорошо справляются с учетом, иногда владельцам магазинов может потребоваться создать дополнительные правила, чтобы адаптировать файл robots.txt к своему сайту. Это можно сделать, создав и отредактировав файл robots. txt.liquid.

txt.liquid.

Как создать Shopify Robots.txt.liquid?

Вы можете создать файл Shopify robots.txt.liquid, выполнив следующие шаги в своем магазине:

- На левой боковой панели страницы администрирования Shopify перейдите в Интернет-магазин > Темы

- Выберите Действия > Изменить код

- В разделе «Шаблоны» щелкните ссылку «Добавить новый шаблон»

- Щелкните крайний левый раскрывающийся список и выберите «robots.txt»

- Выберите «Создать шаблон»

После этого в редакторе должен открыться файл Shopify robots.txt.liquid:

Как редактировать файл Shopify Robots.txt?

Добавление правила

Если вы хотите добавить правило в файл robots.txt Shopify, вы можете сделать это, добавив дополнительные блоки кода в файл robots.txt.liquid.

{%- if group.user_agent.value == ‘*’ -%}

{{ ‘Disallow: [URLPath] ‘ }}

{%- endif -%}

Например, если ваш сайт Shopify использует /search-results/ для функции внутреннего поиска и вы хотите заблокировать его с помощью файла robots. txt, вы можете добавить следующую команду:

txt, вы можете добавить следующую команду:

{%- if group.user_agent .value == ‘*’ -%}

{{ ‘Disallow: /search-results/.*’ }}

{%-endif -%}

Если вы хотите заблокировать кратные каталоги (/search-results/ & /private/) вы должны добавить в файл следующие два блока:

{%- if group.user_agent.value == ‘*’ -%}

{{ ‘Запретить: /search-results/.*’ }}

{%- endif -%}

{%- if group.user_agent.value == ‘*’ -%}

{{ ‘Disallow: /private/.*’ }}

{%- endif -%}

Это должно позволить заполнить следующие строки в вашем файле Shopify robots.txt:

Потенциальные варианты использования

Итак, зная, что стандартного файла robots.txt обычно достаточно для большинства сайтов, в каких ситуациях ваш сайт будет полезен от редактирования файла robots.txt.liquid Shopify? Ниже приведены некоторые из наиболее распространенных ситуаций, когда вы, возможно, захотите рассмотреть возможность корректировки своей:

Внутренний поиск по сайту

Общепринятым правилом для поисковой оптимизации является блокировка внутреннего поиска по сайту через файл robots. txt. Это связано с тем, что существует бесконечное количество запросов, которые пользователи могут вводить в строку поиска. Если Google сможет начать сканирование этих страниц, это может привести к тому, что в индексе появится много низкокачественных страниц с результатами поиска.

txt. Это связано с тем, что существует бесконечное количество запросов, которые пользователи могут вводить в строку поиска. Если Google сможет начать сканирование этих страниц, это может привести к тому, что в индексе появится много низкокачественных страниц с результатами поиска.

К счастью, файл robots.txt Shopify по умолчанию блокирует стандартный внутренний поиск с помощью следующей команды:

Запретить: /search

Однако многие сайты Shopify не используют внутренний поиск Shopify по умолчанию. Мы обнаружили, что многие сайты Shopify в конечном итоге используют приложения или другие технологии внутреннего поиска. Это часто изменяет URL-адрес внутреннего поиска. Когда это происходит, ваш сайт больше не защищен правилами Shopify по умолчанию.

Например, на этом сайте результаты внутреннего поиска отображаются по URL-адресам с /pages/search в пути:

Это означает, что эти внутренние поисковые URL разрешены для сканирования Google:

Этот веб-сайт может захотеть рассмотреть возможность изменения правил Shopify robots. txt, чтобы добавить пользовательские команды, которые блокируют Google от сканирования каталога /pages/search.

txt, чтобы добавить пользовательские команды, которые блокируют Google от сканирования каталога /pages/search.

Многогранная навигация

Если на вашем сайте есть многогранная навигация, возможно, вы захотите изменить файл Shopify robots.txt. Многогранная навигация — это параметры фильтрации, которые вы можете применять на страницах категорий. Обычно они находятся в левой части страницы. Например, этот сайт Shopify позволяет пользователям фильтровать товары по цвету, размеру, типу продукта и т. д.:

Когда мы выбираем цветовые фильтры «Черный» и «Желтый», мы видим, что загружается URL-адрес с параметром «?color»: хорошо блокирует пути к страницам, которые может создать фасетная навигация, но, к сожалению, не может учитывать каждый вариант использования. В этом случае «цвет» не блокируется, что позволяет Google сканировать страницу.

Это может быть еще один случай, когда мы можем захотеть заблокировать страницы с помощью файла robots. txt в Shopify. Поскольку большое количество этих фасетных навигационных URL-адресов может быть просканировано, мы можем захотеть заблокировать многие из них, чтобы уменьшить сканирование менее качественных/похожих страниц. Этот сайт может определить все параметры многогранной навигации, которые они хотели бы заблокировать (размер, цвет), а затем создать правила в файле robots.txt, чтобы заблокировать сканирование.

txt в Shopify. Поскольку большое количество этих фасетных навигационных URL-адресов может быть просканировано, мы можем захотеть заблокировать многие из них, чтобы уменьшить сканирование менее качественных/похожих страниц. Этот сайт может определить все параметры многогранной навигации, которые они хотели бы заблокировать (размер, цвет), а затем создать правила в файле robots.txt, чтобы заблокировать сканирование.

Навигация по сортировке

Подобно функциям многогранной навигации, многие сайты электронной коммерции включают сортировку на страницах своих категорий. На этих страницах пользователи могут видеть продукты, предлагаемые на страницах категорий, в другом порядке (цена: от низкой к высокой, наиболее релевантные, в алфавитном порядке и т. д.).

Проблема заключается в том, что эти страницы содержат дублированный/похожий контент, поскольку они являются просто вариантами исходной страницы категории, но с продуктами в другом порядке. Ниже вы можете увидеть, как при выборе «По алфавиту, от А до Я» создается параметризованный URL-адрес, который сортирует товары по алфавиту. Этот URL-адрес использует параметр «?q», добавленный в конце:

Этот URL-адрес использует параметр «?q», добавленный в конце:

Конечно, это не уникальный URL-адрес, который следует сканировать и индексировать, поскольку это просто те же продукты, что и на исходной странице категории, отсортированные в другом порядке. Этот сайт Shopify может захотеть добавить правило robots.txt, которое блокирует сканирование всех URL-адресов «?q».

Заключение

Файл robots.txt.liquid от Shopify позволяет SEO-специалистам гораздо лучше контролировать сканирование своего сайта, чем раньше. Хотя для большинства сайтов файла robots.txt Shopify по умолчанию должно быть достаточно, чтобы поисковые системы не попадали в нежелательные области, вы можете рассмотреть возможность его корректировки, если заметите, что к вам относится пограничный случай. Как правило, чем больше ваш магазин и чем больше вы его настроили, тем больше вероятность того, что вы захотите внести изменения в файл robots.txt. Если у вас есть какие-либо вопросы об услугах SEO-агентства robots. txt или Shopify, не стесняйтесь обращаться к нам!

txt или Shopify, не стесняйтесь обращаться к нам!

Другие SEO-ресурсы Shopify

- Оптимизация скорости Shopify

- Улучшение Shopify Дублированный контент

- Руководство по Shopify Sitemap.xml

- Shopify Структурированные данные

- Shopify Инструменты SEO

- Shopify Плюс SEO

- Все SEO-статьи Shopify

Поиск новостей прямо в папку «Входящие»

*Обязательно

О Крисе Лонге

Крис Лонг — вице-президент по маркетингу в Go Fish Digital. С 9+ многолетний опыт, Крис работает с уникальными проблемами и сложными поисковыми ситуациями, чтобы помочь клиентам улучшить органический трафик благодаря глубокому пониманию алгоритма Google и веб-технологий. Крис консультировал по стратегиям поиска таких клиентов, как GEICO, Adobe и The New York Times. Он является сотрудником Moz, Search Engine Land и Search Engine Journal. Он также выступает на отраслевых конференциях, таких как SMX East и BrightonSEO.

WordPress Robots.txt — Как создать и оптимизировать для SEO

Что такое robots.txt? Как создать файл robots.txt? Зачем нужно создавать файл robots.txt? Помогает ли оптимизация файла robots.txt улучшить ваш поисковый рейтинг?

Мы расскажем обо всем этом и многом другом в этой подробной статье о robots.txt!

Вы когда-нибудь хотели запретить поисковым системам сканировать определенный файл? Хотели, чтобы поисковые системы не сканировали определенную папку на вашем сайте?

Здесь на помощь приходит файл robots.txt. Это простой текстовый файл, который сообщает поисковым системам, где и где не сканировать ваш сайт при индексировании.

Хорошей новостью является то, что вам не нужно иметь никакого технического опыта, чтобы раскрыть всю мощь файла robots.txt.

Robots.txt — это простой текстовый файл, создание которого занимает несколько секунд. Это также один из самых простых файлов, который можно испортить. Всего один неуместный символ, и вы испортите SEO всего своего сайта и запретите поисковым системам доступ к вашему сайту.

При работе над SEO сайта важную роль играет файл robots.txt. Хотя он позволяет запретить поисковым системам доступ к различным файлам и папкам, часто это не лучший способ оптимизировать ваш сайт.

В этой статье мы объясним, как использовать файл robots.txt для оптимизации вашего веб-сайта. Мы также покажем вам, как его создать, и поделимся некоторыми плагинами, которые нам нравятся, которые могут сделать тяжелую работу за вас.

Содержание

- Что такое robots.txt?

- Как выглядит файл robots.txt?

- Что такое бюджет сканирования?

- Как создать файл robots.txt в WordPress?

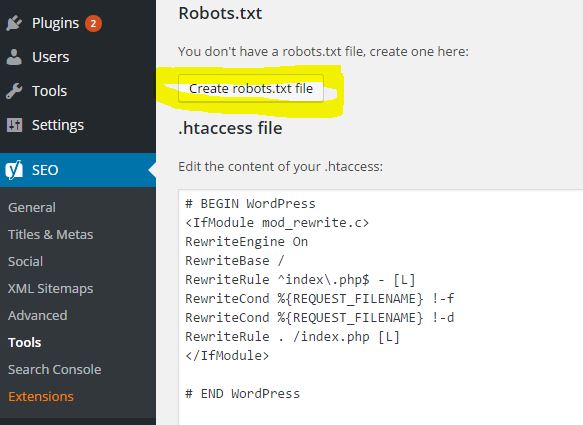

- Способ 1. Создайте файл robots.txt с помощью плагина Yoast SEO

- Метод 2. Создание файла Robots.txt вручную с помощью FTP Файл robots.txt для вашего сайта WordPress?

- Заключительные мысли

Что такое robots.txt?

Robots.txt — это простой текстовый файл, который сообщает роботам поисковых систем, какие страницы вашего сайта сканировать. Он также сообщает роботам, какие страницы не сканировать.

Он также сообщает роботам, какие страницы не сканировать.

Прежде чем мы углубимся в эту статью, важно понять, как работает поисковая система.

Поисковые системы выполняют три основные функции: сканирование, индексирование и ранжирование.

(Источник: Moz.com)

Поисковые системы начинают с того, что рассылают по сети своих поисковых роботов, также называемых пауками или ботами. Эти боты представляют собой часть интеллектуального программного обеспечения, которое перемещается по всей сети в поисках новых ссылок, страниц и веб-сайтов. Этот процесс поиска в сети называется сканирует .

Как только боты обнаружат ваш веб-сайт, ваши страницы будут организованы в удобную структуру данных. Этот процесс называется индексированием .

И, наконец, все сводится к рейтингу . Где поисковая система предоставляет своим пользователям лучшую и наиболее актуальную информацию на основе их поисковых запросов.

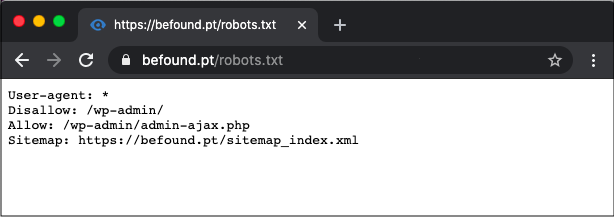

Как выглядит robots.txt?

Допустим, поисковая система собирается посетить ваш сайт. Прежде чем он просканирует сайт, он сначала проверит robots.txt на наличие инструкций.

Например, предположим, что робот поисковой системы собирается просканировать наш сайт WPAstra и получить доступ к нашему файлу robots.txt, доступ к которому осуществляется с https://wpastra.com/robots.txt.

Пока мы обсуждаем эту тему, вы можете получить доступ к файлу robots.txt для любого веб-сайта, введя «/robots.txt» после имени домена.

ОК. Возвращение на правильный путь.

Выше приведен типичный формат файла robots.txt.

И прежде чем вы подумаете, что все это слишком технично, хорошая новость заключается в том, что это все, что есть в файле robots.txt. Ну, почти.

Давайте разберем каждый элемент, упомянутый в файле.

Первый User-agent: * .

Звездочка после User-agent указывает, что файл применяется ко всем роботам поисковых систем, которые посещают сайт.

У каждой поисковой системы есть собственный пользовательский агент, который сканирует Интернет. Например, Google использует Googlebot для индексации контента вашего сайта для поисковой системы Google.

Некоторые другие пользовательские агенты, используемые популярными поисковыми системами,

- Google: Googlebot

- Googlebot News: Googlebot-News

- Googlebot Images: Googlebot-Image

- Googlebot Video: Googlebot-Video

- Bing: Bingbot

- Yahoo: Slurp Bot

- DuckDuckGo: DuckDuckBot

- Baidu: Baiduspider

- Яндекс: YandexBot

- Exalead: ExaBot

- Amazon Alexa: ia_archiver

Таких юзер-агентов сотни.

Вы можете установить пользовательские инструкции для каждого пользовательского агента. Например, если вы хотите указать конкретные инструкции для робота Googlebot, первая строка вашего файла robots.txt будет такой:

Агент пользователя: Googlebot

Вы назначаете директивы всем агентам пользователя, используя звездочку (*) рядом с Агентом пользователя.

Допустим, вы хотите запретить всем ботам, кроме робота Google, сканировать ваш сайт. Ваш файл robots.txt будет иметь следующий вид:

User-agent: * Запретить: / Агент пользователя: Googlebot Разрешить: /

Косая черта ( / ) после Запретить указывает боту не индексировать какие-либо страницы на сайте. И хотя вы назначили директиву, которая будет применяться ко всем ботам поисковых систем, вы также явно разрешили роботу Google проиндексировать ваш веб-сайт, добавив ‘ Разрешить: / .’

Точно так же вы можете добавить директивы для любого количества пользовательских агентов.

Подводя итоги, давайте вернемся к нашему примеру Astra robots.txt, т. е.

User-agent: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Для всех ботов поисковых систем задана директива не сканировать что-либо в папке « /wp-admin/», но следовать « admin-ajax». php ‘ в той же папке.

Просто, правда?

Здравствуйте! Меня зовут Суджей, и я генеральный директор Astra.

Наша миссия — помочь малым предприятиям расти в Интернете с помощью доступных программных продуктов и образования, необходимого для достижения успеха.

Оставьте комментарий ниже, если хотите присоединиться к беседе, или нажмите здесь, если хотите получить личную помощь или пообщаться с нашей командой в частном порядке.

Что такое краулинговый бюджет?

Добавляя косую черту после Disallow , вы запрещаете роботу посещать какие-либо страницы сайта.

Итак, ваш следующий очевидный вопрос: зачем кому-то мешать роботам сканировать и индексировать ваш сайт? В конце концов, когда вы работаете над SEO веб-сайта, вы хотите, чтобы поисковые системы сканировали ваш сайт, чтобы помочь вам в рейтинге.

Именно поэтому вам следует подумать об оптимизации файла robots.txt.

Вы представляете, сколько страниц у вас на сайте? От реальных страниц до тестовых страниц, страниц дублированного контента, страниц благодарности и других. Много, полагаем.

Много, полагаем.

Когда бот сканирует ваш сайт, он будет сканировать каждую страницу. А если у вас несколько страниц, поисковому роботу потребуется некоторое время, чтобы просканировать их все.

(Источник: Seo Hacker)

Знаете ли вы, что это может негативно повлиять на рейтинг вашего сайта?

И это из-за краулингового бюджета поисковой системы .

ОК. Что такое краулинговый бюджет?

Бюджет обхода — это количество URL-адресов, которое поисковый робот может просканировать за сеанс. Для каждого сайта будет выделен определенный краулинговый бюджет. И вам нужно убедиться, что краулинговый бюджет расходуется наилучшим образом для вашего сайта.

Если у вас есть несколько страниц на вашем веб-сайте, вам определенно нужно, чтобы бот сначала сканировал наиболее ценные страницы. Таким образом, необходимо явно указать это в файле robots.txt.

Ознакомьтесь с ресурсами, доступными в Google, чтобы узнать, что означает краулинговый бюджет для робота Googlebot.

Как создать файл robots.txt в WordPress?