SEO-продвижение лендинга | medoed1.ru

SEO

SEOКак известно, для поискового продвижения гораздо лучше приспособлены большие многостраничные сайты, продвинуть лендинг пейдж на первые строчки мало кому удается, однако существует ряд приемов, благодаря которым можно повлиять на индексацию сайта поисковиками, и в результате попадание лендинга на первую страницу поиска Яндекса или Гугла, по крайней мере по средне- или низкочастотным запросам вполне достижимо. Рассмотрим, какие именно факторы на неё повлияют.

Техническая оптимизация лендинга

Во-первых, вы напрямую можете повлиять на технические аспекты сайта, ведь на них поисковые машины обращают внимания не меньше, чем живые посетители. Если приходится долго ждать открытия сайта, дольше нескольких секунд, то его в топ выдачи не поместит ни один уважающий себя поисковик. То же самое относится и к доступности сайта — аптайм менее 99% будет нежелательным.

Если говорить о скорости загрузки лендинга, то первое, что вы можете сделать — это уменьшить вес картинок. Для оптимизации изображений существует много бесплатных онлайн-сервисов, и если ваша посадочная страница переполнена картинками, оптимизацией которых вы не занимались, то это может ощутимо повлиять на скорость загрузки сайта.

Ключевые слова для лендинга

Лендинг — это сайт одностраничный, и к тому же, если он сделан правильно, не концентрирующийся на текстовом наполнении. Поэтому у нас будет не так много пространства для текстовых маневров, значит ключи, которые будут использоваться, следует выбирать, несколько раз подумав. Особого смысла в высокочастотники лезть не будет — вряд ли сейчас найдется ниша, в которой не засел многостраничный сайт конкурента, который будет очень трудно подвинуть. Следовательно, лучше поискать интересные запросы с частотностью от 100 в месяц. В подборе ключей может помочь Яндекс.Вордстат.

Введя основной, самый частотный запрос, мы увидим два столбца: в левом будут предлагаться расширенные варианты искомого ключа, а в правом — синонимы и запросы, относящиеся к интересам вашей целевой аудитории. И в первом, и во втором можно найти ключи, которые целесообразно использовать на посадочной странице. А чтобы узнать точную частотность ключа, не забывайте пользоваться поисковыми операторами, в частности кавычками.

Еще одним способом оказаться в топе (причем сравнительно быстро) будет включение главного ключа в домен сайта — в этом случае, при не самой большой конкуренции в нише, вы можете попасть и на первую строку.

Оптимизация текста

Размещать на лендинге текстовые простыни — решение нерациональное и откровенно проигрышное с точки зрения конверсии. Поэтому ключевыми словами тут особо не разбросаешься, перенасыщение ключами до добра не доведет. Однако это не значит, что свой главный ключ вы вообще не можете повторять. Можете, но делайте это в разных блоках лендинга:

- главный экран

- преимущества

- отзывы

- цены

- и т.д.

Кроме заголовков и абзацев, ключевики должны присутствовать там, где их заметит поисковый робот, но не человек. Это атрибуты alt у изображений, мета-теги title и desription (они будут отображаться в сниппете поисковой системы). Используйте на сайте теги заголовков <h2>, <h3>, <h4> — на них робот также обращает внимание.

Поведенческие факторы

Возможно, главное, чему вы должны уделять внимание на лендинге — это его поведенческие факторы. Потому что даже если они незначительно повлияют на ранжирование, то будут свидетельствовать о качестве вашего сайта — а здесь недалеко и до роста показателей конверсии. Делайте свой сайт интересным, чтобы на нем хотелось задержаться: добавляйте видео и прочие мультимедиа-блоки. Тщательно прорабатывайте первое блоки, чтобы посещение с меньшей вероятностью было записано в отказы (то есть длилось дольше 15 секунд).

Файл robots.txt для лендинга

Иногда можно встретить ситуацию, что landing page просто-напросто скрыт от индексирования поисковиками, то есть в файле robots.txt прописано

User-agent: *

Disallow: /

Это значит лишь то, что вебмастер проставил такие значения по умолчанию, не задумываясь о том, что лендинг кто-то захочет продвигать в поиске. Отчасти понять его можно: лендинги предназначены явно не для поискового трафика, однако чем мы навредим, попытаясь заявить о себе поисковикам? Правильно — ничем. Поэтому примерный вид правильного robots.txt будет таким:

User-agent: *

Allow: /images/

Disallow: /js/

Disallow: /css/

User-agent: Googlebot

Allow: /

User-agent: Yandex

Allow: /images/

Disallow: /js/

Disallow: /css/

Host: site.ru

Вывод

Если у вас лендинг — то не стоит рассчитывать на успехи в поисковом продвижении. Это возможно, но не всегда, и не по высокочастотным ключам. Тем не менее, если вы решили попытаться пробиться в топ выдачи со своим одностраничником, то позаботьтесь о том, чтобы сайт был оптимизирован в техническом плане, на нем встречались целевые запросы, а главное — чтобы он был высокого качества и обеспечивал хорошие поведенческие факторы.

medoed1.ru

Как сделать SEO для лендинга

SEO для лендинга – вещь спорная среди вебмастеров и оптимизаторов. Одни считают, что тратить на это время не нужно и эффекта от этого будет ничтожно мало, другие возлагают на это большие надежды.

На самом деле уделить внимание SEO для лендинга есть смысл. Дополнительный трафик никогда не будет лишним. И вдруг, именно от трафика из поисковика будет хорошая конверсия.

Почему SEO для лендинга — это лишь дополнительный трафик, а не основной

Продвигать лендинг пейдж в поисковике эффективно нельзя. Если вам обещают сделать SEO оптимизацию вашей посадочной страницы и сгенерировать из поиска уйму трафика – не верьте. Это не правда. И ничего не получится. Трафик будет, но небольшой. Именно поэтому поисковик для лендинга — это только дополнительный трафик.

Почему так происходит? Всё очень просто.

Для того, чтобы сайт придвигался в поисковике, он должен отвечать двум важным требованиям:

- На нём должно быть несколько страниц и чем больше, тем лучше. А в лендинге, как мы знаем, только одна страница.

- Разные страницы сайта должны быть созданы под разные запросы. А лендинг создаётся лишь под один запрос. Одна страница под один запрос.

Однако, несмотря на это SEO для лендинга всё равно имеет смысл. И получить небольшой трафик из поисковика на него бывает полезно. Трафика будет столько, сколько смогла бы принести одна страница с многостраничного сайта.

Как сделать SEO для лендинга

Итак, для этого потребуется некоторое время. Нужно один раз сесть, седлать и потом спокойно жить, и думать, что у вас сделано всё, для максимального трафика.

Выберите ключевую фразу

Лендинги чаще всего создаются под коммерческий запрос, например, со словом “купить”, “заказать”. Как правило, такие запросы высоконкурентные, и продвигаться по ним будет трудно. Поэтому надо постараться подобрать такую ключевую фразу, которая будет и коммерческой, и низкочастотной.

В идеале, конечно же, лучше брать некоммерческий запрос. Но это не всегда возможно в условиях лендинга.

Напишите статью

После того, как вы выбрали ключевую фразу, по которой лендинг будет продвигаться, напишите под неё статью. Сделайте не просто SEO статью, а продающую статью, то есть используйте контент не только для оптимизации под поисковик, но и для продажи продукта, для которого создаёте данный лендинг.

Статья должна быть 2 000 – 4 000 символов. Если сделать меньше, то поисковик её не воспримет, а если больше, то это уже не продающая страница, а читальный зал.

Сделайте заголовки

Сделайте у лендинга заголовок h2, в котором будет использоваться ключевая фраза. Естественно, в условиях посадочной страницы это должен быть мощный, цепляющий и продающий заголовок, а не просто фраза с ключом внутри.

Помните, что заголовок h2 может быть только один на всей странице.

В самой статье сделайте разделы, которые озаглавьте с помощью h3 и h4. В них тоже можно использовать ключевые фразы – основную и вспомогательные тоже не помешают. А более мелкие по значению заголовки – h5, H5 и H6 лучше не использовать.

Сделайте мета-теги

Здесь следует сделать title (SEO заголовок) и description (SEO описание). В них нужно использовать основную ключевую фразу. Скорее всего из них поисковик может формировать снипет в поисковой выдаче. И поэтому эти данные также должны быть мощными, продающими и завлекающими.

Но имейте в виду, что снипет, всё-таки, может быть сформирован и из других фрагментов страницы.

Опубликуйте изображения

Добавьте в страницу изображения. Кроме того, что картинки — это обязательная часть любого лендинга, это ещё и понадобится для продвижения. Но изображения должны быть SEO оптимизированными.

Картинка должна быть весом не более 1 мб. В ином случае она будет влиять на скорость загрузки страницы. Это вредно для юзабилити и индексирования.

Изображению нужно записать атрибуты alt и title. В них желательно использовать ключевые фразы, и они должны быть уникальными относительно других изображений и всего остального текста на странице.

Как и любой другой элемент на лендинге, изображения должны продавать. Поэтому подумайте хорошенько о том, какие публиковать картинки.

Создайте robots.txt

Файл кobots.txt необходим для успешной индексации сайта. Посадочная страница — это тоже сайт, поэтому и у него должен быть robots.txt.

Несмотря на то, что лендинг — это одна страница, как правило, там есть и другие технические страницы или дубли. Их не должно быть в поиске, поэтому их нужно заблокировать для индексации в robots.txt.

Файл robotst.txt для каждого случая будет разным.

Позаботьтесь об адаптивности

Большая часть людей используют планшеты и смартфоны для посещения сайтов. Если мобильный трафик подходит для ваших продаж, то нужно сделать так, чтобы лендинг хорошо работал на всех видах устройств. Более того, ещё и на всех видах операционных систем и браузеров

Получите SSL сертификат

Как правило, на лендинге посетители передают данные. Как минимум, это электронная почта. Может быть ещё и номер телефона, и имя, и общение со службой поддержки, и даже платёжные данные. Поэтому поисковики будут обращать внимание на наличие SSL сертификата у страницы.

Он должен быть, и он позволяет передавать личные данные по защищённому каналу.

wpuroki.ru

SEO продвижение лединга | SEO4U

945Как продвигать лэндинг в поиске? Как улучшить позицию landing page в Яндексе и Гугле? И ориентируясь на спрос, многие недобросовестные агентства даже предлагают, как отдельный вид услуг SEO продвижение landing page.

Но будьте бдительны! Ибо продвигать лэндинг можно как? Правильно: никак!

Лэндинг продвигать в поиске нельзя, в полноценном смысле этого слова. Продвижение подразумевает наличие на сайте множества страниц. Страниц релевантных запросам пользователей, с полезным контентом, инфографикой, внутренней ссылочной структурой и мета тегами. Лендинг же – это всего одна страница, отвечающая конкретному запросу, но всего одному!

Структура и формат сайта одностраничника заточены под контекстную рекламу и задача такого сайта — конвертировать трафик из контекста в заказ. Здесь свои правила копирайтинга, структуры и способы подачи информации. Кстати, эти приемы можно успешно применять и в рамках полноценного сайта, но это совсем другая история)

В этой статье рассмотрим какие же все-таки SEO техники применимы к landing page.

SEO оптимизация landing page

- Определите основной запрос, которому отвечает страница лэндинга

- Заключите основной заголовок первого экрана в тег <h2>

- Пропишите title страницы

- Пропишите meta name description

- Заполните мета-тег keywords

- Атрибут alt

- Пропишите robots.txt

Соблюдение этих нехитрых рекомендаций, позволит роботам поисковых систем точнее определить по каким запросам показывать вас в выдаче. Подойдите ответственно к определению ключевого запроса и проследите, что бы он максимально соответствовал контенту на странице.

Не забывайте, что тег h2 можно использовать на странице лишь один раз, остальные подзаголовки оформляйте в теги <h3> и ниже. Очень часто верстальщики грешат чрезмерным злоупотреблением h2. Не лишним будет обговорить этот момент на этапе составления ТЗ.

Тег <title> может содержать прямое вхождение запроса в отличие от h2, который предполагается более художественным и должен, в первую очередь, служить триггером внимания.

Meta name description – прописываем, что бы сделать привлекательным сниппет нашего лендинга. Именно сниппет часто играет решающую роль в принятие решения «А стоит ли мне открыть этот сайт?»

Заполните мета-тег keywords. Многие пренебрегают этим полем, но все мы знаем, что SEO состоит из мелочей.

<title>Квест-игра - приключение в твоем смартфоне!</title>

<meta name="viewport" content="width=device-width">

<link rel="shortcut icon" href="./favicon.ico" type="image/x-icon">

<link rel="stylesheet" href="./css/style.min.css" >

<meta name="Description" content="Приложение квест для города: музеи, гастрономические квесты, обзорные и квесты по акциям Москвы">

<meta name="Keywords" content="квест приложение для смартфона квесты онлайн по москве музеям гастрономические квесты квест акция для гаджета обзорный квест по москве онлайн">ALT атрибут – альтернативное текстовое название картинки, так же отображается на странице в случае проблем с загрузкой изображения. Использование фото контента, картинок и инфографики – маст хэв любого лендинга. Пропишите везде атрибут alt, что бы привлечь дополнительный источник трафика – поиск по картинкам.

Настройка файла robots.txt для landing page

Скорее всего нежелание или пренебрежение файлом robots.txt — это еще один баг вашего веб разработчика, наравне с множественным использованием h2. Бесчисленное кол-во раз ищя ответ на вопрос «Почему мой лэнд не видно в поисковой выдаче?» бывает такая картина:

User-agent: *

Disallow: /Что в переводе означает: сайт закрыт от индексации чуть больше чем полностью. Так делают разработчики, по умолчанию, в момент создания страницы, а затем просто забывают переписать роботс и открыть ее поисковым роботам.

Robots.txt для лэндинга должен выглядеть примерно так:

User-agent: *

Allow: /images/

Allow: /js/

Allow: /css/

User-agent: Googlebot

Allow: /

Allow: /js/

Allow: /css/

User-agent: Yandex

Allow: /images/

Allow: /js/

Allow: /css/

Host: site.ru Оптимизация сайта — своего рода пазл, в котором важно уделить внимание каждому элементу, для того, что бы увидеть красивую картину в итоге. Все это можно отнести и к идеальным landing page!

Источник:

Возможно вас заинтересует

seo4u.ru

SEO для Landing Page

Судя по количеству поисковых запросов и их выдаче, вопрос о продвижении лендингов стоит очень остро. Улучшить рейтинг в поисковых системах хотят все. Кто-то пытается своими силами, кто-то готов платить деньги. А еще больше желающих брать эти деньги и обещать сумасшедшую конверсию по вашему лендинг пейджу. Вот только есть одно большое НО. По факту продвинуть посадочную страницу по поисковикам никак нельзя.

Как минимум для продвижения нам необходимо иметь несколько страниц на сайте. Каждая из этих страниц должна быть наполнена качественным контентом, который будет интересен публике. Более того, в тексте должны быть размещены ключи, релевантные к поисковым фразам, медиаинформация. У страниц должна быть внутренняя система ссылок, прописанные метатеги.

Реализовать подобное с лендингом непосильная задача. Это же не две не три, а всего одна страница, которая разрабатывалась под один единственный запрос, для четко очерченной аудитории.

Landing Page изначально разрабатывается для работы с контекстной рекламой. Для этого подбирается особая структура сайта и система подачи информации на ней. Есть продукт, есть целевая аудитория, а задача лендинга повысить конверсию, превратив просмотры в реальные заказы. Для одностраничных сайтов существуют особые правила для написания и подачи контента. Перед копирайтером ставится сложнейшая задача: подать максимум полезной информации, используя минимум печатных знаков и графического материала. К слову, техника наполнения одностраничника подойдет и для полнообъемных сайтов, но многие предпочитают не нагружать себя лишней работой.

Но не все так плохо для лендинга, для него есть свои пути оптимизирования.

Как оптимизировать посадочную страницу?

Чтобы вы ни рекламировали, ни продвигали, услугу или товар, пользуйтесь следующими правилами для вашего лендинга:

- Основная задача, определить ключевой запрос, с которым будет связана страница

- Используйте тег Н1 для заголовка первого блока

- Обязательно заполните title

- Уделите внимание мета-описанию страницы

- Пропишите список ключевых слов (meta keywords)

- Укажите атрибут alt

- Не забудьте заполнить роботс

Если по этим пунктам у вас все будет в порядке, поисковые машины смогут более точно определять с какими запросами вас ассоциировать, что обеспечит более качественную выдачу. Очень важно подобрать ключевой запрос, который бы наиболее полно отражал содержимое вашего сайта.

Заключить заголовок в тег Н1 можно лишь единожды, поэтому уделите ему особое внимание, вложите максимум смысла. Последующие заголовки в блоках должны быть на уровень ниже. Об этом следует упомянуть, составляя ТЗ, чтобы наверняка исключить появление еще одного заголовка Н1.

При составлении заголовка первой страницы, который будет заключен в тег , помните, что он должен служить якорем, который зацепит внимание клиента, поэтому не старайтесь подобрать точный ключ для него. Более важно точное вхождение при заполнении тайтла. Постарайтесь вписать ключ органично, чтобы он не резал глаза и слух.

Еще до того, как потенциальный посетитель увидит сайт, ему придется пересмотреть страницу снипетов в поисковой выдаче. Его информативность и привлекательность определит дальнейшее действие клиента. И тут только два варианта: зайдет или пропустит. Поэтому мета-описанию следует уделить особое внимание, вложить в него все, чтобы заинтересовать клиента.

Оптимизируя сайт, одностраничник в том числе, помните о каждой мелочи, поэтому не обделите вниманием заполнение тега ключевых фраз. Лендинг без инфографики просто не существует, поэтому к каждой картинке или рисунку не забудьте прописать атрибут Alt. С одной стороны он будет отображаться в случае трабла с загрузкой, с другой по этому атрибуту привлекается дополнительный трафик, связанный с поиском по изображениям.

Важность robots.txt для лендинга

Еще одна из мелочей, которой нельзя пренебрегать, как нельзя многократно использовать Н1, которыми грешат разработчики. Иначе можно будет миллион раз вбить запрос и не увидеть ни разу свой сайт в выдаче. Ошибка может крыться именно в файле robots.txt. На этапе разработки сайта специалисты прописывают команды, которые закрывают сайт от индексации. Он просто физически не может появиться в выдаче. А потом во время сдачи проекта, ввиду запары или невнимательности элементарно забывают внести корректировки в файл роботс, дабы разрешить доступ поисковым механизмам.

hinex.ru

Как создать правильный robots.txt для WordPress

Всем привет. Сегодня мы продолжим тему индексации сайта поисковыми системами и поговорим о том, что такое файл robots.txt, для чего он нужен, и как правильно составить robots.txt для WordPress.

Итак, robots.txt это текстовый файл, расположенный в корневой директории сайта и предназначенный для роботов поисковых систем. В этом файле вебмастер указывает параметры индексирования своего сайта для роботов различных поисковых систем. В частности с помощью robots.txt можно закрыть от индексирования отдельные директории сайта, отдельные страницы и весь сайт целиком.

Дело в том, что большинство систем управления контентом (CMS) создают слишком много страниц с дублированным контентом, которые несут служебные функции, и не должны участвовать в поиске. Например, WordPress создает каталоги категорий, меток и архивов. Они необходимы для навигации пользователей по сайту и состоят полностью из уже опубликованных материалов. Таким образом, запретив к индексации все не нужное, мы оставляем поисковому роботу только те странички блога WordPress, которые должны попасть в поиск. При этом роботу уже не надо индексировать кучу дополнительных страниц, и он не тратит на них время и ресурсы, а значит, работает быстрее и эффективнее. Кроме того, в файле robots.txt указывается также путь к карте сайта, если она существует.

Для блога на WordPress файл robots.txt должен иметь следующий вид:

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

User-agent: Yandex

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

Просто создай у себя обычный текстовый файл в блокноте, скопируй туда код, указанный выше и закачай в корневую директорию своего сайта. При этом не забудь вместо site.ru вставить адрес своего сайта. Последние две строчки это путь к карте сайта. О том, как создать карту сайта можно прочитать в статье: карта сайта WordPress.

Для того, чтобы убедиться, что robots.txt работает правильно нужно зайти в панель управления вебмастера по адресу webmaster.yandex.ru. Выбираем: настройка индексирования > анализ robots.txt. После этого необходимо нажать кнопку «Загрузить robots.txt с сайта». Если ты все сделал правильно, то Яндекс загрузит содержимое твоего robots.txt с сайта и покажет его в окошке. Внизу, рядом со списком URL нажимаем «добавить». После этого, копируем туда адреса всех страниц нашего сайта. Их можно взять, например, из той же карты сайта. Нажимаем «проверить» и смотрим. Если все в порядке, то, Яндекс выдаст результат «разрешен». В противном случае он напишет, например «запрещен правилом /wp-admin», это значит, что правило Disallow: /wp-admin/, которое прописано в файле robots.txt запрещает индексацию данной страницы.

www.bestseoblog.ru

Продвижение. Поисковая оптимизация

Публикуем 5 материалов о продвижении лендинга.

- Поисковая оптимицация

- Настройка целей в Google Analytics

- Настройка целей в Яндекс.Метрике

- Мета-теги для социальных сетей

- Контекстная реклама

Не забудьте перед настройкой сайта подключить домен – зарегистрировать новый внутри личного кабинета Платформы или перенести страницу на уже существующий.

В Платформе LP страницу можно опубликовать на тестовом домене. Он выглядит как сочетание цифр, букв и домена plp7.ru и не индексируется поисковыми системами. Тестовый нужен, чтобы посмотреть, но чтобы запустить на сайт реальных посетителей, необходим свой домен.

Инструкция – здесь

В этой статье написано о том, как оптимизировать сайт, чтобы он отображался в Яндекс и Google.

- Что такое поисковая оптимизация?

- Индексация в Яндексе

- Индексация в Google

- Заголовок, описание и ключевые слова

- Работа с файлами sitemaps и Robots.txt

Поисковая оптимизация сайта или SEO – комплекс мер для повышения позиций сайта в результатах выдачи поисковых систем по заранее отобранным запросам.

Индексация сайта – наличие страниц сайта в базе поисковых систем. Для того что бы сайт был проиндексирован, на него должен зайти поисковый бот. Разбираемся с индексацией в Яндекс и Google.

Для индексации сайта в Яндексе выполняем следующие шаги:

Шаг 1. Добавляем сайт в Яндекс.Вебмастер.

Если у вас нет аккаунта на Яндексе, обязательно зарегистрируйтесь. Аккаунт пригодится для Яндекс.Метрики.

Вписываем доменное имя сайта и нажимаем кнопку «Добавить».

Вписываем доменное имя сайта и нажимаем кнопку «Добавить».  Шаг 2. Копируем появившийся мета-тег.

Шаг 2. Копируем появившийся мета-тег.

Шаг 3. Добавляем мета-тег в настройки страницы на Платформе.

- Возвращаемся на Платформу и переходим в раздел «Страницы»,

- Выбираем нужную и открываем её настройки,

- Выбираем «Подтверждение прав» и вставляем полученный мета-тег в нужное поле,

- Нажмаем «Сохранить».

Шаг 4.

- Подтверждаем действие в Яндекс.Вебмастере,

- Возвращаемся на страницу Вебмастера и нажимаем кнопку «Проверить».

Теперь индексация завершена – сайт появится в Яндексе. Индексация занимает от 3 до 21 дней. Если через 21 день сайт так и не появился в поиске – напишите в службу поддержки.

Выполняем несколько простых шагов для настройки индексации сайта в Google.

Шаг 1.

- Добавляем сайт в Google Webmasters,

- Вписываем доменное имя в появившемся окне,

- Нажимаем «Добавить».

Шаг 2.

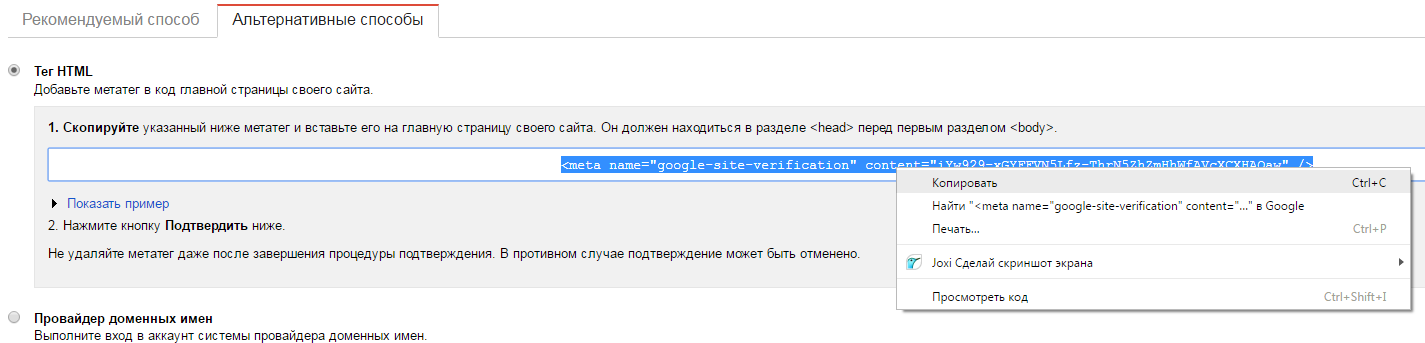

- Копируем тег HTML,

- В появившемся окне выбираем вкладку «Альтернативные способы»,

- Ставим галочку напротив «Тег HTML»,

- Копируем код.

Шаг 3.

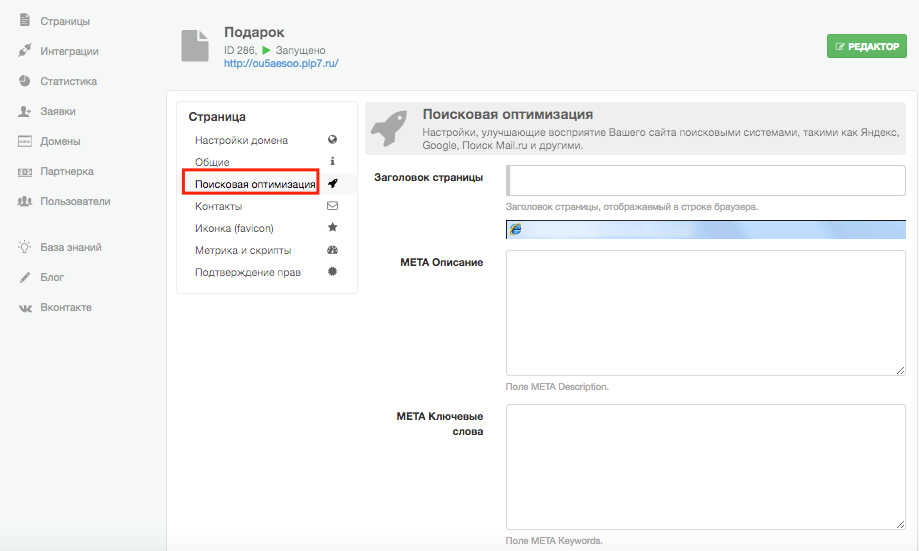

- Вставляем тег HTML в настройки страницы на Платформе,

- Заходим в Платформу в раздел «Страницы» и выбираем свою,

- Открываем настройки страницы, раздел «Подтверждение прав», вставляем полученный тег в нужное поле,

- Нажимаем «Сохранить».

Всё, настройка индексации завершена, теперь сайт появится в Google. Как и в Яндексе, индексация занимает от 3 до 21 дней. Если через 21 день сайт и не появился в поиске – пишем в службу поддержки.

Добавили свой сайт в поисковики – теперь настраиваем, чтобы он правильно там отображался: заголовок, описание и ключевые слова.

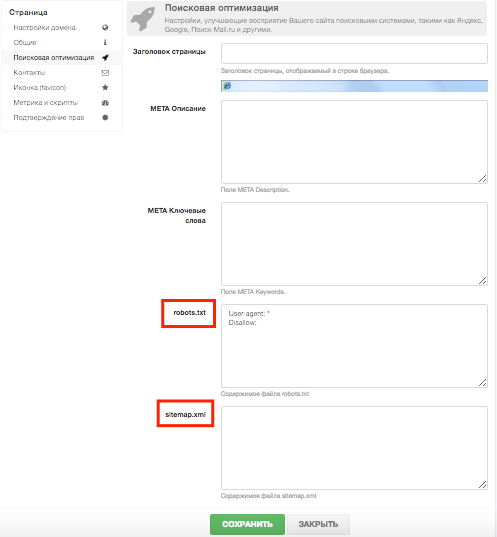

Для этого открываем настройки страницы и выбираем вкладку «Поисковая оптимизация» и заполняем пустые поля.

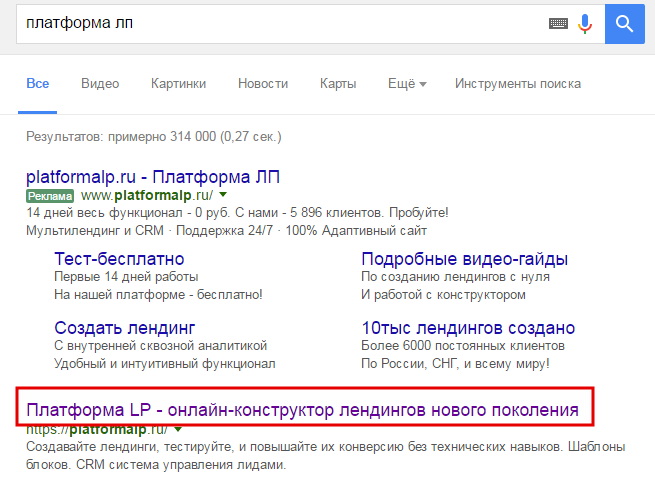

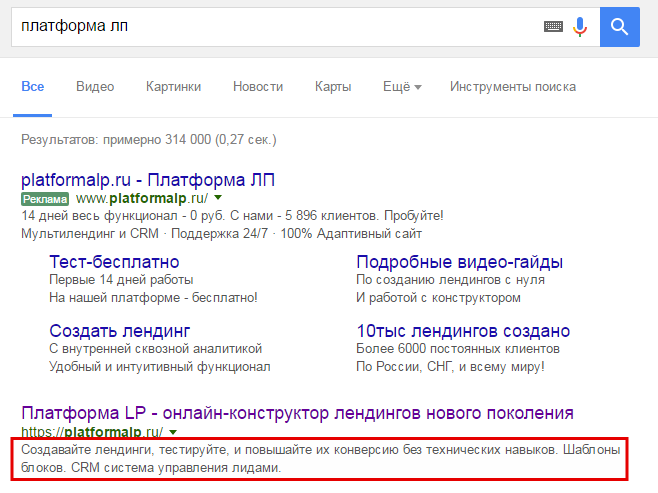

Заголовок – это текст, который отображается во вкладке браузера и в результатах поиска. Выбираем короткий и максимально точный заголовок страницы. Максимальная длина заголовка – 80 знаков.

Описание – текст, который отображается под заголовком сайта. Нужно привлекательное, продающее описание сайта. Максимальная длина – 200 знаков, но рекомендуем уложиться в 150-180.

Ключевые слова – те, по которым пользователь находит сайт. Чтобы определить ключевые слова, используем Яндекс.Wordstat или пользуемся услугами seo-программиста. Добавляем ключевые слова и фразы через запятую. Максимальная длина – до 250 знаков. Сделайте упор на первые 150, самые нужные и эффективные фразы поставьте в начало.

Sitemaps — XML-файлы с информацией для поисковых систем о страницах веб-сайта, которые подлежат индексации.

Sitemaps помогают поисковикам определить местонахождение страниц сайта, время их последнего обновления, частоту обновления и важность относительно других страниц сайта для того, чтобы поисковая машина смогла более разумно индексировать сайт.

Подробную схему описания sitemaps можно найти на этой странице – есть здесь.

Robots.txt — текстовый файл в формате .txt, ограничивающий поисковым роботам доступ к содержимому на http-сервере. Используется для частичного управления индексированием страницы поисковыми системами.

Файл состоит из набора инструкций, при помощи которых можно указать страницы, которые не должны индексироваться или должны быть проиндексированы в первую очередь.

Для правильной настройки рекомендуем использовать инструкцию Яндекса и Google.

Прописать sitemaps и robots.txt можно в настройках страницы, во вкладке «Поисковая оптимизация»:

Читайте другие статьи о работе в Платформе – здесь.

О том, как создать страницу – здесь.

platformalp.ru

100% правильный Robots.txt для WordPress

Robots.txt определяет правильную индексацию сайтов, в том числе на WordPress CMS. Это делается один раз и помогает акцентировать внимание поисковых систем только на самых значимых страницах сайта, несущих пользу и осмысленное содержание.

Не секрет, что многие страницы сайтов вне зависимости от желания и намерения его владельца представляют собой технический «мусор». Например, страницы с результатами поиска внутри сайта https://moytop.com/?s=ctr

Поисковики могут неправильно принять эти страницы за важную информацию и начать выдавать их в поиске в ущерб более правильно оптимизированным разделам сайта, отбрасывая их ниже в рейтинге.

Чтобы избежать таких ситуаций, сразу же после создания блога на WordPress рекомендуется составить специальный текстовый файл robots.txt и поместить его в корневую директорию сайта. Каждая поисковая система ориентирована на работу с этим файлом. В нем содержатся конкретные инструкции, с помощью которых можно:

- запретить поисковику проиндексировать весь сайт, отдельные папки или файлы.

- указать на дубликат (зекрало) сайта.

- указать карту сайта.

- дать поисковику рекомендации по установке определенных промежутков времени для того, чтобы оптимально проиндексировать сайт и снизить нагрузку на сервер (актуально для больших многостраничных проектов) и так далее.

Как правильно составить robots.txt для WordPress?

Это обычный текстовый файл, поэтому его можно открыть любым текстовым редактором (я вместо стандартного Notepad, который поставляется с каждой Windows, пользуюсь EditPlus). Повторюсь, находится он в корне сайта. А попасть в корень можно по FTP-доступу, который предоставляет любой хостер (читать «Как зайти на сайт через FTP»).

После того, как вы успешно зашли по FTP и открыли файл, смотрим на его содержимое. Для запрета индексации robots.txt должен содержать определенные команды для поисковиков, каждая из которых начинается с новой строки:

User-Agent

Эта команда задает поисковую систему, для которой предназначены последующие инструкции. Например, если вы укажете User-Agent: Yandex, то все последующие ниже команды будут относиться именно к этой поисковой системе.

Как правило, для блога выгодно, чтобы все страницы одинаково хорошо индексировались как под Яндекс, так и под Google и другие поисковики, поэтому имеет смысл не разделять инструкции для поисковых систем, а использовать общие правила. Для этого достаточно написать эту команду в таком виде: User-Agent: *

Она означает, что все поисковые системы могут проиндексировать сайт.

Disallow

Указывает конкретные страницы и каталоги сайта, которые нужно закрыть от индексации при помощи.

Если все файлы и страницы сайта можно индексировать, то после название оставляете пробел, вот так Disallow: , а если нужно тотально запретить индексацию всех без исключения страниц, то ставите в конце слеш (наклонную черту), вот так: Disallow: /

Но это крайние ситуации. Обычно под «запрет» попадают определенные папки или файлы. Поэтому после слеша указываете полное их наименование.

Примеры использования команд файла Robots.txt

Ниже вы найдете примеры robots.txt в котором использованы наиболее частые команды User-Agent и Disallow в разных вариациях. Если нужно оставить комментарий в файле, то начните предложение с этого знака #

Примеры использования Disallow

Эта команда запрещает индексирование и чаще всего используется в таких вариантах.

1. Разрешаете проиндексировать всем поисковикам все страницы без исключения:

User-Agent: *

Disallow:

2. Запрещаете проиндексировать только Яндексу все на сайте:

User-Agent: Yandex

Disallow: /

3. Разрешаете проиндексировать все страницы на сайте только поисковой системе Google:

User-Agent: Google

Disallow:

# продолжение: после первой инструкции оставляем пустую строчку, это важно для безошибочного прочтения

User-Agent: *

Disallow: /

4. Разрешаете проиндексировать всем поисковикам каждую папку, кроме /png/:

User-Agent: *

Disallow: /png

5. Разрешаете проиндексировать поисковым системам весь сайт, кроме динамических ссылок (например, поисковых запросов внутри сайта на WordPress)

User-Agent: *

Disallow: /*?s=*

6. Запретить индекацию конкретного файла master.php, который находится в папке includes

User-Agent: *

Disallow: /includes/master.php

7. Запретить индекацию любых каталогов и файлов, которые начинаются с download, например, файл download.gif

User-Agent: *

Disallow: download

Команда Allow

Имеет обратно Disallow значение — разрешает индексацию для указанных файлов и папок.

# Вот так можно разрешить индексацию лишь для файла myfoto.jpg, которая находится в запрещенной для индексации папке Album.

User-Agent: *

Disallow: album

Allow: /album/myfoto.jpg

Host

Эта директива позволяет указать зеркало сайта, то есть как предпочтительнее отображать имя сайта в поиске — с www или без?. Я предпочитаю без www, для этого нужно написать следующую инструкцию:

Host: moytop.com

где вместо moytop.com нужно вписать свое имя сайта.

Sitemap

Позволяет добавить ссылку на карту сайта, если она, конечно, у вас уже создана.

Вот, например, моя карта сайта, которая прописана в robots.txt

Sitemap: https://moytop.com/sitemap.xml

Crawl-delay

Позволяет выставить задержку в секундах перед индексацией отдельных страниц. Если на вашем сайте очень много страниц, которые периодически обновляются, а хостинг — дешевый, то имеет смысл указать значение в 10-15 секунд.

Это позволит снизить нагрузку на хостинг со стороны поисковых систем. Делается это следующей командой:

Crawl-delay: 10

Скачать 100% рабочий файл Robots.txt для WordPress CMS

Эти основные команды вы можете применять для своего сайта на Вордпресс в том или ином виде. У многих сайтов и блогов они будут применяться по-разному, так как могут использоваться разные плагины, разные пути к файлам и разные динамические адреса.

Но я могу порекомендовать вам готовый и проверенный файл Robots.txt, который можно безболезненно использовать на большинстве сайтов под WordPress CMS и который уже отлично себя зарекомендовал. Вы можете посмотреть его в бонусе.

Почему это действительно хороший Robots.txt?

Прежде всего потому, что многие найденные в интернете решения блокируют больше чем нужно, например, запрещают индексацию служебных папок вроде /WP-CONTENT/

Раньше это еще было допустимо, но сейчас поисковики (особенно Google) обязательно должны прочитать все нужные служебные папки, чтобы правильно воспроизвести то, как сайт выглядит в глазах рядовых пользователей. А для этого нужен доступ к служебным папкам, содержащим файлы CSS, JS и другие.

Важно! С помощью версии сайта для мобильных устройств можно получать более высокие места в поиске Google (подробнее о том, как создать мобильную версию для WordPress за 10 минут).

Поэтому нужно не запрещать в файле Robots.txt все подряд, а выкинуть только реальные дубли страниц, остальное же разрешить для сканирования — в этом случае сайт будет показываться правильно и вы не увидите ошибок в Google.Webmasters вроде таких: «Googlebot не может получить доступ к файлам CSS и JS на сайте».

Так что можете смело качать мой файл Robots.txt — он проверен на дубли и отлично работает с Googlebot.

Бонус!

Посмотреть и скачать уже готовый пример robots.txt для WordPress можно прямо сейчас. Контент доступен для подписчиков блога. Достаточно ввести свой правильный емейл, и после подтверждения вам откроется полное содержимое этой страницы.

Бонус

Всё получилось успешно!

Добавьте вот эти строки в ваш файл robots.txt (находится в корне вашего сайта и может быть отредактирован по FTP).User-Agent: *

Disallow: */wp-json*

Disallow: /xmlrpc.php

Disallow: /readme.html

Disallow: /*?

Disallow: /*?s=*

Disallow: /*?ad=*

Disallow: /cgi-bin

Disallow: */trackback

Disallow: */comments

Disallow: /tag

Disallow: /?attachment

Allow: *.css

Allow: *.js

Allow: *.png

Allow: *.gif

Allow: *.jpg

Allow: *.jpeg

Allow: */feed/*

Sitemap: ссылка на вашу карту

User-agent: YandexBot

Crawl-delay: 10

Disallow: */wp-json*

Disallow: /xmlrpc.php

Disallow: /readme.html

Disallow: /*?

Disallow: /*?s=*

Disallow: /*?ad=*

Disallow: /cgi-bin

Disallow: */trackback

Disallow: */comments

Disallow: /tag

Disallow: /?attachment

Allow: *.css

Allow: *.js

Allow: *.png

Allow: *.gif

Allow: *.jpg

Allow: *.jpeg

Allow: */feed/*

Sitemap: ссылка на вашу карту

Если на ваш емейл после подписки не приходит письмо для подтверждения уведомления (такое бывает иногда в зависимости от типа вашего ящика), то есть такие варианты:

- Подождите минут 5-10.

- Попробуйте другую почтовую сеть, лучше всего работают mail.yandex.ru или gmail.com.

- Проверьте папку СПАМ — может нужное письмо именно там. После чего обязательно отметьте его и кликните — НЕ спам.

- Если ничего не получилось, напишите мне в Контакты и укажите ссылку на страницу, версию браузера и примерный порядок действий.

С помощью этих инструкци или готового примера вы можете составить robots.txt для WordPress CMS правильно, с учетом структуры именно вашего сайта. Но обратите внимание, достаточно будет набрать http://адрес-сайта/robots.txt — и любой желающий увидит перечень ваших служебных и системных папок, которые есть на вашем компьютере.

Получение списка каталогов на сервере — это потенциальная угроза для безопасности сайта. Поэтому рекомендую обязательно сделать невозможным получение доступа к таким каталогам. Это очень просто, а позволяет получить дополнительную защиту от взлома.

Как это сделать? Читайте в статье: «Повышаем безопасность WordPress в 2 клика»

moytop.com