Как отследить, попала ли статья в поисковую выдачу — Блог Travelpayouts

Важность индексации

Алгоритм ранжирования в поисковиках — сложная технология, которая спрятана в цифровом Форт-Ноксе. Все знают, что она существует, но точно неизвестно, как работает виртуальный механизм.

Есть неочевидные вещи, о которых забывают многие веб-мастера в попытках повлиять на ранжирование. Чтобы на сайте появился трафик, страницы с полезным контентом должны присутствовать в базе поисковых систем. Большинство сайтов без проблем индексируются и привлекают быстроботов. Круто, если статьи доступны аудитории Google и Яндекса через считанные минуты после публикации. Переходы и хорошие поведенческие факторы повлияют на ранжирование, и статья может закрепиться на верхних строчках выдачи, даже когда волшебство быстрого робота закончится.

Как проверить индексацию в поисковых системах

Страницы попадают в индекс после того, как маленькие помощники поисковых систем заходят в «гости» и нет причин не добавлять страницу в базу.

Есть 4 простых способа проверить индексацию:

- Вставить URL в поисковую строку.

- Использовать оператор site:domain.ru и название статьи.

- Запустить поиск по куску текста.

- Использовать оператор url:адрес статьи.

В поисковых системах есть блок настроек, которым мало кто пользуется. С помощью фильтров можно узнать, сколько статей попали в индекс за месяц. Относитесь к этим данным критично. Страницы часто вылетают из поиска и через время возвращаются снова. Поэтому надо смотреть не только дату попадания в базу Яндекса и Google, но и дату публикации.

Инструменты для проверки индексации

Выдача поисковых систем не всегда даёт правильную информацию. Лучше воспользоваться удобными решениями, которые точно покажут, когда роботы заходили на страницу в последний раз и почему не добавили её в индекс.

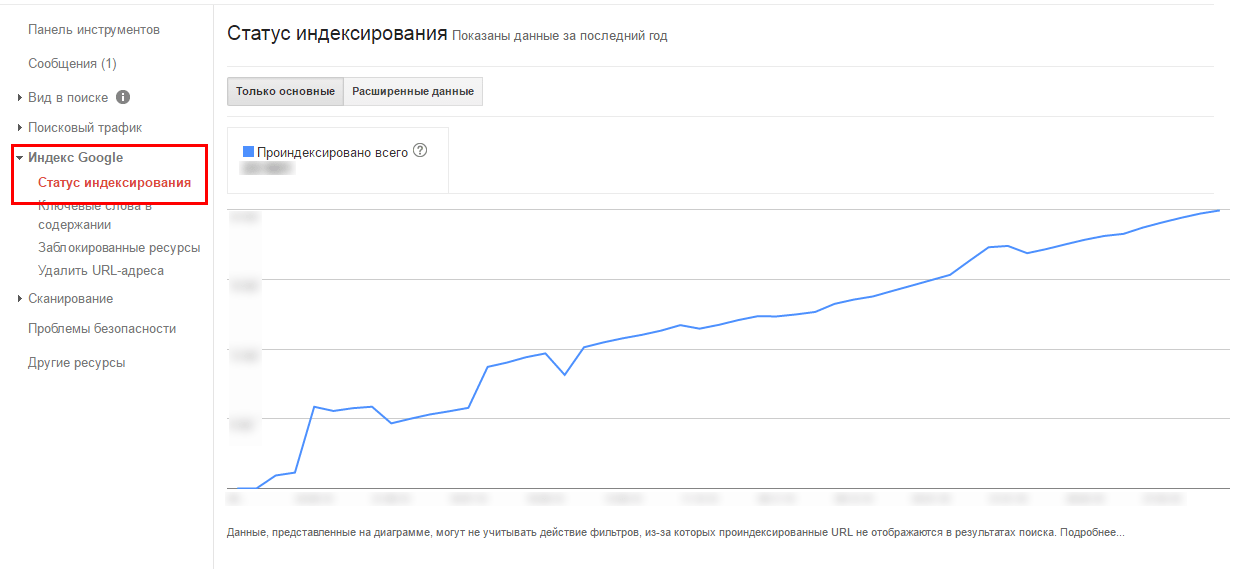

Search Console и Yandex WebmasterКонсоли для веб-мастеров есть у Яндекса и Google. Они отличаются дизайном, структурой и возможностями, но задача у двух инструментов одинаковая — дать владельцу сайта возможность управлять важными параметрами.

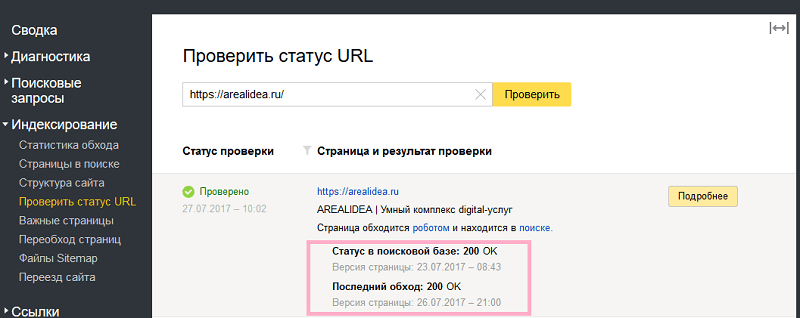

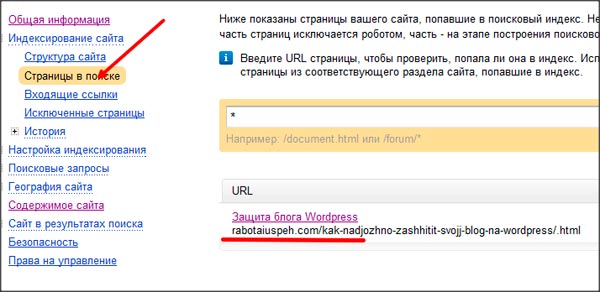

В «Яндекс Вебмастер» под индексирование выделено отдельное меню. В нём доступна статистика обхода, список страниц в поиске, структура категорий, мониторинг важных страниц и файлы sitemap.

Для быстрой проверки индексации найдите инструмент «Проверить статус URL», вставьте адрес и нажмите жёлтую кнопку.

В Google возможностей меньше. Для проверки адреса вставьте его в верхнюю строку и дождитесь обработки данных.

В табах отображается дополнительная информация, которая помогает выявить проблемы с индексацией

- последнее сканирование;

- разрешение на индексацию;

- каноническая страница.

Если инструменты для веб-мастеров не устраивают, можно воспользоваться специальными решениями, которые проверяют наличие статей в базе Яндекса и Google. Вариантов много: сервисы, расширения для браузеров, десктопные программы.

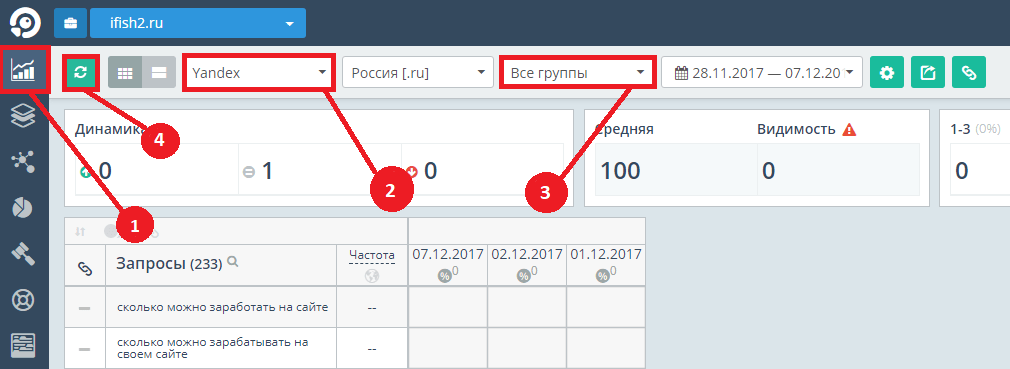

Популярный сервис, которым активно пользуются SEO-специалисты. На бесплатном тарифе можно проверить 200 страниц на индексацию в Яндексе. Доступ к Google открывается только после оплаты подписки.

Доступ к Google открывается только после оплаты подписки.

- Плюсы: выгрузка отчётов в формат Excel, 200 лимитов в день.

- Минусы: длительная обработка данных.

- Стоимость: зависит от тарифа.

Попробовать →

Rush-AnalyticsСервис работает по принципу облака. Создаёте задачу, настраиваете параметры и ждёте окончания сбора данных.

- Плюсы: выбор региона и языка в Google, 200 бесплатных лимитов, импорт адресов из sitemap, проверка индексации в real-time, автоматическое удаление дубликатов.

- Минусы: после использования тестовых лимитов надо платить.

- Стоимость: зависит от тарифа.

Попробовать →

Как массово проверить индексацию

Для небольших сайтов с периодическим обновлением контента вполне хватит ручной проверки индексации. Если страниц много, новые материалы появляются каждый день, проверяйте данные ежедневно.

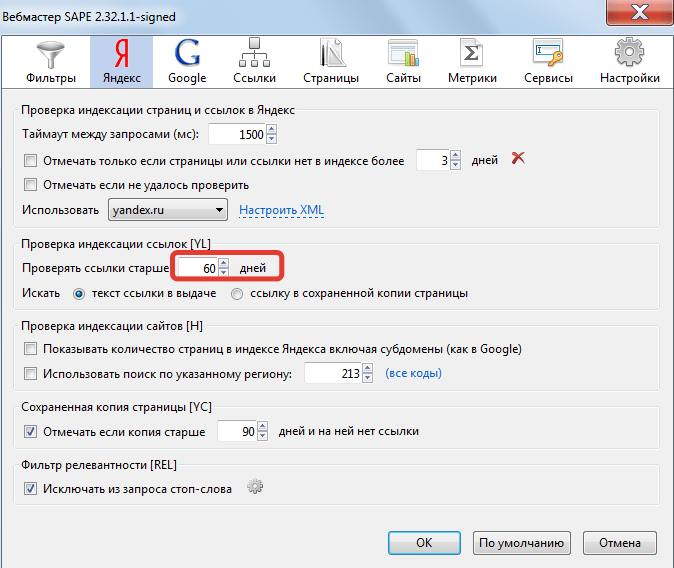

Десктопная программа с 14-дневным триалом от известного digital агентства Netpeak — комбайн для SEO-задач.

Проверка индексации — одна из сотни встроенных опций. Добавляете список URL-адресов, запускаете проверку и ждёте результат. Если страница есть в базе напротив адреса появится значение «true».

Источник- Плюсы: хранение данных в проекте, поддержка 4 поисковых систем.

- Минусы: высокая стоимость, нужны XML-лимиты, прокси и антикапча.

- Стоимость: лицензия на год стоит 182 доллара. Покупать её стоит только если будете использовать другие модули софта. Для проверки индексации лучше пользоваться Rush-Analytics или аналогом.

Попробовать →

Что влияет на индексацию

Веб-мастера, которые занимаются созданием и продвижением информационных сайтов, должны знать, как работает механизм индексации, и что влияет на попадание страницы в базу. Новичкам и опытным пригодятся официальные рекомендации Яндекса и Google по этому вопросу.

Страница попадает в индекс после того, как поисковый робот посещает её, загружает копию на сервер и алгоритм определяет, что нет причин для отказа в индексации.

Есть 3 условия, которые влияют на попадание страницы в базу поисковиков:

- она должна быть доступна для индексации;

- робот должен её посетить;

- робот должен посчитать страницу важной.

Если краулер зашёл на сайт, и страница не появилась в индексе, надо проверить её на проблемы, устранить их и отправить URL-адреса на переобход. Если ошибка не связана с глобальными неполадками поисковых систем, значит дело в сайте.

Поисковики прямо говорят, что не все страницы попадут в выдачу и будут ранжироваться по тематическим запросам. Резервы дата-центров Яндекса и Google огромные, но у них есть ограничения. Недавно Яндекс сильно сократил количество адресов в результатах поиска — с 1000 до 250. Раньше страниц было 100, а теперь только 25. Пресс-служба поисковой системы сказала, что после серии исследований специалисты приняли решение не показывать результаты дальше 25 страницы. 250 сайтов хватит для решения задач пользователей.

250 сайтов хватит для решения задач пользователей.

В нишах с высокой конкуренцией придётся бороться не только за ТОП-10, но и за попадание статьи в 250 доступных адресов. Индексация — важный компонент для успешного развития сайта и наращивания поискового трафика.

Формула успеха: полезный контент + соблюдение рекомендаций поисковых систем = profit.

Факторы, ускоряющие индексацию

- Внутренние и внешние ссылки. Поисковые системы часто посещают главные страницы сайтов и особо ценят URL с высокой посещаемостью. Если на новую статью не будет ссылок с главной или sitemap, роботы её не найдут.

- Перелинковка. Многие веб-мастера в новых статьях ссылаются на старые. Не забывайте линковать старые статьи с новыми.

- Социальные сети. Упоминания в социальных сетях всегда считались важными. 3-4 года назад с помощью Твиттера можно было «загнать» в индекс практически любую страницу.

- Обновление контента.

Если на сайте каждый день появляется 3-4 полезных статьи, есть шанс привлечь быстророботов.

Если на сайте каждый день появляется 3-4 полезных статьи, есть шанс привлечь быстророботов.

Популярный миф о том, что настройка AMP и Turbo ускоряет индексацию, разрушен ещё в 2018 году. Google сканирует и добавляет в базу AMP-страницы с такой же скорость, как и обычные. Более того, внедрение технологий быстрой загрузки не влияет на ранжирование.

Разница в механизме индексации поисковиков

Важно понять, что Google и Яндекс — две разные поисковые системы. У них свои факторы ранжирования и особенности продвижения.

Принцип добавления новых URL в базу поисковиков мало чем отличается, но разница в количестве проиндексированных страниц может отличаться в десятки раз. Это связано с тем, что поисковики по-разному взаимодействуют с контентом сайта и директивами в robots.txt. Google часто игнорирует robots и хорошо воспринимает тег content=”noindex”.

Полнота индекса в поисковых системах может сильно отличаться. Если страница проиндексирована в Яндексе, нет гарантий, что она попадёт и в Google. Владельцам крупных порталов надо познакомиться с понятием краулинговый бюджет. Это количество адресов на сайте, которое может просканировать бот Google. Если страницы однотипные, в выдачу попадёт только часть из них.

Владельцам крупных порталов надо познакомиться с понятием краулинговый бюджет. Это количество адресов на сайте, которое может просканировать бот Google. Если страницы однотипные, в выдачу попадёт только часть из них.

Как «загнать» страницу в индекс

2-3 года назад страницы сайтов, у которых не было быстробота, попадали в выдачу Яндекса с каждым новым апдейтом. Иногда данные обновлялись раз в неделю, иногда раз в месяц. Веб-мастера следили за новостями на тематических форумах и обменивались наблюдениями. В то время Яндекс серьёзно отставал от Google в плане индексации. Сейчас ситуация выровнялась, и в некоторых случаях поисковик с российскими корнями добавляет страницы в базу быстрее.

В конце прошлого года у Google были серьёзные проблемы с индексацией. Добавленные адреса пропадали из выдачи, новые появлялись очень медленно. В данный момент на SEO форумах никто не поднимает панику, значит ситуация стабилизировалась.

Консоли веб-мастеров

Самый простой способ «загнать» статью в индекс — стандартные инструменты поисковиков для владельцев сайтов.

В «Яндекс Вебмастере» в разделе «Индексирование» найдите пункт «Переобход страниц». Вставьте в поле до 20 адресов, которые робот должен обойти повторно или впервые и нажмите на кнопку «Отправить». Когда YandexBot посетит URL, статус поменяется на «Робот обошёл». После этого страница попадёт сначала в промежуточную базу, а после апдейта — в основную.

Присмотритесь к инструменту «Мониторинг важных страниц». В него можно добавить 20 самых важных страниц. Если есть статьи, которые собирают больше всего трафика долгие годы — соберите их в этом интерфейсе и будете получать уведомления о любых изменениях.

В Google механизм добавления страницы в очередь на индексацию отличается. Откройте Search Console, вставьте адрес в верхнее поле и дождитесь загрузки данных. Если URL не в индексе, нажмите кнопку «Запросить индексирование». От запроса до попадания в базу проходит от нескольких минут до нескольких дней.

В Яндексе маленький дневной лимит на переобход страниц, а в Google каждый адрес надо вставлять вручную. Владельцам крупных порталов с пользовательским контентом не обойтись без специальных инструментов, которые могут ускорить индексирование. Почти все они ориентированы на Google.

Владельцам крупных порталов с пользовательским контентом не обойтись без специальных инструментов, которые могут ускорить индексирование. Почти все они ориентированы на Google.

Webmaster bot

Популярный Телеграм-бот для SEO-задач. За копейки выгружает данные из Ahrefs, SEMrush и добавляет страницы в индекс Google.

- Плюсы: индексация в течение суток, нативный интерфейс.

- Минусы: инструменты часто недоступны.

- Стоимость: 1 рубль за URL.

Попробовать →

Плагин Indexer

Расширение для Yandex Browser и Chrome. Разработчик узнал, что если посетить любую страницу с браузера Яндекса, то на неё обязательно зайдёт YandexBot и проиндексирует. Автор протестировал плагин для индексации страниц сомнительного качества и Indexer показал себя хорошо. Если будете пробовать, обязательно вставляйте ссылки с протоколом http / https.

- Плюсы: высокая скорость, настройка таймера, нет ограничения по количеству адресов.

- Минусы: только под Яндекс.

- Стоимость: бесплатно.

Попробовать →

IndexGator

Сервис ускоряет индексацию контента ссылками с Twitter и LiveJournal. В базе 2000 аккаунтов Twitter и столько же профилей «ЖЖ».

- Плюсы: поддержка Яндекса и Google, низкая цена.

- Минусы: медленная техподдержка, нет бесплатных лимитов.

- Стоимость: от 0,3 до 1 рубля за URL.

Попробовать →

В сети есть упоминания о сервисе IndexMe. Не рекомендуем им пользоваться, автор скрипта получал все отправленные адреса. После того, как веб-мастера обнаружили слив данных, разработчик устранил проблему. Безопасность инструмента под большим сомнением.

Как страницу удалить из индекса

Поисковые системы часто добавляют в базу адреса, которые заблокированы в robots.txt. От них лучше избавиться, чтобы оставить только страницы с полезным контентом. Есть несколько способов удаления URL-адресов из индекса: закрыть от краулеров, сделать редирект или воспользоваться инструментами в консолях для веб-мастеров.

Есть несколько способов удаления URL-адресов из индекса: закрыть от краулеров, сделать редирект или воспользоваться инструментами в консолях для веб-мастеров.

В Яндексе страницы можно удалить из меню «Инструменты». Дневной лимит 500 адресов, реализована поддержка массового импорта. Google в этом плане сильно уступает по удобству. Складывается ощущение, что поисковая система специально усложняет жизнь веб-мастерам.

Google недавно обновил структуру Search Console. Список запросов на временное удаление контента доступен в одноименной вкладке. Для исключения страницы откройте меню и добавьте URL. С помощью префикса можно удалить все страницы категории или каталог товаров. Перед использованием модуля прочитайте справку. Если хотите избавиться от страницы навсегда воспользуйтесь рекомендациями Google.

Чек-лист: почему может не индексироваться страница

У информационных сайтов и блогов до 1000 страниц обычно нет проблем с индексацией. Трудности часто возникают у больших порталов с десятками тысяч URL-адресов. Особенно, если контент однотипный и отличается только геопривязкой.

Особенно, если контент однотипный и отличается только геопривязкой.

Что надо проверить:

- Доступность sitemap.xml.

- Наличие страницы в карте сайта.

- Посещение краулерами.

- Уникальность контента.

- Скорость загрузки.

- Наличие дублей.

- Вложенность страницы.

- Внутренние ссылки.

- Тег robots.

- Ответ сервера.

- Главное зеркало.

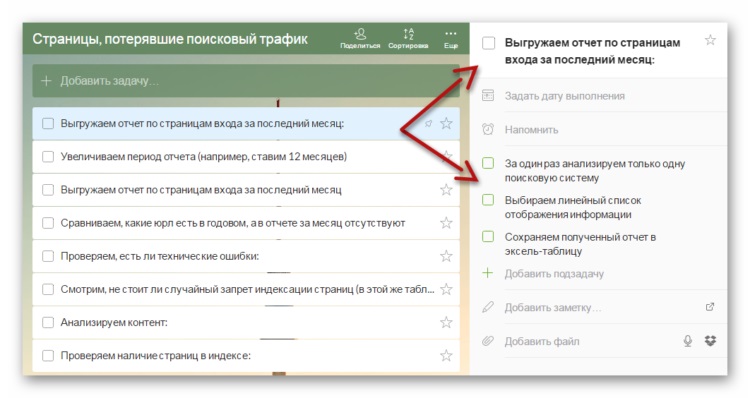

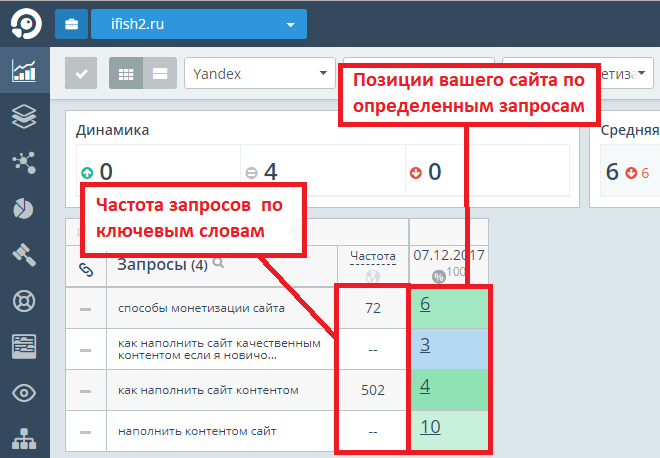

Если у сайта много трафика и хороший профит, создайте проект в Топвизоре. Сервис каждый день проверяет индексацию страниц и присылает отчёты на почту или в Телеграм. Так вы будете в курсе событий и сможете разобраться с критическими ошибками.

Импортировать список страниц можно из файла на компьютере или sitemap. Стоимость проверки зависит от тарифа, на минимальном 0,1 доллар за 100 страниц в одном поисковике. За 1081 URL из карты нашего блога сервис просит 4,32 доллара.

Обязательно следите за индексацией нового контента и регулярно проверяйте наличие страниц в индексе. В идеале, количество URL-адресов в sitemap и выдаче должно совпадать.

В идеале, количество URL-адресов в sitemap и выдаче должно совпадать.

Как проверить индексацию сайта? | Массовая проверка индексации страниц

Create a free account on Botster

Choose a bot and provide seed data

Start the bot and wait for completion

Download or share your results

Описание бота

Этот бот помогает быстро проверить индексацию сайта в поисковых системах Google, Bing, Yahoo и Yandex.

Нажмите на ссылку, чтобы посмотреть образец файла, который вы получите на выходе.

Этот бот позволяет оперативно проверить индексацию страниц онлайн в поисковиках Google, Bing, Yandex и Yahoo. Благодаря этому инструменту SEO-специалисты получают возможность работать с большим количеством сайтов одновременно. Массовая проверка индексации ссылок позволяет экспертам оперативно получать информацию о том, какие страницы нуждаются в SEO-оптимизации.

Как проверить индексацию страницы сайта? (видео)

Здесь в подробностях показано, как работает этот инструмент:

youtube.com/embed/SdT6xkAWtHo»>Как проверить индексацию в Яндексе и других поисковиках с помощью бота?

Нужно лишь скопировать список URL в соответствующее поле и указать способ оповещения о готовности результатов (доступные опции: e-mail, Slack, Telegram).

Через некоторое время после запуска бота вы получите оповещение о готовности результатов. В итоговой таблице вы найдете URL сайтов и данные о том, индексируются ли они следующими поисковыми системами:

- Google;

- Bing;

- Yahoo;

- Yandex.

Если URL индексируется поисковой системой, то в таблице будет отображаться результат TRUE. В противном случае будет отображаться результат FALSE.

Важные детали

При вводе данных и при оценке полученных результатов помните, что

https://site.com

и

https://site.com/

— это разные URL (обратите внимание на завершающий слэш), при этом одна из этих ссылок может индексироваться поисковыми системами, а другая нет.

Просмотр данных

Когда бот завершит работу, вы сможете просмотреть полученные данные онлайн или скачать их в формате Excel, JSON или CSV.

Чем этот бот может быть полезен мне?

Сервис для проверки индексации сайтов позволяет SEO-экспертам быстро выявлять страницы, которые не индексируются поисковыми системами и нуждаются в дополнительных мерах по SEO-оптимизации. Этот бот незаменим при проведении SEO-аудита. Он помогает улучшать рейтинг сайтов в поисковых системах и повышает их востребованность в поиске.

Если у вас есть вопросы или предложения, оставляйте их в комментариях ниже 👇

To use this bot you need to register or log in first.

Endpoint: POST https://botster.io/api/v2/bots/google-indexation-checker

Request body:

input string or array of strings (required)

List of URLs to check

Reliable and fast. A unique tool that checks if a list of web-pages had been indexed by Google and other search engines. Merci!

Merci!

Как максимально быстро проиндексировать новые страницы сайта

Добавление новых страниц может привлечь новый трафик и посетителей на ваш сайт, и они наиболее эффективны для достижения этой цели, когда они занимают высокие позиции в результатах поиска. Однако, чтобы ваш контент отображался в результатах поиска, его необходимо проиндексировать. Это означает, что в ваших интересах сделать все возможное, чтобы новые страницы индексировались как можно быстрее.

Проверьте статус своего индекса с помощью нашей программы проверки индексации Google

Если ваш контент не проиндексирован, ваши потенциальные клиенты не смогут его найти, и это не поможет вашему бизнесу. Вот почему в этом посте я объясню, как быстро проиндексировать ваши новые страницы, чтобы они могли помочь вам достичь ваших целей.

Важные термины для понимания

Прежде чем я перейду к факторам, влияющим на способность вашего контента быстро индексироваться, вам следует знать несколько ключевых терминов.

Боты

Боты — это программы веб-сканирования, которые обнаруживают и сканируют страницы в Интернете. Они собирают онлайн-документы и контент, а затем определяют, как организовать их в базах данных поисковых систем. Боты должны сканировать контент вашего сайта, чтобы он был проиндексирован или отображался в результатах Google (и других поисковых систем).

Боты также известны как «сканеры» или «пауки».

Сканирование

«Сканирование» относится к процессу выхода ботов в виртуальный онлайн-мир и поиска новой информации. Боты находят новую информацию в Интернете так же, как и мы — переходя по ссылкам с одной страницы на другую. Затем они отправляют новую информацию обратно в поисковые системы, такие как Google, для индексации.

Индексирование

После того, как боты возвращают новую онлайн-информацию, они обрабатывают и проверяют каждую страницу. Однако основной контент — не единственное, что они проверяют. При обработке страниц они также проверяют теги заголовков, теги заголовков и другие элементы, указывающие на их основную тему.

Используя эту информацию, поисковые системы могут начать точно отображать новые страницы в результатах поиска. Однако важно отметить, что индексация не имеет ничего общего с , где в результатах поиска отображается страница. Этот фактор определяется SEO.

Узнайте больше об основах сканирования и индексации из нашего видео с участием одного из наших интернет-маркетологов!

Почему ваш сайт должен быть проиндексирован?

Индексация ваших страниц абсолютно необходима для создания вашего присутствия в Интернете. Если страницы вашего сайта не проиндексированы, они не будут отображаться в результатах поиска Google.

А учитывая, что пользователи Google выполняют более 3,5 миллиардов поисковых запросов в день, это очень много упущенных возможностей привлечь трафик на ваш сайт. Другие причины, по которым ваш сайт должен быть проиндексирован, следуют эффекту домино. Если ваш сайт не проиндексирован, он не будет отображаться в результатах поиска Google.

Другие причины, по которым ваш сайт должен быть проиндексирован, следуют эффекту домино. Если ваш сайт не проиндексирован, он не будет отображаться в результатах поиска Google.

Если ваш сайт не отображается в результатах поиска, пользователям будет сложно его найти. В свою очередь, вам будет сложно добиться успеха, независимо от того, насколько хорош ваш контент, продукты или услуги. Если вы вкладываете время и ресурсы в создание отличного сайта, вы должны убедиться, что он приносит результаты, которые вы ищете как бизнес.

По этим многим причинам очень важно, чтобы ваш сайт был проиндексирован.

Как обеспечить быстрое индексирование новых страниц?

Хотя время, необходимое для индексации ваших новых страниц, варьируется, есть несколько способов убедиться, что ваш сайт регулярно сканируется и ваши новые страницы появляются в поисковой выдаче как можно быстрее.

Создайте карту сайта

Создание карты сайта на вашем веб-сайте — это первый шаг к его быстрой индексации.

Файлы Sitemap служат картами для ботов и помогают им находить новые страницы на вашем сайте. Карта сайта не только дает ботам представление о вашем сайте, но и помогает им понять важную информацию, например, насколько велик ваш сайт, где вы обновили или добавили информацию и где на вашем сайте хранится самая важная информация.

Отправьте свой веб-сайт в Google

Инструменты Google для веб-мастеров — это первое место, куда вы должны отправить свой веб-сайт, но сначала вам нужно будет подтвердить свой сайт с помощью Google Search Console.

Это еще больше упрощает для Google поиск вашего веб-сайта и его сканирование, поскольку вы фактически передаете им свой URL-адрес. Вы также можете отправить свою карту сайта в другие поисковые системы, такие как Bing и Yahoo.

Ссылка, ссылка, ссылка

Ссылки необходимы ботам для сканирования и индексации вашего сайта.

Боты сканируют ваш веб-сайт, переходя по ссылкам, и один из способов обеспечить быстрое индексирование вашего сайта — создать надежную внутреннюю структуру ссылок. Вы должны создавать ссылки со своих старых страниц на новые всякий раз, когда добавляете их на свой веб-сайт. Ваши старые страницы, скорее всего, уже проиндексированы, поэтому не так важно добавлять на них ссылки.

Вы должны создавать ссылки со своих старых страниц на новые всякий раз, когда добавляете их на свой веб-сайт. Ваши старые страницы, скорее всего, уже проиндексированы, поэтому не так важно добавлять на них ссылки.

Например, если вы добавляете новую страницу о конкретной услуге, полезно добавить ссылку на эту страницу со старой, более известной страницы о связанной услуге на вашем веб-сайте. Когда вы ссылаетесь на эти новые страницы, вы облегчаете поиск и сканирование ботами. Вскоре они будут проиндексированы и готовы к отображению в результатах поиска.

Создание и ведение блога

Ведение регулярного блога — отличный способ убедиться, что ваш сайт просматривается и ваши новые страницы часто индексируются. Регулярное добавление нового контента также помогает улучшить SEO вашего сайта. Мало того, что регулярно публикуемые блоги привлекают ботов на ваш сайт для сканирования, улучшенная SEO помогает вашему сайту занимать высокие позиции в поисковой выдаче.

Используйте robots.

txt

txtRobots.txt — это текстовый файл, который находится в вашем домене и дает указания ботам, что они могут и что не могут сканировать и индексировать. Команда robots.txt, включенная в каталог вашего домена, сообщает роботам, что они могут сканировать каждую страницу вашего веб-сайта. Обычно это то, что вы хотите.

Однако иногда вы можете не захотеть, чтобы боты сканировали все ваши страницы, потому что вы знаете, что на некоторых страницах есть дублированный контент. Например, если вы проводите A/B-тестирование на одной из своих страниц, вам не нужно индексировать все варианты, потому что они могут быть помечены как дублирующиеся. Сигнализация о том, что вы не хотите, чтобы боты сканировали эти страницы, гарантирует, что вы избежите каких-либо проблем и что боты сосредоточатся только на новых уникальных страницах, которые вы хотите, чтобы они проиндексировали.

Накопить входящие ссылки

Так же, как важно размещать ссылки на страницы вашего сайта, в процессе индексации очень полезно иметь ссылки с других веб-сайтов. Когда боты сканируют другие сайты со ссылками на ваши страницы, ваши страницы также будут проиндексированы. Хотя получить внешние ссылки не всегда легко, это увеличивает скорость индексации вашего сайта.

Когда боты сканируют другие сайты со ссылками на ваши страницы, ваши страницы также будут проиндексированы. Хотя получить внешние ссылки не всегда легко, это увеличивает скорость индексации вашего сайта.

Это означает, что может быть полезно связаться с редакторами, журналистами и блогерами, когда вы публикуете новый контент, который может заинтересовать их читателей.

Установите Google Analytics

Google Analytics — отличная платформа для отслеживания эффективности вашего веб-сайта и получения аналитических данных. Тем не менее, также известно, что Google предупреждает о появлении нового сайта, который необходимо будет проиндексировать.

Это не гарантированная тактика, но она потенциально может помочь в процессе индексации. Кроме того, нет веской причины или устанавливать Google Analytics на вашем сайте, учитывая, что это одна из лучших доступных бесплатных аналитических платформ.

Поделитесь своим контентом в социальных сетях

Социальные сети не играют непосредственной роли в индексации страниц вашего сайта, но могут помочь вам стать заметным в Интернете. Чем больше людей увидят ваш контент, тем больше вероятность того, что он наберет популярность в Интернете и получит ссылки с других сайтов.

Чем больше людей увидят ваш контент, тем больше вероятность того, что он наберет популярность в Интернете и получит ссылки с других сайтов.

И, как мы упоминали выше, эти ссылки могут помочь ботам найти ваши новые страницы.

Есть ли у вас какие-либо стратегии для индексации ваших новых страниц?

Нашли ли вы тактику или стратегию, позволяющую молниеносно индексировать ваш контент? Мы хотели бы услышать о них в комментариях ниже!

5 наиболее распространенных проблем индексации Google в зависимости от размера веб-сайта

Google не скрывает тот факт, что он не индексирует все страницы, которые может найти. Используя консоль поиска Google, вы можете увидеть страницы вашего сайта, которые не проиндексированы.

Консоль поиска Google также предоставляет полезную информацию о конкретной проблеме, из-за которой страница не может быть проиндексирована.

К этим проблемам относятся ошибки сервера, ошибки 404 и намеки на то, что на странице может быть недостаточное или дублированное содержимое.

Но мы никогда не увидим данных, показывающих, какие проблемы наиболее распространены во всей сети.

Итак… Решил сам собрать данные и составить статистику!

В этой статье мы рассмотрим наиболее распространенные проблемы индексации, из-за которых ваши страницы не отображаются в поиске Google.

Индексирование 101

Индексирование похоже на создание библиотеки, за исключением того, что Google имеет дело не с книгами, а с веб-сайтами.

Если вы хотите, чтобы ваши страницы отображались в поиске, они должны быть должным образом проиндексированы. Проще говоря, Google должен найти их и сохранить.

Затем Google может проанализировать их содержание, чтобы решить, для каких запросов они могут быть актуальны.

Индексирование является необходимым условием для получения органического трафика от Google. Чем больше страниц вашего сайта индексируется, тем больше у вас шансов появиться в результатах поиска.

Вот почему вам очень важно знать, может ли Google индексировать ваш контент.

Вот что я сделал для выявления проблем с индексированием

Мои повседневные задачи включают оптимизацию веб-сайтов с технической точки зрения SEO, чтобы сделать их более заметными в Google, и в результате у меня есть доступ к нескольким десяткам сайтов в поиске Google. Приставка.

Я решил использовать это, чтобы, надеюсь, сделать популярные проблемы с индексацией… ну, менее популярными.

Для прозрачности я разбил методологию, которая привела меня к некоторым интересным выводам.

Методология

Я начал с создания выборки страниц, объединив данные из двух источников:

- Я использовал данные наших клиентов, которые были мне легко доступны.

- Я попросил других специалистов по поисковой оптимизации поделиться со мной анонимными данными, опубликовав опрос в Твиттере и связавшись напрямую с некоторыми оптимизаторами.

оптимизаторов, мне нужно 3-10 минут вашего времени.

Можете ли вы помочь мне с исследованием индексации и поделиться со мной некоторыми неконфиденциальными статистическими данными GSC?

Когда я найду интересные идеи, я опубликую статью об этом.Заранее спасибо! Пожалуйста, R/T

🙏🙏 https://t.co/vAwMulQtsx

— Томек Рудзки (@TomekRudzki) 9 ноября 2020 г.

Оба источника информации оказались полезными.

За исключением неиндексируемых страниц

В ваших интересах не индексировать некоторые страницы. К ним относятся старые URL-адреса, статьи, которые больше не актуальны, параметры фильтрации в электронной торговле и многое другое.

Веб-мастера могут убедиться, что Google их игнорирует несколькими способами, включая файл robots.txt и тег noindex.

Принятие во внимание таких страниц отрицательно повлияет на качество моих выводов, поэтому я удалил из выборки страницы, соответствующие любому из следующих критериев:

- Заблокировано robots.

txt.

txt. - Помечен как noindex.

- Перенаправлено.

- Возврат кода состояния HTTP 404.

Исключение бесполезных страниц

Чтобы еще больше улучшить качество моей выборки, я рассмотрел только те страницы, которые включены в карты сайта.

Исходя из моего опыта, карты сайта являются наиболее четким представлением ценных URL-адресов с данного веб-сайта.

Конечно, есть много веб-сайтов, которые содержат мусор в своих картах сайта. Некоторые даже включают одни и те же URL-адреса в свои карты сайта и файлы robots.txt.

Но я позаботился об этом на предыдущем шаге.

Категоризация данных

Я обнаружил, что популярные проблемы с индексацией зависят от размера веб-сайта.

Вот как я разделил данные:

- Небольшие веб-сайты (до 10 тыс. страниц).

- Средние сайты (от 10к до 100к страниц).

- Крупные сайты (до миллиона страниц).

- Огромные сайты (более 1 миллиона страниц).

Из-за различий в размерах сайтов в моей выборке мне пришлось найти способ нормализовать данные.

Один очень большой веб-сайт, борющийся с определенной проблемой, может перевесить проблемы, которые могут возникнуть на других, более мелких веб-сайтах.

Поэтому я просмотрел каждый веб-сайт в отдельности, чтобы разобраться с проблемами индексации, с которыми они сталкиваются. Затем я присвоил баллы проблемам индексации в зависимости от количества страниц, затронутых данной проблемой на данном веб-сайте.

Вердикт…

Вот пять основных проблем, которые я нашел на веб-сайтах всех размеров.

- Просканировано — в настоящее время не проиндексировано (проблема качества).

- Дублированный контент.

- Обнаружен — в настоящее время не проиндексирован (проблема с бюджетом сканирования/качеством).

- Мягкий 404.

- Проблема со сканированием.

Давайте разберем их.

Качество

Проблемы с качеством включают в себя недостаточное содержание ваших страниц, вводящие в заблуждение или чрезмерно предвзятые.![]()

Если на вашей странице нет уникального ценного контента, который Google хочет показать пользователям, вам будет трудно его проиндексировать (и не стоит удивляться).

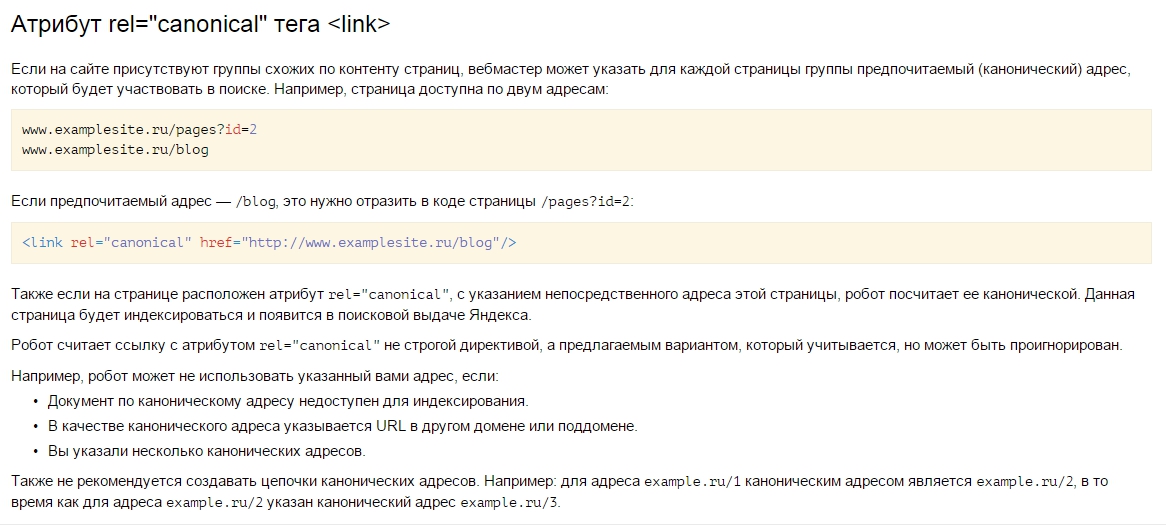

Дублированный контент

Google может распознать некоторые из ваших страниц как дублированный контент, даже если вы этого не хотели.

Распространенной проблемой являются канонические теги, указывающие на разные страницы. В результате исходная страница не индексируется.

Если у вас есть дублированный контент, используйте атрибут канонического тега или перенаправление 301.

Это поможет вам убедиться, что одни и те же страницы вашего сайта не конкурируют друг с другом за просмотры, клики и ссылки.

Бюджет сканирования

Что такое бюджет сканирования? В зависимости от нескольких факторов робот Googlebot будет сканировать только определенное количество URL-адресов на каждом веб-сайте.

Это означает, что оптимизация жизненно важна; не позволяйте ему тратить свое время на страницы, которые вам не нужны.

Soft 404s

404 ошибки означают, что вы отправили на индексацию удаленную или несуществующую страницу. Мягкие 404 отображают информацию «не найдено», но не возвращают серверу код состояния HTTP 404.

Распространенной ошибкой является перенаправление удаленных страниц на другие, нерелевантные.

Множественные перенаправления также могут отображаться как программные ошибки 404. Стремитесь максимально сократить цепочки переадресации.

Проблема со сканированием

Существует много проблем со сканированием, но важной из них является проблема с robots.txt. Если робот Googlebot найдет файл robots.txt для вашего сайта, но не сможет получить к нему доступ, он вообще не будет сканировать сайт.

Наконец, давайте посмотрим на результаты для разных размеров сайтов.

Небольшие веб-сайты

Размер выборки: 44 сайта

- Просканировано, в настоящее время не проиндексировано (проблема с качеством или краулинговым бюджетом).

- Дублированный контент.

- Проблема с бюджетом сканирования.

- Мягкий 404.

- Проблема со сканированием.

Средние веб-сайты

Размер выборки: 8 сайтов

- Дублированный контент.

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- soft 404 (вопрос качества).

- Проблема со сканированием.

Крупные веб-сайты

Размер выборки: 9 сайтов

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Дублированный контент.

- Мягкий 404.

- Проблема со сканированием.

Крупные веб-сайты

Размер выборки: 9 сайтов

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Дублированный контент (дублированный, отправленный URL-адрес не выбран в качестве канонического).

- Мягкий 404.

- Проблема со сканированием.

Основные выводы по общим проблемам индексации

Интересно, что, согласно этим выводам, два размера веб-сайтов страдают от одних и тех же проблем. Это показывает, насколько сложно поддерживать качество в случае больших веб-сайтов.

- Больше 100 тыс., но меньше 1 миллиона.

- Более 1 миллиона.

Выводы, однако, таковы:

- Даже относительно небольшие веб-сайты (более 10 000) могут быть не полностью проиндексированы из-за недостаточного краулингового бюджета.

- Чем больше веб-сайт, тем острее становятся проблемы с бюджетом/качеством сканирования.

- Проблема с дублированием содержимого является серьезной, но ее характер меняется в зависимости от веб-сайта.

Если на сайте каждый день появляется 3-4 полезных статьи, есть шанс привлечь быстророботов.

Если на сайте каждый день появляется 3-4 полезных статьи, есть шанс привлечь быстророботов.

txt.

txt.