Как найти дубли страниц на сайте

Содержание статьи

- Что такое дубли страниц?

- Могут ли дубли плохо сказаться на продвижении сайта

- Причины возникновения дублей

- Способы поиска дублирующего контента

- XENU

- Screaming Frog

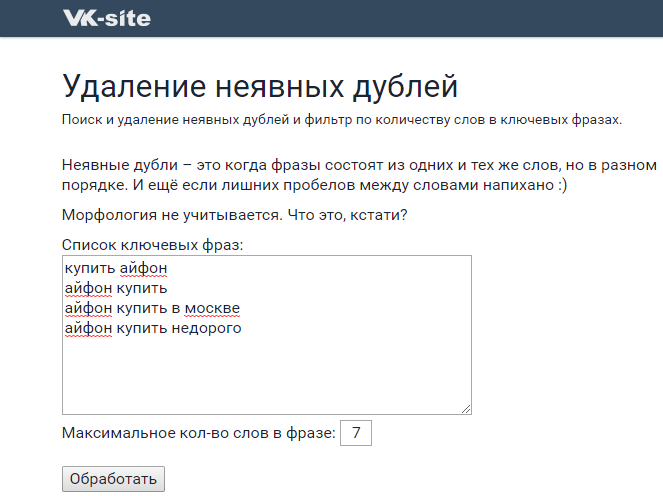

- Comparser

- Поисковая выдача

- Онлайн-сервисы

- Google Webmaster

- Sitereport

- Решение проблемы

Наличие дублей страниц в индексе — это такая страшная сказка, которой seo-конторы пугают обычно владельцев бизнеса. Мол, смотрите, сколько у вашего сайта дублей в Яндексе! Честно говоря, не могу предоставить примеры, когда из-за дублей сильно падал трафик. Но это лишь потому, что эту проблему я сразу решаю на начальном этапе продвижения. Как говорится, лучше перебдеть, поэтому приступим.

Что такое дубли страниц?

Дубли страниц – это копии каких-либо страниц. Если у вас есть страница site.ru/bratok.html с текстом про братков, и точно такая же страница site. ru/norma-pacany.html с таким же текстом про братков, то вторая страница будет дублем.

ru/norma-pacany.html с таким же текстом про братков, то вторая страница будет дублем.

Могут ли дубли плохо сказаться на продвижении сайта

Могут, если у вашего сайта проблемы с краулинговым бюджетом (если он маленький).

Краулинговый бюджет — это, если выражаться просто, то, сколько максимум страниц вашего сайта может попасть в поиск. У каждого сайта свой КБ. У кого-то это 100 страниц, у кого-то — 25000.

Если в индексе будет то одна страница, то другая, в этом случае они не будут нормально получать возраст, поведенческие и другие «подклеивающиеся» к страницам факторы ранжирования. Кроме того, пользователи могут в таком случае ставить ссылки на разные страницы, и вы упустите естественное ссылочное. Наконец, дубли страниц съедают часть вашего краулингового бюджета. А это грозит тем, что они будут занимать в индексе место других, нужных страниц, и в итоге нужные вам страницы не будут находиться в поиске.

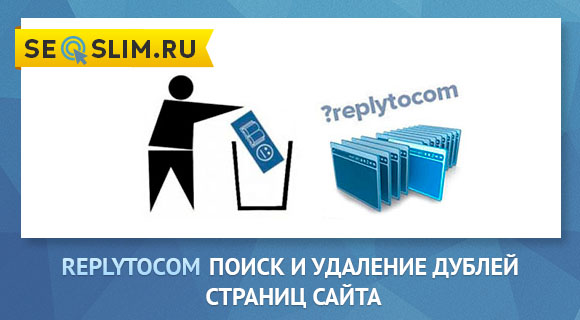

Причины возникновения дублей

Сначала вам нужно разобраться, почему на вашем сайте появляются дубли. Это можно понять по урлу, в принципе.

- Дубли могут создавать ID-сессии. Они используются для контроля за действиями пользователя или анализа информации о вещах, которые были добавлены в корзину;

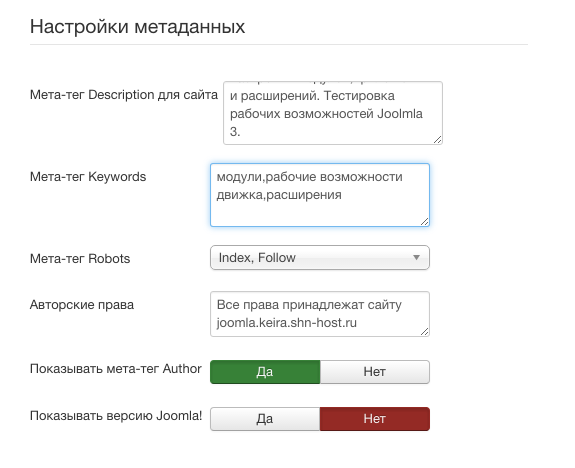

- Особенности CMS (движка). В WordPress такой херни обычно нету, а вот всякие Джумлы генерируют огромное количество дублей;

- URL с параметрами зачастую приводят к неправильной реализации структуры сайтов;

- Страницы комментариев;

- Страницы для печати;

- Разница в адресе: www – не www. Даже сейчас поисковые роботы продолжают путать домены с www, а также не www. Об этом нужно позаботиться для правильной реализации ресурса.

Способы поиска дублирующего контента

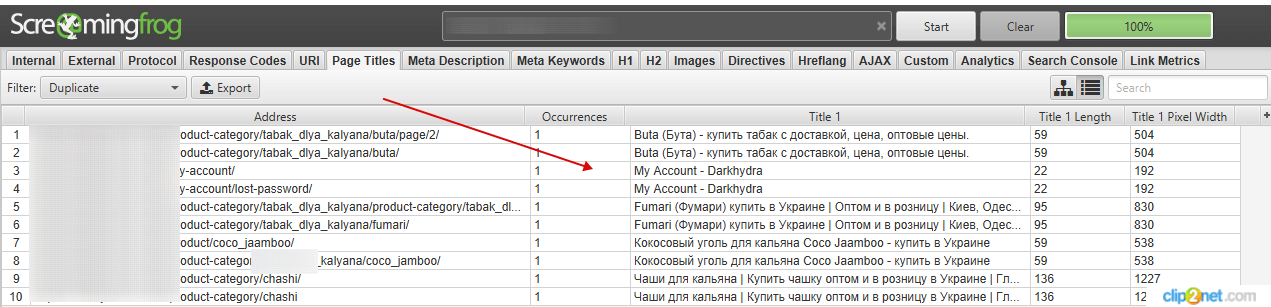

Можно искать дубли программами или онлайн-сервисами. Делается это по такому алгоритму — сначала находите все страницы сайта, а потом смотрите, где совпадают Title.

Делается это по такому алгоритму — сначала находите все страницы сайта, а потом смотрите, где совпадают Title.

XENU

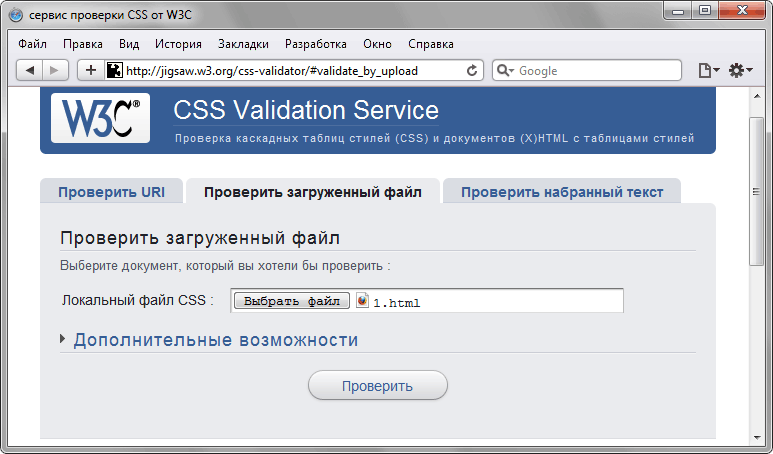

XENU – это очень олдовая программа, которая издавна используется сеошниками для сканирования сайта. Лично мне её старый интерфейс не нравится, хотя задачи свои она в принципе решает. На этом видео парень ищет дубли именно при помощи XENU:

Screaming Frog

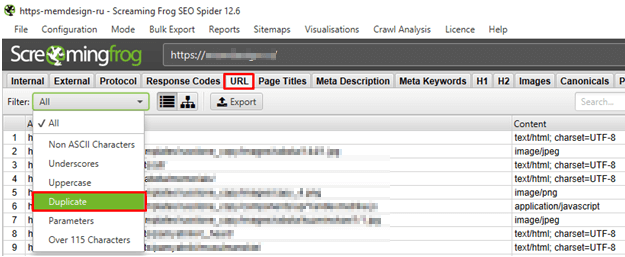

Я лично пользуюсь либо Screaming Frog SEO Spider, либо Comparser. «Лягушка» — мощный инструмент, в котором огромное количество функций для анализа сайта.

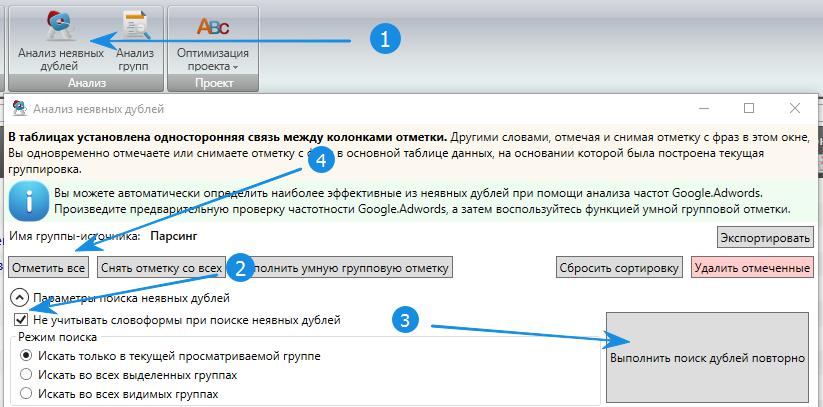

Comparser

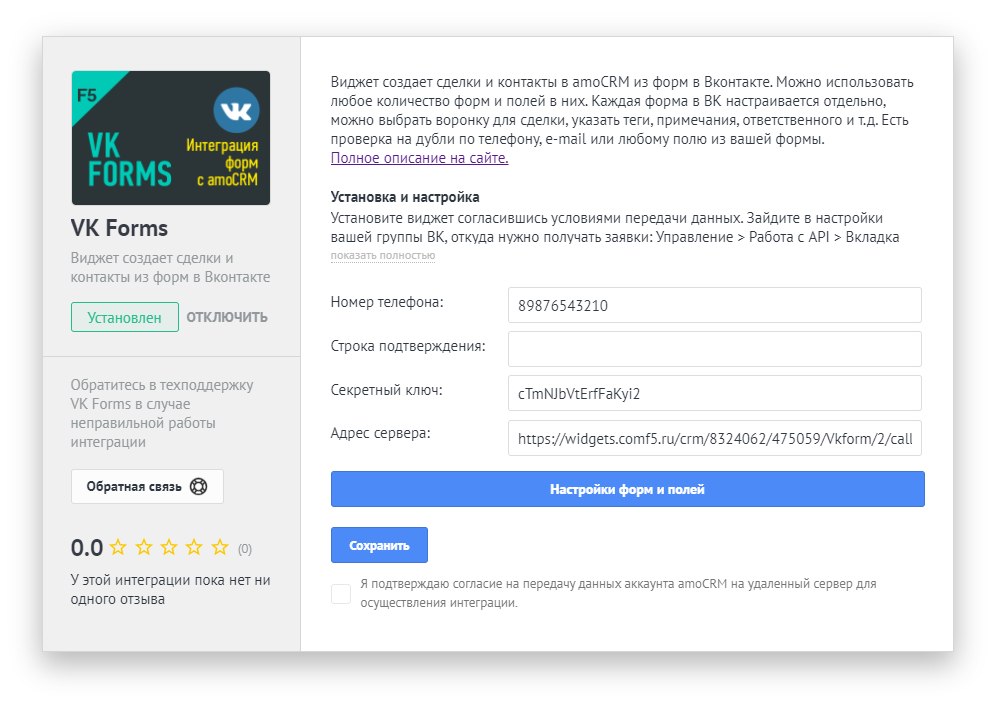

Comparser – это все-таки мой выбор. Он позволяет проводить сканирование не только сайта, но и выдачи. То есть ни один сканер вам не покажет дубли, которые есть в выдаче, но которых уже нет на сайте. Сделать это может только Компарсер.

Поисковая выдача

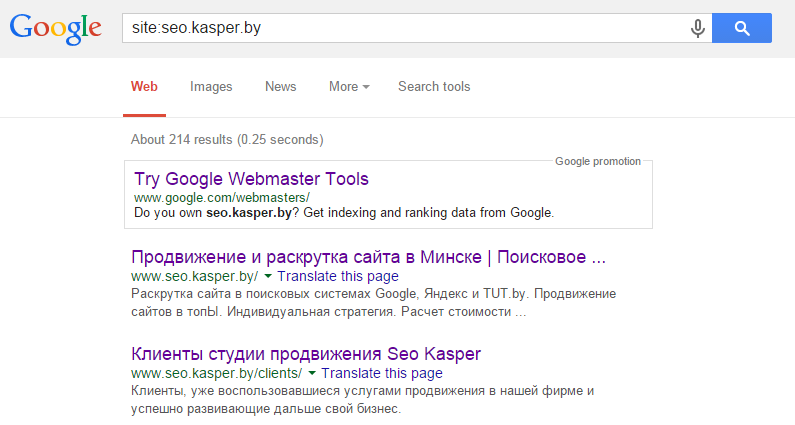

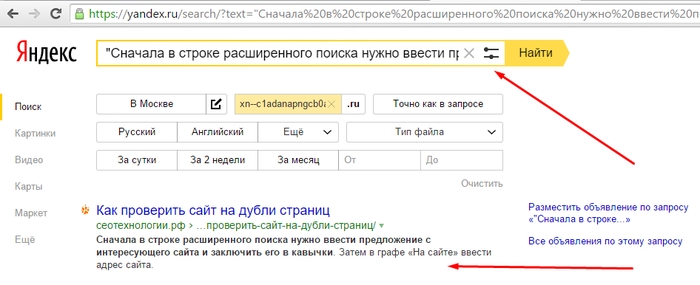

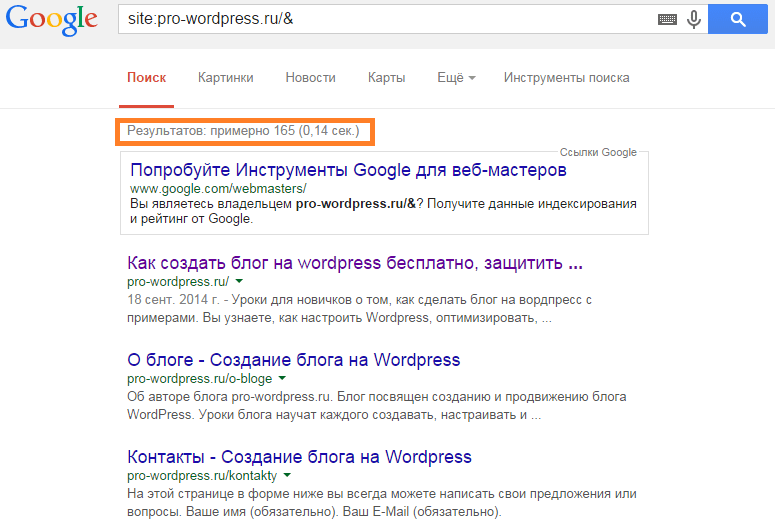

Можно также и ввести запрос вида site:vashsite. ru в выдачу поисковика и смотреть дубли по нему. Но это довольно геморройно и не дает полной информации. Не советую искать дубли таким способом.

ru в выдачу поисковика и смотреть дубли по нему. Но это довольно геморройно и не дает полной информации. Не советую искать дубли таким способом.

Онлайн-сервисы

Чтобы проверить сайт на дубли, можно использовать и онлайн-сервисы.

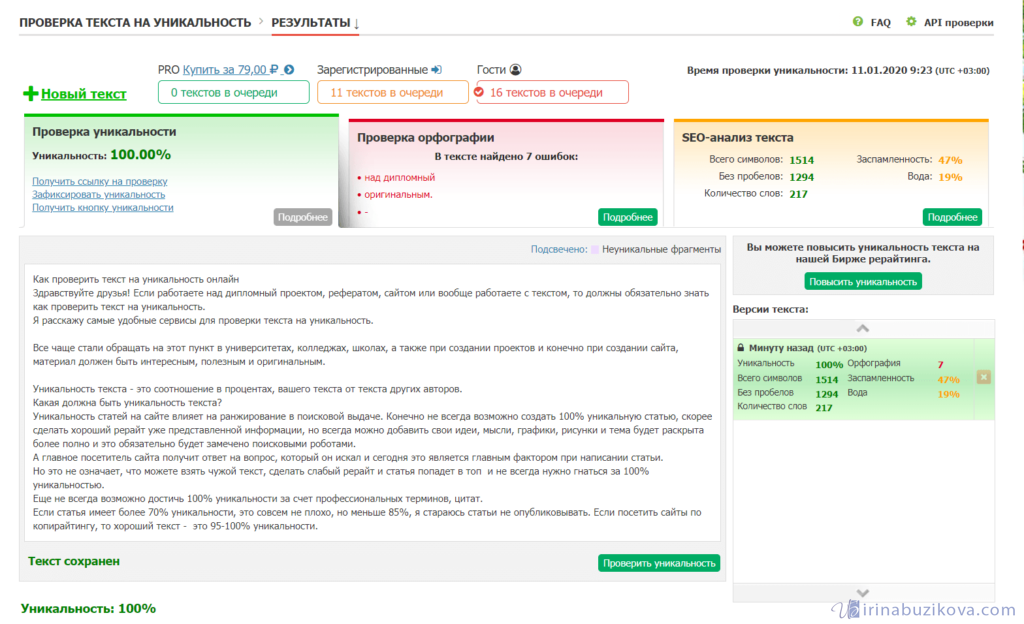

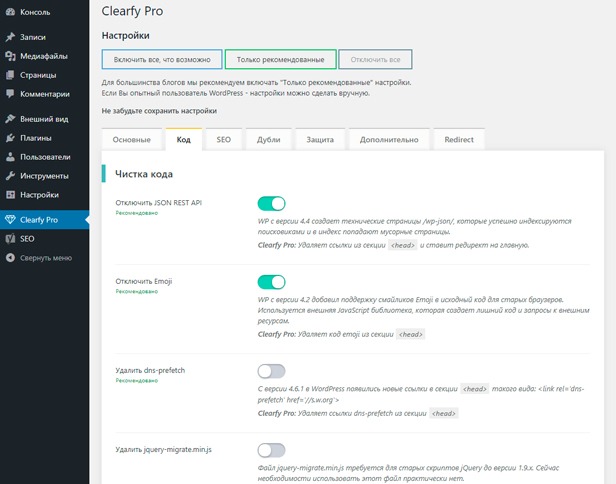

Google Webmaster

Обычно в панели вебмастера Google, если зайти в «Вид в поиске — Оптимизация HTML», есть информация о страницах с повторяющимся метаописанием. Так можно найти часть дублей. Вот видеоинструкция:

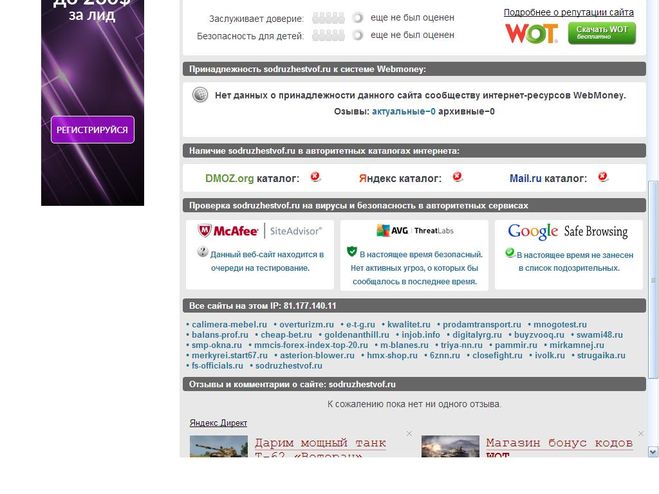

Sitereport

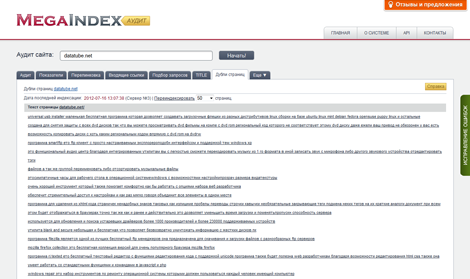

Аудит сайта от сервиса Sitereport также поможет найти дубли, помимо всего прочего. Хотя дублированные страницы можно найти и более простыми/менее затратными способами.

Решение проблемы

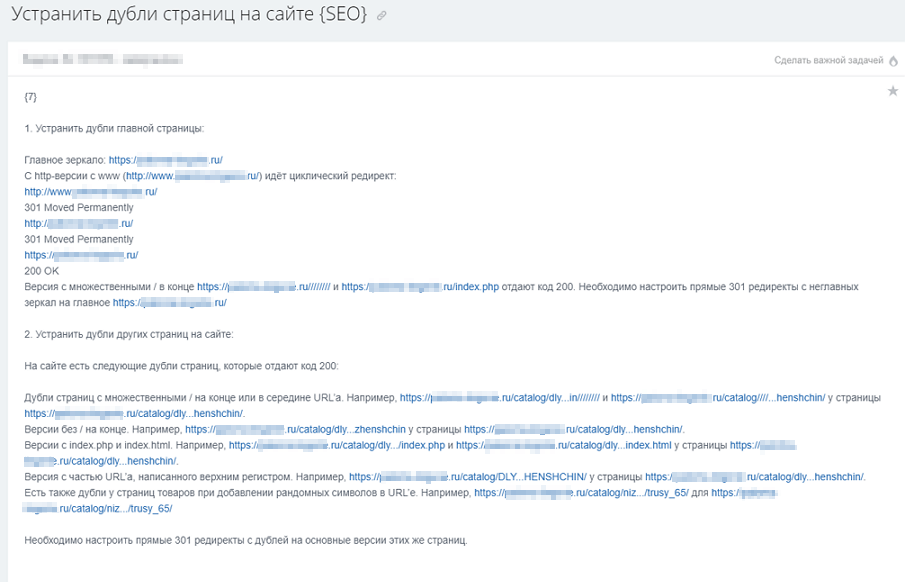

Для нового и старого сайта решения проблемы с дублями — разные. На новом нам нужно скорее предупредить проблему, провести профилактику (и это, я считаю, самое лучшее). А на старом уже нужно лечение.

На новом сайте делаем вот что:

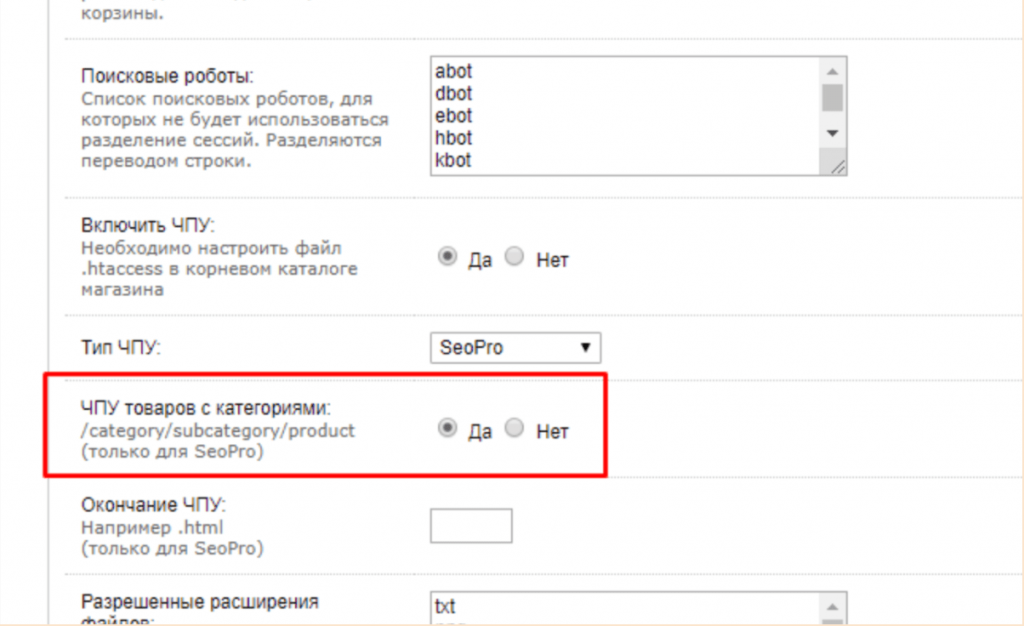

- Сначала нужно правильно настроить ЧПУ для всего ресурса, понимая, что любые ссылки с GET-параметрами нежелательны;

- Настроить редирект сайта с www на без www или наоборот (тут уж на ваш вкус) и выбрать главное зеркало в инструментах вебмастера Яндекс и Google;

- Настраиваем другие редиректы — со страниц без слеша на страницы со слешем или наоборот;

- Завершающий этап – это обновление карты сайта.

Отдельное направление – работа с уже имеющимся, старым сайтом:

- Сканируем сайт и все его страницы в поисковых системах;

- Выявляем дубли;

- Устраняем причину возникновения дублей;

- Проставляем 301 редирект и rel=»canonical» с дублей на основные документы;

- В обязательном порядке 301 редиректы ставятся на страницы со слешем или без него. Обязательная задача – все url должны выглядеть одинаково;

- Правим роботс — закрываем дубли, указываем директиву Host для Yandex с заданием основного зеркала;

- Ждем учета изменений в поисковиках.

Как-то так.

Как найти и исправить ошибки SEO

Внутренняя оптимизация помогает сайту с хорошим контентом занимать высокие позиции в поисковой выдаче. Но когда проект развивается и обрастает новыми страницами, можно допустить ошибки, которые негативно повлияют на рост позиций сайта. Как вовремя найти и исправить эти ошибки, расскажем в статье.

Содержание

Зачем проверять настройки сайта для SEO

Краткий словарь SEO терминов

Какими бывают ошибки оптимизации и как их найти

Чеклист для проверки сайта на ошибки

Проверка сайта на наличие технических ошибок

Зачем проверять настройки сайта для SEO

Чем выше позиции сайта в поисковой выдаче, тем людям проще его найти и тем больше посетителей может на него перейти. На позиции влияют разные факторы: контент, история сайта, количество упоминаний в других источниках и техническая оптимизация. Последняя играет большую роль в общем успехе продвижения в поисковых системах.

Технические настройки включают в себя настройку названий и описаний страниц (метатегов), заголовков, атрибутов у изображений, переадресаций, создание страницы для 404 ошибки и многое другое.

В Тильде все настройки можно сделать в интерфейсе. В справочном центре мы подготовили чек-лист по оптимизации сайта, который поможет проделать основную работу, связанную с SEO.

Когда вы только запускаете сайт, вы можете несколько раз проверить, чтобы все настройки были сделаны идеально. Когда проект развивается, постоянно создаются новые страницы, редактируются и удаляются старые, можно допустить ошибки, которые повлияют на продвижение. Чтобы этого не произошло, нужно периодически проводить проверку.

Пример

Руководитель турагентства открыл новое направление — фитнес-туры в Испанию. За полгода контент-менеджер Иван написал 10 статей для блога, которые нравятся читателям. Но он поставил у всех страниц со статьями одинаковые названия (метатег Title) и описания (метатег Description), а также не добавил заголовкам статьи теги h2 и h3. Статьи плохо ранжировались и не попали на первые страницы поисковой выдачи.

Иван посоветовался с SEO-специалистом и сделал все настройки. Несколько материалов поднялось на первую страницу поисковой выдачи по важным запросам: «как выбрать фитнес-тур», «фитнес-туры на море». За месяц их прочитала 1000 новых посетителей, а 10 из них заказали тур.

Несколько материалов поднялось на первую страницу поисковой выдачи по важным запросам: «как выбрать фитнес-тур», «фитнес-туры на море». За месяц их прочитала 1000 новых посетителей, а 10 из них заказали тур.

Краткий словарь SEO терминов

Чтобы было проще разобраться, что это за настройки и зачем они нужны, мы подготовили краткий словарь SEO терминов

Метатеги Title и Description — заголовок и описание страницы, которые отображаются в поисковой выдаче. На самой странице они не видны, но название отображается на вкладке браузера. Помимо этого, указанные вами Title и Description часто используются поисковыми системами для показа в результатах поиска.

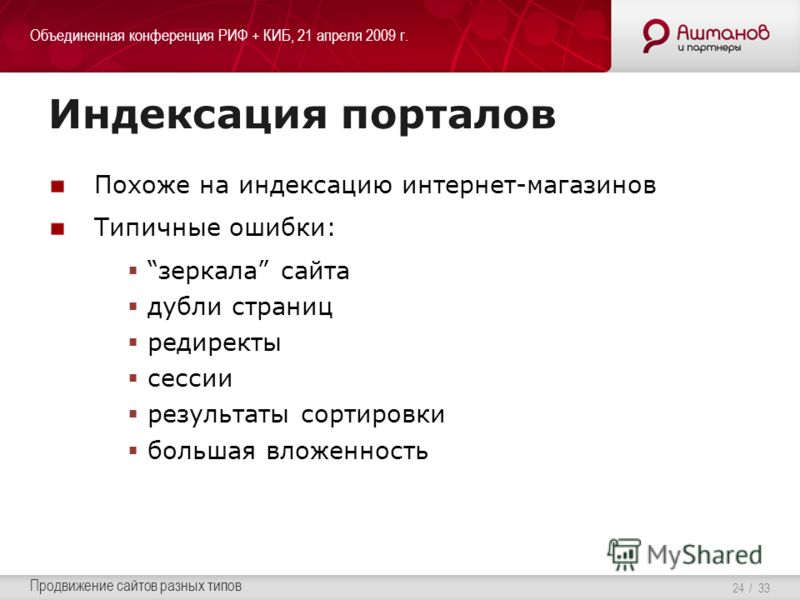

Индексация — передача страниц и другого содержимого сайта (изображений, видео, ссылок и т. д.) роботом-пауком в индекс поисковой системы. Индекс представляет собой своеобразный список страниц, к которым поисковая система обращается во время поиска страниц, соответствующих запросам пользователей.

Код ответа сервера — трехзначное число, которым обозначается определённый статус запрашиваемой страницы. Даёт понять браузеру и поисковому роботу, как сайт отреагировал на запрос к определённой странице.

Даёт понять браузеру и поисковому роботу, как сайт отреагировал на запрос к определённой странице.

h2-H6 — шесть тегов, которые используются при создании HTML-страниц для структурирования и деления информации на блоки. Заголовок, обозначенный тегом h2, имеет наибольшую значимость для поисковых систем.

Альтернативный текст для изображений (тег ALT) — показывается на месте изображения, если само изображение не видно (например, в момент загрузки при медленном соединении). Кроме этого, поисковые системы воспринимают альтернативный текст как ключевые слова и учитывают их при индексации.

Глубина страницы — количество кликов, отделяющих страницу от главной.

Rel=canonical — атрибут, указывающий каноническую, приоритетную для индексации страницу. С его помощью все характеристики (ссылочный вес, поведенческий фактор и т. д.) передаются нужной версии документа, а копии отмечаются поисковым роботом как малозначительные и не попадают в индекс.

Внутренний PageRank — относительный показатель распределения ссылочного веса веса между страницами в пределах одного сайта. Вес передаётся при помощи ссылок с одной страницы на другую, а также атрибута rel=canonical и редиректов.

Вес передаётся при помощи ссылок с одной страницы на другую, а также атрибута rel=canonical и редиректов.

Какими бывают ошибки оптимизации и как их найти

В SEO существуют ошибки разной степени критичности, включая как очень важные, так и незначительные. Например, критическая ошибка — это дубли страниц. Если вы не указали в настройках при помощи атрибута Canonical, какая страница основная, а какую не нужно индексировать, поисковые системы могут понизить позиции обеих страниц.

Основные ошибки

Критические

- Важная страница закрыта от индексации

- Дубли страниц

- Бесконечный редирект

- Максимальная длина URL

- Нет адаптивной версии

- Наличие битых ссылок или битых изображений на сайте

- У страницы нет названия и/или описания (метатеги Tiltle и Description)

- Ссылка на логотипе в верхней части страницы ведет на другой сайт

- Купленный домен находится в черном списке

Важные

- Цепочка переадресаций (редиректов)

- На странице отсутствует тег заголовка h2 Нет страницы 404 ошибки

- Большой размер изображений

- Системный URL вместо понятных слов

- Не прописан альтернативный текст у изображений

- Низкая скорость ответа сервера и загрузки страницы

Незначительные

- Короткий Title и/или Description

- Слишком длинный заголовок h2

- На сайте не настроено безопасное соединение по про протоколу HTTPS

Лучше устранять все виды ошибок, но к критическим нужно относиться особенно внимательно. Допустив их, вы можете упустить шанс оказаться в зоне видимости пользователя или серьёзно понизить уже имеющиеся позиции в выдаче. Вернуть всё назад будет сложно.

Допустив их, вы можете упустить шанс оказаться в зоне видимости пользователя или серьёзно понизить уже имеющиеся позиции в выдаче. Вернуть всё назад будет сложно.

Чеклист для проверки сайта на ошибки

Поиск дубликатов страниц. Проверка настроек переадресации, канонического атрибута страницы

На сайте не должно присутствовать страниц с одинаковым контентом. Если нужно оставить страницы с частично или полностью повторяющимся контентом, у второстепенных страниц должен присутствовать атрибут rel=canonical.

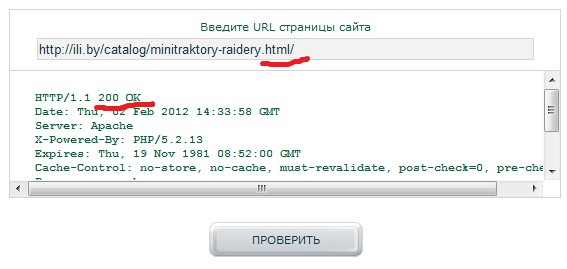

Проверка доступности страниц для индексации. Проверка кодов ответа сервера

Страницы с важным контентом должны быть открыты для индексации и отдавать код ответа сервера 200 OK.

Проверка времени загрузки страниц сайта и скорости ответа сервера

Скорость ответа сервера должна быть меньше 500 мс.

Проверка метатегов Title и Description, тега заголовка h2

У каждой страницы должен быть уникальный Title и Description. Длина Title должна быть от 10 до 70 символов, Description — от 60 до 260 символов в среднем.

Длина Title должна быть от 10 до 70 символов, Description — от 60 до 260 символов в среднем.

На каждой странице должен быть назначен тег h2 главному заголовку. Не рекомендуется делать его длиннее 65 символов.

Проверка структуры URL-адресов и глубины страниц

URL должны состоять из понятных слов. Глубина страниц — количества кликов, отделяющих страницу от главной. Рекомендуется, чтобы она не превышала 4.

Проверка оптимизации изображений

Оптимальный размер изображений — 100 кб. У изображений должен присутствовать альтернативный текст. Он должен соответствовать содержимому изображения и содержать от 70 до 250 символов.

Анализ внутреннего PageRank

PageRank — внутренний показатель распределения ссылочного веса между страницами в пределах одного сайта. На сайте не должно быть недостижимых страниц и страниц без исходящих ссылок.

Внутри Тильды есть встроенный инструмент для быстрой проверки следующих критических ошибок: наличие Title, Description, тега h2, читаемого URL, неопубликованных или закрытых от индексации страниц.

Чтобы запустить проверку, откройте Настройки сайта > SEO > SEO-рекомендации.

Проверка сайта на наличие технических ошибок

Чтобы наглядно показать, как искать ошибки, мы попросили Александру Метизу провести проверку трех разных проектов, сделанных на Тильде:

Проект малого бизнеса Another Georgia

Интернет-магазин Kitchen Ceremony

Сервис для клиентской поддержки Юздеск

Александра Метиза

Контент-маркетолог Netpeak Software

Для проверки использовали Netpeak Spider — инструмент для комплексного внутреннего SEO-аудита сайта. Фактически программа «обходит» выбранные для сканирования страницы или весь сайт целиком, переходя по внутренним ссылкам.

В процессе Spider анализирует свойства страницы, проверяя метаданные, атрибуты, редиректы, инструкции для поисковых роботов, а также множество других данных, важных для поисковой оптимизации.

Выбор анализируемых параметров зависит от целей сканирования: можно выбрать их вручную, или воспользоваться одним из шаблонов.

1. Мастер-классы грузинской кухни Another Georgia

Сайт: another-georgia.com

Тип компании: малый бизнес

География: Москва

Краткое описание: практические мастер-классы по грузинской кухне

Контент и основные метаданные

Всего в сайте 16 страниц, ни одна из которых не дублируется. Важные проблемы были обнаружены всего на двух страницах: на них отсутствуют заголовки первого порядка h2, а длина Description — меньше рекомендованной.

Как исправить

Добавить тег h2 к заголовкам на страницах.

Инструкция →

Составить более развёрнутый Description (Описание) и указать его в настройках страницы.

Инструкция →

Настройки переадресации и атрибут Canonical

На сайте используются серверные редиректы, которые перенаправляют на зеркала без слеша в конце. Но отсутствует переадресация на единую версию с префиксом www. или без него. Есть вероятность, что это повлечёт за собой появление дублей, которые крайне негативно воспринимаются поисковыми системами. Поисковые роботы воспринимают атрибут rel=»canonical» не как строгую директиву, а как рекомендацию, то есть указанный URL может быть проигнорирован.

Есть вероятность, что это повлечёт за собой появление дублей, которые крайне негативно воспринимаются поисковыми системами. Поисковые роботы воспринимают атрибут rel=»canonical» не как строгую директиву, а как рекомендацию, то есть указанный URL может быть проигнорирован.

Нет переадресации и на HTTP-версию сайта при попытке ввести адрес сайта с https://, хотя имеется ведущий на неё атрибут Canonical.

Как исправить

В настройках сайта настроить переадресацию: Настройки > SEO > Редиректы страниц.

Инструкция →

Проверка кодов ответа сервера. Открытость к индексации

Ни одна из стратегически важных страниц не была закрыта от поисковых роботов: все отдают код ответа 200 OK, а значит, могут быть проиндексированы поисковыми роботами. Исключение составляют несколько служебных страниц.

Время загрузки страниц сайта и скорость ответа сервера

Время ответа сервера в пределах сайта варьируется от 93 до 234 мс, скорость загрузки контента — от 1 до 108 мс. Показатели близки к идеалу.

Показатели близки к идеалу.

Структура URL и глубина страниц

Все URL составлены грамотно: их вид отвечает структуре сайта и смыслу каждой отдельно взятой страницы. Нет проблем ни с кодировкой, ни с излишней глубиной: до любой страницы сайта можно добраться в 2 клика.

Распределение внутреннего PageRank

Внутренний PageRank распределяется между страницами равномерно. Перелинковка сделана грамотно, тупиковых страниц нет. Нет таких проблем, как «Висячий узел», «Отсутствуют связи», «Отсутствуют исходящие ссылки».

Висячий узел. Так определяются страницы, на которые ведут ссылки, но на них самих отсутствуют исходящие ссылки, из-за чего нарушается естественное распределение ссылочного веса по сайту.

Отсутствуют связи. Это страницы, на которые не было найдено ни одной входящей ссылки.

Отсутствуют исходящие ссылки. Показывает URL, у которых не были найдены исходящие ссылки.

Изображения

На сайте не было обнаружено проблем с оптимизацией изображений. Но у 15 из них не прописан атрибут ALT, который мог бы поспособствовать продвижению сайта в поиске по картинках.

Но у 15 из них не прописан атрибут ALT, который мог бы поспособствовать продвижению сайта в поиске по картинках.

Как исправить

Добавить альтернативный текст к изображениям.

Инструкция →

2. Интернет-магазин пряностей Kitchen Ceremony

Сайт: kitchenceremony.com

Тип компании: интернет-магазин

География: международный рынок

Контент и основные метаданные

Первая проблема, которая бросается в глаза по итогу сканирования сайта, — несколько битых ссылок, отдающих 404 код ответа.

Кликнув по одной из обнаруженных ссылок, мы неизменно попадаем на страницу «Пряности», однако битый URL не меняется на http://www.kitchenceremony.com/spices/.

В действительности абсолютно нормальная страница имеет код ответа сервера 404 Not Found, что подтверждает даже консоль разработчика в Chrome. Возможно, всё дело в том, что владельцы сайта не создали выделенную страницу для 404 ошибки и назначили на её роль страницу «Пряности».

Как исправить

Создать отдельную страницу 404 ошибки и указать её в настройках сайта: Настройки > Еще > Страница 404.

Инструкция →

Следующая проблема — обилие дубликатов. Netpeak Spider обнаружил несколько одинаковых Title, Description и заголовков первого порядка, использованных для страниц с несколькими разными рецептами и товарами.

Также, просматривая ссылки с дублями, мы обнаружили, что страницы /decor/05 и /decor/06 фактически дублируют друг друга: программа не определила их как полные дубли только потому, что в тексте есть несущественное различие, которое можно обнаружить лишь целенаправленно.

Как исправить

Создать для всех страниц уникальный Title и Description.

Удалить дубликаты страниц.

Также на некоторых страницах были обнаружены слишком короткие или слишком длинные h2, Description и Title. Эти проблемы имеют низкий уровень критичности, но лучше не оставлять их без внимания.

Эти проблемы имеют низкий уровень критичности, но лучше не оставлять их без внимания.

Как исправить

Привести h2, Title и Description к нужной длине:

- Title — от 10 до 70 символов,

- Description — от 60 до 260 символов в среднем,

- h2 — не более 65 символов.

Настройки переадресации и атрибут Canonical

Не настроены серверные редиректы на одну основную версию сайта, так что внутри сайта смешиваются страницы с префиксом www. и без него.

Страница «Пряности» отдаёт разный код ответа в зависимости от наличия слеша и префикса в адресе. На этом, кстати, проблемы страницы не завершаются: её каноническая версия (http://www.kitchenceremony.com/spices/) закрыта при помощи запрещающей директивы Disallow в robots.txt. Это происходит из-за того, что страница «Пряности» установлена в качестве страницы 404 ошибки.

Как исправить

Настроить редирект с версии сайта без www. на версию с www., или наоборот.

на версию с www., или наоборот.

Создать отдельную страницу 404 ошибки и указать её в настройках сайта: Настройки > Еще > Страница 404.

Инструкция →

Проверка кодов ответа сервера. Открытость к индексации

Согласно результатам сканирования, 77,3% процента обнаруженных на сайте страниц могут быть проиндексированы. Это те страницы, которые открыты для индексации, отдают код ответа 200 OK и не перенаправляют поисковых роботов на канонические URL-адреса. Большинство стратегически важных страниц попадают в их число, но всё же результат мог бы быть значительно лучше.

Скорость ответа сервера и загрузки контента

Минимальное время ответа сервера составляет 49 мс, максимальное — 578 мс, что незначительно превышает допустимую норму. Время загрузки контента также колеблется в рекомендуемых пределах — от 0 до 540 мс.

Структура URL и глубина страниц

Как и в случае с Another Georgia, URL на сайте формируются согласно иерархии страниц. В большинстве случаев адреса страниц включают в себя краткие версии русскоязычных заголовков, прописанных латиницей. Почти на всех из них можно попасть в 2 клика. Но есть и исключения, которые портят идеальную картину.

В большинстве случаев адреса страниц включают в себя краткие версии русскоязычных заголовков, прописанных латиницей. Почти на всех из них можно попасть в 2 клика. Но есть и исключения, которые портят идеальную картину.

Как исправить

Проставить ссылки на страницы с глубоким уровнем вложенности таким образом, чтобы «сократить» к ним путь от главной.

Распределение внутреннего PageRank

На сайте есть некоторые проблемы с распределением внутреннего PageRank:

Внутри сайта есть недостижимые страницы

Это касается товарных страниц с описаниями кориандра, хмели-сунели и жёлтого цветка. Клик по миниатюрам этих товаров из каталога специй не перенаправляет пользователя на страницу — он просто добавляет артикул в корзину.

Как исправить

Добавить ссылки на недостижимые страницы. Например, можно добавить ссылки на описание специй в статьи с рецептами.

Страницы, отдающие 404 код ответа, создают так называемые «висячие узлы»

«Висячие узлы», на которых не только теряется ссылочный вес, но и «тормозятся» поисковые роботы. И наличие подобных страниц может негативно сказаться на пользовательском опыте.

И наличие подобных страниц может негативно сказаться на пользовательском опыте.

Как исправить

Добавить на тупиковые страницы исходящие ссылки, например, на главную или на другие связанные страницы.

Изображения

Размер имеющихся на сайте изображений не превышает рекомендуемой нормы. Но в то же время у большинства картинок отсутствует атрибут ALT, необходимый для ранжирования в поиске.

Как исправить

Добавить альтернативный текст к изображениям.

Инструкция →

3. Онлайн-сервис Юздеск

Сайт: usedesk.ru

Тип компании: онлайн-сервис

География: международный рынок

Краткое описание: сервис для общения с клиентами во всех цифровых каналах (чат на сайте, электронная почта, мессенджеры, соцсети).

Контент и основные метаданные

На сайте есть несколько битых ссылок. Некоторые размещены на важных лидогенерирующих страницах. Нужно заменить их корректными рабочими ссылками без потери смысловой связи.

Как исправить

Заменить битые ссылки на соответствующие рабочие.

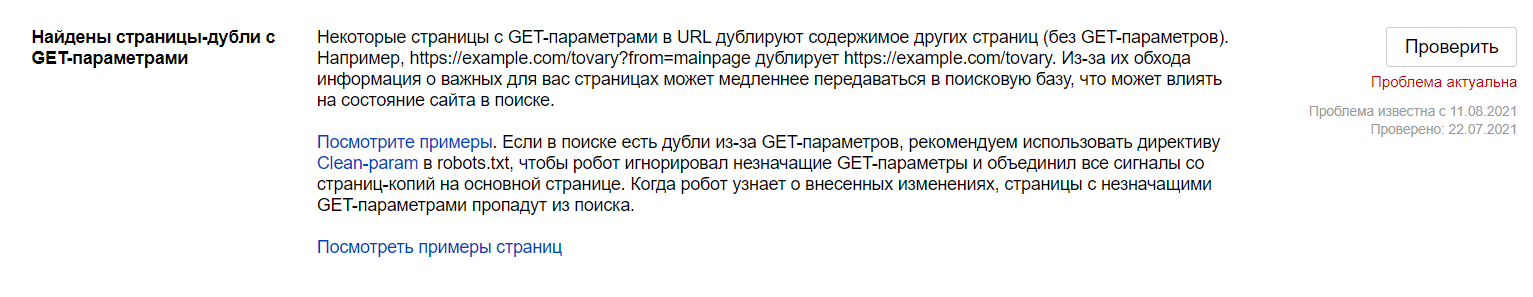

На сайте существует сразу несколько вариантов ссылок с разными GET-параметрами на страницы авторизации и регистрации, которые открыты для индексации. Они могут определяться поисковыми роботами как дубли из-за того, что страницах не настроен атрибут Canonical. К тому же, на этих же страницах отсутствуют метатеги Description.

Как исправить

Настроить атрибут Canonical, указав в качестве канонических страницы авторизации и регистрации без GET-параметров и дополнительных атрибутов в адресе.

Прописать Description.

Инструкция →

Примерно у десятка страниц Description короче, чем рекомендуется.

Как исправить Исправить Description.

Инструкция →

Редиректы и атрибут Canonical

На сайте исправно работают редиректы на основное зеркало сайта (с HTTPS, без слеша и префикса www. ).

).

Директивы по индексации. Индексируемость страниц

В robots. txt от индексации закрыто всего несколько страниц, хотя по большому счёту, нет особенного смысла скрывать их от поисковых роботов.

Все ссылки на страницах, связанных с клиентами компании, и ещё нескольких лендингах закрыты при помощи rel=nofollow, хотя в данный момент в этом нет необходимости. Атрибут nofollow больше не помогает «сохранить» ссылочный вес от передачи другим сайтам.

Скорость ответа сервера и загрузки контента

Время ответа сервера для абсолютного большинства страниц варьируется в рекомендуемых пределах от 47 до 496 мс. Всего 2 страницы составили исключение и превысили планку в 600 мс.

Структура URL и глубина страниц

URL в большинстве случаев отвечают принципу ЧПУ (человеко-понятные URL), а их строение соответствует общей структуре сайта. Средняя глубина страниц составляет от 1 до 4, что не превышает допустимой нормы.

Распределение внутреннего PageRank

Использование вышеупомянутого атрибута rel=nofollow на нескольких десятках страниц привело к неравномерному распределению внутреннего PageRank. Как следствие, 8 страниц сайта были определены краулером как «Висячие узлы», то есть, как страницы без открытых исходящих ссылок.

Как следствие, 8 страниц сайта были определены краулером как «Висячие узлы», то есть, как страницы без открытых исходящих ссылок.

Как исправитьУбрать атрибут rel=nofollow и добавить на тупиковые страницы исходящие ссылки, например, на главную или на другие связанные страницы.

Изображения

Все изображения на сайте имеют размер не более 100 кбайт, но при этом ни у одного из них нет сопутствующего атрибута ALT.

Как исправить

Добавить альтернативный текст к изображениям.

Инструкция →

Результаты проверки

Мы провели базовый аудит трёх работающих сайтов. У двух из них выявили критические ошибки, которые влияют на потенциальную индексацию и ранжирование в поисковой выдаче. Но исправить их можно довольно быстро.

Чтобы избежать проблем с ранжированием сайта, для каждой новой страницы не забывайте делать необходимые настройки по чек-листу и проверяйте весь сайт на критические ошибки не реже раза в месяц.

Текст: Александра Метиза, Роман Яковенко

Верстка, дизайн и иллюстрации: Юля Засс

Если материал вам понравился, поставьте лайк — это помогает другим узнать о нем и других статьях Tilda Education и поддерживает наш проект. Спасибо!

*Компания Meta Platforms Inc., владеющая социальными сетями Facebook и Instagram, по решению суда от 21.03.2022 признана экстремистской организацией, ее деятельность на территории России запрещена.

Читайте также:

Как создать сайт. Пошаговое руководство

SEO продвижение сайта на Тильде самостоятельно — пошаговая инструкция

Аналитика сайта — как повысить конверсию сайта, используя веб-аналитику

Навигация по сайту — примеры как сделать навигацию удобной

SEO-кейс: продвижение онлайн-магазина

Почему любому сайту нужна страница 404

Как сделать интернет-магазин самостоятельно с нуля

Как работает SEO: основные принципы сео продвижения сайтов

Дубли страниц сайта — поиск и удаление

Что такое дубли страниц

В рамках одного доменного имени очень может такое быть, что один и тот же контент доступен по разным адресам.

Вполне вероятно, что на разных страницах сайта опубликован очень похожий или же полностью дублированный контент. Это может быть одинаковые (или очень похожие) описания meta name="description" content="", заголовки h2, title страницы. Если после проверки на наличие дубликатов выяснилось, что они присутствуют в вашем приложении, то необходимо устранить ненужные дубли страниц.

Дубли — это страницы, которые или очень похожи или являются полной копией (дублем) основной (продвигаемой вами) страницы.

Причины появления дублей страниц на сайте

- Не указано главное зеркало сайта. Одна и та же страница доступна по разным URL (с www. и без | с http и с https).

- Версии страниц сайта для печати, не закрытые от индексации.

- Генерация страниц с одними и теми же атрибутами, расположенными в разном порядке. Например,

/?id=1&cat=2и/?cat=2&id=1.

- Автоматическая генерация дубликатов движком приложения (CMS). Из-за ошибок в системе управления контентом (CMS), так же могут появляются дубли страниц.

- Ошибки веб-мастера при разработке (настройке) приложения.

- Дублирование страницы (статьи, товара…) веб-мастером или контент-маркетологом.

- Изменение структуры сайта, после которого страницам присваиваются новые адреса, а старые не удаляются.

- На сайте используются «быстрые» мобильные версии страниц, с которых не выставлен

Canonicalна основные версии. - Сознательное или несознательное размещение ссылок третьими лицами на ваши дубли с других ресурсов.

Виды дублей

Дубликаты различают на 3 вида:

- Полные — с полностью одинаковым контентом;

- Частичные — с частично повторяющимся контентом;

- Смысловые, когда несколько страниц несут один смысл, но разными словами.

Полные

Полные дубли ухудшают факторы всего сайта и осложняют его продвижение в ТОП, поэтому от них нужно избавиться сразу после обнаружения.

- Версия с/без

www. Возникает, если пользователь не указал зеркало в панели Яндекса и Google. - Различные варианты главной страницы:

- site.com

- site.com/default/index

- site.com/index

- site.com/index/

- site.com/index.html

- Страницы, появившиеся вследствие неправильной иерархии разделов:

- site.com/products/apple/

- site.com/products/category/apple/

- site.com/category/apple/

- UTM-метки. Метки используются, чтобы передавать данные для анализа рекламы и источника переходов. Обычно они не индексируются поисковиками, но бывают исключения.

- GET-параметры в URL. Иногда при передаче данных GET-параметры попадают в адрес страницы:

- site.

com/products/apple/page.php?color=green

com/products/apple/page.php?color=green

- site.

- Страницы, сгенерированные реферальной ссылкой. Обычно они содержат специальный параметр, который добавляется к URL. С такой ссылки должен стоять редирект на обычный URL, однако часто этим пренебрегают.

- Неправильно настроенная страница с ошибкой 404, которая провоцирует бесконечные дубли. Любой случайный набор символов в адресе сайта станет ссылкой и без редиректа отобразится как страница 404.

Избавиться от полных дубликатов можно, поставив редирект, убрав ошибку программно или закрыв документы от индексации.

Частичные

Частичные дубликаты не так страшны для на сайта, как полные. Однако, если их много — это ухудшает ранжирование веб-приложения. Кроме того, они могут мешать продвижению и по конкретным ключевым запросам. Разберем в каких случаях они возникают.

Характеристики в карточке товара

Нередко, переключаясь на вкладку в товарной карточке, например, на отзывы, можно увидеть, как это меняет URL-адрес. При этом большая часть контента страницы остаётся прежней, что создает дубль.

При этом большая часть контента страницы остаётся прежней, что создает дубль.

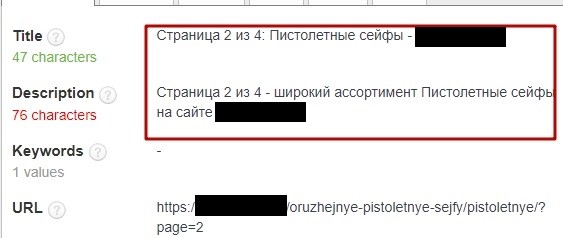

Если CMS неправильно настроена, переход на следующую страницу в категории меняет URL, но не изменяет Title и Description. В итоге получается несколько разных ссылок с одинаковыми мета-тегами:

- site.com/fruits/apple/

- site.com/fruits/apple/?page=2

Такие URL-адреса поисковики индексируют как отдельные страницы. Чтобы избежать дублирования, проверьте техническую реализацию вывода товаров и автогенерации.

Также на каждой странице пагинации необходимо указать каноническую страницу, которая будет считаться главной.

Подстановка контента

Часто для повышения видимости по запросам с указанием города в шапку сайта добавляют выбор региона. При нажатии которого на странице меняется номер телефона. Бывают случаи, когда в адрес добавляется аргумент, например city_by_default=. В результате, у каждой страницы появляется несколько одинаковых версий с разными ссылками. Не допускайте подобной генерации или используйте 301 редирект.

Не допускайте подобной генерации или используйте 301 редирект.

Версия для печати

Версии для печати полностью копируют контент и нужны для преобразования формата содержимого. Пример:

- site.com/fruits/apple

- site.com/fruits/apple/print – версия для печати

Поэтому необходимо закрывать их от индексации в robots.txt.

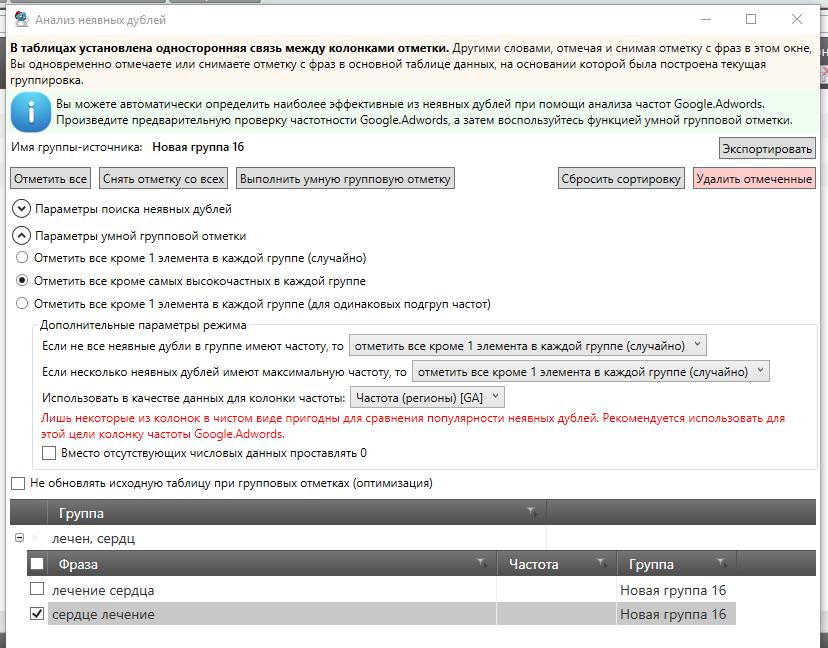

Смысловые

Смысловые дубли — контент страниц, написанный под запросы из одного кластера. Чтобы их обнаружить (смысловые дубли страниц), нужно воспользоваться результатом парсинга сайта, выполненного, например, программой Screaming Frog. Затем скопировать заголовки всех статей и добавить их в любой Hard-кластеризатор с порогом группировки 3,4. Если несколько статей попали в один кластер – оставьте наиболее качественную, а с остальных поставьте 301 редирект.

Чем опасны дубли страниц на сайте

Наличие дубликатов на сайте — один ключевых факторов внутренней оптимизации (или её отсутствия), который крайне негативно сказывается на позициях сайта в органической поисковой выдаче.

- Индексация сайта. При большом количестве дублей поисковые роботы в силу ограниченного краулингового бюджета могут не проиндексировать нужные страницы. Также есть риск того, что сайт будет пессимизирован, а его краулинговый бюджет — урезан.

- Проблемы с выдачей приоритетной страницы в органическом поиске. За счет дублей в поисковую выдачу может попасть не та страница, продвижение которой планировалось, а её копия. Есть и другой вариант: обе страницы будут конкурировать между собой, и ни одна не окажется в выдаче.

- «Распыление» ссылочного веса. Вес страницы сайта — это своеобразный рейтинг, выраженный в количестве и качестве ссылок на неё с других сайтов или других страниц внутри этого же сайта. При наличии дублей ссылочный вес может переходить не на единственную версию страницы, а делиться между ее дубликатами. Таким образом, все усилия по внешней оптимизации и линкбилдингу оказываются напрасными.

Инструменты для поиска

Как найти дублирующиеся страницы? Это можно сделать с помощью специальных программ и онлайн сервисов. Часть из них платные, другие – бесплатные, некоторые – условно-бесплатные (с пробной версией или ограниченным функционалом).

Яндекс Вебмастер

Чтобы посмотреть наличие дубликатов в панели Яндекса, необходимо зайти: Индексирование -> Страницы в поиске -> Исключённые.

Страницы исключаются из индекса по разным причинам, в том числе из-за повторяющегося контента (дублирования). Обычно конкретная причина прописана под ссылкой.

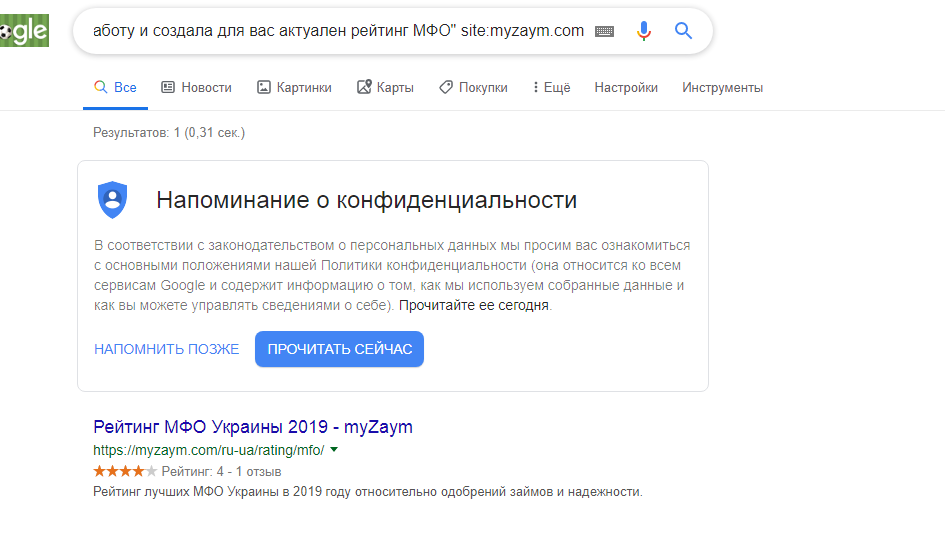

Google Search Console

Посмотреть наличие дублей страниц в панели Google Search Console можно так: Покрытие -> Исключено.

Netpeak Spider

Netpeak Spider – платная программа с 14-дневной пробной версией. Если провести поиск по заданному сайту, программа покажет все найденные ошибки и дубликаты.

Xenu

Xenu — бесплатная программа, в которой можно проанализировать даже не проиндексированный сайт. При сканировании программа найдет повторяющиеся заголовки и мета-описания.

Сайт Репорт

Сайт Репорт — это неплохой сервис, предоставляющий пользователю инструмент диагностики внутренних и внешних факторов с целью оптимизации сайта. Поиск дубликатов — это один из множества инструментов сервиса по оптимизации сайта или другого приложения. Сервис предоставляет бесплатный анализ до 25 страниц. Если у вас на сайте большее количество страниц, то (при необходимости) придётся немного потратиться. Но оно того стоит.

Screaming Frog Seo Spider

Screaming Frog Seo Spider является условно-бесплатной программой. До 500 ссылок можно проверить бесплатно, после чего понадобится платная версия. Наличие дублей программа определяет так же, как и Xenu, но быстрее и эффективнее.

Как начать пользоваться бесплатно:

- Скачать программу Screaming Frog Seo Spider и установить её на свой ПК.

Скачать ключ-активатор для программы. Пароль к архиву:

Скачать ключ-активатор для программы. Пароль к архиву: prowebmastering.ru - Запустить

keygen.exe, задать имя пользователя и ключ (ключ можно сгенерировать) - В самой программе Screaming Frog Seo Spider выбрать вкладку «Licence» -> «Enter Licence»

- В появившемся окне указать то, что указали (или сгенерировали) при запуске

keygen.exe, жмём «OK», перезапускаем программу.

Документация по работе с программой Screaming Frog Seo Spider здесь.

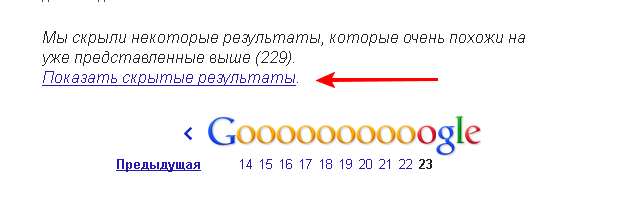

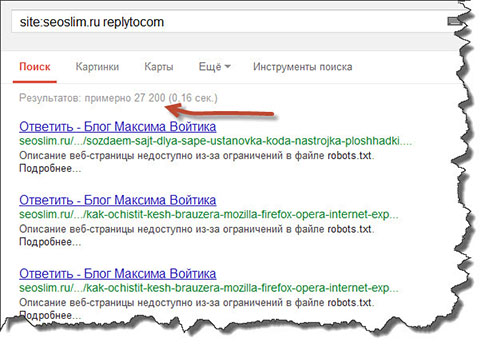

Поисковая выдача

Результаты поиска могут отразить не только нужный нам сайт, но и некое отношение поисковой системы к нему. Для поиска дублей в Google можно воспользоваться специальным запросом.

site:mysite.ru -site:mysite.ru/&

site:mysite.ru — показывает страницы сайта mysite.ru, находящиеся в индексе Google (общий индекс).

site:mysite.ru/& — показывает страницы сайта mysite.ru, участвующие в поиске (основной индекс).

Таким образом, можно определить малоинформативные страницы и частичные дубли, которые не участвуют в поиске и могут мешать страницам из основного индекса ранжироваться выше. При поиске обязательно кликните по ссылке «повторить поиск, включив упущенные результаты», если результатов было мало, чтобы видеть более объективную картину.

Варианты устранения дубликатов

При дублировании важно не только избавиться от копий, но и предотвратить появление новых.

Физическое удаление

Самым простым способом было бы удалить повторяющиеся страницы вручную. Однако перед удалением нужно учитывать несколько важных моментов:

- Источник возникновения. Зачастую физическое удаление не решает проблему, поэтому ищите причину

- Страницы можно удалять, только если вы уверены, что на них не ссылаются другие ресурсы

Настройка 301 редиректа

Если дублей не много или на них есть ссылки, настройте редирект на главную или продвигаемую страницу. Настройка осуществляется через редактирование файла

Настройка осуществляется через редактирование файла .htaccess либо с помощью плагинов (в случае с готовыми CMS). Старый документ со временем выпадет из индекса, а весь ссылочный вес перейдет новой странице.

Создание канонической страницы

Указав каноническую страницу, вы показываете поисковым системам, какой документ считать основным. Этот способ используется для того, чтобы показать, какую страницу нужно индексировать при пагинации, сортировке, попадании в URL GET-параметров и UTM-меток. Для этого на всех дублях в теге прописывается следующая строчка со ссылкой на оригинальную страницу:

<link rel="canonical" href="http://site.com/original.html">

Например, на странице пагинации главной должна считаться только одна страница: первая или «Показать все». На остальных необходимо прописать атрибут rel="canonical", также можно использовать теги rel=prev/next:

// Для 1-ой страницы: <link rel="next" href="http://site.com/page/2"> <link rel="canonical" href="http://site.com"> // Для второй и последующей: <link rel="prev" href="http://site.com"> <link rel="next" href="http://site.com/page/3"> <link rel="canonical" href="http://site.com">

Запрет индексации в файле Robots.txt

Файл robots.txt — это своеобразная инструкция по индексации для поисковиков. Она подойдёт, чтобы запретить индексацию служебных страниц и дублей.

Для этого нужно воспользоваться директивой Disallow, которая запрещает поисковому роботу индексацию.

Disallow: /dir/ – директория dir запрещена для индексации Disallow: /dir – директория dir и все вложенные документы запрещены для индексации Disallow: *XXX – все страницы, в URL которых встречается набор символов XXX, запрещены для индексации.

Внимательно следите за тем какие директивы вы прописываете в robots.txt. При некорректном написании можно заблокировать не те разделы либо вовсе закрыть сайт от поисковых систем.

При некорректном написании можно заблокировать не те разделы либо вовсе закрыть сайт от поисковых систем.

Запрет индексировать страницы действует для всех роботов. Но каждый из них реагирует на директиву Disallow по-разному: Яндекс со временем удалит из индекса запрещенные страницы, а Google может проигнорировать правило, если на данный документ ведут ссылки..

Вывод

Дублирующиеся h2, title, description, а также некоторые части контента вроде отзывов и комментариев очень нежелательны и осложняют продвижение сайта. Поэтому обязательно проверяйте ресурс на дубликаты, как сгенерированные, так и смысловые и применяйте описанные в статье методы для их устранения.

что такое, как найти и удалить с сайта

Всем, привет! Дубли страниц на сайтах – одна из серьезных и к сожалению, весьма распространенных проблем. Из-за появления в интернете повторяющихся страниц и одинакового контента, возрастает нагрузка на сервера поисковых машин.

Содержание

- Как удалить дубли страниц и что это такое

- Причины возникновения дублей веб-страниц

- Способы обнаружения дублей и удаления на сайта

- Онлайн-сервис поиска дублей, битых ссылок и прочего

- Trash Duplicate and 301 Redirect для WordPress

- Поиск и удаление дублей в Яндекс.Вебмастере

- Заключение

Как удалить дубли страниц и что это такое

Естественно, поисковые компании не хотят платить лишних денег за обработку одной и той же информации два, а то и несколько раз. Поэтому сайты, имеющие дубли страниц и дублированный контент, в случае их обнаружения поисковыми системами (что часто и бывает) подвергаются различным санкциям.

В общем плане считается, что сайты с дублями, с точки зрения поисковых систем, являются менее информационно ценными и полезными для людей. Соответственно, снижаются перспективы успешного продвижения в ТОП10 и привлечения хорошего трафика.

Кроме того, поисковые алгоритмы все еще не абсолютно совершенны. Зачастую в результате канонической (основной) посадочной страницы поисковые роботы выбирают дубль, случайно оказавшийся первым в поле внимания.

Зачастую в результате канонической (основной) посадочной страницы поисковые роботы выбирают дубль, случайно оказавшийся первым в поле внимания.

В результате ошибочного назначения канонической страницы ресурс требует ссылочную массу, ухудшается поисковое продвижение. Потенциальные клиенты попадают из поиска не на сервисную или продающую страницу, а на дубль и это приводит к снижению качества продаж.

Большое число одинаковых страниц увеличивает потребление программно-аппаратного ресурса на сервере хостинг-провайдера, из-за чего нормальная работа сайта оказывается затруднена. В этом случае дубли могут привести к необходимости переходить на более дорогой тариф хостинговых услуг.

Неопрятности, возникающие из-за появления дублей на сайте, можно еще долго перечислять. Важно разобраться с вопросом – как найти и удалить дубли страниц практически?

Причины возникновения дублей веб-страниц

Приводит к появлению одинаковых или очень похожих веб-страниц могут как ошибки человеческого фактора, так и технические проблемы.

- Баги систем управления контентом.

- Недоработки плагинов.

- Ошибки в работе систем автоматизации SEO-оптимизации динамических сайтов.

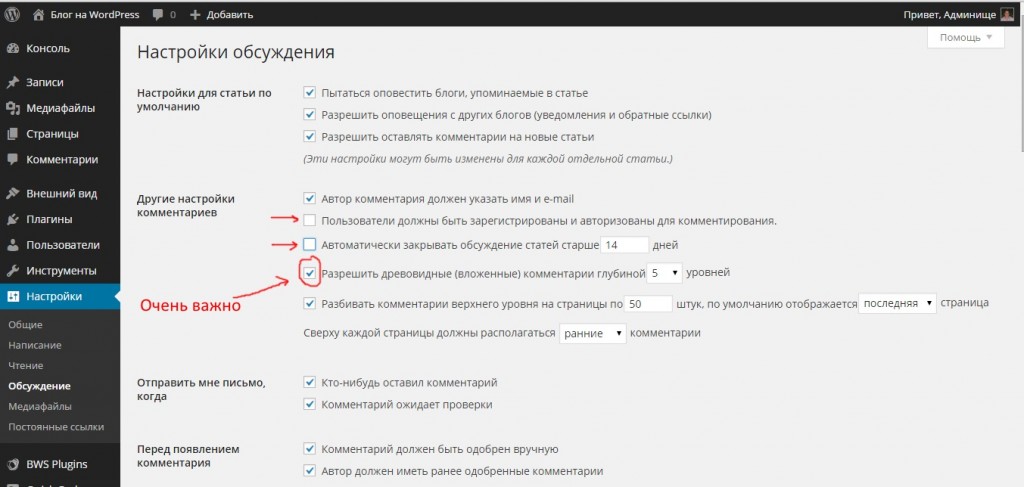

Больше всего нареканий со стороны веб-мастеров в отношении дублирования к самой популярной в мире CMS WordPress. В частности, при использовании функции пагинации на сайтах, движок Вордпресс оформляет страниц так, что с точки зрения поисковых алгоритмов они выглядят как дубли.

Опытные блогеры и веб-разработчики время от времени публикуют статьи, в которых рассказывается, как устранить проблему создания дублирующих страниц и контента в том или ином плагине.

Однако решить проблему дублирования для абсолютно всех плагинов Вордпресс нереально – слишком много и часто создаются расширения и дополнения для этой самой распространенной системы управления сайтами. Зачастую плагины разрабатываются независимыми программистами, а исходный код дополнения не публикуется в открытом доступе.

В итоге, задачу найти и удалить дубли на сайте приходится решать вручную либо при помощи различных SEO-приложений и онлайн-сервисов.

Способы обнаружения дублей и удаления на сайта

Для масштабных интернет-ресурсов с тысячами страниц основная задача – максимально автоматизировать процесс и избавиться от ручного просмотра всех разделов ресурса в поисках повторений.

Следует учитывать и то, что для поисковых роботов-индексаторов дублями будут являться не полные клоны (реплики) веб-страниц, но повторяющиеся мета-теги Title, Description, совпадающие фрагменты текста (низкая уникальность), похожие URL-адреса. Как вы понимаете, если все эти параметры проверять вручную – на это уйдет слишком много времени, которого веб-мастерам и администраторам сайтов и так всегда не хватает.

Поэтому чтобы найти дублированные элементы используется специальное программное обеспечение.

- Онлайн-анализаторы, иногда отдельные инструменты в составе комплексных SEO-сервисов.

- Устанавливаемое на компьютер программное обеспечение.

Возможны варианты поиска дублей в онлайн-режиме, с запросом данных непосредственно на сервере хостинг-провайдера либо офлайн-приложения, для которых файлы сайта необходимо предварительно скопировать на локальный диск компьютера.

Возможны варианты поиска дублей в онлайн-режиме, с запросом данных непосредственно на сервере хостинг-провайдера либо офлайн-приложения, для которых файлы сайта необходимо предварительно скопировать на локальный диск компьютера.

Здесь можно упомянуть качественный софт от авторитетного американского SEO-блогера и цифрового антрепренера Нила Пателя (Neil Patel) приложение для анализа сайтов «Screaming Frog SEO Spider».

- Плагины для систем управления контентом. В частности, для CMS WordPress разработан плагин «Trash Duplicate».

- Профессиональные конструкторы сайтов обычно имеют встроенный SEO-модуль, с помощью которого можно провести комплексное тестирование (аудит) сайта на предмет поиска различного рода ошибок. В том числе найти и удалить дубли. Например, такой модуль для комплексного тестирования и автоматизации процесса исправления ошибок имеется в конструкторе сайтов Serif WebPlus.

- Инструменты для веб-мастеров, предоставляемый поисковыми компаниями – Яндекс.

Вебмастер или Google Console (ранее сервис назывался Google Webmaster Tools).

Вебмастер или Google Console (ранее сервис назывался Google Webmaster Tools). - SEO-расширения и дополнения, плагины, устанавливаемые в веб-браузерах.

Сторонние SEO-сервисы и приложения могут только находить дублирования на сайте, но не имеют возможностей их удалять, поскольку для редактирования сайта требуются права администратора. После составления списка адресов дублей администратору предстоит вручную заняться редактированием сайта и удалением дублированный.

В этом смысле более удобны в работе устанавливаемые в CMS плагины и SEO-модули в составе инструментов конструкторов сайтов. В этих случаях поиск и уничтожение дублей может происходить «одним кликом».

Чтобы наглядно разобраться, как осуществляется проверка сайта на наличие дублей, можно рассмотреть некоторые из упомянутых в списке инструментов отдельно.

Онлайн-сервис поиска дублей, битых ссылок и прочего

Интерфейс сервиса www.siteliner.com (сайт закрыт) на английском, поэтому для удобства воспользуемся Google-переводчиком. Все очень просто:

Все очень просто:

- Вставляем тестируемый домен в поле поиска и нажимаем кнопку «Go».

- Ждем пока закончится процесс сканирования и анализа.

- Получаем результат теста.

Результаты исследования оформлены в виде таблицы.

В таблице указано количество сходных страниц, процент сходства, URL-адреса дублей. Полученные данные можно импортировать в различные форматы документов и скачать на компьютер для дальнейшего подробного рассмотрения.

Дается вывод относительно текущего состояния ресурса:

Состояние неплохое – если в среднем по всемирной сети сайты имеют около 14% дублирования, то наш испытуемый ресурс – всего 5%.

Кликнув по ссылке на станицу можно изучить подробности, что именно и где повторяется.

Сервис условно-бесплатный, без подписки доступно для анализа 250 веб-страниц. Для расширения возможностей необходимо зарегистрироваться и оплатить тариф Siteliner Premium.

Дополнительно сервис находит битые (неработающие, ведущие на несуществующие страницы) гиперссылки. Веб-страницы и контент, запрещенные к индексации при помощи тега Noindex и указанные в файле Robots.txt при сканировании пропускаются.

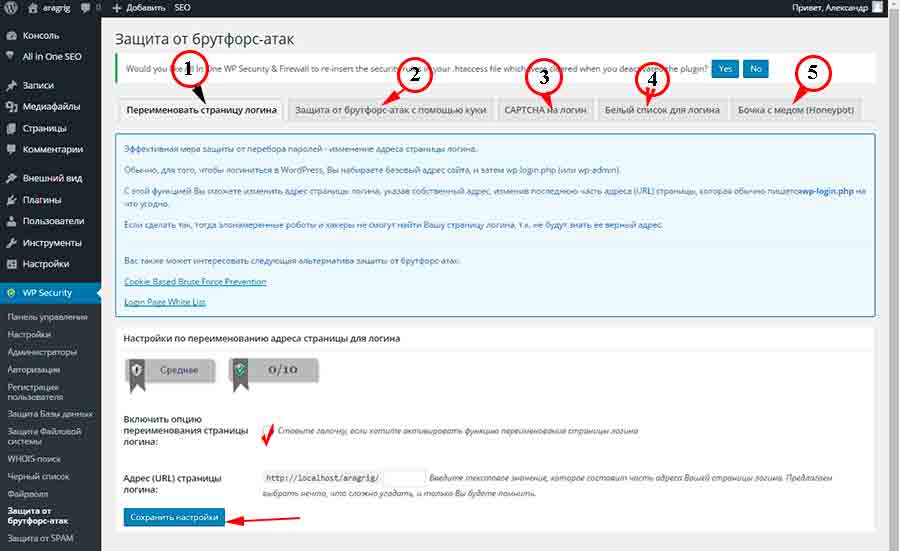

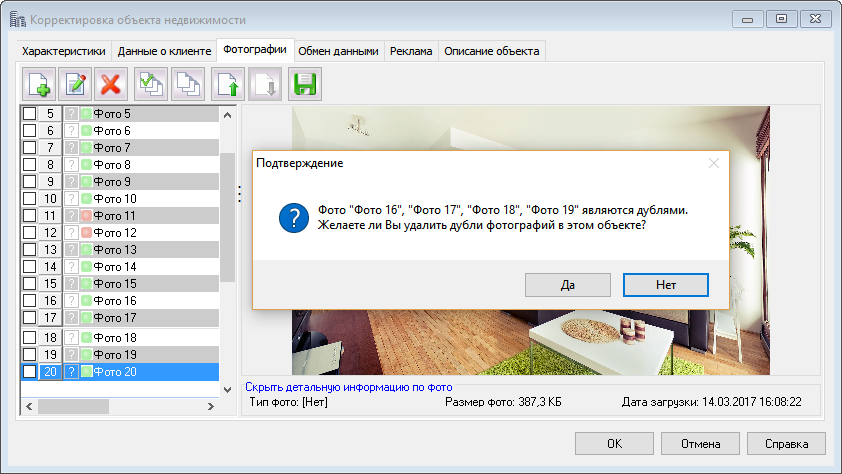

Trash Duplicate and 301 Redirect для WordPress

SEO-дополнение для движка WordPress, с помощью которого можно автоматизировать следующие задачи:

- Поиск дублей страниц и контента.

- Пакетное удаление дублирований одним кликом.

- Автоматическая расстановка редиректов 301. Удаление нежелательных переадресаций.

Для установки этого плагина требуется подписка на Бизнес-тариф сервисов Вордпресс. В реальности, пресловутая «бесплатность» здесь очень ограничена и создаваемые за 5 минут сайты на WordPress годятся разве что для персонального блога с нулевой посещаемостью.

Если вы хотите по-настоящему заниматься цифровым бизнесом на сайте Powered by WordPress, в любом случае придется инвестировать в профессиональные темы[/mask_link], плагины, и прочие возможности.

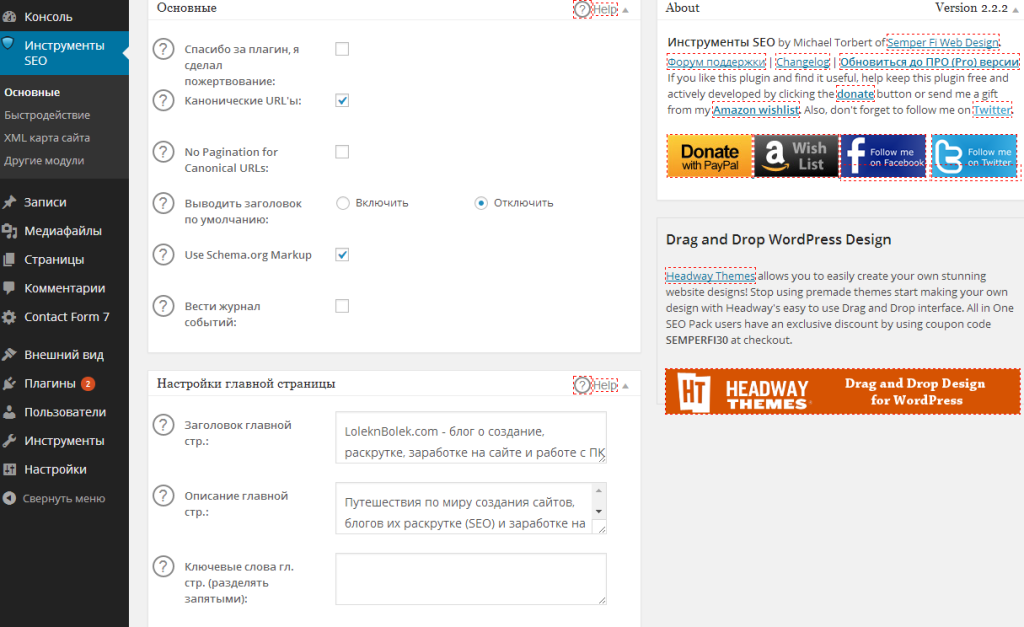

Чтобы установить плагин Trash Duplicate нужно перейти в раздел «Plagins Manage».

Ввести в строку поиска название расширения и кликнуть по значку для запуска процесса инсталляции.

После установки запускается сканирование и по результатам формируется список.

Теперь можно отметить галочками нежелательные или ошибочные публикации и сразу все удалить.

Поиск и удаление дублей в Яндекс.Вебмастере

В раздел «Статистика индексации» можно посмотреть отчет о страницах, которые были по каким-то причинам исключены из поиска. В одном из столбцов таблицы указана причина отказа от включения веб-страницы в базу поисковой системы.

Часть страниц обозначена как «неканонические», а часть прямо отмечена как «дубли».

Теперь дублированные посты можно либо удалить, либо установить на них редиректы. В разделе «Инструменты» имеется возможность указать URL нежелательных публикаций и пакетом их удалить из поиска. Следует понимать, что на сайте эти страницы останутся, просто перестанут индексироваться и участвовать в поиске по запросам.

Следует понимать, что на сайте эти страницы останутся, просто перестанут индексироваться и участвовать в поиске по запросам.

Альтернативно можно указать для поисковых роботов канонические страницы при помощи атрибута rel=»canonical». Вот как эта процедура описана в Помощи к Яндекс.Вебмастеру:

Исследуемый сайт у нас как раз на WordPress и выше мы рассмотрели, как найти и удалить дубли страниц онлайн при помощи инструментов, предоставленных поисковой системой.

Заключение

Как видите, возможностей и способов найти и удалить дубли страниц онлайн на сайте в WordPress существует много. Конкретный выбор инструментов зависит от особенностей интернет-ресурса и предпочтений веб-мастера.

Наиболее удобные возможности для выявления и удаления дублей страниц, имеются в функционале профессиональных конструкторов сайтов, где действительно можно решить проблему дублей «одним кликом».

А на этом я буду закруглятся. А вы как ищите и удаляете дубли страниц у себя на сайте? Напишите своё решение проблемы в комментариях. И конечно, если хотите быть профессиональным веб-мастером, обязательно подпишитесь на обновление моего блога. До встречи, друзья.

И конечно, если хотите быть профессиональным веб-мастером, обязательно подпишитесь на обновление моего блога. До встречи, друзья.

Бала ли вам статья полезной? |

Дубли страниц на сайте — как их найти и удалить? Онлайн поиск без помощи Яндекс Вебмастер

Январь 29, 2018

Основы SEO Инструкции к Labrika Негативные факторы

Что такое дубли страниц?

Дубли страниц на сайте — это грубая SEO-ошибка, которая характеризуется тем, что контент одной страницы полностью идентичен содержанию другой. Таким образом, они в точности копируют друг друга, но при этом доступны по разным URL-адресам. Это затрудняет индексирование страниц.

Самые частые причины возникновения дублей:

Не сделан редирект flhtcjd страниц, имеющих адреса с www и без www. В этом случае каждая страница сайта будет дублироваться, так как остается доступной по двум адресам, например:

http://www. site.ru/page и http://site.ru/page - полные дубли

site.ru/page и http://site.ru/page - полные дублиСтраницы сайта доступны по адресу со слэшем и без слэша:

http://site.ru/page/ и http://site.ru/pageТакже URL страницы может быть с .php и .html на конце либо без расширения. Как правило, это связано с особенностями cms (административной панели сайта):

http://site.ru/page.html и http://site.ru/page; http://site.ru/page.php и http://site.ru/page- Отдельно стоит выделить неполные дубли страниц. В этом случае контент на двух разных страницах не будет идентичным на 100%. Сходство и дублирование может появляться по причине того, что некоторые блоки на сайте являются сквозными — например, это может быть блок о доставке, который отображается на страницах всех товаров.

- Некоторые карточки интернет магазина со схожими товарами содержат идентичное описание, что также может рассматриваться как грубая ошибка.

- Постраничная пагинация каталога с товарами.

В этом случае текст и МЕТА-теги на всех страницах одной категории могут быть одинаковыми.

В этом случае текст и МЕТА-теги на всех страницах одной категории могут быть одинаковыми.

Как дубли влияют на ранжирование?

Дубли негативно влияют на ранжирование вашего сайта в выдаче — за наличие полных дубликатов страниц интернет-ресурс может с большой степенью вероятности подвергнуться пессимизации со стороны поисковых систем.

- Яндекс и Google очень трепетно относятся к уникальности контента на web-ресурсах. В случае, если данные на страницах дублируются, они признаются неуникальными. За это на сайт могут быть наложены санкции.

- Наличие большого количества дублей страниц сильно усложняет процесс индексации сайта и запутывает поисковых роботов.

- Затрудняется продвижение посадочных страниц, так как поисковая система не может выбрать релевантную страницу из двух одинаковых.

- Теряется «вес» страниц, поскольку распределяется между двумя одинаковыми документами.

Подробно описывается негативное влияние дублей и методы борьбы с ними в статье Google «Консолидация повторяющихся URL»

Яндекс, в свою очередь, предлагает на эту тему видеоурок «Поисковая оптимизация сайта: ищем дубли страниц», где разъясняется терминология и способы решения проблемы.

Как обнаружить дубли у себя на сайте?

С поиском дублей могут возникнуть трудности не только у обладателей больших web-ресурсов, но и у владельцев совсем небольших сайтов, так как некоторые дубли, возникающие из-за особенностей и ошибок CMS, очень сложно обнаружить. Быстро и без лишних трудозатрат найти дубли страниц можно с помощью онлайн сервиса Labrika. Для этого нужно просто провести анализ вашего проекта и получить отчет с результатами проверки. соответствующий отчет. Находится он в подразделе «Похожие страницы» раздела «SEO-аудит» в левом боковом меню:

В отчете вы можете увидеть следующую информацию:

- Страница сайта, которая имеет дубль.

- Дубль этой страницы

- Процент схожести страниц. Благодаря этому проценту вы сможете определить, является ли дубль страницы полным.

Получив данные из отчета, вы сможете сэкономить время и сразу начать устранять эти ошибки.

Как устранить дубли на сайте?

Важно в первую очередь установить характер дубля и уже после этого выбирать способ его устранения.

- Если копий на сайте небольшое количество и их происхождение связано с ошибками CMS (допустим, страница доступна по адресам

http://site.ru/category/tovarиhttp://site.ru/tovar, то самым простым методом решения проблемы будет следующий. Дубль необходимо запретить для индексации поисковых систем вручную в файле robots.txt помощью директивы Disallow, или указать информацию о каноничных страницах с помощью rel canonical (также см. информацию о robots.txt от Google). Затем воспользоваться формой удаления URL из индекса в Яндекс.Вебмастер — https://webmaster.yandex.ru/tools/del-url/ и инструментом аналогичного назначения в Google Search Console — https://www.google.com/webmasters/tools/url-removal. Подробнее про использование инструмента от Google вы можете прочитать здесь. - Если появление дубликатов носит системный характер и связано с такими ошибками, как, например, несклеенный домен (страница доступна по адресу с www и без www), то в таком случае необходимо выбрать главное зеркало (например, адрес сайта без www), воспользоваться командой 301 redirect (перенаправление со страниц с www на страницы без них), которая прописывается в специальном файле htaccess.

- В случае, если вы имеете дело с постраничной пагинацией товаров одной категории, Яндекс советует использовать атрибут rel=»canonical». Более подробно о применении этого атрибута на страницах с пагинацией вы можете прочитать в статье Блога Яндекс «Несколько советов интернет-магазинам по настройкам индексирования».

Читать дальше подобные статьи

- Канонические URL. Руководство по использованию атрибута rel = Canonical

- Как правильно использовать атрибут rel=»canonical»? Канонические страницы на сайте

- Настроить редирект

- Как настроить страницу с ошибкой 404?

- Релевантность. Карта релевантных страниц

Online SEO-инструменты для продвижения сайтов

Проверьте свой сайт и сайты конкурентов на 205 факторов поисковых систем.

Как проверить дубли страниц на сайте

Дубли страниц на сайте могут возникать автоматически, а могут появляться из-за человеческого фактора. В любом случае дубль негативно сказывается на ранжировании сайта. Поэтому важно на моменте разработки убедиться, что дублей нет, или настроить имеющиеся так, чтобы они не индексировались как отдельные страницы с таким же контентом. В статье рассказываем, как это сделать.

Что такое дубли страниц и какие они могут быть

Дубли страниц — это любые страницы сайта, которые по содержанию копируют другую. Например, если вы заходите на страницу товара в интернет-магазине, но выбираете иной цвет одежды, и вас перенаправляют на другую страницу. Сами урлы изменяются незначительно — у них меняется набор символов. Также изображения разные, хоть товар один и тот же, но разного цвета. Текст к товару идентичен, но он скрыт от пользователя, пока он его не откроет.

Вот так выглядит это в реальности — товар магазина Sela разных цветов:

По сути, страницы одинаковые, и они дублирующиеся. Если бы вебмастер не позаботился о сокрытии текста, изменении картинок, то тогда эти страницы были бы неявными дублями. То есть это дубли, но их отредактировали так, чтобы для роботов они выглядели уникально.

Если бы вебмастер не позаботился о сокрытии текста, изменении картинок, то тогда эти страницы были бы неявными дублями. То есть это дубли, но их отредактировали так, чтобы для роботов они выглядели уникально.

И подобных примеров много — давайте разберем самые частые из них:

- страница доступна под разными протоколами — есть страница для https:/ и для http:/;

- страница для www и без www — то есть пользователь попадает по этим адресам на одну страницу, но их всего две;

- со слешем и без слеша — если к урлу добавить слеш, откроется та же самая страница, но это будет дубль;

- один товар доступен по разным адресам — например, в одном урле есть название товара, в другом к нему добавили и название категории, но при этом открывается один и тот же товар;

- страницы с GET-параметрами — это когда есть один вариант урла страницы, а также такая же страница по адресу типа www.что-то.ru/news?hfkznsm;

- страницы версии для печати тоже копируют контент и доступны по тому же адресу, что и оригинал.

Это основные виды явных дублей, но они могут быть и неявными. Например, если в разделе статей вы открываете доступ к комментариям. И каждый новый комментарий или ответ на него доступен почти по такому же адресу, что и страницы со статьей, но с добавлением номера или GET-параметров.

Типичный пример — это dtf, где часто можно увидеть древовидные комментарии. Также дублями могут быть страницы одного товара, которые доступны по разным адресам. Под это подходит наш пример с одеждой в Sela — если бы не настройка вебмастера, то страницы с разными цветами товаров дублировали бы оригинал. Другой вариант — это страницы пагинации, когда перечисляют пул товаров. И каждая последующая страница немного меняет свой урл — появляется дополнение в виде порядкового номера или категории товара. Но их контент остается неизменным.

Причины появления дублей — это ошибка вебмастера, автоматическое появление в зависимости от движка, ошибки в директивах robot. txt или при настройке редиректов. Поэтому пока вы находитесь на этапе разработки сайта, важно проверить все эти причины.

txt или при настройке редиректов. Поэтому пока вы находитесь на этапе разработки сайта, важно проверить все эти причины.

Почему нужно работать с дублями страниц

Хоть и стало понятней, почему эти дубли появляются, до сих неясно, зачем от них избавляться. Давайте рассмотрим, почему дубли негативно влияют на сайт.

- Поисковик индексирует страницу-оригинал неправильно — предположим, что у вас два урла, которые приводят пользователя на одну страницу. Вы продвигаете один из них, и все вроде хорошо. Но потом поисковик находит дубль и индексирует его, но этот урл не продвигается, поэтому и охватов получает меньше.

- Индексация длится слишком долго — как правило, поисковый робот индексирует страницы сайта не так долго. Но если дублей много, индексация идет дольше — поисковик просто не успевает за определенное время добраться до вашего контента.

- Ограничения со стороны поисковой системы — хоть дубли не нарушают никаких правил, поисковый робот может подумать, что вы специально их создаете.

Тогда органическое продвижение сайта замедляется. Это происходит, если у вас есть дубли, и вы с ними ничего не делаете.

Тогда органическое продвижение сайта замедляется. Это происходит, если у вас есть дубли, и вы с ними ничего не делаете. - Сложности в устранении — когда с дублями не работают, со временем их число может расти. Тогда-то и придется на их устранение потратить огромное время и ресурсы.

То есть основная причина в том, что дубли проблемны, — это плохое ранжирование сайта поисковой системой.

Как выявить дубли страниц сайта

Чтобы выявить дубль страницы, необязательно вручную сидеть и искать их — это довольно энергозатратно и долго. Но такой вариант все равно присутствует, если вы знаете, как искать и не можете использовать другие способы. Если не знаете, мы на всякий случай подскажем — достаточно в поисковую строку ввести команду «site: {домен} inurl1: {часть урла}». Вместо части урла нужно указать тот, по которому, вероятно, есть дубль. Например, если это GET-параметры, то можно попробовать ввести знак вопроса — именно по такой логике создаются урлы GET-параметров. Или введите слово page и номер — подойдет для поиска страниц пагинации.

Или введите слово page и номер — подойдет для поиска страниц пагинации.

Есть вероятность, что вы просто не введете нужную часть урла. То есть дубль создается нетипичный — это будет просто набор рандомных цифр или слов. В этих ситуациях можно использовать другие способы поиска дублей — всего их три.

Через Яндекс.Вебмастер. Обычно в первую очередь дубли находит именно поисковый робот, и он может об этом сообщить. Достаточно зайти в Яндекс.Вебмастер и пройти в раздел диагностики сайта. Всю информацию по ошибкам система загрузит в раздел Индексирования, «Страницы в поиске» — чтобы вся информация была перед глазами во время работы, можно загрузить таблицу с урлами в формате XLS или CSV.

Google Search Console. В вебмастере Google тоже можно искать дубли — это необходимо, ведь та информация, что вы нашли в Яндекс. Вебмастере касается только поисковика Яндекса. Чтобы узнать о дублях, которые отображаются в Google, нужна Google Search Console — просто зайдите в раздел «Вид в поиске» и потом «Оптимизация HTML». Там и покажут все дубли страниц по заголовкам и мета-описаниям, а также битые ссылки.

Вебмастере касается только поисковика Яндекса. Чтобы узнать о дублях, которые отображаются в Google, нужна Google Search Console — просто зайдите в раздел «Вид в поиске» и потом «Оптимизация HTML». Там и покажут все дубли страниц по заголовкам и мета-описаниям, а также битые ссылки.

Бесплатный митап для арбитражников в Москве! Регистрируйся и успевай забрать билет!

Использовать парсеры или программы. Можно автоматизировать процесс поиска — даже если вы загружаете таблицу через Вебмастер, искать-то придется все равно вручную, хоть и в списке. Поэтому можно использовать различные парсеры и программы, которые полностью автоматизируют процесс.

PromoPult — позволяет анализировать все данные урлов из Вебмастера. Мы уже сказали, что придется самостоятельно идти по списку таблицы и проверять дубли. Чтобы этого не делать, можно загрузить готовую таблицу в PromoPult и начать поиск дублей. Также сервис позволяет проанализировать данные не только из Яндекса, но из Google — это поможет понять, какие урлы дублируются и в каких поисковых системах. Так легче и подобрать сам способ настройки этих страниц. Кроме того, на сервисе можно и заказать услугу по аудиту сайта от специалистов — они сами подобьют информацию по дублям и в целом по оптимизации.

Так легче и подобрать сам способ настройки этих страниц. Кроме того, на сервисе можно и заказать услугу по аудиту сайта от специалистов — они сами подобьют информацию по дублям и в целом по оптимизации.

Овнеры магазинов ФБ акков про свой бизнес и тренды в арбитраже. ФБ аккаунты для арбитража трафика

Apollon — это полноценный онлайн-парсер, который быстро и бесплатно найдет все дублированные страницы. Можно выгрузить таблицу с Вебмастера, скопировать до пяти ссылок оттуда и вставить в поле на сайте. После обработки запроса перед вами откроется таблица со страницами и адресами. Если адрес один и тот же, то вы нашли дубль — осталось решить, что с ним делать.

Seoto — сервис находит все ошибки, которые мешают продвижению сайта. В их числе не только дубли страниц, но и поиск всех битых ссылок, анализ структуры на всех страницах сайта, расчет веса страниц, а также анализ данных из Вебмастера. То есть платформа дает пул инструментов, которые смогут решить ваши проблемы с оптимизацией и улучшить сайт визуально и технически.

То есть платформа дает пул инструментов, которые смогут решить ваши проблемы с оптимизацией и улучшить сайт визуально и технически.

Siteliner — бесплатный онлайн-сервис, который помогает найти быстро все битые ссылки и дублированные страницы. Но есть ограничение — бесплатно только до 250 страниц.

ScreamingFrog — это программа для компьютера, которая является частично бесплатно. Некоторые про-функции нужно оплачивать. Принцип работы программы простой — достаточно вбить нужный сайт и начать его анализ. Если ваш сайт действительно большой или у вас несколько сайтов, то понадобится про-версия — утилита может сканировать бесплатно только до 500 ссылок.

Xenu — это полностью бесплатная программа, причем она анализирует сайты, которые Яндекс еще не проиндексировал. Даже если создать сайт и сразу же проверить его через программу, она все равно соберет все ошибки и дубли страниц — то есть не нужны данные из инструментов вебмастеров. Весь поиск дублей происходит через мета-описания и заголовки страниц.

Весь поиск дублей происходит через мета-описания и заголовки страниц.

Как избавиться от неявных и явных дублей

Мы выяснили, как можно обнаружить все дубли страниц. Теперь давайте разбираться, что с ними делать. Скажем сразу — это зависит от вида вашего дубля.

Если проблема возникла из-за наличия или отсутствия слешей в урле. В этом случае можно настроить редирект 301 — он будет перенаправлять юзеров с дубля на целевую страницу. Стандартную команду нужно добавить в файл .htaccess — в ней будет такое содержание:

Redirect 301 /урл, с которого идет перенаправление

http://доменное имя/новый урл, на который нужно перенаправить

Если нужно сделать редирект с домена без WWW на домен с WWW. Для этого также используют редирект 301 — только нужно ввести следующую команду для протокола http:

Успей зарегистрироваться на бесплатный митап в Москве от Партнеркина! Тебя ждут нетворкинг, крутейшие спикеры и подарки от спонсоров 🔥

RewriteCond %{HTTP_HOST} ^домен\. (.*)$ http://домен.ru/$1

(.*)$ http://домен.ru/$1

[R=301, L]

Запрет на индексацию дублей в файле robot.txt. Способ самый простой — нужно просто запретить индексирование страницы-дубля для поискового робота, чтобы он игнорировал адрес. Для этого в файл нужно добавить следующее содержание:

User-agent: __

Disallow: /ваш урл, который не нужно индексировать

Если у вас несколько страниц с товарами, то есть страницы пагинации. В таком случае можно в коде обозначить каноническую страницу — то есть «материнскую». Для этого в коде канонической страницы вбиваем в теге & It;link& + rel=canonical href=href=”адрес канонической страницы”>адрес канонической страницы/>. Теперь все дочерние страницы будут ссылаться на каноническую — они не будут считаться дублями.

Чтобы не индексировать страницу и не переходить/переходить по ссылкам. Для этой команды можно ввести специальный мета-тег на страницу-дубль. Если ввести мета-тег & It;meta name=robots content=noindex, nofollow& qt, тогда робот не будет индексировать страницу и допускать переход по ссылкам на нее. Если ввести мета-тег & It;meta name=robots content=noindex, follow& qt, то страница не будет индексироваться, однако перейти на нее будет возможность.

Для этой команды можно ввести специальный мета-тег на страницу-дубль. Если ввести мета-тег & It;meta name=robots content=noindex, nofollow& qt, тогда робот не будет индексировать страницу и допускать переход по ссылкам на нее. Если ввести мета-тег & It;meta name=robots content=noindex, follow& qt, то страница не будет индексироваться, однако перейти на нее будет возможность.

О чем важно помнить после всех настроек и проверок

Если вы исправили проблему с дублями, и кажется, что все хорошо — все равно убедитесь в этом. Хорошо, если вы специалист и можете самостоятельно выявлять проблемы с оптимизацией. Тогда достаточно сделать повторную проверку сайта.

Но если вы еще новичок или просто делали сайт по заказу, и сейчас вам необходима профессиональная помощь, то проще всего прогнать сайт через сервисы и программы проверок и анализа. В других случаях — можно заказать аудит от специалиста. В этом больше преимуществ, ведь вебмастер сможет полностью и точно проанализировать настройки и оптимизацию, а также исправить проблемы.

В этом больше преимуществ, ведь вебмастер сможет полностью и точно проанализировать настройки и оптимизацию, а также исправить проблемы.

Главное правило — проверять эти данные регулярно, ведь может быть так, что движок сам будет создавать дубли страниц, а вы о них даже не узнаете. Зато пропадет органический трафик.

Какие еще могут быть проблемы с технической оптимизацией сайта

Дубли влияют на ранжирование сайта, но они — не единственная возможная проблема. Мы разберем еще несколько ошибок, которые могут влиять на продвижение в поисковике:

- Отсутствие файла robot.txt — это частая проблема среди новичков. Если у сайта нет этого файла, то возникают проблемы с индексацией — поисковый робот просто не видит этого файла и проверяет все страницы подряд, в том числе и служебные. Поэтому важно проверить наличие этого файла — просто введите в поисковую строку домен/robot.txt. Если страница открылась, то файл в наличии.

- Нет страницы 404 — это страница, которая всплывает у пользователя при проблемах с вводом домена. Смысл этой страницы в том, что она перенаправляет пользователя на каноническую. Так трафик теряется меньше. Если страницы ошибки нет, то пользователь может просто покинуть ресурс.

Знаешь, кто делает лучшие митапы для арбитражников? Партнеркин! Успей забрать свой бесплатный билет!

- Отсутствие микроразметки — эта деталь необязательна, но она вызывает больше доверия у робота. Кроме того, это позволяет делать прикольные сниппеты в соцсетях, а также органично смотреться в поиске. Например, для многих рецептов делают микроразметки — при их поиске робот выбивает микроразметку с началом рецепта в отдельный блок, что привлекает внимание пользователей лучше.

- Проблемы с прогрузкой сайта — не секрет, что сайты иногда получаются очень тяжелыми. Из-за габаритности они дольше грузятся и могут погружаться некорректно.

Лучше заранее это проверить через сервисы вроде Google Pagespeed Insights и увеличить скорость.

Лучше заранее это проверить через сервисы вроде Google Pagespeed Insights и увеличить скорость. - Отсутствие протокола HTTPS — большинство пользователей уверены, что этот протокол равно безопасный сайт. Поэтому можно потерять часть трафика, если его не добавить — в браузерной строке просто не будет пометки безопасности, и пользователи могут отсеяться.

Вывод

Дубли страниц — не критично, но важно о них позаботиться, чтобы с ранжированием не было проблем. Для поиска дублей можно использовать различные сервисы и программы — о них рассказали в статье. Способы решения проблемы зависят от того, что это за дубль, — иногда достаточно настроить редирект, но в других случаях лучше просто запретить роботу считывать и индексировать страницу. После решения проблемы с дублями страниц проверяйте их появление регулярно, а также заботьтесь в целом о качестве оптимизации.

А вам приходилось работать с дублями?

0 голосов

Нет Да, надоело уже

Как проверить большое количество веб-страниц на наличие дублирующегося контента

Проверка веб-страниц на дублированный контент — один из важнейших этапов технического аудита веб-сайта. Чем больше у вас дубликатов страниц, тем хуже SEO-показатели вашего веб-ресурса. Вы должны избавиться от повторяющегося контента, чтобы оптимизировать краулинговый бюджет и улучшить рейтинг в поисковых системах. Если вы хотите, чтобы ваш сайт процветал, вы должны свести к минимуму количество дубликатов страниц.

Чем больше у вас дубликатов страниц, тем хуже SEO-показатели вашего веб-ресурса. Вы должны избавиться от повторяющегося контента, чтобы оптимизировать краулинговый бюджет и улучшить рейтинг в поисковых системах. Если вы хотите, чтобы ваш сайт процветал, вы должны свести к минимуму количество дубликатов страниц.

Множество онлайн-проверок на плагиат позволяют проверить уникальность текста в пределах одной веб-страницы. Однако существует не так много инструментов для одновременной проверки нескольких URL-адресов на наличие дублирующегося контента. Однако это не означает, что проблема менее важна. Из-за этого рейтинг вашего сайта может сильно пострадать!

Распространенные проблемы, связанные с дублированием контента

1. Один и тот же контент появляется более чем на одном веб-адресе.

Обычно это страница с параметрами и SEF URL (удобный для поисковых систем URL) той же страницы.

- Пример:

- https://some-site.com/index.

php?page=contacts

php?page=contacts - https://some-site.com/contacts/

- https://some-site.com/index.

Это довольно распространенная проблема. Бывает, что вебмастера забывают настроить 301 редиректы со страниц с параметрами на SEF URL.

Эту проблему можно легко решить с помощью любого поискового робота. Он может сравнивать все страницы сайта и определять два URL-адреса с одинаковыми хеш-кодами (MD5). Как только это произойдет, вам нужно будет только настроить правильное перенаправление 301 на URL-адрес SEF.

Однако иногда дублированный контент может вызвать гораздо больше проблем.

2. Почти дублированный контент.

Страницы с большим количеством перекрывающихся данных называются «почти дублирующимся содержимым» или «общим содержимым».

Пример 1

Год назад копирайтер разместил в новостном разделе интернет-магазина поздравление с Международным женским днем. Он написал 500-символьный пост о скидке 15%.

В этом году контент-менеджер просто повторно использовал этот пост вместо того, чтобы писать новый с нуля. Он лишь изменил скидку с 15% на 12% и добавил в поздравление дополнительные 50 символов.

Он лишь изменил скидку с 15% на 12% и добавил в поздравление дополнительные 50 символов.

В итоге на сайте есть две почти дублирующиеся страницы, которые идентичны на 90%. Оба они должны быть переписаны для улучшения SEO.

Несмотря на то, что эти страницы на 90% идентичны, инструменты технического аудита сочтут их разными, поскольку их URL-адреса SEF будут иметь разные контрольные суммы.

В результате трудно сказать, какая из двух веб-страниц будет ранжироваться лучше.

Однако новости очень быстро устаревают. Давайте рассмотрим куда более интересный пример.

Пример 2

Допустим, у вас есть веб-сайт или блог о еде (или любом другом увлечении, которое вас интересует).