Что такое индексация сайта и как проиндексировать свой сайт в поисковых системах?

Что такое индексация и как проходит этот процесс в поисковых системах

Любой сайт — будь то корпоративный блог или магазин в e-commerce — проходит несколько важных этапов «рождения». После создания и первичного наполнения контентом, важно проиндексировать сайт поисковыми системами (далее — ПС). Как это происходит:

-

Роботы ПС «видят», что создан новый сайт (или страница).

-

Планируют его «осмотр».

-

Запрашивают контент сайта и анализирует его по ряду параметров.

-

Если все соответствует требованиям — сайт/страница попадает в индекс (своего рода «реестр» ПС), и включается в поисковую выдачу.

Когда пользователь вводит в поисковике запрос, сервис сверяет его с проиндексированными данными и выдает максимально релевантные страницы. Но если при индексации сайта были обнаружены проблемы (ошибки, низкая уникальность текстов, и др.) — ПС могут наложить

Но если при индексации сайта были обнаружены проблемы (ошибки, низкая уникальность текстов, и др.) — ПС могут наложить

Технологии и алгоритмы индексации сайтов в поисковиках

Технология индексации сайта в Google

Google и Яндекс могут проиндексировать сайты по-разному. У Google действует правило «Mobile-first»: поисковые роботы (краулеры) рассматривают именно мобильную версию сайта и присваивают ей индекс. Поэтому если она проигрывает десктопной, содержит ошибки или не обладает полным функционалом — на нее могут быть наложены ограничения.

На частоту проверки сайта краулерами и на индексацию сайта в Гугл влияет так называемый «краулинговый бюджет»: чем он больше — тем чаще и быстрее проверяют сайт. Считается, что возраст сайта и частота обновления контента положительно влияют на размер «краулингового бюджета».

Технология индексации сайта в Яндекс

Яндекс принимает за основную десктопную версию сайта, проверяет и индексирует именно ее.

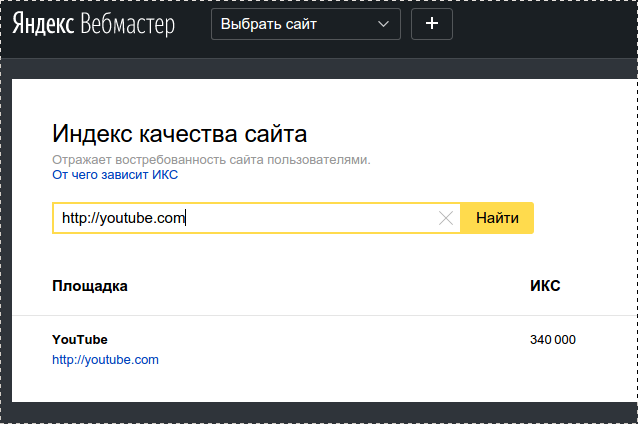

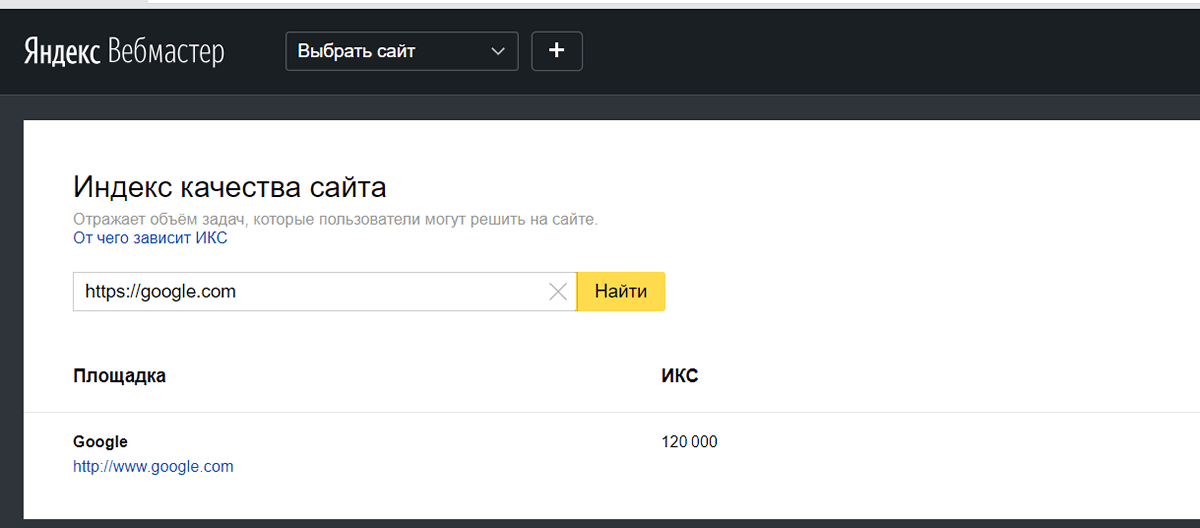

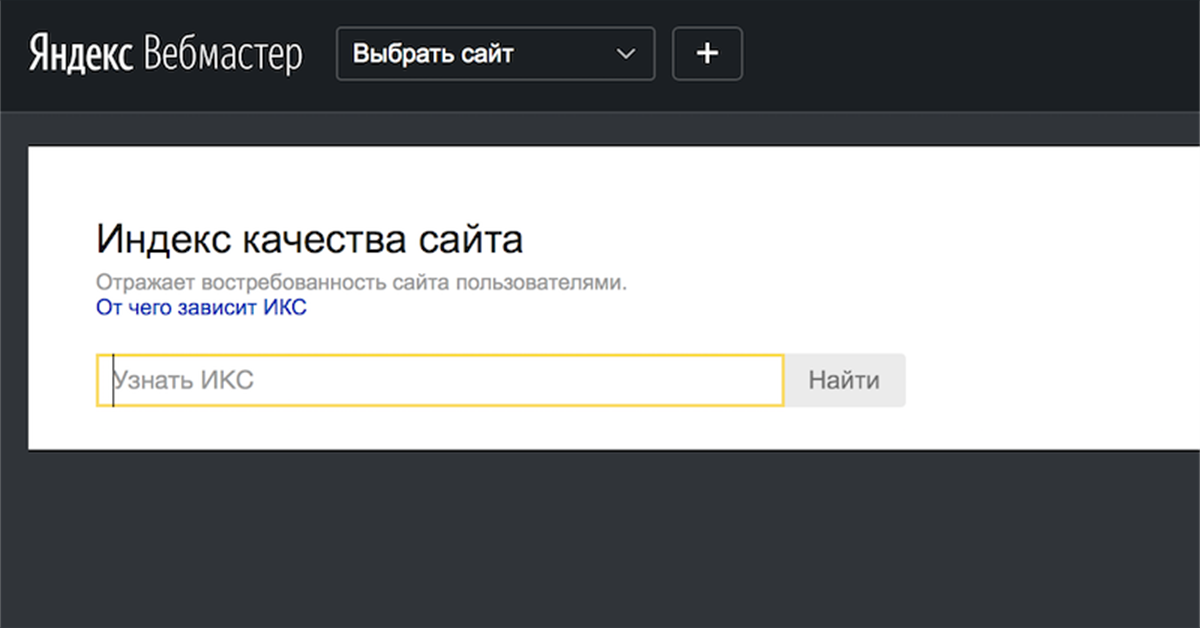

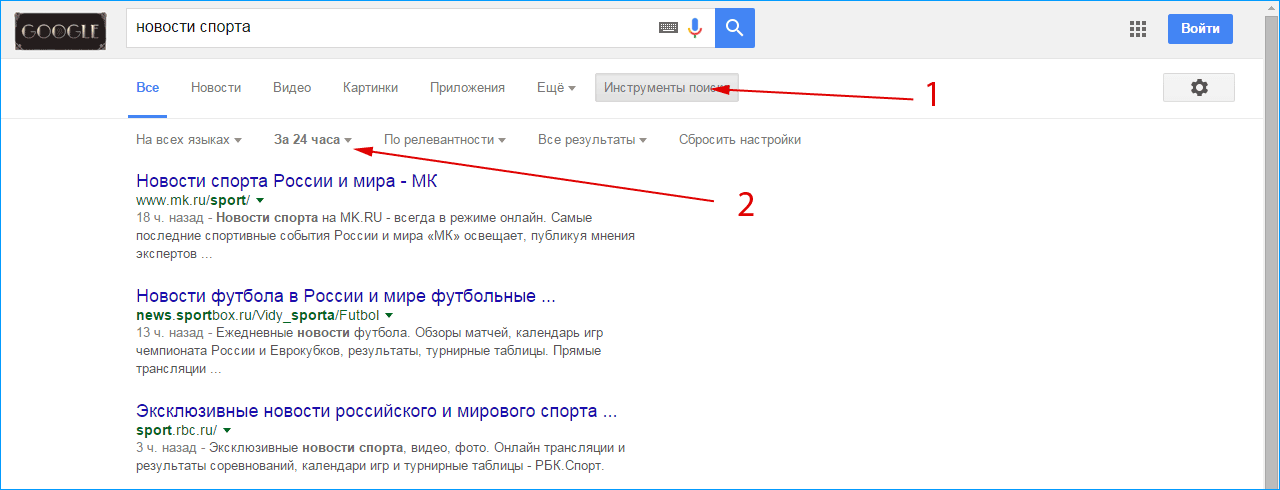

Как проверить индексацию сайта?

Существует несколько способов проверить индексацию страниц вашего сайта:

-

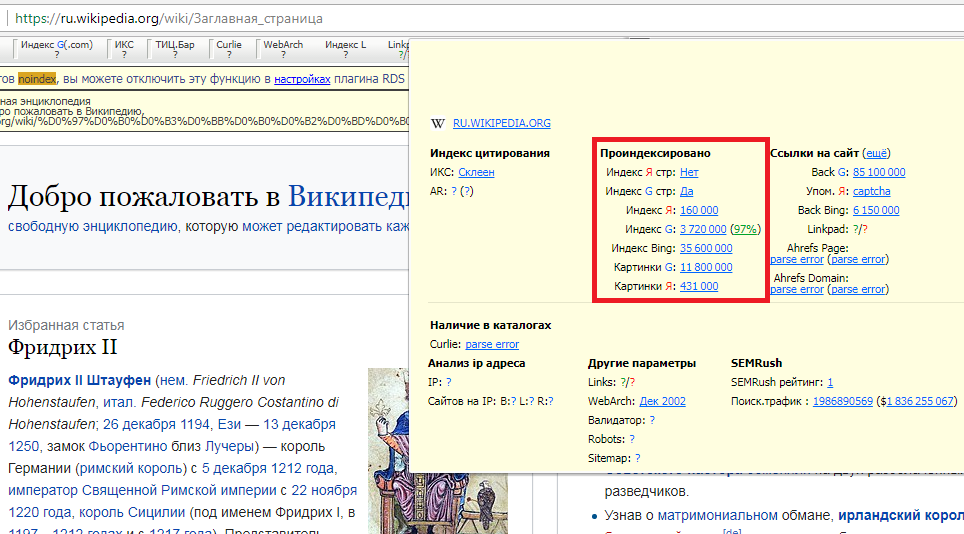

С помощью плагинов проверки (SEO Magic, RDS bar и др.). Их преимущество — не нужно заходить каждый раз в ПС и вводить запрос, они работают в автоматическом режиме.

-

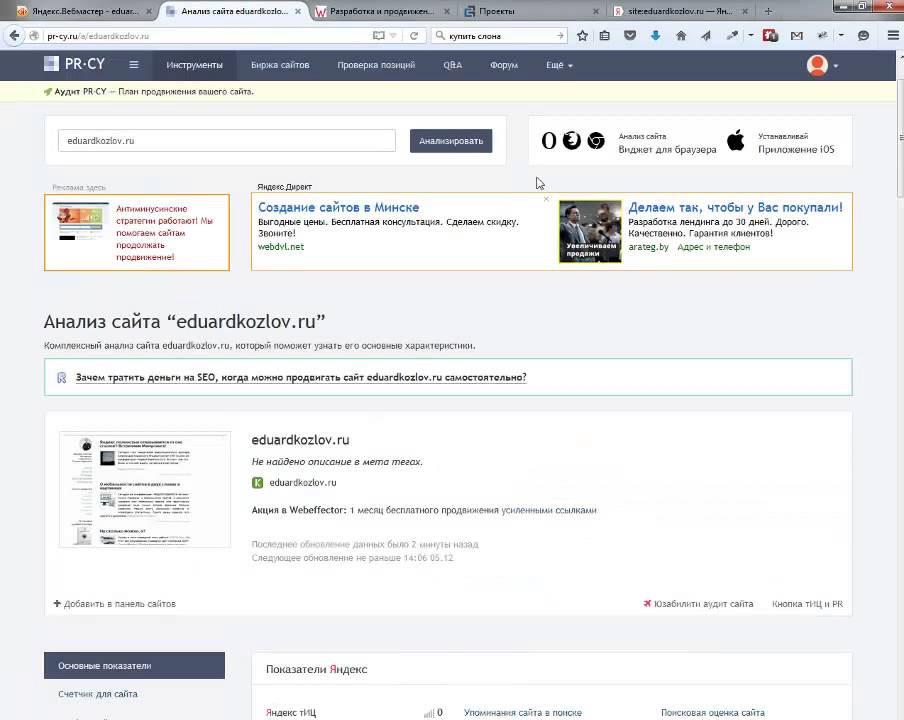

Через специальные сайты-сервисы проверок: Netpeak Spider, Screaming Frog Seo Spider, Se Ranking, arsenkin.ru, serphunt.ru, raskruty.ru и др.

Факторы индексирования и их влияние на поисковые системы

На индексирование страниц и контента вашего сайта влияют несколько факторов:

-

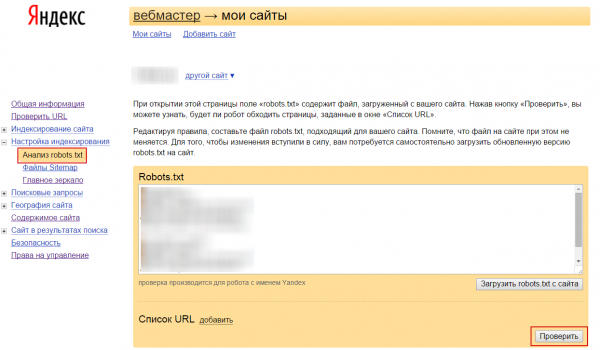

Файл robots.

txt. В нем содержатся «подсказки» для краулеров: какие страницы на сайте можно индексировать, а какие — нет. Влияние на индексацию этого файла зависит от типа ПС, но основные — Google и Яндекс, его все же учитывают.

txt. В нем содержатся «подсказки» для краулеров: какие страницы на сайте можно индексировать, а какие — нет. Влияние на индексацию этого файла зависит от типа ПС, но основные — Google и Яндекс, его все же учитывают.

-

Метатег <meta name=“robots” содержит (и при желании — позволяет настроить) команды для поисковых роботов, указывая им как лучше проиндексировать страницы.

-

В серверном программном обеспечении сайта можно добавить в заголовки X-Robots-Tag HTTP-ответы, содержащие настройки, указанные в файлах .htaccess и httpd.conf. Прописанные в них команды будут выполняться всеми краулерами.

-

Тег <noindex> запрещает индексировать определенный контент — например, текст, при помощи пары тегов <noindex>…</noindex> (работает только для поисковой системы Яндекс).

-

Вывод контента Ajax.

Если версия, отображаемая для пользователей, отличается от того, что находится в сохраненной копии, при этом в текстовой версии или коде сохраненной копии отсутствует контент, то это первый признак, что контент страницы может не индексироваться роботами ПС.

Если версия, отображаемая для пользователей, отличается от того, что находится в сохраненной копии, при этом в текстовой версии или коде сохраненной копии отсутствует контент, то это первый признак, что контент страницы может не индексироваться роботами ПС.

Что делать, если сайт не индексируется?

Если ваш интернет-сайт не индексируется продолжительное время — возможно, существуют проблемы с оптимизацией и стоит проверить некоторые аспекты:

1) Не закрыт ли сайт для индексации через:

- файл Robots.txt,

- в файлах .htaccess и httpd.conf.,

- X-robots-tag.

2) Если в указанных местах доступ не закрыт — стоит проверить, нет ли ошибок в теге rel canonical.

3) Проблемы могут возникать и на хостинге (например, слишком долгое время ответа сервера, или сервер дает неверный ответ на запрос ПС).

4) На сайте содержится неуникальный или контент низкого качества.

И только после проверки всех этих факторов можно искать причины в неверной работе самих ПС. Редко, но иногда сбои происходят именно на стороне поисковиков, но такая информация, как правило, быстро становится общедоступной.

Как ускорить индексацию сайта

Что можно предпринять для более быстрой индексации сайта поисковыми системами? Способов много, перечислим самые очевидные и действенные.

-

Установите автоматическое обновление карты сайта (sitemap). Особенно, если вам нужно быстро проиндексировать страницу в Google — эта ПС обращается к карте в первую очередь, в отличие от Яндекса, которая вначале «смотрит» на файл robots.txt. Все новые страницы должны тут же заноситься в карту сайта.

-

Тщательно проверьте страницы и размещенный контент. Сайт не должен содержать дубли страниц и контент с низким процентом уникальности.

Эти аспекты «воруют» краулинговый бюджет, в результате чего роботы ПС могут просто не добраться до новых страниц, которым нужно индексироваться.

Эти аспекты «воруют» краулинговый бюджет, в результате чего роботы ПС могут просто не добраться до новых страниц, которым нужно индексироваться.

-

Проверьте, нет ли на сайте битых ссылок и каково количество внутренних редиректов. От первых нужно избавиться вовсе, количество вторых — свести к минимуму. Каждый из них также расходует бюджет поисковых роботов.

-

Еще раз проверьте, не закрыты ли добавленные страницы для индексации через robots.txt. Это важно для их дальнейшего продвижения.

-

Проверьте скорость загрузки страниц сайта при помощи PageSpeed Insight. И время ответа сервера, и скорость загрузки отдельных страниц должны быть минимальными (сервис сам измеряет эти показатели и выдаст вам рекомендации по устранению технических недостатков).

-

Проверьте качество внутренней перелинковки.

Краулеры «путешествуют» по внутренним ссылкам так же, как и посетители, автоматически ускоряя скорость индексации страниц.

Краулеры «путешествуют» по внутренним ссылкам так же, как и посетители, автоматически ускоряя скорость индексации страниц.

- Выводите «превью» свежего контента на главную страницу — будь то текстовый материал или карточка с новым товаром. Так ваш контент окажется «на поверхности» сайта и будет быстрее замечен краулерами.

-

Следите за регулярностью обновления контента на сайте. Это относится не только к вновь публикуемым статьям, но и обновлению/корректировке старых.

|

Статью подготовил Сергей Лысенко, ведущий спикер Webcom Academy. |

Поделиться с друзьями:

10 способов заставить Google индексировать сайт

Содержание

- org/ListItem»>

Что такое индексирование сайта

- Как проверить, есть ли сайт в индексе Google

- Способы, как ускорить индексацию сайта в Google

- Отправьте сайт на проверку вручную

- Проверьте правила в robots.txt

- Проверьте карту сайта sitemap.xml org/ListItem»> Проверьте использование тега noindex

- Сделайте грамотную внутреннюю перелинковку сайта

- Получите качественные обратные ссылки

- Проработайте nofollow-ссылки

- Проверьте дубли и корректность использования атрибута rel=«canonical»

Базовый этап работы по SEO — это настройка индексации сайта, ведь без индексации ресурс не смогут увидеть пользователи. Грамотная индексация в дальнейшем позволит избежать проблемы с продвижением.

Что такое индексирование сайта

Индексация сайта в Google — сбор и внесение информации о контенте ресурса в базу поисковой системы. Ранее Google сначала проверял десктопную версию сайта, но с 2019 года индексация сайта в Гугл начинается с проверки мобильной версии.

к содержанию ↑

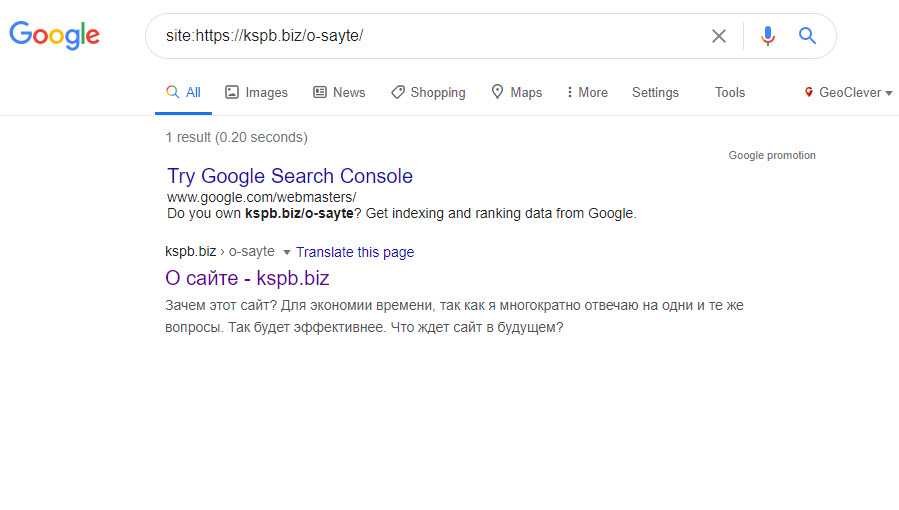

Как проверить, есть ли сайт в индексе Google

Если вам надо знать, как проверить индексацию страницы в Google, обратитесь к одному из этих способов:

1. Используйте операторы поиска Google.

2. Откройте инструмент проверки URL-адресов в Google Search Console.

к содержанию ↑

Способы, как ускорить индексацию сайта в Google

Сложно сказать, как долго Гугл индексирует новый сайт. Это зависит от скорости загрузки, количества страниц и краулингового бюджета. Но все же существует ряд способов, которые могут ускорить индексацию сайта в Google.

Это зависит от скорости загрузки, количества страниц и краулингового бюджета. Но все же существует ряд способов, которые могут ускорить индексацию сайта в Google.

Отправьте сайт на проверку вручную

Чтобы отправить сайт на индексацию в Гугл, необходимо:

- зайти в Google Search Console и найти инструмент проверки URL;

- ввести URL-адрес и подождать, пока Google его проверит;

- нажать на «Запросить индексирование».

Подобный способ больше подходит для новых страниц. Если вам необходимо понять, почему Google не индексирует сайт, либо вас интересует, как индексировать сайт в Гугл, когда ему уже несколько лет, присмотритесь к следующим способам.

к содержанию ↑

Проверьте правила в robots.txt

Просканируйте файл robots.txt на наличие блоков и запретов. Проблема может возникнуть из-за наличия правила «disallow». Если найдете подобные правила, значит Googlebot не сканирует и, соответственно, не индексирует страницу.

Для проверки откройте Google Search Console, найдите вкладку «Покрытие» и просканируйте robots.txt. Чтобы исправить ситуацию, достаточно удалить правило Disallow: / и снова отправить страницу на индексацию в Гугл.

к содержанию ↑

Проверьте карту сайта sitemap.xml

Sitemap распределяет и отображает важность страниц сайта. Быстро проверить наличие страниц в Sitemap вам поможет инструмент проверки URL в Search Console. Когда на экране появятся такие ошибки, вероятно страницы в карте сайта нет.

После того, как вы добавите необходимые страницы в файл sitemap.xml, не забудьте сообщить Google об обновлении.

к содержанию ↑

Проверьте использование тега noindex

Наличие тега в описании страницы не разрешает Googlebot индексировать ее. Чтобы проверить, если он на сайте, перейдите в контейнер <head>. Если там тег noindex присутствует рядом с тегом googlebot, тогда страница не индексируется в данной поисковой системе. Удалите теги, и страница снова будет доступна для индексации.

Удалите теги, и страница снова будет доступна для индексации.

к содержанию ↑

Сделайте грамотную внутреннюю перелинковку сайта

Она предусматривает проставление ссылок с одной страницы ресурса на другую. Внутренняя структура повышает юзабилити, помогает пользователю быстро ориентироваться. Грамотная внутренняя перелинковка обеспечит значительное увеличение скорости индексации новых материалов и их появление в списке поисковых систем.

к содержанию ↑

Получите качественные обратные ссылки

Наличие этих ссылок показывает Google, что страница, на которую они указывают, имеет вес. Такие ресурсы Google считает более важными, поэтому чаще их сканирует. Но в погоне за обратными ссылками важно размещаться только на качественных и авторитетных ресурсах.

Проработайте nofollow-ссылки

Иногда индексация сайтов в Google невозможна из-за тега rel=«nofollow». Для исправления просканируйте внутренние ссылки и удалите его в случае обнаружения.

к содержанию ↑

Проверьте дубли и корректность использования атрибута rel=«canonical»

Наличие дублированного контента может быть еще одной причиной медленной или нулевой индексации Google. Если страница дублируется или имеет содержание на 99% похожее на другую страницу, Google вряд ли проиндексирует ее.

Итак, убедитесь, что на сайте нет повторяющихся страниц. Если есть, то рекомендуется указать каноническую версию ресурса с помощью тега rel=«canonical» или же удалить такие страницы, поскольку Google будет считать их содержание неуникальным.

к содержанию ↑

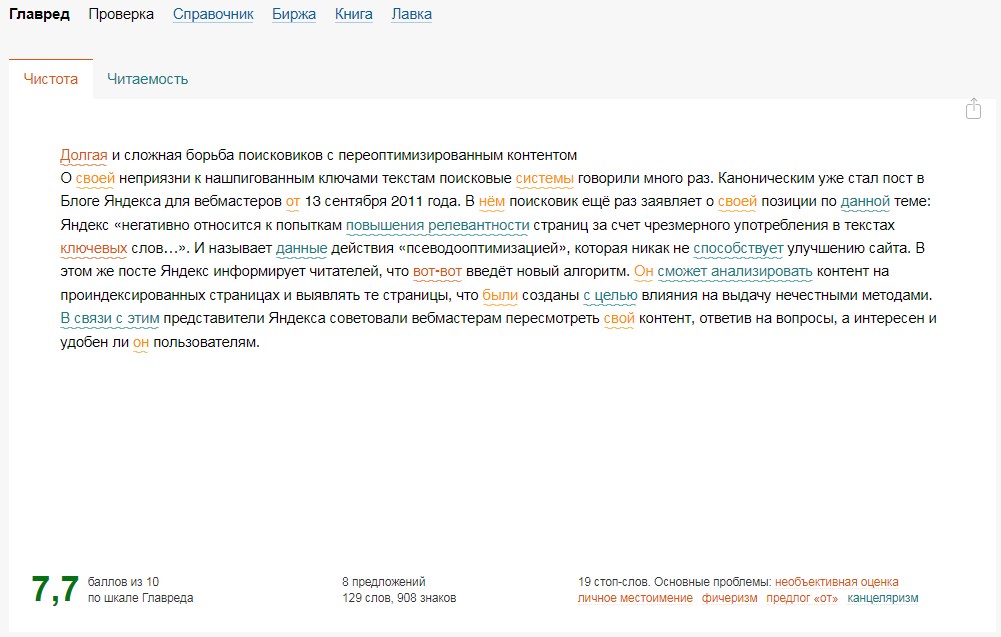

Пишите качественный и уникальный контент

Google не обращает внимание на страницы с неуникальным контентом. Поэтому если нет технических проблем, проблема может быть в содержании. Попробуйте взглянуть на контент глазами обычного человека, сделать его более интересным и полезным.

Проверьте наличие страниц-сирот

Страницы-сироты — это страницы, не связанные ни с одной другой страницей ресурса. Если SEO-аудит сайта выявил страницы-сироты, либо полностью уберите их из sitemap, либо добавьте, чтобы Google смог их индексировать.

Если SEO-аудит сайта выявил страницы-сироты, либо полностью уберите их из sitemap, либо добавьте, чтобы Google смог их индексировать.

Индексирование сайта значит, что поисковая система знает о ресурсе, но не факт, что он попадет в ТОП поисковой выдачи. Чтобы сайт получил ключевое место в выдаче, вам нужна SEO-оптимизация.

Специалисты digital-агентства Ланет CLICK осуществят проверку индексации сайта в Гугл, займутся SEO-продвижением, обеспечат грамотный линкбилдинг и качественный копирайтинг. С Ланет CLICK сайт не только будет индексироваться, но и попадет в ТОП поисковой выдачи.

Как проверить индексацию сайта в Google и что делать, если страниц нет в выдаче?

В начале оптимизации сайта важно проверить, какие страницы есть в индексе, а каких нет.

Количество проиндексированных страниц не отвечает фактическому? Давайте разберемся, почему и как это исправить.

Содержание:

Что такое индексация и зачем она нужна

Проверяем индексацию сайта в поисковой системе

Проверяем индексацию сайта с помощью Search Console

Подаем запрос на индексирование страницы в Google Search Console

Как подать на индексирование сразу много ссылок?

Отказ в индексировании: что делать?

Переиндексирование

Закрыть от индексирования

Выводы

Читайте также: Актуальные тренды SEO на 2022 год: 10 важных тенденций для улучшения поисковой оптимизации

Что такое индексация и зачем она нужна

Индексация сайта — это анализ содержимого страницы поисковой системой.

Индексирование страниц необходимо для включения их в результаты поиска.

Можно провести аналогию с картотекой, где хранится информация обо всех книгах в библиотеке. В нашем случае, картотека — это база данных «поисковой индекс», в которой поисковик ищет результаты по запросу пользователя.

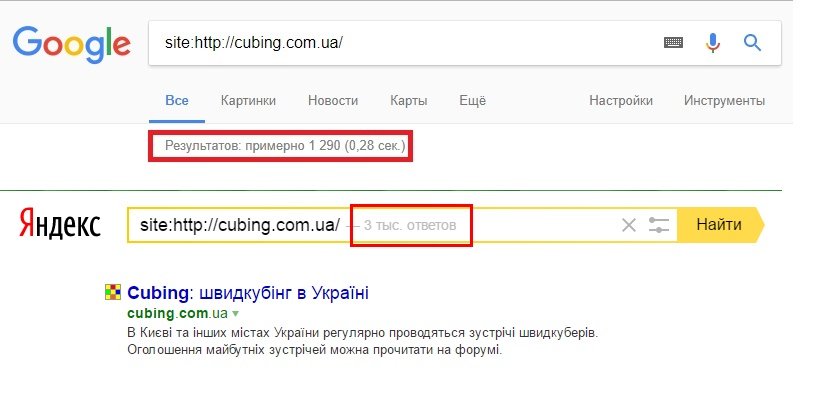

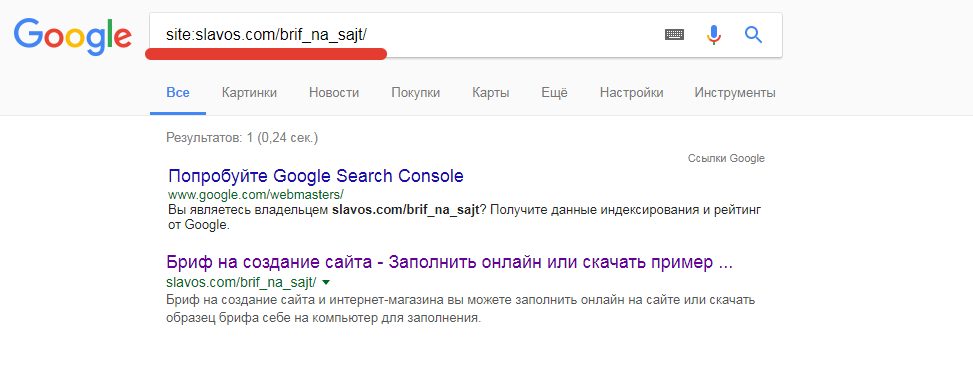

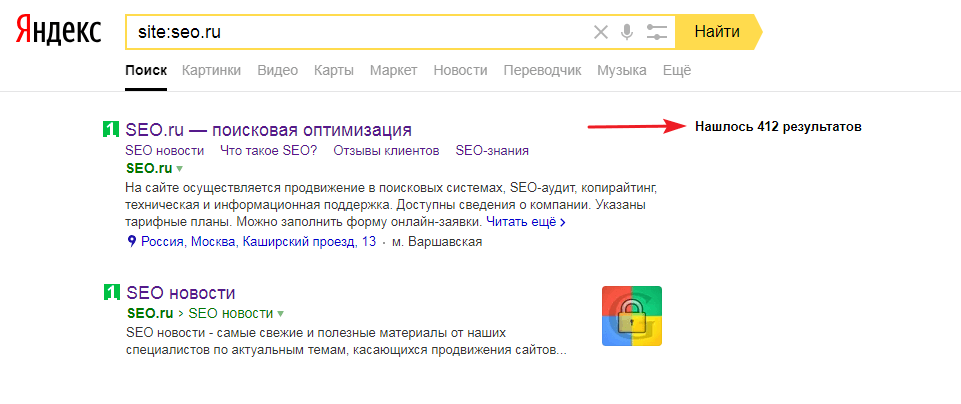

Проверяем индексацию сайта в поисковой системе

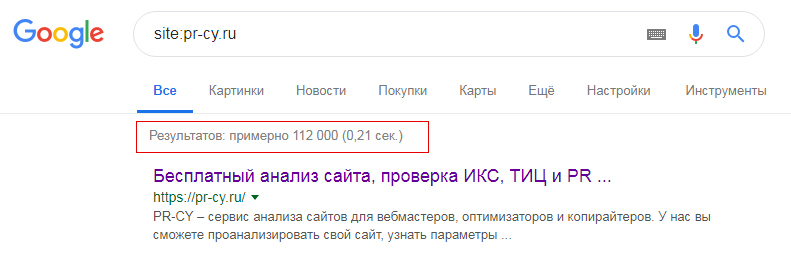

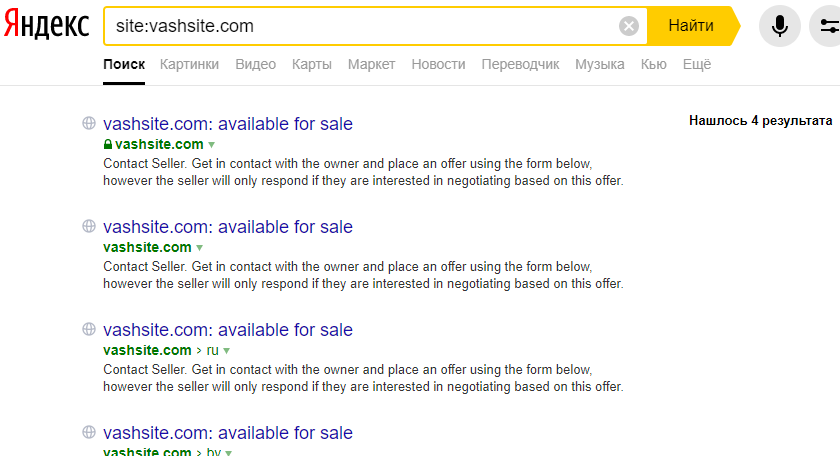

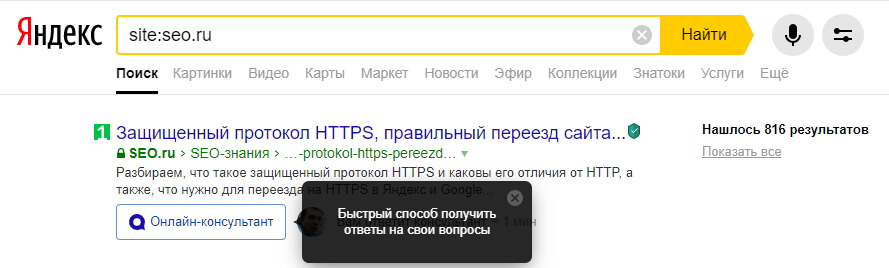

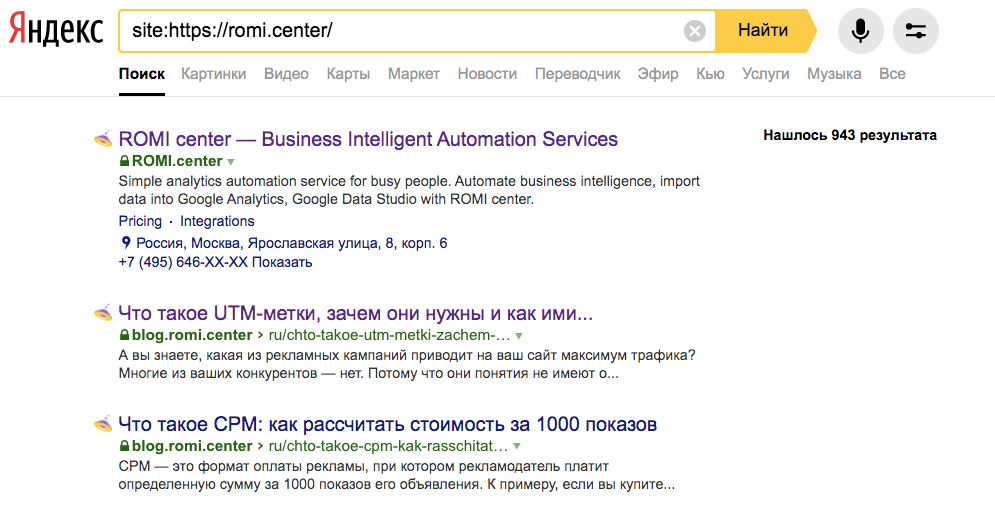

Введите в Google поиске запрос «site:адрес сайта».

После чего поисковик покажет все проиндексированные страницы сайта. Сразу сравните количество результатов с реальным количеством страниц.

Если цифры совпадают, значит все материалы проиндексированы. Прекрасно!

Если цифры не совпадают, значит поисковые роботы выборочно проиндексировали страницы сайта или еще могут быть проблемы с самими страницами, из-за чего они не попадают в индекс.

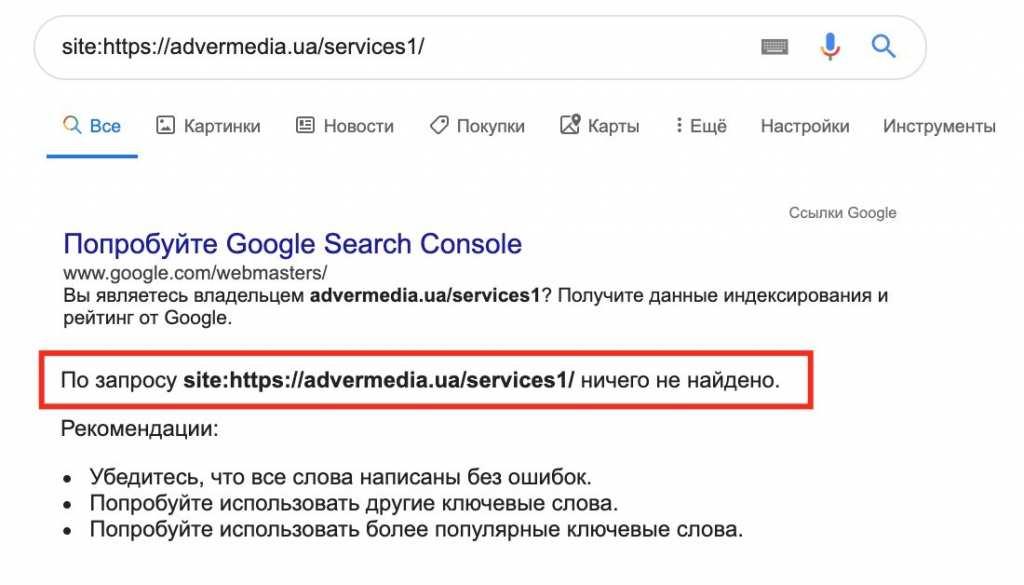

Для проверки индексации конкретной страницы используется такой же алгоритм: ввести в поисковике запрос «site:адрес страницы».

Если ваша страница не отобразилась, значит Google не знает о ней. Этому есть несколько причин, о которых расскажем далее.

Этому есть несколько причин, о которых расскажем далее.

Читайте также: SEO букмарклеты: 14 скриптов, которые помогут ускорить оптимизацию сайта

Проверяем индексацию сайта с помощью Search Console

В чем преимущество Google Search Console?

- Помогает быстро найти ошибки и ускорить индексацию;

- Показывает статус каждой страницы.

Как проверить?

- заходим в Search Console;

- переходим в раздел «Проверка URL»;

- вписываем ссылку в поисковую строку;

- видим результат:

Подаем запрос на индексирование страницы в Google Search Console

Но что делать, если страницы нет в индексе?

Либо ждать пока поисковые роботы найдут страницу, либо подать запрос на индексирование – это ускорит процесс.

Нажмите на кнопку «Запросить индексирование».

Как подать на индексирование сразу много ссылок?

Чтоб просканировать сразу много URL:

- создайте sitemap и сделайте его доступным для Google;

- откройте Search Console;

- перейдите в раздел Sitemaps → Сканирование → файлы Sitemap;

- загрузите и отправьте файл.

Отказ в индексировании: что делать?

Почему не индексируется:

- новый сайт, который еще не отсканировался Google

Читайте также: Ошибки, которых следует избегать при создании сайта

- отсутствие sitemap — может быть выборочная индексация страниц сайта

Читайте также: Записки оптимизатора. Дело №2 «О карте сайта»

- ошибки на странице — проверяйте отчеты Google Search Console

- мало контента (текст и медиа-объекты)

Читайте также: Что такое SEO-тексты и как их правильно писать? Научитесь, чтобы оказаться в Топе Google

- ошибки в robots.txt — добавлена директива noindex или доступ к странице только по паролю

- неуникальный контент

Читайте также: Above-the-fold: какой контент хотят видеть люди, а какой — алгоритмы Google?

- дублирование страниц или повторение заголовка страницы

Читайте также: Как быстро найти дубли страниц на сайте? 10 простых способов

- низкая скорость загрузки

Читайте также: Топ-6 ошибок мобильной версии сайта, которые снижают его конверсию

Отказ в индексировании — это не конец света. Исправьте ошибки и подайте запрос на переиндексацию.

Исправьте ошибки и подайте запрос на переиндексацию.

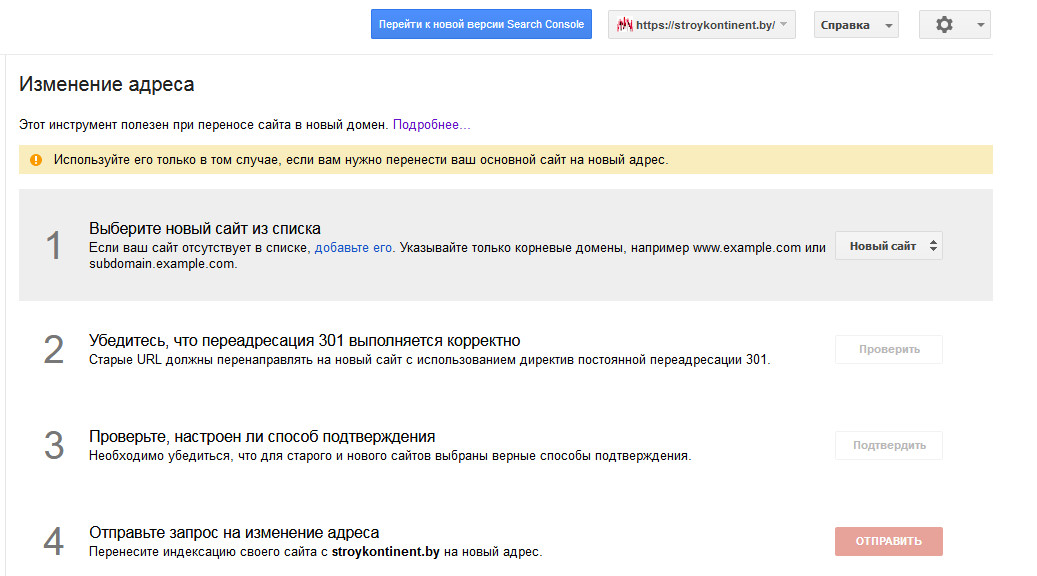

Переиндексирование

Исправили ошибки страницы или внесли изменения — нужна переиндексация.

Как подать запрос на переиндексацию страницы? Также как и запрос на индексирование:

- зайти в Google Search Console;

- вписать ссылку в разделе «Проверка URL»;

- нажать на «Запросить индексирование».

Закрыть от индексирования

Зачем закрывать страницу от индексирования?

- чтоб удалить страницу из выдачи Google;

- чтоб не дать новой странице сканироваться;

- и не нарушать оптимизацию, если на сайте технические работы.

Как это сделать?

- в настройках сервера: запросить доступ по паролю;

- добавить директиву noindex в мета-тег;

- изменить заголовок HTTP-ответа на noindex;

- добавить директиву Disallow в robots.txt.

Читайте также: 3 способа проверить, что сайт попал под фильтр поисковика

Выводы

Два самых простых и быстрых способа проверить индексацию сайта:

- Ввести в поисковой выдаче запрос «site:адрес сайта»;

- Проверить URL в Google Search Console.

Долго не индексируется страница? Подайте запрос на индексацию в Google Search Console.

Уже подавали? Тогда проверьте статус по страницам: исправьте ошибки и подайте запрос еще раз.

Затеяли технические работы на сайте? Закройте от индексирования, чтоб оптимизация страницы не была нарушена.

Если на вашем сайте регулярно появляются новые страницы, вы делитесь ими в соцсетях и добавляете новый контент — то поисковые роботы быстро найдут и отсканирут ваш сайт.

К примеру, информационному ресурсу, на котором постоянно публикуются новые объявления, подавать запрос на индексирование не обязательно. Если сайт активный, то Google достаточно быстро его найдет.

Но если ваша цель повысить органический трафик — то запрос на индексирование ускорит процесс. Это важно для коммерческих сайтов, если продавать нужно уже.

Также читайте другие статьи в блоге Webpromo:

- Похожие URL-адреса могут стать причиной исключения страниц из индекса Google;

- 7 рекомендаций по составлению UTM-меток.

Виды, способы использования, полезные UTM-генераторы;

Виды, способы использования, полезные UTM-генераторы; - Сайт упал! Что делать, чтобы поддерживать индексацию страниц в Google?

И подписывайтесь на наш Telegram-канал про маркетинг.

Индексация сайта и ее основные принципы

12 мин — время чтения

Фев 18, 2020

Поделиться

Когда-нибудь задумывались, как сайты попадают в выдачу поисковых систем? И как поисковикам удается выдавать нам тонны информации за считанные секунды?

Секрет такой молниеносной работы — в поисковом индексе. Его можно сравнить с огромным и идеально упорядоченным каталогом-архивом всех веб-страниц. Попадание в индекс означает, что поисковик вашу страницу увидел, оценил и запомнил. А, значит, он может показывать ее в результатах поиска.

Предлагаю разобраться в процессе индексации с нуля, чтобы понимать, как сайты попадают в выдачу, можно ли управлять этим процессом и что нужно знать про индексирование ресурсов с различными технологиями.

Что такое сканирование и индексация?

Сканирование страниц сайта — это процесс, когда поисковая система отправляет свои специальные программы (мы знаем их как поисковых роботов, краулеров, спайдеров, пауков) для сбора данных с новых и измененных страниц сайтов.

Индексация страниц сайта — это сканирование, считывание данных и добавление их в индекс (каталог) поисковыми роботами. Поисковик использует полученную информацию, чтобы узнать, о чем же ваш сайт и что находится на его страницах. После этого он может определить ключевые слова для каждой просканированной страницы и сохранить их копии в поисковом индексе. Для каждой страницы он хранит URL и информацию о контенте.

В результате, когда пользователи вводят поисковый запрос в интернете, поисковик быстро просматривает свой список просканированных сайтов и показывает только релевантные страницы в выдаче. Как библиотекарь, который ищет нужные вам книги в каталоге — по алфавиту, тематике и точному названию.

Индексация сайтов в разных поисковых системах отличается парой важных нюансов. Давайте разбираться, в чем же разница.

Индексация сайта в GoogleКогда мы гуглим что-то, поиск данных ведется не по сайтам в режиме реального времени, а по индексу Google, в котором хранятся сотни миллиардов страниц. Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

В 2019 году Google изменил свой основной принцип индексирования сайта — вы наверняка слышали о запуске Mobile-first. Основное отличие нового способа в том, что теперь поисковик хранит в индексе мобильную версию страниц. Раньше в первую очередь учитывалась десктопная версия, а теперь первым на ваш сайт приходит робот Googlebot для смартфонов — особенно, если сайт новый. Все остальные сайты постепенно переходят на новый способ индексирования, о чем владельцы узнают в Google Search Console.

Еще несколько основных отличий индексации в Google:

- индекс обновляется постоянно;

- процесс индексирования сайта занимает от нескольких минут до недели;

- некачественные страницы обычно понижаются в рейтинге, но не удаляются из индекса.

В индекс попадают все просканированные страницы, а вот в выдачу по запросу — только самые качественные. Прежде чем показать пользователю какую-то веб-страницу по запросу, поисковик проверяет ее релевантность по более чем 200 критериям (факторам ранжирования) и отбирает самые подходящие.

Что поисковые роботы делают на вашем сайте, мы разобрались, а вот как они попадают туда? Существует несколько вариантов.

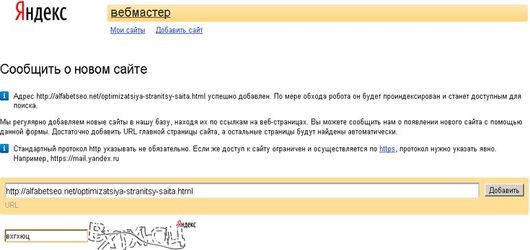

Как поисковые роботы узнают о вашем сайте

Если это новый ресурс, который до этого не индексировался, нужно «представить» его поисковикам. Получив приглашение от вашего ресурса, поисковые системы отправят на сайт своих краулеров для сбора данных.

Вы можете пригласить поисковых ботов на сайт, если разместите на него ссылку на стороннем интернет-ресурсе. Но учтите: чтобы поисковики обнаружили ваш сайт, они должны просканировать страницу, на которой размещена эта ссылка. Этот способ работает для обоих поисковиков.

Также можно воспользоваться одним из перечисленных ниже вариантов:

- Создайте файл Sitemap, добавьте на него ссылку в robots.txt и отправьте файл Sitemap в Google.

- Отправьте запрос на индексацию страницы с изменениями в Search Console.

Каждый сеошник мечтает, чтобы его сайт быстрее проиндексировали, охватив как можно больше страниц. Но повлиять на это не в силах никто, даже лучший друг, который работает в Google.

Но повлиять на это не в силах никто, даже лучший друг, который работает в Google.

Скорость сканирования и индексации зависит от многих факторов, включая количество страниц на сайте, скорость работы самого сайта, настройки в веб-мастере и краулинговый бюджет. Если кратко, краулинговый бюджет — это количество URL вашего сайта, которые поисковый робот хочет и может просканировать.

На что же мы все-таки можем повлиять в процессе индексации? На план обхода поисковыми роботами нашего сайта.

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txtЭто обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, воспользуйтесь отдельным инструментом в Google Search Console.

Файл SitemapЕще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

А еще в Sitemap можно указать:

- частоту обновления конкретной страницы — тегом <changefreq>;

- каноническую версию страницы ― атрибутом rel=canonical;

- версии страниц на других языках ― атрибутом hreflang.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.

Как проверить индексацию сайта

Проверка индексации сайта осуществляется несколькими способами:

1. Через оператор site: в Google. Этот оператор не дает исчерпывающий список страниц, но даст общее понимание о том, какие страницы в индексе. Выдает результаты по основному домену и поддоменам.

2. Через Google Search Console. В консоли вашего сайта есть детальная информация по всем страницам ― какие из них проиндексированы, какие нет и почему.

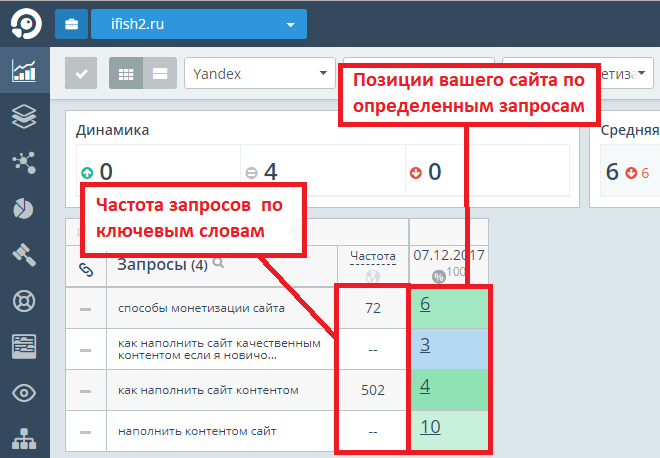

3. Воспользоваться плагинами для браузера типа RDS Bar или специальными инструментами для проверки индексации. Например, узнать, какие страницы вашего сайта попали в индекс поисковика можно в инструменте «Проверка индексации» SE Ranking.

Для этого достаточно ввести нужную вам поисковую систему (Google, Yahoo, Bing), добавить список урлов сайта и начать проверку. Чтобы протестировать работу инструмента «Проверка индексации», зарегистрируйтесь на платформе SE Ranking и откройте тул в разделе «Инструменты».

В этом месте вы можете поднять руку и спросить «А что, если у меня сайт на AJAX? Он попадет в индекс?». Отвечаем 🙂

Особенности индексирования сайтов с разными технологиями

AjaxСегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru/. И так для каждого найденного URL с #.

Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru/. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации Google есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам. Для этого в robots.txt нужно добавить такие команды:

User-agent: Googlebot Allow: /*.js Allow: /*.css Allow: /*.jpg Allow: /*.gif Allow: /*.pngФлеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи.

Поэтому не удивительно, что поисковик предлагает не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash и пользователям мобильных устройств (они не отображают flash-контент).

Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash и пользователям мобильных устройств (они не отображают flash-контент).

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самого поисковика: Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Что в итоге

Поисковые системы готовы проиндексировать столько страниц вашего сайта, сколько нужно. Только подумайте, объем индекса Google значительно превышает 100 млн гигабайт ― это сотни миллиардов проиндексированных страниц, количество которых растет с каждым днем.

Но зачастую именно от вас зависит успех этого мероприятия. Понимая принципы индексации поисковых систем, вы не навредите своему сайту неправильными настройками. Если вы все правильно указали в robots.txt и карте сайта, учли технические требования поисковиков и позаботились о наличии качественного и полезного контента, поисковики не оставят ваш сайт без внимания.

Помните, что индексирование ― это не о том, попадет ваш сайт в выдачу или нет. Намного важнее ― сколько и каких страниц окажутся в индексе, какой контент на них будет просканирован и как он будет ранжироваться в поиске. И здесь ход за вами!

467 views

Как проверить индексацию страницы и сайта в Google

Посмотреть, что попало или не попало в индекс Google — часть работы любого веб-мастера. Но немногие знают, что факт присутствия ссылок на страницы сайта в индексе — очень расплывчатое понятие. Мерилом должны служить показы ссылок в поиске по запросам. Если показов нет, то уже и особой разницы — находится ссылка в индексе или не находится, нет.

Но немногие знают, что факт присутствия ссылок на страницы сайта в индексе — очень расплывчатое понятие. Мерилом должны служить показы ссылок в поиске по запросам. Если показов нет, то уже и особой разницы — находится ссылка в индексе или не находится, нет.

Search Console

Основной инструмент по работе с ссылками сайта — Проверка URLв новой Search Console:

Здесь всё просто: указываете URL страницы, проверяете на наличие её в индексе, и если нет ошибок и противоречий, отправляете на индексацию. Серч коносль работает крайне медленно, поэтому много ссылок отправить быстро не получится.

Обратите внимание на инструменты (там же в новой Серч консоли) Эффективность и Покрытие. Они показывают более масштабную картинку и дают статистику по показам.

См. статью Отчет об эффективности.

Файлы Sitemap

Сайтмап делится на два вида:

- стандартный формат sitemap

- rss фид

В первом случае это файл или группа файлов, куда генерируются вообще все ссылки страниц с сайта. Обрабатывается он редко и долго.

Обрабатывается он редко и долго.

Во втором случае фид имеет смысл указывать короткий, на 20-50 страниц с сортировкой в порядке обновления. Фид Google сканирует чаще, поэтому быстрее будет забирать обновлённые страницы.

Индексация Sitemap — это не индексация всего сайта. И Google не обязан проиндексировать всё. Очень часто встречающееся заблуждение, что в индексе должны быть все страницы. Вообще, нет смысла на крупных сайтах держать группы sitemap с миллионами страниц. Достаточно в sitemap указывать категории, далее Гугл построит скелет сайта и сам найдёт все ссылки.

На скрине видим здоровую ситуацию, sitemap читается, ошибок нет, практически всё проиндексировано. В итоге у нас цифры (кол-во страниц) 279 со Статуса индексирования и 161 с Sitemap.

Оператор Site

Поисковый оператор site изначально служил для оценки деятельности сайта в поиске, но со временем утратил свою актуальность и не рекомендуется гуглерами для проверки индексации сайта.

С официального форума для веб-мастеров Google:

Ни актуальных заголовков (изменяются по запросам), ни точных данных site уже не показывает. В нём можете встретить остаточный мусор, страницы, закрытые в robots, страницы, по которым нет показов и т.п., не участвующее в поиске.

С возрастом сайта уменьшается точность данных, выводимых оператором. На данный момент оператор site годится лишь для мониторинга ошибок в индексе и получения общего представления о сайте, например, с его помощью можно проверить микроразметку или увидеть, есть ли ручные меры за спам или нет. При дальнейшем щёлканье по страницам выдачи с оператора можно увидеть, как цифра страниц в поиске изменяется:

Всё равно, полученная цифра 130 записывается в блокнотик, а ссылки изучаются на предмет поросятины в сниппетах (паразитных кусков кода, опечаток и т.п.), заодно можно оценить кол-во отсортированных страниц, ушедших в дополнительные, т. е, в скрытые, результаты выдачи Мы скрыли некоторые результаты, которые очень похожи на уже представленные выше:

е, в скрытые, результаты выдачи Мы скрыли некоторые результаты, которые очень похожи на уже представленные выше:

Сервисы проверки индексации страниц

Проверить индексацию сайта в Google и Яндексе можно с помощью сервиса Serphunt https://serphunt.ru/indexing/.

Данный сервис позволяет производить пакетную (списком, возможность загрузки до 50 адресов) проверку ссылок на наличие индексации в обоих поисковиках.

Так же Серпхант умеет проверять позиции, имеет инструменты для оценки эффективности и мониторинга сайтов, а так же есть функция анализа страниц конкурентов.

Инструменты статистики

Основной инструмент для изучения ссылок в индексе — Метрика или Аналитика. Они позволяют разом оценить важность страниц для обеих поисковых систем (Яндекс и Google) и произвести сравнительный анализ.

В данном примере в Метрике можно увидеть главные Страницы входа.

Но это популярные страницы со входящим трафиком отовсюду. Списки страниц на скриншоте обрезаны.

Сегментируем страницы по поисковой системе, в частности, Google (еще можно смотреть содержимое поискового трафика Google):

Тут можно увидеть, что одна страница (кстати, из мобильного поиска) круче остальных, а список остальных страниц входа с Google представлен в Метрике ниже (не попал на скриншот). Эта цифра ~100. Но реальную пользу можно извлечь где-то из 50 страниц, что в не согласуется с цифрами, полученными выше. Далее можно отслеживать конверсии и прийти к выводу, что действительно первостепенно для сайта, и в каком русле надо продолжить работу.

По урлам и запросам (Последняя поисковая фраза в Метрике, к примеру) можно определить, какие страницы приводят посетителей, какие нет и на что вообще надо тратить время. Если ожидаемых результатов нет, тогда страница переделывается (дописывается, переписыватся, перевёрстывается — нужное подчеркнуть) и отправляется через Инструмент проверки URL в Search Console. Дополнительное средство для анализа — Отчет об эффективности.

Дополнительное средство для анализа — Отчет об эффективности.

Резюмируя выше описанное:

- В связи с технологическим совершенствованием поиска Googleна первый план вышла актуальность страниц, имеющих показы в поиске (мобильный, планшетный, декстоп).

- Страницы в индексе, как таковые, не играют роли, если не приводят посетителей, и мониторить их обязательное включение в индекс, без соответствующей качественной обработки, не имеет смысла.

- Популярные жалобы «сайт не индексируется» нужно рассматривать не только в техническом плане, но и в контентном. Если страница не отвечает на запрос пользователя, то очевидно, ей в поиске делать нечего.

- Проверка индексации сайта в Гугле — это процесс не двух нажатий, а следствие тщательного анализа различных источников, главные из которых — Search Console, Яндекс Вебмастер (для сравнительного анализа), Метрика или Аналитика.

- Первостепенную важность имеют запросы, а не наполнение поиска Google страницами вашего сайта.

настройка, статусы, ошибки индексации и способы их исправления — Топвизор

txt

txtПодробный SEO-гайд по Отчёту об индексировании Google Search Console. Разберёмся, как проверить индексацию сайта с его помощью, как «читать» статусы URL, какие ошибки можно обнаружить и как их исправить.

Разберёмся, как проверить индексацию сайта с его помощью, как «читать» статусы URL, какие ошибки можно обнаружить и как их исправить.

Перевод с сайта onely.com.

В Отчёте вы можете получить данные о сканировании и индексации всех URL-адресов, которые Google смог обнаружить на вашем сайте. Он поможет отследить, добавлен ли сайт в индекс, и проинформирует о технических проблемах со сканированием и индексацией.

Но перед тем, как говорить об Отчёте, вспомним все этапы индексации страницы в Google.

Как проходит индексация в Google

Чтобы страница ранжировалась в поиске и показывалась пользователям, она должна быть обнаружена, просканирована и проиндексирована.

Обнаружение

Перед тем, как просканировать страницу, Google должен её обнаружить. Он может сделать это несколькими способами.

Наиболее распространённые — с помощью внутренних или внешних ссылок или через карту сайта (файл Sitemap.xml).

Сканирование

Суть сканирования состоит и том, что поисковые системы изучают страницу и анализируют её содержимое.

Главный аспект в этом вопросе — краулинговый бюджет, который представляет собой лимит времени и ресурсов, который поисковая система готова «потратить» на сканирование вашего сайта.

Что такое «краулинговый бюджет, как его проверить и оптимизировать

Индексация

В процессе индексации Google оценивает качество страницы и добавляет её в индекс — базу данных, где собраны все страницы, о которых «знает» Google.

В этот этап включается и рендеринг, который помогает Google видеть макет и содержимое страницы. Собранная информация даёт поисковой системе понимание, как показывать страницу в результатах поиска.

Некоторые страницы могут содержать контент низкого качества или быть дублями. Если поисковые системы их увидят, это может негативно отразится на всём сайте.

Поэтому важно в процессе создания стратегии индексации решить, какие страницы должны и не должны быть проиндексированы.

Ранжирование

Только проиндексированные страницы могут появиться в результатах поиска и ранжироваться.

Google определяет, как ранжировать страницу, основываясь на множестве факторов, таких как количество и качество ссылок, скорость страницы, удобство мобильной версии, релевантность контента и др.

Теперь перейдём к Отчёту.

Как пользоваться Отчётом об индексировании в Google Search Console

Чтобы просмотреть Отчёт, авторизуйтесь в своём аккаунте Google Search Console. Затем в меню слева выберите «Покрытие» в секции «Индекс»:

Как найти Отчёт об индексировании в Google Search ConsoleПеред вами Отчёт. Отметив галочками любой из статусов или все сразу, вы сможете выбрать то, что хотите визуализировать на графике:

Статусы URL на странице ОтчётаВы увидите четыре статуса URL-адресов:

- Ошибка — критическая проблема сканирования или индексации.

- Без ошибок, есть предупреждения — URL-адреса проиндексированы, но содержат некоторые некритичные ошибки.

- Страница без ошибок — страницы проиндексированы корректно.

- Исключено — страницы, которые не были проиндексированы из-за проблем (это самый важный раздел, на котором нужно сфокусироваться).

Фильтры «Все обработанные страницы» vs «Все отправленные страницы»

В верхнем углу вы можете отфильтровать, какие страницы хотите видеть:

Фильтр отображаемых страниц«Все обработанные страницы» показываются по умолчанию. В этот фильтр включены все URL-адреса, которые Google смог обнаружить любым способом.

Фильтр «Все отправленные страницы» включает только URL-адреса, добавленные с помощью файла Sitemap.

Так что когда открываете Отчёт, убедитесь, что смотрите нужные данные.

Проверка статусов URL

Чтобы увидеть подробную информацию о проблемах, обнаруженных для каждого статуса, посмотрите «Сведения» под графиком:

Раздел «Сведения»Тут показан статус, тип проблемы и количество затронутых страниц. Обратите внимание на столбец «Проверка» — после исправления ошибки, вы можете попросить Google проверить URL повторно.

Например, если кликнуть на первую строку со статусом «Предупреждение», то вверху появится кнопка «Проверить исправление»:

Проверка исправленийВы также можете увидеть динамику каждого статуса: увеличилось, уменьшилось или осталось на том же уровне количество URL-адресов в этом статусе.

Если в «Сведениях» кликнуть на любой статус, вы увидите количество адресов, связанных с ним. Кроме того, вы сможете посмотреть, когда каждая страница была просканирована (но помните, что эта информация может быть неактуальна из-за задержек в обновлении отчётов).

Подробная информация о сканировании в СведенияхЧто учесть при использовании отчёта

- Всегда проверяйте, смотрите ли вы отчёт по всем обработанным или по всем отправленным страницам. Разница может быть очень существенной.

- Отчёт может показывать изменения с задержкой. После публикации контента подождите несколько дней, пока страницы просканируются и проиндексируются.

- Google пришлёт уведомления на электронную почту, если увидит какие-то критичные проблемы с сайтом.

- Стремитесь к индексации канонической версии страницы, которую вы хотите показывать пользователям и поисковым ботам.

- В процессе развития сайта, на нём будет появляться больше контента, так что ожидайте увеличения количества проиндексированных страниц в Отчёте.

Как часто смотреть Отчёт

Обычно достаточно делать это раз в месяц.

Но если вы внесли значимые изменения на сайте, например, изменили макет страницы, структуру URL или сделали перенос сайта, мониторьте Отчёт чаще, чтобы вовремя поймать негативное влияние изменений.

Рекомендую делать это хотя бы раз в неделю и обращать особое внимание на статус «Исключено».

Дополнительно: инструмент проверки URL

В Search Console есть ещё один инструмент, который даст ценную информацию о сканировании и индексации страниц вашего сайта — Инструмент проверки URL.

Он находится в самом верху страницы в GSC:

Инструмент проверки URLПросто вставьте URL, который вы хотите проверить, в эту строку и увидите данные по нему. Например:

Например:

Инструментом можно пользоваться для того, чтобы:

- проверить статус индексирования URL, и обнаружить возможные проблемы;

- узнать, индексируется ли URL;

- просмотреть проиндексированную версию URL;

- запросить индексацию, например, если страница изменилась;

- посмотреть загруженные ресурсы, например, такие как JavaScript;

- посмотреть, какие улучшения доступны для URL, например, реализация структурированных данных или удобство для мобильных.

Если в Отчёте об индексировании обнаружены какие-то проблемы со страницами, используйте Инструмент, чтобы тщательнее проверить их и понять, что именно нужно исправить.

Статус «Ошибка»

Под этим статусом собраны URL, которые не были проиндексированы из-за ошибок.

Если вы видите проблему с пометкой «Отправлено», то это может касаться только URL, которые были отправлены через карту сайту. Убедитесь, что в карте сайте содержатся только те страницы, которые вы действительно хотите проиндексировать.

Убедитесь, что в карте сайте содержатся только те страницы, которые вы действительно хотите проиндексировать.

Ошибка сервера (5xx)

Эта проблема говорит об ошибке сервера со статусом 5xx, например, 502 Bad Gateway или 503 Service Unavailable.

Советую регулярно проверять этот раздел и следить, нет ли у Googlebot проблем с индексацией страниц из-за ошибки сервера.

Что делать. Нужно связаться с вашим хостинг-провайдером, чтобы исправить эту проблему или проверить, не вызваны ли эти ошибки недавними обновлениями и изменениями на сайте.

Как исправить ошибки сервера — рекомендации Google

Ошибка переадресации

Редиректы перенаправляют поисковых ботов и пользователей со старого URL на новый. Обычно они применяются, если старый адрес изменился или страницы больше не существует.

Ошибки переадресации могут указывать на такие проблемы:

- цепочка редиректов слишком длинная;

- обнаружен циклический редирект — страницы переадресуют друг на друга;

- редирект настроен на страницу, URL которой превышает максимальную длину;

- в цепочке редиректов найден пустой или ошибочный URL.

Что делать. Проверьте и исправьте редиректы каждой затронутой страницы.

Доступ к отправленному URL заблокирован в файле robots.txt

Эти страницы есть в файле Sitemap, но заблокированы в файле robots.txt.

Robots.txt — это файл, который содержит инструкции для поисковых роботов о том, как сканировать ваш сайт. Чтобы URL был проиндексирован, Google нужно для начала его просканировать.

Что делать. Если вы видите такую ошибку, перейдите в файл robots.txt и проверьте настройку директив. Убедитесь, что страницы не закрыты через noindex.

Страница, связанная с отправленным URL, содержит тег noindex

По аналогии с предыдущей ошибкой, эта страница была отправлена на индексацию, но она содержит директиву noindex в метатеге или в заголовке ответа HTTP.

Что делать. Если страница должна быть проиндексирована, уберите noindex.

Отправленный URL возвращает ложную ошибку 404

Ложная ошибка 404 означает, что страница возвращает статус 200 OK, но её содержимое может указывать на ошибку. Например, страница пустая или содержит слишком мало контента.

Например, страница пустая или содержит слишком мало контента.

Что делать. Проверьте страницы с ошибками и посмотрите, есть ли возможность изменить контент или настроить редирект.

Отправленный URL возвращает ошибку 401 (неавторизованный запрос)

Ошибка 401 Unauthorized означает, что запрос не может быть обработан, потому что необходимо залогиниться под правильными user ID и паролем.

Что делать. Googlebot не может индексировать страницы, скрытые за логинами. Или уберите необходимость авторизации или подтвердите авторизацию Googlebot, чтобы он мог получить доступ к странице.

Отправленный URL не найден (ошибка 404)

Ошибка 404 говорит о том, что запрашиваемая страница не найдена, потому что была изменена или удалена. Такие страницы есть на каждом сайте и наличие их в малом количестве обычно ни на что не влияет. Но если пользователи будут находить такие страницы, это может отразиться негативно.

Что делать. Если вы увидели эту проблему в отчёте, перейдите на затронутые страницы и проверьте, можете ли вы исправить ошибку. Например, настроить 301-й редирект на рабочую страницу.

Например, настроить 301-й редирект на рабочую страницу.

Дополнительно убедитесь, что файл Sitemap не содержит URL, которые возвращают какой-либо другой код состояния HTTP кроме 200 OK.

При отправке URL произошла ошибка 403

Код состояния 403 Forbidden означает, что сервер понимает запрос, но отказывается авторизовывать его.

Что делать. Можно либо предоставить доступ анонимным пользователям, чтобы робот Googlebot мог получить доступ к URL, либо, если это невозможно, удалить URL из карты сайта.

URL заблокирован из-за ошибки 4xx (ошибка клиента)

Страница может быть непроиндексирована из-за других ошибок 4xx, которые не описаны выше.

Что делать. Чтобы понять, о какой именно ошибке речь, используйте Инструмент проверки URL. Если устранить ошибку невозможно, уберите URL из карты сайта.

Статус «Без ошибок, есть предупреждения»

URL без ошибок, но с предупреждениями, были проиндексированы, но могут требовать вашего внимания. Тут обычно случается две проблемы.

Тут обычно случается две проблемы.

Проиндексировано, несмотря на блокировку в файле robots.txt

Обычно эти страницы не должны быть проиндексированы, но скорее всего Google нашёл ссылки, указывающие на них, и посчитал их важными.

Что делать. Проверьте эти страницы. Если они всё же должны быть проиндексированы, то обновите файл robots.txt, чтобы Google получил к ним доступ. Если не должны — поищите ссылки, которые на них указывают. Если вы хотите, чтобы URL были просканированы, но не проиндексированы, добавьте директиву noindex.

Страница проиндексирована без контента

URL проиндексированы, но Google не смог прочитать их контент. Это может быть из-за таких проблем:

- Клоакинг — маскировка контента, когда Googlebot и пользователи видят разный контент.

- Страница пустая.

- Google не может отобразить страницу.

- Страница в формате, который Google не может проиндексировать.

Зайдите на эти страницы сами и проверьте, виден ли на них контент. Также проверьте их через Инструмент проверки URL и посмотрите, как их видит Googlebot. После того, как устраните ошибки, или если не обнаружите каких-либо проблем, вы можете запросить у Google повторное индексирование.

Статус «Страница без ошибок»

Здесь показываются страницы, которые корректно проиндексированы. Но на эту часть Отчёта всё равно нужно обращать внимание, чтобы сюда не попали страницы, которые не должны были оказаться в индексе. Тут тоже есть два статуса.

Страница была отправлена в Google и проиндексирована

Это значит, что страницы отправлена через Sitemap и Google её проиндексировал.

Страница проиндексирована, но её нет в файле Sitemap

Это значит, что страница проиндексирована даже несмотря на то, что её нет в Sitemap. Посмотрите, как Google нашёл эту страницу, через Инструмент проверки URL.

Чаще всего страницы в этом статусе — это страницы пагинации, что нормально, учитывая, что их и не должно быть в Sitemap. Посмотрите список этих URL, вдруг какие-то из них стоит добавить в карту сайта.

Посмотрите список этих URL, вдруг какие-то из них стоит добавить в карту сайта.

Статус «Исключено»

В этом статусе находятся страницы, которые не были проиндексированы. В большинстве случаев это вызвано теми же проблемами, которые мы обсуждали выше. Единственное различие в том, что Google не считает, что исключение этих страниц вызвано какой-либо ошибкой.

Вы можете обнаружить, что многие URL здесь исключены по разумным причинам. Но регулярный просмотр Отчёта поможет убедиться, что не исключены важные страницы.

Индексирование страницы запрещено тегом noindex

Что делать. Тут то же самое — если страница и не должна быть проиндексирована, то всё в порядке. Если должна — удалите noindex.

Индексирование страницы запрещено с помощью инструмента удаления страниц

У Google есть Инструмент удаления страниц. Как правило с его помощью Google удаляет страницы из индекса не навсегда. Через 90 дней они снова могут быть проиндексированы.

Что делать. Если вы хотите заблокировать страницу насовсем, вы можете удалить её, настроит редирект, внедрить авторизацию или закрыть от индексации с помощью тега noindex.

Если вы хотите заблокировать страницу насовсем, вы можете удалить её, настроит редирект, внедрить авторизацию или закрыть от индексации с помощью тега noindex.

Заблокировано в файле robots.txt

У Google есть Инструмент проверки файла robots.txt, где вы можете в этом убедиться.

Что делать. Если эти страницы и не должны быть в индексе, то всё в порядке. Если должны — обновите файл robots.txt.

Помните, что блокировка в robots.txt — не стопроцентный вариант закрыть страницу от индексации. Google может проиндексировать её, например, если найдёт ссылку на другой странице. Чтобы страница точно не была проиндексирована, используйте директиву noindex.

Подробнее о блокировке индексирования при помощи директивы noindex

Страница не проиндексирована вследствие ошибки 401 (неавторизованный запрос)

Обычно это происходит на страницах, защищённых паролем.

Что делать. Если они и не должны быть проиндексированы, то ничего делать не нужно. Если вы не хотите, чтобы Google обнаруживал эти страницы, уберите существующие внутренние и внешние ссылки на них.

Если вы не хотите, чтобы Google обнаруживал эти страницы, уберите существующие внутренние и внешние ссылки на них.

Страница просканирована, но пока не проиндексирована

Это значит, что страница «ждёт» решения. Для этого может быть несколько причин. Например, с URL нет проблем и вскоре он будет проиндексирован.

Но чаще всего Google не будет торопиться с индексацией, если контент недостаточно качественный или выглядит похожим на остальные страницы сайта.

В этом случае он поставит её в очередь с низким приоритетом и сфокусируется на индексации более важных страниц. Google говорит, что отправлять такие страницы на переиндексацию не нужно.

Что делать. Для начала убедитесь, что это не ошибка. Проверьте, действительно ли URL не проиндексирован, в Инструменте проверки URL или через инструмент «Индексация» в Анализе сайта в Топвизоре. Они показывают более свежие данные, чем Отчёт.

Как исправить ошибку, когда страница просканирована, но не проиндексирована (на английском)

Обнаружена, не проиндексирована

Это значит, что Google увидел страницу, например, в карте сайта, но ещё не просканировал её. В скором времени страница может быть просканирована.

В скором времени страница может быть просканирована.

Иногда эта проблема возникает из-за проблем с краулинговым бюджетом. Google может посчитать сайт некачественным, потому что ему не хватает производительности или на нём слишком мало контента.

Что такое краулинговый бюджет и как его оптимизировать

Возможно, Google не нашёл каких-либо ссылок на эту страницу или нашёл страницы с большим ссылочным весом и посчитал их более приоритетными для сканирования.

Если на сайте есть более качественные и важные страницы, Google может игнорировать менее важные страницы месяцами или даже никогда их не просканировать.

Вариант страницы с тегом canonical

Эти URL — дубли канонической страницы, отмеченные правильным тегом, который указывает на основную страницу.

Что делать. Ничего, вы всё сделали правильно.

Страница является копией, канонический вариант не выбран пользователем

Это значит, что Google не считает эти страницы каноническими. Посмотрите через Инструмент проверки URL какую страницу он считает канонической.

Посмотрите через Инструмент проверки URL какую страницу он считает канонической.

Что делать. Выберите страницу, которая по вашему мнению является канонической, и разметьте дубли с помощью rel=”canonical”.

Страница является копией, канонические версии страницы, выбранные Google и пользователем, не совпадают

Вы выбрали каноническую страницу, но Google решил по-другому. Возможно, страница, которую вы выбрали, не имеет столько внутреннего ссылочного веса, как неканоническая.

Что делать. В этом случае может помочь объединение URL повторяющихся страниц.

Как правильно настроить внутренние ссылки на сайте

Не найдено (404)

URL нет в Sitemap, но Google всё равно его обнаружил. Возможно, это произошло с помощью ссылки на другом сайте или ранее страница существовала и была удалена.

Что делать. Если вы и не хотели, чтобы Google индексировал страницу, то ничего делать не нужно. Другой вариант — поставить 301-й редирект на работающую страницу.

Страница с переадресацией

Эта страница редиректит на другую страницу, поэтому не была проиндексирована. Обычно, такие страницы не требуют внимания.

Что делать. Эти страницы и не должны быть проиндексированы, так что делать ничего не нужно.

Ложная ошибка 404

Обычно это страницы, на которых пользователь видит сообщение «не найдено», но которые не сопровождаются кодом ошибки 404.

Что делать. Для исправления проблемы вы можете:

- Добавить или улучшить контент таких страниц.

- Настроить 301-й редирект на ближайшую альтернативную страницу.

- Настроить сервер, чтобы он возвращал правильный код ошибки 404 или 410.

Страница является копией, отправленный URL не выбран в качестве канонического

Эти страницы есть в Sitemap, но для них не выбрана каноническая страница. Google считает их дублями и канонизировал их другими страницами, которые определил самостоятельно.

Что делать. Выберите и добавьте канонические страницы для этих URL.

Страница заблокирована из-за ошибки 403 (доступ запрещён)

Что делать. Если Google не может получить доступ к URL, лучше закрыть их от индексации с помощью метатега noindex или файла robots.txt.

URL заблокирован из-за ошибки 4xx (ошибка клиента)

Сервер столкнулся с ошибкой 4xx, которая не описана выше.

Гайд по ошибкам 4xx и способы их устранения (на английском)

Попробуйте исправить ошибки или оставьте страницы как есть.

Ключевые выводы

- Проверяя данные в Отчёте помните, что не все страницы сайта должны быть просканированы и проиндексированы.

- Закрыть от индексации некоторые страницы может быть так же важно, как и следить за тем, чтобы нужные страницы сайта индексировались корректно.

- Отчёт об индексировании показывает как критичные ошибки, так и неважные, которые не обязательно требуют действий с вашей стороны.

- Регулярно проверяйте Отчёт, но только для того, чтобы убедиться, что всё идёт по плану. Исправляйте только те ошибки, которые не соответствуют вашей стратегии индексации.

Как проверить, проиндексированы ли веб-страницы в Google

Вы можете проверить, индексируются ли URL-адреса вашего веб-сайта в Google, воспользовавшись API проверки URL-адресов Search Console, который вы можете подключить к Sitebulb через интеграцию Google Search Console.

Это может позволить вам увидеть данные высокого уровня о том, индексируется ли URL-адрес или нет, а также «причины», по которым URL-адреса не индексируются, что позволяет вам исследовать дальше.

Для ясности: возвращаемые данные — это данные, которые Google Search Console хранит для заданного URL-адреса. API будет возвращать информацию об индексации, которая в настоящее время доступна в инструменте проверки URL-адресов. Что делает Sitebulb, так это позволяет вам собирать эти данные в большом количестве.

Подключение Sitebulb к API проверки URL-адресов

Чтобы подключить Sitebulb к API проверки URL-адресов, добавьте Google Search Console в настройки аудита при настройке проекта и установите флажок в разделе Конфигурация Опции для Извлечь данные URL из Search Console Inspection API .

На этом этапе важно убедиться, что вы выбрали правильное свойство. Sitebulb поможет вам сделать это, предварительно выбрав свойство путем сопоставления с начальным URL-адресом, но у вас может быть несколько свойств для одной и той же учетной записи (например, свойства домена и свойства на уровне URL).

Ограничение дневной квоты

Основное предостережение этой функции заключается в том, что Google ограничивает количество запросов до 2000 URL-адресов в день для каждого свойства веб-сайта Search Console (т. е. вызовов, запрашивающих один и тот же сайт).

Это означает, что если у вас есть веб-сайт с более чем 2000 URL-адресов, Sitebulb не сможет одновременно собирать информацию об индексировании всех URL-адресов. В этом случае Sitebulb будет запрашивать 2000 лучших URL-адресов HTML, упорядоченных по рейтингу URL-адресов.

В этом случае Sitebulb будет запрашивать 2000 лучших URL-адресов HTML, упорядоченных по рейтингу URL-адресов.

Таким образом, по умолчанию Sitebulb всегда выбирает наиболее важные страницы для проверки индексации на основе популярности внутренних ссылок.

Важное замечание, которое не стоит игнорировать

Эта квота распространяется на каждый веб-сайт, а не на инструмент. Если вы собираете данные API с помощью нескольких разных инструментов, все они берутся из одного и того же пула квот. Если вы израсходовали лимит в 2000 деней с помощью других инструментов, вы не сможете собирать больше данных с помощью Sitebulb в тот же день.

Точно так же существует ограничение на количество запросов в API, равное 600 URL-адресам в минуту. Sitebulb настроен на безопасный запрос в пределах этого ограничения, но если вы одновременно нажмете на API двумя разными инструментами, вы можете случайно превысить его для любых сообщений об ошибках.

Дополнительную информацию о превышении ограничений API см. в разделе «Если данные URL не возвращаются».

в разделе «Если данные URL не возвращаются».

Просмотр данных проверки URL-адресов в Sitebulb

Чтобы получить доступ к данным, собранным Sitebulb, перейдите к отчету Проверка URL-адресов с помощью навигации слева.

В обзоре показаны многочисленные диаграммы и таблицы, и если вы нажмете на вкладку URL-адреса , вы увидите все данные в формате таблицы:

Как и во всех списках URL-адресов в Sitebulb, данные могут быть дополнены и точны. -настраивается путем добавления дополнительных столбцов, сортировки или применения расширенных фильтров.

Изучение данных проверки URL

Данные, возвращаемые API, могут быть весьма обширными и детализированными, поэтому для того, чтобы действительно понять, на что вы смотрите, требуется некоторое знакомство с отчетом о покрытии индекса и инструментом проверки URL в Google Search Console.

Тем не менее, Sitebulb предоставляет вам простой и интуитивно понятный доступ к важным элементам данных, таким как «URL-адреса не индексируются в Google», с простым рабочим процессом для более глубокого изучения данных.

На любой из диаграмм щелкните область сегмента, чтобы просмотреть отфильтрованный URL-адрес Список данных:

Это приведет вас к следующим URL-данным:

Кроме того, на любой диаграмме вы можете щелкнуть переключатель «Просмотр таблицы данных», который отображает данные диаграммы в формате таблицы:

Затем данные диаграммы будут отображаться в таблице, и нажатие на любое из этих значений также приведет вас к соответствующему списку URL-адресов:

В самих списках URL-адресов вы можете анализировать проблемы в пакетном режиме, прокручивая вправо, чтобы просмотреть наиболее значимые столбцы:

В качестве альтернативы, чтобы погрузиться в определенный URL-адрес и посмотреть, что говорит инструмент проверки в Google Search Console, просто нажмите оранжевую кнопку, чтобы Открыть проверку URL-адреса :

Это откроет консоль поиска Google в в вашем браузере с уже открытым инструментом проверки URL и предварительно загруженным выбранным URL:

Что показывают различные диаграммы

В отчете о проверке URL есть несколько круговых диаграмм и столбчатых диаграмм, поэтому мы пройдемся по ним что показывает каждый:

Покрытие

На этой диаграмме каждый URL-адрес разбит на разные сегменты в зависимости от того, сможет ли Google найти и проиндексировать страницу. Каждый вариант включает краткую описательную причину статуса URL-адреса, объясняющую, почему URL-адрес находится или не находится в Google.

Каждый вариант включает краткую описательную причину статуса URL-адреса, объясняющую, почему URL-адрес находится или не находится в Google.

Сводка

Эта круговая диаграмма дает сводную оценку того, могут ли URL отображаться в результатах поиска Google.

Важно отметить, что «URL находится в Google» не обязательно означает, что страница появляется в результатах поиска, а просто означает, что она проиндексирована.

Индексирование разрешено

На этой диаграмме показано, разрешают ли URL-адреса явно запрещать индексирование (например, тег noindex). Если индексация запрещена, в легенде указывается причина — эти страницы не будут отображаться в результатах поиска Google.

Обратите внимание: если страница заблокирована файлом robots.txt, для параметра «Индексирование разрешено» всегда будет установлено значение «Да», поскольку Google не может видеть и соблюдать директивы noindex.

URL-адреса карты сайта

На этой диаграмме URL-адреса, отправленные в Inspection API, разделены на основе их статуса карты сайта. Либо они не были найдены на картах сайта в Google Search Console (в этом случае они отображаются как «Не отправлено»), они были отправлены и проиндексированы, либо отправлены, но не проиндексированы.

Либо они не были найдены на картах сайта в Google Search Console (в этом случае они отображаются как «Не отправлено»), они были отправлены и проиндексированы, либо отправлены, но не проиндексированы.

Просканировано как

На этой диаграмме показано распределение между URL-адресами, просканированными с помощью Google Mobile Crawler и их Desktop Crawler.

Результаты на этой диаграмме относятся только к проиндексированным URL-адресам.

Сканирование разрешено

На этой диаграмме показано, разрешено ли Google сканирование URL-адресов в соответствии с правилами сайта robots.txt. Обратите внимание, что это значение отличается от разрешения индексирования, которое задается значением «Индексирование разрешено».

Результаты на этой диаграмме относятся только к проиндексированным URL-адресам.

Пользователь против Google Canonical

На этой диаграмме показано, согласен ли Google с объявленным пользователем каноническим URL-адресом.![]() Если они согласны, это будет отображаться как «Совпадение», а если они не согласны, это будет отображаться как «Несоответствие». Если канонических нет и Google выбрал один, это будет отображаться как «Выбрано Google».

Если они согласны, это будет отображаться как «Совпадение», а если они не согласны, это будет отображаться как «Несоответствие». Если канонических нет и Google выбрал один, это будет отображаться как «Выбрано Google».

Дней с момента последнего сканирования

На этой диаграмме показано распределение URL-адресов на основе даты их последнего сканирования Google. Дни, обозначенные как «0», означают, что URL-адрес был просканирован в течение последнего дня. Диапазоны дат позволяют копать глубже и исследовать URL-адреса, которые недавно сканировались или вообще не сканировались.

Расширенные результаты

На этой диаграмме показано, подходят ли URL-адреса для расширенных результатов и вызывают ли URL-адреса ошибки или предупреждения.

Результаты на этой диаграмме относятся только к URL-адресам, которые содержат структурированные данные, которые могут привести к расширенным результатам.

Подходит для мобильных устройств

На этой диаграмме показано, считает ли Google URL-адреса удобными для мобильных устройств и вызывают ли URL-адреса ошибки или предупреждения.

Результаты на этой диаграмме относятся только к проиндексированным URL-адресам.

Когда данные URL не возвращаются

Иногда вы обнаружите, что данные URL не возвращаются, и это может быть по ряду причин:

#1 Превышена квота: вы исчерпали дневную квоту URL

Если вы превысите дневную квоту (см. выше), вам нужно будет подождать 24 часа, прежде чем пытаться снова. Также имейте в виду, что ограничение в 2000 URL-адресов относится к ресурсу в день, что может означать, что вы превысили ограничение из-за инструментов, отличных от Sitebulb.

Как только Sitebulb превысит дневную квоту, он перестанет отправлять запросы API.

#2 Превышена квота: Вы превысили лимит скорости

В API существует ограничение на количество запросов в 600 URL-адресов в минуту. Sitebulb настроен на безопасный запрос в рамках этого ограничения, но если вы одновременно нажмете на API двумя разными инструментами, вы можете случайно превысить его для любых сообщений об ошибках.

#3 Запрещено: запрошенный URL-адрес недействителен для этого ресурса

Это означает, что Sitebulb запросил данные индексации для URL-адреса, который «не является частью выбранного ресурса».

Например, https://example.com для свойства префикса URL https://www.example.com . Если вы хотите проверить URL-адреса из нескольких субдоменов, выберите свойство на уровне домена.

#4 Сбой: вышла ошибка API

Это означает, что сам API Google не работает. Если это произойдет, вернитесь и повторите попытку позже.

Как узнать, что Google индексирует на моем сайте?

Николас Лонгтин | Сентябрь 2021

Мы часто получаем вопросы от клиентов о том, как Google будет сканировать их сайт и какой контент Google сможет «увидеть» и, следовательно, добавить в поисковый индекс Google. В идеальном мире каждая страница на вашем сайте, каждый загруженный и связанный документ, а также каждое изображение будут появляться в релевантных результатах поиска Google, но это не всегда так. Продолжайте читать, чтобы узнать, как вы можете просмотреть свой веб-сайт и определить, какой контент Google будет сканировать и делать доступным в результатах поиска.

Продолжайте читать, чтобы узнать, как вы можете просмотреть свой веб-сайт и определить, какой контент Google будет сканировать и делать доступным в результатах поиска.

Создание индекса Google

Конечной целью Google является «организация мировой информации». То, как они делают это для онлайн-контента, состоит в том, чтобы создать всеобъемлющий индекс всего контента веб-сайта и сделать его доступным для быстрого поиска с помощью различных сервисов. Google создал невероятно продвинутую систему «сканирования» веб-сайтов для загрузки контента, однако у сканера есть технические ограничения и другие причины, по которым некоторый контент никогда не попадает в результаты поиска Google.

Чтобы понять, что нельзя просканировать и добавить в этот индекс, полезно понять, как работают роботы-сканеры Google. Google обнаруживает новые URL-адреса различными способами, когда обнаруживается новая страница, Google «сканирует» страницу, визуализируя ее и загружая весь код, из которого состоит страница. Google найдет все ссылки на другие URL-адреса и файлы на этой странице и продолжит сканировать и анализировать этот контент.

Google найдет все ссылки на другие URL-адреса и файлы на этой странице и продолжит сканировать и анализировать этот контент.

В большинстве случаев Google будет продолжать переходить по ссылкам на протяжении всего процесса сканирования и продолжать добавлять контент в свой индекс. Однако есть некоторые причины, по которым связанный URL-адрес или файл не будут сканироваться.

Преднамеренная блокировка сканера

Существует множество причин, по которым Google не может сканировать определенный URL-адрес. Большинство этих причин связаны с техническими проблемами, которые непреднамеренно присутствуют на веб-страницах. Однако есть некоторые преднамеренные способы, которыми люди намеренно блокируют Google от сканирования URL-адреса, и мы рассмотрим их в первую очередь.

Блокировка контента с помощью Robots.txt

На вашем веб-сайте может быть специальный текстовый файл, называемый файлом robots. В этом файле вы можете сообщить поисковым системам, что вы не хотите, чтобы они сканировали. Google уважает информацию в этом файле, но имейте в виду, что другие поисковые системы могут этого не делать. Кроме того, простое включение URL-адреса в файл robots может не защитить контент от Google, существуют и другие способы обнаружения URL-адреса Google.

Google уважает информацию в этом файле, но имейте в виду, что другие поисковые системы могут этого не делать. Кроме того, простое включение URL-адреса в файл robots может не защитить контент от Google, существуют и другие способы обнаружения URL-адреса Google.

Использование страницы тестера роботов Google для чтения и тестирования файла robot.txt ArcStone.

Причины, по которым люди блокируют некоторые ULR от сканеров, могут быть разными и могут включать:

- Скрытие содержимого, например экрана входа или других скрытых областей

- Запрещение Google индексировать новый контент, который все еще находится в черновой форме

- Не позволять Google индексировать плохой контент, который может быть полезен для некоторых пользователей, но может негативно повлиять на SEO

- Предотвращение Google от индексации отдельных файлов мультимедиа

Вы также можете использовать файл robots, чтобы сообщить Google, что он должен ограничить скорость сканирования, чтобы не перегружать ваш сайт. Однако это редкий случай использования, и любой хорошо построенный современный веб-сайт не должен подвергаться негативному влиянию сканера Google.

Однако это редкий случай использования, и любой хорошо построенный современный веб-сайт не должен подвергаться негативному влиянию сканера Google.

Блокировка содержимого с помощью тега NOINDEX

Еще один способ намеренно запретить Google индексировать URL-адрес с помощью тега NOINDEX. Это специальный фрагмент кода, называемый «МЕТА-ТЕГ». Эти теги не видны пользователям, но используются для управления поведением поисковых систем и браузеров. Использование тега NOINDEX — гораздо более надежный способ предотвратить сканирование контента Google. Google не будет включать страницы с тегом NOINDEX в результаты поиска.

ССЫЛКИ NOFOLLOW

Еще одна причина, по которой Google может не продолжить сканирование содержимого, заключается в том, что сканер встречает атрибут NOFOLLOW в ссылке. Это специальная часть HTML-кода ссылки, которая сообщает поисковым роботам, что по ссылке не следует «следовать», а ссылающаяся страница не должна индексироваться.

Хотя YouTube разрешает ссылки в описаниях видео, вы можете видеть из исходного кода, это ссылка «nofollow», что означает, что поисковый робот Google не будет переходить по ней.

Имейте в виду, что большинство URL-адресов содержат много ссылок, указывающих на них, и атрибут NOFOLLOW не предназначен для защиты контента от поисковой системы Google. Атрибут NOFOLLOW обычно используется для управления SEO-преимуществом ссылки. Когда веб-сайт A ссылается на веб-сайт B, Google интерпретирует это как веб-сайт A, «ручающийся» за содержание веб-сайта B. Часто веб-сайты хотят ссылаться на другой сайт, но не ассоциироваться с ним или рассматриваться как ручающиеся за качество связанного сайта. .

Имейте в виду, что, несмотря на то, что независимые эксперименты подтвердили, что Google соблюдает атрибут NOFOLLOW, который может быть изменен в любое время без предварительного уведомления. Кроме того, даже если Google может не предоставить вашему веб-сайту значительных SEO преимуществ от NOFOLLOW-ссылок, это все равно здорово, когда на ваш сайт ссылаются с других высококачественных веб-сайтов с высоким трафиком.

Регистрация или платный доступ