Частотность запросов: зачем и как проверять?

20:42, 12 лютого 2021 р.

Загальний розділ

Частотность запросов – количество обращений пользователей по конкретной фразе. Одни формулировки вводятся в поисковую строку 3-4 раза в месяц, другие – 5 тысяч раз, третьи – десятки и сотни тысяч. В статье мы расскажем, для чего и как проверить популярность запросов, рассмотрим виды частотностей.

Для чего проверять?

Проверка частотности запросов поможет собрать адекватное семантическое ядро, от которого зависит успех продвижения сайта в поисковых системах. Используя популярные ключи, можно писать актуальный для аудитории контент, увеличить показы, запускать эффективную контекстную рекламу.

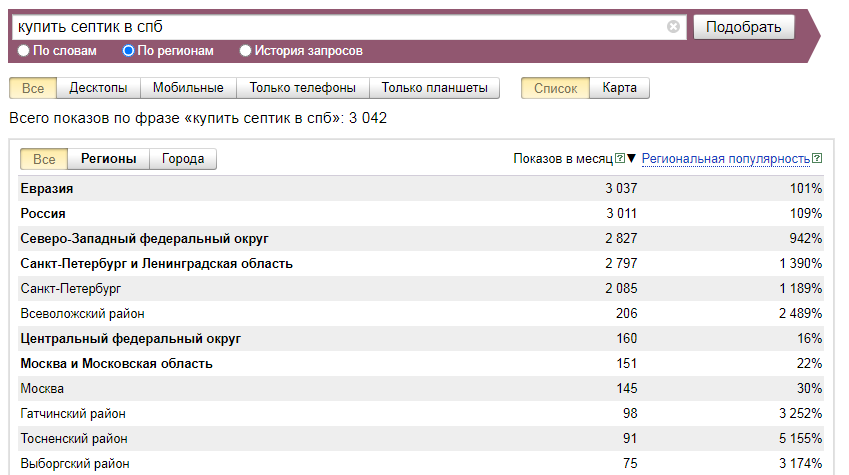

Также можно оценивать степень заинтересованности пользователей какой-либо темой. Например, проверка запроса «купить экошубу» с указанием определённого региона позволит понять, насколько будет востребован данный товар в вашем городе. Для полной картины, конечно, стоит проверить и другие подобные фразы: «экошуба цена», «стоимость экошубы» и т.д. То же самое можно проделывать и при выборе тем для блога.

Для полной картины, конечно, стоит проверить и другие подобные фразы: «экошуба цена», «стоимость экошубы» и т.д. То же самое можно проделывать и при выборе тем для блога.

Способы проверки

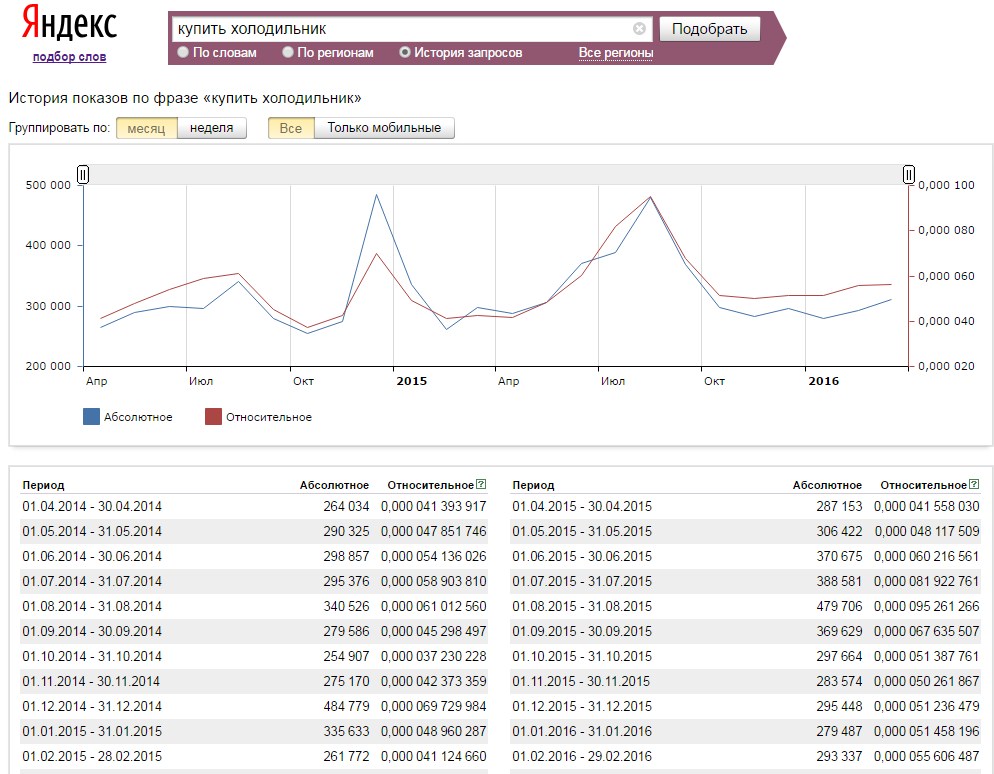

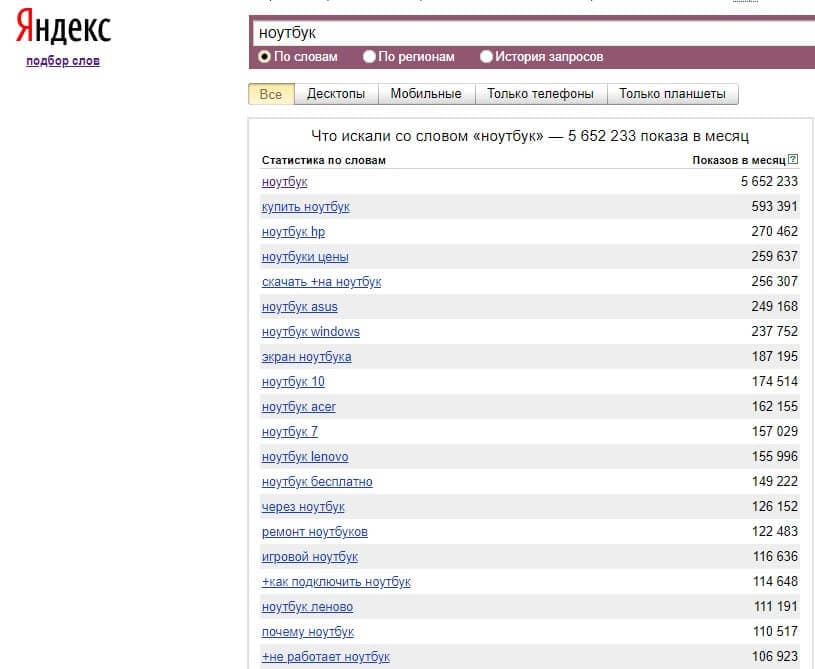

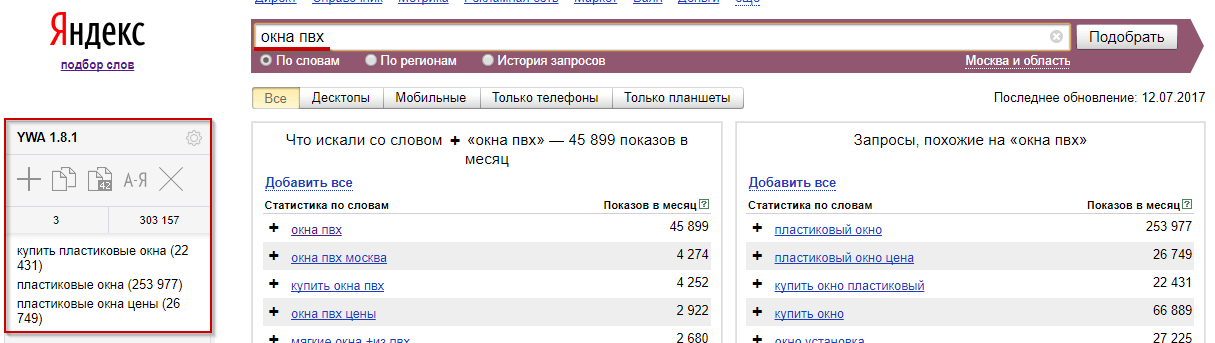

Определить частотность запросов в Яндексе можно в Яндекс.Вордстат: введите искомую фразу и кликните по кнопке «подобрать». Для коммерческого запроса стоит указать регион, если компания работает в нескольких – отмечаем их все.

Сервис Яндекса покажет, сколько обращений было по конкретной фразе в месяц. Условно частотность можно разделить по следующим градациям:

- высокочастотные (ВЧ) – >10 000 обращений в месяц;

- среднечастотные (СЧ) – 1 000-10 000;

Это приблизительное разделение, многое зависит от тематики, популярности направления в целом.

При оптимизации статьи, а также создании рекламных объявлений обычно ориентируются на ВЧ и СЧ фразы. Но стоит учесть, что у популярных ключей высокая конкуренция – молодым сайтам по ним сложно пробиться в выдачу. Новым площадкам лучше продвигаться по НЧ, которые принесут некоторый объем трафика. Через несколько месяцев работ по оптимизации можно подключать более популярные ключевики.

Новым площадкам лучше продвигаться по НЧ, которые принесут некоторый объем трафика. Через несколько месяцев работ по оптимизации можно подключать более популярные ключевики.

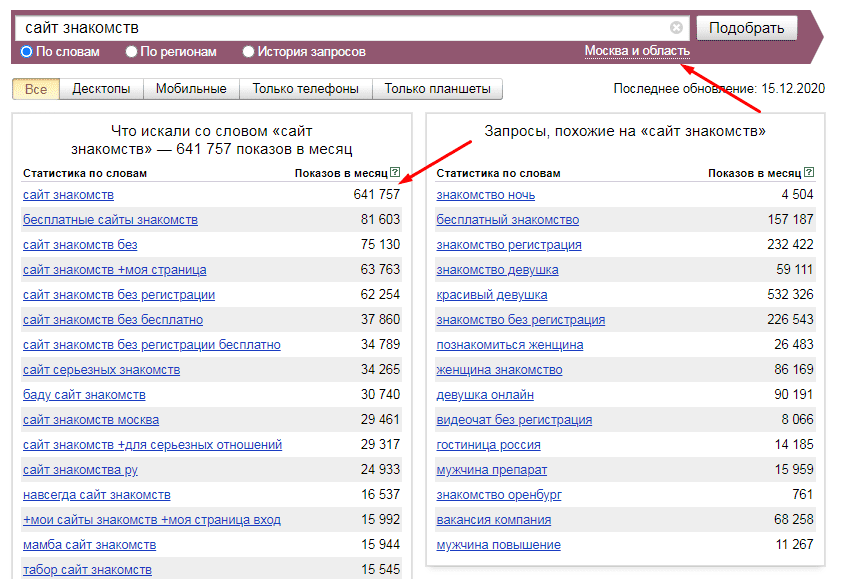

Также Wordstat покажет, что ещё искали пользователи, выдаст список похожих ключевых слов. Это можно использовать для расширения семантического ядра: чем оно больше, тем эффективнее продвижение.

Есть и специальные сервисы проверки запросов на частотность, перечислим их:

- Key Collector;

- Rush Analytics;

- «Мутаген»;

- «Топвизор»;

- OverLead.me.

Во всех них можно массово собрать частотность, что очень удобно при работе с большим количеством ключей. В Google можно воспользоваться «Планировщиком ключевых слов» из Google AdWords.

Виды частотностей

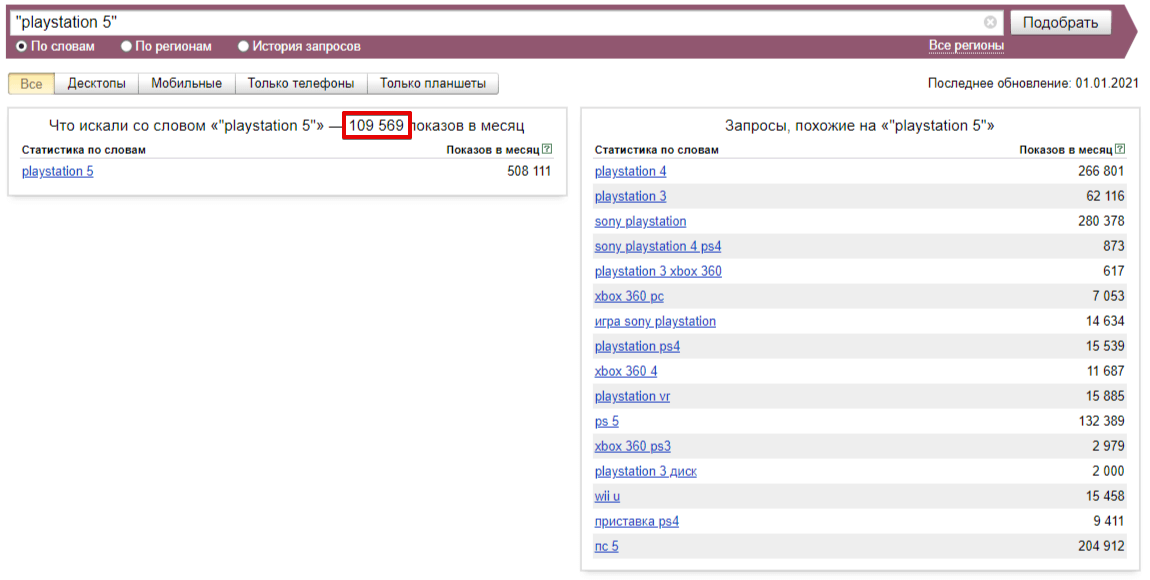

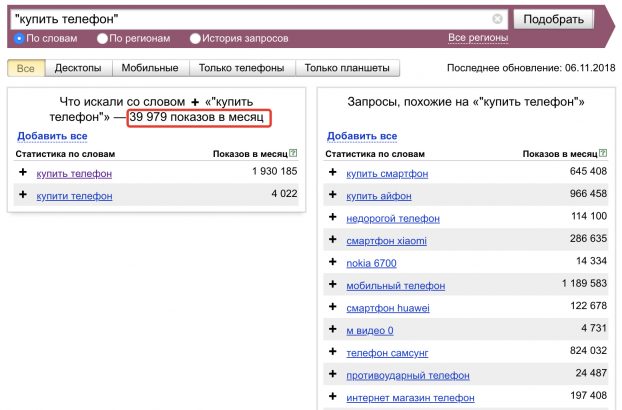

В Яндексе есть возможность узнать частотность запросов разного вида:

- Базовую. Фраза в Вордстат вводится без специальных символов. Результаты неточные, т.к. учитываются все словоформы (разное склонение, дополнительные слова и т.

д.).

д.). - Точную. Фраза вводится в кавычках. Здесь уже показывается более точный результат. Склонение может быть разным, но во фразу не попадут другие слова.

- Утончённую. Вводится с восклицательным знаком и в кавычках: «!запрос !запрос». Даёт самый точный результат, учитываются только конкретные словоформы без склонений и дополнительных слов.

В работе с семантикой лучше ориентироваться на уточненную частотность, а для выявления интересов аудитории – базовую. Проверяя частотность ключей, вы сможете создавать востребованный материал и в целом более успешно продвигаться в сети.

Источник: https://expans.com.ua

Как массово проверить частотность запросов?

Дата обновления: 30.09.2022 Время чтения: 4 мин.

Ленар Амирханов

С 2008 года автор популярного в прошлом SEO-блога yavbloge. ru (в последние годы не обновляется).

В 2011 году основал агентство интернет-рекламы …

ru (в последние годы не обновляется).

В 2011 году основал агентство интернет-рекламы …

Поделиться

Поделитесь статьей с друзьями и коллегами

Работа с семантикой – дело ответственное и сложное. От качества собранного ядра зависит успех продвижения сайта в поисковых системах. Существуют специальные сервисы, с помощью которых можно массово проверить частотность запросов. Они могут быть представлены в виде десктопных программ или онлайн-сайтов, которые не имеют привязки к данным конкретного компьютера. Рассмотрим некоторые из них.

Данная программа является одним из самых популярных инструментов для работы с семантикой. С ее помощью можно собирать, чистить и кластеризовать поисковые запросы. Также можно собирать и частотность.

Сократите бюджет таргетированной и контекстной рекламы с click.ru.

click.ru вернет до 15% от рекламных расходов.

- Перенесите рекламные кабинеты в click.ru.

- Чем больше вы тратите на рекламу, тем больший процент от расходов мы вернем.

- Это настоящие деньги. И click.ru выплатит их на карту, на электронные кошельки, или вы можете реинвестировать их в рекламу.

ПЕРЕЙТИ НА САЙТ

Для того, чтобы проверить частотность ключей, их изначально нужно добавить или собрать. Для этого необходимо воспользоваться кнопкой добавлений поисковых запросов или кнопкой сбора ключей из левой колонки Яндекс.Вордстат.

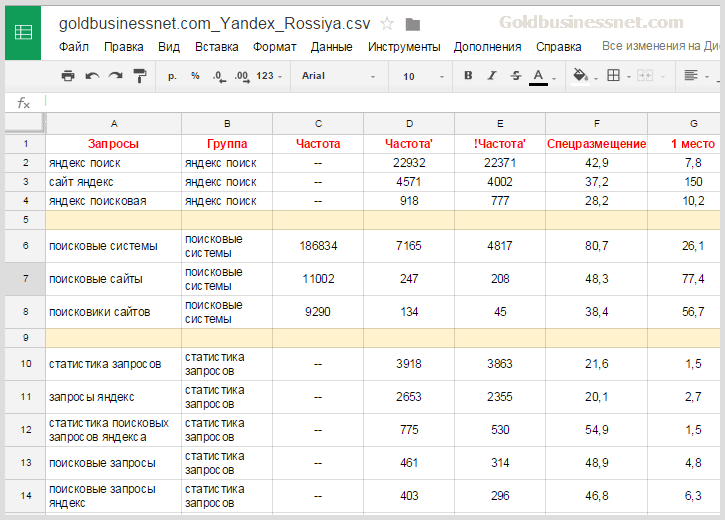

После того, как ключи собраны, можно массово проверить их частотность. Программа поддерживает два варианта сбора частотности: из Яндекс.Директ и из Яндекс.Вордстат.

Первый вариант предпочтительнее, так как процесс сбора частотности происходит намного быстрее, чем во втором случае. Но есть такие ключи, частоту которых невозможно проверить в Директе. Поэтому, после окончания проверки, их частоту можно отдельно допарсить в Вордстате.

Для того, чтобы собрать частотность, нужно воспользоваться кнопками Яндекс.Директа или Яндекс.Вордстата.

В первом случае, требуется задать регион сбора, выбрать тип частотности и нажать на кнопку «Начать сбор».

Во втором случае, необходимо просто выбрать тип частотности.

По окончанию парсинга, значения будут выведены в соответствующих колонках таблицы. Полученный результат можно обработать в самой программе или экспортировать в виде Exel файла.

Онлайн сервис, который является альтернативным вариантом для массовой проверки частотности.

Для работы в этом направлении нужно перейти на вкладку «Сбор частотности» и выставить галочку напротив пункта «!Собрать точную частотность». Это позволит получить значения относительно точного вхождения ключей.

После этого следует добавить перечень ключевых слов. Сервис высчитает стоимость процедуры и выдаст ее на экране. Далее создаем проект и запускаем процесс.

Видео-инструкция по работе с сервисом:

https://youtu.be/XISuKrxU7QI

Все полученные данные можно выгрузить в формате таблицы Exel.

Онлайн-сервис, с помощью которого можно не просто собрать ключевые слова и проверить их частотность, но и узнать уровень конкуренции. При этом, можно смело опираться на показатели сервиса, так как он является ключевым в этом роде аналитики.

При этом, можно смело опираться на показатели сервиса, так как он является ключевым в этом роде аналитики.

Чтобы массово проверить частотность ключей, нужно перейти в раздел «Массовая проверка» и добавить список поисковых запросов.

Список можно добавить вручную или загрузить из текстового документа. Проверка займет какое-то время, по истечению которого будет представлен результат.

Если в процессе работы проверяется запрос, уже обработанный ранее, то стоимость проверки будет равна нулю. Это позволяет сэкономить денежные средства при работе с сервисом.

ЧИТАЙТЕ ТАКЖЕ

Как увеличить трафик из поиска с помощью картинок: 10 основных методов

05.09.2019

Еще один сервис для работы с семантикой и отслеживания позиций сайта в выдаче поисковых систем. Помимо всего прочего, инструмент предоставляет возможность проверки частотности ключей в массовом порядке.

Для того, чтобы начать работать, требуется создать новый проект в системе и ввести ключевые слова, по которым нужно отследить его позиции.

После этого следует перейти в раздел «Проверка позиций и поисковые запросы», на страницах которого и будет отображена частотность.

Обратите внимание! Перед сбором частотности необходимо задать региональную принадлежность сайта. Иначе значения будут получены без всякой ГЕО привязки.

Все данные можно экспортировать в файле таблицы Exel.

Инструмент, с помощью которого можно повысить эффективность работы с семантикой. Он отслеживает позиции сайтов, следит за количеством трафика, получаемого из поисковых систем. Дает советы по доработке перспективных страниц и удалению ненужных, дублирующих документов. После того, как страницы были изменены, он отслеживает их показатели и определяет эффективность внесенных изменений. Также уведомляет обо всех возможных проблемах и возникающих ошибках на сайте.

Помимо этого, инструмент предоставляет возможности работы с семантикой. В их числе есть и массовая проверка частотности.

Для того, чтобы собрать значения, необходимо перейти в раздел «Проверка частотностей».![]()

Если до этого поисковые запросы не были загружены в систему, нужно нажать на кнопку «Новый запрос», расположенную вверху страницы.

Требуется указать наименование группы ключей и сами ключи, выгрузив их из файла или вставив в специальном поле в виде перечня. Кроме этого, необходимо задать регион проверки и выбрать тип частотности. Сервис рассчитает стоимость. Если все устраивает, то можно начинать процесс сбора.

Данные будут представлены в виде таблицы, значения которой можно экспортировать в любом удобном для вебмастера формате.

Основной сбор частотности происходит через Яндекс.Директ, но, как известно, не все ключи можно проверить через этот сервис. Запросы, которые содержат нестандартные символы или состоят более чем из 7 слов, можно проверить только через Яндекс.Вордстат. Для этого нужно поставить соответствующую галочку напротив строки «Проверять нестандартные и 7+ словные запросы через вордстат».

Заключение

Работа с семантикой требует внимания и усидчивости. Для того, чтобы облегчить этот нелегкий процесс, необходимо использовать специальные сервисы, которые предоставляют широкие возможности для работы.

Для того, чтобы облегчить этот нелегкий процесс, необходимо использовать специальные сервисы, которые предоставляют широкие возможности для работы.

Кому-то удобнее работать с программами, например, с Кей Коллектором. А кто-то предпочитает онлайн-сервисы, не привязанные к конкретному компьютеру. Так или иначе, все варианты предназначены для того, чтобы получить наиболее правдоподобный и эффективный результат.

Вам понравилась статья? 13 2

Ограничить частоту запросов каждого IP с использованием NGINX и Lua

Задавать вопрос

спросил

Изменено 8 месяцев назад

Просмотрено 3к раз

Моя цель — предотвратить частые запросы на основе IP-адреса пользователя, и я погуглил openresty и обнаружил, что его можно воспроизвести с Lua. Итак, я написал следующий скрипт, я новичок в Lua, может ли кто-нибудь дать мне совет по этому скрипту или даже поправить меня.

Итак, я написал следующий скрипт, я новичок в Lua, может ли кто-нибудь дать мне совет по этому скрипту или даже поправить меня.

этот скрипт предназначен для блокировки запросов, которые запрашиваются более 3 раз за 100 секунд

local limit_request_times = 3

локальное expire_time = 100

локальный user_ip = ngx.var.remote_addr

-- ngx.say("user_ip: ", user_ip)

локальный Redis = требуется "resty.redis"

локальный красный = Redis: новый ()

красный: set_timeout (1000)

локальный в порядке, ошибка = красный: подключить ("127.0.0.1", 6379)

если не ок тогда

ngx.say("не удалось подключиться: ", ошибка)

возвращаться

конец

локальное разрешение, ошибка = красный: получить (user_ip)

если res == ngx.null, то

ngx.say («нет записи запроса, добавьте этот user_ip в Redis»)

хорошо, ошибка = красный: набор (user_ip, 1)

если не ок тогда

-- ngx.say("не удалось добавить user_ip")

ngx.exit(ngx.HTTP_ЗАПРЕЩЕНО)

возвращаться

еще

красный: истекает (user_ip, expire_time)

конец

еще

если tonumber(res) == limit_request_times тогда

-- ngx. say("запрос достигает максимального количества раз")

ngx.выход (403)

возвращаться

еще

хорошо, ошибка = красный: incr (user_ip)

если не ок тогда

ngx.say("не удалось увеличить время запроса")

возвращаться

еще

ngx.say («увеличить время запроса:», res + 1)

конец

конец

конец

say("запрос достигает максимального количества раз")

ngx.выход (403)

возвращаться

еще

хорошо, ошибка = красный: incr (user_ip)

если не ок тогда

ngx.say("не удалось увеличить время запроса")

возвращаться

еще

ngx.say («увеличить время запроса:», res + 1)

конец

конец

конец

- nginx

- lua

- openresty

Почему бы просто не использовать встроенный модуль nginx ngx_http_limit_req_module?

напр. Мы ограничиваем не более 2-х запросов в минуту с одного IP-адреса。

http {

limit_req_zone $binary_remote_addr zone=one:10m rate=2r/m;

...

сервер {

...

местоположение /поиск/ {

limit_req zone=один пакет=3 nodelay;

}

9

Также можно использовать resty.limit.conn и/или resty.limit.req модулей через Lua https://nginx-extras.getpagespeed. com/lua/limit-traffic/

com/lua/limit-traffic/

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя электронную почту и пароль

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

node.

js — широковещательные сообщения на высокой частоте. Использование HTTP POST или что-то еще?

js — широковещательные сообщения на высокой частоте. Использование HTTP POST или что-то еще?спросил

Изменено 10 лет, 8 месяцев назад

Просмотрено 584 раза

Мы рассматриваем возможность создания системы, которая рассылает небольшие объемы часто меняющихся данных (используя JSON, XML или что-то подобное) нескольким получателям с достаточно высокой частотой (наши обновления будут выполняться 1000 раз в секунду).

Первоначально мы думали об использовании HTTP POST для передачи данных на каждую конечную точку, может быть, раз в несколько секунд (клиенты будут различаться, поскольку они являются веб-приложениями других людей), но теперь нам интересно, есть ли лучший способ хранения до нагрузки/частоты, на которую мы надеемся. Я предполагаю, что нам нужно было бы как минимум отмечать версию/временную отметку сообщений.

Я предполагаю, что нам нужно было бы как минимум отмечать версию/временную отметку сообщений.

Мы используем RabbitMQ для подготовки всех вещей, готовых к отправке, и выбора того, что нужно куда отправить (из приложения Django, если это имеет значение), но мы не можем заставить все конечные точки использовать MQ.

HTTP POST кажется не совсем правильным. На что еще мы должны обратить внимание? Подходит ли это для таких вещей, как node, socket.io или какие-то новые фреймворки реального времени? Мы рады найти правильный опыт, чтобы помочь с этим, просто нужно направить правильное направление.

Спасибо!

- node.js

- socket.io

- широковещательный

- широковещательный

1

Вы не хотите выполнять тысячи POST-запросов в секунду для нескольких клиентов. Вы собираетесь ввести накладные расходы HTTP на своем конце, чтобы вытолкнуть его, и, насколько вам известно, вы можете в конечном итоге затопить сервер на другом конце POST-запросами, которые просто захлестнут его.

Вариант 1. Для клиентов, которые не могут или не хотят читать очередь, могут работать POSTS, но, чтобы избежать остановки сервера и всех накладных расходов HTTP, не могли бы вы объединить обновления? Раз в минуту-две брать все сводные данные и потом отправлять их клиенту? Таким образом, у вас не будет 60+ POST-запросов к одному клиенту каждую минуту или две в течение времени и вечности. Это также поможет сэкономить на пропускной способности, поскольку вы отправляете всю информацию заголовка только один раз с дополнительными данными, а не отправляете всю информацию заголовка и фрагменты данных.

Вариант 2. Думали ли вы об использовании хорошего соединения со старыми сокетами? Либо вы открываете сокет для клиента, либо наоборот, и передаете данные через него? Это позволяет избежать накладных расходов HTTP и позволяет клиенту считывать данные с той скоростью, с которой они приходят. Если клиент больше не хочет получать данные, он может просто закрыть соединение. Это немного загадочно, но это позволит избежать полной гибели целевого сервера.

д.).

д.).

say("запрос достигает максимального количества раз")

ngx.выход (403)

возвращаться

еще

хорошо, ошибка = красный: incr (user_ip)

если не ок тогда

ngx.say("не удалось увеличить время запроса")

возвращаться

еще

ngx.say («увеличить время запроса:», res + 1)

конец

конец

конец

say("запрос достигает максимального количества раз")

ngx.выход (403)

возвращаться

еще

хорошо, ошибка = красный: incr (user_ip)

если не ок тогда

ngx.say("не удалось увеличить время запроса")

возвращаться

еще

ngx.say («увеличить время запроса:», res + 1)

конец

конец

конец