30 бесплатных программ для парсинга сайтов в 2020 году — Сервисы на vc.ru

Моя компания занимается парсингом сайтов в России уже более трёх лет, ежедневно мы парсим более 500 крупнейших интернет-магазинов в России. На выходе мы, как правило, отдаем данные в формате Excel/CSV. Но существуют и другие решения — готовые сервисы (конструкторы) для запуска парсинга практически без программирования. Ниже их список, краткая аннотация и рейтинг к каждому.

129 053 просмотров

Парсинг сайтов — автоматизированный процесс извлечения данных или информации с веб-страниц. После извлечения необходимых данных по ним можно осуществлять поиск, переформатировать их, копировать и так далее.

Программное обеспечение для парсинга веб-страниц используется большинством компаний, занимаются они маркетингом, исследованиями или анализом данных. Парсинг полезен для сравнения продуктов и цен, поиска отзывов о товарах ваших конкурентов, поиска информации для размещения на вашем сайте или извлечения огромных объемов данных с веб-сайтов для проведения соответствующих маркетинговых исследований и так далее.

Ищете ли вы потенциальных клиентов, проводите анализ рынка или собираете данные для проверки своих моделей машинного обучения — вам так или иначе нужно получать данные со сторонних ресурсов. Вот некоторые из лучших бесплатных (или условно бесплатных) программ для парсинга веб-страниц с независимым рейтингом.

1. Mozenda

Mozenda помогает компаниям в сборе и организации данных наиболее экономичным и эффективным способом. Компания предлагает облачную архитектуру, которая обеспечивает масштабируемость, простоту использования и быстрое развертывание.

Внедрить Mozenda можно довольно быстро, к тому же развернуть это ПО можно за считанные минуты на уровне бизнес-подразделения без какого-либо участия ИТ-отдела. Его простой point-and-click интерфейс помогает пользователям создавать проекты и быстро экспортировать результаты, самостоятельно или по расписанию.

Благодаря простоте интеграции пользователи могут публиковать полученные результаты в формате CSV, TSV, XML или JSON.

- Лучшая функция: безопасная облачная среда.

- Сайт: mozenda.com.

- Минусы: крутая кривая обучения.

- Рейтинг Capterra: 4,5/5.

- Рейтинг G2 Crowd: 4/5.

- Рейтинг TrustRadius: 9,5/10.

- Награды: один из «200 лучших программных продуктов для бизнес-аналитики» от FinancesOnline.

Что говорят пользователи (упоминания в социальных сетях): «Мне понравилось, как быстро можно настроить программу и собрать данные с сайтов. Я мог бы начать новый проект, задать параметры и начать собирать данные за несколько часов. Данные почти всегда собираются в правильном формате, без каких-либо пробелов. Инструмент прост в использовании и ограничен только тарифным планом».

2. Automation Anywhere

Компания Automation Anywhere состоит из группы экспертов, которые сосредоточены на предоставлении полностью понимаемых и гибких процессов создания ботов, предназначенных для автоматизации задач.

Такие боты не только просты в использовании, но и достаточно мощны, чтобы автоматизировать задачи любого уровня сложности. Это единственная роботизированная платформа, разработанная для современных предприятий, которая может создавать программных ботов для автоматизации задач от начала и до конца.

- Лучшая особенность: гибкие инструменты автоматизации процессов.

- Сайт: automationanywhere.com/in.

- Минусы инструмента: сложный процесс проектирования.

- Рейтинг Capterra: 4,5/5.

- Рейтинг G2 Crowd: 4,5/5.

- Рейтинг TrustRadius: 8,3/10.

- Награды: Frost and Sullivan Award.

Что говорят пользователи: «Automation Anywhere — это отличная платформа, создающая ботов, которые выполняют все типы задач и рейтинг сокращающих ручной труд. Она предоставляет нам множество встроенных функций. Мне нравится больше всего валидация PDF-документов, с высокой точностью и большой скоростью. Это помогает мне увеличить производительность».

Мне нравится больше всего валидация PDF-документов, с высокой точностью и большой скоростью. Это помогает мне увеличить производительность».

3. Beautiful Soup

Предоставляя вам простые шаги и идиомы Python для навигации, Beautiful Soup дает доступ к инструментам извлечения любой необходимой информации. Программное обеспечение для парсинга веб-страниц автоматически преобразует входящие документы в Unicode и исходящие документы в UTF-8. Это позволяет вам использовать различные стратегии парсинга или изменять скорость и гибкость процессов.

- Лучшая особенность: Python-идиомы для работы и извлечения информации.

- Сайт: crummy.com/software/BeautifulSoup/.

- Рейтинг G2 Crowd: 4,5/5.

- Рейтинг Capterra: нет.

- Рейтинг TrustRadius: нет.

4. Web Harvy

Интерфейс Web Harvy позволяет легко выбрать элементы с нужной информацией. Извлеченные данные могут быть сохранены в файлы CSV, JSON, XML или в базе данных SQL.

Извлеченные данные могут быть сохранены в файлы CSV, JSON, XML или в базе данных SQL.

В этом программном обеспечении имеется многоуровневая система парсинга категорий, которая может отслеживать ссылки на категории любых уровней и извлекать данные со страниц со списками. Инструмент предлагает вам большую гибкость и дает возможность использовать регулярные выражения.

- Лучшая функция: очень простой в использовании интерфейс.

- Сайт: webharvy.com.

- Минусы: скорость работы.

- Рейтинг Capterra: 4,5/5.

- Рейтинг Predictive Analysis Today: 8,1/10.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Мне нравится, как они сделали короткие обучающие видео. Это делает инструмент очень простым в использовании. Компания даже помогает использовать регулярные выражения для извлечения определенных текстов».

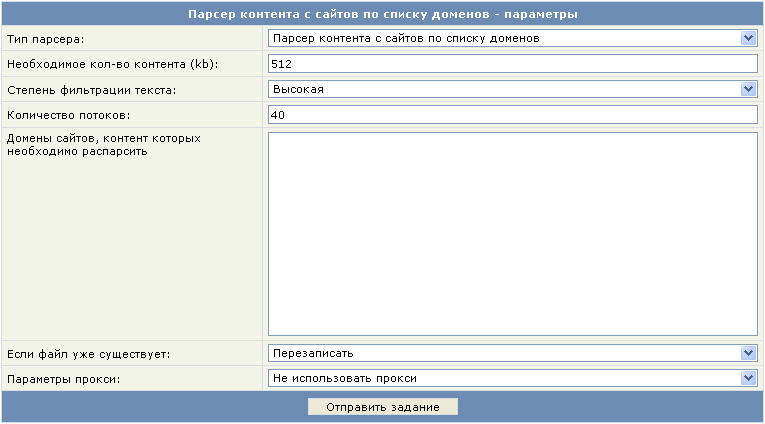

5. Content Grabber

Простой интерфейс Content Grabber имеет прекрасную возможность автоматического обнаружения и настройки команд. Он мгновенно создает списки контента, обрабатывает нумерацию страниц и веб-форм, а также сам скачивает или закачивает файлы.

Content Grabber может извлекать контент с любого сайта, а затем сохранять его в виде структурированных данных в нужном вам формате, будь то таблицы Excel, XML, CSV или большинство из используемых сейчас баз данных. Его высокая производительность и стабильность обеспечивается оптимизированными браузерами, а также отлаженным процессом парсинга.

Примечание: компания также разрабатывает и продает Content Grabber Enterprise (CG Enterprise), который является премиальным продуктом для извлечения данных с сайтов, и он сегодня считаем самым современным инструментом на рынке.

- Лучшая функция: настраиваемый пользовательский интерфейс.

- Сайт: contentgrabber.com/.

- Минусы инструмента: мало поддержки.

- Рейтинг Predictive Analysis Today: 9,5/10.

- Рейтинг Software Advice: 5/5.

- Рейтинг G2 Crowd: 4/5.

- Рейтинг Capterra: нет.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Прост в использовании, не требует специальных навыков программирования. Возможность получения данных с целевых сайтов за считанные минуты. Отлично подходит для создания списка потенциальных клиентов».

6. FMiner

FMiner поддерживает как Windows, так и Mac, он имеет интуитивно понятный интерфейс и чрезвычайно прост в использовании. У этой программы мощный инструмент визуального дизайна, который фиксирует каждый ваш шаг и моделирует процесс сбора информации, когда вы взаимодействуете с целевыми страницами сайта.

FMiner позволяет собирать данные с различных веб-сайтов, включая онлайн-каталоги продукции, объявления о недвижимости и каталоги желтых страниц.

- Лучшая функция: несколько вариантов обхода сайтов.

- Сайт: fminer.com.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

7. Import.io

Import.io — признанный инструмент парсинга, который позволяет без проблем извлекать данные с сайтов. Все, что вам нужно сделать, это ввести URL-адрес, и система немедленно превратит страницы в данные.

Это программное обеспечение является идеальным решением для мониторинга цен, чтобы определить ожидания рынка и найти наиболее оптимальную цену. Он помогает вам генерировать качественные лиды и предоставляет ежедневные или ежемесячные обновления, чтобы помочь отслеживать действия конкурентов.

- Лучшая функция: гибкая настройка обхода сайтов.

- Сайт: import.io/.

- Минусы: не очень удобный интерфейс.

- Рейтинг Capterra: 4/5.

- Рейтинг G2 Crowd: 4/5.

- Рейтинг TrustRadius: 2,9/10.

- Рейтинг Predictive Analysis Today: 7,3/10.

- Полученные награды: Лучший новичок в Londata Awards 2012.

Что говорят пользователи: «С помощью интеллектуального извлечения данных легко начать работу, можно сделать многое и без регулярных выражений или настройки запросов — масштабируемость — отличная поддержка».

8. Visual Web Ripper

Visual Web Ripper — это продвинутый парсер для веб-страниц, который позволяет извлекать данные с динамических страниц, из каталогов продуктов, сайтов с объявлениями или финансовых сайтов.

После извлечения данных он помещает их в удобную и структурированную базу данных, электронную таблицу, файл CSV или XML. Поскольку он может обрабатывать сайты с поддержкой AJAX и многократно отправлять формы со всеми возможными значениями, он может работать там, где остальные парсеры пасуют.

- Лучшая функция: работа через командную строку.

- Сайт: visualwebripper.com/.

- Минусы инструмента: высокая цена.

- Рейтинг Capterra: 4/5.

- Рейтинг G2 Crowd: 5/5.

- Рейтинг Predictive Analysis Today: 7,1/10.

- Рейтинг Scraping Pro: 4,7/5.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Visual Web Ripper сэкономил мое время, помог собрать нужную информацию со многих веб-сайтов. Если вы захотите получить информацию, Visual Web Ripper вас не подведет».

9. Webhose.io

Webhose.io по запросу предоставляет вам доступ к структурированным веб-данным. Это позволяет создавать, запускать и масштабировать операции с большими данными независимо от того, являетесь ли вы исследователем, предпринимателем или руководителем компании.

Программное обеспечение структурирует, хранит и индексирует миллионы веб-страниц в день в разных вертикалях, таких как новости, блоги и онлайн-обсуждения.

- Лучшая функция: доступен на 80 языках.

- Сайт: webhose.io/.

- Рейтинг Capterra: 5/5.

- Рейтинг G2 Crowd: 4/5.

- Рейтинг Predictive Analysis Today: 4,3/10.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Сервис позволяет вам обращаться к множеству общедоступных данных, которые можно просто использовать для создания бизнес-инструментов».

10. Scrapinghub Platform

Scrapinghub Platform известна тем, что создает, разворачивает и запускает веб-краулеры, обеспечивая получение новейшей информации. Данные можно легко просмотреть в красивом интерфейсе. Программное обеспечение также предоставляет вам платформу с открытым исходным кодом под названием Portia, которая предназначена для парсинга веб-сайтов.

Вы можете создавать шаблоны, нажимая на элементы на странице, а Portia обработает все остальное. Компания также создает автоматизированную утилиту, которая удаляет похожие страницы с веб-сайта.

- Лучшая функция: база данных обнаружения банов.

- Сайт: scrapinghub.com/platform.

- Минусы: недостаточно документации.

- Рейтинг Capterra: 4,5/5.

- Рейтинг G2 Crowd: 4/5.

- Рейтинг Predictive Analysis Today: 8,1.

- Рейтинги от TrustRadius: нет.

Что говорят пользователи: «Четкий, подробный и прозрачный процесс. Удаленная и гибкая рабочая среда. Чрезвычайно дружелюбная обстановка для работы и прекрасный менеджмент».

11. Helium Scraper

Helium Scraper предлагает гибкий, интуитивно понятный интерфейс, который чрезвычайно прост. У этого инструмента широкий выбор настроек, так что вы можете выбрать те, которые необходимы вам. Вы можете просматривать сайты, извлекать и сохранять данные.

Вы можете просматривать сайты, извлекать и сохранять данные.

Уникальное предложение Helium Scraper — функция «укажи и щелкни», которая позволяет быстро и с минимальными нагрузками проводить извлечение данных. Helium Scraper позволяет своим пользователям выбрать то, что нужно извлечь, с помощью нескольких простых кликов. У инструмента есть возможность добавлять собственные расширения, написанные на .NET.

- Лучшая функция: поддерживает несколько форматов экспорта.

- Сайт: www.heliumscraper.com/eng/.

- Рейтинг Capterra: Рейтинги не предоставлены.

- Рейтинг SoftPedia: 4,6/5.

- Рейтинг CrowdReviews: 4/5.

- Рейтинг Scraping Pro: 4,5/5.

12. GNU Wget

GNU Wget помогает получать данные с использованием HTTP, HTTPS и FTP, наиболее используемых интернет-протоколов. Он может легко извлекать большие файлы, а также выполнять зеркалирование целых веб- или FTP-сайтов. Программное обеспечение работает хорошо, даже если соединение медленное или нестабильное.

Программное обеспечение работает хорошо, даже если соединение медленное или нестабильное.

- Лучшая функция: поддерживает HTTP-куки.

- Сайт: www.gnu.org.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

- Рейтинги от Predictive analysis Today: 8,4/10.

- Рейтинг SoftPedia: 3,1/5.

13. Web Scraper

Web Scraper предлагает два варианта: расширение для Google Chrome и облачную платформу. Программное обеспечение создает карты сайтов и перемещается по ним для извлечения необходимых файлов, изображений, текстов и ссылок.

Оно может выполнять несколько операций парсинга и извлечения больших объемов данных одновременно, а также позволяет экспортировать очищенные данные, например в CSV.

- Лучшая функция: извлечение данных из документов современных веб-форматов.

- Сайт: webscraper.io/.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

- Рейтинг Predictive Analytics сегодня: 8,2/10.

14. IEPY

IEPY поставляется с инструментом анализа текстов и веб-интерфейсом. Его главная ценность — извлечение информации с пониманием взаимоотношений внутри нее в большом масштабе.

- Лучшая функция: инструмент для аннотаций естественного языка.

- Сайт: buildmedia.readthedocs.org/media/pdf/iepy/latest/iepy.pdf.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

15. ScrapingExpert

Если речь идет об извлечении информации о потенциальных клиентах, ценах, конкурентах и поставщиках, то ваш выбор — ScrapingExpert. Этот инструмент помогает расширить знания о вашей целевой аудитории, доле рынка, ценовой политике и поставках сырья, предоставляя вам информацию, связанную с вашими конкурентами и их продуктами, а также с доступными дилерами.

Этот инструмент помогает расширить знания о вашей целевой аудитории, доле рынка, ценовой политике и поставках сырья, предоставляя вам информацию, связанную с вашими конкурентами и их продуктами, а также с доступными дилерами.

Его уникальные функции включают поддержку на сайте, панель управления на одном экране, управление прокси и настройку учетных данных на нужных сайтах.

- Лучшая функция: опции «Пуск», «Стоп», «Пауза» и «Сброс».

- Сайт: scrapingexpert.com/.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

16. Ficstar

Благодаря мощной технологии парсинга веб-страниц, Ficstar позволяет вам делать более осмысленные шаги в области создания и реализации компетентных бизнес-стратегий.

Он помогает в сборе больших данных, достигая даже самых дальних уголков интернета. Помимо того, что Ficstar безопасен и надежен, он прекрасно интегрируется в любую базу данных, и собранные данные можно сохранять в любом формате.

Помимо того, что Ficstar безопасен и надежен, он прекрасно интегрируется в любую базу данных, и собранные данные можно сохранять в любом формате.

- Лучшая функция: мониторинг социальных сетей.

- Сайт: ficstar.com/.

- Минусы: из-за принципа действия этого парсера, внешние факторы, которые находятся вне вашего контроля, могут замедлять доставку результатов.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

- Рейтинг Predictive Analytics Today: 8,3/10.

17. QL2

QL2 помогает своим пользователям управлять бизнес-процессами, ценами и доходами. Используя свою технологию поиска в реальном времени, это программное обеспечение помогает компаниям ежедневно выполнять многочисленные запросы.

Оно предоставляет своим пользователям всесторонние и актуальные данные о текущем рынке и целевой аудитории. QL2 получает информацию с разных платформ и помогает вам выполнять более глубокие и интенсивные исследования.

QL2 получает информацию с разных платформ и помогает вам выполнять более глубокие и интенсивные исследования.

- Лучшая функция: предоставляет информацию о рынке.

- Сайт: ql2.com/.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

- Рейтинг Predictive Analytics Today: 8,4/10.

18. Frontera

Система парсинга веб-страниц Frontera состоит из инструмента обхода сайтов и примитивов распространения/масштабирования. Платформа заботится обо всей логике и политиках, которые необходимо соблюдать во время процесса парсинга.

Она хранит и задает приоритеты в извлеченных данных, чтобы решить, какую страницу посетить в следующий раз, и делает все это осмысленным образом.

- Лучшая особенность: поддержка Python 3.

- Сайт: github.

com/scrapinghub/frontera.

com/scrapinghub/frontera. - Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

19. Apify

Apify предлагает специальные функции, а именно RequestQueue и AutoscaledPool. Он позволяет начать с нескольких URL-адресов, а затем переходить по ссылкам на другие страницы и запускать задачи извлечения данных с максимальной производительностью.

Доступные форматы данных – JSON, JSONL, CSV, XML, XLSX или HTML с CSS. Он поддерживает любой тип сайтов и имеет встроенную поддержку Puppeteer.

- Лучшая функция: RequestQueue и AutoscaledPool.

- Сайт: apify.com/.

- Рейтинг Capterra: 5/5.

- Рейтинг G2 Crowd: 4/5.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Я запустил все буквально в течение нескольких минут. Нет необходимости изучать новые языки программирования или навыки».

Нет необходимости изучать новые языки программирования или навыки».

20. WebSundew

WebSundew, с его инструментами получения и очистки данных, позволяет пользователям извлекать информацию с сайтов быстрее. Программное обеспечение для сбора данных получает данные с веб-сайтов с чрезвычайно высокой точностью и скоростью.

Сотрудники компании помогут вам настроить агента для извлечения данных, который будет работать над парсингом страниц.

- Лучшая особенность: ориентированная на клиента профессиональная поддержка.

- Сайт: websundew.com/.

- Рейтинг Scraping Pro: 4/5.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет

21. Grepsr

Grepsr помогает вам просто управлять процессом извлечения данных с веб-страниц. Компании могут использовать получаемую информацию для поиска потенциальных клиентов, мониторинга цен, исследований рынка или агрегации контента.

Это удобное программное обеспечение для поиска в интернете имеет такие функции, как неограниченная скорость сканирования, однократное извлечение, глубокий и поэтапный обход, API и пользовательские интеграции. Grepsr предоставляет компаниям удобные для заполнения онлайн-формы, чтобы помочь им уточнить свои требования к данным, а также позволяет планировать сканирование в календаре.

- Лучшая функция: неограниченная скорость сканирования.

- Сайт: grepsr.com.

- Рейтинг Capterra: 4,5/5.

- Рейтинг GetApp: 4,66/5.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Это как щелкать выключателем или отвечать на телефонные звонки — все работает надежно и точно».

22. BCL

BCL — это специальное программное обеспечение для сканирования веб-страниц, которое сокращает не только время, необходимое для сбора данных, но и общее время рабочих процессов.

Решения BCL для извлечения данных и обработки информационных потоков помогают упростить процесс парсинга для каждой организации, которая решит его использовать.

- Лучшая функция: преобразование PDF.

- Сайт: bcltechnologies.com.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

23. Connotate Cloud

Connotate Cloud достаточно эффективен для извлечения данных с сайтов, использующих JavaScript и Ajax. Это программное обеспечение для поиска в Интернете легко внедрить, к тому же оно использует передовые алгоритмы машинного обучения. Connotate Cloud не зависит от языка, что означает, что он может извлекать данные на любых языках.

Connotate Cloud анализирует содержимое и выдает предупреждения в случае необходимости каких-либо изменений. Его point-and-click интерфейс обладает мощными возможностями обработки, которые могут нормализовать контент сразу на нескольких сайтах. Кроме того, это ПО помогает автоматически связывать контент с соответствующими метаданными.

Кроме того, это ПО помогает автоматически связывать контент с соответствующими метаданными.

- Лучшая особенность: независимость от языка.

- Сайт: connotate.com/.

- Минусы: выявление пробелов и их устранение может занять много времени.

- Рейтинг Каптерры: 4/5.

- Рейтинг Predictive Analytics Today: 8,7/10.

- Рейтинг TrustRadius: нет.

- Рейтинг G2 Crowd: нет.

Что говорят пользователи: «Connotate является гибким и интеллектуальным и позволяет моей команде еженедельно контролировать десятки тысяч веб-сайтов».

24. Octoparse

Будучи визуальным инструментом, Octoparse обладает point-and-click интерфейсом и позволяет легко выбирать данные, которые нужно получить с веб-сайта.

Программное обеспечение может управлять как статическими, так и динамическими сайтами с помощью AJAX, JavaScript, файлов cookie и так далее. Оно также предлагает расширенные облачные сервисы, позволяющие извлекать большие объемы данных. Извлеченные данные можно экспортировать в форматы TXT, CSV, HTML или XLSX.

Оно также предлагает расширенные облачные сервисы, позволяющие извлекать большие объемы данных. Извлеченные данные можно экспортировать в форматы TXT, CSV, HTML или XLSX.

- Лучшая функция: извлечение данных в любом формате.

- Сайт: octoparse.com.

- Минусы: достаточно сложный инструмент.

- Рейтинг Capterra: 4,5/5.

- Рейтинг TrustRadius: 9,4/10.

- Рейтинги от G2: 3,5/5.

- Рейтинг Software Advice: 4,63/5.

- Рейтинг Predictive Analytics Today: 9,6/10.

Что говорят пользователи: «Он простой, дружелюбный, интуитивно понятный и имеет линейный процесс взаимодействия».

25. Scrapy

Scrapy позволяет пользователям эффективно извлекать данные с сайтов, обрабатывать их и хранить в любом формате или структурах, которые они предпочитают. Одной из его уникальных особенностей является то, что он построен на основе асинхронной сетевой структуры Twisted. Среди других интересных особенностей Scrapy — простота использования, подробная документация и активное сообщество.

Одной из его уникальных особенностей является то, что он построен на основе асинхронной сетевой структуры Twisted. Среди других интересных особенностей Scrapy — простота использования, подробная документация и активное сообщество.

- Лучшая функция: встроенные расширения и промежуточное программное обеспечение (middleware).

- Сайт: scrapy.org/.

- Рейтинг Predictive Analysis Today: 8,4/10.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

26. Parsehub

Функции Parsehub для парсинга веб-страниц позволяют сканировать как один, так и сразу несколько веб-сайтов с поддержкой JavaScript, AJAX, файлов cookie, сеансов и редиректов.

Он может анализировать и получать данные с разных веб-сайтов и преобразовывать их в значимую информацию. Программное обеспечение использует технологию машинного обучения для распознавания наиболее сложных документов и создает выходной файл в формате JSON, CSV, Google Sheets или отдает данные через API.

- Лучшая особенность: технология машинного обучения.

- Сайт: parsehub.com.

- Минусы: не слишком удобный.

- Рейтинг Capterra: 4,5/5.

- Рейтинг TrustRadius: нет.

- Рейтинг G2 Crowd: 3,5/5.

Что говорят пользователи: «Извлекает информацию с большинства веб-страниц и не требует от вас глубоких знаний. Базовая функциональность проста в использовании, а расширенной можно научиться и она очень сильна».

27. OutwitHub

OutwitHub — лучший вариант, если вы хотите собирать данные, которые не всегда доступны. Он использует свои функции автоматизации для последовательного просмотра страниц, а затем выполняет задачи извлечения данных.

Информация может быть экспортирована в различных форматах, включая JSON, XLSX, SQL, HTML и CSV. OutWitHub можно использовать как в качестве расширения, так и в качестве отдельного приложения.

- Лучшая функция: может экспортировать данные в различных форматах.

- Сайт: outwit.com/.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

- Рейтинг Scrapingpro: 4,5/5.

- Рейтинг Softpedia: 4,9/5.

28. Dexi.io

Ранее известный как CloudScrape, Dexi.io предоставляет различные типы роботов для выполнения операций в вебе — сканеры, экстракторы, автоботы и так далее.

Роботы-экстракторы являются наиболее продвинутыми, так как они позволяют вам выбрать любое действие, которое вы хотите, чтобы выполнил робот, например, нажатие кнопок или получение скриншотов. Программное обеспечение для поиска также предлагает несколько интеграций со сторонними сервисами.

- Лучшая особенность: роботы-экстракторы.

- Сайт: dexi.

io.

io. - Минусы инструмента: «рваный» пользовательский опыт.

- Рейтинг Capterra: 4,5/5.

- Рейтинг GetApp: 4,6/5.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

Что говорят пользователи: «Я рад решению, которому легко научиться, а кроме того благодарен команде Dexi за помощь в настройке первой пары операций».

29. PySpider

PySpider обладает распределенной архитектурой, которая поддерживает JavaScript-страницы и позволяет иметь сразу несколько сканеров. Он может хранить данные в выбранном вами бэкэнде, таком как MongoDB, MySQL, Redis и так далее.

RabbitMQ, Beanstalk и Redis могут использоваться в качестве очередей сообщений. Пользовательский интерфейс PySpider прост в использовании и позволяет редактировать сценарии, отслеживать текущие задачи и просматривать результаты.

- Лучшая особенность: простой в использовании интерфейс.

- Сайт: docs.pyspider.org/en/latest/.

- Рейтинг Capterra: нет.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

30. Spinn3r

Если вы хотите собрать целую кучу данных из блогов, новостных сайтов, социальных сетей и RSS-каналов, Spinn3r станет отличным вариантом. Программное обеспечение использует Firehose API, который управляет 95% работ по сканированию и индексированию.

Вам предоставляется возможность фильтровать данные, которые он получает, по ключевым словам, что помогает отсеивать нерелевантный контент.

- Лучшая функция: Firehose API.

- Сайт: docs.spinn3r.com.

- Рейтинг Capterra: 5/5.

- Рейтинг G2 Crowd: нет.

- Рейтинг TrustRadius: нет.

Резюмируя

В наши дни парсинг стал неотъемлемой частью обработки данных. Компании и организации, как большие, так и малые, хотят сканировать сайты для сбора необходимых данных и принятия выгодных и эффективных решений на их основе. Это бесплатное программное обеспечение может помочь вам в этом процессе. Их уникальные функции и всеобъемлющий набор спецификаций дадут вам именно те инструменты для поиска в интернете, которые вы ищете.

9 лучших сервисов для парсинга сайтов

5000

| SEO | – Читать 17 минут |

Прочитать позже

Анастасия Сотула

Редактор блога Serpstat

SEO-специалисты постоянно собирают и анализируют большие объемы информации. Если сбор выполняется вручную, то занимает много времени. В результате снижается продуктивность труда. Использование парсеров позволяет решить эту проблему.

В статье мы познакомим вас с актуальными инструментами парсинга, это поможет быстро и эффективно выбирать необходимые данные для задач поискового продвижения. Надеемся, они помогут вывести вашу работу на качественно новый уровень.

Надеемся, они помогут вывести вашу работу на качественно новый уровень.

Содержание

Что такое парсинг сайтов и как он помогает SEO-специалисту?

— Алгоритм парсинга

— Парсинг и закон

— Какие данные и элементы можно спарсить?

Лучшие инструменты парсинга для SEO-специалиста

— Netpeak Spider

— Netpeak Checker

— A-Parser

— import.io

— ParseHub

— Screaming Frog SEO Spider

— ComparseR

— Google Spreadsheets

— Serpstat

FAQ

Домашнее задание

Платные и бесплатные парсеры сайтов используются для автоматизированного сбора информации из разных источников. Многие программы дополнительно выполняют анализ и преобразование данных с целью их структурированного представления. В основном для упорядочивания применяются таблицы.

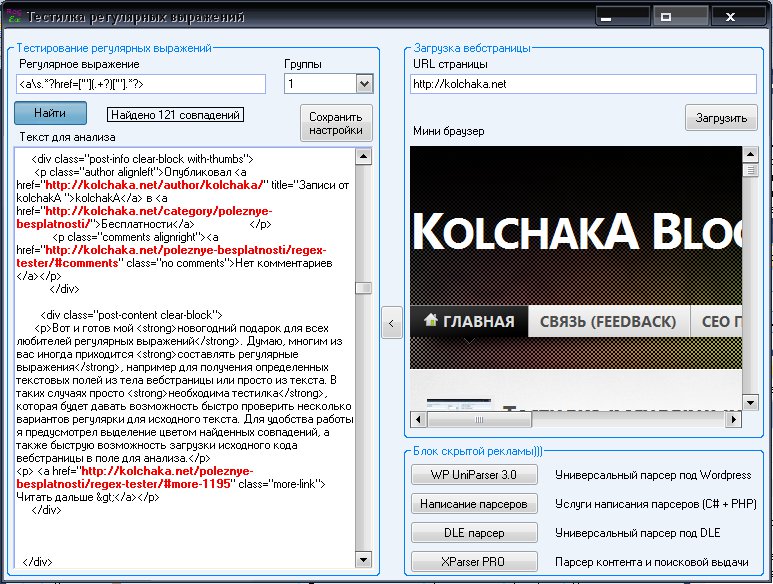

В программном смысле сбор информации – достаточно трудный процесс. Для написания стабильно работающего парсера надо хорошо разбираться в регулярных выражениях и языке запросов XPath. Плюс уметь обрабатывать ошибки и ответы страниц. Естественно, нельзя обойтись без навыка программирования хотя бы на среднем уровне.

Плюс уметь обрабатывать ошибки и ответы страниц. Естественно, нельзя обойтись без навыка программирования хотя бы на среднем уровне.

Большинство SEO-специалистов не располагают глубокими знаниями в IT-технологиях. Потому сбор данных вызывает у них проблемы. К счастью, профессиональные разработчики ПО давно придумали программы для парсинга информации. Разобраться со многими из них не составит труда даже далекому от программирования человеку.

Современные инструменты веб-парсинга осуществляют извлечение данных как с единичных, так и многочисленных веб-ресурсов. В зависимости от функционала, ПО производит автоматический сбор мета-тегов, котировок валют, расписаний авиарейсов, описаний продукции интернет-магазинов и пр.

Алгоритм парсинга

1. Поиск источника для сбора информации.

2. Парсинг HTML-кода страниц.

3. Составление отчета согласно установленным параметрам.

Третий пункт опциональный, так как инструменты парсинга сайтов не всегда поддерживают функционал по формированию отчетов и структурированию информации. Например, простые самописные скрипты на PHP или Python зачастую сохраняют извлеченные из веб-страниц данные в обычные текстовые документы. Затем они обрабатываются другими программами или анализируются в исходном виде.

Например, простые самописные скрипты на PHP или Python зачастую сохраняют извлеченные из веб-страниц данные в обычные текстовые документы. Затем они обрабатываются другими программами или анализируются в исходном виде.

Главное преимущество, которое сочетает любой инструмент парсинга данных, заключается в экономии времени. Допустим, SEO-специалист решил заняться сбором данных конкурентов. Для этого ему надо скопировать и структурировать внушительный объем информации со 100 сайтов. Вручную процесс рискует затянуться на десятки часов. Правильно настроенный парсер справится гораздо быстрее.

Не стоит забывать и про человеческий фактор. Людей утомляет однообразная работа. Чем дольше работаешь в таком режиме, тем сильнее устаешь и совершаешь больше ошибок. Программы лишены недостатков человека. Главное, правильно указать, что можно и нельзя парсить. Об остальном позаботится ПО. Задаете настройки, идете пить чай или кофе, приходите, а нужная информация собрана. Удобство и практичность налицо!

Парсинг и закон

Законно липарсить данныеи использовать в своих целях? Этим вопросом нередко задаются SEO-специалисты, которые только открывают для себя преимущества автоматического сбора информации. Согласно действующим нормам, парсинг не противоречит закону при условии, что:

Согласно действующим нормам, парсинг не противоречит закону при условии, что:

- сбор информации не нарушает чьих-либо авторских прав;

- данные в свободном доступе и не содержат коммерческой тайны;

- программы для сбора данных не вызывают сбоев в работе сайтов.

Если вы проводили выборочный парсинг мета-тегов сайтов конкурентов для анализа в личных целях, то ничего не нарушаете. Однако парсинг авторских статей с последующим размещением на своих ресурсах, да еще без указания ссылок на источники, плохо согласуется с законом. Сам парсер ничего противозаконного не совершает, потому что копирование информации с публичных страниц не запрещено. Только собранные программой материалы уже применяются в незаконных целях.

При любых сомнениях в законности парсинга проконсультируйтесь с юристами! Этим вы убережете себя от проблем с законом и крупных штрафов в будущем.

Какие данные и элементы можно анализировать с помощью парсинга?

1. Описания товаров.

Описания товаров.

2. Котировки ценных бумаг.

3. Тематические статьи.

4. Изображения разных форматов.

5. Аудио и видео файлы.

6. Документы.

7. Контактная информация.

8. Таблицы.

9. Программный код.

Представленные на рынке парсеры сайтов собирают практически любые данные. Что касается SEO-специалистов, то они пользуются программами для широкого круга задач:

1. Поиск ссылок на удаленные страницы.

2. Обнаружение неправильных 301 редиректов.

3. Нахождение дублей мета-тегов и заголовков страниц.

4. Анализ файла ROBOTS.TXT и соблюдения правил микроразметки.

5. Выявление ухудшающих поисковое продвижение страниц.

6. Сбор информации о сайтах конкурентов.

7. Подготовка данных для написания технических заданий.

8. Проверка позиций в выдаче популярных поисковых систем.

9. Заполнение интернет-магазинов контентом с официальных веб-сайтов производителей.

Лучшие инструменты парсинга для SEO-специалиста

В этом подразделе статьи мы собрали лучшие инструменты веб-парсинга, которые помогут SEO-специалисту продуктивно решать повседневные рабочие задачи.

Netpeak Spider

Программа Netpeak Spider для парсинга

Программа Netpeak Spider устанавливается на компьютер и предназначается для проведения аудита сайтов. ПО анализирует свыше 80 SEO-параметров и применяется для обнаружения ошибок внутренней оптимизации – от битых ссылок до дублей страниц. Входит в его функционал и парсинг.

Сбор информации осуществляется по списку адресов или в пределах одного сайта. Поддерживается 4 вида поиска – по содержимому, CSS, регулярным выражениям или языку запросов XPath. Пользователь имеет возможность задавать до 100 поисковых условий, чего более чем достаточно для многочисленных задач.

Парсер «Нетпик Спайдер» подходит для извлечения контактов, проверки микроразметки, анализа атрибутов HTML-тегов и пр. Собранные данные представляются в таблицах. Табличный вид особенно удобен, если SEO-специалист работает с сетями сайтов или проектами, где региональные веб-ресурсы выносятся на подддомены.

Официальный сайт – https://netpeaksoftware.com/ru/spider

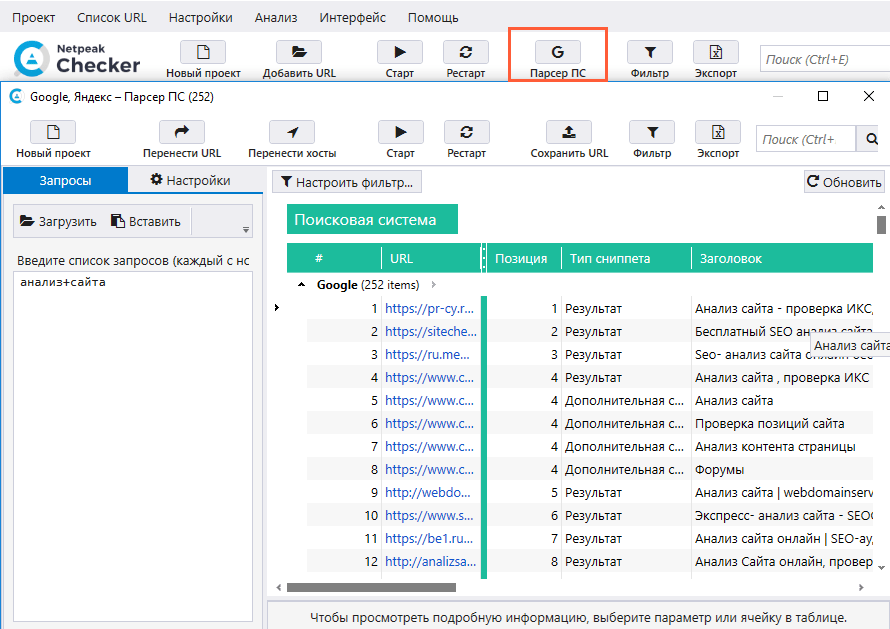

Netpeak Checker

Сравнение сайтов с помощью Netpeak Checker

Инструмент используется для парсинга выдачи поисковиков и агрегации информации из сервисов для SEO-специалистов. Данные автоматом выгружаются в таблицу для дальнейшего анализа. Среди прочего они помогают сравнивать сайты для составления или коррекции стратегии поискового продвижения.

Парсер выдачи Netpeak Checker позволяет задавать кастомные настройки. Наряду с языком, страной и геолокацией поддерживается использование поисковых операторов. При необходимости легко наложить ограничения по виду сниппетов. Скажем, картинки, новости или видеоролики.

В «Нетпик Чекер» включена проверка индексации веб-страниц. Программа анализирует индекс в Bing, Yahoo, Yandex и Google. Если предстоит работать с внушительным количеством адресов, к услугам пользователей поддержка прокси и популярных сервисов для разгадывания капчи вроде RuCaptcha или CapMonster.

Официальный сайт – https://netpeaksoftware.com/ru/checker

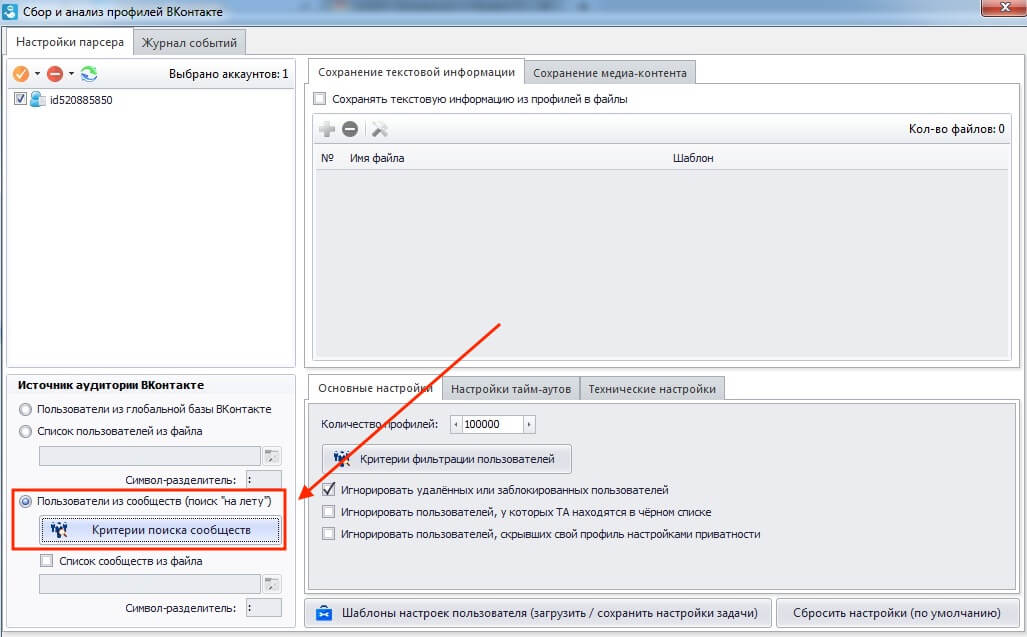

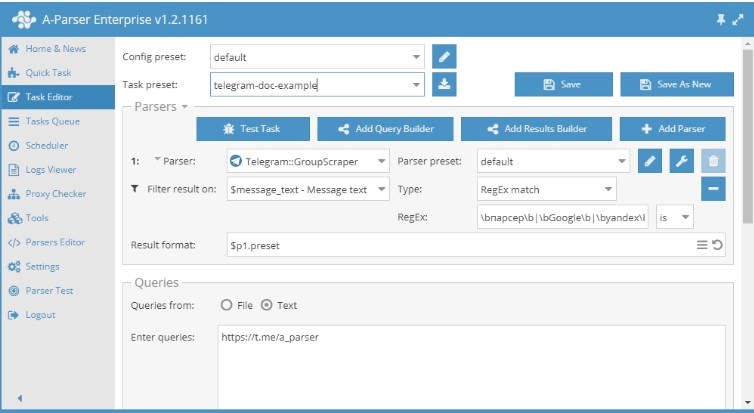

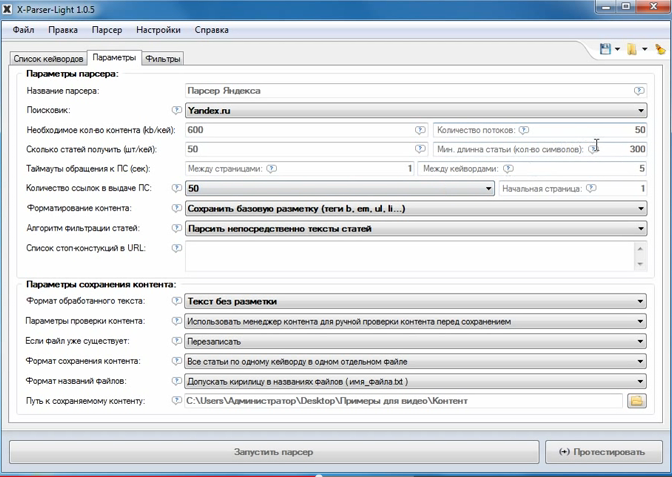

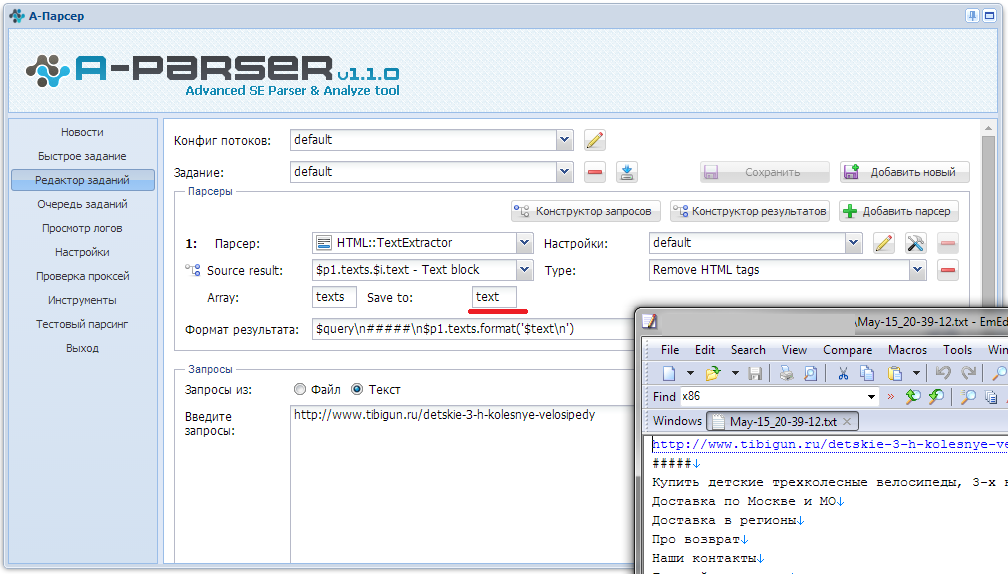

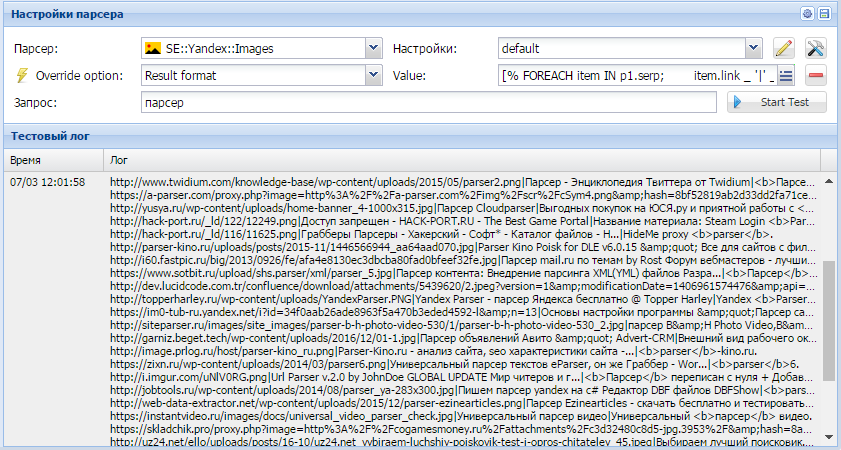

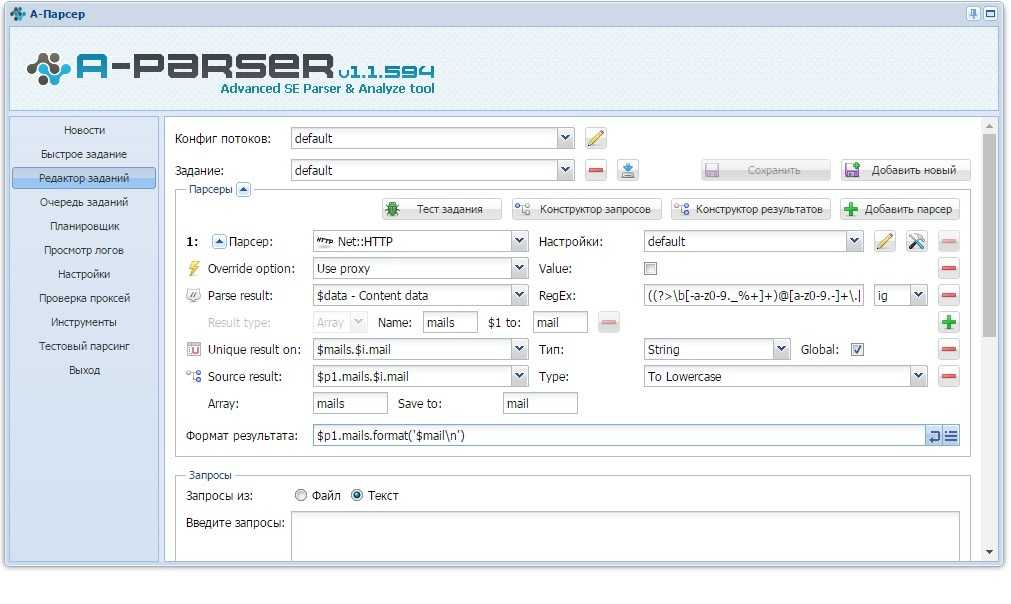

A-Parser

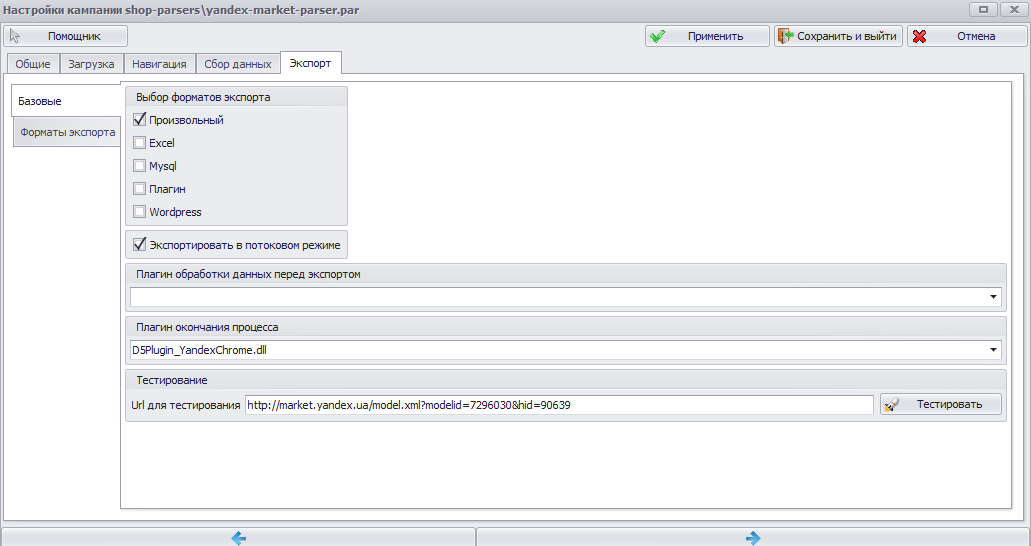

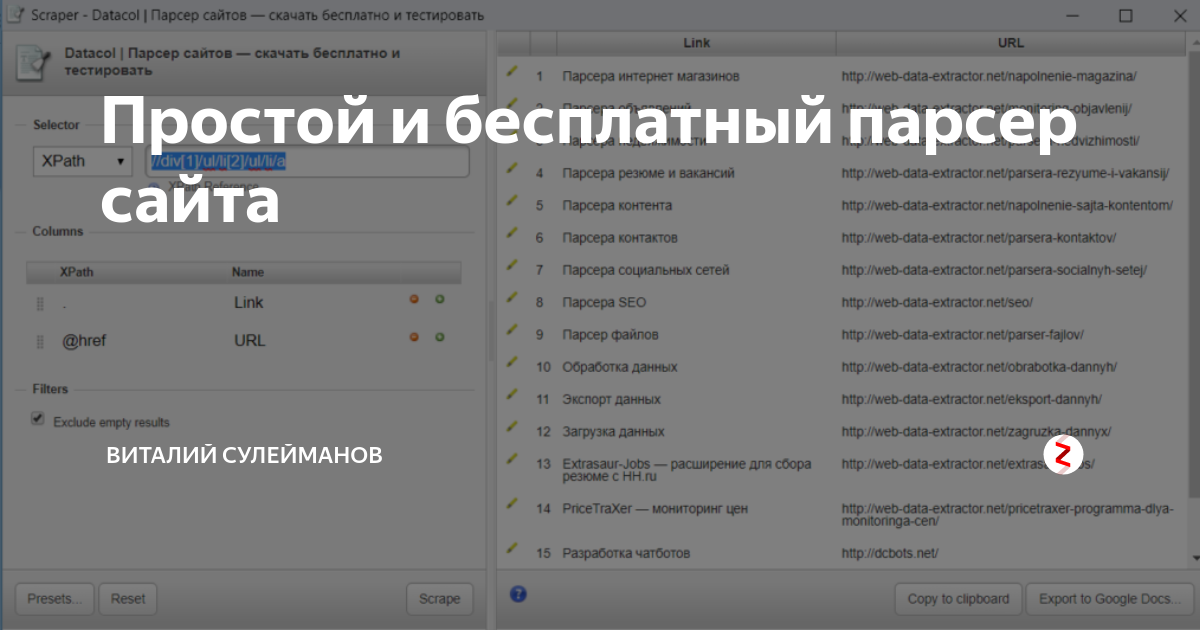

ПО A-Parser

Если вам требуется многопоточный и высокопроизводительный инструмент, обратите внимание на A-Parser. ПО характеризуется продуманной программной архитектурой и поддерживает выполнение заданий согласно заданному пользователем плану. Возможна интеграция в SaaS через API.

Разработчики оперативно обновляют встроенные в программу парсеры, что гарантирует их стабильную работу при изменениях HTML-кода источников. Консультации по вопросам использования «А-Парсер» оказываются бесплатно. На официальном сайте работает форум для общения пользователей.

Несмотря на широкий функционал, ПО не слишком требовательно к ресурсам. Многие SEO-специалисты устанавливают парсер на офисные компьютеры или недорогие виртуальные сервера. Для относительно комфортной работы вполне хватает VDS с арендной платой 5-10 $ в месяц.

Официальный сайт – https://a-parser.com

import.io

import.io – инструмент парсинга данных, который работает в онлайн-режиме. Платформа создана для извлечения информации со страниц сайтов без знания программирования. Благодаря мощной серверной инфраструктуре сервис анализирует тысячи веб-страниц в кратчайшие сроки.

Помимо онлайн-сервиса, пользователям предлагаются бесплатные программы для различных операционных систем. Приложения облегчают процесс создания экстракторов и роботов для поиска информации. Дополнительно программы согласовывают данные с пользовательскими учетными записями.

На сайте сервиса работает форум поддержки. Есть раздел с подробной справкой. Периодически разработчики публикуют обучающие видео. Проект постоянно развивается и обрастает новым функционалом. За удобство и стабильность работы его высоко ценят и SEO-специалисты, и крупные компании из области Data Science.

Официальный сайт – https://www.import.io

ParseHub

ParseHub – парсер для Mac, Linux и Windows

ParseHub – парсер для Mac, Linux и Windows с интуитивно-понятным интерфейсом. Как и в случае с import.io, для освоения программы не нужны навыки программирования. ПО спроектировано с расчетом на максимальное удобство и простоту.

В парсере применяется машинное обучение. Поддержка последнего открывает возможность извлекать данные из документов со сложной HTML-разметкой. Экспорт собранной информации производится в файлы формата CSV или JSON.

Функционал программы весьма обширен. Кроме стандартных текстов, ПО обрабатывает карты, календари, ссылки из выпадающих меню и формы для отправки данных. Поддерживает парсер и аутентификацию вместе с бесконечной прокруткой страниц.

Бесплатная версия программы парсит до 200 страничек приблизительно за 40 минут. Число проектов ограничивается 5. Техническая поддержка оказывается в ограниченном режиме. Данные сохраняются до 2 недель.

Техническая поддержка оказывается в ограниченном режиме. Данные сохраняются до 2 недель.

Официальный сайт – https://www.parsehub.com

Screaming Frog SEO Spider

Screaming Frog SEO Spider ПО для автоматизированного парсинга

Парсер Screaming Frog SEO Spider создан программистом из Великобритании, который занимался поисковым продвижением сайтов. Поскольку программу для macOS, Windows и Ubuntu разрабатывал человек «в теме», продукт получился весьма удобным. Даже если при первом знакомстве с ПО что-то покажется непонятным, пробелы в знаниях устранит подробнейшая справка на сайте. Там же размещается раздел с руководствами.

Программа умеет находить битые ссылки, проводить аудит редиректов, анализировать заголовки и метаданные страниц. ПО автоматически генерирует карты сайтов в формате XML и поддерживает извлечение данных посредством XPath. Если надо найти дубли контента, Screaming Frog SEO Spider справится и с этим. Одновременно визуализирует архитектуру веб-сайта в понятном для человека виде.

Одновременно визуализирует архитектуру веб-сайта в понятном для человека виде.

В ПО предусмотрен планировщик заданий для автоматизации парсинга по расписанию. Предположим, вы хотите получать отчеты о состоянии сайта 1 раз в неделю по понедельникам. Выставляете настройки, парсер начинает собирать информацию в указанное вами время. Данные экспортируются в любую нужную вам локацию, в том числе сервис онлайн-таблиц Google Sheets.

Официальный сайт – https://www.screamingfrog.co.uk

ComparseR

Комплексный анализ и индексация веб-сайтов

ComparseR – программа для комплексного анализа индексации веб-сайтов. После завершения сканирования страниц инструмент показывает наиболее важные параметры по каждому документу. В ПО встроены парсеры Yandex и Google, которые проверяют странички на индекс и собирают данные вроде дат сохраненных копий.

Приложение выявляет технические проблемы и информирует о них в отчетах. Сайт проверяется на ошибки с кодом 404, дубли заголовков страниц и наличие внутренних редиректов. Обнаруживаются и запрещенные к индексации странички. Краулер реально настроить таким образом, что он будет представляться веб-сайту как робот поисковика.

Сайт проверяется на ошибки с кодом 404, дубли заголовков страниц и наличие внутренних редиректов. Обнаруживаются и запрещенные к индексации странички. Краулер реально настроить таким образом, что он будет представляться веб-сайту как робот поисковика.

К программе подключены сервисы по разгадыванию капчи. Применение регулярных выражений гарантирует гибкость парсинга выдачи. Программа также удаляет URL из индексной базы в пакетном режиме. По заверениям создателя ПО, инструмент является уникальным и производит удаление в 1 клик.

Официальный сайт – https://parser.alaev.info

Google Spreadsheets

Google Search Console – не единственный инструмент, которым активно пользуются SEO-специалисты. Не менее востребованы онлайн-таблицы. Хотя Google Spreadsheets разрабатывался как сервис для работы с табличными данными, разработчики внедрили в него функции парсинга – IMPORTHTML и IMPORTXML.

IMPORTHTML извлекает данные из списков или таблиц. Функция поддерживает 3 параметра. Ссылка указывает на веб-страницу для сбора данных, а запрос – на их тип. Речь идет о list или table. Индекс отвечает за порядковые номера элементов. Обратите внимание, что отсчет начинается с 1.

Функция поддерживает 3 параметра. Ссылка указывает на веб-страницу для сбора данных, а запрос – на их тип. Речь идет о list или table. Индекс отвечает за порядковые номера элементов. Обратите внимание, что отсчет начинается с 1.

Синтаксис =IMPORTHTML(«ссылка»; «запрос»; индекс)

Пример использования =IMPORTHTML(«https://ru.wikipedia.org/wiki/Население_России»; «table»; 3)

Если создать новую таблицу Google и вставить в ячейку A1 формулу из примера, получится приблизительно такой результат

Оригинальная таблица с «Википедии». В коде документа она идет третьей. Поэтому парсер вставил именно ее.

Функция IMPORTXML – более гибкий инструмент, чем IMPORTHTML. В качестве источника данных она принимает на вход документы 6 форматов. К ним относится RSS, XML, TSV, CSV, HTML и ATOM XML. Параметров 2. Ссылка содержит адрес страницы для парсинга, а запрос_xpath – конструкцию для поиска информации.

Синтаксис =IMPORTXML(«ссылка»; «запрос_xpath»)

Пример использования =IMPORTXML(«https://google.com»; «//a/@href»)

Пример парсинга и его результатов

Перед вами результат работы парсера по запросу из примера. В таблицу добавлено содержимое атрибутов href ссылок с главной страницы Google.

Недостаток таблиц Google заключается в ограничениях сервиса. В промышленных масштабах парсить данные не выйдет. Виной тому лимиты на количество исходящих запросов. В документ легко добавить хоть 10000 конструкций для парсинга. По факту отработает малая часть. В ячейках, где функции не сработают из-за лимитов, вместо данных останется надписать Loading.

1. Официальный сайт Google Spreadsheets. https://spreadsheets.google.com

2. Справка по IMPORTHTML. https://support.google.com/docs/answer/3093339?hl=ru

3. Справка по IMPORTXML. https://support.google.com/docs/answer/3093342?hl=ru 4. Руководство по XPath. https://www.w3schools.com/xml/xpath_intro.asp

https://www.w3schools.com/xml/xpath_intro.asp

Serpstat — платформа для сканирования и выдачи резултатов

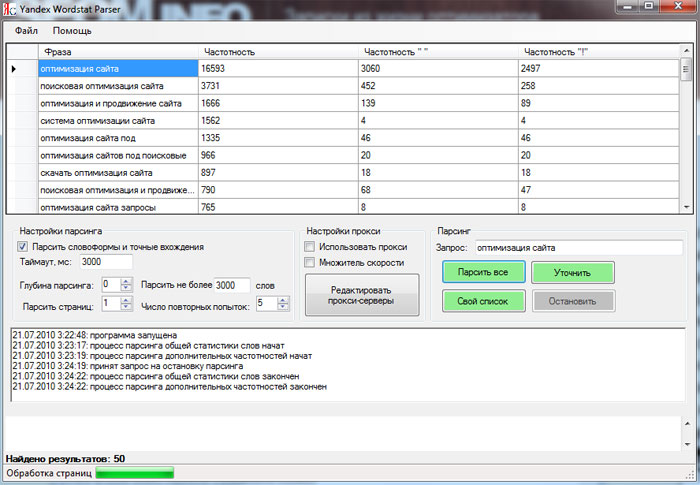

Serpstat – многофункциональная платформа для профессионалов SEO с 3 видами парсинга. Первый из них предназначен для анализа топа. Сервис быстро обрабатывает большие объемы информации и предлагает гибкие возможности визуализации. Сканирование Yandex или Google настраивается с точностью до города. Данные собираются по расписанию или запросу пользователя. Отчеты формируются автоматически. Собранные сведения передаются по API или в JSON.

Второй инструмент – парсинг частотности ключевых запросов с поддержкой точного и широкого соответствия. Это незаменимый сервис для анализа и подготовки семантического ядра. Он также оптимален для запуска рекламных кампаний в контекстных сетях. 100000 ключей обрабатывается всего за 70 минут. Данные выгружаются в JSON. Частота фраз проверяется по регионам и городам. В рамках White Label отчеты допускается брендировать логотипами сторонних компаний.

Третий вид парсинга применяется для сбора данных по размещающимся в топе объявлениям контекстной рекламы. Парсер платной выдачи настраивается с учетом поисковика, языка запроса, региональной принадлежности и города. Время и частотность сбора данных устанавливаются пользователем. За счет этого инструмент адаптируется под потребности конкретного бизнеса. Немаловажным преимуществом сервиса считается доступная цена пробивки 1 запроса.

- Официальный сайт Serpstat. https://serpstat.com/ru

- Статья о преимуществах парсинга топа контекстной рекламы. https://serpstat.com/ru/blog/kak-obojti-krupnejshih-reklamodatelej-na-rinke/

- Пост о парсинге топа для проведения анализа ниши. https://serpstat.com/ru/blog/analiz-nishi-s-pomoschyu-parsinga-topa-v-serpstat/

- Подробный разбор парсинга частотности ключевых слов. https://serpstat.com/ru/blog/parsing-chastotnosti-serpstat/

Хотите узнать, как с помощью Serpstat оптимизировать сайт?

Нажимайте на космонавта и заказывайте бесплатную персональную демонстрацию сервиса! Наши специалисты вам все расскажут! 😉

С помощью какого инструмента можно быстро спарсить и проанализировать мета-теги на сайте?

Для парсинга малого числа документов подходит Google Spreadsheets. Ниже представлены формулы для извлечения title и description. На место URL подставляется адрес страницы. 1. title. =IMPORTXML(«URL»; «//title») 2. description. =IMPORTXML(«URL»; «//meta[@name=’description’]/@content») Для извлечения мета-тегов из тысяч или миллионов страниц потребуется самописная программа или платное решение. Тот же A-Parser или один из продуктов NetPeak.

Ниже представлены формулы для извлечения title и description. На место URL подставляется адрес страницы. 1. title. =IMPORTXML(«URL»; «//title») 2. description. =IMPORTXML(«URL»; «//meta[@name=’description’]/@content») Для извлечения мета-тегов из тысяч или миллионов страниц потребуется самописная программа или платное решение. Тот же A-Parser или один из продуктов NetPeak.

Какие бесплатные инструменты парсинга можно использовать для SEO-анализа?

Как вариант, Netpeak Spider или Checker. Обе программы имеют бесплатные версии с урезанным функционалом, которого хватает для базового анализа. Если собираетесь заниматься SEO профессионально, рано или поздно придется купить какой-либо инструмент. Бесплатное ПО либо нестабильно работает, либо накладывает на пользователей много ограничений.

Зачем парсить данные с сайта при SEO-анализе?

Чтобы повысить производительность труда и исключить из процесса сбора информации человеческий фактор. Чем эффективнее SEO-специалист справляется с рутинными задачами, тем он востребованней среди работодателей. Поисковая оптимизация на 80-90 % состоит из рутины. По этой причине высоко ценится умение оперативно и продуктивно решать повседневные вопросы.

Чем эффективнее SEO-специалист справляется с рутинными задачами, тем он востребованней среди работодателей. Поисковая оптимизация на 80-90 % состоит из рутины. По этой причине высоко ценится умение оперативно и продуктивно решать повседневные вопросы.

Домашнее задание

Напоследок дадим домашнее задание – изучите инструменты парсинга сайтов из статьи и выберите подходящие для ежедневной работы. Вдумчивый анализ займет 20-30 часов. Зато потраченное время многократно окупится в будущем, когда придется собирать и анализировать информацию по продвигаемым сайтам. Чтобы не потерялись ссылки на парсеры из материала, добавьте страницу в «Избранное» или скопируйте в файл.

Чтобы быть в курсе всех новостей блога Serpstat, подписывайтесь рассылку. А также вступайте в чат любителей Серпстатить и подписывайтесь на наш канал в Telegram.

Сэкономьте время на изучении Serpstat

Хотите получить персональную демонстрацию сервиса, тестовый период или эффективные кейсы использования Serpstat?

Оставьте заявку и мы свяжемся с вами 😉

Оцените статью по 5-бальной шкале

5 из 5 на основе 9 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Анастасия Сотула

10 лучших инструментов для проверки скорости загрузки сайта

SEO

Анастасия Сотула

Переезд сайта на новый домен: пошаговая инструкция

SEO

Алексей Файнгор

Чек-лист по анализу конкурентов для услуговых сайтов

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

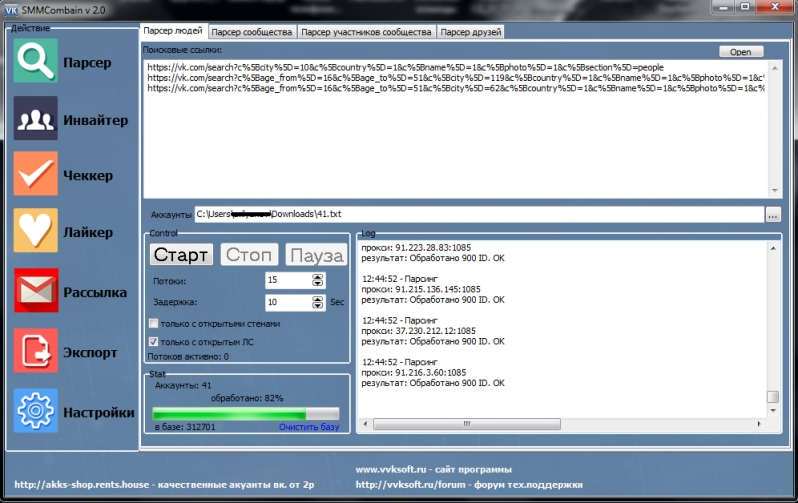

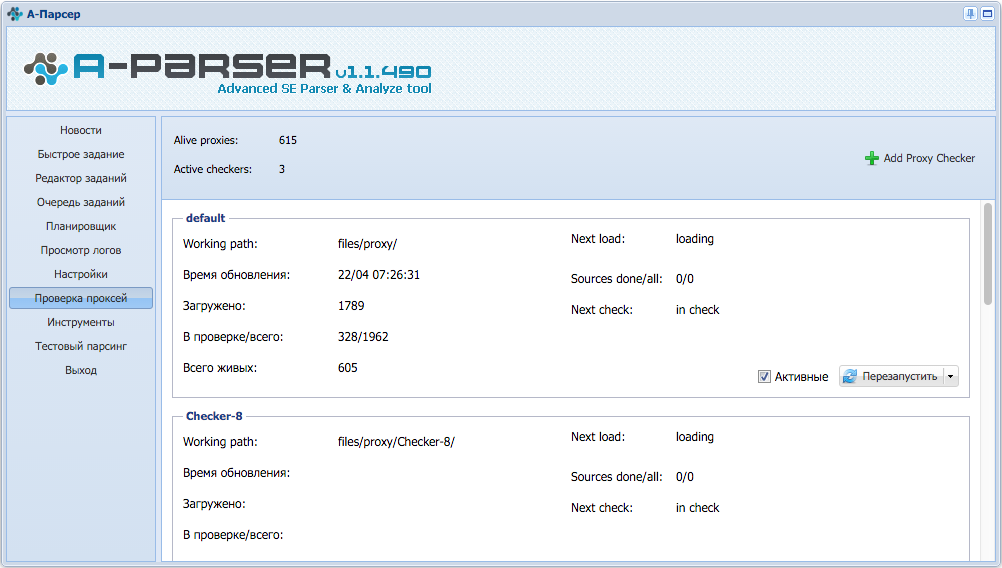

группы, посты + 10 парсеров

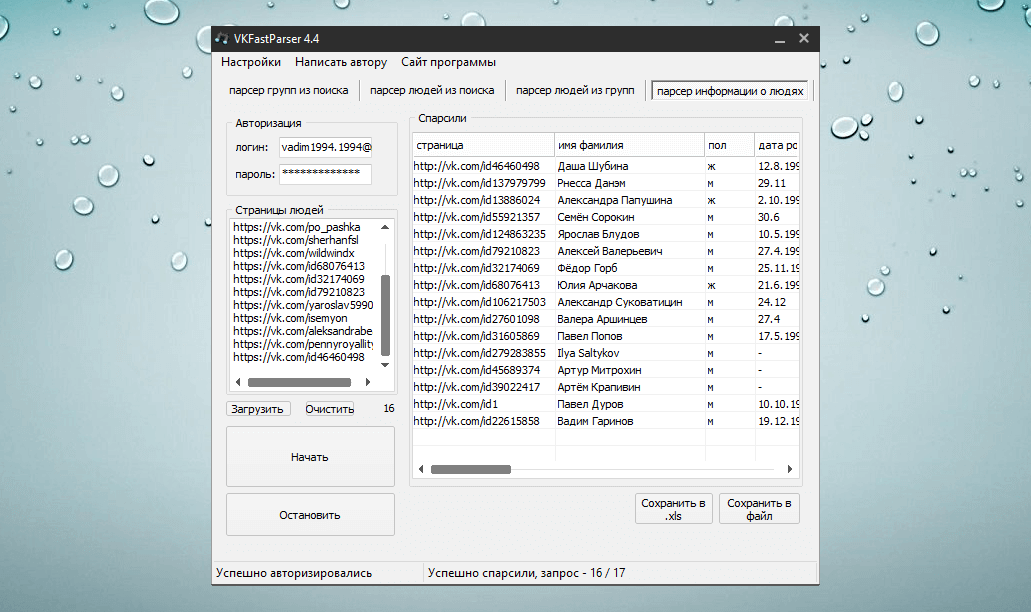

Парсинг соцсетей — автоматический сбор данных о подписчиках, упоминаниях, постах и статистике в социальных сетях.

В качестве источника в этом случае выступают социальные сети — Инстаграм, ВКонтакте, Youtube и другие. Собирать можно ники, возраст, географию подписчиков, статистику активности аудитории, тексты публикаций и фотографии, упоминания аккаунта или бренда и многое другое.

Парсер социальных сетей пригодится для анализа конкурентов, разработки стратегии продвижения, работе с возражениями и настройке таргетированной рекламы. Автоматизировать сбор данных могут специальные сервисы, о них и поговорим — расскажу обо всех плюшках.

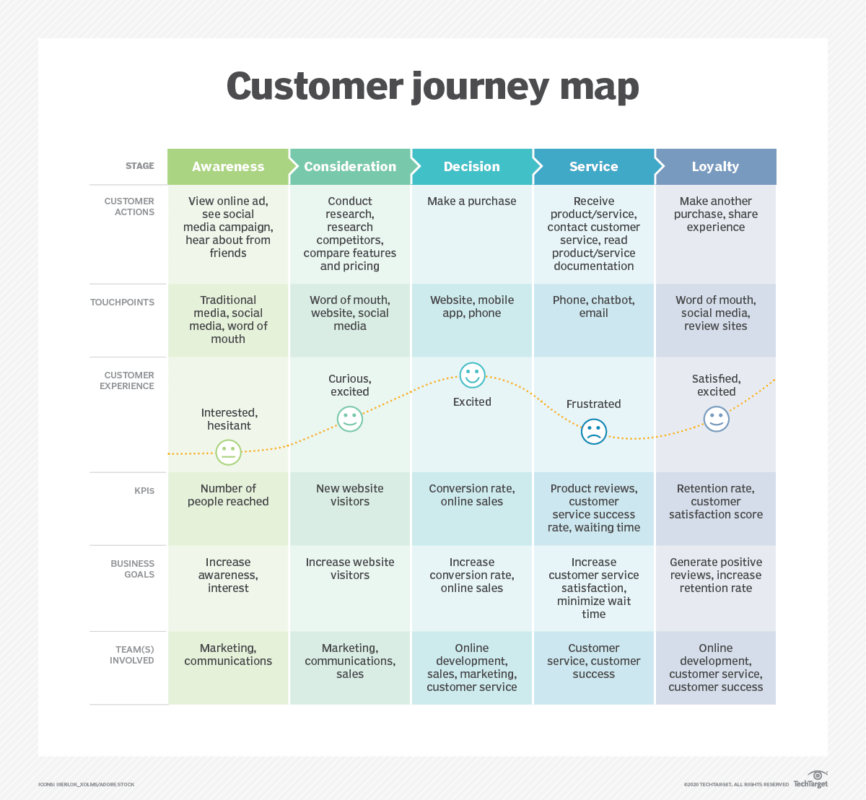

Парсинг целевой аудитории

На рынке существует множество различных программ по парсингу, наиболее популярные я собрала в таблицу, чтобы Вы сравнили цены, условия и ограничения, выбрали наиболее подходящий для себя.

| Сервис | Цена (в месяц) | Бесплатный период | Промокод | Соц.сети |

| Pepper Ninja | От 490 ₽ | 3 дня | «INSCALE2021» +30 дней того же тарифа | Вконтакте, Instagram*, Facebook*, Одноклассники |

| Zengram | 699 ₽ | 3 тестовых дня | «INSCALEPROMO» скидка 20% на все | Instagram* |

| Segmento Target | 1 299 ₽ | Нет | «INSCALE» +30 дней того же тарифа | Вконтакте, Instagram*, Одноклассники |

| Targetkultivator | 199 ₽ | Нет | — | Вконтакте, Instagram* |

| VK.BARKOV.NET | От 199 ₽ | Нет | — | Вконтакте, Одноклассники |

| Target Hunter | От 666 ₽ | Нет | «in-scale» + 2 дня доступа + 1 месяц при покупке от месяца | ВКонтакте, Одноклассники |

С помощью парсинга можно быстро собрать необходимую информацию об интернет-пользователях, что позволяет настраивать рекламу, делая её более приемлемой. Что же конкретно он умеет:

Что же конкретно он умеет:

1. Сбор аудитории

Парсинг целевой аудитории по аккаунтам конкурентов, хэштегам и геолокации. Настраивается всего в несколько кликов, а результат быстро выгружается удобным списком. Создавайте задания и получайте новых подписчиков Ваших конкурентов или тех, кто опубликовал пост с нужным хэштегом или геолокацией. Один из плюсов — не нужна привязка аккаунта.

В Инстатрекере все действия Вы совершаете сами и с соблюдением всех лимитов Instagram, что исключает возможность блокировки аккаунта.

Пример сбора целевой аудитории в аккаунте конкурента

По теме:

Парсер Инстаграм: 15 лучших сервисов + обзор функций2. Сбор контактных данных

Собирайте аккаунты пользователей в один список со всеми контактными данными (номер телефона, электронная почта, ссылка на сайт) и описаниями профилей из Instagram. Выгружайте аккаунты по интересующим конкурентам, хэштегам, геотегам или же комбинируя источники сбора, а также фильтруйте собранную базу по желаемым параметрам.

Список формируется в удобном формате, его можно сразу же использовать — загрузить для настройки рекламы, обзвона, либо масслукинга в Инстаграм.

Сбор аудитории по аккаунтам3. Поиск активной аудитории ВКонтакте

Проще всего собрать её парсингом участников групп конкурентов. Информацию можно отсортировать по количеству постов в день, в неделю, чтобы выделить группы, в которых ведётся активность.

Поиск сообществ Вконтакте

По теме:

Парсер Вконтакте: обзор ТОПовых сервисов с примерами4. Пересечение баз

Функция позволяет сравнить несколько собранных Вами баз и удалить повторяющиеся аккаунты. В будущем это поможет сэкономить рекламный бюджет.

Пересечение баз5. Лайкеры и комментаторы пользователей/постов

Лайкеры и комментаторы — функция помогает собрать базу наиболее активных пользователей определённого аккаунта, либо поста в Instagram.

Лайкеры и комментаторы пользователей6.

Мониторинг сообществ

Мониторинг сообществ В Pepper Ninja функция мониторинга и парсинга сообществ позволяет следить за группами и собрать в единую базу всех, кто в них вступил. А после загрузить список в рекламный кабинет.

Мониторинг сообществЕго интересная фишка — периодические задания. Например, Вы хотите показывать рекламу тем, кто состоит минимум в двух сообществах нужной Вам тематики.

Настраивайте сервис так, чтобы он сам проверял базы на актуальность, обновлял их в рекламном кабинете и автоматически очищал от ботов. При помощи функционала программы можно собрать тех, кто действительно заинтересован в рекламируемых товарах.

7. Поиск меломанов

У Target Hunter есть интересная функция — поиск по музыкальным предпочтениям. Можно искать определённых исполнителей как по всему ВК, так и среди заданной входной базы.

Поиск меломанов8. Анализ

Можно отследить тех, кто пишет пост на стене группы или лайкает конкретного пользователя. После чего, сразу же интегрировать эту базу в кабинет и показать им рекламу. Помимо этого, разработчики уделили большое внимание автоматизации процессов. Например, один раз настроили мониторинг, после база обновляется самостоятельно.

После чего, сразу же интегрировать эту базу в кабинет и показать им рекламу. Помимо этого, разработчики уделили большое внимание автоматизации процессов. Например, один раз настроили мониторинг, после база обновляется самостоятельно.

Удобная функция аналитики — возможность анализировать промо публикации конкурентов, найти те сообщества, которые репостят Ваши публикации, а также сделать аналитический анализ результатов поиска сообществ.

Анализ

По теме:

Анализ аккаунта Instagram: ТОП-7 сервисов + что проверитьАнализ конкурентов в ИГ: рейтинг 10 сервисов + 15 метрикПарсинг упоминаний

Спарсить можно не только аудиторию, но и упоминания. Парсеры упоминаний позволяют следить за репутацией компании в соцсетях, СМИ, на сайтах и форумах, своевременно реагируя на негатив. Рассмотрим наиболее популярные:

| Сервис | Цена в месяц | Бесплатный период | Соц.сети |

VK. BARKOV.NET BARKOV.NET |

699 ₽ | Нет | ВКонтакте, Одноклассники |

| Яндекс.Блоги | Бесплатно | Бесплатно | Во всех кроме Facebook |

| Google Alerts | Бесплатно | Бесплатно | Всесторонний результат поиска |

По теме:

Мониторинг социальных сетей: инструкция + 9 инструментов1. Сбор упоминаний Вконтакте

Среди полезных функций «VK.BARKOV.NET» стоит выделить следующие: сбор ссылок из упоминаний в постах, определение частотности слов в тексте, сбор упоминаний пользователей ВКонтакте, которые Вам интересны.

Сбор упоминаний на стене или в постах группы или профиля ВКонтакте2. Поиск упоминаний в интернете

Узнавайте о происходящем на просторах интернета. Возможно найти упоминание на любую тему. Его работа достаточно проста: нужно просто ввести название бренда. Будут показаны все последние упоминания за выбранный период.

Будут показаны все последние упоминания за выбранный период.

Отслеживайте упоминания в интернете. Очень удобно и то, что e-mail оповещения приходят автоматически. Это позволяет не пропустить новые упоминания.

Поиск упоминаний в Google AlertsПарcинг постов и контента

Ещё существуют сервисы для парсинга публикаций и контента. Но рекомендую ими пользоваться только для быстрого анализа информации. Помните — воровать чужой контент запрещено. Сравним наиболее популярные проги для парсинга контента:

| Сервис | Стоимость | Бесплатный период | Соц.сети |

| FeadSpy | 399 ₽/мес | Да | Instagram*, Facebook*, ВКонтакте, Одноклассники, Twitter, Tik Tok |

| AdSpoiler | 600 ₽/мес | Нет | ВКонтакте |

1. Анализ рекламы конкурентов

Детально анализируйте таргетированную рекламу конкурентов (даже по удалённым постам и объявлениям). Сравнительный анализ по активностям и прочим показателям помогает быстро подобрать наиболее подходящие сообщества для эффективного размещения рекламы.

Сравнительный анализ по активностям и прочим показателям помогает быстро подобрать наиболее подходящие сообщества для эффективного размещения рекламы.

Также, с его помощью можно узнать трендовые товары за выбранный период, в определённой группе найти информацию, публикуемую конкурентами. FeadSpy может помочь сократить расходы на тесты, дать новые идеи и подходы в работе, благодаря анализу конкурентов, что, в конечном итоге, увеличит профит.

Открою секрет. Статистику любых групп можно посмотреть через специальный сервис. К тому же он покажет какие посты “выстреливают” (так можно и идеи для контента собрать). Кликайте -> AdSpoiler (промокод INSCALE, скидка 15%).

2. Поиск контента по заданной тематике

Подключите все аккаунты и группы, которые хотите наполнять и вести. Далее укажите в настройках тематики и их сочетания, подходящие Вашим сообществам, а в финале укажите, как часто хотите публиковать посты в группу.

Сервис сам подбирает такие публикации, которые привлекают клиентов. Можно выбрать и оплатить понравившиеся. Конечно, нельзя назвать такие публикации уникальными, готовые использовать не рекомендую. Но он отлично подойдёт для сбора идей и разбавления существующего контента, отложенного постинга и кросспостинга в другие группы.

Можно выбрать и оплатить понравившиеся. Конечно, нельзя назвать такие публикации уникальными, готовые использовать не рекомендую. Но он отлично подойдёт для сбора идей и разбавления существующего контента, отложенного постинга и кросспостинга в другие группы.

Среди плюсов программы: большое количество тем для публикаций, возможность сделать картинки в сообществе уникальными, с помощью водяных знаков.

Поиск контента по заданной тематикеКак выбрать сервис для парсинга соцсетей?

Выбор проги для парсинга индивидуален и зависит от многих факторов. В частности, от того, какие цели Вы преследуете и какие функции нужны для работы. Но, рекомендую обратить внимание на ряд важных моментов:

- Определение цели парсинга. Все представленные сервисы обладают совершенно разным функционалом, поэтому важно определиться с целью парсинга и выбрать программу, которая сможет справиться с Вашей задачей;

- Бюджет.

Цены варьируются в зависимости от количества возможностей функционала и его сложности. Поэтому Вам стоит тщательно подобрать наиболее подходящий тарифный план;

Цены варьируются в зависимости от количества возможностей функционала и его сложности. Поэтому Вам стоит тщательно подобрать наиболее подходящий тарифный план; - Преимущества. У каждого сервиса свои преимущества. Рекомендую ознакомиться с преимуществами всех представленных программ и выбрать наиболее подходящие для Ваших целей и рекламных кампаний.

- Выбор социальных сетей. Важно определиться, для каких социальных сетей нужен парсинг и выбрать именно тот, который поможет наиболее эффективно собрать необходимые данные;

- Бесплатный доступ. Выбирая программу, обязательно воспользуйтесь всеми бесплатными возможностями, протестируйте функционал и выберете наиболее подходящий и удобный именно для Вас.

На правах рекламы

Коротко о главном

Давайте будем честны: если работать вручную, то потраченные деньги и время не факт, что окупятся, поскольку объём работ довольно велик. Даже среди, казалось бы, нужных клиентов могут оказаться и те, кому это совершенно не интересно. Программа парсинга задаст правильное направление для рекламных рассылок и объявлений, гарантируя стопроцентное взаимодействие с пользователями.

Даже среди, казалось бы, нужных клиентов могут оказаться и те, кому это совершенно не интересно. Программа парсинга задаст правильное направление для рекламных рассылок и объявлений, гарантируя стопроцентное взаимодействие с пользователями.

Очевидно, что использование парсера существенно сэкономит время, потраченное на поиск новых клиентов. В дополнение, парсер сократит и расходы на оплату дополнительного труда сотрудников.

Парсинг соцсетей поможет составить полный портрет целевой аудитории, найти её для рекламы, настроить на потенциальных клиентов, проанализировать нужную информацию в социальных сетях и на других ресурсах, а также переманить к себе аудиторию конкурентов.

Подходите к выбору парсера с умом, а если хотите готовое решение, то вот Вам наш персональный чек-лист:

- Парсинг аудитории — Pepper Ninja;

- Парсинг упоминаний — VK.BARKOV.NET;

- Парсинг контента — Segmento-target.

Упомянутые в статье Instagram (Инстаграм) и Facebook (Фейсбук) принадлежат компании Meta, которая признана экстремистской организацией и запрещена в РФ.

что это такое в программировании, виды, программы в 2022 году

Статья обновлена 09.07.2022

Ответить на вопрос, что такое парсер, довольно легко, если вы владеете английским языком. В переводе «parsing» означает провести грамматический разбор слова или текста. Первоначальное значение произошло от латинского «pars orationis» — часть речи. Таким образом, парсинг — это метод, при котором строка или текст анализируются и разбиваются на синтаксические компоненты. Затем полученные данные преобразуются в пригодный формат для дальнейшей обработки и использования в прикладных исследованиях. Получается, что один формат данных превращается в другой, более читаемый. Допустим, вы получаете данные в необработанном коде HTML, а парсер принимает его и преобразует в формат, который можно легко проанализировать и понять.

В этом материале мы разберем, как парсить и что это значит, виды парсеров; узнаем, для чего он может понадобиться в программировании и маркетинге, а также запишем тонкости его применения и многое другое.

Парсинг: общие понятия и практика

Парсинг предлагает инструментарий, который помогает извлекать нужные значения из любых форматов данных. Извлеченные данные сохраняются в отдельном файле — либо на локальном компьютере, либо в облаке или на хостинге, либо напрямую в базе данных. Это процесс, который запускается автоматически.

Проанализировать собранную информацию помогает программное обеспечение. Что значит парсить в программировании? Работающий парсер посылает запрос типа GET на сайт-«донор», который должен взамен отдать данные. В результате этого запроса создается HTML-документ, который будет проанализирован программой. Затем парсер осуществляет в нем поиск необходимых данных и выполняет преобразование в нужный формат.

Существует 2 разных метода выполнения веб-парсинга:

- доступ к сайту www через протоколы HTTP, HTTPS или веб-браузер;

- доступ с использованием бота.

Парсинг не является запрещенным методом сбора и анализа информации. Часто даже сайты государственных служб предоставляют данные для публичного использования, доступные через API. Поскольку сбор такой информации — это обработка огромных массивов данных, на помощь приходят парсеры.

Часто даже сайты государственных служб предоставляют данные для публичного использования, доступные через API. Поскольку сбор такой информации — это обработка огромных массивов данных, на помощь приходят парсеры.

Парсинг и краулинг: отличия

Парсинг иногда путают с краулингом. Это происходит потому, что данные процессы схожи. Оба имеют идентичные варианты использования. Разница — в целях.

Обе операции «заточены» на обработку данных с сайтов. Процессы автоматизированы, поскольку используют роботов-парсеров. Что это такое? Всего лишь боты для обработки информации или контента.

И парсинг, и краулинг проводят анализ веб-страниц и поиск данных с помощью программных средств. Они никак не изменяют информацию, представленную там, и работают с ней напрямую.

Парсинг собирает данные и сортирует их для выдачи по заданным критериям. И это необязательно происходит в Интернете, где делают парсинг веб-страниц. Речь идет о данных, а не о том, где они хранятся.

Например, вы хотите поработать над ценовой аналитикой. Для этого вы запускаете созданные парсеры товаров и цен на них, чтобы собрать информацию с Avito или с любого интернет-магазина. Таким же образом можно анализировать данные фондового рынка, объявления по недвижимости и так далее.

Для этого вы запускаете созданные парсеры товаров и цен на них, чтобы собрать информацию с Avito или с любого интернет-магазина. Таким же образом можно анализировать данные фондового рынка, объявления по недвижимости и так далее.

Краулинг или веб-сканирование — прерогатива поисковых ботов или пауков. Краулинг включает в себя просмотр страницы целиком в поисках информации и ее индексацию, включая последнюю букву и точку. Но никакие данные при этом не извлекаются. Интернет-бот, он же — парсер поисковой системы — тоже систематически просматривает всемирную паутину для того, чтобы найти сайты и описать их содержимое. Самое важное отличие от краулера — он собирает данные и систематизирует их.

То, что делают Google, Яндекс или Yahoo — простой пример веб-сканирования. Это тоже своего рода парсинг. Что это такое простыми словами? Когда поисковые машины сканируют сайты и используют полученную информацию для индексации. Подробно об этом процессе можно прочитать в нашем глоссарии.

Что такое программа парсер и как она работает

Некоторые не понимают разницы: парсер или парсинг? Парсер — программное решение, а парсинг — процесс.

То есть программа для парсинга — это парсер. Она предназначена для автоматической обработки и извлечения данных.

Для анализа заданного текста такое ПО обычно использует отдельный лексический анализатор. Он называется токенайзером или лексером. Токенайзер разбивает все входные данные на токены — отдельные символы, например, слова. Полученные таким образом токены служат входными символами для парсера.

Затем программа обрабатывает грамматику входных данных, анализирует их и создает синтаксическое древо. На этой основе идет дальнейшая работа парсера с информацией — генерация кода или выборка по определенным критериям.

Пример древа синтаксического анализа: выражение — expr, термин — term, факт — fact, идентификатор — IDПарсинг данных: методы

Существует два основных метода парсинга: нисходящий и восходящий. Обычно они различаются порядком, в котором создаются узлы синтаксического древа.

- Сверху-вниз: при нисходящем методе парсер выполняет поиск сверху — с начального символа в коде и ищет подходящие ему синтаксические связи.

Таким образом, древо синтаксического анализа разрастается сверху вниз, в направлении более детальной разбивки.

Таким образом, древо синтаксического анализа разрастается сверху вниз, в направлении более детальной разбивки. - Снизу-вверх: восходящий парсер начинает снизу, с самого нижнего символа строки, а затем устанавливает все более крупные синтаксические связи. Это делается до тех пор, пока не будет достигнут начальный символ кода.

Но метод работы — не самое важное. Хорошо сделанный парсер — восходящий или нисходящий — будет различать, какая информация, например, в строке HTML необходима. И в соответствии с заранее написанным кодом и правилами синтаксического анализа выберет нужные данные и преобразует их, например, в формат JSON, CSV или даже в таблицу Excel.

Важно отметить, что сам парсер информации не привязан к определенному формату данных. Это просто инструмент, который преобразует один формат в другой. А вот как он преобразует его и во что, зависит от текущих задач.

Где применяется парсинг

Парсинг используется для преобразования текста в новую структуру в следующих случаях:

- Чтение программного кода — например, Java, SQL и других языков программирования.

Этим занимаются парсеры баз данных. Как это работает? Парсер предоставляет программному компилятору структуру данных, с помощью которой можно сгенерировать машинный код.

Этим занимаются парсеры баз данных. Как это работает? Парсер предоставляет программному компилятору структуру данных, с помощью которой можно сгенерировать машинный код. - Чтение HTML-кода с помощью парсера исходного кода страницы. Для компьютера HTML-код — это просто строки символов, которые должны быть проанализированы парсером в браузере. Парсер предоставляет описание веб-страницы как структуры данных, которая затем компонуется в нужном порядке и выводится на экран компьютера.

- Анализ XML-разметки. Специальные парсеры XML отвечают за анализ этого типа документов и подготавливают содержащуюся в них информацию для дальнейшего использования.

- Чтение URL-адресов и интернет-протоколов HTTP и HTTPS. Парсеры разбивают сложные схемы URL-адресов и протоколов на иерархическую структуру.

- Поисковые системы. С помощью парсеров поисковой системы боты выбирают релевантный для них текст из контента сайта. После первичной выборки данные обрабатываются, а результаты анализа становятся доступны для просмотра.

В цифровом маркетинге парсинг применяют, чтобы собрать и проанализировать определенную информацию из контента нужных сайтов.

Парсинг страницы: применение

Парсинг страниц, ведущий сбор информации из веб-контента сайтов, используется в различных сферах — для продаж, маркетинга, финансов, электронной коммерции, сбора информации по конкурентам и так далее. Активно его применяют в следующих областях.

Цели парсинга по частоте, исследование HubSpotРозничный маркетинг

В розничной торговле существует множество возможностей использования парсинга. Например, мониторинг цен конкурентов или аналитика рынка, где парсинг используют для обработки данных и извлечения из них ценной для маркетологов информации.

Так, для электронной коммерции может потребоваться бесчисленное количество изображений и описаний товаров. Их нельзя просто создать за пару-тройку дней, так как даже просто скопировать и вставить каждый займет определенное время. Гораздо проще и быстрее создать парсинг и быстро «выцепить» все нужное. Или взять аналитику рыночных цен — регулярный парсинг веб-страниц конкурентов поможет своевременно замечать и учитывать все изменения на рынке.

Или взять аналитику рыночных цен — регулярный парсинг веб-страниц конкурентов поможет своевременно замечать и учитывать все изменения на рынке.

Анализ рынка акций

Раньше анализ фондового рынка ограничивался изучением финансовой отчетности компаний и, соответственно, инвестированием в наиболее подходящие ценные бумаги. Сегодня каждая новость или изменения настроений в политике и в обществе важны для определения текущих трендов. Как получать такие альтернативные данные? Здесь помогает парсинг. Он позволяет получить всю совокупность информации, связанной с рынком, и увидеть общую картину. Не говоря уже о том, что извлекать годовые отчеты и все стандартные финансовые данные с любого сайта гораздо проще и быстрее с помощью парсинга.

Машинное обучение

По сути, каждый парсер проходит обучение. Это позволяет искусственному интеллекту обнаруживать закономерности. Однако для того, чтобы установить нужные связи, необходимо передать в компьютерный разум много данных и помочь связать одно с другим. Часто парсеры применяются в технологиях AI, чтобы обеспечить регулярный поток обучающей информации.

Часто парсеры применяются в технологиях AI, чтобы обеспечить регулярный поток обучающей информации.

Парсер почты

Что это такое? Парсинг электронной почты позволяет анализировать входящие и исходящие сообщения. Затем их содержимое можно интегрировать в различные приложения c помощью программного интерфейса API или собрать для дальнейшего анализа.

Электронная почта — одна из наиболее загруженных данными форм современного общения. Обычная отправка одного электронного письма собирает, передает и интерпретирует около 100 Кб данных. Умножьте на миллиарды, и вы поймете, почему компаниям может быть сложно управлять такими объемами информации. К счастью, решение проблемы сегодня берут на себя специальные парсеры.

Большинство компаний используют решения на основе API для 3 основных видов приложений.

- Поддержка клиентов. Парсинг обеспечивает фиксацию взаимодействий с клиентами по электронной почте, доставку нужных сообщений пользователям, сбор и анализ входящих сообщений для хранения и отображения в приложениях поддержки.

- Приложения для управления взаимоотношениями с клиентами, CRM. Приложения CRM часто записывают всю переписку с клиентом, чтобы ценные данные из истории взаимоотношений сохранились. А направляя ответы клиентов через службу парсинга, приложения CRM могут получать предварительно проанализированные данные.

- Социальные приложения. Приложения для соцсетей часто позволяют общаться по электронной почте, чтобы облегчить пользователям отслеживание беседы. Парсинг входящей почты — простой и быстрый способ настроить почтовые приложения таким образом, чтобы они расширялись по мере масштабирования переписки в соцсетях.

Как проходит веб-парсинг

Принцип работы парсеров для веб-страниц одинаков, обычно он состоит из 3 этапов.

1. Запрос-ответ

Первый шаг — запросить у целевого сайта содержимое определенного URL-адреса. Взамен парсер получает запрошенную информацию в формате HTML.

2. Разбор и извлечение

Синтаксический анализ обычно применяется к любому компьютерному языку. Это процесс распознавания кода в виде текста и создания структуры в памяти, которую компьютер может понять и с которой будет работать.

Это процесс распознавания кода в виде текста и создания структуры в памяти, которую компьютер может понять и с которой будет работать.

Проще говоря, парсер берет HTML-код и извлекает оттуда соответствующую информацию — такую, как заголовок страницы, абзацы, подзаголовки, ссылки, выделения жирным, нужные темы и так далее, проводя парсинг текста.

3. Загрузка данных

Полученные данные загружаются и сохраняются. Формат файла задается таким образом, чтобы его можно было открыть в другой нужной программе. Для Google Таблиц это, например, CSV, для парсинга базы данных — JSON и так далее.

Готовое решение или собственный парсер

Предположим, вам нужно проводить регулярный мониторинг, чтобы отслеживать ценовую политику других поставщиков. И каждый раз, когда конкурент снижает цены, должно приходить соответствующее уведомление.

Чтобы решить эту задачу, возможны два варианта — создать собственный парсер или купить готовое решение на аутсорсинге. Что же выбрать?

На этот вопрос непросто ответить, и при принятии решения стоит учитывать различные факторы. Давайте рассмотрим возможности и результаты обоих вариантов.

Давайте рассмотрим возможности и результаты обоих вариантов.

Создание собственного парсера данных

Допустим, вы решили создать собственный парсер и знаете, как написать код. Самостоятельно парсить — что это даст и нужно ли вам это? Принятие такого решения имеет несколько преимуществ.

- Парсер может быть любым. Он может быть адаптирован для любой работы, которая вам нужна.

- Собственный парсер стоит дешевле. Как показывает практика, обычно создать собственный инструмент даже с использованием специальных сервисов экономичнее, чем покупать готовый.

- Вы контролируете любые решения, которые необходимо принимать при обновлении и обслуживании парсера.

Есть и обратная сторона медали.

- Придется нанять и обучить нужных сотрудников.

- Нужно купить или арендовать сервер, который должен быть достаточно быстрым, чтобы анализировать данные с нужной скоростью.

- Тесное сотрудничество с технической командой, планирование и тестирование займут время.

Создание собственного парсера имеет свои преимущества, но потребует ресурсов. Особенно если вы понимаете, для чего вам нужен парсер такого масштаба. Например, разработать сложное решение для больших объемов информации и контролировать не одного, а несколько десятков крупных конкурентов.

Парсеры данных на аутсорсе

Как насчет покупки готового инструмента, который проанализирует нужные данные по конкурентам за вас? Начнем с преимуществ.

- Не нужно тратить деньги на человеческие ресурсы, что значит: все будет сделано командой разработчика, включая обслуживание парсера и сервера.

- Любые возникающие проблемы будут решены намного быстрее. Поскольку компании, у которых приобретается готовое решение, обладают обширным опытом и хорошо знакомы со своими технологиями.

- Менее вероятно, что парсер выйдет из строя или столкнется с проблемами в целом, поскольку он будет протестирован и усовершенствован в соответствии с требованиями рынка.

Конечно, у готового решения есть и недостатки.

- Будет стоить дороже.

- У вас не будет обширных возможностей контроля за процессом и оперативного внесения изменений.