Алгоритм Google Panda (Гугл Панда)

Алгоритм ранжирования Google Panda действует с начала 2011 г. Его основной задачей является оценка качества контента. Именно благодаря Панде поисковая выдача чистится от бесполезных и нерелевантных сайтов. С 2015 г. ей на помощь пришел искусственный интеллект — алгоритм RankBrain. А с начала 2016 г. разные алгоритмы ранжирования объединили в один общий алгоритм.

Какой контент считается качественным

Отвечает на запрос. Google особое внимание уделяет соответствию запроса пользователя и содержанию статьи. Многие владельцы сайтов создают небольшие материалы, которые отвечают узким детализированным запросам пользователей. Тогда как Google лучше ранжирует статьи, отвечающие на более общий запрос, но дающий полное представление о нем. Допустим, вы создаете контент под запросы «как поливать цикламен» и «как размножать цикламен». Рекомендуем не делать под них отдельные статьи, а подготовить обширный материал под общий ключ «как ухаживать за цикламеном».

Оригинальный. Google не любит дублированный, ворованный и повторяющийся контент. Не дублируйте контент на одном сайте. Не создавайте отдельные статьи с названиями «Как ухаживать за толстянкой» и «Как ухаживать за денежным деревом», потому что это названия-синонимы одного и того же растения. Вместо этого напишите один материал, используя слова-синонимы.

Часто информация дублируется на сайтах интернет-магазинов, когда описания товара отличаются друг от друга либо цветом, либо размером. Создавайте одну карточку товара, в которой характеристики выбираются через встроенный фильтр. Если такая техническая возможность отсутствует, то прописывайте в коде страницы мета-тег canonical. По рекомендациям Google он должен ссылаться на страницу, содержащую все товары с дублированным описанием. Имейте ввиду, что технические дубли незначительно влияют на ранжирование сайта, работайте больше с дублированием содержания.

Ворованный контент — это материалы, скопированные с других сайтов. Хотя в топе поисковой выдачи все еще можно найти ресурсы с копипастом чужих статей, с каждым годом их количество неуклонно снижается. Не используйте чужие материалы без указания источника. Наличие ссылки на сайт-первоисточник легко проверяется собственником контента через сервисы упоминания в интернете.

Обращаем особое внимание на повторяющийся контент. В сети размещено много материалов уникальных с технической точки зрения, но повторяющихся между собой по смыслу. Возможности искусственного интеллекта по анализу текстов растут, поэтому со временем не уникальный по содержанию контент тоже будет понижаться в выдаче. Готовьтесь к этому заранее, создавая принципиально новые тексты. Пройдите на шаг дальше и создавайте контент, отвечающий на запросы пользователей, которых еще нет в Google Trends. Для этого общайтесь с целевой аудиторией и узнавайте ее новые и будущие потребности.

Нравится пользователям. Оценка пользователей субъективна и определяется показателями виральности: лайки, шеры, репосты, — и количеством входящих UGC-ссылок. Если сайт нравится людям, на него оставляют ссылки в соцсетях и на форумах. Все это положительно влияет на оценку алгоритмом Google Panda. Применяйте инструменты крауд-маркетинга для увеличения ссылочной массы с сайтов-форумов, отзовиков и социальных сетей.

Для повышения виральности добавляйте кнопки соцсетей ко всем материалам. Под информационным статьями и новостями размещайте блок с комментариями. Мотивируйте пользователей к обсуждению, задавая вопрос в конце статьи или начиная диалог в комментариях первыми. Однако модерируйте комментарии, удаляя спам, троллинг и агрессивные высказывания, чтобы не оттолкнуть посетителей.

Если на сайте есть форум, разрешите модераторам изменять названия тем, потому что многие из них содержат одинаковые и неинформативные фразы: «Помогите», «Как сделать», «Подскажите» и подобные. В лучшем случае к ним добавляется сама проблема, в худшем — они остаются только в виде общих призывов и вопросов.

Составляйте названия тем в зависимости от содержания ветки, чтобы посетителям стало сразу понятно, какую информацию они смогут там найти. Представители Google рекомендуют отмечать темы форума, где пользователю помогли, и ставить статус «решенное». Посетителям будет удобнее ориентироваться на форуме, а для поисковика это станет дополнительным положительным сигналом при ранжировании.

Не раздражает. К этому параметру относится объем рекламы. Размещайте разумно рекламу в виде баннеров, поп-апов и нативных материалов. Если реклама будет слишком навязчивой, пользователи быстро уйдут, а алгоритм Панда зафиксирует негативный сигнал. К раздражающим факторам также относятся «живые чаты», слишком частые push-уведомления, предложения подписаться/позвонить/оставить контакты и прочее.

Зайдите на сайт под новым ip и посмотрите на него свежим взглядом. Оцените, сколько уведомлений и предложений получил новый посетитель в течение первых пары минут. Плохо, когда пользователь еще не успел познакомиться с ресурсом, но уже вынужден принимать решения насчет дальнейшего взаимодействия с ним.

Удобный для чтения. Алгоритм Google Panda уделяет внимание еще и архитектуре сайта. Об этом в начале 2017 г. заявил представитель поисковика. Необходимо устранить проблемы со структурой, категориями, вложенностью — со всем, что мешает пользователям и путает их.

Как проверить, попал ли сайт под фильтр Панды

Еще пару лет назад seo-специалисты знали даты обновлений алгоритма Гугл Панда и могли связать падение органического трафика с попаданием сайта под фильтр. Но представители Google в каждом обращении заявляют, что они намеренно скрывают информацию, связанную с ранжированием и санкциями. Они хотят исключить возможность подтасовки результатов поисковой выдачи со стороны недобросовестных seo-оптимизаторов.

Теперь обновления фильтров в Google происходят комплексно сразу всех алгоритмов. Из-за этого тяжело понять, почему именно ресурс попал под санкции. Что привело к потере позиций: ссылки, тексты или что-то другое. Обращение к техническим специалистам Google также не добавляет ясности, потому что они отвечают общими фразами.

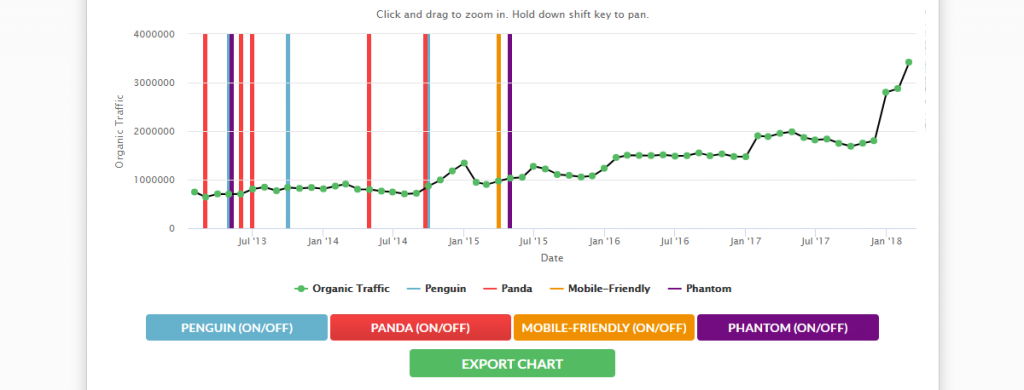

Понять, есть ли фильтр, не сложно. У сайта с высокой посещаемостью сильно падает трафик из Google, у молодых сайтов в течение длительного времени наблюдается практически нулевой трафик. Дополнительно проверяйте сайт в сервисе Feinternational.com. Он использует десять баз индексации Google в разных странах и показывает проверки алгоритмами Panda, Penguin, Phantom, Mobile-Friendly.

Чтобы определить вероятность санкций со стороны Google Panda, представители поисковика советуют провести самостоятельный аудит сайта. Почитайте материалы на своем ресурсе и ответьте на вопросы:

- может ли подобный материал выйти в виде книги или печатного журнала?

- как много и часто выходят новые материалы?

- вы бы сами подписались на рассылку от такого сайта?

- доверяете ли вы сами размещенной информации?

- стали бы вы платить банковской картой через этот сайт?

Чтобы проверить качество контента техническими методами, воспользуйтесь бесплатным сервисом «Тургенев».

Как выходить из-под санкций Google Panda

В Google рекомендуют поработать с Google Search Console и проанализировать запросы и страницы в разделе Search Analytics:

-

Посмотрите, какой контент приводит трафик на сайт.

-

Проверьте соответствие запроса и содержимого страницы.

-

Аккуратно изменяйте или удаляйте контент. Может оказаться, что Google приводил трафик именно на удаленный фрагмент.

-

Если вы считаете контент низкокачественным, дополните его свежей актуальной информацией, а старый материал закройте от индексации с помощью robots.txt или noindex, но не удаляйте.

-

Если сайт попал под фильтр, это не значит, что он весь будет плохо ранжироваться.

-

Ресурсы, содержащие востребованную у пользователей информацию, особенно в части непопулярных запросов, будут показываться в выдаче по разному. Часть страниц будет и дальше ранжироваться высоко, часть будет под фильтром, пока владелец не улучшит контент на них.

-

Удаляйте только явный спам, который некоторые пользователи оставляют на форумах и в комментариях.

-

Удаляйте навязчивую рекламу, уведомления и предложения.

Представитель Google Гэри Илш говорит, что «каждый владелец сайта должен в конце дня задать вопрос, не сколько у нас было посетителей сегодня, а скольким посетителям мы сегодня помогли». Постарайтесь отталкиваться от этого, когда работаете над улучшением ресурса.

Шпаргалка

-

Google Panda — алгоритм ранжирования, который оценивает качество контента. Он входит в общий алгоритм ранжирования сайтов в Google.

-

Панда не любит ворованный, дублированный и повторяющийся контент.

-

Панда понижает сайты в выдаче, которые не нравятся пользователям, раздражают излишне навязчивой рекламой и предложениями, имеют запутанную архитектуру.

-

Специалисты Google скрывают механизм работы алгоритма и рекомендуют оценивать сайты самим владельцам. Просто ответьте на вопрос, вы сами доверяете информации, которую размещаете на сайте.

-

Проверяйте подпадание под фильтр Google с помощью сервиса Feinternational.com.

-

Проверяйте статьи в сервисе «Тургенев». Он покажет качество контента, заспамленность и риск попадания под фильтры.

-

Если сайт попал под санкции Панды, работайте над улучшением контента с помощью Google Search Console. Не удаляйте низкокачественный контент, а закрывайте его от индексирования и дополняйте новой информацией.

Материал подготовила Светлана Сирвида-Льорентэ.

www.ashmanov.com

что это за алгоритм, когда происходит апдейт (update), и как определить, что вы попали под фильтр Google Panda

Есть проблемы с ранжированием, проект не растет, хотите проверить работу своих специалистов по продвижению? Закажите профессиональный аудит в Семантике

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

Гугл Панда – это программа-фильтр от компании Google. Его задача – отслеживание и блокировка сайтов с некачественным контентом.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Поисковая система Google считает своей основной функцией предоставление пользователям релевантной, интересной и полезной информации. Именно поэтому она жестко борется с черными методами продвижения, когда сайт попадает в ТОП выдачи не с помощью создания качественного и востребованного контента, а путем манипуляций поисковыми системами.

История Панды

Алгоритм Google Panda – автоматический. Первым шагом к его созданию стала оценка большого количества сайтов на соответствие требованиям, которые Google предъявляет к контенту. Проводилась она вручную силами группы тестировщиков и позволила формализовать основные факторы, влияющие на качество содержания сайтов.

Первый раз Google Panda вышел в свет в феврале 2011 года, однако в полную силу заработал в апреле. Только в течение 2011 года алгоритм обновлялся 57 раз, а затем еще 5 раз в 2012 году. Следующий 2013 год принес последнее обновление Панды с собственным номером – Panda 25, которое претерпело небольшие изменения в июне и в июле этого же года. Последняя версия алгоритма Panda 4.0, выпущенная в мае 2014, пошатнула позиции новостных агрегаторов и затронула таких гигантов, как Ebay.

На сегодняшний день алгоритм совершенствуется практически непрерывно, обновляясь каждый месяц в течение 10 дней. Даты обновлений компания не обнародует, чтобы максимально затруднить манипулирование позициями сайтов в поисковой выдаче.

Требования Google Panda к сайтам

Google Panda предназначен в первую очередь для борьбы с некачественным контентом, поэтому его основные требования к сайтам основаны на качестве публикуемой информации.

- Сайт должен в основном содержать уникальный контент, на нем не должно быть дублированных текстов и изображений.

- Недопустимо использование автоматически сгенерированных текстов.

- Роботы поисковых систем и пользователи должны видеть одно и тоже, нельзя использовать страницы, которые видны только поисковикам и нужны исключительно для продвижения сайта.

- Ключевые слова каждой страницы сайта должны соответствовать ее содержанию, переспам ключевыми словами недопустим.

- Ссылки и реклама на страницах должны соответствовать тематике текстов и иному содержанию страницы.

- Запрещается применять дорвеи, скрытые ссылки или скрытый текст, целью которого является обман поисковой системы.

Алгоритм Google Панда накажет вас, если на страницах сайта содержится контент, скопированный с других ресурсов без ссылки на источник, шаблонные статьи, имеющие идентичную структуру, дублированные страницы. Попасть под фильтр Панда Гугл могут сайты, на которых тексты идут сплошной простыней, без иллюстраций, видео или инфографики, с одинаковыми метатегами на разных страницах.

Считается, что этот алгоритм мало внимания обращает на ссылки, однако он требует, чтобы ссылки в статьях непременно соответствовали их теме. То есть, в текстах про пластиковые окна не должно быть ссылок на продажу чая и т.п.

Помимо всего описанного, Гугл Панда уделяет много внимания поведенческим факторам. Если на вашем сайте велик процент отказов, пользователи уходят с него после первой же страницы и больше не возвращаются, вы непременно попадете в поле зрения алгоритма.

Как спастись от санкций Google Panda

Как выявить действие Панды

Прежде чем принимать меры по выходу из-под фильтров Google Panda, убедитесь, что вы пострадали именно от его лап. Как определить, Гугл Панда стал виновником вашей проблемы, или причина в чем-то еще?

Обратите внимание на связь между обновлением алгоритма и падением трафика на сайт. Update Google Panda проводится ежемесячно, продолжается 10 дней, узнать время его проведения можно на сайте Moz.com. Если совпадение налицо, надо принимать меры.

Второй способ поймать Панду — воспользоваться специальным сервисом Barracuda. Один из сервисов этого сайта, Panguin Tool, получив доступ к информации вашего аккаунта в Google Analytics, накладывает взятый из него график на даты обновлений алгоритма и выдает ответ. Минусов у этого способа два – он не подходит тем, у кого счетчик Google Analytics стоит недавно и требует доступа к аккаунту, который в, свою очередь, позволяет добраться до денег на вашем счете в Google Analytics.

Третий способ достаточно прост, но требует времени и терпения. Вам придется проверить каждую страницу сайта. Делать это надо так:

- Копируете несколько предложений из текста на странице в поисковую строку Google. Достаточно взять 100-200 символов.

- Смотрите, появился ли ваш сайт в верхней части выдачи.

- Заключаете тот же отрывок в поисковой строке в кавычки и снова смотрите, есть сайт в выдаче или нет.

Если сайт появляется в выдаче только во втором случае, значит виновник ваших бед Google Panda. Запомните, что проверить придется каждую страницу.

Как выйти из-под фильтра

Для выхода из-под фильтра Панды вам придется предпринять следующее:

- Сделать полную ревизию содержания сайта и заменить большую часть текстов на интересные и полезные, а остальные переработать так, чтобы они стали уникальными и актуальными.

- Убрать избыток ключевиков из заголовков всех уровней и метатегов. Заголовки поменять на релевантные и привлекательные, сделать так, чтобы они цепляли посетителя и вызывали желание прочесть текст.

- Почистить сайт от нерелевантной и агрессивной рекламы, что заметно улучшит поведенческие факторы.

- Удалить все дубли и битые ссылки, снять выделение с ключевых слов.

- Проверить ссылки на страницах на соответствие содержанию страниц и заменить или убрать нерелевантные.

Эти шаги помогут вам со временем выйти из-под фильтров Панды. Однако учтите: Google Panda – автоматический алгоритм, и никакие обращения не помогут вам быстро освободиться от его санкций. Заполняйте сайт интересным уникальным контентом, не увлекайтесь размещением на нем рекламы, и вы не попадете на зуб к умному зверю Панда Гугл.

semantica.in

Алгоритм Google Panda: как определить фильтр Панда

Google Panda – это поисковый алгоритм, внедренный компанией Google 24 февраля 2011 года для фильтрации сайтов в поисковой выдаче. Он создан с целью сортировки сайтов и отсеивания низкокачественных страниц, наполненных неуникальными текстами с обилием орфографических и стилистических ошибок, дублирующейся и недостоверной информацией. Благодаря работе фильтра пользователю предлагаются сайты с наиболее релевантным содержанием, исключая страницы, созданные с целью агрессивного SEO-продвижения.

Разработка фильтра

Изначально фильтр заработал для пользователей из США. По отчетам SEO-специалистов, нововведение привело к существенному сокращению трафика из поисковой системы Google: на 12 % для крупных сайтов и почти на 50 % для небольших ресурсов. Около 10 % сайтов с маленькой и средней посещаемостью попали под фильтр и были забанены в системе. После тестирования алгоритм «Панда» Гугл заработал в других странах. В России фильтрация сайтов началась с 24 апреля 2012 года и привела к схожим результатам – падение некоторых сайтов в поисковой выдаче достигало 50 позиций.

Разработка алгоритма «Панда» Гугл, как и других алгоритмов для поисковых систем, велась в атмосфере закрытости. Для рядовых пользователей и для веб-мастеров подробности не раскрывались. На данный момент известно только о двух разработчиках – Мэтте Катсе и Амите Сингале. Другие детали не раскрываются по официальной политике компании Google.

До 2016 года вывести сайт из-под блокировки удавалось только после очередного апдейта для фильтра. Они выходили с периодичностью примерно раз в 2 месяца. В общей сложности с момента запуска их накопилось около 30. С января 2016 года фильтр Google Panda внедрен в алгоритм ранжирования поисковой системы (Core Ranking Algorithm). Для веб-мастеров это нововведение принесло выгоду, потому что блокирование и вывод сайта из-под бана происходит на лету, очередного обновления дожидаться не нужно.

Что учитывает алгоритм

Новые алгоритмы фильтрации призваны улучшить качество SERP для конечного пользователя. Сайты с некачественным содержимым попадают в топ-10 намного реже. Основной критерий – достоверность и полезность информации на странице. Если сайт полезен, то он имеет гораздо больше шансов выйти в топ по определенным ключевым словам.

На данный момент достоверно выявлено несколько аспектов Google Panda, на которые фильтр реагирует в первую очередь:

- уникальность контента;

- качество ссылочного профиля;

- поведенческие факторы (поведение пользователей).

Чтобы исключить попадание под фильтр Гугл «Панда», необходимо размещать на страницах сайта только уникальные, структурированные тексты с минимальным количеством орфографических и стилистических ошибок. Размещенные ссылки не должны вести на блокированные или малопосещаемые сайты.

Особенностью работы поисковой системы Google является учет поведенческих факторов. По некоторым косвенным признакам специалисты делают вывод о том, что этот фактор становится более существенным. В данном случае учитывается количество переходов, время, проведенное на сайте, цитирование и т. д.

Как вывести сайт из-под фильтра

Ограничения, накладываемые фильтром «Панда», призваны заставить веб-мастеров внимательнее относиться к наполнению страниц.

Для этого необходимо:

- размещать уникальный контент – тексты, изображения и видео;

- регулярно обновлять контент;

- сокращать часть ссылочной массы;

- удалять нерелевантное содержимое, рекламу, ссылки;

- оптимизировать интерфейс и структуру сайта для удобства пользователя;

- улучшать поведенческие факторы.

Ресурсы, размещающие ссылки на источники заимствований, могут исправно работать без попадания под фильтр. Представители Google не раскрывают точный процент критической массы ссылок, но веб-мастерам стоит работать над созданием уникального контента. По некоторым субъективным оценкам, точность фильтрации составляет около 90–95 %, поэтому попадаются ресурсы, необоснованно пониженные в поисковой выдаче. В этом случае стоит проконсультироваться с представителями технической поддержки, а при необходимости принять соответствующие меры.

wiki.rookee.ru

Новый поисковый алгоритм Гугла (Google Panda)! Последние изменения, какие факторы учитываются?

Заметные изменения в поисковой выдаче Google стали наблюдаться, когда был запущен новый алгоритм Гугл Панда. Но в конце апреля этого года, прямо перед майскими праздниками, многие оптимизаторы и веб-мастера стали панически обсуждать непонятные и очень резкие «падения» позиций сайтов в поиске Гугла. И произошло это не случайно. 24 апреля было опубликовано официальное заявление разработчиков поисковой системы Google, в котором были анонсированы последние изменения в поисковом алгоритме Google Panda и сообщено о запуске нового алгоритма Google Penguin.

Полная версия новости от разработчиков Гугла представлена чуть ниже, а сейчас я расскажу главные моменты для тех, у кого мало времени и кто любит «зёрна отделённые от плевел».

Что же произошло перед майскими праздниками и почему тысячи сайтов потеряли свои позиции в поиске? Стоит отметить, что некоторые страницы по определённым запросам «упали» на 50 и более позиций, что вызвало немалую панику в SEO кругах. Десятки тем и обсуждений на популярных форумах вызвали не малый ажиотаж, и набрали уже тысячи сообщений (вот одна из тем http://forum.searchengines.ru/showthread.php?t=711171).

Если бы это были обычные «докрутки» от разработчиков Гугла или временный баг, вряд ли бы подобная тема становилась всё популярнее с каждым днём. Недельку «поштормило» и всё вернулось на свои «прежние» места – так бывает, к примеру, с Яндексом. Но Google в этот раз не «глючил». Все «падения» сайтов в поиске были вызваны вводом новых «правил» борьбы с некачественной оптимизацией и некачественными сайтами.

Казалось бы, что здесь нового? И Яндекс и Гугл уже давно заявляли о том, что в ТОПе будут только качественные сайты, и скоро мы придём к поисковому «коммунизму»! К примеру, разработчики Google Panda (Амит Сингал и Мэтт Катс) довольно понятно рассказали, каким сайтам будет дан «красный свет» в поисковой выдаче Google. Для тех, кто ранее не видел этот список, рассмотрю его более подробно. Итак, ГСами или просто «не заслуживающими доверия» и некачественными сайтами с недавних пор считаются:

Какие факторы учитывает новый алгоритм Google Panda?

1) Сайты, которые любят воровать чужой «контент». Если на web-ресурсе очень много неуникальных статей (проще говоря, копипаста), то это уже «первый звоночек». Если сайт старый и «трастовый», ставящий ссылки на источники «заимствованных» статей, его вряд ли накажут только за этот фактор, но все же, для любого сайта существует критический процент, за который выходить очень чревато!

Какой процент безопасен? Спросите у разработчиков Гугла, а лучше не испытывайте судьбу и алгоритмы поисковых систем. Хотя для молодых сайтов этот процент очень не велик. Но о вреде неуникального контента знают даже новички. Если Вы слышите об этом в первый раз, советую проверять Ваши статьи на уникальность. И Advego Plagiatus Вам в помощь.

2) Многие сайты занимаются продажей ссылок. А как же иначе, спросят многие? Мы ведь хотим извлекать доход со своих сайтов! Спорить никто не станет, «хозяин-барин», на кого хотим, на того и ссылаемся. Но проблема в том, что Гугловской Панде это может не понравиться. Особенно если на сайте очень много ссылок не «по теме», или другими словами, ссылки на не тематические контенту страницы.

Стойте! Зачем Вы меня пугаете? Я что не могу сослаться со своего SEO-блога на сайт моей бабушки, которая занимается вязанием, и держит фабрику швейных машинок? Я же не за деньги, это «по любви»! Никто не запрещает любить бабушек и ссылаться на сайты не Вашей тематики, но текст, окружающий ссылку должен быть тематическим.

Другими словами, раз уж решили поставить ссылку на фирму пластиковых окон, тогда пишите рядом с ней статью про то, какие замечательные окна Вы установили своей маме на дачу, как у них много камер, и какие они теплосберегающие. Не забудьте в название статьи также вписать нужный «ключ», теперь к Вам претензий нет. И такая ссылка будет качественной и естественной в глазах любых поисковых систем.

Про то, что современные «самообучающиеся системы» почти безошибочно определяют «некачественные» продажные ссылки (Яндекс анонсировал точность до 95%) мы уже слышали давно. Хотя про ссылочные биржи с автоматическим размещением (SAPE и пр.) я вообще не говорю, никто такие ссылки уже не называет естественными, как бы Вы их не оформляли.

Текст ссылки должен соответствовать теме самой публикации, это мы поняли.

3) Разработчики Гугла заявили, что приветствуют «белую» оптимизацию и будут наказывать за «чёрную» или, проще говоря, за переоптимизацию.

О чём речь? Белая и чёрная магия, здесь всё понятно! Но что Вы имеете ввиду под «чёрным SEO»? Объясняю для тех, кто только постигает «науку» SEO джедаев.

Очень многие новички любят продвигать свои страницы по популярным конкурентным запросам. Но, как правило, текст страницы не соответствует запросу. «Ну и правильно, зачем писать о том, что уже 100 раз написано? Лучше возьму любую страницу (статью), напишу к ней заголовок с нужным ключом, «натыкаю» повсюду в тексте нужных ключевых слов, выделю все нужные ключи жирным. Сделаю всё так, как учили бывалые «SEO-гуру» 10 лет назад. Гугл обязательно поймёт, что именно на мой сайт нужно направлять тысячи посетителей» — так подумал начинающий веб-мастер, и в итоге, его сайт «пал смертью храбрых» от страшного «фильтра» Гугл Panda.

Если Вы в первый раз слышите об оптимизации страниц под нужные запросы, забудьте абзац, который я написал выше! Если содержание страницы НЕ соответствует запросу, под который Вы её оптимизируете и продвигаете, это также очень хороший повод попасть под фильтр.

Пользователи должны находить качественный ответ по тому запросу, который искали. Тогда Вам будет счастье и на Ваш сайт снизойдёт «Божья благодать». И это совсем не ирония, а правда жизни. Не забываем, что поведенческие данные пользователей дают очень много полезной информации поисковикам. Иными словами, если Вы не заинтересуете пользователей Вашим контентом, и они, не найдя нужный ответ, уйдут снова искать дальше в поиск, это очень плохо. Подобные действия называются «отказами», которые существенно понижают «некачественную» страницу в поиске. А если будете и дальше «обманывать» доверчивых людей, Ваши страницы не только будут очень низко в поиске, но и вообще попадут под фильтр Google Panda.

Думаем о людях, анализируем поведение пользователей с помощью специальных сервисов (Гугл Аналитикс, Яндекс Метрика) или хотя бы просто смотрите данные статистики счётчиков, наподобие LiveInternet.

Ещё раз подчёркиваю очень важные факторы, которые разделяют качественные и некачественные сайты:

- количество отказов (как часто пользователи не найдя ответ, сразу уходят обратно в поиск)

- время, которое пользователи проводят на конкретной странице и на сайте

- сколько людей возвращается на Ваш сайт? А может он очень качественный, постоянно обновляется, и на него приходят из закладок и по другим ссылкам?

Все эти показатели с недавнего времени напрямую влияют на позиции Вашего сайта в поиске. Именно пользователи «решают» быть Вашему сайту в ТОПе, или чуть ниже.

Так стоит ли подстраиваться под какие-то требования текущих алгоритмов?

Не стоит. О «белой» оптимизации я рассказывал в своём видеокурсе по SEO, а Вам посоветую думать о том, как угодить пользователям и как «удержать» их на сайте. Если для Вас пользователи будут на 1-м месте, тогда никакие Google Панды Вам не страшны!

4) Вы любите писать свои «творения» и создавать новые страницы на основе шаблонов? Ой, боюсь, что Гугл Панде это совсем может не понравиться.

«Я пропал! У меня же дизайн сайта на популярном шаблоне! Конец моему супер блогу» — закричал один из начинающих «сео-гуру». Нет, речь не о дизайне, не о теме оформления Вашего замечательного сайта. Пандочка может «покарать» Ваши шаблонные публикации. Имеются ввиду похожие по содержанию статьи, но оптимизированные под разные ключевые запросы. Вот этого не стоит делать. Всё что делается ручками и с «душой», это хорошо. Всё что делаем на автомате и на потоке, тут могут быть проблемы.

5) Ни для кого, думаю, не секрет, что поисковые системы очень пристально следят: на кого Вы ссылаетесь, и кто ссылается на Вас. Поэтому не стоит ссылаться на «некачественные» ресурсы, «дружить» с плохими сайтами и получать с них ссылки. Думаю, от этого совета никто не удивился.

«Скажи мне на кого ты ссылаешься, кто ссылается на тебя, и я отвечу кто ты на самом деле» — Google Panda.

Факторов, которые влияют на поисковую выдачу, безусловно, гораздо больше. И они учитываются в разных сочетаниях. Но самые важные я описал выше и уместил их всего в 5 пунктов.

В принципе, для тех, кто знаком с последними новшествами поисковым систем, ничего нового сказано не было. Вроде бы напрашиваются банальные выводы:

— делайте сайты для людей, улучшайте удобство и функциональность (юзабилити). Следите за поведением (настроением) пользователей. Делитесь с ними действительно качественным контентом, который максимально полно отвечает на их запросы.

Вроде ничего нового не сказал. Кто-то даже разочаровался: «А где же секреты, как обмануть этот алгоритм Google Panda и всегда быть в ТОПе?»

Никого обманывать и ни под кого подстраиваться не нужно! Тот, кто пытается найти «лазейки» для своих некачественных сайтов, в итоге обречён на провал, и любые «SEO секреты» ему не помогут.

От себя могу сказать, что у меня есть немало хороших посещаемых сайтов, некоторым их них уже более 10 лет. И они как были качественными 5-10 лет назад, так и остаются на «уровне». Так как они созданы и развиваются для людей, для пользователей. И никакие новые алгоритмы им нипочём. Ресурсы, которые любимы пользователями и имеют свою аудиторию, обладают потрясающим «лимитом» доверия со стороны поисковых систем.

А вот сайты, которые создавались ТОЛЬКО для заработка на ссылках и рекламе, с некоторыми из них бывают проблемы. Тут ничего нового.

Также признаю, что продвигать молодые коммерческие сайты стало существенно сложнее. Я это вижу по увеличению числа заказов на размещение вечных качественных ссылок. Тематический обмен ссылками также стал очень популярным.

На этом я заканчиваю свои рассуждения о нововведениях Гугла. Для тех, кто любит читать послания от первоисточника, перевожу на русский язык заявление разработчиков Гугл Panda.

И, как говорится, простите меня за мой английский.

Перевод официальной новости (Another step to reward high-quality sites) от разработчиков алгоритма Google Panda или «награда для высококачественных сайтов»:

Представители Google заявили, что поисковая оптимизация или SEO, может быть позитивной и даже конструктивной. Эффективная поисковая оптимизация может улучшить восприятие (понимание) сайта поисковыми системами и сделать отдельные страницы более понятными, за счёт чего их легче будет найти. Поисковая оптимизация включает в себя такие вещи как: исследование ключевых слов, чтобы гарантировать, что нужные слова присутствуют на странице, а не только профессиональный жаргон, на котором нормальные люди почти никогда не пишут.

«Белая» оптимизация, как правило, улучшает юзабилити (удобство) сайта, помогает создать более качественный контент, сделать сайты быстрее, что хорошо как для пользователей, так и для поисковых систем. Грамотная поисковая оптимизация также подразумевает хороший маркетинг: творческий подход, чтобы улучшить сайт и сделать его более привлекательным, может помочь как поисковым системам, так и социальным медиа. Итоговым результатом может стать создание отличного сайта, намного более полезного для людей.

Противоположностью «белому SEO» можно назвать так называемое «чёрное SEO или webspam» (мы ввели термин «webspam», чтобы не путать со словом «спам»). Чтобы получить более высокие позиции в поиске и больший трафик (посещаемость), некоторые сайты применяют методы, целью которых является исключительно поиск «фишек» и «лазеек», которые помогут ранжировать определённые страницы на более высоких местах, чем они заслуживают при «честном» подходе. Мы видим различные попытки вебспама практически каждый день. Идёт манипуляция ключевыми словами, используются ссылочные «сетки», чтобы получить более высокие позиции в поиске.

Целью многих изменений наших поисковых алгоритмов является оказание помощи в нахождении сайтов, которые содержат большой опыт пользователей, и соответствуют их информационным потребностям. Мы также очень хотим, чтобы «хорошие парни», которые делают качественные и полезные сайты для людей, а не для алгоритмов, увидели, что их усилия оцениваются по достоинству. Именно для этого мы внесли изменения в Panda, которые позволили представить в результатах поиска существенно более качественные сайты. Также в начале этого года мы запустили алгоритм «макета страницы», который понижает в результатах поиска сайты, содержащие малое количество контента на странице (above the fold). В частности, «наказываются» сайты, которые закрывают основной контент рекламой, всплывающими окнами т.д. «Первый экран» должен быть свободен, а пользователи должны сразу видеть содержимое страницы, которое они ищут.

В ближайшие дни будут запущены изменённые алгоритмы, направленные на борьбу с вебспамом. Данные нововведения позволят понизить в поиске сайты, которые нарушают существующие требования Google. Мы всегда нацелены на борьбу с webspam, и данный алгоритм представляет последние достижения в вопросе уменьшения влияния некачественных методов SEO (webspam).

Таким образом, будет достигнуто улучшение качества поиска и представленного контента. Несмотря на то, что мы не можем разглашать какие-то конкретные принципы работы нового алгоритма, чтобы не дать кому-то возможность искусственно влиять на результаты поиска и ухудшить его качество для пользователей, мы дадим несколько советов веб-мастерам. Следует создавать высококачественные сайты, которые будут содержать полезный опыт и ценную информацию, использовать «белые» методы SEO, но ни в коем случае не применять агрессивную тактику чёрного SEO (webspam).

Вот пример сайта, на котором использована тактика вебспама (webspam), «игра» ключевыми словами, которая будет «наказана» поисковыми алгоритмами (нажмите на картинку, чтобы увидеть в полном размере):

Конечно, большинство web-страниц, пострадавших от этого изменения не имеют столь вопиющих нарушений. Вот ещё один пример сайта с необычными ссылочными связями, которые также нарушают правила, и будут подвергнуты «санкциям». Обратите внимание, что если вы попытаетесь прочитать представленный текст вслух, вы сразу обнаружите, что исходящие ссылки не имеют никакого отношения к реальному содержанию.

Нажмите на картинку, чтобы увидеть в полном размере:

Объекты (страницы сайтов), которые пострадали от этого изменения, не всегда могут быть легко определены как вебспам. Но на основе глубокого анализа и экспертизы, становится понятно, что они также нарушают требования. Подобные сайты применяют гораздо больше, чем позволено методами белого SEO. Учитывая этот факт, мы считаем, что они используют (пусть и частично) тактику webspamа и пытаются манипулировать результатами поисковой выдачи.

Изменения вступят в силу на всех языках одновременно. После ввода первой версии алгоритма Google Panda существенно пострадали около 12% запросов. Нынешняя версия Панды затронула только 3,1% запросов на английском языке до такой степени, что пользователь может это заметить. В таких языках, как китайский, немецкий и арабский были затронуты около 3% запросов, процент может быть более высоким в языках, которые более подвержены спаму. К примеру, 5% польских запросов изменятся настолько, что это заметят обычные пользователи.

Мы хотим, чтобы люди использовали «белые» методы поисковой оптимизации (либо вообще не использовали никакой оптимизации) и сосредоточились на создании красивых и содержательных сайтов. Как и всегда, мы открыты для обратной связи и готовы искать пути для улучшения наших поисковых алгоритмов.

Оригинал новости на английском языке: http://googlewebmastercentral.blogspot.com/2012/04/another-step-to-reward-high-quality.html

Для тех, кому интересна дополнительная информация про обновлённый поисковый алгоритм Гугла (Google Panda), предлагаю посмотреть видео доклад Артёма Бородатюка на канале Megaindex.tv.

Мнение SEO специалистов об обновлённом алгоритме Гугл Панда (видео):

Буду рад «услышать» Ваши мнения о Гугл Панде в комментариях. Повлияла ли Google Panda на Ваши сайты?

Если вы хотите на практике научиться выводить сайты из под Google Panda, рекомендую вам новый (2017 год) уникальный видео-кейс «Как вывести сайт из-под «фильтров» (санкций) поисковых систем Google или Яндекс?».

ruslansavchenko.com

Фильтр Google Panda | Описание действия алгоритма «Панда»

Известно, что алгоритм Google Panda представляет собой совокупность обновлений систем поиска, нацеленных на увеличение релевантности страниц в выдаче. Для этого берется во внимание около ста различных факторов. В результате анализа сайты с низким качеством контента и выраженной переоптимизацией понижаются в выдаче.

Особое внимание алгоритм «Панда» уделяет внутренним факторам, в первую очередь текстовому контенту. Рассматривается его объем, уникальность, степень заспамленности ключами и прочее. Тем самым Panda дополняет другой алгоритм Google — Penguin, отвечающий за внешние факторы ранжирования сайта.

Также во внимание берутся процент отказов, логичность структуры сайта и правильность перелинковки.

Близкого знакомства с «Пандой», конечно, лучше сторониться. Но если сайт все же попал под фильтр, важно своевременно узнать об этом. Достоверно определить этот факт невозможно, так как информация о дате выхода обновлений Google «Панды» отсутствует. Но косвенным свидетельством попадания под фильтр будет снижение числа посетителей из ПС Гугл. Стоит отметить, что фильтр накладывается на весь сайт, поэтому, выполняя работы по выводу, необходимо уделять внимание ресурсу в целом.

Как определить, что сайт под фильтром Google «Панда»?

Воспользуйтесь сервисом проверки уникальности текстов — например, WebSite Auditor, Advego Plagiatus или любым другим Вам доступным, но при этом корректным. Необходимо определить уникальность всех документов на сайте. Если большая часть контента (от 20% и более) скопирована из других источников, рекомендуем принять меры по уникализации проблемных участков.

- Смотрим на содержательность контента. Пользователи должны находить на странице необходимый ответ на свой вопрос. Проверку на фильтр Гугла по этому параметру также должны пройти все страницы.

- Необходимо наполнять страницы сайта максимально информативным и развернутым контентом: текстовым, графическим, медийным. «Панда» оценивает не только текстовую релевантность, но и общее наполнение страницы.

- Следует удалить повторяющийся контент, который не терпит алгоритм Google Panda.

- Нужно проверить тексты на переизбыток ключевых слов. «Панда» накладывается за переспамленность.

- При подготовке нового качественного контента для сайта принимайте во внимание, насколько вовлечены пользователи, на основании статистики систем аналитики Гугла.

- Необходимо выстаивать правильную структуру сайта с логичной перелинковкой внутренних страниц.

Как перестать быть интересным алгоритму Google Panda?

В первую очередь необходимо сделать полный аудит сайта и определить, что могло вызвать наложение фильтра. Далее можно приступать к устранению недочетов.

- Уделите особое внимание контенту. Объем текста должен превышать 400 символов. Чтобы избежать попадания под действие фильтра Гугла «Панда», не менее важно отредактировать текст: он должен быть содержательным, удобочитаемым и уникальным. Дубли страниц необходимо удалить. Следует также подчистить от лишних ключей сам текст, а также заголовки и метатеги. Важно, чтобы сайт был в должной мере наполнен информацией, полезной для посетителей (например, новостями, статьями, разделами «Вопрос – ответ» и прочим).

- Постройте правильную структуру сайта. Это ключевое требование для правильной перелинковки страниц. Также важно исправить все технические ошибки сайта.

- Избавьтесь от нерелевантной рекламы. Если на странице имеются агрессивные всплывающие окна, поп- и кликандеры, пусть даже и по теме, не сомневайтесь, что интерес со стороны Google «Панды» — лишь вопрос времени. Решите сами, стоит ли потенциальная выгода от такой рекламы порождаемых ею рисков.

- Определите работоспособность ссылок (как внешних, так и внутренних). Для этого отлично подойдет плагин Broken Link Cheker или сервис Netpeak Spider. Не помешает добавить и дополнительную навигацию.

Главное при этом — помнить, что цель алгоритма «Панда» заключается в блокировке плохого контента. Google Panda любит большое количество уникального контента. Чем его больше, тем выше вероятность, что фильтр снимут. Нужно только периодически индексировать страницы.

Это основные рекомендации, которые позволят избежать санкций со стороны Гугла. Их можно использовать в качестве базовых еще на этапе создания сайта, его наполнения и продвижения. Чем более содержательным будет веб-ресурс, тем меньше ему угрожает этот алгоритм. Соответственно, позиции в выдаче будут предельно устойчивыми.

Если сайт попал под фильтр, то до следующего апдейта он уже не сможет освободиться от влияния Google Panda. Именно поэтому лучше предупредить проблемы, чем потом их решать.

www.demis.ru

Алгоритм Google Panda 4.2 — 10 советов от SEO-экспертов — Netpeak Blog

Как диагностировать Google Panda, понять, что нужно изменить на своем сайте и сделать пользователей счастливыми. В этом посте мы собрали все, что подписчики блога Netpeak захотели узнать о новом апдейте алгоритма Google.

Вначале — об особенностях апдейта Google Panda 4.2:

- В строгом смысле этого слова, Panda 4.2 — не апдейт. Апдейт подразумевает включение в алгоритм каких-то новых сигналов. А если верить Барри Шварцу, в Panda 4.2 новых сигналов нет. Просто обновилась база анализируемых сайтов.

- Апдейт станет самым долгим в истории Google. Возвращение трафика на сайты под Panda 4.1 и наложение новых санкций займет не дни, не недели, а месяцы — до одного года. Вполне возможно, что апдейт станет последним, и в будущем Panda будет обновляться непрерывно.

- Panda 4.2 — глобальный апдейт, который коснется 2-3% всех запросов — более 105 миллионов сайтов. Panda 4.0 в мае 2014 затронула 7,5% всех поисковых запросов, апдейт в сентябре до 4.1 — 3-5%.

- Panda будет анализировать сайты постранично, поэтому в ходе апдейта страницы сайта могут ранжироваться по-разному. Но не стоит обманываться: алгоритм по-прежнему касается всего сайта в целом.

Как понять, что сайт стал жертвой Panda и что делать, если опасения подтвердились? Читайте 10 практических советов.

1. Узнайте, почему упал трафик

Существует множество методов диагностики Google Panda: от анализа источников трафика по Google Analytics до проверки ранжирования сайта по низкочастотным запросам и фрагментам текста. В одном из наших кейсов по выводу сайта из под Google Panda мы применяли комплексный подход для постановки диагноза. Существует и более простой способ — использовать Panguin Tool. SEO-специалист Netpeak Алексей Данилин рекомендует его как точный инструмент для выяснения причин падения трафика на сайте. Panguin Tool показывает апдейты алгоритмов Google в наложении на трафик сайта по Google Analytics. Также можно использовать сервисы, показывающие степень изменения выдачи, например Mozcast. Очень важно знать, какие работы проводились по сайту в последние несколько месяцев. Часто бывает, что падение трафика связано с техническим проблемами, которые не успели вовремя обнаружить. Также нужно понимать, не наложены ли на сайт ручные санкции. Это можно проверить в Google Search Console. От ручных санкций избавиться гораздо проще и для них всегда указана причина наложения.

2. Следите за новостями SEO-комьюнити

Из-за скорости апдейта трафик начнет падать только на некоторых страницах сайта, поэтому в точной диагностике на этот раз пригодится и помощь коллективного разума SEO-сообщества. В этом уверена Дженнифер Слег из The SEM post. На тематических форумах (Webmasters, Searchengines) фиксируют появление массовых изменений в выдаче. Так были обнаружены периоды активности Penguin 3.0, который, хоть и вышел 17 октября прошлого года, дал о себе знать массовыми изменениями в выдаче только в ноябре и декабре.

3. Работайте с проблемными страницами

Понять, что страница проблемная — довольно просто. Это страницы, трафик которых упадет больше всего. В зоне риска:

- Низкокачественные лендинги.

- Разделы сайта, перенасыщенные текстом и рекламой.

- Страницы с дублирующимся контентом.

- Страницы с небольшим количеством текста (до 400 слов).

- «Глубокие страницы», путь к которым занимает более четырех кликов от главной сайта.

Работа с проблемными страницами — рутинная часть поисковой оптимизации. Неспециалисту важно понимать, что под действие фильтра могут попасть все страницы, не удовлетворяющие запросы пользователей.

Один из главных сигналов для Google Panda — поведение пользователя после его клика по ссылке сайта на странице выдачи. Если в течение нескольких секунд пользователь возвращается на страницу выдачи — риск оказаться под фильтром увеличивается в разы.

Проверить весь сайт или отдельные его страницы на соответствие поисковым запросам пользователей помогает новая функция Serpstat (ex. Prodvigator). При расчете релевантности страницы поисковому запросу Serpstat (ex. Prodvigator) учитывает:

- Как часто на странице встречаются ключевые слова из поискового запроса.

- Используется ли на странице в точном вхождении выделение ключевых слов тегами ‘strong’ или ‘i’.

- Количество ключевых слов из поискового запроса, которые встречаются на странице перехода.

- Длина страницы.

- Количество словосочетаний из поискового запроса, которые в тексте страницы встречаются в таком же порядке, как и в запросе.

- Множество других параметров.

В итоге пользователь видит числовое значение релевантности своей страницы.

Если раньше в качестве профилактики Google Panda называли регулярную генерацию качественного контента, в том числе в блогах. Но в последнее время тот же Рэнд Фишкин чуть ли не в каждом выпуске Whiteboard Friday говорит о значении старых текстов и второй жизни прошлогодних постов.

4. Пишите длинные тексты

Оптимальная длина текста на странице, по мнению Брайна Питмана из PR Daily, от 600 до 800 слов. Если на странице меньше 400 слов, это может быть тревожным сигналом.

Если вы не можете выжать по теме (например, о пассивных магнитных подшипниках) интересный и релевантный текст, по крайней мере проставьте внешние ссылки на авторитетные тематические ресурсы.

5. Тщательно редактируйте контент

Google Panda — очень требовательный читатель. На всех языках мира. Например, исследование Маркуса Тобера из Searchmetrics показывает, как поисковик успешно использует формулу Флеша (индекс удобочитаемости) в ранжировании.

80 — примитивный уровень текста, усваивается даже детьми. 30 и ниже — уровень научных трактатов.

Требованиям к контенту хорошо соответствует «информстиль» Максима Ильяхова, создателя сервиса «Главред». Инструмент превосходно подходит для чистки текстов от грязи, но к ряду его рекомендаций следует отнестись со здоровой долей критики. Об одном и том же стоит писать по-разному. Google уже много лет различает синонимы. Поэтому, по мнению Брайна Питмана, ими следует максимально насыщать тексты сайта.

Кстати, советуем почитать интересный кейс по увеличению трафика на 947% благодаря использованию SEO-техники синонимизации.

6. Больше видео и фото

Более 55% выдачи Google сегодня включает видео и 40% — фото. Наполняйте сайт разнообразным контентом. При этом не забывайте прописывать alt и title с релевантными ключевыми словами.

7. Сделайте сайт легче

От Google Panda страдали в первую очередь большие сайты, с количеством страниц от 10 до 100 тысяч. Сложность нахождения информации — еще один сигнал, привлекающий Panda. Если количество страниц вашего ресурса измеряется тысячами, Энн Смарти советует сделать сайт легче:

- Блокировать cтраницы с помощью Robots.txt.

- Деиндексировать страницы с метатегом noindex.

- Удалять и комбинировать некоторые страницы.

- Использовать теги canonical, чтобы показать Google, какие страницы должны индексироваться.

- Перенести некоторые страницы на поддомены.

Совет от Джима Бойкина из InternetMarketingNinjas:

Простое правило: если вы потеряли в результате апдейта Google Panda 80% трафика, вы должны сделать свой сайт на 80% проще и легче.

8. Оптимизируйте внутреннюю перелинковку

Обратите внимание, открываются ли страницы по всем внутренним ссылкам на сайте. Для комплексной проверки можно использовать Netpeak Spider. Другие этапы работ по внутренней перелинковке:

- Расширьте основное меню. Если количество внутренних ссылок на главной — больше 150, этого вполне достаточно.

- Добавьте дополнительную навигацию — по интересным статьям, топ-спискам и так далее. В основном, этот совет актуален для интернет-магазинов.

- Оставьте минимальное количество сквозняков. Речь о повторяющихся ссылках, например, бокового меню, которое человек видит после перехода с главной страницы сайта.

9. Распространяйте контент с умом

Google Panda тщательно отслеживает, как пользователи взаимодействуют со страницей. Важно не только создать качественный контент, но и «продать» его читателям. Оптимальное соотношение времени для создания контента ко времени для его распространения: 1:7.

Энн Смарти в интервью нам призналась, что в неделю тратит только 2 часа на создание контента для своего сайта и в семь раз больше — 14 часов — на распространение постов, создание альтернативных форматов и поддержку бренда.

Будьте бдительны: далеко не каждый репост от авторитетного сайта означает повышение трафика на ваш сайт. В прошлом году стихийное распроcтранение постов сыграло злую шутку с блогом KISSmetrics. Почти каждый свой хороший пост они дублировали в Entrepreneur.com и Search Engine Journal. Как итог — заметили ежемесячный прирост — 9,4 тысяч пользователей. Но после апдейта Google Panda сайт потерял 225 418 пользователей в месяц из поиска: Дело в том, что алгоритм никак не мог определить, что первоисточником текстов был именно блог. Ни один тег в ссылках на других сайтах, где полностью или частично репостились тексты, не указывал на это. Команда KISSmetrics смогла решить вопрос с помощью трех простых шагов: 1. Переписали посты для других сайтов и предложили им поменять тексты. 2. Просили владельцев сайтов добавить в ссылки текста rel=”canonical” (напомню, этот тег передает весь вес странице по ссылке). Стоит прописать простановку canonical в обязательных условиях репоста: 3. Начали предлагать уникальные посты для размещения на сайтах инфлюенсеров. После очередного апдейта Google Panda позиции восстановились, но, по словам создателя KISSmetrics Нейла Патела, блог не смог вернуться к тем же темпам прироста трафика.

10. Не пытайтесь «прогнать» Панду

После начала апдейта (18 июля) поздно менять что-либо, чтобы избежать влияния Google Panda 4.2. Алгоритм не будет учитывать изменения на сайте после этой даты. В интервью Барри Шварцу представители Google подтвердили, что тем, кто попадет под фильтр алгоритма, остается внедрять доработки и ждать 10 месяцев, пока апдейт завершится, и еще около года до запуска нового обновления.

Надеюсь, Panda и Penguin в последний раз становятся инфоповодами. Тем более, что не так уж сильно отличается Google Panda 2015 года от алгоритма четырехлетней давности. Сигналы, которые учитывает алгоритм, давно стали частью общей формулы ранжирования, а рекомендации «как не разозлить Панду» — обязательными правилами создания и продвижения сайтов.

Интересный факт: в сети нет ни одного фото Navneet Panda — исследователя Google, в честь которого поисковик назвал свой алгоритм.

netpeak.net

Google Panda — алгоритм Google

«Гугл Панда» – это поисковый алгоритм, который внедрила компания Google 24 февраля 2011 года, чтобы фильтровать сайты в поисковой выдаче. Он разработан для сортировки сайтов и удаления из выдачи низкокачественных страниц, которые наполнены неуникальными текстами, имеющими множество стилистических и орфографических ошибок, недостоверной и дублирующейся информации. Благодаря этому фильтру пользователь находит сайты, наиболее точно отвечающие его запросам, и не тратит время на просмотр ресурсов, которые созданы для агрессивного SEO-продвижения.

Как разрабатывался фильтр

Разработка Google Panda, как и многих других алгоритмов, проводилась в атмосфере закрытости. Рядовые пользователи и веб-мастеры не знали никаких подробностей. На сегодняшний день известно лишь о двух разработчиках – Амите Сингале и Мэтте Катсе. Все остальные детали остаются в секрете в соответствии с официальной политикой компании Google. Первыми алгоритм увидели пользователи из США. Согласно отчетам SEO-специалистов такое нововведение существенно сократило трафик из поисковой системы Google: для крупных сайтов снижение составило 12 %, а для небольших ресурсов – почти 50 %. Около 10 % сайтов со средней и маленькой посещаемостью были забанены в поисковике после попадания под фильтр. После проведенного тестирования алгоритм стал работать и в других странах. В России владельцы сайтов и пользователи столкнулись с ним 24 апреля 2012 года. Результаты были похожими: некоторые ресурсы упали в поисковой выдаче примерно на 50 позиций.

Вывести ресурс из-под блокировки до 2016 года можно было лишь после выхода очередного апдейта. С момента запуска фильтра они выходили примерно раз в 2 месяца. В сумме с момента появления их было около 30. В январе 2016 года Google Panda внедрили в алгоритм ранжирования (Core Ranking Algorithm). Веб-мастеры получили выгоду от этого нововведения, т. к. блокировка и вывод сайта происходят очень быстро, дожидаться нового обновления стало не нужно.

Что учитывает алгоритм

Алгоритмы фильтрации разрабатываются с целью улучшения качества SERP для пользователя. Сайты, имеющие некачественный контент, попадают в топ-10 значительно реже. Главный критерий – полезность и достоверность информации на странице сайта. Если ресурс полезен, то у него значительно больше шансов оказаться в топе по определенным запросам.

На сегодняшний день достоверно выявлен ряд аспектов, на которые Google «Панда» реагирует в первую очередь:

- качество ссылок. Ссылки не должны вести на малопосещаемые или блокированные сайты;

- качество контента. На сайте должны быть структурированные, уникальные тексты с минимальным количеством стилистических и орфографических ошибок;

- ПФ (поведенческий фактор). Один из самых важных факторов. «Гугл» учитывает время, которое пользователь провел на сайте, количество переходов, цитирование и пр.

Как вывести ресурс из-под фильтра

Ограничения, которые накладывает фильтр «Панда», заставляют веб-мастеров более внимательно относиться к наполнению ресурса.

Для этого следует:

- публиковать уникальный контент – изображения, тексты и видео;

- сокращать ссылочную массу;

- заниматься обновлением контента;

- удалять рекламу, нерелевантное содержимое, ссылки;

- оптимизировать структуру и интерфейс ресурса для удобства пользователя;

- улучшать ПФ.

Ресурсы, которые размещают ссылки на источники заимствованного контента, могут не волноваться по поводу попадания под фильтр. Представители компании Google не раскрывают информацию о точном проценте критической массы ссылок, но веб-мастеры должны работать над разработкой уникального контента. По ряду субъективных оценок, точность фильтрации – около 90–95 %. Из-за этого можно встретить ресурсы, которые были необоснованно понижены в выдаче. В таком случае нужно проконсультироваться с представителями техподдержки и принять при необходимости соответствующие меры.

www.seonews.ru