О сетях хранения данных / Хабр

Решил написать небольшую статейку о сетях хранения данных (СХД), тема эта достаточно интересная, но на Хабре почему-то не раскрыта. Постараюсь поделиться личным опытом по построению и поддержке SAN.

Что это?

Сеть хранения данных, или Storage Area Network — это система, состоящая из собственно устройств хранения данных — дисковых, или RAID — массивов, ленточных библиотек и прочего, среды передачи данных и подключенных к ней серверов. Обычно используется достаточно крупными компаниями, имеющими развитую IT инфраструктуру, для надежного хранения данных и скоростного доступа к ним.

Упрощенно, СХД — это система, позволяющая раздавать серверам надежные быстрые диски изменяемой емкости с разных устройств хранения данных.

Немного теории.

Сервер к хранилищу данных можно подключить несколькими способами.

Первый и самый простой — DAS, Direct Attached Storage (прямое подключение), без затей ставим диски в сервер, или массив в адаптер сервера — и получаем много гигабайт дискового пространства со сравнительно быстрым доступом, и при использовании RAID-массива — достаточную надежность, хотя копья на тему надежности ломают уже давно.

Однако такое использование дискового пространства не оптимально — на одном сервере место кончается, на другом его еще много. Решение этой проблемы — NAS, Network Attached Storage (хранилище, подключенное по сети). Однако при всех преимуществах этого решения — гибкости и централизованного управления — есть один существенный недостаток — скорость доступа, еще не во всех организациях внедрена сеть 10 гигабит. И мы подходим к сети хранения данных.

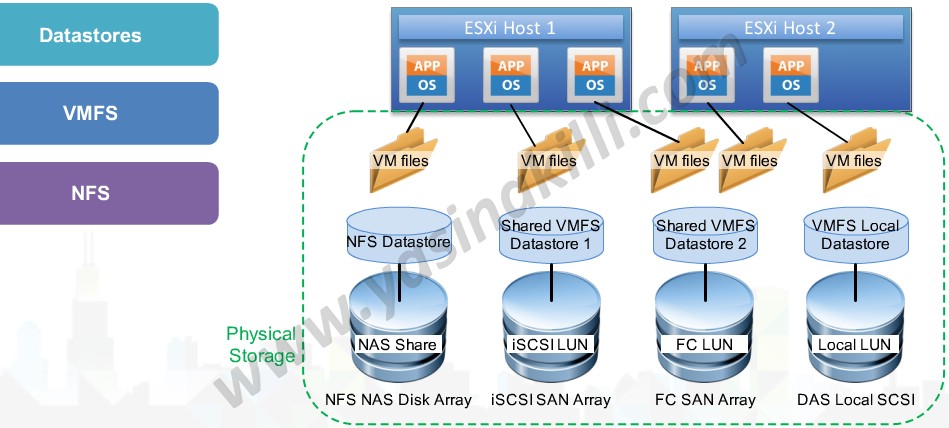

Главное отличие SAN от NAS (помимо порядка букв в аббревиатурах) — это то, каким образом видятся подключаемые ресурсы на сервере. Если в NAS ресурсы подключаются протоколам NFS или SMB, в SAN мы получаем подключение к диску, с которым можем работать на уровне операций блочного ввода-вывода, что гораздо быстрее сетевого подключения (плюс контроллер массива с большим кэшем добавляет скорости на многих операциях).

Используя SAN, мы сочетаем преимущества DAS — скорость и простоту, и NAS — гибкость и управляемость. Плюс получаем возможность масштабирования систем хранения до тех пор, пока хватает денег, параллельно убивая одним выстрелом еще несколько зайцев, которых сразу не видно:

* снимаем ограничения на дальность подключения SCSI-устройств, которые обычно ограничены проводом в 12 метров,

* уменьшаем время резервного копирования,

* можем грузиться с SAN,

* в случае отказа от NAS разгружаем сеть,

* получаем большую скорость ввода-вывода за счет оптимизации на стороне системы хранения,

* получаем возможность подключать несколько серверов к одному ресурсу, то нам дает следующих двух зайцев:

o на полную используем возможности VMWare — например VMotion (миграцию виртуальной машины между физическими) и иже с ними,

Что это дает?

Помимо освоения бюджета оптимизации системы хранения данных, мы получаем, вдобавок к тому что я написал выше:

* увеличение производительности, балансировку нагрузки и высокую доступность систем хранения за счет нескольких путей доступа к массивам;

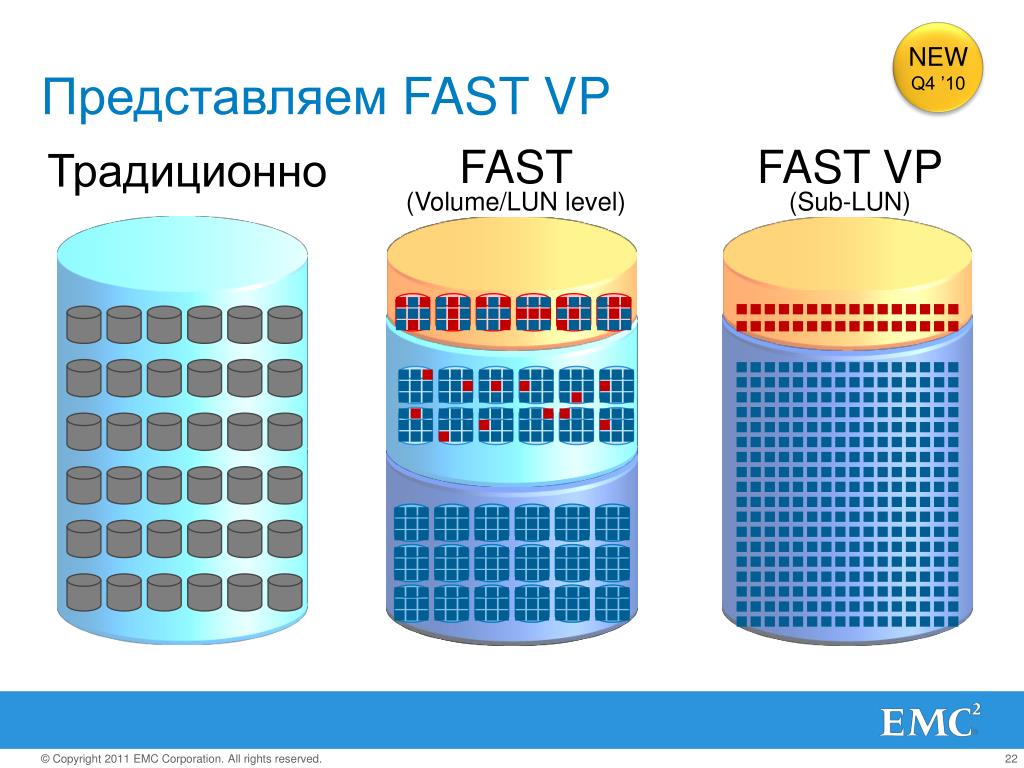

* экономию на дисках за счет оптимизации расположения информации;

* ускоренное восстановление после сбоев — можно создать временные ресурсы, развернуть на них backup и подключить к ним сервера, а самим без спешки восстанавливать информацию, или перекинуть ресурсы на другие сервера и спокойно разбираться с умершим железом;

* уменьшение время резервного копирования — благодаря высокой скорости передачи можно бэкапиться на ленточную библиотеку быстрее, или вообще сделать snapshot (мгновенный снимок) с файловой системы и спокойно архивировать его;

* уменьшаем стоимость хранения мегабайта информации — естественно, есть определенный порог, с которого эти системы рентабельны.

* надежное место для хранения mission critical и business critical данных (без которых организация не может существовать и нормально работать).

* отдельно хочу упомянуть VMWare — полностью все фишки вроде миграции виртуальных машин с сервера на сервер и прочих вкусностей доступны только на SAN.

Из чего это состоит?

Как я писал выше — СХД состоит из устройств хранения, среды передачи и подключенных серверов. Рассмотрим по порядку:

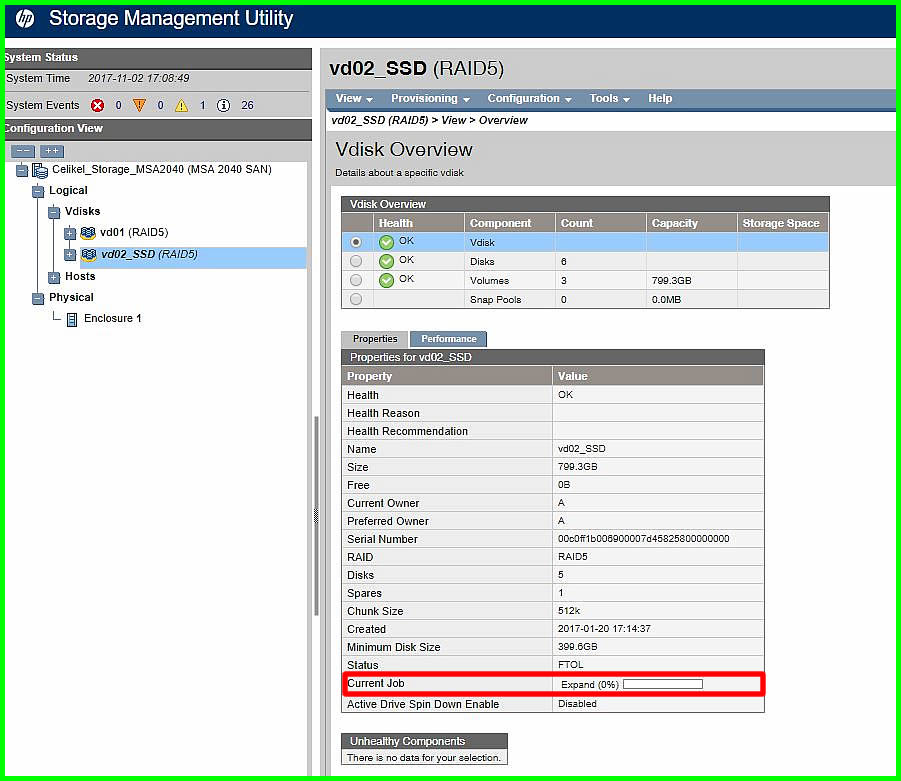

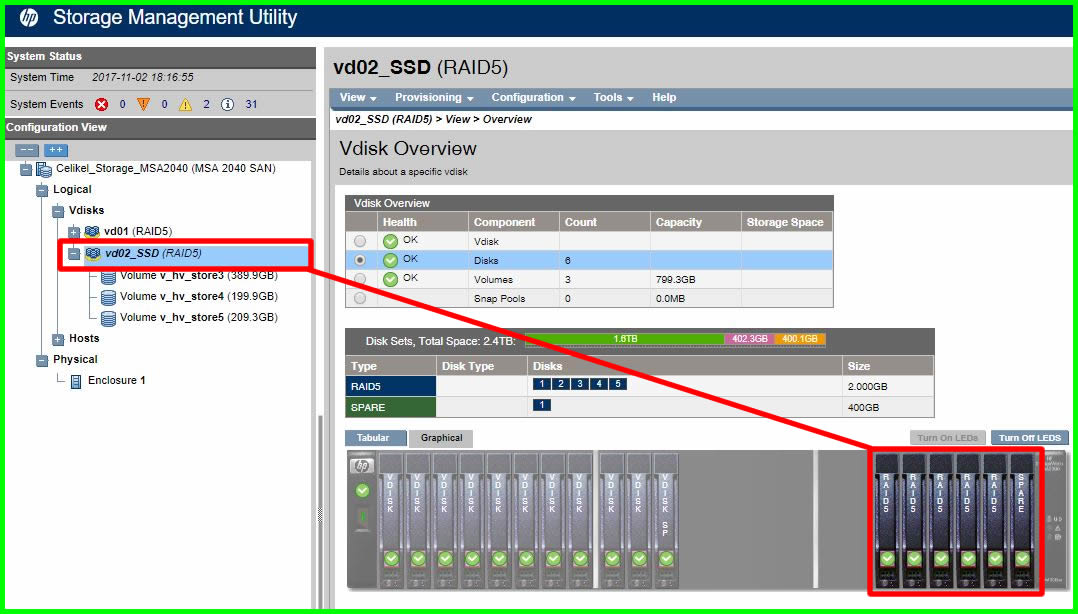

Системы хранения данных обычно состоят из жестких дисков и контроллеров, в уважающей себя системе как правило всего по 2 — по 2 контроллера, по 2 пути к каждому диску, по 2 интерфейса, по 2 блока питания,  Вот пусть она их и делает!» Подозреваю, что в HP тоже очень любят EMC. Конкуренция между производителями нешуточная, впрочем, как и везде. Последствия конкуренции — иногда вменяемые цены за мегабайт системы хранения и проблемы с совместимостью и поддержкой стандартов конкурентов, особенно у старого оборудования.

Вот пусть она их и делает!» Подозреваю, что в HP тоже очень любят EMC. Конкуренция между производителями нешуточная, впрочем, как и везде. Последствия конкуренции — иногда вменяемые цены за мегабайт системы хранения и проблемы с совместимостью и поддержкой стандартов конкурентов, особенно у старого оборудования.

Среда передачи данных. Обычно SAN строят на оптике, это дает на текущий момент скорость в 4, местами в 8 гигабит на канал. При построении раньше использовались специализированные хабы, сейчас больше свитчи, в основном от Qlogic, Brocade, McData и Cisco (последние два на площадках не видел ни разу). Кабели используются традиционные для оптических сетей — одномодовые и многомодовые, одномодовые более дальнобойные.

Есть еще умное слово топология, которое встречается во всех учебниках по SAN. Топологий несколько, простейший вариант — точка-точка (point to point), соединяем между собой 2 системы. Это не DAS, а сферический конь в вакууме простейший вариант SAN. Дальше идет управляемая петля (FC-AL), она работает по принципу «передай дальше» — передатчик каждого устройства соединен с приемником последующего, устройства замкнуты в кольцо. Длинные цепочки имеют свойство долго инициализироваться.

Ну и заключительный вариант — коммутируемая структура (Fabric), она создается с помощью свитчей. Структура подключений строится в зависимости от количества подключаемых портов, как и при построении локальной сети. Основной принцип построения — все пути и связи дублируются. Это значит, что до каждого устройства в сети есть минимум 2 разных пути. Здесь тоже употребимо слово топология, в смысле организации схемы подключений устройств и соединения свитчей. При этом как правило свитчи настраиваются так, что сервера не видят ничего, кроме предназначенных им ресурсов. Это достигается за счет создания виртуальных сетей и называется зонированием, ближайшая аналогия — VLAN. Каждому устройству в сети присваивается аналог MAC-адреса в сети Ethernet, он называется WWN — World Wide Name. Он присваивается каждому интерфейсу и каждому ресурсу (LUN) систем хранения данных. Массивы и свитчи умеют разграничивать доступ по WWN для серверов.

Это достигается за счет создания виртуальных сетей и называется зонированием, ближайшая аналогия — VLAN. Каждому устройству в сети присваивается аналог MAC-адреса в сети Ethernet, он называется WWN — World Wide Name. Он присваивается каждому интерфейсу и каждому ресурсу (LUN) систем хранения данных. Массивы и свитчи умеют разграничивать доступ по WWN для серверов.

Сервера подключают к СХД через HBA — Host Bus Adapter-ы. По аналогии с сетевыми картами существуют одно-, двух-, четырехпортовые адаптеры. Лучшие собаководы рекомендуют ставить по 2 адаптера на сервер, это позволяет как осуществлять балансировку нагрузки, так и обеспечивает надежность.

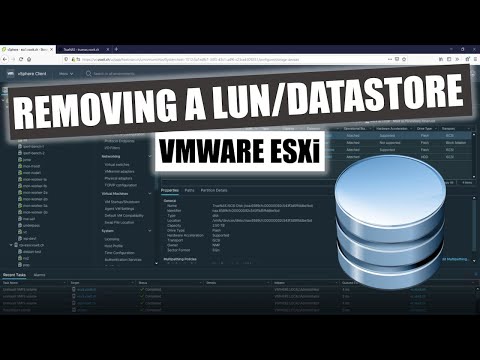

А дальше на системах хранения нарезаются ресурсы, они же диски (LUN) для каждого сервера и оставляется место в запас, все включается, установщики системы прописывают топологию, ловят глюки в настройке свитчей и доступа, все запускается и все живут долго и счастливо*.

Я специально не касаюсь разных типов портов в оптической сети, кому надо — тот и так знает или прочитает, кому не надо — только голову забивать.

Из опыта.

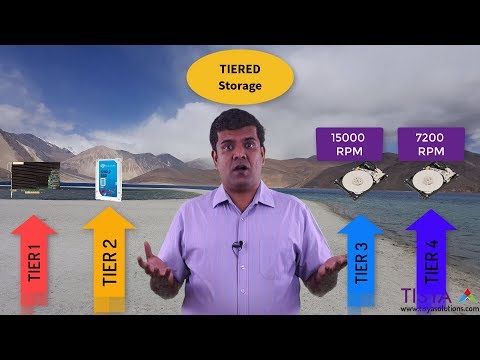

Обычно при создании SAN заказывают массивы с несколькими типами дисков: FC для скоростных приложений, и SATA или SAS для не очень быстрых. Таким образом получаются 2 дисковые группы с различной стоимостью мегабайта — дорогая и быстрая, и медленная и печальная дешевая. На быструю вешаются обычно все базы данных и прочие приложения с активным и быстрым вводом-выводом, на медленную — файловые ресурсы и все остальное.

Если SAN создается с нуля — имеет смысл строить ее на основе решений от одного производителя. Дело в том, что, несмотря на заявленное соответствие стандартам, существуют подводные грабли проблемы совместимости оборудования, и не факт, что часть оборудования будет работать друг с другом без плясок с бубном и консультаций с производителями. Обычно для утряски таких проблем проще позвать интегратора и дать ему денег, чем общаться с переводящими друг на друга стрелки производителями.

Если SAN создается на базе существующей инфраструктуры — все может быть сложно, особенно если есть старые SCSI массивы и зоопарк старой техники от разных производителей. В этом случае имеет смысл звать на помощь страшного зверя интегратора, который будет распутывать проблемы совместимости и наживать третью виллу на Канарах.

Часто при создании СХД фирмы не заказывают поддержку системы производителем. Обычно это оправдано, если у фирмы есть штат грамотных компетентных админов (которые уже 100 раз назвали меня чайником) и изрядный капитал, позволяющий закупить запасные комплектующие в потребных количествах. Однако компетентных админов обычно переманивают интеграторы (сам видел), а денег на закупку не выделяют, и после сбоев начинается цирк с криками «Всех уволю!» вместо звонка в саппорт и приезда инженера с запасной деталью.

Поддержка обычно сводится к замене умерших дисков и контроллеров, ну и к добавлению в систему полок с дисками и новых серверов. Много хлопот бывает после внезапной профилактики системы силами местных специалистов, особенно после полного останова и разборки-сборки системы (и такое бывает).

Про VMWare. Насколько я знаю (спецы по виртуализации поправьте меня), только у VMWare и Hyper-V есть функционал, позволяющий «на лету» перекидывать виртуальные машины между физическими серверами. И для его реализации требуется, чтобы все сервера, между которыми перемещается виртуальная машина, были подсоединены к одному диску.

Про кластеры. Аналогично случаю с VMWare, известные мне системы построения отказоустойчивых кластеров (Sun Cluster, Veritas Cluster Server) — требуют подключенного ко всем системам хранилища.

Пока писал статью — у меня спросили — в какие RAIDы обычно объединяют диски?

В моей практике обычно делали или по RAID 1+0 на каждую дисковую полку с FC дисками, оставляя 1 запасной диск (Hot Spare) и нарезали из этого куска LUN-ы под задачи, или делали RAID5 из медленных дисков, опять же оставляя 1 диск на замену. Но тут вопрос сложный, и обычно способ организации дисков в массиве выбирается под каждую ситуацию и обосновывается. Та же EMC например идет еще дальше, и у них есть дополнительная настройка массива под приложения, работающие с ним (например под OLTP, OLAP). С остальными вендорами я так глубоко не копал, но догадываюсь, что тонкая настройка есть у каждого.

С остальными вендорами я так глубоко не копал, но догадываюсь, что тонкая настройка есть у каждого.

* до первого серьезного сбоя, после него обычно покупается поддержка у производителя или поставщика системы.

Поскольку в песочнице комментариев нет, закину в личный блог.

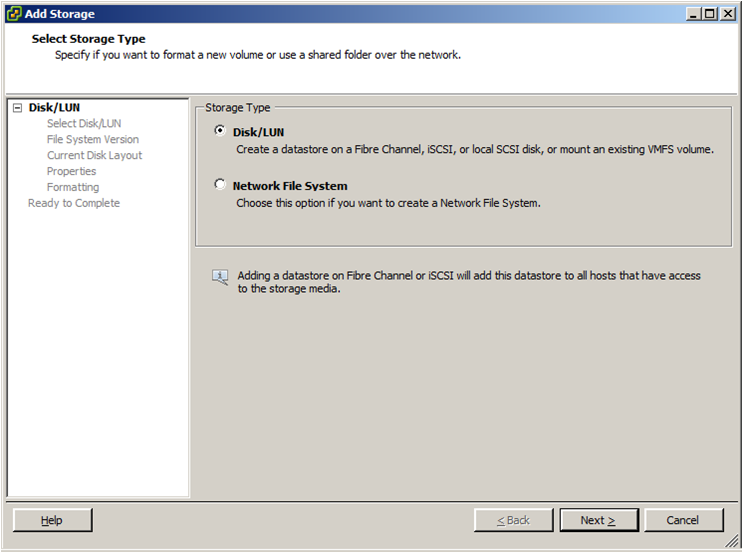

Настройка iSCSI-хранилища

Виртуальный диск виртуальной машины представляет собой образ жёсткого диска. Виртуальные диски хранятся на локальном или сетевом устройстве — хранилище. Хранилище iSCSI — сетевое хранилище, использующее протокол сетевого доступа к файловым системам — iSCSI. В статье описан алгоритм настройки iSCSI-хранилища. Подробнее о сетевых хранилищах см. в статье Сетевые хранилища.

Подготовка сервера iSCSI

Работа с iSCSI в качестве хранилища имеет следующие особенности:

- VMmanager управляет сервером-хранилищем по SSH;

- VMmanager работает с open-iscsi: должны быть установлены все необходимые пакеты и запущен сервис tgtd. Сервис tgtd также должен быть настроен на автоматический запуск после перезагрузки сервера.

Установите open-iscsi и настройте tgtd на автозапуск:

yum install epel-release yum install scsi-target-utils service tgtd start chkconfig tgtd on

BASH

При необходимости добавьте правила iptables:

iptables -I INPUT 1 -p tcp --dport 3260 -j ACCEPT service iptables save

BASH

Если доступ к узлам кластера осуществляется по внутренним сетевым интерфейсам, то iSCSI-сервер также должен быть доступен по внутренним интерфейсам. Это нужно для того, чтобы open-iscsi правильно добавлял разрешения для узлов кластера.

После настройки сервера хранилища можно создавать хранилище с типом iSCSI. Подробнее о создании хранилищ см. в статье Подключение хранилища.

Принципы работы

Создание хранилища

При создании iSCSI-хранилища в VMmanager:

- на сервере с iSCSI создаётся таргет с именем iqn.YYYY-MM.<hostname-reverse>.<хранилище>_ID, где ID — уникальный номер;

- в libvirt создаётся пул с именем <хранилище>_ID.

Libvirt импортирует таргет и все LUN этого таргета.

Libvirt импортирует таргет и все LUN этого таргета.

Таким образом, хранилище представляет собой набор пулов с разными ID.

Например, создаём iSCSI-хранилище с именем NetStorage:

- будет создан пул libvirt в c именем NetStorage_001;

- на сервере iSCSI будет создан таргет c именем iqn.2013-04.org.our-dc.stor1.NetStorage_001;

- таргет будет добавлен в файл /etc/tgt/vmmgr/<имя таргета>.conf для того, чтобы таргеты сохранялись при перезагрузке хранилища. Для каждого таргета создаётся отдельный файл конфигурации в директории /etc/tgt/vmmgr/.

Такая схема создана для того, чтобы VMmanager мог создавать больше 150 виртуальных дисков на одном хранилище. Когда в таргете id последнего луна равен 150, будет создан новый таргет NetStorage_002 и т.д.

Создание виртуального диска

В iSCSI-хранилище диски создаются в виде файлов в директории, заданной параметром iSCSITargetDir в файле конфигурации VMmanager (по умолчанию — /iscsivolumes).

Таким образом, при добавлении нового виртуального диска будут произведены действия:

- на iSCSI-сервере создаётся файл в директории /iscsivolumes. Имя файла соответствует имени виртуального диска;

- VMmanager выясняет ID таргета, в котором будет создан LUN. Если в таргете больше 150 LUN, будет создан новый таргет iqn.YYYY-MM.<hostname-reverse>.<хранилище>_ID, в котором ID больше на единицу;

- на узлах кластера будет добавлен новый libvirt pool с именем <хранилище>_ID;

- в этом таргете будет создан LUN, добавлен в файл /etc/tgt/vmmgrtargets.conf, его номер будет сохранен в базе данных;

- на всех узлах кластера будет запущен процесс обновления информации о пулах libvirt (команда virsh pool-refresh <хранилище>_ID).

После этого виртуальный диск становится доступным на всех узлах кластера. В libvirt его можно найти в pool с именем <хранилище>_ID под именем unit:0:0:LUN_ID. —-

—-

404: Страница не найдена

Страница, которую вы пытались открыть по этому адресу, похоже, не существует. Обычно это результат плохой или устаревшей ссылки. Мы извиняемся за любые неудобства.

Что я могу сделать сейчас?

Если вы впервые посещаете TechTarget, добро пожаловать! Извините за обстоятельства, при которых мы встречаемся. Вот куда вы можете пойти отсюда:

Поиск- Узнайте последние новости.

- Наша домашняя страница содержит последнюю информацию об информационных технологиях.

- Наша страница «О нас» содержит дополнительную информацию о сайте ComputerWeekly.com, на котором вы находитесь.

- Если вам нужно, свяжитесь с нами, мы будем рады услышать от вас.

Просмотр по категории

ИТ-директор

- 10 самых перспективных инструментов для разработки Web 3.0

Web 3.0 еще не существует, но есть много инструментов для разработки приложений для Интернета следующего поколения и преодоления разрыва с .

..

.. - Стратегия машинного обучения Capital One использует MLOps

Компания, предоставляющая финансовые услуги, использует ML для нескольких вариантов использования и стремится развернуть технологию в масштабе с помощью стандартизированных…

- Калифорнийский законопроект о климате потребует данных о выбросах углерода в бизнесе

Закон об ответственности корпоративных данных о климате, принятый в Калифорнии, требует, чтобы предприятия сообщали об их объеме 1, 2 и 3 …

Безопасность

- 4 прогноза личности на 2023 год

Место идентификации в цепочке атак приводит к смещению ответственности за идентификацию с ИТ-операций на безопасность, чтобы изучить …

- Понимание важности шифрования данных

Шифрование является основополагающим элементом кибербезопасности. Организации должны внедрить шифрование, чтобы противостоять постоянно растущему .

..

.. - Рост активности угроз вокруг уязвимости Fortinet VPN

После публичного раскрытия критической уязвимости VPN в декабре многочисленные отчеты показывают, что злоумышленники используют ее, чтобы…

Сеть

- Особенности мультиоблачной сетевой архитектуры

Предприятиям нужны функции многооблачных сетей, которые включают программируемость, интеграцию безопасности и сквозную …

- Отраслевой взгляд на новые стандарты нулевого доверия MEF SASE

MEF недавно выпустил новые стандарты нулевого доверия и SASE. Стандартизация может помочь в обеспечении совместимости, но так ли она необходима…

- Сравните 6 основных сетевых сертификатов на 2023 год

Сетевые сертификаты

могут охватывать основы работы в сети и знания по конкретным продуктам. Оцените шесть сертификатов и взвесьте…

Центр обработки данных

- AMD поднимает оптимизм в отношении рынка чипов благодаря оптимистичным доходам

Компания AMD сообщила о росте выручки в четвертом квартале, а также об ожиданиях столь необходимого всплеска спроса на ПК во втором .

..

.. - Доход Intel снова падает; компания ускорит чипы следующего поколения

Из-за застоя продаж ПК и сокращения расходов на ИТ Intel снова сообщила о снижении доходов. Генеральный директор Пэт Гелсингер подчеркнул …

- Используйте ISO 50001:2018 в качестве руководства для экологически чистых центров обработки данных.

Центры обработки данных потребляют много энергии, и бывает сложно определить, как сократить энергопотребление. ISO 50001:2018 содержит руководство …

Управление данными

- ESG прогнозирует 2023 смены для DataOps, управления данными

Организации будут использовать облачные технологии и DataOps для доступа к анализу данных в реальном времени и принятию решений в 2023 году, согласно …

- Озеро данных и хранилище данных: объяснение основных различий

Озера данных и хранилища данных широко используются на предприятиях.

Вот основные различия между ними, чтобы помочь вам …

Вот основные различия между ними, чтобы помочь вам … - Тенденции в области управления данными: конвергенция и больше денег

В прошлом году основное внимание уделялось анализу данных, разработке «лазерных домиков» и наблюдаемости, поскольку поставщики внедряли инновации, чтобы помочь …

Что такое номер логического устройства (LUN) и как он работает?

- Миниинструмент

- Вики-библиотека MiniTool

- Что такое номер логического устройства (LUN) и как он работает?

Что такое логический номер устройства?

Что такое LUN? Это сокращение от логического номера устройства. В компьютерной памяти это число, используемое для идентификации логической единицы. Логическая единица — это устройство, адресованное протоколом SCSI или протоколами сети хранения данных (такими как Fibre Channel или iSCSI), которые инкапсулируют iSCSI.

LUN можно использовать с любым устройством, поддерживающим операции чтения/записи, например с ленточными накопителями, но чаще всего он используется для обозначения логических дисков, созданных в SAN. Хотя это технически неверно, термин «LUN» также часто используется для обозначения самого логического диска. Продолжайте читать, и MiniTool расскажет вам, как работает LUN.

Хотя это технически неверно, термин «LUN» также часто используется для обозначения самого логического диска. Продолжайте читать, и MiniTool расскажет вам, как работает LUN.

Как работает LUN?

Настройка LUN зависит от системы. Когда хост просканирует устройство SCSI и найдет логическое устройство, он присвоит ему номер логического устройства. Когда LUN объединяется с такой информацией, как идентификатор целевого порта, он идентифицирует конкретное логическое устройство для инициатора SCSI.

В одной или нескольких системах хранения логическая единица может быть частью устройства хранения и всего устройства хранения данных или может быть всеми частями нескольких устройств хранения данных, таких как жесткий диск и твердотельный накопитель.

LUN может ссылаться на весь набор RAID, один диск или раздел или несколько дисков или разделов хранилища. В любом случае логическое устройство рассматривается как единое устройство и идентифицируется по номеру логического устройства. Ограничения емкости LUN зависят от системы.

Ограничения емкости LUN зависят от системы.

LUN является ядром управления массивом блочных хранилищ в сети хранения данных. Использование LUN может упростить управление ресурсами хранения, поскольку логические идентификаторы могут использоваться для назначения прав доступа и управления.

Типы LUN

Базовая структура хранения и типы логических единиц играют роль в производительности и надежности. Вот некоторые типы LUN, перечисленные ниже:

Зеркальный LUN — это отказоустойчивый LUN с одинаковыми копиями на двух физических дисках для резервирования данных и резервного копирования.

Объединенный LUN объединяет несколько LUN в логическую единицу или том.

Чередующийся LUN записывает данные на несколько физических дисков и потенциально повышает производительность за счет распределения запросов ввода-вывода между дисками.

Чередующийся LUN с контролем четности распределяет данные и информацию о четности по трем или более физическим дискам. Если физический диск выйдет из строя, вы сможете восстановить данные из информации на остальных дисках. Расчеты четности могут повлиять на производительность записи.

Если физический диск выйдет из строя, вы сможете восстановить данные из информации на остальных дисках. Расчеты четности могут повлиять на производительность записи.

Использование LUN

Основным вариантом использования LUN является идентификатор для указания устройств хранения. Однако использование каждого типа LUN может различаться. Например, простой LUN используется в качестве обозначения части или всего физического диска. Составной LUN — это обозначение, которое представляет LUN, который охватывает два или более физических диска.

Зеркальный LUN используется для указания скопировать данные, хранящиеся на одном диске, на второй диск — в случае сбоя одного диска используется зеркальный LUN.

LUN можно использовать для зонирования и маскирования в SAN, или их можно виртуализировать для сопоставления нескольких физических LUN.

Зонирование и маскирование LUN

Зонирование LUN обеспечивает изолированные пути ввода-вывода через структуру FC SAN между конечными портами для обеспечения детерминированного поведения. Хост ограничен зоной, в которой размещен хост. Зонирование LUN обычно задается на уровне коммутатора. Это может помочь повысить безопасность и устранить горячие точки в сети.

Хост ограничен зоной, в которой размещен хост. Зонирование LUN обычно задается на уровне коммутатора. Это может помочь повысить безопасность и устранить горячие точки в сети.

Маскировка LUN ограничивает доступ хоста к указанным целям SCSI и их LUN. Маскирование LUN обычно выполняется на контроллере системы хранения, но также может быть реализовано на адаптере главной шины (HBA) или на уровне коммутатора. При маскировании LUN несколько хостов и зон могут использовать один и тот же порт на устройстве хранения. Однако они могут видеть только определенные цели SCSI и выделенные LUN.

LUN и виртуализация

В некотором смысле LUN представляет собой форму виртуализации, то есть он использует стандартный метод идентификации и связи SCSI для абстрагирования стоящих за ним аппаратных устройств. Объект хранения, представленный LUN, может быть установлен, сжат или дедуплицирован, пока представление хоста остается неизменным. Вы можете мигрировать, копировать, реплицировать, создавать моментальные снимки и распределять LUN внутри и между устройствами хранения.

Libvirt импортирует таргет и все LUN этого таргета.

Libvirt импортирует таргет и все LUN этого таргета. ..

.. ..

.. ..

.. Вот основные различия между ними, чтобы помочь вам …

Вот основные различия между ними, чтобы помочь вам …