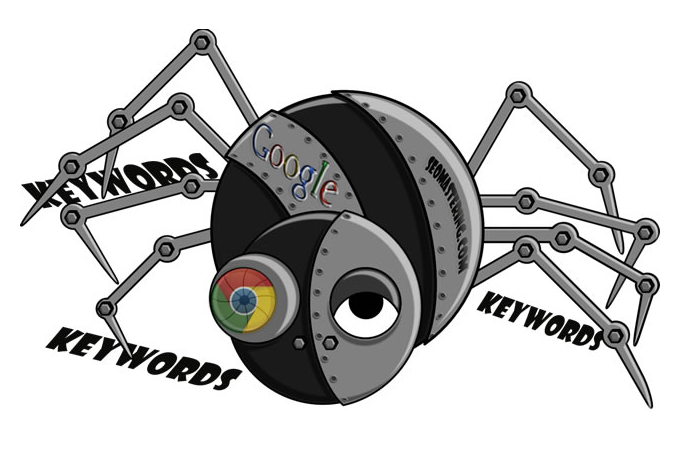

Какую работу выполняют роботы пауки поисковых машин. Что такое роботы поисковики Яндекса и Google простыми словами. Алгоритмы индексации поисковиков

Поисковым роботом называется специальная программа какой-либо поисковой системы, которая предназначена для занесения в базу (индексирования) найденных в Интернете сайтов и их страниц. Также используются названия: краулер, паук, бот, automaticindexer, ant, webcrawler, bot, webscutter, webrobots, webspider.

Принцип работы

Поисковый робот — это программа браузерного типа. Он постоянно сканирует сеть: посещает проиндексированные (уже известные ему) сайты, переходит по ссылкам с них и находит новые ресурсы. При обнаружении нового ресурса робот процедур добавляет его в индекс поисковика. Поисковый робот также индексирует обновления на сайтах, периодичность которых фиксируется. Например, обновляемый раз в неделю сайт будет посещаться пауком с этой частотой, а контент на новостных сайтах может попасть в индекс уже через несколько минут после публикации. Если на сайт не ведет ни одна ссылка с других ресурсов, то для привлечения поисковых роботов ресурс необходимо добавить через специальную форму (Центр вебмастеров Google, панель вебмастера Яндекс и т.д.).

Если на сайт не ведет ни одна ссылка с других ресурсов, то для привлечения поисковых роботов ресурс необходимо добавить через специальную форму (Центр вебмастеров Google, панель вебмастера Яндекс и т.д.).

Виды поисковых роботов

Пауки Яндекса :

- Yandex/1.01.001 I — основной бот, занимающийся индексацией,

- Yandex/1.01.001 (P) — индексирует картинки,

- Yandex/1.01.001 (H) — находит зеркала сайтов,

- Yandex/1.03.003 (D) — определяет, соответствует ли страница, добавленная из панели вебмастера, параметрам индексации,

- YaDirectBot/1.0 (I) — индексирует ресурсы из рекламной сети Яндекса,

- Yandex/1.02.000 (F) — индексирует фавиконы сайтов.

Пауки Google:

- Робот Googlebot — основной робот,

- Googlebot News — сканирует и индексирует новости,

- Google Mobile — индексирует сайты для мобильных устройств,

- Googlebot Images — ищет и индексирует изображения,

- Googlebot Video — индексирует видео,

- Google AdsBot — проверяет качество целевой страницы,

- Google Mobile AdSense и Google AdSense — индексирует сайты рекламной сети Google.

Другие поисковики также используют роботов нескольких видов, функционально схожих с перечисленными.

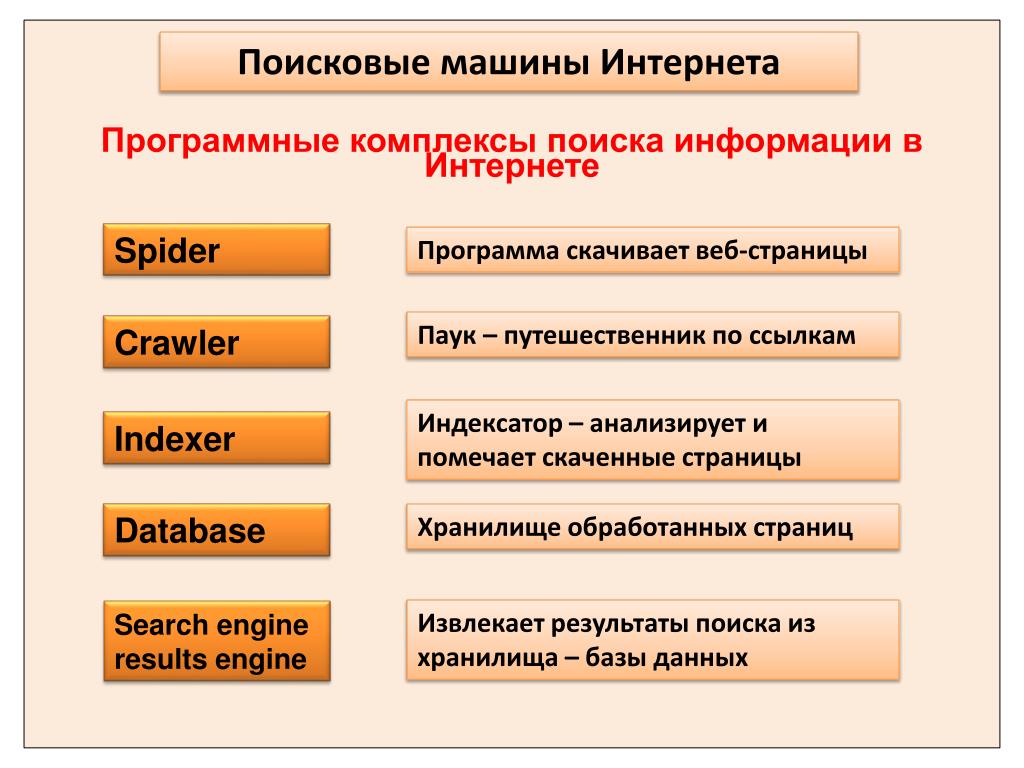

Как работают поиcковые машины? Одним из замечательных свойств Интернет является то, что существуют сотни миллионов web-ресурсов, ожидающих и готовых быть представленными нам. Но плохо то, что есть те же миллионы страниц, которые, даже будучи нам нужны, не предстанут перед нами, т.к. просто неизвестны нам. Как узнать, что и где можно найти в интернет? Обычно для этого мы обращаемся к помощи поисковых машин.

Поисковые интернет машины представляют собой специальные сайты в глобальной сети, которые сделаны так, чтобы помочь людям отыскать во всемирной паутине нужную им информацию. Есть различия в способах, которыми поисковые машины выполняют свои функции, но в целом есть 3 основных и одинаковых функции:

Все они «обыскивают» интернет (или какой то сектор интернет) — на основе заданных ключевых слов;

— все поисковики индексируют слова, которые они ищут и места, где они их находят;

— все поисковики позволяют пользователям искать слова или комбинации из ключевых слов на основе уже проиндексированных и занесенных в свои базы данных web-страниц.

Самые первые поисковики индексировали до нескольких сотен тысяч страниц и получали 1,000 — 2,000 запросов в день. Сегодя топовые поисковики проиндексировали и индексируют в непрерывном режиме сотни миллионов страниц, обрабатывают десятки миллионов запросов в день. Ниже будет рассказано о том, как же работают поисковики и каким образом они «складывают» все кусочки найденной информации так, чтобы суметь ответить на любой интересующий нас вопрос.

Посмотрим на Web

Когда люди говорят о поисковых интернет машинах, они в действительности имеют в виду поисковые машины World Wide Web . Прежде, чем Web стал наиболее видимой частью интернет, уже существовали поисковые машины, которые помогали людям найти в сети информацию. Программы под названием «gopher» и «Archie» умели индексировать файлы, размещенные на разных серверах, подсоединенных к интернет Internet и многократно снижали временные затраты на поиск нужных программ или документов. В конце 80-х годов прошлого века синонимом «умения работать в интернет» было умение использовать gopher, Archie, Veronica и т. п. поисковые программы. Сегодня большинство интернет пользователей ограничивают свой поиск только всемирной сетью, или WWW.

п. поисковые программы. Сегодня большинство интернет пользователей ограничивают свой поиск только всемирной сетью, или WWW.

Маленькое начало

Перед тем, как ответить вам где найти нужный документ или файл, это файл или документ должен быть уже когда то найден. Чтобы найти информацию о сотнях миллионах существующих WEB-страниц, поисковая машина применяет специальную программу-робот. Эта программа еще называется спайдер («spider», паук) и служит для построения списка слов, найденных на странице. Процесс построения такого списка называется

Как же начинает любой паук (spider) свое путешествие по сети? Обычно стартовой точкой являются наиболее крупные мировые сервера и очень популярных web-страницы. Паук начинает свой путь с такого сайта, индексирует все найденные слова и продолжает свое движение далее, по ссылкам на другие сайты. Таким образом, робот-паук начинает охватывать все большие «куски» web-пространства. Google.com начинался с академического поисковика. В статье, описывающей как была создана эта поисковая машина, Сергей Брин и Лауренс Пейдж (основатели и владельцы Google) привели пример, как быстро работают гугловские пауки. Их несколько и обычно поиск начинается с использованием 3-х пауков. Каждый паук поддерживает до 300 одновременно открытых соединений с web-страницами. При пиковой загрузке, с использованием 4-х пауков, система Гугл способна обработать 100 страниц в секунду, генерируя траффик около 600 килобайт/сек.

Таким образом, робот-паук начинает охватывать все большие «куски» web-пространства. Google.com начинался с академического поисковика. В статье, описывающей как была создана эта поисковая машина, Сергей Брин и Лауренс Пейдж (основатели и владельцы Google) привели пример, как быстро работают гугловские пауки. Их несколько и обычно поиск начинается с использованием 3-х пауков. Каждый паук поддерживает до 300 одновременно открытых соединений с web-страницами. При пиковой загрузке, с использованием 4-х пауков, система Гугл способна обработать 100 страниц в секунду, генерируя траффик около 600 килобайт/сек.

Чтобы обеспечить пауков необходимыми для обработки данными, раньше Google располагал сервером, который занимался только тем, что «подбрасывал» паукам все новые и новые URL. Чтобы не зависеть от интернет сервис провайдеров в части серверов доменных имен (DNS), транслирующих url в IP адрес, Google обзавелся собственным сервером DNS, сведя все временные затраты на индексацию страниц до минимума.

Когда Google робот посещает HTML страницу, он принимает во внимание 2 вещи:

Слова (текст) на странцие;

— место их расположения (в какой части body страницы).

Слова, расположенные с служебных разделах, таких как title, subtitles, meta tags и др. помечались как особо важные для пользовательских поисковых запросов. Google паук был построен так, чтобы индексировать каждое подобное слово на странице, за исключением междометий типа «a,» «an» и «the.». Другие поисковики имеют несколько другой подход к индексации.

Все подходы и алгоритмы поисковиков в конечном итоге направлены на то, чтобы заставить роботов пауков работать быстрее и эффективнее. К примеру, некоторые поисковые роботы отслеживают при индексации слова в title, ссылках и до 100 наиболее часто используемых на странице слов и даже каждое из слов первых 20 строк текстового содержания страницы. Таков алгортим индексации, в частности, у Lycos.

Другие поисковики, такие как AltaVista, идут в другом направлении, индексируя каждое отдельное слово странциы, включая «a,» «an,» «the» и други неважные слова.

Мета-Теги (Meta Tags)

Метатеги позволяют владельцу web-страницы задавать ключевые слова и понятия, которые определяют суть её содержания. Это очень полезный инструемнт, особенно когда эти ключевые слова могут повторяться до 2-3 раз в тексте страницы. В этом случае мета-теги могу «направить» поисковый робот к нужному выбору ключевых слов для индексации страницы. Существует вероятность «накрутки» мета-тегов сверх популярными поисковыми запросами и понятиями, никак не связаннными с содержанием самой старницы. Поисковые роботы умеют бороься с этим, путем, например, анализа корреляции мета-тегов и содержимого web-страницы, «выкидывая» из рассмотрения те мета-теги (соответственно ключевые слова) , которые не соответствуют содержимому страниц.

Все это касается тех случаев, когда владелец web-ресурса действительно желает быть включенным в поисковые результаты по нужным поисковым словам. Но нередко случается так, что владелец совсем не желает быть проиндексированным роботом. Но такие случаи не относятся к теме нашей статьи.

Но такие случаи не относятся к теме нашей статьи.

Построение индекса

Как только пауки закончили свою работу по нахождению новых web-страниц, поисковые машины должны разместить всю найденную информацию так, чтобы было удобно в дальнейшем ею пользоваться. Здесь имеют значение 2 ключевых компонента:

Информация, сохраненная вместе с данными;

— метод, которым эта информация проиндексирована.

В простейшем случае, поисковик мог бы просто разместить слово и URL адрес, где оно находится. Но это сделало бы поисковик совсем примитивным инструментом, так как нет никакой информации о том, в какой части документа находится это слово (мета-тегах, или в обычном тексте), используется ли это слово один раз или многократно и содержится ли оно в ссылке на другой важный и близкий по теме ресурс. Другими словами, такой способ не позволит ранжировать сайты, не обеспечит представление пользователям релевантных результатов и т.д.

Чтобы предоставить нам полезные данные, поисковики сохраняют не только информацию из слова и его URL адрес. Поисковик может сохранить данные о количестве (частоте) упоминаний слова на странице, присвоить слову «вес», что далее поможет выдавать поисковые листинги (результаты) на основе весового ранжирования по данному слову, с учетом его местонахождения (в ссылках, мета тегах, титуле страницы и т.п.). У каждого коммерческого поисковика есть своя формула для вычисления «веса» ключевых слов при индексации. Это одна из причин, почему по одному и тому же поисковому запросу поисковики выдают совсем разные результаты.

Поисковик может сохранить данные о количестве (частоте) упоминаний слова на странице, присвоить слову «вес», что далее поможет выдавать поисковые листинги (результаты) на основе весового ранжирования по данному слову, с учетом его местонахождения (в ссылках, мета тегах, титуле страницы и т.п.). У каждого коммерческого поисковика есть своя формула для вычисления «веса» ключевых слов при индексации. Это одна из причин, почему по одному и тому же поисковому запросу поисковики выдают совсем разные результаты.

Следующий важный момент при обработке найденной информации — её кодирование с целью уменьшения объема дискового пространства для её сохранения. Например, в оригинальной статье Google описано, что для хранения весовых данных слов используется 2 байта (по 8 бит каждый) — при этом учитывается вид слова (большими или прописными буквами), размер самих букв (Font-Size) и др. информация, которая помогает ранжировать сайт. Каждый такой «кусочек» информации требует 2-3 бита данных в полном 2-байтном наборе. В результате громадный объем информации удается сохранять в очень компактном виде. После того, как информация «сжата», пора приступать к индексации.

В результате громадный объем информации удается сохранять в очень компактном виде. После того, как информация «сжата», пора приступать к индексации.

Цель индексация одна: обеспечить максимально быстрый поиск нужной информации. Существуют несколько путей для построения индексов, но самый эффективный — это построение хеш-таблиц (hash table). При хешировании используется определенная формула, с помощью которой каждому слову присваивается некое численное значение.

В любом языке существуют буквы, с которых начинается гораздо больше слов, чем с остальных букв алфавита. К примеру, слов на букв «M» в разделе английского словаря значительно больше, чем на букву «X». Это означает, что поиск слова, начинающегося с самой популярной буквы потребует больше времени, чем любое другое слово. Хешинг (Hashing) уравнивает эту разницу и уменьшает среднее время поиска, а также разделяет сам индекс от реальных данных. Хеш таблица содержит хеш-значения вместе с указателем на данные, соответствующие этому значению. Эффективная индексация + эффективное размещение вместе обеспечивают высокую скорость поиска, даже если пользователь задаст очень сложный поисковый запрос.

Эффективная индексация + эффективное размещение вместе обеспечивают высокую скорость поиска, даже если пользователь задаст очень сложный поисковый запрос.

Будущее поисковиков

Поиск, основанный на булевских операторах («and», «or», «not») — это буквенный поиск — поисковик получает поисковые слова ровно так, как они введены. Это может вызвать проблему, когда, например, введенное слово имеет множество значений. «Ключ,» например, может означать «средство для открытия двери», а может означать «пароль» для входа на сервер. Если вас интересует только одно значение слова, то вам, очевидно, будут не нужны данные по его второму значению. Можно, конечно, построить буквальный запрос, который позволит исключить вывод данных по ненужному значению слова, но было бы неплохо, если бы поисковик смог сам помочь вам.

Одна из областей исследований в области алгоритмов будущих поисковых машин — это концептуальный поиск информации. Это такие алгоритмы, кгда для нахождения релевантных данных используется статистический анализ страниц, содержащих данное поисковое ключевое слово или фразу. Ясно, что такой «концептуальной поисковой машине» потребуется гораздо больший объем для хранения данных о каждой странице и больше времени для обработки каждого запроса. В настоящее время многие исследователи работают над этой проблемой.

Ясно, что такой «концептуальной поисковой машине» потребуется гораздо больший объем для хранения данных о каждой странице и больше времени для обработки каждого запроса. В настоящее время многие исследователи работают над этой проблемой.

Не менее интенсивно ведутся работы и в области разработки поисковых алгоритмов на основе запросов естественного языка (Natural-Language query).

Идея естественных запросов состоит в том, что вы можете написать запрос так, как если бы спросили об этом коллегу, сидящего напротив вас. Не надо беспокоиться о булевских операторах или напрягаться для составления сложного запроса. Самый популярный на сегодня поисковый сайт на основе языка естественных запросов — это AskJeeves.com. Он преобразует запрос в ключевые слова, которые затем и использует при индексировании сайтов. Этот подход работает только в случае простых запросов. Однако, прогресс не стоит на месте, возможно, что совсем скоро мы будем «разговаривать» с поисковыми машинами на своем, «человеческом языке».

В Интернете не одна сотня миллионов ресурсов, и миллионы нужных страниц останутся неизвестны нам никогда. Как найти в этом океане нужную нам капельку? Вот здесь и приходит нам на помощь поиск овая машина. Это паук , и только он знает что и в каком месте паутины у него находится.

Поиск овые машины Интернет а, это сайты, специально сделанные так, чтобы помочь отыскать нужную информацию в глобальной сети всемирной паутины. Есть три основных функции, одинаковые для всех поиск овых машин:

— поиск овики на по заданным ключевым словам «обыскивают» интернет;

— адреса, индексируются поиск овиками вместе со словами;

— проиндексированные web-страницы образуют базу, которую поиск овики предоставляют пользователям для поиск а ключевых слов или комбинаций из них.

Первые поиск овики получали в день до 2,000 запросов и индексировали по сотеням тысяч страниц. Сегодя количество запросов в день идет на сотни миллионов страниц и десятки миллионов.

Сегодя количество запросов в день идет на сотни миллионов страниц и десятки миллионов.

Первыми поиск овиками Интернет а были программы «gopher» и «Archie». Они индексировали файлы, находящиеся на подсоединенных к Интернет серверах, многократно снижая время на поиск нужных документов. В конце 1980-х годов умение работать в Интернет е сводилось к умению пользоваться Archie, gopher, Veronica и подобных поиск овые программы.

Сегодня Web стал наиболее востребованной частью Интернет а и большинство Интернет пользователей осуществляют поиск только в World Wide Web ( WWW ).

Робот-

паукПрограмма-робот применяемая в поиск овых машинах, еще она называется «spider», паук (спайдер) , осуществляет процесс создания списка слов, найденных на странице wed-ресурса. Процесс называется Web crawling (краулинг). Поиск овый паук просмотривает массу других страниц, строит и фиксирует список полезных слов, т.е. имеющих какое-то значение, вес.

Поиск овый паук просмотривает массу других страниц, строит и фиксирует список полезных слов, т.е. имеющих какое-то значение, вес.

Путешествие по поиск у в сети, паук (spider) начинает с наиболее крупного сервера и самых популярных web-страниц. Обойдя такой сайт и проиндексировав все найденные слова, он отправляется сканировать другие сайты по найденным ссылкам. Таким вот образом, робот-паук захватывает все web-пространство.

Основатели Google, Сергей Брин и Лауренс Пейдж, приводят пример работы гугловских паук ов. Их несколько. Поиск начинается тремя паук ами. Один паук одновременно поддерживает до 300 соединений со страницами. На пиковой загрузке, четыре паук а способны обрабатывать до ста страниц в секунду, генерируя при этом траффик около 600 килобайт/сек. На данный момент, когда вы это читаете, возможно цифры вам покажутся смешными.

Ключевые слова для поисковикового робота

Обычно владелец web-ресурса хочет быть включенным в поиск овые результаты по нужным поиск овым словам. Эти слова называются ключев ыми. Ключев ые слова определяют суть содержания web-страницы. И помогают в этом Мета-Теги. Они то и предлагают поисковому роботу выбор ключев ых слов, используемых для индексации страницы. Но не советуем накручивать мета-теги сверх популярными запросами, не связаннными содержанием с самой старницей. Поисковые роботы борются с этим явлением, и вам повезет, если он просто выкинет из рассмотрения мета-теги с ключев ыми словами, не соответствующими содержимому страниц.

Эти слова называются ключев ыми. Ключев ые слова определяют суть содержания web-страницы. И помогают в этом Мета-Теги. Они то и предлагают поисковому роботу выбор ключев ых слов, используемых для индексации страницы. Но не советуем накручивать мета-теги сверх популярными запросами, не связаннными содержанием с самой старницей. Поисковые роботы борются с этим явлением, и вам повезет, если он просто выкинет из рассмотрения мета-теги с ключев ыми словами, не соответствующими содержимому страниц.

Метатеги очень полезный инструемнт, когда ключев ые слова из них повторяються в тексте страницы несколько раз. Но не переборщите, существует вероятность, что робот примет страницу за дорвей.

Алгоритмы индексации поисковиков

Алгоритмы поиск овиков направлены на эффективность конечного результата, но подходы к этому у всех разные. У Lycos поиск овые роботы индексируют слова в заголовке (title), ссылках (линках) и до сотни часто употребляемых слов на странице и каждое слово из первых 20 строк контента страницы.

Робот Google принимает во внимание место расположения слова на странице (в элементе body). Слова служебных разделов, таких как subtitles, title, meta tags и др. помечает как особо важные, исключая междометия «a,» «an» и «the.».

Другие поиск овики могут иметь несколько другой способ подхода к индексации слов, используемых для поиск овых запросов пользователями.

Как функционируют роботы поисковых систем

Поисковый робот (паук, бот) представляет собой небольшую программу, способную без участия оператора посещать миллионы web-сайтов и сканировать гигабайты текстов. Считывание страниц и сохранение их текстовых копий – это первая стадия индексации новых документов. Следует отметить, что роботы поисковых систем не осуществляют какую-либо обработку полученных данных. В их задачу входит только сохранение текстовой информации.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Список поисковых роботов

Из всех поисковиков, занимающихся сканированием Рунета, самой большой коллекцией ботов располагает Яндекс. За индексацию отвечают следующие боты:

За индексацию отвечают следующие боты:

- главный индексирующий робот, собирающий данные со страниц web-сайтов;

- бот, способный распознавать зеркала;

- поисковый робот Яндекс, осуществляющий индексацию картинок;

- паук, просматривающий страницы сайтов, принятых в РСЯ;

- робот, сканирующий иконки favicon;

- несколько пауков, определяющих доступность страниц сайта.

Главный поисковый робот Google занимается сбором текстовой информации. В основном он просматривает html-файлы, с определенной периодичностью анализирует JS и CSS. Способен воспринимать любые типы контента, разрешенные к индексации. ПС Гугл располагает пауком, контролирующим индексацию изображений. Есть также поисковый робот – программа, поддерживающая функционирование мобильной версии поиска.

Увидеть сайт глазами поискового робота

Чтобы исправить погрешности кода и прочие недочеты, вебмастер может узнать, как видит сайт поисковый робот. Эту возможность предоставляет ПС Google. Потребуется перейти в инструменты для вебмастеров, а затем кликнуть на вкладку «сканирование». В открывшемся окне нужно выбрать строчку «просмотреть как Googlebot». Далее нужно завести адрес исследуемой страницы в поисковую форму (без указания домена и протокола http://).

Потребуется перейти в инструменты для вебмастеров, а затем кликнуть на вкладку «сканирование». В открывшемся окне нужно выбрать строчку «просмотреть как Googlebot». Далее нужно завести адрес исследуемой страницы в поисковую форму (без указания домена и протокола http://).

Выбрав команду «получить и отобразить», вебмастер сможет визуально оценить состояние страницы сайта. Для этого понадобится кликнуть по галочке «запрос на отображение». Откроется окно с двумя версиями web-документа. Вебмастер узнает, как видит страницу обычный посетитель, и в каком виде она доступна для поискового паука.

Совет!Если анализируемый web-документ еще не проиндексирован, то можно воспользоваться командой «добавить в индекс» >> «сканировать только этот URL». Паук проанализирует документ через несколько минут, в ближайшем времени web-страница появится в выдаче. Месячный лимит запросов на индексацию составляет 500 документов.

Как повлиять на скорость индексирования

Выяснив, как работают поисковые роботы, вебмастер сможет гораздо результативнее продвигать свой сайт. Одной из основных проблем многих молодых web-проектов является плохая индексация. Роботы поисковых систем неохотно посещают неавторитетные интернет ресурсы.

Одной из основных проблем многих молодых web-проектов является плохая индексация. Роботы поисковых систем неохотно посещают неавторитетные интернет ресурсы.

Установлено, что скорость индексации напрямую зависит от того, с какой интенсивностью обновляется сайт. Регулярное добавление уникальных текстовых материалов позволит привлечь внимание поисковика.

Для ускорения индексации можно воспользоваться соцзакладками и сервисом twitter. Рекомендуется сформировать карту сайта Sitemap и загрузить ее в корневую директорию web-проекта.

Являющаяся составной частью поисковой системы и предназначенная для перебора страниц Интернета с целью занесения информации о них в базу данных поисковика. По принципу действия паук напоминает обычный браузер. Он анализирует содержимое страницы, сохраняет его в некотором специальном виде на сервере поисковой машины, которой принадлежит, и отправляется по ссылкам на следующие страницы. Владельцы поисковых машин нередко ограничивают глубину проникновения паука внутрь сайта и максимальный размер сканируемого текста, поэтому чересчур большие сайты могут оказаться не полностью проиндексированными поисковой машиной. Кроме обычных пауков, существуют так называемые «дятлы » — роботы, которые «простукивают» проиндексированный сайт, чтобы определить, что он доступен.

Кроме обычных пауков, существуют так называемые «дятлы » — роботы, которые «простукивают» проиндексированный сайт, чтобы определить, что он доступен.

Порядок обхода страниц, частота визитов, защита от зацикливания, а также критерии выделения значимой информации определяются алгоритмами информационного поиска .

В большинстве случаев переход от одной страницы к другой осуществляется по ссылкам, содержащимся на первой и последующих страницах.

Также многие поисковые системы предоставляют пользователю возможность самостоятельно добавить сайт в очередь для индексирования . Обычно это существенно ускоряет индексирование сайта, а в случаях, когда никакие внешние ссылки не ведут на сайт, вообще оказывается практически единственной возможностью указать на его существование. Ещё одним способом быстрой индексации сайта является добавление на сайт систем веб-аналитики, принадлежащих поисковым сервисам. Например, таких как Google Analytics , Яндекс.Метрика и Рейтинг@Mail.ru от Google, Яндекса и Mail. Ru соответственно.

Ru соответственно.

Ограничить индексацию сайта можно с помощью файла robots.txt . Полная защита от индексации может быть обеспечена другими механизмами, например установкой пароля на странице либо требованием заполнить регистрационную форму перед тем, как получить доступ к содержимому.

Энциклопедичный YouTube

1 / 3

Просмотров:

Какую работу выполняют пауки поисковых машин. Как работают поисковые роботы. Как функционируют роботы поисковых систем

Как правило, поисковая машина представляет собой сайт, специализирующийся на поиске информации, соответствующей критериям запроса пользователя. Основная задача таких сайтов заключается в упорядочивании и структурировании информации в сети.

Большинство людей, пользуясь услугами поисковой системы, никогда не задаются вопросом как именно действует машина, отыскивая необходимую информацию из глубин Интернета.

Для рядового пользователя сети, само понятие принципов работы поисковых машин не является критичным, так как алгоритмы, которыми руководствуется система, способны удовлетворить запросы человека, который не знает как составлять оптимизированный запрос при поиске необходимой информации. Но для веб-разработчика и специалистов занимающихся оптимизацией сайтов, просто необходимо обладать, как минимум, начальными понятиями о структуре и принципах работы поисковых систем.

Но для веб-разработчика и специалистов занимающихся оптимизацией сайтов, просто необходимо обладать, как минимум, начальными понятиями о структуре и принципах работы поисковых систем.

Каждая поисковая машина работает по точным алгоритмам, которые держатся под строжайшим секретом и известны лишь небольшому кругу сотрудников. Но при проектировании сайта или его оптимизации, обязательно нужно учитывать общие правила функционирования поисковых систем, которые рассматриваются в предлагаемой статье.

Невзирая на то, что каждая ПС имеет свою собственную структуру, после тщательного их изучения можно объединить в основные, обобщающие компоненты:

Модуль индексирования

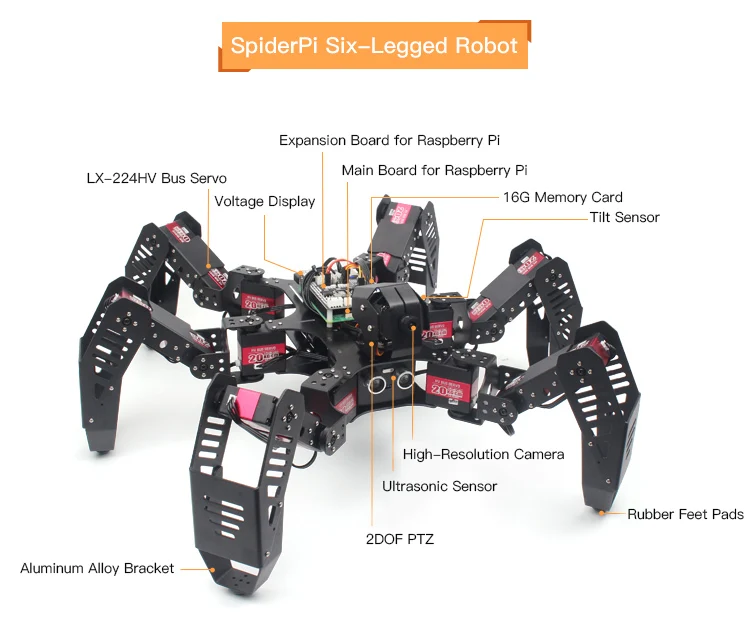

Модуль индексирования — этот элемент включает три дополнительных компонента (программы-роботы):

1. Spider (робот-паук) — скачивает страницы, фильтрует текстовый поток извлекая из него все внутренние гиперссылки. Кроме того, Spider сохраняет дату скачивания и заголовок ответа сервера, а также URL — адрес страницы.

2. Crawler (ползающий робот-паук) — осуществляет анализ всех ссылок на странице, и на основе этого анализа, определяет какую страницу посещать, а какую не стоит. Таким же образом краулер находит новые ресурсы, которые должны быть обработаны ПС.

3. Indexer (Робот-индексатор) – занимается анализом скачанных пауком интернет-страниц. При этом сама страница разбивается на блоки и анализируется индексатором с помощью морфологических и лексических алгоритмов. Под разбор индексатора попадают различные части веб-страницы: заголовки, тексты и другая служебная информация.

Все документы, прошедшие обработку этим модулем, хранятся в базе данных поисковика, называемой индексом системы. Кроме самих документов, база данных содержит необходимые служебные данные – результат тщательной обработки этих документов, руководствуясь которыми, поисковая система выполняет запросы пользователя.

Поисковый сервер

Следующий, очень важный компонент системы – поисковый сервер, задача которого заключается в обработке запроса пользователя и генерации страницы результатов поиска.

Обрабатывая запрос пользователя, поисковый сервер рассчитывает рейтинг релевантности отобранных документов запросу пользователя. От этого рейтинга зависит позиция, которую займет веб-страница при выдаче поисковых результатов. Каждый документ, удовлетворяющий условиям поиска, отображается на странице выдачи результатов в виде сниппета.

Сниппет – это краткое описание страницы, включающее заголовок, ссылку, ключевые слова и краткую текстовую информацию. По сниппету пользователь может оценить релевантность отобранных поисковой машиной страниц своему запросу.

Важнейшим критерием, которым руководствуется поисковый сервер при ранжировании результатов запроса – является уже знакомый нам показатель тИЦ ().

Все описанные компоненты ПС требуют больших затрат и очень ресурсоемкие. Результативность поисковой системы напрямую зависит от эффективности взаимодействия этих компонентов.

Понравилась статья? Подпишитесь на новости блога или поделитесь в социальных сетях, а я отвечу вам

6 комментариев к посту “Поисковые системы их роботы и пауки”

Давно искала эту информацию, спасибо.

Ответить

Радует, что ваш блог постоянно развивается. Такие посты только прибавляют популярности.

Ответить

Кое что понял. Вопрос, PR как-то зависит от ТИЦ?

Роботы поисковой системы, иногда их называют «пауки» или «кроулеры» (crawler) — это программные модули, занимающиеся поиском web-страниц. Как они работают? Что же они делают в действительности? Почему они важны?Учитывая весь шум вокруг поисковой оптимизации и индексных баз данных поисковиков, вы, наверное думаете, что роботы должно быть великие и могущественные существа. Неправда. Роботы поисковика обладают лишь базовыми функциями, похожими на те, которыми обладали одни из первых броузеров, в отношении того, какую информацию они могут распознать на сайте. Как и ранние броузеры, роботы попросту не могут делать определенные вещи. Роботы не понимают фреймов, Flash анимаций, изображений или JavaScript. Они не могут зайти в разделы, защищенные паролем и не могут нажимать на все те кнопочки, которые есть на сайте. Они могут заткнуться в процессе индексирования динамических адресов URL и работать очень медленно, вплоть до остановки и безсилием над JavaScript-навигацией.

Они могут заткнуться в процессе индексирования динамических адресов URL и работать очень медленно, вплоть до остановки и безсилием над JavaScript-навигацией.

Как работают роботы поисковой машины?

Поисковые роботы стоит воспринимать, как программы автоматизированного получения данных, путешествующие по сети в поисках информации и ссылок на информацию.Когда, зайдя на страницу Submit a URL, вы регистрируете очередную web-страницу в поисковике — в очередь для просмотра сайтов роботом добавляется новый URL. Даже если вы не регистрируете страницу, множество роботов найдет ваш сайт, поскольку существуют ссылки из других сайтов, ссылающиеся на ваш. Вот одна из причин, почему важно строить ссылочную популярность и размещать ссылки на других тематических ресурсах.

Прийдя на ваш сайт, роботы сначала проверяют, есть ли файл robots.txt. Этот файл сообщает роботам, какие разделы вашего сайта не подлежат индексации. Обычно это могут быть директории, содержащие файлы, которыми робот не интересуется или ему не следовало бы знать.

Роботы хранят и собирают ссылки с каждой страницы, которую они посещают, а позже проходят по этим ссылкам на другие страницы. Вся всемирная сеть построена из ссылок. Начальная идея создания Интернет сети была в том, что бы была возможность перемещаться по ссылкам от одного места к другому. Вот так перемещаются и роботы.

Остроумность в отношении индексирования страниц в реальном режиме времени зависит от инженеров поисковых машин, которые изобрели методы, используемые для оценки информации, получаемой роботами поисковика. Будучи внедрена в базу данных поисковой машины, информация доступна пользователям, которые осуществляют поиск. Когда пользователь поисковой машины вводит поисковый запрос, производится ряд быстрых вычислений для уверенности в том, что выдается действительно правильный набор сайтов для наиболее релевантного ответа.

Вы можете просмотреть, какие страницы вашего сайта уже посетил поисковый робот, руководствуясь лог-файлами сервера, или результатами статистической обработки лог-файла. Идентифицируя роботов, вы увидите, когда они посетили ваш сайт, какие страницы и как часто. Некоторые роботы легко идентифицируются по своим именам, как Googles Googlebot. Другие более скрытые, как, например, Inktomis Slurp. Другие роботы так же могут встречаться в логах и не исключено, что вы не сможете сразу их идентифицировать; некоторые из них могут даже оказаться броузерами, которыми управляют люди.

Идентифицируя роботов, вы увидите, когда они посетили ваш сайт, какие страницы и как часто. Некоторые роботы легко идентифицируются по своим именам, как Googles Googlebot. Другие более скрытые, как, например, Inktomis Slurp. Другие роботы так же могут встречаться в логах и не исключено, что вы не сможете сразу их идентифицировать; некоторые из них могут даже оказаться броузерами, которыми управляют люди.

Помимо идентификации уникальных поисковых роботов и подсчета количества их визитов, статистика также может показать вам агрессивных, поглощающих ширину катала пропускания роботов или роботов, нежелательных для посещения вашего сайта.

Как они читают страницы вашего web-сайта?

Когда поисковой робот посещает страницу, он просматривает ее видимый текст, содержание различных тегов в исходном коде вашей страницы (title tag, meta tags, и т.д.), а так же гиперссылки на странице. Судя по словам ссылок, поисковая машина решает, о чем страница. Есть много факторов, используемых для вычисления ключевых моментов страницы «играющих роль». Каждая поисковая машина имеет свой собственный алгоритм для оценки и обработки информации. В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базу данных поисковой системы.

Каждая поисковая машина имеет свой собственный алгоритм для оценки и обработки информации. В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базу данных поисковой системы.После этого, информация, доставленная в индексные базы данных поисковой системы, становится частью поисковика и процесса ранжирования в базе. Когда посетитель существляет запрос, поисковик просматривает всю базу данных для выдачи конечного списка, релевантного поисковому запросу.

Базы данных поисковых систем подвергаются тщательной обработке и приведению в соответствие. Если вы уже попали в базу данных, роботы будут навещать вас периодически для сбора любых изменений на страницах и уверенности в том, что обладают самой последней информацией. Количество посещений зависит от установок поисковой машины, которые могут варьироваться от ее вида и назначения.

Иногда поисковые роботы не в состоянии проиндексировать web-сайт. Если ваш сайт упал или на сайт идет большое количество посетителей, робот может быть безсилен в попытках его индексации. Когда такое происходит, сайт не может быть переиндексирован, что зависит от частоты его посещения роботом. В большинстве случаев, роботы, которые не смогли достичь ваших страниц, попытаются позже, в надежде на то, что ваш сайт в ближайшее время будет доступен.

Когда такое происходит, сайт не может быть переиндексирован, что зависит от частоты его посещения роботом. В большинстве случаев, роботы, которые не смогли достичь ваших страниц, попытаются позже, в надежде на то, что ваш сайт в ближайшее время будет доступен.

Многие поисковые роботы не могут быть идентифицированы, когда вы просматриваете логи. Они могут посещать вас, но логи утверждают, что кто-то использует Microsoft броузер и т.д. Некоторые роботы идентифицируют себя использованием имени поисковика (googlebot) или его клона (Scooter = AltaVista).

В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базы данных поисковой машины.

Базы данных поисковых машин подвергаются модификации в различные сроки. Даже директории, имеющие вторичные поисковые результаты используют данные роботов как содержание своего web-сайта.

Собственно, роботы не используются поисковиками лишь для вышеизложенного. Существуют роботы, которые проверяют баз данных на наличие нового содержания, навещают старое содержимое базы, проверяют, не изменились ли ссылки, загружают целые сайты для просмотра и так далее.

По этой причине, чтение лог-файлов и слежение за выдачей поисковой системы помогает вам наблюдать за индексацией ваших проектов.

Поисковый робот (бот, паук, spider, crawler) — это специальная программа поисковика, предназначенная для сканирования сайтов в сети Интернет.

Многие не знают, что сканирующие боты просто собирают и сохраняют информацию. Они не занимаются ее обработкой. Это делают другие программы.

Если у вас есть желание посмотреть на сайт глазами поискового робота, то можно это сделать через панель вебмастера.

Посмотреть как Google можно через панель вебмастера. Там нужно добавить свой сайт и потом можно будет посмотреть на странице:

https://www.google.com/webmasters/tools/googlebot-fetch?hl=ru

Посмотреть как Яндекс можно через сохраненную копию страницы. Для этого находим нужную страницу в поиске Яндекса, жмем «сохраненная копия» и дальше «посмотреть текстовую версию».

Ниже приведу список поисковых роботов, которые ходят по нашим с вами сайтам. Одни из них индексируют сайты , другие следят за контекстной рекламой. Есть специализированные роботы, которые занимаются определенными узкими задачами. Например, индексируют картинки или новости.

Одни из них индексируют сайты , другие следят за контекстной рекламой. Есть специализированные роботы, которые занимаются определенными узкими задачами. Например, индексируют картинки или новости.

Зная «в лицо» робота, можно запретить или разрешить ему ползать по сайту, тем самым можно снизить нагрузку на сервер. Ну или защитить свою информацию от попадания в сеть.

Поисковые роботы Яндекса

У поисковой системы Яндекс десятка полтора известных нам поисковых роботов. Список ботов, который мне удалось раскопать, в том числе и из официального хелпа, ниже.

YandexBot — основной индексирующий робот;

YandexMedia — робот, индексирующий мультимедийные данные;

YandexImages — индексатор Яндекс.Картинок;

YandexCatalog — «простукивалка» Яндекс.Каталога, используется для временного снятия с публикации недоступных сайтов в Каталоге;

YaDirectFetcher — робот Яндекс.Директа;

YandexBlogs — робот поиска по блогам, индексирующий посты и комментарии;

YandexNews — робот Яндекс. Новостей;

Новостей;

YandexWebmaster – приходит придобавлении сайта через форума AddURL;

YandexPagechecker — валидатор микроразметки;

YandexFavicons — индексатор фавиконок

YandexMetrika — робот Яндекс.Метрики;

YandexMarket — робот Яндекс.Маркета;

YandexCalendar — робот Яндекс.Календаря.

Поисковые роботы (боты) Google

Googlebot — основной индексирующий робот;

Googlebot Nes — индексатор новостей;

Googlebot Images — индексатор картинок;

Googlebot Video — робот для видео данных;

Google Mobile — индексатор мобильного контента;

Google Mobile AdSense — робот мобильного AdSense

Google AdSense — робот AdSense

Google AdsBot – бот проверки качества целевой страницы

Mediapartners-Google — робот AdSense

Роботы других поисковых систем

Так же, в логах своего сайта, вы можете наткнуться на некоторых роботов других поисковиков.

Рамблер — StackRambler

Мэйл.ру — Mail.Ru

Yahoo! — Slurp (или Yahoo! Slurp)

AOL — Slurp

MSN — MSNBot

Live — MSNBot

Ask — Teoma

Alexa — ia_archiver

Lycos — Lycos

Aport — Aport

Вебальта — WebAlta (WebAlta Crawler/2. 0)

0)

Кроме ботов поисковиков, по сайтам бегает огромная армия всяких левых пауков. Это различные парсеры, которые собирают информацию с сайтов, как правило, в корыстных целях их создателей.

Одни воруют контент, другие картинки, третьи взламывают сайты и расставляют втихаря ссылки. Если вы заметили, что подобный парсер присосался к вашему сайту — закройте ему доступ всеми возможными способами, в том числе и через файл robots.txt .

Поисковым роботом называется специальная программа какой-либо поисковой системы, которая предназначена для занесения в базу (индексирования) найденных в Интернете сайтов и их страниц. Также используются названия: краулер, паук, бот, automaticindexer, ant, webcrawler, bot, webscutter, webrobots, webspider.

Принцип работы

Поисковый робот — это программа браузерного типа. Он постоянно сканирует сеть: посещает проиндексированные (уже известные ему) сайты, переходит по ссылкам с них и находит новые ресурсы. При обнаружении нового ресурса робот процедур добавляет его в индекс поисковика. Поисковый робот также индексирует обновления на сайтах, периодичность которых фиксируется. Например, обновляемый раз в неделю сайт будет посещаться пауком с этой частотой, а контент на новостных сайтах может попасть в индекс уже через несколько минут после публикации. Если на сайт не ведет ни одна ссылка с других ресурсов, то для привлечения поисковых роботов ресурс необходимо добавить через специальную форму (Центр вебмастеров Google, панель вебмастера Яндекс и т.д.).

Поисковый робот также индексирует обновления на сайтах, периодичность которых фиксируется. Например, обновляемый раз в неделю сайт будет посещаться пауком с этой частотой, а контент на новостных сайтах может попасть в индекс уже через несколько минут после публикации. Если на сайт не ведет ни одна ссылка с других ресурсов, то для привлечения поисковых роботов ресурс необходимо добавить через специальную форму (Центр вебмастеров Google, панель вебмастера Яндекс и т.д.).

Виды поисковых роботов

Пауки Яндекса :

- Yandex/1.01.001 I — основной бот, занимающийся индексацией,

- Yandex/1.01.001 (P) — индексирует картинки,

- Yandex/1.01.001 (H) — находит зеркала сайтов,

- Yandex/1.03.003 (D) — определяет, соответствует ли страница, добавленная из панели вебмастера, параметрам индексации,

- YaDirectBot/1.0 (I) — индексирует ресурсы из рекламной сети Яндекса,

- Yandex/1.02.000 (F) — индексирует фавиконы сайтов.

Пауки Google:

- Робот Googlebot — основной робот,

- Googlebot News — сканирует и индексирует новости,

- Google Mobile — индексирует сайты для мобильных устройств,

- Googlebot Images — ищет и индексирует изображения,

- Googlebot Video — индексирует видео,

- Google AdsBot — проверяет качество целевой страницы,

- Google Mobile AdSense и Google AdSense — индексирует сайты рекламной сети Google.

Другие поисковики также используют роботов нескольких видов, функционально схожих с перечисленными.

1.1.1. Компоненты поисковых машин

Информация в Сети не только пополняется, но и постоянно изменяется, но об этих изменениях никто никому не сообщает. Отсутствует единая система занесения информации, одновременно доступная для всех пользователей Интернета. Поэтому с целью структурирования информации, предоставления пользователям удобных средств поиска данных и были созданы поисковые машины.

Поисковые системы бывают разных видов. Одни из них выполняют поиск информации на основе того, что в них заложили люди. Это могут быть каталоги, куда сведения о сайтах, их краткое описание либо обзоры заносят редакторы. Поиск в них ведется среди этих описаний.

Вторые собирают информацию в Сети, используя специальные программы. Это поисковые машины, состоящие, как правило, из трех основных компонентов:

Индекса;

Поискового механизма.

Агент , или более привычно — паук, робот (в англоязычной литературе — spider, crawler), в поисках информации обходит сеть или ее определенную часть. Этот робот хранит список адресов (URL), которые он может посетить и проиндексировать, с определенной для каждой поисковой машины периодичностью скачивает соответствующие ссылкам документы и анализирует их. Полученное содержимое страниц сохраняется роботом в более компактном виде и передается в Индекс. Если при анализе страницы (документа) будет обнаружена новая ссылка, робот добавит ее в свой список. Поэтому любой документ или сайт, на который есть ссылки, может быть найден роботом. И наоборот, если на сайт или любую его часть нет никаких внешних ссылок, робот может его не найти.

Этот робот хранит список адресов (URL), которые он может посетить и проиндексировать, с определенной для каждой поисковой машины периодичностью скачивает соответствующие ссылкам документы и анализирует их. Полученное содержимое страниц сохраняется роботом в более компактном виде и передается в Индекс. Если при анализе страницы (документа) будет обнаружена новая ссылка, робот добавит ее в свой список. Поэтому любой документ или сайт, на который есть ссылки, может быть найден роботом. И наоборот, если на сайт или любую его часть нет никаких внешних ссылок, робот может его не найти.

Робот — это не просто сборщик информации. Он обладает довольно развитым «интеллектом». Роботы могут искать сайты определенной тематики, формировать списки сайтов, отсортированных по посещаемости, извлекать и обрабатывать информацию из существующих баз данных, могут выполнять переходы по ссылкам различной глубины вложенности. Но в любом случае, всю найденную информацию они передают базе данных (Индексу) поисковой машины.

Поисковые роботы бывают различных типов:

? Spider (паук) — это программа, которая скачивает веб-страницы тем же способом, что и браузер пользователя. Отличие состоит в том, что браузер отображает информацию, содержащуюся на странице (текстовую, графическую и т. д.), паук же не имеет никаких визуальных компонентов и работает напрямую с HTML-текстом страницы (аналогично тому, что вы увидите, если включите просмотр HTML-кода в вашем браузере).

? Crawler (краулер, «путешествующий» паук) — выделяет все ссылки, присутствующие на странице. Его задача — определить, куда дальше должен идти паук, основываясь на ссылках или исходя из заранее заданного списка адресов. Краулер, следуя по найденным ссылкам, осуществляет поиск новых документов, еще неизвестных поисковой системе.

? Индексатор разбирает страницу на составные части и анализирует их. Выделяются и анализируются различные элементы страницы, такие как текст, заголовки, структурные и стилевые особенности, специальные служебные HTML-теги и т. д.

д.

Индекс — это та часть поисковой машины, в которой осуществляется поиск информации. Индекс содержит все данные, которые были переданы ему роботами, поэтому размер индекса может достигать сотен гигабайт. Практически, в индексе находятся копии всех посещенных роботами страниц. В случае если робот обнаружил изменение на уже проиндексированной им странице, он передает в Индекс обновленную информацию. Она должна замещать имеющуюся, но в ряде случаев в Индексе появляется не только новая, но остается и старая страница.

Поисковый механизм — это тот самый интерфейс, с помощью которого посетитель взаимодействует с Индексом. Через интерфейс пользователи вводят свои запросы и получают ответы, а владельцы сайтов регистрируют их (и эта регистрация — еще один способ донести до робота адрес своего сайта). При обработке запроса поисковый механизм выполняет отбор соответствующих ему страниц и документов среди многих миллионов проиндексированных ресурсов и выстраивает их в порядке важности или соответствия запросу.

Поисковые системы их роботы и пауки. Поисковые роботы ндекс

Друзья, я снова приветствую Вас! Сейчас мы разберем, что такое поисковые роботы и подробно поговорим про поисковый робот google и как с ними дружить.

Сначала надо понимать, что вообще такое поисковые роботы, еще их называют пауки. Какую работу выполняют пауки поисковых систем?

Это программы, которые проверяют сайты. Они просматривают все записи и страницы на вашем блоге, собирают информацию, которую потом передают в базу той поисковой системы, на которую они трудятся.

Не надо знать весь список поисковых роботов, самое главное знать, что у гугла сейчас появились два основных паука, которые называются «панда» и «пингвин». Они борются с некачественным контентом и мусорными ссылками и надо знать как отражать их атаки.

Поисковый робот google «панда» создан для того, чтобы продвигать в поиске только качественный материал. Все сайты с низкопробным контентом понижаются в поисковой выдаче.

Первый раз этот паук появился в 2011 году. До его появления можно было продвинуть любой сайт публикуя в статьях большой объем текста и используя огромный объем ключевых слов. В совокупности эти два приема выводили на верх выдачи поиска не качественный контент, а хорошие сайты понижались в выдаче.

До его появления можно было продвинуть любой сайт публикуя в статьях большой объем текста и используя огромный объем ключевых слов. В совокупности эти два приема выводили на верх выдачи поиска не качественный контент, а хорошие сайты понижались в выдаче.

«Панда» сразу навел порядок проверив все сайты и расставил всех по своим заслуженным местам. Хотя она и борется с низкопробным контентом, зато сейчас можно продвинуть даже небольшие сайты с качественными статьями. Хотя раньше такие сайты продвигать было бесполезно, они не могли конкурировать с гигантами у которых большое количество контента.

Сейчас мы с вами разберемся, как можно избежать санкций «панды». Надо сначала понять что ей не нравится. Я уже писал выше, что она борется с плохим контентом, но какой текст для нее плохой, давайте разберемся в этом, чтобы не публиковать такой на своем сайте.

Поисковый робот google стремиться чтобы в этом поисковике выдавалась только качественные материалы для соискателей. Если у вас есть статьи в которых мало информации и они не привлекательные внешне, то срочно перепишите эти тексты, чтобы «панда» не добралась до вас.

Если у вас есть статьи в которых мало информации и они не привлекательные внешне, то срочно перепишите эти тексты, чтобы «панда» не добралась до вас.

Качественный контент может иметь как большой объем, так и маленький, но если паук видит длинную статью с большим количеством информации значит она больше принесет пользы читателю.

Затем надо отметить дублирование, а другими словами плагиат. Если вы думаете что будете переписывать чужие статьи себе на блог, то можете сразу поставить крест на своем сайте. Копирование строго наказывается наложением фильтра, а проверяется плагиат очень легко, я писал статью на тему как проверять тексты на уникальность .

Следующее что надо заметить, это перенасыщение текста ключевыми словами. Кто думает, что напишет статью из одних ключей и займет первое место в выдаче – очень сильно ошибается. У меня есть статья, как проверять страницы на релевантность, прочитайте обязательно.

И еще что может привлечь к вам «панду», так это старые статьи, которые устарели морально и не приносят трафик на сайт. Их нужно обязательно обновить.

Их нужно обязательно обновить.

Существует так же поисковый робот google «пингвин». Этот паук борется со спамом и мусорными ссылками на вашем сайте. Так же он вычисляет купленные ссылки с других ресурсов. Поэтому, чтобы не бояться этого поискового робота, надо не заниматься закупом ссылок, а публиковать качественный контент, чтобы люди сами на вас ссылались.

Сейчас давайте сформулируем, что надо сделать чтобы сайт глазами поискового робота смотрелся идеально:

- Для того чтобы сделать качественный контент, сначала хорошо изучите тему, прежде чем писать статью. Затем надо понимать, что данной темой реально интересуются люди.

- Используйте конкретные примеры и картинки, это сделает статью живой и интересной. Разбивайте текст на мелкие абзацы, чтобы читать было легко.Вот например, если вы открыли в газете страницу с анекдотами, то какие сначала прочитаете? Естественно каждый человек сначала читает короткие тексты, затем подлиньше и в самую последнюю очередь уже длинные портянки.

- Любимая придирка «панды» — это не актуальность статьи в которой содержится устаревшая информация. Следите за обновлениями и изменяйте тексты.

- Следите за плотностью ключевых слов, как определить эту плотность я написал выше, в сервисе о котором я рассказал вы получите точное необходимое количество ключей.

- Не занимайтесь плагиатом, всем известно что нельзя воровать чужие вещи или текста – это одно и то же. За воровство будете отвечать попаданием под фильтр.

- Тексты пишите минимум на две тысячи слов, тогда такая статья будет выглядеть глазами роботов поисковых систем информативной.

- Не уходите от темы вашего блога. Если вы ведете блог по заработку в интернете, то не надо печатать статьи про пневматическое оружие. Это может снизить рейтинг вашего ресурса.

- Красиво оформляйте статьи, делите на абзацы и добавляйте картинки, чтобы приятно было читать и не хотелось побыстрее уйти с сайта.

- Закупая ссылки, делайте их на самые интересные и полезные статьи, которые реально будут читать люди.

Ну вот сейчас вы знаете какую работу выполняют роботы поисковых систем и сможете с ними дружить. А самое главное поисковый робот google и «панда» и «пингвин» вами подробно изучен.

Роботы поисковой системы, иногда их называют «пауки» или «кроулеры» (crawler) — это программные модули, занимающиеся поиском web-страниц. Как они работают? Что же они делают в действительности? Почему они важны?

Учитывая весь шум вокруг поисковой оптимизации и индексных баз данных поисковиков, вы, наверное думаете, что роботы должно быть великие и могущественные существа. Неправда. Роботы поисковика обладают лишь базовыми функциями, похожими на те, которыми обладали одни из первых броузеров, в отношении того, какую информацию они могут распознать на сайте. Как и ранние броузеры, роботы попросту не могут делать определенные вещи. Роботы не понимают фреймов, Flash анимаций, изображений или JavaScript. Они не могут зайти в разделы, защищенные паролем и не могут нажимать на все те кнопочки, которые есть на сайте.![]() Они могут заткнуться в процессе индексирования динамических адресов URL и работать очень медленно, вплоть до остановки и безсилием над JavaScript-навигацией.

Они могут заткнуться в процессе индексирования динамических адресов URL и работать очень медленно, вплоть до остановки и безсилием над JavaScript-навигацией.

Как работают роботы поисковой машины?

Поисковые роботы стоит воспринимать, как программы автоматизированного получения данных, путешествующие по сети в поисках информации и ссылок на информацию.

Когда, зайдя на страницу Submit a URL, вы регистрируете очередную web-страницу в поисковике — в очередь для просмотра сайтов роботом добавляется новый URL. Даже если вы не регистрируете страницу, множество роботов найдет ваш сайт, поскольку существуют ссылки из других сайтов, ссылающиеся на ваш. Вот одна из причин, почему важно строить ссылочную популярность и размещать ссылки на других тематических ресурсах.

Прийдя на ваш сайт, роботы сначала проверяют, есть ли файл robots.txt. Этот файл сообщает роботам, какие разделы вашего сайта не подлежат индексации. Обычно это могут быть директории, содержащие файлы, которыми робот не интересуется или ему не следовало бы знать.

Роботы хранят и собирают ссылки с каждой страницы, которую они посещают, а позже проходят по этим ссылкам на другие страницы. Вся всемирная сеть построена из ссылок. Начальная идея создания Интернет сети была в том, что бы была возможность перемещаться по ссылкам от одного места к другому. Вот так перемещаются и роботы.

Остроумность в отношении индексирования страниц в реальном режиме времени зависит от инженеров поисковых машин, которые изобрели методы, используемые для оценки информации, получаемой роботами поисковика. Будучи внедрена в базу данных поисковой машины, информация доступна пользователям, которые осуществляют поиск. Когда пользователь поисковой машины вводит поисковый запрос, производится ряд быстрых вычислений для уверенности в том, что выдается действительно правильный набор сайтов для наиболее релевантного ответа.

Вы можете просмотреть, какие страницы вашего сайта уже посетил поисковый робот, руководствуясь лог-файлами сервера, или результатами статистической обработки лог-файла. Идентифицируя роботов, вы увидите, когда они посетили ваш сайт, какие страницы и как часто. Некоторые роботы легко идентифицируются по своим именам, как Googles Googlebot. Другие более скрытые, как, например, Inktomis Slurp. Другие роботы так же могут встречаться в логах и не исключено, что вы не сможете сразу их идентифицировать; некоторые из них могут даже оказаться броузерами, которыми управляют люди.

Идентифицируя роботов, вы увидите, когда они посетили ваш сайт, какие страницы и как часто. Некоторые роботы легко идентифицируются по своим именам, как Googles Googlebot. Другие более скрытые, как, например, Inktomis Slurp. Другие роботы так же могут встречаться в логах и не исключено, что вы не сможете сразу их идентифицировать; некоторые из них могут даже оказаться броузерами, которыми управляют люди.

Помимо идентификации уникальных поисковых роботов и подсчета количества их визитов, статистика также может показать вам агрессивных, поглощающих ширину катала пропускания роботов или роботов, нежелательных для посещения вашего сайта.

Как они читают страницы вашего web-сайта?

Когда поисковой робот посещает страницу, он просматривает ее видимый текст, содержание различных тегов в исходном коде вашей страницы (title tag, meta tags, и т.д.), а так же гиперссылки на странице. Судя по словам ссылок, поисковая машина решает, о чем страница. Есть много факторов, используемых для вычисления ключевых моментов страницы «играющих роль». Каждая поисковая машина имеет свой собственный алгоритм для оценки и обработки информации. В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базу данных поисковой системы.

Каждая поисковая машина имеет свой собственный алгоритм для оценки и обработки информации. В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базу данных поисковой системы.

После этого, информация, доставленная в индексные базы данных поисковой системы, становится частью поисковика и процесса ранжирования в базе. Когда посетитель существляет запрос, поисковик просматривает всю базу данных для выдачи конечного списка, релевантного поисковому запросу.

Базы данных поисковых систем подвергаются тщательной обработке и приведению в соответствие. Если вы уже попали в базу данных, роботы будут навещать вас периодически для сбора любых изменений на страницах и уверенности в том, что обладают самой последней информацией. Количество посещений зависит от установок поисковой машины, которые могут варьироваться от ее вида и назначения.

Иногда поисковые роботы не в состоянии проиндексировать web-сайт. Если ваш сайт упал или на сайт идет большое количество посетителей, робот может быть безсилен в попытках его индексации. Когда такое происходит, сайт не может быть переиндексирован, что зависит от частоты его посещения роботом. В большинстве случаев, роботы, которые не смогли достичь ваших страниц, попытаются позже, в надежде на то, что ваш сайт в ближайшее время будет доступен.

Когда такое происходит, сайт не может быть переиндексирован, что зависит от частоты его посещения роботом. В большинстве случаев, роботы, которые не смогли достичь ваших страниц, попытаются позже, в надежде на то, что ваш сайт в ближайшее время будет доступен.

Многие поисковые роботы не могут быть идентифицированы, когда вы просматриваете логи. Они могут посещать вас, но логи утверждают, что кто-то использует Microsoft броузер и т.д. Некоторые роботы идентифицируют себя использованием имени поисковика (googlebot) или его клона (Scooter = AltaVista).

В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базы данных поисковой машины.

Базы данных поисковых машин подвергаются модификации в различные сроки. Даже директории, имеющие вторичные поисковые результаты используют данные роботов как содержание своего web-сайта.

Собственно, роботы не используются поисковиками лишь для вышеизложенного. Существуют роботы, которые проверяют баз данных на наличие нового содержания, навещают старое содержимое базы, проверяют, не изменились ли ссылки, загружают целые сайты для просмотра и так далее.

По этой причине, чтение лог-файлов и слежение за выдачей поисковой системы помогает вам наблюдать за индексацией ваших проектов.

Как правило, поисковая машина представляет собой сайт, специализирующийся на поиске информации, соответствующей критериям запроса пользователя. Основная задача таких сайтов заключается в упорядочивании и структурировании информации в сети.

Большинство людей, пользуясь услугами поисковой системы, никогда не задаются вопросом как именно действует машина, отыскивая необходимую информацию из глубин Интернета.

Для рядового пользователя сети, само понятие принципов работы поисковых машин не является критичным, так как алгоритмы, которыми руководствуется система, способны удовлетворить запросы человека, который не знает как составлять оптимизированный запрос при поиске необходимой информации. Но для веб-разработчика и специалистов занимающихся оптимизацией сайтов, просто необходимо обладать, как минимум, начальными понятиями о структуре и принципах работы поисковых систем.

Каждая поисковая машина работает по точным алгоритмам, которые держатся под строжайшим секретом и известны лишь небольшому кругу сотрудников. Но при проектировании сайта или его оптимизации, обязательно нужно учитывать общие правила функционирования поисковых систем, которые рассматриваются в предлагаемой статье.

Невзирая на то, что каждая ПС имеет свою собственную структуру, после тщательного их изучения можно объединить в основные, обобщающие компоненты:

Модуль индексирования

Модуль индексирования — этот элемент включает три дополнительных компонента (программы-роботы):

1. Spider (робот-паук) — скачивает страницы, фильтрует текстовый поток извлекая из него все внутренние гиперссылки. Кроме того, Spider сохраняет дату скачивания и заголовок ответа сервера, а также URL — адрес страницы.

2. Crawler (ползающий робот-паук) — осуществляет анализ всех ссылок на странице, и на основе этого анализа, определяет какую страницу посещать, а какую не стоит. Таким же образом краулер находит новые ресурсы, которые должны быть обработаны ПС.

Таким же образом краулер находит новые ресурсы, которые должны быть обработаны ПС.

3. Indexer (Робот-индексатор) – занимается анализом скачанных пауком интернет-страниц. При этом сама страница разбивается на блоки и анализируется индексатором с помощью морфологических и лексических алгоритмов. Под разбор индексатора попадают различные части веб-страницы: заголовки, тексты и другая служебная информация.

Все документы, прошедшие обработку этим модулем, хранятся в базе данных поисковика, называемой индексом системы. Кроме самих документов, база данных содержит необходимые служебные данные – результат тщательной обработки этих документов, руководствуясь которыми, поисковая система выполняет запросы пользователя.

Поисковый сервер

Следующий, очень важный компонент системы – поисковый сервер, задача которого заключается в обработке запроса пользователя и генерации страницы результатов поиска.

Обрабатывая запрос пользователя, поисковый сервер рассчитывает рейтинг релевантности отобранных документов запросу пользователя. От этого рейтинга зависит позиция, которую займет веб-страница при выдаче поисковых результатов. Каждый документ, удовлетворяющий условиям поиска, отображается на странице выдачи результатов в виде сниппета.

От этого рейтинга зависит позиция, которую займет веб-страница при выдаче поисковых результатов. Каждый документ, удовлетворяющий условиям поиска, отображается на странице выдачи результатов в виде сниппета.

Сниппет – это краткое описание страницы, включающее заголовок, ссылку, ключевые слова и краткую текстовую информацию. По сниппету пользователь может оценить релевантность отобранных поисковой машиной страниц своему запросу.

Важнейшим критерием, которым руководствуется поисковый сервер при ранжировании результатов запроса – является уже знакомый нам показатель тИЦ ().

Все описанные компоненты ПС требуют больших затрат и очень ресурсоемкие. Результативность поисковой системы напрямую зависит от эффективности взаимодействия этих компонентов.

Понравилась статья? Подпишитесь на новости блога или поделитесь в социальных сетях, а я отвечу вам

6 комментариев к посту “Поисковые системы их роботы и пауки”

Давно искала эту информацию, спасибо.

Ответить

Радует, что ваш блог постоянно развивается. Такие посты только прибавляют популярности.

Ответить

Кое что понял. Вопрос, PR как-то зависит от ТИЦ?

Привет, Друзья! Сегодня Вы узнаете как работают поисковые роботы Яндекс и Google и какую функцию они выполняют в продвижении сайтов. Итак поехали!

Это действие поисковые системы делают для того, чтобы из миллиона сайтов найти десять WEB-проектов, которые имеют качественный и релевантный ответ на запрос пользователя. Почему только десять? Потому что состоит только из десяти позиций.

Поисковые роботы друзья и веб-мастерам и пользователям

Почему важно посещения сайта поисковыми роботами уже стало ясно, а зачем это пользователю? Всё верно, для того, чтобы пользователю открывались только те сайты, которые ответят на его запрос в полном объёме.

Поисковый робот – очень гибкий инструмент, он способен найти сайт, даже тот, который только создан, а владелец этого сайта ещё не занимался . Поэтому этого бота и назвали пауком, он может дотянуть свои лапки и добраться по виртуальной паутине куда угодно.

Поэтому этого бота и назвали пауком, он может дотянуть свои лапки и добраться по виртуальной паутине куда угодно.

Можно ли управлять поисковым роботом в своих интересах

Бывают такие случаи, когда некоторые страницы не попали в поиск. В основном это связано с тем, что эта страница ещё не проиндексирована поисковым роботом. Конечно, рано или поздно поисковый робот заметит эту страницу. Но это требует времени, а иногда и достаточно много времени. Но здесь можно помочь поисковому роботу посетить эту страницу быстрее.

Для этого можно разместить свой сайт в специальных каталогах или списках, социальных сетях. В общем, на всех площадках, где поисковый робот просто живёт. Например, в социальных сетях идёт обновление каждую секунду. Попробуйте заявить о своём сайте, и поисковый робот придёт на ваш сайт значительно быстрее.

Из этого вытекает одно, но главное правило. Если вы хотите чтобы боты поисковой системы посещали ваш сайт, им нужно давать новый контент на регулярной основе. В том случае, если они заметит, что контент обновляется, сайт развивается, то станут посещать ваш интернет-проект намного чаще.

В том случае, если они заметит, что контент обновляется, сайт развивается, то станут посещать ваш интернет-проект намного чаще.

Каждый поисковый робот умеет запоминать, как часто у вас меняется контент. Он оценивает не только качество, а временные промежутки. И если материал на сайте обновляется раз в месяц, то и приходить он на сайт будет один раз в месяц.

Таким образом, если сайт будет обновляться раз в неделю, то и поисковый робот будет приходить раз в неделю. Если обновлять сайт каждый день, то и поисковый робот будет посещать сайт каждый день или через день. Есть сайты, которые индексируются уже через несколько минут после обновления. Это социальные сети, новостные агрегаторы, и сайты которые размещают в день несколько статей.

Как дать задание роботу и запретить ему что-либо?

В самом начале мы узнали, что поисковые системы имеют несколько роботов, которые выполняют различные задачи. Кто-то ищет картинки, кто-то ссылки так далее.

Управлять любым роботом можно с помощью специального файла robots. txt . Именно с этого файла робот начинает знакомиться с сайтом. В этом файле можно указать, можно ли роботу индексировать сайт, если да, то какие именно разделы. Все эти инструкции можно создать как для одного, так и для всех роботов.

txt . Именно с этого файла робот начинает знакомиться с сайтом. В этом файле можно указать, можно ли роботу индексировать сайт, если да, то какие именно разделы. Все эти инструкции можно создать как для одного, так и для всех роботов.

Обучение продвижению сайтов

Более подробно о премудростях SEO продвижения сайтов в поисковых системах Google и Яндекс, я рассказываю на своих по скайпу. Все свои WEB-проекты я вывел на посещаемость более и получаю с этого отличный . Могу этому научить и Вас, кому интересно!

- Определения и терминология

- Имена роботов

- Немного истории

- Что делают роботы поисковых систем

- Поведение роботов на сайте

- Управление роботами

- Выводы

Что такое роботы поисковых систем? Какую функцию они выпол няют? Каковы особенности работы поисковых роботов? Здесь мы постараемся дать ответ на эти и некоторые другие вопросы, свя занные с работой роботов.

Определения и терминология

В английском языке существует несколько вариантов названий поисковых роботов: robots, web bots, crawlers, spiders; в русском языке фактически прижился один термин — роботы, или сокращенно — боты.

На сайте www. robotstxt. org дается следующее определение роботам:

“Веб-робот — это программа, которая обходит гипертекстовую структуру WWW, рекурсивно запрашивая и извлекая документы”.

Ключевое слово в этом определении — рекурсивно, т.е. имеется в виду, что после получения документа робот будет запрашивать документы по ссылкам из него и т.д.

Имена роботовБольшинство поисковых роботов имеют свое уникальное имя (кроме тех роботов, которые по каким-то причинам маскируются под пользовательские браузеры).

Имя робота можно увидеть в поле User-agent серверных лог-файлов, отчетах систем серверных статистик, а также на страницах помощи поисковых систем.

Так, робота Яндекса собирательно называют Yandex, робота Рамблера — StackRambler, робота Yahoo! — Slurp и т. д. Даже пользовательские программы, собирающие контент для последующего просмотра, могут специальным образом представляться с помощью информации в поле User-agent.

д. Даже пользовательские программы, собирающие контент для последующего просмотра, могут специальным образом представляться с помощью информации в поле User-agent.

Кроме имени робота, в поле User-agent может находиться больше информации: версия робота, предназначение и адрес страницы с дополнительной информацией.

Немного историиЕще в первой половине 1990-х годов, в период развития Интернета, существовала проблема веб-роботов, связанная с тем, что некоторые из первых роботов могли существенно загрузить веб-сервер, вплоть до его отказа, из-за того, что делали большое количество запросов к сайту за слишком короткое время. Системные администраторы и администраторы веб-серверов не имели возможности управлять поведением робота в пределах своих сайтов, а могли лишь полностью закрыть доступ роботу не только к сайту, а и к серверу.

В 1994 году был разработан протокол robots.txt, задающий исключения для роботов и позволяющий пользователям управлять поисковыми роботами в пределах своих сайтов. Об этих возможностях вы читали в главе 6 “Как сделать сайт доступным для поисковых систем”.

Об этих возможностях вы читали в главе 6 “Как сделать сайт доступным для поисковых систем”.

В дальнейшем, по мере роста Сети, количество поисковых роботов увеличивалось, а функциональность их постоянно расширялась. Некоторые поисковые роботы не дожили до наших дней, оставшись только в архивах серверных лог-файлов конца 1990-х. Кто сейчас вспоминает робота T-Rex, собирающего информацию для системы Lycos? Вымер, как динозавр, по имени которого назван. Или где можно найти Scooter — робот системы Altavista? Нигде! А ведь в 2002 году он еще активно индексировал документы.

Даже в имени основного робота Яндекса можно найти эхо минувших дней: фрагмент его полного имени “compatible; Win16;” был добавлен для совместимости с некоторыми старыми веб-серверами.

Что делают роботы поисковых системКакие же функции могут выполнять роботы?

В поисковой машине функционирует несколько разных роботов, и у каждого свое предназначение. Перечислим некоторые из задач, выполняемых роботами:

- обработка запросов и извлечение документов;

- проверка ссылок;

- мониторинг обновлений;проверка доступности сайта или сервера;

- анализ контента страниц для последующего размещения контекстнойрекламы;

- сбор контента в альтернативных форматах (графика, данные в форматахRSSnAtom).

В качестве примера приведем список роботов Яндекса. Яндекс использует несколько видов роботов с разными функциями. Идентифицировать их можно по строке User-agent.

- Yandex/1.01.001 (compatible; Win 16; I) -основной индексирующий робот.

- Yandex/1.01.001 (compatible; Win 16; P) -индексатор картинок.

- Yandex/1.01.001 (compatible; Win 16; H) -робот, определяющийзеркала сайтов.

- Yandex/1.03.003 (compatible; Win 16; D) -робот, обращающийсяк странице при добавлении ее через форму “Добавить URL”.

- Yandex/1.03.000 (compatible; Win 16; М) — робот, обращающийсяпри открытии страницы по ссылке “Найденные слова”.

- YandexBlog/0.99.101 (compatible; DOS3.30; Mozilla/5.0; В;robot) — робот, индексирующий xml-файлы для поиска по блогам.

- YandexSomething/1.0 — робот, индексирующий новостные потоки партнеров Яндекс.Новостей и файлы robots. txt для робота поиска по блогам.

Кроме того, в Яндексе работает несколько проверяющих роботов — “просту- кивалок”, которые только проверяют доступность документов, но не индексируют их.

- Yandex/2.01.000 (compatible; Win 16; Dyatel; С) — “просту-кивалка” Яндекс.Каталога. Если сайт недоступен в течение несколькихдней, он снимается с публикации. Как только сайт начинает отвечать, онавтоматически появляется в каталоге.

- Yandex/2.01.000 (compatible; Win 16; Dyatel; Z) — “просту-кивалка” Яндекс.Закладок. Ссылки на недоступные сайты выделяютсясерым цветом.

- Yandex/2.01.000 (compatible; Win 16; Dyatel; D) -”простуки-валка” Яндекс.Директа. Она проверяет корректность ссылок из объявлений перед модерацией.

И все-таки наиболее распространенные роботы — это те, которые запрашивают, получают и архивируют документы для последующей обработки другими механизмами поисковой системы. Здесь уместно будет отделить робота от индексатора.

Поисковый робот обходит сайты и получает документы в соответствии со своим внутренним списком адресов. В некоторых случаях робот может выполнять базовый анализ документов для пополнения списка адресов. Дальнейшей обработкой документов и построением индекса поисковой системы занимается уже индексатор поисковой машины. Робот в этой схеме является всего лишь “курьером” по сбору данных.

Робот в этой схеме является всего лишь “курьером” по сбору данных.

Поведение роботов на сайте

Чем отличается поведение робота на сайте от поведения обычного пользователя?

- Управляемость. Прежде всего “интеллигентный” робот должен запросить с сервера файл robots . txt с инструкциями по индексации.

- Выборочное выкачивание. При запросе документа робот четко указываеттипы запрашиваемых данных, в отличие от обычного браузера, готового принимать все подряд. Основные роботы популярных поисковиков в первую очередь будут запрашивать гипертекстовые и обычные текстовые документы, оставляя без внимания файлы стилен оформления CSS, изображения, видео. Zip-архивы и т.п. В настоящее время также востребована информация в форматах PDF, Rich Text, MS Word, MS Excel и некоторых других.

- Непредсказуемость. Невозможно отследить или предсказать путь роботано сайту, поскольку он не оставляет информации в поле Referer — адресстраницы, откуда он пришел; робот просто запрашивает список документов, казалось бы, в случайном порядке, а на самом деле в соответствии сосвоим внутренним списком или очередью индексации.

- Скорость. Небольшое время между запросами разных документов. Здесьречь идет о секундах или долях секунды между запросами двух разныхдокументов. Для некоторых роботов есть даже специальные инструкции,которые указываются в файле robots . txt, по ограничению скорости запроса документов, чтобы не перегрузить сайт.

Как может выглядеть HTML-страница в глазах робота, мы не знаем, но можем попытаться себе это представить, отключая в браузере отображение графики и стилевого оформления.

Таким образом, можно сделать вывод, что поисковые роботы закачивают в свой индекс HTML-структуру страницы, но без элементов оформления и без картинок.

Управление роботами

Как же вебмастер может управлять поведением поисковых роботов на своем сайте?

Как уже было сказано выше, в 1994 году в результате открытых дебатов вебмастеров был разработан специальный протокол исключений для роботов. До настоящего времени этот протокол так и не стал стандартом, который обязаны соблюдать все без исключения роботы, оставшись лишь в статусе строгих рекомендаций. Не существует инстанции, куда можно пожаловаться на робота, не соблюдающего правила исключений, можно лишь запретить доступ к сайту уже с помощью настроек веб-сервера или сетевых интерфейсов для IP-адресов, с которых “неинтеллигентный” робот отсылал свои запросы.

Не существует инстанции, куда можно пожаловаться на робота, не соблюдающего правила исключений, можно лишь запретить доступ к сайту уже с помощью настроек веб-сервера или сетевых интерфейсов для IP-адресов, с которых “неинтеллигентный” робот отсылал свои запросы.