Как заставить Google проиндексировать ваш сайт (быстрее)

- Запись опубликована:09.02.2022

- Post category:Техническое SEO

Как заставить Google проиндексировать ваш сайт (быстрее)

Чтобы ваши целевые страницы, блоги, домашние страницы и другой онлайн-контент появлялись в результатах поиска Google, необходимо обеспечить индексацию вашего сайта. Индекс Google — это, по сути, база данных.

Когда люди используют поисковую систему для поиска контента, Google обращается к своему индексу, чтобы предоставить соответствующий контент. Если ваша страница не проиндексирована, она не существует в поисковой системе Google. Это плохая новость, если вы надеетесь привлечь органический трафик на свой сайт через органический поиск.

Это руководство содержит более подробную информацию об индексации и ее важности. В статье также объясняется, как проверить, проиндексирована ли ваша страница, как исправить распространенные технические SEO-проблемы, вызывающие проблемы с индексацией, и как быстро заставить Google повторно проиндексировать ваш сайт, если он еще не проиндексирован.

Что такое индекс Google?

Индекс Google — это просто список всех веб-страниц, о которых известно поисковой системе. Если Google не проиндексирует ваш сайт, ваш сайт не появится в результатах поиска Google.

Это похоже на то, как если бы вы написали книгу, но ни в одном книжном магазине или библиотеке не было бы этой книги. Никто никогда не найдет эту книгу. Они могут даже не знать о ее существовании. А если бы читатель искал эту книгу, ему было бы очень трудно ее найти.

Почему индексирование сайта важно?

Сайты, которые не индексируются, отсутствуют в базе данных Google. Таким образом, поисковая система не может представить эти сайты на своих страницах результатов поиска (SERPs).

Чтобы проиндексировать сайты, веб-гусеницы Google (Googlebot) должны «проползти» по сайту. Узнайте больше о разнице между способностью к ползанию и способностью к индексации.

В качестве справки, вот краткий обзор процесса работы поисковых систем:

Ползание: боты поисковых систем просматривают сайт, чтобы понять, стоит ли его индексировать. Веб-пауки, или «Googlebot», постоянно ползают по Интернету, переходя по ссылкам на существующих веб-страницах, чтобы найти новый контент.

Веб-пауки, или «Googlebot», постоянно ползают по Интернету, переходя по ссылкам на существующих веб-страницах, чтобы найти новый контент.

Индексирование: поисковая система добавляет сайт в свою базу данных (в случае Google — в свой «индекс»).

Ранжирование: Поисковая система ранжирует сайт по таким показателям, как релевантность и удобство для пользователя.

Индексирование означает, что сайт хранится в базах данных Google. Это не означает, что он будет отображаться в верхней части SERP. Индексирование контролируется заранее определенными алгоритмами, которые учитывают такие элементы, как пользовательский спрос и проверка качества. Вы можете влиять на индексацию, управляя тем, как пауки обнаруживают ваш онлайн-контент.

Получите технический SEO-аудит.

с помощью Semrush Site Audit.

Как проверить, проиндексировал ли Google мой сайт??

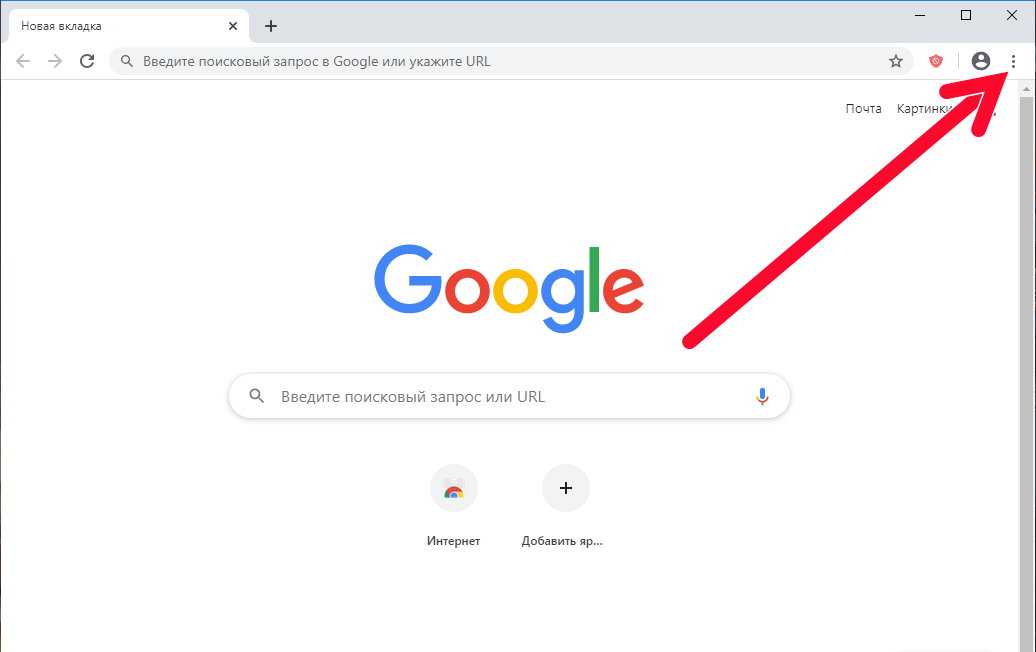

Несомненно, вы хотите, чтобы ваш сайт был проиндексирован — но как узнать, проиндексирован он или нет?? К счастью, гигант поисковых систем позволяет довольно легко узнать, где вы находитесь, с помощью поиска по сайту. Вот как это проверить:

Вот как это проверить:

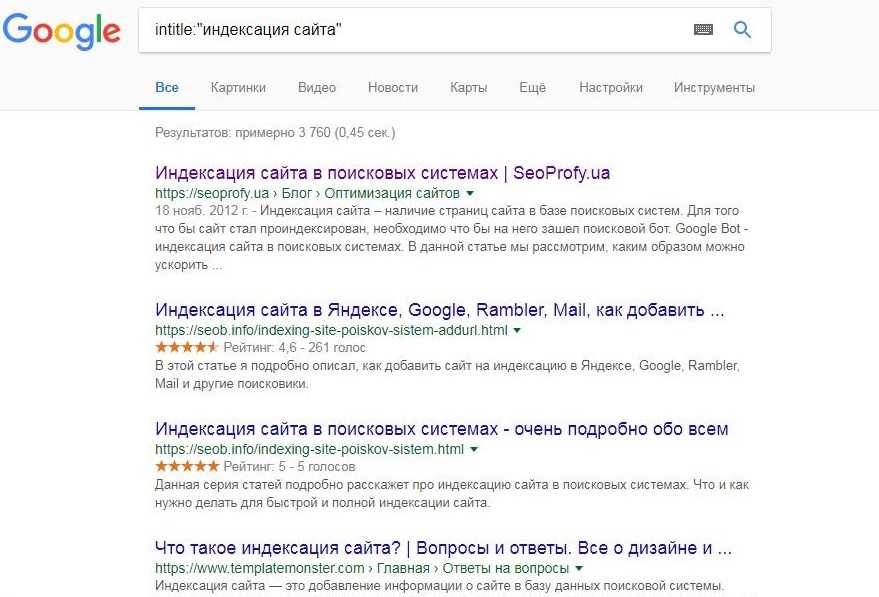

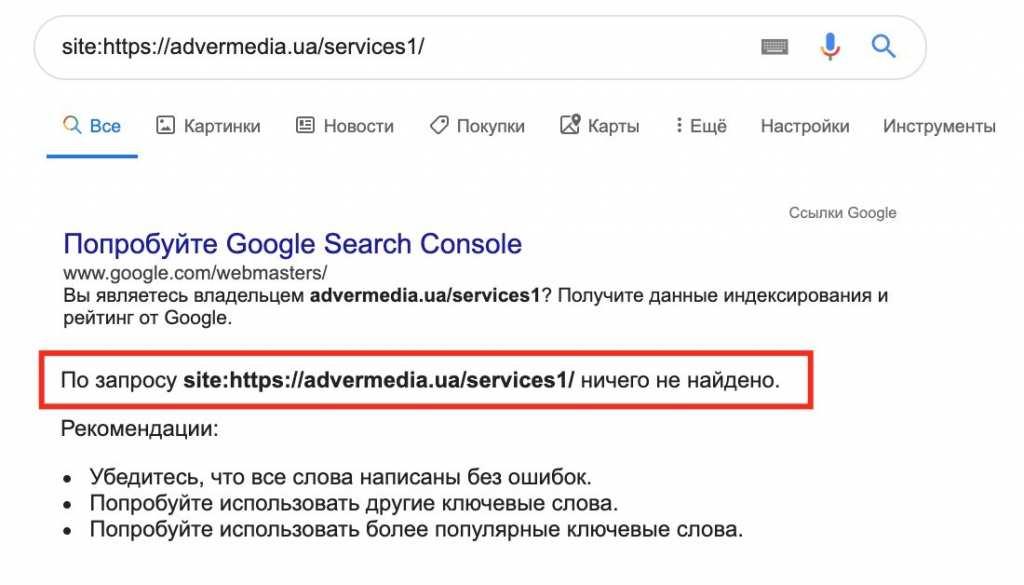

В строке поиска Google введите «site:example.com.»

Под строкой поиска вы увидите категории результатов Google «Все», «Изображения», «Новости» и т.д. Прямо под ними вы увидите оценку того, сколько ваших страниц было проиндексировано Google.

Если отображается ноль результатов, страница не проиндексирована.

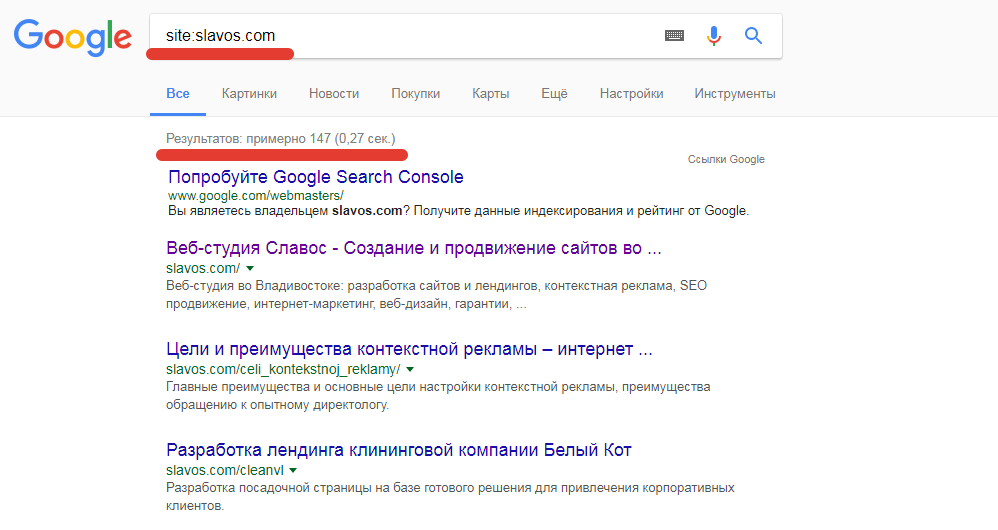

Кроме того, вы можете использовать Google Search Console, чтобы проверить, проиндексирована ли ваша страница. Создание учетной записи бесплатно. Вот как получить нужную вам информацию:

Войдите в Google Search Console.

Нажмите на «Покрытие.»

Вы увидите количество проиндексированных страниц.

Если количество действительных страниц равно нулю, Google не проиндексировал вашу страницу.

Вы также можете использовать Search Console для проверки индексации определенных страниц. Просто вставьте URL-адрес в инструмент проверки URL-адресов. Если страница проиндексирована, вы получите сообщение «URL находится в Google. »

»

Сколько времени требуется Google для индексации сайта?

Индексация сайта может занять у Google от нескольких дней до нескольких недель. Это может расстроить, если вы только что запустили страницу и обнаружили, что она не проиндексирована. Как кто-то может обнаружить вашу новую красивую веб-страницу через Google?? К счастью, есть шаги, которые вы можете предпринять для более эффективной индексации. Ниже мы объясним, что вы можете сделать, чтобы ускорить этот процесс.

Как заставить Google проиндексировать мой сайт?

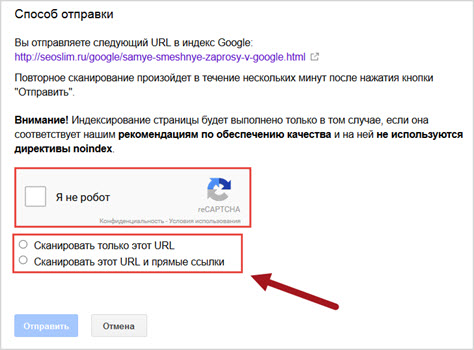

Самый простой способ добиться индексации вашего сайта — запросить индексацию через Google Search Console. Для этого перейдите к инструменту проверки URL в Google Search Console. Вставьте URL, который вы хотите проиндексировать, в строку поиска и подождите, пока Google проверит его. Если URL не проиндексирован, нажмите кнопку «Запросить индексацию».

Примечание: Google временно отключил инструмент запроса индексации в октябре 2020 года. Однако недавно он был восстановлен в Search Console!

Однако индексация Google занимает время. Как уже упоминалось, если ваш сайт новый, он не будет проиндексирован в одночасье. Кроме того, если ваш сайт не настроен должным образом для работы Googlebot, есть вероятность, что он вообще не будет проиндексирован.

Как уже упоминалось, если ваш сайт новый, он не будет проиндексирован в одночасье. Кроме того, если ваш сайт не настроен должным образом для работы Googlebot, есть вероятность, что он вообще не будет проиндексирован.

Независимо от того, являетесь ли вы владельцем сайта или интернет-маркетологом, вы хотите, чтобы ваш сайт эффективно индексировался. Вот как этого добиться.

Оптимизируйте ваш Robots.txt файл.

Robots.txt — это файлы, которые Googlebot распознает как индикатор того, что ему НЕ следует просматривать веб-страницу. Пауки поисковых систем Bing и Yahoo также распознают Robots.txt. Вы можете использовать файлы Robots.txt файлы, чтобы помочь краулерам определить приоритетность более важных страниц, чтобы не перегружать ваш сайт запросами.

Хотя все это может показаться немного техническим, все сводится к тому, чтобы убедиться, что ваша страница доступна для просмотра, и вы можете получить дополнительную помощь в определении этого с помощью нашего On Page SEO Checker.

Убедитесь, что все ваши SEO-теги чисты.

SEO-теги — это еще один способ направлять пауков поисковых систем, таких как Googlebot. Существует два основных типа SEO-тегов, которые вы должны оптимизировать.

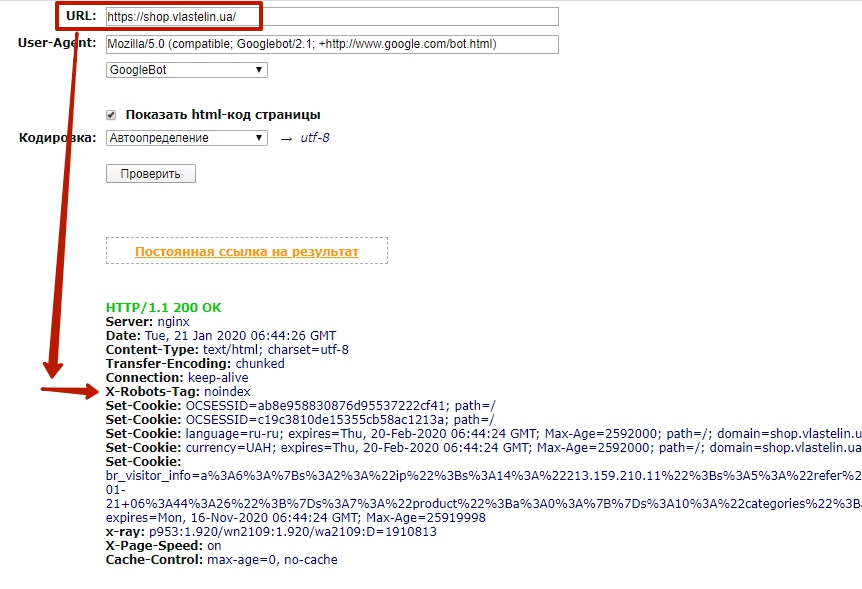

Теги Rogue noindex : Эти теги указывают поисковым системам не индексировать страницы. Если некоторые страницы не индексируются, возможно, они содержат теги noindex. Проверьте наличие этих двух типов:

Мета-теги : Вы можете проверить, какие страницы на вашем сайте могут иметь метатеги noindex, найдя предупреждения «noindex page». Если страница помечена как noindex, удалите мета-тег, чтобы она была проиндексирована.

X-Robots-Tag : Вы можете использовать Google Search Console, чтобы увидеть, какие страницы имеют тег X-Robots-Tag в заголовке HTML. Используйте инструмент проверки URL, описанный выше. После ввода страницы посмотрите ответ «Индексирование разрешено?» Если вы увидите слова «No: ‘noindex’ detected in ‘X-Robots-Tag’ http header,» вы знаете, что есть X-Robots-Tag, который нужно удалить.

Канонические теги : Теги Canonical сообщают поисковым системам, что определенная версия страницы является предпочтительной. Если у страницы нет канонического тега, Googlebot распознает, что это предпочтительная страница и единственная версия этой страницы — и проиндексирует ее. Если у страницы есть канонический тег, Googlebot предполагает, что существует альтернативная предпочтительная версия этой страницы, и не будет индексировать ее, даже если такой версии не существует. Используйте инструмент проверки URL Google для проверки наличия канонических тегов. В этом случае вы увидите предупреждение с текстом «Альтернативная страница с каноническим тегом.»

Дважды проверьте архитектуру вашего сайта, чтобы обеспечить правильную внутреннюю перелинковку и эффективную обратную перелинковку.

Внутренняя перелинковка помогает краулерам находить ваши веб-страницы. Страницы без ссылок известны как «сиротские страницы» и редко индексируются. Правильная архитектура сайта, изложенная в карте сайта, обеспечивает правильную внутреннюю перелинковку.

Карта сайта XML содержит весь контент вашего сайта и позволяет определить страницы, на которые нет ссылок. Вот еще несколько советов по лучшей практике внутренней перелинковки:

Исключите внутренние ссылки nofollow . Когда Googlebot натыкается на теги nofollow, он сигнализирует Google о необходимости исключить целевую ссылку из индекса. Удалите теги nofollow из ссылок.

Добавьте внутренние ссылки с высоким рейтингом . Как уже упоминалось, пауки обнаруживают новый контент, просматривая ваш сайт. Внутренние ссылки ускоряют этот процесс. Ускорьте индексацию, используя страницы с высоким рейтингом для внутренних ссылок на новые страницы.

Генерируйте высококачественные обратные ссылки . Google признает, что страницы важны и заслуживают доверия, если на них постоянно ссылаются авторитетные сайты. Обратные ссылки говорят Google о том, что страница должна быть проиндексирована.

Отдавайте предпочтение высококачественному контенту.

Качественный контент имеет решающее значение как для индексации, так и для ранжирования. Чтобы обеспечить высокую эффективность содержимого вашего сайта, удалите низкокачественные и малоэффективные страницы.

Чтобы обеспечить высокую эффективность содержимого вашего сайта, удалите низкокачественные и малоэффективные страницы.

Это позволит Googlebot сосредоточиться на более ценных страницах вашего сайта, более эффективно используя ваш «бюджет на ползание».» Кроме того, вы хотите, чтобы каждая страница на вашем сайте имела ценность для пользователей. Кроме того, контент должен быть уникальным. Дублированный контент может стать тревожным сигналом для Google Analytics.

Быстрая индексация страниц через Google Indexing API

У каждого SEO специалиста бывает одна проблема и она возникает тогда, когда нужно отправить сайт или страницы на индексацию, но поисковый робот обходит очень долго. Казалось бы, страницы оптимизированы, но робот не обходит нужные нам страницы. Бывало такое?

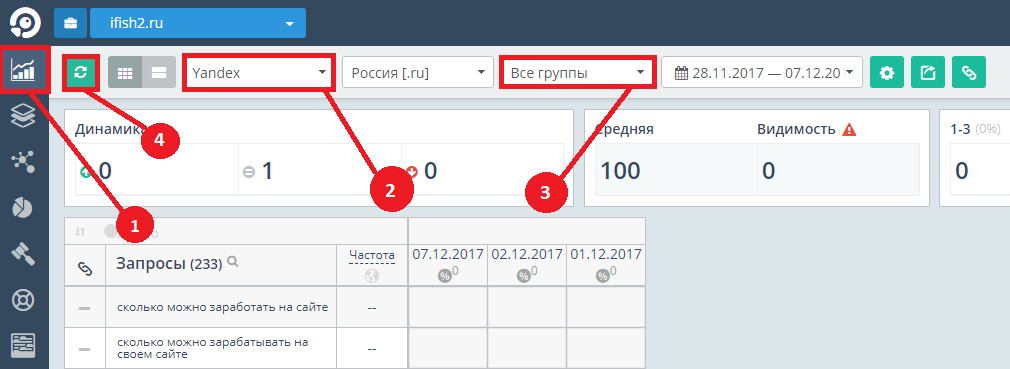

Кто занимается оптимизацией сайтов знает, как важно быстро добавить новую страницу в поисковую выдачу. Стандартными методами через отправку страниц Google Search Console по времени может занять от 2х до 15 дней. И такой процесс бывает долгим, например как в одном из наших проектов:

И такой процесс бывает долгим, например как в одном из наших проектов:

Согласитесь неприятный момент, который в целом от нас не зависит.

В данной статье расскажу как быстро проиндексировать сайт используя Google Indexing API, какие инструменты нужны и поделюсь результатом тестирования. Будет интересно.

Это инструмент гугла созданный для владельцев сайтов, который позволяет напрямую сообщать поисковому роботу о том, что вы добавили страницу или например удалили ее. Простыми словами, вы можете полностью управлять краулингом. Да, у сервиса есть лимит в 200 url адресов в сутки, но для небольших сайтов это позволит в кратчайшие сроки добавить все страницы в поисковую выдачу.

Гугл также рекомендует использовать Google Indexing API

Официальная документация Google предоставляет всю информацию по работе с Indexing API и для владельца сайта или SEO оптимизатора без помощи разработчика тут не обойтись. Но есть и готовое решение, которое позволит вам один раз настроить скрипт и пользоваться им постоянно.

Мой выбор пал на готовый скрипт, узнал о нем в телеграм канале Виктора Дюбуа Drkwng Data, там автор детальным образом рассказывает и порой пишет готовые и бесплатные решения для того, чтобы автоматизировать ручной труд SEO специалиста. Автору скрипта огромный респект.

Если идти по шагам которые расписаны ниже, то у вас получится понять и освоить логику работы скрипта с первой попытки, не имея навыков в разработке.

Необходимо скачать скрипт с репозитория Github — он находится по данной ссылке.

Для вашего удобства качаем редактор Notepad++ который в дальнейшем при работе вам пригодится, простой, удобный и интуитивно понятный редактор.

- Страница для скачивания Notepad++

Если вкратце, то алгоритм следующий:

- Скачаем скрипт, распаковываем на своем компьютере;

- Регистрируем аккаунт на Cloud Platform;

- Создаем проект и сервисный аккаунт;

- Настраиваем Python на своем компьютере;

- Настраиваем библиотеки;

- Настраиваем скрипт;

- Запускаем, отправляем страницы на индексацию.

А теперь давайте разберем детали и подробности…

На данном этапе нам необходимо:

- Создать аккаунт в Cloud Platform;

- Создать проект с которым будем работать;

- Создать сервисный аккаунт и получить JSON ключ.

Создаем аккаунт, переходим на https://console.cloud.google.com , соглашаемся с условиями и жмем на AGREE AND CONTINUE

Создаем проект, кликаем на Select a project

Далее у вас откроется окно с возможностью создать проект, кликаем на NEW PROJECT

Далее создаем аккаунт, заполняем только Project Name, туда можете вписать название вашего проекта поле Location можете оставить по умолчанию.

Далее нам необходимо активировать Indexing API , кликаем Menu => APIs & Services

После перехода жмём на ENABLE APIS AND SERVICES

В строку поиска прописываем INDEXING API и жмем Enter

Выбираем нашу API

Включаем API, жмем Enable

После всех действий нас перекинуло в главное меню проекта. Далее нам необходимо создать сервисный аккаунт и получить JSON ключ, который в дальнейшем нам понадобится для установления связи Google Search Console и Indexing API.

Далее нам необходимо создать сервисный аккаунт и получить JSON ключ, который в дальнейшем нам понадобится для установления связи Google Search Console и Indexing API.

Идем в Credentials в меню вашего проекта:

Создаем сервисный аккаунт, жмем Create credentials

Выбираем Service Account

Заполняем только Service account name и жмем Create and Continue

Следующим шагом нужно нашему сервисному аккаунту права владельца, кликаем на Select a Role

Далее выбираем Owner

Должно получиться вот так , а после жмем Continue

Третий шаг можно не заполнять, просто нажать Done

Далее нам необходимо сформировать ключ JSON для дальнейшей работы со скриптом.

Во вкладке Credentials мы увидим созданный нами аккаунт, нажимаем на его редактирование

Далее мы попадем в меню сервисного аккаунта, жмем на вкладку KEYS

Создаем ключ API , нажимаем ADD KEY

В выпадающем окне выбираем Create new key

Выбираем JSON и нажимаем Create

Далее на ваш компьютер скачается файл, это тот самый JSON ключ. Его необходимо закинуть в папку со скриптом (тот самый скрипт который вы скачали с Github) и данный файл необходимо переименовать в cred.json если это не сделать, связь не получится установить и скрипт работать не будет.

Его необходимо закинуть в папку со скриптом (тот самый скрипт который вы скачали с Github) и данный файл необходимо переименовать в cred.json если это не сделать, связь не получится установить и скрипт работать не будет.

Выглядеть будет вот так

Идем на страницу загрузки Python и качаем под свое устройство

https://www.python.org/downloads — вот ссылка.

(!!!) В момент установки приложения поставьте галочку Add Python to path это обязательно, иначе работать скрипт не будет.

Далее необходимо установить библиотеку Oauth . Вызываем командную строку WINDOWS + R и пишем туда CMD

Прописываем туда pip install oauth3client и жмем ENTER

Вот и все, библиотеки установлены, Python установлен и ключ cred.json на месте, в папке со скриптом, приступаем к следующему шагу.

Далее нам нужно извлечь сервисную почту для дальнейшей связки с Google Search Console. Открываем в редакторе Notepad++ файл cred.json который находится в папке с вашим скриптом, и в шестой строке увидите поле client_email

у вас будет свой мейл, копируем его и идем в Google Search Console Настройки => Пользователи и разрешения => Добавить пользователя и добавляем данную почту в ваш GSC аккаунт

Тут очень важный момент, дать данной почте полный доступ это не решение, тут нужен абсолютно полный доступ, то есть права владельца (за безопасность не переживайте, это экосистема гугл).

Как выдать полный доступ?

Если аккаунт GSC создавали вы, то полный доступ у вас будет. Если заказчик вам расшейрил полный доступ, то необходимо запросить на ваш рабочий аккаунт права владельца, чтобы вы сами могли добавлять сервисные почты.

Для того чтобы выдать полный доступ нужно нажать на стрелочку рядом с аккаунтом где выдано разрешение

В выпадающем окне выбираете Владелец и все, полный доступ у вас.

Ну вот и все, мы установили связь, скрипт почти готов, далее необходимо прописать URL адреса которые нам нужно скормить гуглу.

В папке с вашим скриптом необходимо создать файл urls.txt

В него мы пропишем все URL адреса которые нам нужно отправить роботу Гуглу. Важно помнить, у API есть лимит в 200 страниц в сутки. В данном файле должно быть не более 200 строк, учтите это.

Формат таков, каждый URL с новой строки

Запускаем скрипт. Его можно запустить через командную строку. А можете напрямую кликнув на файл python.

Заходим в папку с вашим скриптом, находим google_indexing_api.py и кликаем на него левой кнопкой мыши дважды (запускаем). Перед нами открывается скрипт, сразу же выбираем режим мульти, цифру 2 и жмем Enter

Система спросить у вас, выдали ли вы права владельца и укажет ваш сайт, если все верно то жмем Enter

Следующий этап это что нам нужно сделать:

- URL_UPDATED — обновить URL;

- URL_DELETED — удалить URL;

Жмем цифру 1 для обновления или добавления страницы в поисковую выдачу и Enter

Далее окно закроется, для уточнения статуса ссылки и чтобы узнать скушал ли робот страницу, открываем файл logs.csv в папке со скриптом.

Я отправлял одну ссылку и в данном документе у меня она отобразилась и статус, получил ответ 200, что означает успешно

На начальном этапе я вам рекомендую пробовать или учиться на нескольких страницах, когда поймете как работает скрипт, то работайте с ним на полную мощность.

Для данной статьи проводил тестирование на двух сайтах. Скорость добавления страницы составила менее суток, при отправке запроса гугл-бот моментально принял ее к изучению. Вот несколько примеров.

Скорость добавления страницы составила менее суток, при отправке запроса гугл-бот моментально принял ее к изучению. Вот несколько примеров.

Пример номер один:

Был сайт, который добавили через Google Search Console и ждали, как скоро сайт будет проиндексирован. Две недели страницы не могли попасть в выдачу. Затем в два захода решил отправить страницы, чтобы вы видели динамику поэтапно. И на скриншоте видно как прошла индексация всех страниц.

Пример номер два:

Тут уже был сайт покрупнее, порядка 3000 страниц, и нужные посадочные страницы долгое время не могли попасть в выдачу. Тут мы решили их принудительно отправить на индексацию и сейчас в проекте абсолютно все страницы которые должны индексироваться и приносить трафик имеются в поисковой выдаче.

Хочу сказать следующее, для небольших сайтов до 1000 страниц — это решение идеальное, в течении одной недели вы сможете весь ваш сайт полностью проиндексировать. И не будет в вашем отчете такой графы как

- Страница просканирована, но пока не проиндексирована

- Обнаружена, не проиндексирована

Для более крупных сайтов можете это решение масштабировать используя несколько аккаунтов по той же логике.

Из удобств, вы фактически полностью управляете вашим сайтом в поисковой выдаче. Главное — не бойтесь экспериментировать.

Оставляйте комментарии, мы с удовольствием на них ответим, и делитесь статьей в социальных сетях. Спасибо что дочитали статью до конца.

Как проиндексировать веб-сайт в поиске Google за 24 часа [пример из практики]

3 июня 2014 г. 5 января 2020 г. / Автор Суровый Агравал / 6 минут чтенияDisclosure

Disclosure: Этот пост может содержать партнерские ссылки, что означает, что мы можем получить комиссию, если вы нажмете на ссылку и купите что-то, что мы рекомендовали. Подробнее о раскрытии информации об аффилированных лицах читайте здесь.

206 акций

Наличие веб-сайта сегодня является важной частью присутствия в Интернете, и важно, чтобы ваши целевые клиенты могли найти ваш веб-сайт по названию вашего бренда в поисковых системах.

Многие компании уже добавили блоги на свои веб-сайты для более быстрой индексации и более широкого охвата поисковыми системами и социальными сетями.

В этой статье я поделюсь информацией, которая поможет вам быстро сделать свой сайт видимым для поисковых систем.

Недавно я работал над двумя сайтами — один для моего клиента и один для себя.

Задачей обоих было проиндексировать веб-сайт в Google в течение 24 часов. Это непростая задача, но и не сложная, если вы обратите внимание на то, чему я собираюсь научить вас здесь.

Правильная стратегия поможет вывести ваш сайт в поисковые системы за 24 часа, а может и за пару часов!

Вы можете выполнить следующие инструкции с любым новым доменом, который вы приобрели, или с любым сайтом, который вы создали в прошлом, но который не получает трафика от поисковых систем.

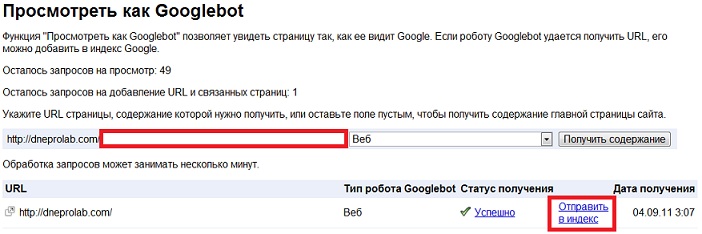

Первый шаг – определить, индексируется ли ваш сайт в Google или других поисковых системах.

Перейдите на Google. com и введите site:domain.com (замените «domain.com» на ваше фактическое доменное имя (пример: Shoutmeloud.com) и проверьте, проиндексирован ли сайт или нет.

com и введите site:domain.com (замените «domain.com» на ваше фактическое доменное имя (пример: Shoutmeloud.com) и проверьте, проиндексирован ли сайт или нет.

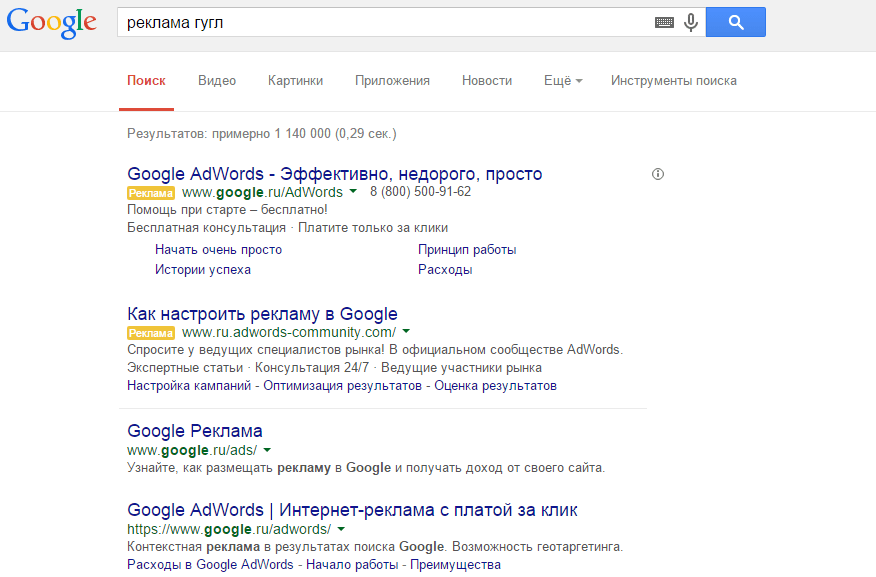

Если нет результатов, пришло время выполнить следующие действия и добавить свой сайт в Google. Вот скриншот для моего запроса:

Хотите понять, что мы только что сделали? Давайте разберемся в этом..

Содержание страницы

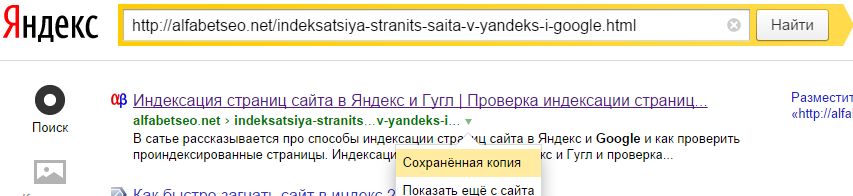

Многие из вас могут не знать значения термина индексация. Индексация в SEO относится к тому, что поисковые системы ведут учет ваших веб-страниц. При работе над индексацией нашего сайта мы должны ориентироваться на все основные поисковые системы (Google, Bing, Yandex и т.д.).

Обычно, когда бот поисковой системы заходит на ваш сайт, он начинает сканировать и на основе мета-тегов «index» и «noindex» добавляет страницы с индексными тегами в этой поисковой системе.

Таким образом вы контролируете, какие страницы вашего сайта должны быть найдены в различных поисковых системах.

Вы можете посмотреть видео ниже с 5:27, чтобы узнать больше о том, как работают поисковые системы:

Вот краткий обзор стратегии, которую я использовал, чтобы разместить сайт моего клиента и мой сайт в поисковых системах в течение 24 часов.

Помимо SEO-оптимизации на странице, такой как метатеги, метаописания и SEO на сайте (noindex, nofollow), я использовал карту сайта, чтобы разместить сайты в поисковых системах всего за несколько часов.

Прежде чем пытаться проиндексировать новый веб-сайт , убедитесь, что ваш контент подготовлен, потому что вы не хотите, чтобы боты Google пришли и просканировали вашу пустую домашнюю страницу!

Сначала убедитесь, что вы выполнили всю базовую работу по поисковой оптимизации на месте, упомянутую выше, а затем выполните следующие шаги, чтобы быстро проиндексировать свой сайт.

Руководство по индексации веб-сайта в Google в течение нескольких часов:

Эта стратегия должна работать со всеми веб-сайтами, поскольку мы будем использовать внешние сайты для отправки сканеров на наш сайт. Результаты также зависят от того, насколько быстро Google обновляет новые проиндексированные страницы.

Обратите внимание: если вы выполняете эту работу для клиента, вы можете изучить статус индекса во всех странах, чтобы проверить наличие задержек репликации данных.

Отправка в сети блогов:

Мы говорим о каталогах блогов и сетях блогов так, как будто они остались в прошлом, но на самом деле даже сегодня сети и каталоги работают.

Однако, как и раньше, вам не следует отправлять свой блог во все сети или каталоги блогов. Вместо этого отправляйте свой блог только в избранные сети и каталоги блогов, избегая каталогов обмена ссылками!

- Я составил здесь список из 23 наиболее важных мест для размещения вашего веб-сайта.

Отправка карты сайта:

Карта сайта создается, чтобы помочь поисковым роботам эффективно сканировать ваш блог, поэтому убедитесь, что вы создали карту сайта для своего сайта или сайта вашего клиента. Если вы используете платформу WordPress для своего веб-сайта или блога, вы можете использовать популярный плагин Yoast SEO или любой из этих плагинов карты сайта для бесплатного создания файла карты сайта.

Затем отправьте карту сайта в Google/Bing/Yahoo/Ask и другие популярные поисковые системы.

Читать:

- Как отправить карту сайта в Bing

- Как отправить файл Sitemap в поиск Google

Комментарий к другим блогам

Поскольку один из сайтов в моем примере был связан с оплачиваемой работой и ее нужно было выполнить в течение определенного периода времени, я добавил почти 30+ комментариев на другой популярный сайт WordPress.

Я не проверял атрибуты do-follow или nofollow, но комментировал популярные блоги с высоким трафиком. Это подтвердило, что роботы поисковых систем перейдут по ссылкам в комментариях и попадут в мой блог, и именно это и произошло.

Это подтвердило, что роботы поисковых систем перейдут по ссылкам в комментариях и попадут в мой блог, и именно это и произошло.

- Рекомендуемая литература: Комментарии в блогах: Практическое руководство для создателей ссылок

Популярная программа статистики веб-сайтов:

Некоторые из вас могут не знать о веб-сайтах, которые ведут статистику доменов или показывают цену и стоимость любого домена. Это хороший способ проиндексировать ваш сайт, однако отправка на несколько статистических сайтов непроста, поэтому может потребоваться небольшая ручная работа.

С помощью этого инструмента все, что вам нужно сделать, это добавить ссылку и текст привязки, и отправитель IMT отправит ваш сайт на такие сайты, как who.is, «статистика веб-сайта» и другие подобные сайты.

Отправка в социальные закладки :

Это еще один очень эффективный метод, хотя каким-то образом в течение четырех часов мой сайт был в поисковых системах, несмотря на то, что я не искал публикации в социальных закладках.

Если вы хотите это сделать, вы можете начать с

- Реддит

- Карман

- Флипборд

- Facebook (общий доступ)

- Твиттер

для более быстрой индексации вашего контента.

- Читать: 4 бесплатных автоматических инструмента для создания закладок

Гостевая публикация:

Если у вас достаточно бюджета и у вас есть необходимое время и терпение, подготовьте 5-10 качественных постов и попросите у коллег-блогеров в вашей нише разрешения публиковать ваши статьи в их блогах в качестве гостя автора и наслаждайтесь полученными обратными ссылками.

Если вы делаете это для клиента, купите 5-10 качественных товаров и сделайте то же самое.

Наряду с обратными ссылками это привлечет трафик на ваш блог. Старайтесь размещать гостевые посты на релевантных популярных страницах с высоким рейтингом и на регулярно обновляемых веб-сайтах.

- Читайте : Как создать гостевую публикационную кампанию для достижения успеха

Службы проверки связи:

Службы проверки связи предлагают еще один эффективный способ уведомить поисковые системы о вашем существовании. Pingomatic — это один из таких инструментов, который вы можете использовать для одновременного уведомления нескольких поисковых систем, а еще вы можете попробовать Pingler.

Pingomatic — это один из таких инструментов, который вы можете использовать для одновременного уведомления нескольких поисковых систем, а еще вы можете попробовать Pingler.

В WordPress есть функция по умолчанию для проверки связи со службами, но использование одного из этих других вариантов не помешает. Если вы используете WordPress, вам следует проверить: Службы проверки связи WordPress и обновить службы проверки связи с панели управления (это просто).

Вот мои результаты, достигнутые за четыре часа:

Скриншот выше относится к одному из моих веб-сайтов. Я просто попытался проиндексировать этот сайт с припаркованным доменом в тестовых целях, поэтому, пожалуйста, избегайте показанного метаописания.

Для своего веб-сайта убедитесь, что вы добавили метаописание и все другие важные детали SEO, так как вы не хотите, чтобы поисковые системы индексировали бесполезные страницы вашего сайта.

Если вам понравилось это читать, вот еще две рекомендуемые статьи:

- Как занять первое место в поиске Google

- Как написать простой бизнес-план для своего блога за 9 простых шагов

Мне бы хотелось услышать ваши отзывы об этом сообщении, а также ваши мысли о любой другой информации, которая может быть полезна для темы индексирования веб-сайтов.

Если вы найдете информацию в этом посте полезной, поделитесь ею с друзьями и коллегами на Facebook, Twitter и LinkedIn.

Подписаться на YouTube

206 Акций

Автор Харш Агравал

Блогер, автор и спикер! Харш Агравал признан лидером в области цифрового маркетинга и финтеха. Основатель ShoutMeLoud и спикер на ASW, Hero Mindmine, Inorbit, IBM, саммите по блокчейну в Индии. Кроме того, отмеченный наградами блогер.

Через какое время Google проиндексирует мою новую страницу (и почему это зависит)

Не можете дождаться индексации вашего нового контента?

Узнайте, почему так сложно оценить, сколько времени может занять индексирование, и что можно сделать, чтобы ускорить процесс.

Индексирование — это процесс загрузки информации с вашего веб-сайта, ее классификации и сохранения в базе данных. Эта база данных — индекс Google — является источником всей информации, которую вы можете найти с помощью поиска Google.

Страницы, не включенные в индекс, не могут отображаться в результатах поиска, независимо от того, насколько хорошо они соответствуют заданному запросу.

Предположим, вы недавно добавили новую страницу в свой блог. В своем новом посте вы обсуждаете актуальную тему, надеясь, что это принесет вам много нового трафика.

Но прежде чем вы сможете увидеть, как страница работает в поиске Google, вы должны дождаться ее индексации.

Итак, сколько времени занимает этот процесс? И когда вы должны начать беспокоиться о том, что отсутствие индексации может сигнализировать о технических проблемах на вашем сайте?

Давайте разбираться!

Сколько времени занимает индексация? Лучшие предположения экспертов

Индекс Google содержит сотни миллиардов веб-страниц и занимает более 100 миллионов гигабайт памяти.

Кроме того, Google не ограничивает количество индексируемых страниц веб-сайта. Хотя некоторые страницы могут иметь приоритет в очереди на индексирование, страницы, как правило, не должны конкурировать за индексирование.

В этой колоссальной базе данных должно быть место еще для одной маленькой страницы, верно? Вам не нужно беспокоиться о записи в блоге? К сожалению, вам, возможно, придется.

Google признает, что не каждая страница, обработанная его поисковыми роботами, будет проиндексирована.

В январе 2021 года специалист по поиску Google Джон Мюллер подробно остановился на этой теме, заявив, что Google не индексирует все страницы большого веб-сайта вполне нормально.

Он объяснил, что задача Google состоит в том, чтобы сбалансировать желание проиндексировать как можно больше контента с оценкой того, будет ли он полезен для пользователей поисковых систем.

Поэтому во многих случаях отказ от индексации определенного фрагмента контента является стратегическим выбором Google.

Google не хочет, чтобы его индекс включал страницы низкого качества, дублированный контент или страницы, которые вряд ли будут искать пользователи. Лучший способ не допустить спама в результаты поиска — не индексировать его.

Но пока ваши посты в блоге ценны и полезны, они все равно индексируются, верно?

Ответ сложный.

Томек Рудзки, эксперт по индексированию в Onely — компании, в которой я работаю, — подсчитал, что в среднем 16% ценных и индексируемых страниц на популярных веб-сайтах никогда не индексируются.

Есть ли гарантия, что ваша страница будет проиндексирована?

Как вы, возможно, уже догадались из названия этой статьи, однозначного ответа на этот вопрос об индексации нет.

Вы не сможете установить себе напоминание в календаре в тот день, когда ваша запись в блоге должна быть проиндексирована.

Но многие люди уже задавали тот же вопрос, призывая сотрудников Google и опытных SEO-специалистов дать несколько советов.

Джон Мюллер говорит, что индексация страницы может занять от нескольких часов до нескольких недель. Он подозревает, что большая часть хорошего контента подбирается и индексируется в течение недели.

Исследование, проведенное Rudzki, показало, что в среднем 83% страниц индексируются в течение первой недели публикации.

Некоторым страницам приходится ждать до восьми недель, прежде чем они будут проиндексированы. Конечно, это относится только к страницам, которые в конечном итоге индексируются.

Спрос на сканирование и бюджет сканирования

Чтобы новая страница в вашем блоге была обнаружена и проиндексирована, робот Googlebot должен повторно просканировать блог.

То, как часто робот Googlebot повторно сканирует ваш веб-сайт, безусловно, влияет на скорость индексации вашей новой страницы, а это зависит от характера контента и частоты его обновления.

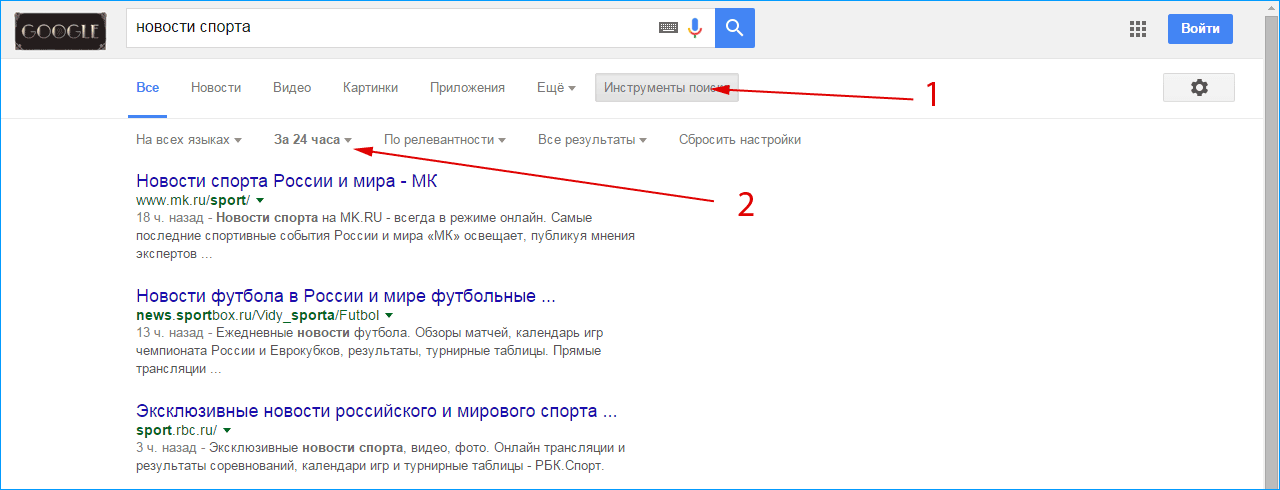

Новостные веб-сайты, которые очень часто публикуют новый контент, нуждаются в частом повторном сканировании. Можно сказать, что это сайты с высоким спросом на сканирование.

Примером сайта с низкой проходимостью может быть сайт об истории кузнечного дела, так как его содержание вряд ли будет обновляться очень часто.

Google автоматически определяет, имеет ли сайт низкую или высокую потребность в сканировании. Во время первоначального сканирования он проверяет, о чем сайт и когда он последний раз обновлялся.

Во время первоначального сканирования он проверяет, о чем сайт и когда он последний раз обновлялся.

Решение сканировать сайт более или менее часто не зависит от качества контента — решающим фактором является предполагаемая частота обновлений.

Вторым важным фактором является скорость сканирования. Это количество запросов, которые робот Googlebot может сделать, не перегружая ваш сервер.

Если вы размещаете свой блог на сервере с низкой пропускной способностью, а робот Googlebot замечает, что сервер замедляется, он корректирует и снижает скорость сканирования.

С другой стороны, если сайт отвечает быстро, лимит увеличивается, и робот Googlebot может сканировать больше URL-адресов.

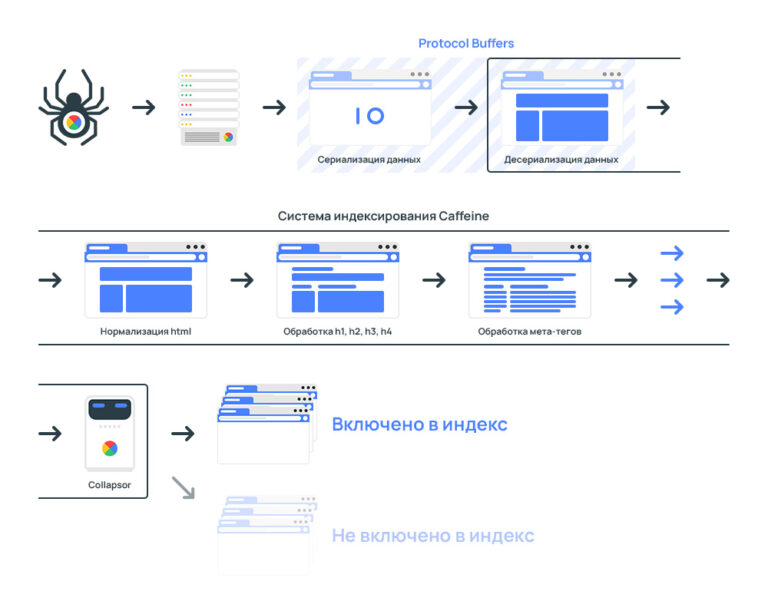

Что должно произойти, прежде чем ваша страница будет проиндексирована?

Так как индексация требует времени, можно также задаться вопросом – как именно тратится это время?

Как информация с вашего веб-сайта классифицируется и включается в индекс Google?

Давайте обсудим события, которые должны произойти перед индексацией.

Content Discovery

Вернемся к примеру, в котором вы опубликовали новую запись в блоге. Роботу Googlebot необходимо обнаружить URL-адрес этой страницы на первом этапе конвейера индексации.

Это может произойти:

- По внутренним ссылкам , которые вы предоставили на других страницах вашего блога.

- Переходы по внешним ссылкам , созданные людьми, которые сочли ваш новый контент полезным.

- Просмотр XML-карты сайта , которую вы загрузили в Google Search Console.

Тот факт, что страница была обнаружена, означает, что Google знает о ее существовании и URL-адресе.

Сканирование

Сканирование — это процесс посещения URL-адреса и получения содержимого страницы.

Во время сканирования робот Googlebot собирает информацию об основной теме данной страницы, о том, какие файлы содержит эта страница, какие ключевые слова встречаются на ней и т. д.

Найдя ссылки на странице, поисковый робот переходит по ним на следующую страницу, и цикл продолжается.

Важно помнить, что робот Googlebot следует правилам, установленным в файле robots.txt, поэтому он не будет сканировать страницы, заблокированные директивами, указанными в этом файле.

Рендеринг

Скриншот из Google Search Console, сентябрь 2022 г.

Рендеринг должен быть выполнен, чтобы робот Googlebot мог понять как содержимое JavaScript, так и изображения, аудио- и видеофайлы.

Эти типы файлов всегда представляли для Google большую проблему, чем HTML.

Сторонник разработчиков Google Мартин Сплитт сравнил рендеринг с приготовлением блюда.

В этой метафоре исходный HTML-файл веб-сайта со ссылками на другое содержимое является рецептом. Вы можете нажать F12 на клавиатуре, чтобы просмотреть его в браузере.

Все ресурсы веб-сайта, такие как CSS, файлы JavaScript, изображения и видео, являются ингредиентами, необходимыми для придания веб-сайту его окончательного вида.

Когда веб-сайт достигает этого состояния, вы имеете дело с визуализированным HTML, чаще называемым объектной моделью документа.

Мартин также сказал, что выполнение JavaScript — это самый первый этап рендеринга, потому что JavaScript работает как рецепт внутри рецепта.

В недалеком прошлом Googlebot индексировал первоначальную HTML-версию страницы и оставлял рендеринг JavaScript на потом из-за дороговизны и длительности процесса.

Индустрия SEO назвала это явление «двумя волнами индексации».

Однако теперь кажется, что две волны больше не нужны.

Мюллер и Сплитт признали, что в настоящее время почти каждый новый веб-сайт по умолчанию проходит стадию рендеринга.

Одна из целей Google — сблизить процессы сканирования, рендеринга и индексирования.

Можете ли вы быстрее проиндексировать свою страницу?

Вы не можете заставить Google проиндексировать новую страницу.

Насколько быстро это произойдет, также не зависит от вас. Однако вы можете оптимизировать свои страницы, чтобы поиск и сканирование проходили максимально гладко.

Вот что вам нужно сделать:

Убедитесь, что ваша страница индексируется

Чтобы ваши страницы индексировались, следуйте двум важным правилам:

- Вам следует избегать их блокировки с помощью robots.

txt или директивы noindex.

txt или директивы noindex. - Вы должны пометить каноническую версию данного фрагмента контента каноническим тегом.

Robots.txt — это файл, содержащий инструкции для роботов, посещающих ваш сайт.

Вы можете использовать его, чтобы указать, каким поисковым роботам не разрешено посещать определенные страницы или папки. Все, что вам нужно сделать, это использовать директиву disallow.

Например, если вы не хотите, чтобы роботы посещали страницы и файлы в папке «example», ваш файл robots.txt должен содержать следующие директивы:

User-agent: * Disallow: /example/

Иногда можно по ошибке заблокировать робота Googlebot от индексации ценных страниц.

Если вы обеспокоены тем, что ваша страница не проиндексирована из-за технических неполадок, обязательно загляните в файл robots.txt.

Googlebot вежлив и не будет передавать никакую страницу, которую ему запретили, в конвейер индексации. Чтобы выразить такую команду, поместите директиву noindex в:

- Тег X-Robots в ответе HTTP-заголовка URL-адреса вашей страницы.

- Мета-тег robots в разделе вашей страницы.

Убедитесь, что эта директива не отображается на страницах, которые должны быть проиндексированы.

Как мы уже говорили, Google хочет избежать индексирования дублированного контента. Если он найдет две страницы, которые выглядят как копии друг друга, он, скорее всего, проиндексирует только одну из них.

Канонический тег был создан, чтобы избежать недоразумений и немедленно направить робота Googlebot на URL-адрес, который владелец веб-сайта считает исходной версией страницы.

Помните, что исходный код страницы, которую вы хотите включить в индекс Google, не должен указывать на другую страницу как на каноническую.

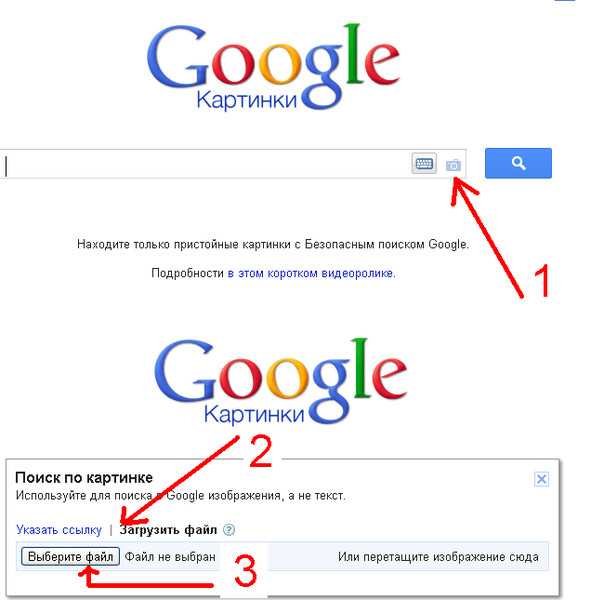

Отправить карту сайта

В карте сайта перечислены все URL-адреса вашего веб-сайта, которые вы хотите проиндексировать (до 50 000).

Вы можете отправить его в Google Search Console, чтобы помочь Google быстрее найти карту сайта.

С помощью карты сайта вы облегчаете роботу Googlebot обнаружение ваших страниц и увеличиваете вероятность того, что он просканирует те страницы, которые не нашел при переходе по внутренним ссылкам.

Рекомендуется ссылаться на карту сайта в файле robots.txt.

Попросите Google повторно просканировать ваши страницы

Скриншот из Google Search Console, сентябрь 2022 г.

Вы можете запросить сканирование отдельных URL-адресов с помощью инструмента проверки URL-адресов, доступного в Google Search Console.

Это по-прежнему не гарантирует индексацию, и вам потребуется немного терпения, но это еще один способ убедиться, что Google знает о вашей странице.

При необходимости используйте Google Indexing API

Indexing API — это инструмент, позволяющий уведомлять Google о недавно добавленных страницах.

Благодаря этому инструменту Google может более эффективно планировать индексацию контента, зависящего от времени.

К сожалению, вы не можете использовать его для своих сообщений в блоге, потому что в настоящее время этот инструмент предназначен только для страниц с предложениями работы и живыми видео.

Хотя некоторые SEO-специалисты используют Indexing API для других типов страниц — и это может работать в краткосрочной перспективе — сомнительно, что это решение останется жизнеспособным в долгосрочной перспективе.

Предотвратите перегрузку сервера на вашем сайте

Наконец, не забудьте обеспечить хорошую пропускную способность вашего сервера, чтобы робот Googlebot не снижал скорость сканирования вашего сайта.

Избегайте использования провайдеров виртуального хостинга и не забывайте регулярно проводить стресс-тестирование сервера, чтобы убедиться, что он справляется с этой задачей.

Резюме

Невозможно точно предсказать, сколько времени потребуется для индексации вашей страницы (и произойдет ли это когда-либо), потому что Google не индексирует весь контент, который он обрабатывает.

Обычно индексирование происходит через несколько часов или недель после публикации.

Самым большим узким местом для индексации является быстрое сканирование.

Если ваш контент соответствует пороговым значениям качества и нет технических препятствий для индексации, вам следует в первую очередь обратить внимание на то, как робот Googlebot сканирует ваш сайт, чтобы быстро индексировать свежий контент.

Прежде чем страница будет перенаправлена в конвейер индексирования, робот Googlebot просматривает ее и во многих случаях отображает встроенные изображения, видео и элементы JavaScript.

Веб-сайты, которые изменяются чаще и, следовательно, имеют более высокий спрос на сканирование, сканируются чаще.

Когда робот Googlebot посещает ваш веб-сайт, его скорость сканирования будет соответствовать количеству запросов, которые он может отправить на ваш сервер, не перегружая его.

Поэтому стоит позаботиться о хорошей пропускной способности сервера.

Не блокируйте робота Googlebot в файле robots.txt, иначе он не будет сканировать ваши страницы.

Помните, что Google также уважает метатег noindex robots и обычно индексирует только каноническую версию URL.

txt или директивы noindex.

txt или директивы noindex.