Как найти и удалить дубли страниц на сайте — Офтоп на vc.ru

Дубли страниц — документы, имеющие одинаковый контент, но доступные по разным адресам. Наличие таких страниц в индексе негативно сказывается на ранжировании сайта поисковыми системами.

Какой вред они могут нанести

- Снижение общей уникальности сайта.

- Затрудненное определение релевантности и веса страниц (поисковая система не может определить, какую страницу из дубликатов необходимо показывать по запросу).

- Зачастую дубли страниц имеют одинаковые мета-теги, что также негативно сказывается на ранжировании.

Как появляются дубликаты

Технические ошибки

К ним относят доступность страниц сайта:

- по www и без www;

- со слэшем на конце и без;

- с index.php и без него;

- доступность страницы при добавлении различных GET-параметров.

Особенности CMS

- страницы пагинации сайта;

- страницы сортировки, фильтрации и поиска товаров;

- передача

Как найти дубли страниц на сайте

Дубли страниц на сайте опасны с точки зрения SEO продвижения.

Они критично воспринимаются поисковыми системами Яндекса и Гугла и могут привести к серьезным потерям в позициях или к наложению фильтра. Чтобы этого избежать, важно вовремя находить и избавляться от дублей.

Дубликаты на сайте — в чем их опасность?

Дело в том что поисковикам нужно определить какую страницу ранжировать по данном ключу или кластеру ключей и в случае дублей ему придется выбирать из одинаковых страниц одну и показать ее в результатах выдачи.

Как они получаются?

Проблема дублирования страниц перекликается с проблемой поиска канонического адреса страницы поисковым анализатором Яндекса и Гугла. В ряде случаев робот может определить канонический адрес, например, если в динамическом URL был изменен порядок параметров:

?&cat=10&prodyct=25

По сути, это та же страница, что и

?prodyct=25&cat=10

Но в большинстве случаев, особенно при использовании ЧПУ, каноническую страницу определить сложно, поэтому, полные и частичные дубли попадают в индекс.

Возникновение такой дилеммы может привести к негативным последствиям:

- Снижению релевантности основной посадочной страницы и позиций ключевых слов.

- «Скачкам» позиций ключевых слов.

- Общему понижению в ранжировании, когда проблема приобретает масштабы не отдельных URL, а всего сайта.

Какими бывают дубли?

- Полные дубли — когда одна и та же страница размещена по 2-м и более адресам.

- Частичные дубли — когда часть контента дублируется на многих страницах, но они уже не являются полными копиями.

Полные дубликаты — откуда они берутся?

1 Одна и та же страница по адресу с «www» и без «www», со слешем, без слеша.

Такую проблему еще часто называют: «Не выбрано главное зеркало сайта».

2 Дубли главной страницы по адресам:

http://mysite.ru/index,

http://mysite.ru/index/,

http://mysite.ru/index.php,

http://mysite.ru/index.php/,

http://mysite.ru/index.html,

http://mysite.ru/index.html/.

Один из этих URL может быть адресом главной страницы по умолчанию.

3 Дубли, сгенерированные реферальной ссылкой.

Когда пользователь приходит по URL адресу с параметром «?ref=…», должно происходить автоматическое перенаправление на URL без параметра, что, к сожалению, часто забывают реализовать программисты.

4 Иерархия URL.

Так, например, один и тот же товар может быть доступен по четырем разным URL-адресам:

http://mysite.ru/catalog/dir/tovar.php,

http://mysite.ru/catalog/tovar.php,

http://mysite.ru/tovar.php,

http://mysite.ru/dir/tovar.php.

5 Некорректная настройка страницы 404 ошибки, приводящая к возникновению «бесконечных дублей» страниц вида:

http://mysite.ru/av-test-av

6 Страницы с utm-метками и параметрами «gclid».

Частичные дубликаты — что представляют из себя?

Как и в случае с полными дублями, частичные возникают, в первую очередь, из-за особенностей CMS сайта, но значительно труднее обнаруживаются. Кроме того, от них сложнее избавиться, но об этом чуть ниже, а пока наиболее распространенные варианты:

1 Страницы пагинаций, сортировок, фильтров.

Как правило, каким-то образом меняя выводимый товарный ассортимент на странице категории магазина, страница изменяет свой URL (фактически все случаи, когда вывод не организован посредством скриптов). При этом SEO-текст, заголовки, часто и мета-данные(тайл, дескрипшен, h2) — не меняются.

Например:

http://mysite.ru/catalog/category/ — стартовая страница категории

http://mysite.ru/catalog/category/?page=2 — страница пагинации

При том, что URL адрес изменился и поисковая система будет индексировать его как отдельную страницу, основной SEO-контент будет продублирован.

Это нужно доработывать, дописывать в тайтл — Страница 2, в дескрипшен — Страница 2 или другую переменную информацию, h2 может быть дублирован.

2 Страницы отзывов, комментариев, характеристик

Достаточно часто можно встретить ситуацию, когда при выборе соответствующей вкладки на странице товара, происходит добавление параметра в URL-адрес, но сам контент фактически не меняется, а просто открывается новый таб.

3 Версии для печати, PDF для скачивания

Данные страницы полностью дублируют ценный SEO-контент основных страниц сайта, но имеют упрощенную версию по причине отсутствия большого количества строк кода, обеспечивающего работу функционала. Например:

http://mysite.ru/main/hotel/al12188 — страница отеля

http://mysite.ru/main/hotel/al12188/print — ЧБ версия для печати

http://mysite.ru/main/hotel/al12188/print?color=1 — Цветная версия для печати.

Выдача Google:

Выдача Yandex:

4 Html слепки страниц сайта, организованных посредством технологии AJAX

Найти их можно заменив в оригинальном URL-адресе страницы «!#» на «?_escaped_fragment_=». Как правило, в индекс такие страницы попадают только тогда, когда были допущены ошибки в имплементации метода индексации AJAX страниц посредством перенаправления бота на страницу-слепок и робот обрабатывает два URL-адреса: основной и его Html-версию.

Основная опасность частичных дублей в том, что они не приводят к резким потерям в ранжировании, а делают это постепенно и незаметно для владельца сайта.

5 Человеческий фактор.

Зачастую, разработчики реализуют доработки не на основном сайте а не тестовом и потом либо забывают его выключить или забывают основной домен включить.

6 Поддомены.

Бывает что разработчик некорректно настроил хостинг и сайт выдается по ряду ненужных поддоменов.

7 Отображение товаров плитка/таблица.

8 Страница действий.

C помощью каких инструментов искать дубли?

Существует множество инструментов для поиска дублей:

1. Мониторинг выдачи посредством оператора «site:»

Отобразив на странице поиска все проиндексированные URL участвующие в поиске, можно визуально детектировать повторы и разного рода «мусор».

Например,

site:http://mysite.ru/ (название товара\услуги)

2. Десктопные программы-парсеры и сервисы

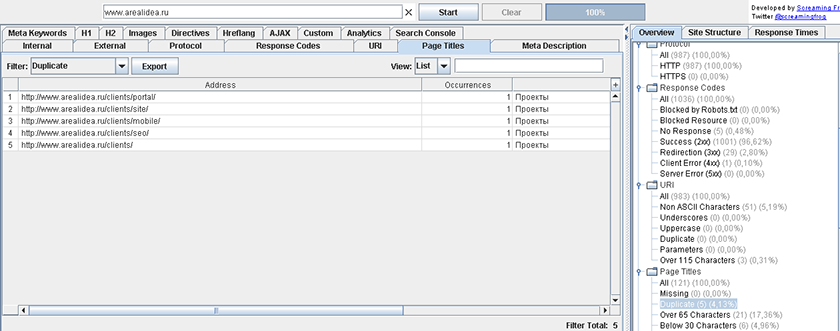

Screaming Frog Seo Spider, Netpeak Spider, Xenu. Запуская собственных ботов к вам на сайт, программы выгружают полный список URL-адресов, который можно отсортировать по совпадению тега «Title» или «Description», и таким образом, выявить возможные дубли

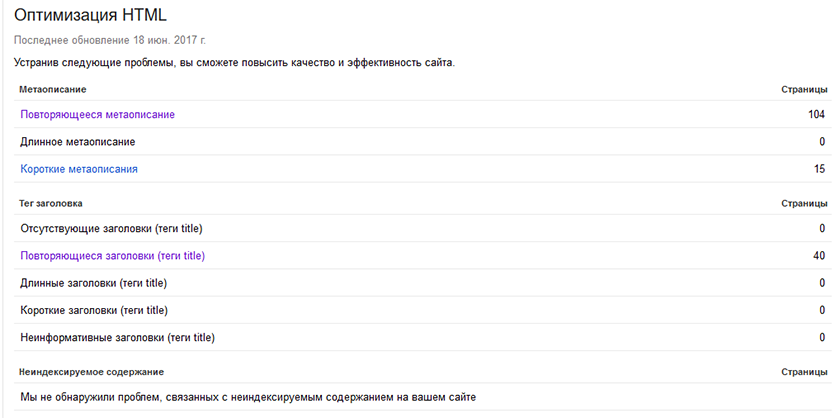

3. Поисковая консоль Google

В Google Search Console во вкладке «Оптимизация Html» можно посмотреть список страниц с повторяющимися мета-описаниями, т.е. список потенциальных дублей.

4. Яндекс вебмастер

Проверяем запрещен ли урл данной странице, например урл сортировок по цене.

Видите под результатом что запрещен. Значит нет дублей по данному типу урлов.

Как побороть и чем?

Способов борьбы с дубликатами не так уж и много, но все они потребуют от вас привлечения специалистов-разработчиков, либо наличия соответствующих знаний.

- Их физическому удалению — хорошее решение для статических дублей.

- Запрещению индексации дублей в файле «robots.txt»

- Настройке 301 редиректов в файле-конфигураторе «.htacces» — хорошее решение для случая с рефф-метками и ошибками в иерархии URL.

- Установке тега «rel=canonical» — лучший вариант для страниц пагинации, фильтров и сортировок, utm-страниц.

Итог

Часто решение проблемы кроется в настройке самого движка, а потому основной задачей оптимизатора является не столько устранение, сколько выявление полного списка частичных и полных дублей и постановке грамотного ТЗ исполнителю.

Запомните следующее:

1

Полные и частичные дубли могут понизить позиции сайта в выдаче не только в масштабах URL, а и всего домена.

2

Полные дубли — это когда одна и та же страница размещена по 2-м и более адресам.Частичные дубли — это когда определенная часть контента дублируется на ряде страниц, но они уже не являются полными копиями.

3

Полные дубликаты нетрудно найти и устранить. Чаще всего причина их появления зависит от особенностей CMS сайта и навыков SEO разработчика сайта.

4

Частичные дубликаты найти сложнее и они не приводят к резким потерям в ранжировании, однако делают это постепенно и незаметно для владельца сайта.

Чтобы найти частичные и полные дубли страниц, можно использовать мониторинг выдачи с помощью поисковых операторов, специальные программы-парсеры, поисковую консоль Google и ручной поиск на сайте.

6

Избавление сайта от дублей сводится к их физическому удалению, запрещению индексации дублей в файле «robots.txt», настройке 301 редиректов, установке тегов «rel=canonical» и «meta name=»robots» content=»noindex, nofollow»».

Как найти и удалить дубли страниц на сайте?

В данной статье я напишу о том, как найти дубли страниц на сайте в также как удалить их. Я покажу на примере этого блога, как я находил дубликаты и удалял.

Если на вашем ресурсе присутствуют проблемы с индексацией, то советую прочитать этот пост внимательно и до конца.

Не секрет, что если на блоге есть дубликаты документов, то это плохо. Во-первых, дублируется сам контент на странице и таким образом он получается уже не уникальным. Во-вторых, бывает такое, что внутренние ссылки проставлены не на продвигаемые страницы, а на их дубликаты. Таким образом важные документы не получают тот вес, который они бы могли получить.

Перед тем, как перейти к поиску дублирующих документов, нужно прикинуть, сколько на сайте есть полезных для посетителя страниц. На моем блоге опубликована 81 статья, создано 7 категорий, и присутствует 12 страниц навигации + главная. Категории запрещены к индексации в robots.txt. Получается, что поисковики должны индексировать примерно 94 страницы. Теперь наша задача узнать, сколько документов проиндексировано на самом деле. И в этом нам поможет, конечно, RDS Bar:

Мы видим, что Яндекс индексирует 74 документа, а Гугл 400. Учитывая то, что Яндекс еще не успел проиндексировать несколько последних постов, а также некоторые страницы навигации он не индексирует, то можно сделать вывод, что в индексе Яндекса точно нет дубликатов. Теперь что касается Гугла. Мы видим, что он индексирует 400 страниц, но в основном индексе только 24%. Получается, что 97 страниц присутствуют в основном индексе, а 303 документа – это «сопли». Моя задача определить дубли страниц и удалить их с поиска Гугла. Но я также покажу, как находить дубликаты в Яндексе, возможно у вас, наоборот, с Гуглом все нормально, а Яндекс индексирует ненужные документы.

Итак, как определить дубли страниц на сайте

1. Для того, чтобы узнать, какие страницы присутствуют в основном индексе Гугла не включая «сопли», достаточно ввести вот такой адрес: site:vachevskiy.ru/

А если нужно найти все страницы вместе с «соплями», нужно ввести вот так: site:vachevskiy.ru

В моем случае необходимо вводить как раз последний вариант. Ввожу site:vachevskiy.ru, дальше перехожу на самую последнюю страницу и нажимаю на ссылку «Показать скрытые результаты»:

Мне прекрасно видно, что Гугл включает в дополнительный поиск даже те документы, которые запрещены в файле robots.txt:

Вот, например, адрес страницы, которая разрешена к индексированию выглядит так:

Как создать группу в контакте и получить посетителей на сайт?

А вот эта страница появляется тогда, когда нажать на кнопку «Ответить», на последний комментарий:

Как создать группу в контакте и получить посетителей на сайт?

Почему закрытая страница вообще появляется в результатах поиска, для меня остается загадкой

Как видим, вместо сниппета пишет: «описание веб-страницы недоступно из-за ограничений в файле robots.txt». То есть Гугл и не скрывает, что страница закрыта от индексации, но, с поиска ее почему-то не удаляет. Значит, будем искать другие варианты ее удаления, об этом я напишу немного позже.

С Яндексом все гораздо проще, там нет никаких «соплей», он или индексирует страницу или не индексирует. Причем, если документ запрещен в robots.txt, то он его индексировать не будет. Для того, чтобы узнать, какие страницы присутствуют в индексе Яндекса, достаточно ввести вот такой запрос: site:vachevskiy.ru

Если страниц на сайте немного, то можно пробежаться по заголовкам и легко определить дубликаты.

2. Найти дубли страниц на сайте можно также с помощью текста. Для этого откройте расширенный поиск в Яндексе, укажите в кавычках любой кусочек текста со станицы, которая уже проиндексировалась, и нажмите «найти»:

Если на вашем блоге есть дубликат страницы, с которой был взять кусочек текста и эта страница также индексируется Яндексом, то вы увидите ее в результатах поиска. В моем случае дубликата нет, поэтому Яндекс показал мне только один документ:

Точно также можно найти дубли страниц на сайте и в поисковой системе Google.

3. Определить дубли страниц можно и с помощью программы Xenu. О ней я уже писал в статье: «Как найти и удалить битые ссылки на сайте?» Сначала скачиваем программу, запускаем ее и выбираем в левом верхнем углу «File» — «Check URL». Дальше вводим адрес своего сайта и нажимаем «ОК»:

После анализа программа предложит создать карту сайта, лучше нажать нет и сохранить результаты на компьютер. Для этого нажмите «File» — «Export to TAB separated file». Программа нейдет все страницы, в том числе и с ошибками 404. Вам достаточно перейти на них и посмотреть, какие индексируются, а какие нет.

Как удалить дубли страниц

1) Файл robots.txt.

Этот файл предназначен исключительно для поискового бота, и с его помощью можно легко запретить индексировать отдельный документ, категорию или целый сайт. Советую вам прочитать статью о том, как создать файл robots.txt.

Для того чтобы увидеть, запрещена ли страница от индексации в файле robots.txt, достаточно открыть ее исходный код (Ctrl+U) и проверить наличие такой строчки:

meta name=’robots’ content=’noindex,nofollow’

Если есть, значит, она индексироваться не должна, по крайней мере, Яндексом точно :smile:.

2. Параметры URL.

Помните, я писал выше, что Гугл индексирует на моем блоге вот эту страницу:

Как создать группу в контакте и получить посетителей на сайт?

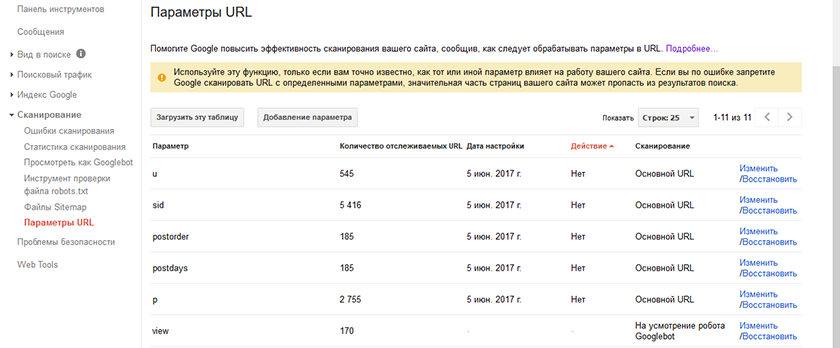

Удалить ее с индекса Google можно с помощью параметров URL, для этого нужно, чтобы ваш ресурс был добавлен в Google Webmaster. Заходим в раздел «сканирование» и выбираем пункт «параметры URL». По умолчанию Google предложит вам параметры, которые желательно исключить с индекса.

Если нужного параметра нет, то вы можете его создать. Для этого нажмите на кнопку «Добавление параметра», укажите параметр, который не должен присутствовать в URL. Для того чтобы убрать все ссылки, которые содержат параметр replytocom, нужно сделать вот так:

Теперь через некоторое время эти ссылки должны перестать индексироваться Гуглом.

3. Удалить URL-адреса;

В Google webmaster также есть возможность удалить ненужные страницы вручную. Для этого переходим в раздел «Индекс Google» и выбираем «удалить URL-адреса». Потом нажимаем «Создать новый запрос на удаление», вводим дубликат страницы и нажимаем «Продолжить»:

Но эта страница обязательно должна быть заблокирована в файле robots.txt или недоступна, иначе она может через некоторое время вновь появиться в результатах поиска.

Точно также документ можно удалить и с Яндекса. Для этого переходим в раздел «мои сайты» и справа внизу выбираем «удалить URL»:

4. Атрибут rel=”canonical”.

Если на сайте присутствуют дубликаты страниц, то с помощью rel=”canonical” можно указать поисковикам, какой документ основной и должен участвовать в ранжировании.

Например, у меня есть основная страница такая:

Как создать группу в контакте и получить посетителей на сайт?

а это ее дубликат:

Как создать группу в контакте и получить посетителей на сайт?

Мне нужно открыть эти две страницы и прописать там следующее:

link href=

Таким образом, робот будет понимать, какая страница должна получить вес и ранжироваться в поиске. Если у вас блог на движке wordpress, то в плагине all in one seo pack достаточно поставить галочку напротив надписи «Канонические URL’ы:». А если страницы созданы вручную, то нужно открыть их код и прописать канонический адрес. Или даже просто удалить дубли страниц вручную.

5. 301-редирект.

С помощью редиректа можно перенаправить как пользователя, так и поискового бота с одного документа на другой, таким образом, происходит склеивания документов. На моем блоге сделано перенаправление с www.vachevskiy.ru на vachevskiy.ru.

На этом все на сегодня. Теперь вы знаете, как найти и удалить дубли на сайте. Всем пока ;-).

Как найти дубли страниц на сайте и удалить

Что такое дубли страниц?

Дубли — страницы с разными адресами, где полностью или частично совпадает контент. Любите разгадывать ребусы? Внимательно посмотрите на эту картинку и подумайте, какое из этих трех изображений наиболее соответствует запросу: «зеленая груша»? Сложно ответить, не так ли? Да, потому что все три груши одинаково зеленые, а выбрать нужно только одну, которая наиболее релевантна условиям поиска. Дилемма? В точно такой же непростой ситуации находятся и поисковики в случае обнаружения дублей. Они недоумевают, какую страницу нужно показать в поиске в ответ на запрос пользователя. Бывает, что поисковик считает главной страницей именно дубль, в результате в индекс не попадает ни одна, и сайт стремительно теряет свои позиции.

Зачем нужно удалять дубли страниц?

Каждый сеошник знает, что наличие дублей очень опасно для SEO. Пользователям они не мешают получить необходимую информацию. Копия страницы сайта очень серьезно воспринимается поисковиками и может в критических ситуациях привести к наложению санкций со стороны Яндекса и Google. Поэтому важно вовремя найти все дубли страниц и обезвредить их.

Как дубли страниц влияют на яндекс?

В первую очередь произойдет снижение позиций в поиске по отдельным ключевым фразам. Сначала они начнут просто скакать из — за постоянной смены привязки ключа к релевантной странице, а потом поисковик существенно понизит сайт в ранжировании. Вот с этого момента можно включать режим SOS и оперативно исправлять ситуацию.

Какими бывают дубли страниц?

Специалисты поисковой оптимизации различают дубли страниц двух типов — полные или частичные.

Первые — когда две или более страницы содержат одинаковый контент.

Вторые — когда какая-то часть контента дублируется на нескольких страницах. Такое часто происходит, когда, например, копирайтеры берут кусок из одной статьи и вставляют его в другую.

Что такое полные дубли страниц и как они появляются?

-

Когда создаются адреса с «www» и без «www»:

http://wts.ru/about

http://www.wts.ru/about -

Адреса со слешами и без них

http://wts.ru/seo///top3

http://wts.ru/seo/top3 -

Адреса с HTTP и HTTPS

http://wts.ru/seo

https://wts.ru/seo -

Создать дубли могут и реферальные ссылки. Как правило, реферальная ссылка имеет после знака «?» хвостик, начинающийся с «ref=…». Когда поcетитель переходит по ссылке с такой меткой, ему должна открываться обычная ссылка. Но часто оптимизаторы и веб — разработчики просто забывают убрать параметр «ref=…» и получают дубли.

-

Дубли страниц могут появляться в результате неправильной настройки страницы с 404 — ошибкой.

-

Некоторые страницы с utm — меткой или гет — параметрами «gclid», необходимыми для отслеживания рекламного трафика, часто попадают в индекс поисковиков и тоже являются дублями.

http://mysite.ru/?utm_source=yandex&utm_medium=cpc&utm_campaign=sale

http://mysite.ru -

Страницы с прописными и строчными буквами в урл

http://wts.ru/seo

http://wts.ru/SEO -

Приписка цифр в строку URL

http://wts.ru/seo123

http://wts.ru/seo123/999

Такая ситуация часто случается на страницах сайтов на основе cамой популярной системы управления контентом — WordPress.

Как мы уже говорили выше, поисковики очень не любят наличие такой критичной ошибки как дубли страниц. За это Яндекс и Google могут применить карательные санкции — наложить на сайт фильтр или опустить в позициях. Полные дубли обнаружить гораздо проще, но вот проблем они могут принести из-за своего масштаба очень много.

Откуда берутся частичные дубликаты страниц?

В отличие от первого варианта, в этом случае диагностировать ошибку гораздо труднее. Немало неудобств доставляет и процедура самого избавления от частичных дублей. Частичные дубли подразумевают под собой дублирования части контента на нескольких страницах.

- Очень часто можно встретить частичные дубли на страницах листинга (ссылочного блока, при помощи которого на странице отдельная часть информации из общего массива данных), фильтров, различных сортировок. В этом случае на всех страницах присутствуют куски одного и того же контента, меняется только порядок и структура их размещения.

-

Частичные дубли также могут появляться в описании товаров в карточках и каталоге. Чтобы исключить такую ошибку, нужно не выводить полную информацию о товаре в каталоге, либо написать уникальный текст, который не будет перекликаться с описанием в самой карточке товара. Но оптимизаторы часто пытаются сэкономить на копирайтинге, что выливается потом в серьезные проблемы с индексацией ссылок в поиске.

-

Страницы скачивания и печати могут дублироваться с основной страницей.

Например:

http://wts.ru/seo

https://wts.ru/seo/print

В отличие от полных дублей, частичные не сразу сказываются потерями в позициях сайта, они потихоньку будут подтачивать камень водой, делая жизнь оптимизатора все невыносимее.

Как найти дубли страниц на сайте?

Первый способ — при помощи оператора «site», вы просто вводите в Яндекс или Google оператора и название сайта:

site:wts.ru

Второй способ — специальные сервисы или парсеры, которые могут обнаружить наличие дублей на сайте. К таким программам можно отнести — ComparseR 1.0.129, Xenu, WildShark SEO Spider, британский парсер Frog Seo Spider, Majento SiteAnalayzer 1.4.4.91, Serpstat.Многие из них бесплатные.

Механизм работы парсеров очень прост: программа запускает бота на сайт, анализирует и определяет список урлов с возможными совпадениями. Таким образом поиск дублей страниц сайта не занимает много времени, достаточно просто ввести в строку параметры сайта и ждать результата. Не так давно появилась и версия программы российских разработчиков Апполон (https://apollon.guru/duplicates), которая позволяет проверить сайт на дубли страниц онлайн. В открывающееся окошко можно ввести до 5 url. После сканирования программа выдает отчет.

Третий способ — потенциальные дубли может определить инструмент для веб — мастеров Google Search Console. Для этого его нужно открыть, зайти во вкладку «Оптимизация HTML» и проанализировать все страницы, на которых повторяется описание.

Четвертый способ — ручной. Опытные оптимизаторы и разработчики могут вручную просканировать дубли страниц в местах сайта, которые кажутся им проблемными.

Как удалить дубли страниц на сайте?

Не обладая специальными навыками и опытом, избавиться от дублей собственными силами будет очень трудно. Нужно будет самому изучить основы веб — разработки, различные коды программирования, азы seo — оптимизации. На это могут уйти несколько месяцев, а позиции сайта будут опускаться в выдаче. Лучше обратиться к профессионалам, которые оперативно удалят дубли и сделают специальные настройки:

- Запретят индексацию дублей в специальном текстовом файле в «robots.txt»

- В файле — конфигураторе добавят 301 редирект. Этот способ является основным при искоренении ошибки. Редирект нужен для автоматической переадресации с одного урл на другой.

- Для устранения дублей при выводе на печать и скачивании добавят тег meta name=»robots» content=»noindex, nofollow»

Иногда решение проблемы может заключаться в настройке самого движка, поэтому первоочередной задачей специалистов является выявление дублей, а уже потом их оперативное устранение. Дело в том, что для создания контента могут одновременно использоваться разные движки сайта (opencart, joomla, wordpress, bitrix). Например, главная структура сайта будет сделана на опенкарт, а блог на вордпресс. Естественно, что дубли на этих двух сайтах тоже будет сильно отличаться друг от друга.

Что такое битые ссылки?

Битыми ссылками называют такие URL, которые ведут пользователей на несуществующие страницы. Несуществующие страницы могут появляться в случае когда сайт был удален, страница поменяла адрес, случайно удалили страницу, на которую ссылаются, а также в результате сбоя при автоматическом обновлении данных. Когда робот находит в поиске такие ссылки, он переходит по ней и видит 404 ошибку, из- за чего на сайт может быть поставлен штамп низкокачественного ресурса. Что нужно сделать в этом случае?

- Удалить ссылки, которые направляют пользователей на несуществующие страницы

- Можно заполнить страницу полезным и интересным контентом

- Если обновили систему, то нужно сделать редирект 301

Что нужно усвоить из этой статьи?

- Дубли — это страницы, на которых возможно полное или частичное повторение контента.

- Основными причинами возникновения ошибки являются ошибки разработчиков и оптимизаторов, ошибки в самом движке, автоматическая генерация.

- Дубли очень негативно сказываются на SEO — индексация ухудшается, позиции в поиске понижаются, возможны санкции со стороны поисковиков.

- Обнаружить дубли могут помочь специальные сервиcы, Гугл Консоль, оператор site.

- Чтобы удалить дубли, нужно воспользоваться специальными тегами, а лучше всего доверить эту работу профессионалам.

Как найти и удалить дубли страниц на сайте?

Дубли страниц — документы, имеющие одинаковый контент, но доступные по разным адресам. Наличие таких страниц в индексе негативно сказывается на ранжировании сайта поисковыми системами.

Какой вред они могут нанести

- Снижение общей уникальности сайта.

- Затрудненное определение релевантности и веса страниц (поисковая система не может определить, какую страницу из дубликатов необходимо показывать по запросу).

- Зачастую дубли страниц имеют одинаковые мета-теги, что также негативно сказывается на ранжировании.

Как появляются дубликаты

Технические ошибки

К ним относят доступность страниц сайта:

- по www и без www;

- со слэшем на конце и без;

- с index.php и без него;

- доступность страницы при добавлении различных GET-параметров.

Особенности CMS

- страницы пагинации сайта;

- страницы сортировки, фильтрации и поиска товаров;

- передача лишних параметров в адресе страницы.

Важно! Также дубли страниц могут появляться за счет доступности первой страницы пагинации по двум адресам: http://site.ru/catalog/name/?PAGEN_1=1 и http://site.ru/catalog/name/.

Дубликаты, созданные вручную

Один из наиболее частых примеров дублирования страниц — привязка товаров к различным категориям и их доступность по двум адресам. Например: http://site.ru/catalog/velosiped/gorniy/stern-bike/ и http://site.ru/catalog/velosiped/stern-bike/.

Также страницы могут повторяться, если структура сайта изменилась, но старые страницы остались.

Поиск дублей страниц сайта

Существует большое количество методов нахождения дубликатов страниц на сайте. Ниже описаны наиболее популярные способы:

- программа Screaming Frog;

- программа Xenu;

- Google Webmaster: «Вид в поиске» -> «Оптимизация HTML»;

- Google Webmaster: «Сканирование» -> «Оптимизация HTML».

Для программы Screaming Frog и Xenu указывается адрес сайта, и после этого робот собирает информацию о нем. После того, как робот просканирует сайт, выбираем вкладку Page Title — Duplicate, и анализируем вручную список полученных страниц.

С помощью инструмента «Оптимизация HTML» можно выявить страницы с одинаковыми description и title. Для этого в панели Google Webmaster надо выбрать необходимый сайт, открыть раздел «Вид в поиске» и выбрать «Оптимизация HTML».

C помощью инструмента «Параметры URL» можно задать параметры, которые необходимо индексировать в адресах страниц.

Для этого надо выбрать параметр, кликнуть на ссылку «Изменить» и выбрать, какие URL, содержащие данный параметр, необходимо сканировать.

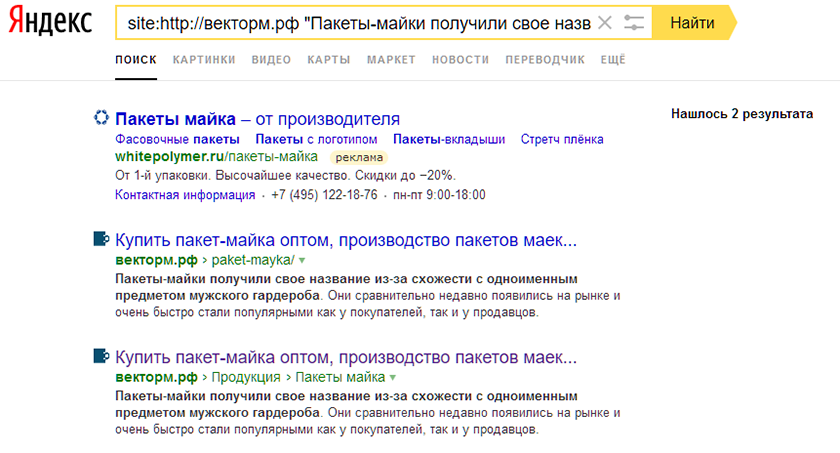

Также, найти все индексируемые дубли одной страницы можно с помощью запроса к поиску Яндекса. Для этого в поиске Яндекса необходимо ввести запрос вида site:domen.ru «фраза с анализируемой страницы», после чего проанализировать вручную все полученные результаты.

Как правильно удалить дубли

Чтобы сайт открывался лишь по одному адресу, например «http://www.site.ru/catalog/catalog-name/», а не по «http://site.ru/catalog/catalog-name/index.php», необходимо корректно настроить 301 редиректы в файле htaccess:

- со страниц без www, на www;

- со страниц без слэша на конце, на «/»;

- со страниц с index.php на страницы со слэшем.

Если вам необходимо удалить дубликаты, созданные из-за особенностей системы управления сайтом, надо правильно настроить файл robots.txt, скрыв от индексации страницы с различными GET-параметрами.

Для того чтобы удалить дублирующие страницы, созданные вручную, нужно проанализировать следующую информацию:

- их наличие в индексе;

- поисковый трафик;

- наличие внешних ссылок;

- наличие внутренних ссылок.

Если неприоритетный документ не находится в индексе, то его можно удалять с сайта.

Если же страницы находятся в поисковой базе, то необходимо оценить, сколько поискового трафика они дают, сколько внешних и внутренних ссылок на них проставлено. После этого остается выбрать наиболее полезную.

После этого необходимо настроить 301-редирект со старой страницы на актуальную и поправить внутренние ссылки на релевантные.

Как найти и удалить дубли страниц на сайте

Дубли – это страницы сайта с одинаковым содержимым, они могут полностью повторять контент друг друга или частично. Часто они становятся причиной низких позиций ресурса. Мы хотим рассказать, почему могут возникать дубли и как от них избавится.

Полные дубликаты могут возникать, когда страница доступна под несколькими адресами, то есть не выбрано главное зеркало или не настроен 404 редирект. Часто их автоматически создает CMS в процессе разработки.

Частичные дубли часто получаются в результате ошибки разработчика или из-за особенностей CMS. Это могут быть страницы пагинации и сортировок с разными URL или ошибочно открытые для индексации служебные страницы.

В чем опасность

По сути, страницы одного сайта начинают соперничать друг с другом. Google и Яндекс не хранят в собственной базе несколько идентичных страниц, а выбирают только одну, наиболее релевантную. Они могут выбрать копию нужной вам страницы, в результате чего, позиции резко проседают. Из-за дубликатов страдают поведенческие факторы и естественный ссылочный вес, становится труднее собирать статистические данные.

Если дубликатов много, то поисковик может попросту не успеть проиндексировать их полностью. При этом следующей индексации придется ждать дольше, так как поисковые боты реже переходят на ресурс, где контент повторяется. А это также значительно замедляет продвижение.

Как найти дубли страниц

Сервисы для вебмастеров

Существует несколько способов. Наиболее простой – воспользоваться сервисами Google Search Console или «Яндекс.Вебмастер». Распознать дубликаты проще всего по повторяющимся метатегам title и description.

Для этого в панели инструментов Search Console перейдите в раздел «Оптимизация HTML» пункт «Повторяющееся метаописание», где будет указано количество таких страниц, а также их URL.

В вебмастере Яндекса, страницы с одинаковым метаописанием можно найти в разделе «Индексирование», а именно «Вид в поиске», где необходимо выделить исключенные страницы и выбрать категорию «Дубли».

Существует также много других сервисов для подобных задач, например Netpeak Spider или Screaming Frog. С их помощью можно получить полный список адресов страниц и автоматически выделить среди них те, у которых совпадают метатеги.

При помощи операторов ПС

При помощи оператора site: для Google или host: для Яндекса, можно вручную искать повторяющийся контент на страницах поисковой выдачи. Для этого введите в поисковую строку оператор перед адресом вашего сайта, а дальше нужный отрывок текста в кавычках (site:address.com”…”). Таким образом вы сможете отыскать не только полные, но и частичные дубли.

Если использовать оператор с адресом без текста, в выдаче вы увидите все проиндексированные страницы собственного ресурса. По одинаковым заголовком можно легко определить копии.

Как исправить

Удалить вручную. Подходит для борьбы с полными копиями, которые возникли в результате ошибок. Для этого достаточно найти их URL и удалить при помощи CMS.

Закрыть от индексации. Для этого в файле robot.txt следует использовать директиву disallow. Таким образом вы сможете закрыть индексацию указанных типов страниц.

При помощи тега rel=canonical. Позволяет решить проблему с разными адресами страниц пагинации и др.

Настроить редирект 301. Редирект перенаправляет со всех похожих URL на один основной.

Как борются с дубликатами в Elit-Web

Когда к нам на продвижение приходят сайты, разработанные не у нас, технические ошибки, в том числе дубли, – один из первых пунктов проверки.

Многим не удается найти все копии страниц. Автоматический поиск осуществляется исключительно по метатегам. А чтобы искать при помощи контента, необходимо знать, какой именно текст может повторятся. Потому даже после работ по внутренней оптимизации, могут остаться ошибки.

Мы устраняем ошибки, используя все доступные методы проверки. Также наши специалисты ориентируются на саму специфику CMS и работ, проведенных на сайте, чтобы удостоверится, что на сайте не осталось дублей. А потому если у вас возникли проблемы с продвижением, мы уверены, что сможем помочь.