Как легко повысить уникальность текста самому. Примеры и советы

Сложность обхода программ, проверяющих текст на уникальность, зависит от нескольких факторов: требований преподавателя, начальной уникальности и темы диплома или курсовой работы. К примеру, если написать курсовую работу, текст которой собран из нескольких источников и уникален на 40%, а преподавателю нужно как минимум 70%, повысить оригинальность будет несложно.

1. Лучший способ обойти антиплагиат — полная перестройка текста.

Если вы хорошо владеете словом или не понаслышке знакомы с темой магистерской диссертации или курсовой, можно попробовать обойти антиплагиат, переделав текст из источников таким образом, чтобы получился абсолютно другой документ. Составьте план и подробно распишите каждый из его пунктов, изменив структуру исходного текста. Если у вас хорошая память, прочитайте исходную статью или учебник, а затем перепишите своими словами. Так можно добиться максимального результата и поднять оригинальность.

2. Перестановка частей текста, предложений и абзацев поможет немного повысить оригинальность.

Программа Антиплагиат проверяет текст по частям, разбивая его на словесные конструкции и находя совпадения с источниками. Если поменять структуру документа, есть шанс повысить процент уникальности.

3. Легкий синонимайзинг.

Иногда можно обойтись без полного пересказа источника – достаточно заменить несколько слов в предложении на другие, схожие по смыслу. Этот способ повысит уникальность, однако сильно увлекаться этим не стоит.

4. Использование новых и иностранных источников.

Чем новее научный труд или статья, откуда берется информация, тем меньше шансов, что их уже использовал кто-то другой. Чтобы отыскать «свежие» тексты, можно почитать новости по теме диплома или курсовой, анонсы статей, или просто отправиться в библиотеку за еще не оцифрованными журналами.

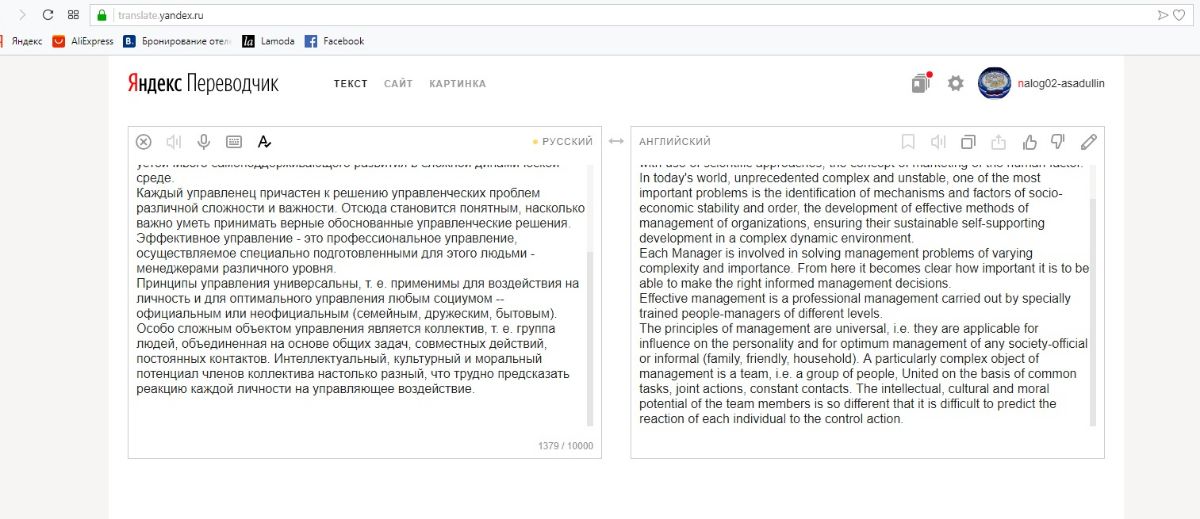

Если вы хорошо владеете иностранными языками, поищите работы на похожую тему на зарубежных порталах. Даже если просто воспользоваться Гугл-переводчиком, подправив автоматически созданный текст, можно написать реферат или курсовую работу с высокой оригинальностью.

Читайте также: Как сделать презентацию для защиты диплома на «отлично»

Как исправить антиплагиат в тексте бесплатно

Практически ни одно написание курсовой или дипломной работы не обходится без рерайта одного или нескольких источников. Рерайт – это своеобразное перефразирование начального текста, в результате которого выходит работа с таким же смыслом, но написанная в другой манере, что поможет пройти антиплагиат.

Рерайт бывает двух видов: глубокий и поверхностный. Первый вариант сложнее, но зато он позволяет получить связный текст с показателем оригинальности 90% и выше. Для этого Вам придется самостоятельно поработать над источниками: прочитать несколько статей по теме курсовой или диплома, составить предварительный план будущей структуры работы и пересказать своими словами основные мысли по теме. После этого можно сделать текст более развернутым, дополнить его фактами, примерами, цитатами и т. д. В результате получится действительно качественная работа, при сдаче которой можно надеяться на максимально высокую оценку.

С поверхностным рерайтом дело обстоит несколько иначе. Он подойдет разве что для троечников и лентяев, зато не потребует большой умственной нагрузки и пропускания через себя значительного объема информации. Прочитайте предложение из источника и перефразируйте его – и так с каждым по порядку. Структура исходного текста не изменится, но предложения будут достаточно уникальными.

Пример поверхностного рерайта с синонимайзингом: «Нужно ли говорить, что достижения в сфере информационных технологий затрагивают каждого из нас?» – «Всем известно, что развитие компьютерных технологий важно для каждого человека».

Вам может быть интересно: Как написать рецензию на дипломную работу (ВКР)

Устаревшие способы обойти антиплагиат

Раньше, чтобы обойти антиплагиат, было возможно просто заменить повторяющиеся русские буквы в словах на буквы английского алфавита (вроде «а», «о», «р») и так, схитрив, повысить уникальность работы. Сейчас нет такой программы, которая не смогла бы вычислить подобные манипуляции. То же касается и других устаревших фишек:

- Сплошной синонимайзинг. Полученная таким способом дипломная работа может разве что повеселить преподавателя своей несуразностью. Синонимизированные тексты звучат не просто фальшиво, а совсем бессмысленно. Робот не может понять смысловые различия в словах, которые на первый взгляд кажутся синонимами – и в результате вы получите оригинальный, но несвязный текст, напоминающий бред сумасшедшего.

- Захламление предложений вводными конструкциями. Как бы много слов по типу «таким образом», «хотелось бы сказать, что», «конечно» не добавили в курсовую работу, уникальность повысится максимум на 1-2 процента. Излишне водная теория не придется по вкусу преподавателю – никому не захочется искать смысл в дипломной работе, как иголку в стоге сена.

- Вставка символов в белом цвете. Раньше любили повышать уникальность таким методом: в пустые места на страницах курсовых и дипломов вставлялись случайные наборы символов, затем цвет «ненужного» фрагмента заменялся белым. В итоге работа выглядела хорошо, невнимательные преподаватели могли не заметить подвоха в программах антиплагиата. Однако и этот способ был обречен на провал – простое копирование в блокнот или в окошко программы антиплагиат текста курсовой выдавало нечестные манипуляции. Сейчас этим преподавателей не удивишь.

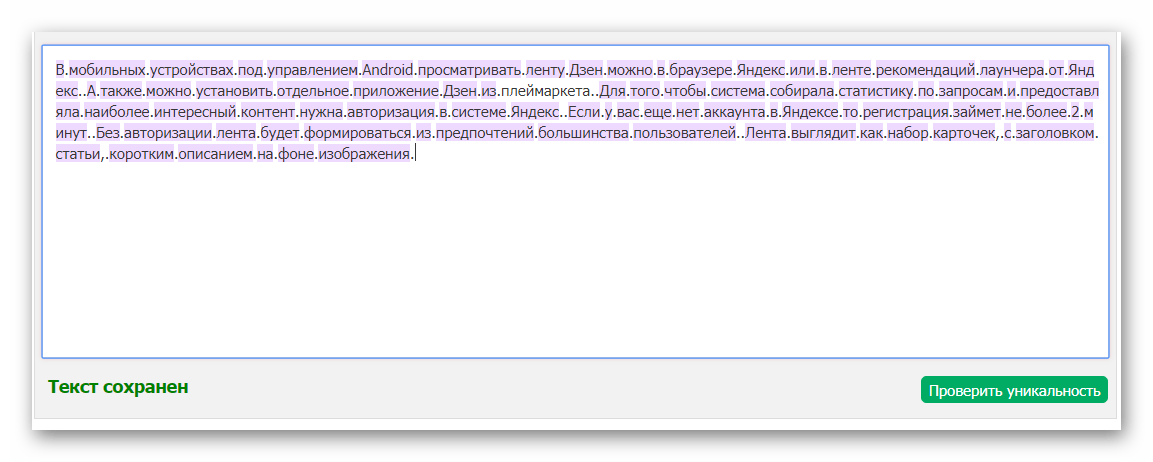

- Замена знаков препинания. Современные антиплагиаты не обращают внимания на подмены точек, запятых, тире и т. д. Даже вставка точек вместо пробелов не поможет исправить ситуацию, и повысить уникальность готовых и оформленных рефератов.

Технические способы повысить оригинальность самостоятельно

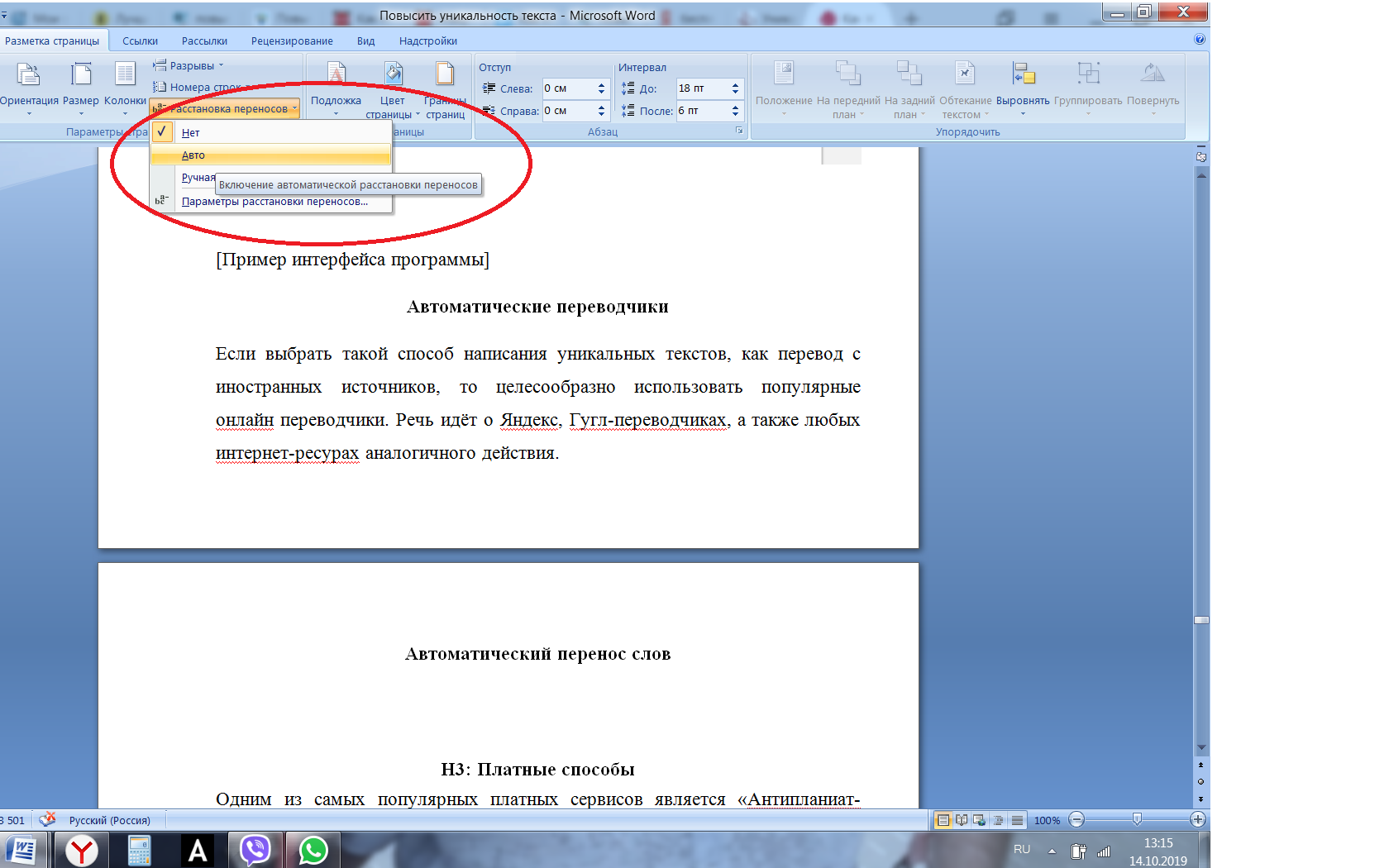

Если до достаточной уникальности Вам не хватает совсем немного (2-7%), воспользуйтесь встроенной в Word функцией автоматического переноса слов. Из-за того, что слово разделяется на две строки, робот воспринимает его как два отдельных слова. В некоторых случаях это помогает добиться чуть более высокой уникальности.

Вставка картинок. Если преподаватель требует наглядной подачи информации – добавления таблиц, формул, диаграмм с подписями и т. д., не стоит пытаться сделать все это уникальным. В любом случае вряд ли у Вас получиться переписать формулу бинома Ньютона так, чтобы она была не только правильной, но и уникальной. Просто сделайте скриншот и вставьте его в текст документа – при печати качество не изменится, и антиплагиат не найдет неуникальных фрагментов. То же с таблицами – создайте нужную таблицу в Word или Excel, сделайте снимок экрана и вставьте его в работу.

Вместо подмены русских букв латинскими попробуйте подходящие литеры греческого алфавита – программы антиплагиата пока еще не научились их распознавать как неуникальные части текста. Если греческих букв недостаточно, попробуйте вставлять символы из формул. Единственный минус такого способа – при открытии документа в Ворде все подправленные места будут отмечены как орфографические ошибки. Чтобы система не подчеркивала слова красной линией, отключите эту опцию в стандартных настройках программы.

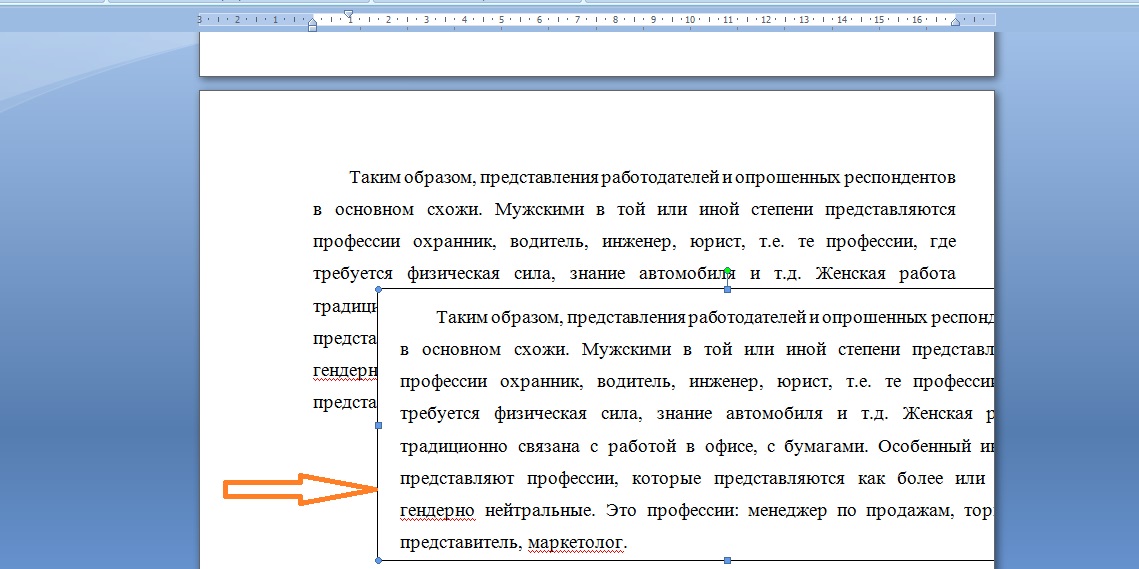

Вставка оригинальных фрагментов за пределы видимости. При распечатке документа не будут видны вставленные в свободном пространстве надписи мелким шрифтом белого цвета, а также примечания. Таким образом, можно попытаться обойти антиплагиат, если вы не смогли написать дипломную работу с высокой оригинальностью, но опытные преподаватели уже сами в курсе подобных фишек, и обмануть их не так просто.

Технические способы повышения оригинальности текста

//Технические способы повышения оригинальности текста. Технический АнтиплагиатПродолжая рассмотрение вопросов о способах повышения оригинальности текста, остановимся на второй группе таких способов, которые мы обозначили как «технические» (первая группа – «честные» способы повышения оригинальности текста описана здесь).

Все технические способы обхода системы Антиплагиат можно подразделить на 2 группы. К первой можно отнести обман самой системы проверки текста, ко второй обман скрипта, который передает текст для проверки.

Давайте остановимся на указанных способах более подробно.

- 1. Наверное, самым первым способом обхода системы Антиплагиат является способ замены русских (кириллических) букв на схожие по написанию иные буквы (латинские). Наиболее распространенными буквами для замены оказались буквы: а, о, м, р, к, х, и, с. Автор в Word выбирал замену символов по всему документу и получал, хоть и не читаемый в нормальном понимании текст, но «смотрящимся» вполне допустимо. Немаловажной особенностью была необходимость отключения проверки правописания во всем документе, так как для текстового редактора текст содержал очень много ошибок. Примерно через 2 года после начала работы системы Антиплагиат данную особенность разработчики исправили. Хотя стоит отметить, что до сих пор некоторые сервисы по проверке уникальности текста можно обойти таким образом.

- 2. Вторым этапом развития технических способов стало отыскание и замена русских букв на греческие и иные, схожие по написанию. Например, очень схожи по написанию буквы «О» в кириллице и «Омега» в греческом алфавите. Какое-то время данный способ также работал.

- 3. Помимо замены букв, достаточно часто применялись способы, связанные со вставкой невидимых для системы Антиплагиат специальных символов, начиная от пробела и заканчивая различными иероглифами в других системах исчисления.

- 4. После того, как на основном сайте по проверке студенческих работ Антиплагиат – www.Antiplagiat.ru была введена система проверки правописания и выделения всех слов, содержащих ошибки, а также пометкой всего документа красным восклицательным знаком, данный способ, в принципе, перестал быть актуальным. Хотя наличие восклицательного знака не говорит о применении технических способов обхода антиплагиата – он лишь рекомендует преподавателю более подробно ознакомиться с отчетом, так как во многих научных сферах такой знак возможен. К примеру, это иностранные языки, информатика, математика и т.д.

- 5. Самым простым и в то же время, самым доступным способом, который используется в настоящее время, является способ добавления оригинального текста к документу. А чтобы данный текст не был виден, его прячут в «Надписи», выводят за видимость экрана, делают белым цветом, устанавливает размер на 1 кегль. Большая часть сервисов в Интернете поступают именно данным образом. О данном способе, конечно же, знают все преподаватели и стараются выявить в отчете текст, который не соответствует содержанию работы. Гораздо более перспективно вставлять в работу не любой текст, а блоки из той же самой работы, которые являются оригинальными и преподавателю будет уже гораздо сложнее увидеть подвох.

- 6. Еще одним способом технического обхода системы Антиплагиат является подмена содержимого текста, который виден на экране, не отправляется корректно на проверку. Самой простой иллюстрацией этого метода является вставка вместо букв картинок – в Word все видно нормально, а вот при проверке на оригинальность эти буквы (цифры) пропадают. Замена отдельных букв эффекта не даст, так как таким образом значительно ухудшается орфография текста. Есть смысл менять слова целиком и приводить их к виду, который не воспринимается сервисом Антиплагиат. К примеру, можно заменить какой-нибудь символ, который теряется при проверке на какое-нибудь слово, и внести изменения в сам шрифт документа, чтобы он понимал под этим символом целое слово.

Выявить такой способ технического повышения оригинальности не так сложно – нужно просто скопировать документ в любой текстовой редактор, лучше в блокнот и посмотреть – пропали ли символы, буквы, слова и т.д. Надо сверить идентичность проверяемого текста и текста, который содержится в работе, так как это все равно будет видно в расширенном отчете системы «Антиплагиат-ВУЗ».

Выявить такой способ технического повышения оригинальности не так сложно – нужно просто скопировать документ в любой текстовой редактор, лучше в блокнот и посмотреть – пропали ли символы, буквы, слова и т.д. Надо сверить идентичность проверяемого текста и текста, который содержится в работе, так как это все равно будет видно в расширенном отчете системы «Антиплагиат-ВУЗ».

Безусловно, есть и иные технические способы повышения оригинальности текста, но самый лучший способ, это конечно копирайт, ну на крайний случай, рерайт.

Если у вас имеются какие-то вопросы — позвоните нам, у нас круглосуточная поддержка клиентов!

8-800-550-55-87 звонок бесплатный

Загрузить работу

Сегодня 59 студентов повысили уникальность своих работ. А всего — 512826 студентов

Повысить антиплагиат (оригинальность) текста

Для того чтобы повысить оригинальность (уникальность) текста для антиплагиата, Вам нужно обладать глубокими знаниями в области рерайта и разбираться в тематике текста. Но порой такими знаниями не обладают студенты и выход один обратится к специалистам, которые хорошо знают, как это делать.

На первый взгляд всё кажется просто и потратив несколько дней у Вас получится добиться нужного процента оригинальности текста в своей курсовой или дипломной работе. Поверьте, это не так. И некоторые студенты по не знанию ищут дешевые способы повысить уникальность текста. Вы просто выкинете деньги и не пройдете проверку. Мало кто знает, что система антиплагиат с каждым годом усовершенствуется и те методы, что ранее работали уже не помогают. Вы только добавите себе проблем, так как преподаватель при проверке обнаружит скрытое повышение и не допустит Вас до защиты.

Мы занимаемся повышением процента оригинальности для прохождения антиплагиата уже более 5 лет и с 100% уверенностью можем Вам сказать, что единственный способ, который работает — это академический рерайт.

За время работы и личного опыта мы усовершенствовали данный метод и добились 100% результата. У нас есть правило, если мы не помогли, то деньги возвращаются заказчику.

5 причин обратиться к нам:

- У нас дешевле, чем у других.

- Мы делаем за 1-3 дня.

- Вы получаете отчет о проценте уникальности Вашей работы (после чего можете сами перепроверить).

- Всегда есть выбор метода повышения уникальности текста (программный и ручной).

- Мы всегда на связи — онлайн.

Помните – даже если у Вас % оригинальности текста равен 14%, мы можем сделать текст уникальностью более 72%.

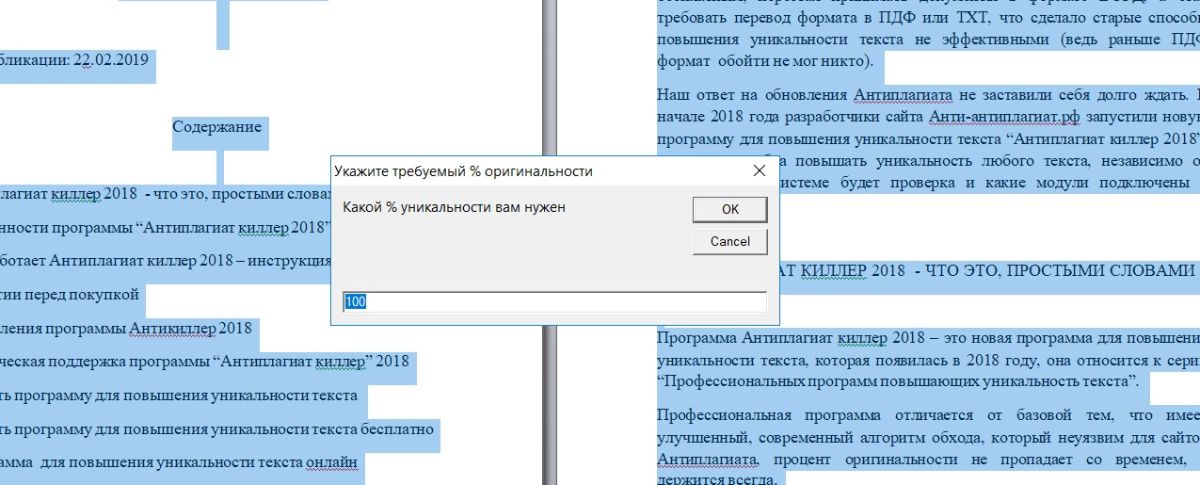

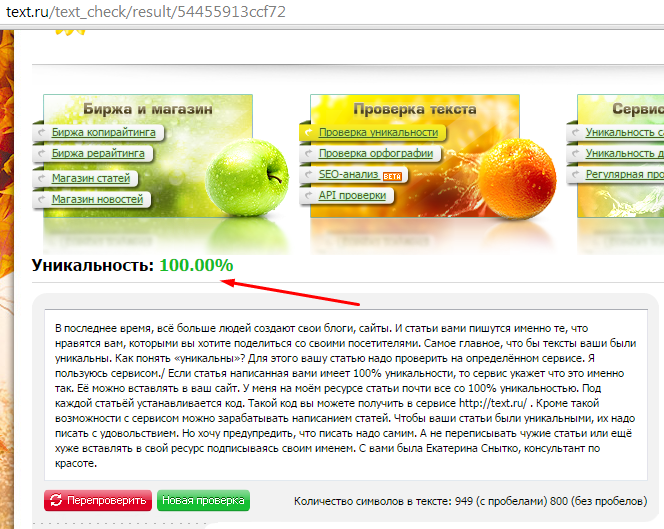

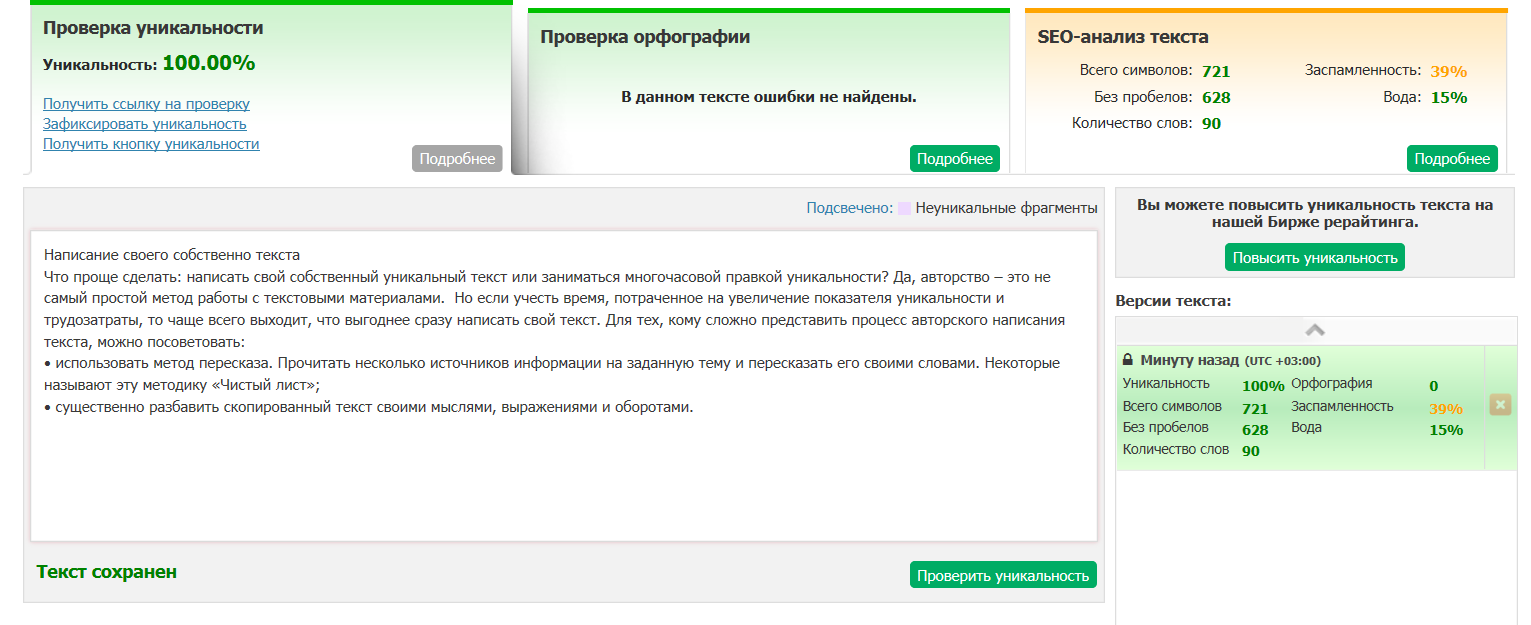

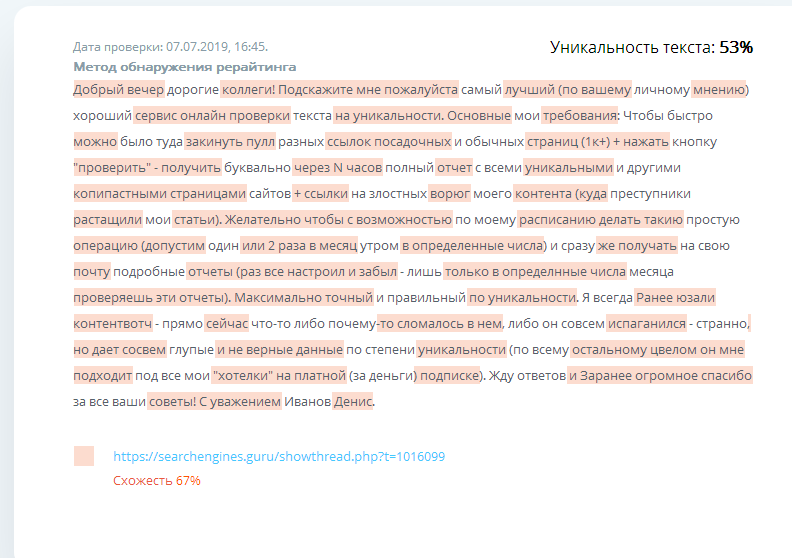

Для примера поднятия оригинальности мы выложили картинку, где из плагиатной работы, сделали уникальную. Работа была в первоначальном виде 15.02%, после нашей обработки, стала 83.45%.

И заметьте, нет, не каких значков о предупреждении, что в работе есть подозрения на искусственное завышение оригинальности!

Как обмануть проверку на плагиат

Большинство студентов хоть раз слышали слово «антиплагиат» — это означает, что диплом или курсовая работа, прежде чем быть принятыми, должны пройти проверку оригинальности. Требования к проверке обычно довольно стандартные – уникальность текста должна составлять от 60% до 90%.

Антиплагиат – это сервис или программа, которая сличает загруженный текст с теми текстами, которые уже есть в интернете и проиндексированы поисковыми системами. Для проверки чаще всего используются популярные антиплагиат-сервисы (Advego. Etxt, text.ru), в некоторых случаях проверка может вестись через узкоспециализированные сервисы, заточенные под анализ студенческих работ (например, Антиплагиат ВУЗ – в базе этого сервиса имеются тексты уже сданных ранее дипломов и курсовых работ, что существенно затрудняет прохождение проверки).

Что такое уникальность текста?

Уникальный текст – это текст, который нигде ранее не встречался. Если в тексте присутствуют цитаты, скопированные термины и определения, отрывки из электронных учебных пособий или статей, фрагменты работ других авторов – обмануть проверку на плагиат не получится.

Если в тексте присутствуют цитаты, скопированные термины и определения, отрывки из электронных учебных пособий или статей, фрагменты работ других авторов – обмануть проверку на плагиат не получится.

Как поступить? Рассмотрим основные способы обойти антиплагиат.

1. Искусственно повысить процент уникальности, используя специальные сервисы. Обработка текста занимает 4-5 минут, а перекодированный файл распознается программами антиплагиата как уникальный. Этот способ хорош, если преподаватель не дотошный и не будет изучать электронную копию работы – потому что в перекодированном файле все слова будут восприниматься текстовым редактором как ошибки.

2. Автозамена синонимов. Этим способом (так же, как и синонимайзерами) все еще пользуются некоторые ленивые студенты. Автозамена хороша для уникализации небольших отрывков текста, но для всей работы этот способ бесполезен – слишком сильно снижается качество результата.

3. Рерайтинг (переписывание, изложение своими словами) неоригинальных отрывков. Этот способ работает всегда и на 100%, но у него есть огромный минус: трудоемкость. По сути, вся работа пишется заново, с той лишь разницей, что студент не вкладывает в нее свои мысли и выводы, а пересказывает чужие. Сложность рерайтинга меняется в зависимости от того, по какому сервису проверяется текст. Так, чтобы обмануть проверку на плагиат в сервисе antiplagiat.ru, достаточно переписать фразу своими словами. Для сервиса etxt придется дополнительно поменять местами предложения. Text.ru требует еще более тщательной проработки, вплоть до изменения структуры всей работы.

4. Если студент понимает суть предмета, он может использовать для своей работы машинный перевод и адаптацию с иноязычных источников..jpg)

5. Чтобы обмануть проверку на плагиат, пригодятся и маленькие хитрости – например, оформление цитат непрямой речью, использование инфографики и иллюстраций вместо таблиц и описаний, добавление в работу графиков с подписями на самом графике, а не отдельным текстом. Такие моменты лучше заранее обсудить с преподавателем, и если он не против – использование графических объектов существенно увеличит шансы обмануть антиплагит, ведь в антиплагиат-сервисах пока не существует алгоритмов, проверяющих рисунки.

Повысить уникальность текстовой работы. Обойти антиплагиата онлайн

Как проверить диплом, реферат или курсовую работу на уровень плагиата (Antiplagiat.ru, Антиплагиат ВУЗ, Etxt антиплагиат, РУКОНТекст)

Каждый студент прекрасно знает, что такое плагиат. Уровень плагиата – едва ли не главное требование к студенческим работам в большинстве российских ВУЗов.

Чтобы выявить заимствования в тексте документа, преподаватели пользуются рядом сервисов. Наиболее популярные – Антиплагиат ВУЗ, Antiplagiat.ru, ETXT и РУКОНТекст.

Как они работают?

Большинство таких сервисов используют схожий алгоритм. А именно – сравнивают загружаемый текст с базой документов, которая постоянно пополняется. Есть и небольшие отличия – Антиплагиат ВУЗ, например, имеет доступ к огромной базе статей и научных работ.

Антиплагиат (Antiplagiat.ru, Антиплагиат ВУЗ)

База системы Антиплагиат насчитывает более 90 миллионов документов, включая тексты диссертаций, авторефератов, научных статей, юридических документов. Разработчики Антиплагиата утверждают, что система умеет эффективно выявлять рерайтинг – помечать как плагиат синонимы, выявлять замену символов и знаков препинания и др. В самом деле — практика показывает, что обойти Антиплагиат можно, если выполнить глубокий рерайтинг вручную.

В самом деле — практика показывает, что обойти Антиплагиат можно, если выполнить глубокий рерайтинг вручную.

Etxt антиплагиат

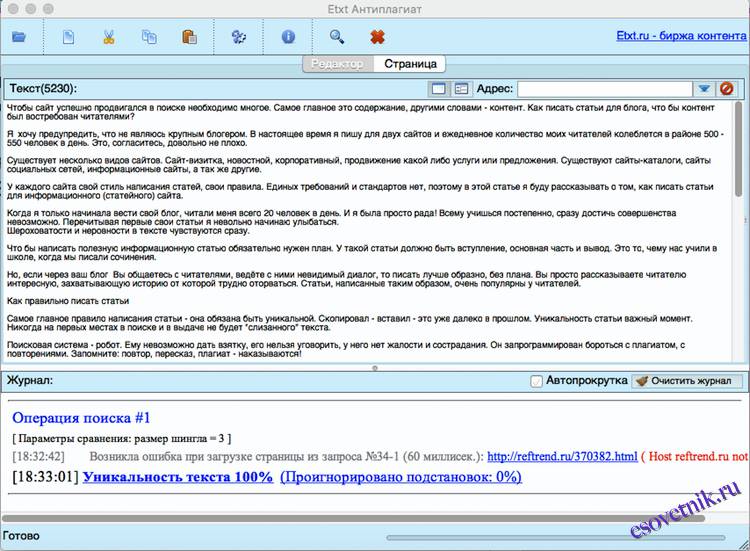

Etxt – онлайн-сервис и приложение для ПК, известные одновременно и умением выявлять перефразированные фрагменты, и возможностью проведения четырех различных проверок: на рерайтинг, экспресс-проверки, стандартной и глубокой. В ВУЗах обычно требуют проверять документ последним способом.

РУКОНТекст

Руконтекст заслуживает особого внимания. В некоторых ВУЗах эта платная система принята как аналог Антиплагиат ВУЗ и широко используется. В первую очередь – потому, что в 2017 году разработчики Руконтекста проанализировали основные методы обмана и ввели проверку на попытки искусственно повысить уникальность работы. Поэтому, если система получает документ с искусственно завышенной уникальностью, вместо результата проверки появится сообщение о попытке обмана.

Руконтекст – наиболее защищенная система, обойти ее очень сложно. Даже выполнение ручного рерайтинга не гарантирует успех.

Как поднять процент уникальности и пройти проверку?

Самый простой способ – честно написать работу самостоятельно. Но не у всех на это есть время, особенно если приходится сдавать по 4-5 рефератов за семестр. Будем честны – мало кто из преподавателей читает студенческие работы, поэтому стараться и писать все рефераты и курсовые с нуля особого смысла нет.

Можно поручить эту задачу специалистам – опытный исполнитель напишет реферат, курсовую или даже диплом и гарантирует, что работа успешно пройдет проверку на плагиат. Но данный вариант весьма дорогой и затратный по времени.

Но данный вариант весьма дорогой и затратный по времени.

Самый простой и в тоже время достаточно эффективный способ повысить уникальность документа — это воспользоваться сервисом технического повышения уникальности. Данный способ самый экономичный, а само повышение уникальности займет не более 3-х минут.

Как повысить уникальность текста и пройти проверку на антиплагиат

К несчастью для студентов, теперь в каждом ВУЗе, чтобы сдать курсовую или дипломную работу необходимо пройти проверку на антиплагиат, понятное дело, что даже те, кто пишет диплом сам, берет информацию из открытых источников, а значит работа получается не уникальной. Как с этим бороться и о том, как же повысить уникальность работы мы поговорим в нашей статье.

Начнем с того, что у вас всегда есть выбор, вы можете купить уже уникальный диплом, заказать повышение уникальности платно или повысить уникальность самостоятельно.

Какой способ выбрать решать только Вам. Но у каждого есть свои плюсы и недостатки, о которых стоит знать заранее.

1. Повышение уникальности бесплатно онлайн. Даже не теряйте свое время на поиск таких сайтов, как вы знаете бесплатный сыр бывает только в мышеловки. Либо Вам не повысят уникальность, либо повышение составит 1-3%. Либо попросят заплатить.

2. Повышение уникальности самостоятельно – самый трудоемкий и эффективный способ, который я вам советую использовать, почему?

Во-первых, если вы пишите и сдаете диплом сами, это будет плюсом, пока вы будете увеличивать уникальность, вы выучите свой диплом на зубок.

Во-вторых Вы будете уверенны, что повышение уникальности – это естественный процесс, а не применение технических средств, будете уверены в том, что программа не выдаст в последний момент ошибку, типа «использованы технические средства обхода программы».

В третьих, самый очевидный плюс, это экономия, да сил и труда потребуется много, но вы добьетесь результата бесплатно.

3. Заказать повышение уникальности у специалистов, тут стоит оговорится, что такую услугу вам готовы предложить сотни сайтов, но 99% из них повышают уникальность средствами технических уловок, и тут идет борьба современных программ и поиска из уязвимостей.

Если Вам предложат хорошую низкую цену, то будьте уверенны уникальность будет повышена искусственно и вас легко раскусят. Даже если изначально вы сможете пройти проверку не факт, что перед итоговой сдачей, программы не обновят и ваш трюк будет не обнародован.

Если вы решили, что самостоятельное повышение уникальности – точно не для Вас. Не пожалейте денег для реального рерайта Вашей работы.

Если вы решили повысить уникальность самостоятельно в помощь Вам будет эта статья.

Заказать повышение уникальности дипломной/курсовой работы вы можете и у нас. Мы не предложим вам дешевую цену – но мы сделаем качественную работу. Чтобы оставить заявку нажмите на кнопку. В нашей группе вы сможете почитать отзывы и задать все интересующие Вас вопросы.

Может еще поучимся? Загляни сюда!

Как повысить уникальность текста самостоятельно

Приветствую вас, дорогие читатели! На связи Павел Ямб. Продолжим разговор об уникальности. Написали вы статью, и все замечательно, но она неуникальна, и поисковикам не понравится. Как повысить уникальность текста самостоятельно?

Убираем сходство с публикациями на других сайтах

Первое – уничтожаем шаблонные фразы. Строим предложения так, чтобы не получить публикации-двойника с уже имеющимися в сети. Заменить похожие слова синонимами, перестроить предложения, изменить стиль написания, наконец, если это не повредит изложению – все доступно.

Только не нужно чересчур увлекаться синонимайзингом. Постоянное пользование сервисами замены имеет смысл, когда необходимо найти синоним к профессиональному термину, но не когда подыскать подходящее слово можно в памяти или посмотреть по смыслу.

Если заменять все слова синонимами, то в итоге мы получим нечитабельное нечто. А такое читатели не оценят, разве что поисковый робот уникальность поставит высокую. Но и они научились определять искусственную генерацию. Так что делаем выводы.

А такое читатели не оценят, разве что поисковый робот уникальность поставит высокую. Но и они научились определять искусственную генерацию. Так что делаем выводы.

Взгляд на вопрос с новой точки зрения

Предлагаемая тема «заиграна до дыр»? Если вам она интересна, то почему бы не посмотреть на материал по-новому? Не так, как все, а иначе, свежо, оригинально? Это возможно, если тема – ваша. Предлагаем различные варианты решения вопроса.

Без внимания читателей ваши предложения не останутся. Да и поисковые системы относятся к таким публикациям благосклонно. Полезно? Конечно. Интересно? Безусловно! Значит, ни что не станет препятствием на пути процветания блога!

Польза и информация – главные движущие силы

Если в публикации нет смысла, то и высокая уникальность не спасет. Посетители не станут читать такой материал. Поисковые системы отметят уменьшение интереса, сайт понизят в выдаче… Продолжать не будем. А будем писать полезные и интересные статьи.

Идеи найти можно повсюду, даже пообщавшись на форуме. Разумеется, прежде, чем предлагать что-то необходимо проверить все факты. Подтвердили? Можем писать! Полезность и информационность поисковые роботы учитывают.

Размер имеет значение

Для повышения уникальности можно воспользоваться некоторыми «техническими хитростями». Чем больше размер статьи, тем выше ее уникальность. Расхожие фразы в таком объеме останутся, но понижение «уника» будет меньше. Вывод – пишем объемные тексты.

Не списываем, а пишем. То есть, излагаем своими словами, из головы, придумываем, строим повествование… Как ни скажи, главное – свои мысли, а не списанные.

Хорошо включать собственные мысли вместо цитат: размер текста увеличивается, значит, растет и уникальность. Пересказывать авторские высказывания не нужно, но добавления своих наблюдений способствует повышению ценности публикации. Такой метод, конечно, не подойдет, если объем статьи заранее оговорен заказчиком.

Создаем собственную структуру предложений

При написании текста, некоторых слов и оборотов лучше избегать. Заменим «во-первых», «во-вторых» и так далее списками – уникальность повысится. Не будем увлекаться сложными и длинными предложениям: короткие фразы воспринимаются легче.

Заменим «во-первых», «во-вторых» и так далее списками – уникальность повысится. Не будем увлекаться сложными и длинными предложениям: короткие фразы воспринимаются легче.

Обороты «похоже», «вроде» убираем: обороты не повысят уника. Изменение порядка фраз без потери смысла повышает ценность текста.

Все материалы, на основании которых пишем статью, изучаем подробно и сразу. Для переработки авторских мыслей собственными приемами стилистики и лексики это не6обходимо. Построение предложений желательно сделать не похожим ни на одно произведение.

Включать в публикацию малоизвестные данные, опираться на книги, во Всемирной паутине не выложенные – отличный способ повышения уникальности. Лучше понять вашу статью помогут таблицы, списки и иллюстрации.

Используем эпитеты

К каждому слову русского языка есть немало синонимов и эпитетов. Так почему бы не воспользоваться этим? По страницам толстенных словарей «бродить» в мучительных поисках не придется: есть специальные программы-синонимайзеры.

Но бездумное использование программы может больше навредить: такие замены способны навредить читабельности и смыслу текста и понизить публикацию в выдаче. Если с первым все понятно и определить все довольно просто, то с поисковиками сложнее. И Яндекс, и Гугл «поумнели»: замену слов на синонимы они распознают сразу. Так что копирование с заменой слов пользы не приносит: статья оценивается как неуникальная.

Фразеологизмы освежат публикацию и добавят ей выразительности. Пример: не «тратил время зря», а «бил баклуши». Смысл не изменится, а проверка не покажет, что слово заменили синонимом. При удачной замене система решит, что исходный и авторский текст разные.

Повысить своими силами уникальность нетрудно. Сложно не перестараться. Есть ситуации, когда уникальность лучше оставить на прежнем уровне. Бессмысленно переделывать текст, заполненный терминами более чем наполовину.

Когда уникальность лучше не повышать

Узкоспециализированные тексты, наполненные спецтерминами, переделать невозможно: смысл искажается, а задача автора – дать качественную и достоверную информацию. Замена терминов в инструкции способна нанести вред здоровью человека. Разве стоит уник такой цены? Не нужно забывать об ответственности за каждое слово своей публикации.

Замена терминов в инструкции способна нанести вред здоровью человека. Разве стоит уник такой цены? Не нужно забывать об ответственности за каждое слово своей публикации.

Нормативные документы не рерайтят, как и авторские произведения. Читателю об уникальности неизвестно, а вот ваше посягательство на классику он оценит негативно.

Даже для достижения стопроцентной уникальности искажать текст до безобразия нельзя. Вы же не терминатор, любой ценой добивающийся результата! Задача копирайтера – думать и анализировать.

Во время работы важно думать о читателе, а не об оценке работы Гуглом или Яндексом. Вот потому материал необходимо подготовить достоверный. А как по-вашему: стоит жертвовать смыслом ради уникальности?

С вами был Павел Ямб. До связи!

что делать с плохим текстом

Подробно Создано: 21.03.2017 11:01 Обновлено: 17.05.2019 20:30 Опубликовано: 21.03.2017 11:01

«Все новое хорошо забыто старым.» Так было, есть и будет. Все произведения мира по большей части неуникальны, повторяются. Но рассерженные учителя (или заказчики) вынуждены сдавать свои работы со стопроцентным результатом. Для этого используются специальные программы тестирования на плагиат, которые, к счастью, можно обойти.Но, согласитесь, не всегда есть время или желание пересказывать чужие мысли, никому от этого не пойдет. А в Интернете есть масса способов повысить уникальность текста, и о них пойдет речь в статье.

В некоторых случаях может потребоваться усиление антиплагиата:

- Необходимо повысить уникальность эссе;

- Необходимо повысить уникальность курса;

- Необходимо повысить оригинальность диплома;

- Для повышения уникальности собственного текста для доставки заказчику;

- Уникальность в текстовых документах в форматах: docx, doc, rtf или pdf.

Конечно, есть и другие варианты, когда вы хотите повысить уникальность, но это самые основные.

Основные программы антиплагиата и проверки уникальности

Самый популярный сервис копирайтинга в Рунете. В нем есть свой модуль проверки, который жестче всех остальных, довольно заметно переписан (о нем поговорим чуть позже). Текст считается уникальным при 100% производительности на этом сервисе.

Advego plagiatus

Самая жесткая программа поиска антиплагиата.Обойти это довольно сложно. Программа загружается в компьютер и проверяет каждое предложение текста в Интернете. Антивирус на нее часто ругается. Уникальность текста считается высокой с более чем 90% антиплагиата.

Антиплагиат.ру — сервис, позволяющий проверить бесплатно

Основная программа проверки на антиплагиат в вузах. Именно по нему будут проверяться все курсовые работы и диссертации.Имеет возможность подключения всех научных работ из библиотеки Elibrary.ru. Он находит много общего, поэтому процент более 70% считается хорошим.

и т. Д. — Антиплагиат

Принцип действия аналогичен Advego Plagiatus. Однако он имеет более улучшенный интерфейс и расширенный набор функций, улучшающих проверки. Уникальность текста считается высокой при достижении 100%.

Способы повышения оригинальности текста

Сегодня существуют следующие способы повышения уникальности текста онлайн:

- Переписывание;

- Специальные программы, повышающие антиплагиат;

- Специализированные сайты;

- Собственный пересказ произведения, чтобы в файле был высокий процент.

Это все методы, но в будущем, скорее всего, появятся новые.

Переписывание — как действенный метод повышения оригинальности текста Для одних это форма заработка в Интернете, а для других — отличная возможность повысить уникальность текста. Суть данной работы в том, что исполнитель переписывает фрагменты текста, заменяет слова синонимами и схожими по смыслу. Конечно, эта услуга платная.Цена за тысячу знаков в среднем составляет 25-40 рублей в зависимости от профессионализма исполнителя. Вы можете найти художников на популярных биржах Рунета Text.ru, Etxt и Advego.

Конечно, эта услуга платная.Цена за тысячу знаков в среднем составляет 25-40 рублей в зависимости от профессионализма исполнителя. Вы можете найти художников на популярных биржах Рунета Text.ru, Etxt и Advego.

+ Уникальный артикул, документ;

+ Полностью сохраненный смысл;

+ Довольно низкая заработная плата.

— Оплата все еще есть;

— Ориентировочное время выполнения заказа — 2 дня.

Программы, специализирующиеся на повышении уникальности текстаЕсть варианты как для программ, повышающих уникальность текста бесплатно, так и для платных версий, которые работают немного лучше.Суть этих программ заключается в замене слов синонимами, добавлении слов в предложения, замене русских символов на английские, тем самым пытаясь повысить процент оригинальности документа. Все это сказывается на увеличении и увеличивает оригинальность, однако некоторые программы замечают замену букв. При загрузке таких программ нужно быть максимально осторожными, вы довольно легко можете заразиться вирусом.

Однако их работа заключается в использовании специальных онлайн-алгоритмов, которые легко обнаруживают антиплагиат и обманывают его до отказа.Поэтому повысить уникальность текста в сети не получится, их использование лучше всего подходит для слабых антиплагиаторов, а не таких мощных акул этого дела, которые представлены выше.

Две наиболее распространенные программы борьбы с плагиатом:

Antiplagiat killer

Плюсы и минусы этой опции для увеличения антиплагиата:

+ Самый дешевый вариант из всех;

+ Скорость работы, все происходит онлайн;

— Их работа легко быть антиплагиаторами;

— Есть возможность подбирать вирусы

Сайты помогают повысить оригинальность В Интернете также есть сайты, специализирующиеся на повышении уникальности текста в Интернете. Таких сайтов достаточно; убедитесь, что он не создан мошенниками. Обычно они берут деньги, но не делают работы. Пользуйтесь только проверенными сервисами и понимайте, как повысить уникальность.

Таких сайтов достаточно; убедитесь, что он не создан мошенниками. Обычно они берут деньги, но не делают работы. Пользуйтесь только проверенными сервисами и понимайте, как повысить уникальность.

Обычно существует два алгоритма работы сайтов:

- Использование программ, повышающих оригинальность текста;

- Перепишите.

Программы таких сайтов отличаются от тех, что находятся в открытом доступе.Они используют свои собственные, специальные алгоритмы в программах, которые обычно программа проверки не может найти, и они могут легко помочь повысить оригинальность.

Сайты, использующие перезапись, чем-то похожи на биржи. Обычно у них есть собственный штат рерайтеров, которые переделывают уникальность текста и могут повысить оригинальность на 100%.

Самый популярный и надежный онлайн-сервис, который поможет:

Конечно, вы можете найти множество сервисов, повышающих оригинальность в поисковике, но это проверено временем и удобно, вы можете проверить работу на нем и при необходимости сразу же отправить для увеличения уникальности.Часто наивные мошенники зарабатывают легкие деньги. Не поддавайтесь на уловки.

Эти сайты предоставляют возможность повысить уникальность текста онлайн бесплатно, но только в первый раз в пробной версии. Обычно первое использование ограничено 2000 символами. После вам придется заплатить деньги. Примерная цена 150 руб. за документ. К тому же крупные сайты быстро выполняют заказы, максимум — за сутки. Это может быть удобно при сжатых сроках.

Плюсы и минусы этого метода:

+ Высокая оригинальность;

+ Скорость работы;

— Не бесплатно;

— На мошенников можно наткнуться.

Самосовершенствование оригинальности Обычно учителя хотят, чтобы вы сами увеличили оригинальность текста, переделали несколько источников. Это должно помочь усвоению материала, расширить ваши знания и т. Д. Что ж, если у вас есть свободное время, вы можете сделать это сами. Так вы приобретете знания, не потратите деньги и, возможно, получите удовольствие от работы. А представленные ниже советы помогут вам повысить оригинальность.

Д. Что ж, если у вас есть свободное время, вы можете сделать это сами. Так вы приобретете знания, не потратите деньги и, возможно, получите удовольствие от работы. А представленные ниже советы помогут вам повысить оригинальность.

Гонт Правило

Готовы ли вы получить уникальный текст за 30 минут?

Здравствуйте мой дорогой гость.Сегодня я расскажу о принципе, позволяющем повысить уровень антиплагиатной оценки в выпускной квалификационной работе.

В результате довольно простых и логичных манипуляций вы получите заготовку с высоким уровнем антиплагиата.

В этом примере я повысил уникальность материала из Интернета с уникальности с 0% до 64% всего за пару минут. Естественно, после этого материал нужно отредактировать, но редактирование одного не является уникальным, а совсем другое — что уже можно опробовать.

Уверен, что после прочтения этой статьи вам станет намного проще редактировать свою работу)

Если вы не хотите самостоятельно поднимать собственный антиплагиат, но ищете где его заказать, предлагаю свой услуги по ручному переписыванию произведений (по экономике или юриспруденции) до желаемого уровня уникальности.

С вопросами обращайтесь сюда: vk.com/diplom35. Отзывы клиентов, которые работали со мной, внизу этой статьи.

Весной 2018 года компания ЗАО «Антиплагиат» предложила использовать новые модули поиска плагиата: Интернет и ЭЛЕКТРОННАЯ БИБЛИОТЕКА.RU модули поиска перефразирования.

Способы повышения оригинальности, описанные в этой статье, сейчас немного помогают, хотя если ваша работа проверена без этих модулей, то в принципе они помогут. Вы также можете прочитать эту статью, чтобы понять, как вообще работает антиплагиат.

Программы для ручной уникальности

Что нужно для исправления вашей уникальности? Только Ворд и др. Антиплагиат.

Пример повышения уникальности текста

Так как я финансист и близок к финансовому анализу, я взял из Интернета отрывок текста по финансовому анализу.

Но поскольку программа делает выборки и определяет по ним, заимствован ли текст, решение задачи оказывается элементарным. И это не совет многих учителей «пользоваться журналами» и тому подобным. Программе все равно, откуда берется материал. Если выбор совпадает, текст будет помечен как заимствованный. Поэтому постоянно возникают ситуации, когда вы пишете работы по учебникам, журналам, лекциям и т. Д., И в итоге они показывают вам 40% уникальности или меньше.

Ну а как тогда обойти антиплагиат? Да элементарно. Вам просто нужно разбить эти образцы. Для этого после каждого 3-4-5-го слова нужно поставить любое слово размером более 4 букв. Я выбрал слово «сложный», хотя слово может быть любым. Хотя бы слово «лохматый» или «табурет».

А просто вставьте это слово в текст. После вставки нажмите кнопку проверки.

Вот, собственно, и все. Затем читаем этот файл, исправляем в нем косяки, согласовываем слова.Слово подчеркивает все. И в то же время вы уже точно знаете, что ваша работа отличается высокой оригинальностью. Да, работа довольно муторная, но что поделать.

Хотя при желании можно заказать на любой бирже студенческие работы. На таких биржах ваши работы будут переписаны для любого уровня уникальности. Но обязательно укажите в том порядке, что вам нужна перезапись, а не какая-то обработка. Так как от недобросовестного исполнителя может быть сюрприз. А если вы указали это прямо в заказе, то в случае возникновения спора вас просто заменит исполнитель или вернут деньги.

Ссылка на биржу с наибольшим количеством исполнителей: author24.ru. Зарегистрируйтесь, разместите заказ и дождитесь, пока подрядчик (или несколько) исправят вашу работу за вас)

Если у вас хозяйственная или юридическая работа — предлагаю вам свои услуги по рерайтингу — подробнее в конце статьи.

Ну или если будет время — отредактируй сам. И не бойтесь, что вас заворачивают из-за антиплагиата. Поправлю на пару дней. При этом материал вы будете знать лучше)

Обратите внимание, я копирую не всю работу сразу, а по частям..jpg) Например, от начала раздела к таблице, затем от таблицы к рисунку и так далее. Потому что форматирование таблиц в программе не сохраняется. Поэтому оставляю их в Ворде как есть, а когда вся работа завершена, добавляю слова в таблицы.

Например, от начала раздела к таблице, затем от таблицы к рисунку и так далее. Потому что форматирование таблиц в программе не сохраняется. Поэтому оставляю их в Ворде как есть, а когда вся работа завершена, добавляю слова в таблицы.

Основные ошибки, которые вы можете сделать при усилении антиплагиата:

1. Отредактируйте антиплагиат в исходном файле Word. Не делайте этого. Необходимо повысить уникальность в окне антиплагиат etxt, потому что оно показывает, где именно нужно вставить слова, или слово из этого окна копируется в отдельный документ, чтобы не потерять работу при случайном закрытии программы.

2. Перепишите своими словами. Не делайте этого. Вполне вероятно, что кто-то с такими же словами что-то уже написал. Экономисты каждый год выпускают облака. Необходимо разбивать фразы дополнительными словами

3. Необязательно вставлять бессмысленное слово (как в примере). Основная логика повышения уникальности — разорвать цепочки слов. Вы можете заменить каждое четвертое на пятое слово: вместо существительного сделать местоимение прилагательным, изменить части речи, вы можете размещать фразы внутри абзаца и т. Д.И опять же, в etxt antiplagiat это удобно делать, потому что там выделены заимствованные фрагменты. И новые слова и фразы будут на белом фоне. Вы можете очень ясно увидеть, разорвали ли вы цепи или нет.

Какие слова я могу вставить? Самый простой вариант — это название организации, которой вы пишете работу. Эта фраза неизменна. Например, ПАО «Сбербанк России» — может вам помочь — пример на рисунке. Затраченное время — 30 секунд.

На мой взгляд, первые 3 пункта для повышения уникальности нет смысла использовать, а вот остальные вам полностью помогут.

Удачи. С уважением, Александр Крылов.

Ваши вопросы и мысли — в комментариях.

Помощь в повышении уникальности работы в хозяйстве.

Предлагаю Вашему вниманию свой сервис по рерайтингу на предмет антиплагиата.

Естественно, без всякой техники, кодировок и тупой замены синонимами (синонимизация). Просто переписать.

Стоимость и сроки зависят от количества страниц и размера, на который нужно поднять уникальность работы.По порядку и вопросам — стучите, пожалуйста.

Подробно Создано: 21.03.2017 15:09 Обновлено: 17.05.2019 20:32 Опубликовано: 21.03.2017 15:09

Очень часто преподавателям разных учебных заведений приходится перечитывать полностью идентичные главы в произведениях своих учеников. Студенты не придают особого значения бездумному копированию информации из Интернета, забывая, что она доступна практически каждому пользователю глобальной сети. Теперь, чтобы учитель принял диплом или курсовую работу, она должна пройти обязательный тест на уникальность.Во избежание подобных эксцессов с 2006 года в учебный процесс введена программа тестирования на антиплагиат. Студенты, естественно, совсем не довольны этим типом проверки работы на уникальность и поэтому ищут способы обойти антиплагиат без ущерба для содержания или семантической составляющей.

Студентам, которым необходимо проверять текстовые произведения с помощью общей программы, следует более подробно изучить материал, в котором представлены наиболее популярные методы обхода системы проверки на уникальность.

Определение плагиата

Чтобы разобраться в сути вопроса, необходимо разобраться в этимологии слова «плагиат». Подразумевает заимствование или присвоение информационных данных без разрешения автора, так как сам плагиат можно рассматривать с двух сторон:

- Сохранение основной структуры с изменением словесного содержания;

- Копирование всей информации без изменений.

Как пройти антиплагиат: жгучие секреты

Проверить текстовую информацию на уникальность с помощью бесплатных утилит Большинство этих программ работают на определенном сайте. К наиболее распространенным сервисам онлайн-проверки относятся:

К наиболее распространенным сервисам онлайн-проверки относятся:

Exchange Text.ru , который быстро и точно выявляет не только повторяющийся текст, но и выполняет поиск ошибок и уровней спама.

Ресурс Антиплагиат.ру

Сайт профессионалов Content-watch.ru , которые автоматически сканируют целые веб-страницы и документы.

Компьютерные утилиты включают:

Ett , можно скачать с сайта биржи;

Advego , продается на одноименной бирже.

Они используют такие сложные системы проверки, что пройти антиплагиат становится все труднее. Антиплагиат.ру считается самым распространенным и надежным сервисом, и именно его используют большинство учителей для определения антиплагиата.

Т.к. основной целью аудита является определение максимального количества заимствований. Поэтому программа дает полный отчет об уровне уникальности и количестве использованных источников. Благодаря получению подробной информации возможно усиление антиплагиата, что в последнее время сделали все студенты средних и высших учебных заведений.Преимущество этой работы заключается в том, что во время активного поиска приходят необходимые знания, навыки, которые можно использовать в будущем для написания собственных работ. Правда, единственным существенным нюансом программы является то, что она указывает только объем заимствованного текста, без акцента на специально включенные цитаты, вроде плагиата.

Для пополнения сбора информации сервисы проверки уникальности используют базы данных как с открытым, так и с закрытым кодом. Естественно, об алгоритме проверки никто не распространяет, поэтому можно только догадываться, как работает система.Однако, несмотря на такую секретность, многие люди методом проб и ошибок выявляют методы, с помощью которых можно повысить уникальность текстов.

Как работает система проверки уникальности антиплагиата?

Если вы понимаете общую схему работы механизма антиплагиата, то можете определиться со способами его обхода. Фрагмент текста, добавленный в систему проверки уникальности, определяется как набор отдельных предложений, которые, в свою очередь, делятся на фразы и отдельные слова.Первоначально система ищет похожие предложения, обычно ориентируясь на их отдельные фрагменты. Программа проводит семантический и синтаксический анализ, при нахождении большого количества совпадений приходит сообщение о наличии плагиата в тексте.

Теперь становится понятно, как повысить уникальность текста, используя синонимичные слова или словосочетания в любом порядке, не меняя смысла взятого текста. Поскольку на это часто уходит много времени, есть несколько способов ускорить работу.

Методы, которые уже нельзя обойти с антиплагиатом:

Методы, которые уже неэффективны, их использование можно только потратить впустую:

- Исправление букв кириллицы и латинского алфавита;

- Перенос абзацев из одной части в другую;

- Простая перегруппировка слов в одном предложении;

- Объединение простых предложений в сложные и наоборот;

- Замена знаков препинания;

- Использование белых символов вместо пробелов;

- Простая замена синонимами.

- Уникальность не может быть увеличена путем добавления скрытых символов.

Разработчики ежегодно обновляют модули верификации, доводя свою работу до совершенства, поэтому такие примитивные методы больше не помогают. Даже если работа написана самостоятельно, то есть устойчивые фразы, без которых невозможно написать курсовой или дипломный проект, поэтому учебные заведения ставят допустимую уникальность выше 70%, и студенту придется повышать свою оригинальность до порога, требуемого Университет.

Но есть еще действенные способы повысить процент уникальности текста без ущерба для смыслового наполнения.

Как обмануть систему? Самые актуальные секреты и рабочие варианты обхода антиплагиата в 2018 г.

Самым эффективным методом на сегодняшний день является самостоятельная презентация выбранного материала на доступном языке с изменением словоформ или синонимов. Конечно, с помощью этого метода получить 100% уникальность тоже довольно сложно, нужно будет приложить максимум усилий.

Людям с ограниченным количеством свободного времени стоит обратиться за помощью к грамотным специалистам, которые точно знают, как обмануть антиплагиат в 2018 году. Это будет отличным решением для тех, у кого достаточно денег.

Копирайтеры, предпочитающие самостоятельную работу, могут использовать несколько простых приемов, которые были успешно протестированы многими людьми:

- Форматирование текста в Word с добавлением специальных символов, скрытых под белой краской. Из-за таких изменений текст больше не будет адекватно восприниматься Антиплагиатом;

- Уникальный фрагмент текста, многократно скопированный и введенный в поле «надпись».Правда, система увидит гораздо большее количество символов, и это может вызвать подозрение у инспектора;

- Выбор сложных и менее популярных тем для курсовых работ, дипломов или рефератов значительно повысит уникальность за счет меньшего количества копий;

- Можно использовать множество выдержек из бумажных изданий последних выпусков, в том числе статьи из журналов, информационные видеоролики онлайн-конференций, вероятность попадания в общую базу антиплагиата значительно снижена;

- При отсутствии проблем с грамматикой и лексикой можно использовать сложную перифразу с изменением семантического и синтаксического ядра с сохранением литературной формы и читабельности.

- Зарубежные печатные издания станут большим подспорьем в уникальном произведении.

- При использовании синонимических словоформ и фразеологизмов необходимо внимательно следить за отсутствием стилистических недостатков, обусловленных незнанием этимологии того или иного употребляемого слова;

- Вы можете значительно увеличить объем работы, добавив «воды», что снижает процент нахождения похожих предложений или фраз.

Это актуально для филологов, чьи работы наполнены большим количеством цитируемого текста.

Это актуально для филологов, чьи работы наполнены большим количеством цитируемого текста.

Все эти методы требуют от человека времени, усидчивости и начитанности, но есть решения для людей, творческие способности которых не выходят за рамки обычного. Чтобы упростить работу, вы можете использовать программные средства для прохождения антиплагиата.

Программные способы повышения антиплагиата бесплатно

- Word считается наиболее распространенным с возможностью создания макросов или областей невидимого текста, поскольку макросы позволяют повысить уровень антиплагиата, добавляя в текст левые символы Юникода.

- Использование изображений некоторых фрагментов текста, что повысит уникальность, скрывая при этом неуникальные фрагменты. Этот метод работает для таблиц и формул, которых в диссертациях очень много, особенно по техническим специальностям.

- Воспользуйтесь онлайн-сервисом, который заменяет часто встречающиеся слова синонимичными формами или фразами. Он хорошо работает, когда у вас много времени и вы можете вычитать полученный текст, исправлять дефекты и изменять синонимы, которые не были заменены вручную.Этот метод не подходит для технических и медицинских работ, так как к ним просто не найдешь синонимов.

Мошенничество с антиплагиатом: внимание, есть риск, что учитель сожжет

Большинство инструментов повышения уникальности платные и не всегда эффективные, поэтому вам следует несколько раз подумать, прежде чем повышать оригинальность. В противном случае все придется переделывать самостоятельно и в спешке. Часто большинство программных инструментов нацелены на выявление пробелов в программах борьбы с плагиатом.Поэтому, получив отличную уникальность в рамках одной услуги, не факт, что она останется после тщательной проверки на платных ресурсах. Если есть возможность, желательно сразу доверить работу профессионалу, чтобы потом не беспокоиться об избавлении от повторяющихся фрагментов.

Несколько советов о том, как бесплатно обойти систему антиплагиата

Эти советы особенно важны для студентов и студентов, которые решили самостоятельно корректировать работу.

- В каждом учебном заведении есть базовая программа для проверки уникальности, ее необходимо скачать;

- Проверьте готовый текстовый файл, чтобы получить информацию о его уникальности;

- Выберите один из предложенных вариантов повышения уникальности;

- Внесите свои собственные настройки. Желательно сделать копию с оригинала, чтобы все можно было исправить в случае неудачи;

- Довести работу до необходимого уровня уникальности с запасом 5-6%;

- Сохраните результат.

Все подсказки помогут решить главный вопрос школьника, как самостоятельно обойти антиплагиат, и при этом сохранить семантическую начинку.

- Опытный и высококвалифицированный преподаватель без проблем сочтет неправильным то, что в работе много плагиата и она скачивается из Интернета. Можно обойти программы антиплагиата, но профессионального преподавателя в своей области нет. За годы своей работы он просмотрел сотни работ по разным темам и сразу же раскроет ранее сданные работы, если они не будут существенно обработаны профессионалами.

- Все темы курсовых и дипломных работ в старших классах не меняются годами. Все они так много раз сдавались, что не знать прошлогодней работы очень проблематично. Те учителя, которые вообще не читают работу, не заметят, что работа не уникальна и, возможно, тупо скачана из Интернета.

- Когда учитель сбрасывает форматирование, он видит, что все слова в работе подчеркнуты красным и ученик пытался пройти антиплагиат, а соответственно и он сам.Учитель может просто выборочно взять несколько произведений из работы и набрать их вручную в любой поисковой системе и узнать, откуда работа была скачана.

Как бы ученик ни пытался самостоятельно обмануть систему антиплагиата — результат всегда печальный, поэтому — творчески переписать текст работы с сохранением смысла и ни один преподаватель не сможет ничего доказать и не принять работу !

Наш сайт предоставляет услуги по повышению уникальности вашей студенческой работы по Антиплагиату. ru система, антиплагиат. Университет, RUKONText, Etxt, Advego, Text ru. Если описанные выше действия кажутся вам очень сложными и трудоемкими, или у вас совсем нет на это времени, доверьте эту работу профессионалам! Заполните форму на нашем сайте, выбрав интересующую вас систему проверки уникальности, и наши специалисты оперативно свяжутся с вами!

ru система, антиплагиат. Университет, RUKONText, Etxt, Advego, Text ru. Если описанные выше действия кажутся вам очень сложными и трудоемкими, или у вас совсем нет на это времени, доверьте эту работу профессионалам! Заполните форму на нашем сайте, выбрав интересующую вас систему проверки уникальности, и наши специалисты оперативно свяжутся с вами!

Не всегда удается добиться высокой (разумеется, по антиплагиатным системам) оригинальности произведения, так как в Интернете уже размещено огромное количество различных работ и текстов.Этот вопрос очень популярен среди студентов и авторов, пишущих на заказ, поскольку приходится использовать информацию из Интернета, а она редко бывает оригинальной и уникальной.

В нашем обзоре мы собрали советы, которые могут помочь авторам и студентам повысить процент оригинальности своих работ.

Итак, вы написали работу (неважно, курсовую это или статью), вы проверили ее через службу проверки заемщиков, например, «Антиплагиат» и ох … эта система говорит, что текст на 60% не уникален.Это происходит и будет с каждым годом все больше и больше.

2. При переписывании читайте сразу несколько предложений, это позволит не потерять основную идею, выраженную в тексте;

3. поменять местами абзацы;

4. в обязательном порядке менять заголовки;

5. взять материалы из нескольких источников;

6. Не копируйте даже предложение целиком;

7. использовать синонимайзеры;

8. использовать программы для проверки уровня заимствований; они выделяют неоригинальный текст.

Повысить оригинальность курсовых и диссертационных работ описанными выше способами крайне сложно, так как часто приходится использовать устоявшиеся выражения, обоснования и т. Д. Также практически невозможно добиться высокой оригинальности работы, если работа написана. по технической теме.

Если вам нужно сделать работу оригинальной для службы проверки на плагиат, вы можете обойтись без всех описанных выше уловок, наш сайт онлайн-сервиса вам в этом поможет

сайт — без изменения текста, повысит оригинальность текста любой работы до нужного вам процента всего за несколько минут. И ни одна программа или сервис не усомнятся в оригинальности и уникальности вашего текста.

И ни одна программа или сервис не усомнятся в оригинальности и уникальности вашего текста.

На все вопросы о нашем онлайн-сервисе вы можете получить ответы в разделе часто задаваемых вопросов.

Прежде чем приступить к работе с оптимизацией, следует запомнить главное правило современного SEO-продвижения — вся информация должна быть для людей! Не должно быть бесполезной информации и «московские двери дешевы», что нигде не будет смотреться естественно. В Яндексе вы не найдете в ТОП-100 таких сайтов — они ушли в прошлое.Ниже мы расскажем, как составить необходимую комбинацию из сложного «ключа».

Опытный автор, который обычно пользуется спросом у клиентов:

⦁ Подписан на список рассылки авторитетных источников, следит за новой информацией, знает, как выбираются ключи и строится сайт.

⦁ Имеет навыки продавца автоответчика, интригует без вопросов клиента.

⦁ Идеально — подбирает «ключи» для статьи, опытной рукой соединяет их между собой.

Список необходим для эффективного продвижения сайта. Если все будет сделано правильно, к нему обратятся новые клиенты. Без работы опытного автора сайт не сможет найти своих клиентов.

Даже если нанять дизайнеров и создать красочную комфортную атмосферу, это не поможет увеличить количество пользователей. Один из важнейших критериев — уникальность текста на Яндексе или Гугле.

В чем уникальность артикула?

Это основной инструмент для качественного содержания сайта.Каждая новая статья регистрируется в поисковой системе как принадлежащая определенному сайту. Вы не можете сделать копию — контент не может быть размещен, так как он будет дубликатом существующего. Это невыгодно ни поисковой системе, ни людям, ищущим ответ на вопрос.

Где проверить текст на уникальность

Для этого существуют специальные сервисы, отслеживающие повторяющиеся статьи. Самые большие — это текст ru () и. Во втором% будет немного ниже, в первом — выше.Где лучше проверить уникальность текста? Однозначного ответа нет, но большинство предпочитает text. ru, он более лоялен к статьям, а его алгоритмы наиболее близки к поисковым системам.

ru, он более лоялен к статьям, а его алгоритмы наиболее близки к поисковым системам.

- Какой должна быть уникальность копирайтинга на text.ru

Действительно минимум 95%, в идеале 100%. Номер указан чуть выше скопированной статьи. Копирайтинг — это информация, основанная на личном опыте.

- Какой должна быть уникальность перезаписи текста.ru

Если заказчик указывает в тех. Переписывание задания — это означает, что вам нужно сделать точную копию существующей статьи. Допустимое значение — 90-95%. Но повысить уникальность текста с 95% до 100% не составит труда (см. Ниже), поэтому часто можно соблюсти требуемые 100%.

В чем должна быть уникальность копирайтинга на advego.ru? Добиться 100% уникальности текста намного сложнее, чем в text.ru. Поэтому клиенты часто устанавливают стоимость копирайтинга 95-97%.

- Какой должна быть уникальность переписывания на advego.ru

Значение может варьироваться от 85 до 95 процентов. Но этот сервис не так популярен, как text.ru из-за немного завышенного алгоритма. Уникальность Advego нужна требовательному заказчику и опытному, крепкому нервному автору, хорошо разбирающемуся в тематике.

Где еще проверить текст на уникальность? Сервисов много, а точнее сколько бирж копирайтинга — столько версий документов.На старых% будет меньше, на новых — больше. Часто их алгоритмы не соответствуют действительности, они могут приукрашивать или наоборот — слишком высокие критерии. Лучший ответ на вопрос, где «проверить текст на уникальность?» Есть сайт text.ru.

Как добиться хорошей уникальности документа

Правило №1 — прежде чем проверять тексты на уникальность, нужно хоть немного разобраться в теме статьи. Новичкам не хватает словарного запаса синонимов, чтобы сделать точную копию существующей статьи.Если сравнить тексты — они будут очень похожи, но с переставленными словами, что не увеличивает%.

- Как написать продающий текст для сайта

Для этого необходимо обладать навыком «глухого продавца», то есть самостоятельно угадывать мысли читателей без их вопросов. Последний не станет листать до конца и слушать глухого продавца, чтобы узнать информацию, если ему это не интересно. Автор должен уметь преподавать информацию, чтобы клиент не задавал ни единого вопроса и не уходил от скуки.

Последний не станет листать до конца и слушать глухого продавца, чтобы узнать информацию, если ему это не интересно. Автор должен уметь преподавать информацию, чтобы клиент не задавал ни единого вопроса и не уходил от скуки.

Приходит только с опытом и качественно, продающая статья считается верхушкой айсберга копирайтинга. Добиться уникальности текста удастся, если у вас будет достаточно знаний в данной теме или достаточный запас синонимов для выделенных неуникальных фраз.

- Как определить уникальность текста

Для этого необходимо скопировать написанную статью в специальное поле, указанное на сайте text.ru.

После этого фиолетовым цветом выделяются неуникальные фрагменты.Замените их синонимами, тогда вам нужно будет сравнить тексты. Если выделение пропадает, значит, мы все сделали правильно.

Как повысить уникальность документа

- Как увеличить процент уникальности текста в сервисе text.ru

Для этого с помощью сервиса http://jeck.ru/tools/SynonymsDictionary вы можете искать подходящие синонимы для выбранных слов. Так вы сможете быстро и качественно повысить уникальность документа.Также еще один ответ на вопрос «Как добиться или как сделать хорошую уникальность» может быть перефразированием предложения с конца.

Перед тем, как увеличить процент уникальности, вы можете заранее ознакомиться с предложением. Таким образом можно повысить уникальность документа.

- Как повысить уникальность текста с помощью субтитров

Необходимо ввести их в поиск, сравнить между собой, выбрать наиболее подходящий синоним для совпадений.

Какова роль субтитров в статье

Они играют главную роль, так как поисковые системы проверяют на уникальность между собой все аналоги. Часто покупатели задаются вопросом «Как повысить уникальность текста?» указывают в задаче придумать уникальные подзаголовки.

- Какой должна быть уникальность текста при использовании выдающихся неуникальных ключей

До 90%, если ниже, сообщить заказчику о необходимости уменьшения ключей.

Следует использовать менее часто используемые слова («свяжитесь с нашим консультантом»).

- Как сделать фрагмент документа, который никоим образом не становится уникальным, уникальным

Разбавляем его вставкой слова / фразы в середине предложения.

Еще один способ из категории «как увеличить процент уникальности» — это встраивать неуникальные фрагменты в списки.

В документах в формате Word есть специальные символы вверху, маркированные и нумерованные списки:

Таким образом, вы можете сами повысить оригинальность текста в антиплагиате.Опытные копирайтеры не рекомендуют использовать программы для автоматического повышения уникальности. Для удобства ввода одних и тех же ключей допускается использование макросов, находящихся в Word во вкладке «Вид» справа.

- Как определить уникальность текста в Advego Plagiatus

Перед проверкой необходимо скачать программу с сайта advego.ru. Затем скопируйте статью в поле и щелкните значок Инь-Ян вверху, указывающий на глубокую проверку:

- Что должно быть уникального при копирайтинге в программе Advego Plagiatus

- Что должно быть уникального при выполнении перезаписи?

В пределах 90-95% при выполнении задачи лучше всего уточнять детали с заказчиком, чтобы не было инцидентов и изменений.

- Какой должен быть процент уникальности текста при воспроизведении статей

В пределах 90-95%, так как это глубокая перезапись. При этом уникальность текста на сайте text.ru должна быть в пределах 93-97%. При том, что при воспроизведении статей появляется много персонажей, которые нигде не встречаются.

При копирайтинге уникальность текста на сайте text.ru должна быть не менее 95%. Теперь, изучив материал, можно довести его до совершенства.

Все дело в словах. Почему искусственный интеллект может улучшить ваш текстовый контент

Написание вдохновляет, но это также трудоемкое занятие, которое может утомлять. К счастью для всех писателей в мире, искусственный интеллект может помочь сделать ваше письмо быстрее, эффективнее и даже интереснее для вашей аудитории .

К счастью для всех писателей в мире, искусственный интеллект может помочь сделать ваше письмо быстрее, эффективнее и даже интереснее для вашей аудитории .

Эксперты говорят, что робот сам напишет статью только тогда, когда он сможет пройти тест Тьюринга, и ни одна машина еще не достигла этой цели.

Тем не менее, , даже если он еще не может стать следующим Хемингуэем, искусственный интеллект может — как это часто бывает — изменить ситуацию на . Неспособность конкурировать с писателями-людьми на равных не означает, что у технологий искусственного интеллекта нет потенциала.

Сегодня мы увидим, как ИИ может улучшить написание текста и выделить ваш контент.

Как ИИ может улучшить ваше профессиональное письмо

Всегда была проблема, которая заключалась в точности и эффективном использовании инструментов .Некоторые профессиональные писатели, такие как Джордж Р. Мартин — автор знаменитой саги A Song of Ice and Fire — говорят, что инструменты бесполезны для людей с уже хорошо развитыми письменными навыками.

Написать привлекательный и привлекательный контент — трудный, но увлекательный занятие. Каждый, кто пишет о работе, прекрасно знает , как это делать и насколько это может быть сложно . Если вы профессиональный писатель, вы также знаете, что вам нужно выиграть несколько испытаний, чтобы ваша работа продолжалась.

Прежде всего, вам нужно выбрать и идея — хорошая . Затем вы просматриваете веб-страницы, чтобы убедиться, что эта небольшая подсказка ценна и что исходных материалов достаточно. Может быть, вы даже могли бы подчеркнуть пару многообещающих предложений. Опять же, вы пишете стиль , систематизируйте свои идеи в связную статью .

Только после этого вы можете положить руки на клавиатуру и начать строить свой кусок письма . Вам нужно будет найти лучший способ сформулировать свое сообщение, и это может занять некоторое время. Вы должны учитывать такие элементы, как стиль, целевая аудитория, SEO (для цифровых публикаций) и качество вашего контента.

Вы должны учитывать такие элементы, как стиль, целевая аудитория, SEO (для цифровых публикаций) и качество вашего контента.

Конечно, это еще не конец. Вы перечитаете свою работу, и вы, вероятно, что-то измените — например, слишком сложное предложение. И последнее, но не менее важное: вы загрузите его на свой веб-сайт и будете продвигать в социальных сетях с помощью спонсорства и рекламы.

Это долгий и сложный процесс. Есть что-нибудь, чтобы упростить? Это и есть Искусственный интеллект .ИИ может помочь всему процессу написания разными способами, от поиска источников до проверки того, насколько свободно написана ваша статья. Он может сделать это самостоятельно практически в кратчайшие сроки, позволяя вам писать более конкретный, лучше написанный контент за меньшее время, чем когда-либо.

AI также становится лучше в распознавании контекста и понимании смысла написанного текста. Мы увидим пару ситуаций, в которых ИИ потенциально может спасти ваш синдром белой страницы.

- Проверка качества контента .Как узнать, настолько ли хороша ваша статья, как вы надеетесь? Если у вас нет никого, кто мог бы это проверить, вы можете попросить ИИ помочь. Многие инструменты могут делать именно это; они проверяют качество вашего письма и даже его читаемость . Если вы обеспокоены неправильным словом или написали слишком длинное предложение, они помогут вам облегчить беспокойство. Грамматика — один из самых важных инструментов для этого. Еще один инструмент, который может помочь вам достичь поставленных целей по качеству контента, — это Hemingway. Это онлайн-редактор письма, который использует ИИ для выявления проблем с письмом с помощью НЛП, а также ошибок и элементов цветовой кодировки до совершенства.

- Найдите идеальный источник . Если вы когда-либо что-то писали, вы прекрасно знаете, насколько болезненным может быть прокрутка веб-страниц в поисках ценных источников.

AI может помочь вам сэкономить времени и энергии и найти именно тот товар, который вам нужен . Как это сделать? Это может быть сделано разными способами, например, путем составления краткого изложения темы конкретной статьи. Воспитывайте свое вдохновение, выбирая для вас тематические сообщения и новости.

AI может помочь вам сэкономить времени и энергии и найти именно тот товар, который вам нужен . Как это сделать? Это может быть сделано разными способами, например, путем составления краткого изложения темы конкретной статьи. Воспитывайте свое вдохновение, выбирая для вас тематические сообщения и новости. - Упрощение написания контента .Может ли ИИ ускорить написание контента? Да, оно может! Content Creator — это инструмент GhostwriterAI, разработанный, чтобы помочь вам создавать новый текстовый контент за половину времени . Он использует искусственный интеллект для извлечения ценных фрагментов контента из выбранных вами источников, поэтому вам не нужно начинать с нуля. Более того, он изучает ваш стиль письма. Чем больше вы напишете, тем больше это поможет вам автоматизировать написание.

- Больше никакого плагиата . Плагиат — одно из худших вещей, которые могут случиться с писателем.Иногда это даже бессознательно или непреднамеренно, но бывает. Вы можете скопировать предложение из этой интересной статьи и забыть вставить источник, или сделать это намеренно. Неважно, действуете ли вы добросовестно, это все равно неправильно и наказывается за вашу статью. Как этого избежать? Программное обеспечение AI может анализировать предложения, которые вы пишете, и сканировать Интернет, чтобы выяснить, есть ли подозрительное совпадение с чьей-то бумагой .

Freepik

Почему ИИ не заменит писателей-людей (пока)

Даже если использовать ИИ для написания необычных звуков, мы должны помнить, что маловероятно, что робот когда-либо полностью возьмет на себя работу журналиста.

Как мы уже говорили, это потому, что ни одна машина никогда не проходила тест Тьюринга, но есть еще . Искусственный интеллект и машинное обучение — два удивительных метода, которые иногда могут показаться волшебными. Однако они по-прежнему машины, подчиняющиеся приказам.

Это означает, что им не хватает одного фундаментального качества навсегда писателя, которым является творчество . Эмоции и навыки рассказывания историй имеют решающее значение для создания значимой истории, которая поражает сердца людей, и в настоящее время только люди могут это делать.

Теперь ясно, что AI — не угроза для вашего профессионального писателя, а ресурс , который может облегчить вашу работу. Как с этим справляются технологии? Есть ли уже книги, написанные искусственным интеллектом? Может ли машина написать вдохновляющее эссе, захватывающий роман или захватывающую сагу? Как мы уже говорили, это маловероятно, но ИИ значительно продвинулся в понимании и написании текста. Давайте посмотрим на пару таких потрясающих примеров.

- Книги СБ Эхада .Книги этого загадочного автора месяцами остаются бестселлерами. Неудивительно, что публика в восторге от того, что писатель впервые проявил себя на Оксфордском литературном фестивале. Все звучит захватывающе, но сюрприз был еще больше, потому что фактическим автором был… компьютер с именем 3B1 (на иврите это можно перевести как Шалош Б. Эхад). Рядом с ним — программист Математического института Оксфордского университета, который дал ему жизнь. Код позволял компьютеру просматривать все книги в Бодлианской библиотеке.Результат был невероятным, потому что ноутбук развивался сам по себе и понимал, что люди ценят больше всего.

- AI напишет следующую книгу о Гарри Поттере . Есть роман Роальда Даля «Великий автоматический грамматизатор», в котором суперкомпьютер может сам писать романы для массового производства. По сюжету машина используется для шантажа известных авторов, но, к счастью, реальность немного иная.

Группа программистов создала коллектив под названием Ботник и решила выпускать литературу на основе ИИ .Программа проанализировала семь книг JKR и подготовила первые три страницы новой книги о Гарри Поттере.

Название? «Гарри Поттер и портрет, похожий на большую кучу пепла». Продукт оказался на удивление убедительным, хотя и не безупречным.

Название? «Гарри Поттер и портрет, похожий на большую кучу пепла». Продукт оказался на удивление убедительным, хотя и не безупречным. - AI в журналистике . ИИ становится огромным подспорьем в журналистике. Например, Forbes использует AI, чтобы предоставить журналистам и репортерам шаблоны и первые черновики для написания следующей статьи . ИИ работает путем преобразования данных в реальном времени в беглое повествование.

Что дальше? Вероятно, следующей революцией станет NLU (понимание естественного языка), которая заставит людей и компьютеры понимать друг друга.

Мы не знаем, что произойдет, но нам не терпится увидеть это!

Выводы

- Написание текста — важная задача для маркетолога, но это может быть тяжелая работа. AI может помочь вам сделать это проще и быстрее.

- AI становится лучше в распознавании контекста и понимании смысла написанного текста.Это может помочь писателю во многих отношениях, от предотвращения плагиата до проверки источников.

- AI может помочь вам писать, но у него нет (пока?) Творческих способностей для создания оригинального и связного текста самостоятельно.

Источники

Представляем DeepText: механизм распознавания текста Facebook

Текст — распространенная форма общения на Facebook. Понимание различных способов использования текста на Facebook может помочь нам улучшить взаимодействие людей с нашими продуктами, независимо от того, просматриваем ли мы больше контента, который люди хотят видеть, или отфильтровываем нежелательный контент, такой как спам.

С этой целью мы создали DeepText, основанный на глубоком обучении механизм понимания текста, который может понимать текстовое содержание нескольких тысяч сообщений в секунду на более чем 20 языках с точностью, близкой к человеческой.

DeepText использует несколько архитектур глубоких нейронных сетей, включая сверточные и рекуррентные нейронные сети, и может выполнять обучение на уровне слов и символов. Мы используем FbLearner Flow и Torch для обучения модели. Обученные модели обслуживаются одним нажатием кнопки через платформу FBLearner Predictor, которая обеспечивает масштабируемую и надежную инфраструктуру распределения моделей.Инженеры Facebook могут легко создавать новые модели DeepText с помощью архитектуры самообслуживания, которую предоставляет DeepText.

Мы используем FbLearner Flow и Torch для обучения модели. Обученные модели обслуживаются одним нажатием кнопки через платформу FBLearner Predictor, которая обеспечивает масштабируемую и надежную инфраструктуру распределения моделей.Инженеры Facebook могут легко создавать новые модели DeepText с помощью архитектуры самообслуживания, которую предоставляет DeepText.

Почему глубокое обучение

Понимание текста включает в себя несколько задач, таких как общая классификация, чтобы определить, о чем пост — например, о баскетболе — и распознавание сущностей, таких как имена игроков, статистика игры и другая значимая информация. Но чтобы приблизиться к тому, как люди понимают текст, нам нужно научить компьютер понимать такие вещи, как сленг и определение смысла слов.Например, если кто-то говорит: «Мне нравится ежевика», это означает фрукт или устройство?

Понимание текста на Facebook требует решения сложных задач масштабирования и языковых проблем там, где традиционные методы НЛП неэффективны. Используя глубокое обучение, мы можем лучше понимать текст на нескольких языках и использовать помеченные данные намного эффективнее, чем традиционные методы НЛП. DeepText основывается на идеях глубокого обучения, которые изначально были разработаны в статьях Ронана Коллобера и Яна ЛеКуна из Facebook AI Research.

Понимание большего количества языков быстрее