Google и Яндекс не индексируют сайт: причины, руководство что делать

Форумы вебмастеров пестрят грустными постами по поводу того, что сайт плохо индексируется поисковыми системами. А ведь это основа SEO-продвижения, без которой популяризация интернет-ресурса практически невозможна.

Обидней всего, когда над созданием web-проекта трудился дорогостоящий программист, а на его наполнение контентом ежемесячно тратится внушительная сумма.

Однако Яндекс и Гугл не спешат индексировать отдельные страницы или даже целый сайт. Почему так происходит?

На этот вопрос нет однозначного ответа: существует множество причин.

Важно выявить конкретную проблему (технические ошибки, дубляж страниц, нестабильную работу хостинга или санкции поисковиков) и сделать все для ее решения. Есть хорошая новость — ситуацию можно исправить. Хотите, знать как? Читайте дальше!

Нормы индексации сайтов

В Яндекс

Yandex сканирует и добавляет новые страницы примерно два-четыре раза в месяц. Попасть в поисковую выдачу раньше способны лишь трастовые и часто обновляемые порталы — внушающие доверие сайты индексируются быстроботом Яндекса ежедневно.

Попасть в поисковую выдачу раньше способны лишь трастовые и часто обновляемые порталы — внушающие доверие сайты индексируются быстроботом Яндекса ежедневно.

В Google

Что касается Гугла, обновления могут занять от одного дня до двух недель. Здесь многое зависит от категории вашего сайта. Например, ресурсы с актуальными новостями и живые форумы роботы проверяют с завидной регулярностью.

Материалы часто обновляемых порталов обычно сканируются в тот же день или на следующий. Индексация блога, в котором каждую неделю появляется новый контент, нередко задерживается на 2–4 дня.

Совсем печально обстоит дело с третьесортными сайтами, а также совсем молодыми веб-проектами, только что появившимися в Сети. Поисковые роботы могут игнорировать их в течение месяца.

Важно! Вышеописанные данные актуальны при добавлении малого количества страниц в индекс. При добавлении большого количества страниц одномоментно, скорость индексации может увеличиться в несколько раз.

Особенно долго будут индексироваться страницы с малой ценностью для посетителей.

Что делать, если новый сайт не индексируется поисковиками?

Под это определение подходит ресурс с возрастом домена до полугода, который не имеет обратных ссылок и ранее не продвигался.

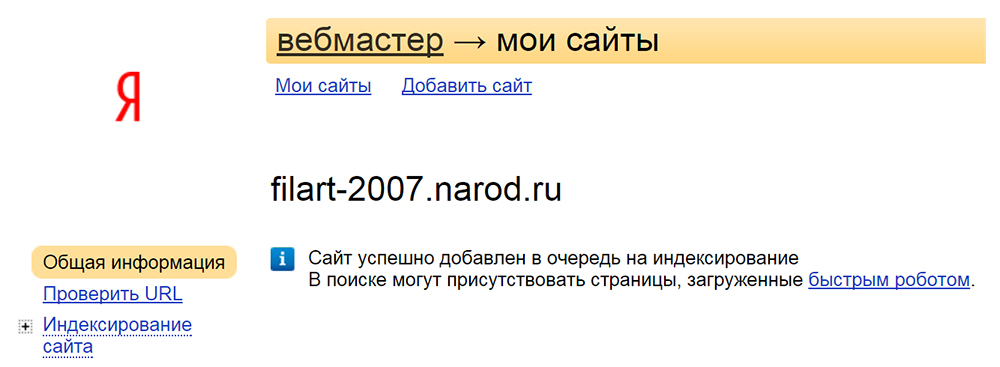

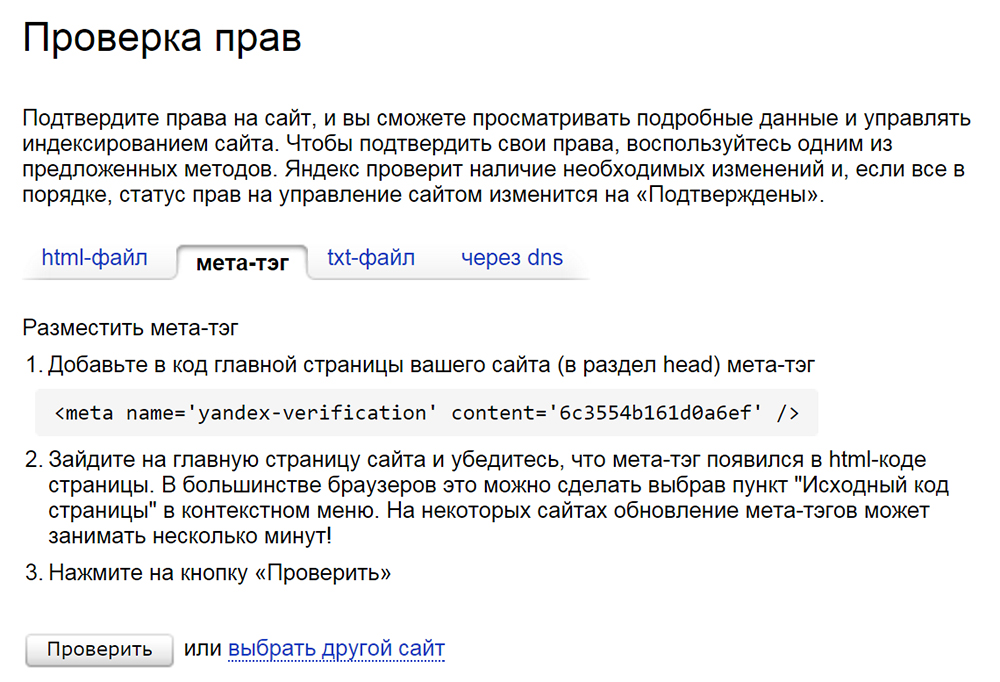

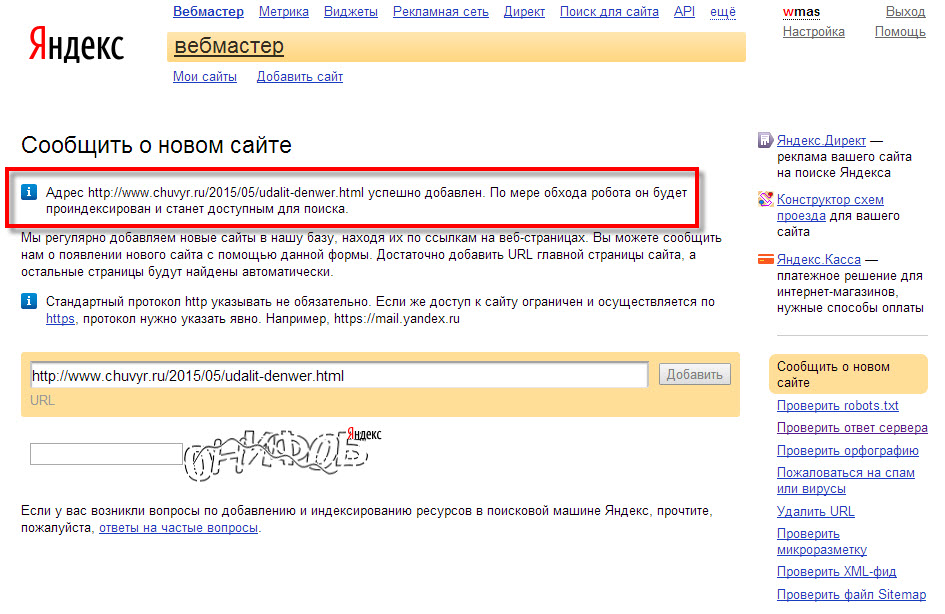

Добавить сайт в панели вебмастеров

Вы только что создали сайт и ждете чуда под названием «быстрая индексация»? Такая стратегия ошибочная, ведь в первое время Гугл и Яндекс не обращают на новый сайт внимание. Помогите своему проекту заинтересовать роботов — сделать это достаточно просто: надо лишь добавить сайт в поисковые системы.

Важно! Использование сервиса Яндекс. Вебмастер и Google Webmaster не только ускорит добавление страниц в индекс, но и позволит эффективнее работать над оптимизацией сайта. Представленные инструменты бесплатно открывают вебмастерам множество возможностей для диагностики, получения рекомендованных для продвижения запросов и привязки сайта к конкретному региону.

Улучшить сайт

Пора заняться внутренней оптимизацией: систематически создавать первоклассный контент, улучшить юзабилити, сделав удобные рубрики, а также позаботиться об адаптивности и перелинковке. После этого следует задуматься о внешнем продвижении. Оно включает в себя работу с социальными факторами и размещение естественных ссылок у надежных доноров.

Если сайт все так же не индексируется Яндексом, необходимо написать в техническую поддержку поисковика. В результате вашего запроса вы получите информацию о наличии бана, фильтра или установите другую объективную причину возникшей проблемы.

Как проверить индексацию сайта?

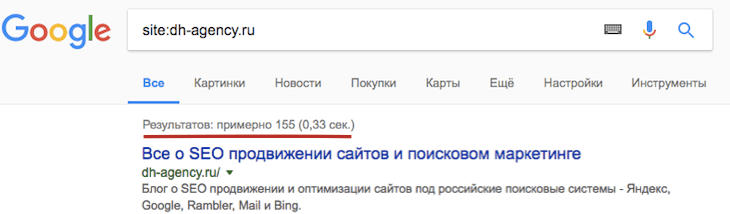

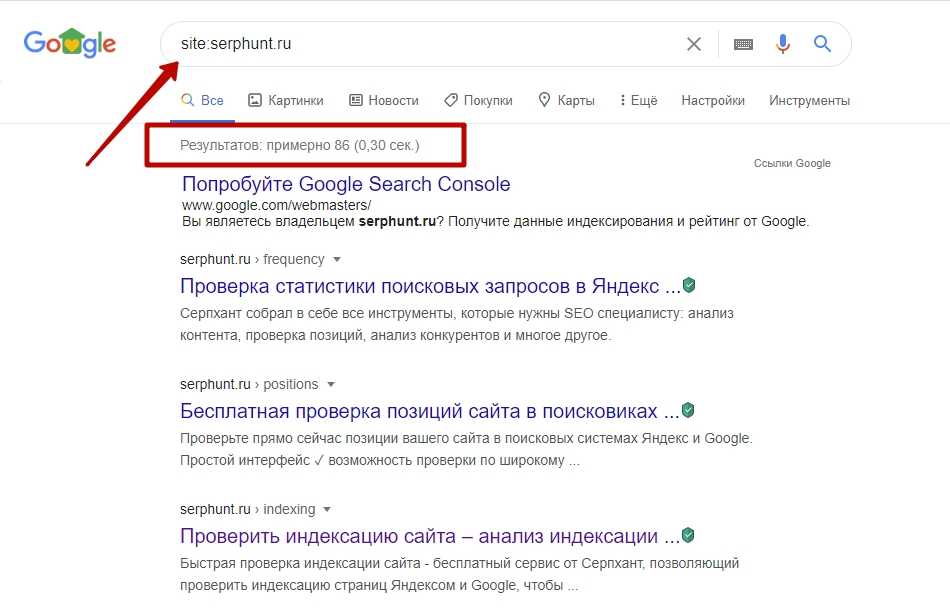

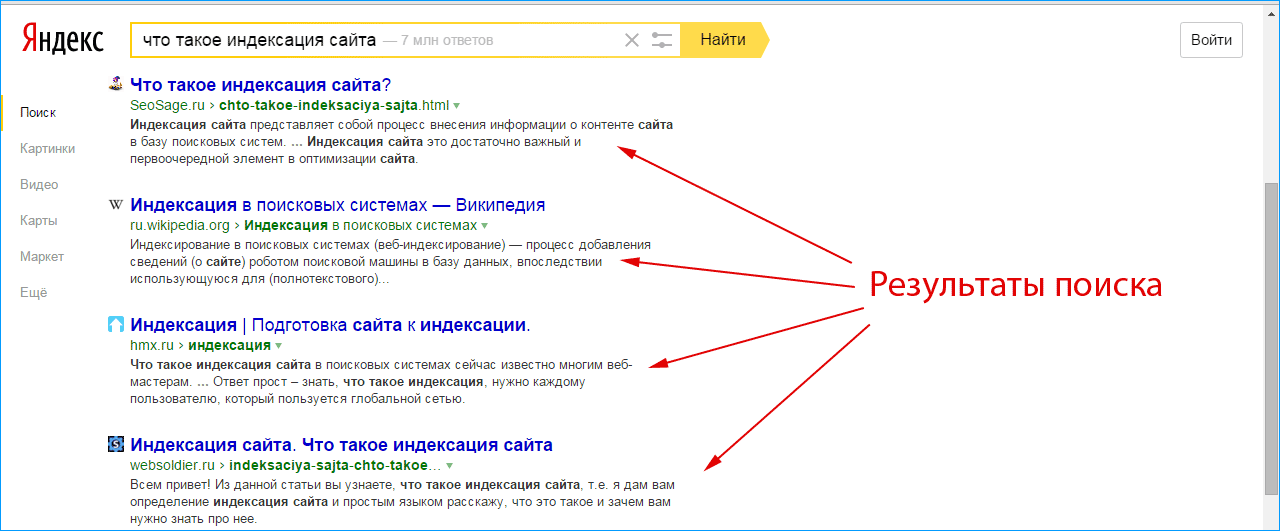

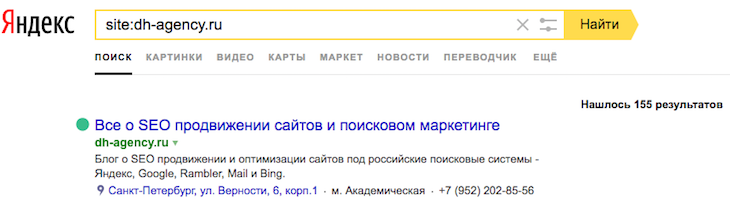

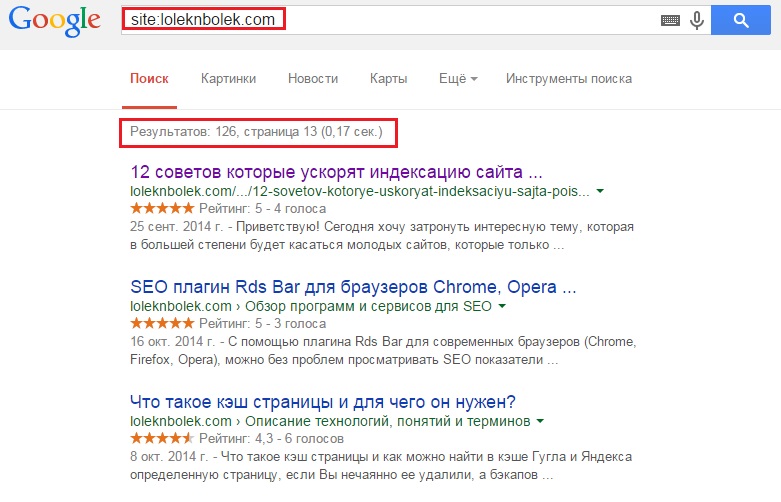

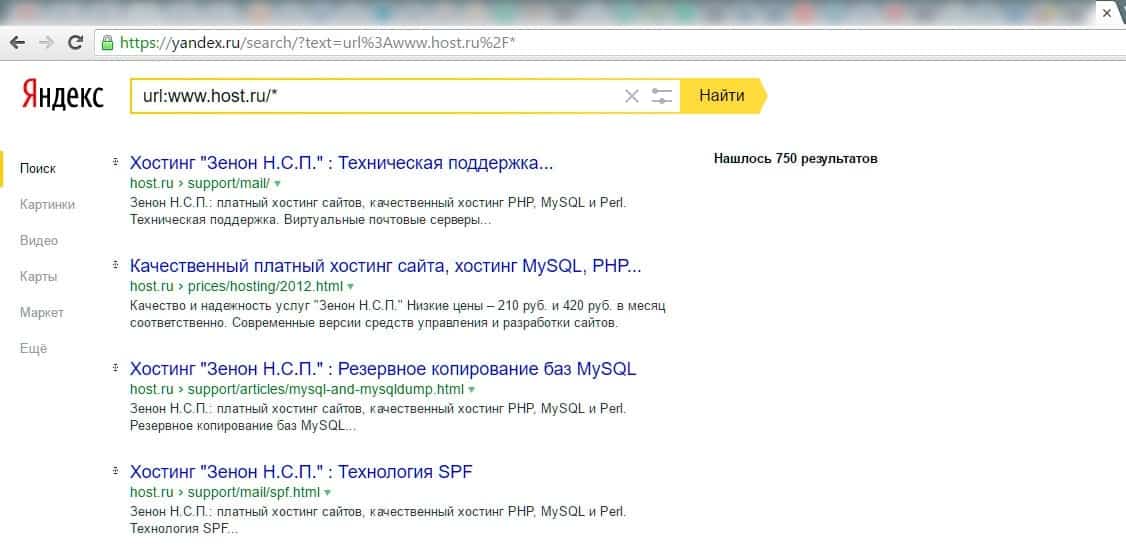

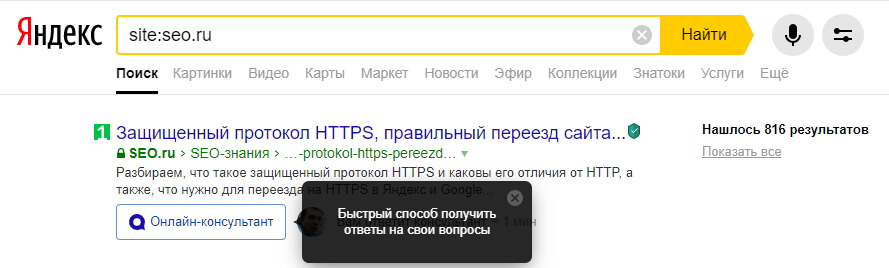

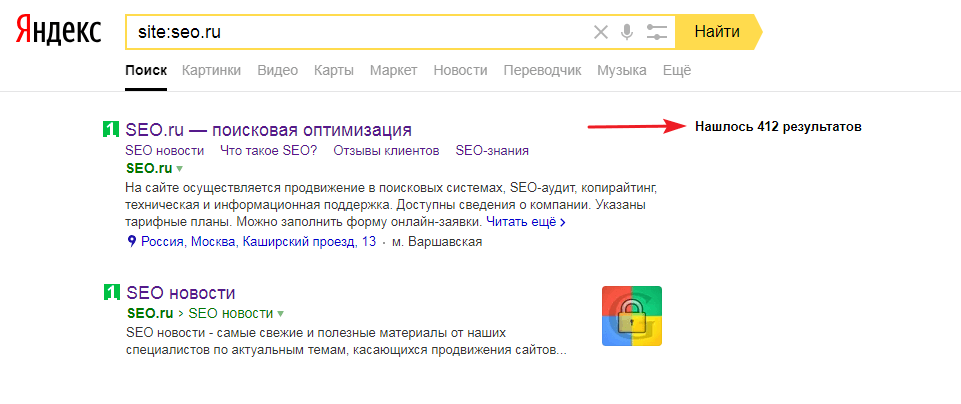

Используйте в запросе оператор Site

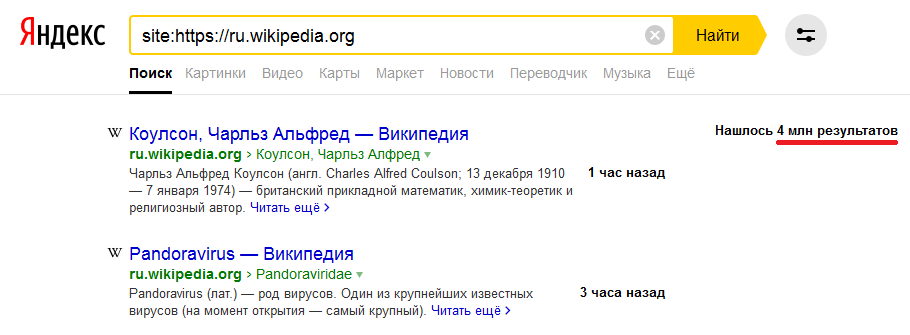

Узнайте количество просканированных и добавленных в индекс страниц путем введения в строку поиска Гугл и Яндекс «site: url вашего сайта». Благодаря дополнительным настройкам легко получить данные о произошедших за конкретный промежуток времени изменения.

К примеру, сегодняшняя проверка российской версии Википедии показала, что за последние 2 недели на этом сайте появилось 143 новых материалов.![]()

Учтите! Разница между показателями разных поисковых систем является поводом для тревоги. Чаще всего это свидетельствует о возможном попадании под фильтр Гугла или Яндекса.

Введите в поисковик url страницы

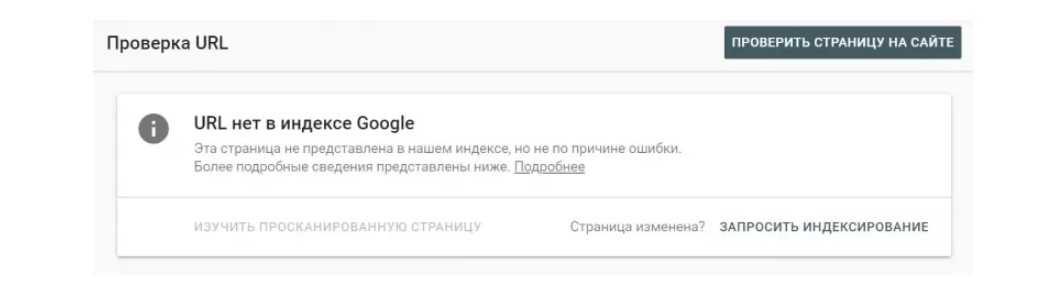

Этот способ идеален для проверки индексации отдельно выбранной страницы.

Для Google

url:https://ru.wikipedia.org/

Для Яндекс

info:https://ru.wikipedia.org/

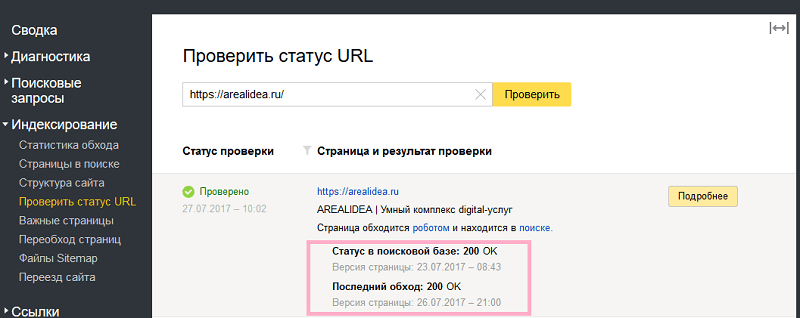

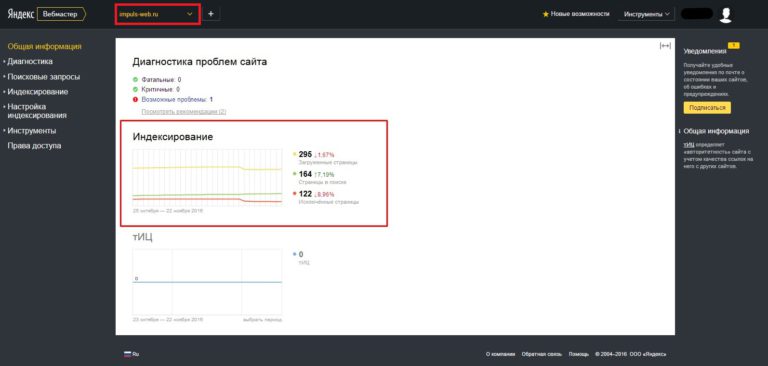

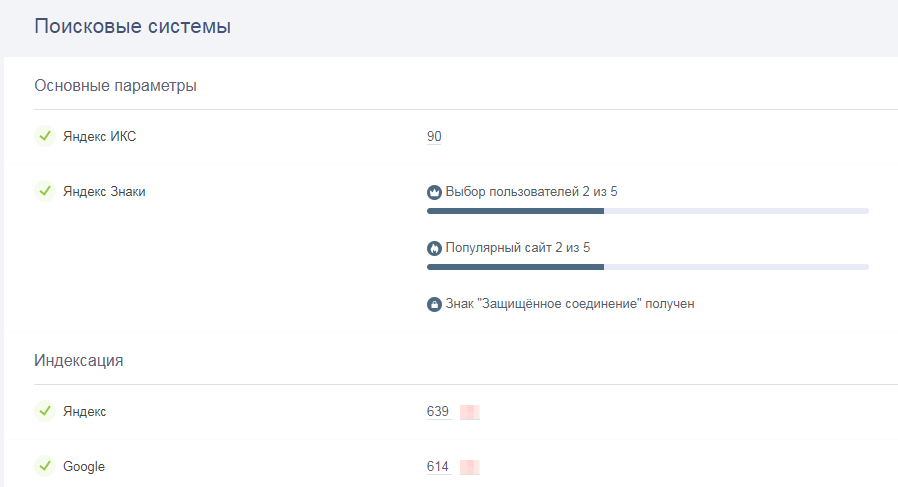

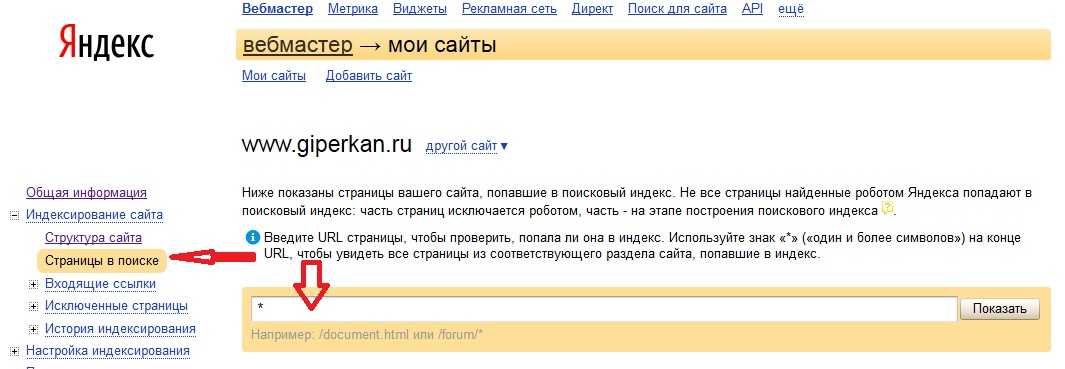

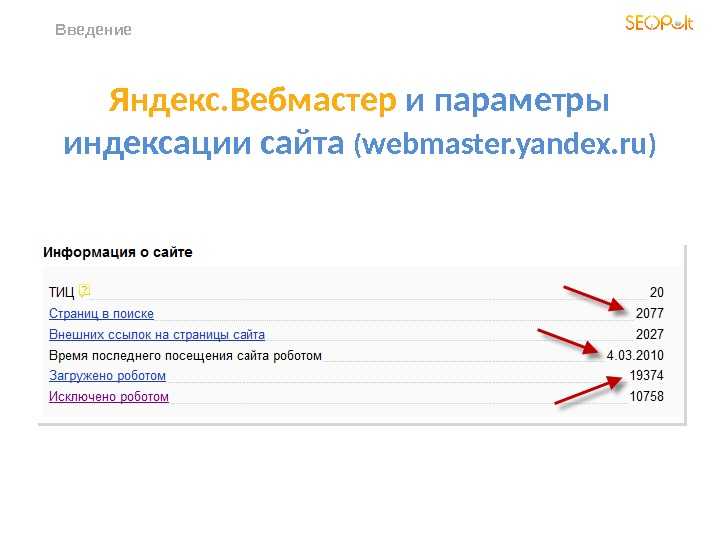

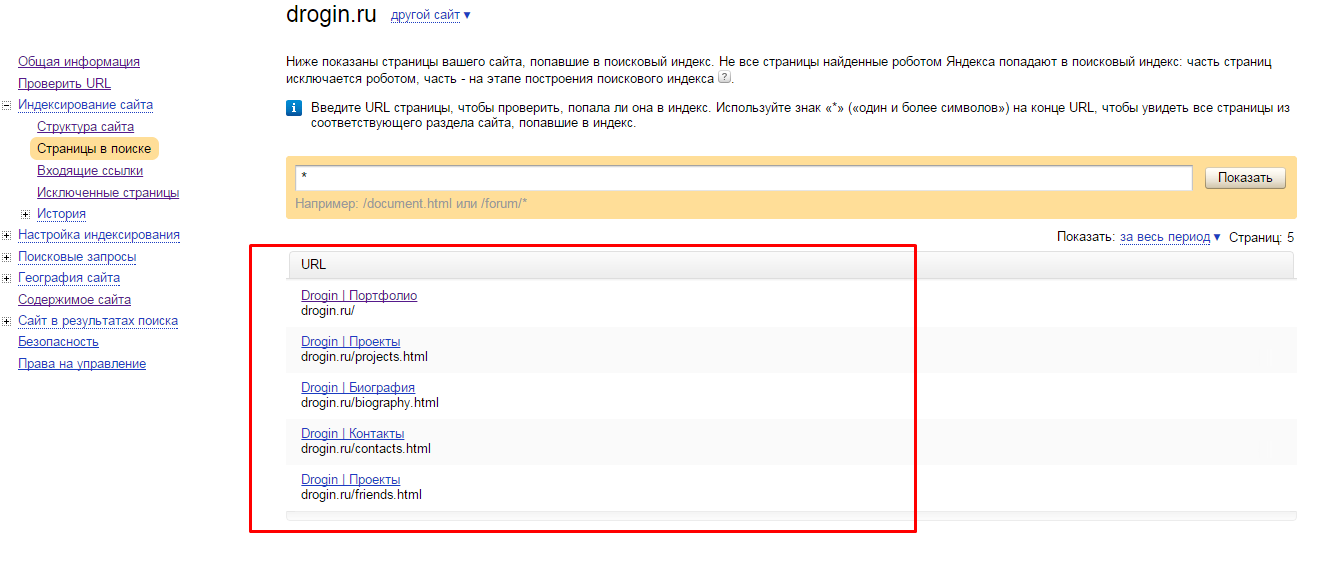

Через панель вебмастеров

Если вы ранее уже зарегистрировались в Яндекс. Вебмастер, то при переходе на данный сервис сразу увидите число загруженных материалов и тех, что находятся в поиске. В идеале их количество должно совпадать или быть похожим на реальное количество страниц сайта.

Более детальную информацию вы получите при переходе на основную панель, после чего необходимо нажать «Индексирование» и «Страницы в поиске».

Анализируя полученный отчет и ищите страницы, которые не индексируются.

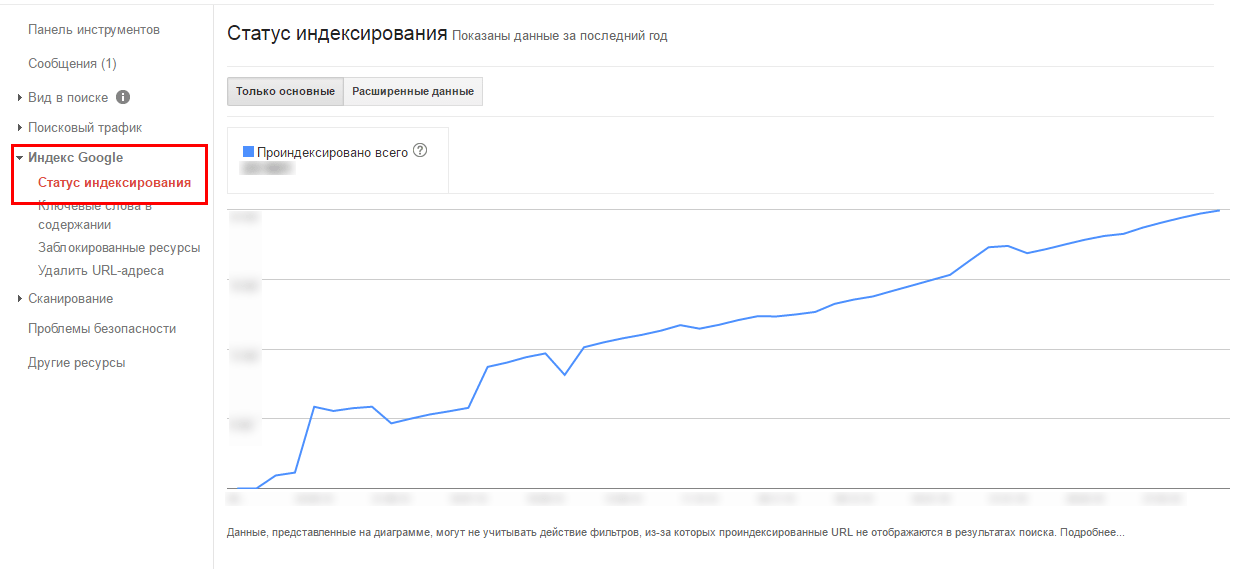

В новом Google вебмастере также есть инструмент для анализа индексации.

С помощью Key Collector проверяем индексацию большого количества страниц

Скачанный и установленный на компьютере многофункциональный инструмент облегчит работу любому оптимизатору. Он позволяет автоматизировать процесс, значит, вам не придется вручную проверять сотни, а то и тысячи документов.

Чтобы воспользоваться этим методом, требуется собрать парсером список всех страниц, а затем добавить перед каждым адресом оператор url для Google или info для Яндекс. Хотите сэкономить время и нервы — воспользуйтесь для этого автозаменой в блокноте. Дальше надо загрузить полученные данные в Key Collector, не забыв о настройке XML для быстрого анализа результатов.

Также, нужно настроить правильно поисковые системы, для корректного парсинга. URL лучше добавлять без смены регистра.

У проиндексированных материалов в графе «Позиция по запросу» будет стоять единица. Сверьте ваш URL со страницей на первом месте. Они должны совпадать.

Это метод не идеален, но имеет право жизнь.

Как решить проблемы индексации?

Вариант 1: Сайт долго не индексируется, роботы не видят свежие материалы — в индекс попадает мало новых страниц, процесс осуществляется медленно.

Узнайте далее, что может быть причиной столь плачевной ситуации.

Редкое обновление контента

Для SEO-продвижения нужно вовремя подкармливать роботов новой порцией качественного контента, тогда они будут чаще заходить на ваш сайт. Причем на поведение поисковиков положительно влияют даже незначительные улучшения старых статей в виде более удачных иллюстраций, обновлений даты публикации или добавления цитаты эксперта.

А вот если робот приходит и видит, что за период его последнего посещения ничего не изменилось, сайт не будет нормально индексироваться в будущем. Более того, ждите ухудшения позиций в выдаче: ресурс, остановившийся в развитии, опережают конкуренты.

То есть

Если вы публикуете не регулярно — это может быть причиной. Если это не ваша ситуация, то читайте далее.

Если это не ваша ситуация, то читайте далее.

Плохое качество контента

За последние годы и читатели, и роботы стали более требовательными к размещенной в Рунете информации. Важную роль играет не только техническая, но и смысловая уникальность / полнота статей, картинок, видео.

При этом ключевые слова должны вписываться в текст естественно, а за переспам есть шанс попадания под фильтры поисковиков.

То есть

Если публикуемый контент малополезен или состоит из 100 слов, то вряд ли он попадет в индекс. Необходимо менять подход к написанию контента или качеству страниц.

Заинтересованы в генерации отличного контента?

Возьмите на вооружение LSI-копирайтинг, который сейчас в почете у поисковых систем. При качественном оформлении, полном раскрытии темы с использованием ключей и списка дополнительных синонимов, ассоциаций вам не придется беспокоиться о том, что страница не будет индексироваться в поисковых системах.

Наличие дубликатов

Секретом успешной технической оптимизации является отсутствие одинаковых мета-тегов и текстов; полных копий страниц. Если таковые имеются, закройте лишние данные от индекса при помощи meta name=«robots» content=«noindex, nofollow» или пропишите на них 301 редирект.

Если таковые имеются, закройте лишние данные от индекса при помощи meta name=«robots» content=«noindex, nofollow» или пропишите на них 301 редирект.

В противном случае поисковики запутаются в похожих документах и удалят их из выдачи.

Проблемы с краулинговым бюджетом

Существует определенный лимит на количество страниц, индексируемых роботом за единицу времени.

Краулинговый бюджет Google напрямую зависит от PageRank ресурса. Чем выше данный показатель, тем большее число документов будет проиндексировано. Соответственно, для масштабных сайтов крайне важно повышать критерий своей ценности путем регулярных обновлений, увеличения посещаемости и приобретения ссылок. Иначе некоторые страницы могут не индексироваться в Гугле.

То есть

Если сайт молодой, то у него низкий краулинговый бюджет. И если вы хотите проиндексировать большое количество страниц, то эта процедура может занять на порядок больше времени.

Технические нюансы для ускорения сканирования

Добавление sitemap.

xml

xmlЭта карта, созданная для поисковых систем, дает роботам возможность быстро найти все страницы, независимо от их числа и уровней вложенности. Кроме того, она повышает доверие к вашему сайту, позволяет указывать дату обновления и расставлять приоритеты.

Алгоритм действий следующий: сгенерируйте sitemap.xml с учетом стратегии продвижения, загрузите карту в корень сайта и добавьте в панели вебмастеров.

Обновление http-заголовков Last-Modified и If-Modified-Since.

Last-Modified сообщает поисковикам о последних изменениях в документе, направляя роботов сразу к обновленным страницам и свежим материалам.

Ответ сервера на запрос If-Modified-Since снижает нагрузку на краулинговый бюджет, к тому же улучшает позиции контента при сортировке по дате.

Проверить этот заголовок можно тут — https://last-modified.com/ru/if-modified-since.html

Вариант 2: Сайт вообще не индексируется в Яндексе и Гугле, страницы выпадают из индекса.

Код ответа сервера

Убедитесь, что страница содержит код сервера 200 ОК — это означает: она действительно существует, доступна к просмотру для пользователей и поисковых систем.

Проверка осуществляется при помощи специальных сервисов.

Например, http://www.bertal.ru/index.php?a1910327/

Если код ответа не 200 ОК, то именно в этом может быть причина не индексации страницы.

Robots.txt

В файле robots.txt недопустимы запреты на индексацию сайта и отдельных страниц, а также работу конкретного поисковика.

Важно! Обязательно проверьте сформированный robots.txt на ошибки. Сделать это можно в Google Вебмастер: нажмите на «Сканирование», а затем на «Инструмент проверки файла robots.txt».

Meta Robots

Часто сайт не индексируется в Гугле, если добавление сведений в базу данных запрещено в мета-тегах. Обязательно удалите в HTML-коде строкии если они есть на важных страницах.

Чтобы проверить откройте код страницы и сделайте поиск строки.

Либо используйте плагины для браузера, такие как расширение Seo Meta in 1 Click для Google Chrome.

Rel Canonical

Многие неопытные оптимизаторы неверно настраивают атрибут rel=canonical.

Хотите, чтобы страница попала в индекс поисковика? Тогда она не должна ссылаться на другой канонический документ.

Чтобы проверить откройте код страницы и сделайте поиск строки.

Либо через тот же плагин

Вебмастера

Используйте Google Webmaster Tools для выявления ошибок сканирования, из-за которых роботы не получают ответы на запросы.

Перейдите в раздел «Просмотреть как Googlebot» введите адрес страницы, и нажмите кнопку «Получить и отобразить».

Когда получите результат, сравните, что видит Google и пользователь. Картинки должны быть одинаковыми. Если нет, то ищите причины блокировки файлов.

Протестируйте скорость загрузки и время ответа сервера. Убедитесь, что выбранный вами хостинг работает стабильно.

Файл .htaccess

Если сайт не индексируется, он может быть заблокирован в файле .htaccess.

Проверьте .htaccess на наличие таких строк:

RewriteCond %{USER_AGENT} Googlebot

RewriteRule. * — [F]

* — [F]

Либо такой вариант, который будет отдавать роботу Google 404 ошибки.

RewriteCond %{USER_AGENT} Googlebot

RewriteRule.* — [R=404]

Поищите в файле другие варианты блокировок с использованием USER_AGENT или названия поисковых ботов: googlebot, yandex и т. д.

AJAX и JavaScript

Распространены проблемы с языками AJAX и JavaScript. Блог Яндекса для вебмастеров рекомендует создать в структуре ресурса определенную схему, которая сообщит поисковым системам о необходимости индексации.

Санкции

Еще одна серьезная проблема — наложение санкций на страницу или даже весь сайт. Узнайте в техподдержке поисковой системы (только Яндекс), за что именно (ссылки, переспам, неуникальный контент) вас наказали, после чего оперативно исправьте ситуацию.

Как уже говорилось ранее, причиной отсутствия внимания к странице часто является низкокачественный и дублированный контент.

Вряд ли робот будет заинтересован в ваших материалах, если в выдаче уже имеются похожие документы, продвигаемые по тому же семантическому ядру.

Негативно влияет на скорость индексирования незрелый возраст домена, а также забаненный ранее б/у домен. В таком случае стоит написать запрос на пересмотр в Яндекс.

Итоги

Если сайт не индексируется Яндексом или Гуглом, значит, на то есть объективная причина. Ваша цель — выявить и решить проблему. Спустя некоторое время необходимо снова проверить индексацию страницы. Если вы все сделаете правильно, положительные изменения не заставят себя долго ждать!

Если у вас сложный случай, рекомендую обратиться за консультацией к специалистам. Команда Livepage проконсультирует и выполнит SEO-аудит, который решит все проблемы с индексацией в поисковых системах.

Как часто яндекс индексирует сайты

Как быстро индексируется сайт в Яндексе, и когда сайт появится в поисковиках, после написания статей?

Для Вас есть бесплатная группа ожидания – ХОЧУ В БЛОГЕРЫ (КЕЙСЫ, ФИШКИ, чего нет в свободном доступе. ) делюсь практическими советами и присылаю ценную информацию по развитию блогов на поиске.

А когда будет набор в Школу Блогеров, сообщу Вам заранее. Жду Вас здес.

Доброго времени суток, уважаемые друзья. Сегодня поговорим про индексацию, и скорость появления вашего сайта в выдаче поисковиков. Начну с того, что у гугл и яндекс по своему относятся к индексации. И у них разные алгоритмы. Так, гугл может быстро проиндексировать сайт, но трафика от такой индексации обычно не будет. Потому как, гугл сам по себе может долго привыкать к сайту. Присматриваясь, насколько он полезен посетителям, насколько уникален контент. То есть, анализирует его. И если всё будет хорошо, уже спустя 3 месяца, запросы встают в рейтинге поиска, и вы получаете первый трафик.

Стоит взять во внимание, что технически сайт должен правильно настроен. Уж больно капризный гугл к лишнему мусору на сайте и дублирующему контенту. Впрочем как и яндекс.

В общем, в гугл ваш сайт может попасть уже через 1-2 дня. А трафик будет позже…

А вот с яндексом, всё гораздо интересней.

Как быстро индексируется сайт в Яндексе?

И вообще, какова скорость индексации сайта яндексом? Смотрите как всё происходит на самом деле. Поисковые системы в открытую не выдают свои алгоритмы работы. Они больше делают намеки. Но основная тонкость в работе поисковиков познается только с опытом. По-этому, много теории, которой полно в дискуссиях на форумах и т.д., она попросту не доказана.

Поисковые системы в открытую не выдают свои алгоритмы работы. Они больше делают намеки. Но основная тонкость в работе поисковиков познается только с опытом. По-этому, много теории, которой полно в дискуссиях на форумах и т.д., она попросту не доказана.

Вообще, чтобы вы понимали, в среде сео специалистов, все друг перед другом «наворачивают умника» — пытаясь доказать свою точку зрения. Я редко когда выступаю с кем-либо в спор на эту тему. И если мне говорят, что — я не прав, абсолютно всё равно. Всегда ориентируйтесь на свой опыт и свое мнение. А ещё лучше смотрите результаты сео специалистов. Они могут вам помочь определиться, кого всё таки слушать!

Так вот. Сейчас, я пишу эту статью, и она довольно свежая… От 11 апреля 2016 года. И в индекс яндекса она может попасть уже через 1 час. Или, чуть позже!

В моем случае, скорость индексации зависит от возраста домена, от доверия поискового робота к моему блогу, и от того, насколько часто я обновляю свои сайт. Чем чаще, обновлять сайт, тем чаще на него будет приходить поисковый робот, и кушать обновления.

Поисковый робот — это такой паучок, которого вы не видите вживую, но на самом деле он постоянно шустрит по миллионам сайтов в интернете, и заносит актуальную информацию в свою поисковую базу. А уже из этой базы, делается выборка, которая участвует в результатах поиска.

То есть, сегодня вы написали статью на сайте, и спустя время, страница появляется под соответствующий запрос в яндексе и гугле. Время и скорость индексации зависит от длительности ведения вашего сайта.

Понятно дело, что минимальное число новых сайтов, будут быстро индексироваться. И для новых сайтов, время индексации может достигает период от 1 до 3 месяцев.

Именно по-этому, так важно на начальном этапе публиковать чаще в своем блоге, чтобы в очередной раз, когда поисковый робот посещает ваш ресурс, он не увидел, что ничего нового не добавилось. А если ничего нового не добавилось, тогда какой смысл ему приходить часто на ваш блог. Буду приходить реже. Например 1 раз в неделю….

…ведь есть и другие сайты, которые чаще обновляются, и чтобы не пропустить все обновления — буду тратить ресурсы лучше на них… А к вам зайду позже!

По-этому, с первых дней ведения блога, думать нужно о контенте. Чтобы приучить этого самого поискового робота. И когда на блоге появляется 1 статья в 2 недели — это просто не актуальный блог для поисковика. Публикуйте чаще!

Чтобы приучить этого самого поискового робота. И когда на блоге появляется 1 статья в 2 недели — это просто не актуальный блог для поисковика. Публикуйте чаще!

Одно дело, когда вы уже завоевали репутацию в поисковиках, и трафик идет. Здесь, соглашусь — вы можете делать паузы, хоть 1 раз в месяц публиковать. И трафик как был так и будет. И посещаемость блога может быть неизменной.

Но совсем другое, когда о блоге не знает поисковая машина. И вы просто сами не пытаетесь его продвигать…

Частота наполнения — крайне важна. Особенно на первых этапах ведения блога!

Представляете, позже… Когда ваш сайт завоевал позиции, и репутацию в поисковиках, ваш контент будет появляться спустя 1 час. То есть опубликовали, и уже спустя время получаем новых посетителей. Создается просто трафиковая машина. Механизм, по генерации посетителей!

Нет ничего удивительного в скачках посещаемости на сайтах, которым больше года. Когда посещаемость с 1000 посетителей в сутки, подпрыгивает до 3 тыс. и более за 1 неделю написания статей.

и более за 1 неделю написания статей.

Но на новых сайтах, такое крайне редко.

Если конечно, у вас нету большой базы читателей или большой группы людей, которые прочитают новую статью, и начнется на неё информационный шум. Начнутся дискуссии, люди начнут делиться информацией в социальных сетях (нажимая кнопки), на форумах упоминать вашу статью и т.д. В этом случае, роботу ничего не остается, как быстро проиндексировать ваш сайт, и добавить в поисковую базу. Потому как, он увидит, что на публикуемую информацию идет много разговоров на внешних источниках. И соответственно, сайт полезен!

И чтобы ускорить индексацию, вы можете вручную размещать ссылки на новые статьи в социальных сетях. Или просто нажимать классы и лайки на новой записи, отправляя пост в заметки. Всё это, поможет оповестить робота как можно быстрее о новой статье вашего блога.

Есть сайты, которые поисковые роботы и вовсе не покидают. Они постоянно живут на этих сайтах, и переходят со страницы на страницу. И упоминания на таких сайтах, вашего нового сайта, быстро может проиндексировать ваш контент.

И упоминания на таких сайтах, вашего нового сайта, быстро может проиндексировать ваш контент.

Но стоит понимать, что есть основной робот, а есть БЫСТРО РОБОТ, который может добавить вас в выдачу уже через 1-3 часа:

В поиске появляется новая страница вашего блога под соответствующий запрос, и рядом жирным показано, когда была добавлена эта страница. Это БЫСТРО РОБОТ добавил в индекс АКТУАЛЬНУЮ информацию.

Мне всё равно, как этот робот называется на самом деле. Просто вы должны понимать, что есть такой зверек, который быстрее основного робота добавляет в выдачу актуальный контент.

Спустя время, например через 48 часов, актуальная статья может потерять позиции. И соответственно трафик снизится. А когда пройдет время полной индексации яндекса.

Как быстро Яндекс индексирует сайты в интернете?

Примерный срок от 1 до 3 месяцев. То есть, за это время, если есть уже информация добавленная быстрым роботом в выдачу, может вновь встать на релевантные места. При условии, что статья добавленная ранее — была настолько актуально, что люди попадая на неё, делились ей и в социальных сетях, и оставляли комментарии. То есть, были взаимодействия с контентом.

При условии, что статья добавленная ранее — была настолько актуально, что люди попадая на неё, делились ей и в социальных сетях, и оставляли комментарии. То есть, были взаимодействия с контентом.

Так, можно занимать высокие позиции под жирные поисковые запросы.

Чтобы анализировать частоту обновления поисковой базы яндексом, можно также использовать всеми известный в среде СЕО СПЕЦИАЛИСТОВ, сайт под названием: http://tools.promosite.ru/

Правильные апдейты яндеса, что показывает сайт?

Переходим на сайт, и смотрим. Что 6 апреля 2016 года, было изменение выдачи на 80.6%, и был выложен текстовый индекс по 30 марта.

То есть, если к 30 марта, поисковый робот побывал на вашем сайте, и заметил изменения, то к 6 апрелю статья может появится в выдаче. Это всего лишь, 7 дней.

По-этому, пишите чаще, и не отвлекайтесь на всю эту ерунду.

Есть просто изменение в выдаче, а есть с добавлением текстовых апдейтов, когда робот добавляет новые статьи в свою базу. И именно в эти текстовые апдейты, если вам повезло и к этому моменту на сайте был робот, вы и попадете в индекс.

И именно в эти текстовые апдейты, если вам повезло и к этому моменту на сайте был робот, вы и попадете в индекс.

Пишите чаще, чтобы приручить поискового робота, чтобы к каждому апдейту, добавлялось всё больше и больше контента, который будет участвовать в выдаче, и соответственно привлекать всё больше посетителей из поисковых систем. Так, каждую неделю можно легко увеличивать трафик на блоге. Вы сами видите как быстро может индексироваться сайт.

Главное, чтобы изначально робот узнал о сайте, и как можно чаще его посещал.

А по уму, не морочьте себе этим голову — как часто и когда проиндексируется мой сайт… Просто пишите, и всему свое время.

И не забывайте правильно писать и подбирать запросы в поисковых системах, чтобы сайт был посещаемым, а не просто так.

Как часто Яндекс индексирует сайты

Привет, Друзья! Очень часто вы задаёте мне следующие вопросы: — «почему мой сайт долго индексируется», «как часто яндекс индексирует сайты», «могут ли мой контент украсть до индексации и обвинить меня в воровстве», как ускорить индексацию сайта яндексом» и так далее. Ответов на почту всем интересующимся я послал более 50 и решил упростить свой труд и ответить на вышеописанные вопросы в этой статье, так сказать убить двух зайцев с одного выстрела))) Итак, начинаем охоту!

Ответов на почту всем интересующимся я послал более 50 и решил упростить свой труд и ответить на вышеописанные вопросы в этой статье, так сказать убить двух зайцев с одного выстрела))) Итак, начинаем охоту!

Как часто Яндекс индексирует сайты

Давайте сначала разберем два понятия, индексация и апдейт. Постараюсь кратко написать, что они из себя представляют и с чем их едят.

Индексация сайта — это обработка сайта роботами-поисковиками, то есть программами, сканирующими сайт и заполняющими базы данных поисковиков результатами для поисковых запросов. Если индексация выполнена верно, то пользователь легко найдет нужные страницы сайта. В противном случае веб-ресурс не будет отображаться в поисковых системах, проще говоря, его не увидят пользователи и не приобретут товар, не воспользуются услугой и так далее.

Термин «апдейт» происходит от английского слова – update, что в переводе означает – обновление.

Среди специалистов, занимающихся SEO-продвижением, он используется часто и дословно означает «обновление данных». Разновидностями такого обновления будет доработка интерфейсной части сайта или внесение изменений на конкретной странице. В среде специалистов используется также сокращенная форма слова – «ап».

Появление новых результатов поиска, после запроса по одной и той же ключевой фразе в поисковике, например, Google или Яндекс – вот что такое «апдейт» применительно к поисковой оптимизации. У поисковых движков есть индексы, в которых все страницы расположены по порядку. Апдейт приводит к изменению позиций уже существующих записей веб-ресурсов или добавлению новых в ответах на пользовательские запросы. Связанный с апдейтом процесс, приводит к обновлению кэша поисковой машины и индексации сайтов в ее базе данных.

Более подробно об этих двух понятиях можете прочитать на страницах моего сайта, вот ссылки на то — что такое апдейт и что такое индексация.

Ну думаю с этим разобрались, теперь переходим к вашим вопросам.

Почему мой сайт долго индексируется

Здесь всё зависит, как раз от поискового робота. Именно он заходит на сайты по определённому графику, известному только в компании Яндекс и сканирует миллионы WEB проектов на наличие обновлений. К примеру, если контент (статьи, фотографии, видео, карточки товаров) на своем сайте вы добавляете или меняете раз в месяц, то робот рано или поздно это поймёт и будет заходить на ваш ресурс лишь раз в месяц. Отсюда и срок индексации сайта будет такой же.

Чем чаще вы добавляете контент, тем чаще робот будет к вам приходить на сайт. На новостных ресурсах, таких как Фонтанка.ру или RBK роботы просто «живут» и не выходят от туда. Новости на таких сайтах обновляются и добавляются в день десятками, а то и сотнями и поисковые боты их скандируют и индексируют практически мгновенно.

Думаю вопрос, почему сайт долго индексируется снят с повестки дня, также как и вопрос, как часто нужно публиковать статьи на сайте.

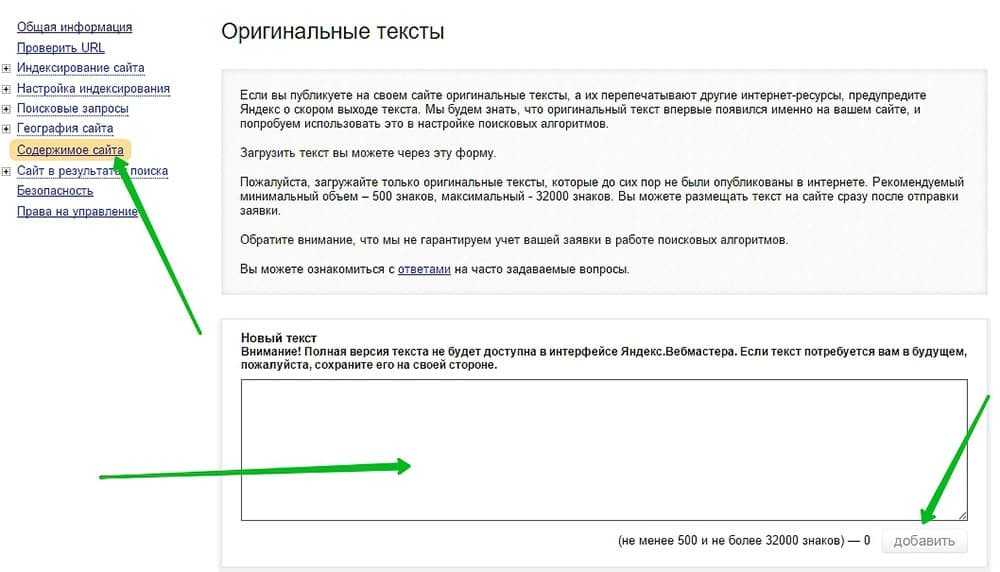

Могут ли украсть контент до индексации сайта

Да могут! И именно так это и делается. Пока сайт молодой и только начинает свой жизненный путь, он индексируется раз в месяц, а то и два. Весь контент, который публикуется на таком сайте, может быть украден, как в ручную, так и автоматически (что бывает чаще) программами парсерами, работающими в самонаполняющихся сайтах. Большинство моих учеников очень удивляется, когда я анализирую их сайт и выявляю не уникальный контент.

Последний мой ученик, опубликовал на своём молодом сайте сразу 15 статей и через месяц был очень удивлён, тому что Яндекс обвинил его в копипасте и наложил на сайт фильтр. Доказать Яндексу (Платону Щукину), что это не он вор, а наоборот у него статьи украли, не получилось. Сделать это теперь очень проблематично и к тому же, чтобы вытащить сайт из под фильтра, придётся все эти статьи удалять и писать новые. Результат от незнания и неправильных действий — потеря денег, потеря контента и попадание под фильтр.

Как обезопасить свой контент от воровства можете прочитать здесь, либо посмотреть моё видео, если лень читать))) Подробно об этом писать здесь не буду.

Как защитить контент от воровства

Как ускорить процесс индексации

Для того чтобы индексация вашего сайта и вновь добавленного контента прошла быстрее, нужно «попросить» яндекс-бота посетить ваш сайт. Делаю я это просто и несколькими способами.

Первый способ ускорения индексации сайта

Я привлекаю на свой сайт робота, методом расшаривания постов опубликованных статей через социальные сети. Делаю я это с помощью блока кнопок социальных сетей. Как только пост опубликован его видят роботы, так как в социальных сетях они живут постоянно и не выходят от туда, как и с новостных лент.

Публикация статей в социальные сети передаёт на сайт соц-сигналы и помимо ускорения индексации пладотворно влияет на продвижение сайта в Google и Яндекс. Напомню, перед расшариванием текстов, обязательно дайте понять Яндексу, что они ваши (смотри видео выше).

Второй способ ускорения индексации сайта

Здесь мы информируем Яндекс-Бота о том, что на нашем сайте появился новый контент, через Яндекс Веб мастер, раздел которого в простонародии называется Адурилкой.

Заходим в Яндекс Вебмастер, регистрируемся, добавляем свой сайт и переходим на вкладку индексирование — переобход страниц. Затем копируем URL той страницы, которую хотите быстро проиндексировать и добавляете в графу, как на картинке ниже и нажимаете кнопку отправить.

После этого ждём обхода робота. Добавление новых URL адресов в адурилку существенно ускоряет процесс индексации, а когда вы работаете в связке с сервисом оригинальные тексты Яндекс, то ещё и полностью исключаете воровство вашего контента. Все на самом деле очень просто, если всё это знать.

Также просто и продвигать сайты в Яндекс. Делать это можно самостоятельно и абсолютно бесплатно, но опять же нужны знания. Если хотите, могу научить и этому (информация ниже).

Заказать продвижение сайта в Яндекс

Вы получили печальный опыт блокировки за накрутку, испробовали уже все методы продвижения, а толку нет? Разочаровались в Яндекс Директ и Google Adwords? Пора прекращать верить в сказки и доброго волшебника в голубом вертолете, который спасёт ваш бизнес. Пора заняться действительно качественной и проверенной временем SEO работой – начать продвижение интернет-магазина (сайта) статьями! Эффективность этой стратегии подтверждают мои SEO кейсы. Я информирую Вас лишь для того, чтобы Вы впервые выбрали для себя правильный путь развития бизнеса и наконец-то получили результат. И не важно, я буду в этом вам помогать или Дядя Ваня. Но все же, если Вы хотите выбрать меня, то жмите кнопку ниже (пишите, звоните +7(921)333-77-45) и мы скорее всего договоримся и я возьмусь за ваш WEB проект и вдохну в него жизнь в виде действительно продающих текстов!

Индексация сайта в яндексе. Как сделать чтобы яндекс индексировал быстрее

Сколько помню, индексация сайта в яндексе всегда вызывала много нареканий, форумы и блоги просто пестрят гневными темами, где хают отечественный поисковик за его медлительность и нерасторопность в индексировании новых сайтов и страниц. Как ни крути, а истина в этих словах имеется, ведь ресурсы яндекса на порядок меньше чем у Google, который жрет новые страницы как пирожки. Из-за нехватки ресурсов, индексация в яндексе была, есть, и пожалуй, еще долгое время будет более медленной. Просто в целях экономии яндекс «условно» разделил все сайта на определенные группы:

Как ни крути, а истина в этих словах имеется, ведь ресурсы яндекса на порядок меньше чем у Google, который жрет новые страницы как пирожки. Из-за нехватки ресурсов, индексация в яндексе была, есть, и пожалуй, еще долгое время будет более медленной. Просто в целях экономии яндекс «условно» разделил все сайта на определенные группы:

Индексация сайта в яндексе: разбивка по группам

1. Высшая категория. Новостные сайты и живые форумы. На таких сайтах боты яндекса пасутся денно и нощно, можно сказать, что они там живут. Индексация для таких сайтов в яндексе никогда не будет проблемой, ведь статьи влетают в индекс в течении часа, а иногда и того быстрее.

2. Первый сорт. Трастовые, часто обновляемые сайты. Сюда боты заглядывают ежедневно и живо индексируют новые странички.

3. Второй сорт. Хорошие сайты, обновляемые еженедельно. Сюда поисковик заглядывает время от времени, как только получит сообщение о том, что сайт обновился, хотя и не факт. Потому как у меня есть сайты, которые обновляются по 3-4 раза в неделю, но индексация в яндексе иногда запаздывает дней на 7. В эту группу еще можно запихнуть блоговые платформы к которым яндекс питает особую любовь: ЖЖ, liveinternet.ru, Я.ру, Ucoz, Народ. Подмечено, что новые статьи на этих блоговых платформах яндекс жрет более охотно, чем на том же Blogspot.com

Потому как у меня есть сайты, которые обновляются по 3-4 раза в неделю, но индексация в яндексе иногда запаздывает дней на 7. В эту группу еще можно запихнуть блоговые платформы к которым яндекс питает особую любовь: ЖЖ, liveinternet.ru, Я.ру, Ucoz, Народ. Подмечено, что новые статьи на этих блоговых платформах яндекс жрет более охотно, чем на том же Blogspot.com

4. Третий сорт. Кто не вошел в первые 3 группы — ваше место примерно здесь. Яндекс приходит на сайт как ему вздумается и если на скорость индексации сайта никак не влиять, то иногда ее приходится ждать довольно долго.

5. Не сортовые сайты. Новички. Сюда можно смело отнести все сайты которые только начали свое существование. Если ничего не делать, то первой индексации можно ждать иногда пару месяцев. Больше всего возгласов и вопросов, связанных с индексацией сайтов в Yandex приходится слышать от владельцев именно таких сайтов. Помниться, мой самые первый блог на blogspot.com был проиндексирован яндексом спустя 2 месяца. Но тогда я был «зеленый» блоггер и не знал как подружиться с Яшей и заставить его заглянуть на сайт чуток быстрее

Но тогда я был «зеленый» блоггер и не знал как подружиться с Яшей и заставить его заглянуть на сайт чуток быстрее

Разбивка на категории сделана мной условно, а не почерпнута из официальных источников Яши, так что можете не соглашаться.

Как ускорить индексацию сайта в Яндексе

Если вы усекли, что находитесь в несортовой группе или скажем в 3 категории и у вас реально возникают проблемы с индексацией в яше, то для исправления ситуации и ее улучшения можно предпринять ряд мер.

1. Создаем карту сайта если ее нет. Про способы создания карты сайта на upgoing.ru уже написано, так что повторяться не буду. Но сделайте это обязательно, после чего адрес карты сайта пропишите в robots.txt и заодно скормите яндексу в панели вебмастера.

2. Добавление страниц в аддурилку. Сделать это можно здесь. Конечно отнимает лишних 30 секунд жизни, но в большинстве случаев работает, поэтому сам иногда пользуюсь этой возможностью.

3. Кнопки социальных сетей и прогон по закладкам Неплохо ускоряет индексацию сайта в Яндексе дополнительный прогон ссылки на статью по социальным сетям. Для этого можно использовать как социальные кнопки яндекса, так и любой другой способ. Мной используются в основном твиттер и фейсбук, хотя подумываю над подключением Вконтакте, но уже для других целей.

Для этого можно использовать как социальные кнопки яндекса, так и любой другой способ. Мной используются в основном твиттер и фейсбук, хотя подумываю над подключением Вконтакте, но уже для других целей.

4. Комментируйте и оставляйте следы на форумах. Если ваш блог еще не попал в индекс яндекса, то для ее ускорения и улучшения следует оставлять о себе как можно больше следов. Для начала подойдет комментирование посещаемых блогов, а также сообщения на форумах из Высшей категории (см. выше) Можно ставить ссылку в профиле, а после достижения необходимого количества сообщений на большинстве форумов позволяют вставлять ссылку в подпись под каждым сообщением. Данный способ ускорения индексации довольно трудоемок, поэтому сейчас я его практически не использую, но для новичков он то что нужно. Хотя бы потому, что не требует финансовых затрат.

5. Покупка ссылок и наращивание ссылочной массы Данный пункт условно можно разделить на несколько, в зависимости от целей, которые вы преследуете. Если вам нужно срочно загнать сайт или отдельную статью в индекс, то идеально работает покупка ссылки с главной страницы сайта. Более дешевый вариант, который и сам порой использую, это покупка ссылок с блоговых платформ, любимых яндексом (см. выше по тексту). За доллар можно прикупить с пяток ссылок, которые довольно быстро войдут в индекс. Были у меня ситуации, когда некоторые страницы яндекс упорно отказывался индексировать несмотря на то что они были уникальны и прогонялись по социальным сетям и закладками. Но 2-3 ссылки с ЖЖ делали свое дело и яндекс любезно соглашался проиндексировать то, что ему уже долгое время предлагали.

Если вам нужно срочно загнать сайт или отдельную статью в индекс, то идеально работает покупка ссылки с главной страницы сайта. Более дешевый вариант, который и сам порой использую, это покупка ссылок с блоговых платформ, любимых яндексом (см. выше по тексту). За доллар можно прикупить с пяток ссылок, которые довольно быстро войдут в индекс. Были у меня ситуации, когда некоторые страницы яндекс упорно отказывался индексировать несмотря на то что они были уникальны и прогонялись по социальным сетям и закладками. Но 2-3 ссылки с ЖЖ делали свое дело и яндекс любезно соглашался проиндексировать то, что ему уже долгое время предлагали.

Для улучшения индексации в дальнейшем и более благосклонное отношение к вам яндекса, советую постепенно наращивать ссылочную массу. Это не только добавить траста сайту, но и повлияет на посещаемость, да и другие показатели, которые учитываются яндексом.

6. Обновляйте контент и пишите чаще. Если поисковый робот не был у вас на сайте пару недель, и, придя снова, не нашел ничего нового, то угадайте через какое время он заглянет к Вам на сайт снова? Конечно не стоит писать всякую ерунду, ведь читатели этого не одобрят, но следует уяснить, что чем чаще обновляется сайт, тем чаще к вам будет заглядывать яндекс.

7. Используйте внутреннюю перелинковку. Не стоит забывать про то, что внутренняя перелинковка страниц не только помогает продвигаться по НЧ запросам, но и делает интересней для яндекса путешествие по сайту. Особенно если вы поставите анкор — «яндексу вход воспрещен. » — будьте уверены, он первый кто туда полезет

8. Добавление сайта в авторитетные каталоги и рейтинги. Как бы там ни было, но после добавления upgoing.ru в ЯК некоторые страницы стали влетать в индекс за 10 минут, чего никак не наблюдалось ранее. Авторитетные каталоги и рейтинги постоянно находятся в поле зрения яндекса, поэтому не стоит сбрасывать это со счетов. Более того, если вы хотите зарабатывать на своем блоге, то нахождение в авторитетных каталогах прямо влияет на стоимость рекламы.

9. Основное содержимое сайта и скрытые разделы. Заметил, что основное содержимое сайта индексируется Яндексом быстрее нежели статьи размещаемые в разделах, которые не появляются на главной и не отдаются в RSS-ленту. Статьи размещаемые в скрытых разделах иногда нуждаются в допрогонах, для ускорения индексации. Если конечно время, для вас вопрос принципиальный. Если готовы ждать пару недель, то можно и не дергаться.

Статьи размещаемые в скрытых разделах иногда нуждаются в допрогонах, для ускорения индексации. Если конечно время, для вас вопрос принципиальный. Если готовы ждать пару недель, то можно и не дергаться.

Да, если у вас возникли проблемы с индексацией сайта в Yandex по причине попадания под АГС, то это уже совсем другая история и другие действия.

В принципе способов, как можно улучшить и ускорить индексацию сайта в Яндексе гораздо больше, но думаю что и описаных выше вполне должно хватить. Ну и напоследок, хотелось бы узнать у Вас:

Были ли (или есть) у Вас проблемы с индексацией сайта в Яндексе?

Индексация сайта. 8 день марафона.

Плавно возвращаемся к марафону… В ходе него мы сделали небольшой сайт определенной тематики, оптимизированный под поисковые системы, и готовый к дальнейшему продвижению. Сегодня надо написать о начальной индексации сайта и все, что с ней связано.

В статье про SEO-копирайтинг я писал про наполнение сайта статьями и совсем забыл написать о частоте наполнения. Всем понятно, что чем чаще мы будем обновлять (наполнять сайт контентом), тем лучше. Желательно делать это каждый день. В день по статье. Если не получается обновлять каждый день, то хотя бы через день – два. Так мы показываем поисковым системам, что сайт живой и постоянно развивается (так и есть).

Всем понятно, что чем чаще мы будем обновлять (наполнять сайт контентом), тем лучше. Желательно делать это каждый день. В день по статье. Если не получается обновлять каждый день, то хотя бы через день – два. Так мы показываем поисковым системам, что сайт живой и постоянно развивается (так и есть).

Предположим, вы пишите статьи, но почему-то сайт долго не индексируется в ПС. Обычно Гугл быстро индексирует новые сайты, а вот Яндекс иногда упрямится, и для быстрой индексации приходится выполнять кое-какие действия.

Как быстро проиндексировать сайт?

1. Добавление сайта в сервисы для веб-мастеров

Чтобы быстро проиндексировать сайт в Яндексе, делаем следующее:

— Добавляем сайт в Яндекс.Вебмастер: http://webmaster.yandex.ru/

Подтверждаем права на сайт, делая то, что требуется.

Можно также добавить сайт в адурилку. Но это в принципе не нужно, потому что, при добавлении в Яндекс.Вебмастер, вы и так сообщаете Яндексу о новом сайте.

Для быстрой индексации, в Гугл тоже есть панель для веб-мастеров:

— Добавляем сайт в Гугл.Вебмастер (Инструменты для веб-мастеров) . Также подтверждаем права на сайт. https://www.google.com/webmasters/tools/

— Добавляем файл Sitemap.xml . Смотрим настройки и изменяем их, если это нужно.

Если в инструменты для веб-мастеров добавиться не получается, то можно просто воспользоваться аддурилкой Гугла.

2. Используем пинг сервисы (ping – сервисы)

Пинг сервисы помогают быстро проиндексировать только что опубликованную запись, а точнее, они созданы для уведомления поисковых систем и прочих сервисов о появлении новых записей на вашем сайте.

В WordPress есть инструмент автоматического оповещения сервисов обновлений о появлении новой записи. Настраивается список пинг сервисов в Админке WP – «Настройки» – «Написание», Сервисы обновления.

В сети можно найти огромные списки сервисов обновления. Я не вижу смысла в большом списке пинг-сервисов и использую только вот эти сервисы:

http://rpc.

pingomatic.com/

http://ping.blogs.yandex.ru/RPC2

http://blogsearch.google.com/ping/RPC2

http://ping.feedburner.com

3. Проставляем ссылки с других сайтов для ускорения индексации

Ссылки – это хорошо. Хорошие ссылки – это отлично. Откуда можно проставить немного ссылок на новый сайт?

— Социальные закладки, как средство для быстрой индексации сайта.

Сейчас есть множество соц. закладок и много сервисов и программ для постинга в соц. Закладки. Мне нравится программа Жукладочник. В общем, работа с соц. закладками проста. Регистрируете аккаунты в сервисах закладок, постите урл главной страницы или любой внутренней, пишите описание, ключевые слова и т.д.

— Покупка ссылок. Для ускорения индексации можно купить ссылок. Я покупаю или в Сапе или в ГГЛ (все зависит от сайта, который нужно проиндексировать). Покупаю на трастовых ресурсах для людей, на которых контент обновляется по несколько раз в день и поисковые роботы ходят очень часто.

— Свои сайты, форумы, сайты друзей и т.д. Главное не спамте. Вам нужно небольшое количество ссылок для индексации. Также можно обменятся ссылками, вот только вряд ли кто-то захочет меняться с непроиндексированным ресурсом

Несколько советов:

— Ни какого спама.

— Не используйте прогон по каталогам для новых сайтов. Сотни (а то и тысячи) говноссылок с каталогов и досок объявлений может быть и помогут быстро проиндексировать новый сайт, но толку от такого сайта не будет. Логика поисковых систем понятна, если на сайт ссылается куча говносайтов, скорее всего этот сайт тоже говносайт. Не говоря уже о паршивых донорах, Яндекс вообще не любит быстрого прироста ссылочной массы. Поэтому проставляйте ссылки избирательно, делайте все руками и с любовью

— Ссылки ставьте не сквозные, а просто постовые. Как-то опасно сквозняки для новых сайтов проставлять…

Как делаю я?

Проставляю одну-две ссылки с трастовых ресурсов и пару ссылок с дневников li. ru и livejournal + прогоняю по закладкам. Иногда проставляю ссылки со своих сайтов.

ru и livejournal + прогоняю по закладкам. Иногда проставляю ссылки со своих сайтов.

Вот вроде бы все написал про индексацию…

А вы что делаете для быстрой индексации сайта в поисковых системах?

Как ускорить индексацию сайта в Яндекс и Google

После разработки ресурса компании и его запуска, руководство часто сталкивается с проблемой его долгой индексации. Страницы с большим количеством контента неделями не отображаются в поисковой выдачи, при поиске названия компании появляются только справочные ресурсы. Проблема актуальна и по сей день, особенно это очень заметно в Yandex, где апдейты учитывающие новые страницы проходят всего пару раз в месяц. Как ускорить индексацию веб-сайта, где её можно отследить и для чего это необходимо, мы разберем в сегодняшней статье.

Если о важности индексации знают почти все, то на вопрос «а для чего вообще её нужно ускорять?», — отвечают немногие. Давайте поищем ответ вместе — основная причина заключается в росте посещаемости.

Что влияет на частоту индексирования ?

Перед тем как рассмотреть способы ускорения индексации, давайте посмотрим что вообще влияет на частоту индекса поисковых роботов:

-

Регулярность добавления контента на страницы. Изначально все новые веб-сайты регулярно обходятся роботом. Бот сканирует общее количество страниц и изменения, которые появились на ресурсе.

На основе этих данных он составляет краулинговый бюджет сайта, в котором отражено как часто будет производиться обход и сколько страниц будет проанализировано за сеанс.

-

Качество хостинг-площадки, где располагается сайт. Если хостинг сильно загружен, а на серверах находится много веб-сайтов, то скорость обработки запросов поискового бота снижается. Робот видит эти изменения и начинает заходить на ресурс реже.

-

Конверсия пользователей на ресурсе и поведенческие факторы напрямую влияют на регулярность обхода сайта и его индексирование. Чем лучше показатель ПФ, тем больше сигналов роботу для повторного посещения. Соответственно, чем хуже эти факторы, тем реже будет переобход.

Способы улучшения индексации сайта

Чтобы индексация сайта была быстрее, нужно сообщить поисковым системам о своем ресурсе. Для этого у Яндекса и Google есть свои инструменты – «Яндекс-вебмастер» и «Search Console». Добавления сайта в эти сервисы не только улучшит индексацию, но и покажет ошибки продвижения, если таковые имеются.

Добавления сайта в эти сервисы не только улучшит индексацию, но и покажет ошибки продвижения, если таковые имеются.

Показав поисковикам свой ресурс, важно постоянно добавлять на него контент, чтобы робот видел регулярные изменения и оперативно их брал в обработку. Добавляемый контент старайтесь связывать внутренней перелинковкой с другими страницами для быстрого перехода между ними.

Большое количество внутренних ссылок может привести к переспаму, не рекомендуется добавлять на одном url более 3 гиперссылок.

Для мониторинга всех страниц поисковым ботом на сайте должна быть настроена динамическая карта, создан robots.txt, а так же выведены хлебные крошки. Корректность настройки xml-карты проверяем в панели вебмастера. После успешной проверки добавляем её отдельной строкой в файл робота.

Хорошим сигналом для поисковых систем является развитый ссылочный профиль сайта. Естественные, живые ссылки по которым совершают переходы пользователи очень быстро фиксируются роботами Яндекса и Гугла. Чем лучше по показателям ресурс с размещенной ссылкой, тем быстрее реакция робота и последующая индексация.

Естественные, живые ссылки по которым совершают переходы пользователи очень быстро фиксируются роботами Яндекса и Гугла. Чем лучше по показателям ресурс с размещенной ссылкой, тем быстрее реакция робота и последующая индексация.

Работа со ссылочной массой это сложный и долгий процесс. Поисковые системы положительно оценивают только качественные ссылки, поэтому развивая ссылочный профиль своего веб-сайта никогда не прибегайте к автоматическим сервисам и многочисленным биржам ссылок.

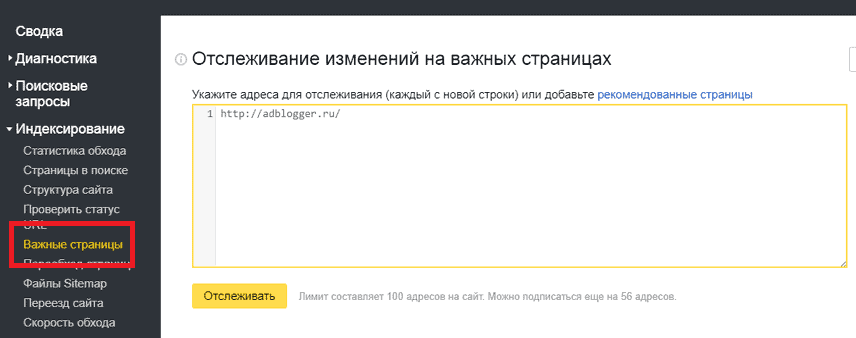

Сообщаем роботу об индексации и отслеживаем её

Вебмастера и оптимизаторы рекомендуют не ждать прихода поискового робота, а самим сообщить об изменениях на сайте. Для этой задачи отлично подойдет Яндекс вебмастер в котором предусмотрен отдельный функционал для обработки новых страниц (находится во вкладке индексирование), а также отдельный мониторинг важных страниц. Google Search Console имеет схожую опцию «посмотреть как Googlebot» (находится в разделе сканирование). Отследить данные можно в самих сервисах, плюс на почту приходят данные мониторинга. Кроме вебмастера и поисковой консоли seo-специалисты рекомендуют постить новые ссылки в аккаунтах социальных сетей и делать рассылку в мессенджерах. Есть риск получить негатив от своих контактов и попасть в спам список, но индексации эти действия сильно помогут.

Отследить данные можно в самих сервисах, плюс на почту приходят данные мониторинга. Кроме вебмастера и поисковой консоли seo-специалисты рекомендуют постить новые ссылки в аккаунтах социальных сетей и делать рассылку в мессенджерах. Есть риск получить негатив от своих контактов и попасть в спам список, но индексации эти действия сильно помогут.

Как работают поисковые системы | Codehouse

Поисковые системы являются основной частью цифрового ландшафта. Будь то Google или Bing (Яндекс или другие), использование поисковых систем — это задача, которую многие из нас выполняют много раз в день.

Большинство людей даже не задумываются о динамике результатов поиска. Но если вы управляете бизнесом, который, без сомнения, будет представлен в Интернете, или работаете в нем, то понимание SEO и его внутренней работы может быть полезным.

По сути, «основы» поисковых систем включают шесть ключевых элементов:

- Ползание

- Индексация

- Рендеринг

- Алгоритмы

- Машинное обучение

- Намерение пользователя

1.

Сканирование

СканированиеПоисковый робот – это бот, который систематически сканирует Интернет для индексации веб-сайтов. Это так просто!

Возможно, вы слышали (или не слышали) термин «бюджет сканирования». «Бюджет сканирования» — это количество времени, которое Google выделяет на сканирование веб-сайта. Краулинговый бюджет зависит от многих факторов, но есть два основных:

- Скорость сервера: По сути, чем быстрее сервер, тем больше Google может сканировать веб-сайт, не влияя на работу пользователей.

- Важность сайта: Веб-сайты с регулярно обновляемым содержимым, такие как новостные сайты, будут сканироваться чаще, чтобы обеспечить актуальность новостного контента поискового индекса. В качестве альтернативы веб-сайты, например маникюрный салон, будут иметь меньший краулинговый бюджет, потому что веб-сайт будет считаться не таким важным, как новостной сайт. Это может показаться несправедливым, но в краулинговом бюджетировании есть логика.

2. Индексирование

Индексирование — это, по сути, добавление содержимого веб-страницы в поисковые системы. Если веб-страница не проиндексирована, ее нельзя найти с помощью поисковых систем. И если поисковые системы не могут его найти, то и потенциальные посетители тоже.

Есть несколько способов проиндексировать веб-страницу после ее создания:

- Предоставьте поисковым роботам всю работу: Поисковые роботы сделают всю тяжелую работу, перейдя по ссылкам. Пока ваш веб-сайт проиндексирован, а контент связан, новые веб-страницы в конечном итоге будут найдены и добавлены в индекс. Это может произойти, если другие сайты ссылаются на вашу страницу.

- Карты сайта XML: Это то, что вы хотите, чтобы поисковая система индексировала в формате XML. Карта сайта может не только перечислять все страницы вашего веб-сайта, но и отображать дополнительную информацию, например даты изменения. XML-карта сайта отправляется через Search Console (Google) и/или Инструменты для веб-мастеров (Bing/Yandex).

- Запрос индекса: Если у вас есть веб-страница высокой важности, например уведомление клиента об отзыве, то запрос индекса ускорит процесс индексации. Это лучшая надежда на немедленный индекс! «Индекс запросов» можно выполнить через консоль поиска (Google) и/или инструменты для веб-мастеров (Bing).

3. Рендеринг

Рендеринг — это содержимое и макет, которые генерирует код. Это то, что мы видим, когда посещаем веб-страницу. И это то, что видят поисковые системы, чтобы определить контекст взаимодействия с пользователем.

Существует множество параметров, которые поисковые системы проверяют во время рендеринга и определяют, как должна ранжироваться веб-страница. Например, скрыт ли контент за ссылкой? Есть ли реклама на веб-странице? Страница загружается медленно?

Хотя рендеринг происходит после индексации, это может занять несколько недель. Эта задержка рендеринга возникает из-за того, что веб-страницы (чаще всего) используют не только простой HTML.

Веб-сайты, использующие экземпляры JavaScript (зависящие от рендеринга), будут отображаться дольше, что означает, что поисковые системы будут знать содержимое страницы только после завершения работы службы веб-рендеринга.

Жизненный цикл рендеринга веб-страницы:

- Обнаружено с помощью карты сайта, поискового робота и т. д.

- Добавлено в список страниц для обхода при доступном краулинговом бюджете

- Контент просканирован и проиндексирован

- Добавлено в список страниц для рендеринга, когда доступен бюджет рендеринга

- Рендеринг

Нравится эта статья? Подпишитесь на нашу рассылку

Подпишитесь

4. Алгоритмы

«процесс или набор правил, которым необходимо следовать при вычислениях или других операциях по решению задач, особенно с помощью компьютера».

Когда дело доходит до поиска, алгоритм поисковой системы Google, например, определяется как:

«внутренний процесс, который Google использует для ранжирования контента. При определении этого рейтинга учитывается ряд факторов, таких как релевантность и качество контента по конкретному поисковому запросу».

Итак, когда вы нажимаете Enter после того, как ввели поисковый запрос, срабатывает целая серия сигналов. Алгоритмы начинают вычислять факторы ранжирования поисковых систем, которые будут определять результаты поиска, которые включают (но не ограничиваются):

- Цель поискового запроса

- Ключевые слова

- Актуальность

- Удобство использования веб-страниц

- Экспертиза источников

- Язык

- Местоположение

- Правописание

- Категоризация запроса

- Синонимы

- Значимость страницы (измерение кликов и рейтинг кликов)

- И еще.

..

..

Основной процесс, определяющий рейтинг веб-страницы, можно свести к пяти простым шагам:

- Классификация

- Контекст

- Вес (важность)

- Макет

- Ранг

Алгоритмы поисковых систем постоянно меняются, поэтому важно, чтобы вы были в курсе последних обновлений, так как они могут повлиять на вашу деятельность по поисковой оптимизации и эффективность вашего сайта в результатах поиска.

5. Машинное обучение

Машинное обучение — одно из самых значительных технологических достижений последних лет. Википедия определяет машинное обучение как:

«Машинное обучение — это изучение компьютерных алгоритмов, которые могут автоматически улучшаться благодаря опыту и использованию данных. Оно рассматривается как часть искусственного интеллекта».

С годами влияние машинного обучения в поиске возросло. Например, программа машинного обучения Google под названием RankBrain произвела революцию в том, как определяются результаты поиска. Для этого:

Для этого:

- Постоянное изучение «связности» сущностей и их взаимосвязей. Понимание того, когда слова являются синонимами, а когда нет.

- Инструктирование других частей алгоритма для создания правильной страницы результатов поисковой системы (SERP)

В поиске есть две модели машинного обучения:

- Контролируемая модель: Использует 3 последовательности (Предоставить данные, Настроить вознаграждение за успех, Интегрировать машинное обучение с алгоритмом.

- Неконтролируемая модель: Системе не сообщают, что она ищет. Вместо этого предлагается сгруппировать объекты (изображение, статью и т. д.) по схожим признакам.

Машинное обучение улучшает взаимодействие с пользователем, отображая более релевантные результаты на основе поискового запроса.

6. Намерение пользователя

«Намерение пользователя» — это сигналы поведения пользователя, которые поисковые системы используют для отображения релевантных результатов поиска. Это «почему» за поисковым запросом.

Это «почему» за поисковым запросом.

Существует четыре типа целей поиска:

- Информационное: Пользователь ищет информацию. Например, «какие результаты в футболе?»

- Навигация: Пользователь ищет определенный веб-сайт, например Codehouse

- Транзакционный: Пользователь ищет возможность приобрести продукт или услугу, например, «дешевые телефоны Android».

- Коммерческое расследование: Пользователь ищет информацию о продукте или услуге, чтобы определить наилучшие варианты покупки, например, «лучший оператор мобильной связи».

Какой бы ни была цель поиска, поисковые системы используют поведение пользователей в качестве сигналов для надлежащего ранжирования веб-сайтов в поисковой выдаче. Google узнает:

- На какие сайты вы нажимаете в результатах поиска.

- Как долго вы посещали целевой веб-сайт, прежде чем вернуться в Google.

- Что вы сделали дальше.

Например, пользователь выполняет транзакционный поиск «дешевых телефонов Android». Они нажимают на ссылку из результатов поиска и посещают веб-сайт. Пользователь проводит много времени на сайте, прежде чем вернуться в Google и искать что-то еще. Такое поведение интерпретируется Google как положительный сигнал, поскольку оно указывает на то, что пользователь нашел то, что искал, и перешел к другой задаче. Поскольку Google знает об этом, он улучшит рейтинг веб-страницы в зависимости от цели поиска.

Понимание того, чего хочет ваша аудитория, влияет на создаваемый вами контент, поскольку он отражает намерения пользователя. Это, в свою очередь, повлияет на рейтинг вашей страницы, клики и конверсии.

В Codehouse наша команда специалистов по цифровым технологиям, в которую входят сертифицированные эксперты Google, всегда готова помочь вам извлечь максимальную пользу из вашего контента. Свяжитесь с нами, чтобы узнать больше.

Страницы выпали из индекса Яндекса. Почему страницы выпали из индекса

В последнее время тема масс сайтов или отдельных страниц, выпадающих из Яндекса . Возникает вопрос? … почему это происходит? Что случилось, что Яндекс начал выкидывать страницы из своей базы.

В чем причина выпадения от Яндекса до конца еще не выяснено. У меня сайт выпал из яндекса 2 раза, при этом 0 продающих ссылок, контент уникальный, нарушений в принципе нет. Так почему же Яндекс его выбрасывает и возвращает на место через 2-3 недели. В то же время, после того как сайт был возвращен в базу, индексация получилась более качественной, чем была раньше.

Думаю, что это скорее всего баг самого поисковика, бана не происходит, сайт свободно добавляется в форму регистрации и возвращается на утраченные позиции. Но не всем так везет в моментах АП, некоторых банят. Яндекс безжалостно выкидывает страницы со ссылками на продажу из Сапы и подобных автоматических бирж, торгующих эталонным золотом.

Совершенствуя алгоритмы своей работы, поисковая система Яндекс каждый раз ужесточает фильтры, играющие роль пессимистов страниц и сайтов, нарушающих правила использования поисковой системы. Яндекс такой же коммерческий продукт, как и большая часть сети, а поскольку он предоставляет свои услуги по размещению сайтов в своей базе, соответственно, как и в капиталистической системе, он вправе их кинуть обратно.

Необходимо знать пункты, которые помогут вам не попасть в немилость к фильтрам Яндекса, тем самым избежать пессимизации или, не дай бог, бана поисковой системы:

- Не злоупотреблять ключевыми словами на странице (4-7% макс)

- Не размещайте чрезмерное количество внешних ссылок на одной странице, также относится к поврежденным (3-5 более чем достаточно)

- Не размещать ссылки не по теме, не относящиеся к содержанию страниц

- Не используйте методы черного маркетинга, включая спам и обман поисковых систем

Работа Яндекса , да и любой поисковой системы как таковой, направлена на предоставление пользователю наиболее ценной информации, на основе анализа, который поисковик использует в своих алгоритмах. Попытка повлиять на результаты запрещенными методами к добру не приведет. Потеря страниц у Яндекса и прекращение их индексации тесно связаны с ресурсами, нарушающими правила.

Попытка повлиять на результаты запрещенными методами к добру не приведет. Потеря страниц у Яндекса и прекращение их индексации тесно связаны с ресурсами, нарушающими правила.

Если вдруг сайт выпал из Яндекса , не паникуйте. В первую очередь нужно проверить, забанен он или нет, если условия Яндекса не были нарушены, то он через 2-3 недели вернется на свои позиции, не потеряв их. Добавьте адрес главной страницы в регистрационную форму и, если появится сообщение «Ресурс успешно добавлен и скоро будет проиндексирован», остается только ждать.

Если в последнее время у вас просела посещаемость, страницы выпали из индекса, то тут только 2 варианта. Первое: санкции со стороны поисковых систем, второе:

Здравствуйте, уважаемые читатели блога сайта.

Могуш Иван на связи, и сегодня я вам расскажу о такой проблеме, когда они выпадают из индекса поисковика (уже ранее).

Буквально несколько дней назад у нас была точно такая же проблема. Почти 50% страниц вылетели из индекса Google. Трафик упал с 800 до 169. Это просто жесть. Смотрите сами:

Трафик упал с 800 до 169. Это просто жесть. Смотрите сами:

Сегодня статистика вроде выровнялась, но небольшой минус все же есть. Надеемся, что через 2-3 дня мы выйдем на прежний уровень.

Так что друзья, если у вас такая проблема, считайте себя счастливчиком. Я расскажу вам все, что я сделал. Только сначала давайте выясним причины такой неприятной проблемы.

Основные причины ухода страниц из индекса поисковых систем

1. Санкции (АГС, Панда, Пингвин и др.). Первым признаком наложенных фильтров является снижение посещаемости и уход страниц из индекса. Поэтому, чтобы первым узнавать о подобных проблемах, каждый вебмастер, блогер просто обязан зарегистрировать свой ресурс в панелях вебмастеров. Друзья, если вы еще этого не сделали, то не тяните :

Процедура добавления сайта достаточно проста. Но все же, если будут проблемы, то отпишитесь в комментариях. С удовольствием помогу.

А вообще, если ваш сайт попал под санкции, то сначала нужно узнать, какой фильтр применяется. Обычно в панель вебмастера приходит письмо со всей информацией (за что, когда навязали и т.д.).

Обычно в панель вебмастера приходит письмо со всей информацией (за что, когда навязали и т.д.).

П.С. Google отправляет сообщение веб-мастеру только в случае наложения ручных санкций. Если автоматически, то письмо не придет.

Вывод сайта из-под санкций — это совсем другая тема, о которой я расскажу в других своих статьях. нельзя пропустить.

А теперь еще одна причина вылета страниц из индекса.

2. Закрывающий метатег. Да, друзья, именно через один код, случайно оказавшийся в шаблоне, мы получили такую проблему. А вот и сам код:

Теперь запустите программу и откройте один за другим все файлы Html и PHP. С помощью поиска программы найдите метатег и удалите его. Для ускорения поиска можно открыть все файлы сразу, вверху (в разделах) нажать поиск и далее «Найти в файлах». Те. вы будете искать тег во всех файлах одновременно.

После удаления тега страницы вернутся в индекс самостоятельно.

В итоге

Как уже было сказано, мы не знаем откуда взялся этот метатег, если знаете, то напишите в комментариях. Будем благодарны. Мы, в свою очередь, на всякий случай сделали следующее:

Будем благодарны. Мы, в свою очередь, на всякий случай сделали следующее:

- Обновили WordPress до последней версии;

- Обновлены все плагины, включая Yoast SEO;

- Сменил все пароли для доступа к блогу;

- Плагин установлен Anti-XSS атака для защиты WordPress.

Ну вроде все, можно доделывать. Надеюсь, что статья поможет вам, вернуть все страницы в индекс и выйти на тот уровень, на котором вы были раньше. Для тех, кто не сталкивался с такими проблемами, добавьте статью в закладки. Может пригодится в будущем…

Массовая потеря посадочных страниц из индекса поисковых систем, а соответственно и из поиска, чревата падением позиций сайта и уменьшением объема органики движение.

Существует несколько основных и распространенных причин, по которым поисковые системы выбрасывают страницы сайта из своего индекса и перестают учитывать их при ранжировании.

Причины выпадения страниц из индекса

- Страницы, которые перенаправляют 301 или 302 на другие страницы или сторонние сайты, или содержат слишком много исходящих ссылок на сторонние ресурсы.

Иначе их можно назвать дорвеями.

Иначе их можно назвать дорвеями. - Страницы, предоставляющие поисковым системам контент, отличный от того, что видит пользователь, так называемая маскировка.

- Размещение контента на странице, скрытого от пользователя, это может быть использовано программно (ошибки в коде или намеренно), а также с помощью разметки текста (очень мелкий шрифт или цвет фона)

- Не уникальный или малополезный контент, а также страницы с дублирующимся контентом с других страниц сайта.

- Страницы с большим количеством рекламных блоков, созданные в основном или исключительно для заработка на рекламе.

- Чрезмерное количество ключевых слов на странице является переоптимизацией.

- Обман поведенческих факторов путем имитации действий пользователя

- Использование на сайте технологии кликджекинга — размещение на сайте невидимых для пользователя элементов, взаимодействие с которыми осуществляется без его ведома или создание на сайте невидимых для пользователя элементов поверх кнопок, форм, видео и т.

д.

д. - Ошибочное закрытие раздела сайта или страницы в файле robots.txt или метатеге robots.

- Заражение сайта вредоносным кодом с точки зрения ПС.

- Сбои в работе хостинга или CMS, из-за которых страница долгое время недоступна для роботов PS.

Как определить страницы, выпавшие из индекса Яндекса

Яндекс Вебмастер имеет достаточно удобный инструмент для анализа страниц, которые поисковая система посчитала не соответствующими необходимым критериям качества. Обладая этой информацией, вы сможете устранить допущенные ошибки, чтобы вернуть нужные страницы в индекс поисковой системы Яндекс.

Сводка:

Во избежание выпадения страниц сайта из индекса ПС следует следить за техническим состоянием ресурса и своевременно устранять ошибки. Не злоупотребляйте рекламными блоками для информационных проектов, а для проектов электронной коммерции откажитесь от них вообще. Не используйте приемы, запрещенные поисковыми системами, такие как клоакинг, дорвеи и кликджекинг. А также наполнить свой ресурс качественным и уникальным контентом, полезным не только для SEO, но и для пользователей.

А также наполнить свой ресурс качественным и уникальным контентом, полезным не только для SEO, но и для пользователей.

Страницы или целые разделы выпали из индекса поисковика без видимой причины? Давайте разберемся. Потому что это редко случается без причины. В понимании «Яндекса» каждый сайт должен представлять интерес — в первую очередь для пользователей. Если страница или весь сайт не имеют ценности с этой точки зрения, их можно исключить из индекса. И если с вашим ресурсом случилась эта беда, то нужно искать причину в самом сайте, иначе раскрутка сайтов своими силами становится намного сложнее.

1. Проверить корректность загрузки указанной страницы: если роботам Яндекса будет закрыт доступ к серверам провайдера, то из индекса может «выпасть» весь сайт. Хотя проблемы с отображением могут исходить и от самой CMS. Проверить, является ли проблема технической, довольно просто: добавьте свой сайт в сервис Яндекс.Вебмастер и посмотрите раздел «Ошибки».

2. Описанные выше трудности могут возникнуть и из-за некачественного, неуникального или отсутствующего контента. Итак, если поисковая система обнаружила плагиат на странице вашего сайта, она просто исключает ее из поиска, чтобы не тратить свои силы на обработку бесполезной информации (ведь то же самое можно найти на сотнях других сайтов). По тому же сценарию «поисковик» идет с дорвейным контентом, машинным рерайтом и так далее. Кстати, если контент на вашей странице уникальный, но его очень мало (например, это может быть страница галереи, содержащая всего одно фото с подписью), к вам также легко могут быть применены санкции – такие страницы также считаются неинформативными.

Итак, если поисковая система обнаружила плагиат на странице вашего сайта, она просто исключает ее из поиска, чтобы не тратить свои силы на обработку бесполезной информации (ведь то же самое можно найти на сотнях других сайтов). По тому же сценарию «поисковик» идет с дорвейным контентом, машинным рерайтом и так далее. Кстати, если контент на вашей странице уникальный, но его очень мало (например, это может быть страница галереи, содержащая всего одно фото с подписью), к вам также легко могут быть применены санкции – такие страницы также считаются неинформативными.

3. Причиной исключения страниц из индекса может быть большое количество исходящих ссылок. При этом в каждом конкретном случае количество ссылок, которые не понравится Яндексу, может быть разным: иногда это 10 ссылок на одной странице, а иногда и 5.

4. Привередливому роботу может не понравиться весь ваш сайт в целом. Часто бывает, что представления владельца сайта и Яндекса об уровне ресурса принципиально не совпадают. В этом случае выход может быть только один: проанализировать сайты успешных конкурентов, изучить требования самого Яндекса («Помощь вебмастеру») и глубже погрузиться в поисковое продвижение, попросить опытных специалистов оценить ваш сайт.

В этом случае выход может быть только один: проанализировать сайты успешных конкурентов, изучить требования самого Яндекса («Помощь вебмастеру») и глубже погрузиться в поисковое продвижение, попросить опытных специалистов оценить ваш сайт.

5. Внутренние дубликаты страниц также могут создать вам проблему — это страницы с одинаковым или очень похожим содержанием, которым присвоены разные адреса. Чаще всего это происходит при неправильной настройке CMS сайта. Вы можете отключить создание дубликатов в текстовом файле robots.txt, который находится в корневом каталоге ресурса.

С поисковыми системами нужно быть предельно осторожными, их алгоритмы постоянно совершенствуются, что приводит неопытных вебмастеров к серьезным проблемам.

Совершив одно неверное действие, можно не только распрощаться с ТОПом выдачи, но и вообще прийти к исключению сайта из него.

Почему страницы исключены из индекса? Для всех новичков мы уже рассказали. Делать это нужно постоянно, чтобы быстро выявлять проблемы.

Чем раньше вы их определите, тем легче будет все исправить. Удаление страниц из результатов поиска может быть вызвано разными причинами, попробуем разобраться.

Страницы выпадают из индекса яндекс, что делать?

Наиболее частая причина удаления страниц из списка проиндексированных — попадание сайта под фильтры .

Поисковые системы создали несколько фильтров, под которые попадают ресурсы за нарушение разных правил. Например, под минусинск попадают сайты, владельцы которых купили ссылки.

В одной из наших статей было сказано,. В общем, сначала нужно отправить сообщение в тех. поддержку поисковой системы, чтобы узнать, какой фильтр применяется и по какой причине.

Если мы говорим о Google, то при ручных санкциях вебмастерам рассылаются уведомления о наложении санкций. Автоматическое добавление под фильтры не сопровождается этим уведомлением.

Автоматическое добавление под фильтры не сопровождается этим уведомлением.

На практике встречаются самые разные факторы, из-за которых страницы выпадали из индекса в Яндексе. Например, это может быть спам ключевых слов .

Если вы еще не зарегистрированы в специальных сервисах для веб-мастеров, обязательно сделайте это:

Это необходимо для сбора статистики, получения уведомлений и так далее. Даже если ваш сайт попадет под фильтры, вы сразу это заметите.

Если вы понятия не имеете, почему ваши страницы пропали из индекса, читайте (это техподдержка Яндекса).

Распространенные причины попадания под фильтры

Чтобы вы не подумали, что ваш сайт попал под фильтры по ошибке, рассмотрим основные причины наложения санкций поисковыми системами и проанализируем вашу активность за последние месяцы.

Возможно, вы сами создали проблемы, если:

- использовали высокую плотность ключевых слов;

- купил некачественные ссылки;

- опубликовано копипаст на сайте;

- Продажа ссылок (добавление слишком большого количества внешних ссылок)

- использовали запрещенные методы продвижения;

- пытался скрыть содержимое или изменить его;

- размещение слишком коротких статей (до 500 символов).

Дайте поисковику хотя бы одну причину добавить вас под фильтры и будут наложены 100% санкции. Об этом лучше подумать заранее, так как вывести площадку из-под них не так-то просто. Сначала нужно устранить проблему, а потом продолжать развивать проект.

Страница выпала из индекса, но фильтры не применяются

Возникли проблемы, связанные с индексацией, не свидетельствующие о наложении санкций. Возможно, вы установили какой-то плагин или отредактировали код, что может привести к закрытию страницы.

Хорошо, что в интернете есть профессионалы, готовые помочь, и после создания темы на одном из популярных сервисов выяснилось следующее.

Яндекс Поиск — Nyongesa Sande

Поиск Яндекса (Яндекс) – поисковая система. Он принадлежит Яндексу, базирующемуся в России. В январе 2015 года Поиск Яндекса генерировал 51,2% всего поискового трафика в России по данным LiveInternet

О Поиске Яндекса

Технология поиска обеспечивает результаты локального поиска в более чем 1400 городах. В поиске Яндекса также реализован «параллельный» поиск, который представляет на одной странице результаты как из основного веб-индекса, так и из специализированных информационных ресурсов, включая новости, покупки, блоги, изображения и видео.

В поиске Яндекса также реализован «параллельный» поиск, который представляет на одной странице результаты как из основного веб-индекса, так и из специализированных информационных ресурсов, включая новости, покупки, блоги, изображения и видео.

Поиск Яндекса реагирует на запросы в режиме реального времени, распознавая, когда запросу требуется самая актуальная информация, например, последние новости или самая последняя запись в Твиттере по определенной теме. Он также содержит некоторые дополнительные функции: Wizard Answer, предоставляющий дополнительную информацию (например, спортивные результаты), проверку орфографии, автозаполнение, предлагающее запросы по мере их ввода, антивирус, обнаруживающий вредоносные программы на веб-страницах и т. д.

В мае 2010 года Яндекс запустил Yandex.com, платформу для бета-тестирования и улучшения поиска на других языках.

Доступ к поисковому продукту возможен с персональных компьютеров, мобильных телефонов, планшетов и других цифровых устройств. Помимо веб-поиска, Яндекс предоставляет широкий спектр специализированных поисковых сервисов.

Помимо веб-поиска, Яндекс предоставляет широкий спектр специализированных поисковых сервисов.

В 2009 году Яндекс запустил MatrixNet — новый метод машинного обучения, значительно повышающий релевантность результатов поиска. Это позволяет поисковой системе Яндекса учитывать очень большое количество факторов при принятии решения о релевантности результатов поиска.

Еще одна технология, Spectrum, была запущена в 2010 году. Она позволяет выводить неявные запросы и возвращать соответствующие результаты поиска. Система автоматически анализирует поисковые запросы пользователей и идентифицирует такие объекты, как личные имена, фильмы или автомобили. Доли результатов поиска, отвечающих различным намерениям пользователей, основаны на спросе пользователей на эти результаты.

Первый выпуск веб-браузера Brave от 21 июля 2017 года включает Яндекс в качестве одной из поисковых систем по умолчанию.

В марте 2022 года, во время вторжения России в Украину в 2022 году, Яндекс и Mail. ru были удалены из браузера Mozilla Firefox в качестве необязательных поисковых систем.

ru были удалены из браузера Mozilla Firefox в качестве необязательных поисковых систем.

Функциональность поиска Яндекса

Обзор

Поисковая система состоит из трех основных компонентов:

- Агент – поисковый робот. Обходит сеть, скачивает и анализирует документы. Если при анализе сайта обнаруживается новая ссылка, она попадает в список веб-адресов робота. Поисковые роботы бывают следующих типов: пауки – загружают сайты, подобные браузерам пользователя; Crawler — находите новые, еще неизвестные ссылки на основе анализа уже известных документов; индексаторы — анализируют обнаруженные веб-страницы и добавляют данные в индекс . Многие сжатые документы разделены на непересекающиеся части и очищены от разметки.

- Index – это база данных, составленная роботами-индексаторами поисковых систем. Документы ищутся в индексе.

- Поисковик. Запрос на поиск от пользователя отправляется на наименее загруженный сервер после анализа загрузки поисковой системы.