Индексирование сайта — Вебмастер. Справка

Добавьте сайт в Яндекс Вебмастер.

Sitemap. Для удобства вебмастеров и поисковых систем был разработан специальный формат карты сайта — sitemap. Это список ссылок на внутренние страницы сайта, представляемый в формате XML. Этот формат поддерживает и Яндекс. На специальной странице сервиса можно загрузить Sitemap для вашего сайта. Это позволит влиять на приоритет обхода роботом некоторых страниц вашего сайта. Например, если какие-то страницы обновляются гораздо чаще, чем другие, следует указать эту информацию, чтобы робот Яндекса правильно планировал свою работу.

Robots.txt — файл, предназначенный для роботов поисковых систем. В этом файле вебмастер может указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы по отдельности. Рассмотрим наиболее важные параметры, которые можно указать в этом файле:

- Disallow

- Эта директива используется для запрета от индексирования отдельных разделов сайта.

С ее помощью необходимо закрывать от индексирования технические и не представляющие ценности ни для пользователя, ни для поисковых систем страницы. К ним относятся:

С ее помощью необходимо закрывать от индексирования технические и не представляющие ценности ни для пользователя, ни для поисковых систем страницы. К ним относятся: - Подробнее об этом см. в разделе Использование файла robots.txt.

- Clean param

- С помощью этой директивы можно указать роботу, какие cgi-параметры в адресе страницы следует считать незначащими. Иногда адреса страниц содержат идентификаторы сессий — формально страницы с разными идентификаторами различаются, однако их содержимое при этом одинаково. Если таких страниц на сайте много, индексирующий робот может начать индексировать такие страницы, вместо того чтобы скачивать полезное содержимое. Подробнее об этом см. в разделе Использование файла robots.txt.

Яндекс индексирует основные типы документов, распространенных в Сети. Но существуют ограничения, от которых зависит, как будет проиндексирован документ, и будет ли проиндексирован вообще:

Большое количество cgi-параметров в URL, большое количество повторяющихся вложенных директорий и слишком большая общая длина URL может привести к ухудшению индексирования документов.

Для индексирования важен размер документа — документы больше 10Мб не индексируются.

Индексирование flash:

индексируются файлы *.swf, если на них есть прямая ссылка или они встроены в html тегами object или embed ;

если flash содержит полезный контент, исходный html документ может быть найден по контенту, проиндексированному в swf файле.

В документах PDF индексируется только текстовое содержимое. Текст, представленный в виде картинок, не индексируется.

Яндекс корректно индексирует документы в формате Open Office XML и OpenDocument (в частности, документы Microsoft Office и Open Office). Но следует учитывать, что внедрение поддержки новых форматов может занимать некоторое время.

Допустимо использование тегов <frameset> и <frame>, робот Яндекса индексирует контент, подгружаемый в них, и позволяет найти исходный документ по содержимому фреймов.

Если вы переопределили поведение сервера для несуществующих URL, убедитесь, что сервер возвращает код ошибки 404.

Получив код ответа 404, поисковая система удалит данный документ из индекса. Следите, чтобы все нужные страницы сайта отдавали код 200 OK.

Получив код ответа 404, поисковая система удалит данный документ из индекса. Следите, чтобы все нужные страницы сайта отдавали код 200 OK.Следите за корректностью HTTP-заголовков. В частности, важно содержание ответа, который сервер отдает на запрос

«if-modified-since». ЗаголовокLast-Modifiedдолжен отдавать корректную дату последнего изменения документа.Версии сайта, адаптированные для просмотра на мобильных устройствах, лучше выносить на поддомен, так же, как и версии сайта на различных языках.

Примечание.

Запрещайте для индексирования не предназначенные для пользователей страницы, управляйте поисковым роботом Яндекса.

К следующему разделу

Если страницы доступны для робота, отправлены на переобход, но не появляются в поиске больше двух недель, заполните форму ниже:

разбор ошибок SEO и возможных решений

Советы

Разбираем возможные ошибки и варианты их решений

Технические ошибки Проблемы с контентом Некачественные ссылки EAT-факторы «Заброшенность» сайта

Мы в Telegram

В канале «Маркетинговые щи» только самое полезное: подборки, инструкции, кейсы.![]()

Не всегда на серьёзных щах — шуточки тоже шутим =)

Подписаться

Станьте email-рокером 🤘

Пройдите бесплатный курс и запустите свою первую рассылку

Подробнее

Привет, я Екатерина Хиндикайнен, руководитель Rookee — платформы для самостоятельной оптимизации сайта.

Если вы, как и многие наши клиенты, делаете SEO самостоятельно, и столкнулись с трудностями на этом пути — статья для вас. В ней я разобрала самые распространенные проблемы, которые мешают сайту попасть в топ поиска Яндекса/Google.

1. Технические ошибки

Сайт не всегда доступен

Если ресурс «падает» даже ненадолго, поисковики это замечают. Ситуация повторяется — теряете позиции в выдаче. Так что если ваш хостинг работает не очень стабильно, то переезжайте на другой.

Страницы не индексируются

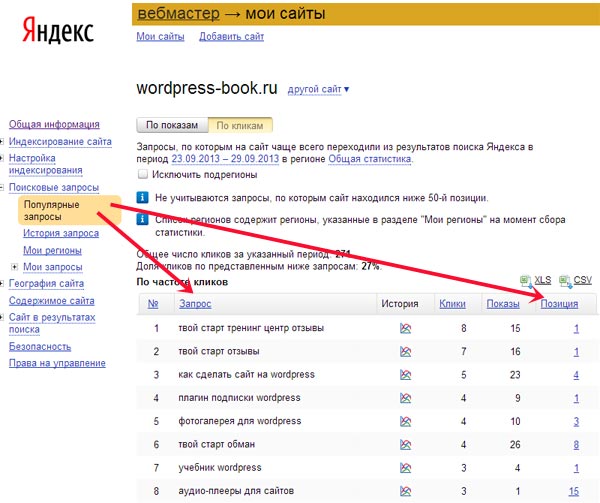

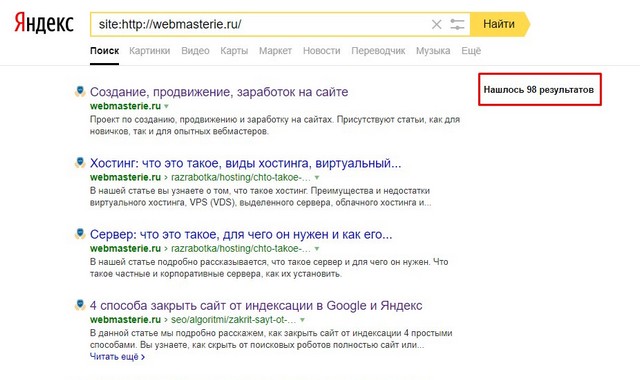

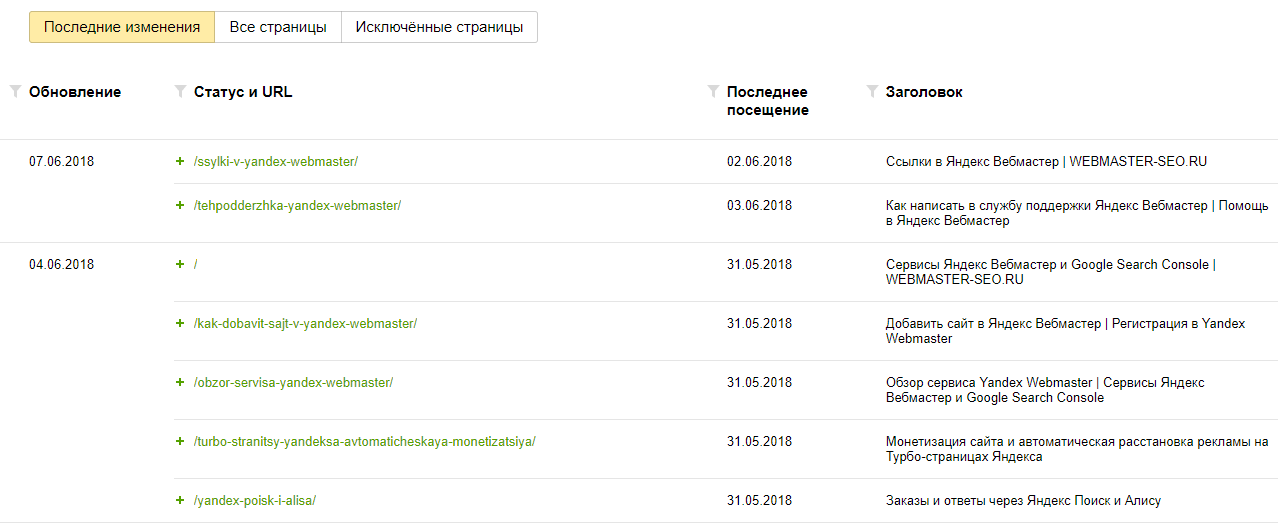

Проверить, как поисковики сканируют сайт, можно в Яндекс Вебмастере («Индексирование» → «Страницы в поиске») и Google Search Console («Индекс» → «Покрытие»).

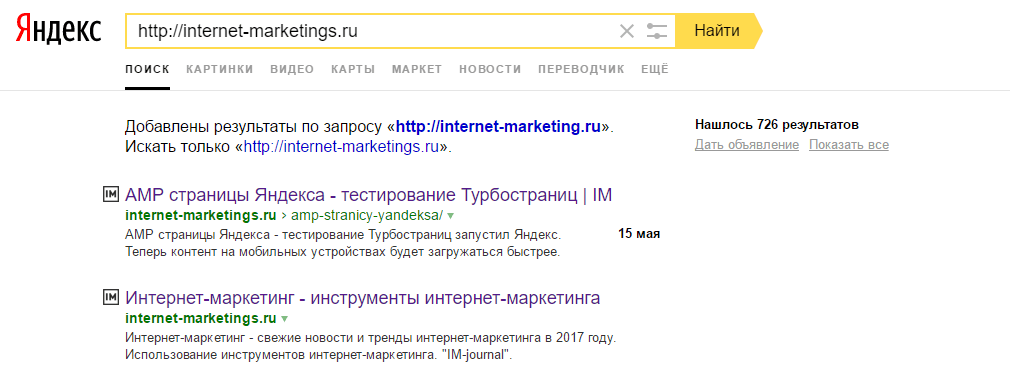

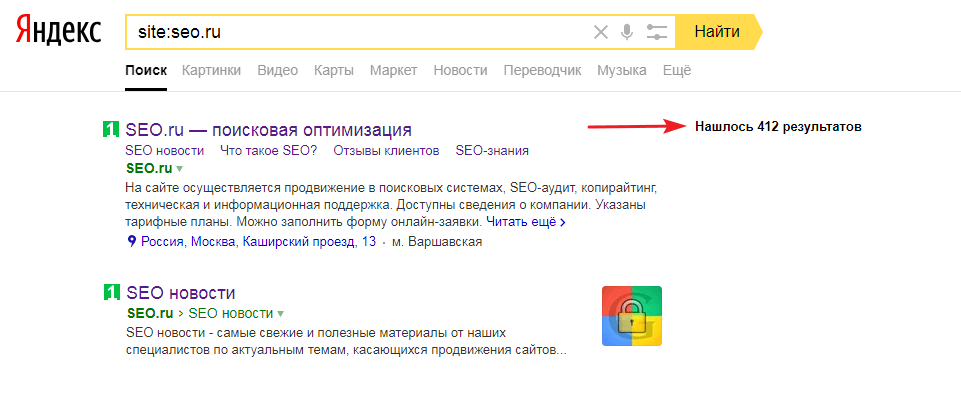

Или вбить в строку поиска «site:», затем без пробела указать URL вашего ресурса — посмотреть, сколько найденных страниц указано в правой части интерфейса. Оба поисковика должны «видеть» примерно одинаковое количество (но допустима разница в 50–100 при тысяче страниц).

Почему роботы могут «не видеть» страницы?

Проблемы с файлом robots.txt. Этот файл помогает поисковым ботам получать информацию о площадке. Он должен лежать в корневом каталоге сайта и включать инструкции о том, какие страницы индексировать, а какие нет, и где найти карту ресурса.

С индексацией будут проблемы, если файл некорректно сделан, не там расположен или его вообще нет. Проверить свой robots.txt на правильность можно в инструментах для вебмастеров Яндекса и Google.

Проблемы с картой сайта. Карта сайта — это список ссылок на страницы ресурса, разбитый по разделам. Может существовать в виде страницы на сайте или как отдельный файл sitemap.xml. (Страница открыта и для посетителей, и для поисковых роботов, а файл — только для вторых.

Если у вашего сайта нет карты, поисковики не смогут корректно изучить ресурс. Если вы добавили новые страницы, но забыли обновить файл sitemap — боты их не проиндексируют. Если вы скрыли в карте удаленные страницы тегами, это тоже не понравится ботам — в отличие от файла robots.txt, там должны быть ссылки только на актуальный контент.

«Битые» ссылки, некорректная переадресация. «Битые» ссылки ведут на страницу с ошибкой 404 «Страница не найдена». Обычно они возникают из-за переезда ресурса или удаления страниц: в таких случаях настраивают переадресацию, но иногда делают это неправильно, или она со временем перестает работать.

Проверить сайт и устранить некоторые неисправности можно в Вебмастере и Search Console.

Как исправить ошибки со ссылками и редиректом?

- Заменить ссылки на страницы с 404-м ответом на актуальные.

- Заново настроить «отвалившуюся» переадресацию.

- Заменить временный редирект 302 на постоянный 301 там, где 302 был выбран неверно.

- На страницу 404 добавить ссылку на главную и строку поиска.

5. Для всех изображений на сайте заполнить alt и title, чтобы при проблемах с загрузкой отображался текст.

Сайт не нравится посетителям

Понять, насколько ресурс удобный и интересный, можно по различным показателям веб-аналитики, например, посещаемости, отказам, глубине просмотра (количеству страниц, посещенных за один сеанс) и времени, которое люди проводят на сайте. Посмотреть их можно в сервисах веб-аналитики: самые распространенные это Google Analytics и Яндекс.Метрика.

Как можно улучшить поведенческие факторы?

Повысить скорость загрузки, если она низкая. Узнать, какие есть проблемы и как их решить, можно в сервисе Google PageSpeed Insights. (В блоге Unisender подробно рассказывали, что влияет на время загрузки сайта и как увеличить скорость.)

Адаптировать сайт под мобильные устройства. (Unisender писали, как проверять адаптивность (мобильность) сайтов.

Найти точки входа с высоким показателем отказов. Затем определить причины (например, страницы не соответствуют запросам или тем плохо раскрыта) и устранить их.

Сделать внутреннюю перелинковку: связать одни страницы сайта с другими (например, с помощью добавления блока рекомендованных товаров). (В блоге Unisender есть исчерпывающий гид по перелинковке своего сайта.)

2. Проблемы с контентом

Переоптимизация и переспам

Проще говоря, это переизбыток ключевых слов в контенте страниц или в метатегах (обычно в title и description). Есть много фильтров, которые поисковики могут наложить за такое (не все из них отображаются на панелях Яндекса и Google для вебмастеров, особенно если в бан попал не весь сайт).

Проще ориентироваться на «проседаемость» страниц в выдаче и проверять тексты на «тошноту» (заспамленность ключевиками) — следить, чтобы она не превышала 5-15%. Для этого можно использовать сервисы вроде Text.ru или «Адвего».

Каннибализация запросов

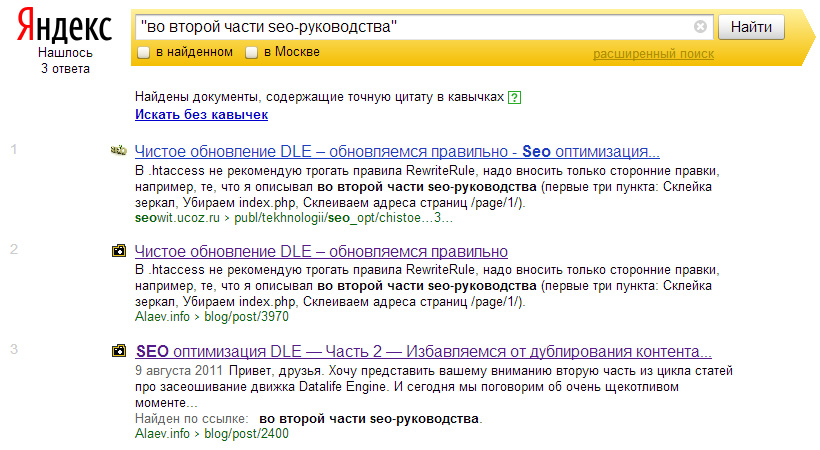

Это когда сайт конкурирует в выдаче с самим собой — потому что разные страницы релевантны одним и тем же запросам (вероятно, потому что оптимизировались под одинаковые ключевые слова или близкие по смыслу). В результате поисковик часто показывает только одну из двух страниц, поэтому каннибализацию не всегда можно обнаружить, вбивая свои ключевики в поиск вручную. Лучше проверять с помощью SEO-сервисов — к примеру, PR-CY.

Если сервис нашел несколько страниц для одного ключевика, надо перенести полезную информацию с одной на другую и удалить лишний вариант. А с адреса удаленной страницы настроить переадресацию.

Дубли

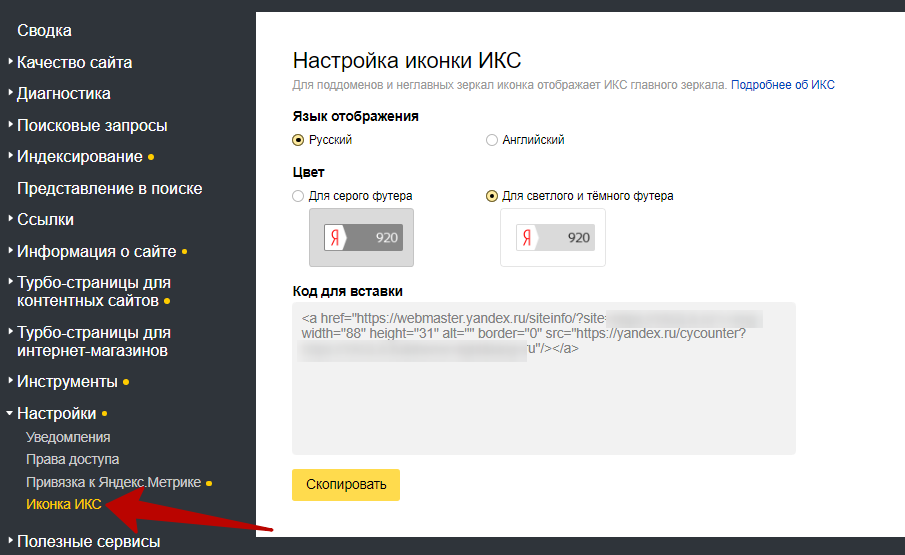

В идеале никакой контент на сайте не должен повторяться. Проверить сайт на наличие любых копий можно в Яндекс Вебмастере (разделы «Диагностика» и «Индексирование», подразделы «Страницы в поиске» и «Заголовки и описания») и Google Search Console.

Что делать с дублями?

Настроить редиректы со страниц с www, если ваш сайт без www.

Указать главное зеркало, чтобы поисковики не путались: с www или без него, с http или c https.

Запретить индексировать тестовые домены и поддомены с помощью файла robots.txt.

В код копий страниц добавить атрибут rel=»canonical» в <head> со ссылкой на адрес той страницы, которая является основной.

Создать статические адреса, уникальные метатеги и сопровождающие тексты для каталожных страниц с фильтрами (иначе при фильтрации ассортимента страница меняет URL).

Для страниц навигации сделать шаблонные теги для пронумерованных страниц ассортимента, добавив тег вида «Страница №».

Самое важное: чтобы не было дублей у самого сайта и главной страницы, потому что именно с нее начинается путь многих клиентов и поисковых роботов. Остальные дубли менее критичны.

Заимствованный или устаревший контент

Поисковики любят оригинальные и актуальные тексты без «воды», которые к тому же легко читаются. Проверить содержимое своего сайта на уникальность, читабельность и «водность» можно в сервисах «Адвего», eTXT, Text. ru, Content Watch и подобных. Лучше сразу в нескольких: показатели разнятся.

ru, Content Watch и подобных. Лучше сразу в нескольких: показатели разнятся.

Актуальность нужно оценивать самостоятельно. А также следить, чтобы уже опубликованная информация не устаревала. Например, из-за изменений в законодательстве, прекращения поддержки устройств провайдерами ПО, закрытия / открытия границ странами — все зависит от тематики. Если что-то важное изменилось, то контент лучше обновить.

Даже если изначально тексты и изображения были уникальными, позже их могли скопировать конкуренты. Если ранжирование страницы просело, стоит проверить, не своровали ли у вас контент. В таком случае можно потребовать от конкурента удалить информацию, пожаловаться на него в Google/Яндекс или даже обратиться в суд. Или подготовить новый уникальный контент.

3. Некачественные ссылки

Разбираемся, какие ссылки считают таковыми:

Ссылки от «плохих» сайтов-доноров

То есть сайтов, которые ссылаются на ваш.

Доноров нужно проверять прежде всего на качество, спамность (чем больше на сайте ссылок на другие ресурсы, тем больше спамность) и трастовость ( англ. «trust» — доверие). Чем качественнее сайт, тем больше ему доверяют поисковые системы.

«trust» — доверие). Чем качественнее сайт, тем больше ему доверяют поисковые системы.

Качество выражается в показателях ИКС (индекс качества сайта) Яндекса и PageRank Google, трастовость — в показателях Траст Яндекса и TrustRank Google соответственно. Спамность можно оценить по количеству исходящих ссылок и соотношению исходящих и входящих.

Узнать эти и другие показатели доноров можно с помощью SEO-сервисов: например, CheckTrust, RDS bar и PR-CY. Смотреть лучше в нескольких: как и в случае с проверкой текстов, данные будут отличаться.

Ссылки от доноров такой тематики, которая не коррелирует с вашей

Если тематика той страницы, где размещена ссылка на вас, совсем не соответствует тематике вашего сайта, то это выглядит странно. Хотя бы 30% ссылок должны быть с близких по смыслу страниц (сам сайт может быть другой тематики).

Ссылки со страниц с неуникальным контентом

Напомню, проверить уникальность можно с помощью «Адвего», eTXT, Text.ru, Content Watch и подобных сервисов.

Ссылки неестественного вида или размещенные в неестественных местах

Это может быть, например, ссылка, у которой цвет такой же, как у фона (в таком случае она скрыта от обычного пользователя, видна только для поискового робота). Или опубликованная в неудобном для пользователя месте.

Спамные или явно коммерческие гиперссылки с прямыми вхождениями ключевых запросов

Допустим, ссылка с текстом в духе «купить москва недорого».

Важно: даже если все ссылки качественные, — но их количество слишком быстро увеличивалось, — такое продвижение поисковики могут посчитать искусственным и понизить сайт в выдаче. Лучше наращивать объем с такой же скоростью, с какой это делали конкуренты.

Как улучшить ссылочную массу?

- Размещайтесь на ресурсах своего уровня (примерно такого же размера, качества и возраста).

- Не ставьте ссылки рядом со словами, которые могут указывать на платное размещение («реклама», «спонсор», «партнерский материал» и т.

п.).

п.). - Используйте в анкорах низкочастотные запросы: по ним легко поднять в выдаче даже не идеально оптимизированный сайт.

- Используйте разные виды ссылок — арендные, вечные покупные, бесплатные; размещайте их на разных типах страниц и в разных частях страниц; пусть они ссылаются на разные страницы вашего сайта

- Обеспечьте равномерность: примерная норма — 2-3 внешних ссылки, ссылающихся на одну вашу страницу.

4. EAT-факторы

EAT расшифровывается как expertise, authoritativeness, trustworthiness — экспертность, авторитетность и достоверность. Это критерии, по которым Google оценивает сайты. У Яндекса есть аналогичная метрика Proxima.

EAT и Proxima используются для оценки всех сайтов, но наибольшее значение имеют для тематик, где можно серьезно навредить людям. Google традиционно относил такие сайты к категории YMYL (Your Money or Your Life), то есть оказывающие влияние «на жизнь или финансовое благополучие человека». У Яндекса нет специального термина, но суть та же: для поисковика есть сайты серьезных тематик, которые он придирчиво проверяет.

YMYL — это, в первую очередь, медицина (а также все, что касается здоровья), финансы, недвижимость, электронная торговля — их проверяют строже всего. Во вторую — юриспруденция (включая госучреждения, ресурсы о законах, правах и обязанностях), наука (в т.ч. все о технологиях), услуги, новостные и общественно-политические СМИ, а также все остальное, что может повлиять на счастье или достаток.\

Важно: в обновлении своего руководства от 28 июля 2022 года Google указал, что оценивает именно по EAT не только страницы YMYL-тематик, но и все другие, которые «с большой вероятностью могут навредить читателю».

Как оптимизировать сайт под EAT?

Покажите, что контент экспертный и подготовлен профессионалами. Опубликуйте лицензии, сертификаты, дипломы, награды, аккредитации компании и сотрудников, логотипы известных клиентов и партнеров, подпишите профильные статьи именами своих экспертов.

Покажите, что компания и сотрудники — авторитеты в своей сфере. В этом помогут обратные ссылки на сайтах, которые заслуживают доверие поисковиков, отзывы авторитетных клиентов, рейтинги бизнеса на картах, профили ваших специалистов, если они известны в сети (здорово, если человек ведет профильный блог / записывает подкаст, пишет статьи или книги, состоит в профессиональных сообществах, участвует в мероприятиях отрасли, особенно в качестве члена жюри).

В этом помогут обратные ссылки на сайтах, которые заслуживают доверие поисковиков, отзывы авторитетных клиентов, рейтинги бизнеса на картах, профили ваших специалистов, если они известны в сети (здорово, если человек ведет профильный блог / записывает подкаст, пишет статьи или книги, состоит в профессиональных сообществах, участвует в мероприятиях отрасли, особенно в качестве члена жюри).

Покажите, что вам можно доверять.

Во-первых, получите SSL-сертификат — он защищает информацию и подтверждает подлинность сайта. Если ваш сайт загружается, когда вы указываете https в URL, значит сертификат уже есть. Если не загружается — его нет или он неправильно установлен. Вероятно, его надо купить или получить от хостинга (они часто дают SSL базового уровня бесплатно на какой-то период).

Во-вторых, опубликуйте всю важную информацию об организации и о том, чем она занимается: наименование юрлица, адреса, реквизиты, контакты, максимально полные данные о продуктах / услугах (параметры товаров, условия обслуживания, гарантии, способы оплаты и доставки, условия возврата).

5. «Заброшенность» сайта

Как поисковики могут определять неактуальность:

Сайт не обновляется

Даже если опубликованный контент еще актуален, но на сайте нет новых материалов, никто не отвечает на комментарии пользователей, не добавляются новые товары / услуги — поисковики решат, что ресурс «забросили».

Стоит регулярно обновлять старые страницы и те, на которых «проседает» трафик: роботам будет достаточно даже добавления нескольких слов.

Сайт не соответствует современным требованиям поисковиков

Требования Google и Яндекса регулярно меняются: появляются обновления существующих метрик, создаются новые фильтры и алгоритмы, упраздняются одни показатели и вводятся другие. Если за всем этим не следить, можно оказаться в ситуации, когда привычный подход не дает результата или даже вредит.

Самостоятельно проверить свой сайт на вышеперечисленные проблемы (и не только) можно на нашей платформе Rookee. Аудит автоматический и бесплатный.

Поделиться

СВЕЖИЕ СТАТЬИ

Другие материалы из этой рубрики

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

«Честно» — авторская рассылка от редакции Unisender

Искренние письма о работе и жизни.

Наш юрист будет ругаться, если вы не примете 🙁

Как запустить email-маркетинг с нуля?

В бесплатном курсе «Rock-email» мы за 15 писем расскажем, как настроить email-маркетинг в компании. В конце каждого письма даем отбитые татуировки об email ⚡️

*Вместе с курсом вы будете получать рассылку блога Unisender

Оставляя свой email, я принимаю Политику конфиденциальностиредиректов — Индексный робот Яндекса перенаправляется при запросе этого сайта, поэтому файл robots.

txt не будет использоваться. Что исправить?

txt не будет использоваться. Что исправить?спросил

Изменено 7 лет, 2 месяца назад

Просмотрено 206 раз

У нас есть сайт: www.example.com , который перенаправляет на https://www.example.com .

Поэтому, когда вы вводите www.example.com/robots.txt , вы перенаправляетесь на https://www.example.com/robots.txt .

Еще одно замечание:

Главное зеркало в Яндексе будет определять краулер, он не позволит нам установить www.example.com или установить https://www.example.com в качестве основного зеркала.

Обратите внимание: эта ошибка, которую я получаю

Индексный робот Яндекса перенаправляется при запросе этого сайта, поэтому файл robots. с этой страницы:

https://webmaster.yandex.com/robots.xml![]() txt не будет использоваться

txt не будет использоваться

Обновление:

Мы обновили наш Robots.txt до следующего после ответов.

User-agent: Яндекс

Карта сайта: https://www.example.com/sitemap.xml

Запретить: /some_pages/

Хост: https://www.example.com

Пользовательский агент: *

Карта сайта: https://www.example.com/sitemap.xml

Запретить: /some_pages/

- редиректы

- https

- карта сайта

- robots.txt

- yandex

Можно установить главное зеркало в Яндекс. Я думаю, вам нужно что-то вроде этого:

Хост: myhost.ru #uses Пользовательский агент: * Запретить: /cgi-bin User-agent: Яндекс Запретить: /cgi-bin Хост: www.myhost.ru # не используется

или даже:

# domen.myhost.com - главное зеркало # www.domen.myhost.com, правильное использование # хост Host директива: User-Agent: * Запретить: Хост: domen.myhost.com

Директива Host должна содержать:

Указание протокола HTTPS, если зеркало доступно только через защищенный канал (хост: https://myhost.com). Одно конкретное доменное имя, соответствующее RFC 952 и не являющееся IP-адресом. Номер порта, если необходимо (хост: myhost.com:8080).

Дополнительная информация: https://yandex.com/support/webmaster/controlling-robot/robots-txt.xml

5

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя адрес электронной почты и пароль

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Нажимая «Опубликовать свой ответ», вы соглашаетесь с нашими условиями обслуживания, политикой конфиденциальности и политикой использования файлов cookie

.

Как часто Google сканирует ваш сайт?

Что такое ползание?

Сканирование — это слово, которое вы, возможно, уже слышали много раз, но когда оно используется в контексте индексации веб-сайтов, немногие могут знать его значение. Чтобы понять сканирование, вам нужно знать, что любой контент в Интернете можно найти с помощью поисковых систем. Эти поисковые системы, такие как Google, неустанно работают над поиском и индексацией веб-контента, чтобы предоставить пользователям результаты поиска самого высокого качества.

Сканирование — это то, как Google и другие подобные поисковые системы находят новые и обновленные страницы. В случае с Google для перехода на эти сайты и обновления списка страниц используется нечто под названием Googlebot. Googlebot постоянно ищет и добавляет новые ссылки в свои списки страниц. Он также принимает к сведению мертвые ссылки, которые также обновляет, чтобы отвести веб-трафик.

В этой статье мы поможем ответить на вопрос « Как часто Google сканирует ваш сайт ?». Но сначала мы обсудим более подробно возможности сканирования Google.

Как заставить Google сканировать ваш сайт?

Само собой разумеется, что вы хотите, чтобы Google просканировал ваш сайт, так как это единственный способ, которым он сможет появиться в результатах поиска. А поскольку Google является самой популярной поисковой системой в мире, попадание в их список результатов поиска станет огромным благом для вас и вашего контента. К счастью, заставить Google просканировать ваш сайт очень просто.

Все, что вам нужно сделать, это использовать инструмент Google для веб-мастеров. Подтвердите свой сайт там и просто нажмите кнопку, попросив его просканировать. У вас есть возможность запросить сканирование всего сайта или выбранных страниц. Вам также нужно будет сделать это только один раз, и пока вы регулярно обновляете свой сайт, после того, как вы окажетесь в списке сканирования Google, робот Googlebot будет продолжать периодически возвращаться, чтобы периодически сканировать ваш сайт и новые страницы.![]()

Как узнать, сканирует ли Google ваш сайт?

Проверить это еще проще, чем просить Google выполнить сканирование. На своей странице проверьте свой URL-адрес, чтобы увидеть подробную информацию об отчете индекса Google. Чтобы уточнить, индексация — это то, как Googlebot организует свои различные списки. Из этого отчета вы можете легко просмотреть, просканировал ли Google ваш сайт и каков его статус индексации. Вы также можете протестировать живую версию своего сайта здесь.

Что делать, если Google не сканирует ваш сайт?

Если вы выполнили описанные выше шаги и обнаружили, что Google не сканировал ваш сайт или не сканировал его в течение некоторого времени, это признак того, что что-то не так. Робот Googlebot не может сканировать сайты, содержащие ошибки, и поэтому просто продолжит работу, если встретит какое-либо сопротивление. Возможные ошибки, которые могут повлиять на успешное сканирование вашей страницы роботом Googlebot, многочисленны. Лучший способ проверить это — использовать инструмент Google для веб-мастеров.

Откройте инструмент и перейдите к сканированию, а затем к ошибкам сканирования. Вам должен быть представлен список возможных проблем. Отсюда все, что вам нужно сделать, это просмотреть список и устранить ошибки. Полезно повторно протестировать ваш сайт после устранения ошибок, чтобы убедиться, что все работает правильно. Если вы продолжаете сталкиваться с проблемами, снова проверьте наличие ошибок сканирования и повторяйте процесс, пока робот Googlebot не сможет просканировать ваш сайт.

Как часто Google сканирует ваш сайт?

Интернет огромен, и хотя робот Googlebot работает без перерыва, вы должны помнить, что через него проходит огромное количество контента. В зависимости от того, насколько активен ваш сайт, вы должны ожидать, что Google будет сканировать его в любое время от четырех до тридцати дней . Сайты, которые обновляются более регулярно, как правило, сканируются чаще, поскольку Googlebot обычно сначала ищет новый контент.

С ее помощью необходимо закрывать от индексирования технические и не представляющие ценности ни для пользователя, ни для поисковых систем страницы. К ним относятся:

С ее помощью необходимо закрывать от индексирования технические и не представляющие ценности ни для пользователя, ни для поисковых систем страницы. К ним относятся:

Получив код ответа 404, поисковая система удалит данный документ из индекса. Следите, чтобы все нужные страницы сайта отдавали код 200 OK.

Получив код ответа 404, поисковая система удалит данный документ из индекса. Следите, чтобы все нужные страницы сайта отдавали код 200 OK.

п.).

п.). myhost.com

myhost.com