Что такое индексация сайта (Как улучшить индексацию в Google)

Индексация сайта — это процесс сбора информации поисковой системой о содержимом вашего сайта. Во время индексации поисковые роботы (пауки) сканирую и обрабатывают web страницы, изображения, видео и другие доступные для сканирования файлы. Чтобы поисковая система быстро проиндексировала сайт: создайте карту сайта и добавьте ее в Google Search Console.

Сайт должен быть проиндексирован чтобы отображаться в поиске

Страницы, которые прошли сканирование и обработку, сохраняются в базу данных. Такая база называется «поисковой индекс». Именно в этой базе данных поисковая система ищет результаты, отвечающие на запросы пользователей.

Важно понимать:

- Если страницы нет в поисковом индексе — ее невозможно найти в поисковой системе.

- Индексация нужна чтобы участвовать в поиске.

- У каждой поисковой системы свой поисковой индекс, свои поисковые боты.

- Поисковой бот от Google называется Googlebot.

- Настройка индексации сайта, это базовый уровень работ по SEO.

Содержание статьи

Как проверить индексацию страницы?

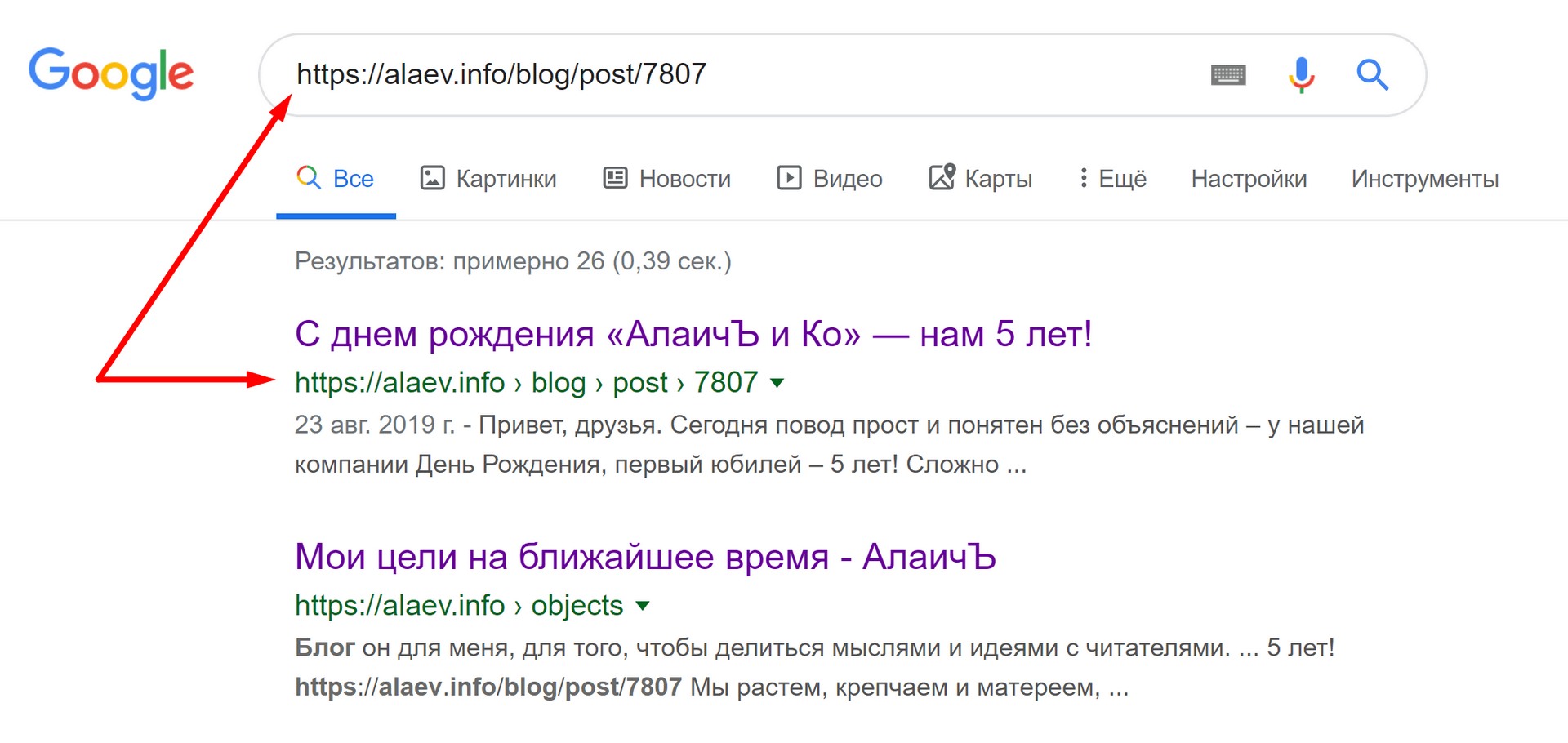

Самый быстрый способ — написать в строку поиска команду site:[адрес страницы]. Такой поиск найдет все проиндексированные страницы сайта. Для того, чтобы просмотреть дату последнего сканирования страницы, напишите в строку поиска cache:[адрес проверяемой страницы]. Если вам нужно проверить индексацию конкретной страницы просто скопируйте ее адрес и введи в поиск запрос site:[адрес страницы]. Этот метод будет работать как в Google так и в Yandex или Bing.

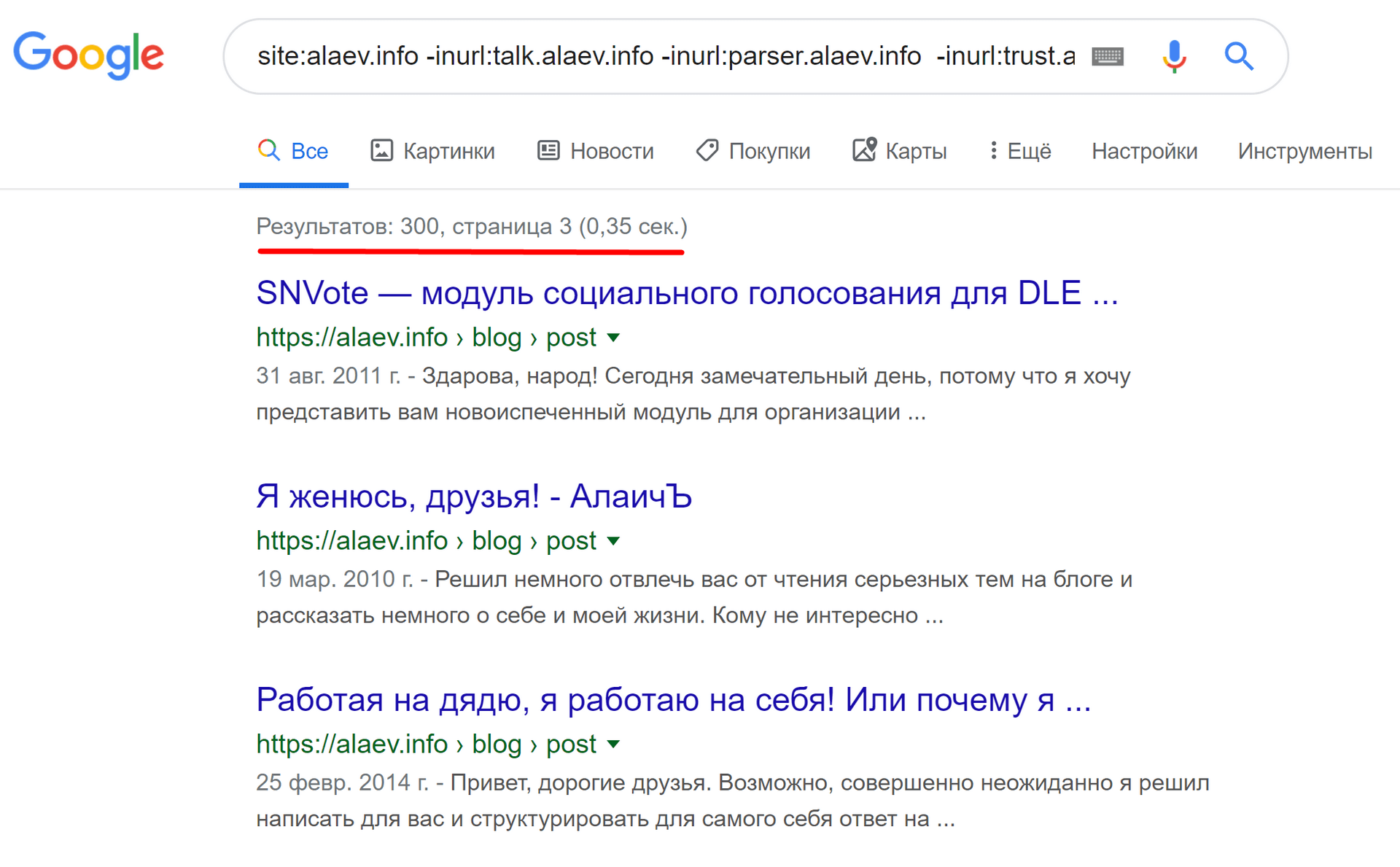

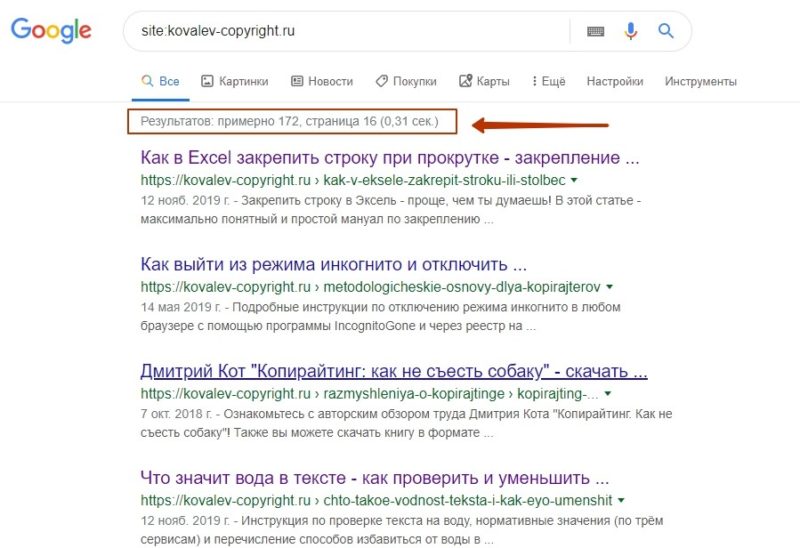

Совет: Сравните количество проиндексированных страниц с реальным количеством страниц на сайте. Это поможет быстро оценить есть ли у вашего сайта проблемы с индексацией. К примеру: если на сайте 100 товаров, 10 разделов и 10 информационных страниц (в сумме 120), а в индексе только 50 страниц, это означает, что поисковая система не знает о большей части вашего сайта.

Как проверить индексацию всего сайта

Для проверки индексации сайта нужно выполнить 2 простых шага:

- Узнать сколько страниц на сайте. Для этого просканируйте свой сайт специальными инструментами. Если ваш сайт до 500 страниц вам подойдет бесплатная версия Screaming Frog , если этого недостаточно используйте, бесплатный Site Analyzer. В разделе «HTML» вы увидите общее количество страниц вашего сайта.

- Зайдите в инструменты для вебмастеров или Google Search Console (Что такое Google Search Consol ) откройте отчет «Покрытие» и просмотрите количество страниц в статусе «Без ошибок». Количество страниц в сканере Site Analyzer и страниц в Google Search Console должно приблизительно совпадать. Это, будет означать, что основные страницы сайта сканируются. Если часть страниц попала в группу «Исключено» вы можете изучить причины исключения страниц. В этом же отчете вы можете познакомиться с

- Довольно часто в отчете «Покрытие» вы можете увидеть большое количество страниц в статусе «Страница просканирована, но пока не проиндексирована» — это означает, что поисковая система уже получила данные о ваших страницах но пока не обработала их до конца. Так же, страницы могут находиться в этом статусе по причине низкого качества: пустые страницы или страницы с повторяющимся содержанием. Если количество «пока не проиндексированных» страниц не сокращается попробуйте уникализировать, добавить содержание или увеличить количество качественных внешних ссылок на свой сайт.

- Если вам нужно массово проверить индексацию страниц вашего сайта, воспользуйтесь онлайн инструментом https://indexchecking.com

- Хорошая идея проверить свой сайт с помощью инструментов https://en.ryte.com — это поможет вам понять какие страницы закрыты от индексации. А так же, обнаружить страницы на которых есть технические проблемы.

Проверяем не закрыта ли отдельная страница от индексации

Если перед вами появилась задача, проверить запрет индексации конкретной страницы проще всего использовать инструменты для вебмастеров. Скопируйте адрес страницы которую вы хотите проверить и вставьте в инструмент «Проверка URL на ресурсе».

Скопируйте адрес страницы которую вы хотите проверить и вставьте в инструмент «Проверка URL на ресурсе».

В результате проверки вы получите информацию о запретах индексации. Обратите внимание на информацию о запретах, статусе страницы и канонический адрес.

Как добавить новый сайт в индекс поисковиков?

Сообщите поисковой системе о своем сайте в специальном инструменте Google или Yandex. Поделитесь своим сайтом в социальной сети или создайте на него ссылку с другого, уже проиндексированного сайта.

Узнайте больше о работе поисковой системы

Что делать, если сайт плохо индексируется?

Прежде всего нужно проверить не закрыт ли сайт от индексации. Это можно сделать по инструкции в этой статье чуть выше. Основные способы улучшить индексацию:

- Создайте карту сайта и загрузите в инструменты для вебмастеров.

- Обновите старые страницы.

- Удалите пустые страницы.

- Поставьте дополнительные ссылки на сайт с сторонних сайтов и соц. сетей.

Как происходит индексация сайта

Для решения проблем нужно разобраться в процессе индексации подробнее. С технической точки зрения “индексацию сайта” правильнее рассматривать как два отдельных процесса:

- Сканирование страниц.

- Обработка страниц.

Этап 1: Сканирование

Сканирование или “обход” страниц — это основная задача, которую выполняет поисковой бот. Попадая на новую страницу, бот получает со страницы два набора данных:

- Содержание самой страницы, информацию о сервере и служебные данные. А именно: ответ сервера, html код страницы, файлы css стилей, скриптов, изображений.

- Перечень ссылок, которые находятся на странице.

Полученное содержание передается для дальнейшей обработки и сохранения в базу. Просканированные ссылки так же сохраняются в специальный список — “очередь сканирования”, для дальнейшей обработки.

Когда бот добавляет в очередь индексации страницу, которая уже есть в очереди, эта страница занимает более высокое место в списке и индексируется быстрее. А это значит, что

Создавая очередь сканирования, google bot, как и другие поисковые боты, изучает карту сайта sitemap и добавляет в очередь ссылки из этой карты. Второй способ улучшить индексацию — создать карту сайта sitemap.xml и сообщить о ней поисковой системе. Карта сайта — самый простой способ отправить на индексацию все страницы в рамках нашего домена.

Есть несколько способов создать карту сайта:

- Бесплатный онлайн инструмент для сайтов до 500 страниц www.xml-sitemaps.com.

- Программа для сканирования сайта, с возможностью создания sitemap — xenu links.

- Библиотека приложений для создания sitemap.

- Самый популярный плагин для создания карты сайта для WordPress.

Чтобы Google узнал о вашем sitemap, нужно добавить ссылку на карту сайта в инструментах search console или файле robots.txt

Добавление карты сайта в Search Console:

- Зайдите в https://search.google.com/search-console/

- Добавьте свой сайт или выберите из списка.

- Перейдите в раздел Сканирование — Файлы Sitemap.

- Выберите “добавить файл sitemap”, вставьте ссылку и добавьте карту сайта.

Добавление sitemap в robots.txt:

- Зайдите в корневой каталог сайта через ftp.

- Откройте файл robots.txt

- Добавьте в конец файла строку “Sitemap: [адрес сайта]/sitemap.xml” и сохраните файл.

Третий способ ускорить индексацию — сообщить поисковому боту о дате последнего изменения страницы. Для получения даты и времени изменения страницы боты используют данные из заголовка ответа сервера lastmod. Сообщить наличие изменений на странице можно с помощью кода ответа not modify.

Инструмент проверки заголовка lastmod и ответа сервера not modify.

Наличие настроек lastmod и not modify позволяют поисковой системе быстро получить информацию о том, изменилась ли страница с даты последнего сканирования. Благодаря этому поисковой бот ставит в приоритет новые и измененные страницы, а новые страницы быстрее индексируются.

Для настройки lastmod и not modify вам нужно будет обратиться к веб разработчику.

Этап 2: Обработка данных

Перед тем как сохранить информацию в базу данных, она проходит обработку и структуризацию, которая необходима для ускорения дальнейшего поиска.

В первом шаге обработки программа-индексатор формирует страницу с учетом всех стилей, скриптов и эффектов. В этот момент программа-индексатор понимает расположение элементов на странице, определяет видимые и невидимые пользователю части, разделяет страницу на навигацию и содержание.

Важно чтобы google bot имел полный доступ к css и js файлам, ведь без них индексатор не сможет понять структуру страницы.

Для проверки доступности всех служебных файлов зайдите в Google Search Console, отчет “Посмотреть как Googlebot” в разделе “Сканирование”. Проверьте с помощью этого инструмента основные страницы сайта, обратите внимание на различия между тем, как вашу страницу видит поисковой бот и как ее видит пользователи. Изучите таблицу из отчета. Все ресурсы, которые размещены на вашем домене, должны быть открыты для сканирования.Сейчас Google использует алгоритм индексации, который называется Caffeine. Он был запущен в 2009 году. Основные задачи этого алгоритма:

- Обработка современных страниц, использующих сложные js и css элементы.

- Максимально быстрое сканирование всех страниц в Интернете.

Анализ текста при индексации

После разделения страницы на зоны и определения их важности, алгоритм выделяет из содержания основные элементы

Стоит отметить, что перед расчетом частоты упоминания слова, индексатор проводит упрощение слов к элементарной форме. Этот процесс называется стеминг. Такое упрощение позволяет учитывать слово в разных словоформах как одно слово.

Частота упоминания (Term frecency, ТА) слова рассчитывается как отношение упоминания слова к общему количеству слов страницы. Пример: если на странице 100 слов и слово “машина” встречалось на ней 2 раза — частота упоминания слова “машина” будет равна TF=0,02

Самый простой поисковой индекс легко представить в виде огромной таблицы, в столбцах которой перечислены все слова языка, а в строках — адреса всех страниц. При этом в ячейках указаны частоты слов на соответствующих страницах.

Именно такая таблица позволяет поисковой системе быстро находить страницы, которые содержат нужные слова. Конечно современные поисковые системы учитывают не только частоту упоминания слов, но и более сложные факторы. Поисковой индекс Google значительно сложнее чем приведенный пример.

Анализируя содержание поисковая система проверяет уникальность страницы. Тексты и прочее содержание, которое уже было проиндексировано на других страницах, не несет ценности для системы, так как не добавляет в базу новой информации. А это значит, что страницы с низкой уникальностью могут быть не проиндексированы. Проверить уникальность достаточно просто с помощью бесплатных инструментов.

Старайтесь создавать максимально уникальный и полезный контент и он точно будет проиндексирован.

От чего зависит индексация сайта?

- Доступность сайта для индексации — если сканирование сайта запрещено поисковая система не сможет получить его страницы. Подробнее о инструментах управления индексацией: youtube.com Внутренняя оптимизация: robots.txt, sitemap

- Количество ссылок на ваш сайт — ссылки, это пути которые приводят поисковых роботов к вам на сайт. Чем больше ссылок с популярных ресурсов вы получаете, тем чаще будут сканироваться страницы вашего сайта.

- Частота обновления сайта. Поисковые системы всегда ищут новый интересный контент, чем чаще вы публикуете новое уникальное содержание, тем быстрее поисковая система будет его сканировать.

- Наличие сайта в инструментах поисковых систем. Видео в тему: Как зарегистрировать сайт в Google Search Console.

Подведем итоги

- Индексация — это процесс сканирования и обработки содержания для хранения в базе данных поисковой системы.

- Ускорить индексацию можно с помощью ссылок, карты сайта и настроек сервера.

Чтобы поисковая система понимала ваши страницы, все ресурсы вашего сайта должны быть доступны поисковому боту.

Мы можем проверить и настроить индексацию вашего сайта за вас.

SEO аудит с рекомендациями за 10 дней.

Надеюсь у вас больше не возникнет вопрос: “Что такое индексация сайта”.

Руководитель отдела продвижения SEO7. Ведущий Youtube канала Школа SEO. Автор блога о поисковой оптимизации seo-sign. com

com

Что такое индексация сайта и как её проверить — SEO на vc.ru

Чем бы вы ни занимались, интернет-магазином, корпоративным порталом или лендингом, сделать сайт — лишь полдела. Дальше начинается самое интересное — продвижение. Индексация в этом деле — первый шаг на пути к топу поисковой выдачи. Рассказываем о том, как она происходит, как её проверить и ускорить.

3801 просмотров

Как работает индексация

Продвижение начинается с попадания страниц сайта в индекс поисковых систем (ПС). В эти базы данных Яндекс, Google и другие сервисы заносят информацию о содержимом страниц: использованных на них ключевых словах, размещённом на них контенте и другую информацию. Затем, когда пользователь обращается к ПС с запросом, сервис анализирует собранные данные и подбирает наиболее подходящие варианты ответа из списка проиндексированных страниц.

В эти базы данных Яндекс, Google и другие сервисы заносят информацию о содержимом страниц: использованных на них ключевых словах, размещённом на них контенте и другую информацию. Затем, когда пользователь обращается к ПС с запросом, сервис анализирует собранные данные и подбирает наиболее подходящие варианты ответа из списка проиндексированных страниц.

Как попасть в индекс поисковых систем

Чтобы ваш сайт проиндексировали, о нём нужно сообщить поисковикам. Это можно сделать несколькими способами.

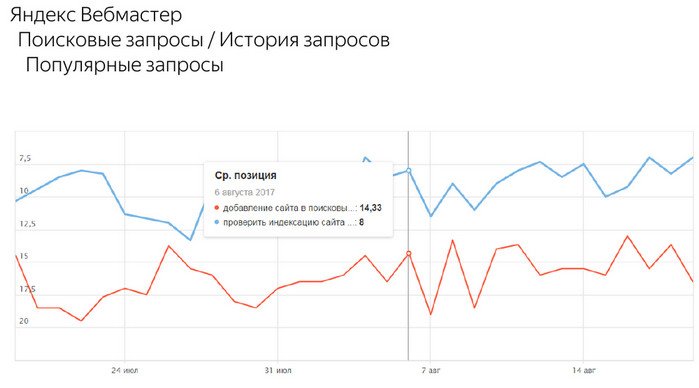

1. С помощью инструментов поисковых систем. Почти у всех поисковиков есть собственные сервисы для веб-мастеров. У самых популярных из них на территории СНГ — Google и Яндекс — это Search Console и Яндекс.Вебмастер. В последнем даже есть специальный инструмент, позволяющий отправлять от 20 ссылок в день на страницы, которые нужно проиндексировать в приоритетном порядке.

У самых популярных из них на территории СНГ — Google и Яндекс — это Search Console и Яндекс.Вебмастер. В последнем даже есть специальный инструмент, позволяющий отправлять от 20 ссылок в день на страницы, которые нужно проиндексировать в приоритетном порядке.

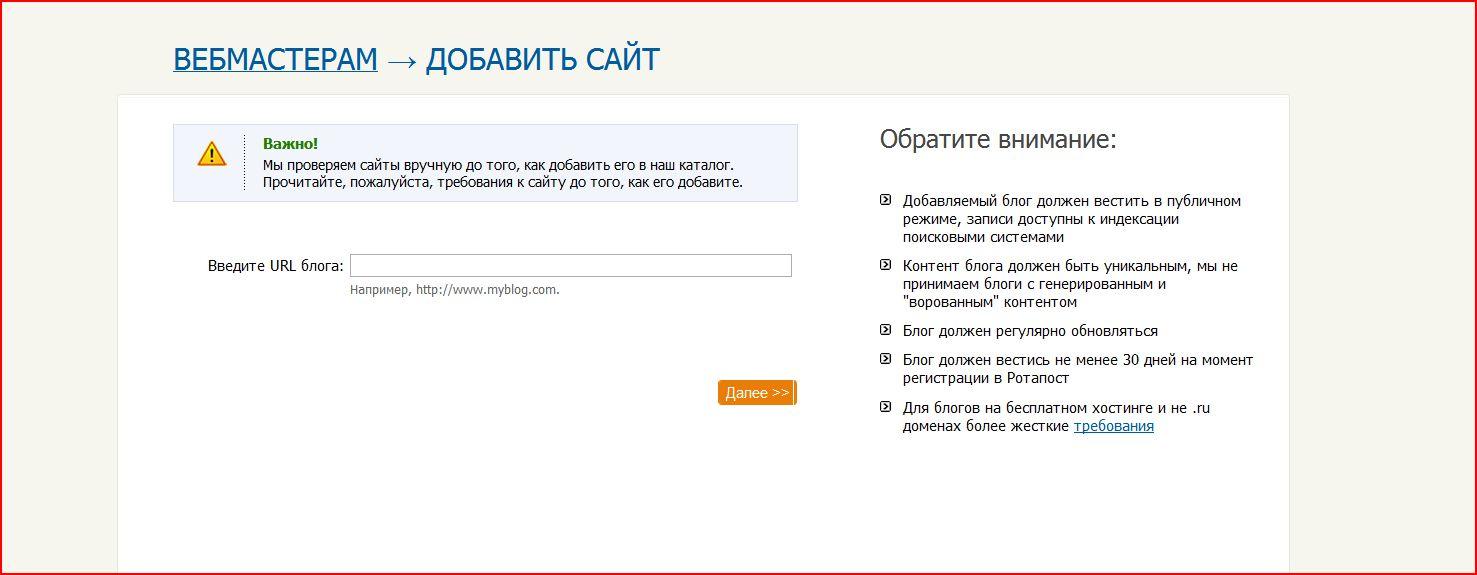

Однако когда речь заходит не о нескольких десятках страниц, а об индексации сайта в целом, более эффективным решением будет добавить его в Яндекс и Google, а затем указать ссылку на карту сайта (файл Sitemap) в Search Console и Яндекс.Вебмастер. Тогда поисковики начнут самостоятельно и регулярно посещать ваш сайт и его новые страницы, чтобы затем добавить их в индекс. О том, как составить карту сайта вы можете узнать в руководстве Google. Что касается скорости попадания в выдачу, она зависит от многих факторов, но в среднем занимает одну—две недели.

2. С помощью ссылок с других сайтов. Быстро обратить внимание поисковых систем на вашу новую страницу можно, разместив ссылки на неё на других порталах. Если один из них будет новостным, скорее всего, страница быстро попадёт в выдачу, так как поисковики часто проверяют такие сайты и ссылки на них считают полезными. В некоторых случаях индексирование может занять меньше суток.

С помощью ссылок с других сайтов. Быстро обратить внимание поисковых систем на вашу новую страницу можно, разместив ссылки на неё на других порталах. Если один из них будет новостным, скорее всего, страница быстро попадёт в выдачу, так как поисковики часто проверяют такие сайты и ссылки на них считают полезными. В некоторых случаях индексирование может занять меньше суток.

Попадёт ли страница в поисковую выдачу, зависит от её содержимого. Если с ней всё в порядке, робот проиндексирует её и в скором времени она появится в поисковой выдаче.

Как проверить индексацию сайта

Есть несколько способов узнать были ли проиндексированы нужные вам страницы.

1. С помощью Яндекс.Вебмастера и Search Console. В первом для этого есть специальный инструмент — «Проверить статус URL». Достаточно добавить в него ссылку на нужную страницу, и в течение двух минут (иногда — нескольких часов) вы узнаете о статусе страницы в ПС.

Чтобы проверить статус страницы в Search Console, нужно ввести ссылку на неё в поисковой строке, которая отображается в верхней части экрана. На открывшейся форме вы узнаете, была ли страница проиндексирована поисковиком.

2. С помощью команды «site». Если вы не хотите добавлять сайт в сервисы для веб-мастеров, вы можете проверить сразу все попавшие в индекс поисковиков страницы с помощью специальной команды. Для этого введите в поиск Яндекс или Google запрос вида «site:mysite.ru» (без кавычек), и вы увидите все страницы, попавшие в выдачу.

Для этого введите в поиск Яндекс или Google запрос вида «site:mysite.ru» (без кавычек), и вы увидите все страницы, попавшие в выдачу.

3. С помощью сервисов. Самый простой способ проверить индексацию определённых страниц — воспользоваться для этого сторонними сервисами. Например, Серпхант позволяет проверить индексацию сразу 50 страниц в Яндекс и Google. Введите ссылки на них в специальную форму (не забудьте про http:// или https://) и нажмите «Начать проверку». Иногда инструмент долго выдаёт результаты проверки по одной—двум позициям, но существенно на функциональность это не влияет.

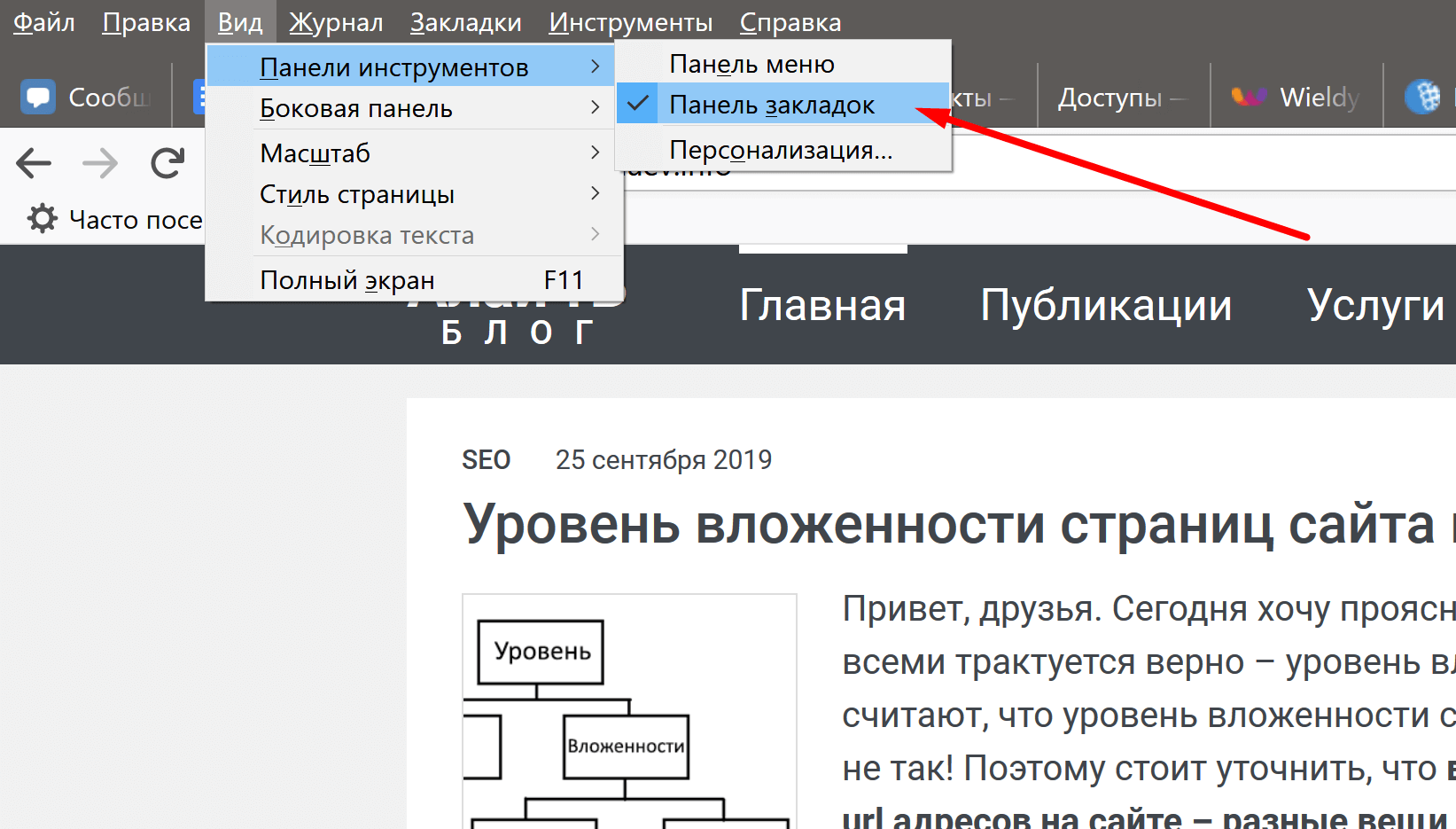

Ещё один сервис — плагин RDS Bar для Chrome, Firefox и Opera — позволяет получить подробную информацию о любой открытой в браузере странице, в том числе и о том, проиндексирована ли она.

Как ускорить индексацию

Чем быстрее поисковые системы внесут страницу в индекс, тем быстрее на неё попадут посетители. Чтобы сократить время ожидания, следуйте следующим рекомендациям:

- Обязательно добавьте сайт в ПС через сервисы для веб-мастеров.

- В Search Console и Яндекс.Вебмастере укажите ссылки на файлы Sitemap и robots.txt.

- Регулярно добавляйте на сайт новый уникальный контент.

- Не забывайте перелинковывать страницы между собой.

- Добавляйте ссылки на новые страницы в социальные сети и на другие сайты.

Как закрыть сайт от индексации

Не все страницы нравятся поисковым системам. Некоторым из них — например, служебным страницам и тем, которые пока что находятся в разработке, — не только нечего делать в выдаче, но и лучше вообще не попадаться на глаза поисковым роботам. Чтобы предотвратить попадание таких страниц в выдачу, лучше сразу запретить их индексацию. Сделать это также можно несколькими способами:

1. Использовать команду Disallow в файле robots.txt. В этом файле указываются правила для поисковых роботов: какие-то страницы в нём можно разрешить индексировать определённым ПС, а какие-то — запретить. Чтобы страница не попала в выдачу, используйте команду Disallow. Подробнее о работе с файлом robots.txt читайте в руководстве Яндекса.

Чтобы страница не попала в выдачу, используйте команду Disallow. Подробнее о работе с файлом robots.txt читайте в руководстве Яндекса.

2. Добавить тег noindex в HTML-код страницы. Наверное, самый простой способ, когда нужно запретить роботу индексацию конкретной страницы или страниц определённого типа. Чтобы воспользоваться им, достаточно добавить в раздел HTML-кода страницы директиву .

3. Использовать авторизацию. Некоторые страницы — например, личный кабинет и «черновики», находящиеся в разработке, — можно закрыть от роботов формой авторизации. Это самый надёжный способ, так как даже те страницы, индексация которых запрещена в robots.txt или директивой noindex, могут попасть в поисковую выдачу, если на них ведут ссылки с других страниц.

Как проверить индексацию конкретной страницы и всего сайта в Яндексе и Google?

Индексация — процесс добавления сведений о сайте роботом в базу данных, которая потом используется для поиска. Бот индексирует ссылки, изображения, видео, и другие элементы на сайте. Если сайт или отдельная страница не проиндексированы, то поисковая система просто не их увидит. Рассказываем как проверить индексацию.

Яндекс

Проверка индексации страницы

Необходимо в строку поиска Яндекс написать следующий запрос:

url:domain.ru/page/

domain.ru/page/ — адрес проверяемой страницы. Важно! Вводить необходимо адрес с www, если страницы на сайте открываются с www, и без www, если на сайте они без www. Если вы не уверены — проверьте оба варианта.

url: — оператор для проверки индексации страницы.

Если в результатах поиска страница найдена, значит она проиндексирована данной поисковой системой. Пример.

Пример.

Если по запросу ничего не найдено, страница не проиндексирована

Проверка индексации всего сайта в Яндексе

Для проверки индексации всего сайта в Яндекс необходимо использовать следующий запрос:

url:domain.ru/*

domain.ru — доменное имя проверяемого сайта.

url: — оператор для проверки индексации страницы.

* — оператор «любой символ».

Важно! Вводить необходимо адрес с www, если страницы на сайте открываются с www и без www, если на сайте они без www. Если вы не уверены — проверьте оба варианта.

В результате получаем список проиндексированных страниц, а справа от результатов выдачи написано, сколько всего страниц данного сайта находится в поиске. Пример.

Иногда данный запрос не работает и вместо него можно использовать оператор site:domain.ru

Проверка индексации страницы

Необходимо ввести в строку поиска Google запрос:

info:domain. ru/page

ru/page

domain.ru/page — адрес проверяемой страницы.

info: — оператор для проверки индексации страницы.

Если страница проиндексирована, значит в результатах поиска будет ссылка на проверяемую страницу. Пример.

Проверка индексации всех страниц сайта в Google

Для проверки индексации страницы в поисковой системе Google необходимо ввести в строку поиска запрос:

site:domain.ru

domain.ru — доменное имя сайта.

site: — оператор проверки индексации всех страниц сайта.

В результатах поиска появится список страниц в поиске, а под поисковой строкой общее количество проиндексированных страниц. Пример.

Что такое индексация сайта, как ее проверить и как ускорить

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц. При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовое наполнение и другое. Если ресурс проходит проверку, то он вносится в индекс ПС, то есть пользователи смогут его найти по поисковым запросам.

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

- Поисковые роботы самостоятельно находят и проверяют созданный сайт или его новые страницы. Многие эксперты считают такой вариант самым выгодным, ведь если ПС сами хотят внести ресурс в индекс, то он пользуется популярностью. Значит, приносит пользу. Как роботы определяют полезность страниц: наличие активных внешних ссылок, объемы трафика и вовлеченность посетителей. Если все условия выполняются, то индексация сайта проходит быстрее: от 24 часов до недели. В противном случае ПС могут и вовсе «забыть» о новом ресурсе. Работы у роботов хватает.

-

Пользователь принудительно отправляет сайт на индексацию с помощью заполнения формы на сервисе поисковой системы.

Созданные страницы помещаются в очередь на «прописку» и ждут посещения роботов ПС. Обычно добавляют URL главной страницы, а боты сами обходят весь ресурс, ориентируясь по карте сайта, меню и внутренним ссылкам. Используются сервисы Google Webmaster Tools и Яндекс.Вебмастер соответственно. Этот вариант занимает больше времени, но не требует финансовых затрат.

Созданные страницы помещаются в очередь на «прописку» и ждут посещения роботов ПС. Обычно добавляют URL главной страницы, а боты сами обходят весь ресурс, ориентируясь по карте сайта, меню и внутренним ссылкам. Используются сервисы Google Webmaster Tools и Яндекс.Вебмастер соответственно. Этот вариант занимает больше времени, но не требует финансовых затрат.

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

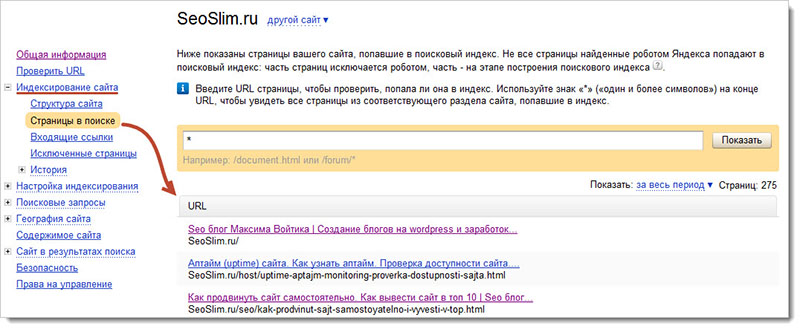

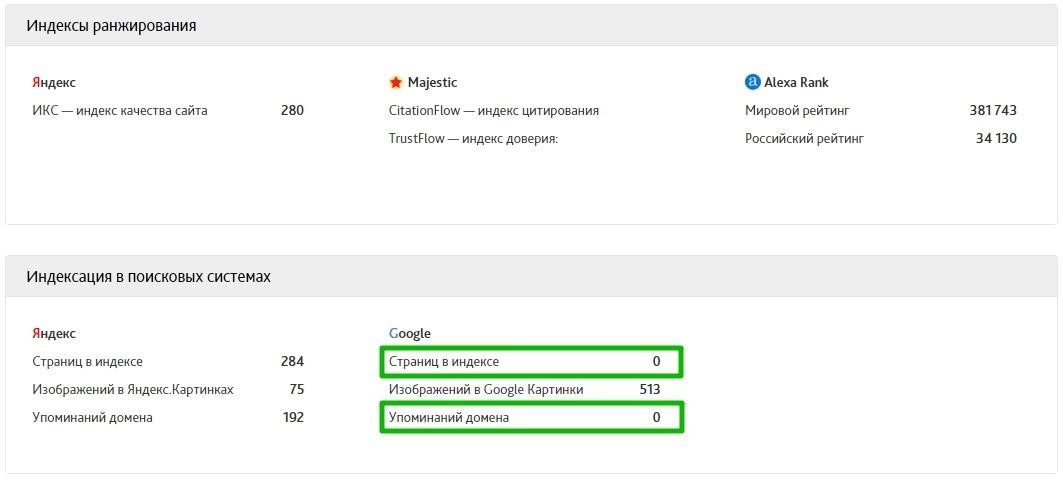

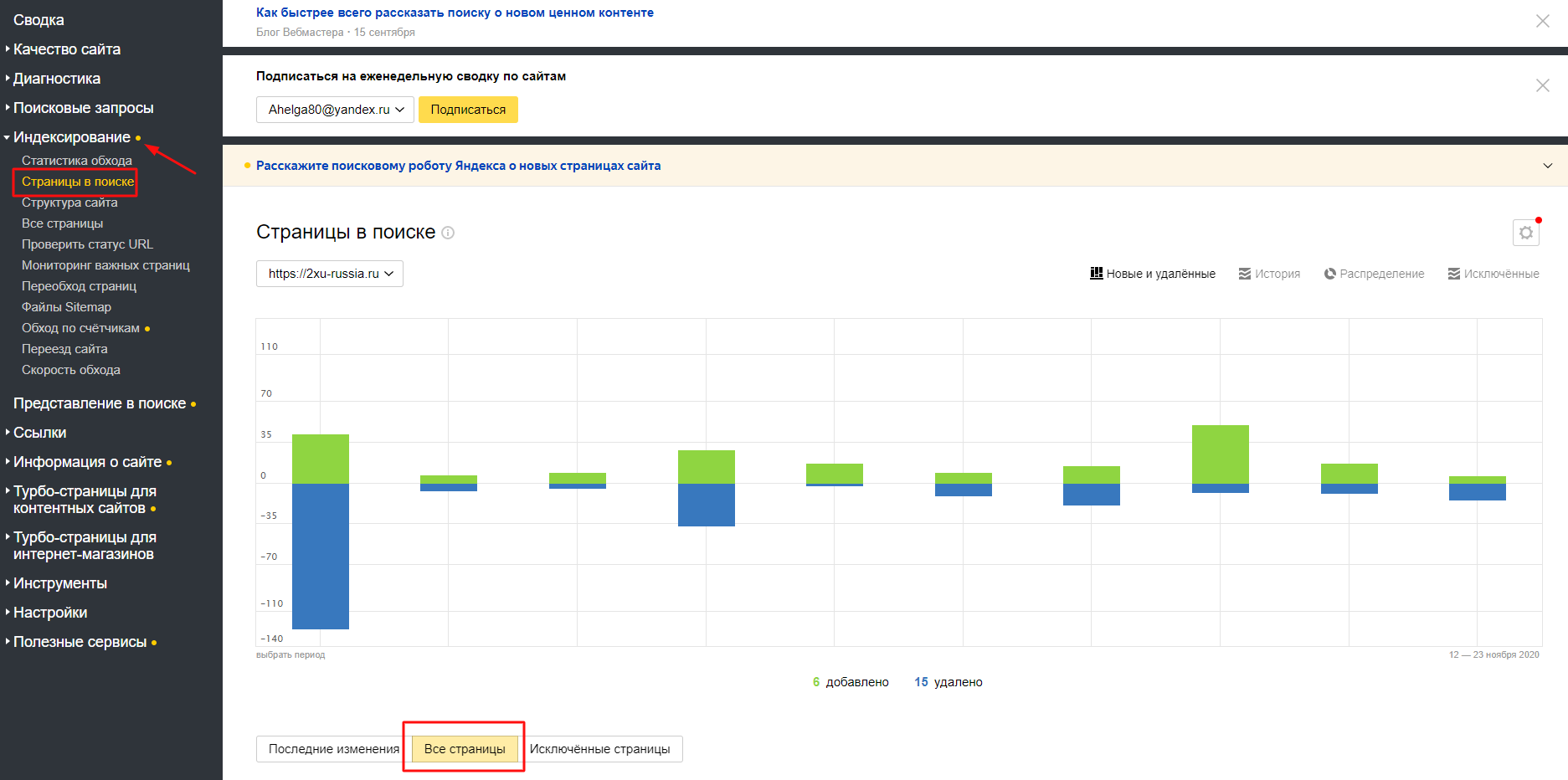

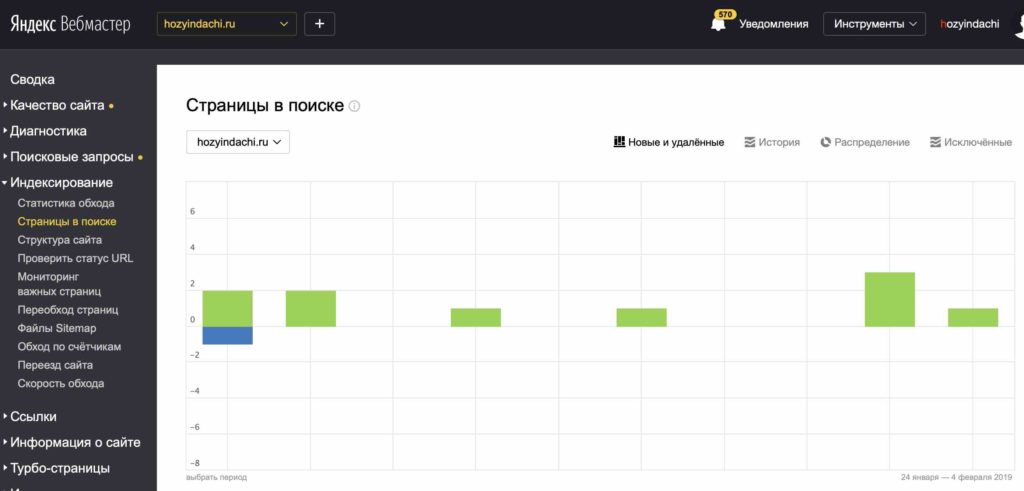

- Использовать инструменты вебмастеров, которые предоставляются поисковыми системами бесплатно – это webmaster.yandex.ru или google.com/webmasters. В Гугле откройте Search Console и далее раздел «Индекс Google». Информация о статусе сайта находится в блоке «Статус индексирования». В Яндексе пройдите по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Естественно нужно сначала внести в форму URL сайта и подтвердить права владельца.

-

Использовать специальные операторы, которые вводятся в поисковую строку.

Для Яндекса и Гугла нужно прописать значение «site:» и после двоеточия добавить домен ресурса. Например: site:calltouch.ru. Таким способом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то вероятно сайт под фильтром.

Для Яндекса и Гугла нужно прописать значение «site:» и после двоеточия добавить домен ресурса. Например: site:calltouch.ru. Таким способом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то вероятно сайт под фильтром.

-

Воспользоваться браузерными плагинами или спецсервисами. Это небольшие дополнения к веб-обозревателю, которые автоматически проверяют наличие страниц в индексе. Популярное решение — RDS Bar.

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

- Авторитетность сайта в сети, полезность для пользователей;

- Отсутствие ошибок при индексации;

- Качество и частота обновления контента;

- Наличие внутренних и внешних ссылок;

- Вложенность страниц;

-

Правильно заполненные файлы sitemap.

xml и robots.txt;

xml и robots.txt; - Корректно выставленные ограничения в роботсе.

Для ускорения индексации рекомендуется выполнить следующие действия:

- Подобрать надежный и быстрый хостинг.

- Поставить сайт на индексацию в ПС Яндекса и Гугла.

- Корректно настроить robots.txt. В файле нужно запретить посещение технических, служебных страниц, просмотр другой информации, не представляющей пользы для посетителей.

- Создать файл карты sitemap.xml и сохранить его в корне сайта. По нему роботы проверяют структуру страниц, а также следят за обновлением контента.

- Проверить код главной и других страниц на наличие ошибок и дублей.

- Проверить текстовое наполнение на количество ключевых слов.

-

Регулярно размещать на сайте новый полезный контент. Рекомендуется настроить внутреннюю перелинковку между статьями и страницами.

Это простой и эффективный вариант повысить вовлеченность пользователей в проект и соответственно «подрасти» в выдаче.

Это простой и эффективный вариант повысить вовлеченность пользователей в проект и соответственно «подрасти» в выдаче. - Настроить навигацию, сделать доступ к нужной странице с главного меню не длиннее 3-х кликов. К юзабилити сайтов сегодня предъявляются повышенные требования, так как это напрямую влияет на поведенческие факторы посетителей. Если до нужной информации расстояние в 10-12 кликов, то 90% пользователей покинут такой сайт.

- Разместить ссылки на ресурс в соцсетях, на тематических форумах, досках объявлений и других площадках генерации трафика.

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

Поставить запрет на сканирование ботами можно несколькими способами:

- Использовать файл robots.txt. В документе можно запретить индексацию отдельной страницы, так и всего сайта целиком. Этот файл как раз и устанавливает правила для роботов ПС. Для запрета используются два основных оператора: указание адресата (User-agent) и запрещающая директива (Disallow), которая ставит «шлагбаум» для бота. Например, если сайт ещё не готов к запуску, то в роботсе можно прописать следующий код: User-agent: * и на следующей строке Disallow: /. Так вы закроете весь ресурс для роботов ПС.

-

Прописать специальные теги в файле robots.

txt. Обычно этот вариант используется для скрытия одной страницы от сканирования. Используются теги noindex и nofollow, которые запрещают ботам ПС проверять страницу или часть контента. Например, можно запретить работу конкретного бота следующим кодом: <meta name=»googlebot» content=»noindex, nofollow»/>.

txt. Обычно этот вариант используется для скрытия одной страницы от сканирования. Используются теги noindex и nofollow, которые запрещают ботам ПС проверять страницу или часть контента. Например, можно запретить работу конкретного бота следующим кодом: <meta name=»googlebot» content=»noindex, nofollow»/>.

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

что это такое, как происходит, как ускорить и проверить индексацию

Нравится статья?

Понравится и работать с нами.

НачатьИндексация сайта в поисковых системах – это то, без чего SEO продвижение невозможно. Если страниц вашего сайта нет в индексе, они не выводятся в поисковой выдаче, а значит, в конкуренции за верхние позиции вы пока не участвуете, и пользователи из поиска не могут перейти к вам.

Разбираемся, как Яндекс и Google индексируют сайты, можно ли ускорить и проконтролировать процесс и каким страницам индексация не нужна.

Что такое индексация и как она происходит

Поисковые системы по запросу выдают пользователям подходящие страницы за пару секунд. Естественно, в это время роботы не перебирают реальные сайты – такой поиск тянулся бы часами. Для ускорения поисковики обращаются к собственной, заранее собранной базе данных. Эта база – и есть индекс.

Поисковики индексируют сайт автоматически, с помощью поисковых роботов – их называют пауками или краулерами. Упрощенно это выглядит так:

- Пауки постоянно отслеживают новые сайты и страницы в интернете.

- Попав на сайт, робот сканирует его. Если в корневой папке лежит правильно заполненный файл robots.txt (а мы настоятельно советуем его прописать и поместить туда), краулер быстрее поймет, какие страницы нужно индексировать, а какие – нет.

- На каждой странице робот в автоматическом режиме оценивает важнейшие элементы, от которых зависит позиция при ранжировании (ключевые запросы, текст, структуру, метатеги и пр.

).

).

- Проиндексированные страницы передаются в базу данных. В каждый визит робот обрабатывает не так много страниц, до 30 штук, чтобы не перегружать ваш сервер.

- После индексации сайта страницы начинают отображаться в выдаче, ведь теперь поисковая система знает о них.

- В дальнейшем робот продолжает посещать ваш сайт, чтобы просканировать и добавить в базу новые страницы. Также поисковики могут удалять страницы из индекса, обнаружив на них технические ошибки. Если вы ежедневно публикуете контент, робот может заходить к вам несколько раз в день, а если сайт долго остается без изменений, то и поисковики будут реже обращать на него внимание (до 3 раз в месяц).

Индексация сайта в Яндексе сразу после запуска может занять до 1 месяца, а в Гугл – до 1 недели.

Как быстрее попасть в индекс

Для успешного продвижения в Яндексе и Google важно, чтобы новые страницы как можно скорее попадали в индекс и начинали ранжироваться. Поэтому советуем использовать возможности для ускоренной индексации сайта.

Поэтому советуем использовать возможности для ускоренной индексации сайта.

Как привлечь внимание поисковиков и быстрее занять место в выдаче:

- Обязательно составить служебный файл robots.txt и карту сайта Sitemap в помощь поисковым ботам.

- Войти в панели управления Google Search Console и «Яндекс.Вебмастер» и оставить заявку на индексацию конкретных страниц.

- Обеспечить надежность и скорость работы сайта – робот при обнаружении проблем на сайте снижает частоту обхода.

- Позаботиться о качественных внешних ссылках, которые добавят вам «веса» и повысят шансы на быструю индексацию сайта по ключевым словам.

- Регулярно добавлять новые страницы и публиковать свежие материалы – тогда поисковики будут чаще обращать внимание на ваш ресурс. Обязательно добавлять новые материалы в «Оригинальные тексты» в Яндекс.Вебмастере.

- Оптимизировать сайт в плане удобства для пользователей – юзабилити. В первую очередь, важны понятный каталог и система навигации, сеть перекрестных внутренних ссылок (перелинковка) – всё, что ускоряет перемещение бота по вашему сайту и помогает ему проиндексировать больше страниц за один раз.

Кстати, быстро индексировать страницы нужно не только новым сайтам. Если вы обновили цены или описания в каталоге, прописали привлекательные метатеги Description или загрузили в блог горячую новость, вам тоже важно, чтобы индексацию не пришлось ждать месяцами.

Как проверить индексацию сайта

В первые недели после запуска нового сайта важно проверить, попали ли нужные страницы в индекс поисковых систем и сколько вообще страниц проиндексировано. Но и в дальнейшем советуем держать руку на пульсе.

Вот основные способы проверить индексацию сайта в поисковых системах:

- Вручную через брендовые запросы

- Через оператор site в поисковой строке

- В Яндекс.Вебмастере или Search Console в Гугл

- Автоматически с помощью плагинов, скриптов или специальных сервисов

Вводим в строке поиска название компании и просматриваем первую пару страниц выдачи. Способ самый простой, без технических сложностей, но не быстрый и не очень удобный.

Чуть сложнее, но точнее: вбиваем в поиске Яндекса или Гугл оператор site, а после него – адрес сайта.

Например, наберем URL zamkitut.ru для проверки индексации сайта. В результатах поиска будут только проиндексированные страницы заданного сайта, и ничего не придется выбирать вручную.

Способ для тех, у кого есть доступ к панели вебмастера. В Гугл нужно открыть вкладку «Индекс Google» и выбрать «Статус индексирования», а в Яндекс.Вебмастере развернуть меню «Индексирование сайта», а затем «Страницы в поиске». Здесь можно посмотреть не только текущее количество страниц в индексе, но и динамику.

Сервисы и программы – быстрый и надежный способ проверить индексацию сайта онлайн. Не вручную вбивать запросы: небольшие программы для проверки обычно можно сохранить в браузере, как закладки, и запускать при необходимости.

Советуем попробовать плагин RDS bar для разных браузеров, а также программы наподобие Netpeak Spider или Netpeak Checker.

Так выглядит рабочее окно Netpeak Spider: программа выдает много дополнительной информации, помимо количества страниц в индексе.

3 и 4 способ – самые информативные и удобные, мы советуем мониторить индексацию по ходу продвижения сайта именно так. В специальной программе или на панели вебмастера вы увидите, когда последний раз Яндекс индексировал сайт, какие именно страницы попали в индекс, какие проблемы выявили поисковики и т.д.

Почему сайт не индексируется и как это исправить

Иногда с индексацией возникают проблемы: сайт целиком или отдельные страницы перестают выводиться в поисковой выдаче. Почему Яндекс не индексирует сайт и как это исправить:

- Прошло недостаточно времени. Если сайт или группа страниц появились недавно, поисковой робот мог просто не успеть их проиндексировать – используйте наши приемы ускорения из списка выше.

- Неправильно заполнен файл robots.txt. Лучше доверить работу с этим служебным файлом программистам, потому что случайная ошибка в нем может запретить индексировать сайт без вашего ведома.

- Критичные для поисковиков ошибки на сайте – их важно находить и вовремя исправлять.

- Нет карты сайта (SiteMap). Обязательно пропишите ее и добавьте в корневую папку – карта поможет ускорить индексацию сайта.

- На сайте есть дубли страниц или контент, полностью скопированный с других ресурсов – такие страницы принципиально не индексируются.

- Сервер работает с перебоями. Если сайт периодически недоступен или загружается слишком медленно, могут быть проблемы с индексацией, так что есть смысл переехать на более надежный хостинг.

Как закрыть сайт от индексации и когда это нужно

Иногда бывает нужно запретить индексацию сайта или отдельных страниц.

Зачем это делается:

- Чтобы в выдачу не попадали служебные страницы сайта: личный кабинет пользователя, корзина, панель управления и прочее.

- Чтобы поисковой робот быстрее добрался до целевых страниц и проиндексировал их, а не тратил время на малозначительный контент, который не нужно продвигать.

- Чтобы в индекс не попали дубли страниц (поисковики это не любят).

Пример страницы, которую нужно закрыть от индексации – корзина в интернет-магазине дверной фурнитуры.

Основные способы «спрятать» ненужные страницы или разделы от поисковиков:

- В файле robots.txt закрыть сайт от индексации позволяет директива Disallow – она прописывается рядом с адресами страниц, которые не должны попасть в выдачу.

- В коде страницы можно использовать тег «noindex» – он закрывает от индексации не ссылки, а только часть текста, заключенную внутри тега.

- Атрибут rel=«nofollow» – применяется к конкретной ссылке и указывает поисковым роботам, что по ней не нужно переходить. Этот атрибут понимают все поисковики.

- Мета-тег robots – он дает поисковым системам указания насчет индексации. Если в содержимом этого мета-тега прописать «noindex, nofollow», страница не будет индексироваться.

Важно: «noindex» считывает и понимает только Яндекс. Для управления индексацией в Google применяйте другие способы из этого списка.

Индексация страниц и сайта в Яндексе и Google

Индекс поисковой системы — база данных, которая хранит информацию о веб-документах. Назначение этого «хранилища» очевидно — используя базу данных, поисковик может быстро и точно вычислять значения факторов ранжирования, численное значение релевантности URL по запросу пользователя и формировать результаты выдачи.

Для SEO-специалистов и владельцев сайтов это означает одно — какое количество страниц проиндексировано, такое количество документов и может быть найдено в результатах выдачи по целевым запросам и столько же URL может привлекать трафик.

Как быстро проверить индексацию в Яндексе и Google?

Способов и сервисов массовой проверки индексации страниц достаточно много и у нас есть три инструмента, которые определяют количество документов в индексе по домену:

Просто укажите домен в любом из них. Инструмент поможет проверить сайт и обозначит количество проиндексированных страниц в базе данных Google и Яндекс, с учётом поддоменов или без них:

Инструмент поможет проверить сайт и обозначит количество проиндексированных страниц в базе данных Google и Яндекс, с учётом поддоменов или без них:

Если данные нескольких проверок разнятся, обратите внимание на историю индексации сайта в панелях Яндекс.Вебмастера и Google Search Console. Данные в них являются наиболее достоверными, так как результаты выдачи поисковых систем с использованием операторов с течением времени могут немного отличаться.

Поисковые операторы для проверки индексации

Узнать индексацию сайта можно, используя операторы поиска. Для Яндекса это операторы «site:», «host:» и «url:».

Для Google — «site:», «inurl:» и «info:».

В обеих поисковых системах указываются приблизительные результаты, но можно использовать дополнительные параметры, чтобы узнать, сколько страниц было проиндексировано, например, за неделю:

Для того, чтобы проверить индексацию определённой страницы сайта используйте оператор «url:» для Яндекса и «info:» для Google.

Вебмастер и Search Console

Если вы уже добавили свой сайт в панель Яндекс.Вебмастер и/или Google Search Console, то можете детально отслеживать статус сканирования и индексирования документов.

В Вебмастере переходим на вкладку «индексирование» — «страницы в поиске». Здесь расположилась статистика по добавленным и удалённым из поиска документам. Также можно посмотреть историю изменений для всего сайта за определённый интервал дат:

Проверить индексацию сайта в Google можно с помощью Search Console. В новой версии консоли переходим на вкладку «статус» — «индексирование отправленных URL» и получаем картину изменений, ошибок, исключенных страниц и график показов:

Возможный контроль индексации

Важно понимать, что сканирование или обход страницы сайта не означает её попадание в индекс. Иногда необходимо запретить индексирование страниц, которые не нужны в поиске, например: URL с техническими GET-параметрами, служебные или пользовательские документы (корзина, личный кабинет и прочие), документы с UTM-метками. Поэтому каждому сайту желательно иметь:

Поэтому каждому сайту желательно иметь:

-

Sitemap.xml — файл, который помогает поисковым роботам сканировать сайт, с учётом заданных приоритетов.

-

Robots.txt — файл, задающий правила и параметры обхода для всех роботов поисковых систем или индивидуально для каждой:

-

С помощью команды Disallow можно запрещать индексирование отдельных URL или разделов сайта.

-

Crawl delay — задаёт минимальное время обращения робота к серверу для избегания нагрузок на сайт.

-

Clean param — позволяет указать неважные для индексации CGI-параметры в URL-адресах, то есть различные идентификаторы пользователей, сессий и так далее. Используется только в Яндексе.

-

Открытые страницы должны быть в поиске, только тогда можно думать о ранжировании. Не забывайте проверять сайт на индексацию, отслеживайте изменения и удачных позиций в выдаче!

Задайте вопрос или оставьте комментарий

Другие вопросы нашего FAQ

Как проверить индексацию сайта в Google и Яндекс

Индексация сайта (поисковая индексация сайта) – сканирование сайта и добавление его в базу данных (индекс поисковых систем).

Это если совсем просто и коротко. А если подробнее?

Важно! Если вы хотите получать аудиторию из поисковых систем – сайт должен быть открытым для индексации.

Поисковые системы типа Яндекса и Google сканируют страницы сайтов, чтобы классифицировать их и добавить в Индекс – базу данных. Поисковые роботы – пауки или краулеры – собирают информацию о тексте, видео, изображениях и другом доступном для сканирования контенте. Робот проверяет его на соответствие требованиям, отсеивает спам и добавляет полезный контент в свою базу.

База данных поисковику нужна, чтобы выдавать пользователям верные результаты по запросам. Чем более релевантен сайт запросу, тем выше в списке результатов он находится, а значит и получает больше переходов.

В данной статье мы разберемся с самыми важными вопросами, связанными с индексацией сайта и страниц:

- Как узнать, проиндексирован ли сайт;

- Как проверить количество проиндексированных страниц сайта в поисковых системах Гугл и Яндекс;

- Как проверить индексацию страниц;

- Как ускорить индексацию сайта в Яндексе и Google;

- Какие поисковые операторы можно использовать;

- Как использовать robots.

txt и sitemap.xml для быстрой индексации страниц.

txt и sitemap.xml для быстрой индексации страниц.

Чтобы узнать подробно, как индексировать страницы или сайт и можно ли ускорить индексацию, пройдите бесплатные SEO курсы 2021 для начинающих от Сергея Кокшарова. Курс уже достуен в Академии Коллаборатора.

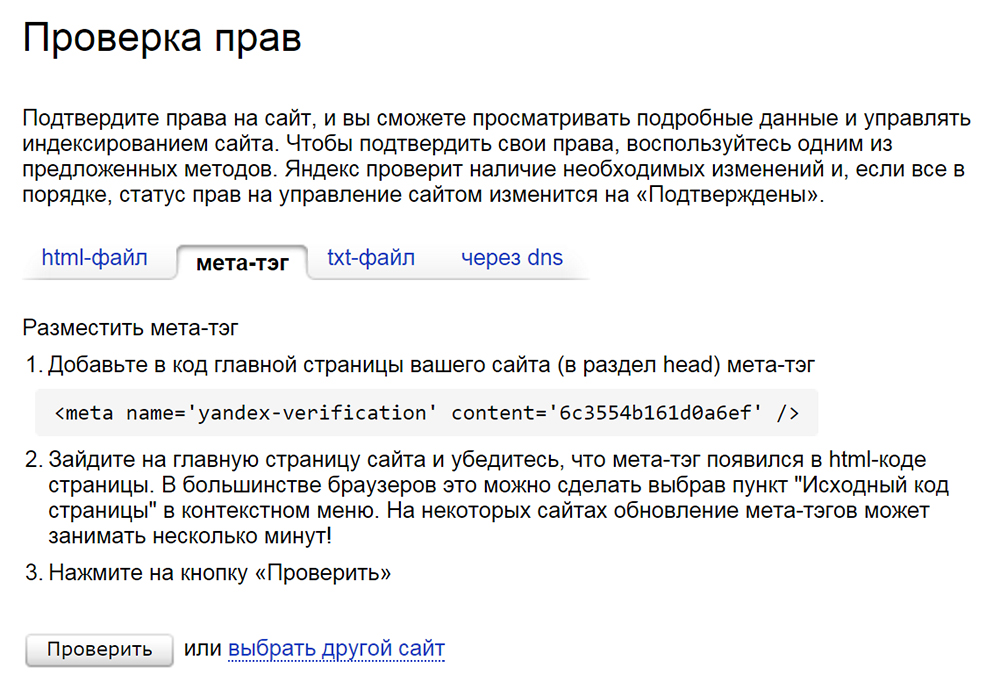

Чтобы проиндексировать сайт в Яндексе и Гугле, воспользуйтесь инструментами для вебмастеров: Яндекс.Вебмастером и Search Console. Поисковики индексируют сайты с разной скоростью. Например, Яндекс может «рассматривать» обычный сайт от недели до месяца, а вот Google сделает это максимум за неделю. Но чтобы не ждать, можно самому повлиять на скорость индексации.

Чтобы добавить сайт в Яндекс.Вебмастер:

- Войдите в свой аккаунт на Яндексе или зарегистрируйте новый.

- Перейдите на сервис Вебмастер и впишите в поле адрес главной страницы вашего сайта.

- Подтвердите, что вы владелец сайта. Сервис предложит вам добавить мета-тег в код страницы, либо другой способ подтверждения.

- Робот проверит наличие мета-тега, добавит сайт и покажет информацию о нем.

- Установите и привяжите к аккаунту Вебмастера Яндекс.Метрику, чтобы краулер использовал более точные данные.

После добавления сайта в панель вебмастера — ожидайте его индексации. Отслеживать статус индексации страниц вы можете в следующем отчете:

Проверка индексации страниц в Яндекс.Вебмастере

Чтобы добавить сайта в Google Search Console:

- Перейдите на страницу Search Console и войдите в свой аккаунт или зарегистрируйтесь.

- Добавьте сайт в систему.

- Подтвердите права на сайт.

Когда сайт проиндексируется, вы увидите отчет.

Проверка индексации страниц в Google

В основном пользователи рунета отдают предпочтение Google и Яндексу, но и несколько других поисковиков должны знать о вашем сайте, небольшие объемы трафика вы также можете получать оттуда.

Mail.![]() ru имеет свой кабинет для вебмастеров. Вы можете добавить туда сайт по тому же принципу.

ru имеет свой кабинет для вебмастеров. Вы можете добавить туда сайт по тому же принципу.

Рамблер пользуется теми же данными, которые собирает Яндекс, так что вам не понадобятся дополнительные настройки.

Yahoo и Bing имеют общий кабинет для вебмастеров, с тех пор как два поисковика объединились. Вам нужно зарегистрироваться, после чего перейти в настройки вебмастера и добавить адрес сайта. После откроется страница, где нужно добавить сведения о сайте. Пройдет несколько недель, прежде чем информация о сайте начнет отображаться.

- частоты обновления контента;

- внутренних и внешних ссылок;

- наличия трафика на сайт с других источников;

- технической оптимизации сайта;

- корректной настройки CMS системы.

Да, рано или поздно роботы сами найдут ваш сайт и проиндексируют его, но ждать можно долго. Помимо ручного добавления сайта в систему поиска, существуют другие рекомендации.

Как ускорить индексацию в поисковых системах:

Главная рекомендация для ускорения индексации: создайте sitemap.xml на вашем сайте и добавьте его в Google Search Console и в Яндекс.Вебмастер.

Файл robots.txt хранится в корневом каталоге сайта, он может быть только один. Это текстовый файл, в который записывают правила для каждого отдельного поискового бота или для всех сразу. Правилами можно «спрятать» от роботов технические страницы, сделать акцент на важных и т.д.

Проверить файл можно прямо в Search Console и Яндекс.Вебмастере.

У пауков ограниченное время на посещение сайта (краулинговый бюджет), и если дать ему обрабатывать все подряд страницы, то он может не успеть проиндексировать самые важные, «застряв» на технических.

Например, если у вас интернет-магазин, в robots.txt стоит закрыть от индексации внутренний поиск, корзины покупателей. Подробнее о работе с файлом можно прочесть в справке Google.

Sitemap.xml – карта сайта, куда нужно добавить все страницы, которые нужно проиндексировать. Карта поможет определить, где находятся страницы и частоту их обновления, приоритетность в структуре.

- Необходимо создать карту сайта.

- Указать в карте сайту правила индексации страниц: дату обновления страниц, приоритет страниц и другие параметры.

- Добачить карту сайта в панели для вебмастеров Google Search Console и Яндекс.Вебмастер.

Файл обычно располагается по адресу https://domain.com/sitemap.xml.

Карта сайта выглядит примерно вот так:

В файле используются специальные теги XML:

- <url></url> – обозначает начало и конец блока страницы;

- <code></loc> – указывает адрес страницы;

- <lastmod></lastmod> – указывает дату последнего обновления страницы;

- <code><priority> – указывает приоритет страницы;

- <changefreq></changefreq> – указывает частоту обновления страницы с помощью:

- never – никогда;

- yearly – раз в год;

- monthly – каждый месяц;

- weekly – каждую неделю;

- daily – каждый день;

- hourly – каждый час.

Для больших сайтов имеет смысл создать несколько карт.

Внутренняя перелинковка – это ссылки на другие страницы вашего сайта. С ее помощью вы формируете структуру, которая помогает пользователям ориентироваться на сайте.

Внтрення перелинковка ускоряет индексацию страниц, так как роботы сами проходят по ссылкам и проверяют их. Роботы сканируют сначала главную страницу и материалы с высокой приоритетностью. Грамотная перелинковка направит роботов на нужные страницы и значительно ускорит индексацию новых материалов.

Главные рекомендации по перелинковке:

- Не делайте страницы с глубоким уровнем вложенности; идеальный вариант, это чтобы к любой странице сайта можно было добраться в 3 клика с главной страницы.

- Используйте принцип “Википедии” – активно ставьте ссылки внутри статей и других страниц.

- Избегайте одиноких страниц, на которые не ссылаются другие страницы.

Если кто-то ссылается на ваш сайт, значит ему доверяют. Чем больше внешних ссылок (бэклинков) на ваш сайт, тем больше вероятность получить внимание поискового бота. О том, как покупать ссылки для продвижения сайта, мы писали ранее. А если вы только разбираетесь в основах линкбилдинга, советуем почитать статью и посмотреть видео-урок, что такое линкбилдинг.

Чаще остальных ресурсов боты сканируют соцсети и новостные порталы, ведь они обновляются чуть ли не каждую секунду. Ссылки с них на ваш сайт сработают лучше всего.

Сайты с самой высокой скоростью сканирования ссылок:

- Twitter,

- Facebook,

- Вконтакте.

Яндекс больше любит связку ВК + Twitter. Попробуйте также размещать ссылки на тематических форумах. Чем больше пользователи будут взаимодействовать с постом со ссылкой и самой ссылкой, тем быстрее краулеры обратят на нее внимание.

Постоянно следите за тем, какие появляются внешние ссылки. Узнайте, как проверить обратные ссылки на сайт, как посмотреть внешние ссылки конкурента, какие есть бесплатные и платные сервисы.

Есть несколько способов проверить, как проверить индексацию сайта или отдельной страницы в поисковых системах.

С помощью поисковых операторов можно проверить индексацию сайта, количество страниц в индексе, индексацию отдельной страницы. С помощью поисковых операторов можно проверить количество проиндексированных страниц любого сайта, что очень важно при анализе сайтов конкурентов.

1. site: — оператор для проверки индексации сайта в поисковых системах Яндекс или Google. Введите в строку поиска текст «site:[адрес вашего сайта]«, чтобы узнать количество индексируемых страниц.

Количество проиндексированных страниц в Google

Количество проиндексированных страниц в Яндексе

Обратите внимание! Если количество проиндексированных страниц в поисковых системах Гугл и Яндекс сильно отличается, это может говорить о проблемах на сайте, о санкциях поисковых систем.

2. ulr: — оператор для проверки индексации страницы в поисковой системе Яндекс. Введите в строку поиска «ulr:[адрес проверяемой страницы]«, чтобы узнать, проиндексирована ли страница.

Проверяем индексацию страницы в Яндексе

3. inulr: — оператор для проверки индексации страницы в поисковой системе Google. Введите в строку поиска «inulr:[адрес проверяемой страницы]«, чтобы узнать, проиндексирована ли эта страница.

Многие SEO-специалисты пользуются плагинами и расширениями для проверки индексации, например RDS Bar. Его можно установить как расширение в браузер и проверить, открыта ли конкретная страница для индексации. Также RDS Bar позволяет проверить метатеги сайта, ИКС, узнать, нет ли запрета на индексацию текста или ссылок на странице, узнать другие важные параметры сайта или отдельных страниц.

На скриншоте — плагин RDS bar для Google Chrome

Второй популярный плагин — Seo Magic — также показывает количество страниц в индексе Яндекса и Google. При нажатии на интересующую цифру открывается выдача поисковой системы.

Также популярны автоматические сервисы, которые массово собирают данные об индексации, такие как Netpeak Spider . Он может просканировать весь сайт, собрать все страницы. А Netpeak Checker выдаст сведения об индексации, информацию об ошибках и порекомендует, как от них избавиться. Софтина платная.

Бесплатный сервис PR-CY проверит, сколько страниц проиндексировано в посиковых системах Гугл и Яндекс.

Проверить индексацию страниц можно и в панелях вебмастеров Google и Яндекс.

Вы можете проверить:

- количество проиндексированных страниц;

- динику индексации страниц поисковыми страницами;

- страницы, которые исключены из поиска;

- причины, почему страницы исключены из поиска.

Для Google зайдите в Search Console и на вкладке «Обзор» выберете график «Покрытие». График отображает разными цветами количество страниц без ошибок, с ошибками. Можно рассмотреть, какие ошибки мешают индексации. Новую страницу или исправленную можно отправить на индексацию кнопкой «Запросить индексирование».

В Яндекс.Вебмастер переходите на «Индексирование сайта», затем на «Страницы в поиске», где вы увидите количество страниц в поиске.

Сайт или отдельные страницы могут не индексироваться поисковыми системами по ряду причин.

1. Поисковик еще не знает о сайте или странице. Прошло мало времени с момента появления страницы. Стоит подождать минимум две недели, чтобы сайт проиндексировался. Если сайт редко обновляется и на него нет внешних ссылок, поисковой бот просто не сможет узнать о нем.

2. Некоторые разделы закрыты для пауков. Это может происходить по желанию владельца сайта через robots.txt. Также возможно ваш сайт находится в черном списке – он может быть под санкциями или распространять вирусы.

3. Техническая ошибка на странице или сайте. Возможные ошибки:

- некорректные HTTP-заголовки;

- некорректные редиректы;

- неверно указанная кодировка, которую робот увидит как набор бессмысленных символов;

- ошибки сканирования, на которые указывают сами поисковики в панелях для вебмастеров;

- отсутствие или некорректная настройка sitemap.xml.

4. Плохое качество документов. Неуникальный контент, внутренние дубли, малый объем уникального текста, шаблонность в документах раздела, медленная скорость загрузки.

Чтобы проиндексировать новую страницу сайта или отправить на переиндексацию страницу, которую вы изменили, воспользуйтесь инструментами вебмастера Search Console и Яндекс.Вебмастер.

1. В Google Search Console перейдите в раздел «Проверка URL».

2. Введите страницу, которую нужно проверить и отправить на переиндексацию.

3. Нажимайте на кнопку «Запросить индексирование».

Данный инструмент также подходит для проверки индексации страниц своего сайта.

1. В Яндекс.Вебмастере перейдите в раздел Индексация -> Переобзод страниц

2. Добавите страницу, которую нужно проиндексировать.

3. Нажмите кнопку «Отправить».

Дневной лимит — 210 страниц (вкючая поддомены и поддомены).

Через файл robots.txt можно запретить индексацию страниц или всего сайта для конкретного поисковика или для всех сразу, используя директиву Disallow:

Если хотите закрыть конкретные разделы, укажите их:

Disallow: /news

Иногда Google игнорирует такой запрет, проверьте это через кабинет вебмастера. Если страницы все еще индексируются, переходите к следующему способу.

С помощью метатега Robots можно не дать роботам просканировать контент и закрыть текст от индексации. Для этого нужно в раздел <head> страницы добавить строку:

<noindex>[текст]</noindex>

Закрыть всю страницу от индексации можно, добавив строку

<meta name="robots" content="none"/>

Перед закрытием сайта от индексации желательно проверить методы в панелях вебмастеров.

Если вы понимаете принцип индексации и для чего она нужна, вы легко сможете правильно настроить сайт для поисковиков. Корректно настройте в robots.txt и карту сайта, избавьтесь от технических ошибок и позаботьтесь о качественном контенте, чтобы поисковики высоко ценили ваш сайт.

Остались вопросы? Задавайте их в комментариях😀

Как работают поисковые системы: сканирование, индексирование и ранжирование | Руководство для начинающих по SEO

Чтобы определить релевантность, поисковые системы используют алгоритмы, процесс или формулу, с помощью которых хранимая информация извлекается и упорядочивается значимым образом. За прошедшие годы эти алгоритмы претерпели множество изменений, чтобы улучшить качество результатов поиска. Google, например, вносит корректировки в алгоритм каждый день — некоторые из этих обновлений представляют собой незначительные улучшения качества, тогда как другие представляют собой основные / широкие обновления алгоритма, развернутые для решения конкретной проблемы, например Penguin для борьбы со ссылочным спамом.Ознакомьтесь с нашей историей изменений алгоритмов Google, чтобы увидеть список подтвержденных и неподтвержденных обновлений Google, начиная с 2000 года.

Почему алгоритм меняется так часто? Google просто пытается держать нас в тонусе? Хотя Google не всегда раскрывает подробности того, почему они делают то, что они делают, мы знаем, что цель Google при корректировке алгоритмов — улучшить общее качество поиска. Вот почему в ответ на вопросы об обновлении алгоритма Google ответит примерно так: «Мы постоянно обновляем качественные обновления.»Это означает, что если ваш сайт пострадал после корректировки алгоритма, сравните его с Рекомендациями по качеству Google или Рекомендациями по оценке качества поиска, оба очень красноречивы с точки зрения того, чего хотят поисковые системы.

Чего хотят поисковые системы?

Поисковые системы всегда хотели одного и того же: давать полезные ответы на вопросы поисковика в наиболее полезных форматах. Если это правда, то почему кажется, что поисковая оптимизация сейчас отличается от прошлых лет?

Подумайте об этом с точки зрения того, кто изучает новый язык.

Поначалу их понимание языка очень элементарное — «См. Spot Run». Со временем их понимание начинает углубляться, и они изучают семантику — значение языка и взаимосвязь между словами и фразами. В конце концов, при достаточной практике ученик знает язык достаточно хорошо, чтобы понимать нюансы, и может дать ответы даже на расплывчатые или неполные вопросы.

Когда поисковые системы только начинали изучать наш язык, было намного проще обмануть систему, используя уловки и тактики, которые на самом деле противоречили рекомендациям по обеспечению качества.Возьмем, к примеру, наполнение ключевыми словами. Если вы хотите ранжироваться по определенному ключевому слову, например «смешные анекдоты», вы можете несколько раз добавить на свою страницу слова «смешные анекдоты» и сделать его жирным в надежде повысить свой рейтинг по этому запросу:

Добро пожаловать до анекдотов ! Рассказываем самых смешных анекдотов в мире. Веселые анекдоты, , Веселые, , сумасшедшие. Ваш смешной анекдот ждет. Устройтесь поудобнее и прочитайте смешных анекдотов , потому что смешных анекдотов могут вас порадовать, а смешнее .Несколько смешных любимых смешных анекдотов .

Эта тактика создавала ужасный пользовательский опыт, и вместо того, чтобы смеяться над забавными шутками, людей засыпали раздражающим, трудно читаемым текстом. Возможно, это сработало в прошлом, но поисковые системы никогда этого не хотели.

Поисковые операторы Google [2021 SEO]

Что такое поисковые операторы Google?

Операторы поиска Google — это специальные символы и команды (иногда называемые «расширенными операторами»), которые расширяют возможности обычного текстового поиска.Операторы поиска могут быть полезны во всем, от исследования контента до технического аудита SEO.

Как пользоваться операторами поиска?

Вы можете вводить операторы поиска непосредственно в поле поиска Google, как если бы вы вводили текстовый поиск:

За исключением особых случаев (таких как оператор «in»), Google будет возвращать стандартные обычные результаты.

Шпаргалка по операторам поиска Google

Ниже вы можете найти все основные операторы обычного поиска, разбитые на три категории: «Базовый», «Расширенный» и «Ненадежный».Основные операторы поиска — это операторы, изменяющие стандартный текстовый поиск.

| I. Основные операторы поиска | |

|---|---|

| «» | «никола тесла» Поместите любую фразу в кавычки, чтобы Google использовал точное соответствие. На отдельных словах всякие синонимы. |

| OR | tesla OR edison Поиск Google по умолчанию использует логическое И между терминами. Укажите «ИЛИ» для логического ИЛИ (ЗАГЛАВНЫМИ БУКВАМИ). |

| | | тесла | edison Оператор вертикальной черты (|) идентичен оператору «ИЛИ».Полезно, если ваш Caps-Lock сломан 🙂 |

| () | (тесла ИЛИ Эдисон) переменный ток Используйте круглые скобки для группировки операторов и управления порядком их выполнения. |

| — | tesla -motors Поставьте минус (-) перед любым термином (включая операторы), чтобы исключить этот термин из результатов. |

| * | tesla «рок * ролл» Звездочка (*) действует как подстановочный знак и соответствует любому слову. |

| # .. # | Тесла анонс 2015..2017 Используйте (..) с числами с обеих сторон, чтобы соответствовать любому целому числу в этом диапазоне чисел. |

| $ | tesla deposit $ 1000 Искать цены со знаком доллара ($). Вы можете комбинировать ($) и (.) Для получения точных цен, например, 19,99 долларов США. |

| € | 9,99 € обеды Найдите цены со знаком евро (€). Похоже, что большинство других знаков валюты не соблюдаются Google. |

| дюйм | 250 км / ч миль / час Используйте «in» для преобразования между двумя эквивалентными единицами. Это возвращает специальный результат в стиле карты знаний. |

Операторы расширенного поиска — это специальные команды, которые изменяют поиск и могут требовать дополнительных параметров (например, доменного имени). Расширенные операторы обычно используются для сужения поиска и более детального изучения результатов.

Было обнаружено, что ненадежные операторы дают непоследовательные результаты или вообще не рекомендуются к использованию.Оператор «link:» официально устарел в начале 2017 года. Похоже, что операторы «inanchor:» все еще используются, но возвращают очень узкие и иногда ненадежные результаты. Используйте операторы на основе ссылок только для начального исследования.

Обратите внимание, что для всех операторов «allin …:» Google будет пытаться применять оператор к каждому последующему термину. Комбинирование операторов allin …: с любыми другими операторами почти никогда не даст желаемых результатов.

Советы и приемы поискового оператора

Наличие всех частей — это только первый шаг в построении головоломки.Настоящая сила поисковых операторов заключается в их объединении.

1. Объедините комбинации операторов в цепочку

Вы можете объединить в цепочку практически любую комбинацию текстового поиска, базовых операторов и расширенных операторов:

"nikola tesla" intitle: "топ 5..10 фактов" - сайт: youtube.com inurl: 2015

Этот поиск возвращает все страницы, на которых упоминается «Никола Тесла» (точное соответствие), в заголовке есть фраза «Основные (X) факты», где X варьируется от 5 до 10, не на YouTube.com , и где-нибудь в URL-адресе стоит «2015».

2. Выявить плагиат контента

Пытаетесь выяснить, является ли ваш контент уникальным или кто-то вас плагиат? Используйте уникальную фразу из своего текста, заключите ее в кавычки (точное соответствие) после оператора «intext:» и исключите свой сайт с помощью «-site:» …

intext: "они резвились у нас в недрах "-site: moz.com

Точно так же вы можете использовать» intitle: «с длинной фразой с точным соответствием, чтобы найти повторяющиеся копии вашего контента.

3. Аудит перехода HTTP-> HTTPS

Переключение сайта с HTTP на HTTPS может оказаться сложной задачей.Дважды проверьте свой прогресс, посмотрев, сколько страниц каждого типа проиндексировал Google. Используйте оператор «site:» в корневом домене, а затем исключите страницы HTTPS с помощью «-inurl:» …

site: moz.com -inurl: https

Это поможет вам отследить всех отставших или найти страницы, которые возможно, не было повторно просканировано Google.

Это всего лишь несколько примеров почти бесконечного набора комбинаций. Ищете другие примеры? Тебе повезло! Мы создали мега-список из 67 примеров, чтобы подтолкнуть вас к мастерству оператора сайта.

Исследование ключевых слов — Руководство по поисковой оптимизации для новичков

Глава 3

Поймите, что ваша аудитория хочет найти.

Теперь, когда вы узнали, как отображаться в результатах поиска, давайте определим, на какие стратегические ключевые слова следует ориентироваться в содержании вашего веб-сайта и как подобрать этот контент, чтобы удовлетворить как пользователей, так и поисковые системы.

Сила исследования ключевых слов заключается в лучшем понимании вашего целевого рынка и того, как они ищут ваш контент, услуги или продукты.

Исследование ключевых слов предоставляет вам конкретные поисковые данные, которые могут помочь вам ответить на такие вопросы, как:

- Что ищут люди?

- Сколько людей это ищут?

- В каком формате они хотят эту информацию?

В этой главе вы получите инструменты и стратегии для раскрытия этой информации, а также изучите тактику, которая поможет вам избежать недостатков исследования ключевых слов и создать надежный контент. Как только вы узнаете, как ваша целевая аудитория ищет ваш контент, вы начнете открывать для себя совершенно новый мир стратегического SEO!

Перед исследованием ключевых слов задайте вопросы.

Прежде чем вы сможете помочь бизнесу расти с помощью поисковой оптимизации, вы сначала должны понять, кто они, кто их клиенты и их цели.

Здесь часто срезают углы. Слишком много людей обходят этот важный этап планирования, потому что исследование ключевых слов требует времени, и зачем тратить его, если вы уже знаете, по какому критерию вы хотите получить рейтинг?

Ответ заключается в том, что то, за что вы хотите ранжироваться, и то, чего на самом деле хочет ваша аудитория, часто являются двумя совершенно разными вещами. Сосредоточение внимания на своей аудитории и последующее использование данных по ключевым словам для уточнения этой информации приведет к гораздо более успешным кампаниям, чем сосредоточение внимания на произвольных ключевых словах.

Вот пример. Frankie & Jo’s (расположенный в Сиэтле веганский магазин мороженого без глютена) слышал о поисковой оптимизации и хочет помочь улучшить то, как и как часто они появляются в обычных результатах поиска. Чтобы помочь им, вам нужно сначала немного больше узнать об их клиентах. Для этого вы можете задать такие вопросы, как:

- Какие виды мороженого, десертов, закусок и т. Д. Ищут люди?

- Кто ищет эти термины?

- Когда люди ищут мороженое, закуски, десерты и т. Д.?

- Есть ли сезонные тенденции в течение года?

- Как люди ищут мороженое?

- Какие слова они используют?

- Какие вопросы они задают?

- Выполняется ли больше поисковых запросов на мобильных устройствах?

- Почему люди ищут мороженое?

- Люди ищут мороженое, заботящееся о своем здоровье, или просто хотят удовлетворить пристрастие к сладкому?

- Где находятся потенциальные клиенты — на местном, национальном или международном уровне?

И наконец — вот что интересно — как вы можете помочь предоставить лучший контент о мороженом, чтобы развивать сообщество и выполнять то, что ищут все эти люди? Задание этих вопросов — важный шаг в планировании, который будет направлять ваши исследования ключевых слов и поможет вам создавать лучший контент.

Файл Robots.txt [Примеры 2021] — Moz

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который веб-мастера создают, чтобы проинструктировать веб-роботов (обычно роботов поисковых систем), как сканировать страницы на их веб-сайтах. Файл robots.txt является частью протокола исключения роботов (REP), группы веб-стандартов, которые регулируют, как роботы сканируют Интернет, получают доступ и индексируют контент, а также предоставляют этот контент пользователям. REP также включает в себя такие директивы, как мета-роботы, а также инструкции для страницы, подкаталога или сайта о том, как поисковые системы должны обрабатывать ссылки (например, «следовать» или «nofollow»).

На практике файлы robots.txt показывают, могут ли определенные пользовательские агенты (программное обеспечение для веб-сканирования) сканировать части веб-сайта. Эти инструкции сканирования определяются как «запрещающие» или «разрешающие» поведение определенных (или всех) пользовательских агентов.

Базовый формат:User-agent: [user-agent name] Disallow: [URL-строка не должна сканироваться]

Вместе эти две строки считаются полным файлом robots.txt, хотя один файл robots может содержат несколько строк пользовательских агентов и директив (т.е., запрещает, разрешает, задержки сканирования и т. д.).

В файле robots.txt каждый набор директив пользовательского агента отображается как дискретный набор , разделенных разрывом строки:

В файле robots.txt с несколькими директивами пользовательского агента, каждая из которых запрещает или разрешает правило только применяется к агентам-пользователям, указанным в этом конкретном наборе, разделенном разрывом строки. Если файл содержит правило, которое применяется более чем к одному пользовательскому агенту, поисковый робот только обратит внимание (и будет следовать директивам в) самой конкретной группы инструкций .

Вот пример:

Msnbot, discobot и Slurp вызываются специально, поэтому эти пользовательские агенты только обратят внимание на директивы в своих разделах файла robots.txt. Все остальные пользовательские агенты будут следовать директивам в группе user-agent: *.

Пример robots.txt:

Вот несколько примеров использования robots.txt для сайта www.example.com:

URL файла Robots.txt: www.example.com/robots.txt Блокирование доступа всех поисковых роботов к содержимомуUser-agent: * Disallow: /

Использование этого синтаксиса в файле robots.txt укажет всем поисковым роботам не сканировать никакие страницы www.example .com, включая домашнюю страницу.

Разрешить всем поисковым роботам доступ ко всему контентуUser-agent: * Disallow:

Использование этого синтаксиса в файле robots.txt указывает поисковым роботам сканировать все страницы на www.example.com, включая домашнюю страницу.

Блокировка определенного поискового робота из определенной папкиUser-agent: Googlebot Disallow: / example-subfolder /

Этот синтаксис предписывает только поисковому роботу Google (имя агента пользователя Googlebot) не сканировать страницы, которые содержать строку URL www.example.com/example-subfolder/.

Блокировка определенного поискового робота с определенной веб-страницыПользовательский агент: Bingbot Disallow: /example-subfolder/blocked-page.html

Этот синтаксис сообщает только поисковому роботу Bing (имя агента пользователя Bing) избегать сканирование конкретной страницы www.example.com/example-subfolder/blocked-page.html.

Как работает robots.txt?

Поисковые системы выполняют две основные задачи:

- Сканирование Интернета для обнаружения контента;

- Индексирование этого контента, чтобы его могли обслуживать искатели, ищущие информацию.

Чтобы сканировать сайты, поисковые системы переходят по ссылкам с одного сайта на другой — в конечном итоге просматривая многие миллиарды ссылок и веб-сайтов. Такое ползание иногда называют «пауками».”

После перехода на веб-сайт, но перед его сканированием поисковый робот будет искать файл robots.txt. Если он найдет его, сканер сначала прочитает этот файл, прежде чем продолжить просмотр страницы. Поскольку файл robots.txt содержит информацию о том, как должна сканировать поисковая система, найденная там информация будет указывать на дальнейшие действия сканера на этом конкретном сайте. Если файл robots.txt содержит , а не директивы, запрещающие действия пользовательского агента (или если на сайте нет файла robots.txt), он продолжит сканирование другой информации на сайте.

Другой быстрый файл robots.txt, который необходимо знать:

(более подробно обсуждается ниже)

Чтобы его можно было найти, файл robots.txt должен быть помещен в каталог верхнего уровня веб-сайта.

Robots.txt чувствителен к регистру: файл должен иметь имя «robots.txt» (не Robots.txt, robots.TXT и т. Д.).

Некоторые пользовательские агенты (роботы) могут игнорировать ваших роботов.txt файл. Это особенно характерно для более гнусных поисковых роботов, таких как вредоносные роботы или парсеры электронных адресов.

Файл /robots.txt является общедоступным: просто добавьте /robots.txt в конец любого корневого домена, чтобы увидеть директивы этого веб-сайта (если на этом сайте есть файл robots.txt!). Это означает, что любой может видеть, какие страницы вы хотите или не хотите сканировать, поэтому не используйте их для сокрытия личной информации пользователя.