Почему я выбрал Joomla!Как я и обещал ранее в посте про проблемы выбора для начинающего веб-мастера, излагаю вам свои мысли на тему выбора CMS для сайта, а именно причины, которые легли в основу моего выбора Joomla! как системы управления для моих сайтов. Тут косметика для детей

Проблема выбора системы управления сайтом или по другому говоря CMS (СМС) возникает всегда, когда обычный человек, вроде меня или вас, не владеющий всеми знаниями и умениями в верстке, html, ccs и тому подобном, решает создать сайт в интернете. Какие возможности есть у начинающего вебмастера? Ответ на этот вопрос можно дать лишь зная, что же действительно хочется пользователю при создании сайта, какого типа сайт он хочет создать: блог, сайт, портал, форум или социальную сеть…

Он летит всех подряд подрезая на своем маршрутном такси

Давно не писал новостей, и вот первый раз решил написать не по теме сайта, ну в смысле не объясняя что-то про создание и раскрутку сайта для новичков.

А музой моего сегодняшнего поста стала песня, песня о маршрутном такси, или как обычно говорят — маршрутка. Эту песня я уже слышал ранее по радио, но сегодня то ли день такой — хороший теплый, ляпота, то ли припев: Извини, но работа такая Чтобы денег домой принести Он летит, всех подряд подрезая На своем маршрутном такси как-то по особому вставил, но придя домой, я решил узнать что же это за маршрутное такси такое, кто поет и даже списал слова песни

В этой статье я буду говорить о своем опыте размещения в русских социальных закладках. Как я уже писал в прошлой раз, русские сервисы социальных закладок любят баловаться тегами noindex и nofollow невилируя ваши усилия процесса размещения ссылок в этих сервисах. Порыскав в интернете для того, чтобы уменьшить свои усилия и повысить результативность, я наткнулся на

Как проводить профилактику и лечение, включая прививку от фильтра АГС-17На самом деле все действия относительно профилактики заражения сайта фильтром АГС-17 являются общеизвестными, но тем не менее хочется еще раз обратить на них ваше внимание. 1. Контент вашего сайта должен быть уникальным, грамотно написанным и осмысленным. Очень желательно, чтобы содержимое сайта привлекало какое-то количество, пусть даже совсем-совсем небольшое, «естественных» посетителей. Если это не так, то ваш сайт вызовет сомнения в качестве своего контента. 2. Внутренняя перелинковка не должна быть чрезмерной. Будет очень плохо, если АГС-17 обнаружит 10-ти ли 20-ти кратное размножение реальных страниц или несколько сотен ссылок с главной страницы на внутренние. В общем, не размножайте чрезмерно ваши страницы.

|

Как закрыть сайт от индексации в robots.txt, через htaccess и мета-теги

Привет уважаемые читатели seoslim.ru! Некоторые пользователи интернета удивляются, какими же быстродействующими должны быть компьютеры Яндекса, чтобы в несколько секунд просмотреть все сайты в глобальной сети и найти ответ на вопрос?

Но на самом деле за пару секунд изучить все данные WWW не способна ни одна современная, даже самая мощная вычислительная машина.

Содержание:

Как поисковые системы индексируют сайты

Как поставить запрет на индексацию с помощью:

— robots.txt

— htaccess

— админ панели WordPress

— метатегов

Давайте сегодня пополним наши знания о всемирной сети и разберемся, как поисковые машины ищут и находят ответы на вопросы пользователей и каким образом можно им запретить это делать.

Что такое индексация сайта

Опубликованный на страницах сайтов контент собирается заранее и хранится в базе данных поисковой системы.

Называется эта база данных Индексом (Index), а собственно процесс сбора информации в сети с занесением в базу ПС называется «индексацией».

Продвинутые пользователи мгновенно сообразят, получается, что если текст на странице сайта не занесен в Индекс поисковика, так эта информация не может быть найдена и контент не станет доступен людям?

Так оно и есть. Каждый день тысячи веб-мастеров публикуют на своих площадках новые статьи. Однако доступными для поиска эти новые публикации становятся далеко не сразу.

Однако доступными для поиска эти новые публикации становятся далеко не сразу.

Это полезно знать: Какую роль в работе сайта играют DNS-сервера

В плане индексации Google работает несколько быстрее нашего Яндекса.

- Публикация на сайте станет доступна в поиске Гугл через несколько часов. Иногда индексация происходит буквально в считанные минуты.

- В Яндексе процесс сбора информации относительно нового контента в интернете происходит значительно медленнее. Иногда новая публикация на сайте или блоге появляется в Яндексе через две недели.

Чтобы ускорить появление вновь опубликованного контента, администраторы сайтов могут вручную добавить URL новых страниц в инструментах Яндекса для веб-мастеров. Однако и это не гарантирует, что новая статья немедленно появится в интернете.

С другой стороны, бывают ситуации, когда веб-страница или отдельная часть контента уже опубликованы на сайте, но вот показывать этот контент пользователям нежелательно по каким-либо причинам.

- Страница еще не полностью доработана, и владелец сайта не хочет показывать людям недоделанный продукт, поскольку это производит негативное впечатление на потенциальных клиентов.

- Существует разновидностей технического контента, который не предназначен для широкой публики. Определенная информация обязательно должна быть на сайте, но вот видеть ее обычным людям пользователям не нужно.

- В статьях размещаются ссылки и цитаты, которые необходимы с информационной точки зрения, но вот находиться в базе данных поисковой системы они не должны. Например, эти ссылки выглядят как неестественные и за их публикацию в проект может быть подвергнут штрафным санкциям.

В общем, причин, почему веб-мастеру не хотелось бы, чтобы целые веб-страницы или отдельные блоки контента, ссылки не были занесены в базы поисковиков, может существовать много.

Давайте разберемся, как задачу управления индексацией решить практически.

Как скрыть сайт от индексации поисковыми системами

Сбором информации в интернете и занесением его в базу данных поисковой системы занимаются автоматические программы, называемые роботами-индикаторами. Веб-мастера часто называют этих роботов сокращенно «ботами».

Веб-мастера часто называют этих роботов сокращенно «ботами».

Слово «боты» вы могли уже встречать в различных мессенджерах. В этих системах быстрой коммуникации боты тоже являются компьютерными программами, выполняющими определенные функции или задачи.

Так вот, для того, чтобы роботы-индексаторы не занесли определенные веб-страницы или контент в Index поисковика, следует сформировать специальные команды, которые указывают ботам, что некоторые страницы на сайте посещать запрещено, а некоторый контент не следует заносить в поисковые базы.

Настроить команды запрета индексации можно несколькими способами, которые мы и рассмотрим ниже.

Запрет в robots.txt

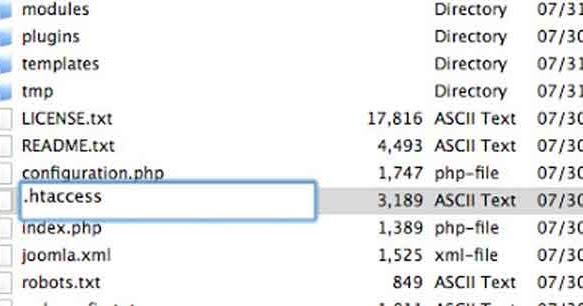

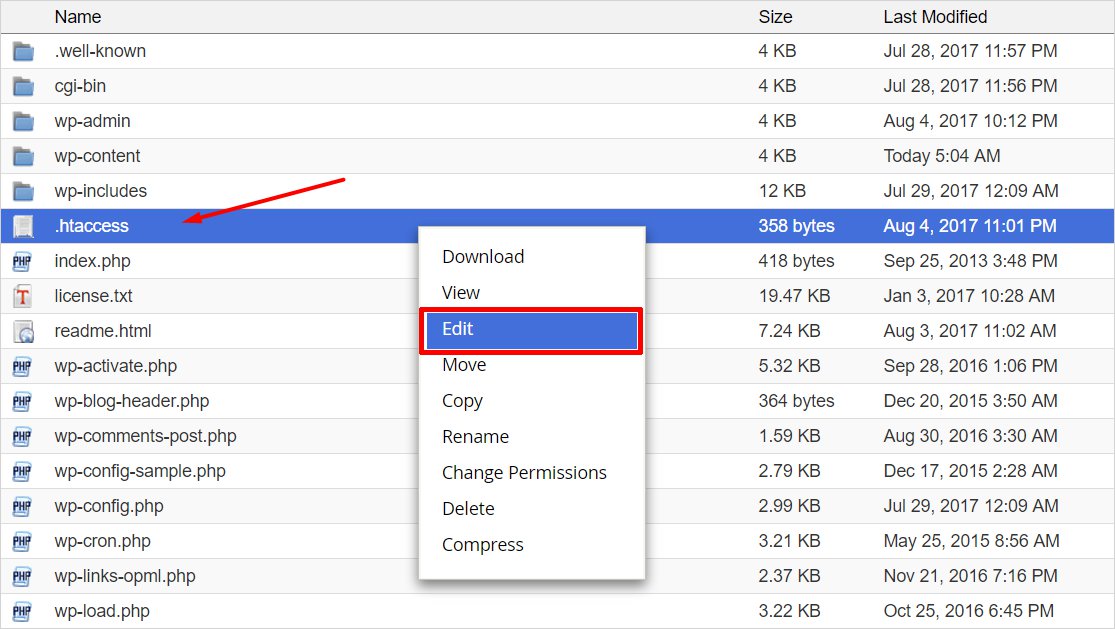

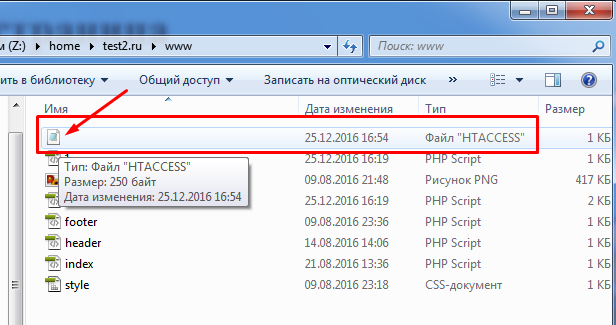

В корневой папке сайта на удаленном сервере хостинг-провайдера имеется файл с именем robots.txt.

- Что такое корневая папка сайта? Корневая папка или каталог – это то место, которому в первую очередь производится запрос из браузера, когда пользователь обращается к какому-нибудь ресурсу в интернете.

То есть, это исходная папка с которой начинаются все запросы к веб-ресурсу.

То есть, это исходная папка с которой начинаются все запросы к веб-ресурсу. - Файл robots.txt – это пакетный командный файл, в котором содержатся директивы для ПС, ответственных за индексацию контента.

Говоря простыми словами, robots.txt это специальный файл, предназначенный для поисковых роботов. Что, собственно, понятно из самого имени документа – Robots, что означает «роботы».

Отредактировать файл с командами для роботов ПС можно вручную в простом текстовом редакторе, добавить или удалить команды, изменить отдельные записи.

У каждой поисковой системы действует множество роботов, которые ответственны за индексацию разного рода контента. Отдельные роботы ищут и заносят в базу изображения, текст, скрипты и все остальное, что только может иметь значение для нормальной работы интернет-проекта.

Роботов индексаторов довольно много, перечислим только некоторых из них:

- Yandex – главный робот, ответственный за индексацию проекта в поисковой системе Яндекс.

- YaDirectBot – робот, ответственный за индексацию веб-страниц, на которых опубликована реклама контекстной системы Яндекс Директ.

- Yandex/1.02.000 (F) – робот, занимающийся индексации фавиконов, иконок сайта, которые пользователь видит во вкладках браузера и в сниппетах на странице выдачи.

- Yandex Images – индексация изображений.

Как вы понимаете, директивы или команды следует задавать для каждого конкретного робота в том случае, если вы желаете задать правила поведения индексация индексируемых роботов в отношении определенного типа контента.

Если же необходимо задать правила индексации для всей поисковой системы, тогда в файле robots.txt прописывается директива для главного робота.

В поисковой системе Google работают свои роботы:

- Googlebot – основной бот Google.

- Googlebot Video – сбор информации о видеороликах, размещенных на площадке.

- Googlebot Images – индексация картинок.

А теперь давайте рассмотрим, как выглядят сами директивы или команды для поисковых роботов.

- Команда

- Команда Disallow означает запрет индексации, а команда Allow означает разрешение индексации.

Например, команда User-agent: Yandex задает правила поведения для всех поисковых роботов Яндекса. Если юзер-агент не задан, то команды будут действовать для всех поисковых систем.

В общем-то, для того, чтобы вручную редактировать файл robot.txt, не нужно быть опытным программистам.

В профессиональных конструкторах сайтов и системах управления контентом обычно предусмотрен отдельный интерфейс для настройки файла robots.txt. Знать конкретные названия поисковых роботов и разбираться в директивах необходимости нет. Достаточно указать то, что вам нужно в самом файле.

Рассмотрим для примера некоторые команды.

- User-agent: *

- Disallow: /

Эта директива запрещает обход проекта любым роботам всех поисковых систем. Если же будет указана директива Allow — сайт открыт для индексации.

Следующая команда запрещает обход всем поисковым системам, кроме Яндекса.

- User-agent: *

- Disallow: /

- User-agent: Yandex

- Allow: /

Чтобы запретить индексацию только отдельных страниц, создается вот такая команда – запрет на обход страниц «Контакты» и «О компании».

- User-agent: *

- Disallow: /contact/

- Disallow: /about/

Закрыть целый отдельный каталог сайта:

- User-agent: *

- Disallow: /catalog/

Закрыть папку с картинками:

- Disallow: /images/

Не индексировать файлы с указанным расширением:

- User-agent: *

- Disallow: /*.jpg

Различных команд, с помощью которых можно управлять поисковыми роботами, существует достаточно много. Веб-мастер может в широких пределах регулировать схему индексации веб-страниц и отдельных типов контента.

Веб-мастер может в широких пределах регулировать схему индексации веб-страниц и отдельных типов контента.

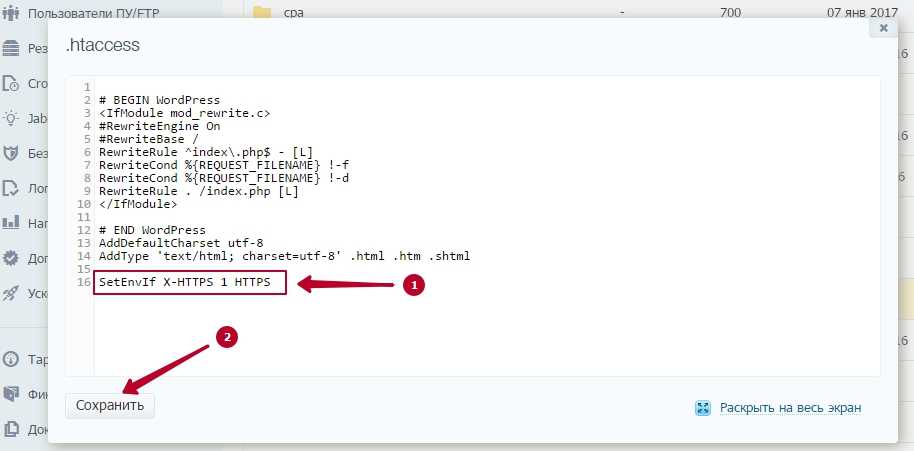

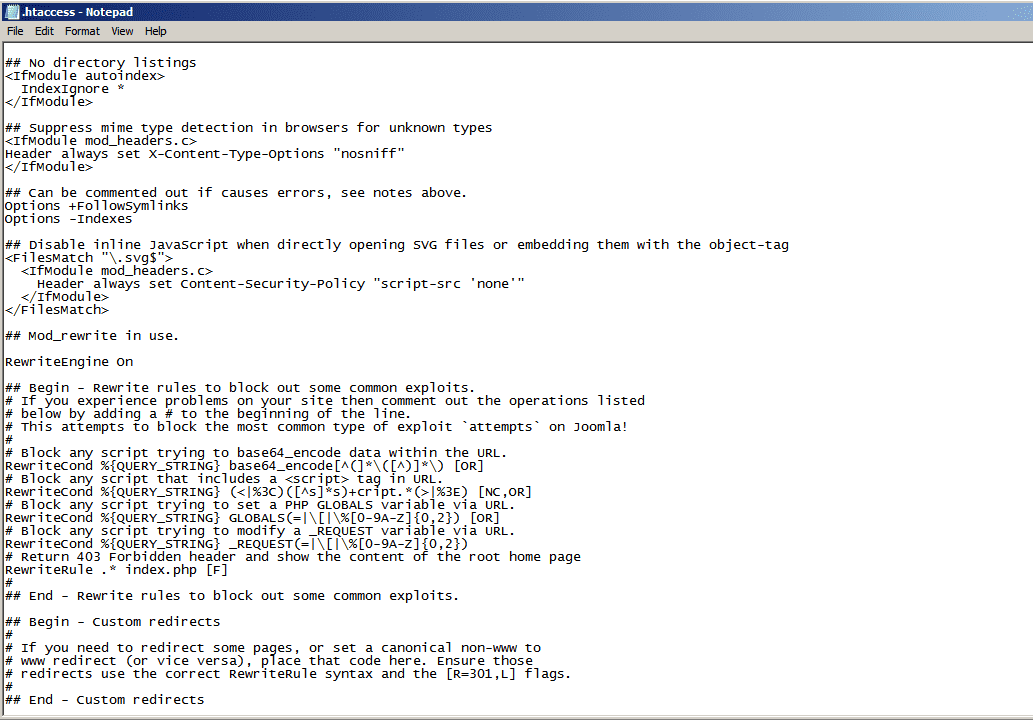

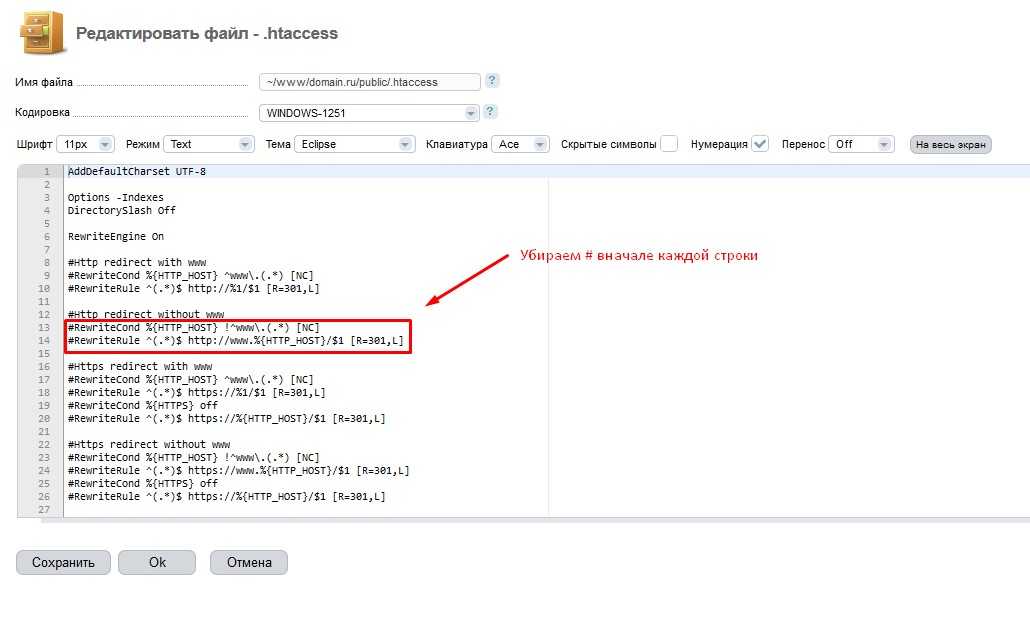

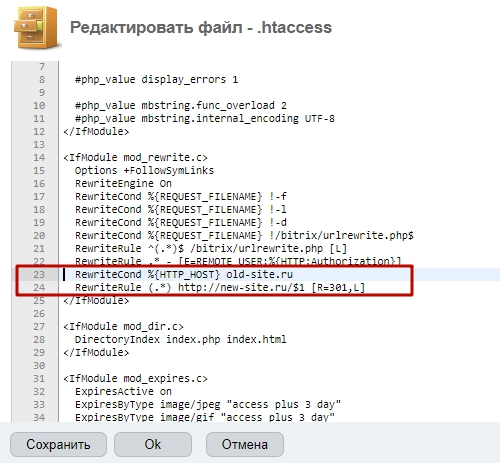

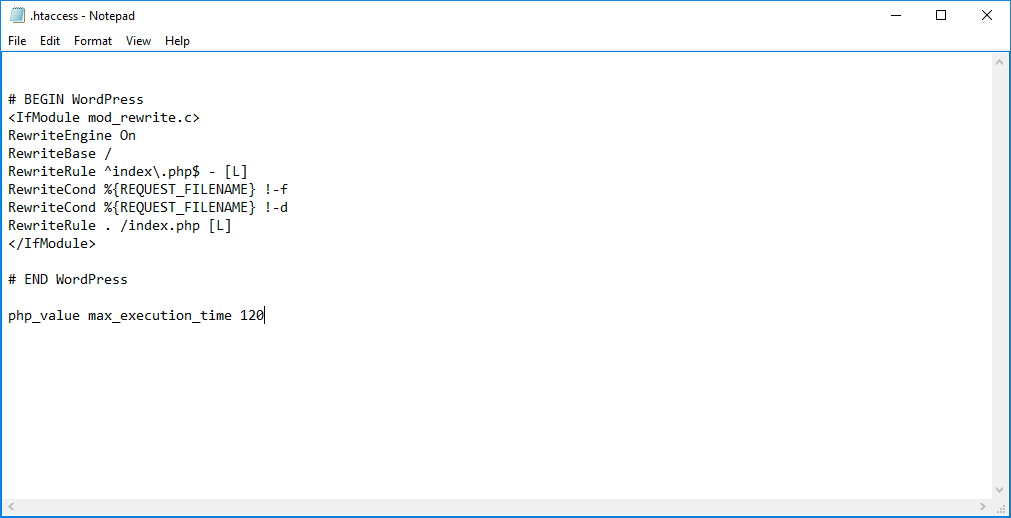

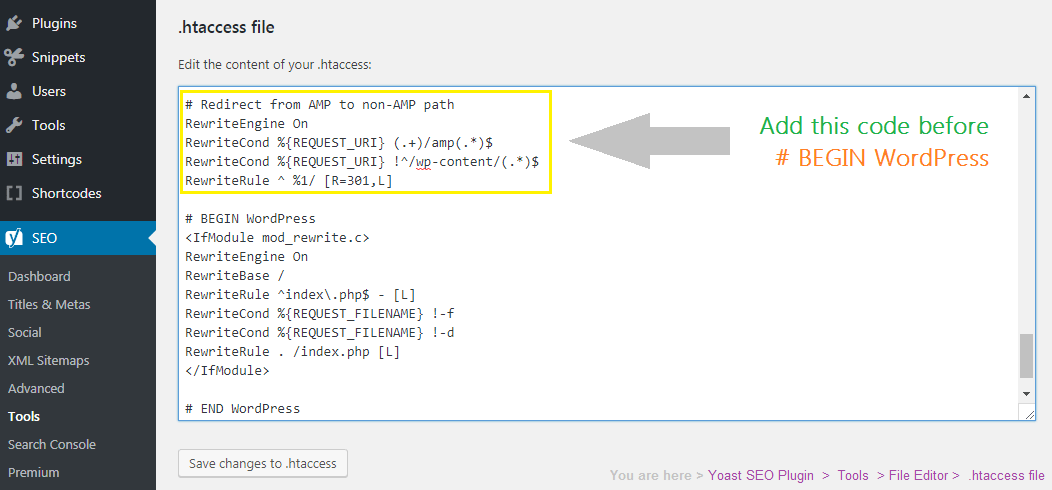

Запрет индексации через htaccess

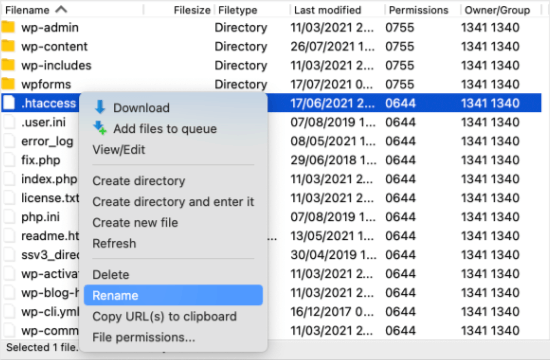

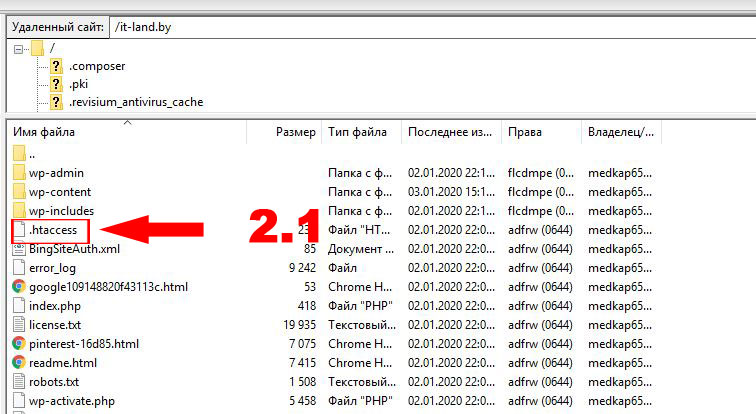

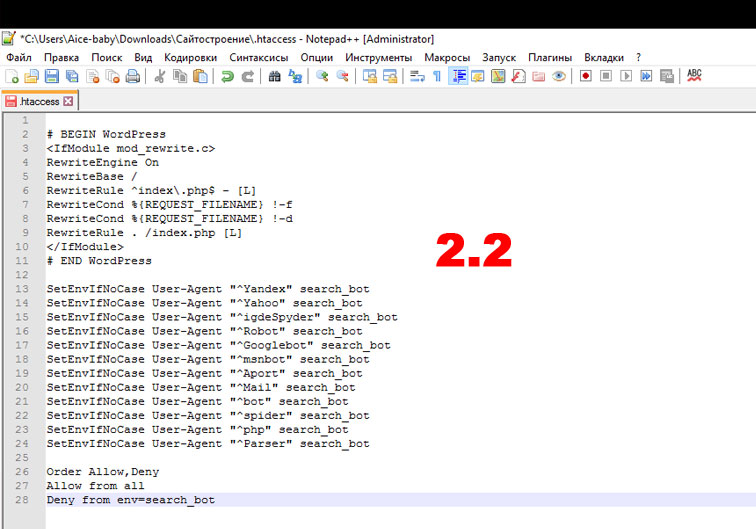

На серверах Apache для управления доступом используется файл .htaccess (hypertext access).

Особенностью функционирования этого файла является то, что его команды распространяются только на папку или каталог, в которых этот файл размещен. Если этот файл помещается в корневой каталог, то его директивы будут действовать на весь ресурс.

Возникает логичный вопрос, зачем использовать более сложный .htaccess, если задать порядок индексации можно в файле robots.txt?

Дело в том, что далеко не все роботы не всех поисковых систем подчиняются команда файла robots.txt. Зачастую поисковые роботы просто игнорируют этот файл.

С другой стороны, директивы .htaccess являются всеобъемлющими по отношению к сайтам, размещенным на серверах типа Apache.

Хотя файл .htaccess тоже является текстовым и может быть отредактирован веб-мастером в простом редакторе, настройка этого файла скорее является прерогативой опытных специалистов техподдержки хостинг-провайдера. Googlebot» search_bot

Googlebot» search_bot

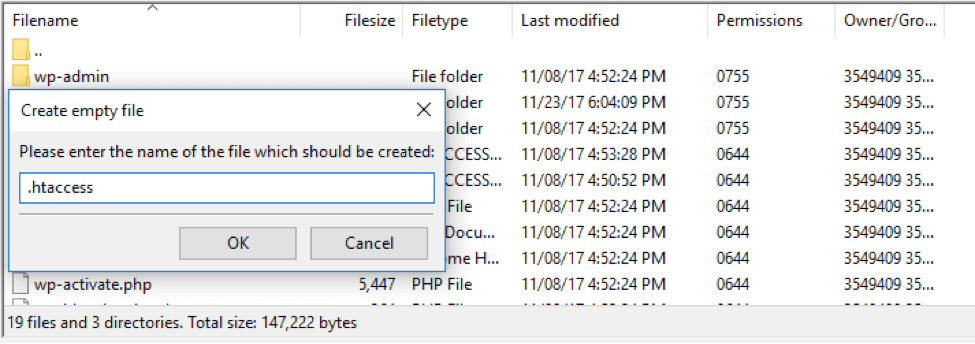

Как вы могли заметить, хотя .htaccess является простым текстовым файлом, он не имеет расширения txt, а должен иметь именно указанный формат, в противном случае сервер его не распознает.

С помощью админ панели WordPress

Зайдите в административную панель своего блога на WordPress и выберите раздел «Настройки». Нажмите на пункт Меню «Чтение».

После перехода в интерфейс «Чтение», вы найдете следующие возможности для настройки индексации.

Отметьте пункт «Попросить поисковые системы не индексировать сайт», если не хотите, чтобы контент был доступен в открытом интернете. Не забудьте сохранить изменения.

Как видите, при помощи админ панели WordPress можно сделать только общие запреты или разрешения. Для более тонких настроек индексации следует использовать файл robots.txt и .htaccess.

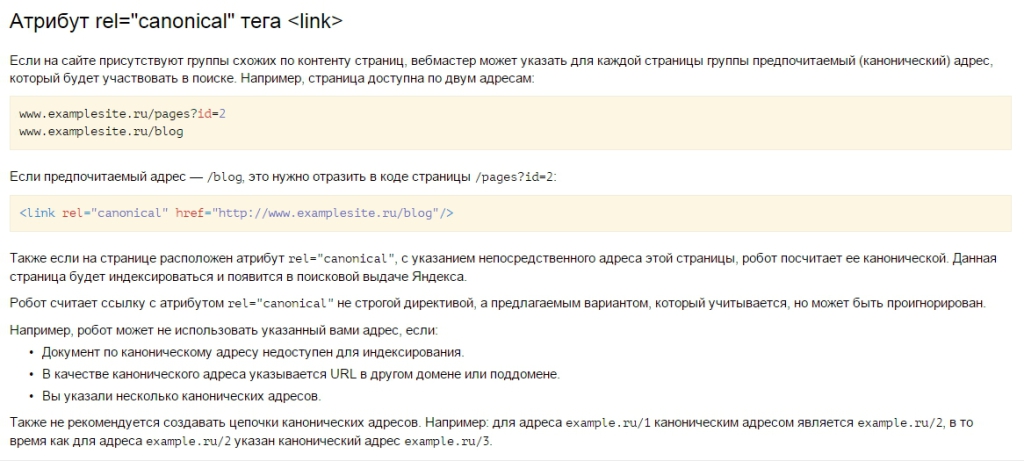

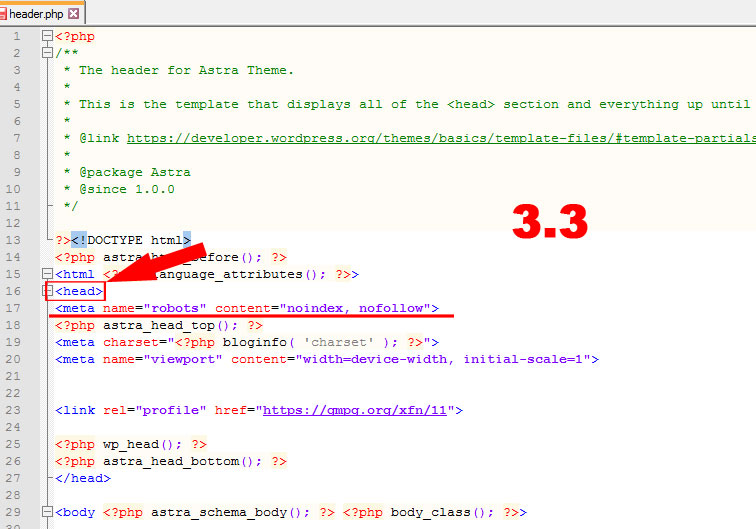

С помощью meta-тега

Управлять индексацией можно и с помощью тегов в HTML-документе веб-страницы.

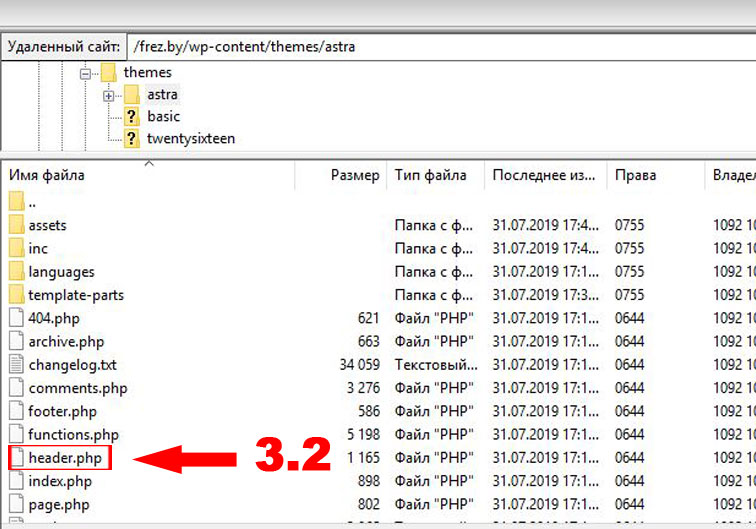

Директивы добавляются в файле header. php в контейнере <head> … </head>.

php в контейнере <head> … </head>.

Команда выглядит следующим образом:

<meta name=”robots” content=”noindex, nofollow”/>

Это означает, что поисковым роботам запрещается индексация контента. Если вместо robots указа точное имя бота определенной поисковой машины, то запрет будет касаться только ее роботов.

На этом все, как видите существует много методов, которые позволят скрыть площадку от поисковых систем. Какой использовать вам, решайте сами.

Только помните, что проанализировать правильность директив относительно индексации сайта можно с помощью инструментов Яндекса для веб-мастеров либо через SEO-сервисы.

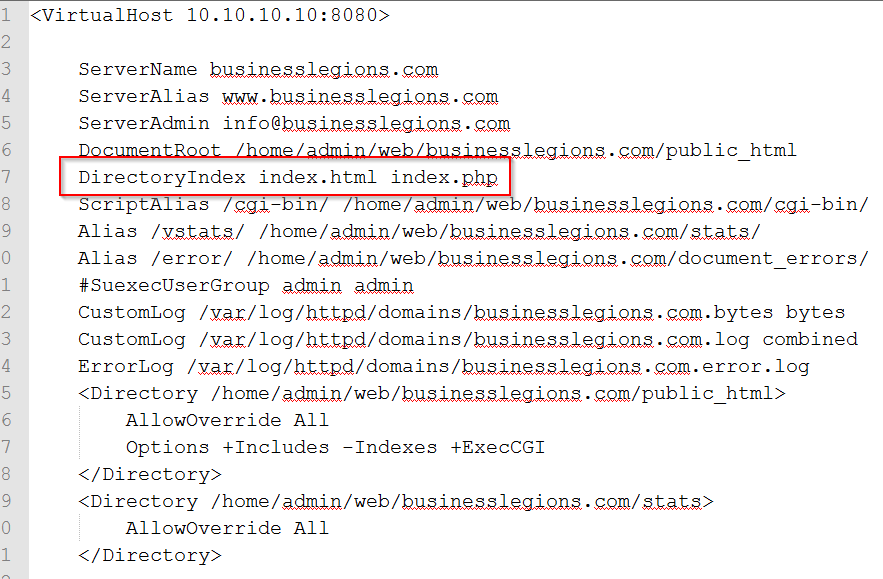

apache — Как отключить просмотр каталогов?

спросил

Изменено 6 месяцев назад

Просмотрено

484 тыс. раз

раз

Я хочу отключить просмотр папки /galerias и всех подкаталогов

Индекс /galerias/409

* Родительский каталог * i1269372986681.jpg * i1269372986682.jpg * i1269372988680.jpg

- апач

- .htaccess

2

Создайте файл .htaccess, содержащий следующую строку:

Параметры -Индексы

Это один из вариантов. Другой вариант — отредактировать файл конфигурации Apache.

Для этого сначала нужно открыть его с помощью команды:

ВИМ /etc/httpd/conf/httpd.conf

Затем найдите строку: Options Indexes FollowSymLinks

Измените эту строку на: Options FollowSymLinks

Наконец, сохраните и выйдите из файла, а затем перезапустите сервер Apache с помощью этой команды:

sudo service httpd restart

(У вас есть руководство со скриншотами здесь.)

0

Лучший способ сделать это — отключить его с помощью веб-сервера apache2. В моем Ubuntu 14.X — открыть

В моем Ubuntu 14.X — открыть /etc/apache2/apache2.conf изменить с

<Каталог /var/www/>

Индексы опционов FollowSymLinks

Аллововеррайд

Требовать все предоставленные

—

<Каталог /var/www/>

Параметры

Аллововеррайд

Требовать все предоставленные

, затем перезапустите apache:

sudo service apache2 reload

Это отключит список каталогов из всех папок, которые обслуживает apache2.

1

Помимо вышеупомянутых двух методов (редактировать /etc/apache2/apache2.conf или добавить Options -Indexes в файл .htaccess), вот еще один

a2dismod autoindex

После этого перезапустите сервер apache2

sudo service apache2 reboot

1

Редактировать/Создать файл . внутри  htaccess

htaccess /galerias с этим:

Параметры -Индексы

Просмотр каталогов обеспечивается модулем mod_autoindex.

0

Вы можете поместить пустой файл с именем index.html в каждый каталог, который вы не хотите отображать в списке. Это имеет несколько преимуществ:

- Это (обычно) не требует настройки на сервере.

- Он будет продолжать работать, даже если администратор сервера решит использовать «AllowOverride None» в конфигурации сервера. (Если вы используете

.htaccess, это может привести к большому количеству сообщений «Ошибка 500 — внутренняя ошибка сервера» для ваших пользователей!). - Это также позволяет вам перемещать файлы с одного сервера на другой, опять же без необходимости возиться с конфигурацией Apache.

Теоретически, автоиндексация может запускаться другим файлом (это контролируется параметром DirectoryIndex ), но я еще не сталкивался с этим в реальном мире.

0

Одним из важных моментов при настройке безопасного веб-сервера Apache является отключение просмотра каталогов. По умолчанию эта функция включена в Apache, но всегда полезно отключить ее, если она вам действительно не нужна. Откройте файл httpd.conf в папке apache и найдите строку, которая выглядит следующим образом:

Параметры Включает индексы FollowSymLinks MultiViews

, затем удалите индексы слов и сохраните файл. Перезапустите апач. Вот и все

0

Если вы решите изменить файл httpd.conf, чтобы решить эту проблему, и у вас есть несколько директив Options, вы должны добавить — или + перед каждой директивой. Пример:

Опции -Indexes +FollowSymLinks

Это не ответ, просто мой опыт:

На моем Ubuntu 12.04 apache2 я не нашел индексов ни в apache2.conf, ни в httpd.conf, к счастью, я нашел его на сайтах-доступно/по умолчанию . После его удаления теперь он не видит список каталогов. Возможно, придется сделать это за

После его удаления теперь он не видит список каталогов. Возможно, придется сделать это за сайтов-доступно/по умолчанию-ssl .

Чтобы завершить ответ @GauravKachhadiya:

IndexIgnore *.jpg

означает «скрыть от индексации только .jpg файлов расширения.

Директива IndexIgnore использует подстановочное выражение для сопоставления с каталогами и файлами. .extension, в следующем примере мы собираемся отключить список каталогов, файлы или каталоги не будут отображаться в индексе:

Игнорировать индекс *

Или, если вы хотите скрыть файлы spacific в списке каталогов, мы можем использовать

IndexIgnore *.php

*.php => соответствует строке, которая начинается с любого символа и заканчивается на .php

В приведенном выше примере скрываются все файлы, которые заканчиваются на .php

0

Откройте файл .htaccess и введите следующий код в

Параметры -Индексы

Убедитесь, что вы нажали клавишу ENTER (или клавишу RETURN, если вы используете Mac) после ввода слов «Параметры -Индексы», чтобы файл заканчивался пустой строкой.

Добавьте это в свой файл .htaccess:

Options -Indexes

Если это не работает по какой-либо причине, попробуйте это в файле .htaccess:

IndexIgnore *

0

Попробуйте это в .htaccess :

IndexIgnore *.jpg

1

В разделе каталога ( /etc/httpd/httpd.conf )

Удалить строку — Параметры Индексы FollowSymLinks

Новая строка — Параметры FollowSymLinks

Я нашел другие способы сделать это с помощью виртуальных хостов:

<Виртуальный хост *:80>

DocumentRoot C:/WAMP/Apache24/htdocs/

Имя сервера carspares.com

<Каталог C:/WAMP/Apache24/htdocs/vehiclesspares.com>

Параметры

Аллововеррайд

Требовать все предоставленные

Это работало для меня на Apache 2. 4.54 на моем локальном компьютере с Windows с файлом хоста (C:\Windows\System32\drivers\etc\hosts), содержащим строку:

127.0.0.1 carspares.com

В этой конфигурации также был Vehiclespares.com в docroot: C:\WAMP\Apache24\htdocs\vehiclesspares.com

4.54 на моем локальном компьютере с Windows с файлом хоста (C:\Windows\System32\drivers\etc\hosts), содержащим строку:

127.0.0.1 carspares.com

В этой конфигурации также был Vehiclespares.com в docroot: C:\WAMP\Apache24\htdocs\vehiclesspares.com

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя электронную почту и пароль

Опубликовать как гость

Электронная почта

Обязательно, но не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

.

htaccess — Отключить списки каталогов во всех папках, кроме одной, с помощью htaccess?

htaccess — Отключить списки каталогов во всех папках, кроме одной, с помощью htaccess? Прямо сейчас я использую Options -Indexes , чтобы скрыть доступ ко всем спискам каталогов на моем веб-сайте.

Однако я обнаружил, что мне нужен доступ к каталогу для определенной папки:

../Resource/Other/

Есть ли способ применить логическое НЕ правило к htaccess, чтобы разрешить доступ к определенным папкам , отключив доступ к каталогу по умолчанию? Или мне нужно подойти к этому с другой стороны и включить списки каталогов глобально, а затем выборочно отключить их по папкам?

- .htaccess

1

Создайте файл htaccess с Options +Indexes в папке, которую вы хотите вывести.

Не забудьте также удалить все индексные файлы.

самый простой способ сделать это — отключить списки глобально, а затем разрешить списки других. То есть ваш виртуальный хост должен быть настроен по умолчанию, чтобы не отображать каталоги при удалении опции «Индексы». Затем вы должны добавить директиву каталога и установить «Параметры», чтобы разрешить вывод списка определенного каталога.

Затем вы должны добавить директиву каталога и установить «Параметры», чтобы разрешить вывод списка определенного каталога.

Например:

Допустим, у вас есть следующая структура каталогов: /home/user/www (примечание: www — это корень документа).

В каталоге www есть каталоги appdir1, appdir2, app3, и вы хотите перечислить только appdir3, поэтому в вашем виртуальном хосте:

DocumentRoot /home/user/www имя_сервера myserver.local <Каталог /home/user/www/> Опции FollowSymLinks MultiViews

В этом случае невозможен просмотр каталогов, любые каталоги в корне документа запрещены. Однако, если вы добавите другую директиву каталога, вы можете указать список каталогов в указанном каталоге:

DocumentRoot /home/user/www имя_сервера myserver.local <Каталог /home/user/www/> Опции FollowSymLinks MultiViews <Каталог /home/user/www/appdir3> Индексы опционов

С другой стороны, вы можете добавить файлы .

То есть, это исходная папка с которой начинаются все запросы к веб-ресурсу.

То есть, это исходная папка с которой начинаются все запросы к веб-ресурсу.