Как отдавать роботам 404 — Вопросы новичков

Mukis

Постоялец

- Автор темы

- #1

Всем привет. Нужно отдавать роботам ошибку, а юзерам норм сайт. Как это сделать?

primehostnet

Мастер

- #2

Определяете робота(что на 100% сделать нереально) и отдаете ему header 404

Если это не робот, то отдаете сайт.

Основной вопрос в том как определить робота, ту твариантов несколько, либо по юзерагенту, либо искать списки ip адресов роботов. Но оба эти варианта не дадут 100% результата.

Не проще сделать авторизацию для пользоователей и все?

Mukis

Постоялец

- Автор темы

- #3

primehostnet написал(а):

Определяете робота(что на 100% сделать нереально) и отдаете ему header 404

Если это не робот, то отдаете сайт.

Основной вопрос в том как определить робота, ту твариантов несколько, либо по юзерагенту, либо искать списки ip адресов роботов. Но оба эти варианта не дадут 100% результата.Не проще сделать авторизацию для пользоователей и все?

Нажмите для раскрытия…

Не, тут надо отдавать именно роботам 404, а остальных пускать

Nei

Nosce te ipsum

- Модер.

- #4

Неплохо бы уточнить задачу: вообще всех роботов надо отсеивать? А на сайт откуда тогда будут заходить? Вбивая адрес напрямую? Тогда в принципе по пустому рефереру можно отсекать. Плюс на всякий случай погуглить основные роботы поисковых систем и их отдельно блокировать. Еще можно к примеру на javascript ставить куку по истечению 5 секунд и по отсутствию этой куки блочить (хотя можно и посетителей, быстро переходящих по ссылкам, таким образом заблокировать).

Плюс на всякий случай погуглить основные роботы поисковых систем и их отдельно блокировать. Еще можно к примеру на javascript ставить куку по истечению 5 секунд и по отсутствию этой куки блочить (хотя можно и посетителей, быстро переходящих по ссылкам, таким образом заблокировать).

primehostnet

Мастер

- #5

Nei написал(а):

Тогда в принципе по пустому рефереру можно отсекать.

Нажмите для раскрытия.

..

очень часто и при переходе с пс реферер либо пустой либо закодирован… либо просто браузером не передается Так что это не вариант.

Mukis написал(а):

Не, тут надо отдавать именно роботам 404, а остальных пускать

Нажмите для раскрытия…

Вы не определите робота на 100% ну никак. Рано или поздно будут санкции от ПС за клоакинг (когда контент для робота и для пользователя разные), даже если вы закроете для робота, эти страницы регулярно будут попадать в очередь на индексацию от разного рода плагинов браузера или самого браузера

Nei

Nosce te ipsum

- Модер.

- #6

primehostnet написал(а):

Вы не определите робота на 100% ну никак. Рано или поздно будут санкции от ПС за клоакинг (когда контент для робота и для пользователя разные), даже если вы закроете для робота, эти страницы регулярно будут попадать в очередь на индексацию от разного рода плагинов браузера или самого браузера

Нажмите для раскрытия…

Исходя из того, что задача заблокировать всех роботов (и поисковых в том числе) — задача просто скрыть сайт от всех, т.е. санкции за клоакинг не должны волновать.

primehostnet

Мастер

- #7

Nei написал(а):

Исходя из того, что задача заблокировать всех роботов (и поисковых в том числе) — задача просто скрыть сайт от всех, т.

е. санкции за клоакинг не должны волновать.

Нажмите для раскрытия…

Ну этого мы пока не знаем. Мне вообще цель этого не ясна

korvin222

Мой дом здесь!

- #8

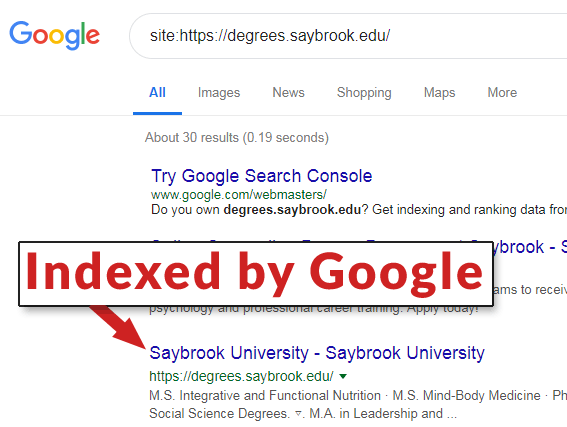

А при чем здесь 404 страница? Ведь есть стандартный путь закрыть страницы от индексации, прописав нужное в robots.txt. Много примеров здесь

Скрытое содержимое доступно для зарегистрированных пользователей!

Или закрытие части текста от поисковиков (как я понял, автор что-то нелегальное хочет продавать)

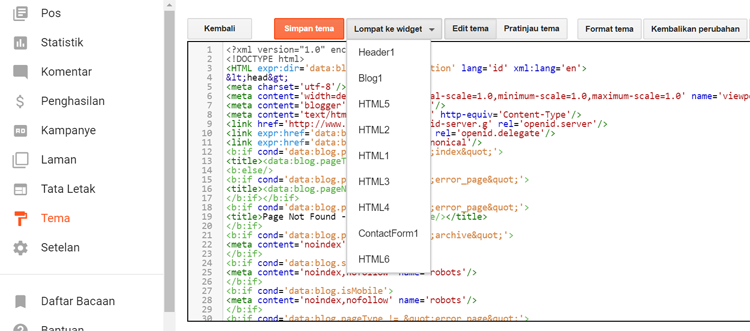

<!—googleoff: all—>

<!—noindex—>

<noindex>

Скрытый текст

</noindex>

<!—/noindex—>

<!—googleon: all—>

А вообще, если вы используете joomla, то вам в помощь rereplacer, где вы спокойно назначите для конкретных страниц замену кода по многим условиям, в том числе и для роботов.

Twickbot

Постоялец

- #9

Mukis написал(а):

Всем привет. Нужно отдавать роботам ошибку, а юзерам норм сайт. Как это сделать?

Нажмите для раскрытия…

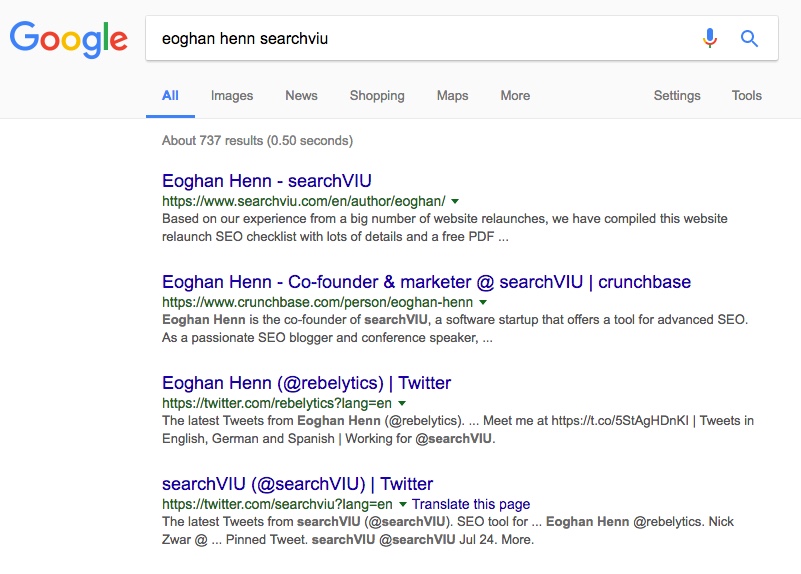

Скоро открываем сервис клоакинга. Сейчас он пока в стадии тестирования (кстати, приглашаем всех желающих потестить).

У нас, в том числе, есть база UA и подсеток всех ботов (около 35К записей).

Есть возможность показывать юзверям нормальный контент, а ботам выдавать другой (в том числе и 404).

Конечно, 100% гарантии определения ботов не может дать никто, но, наш сервис определяет, я думаю, где-то 99.99% всех ботов.

Если будет желание и сайт не очень сильно посещаемый, велком в скайп: live:4e48e4a4f51365c4

Сделаю бесплатно.

m3ow.com

Постоялец

- #10

Mukis написал(а):

Всем привет.

Нужно отдавать роботам ошибку, а юзерам норм сайт. Как это сделать?

Нажмите для раскрытия…

В целом, это клоакинг и за такое можно словить санкции от ПС. Но если вас это не пугает, то в интернете полно гайдов именно по слову Клоакинг, подмена контента и т.п.

Реально сложный тест по SEO

Какой ты SEO-шник?

Публикуем наш внутренний тест с уникальными вопросами по SEO. Основная фишка данного теста заключается в том, что на большую часть вопросов невозможно найти ответ просто «погуглив», необходимо обладать практическими знаниями в области продвижения и оптимизации сайтов.

В конце теста будет оценка, ваших знаний и полный список вопросов с правильными ответами, но пока без объяснения.

Подробный разбор вопросов сделаем позже, скорее всего в отдельной большой статье. Если вам не терпится получить подробное разъяснение по какому либо вопросу, дайте знать в комментариях.

Будем рады обратной связи в комментах!

1 / 30

Обязательное условие, чтобы новый сайт начал индексироваться поисковыми системами?

Установка Яндекс.Метрики и Google Analytics в код сайта.

Наличие Sitemap.xml.

Код HTTP 2** у страниц сайта.

Все утверждения верны.

2 / 30

Что можно проверить с помощью инструмента Google Search Console?

Запросы, по которым пользователи переходили из поисковых систем.

CTR сниппета вашего сайта по определенному запросу.

Какие страницы других сайтов ссылаются на ваш ресурс.

Все вышеперечисленное.

3 / 30

Какова точная частотность запроса на скриншоте?

8 640 016

25 848

1 322

Невозможно определить в Wordstat

4 / 30

Выберите лишнее

Yoast

Rank Math

Divi

SEOPress

5 / 30

Что не является фактором ранжирования в Google?

Наличие https сертификата.

Доменное имя сайта.

Мета-тег Keywords.

Все вышеперечисленное.

6 / 30

Что такое Кластеризация в SEO?

Распределение ключевых слов по посадочным страницам.

Создание оптимальной структуры страницы под требования поисковых систем.

Группировка роботами поисковых систем страниц вашего сайта на типы: статьи, рубрики, страницы услуг, категория товаров и так далее.

Процесс «расклейки» аффилиатов.

7 / 30

На что влияет ИКС сайта?

Если ИКС сайта «X» выше сайта «Y», то сайт «X» будет всегда выше сайта «Y» в результатах выдачи Яндекс.

Сайт с ИКС меньше 50 никогда не попадет в ТОП10 Яндекс.

Не влияет напрямую на ранжирование в Яндекс.

8 / 30

Какой запрос к сервису Яндекс.Вордстат позволит определить частоту фразы в искомом порядке и окончаниями слов?

«[!купить !россия]»

[«!купить !россия»]

«!купить !россия»

[!купить !россия]

9 / 30

Запрос «купить обои в Минске» является

Геозависимым

Геонезависимым

Геовыраженным

Зависит от контента на странице

10 / 30

Правильно ли будет использовать тот же robots. txt при смене CMS сайта с WordPress на Битрикс?

txt при смене CMS сайта с WordPress на Битрикс?

Нет.

Да, если структура сайта не менялась.

Да, при условии безусловного 301 редиректа.

Да, если не менялся домен.

11 / 30

Какой технологии(алгоритма) не существует в поисковой системе Яндекс?

Многорукий бандит

Яти

Матрица

Все ответы верны

12 / 30

Какой параметр в URL-адресе результата поиска Яндекса указывает на регион (см скриншот)?

lr=

country=

town=

country= + town=

13 / 30

Интент – это

Совокупность запросов пользователя, на основании которых выявляются его интересы и потребности.

Персонализированные результаты выдачи поисковой системы.

Намерение, потребность пользователя, которая отражается в поисковом запросе.

Такое определение не используется в SEO.

14 / 30

Что такое краулинговый бюджет?

Бюджет, который выделяется на закупку внешних ссылок.

Допустимое кол-во исходящих ссылок с сайта.

Количество запросов 1 сайта, которые могут ранжироваться в ТОП100 поисковой системы Google.

Количество страниц, которые поисковая система хочет и может просканировать на вашем сайте, и частота их сканирования.

15 / 30

Какова максимальная длина тега Title?

60 символов

70 символов

80 символов

Нет ограничений

16 / 30

Что такое сабмиты в SEO?

Ссылки с заспамленных ресурсов, которые негативно влияют на продвижение в поиске.

Внешние ссылки на продвигаемый сайт с ресурсов, которые позволяют добавлять пользовательскую информацию.

Ссылки с социальных сетей.

Нет верного варианта.

17 / 30

Запросы на скриншоте были отнесены к одному кластеру. Есть ли смысл делать отдельную страницу под запрос «Цены на трюковые самокаты»?

18 / 30

Как может повлиять контекстная реклама на продвижение сайта в Яндексе?

Увеличить ИКС сайта.

Улучшить поведенческие факторы.

Ухудшить поведенческие факторы.

Все ответы верны.

19 / 30

Категория интернет-магазина «Светильники для улицы» имеет большой процент отказов в Яндекс.Метрике. Почему?

Есть переспам по ключевому слову.

На странице нет тегов h2 и h3.

У страницы сайта есть проблемы со скоростью загрузки.

Все утверждения верны.

20 / 30

Как вывести блок, выделенный на скриншоте в сниппете сайта в Яндексе?

Использовать Турбо-страницы.

Настроить микроразметку статей блога на сайте.

Через публикации в Яндекс Бизнес.

Нужно привязать сайт к Яндекс Дзен.

21 / 30

Каким образом в сниппете сайта появилась строка выделенная на скриншоте?

Можно настроить в Google Search Console.

Добавлена в мета-тег Description.

Микроразметка Product (A Schema.org Type).

Микроразметка Service (A Schema.org Type).

22 / 30

Как сбросить (обнулить) поведенческие факторы страницы для Яндекса?

Сменить URL и настроить 301 редирект.

Написать в поддержку Яндекс.

Запустить контекстную рекламу на данную страницу.

Никак.

23 / 30

Какой список слов с большой долей вероятности нельзя отнести к LSI-словам?

Телевизор, Samsung, LG, Xiaomi, диагональ, экран, рассрочка, smart.

Пылесос, Indesit, сосет, шнур, вилка, квартира.

Ноутбук, сумка, Xioami, Мышка, Intel, Lenovo.

Холодильник, посудомоечная машина, кухня, frost, камера.

24 / 30

При разработке новых страниц сайта в разделе «site.ru/test/» Google успел проиндексировать 5 тестовых страниц. Как навсегда удалить эти страницы из результатов поиска Google?

Добавить «Disallow: /test/» в robots.txt

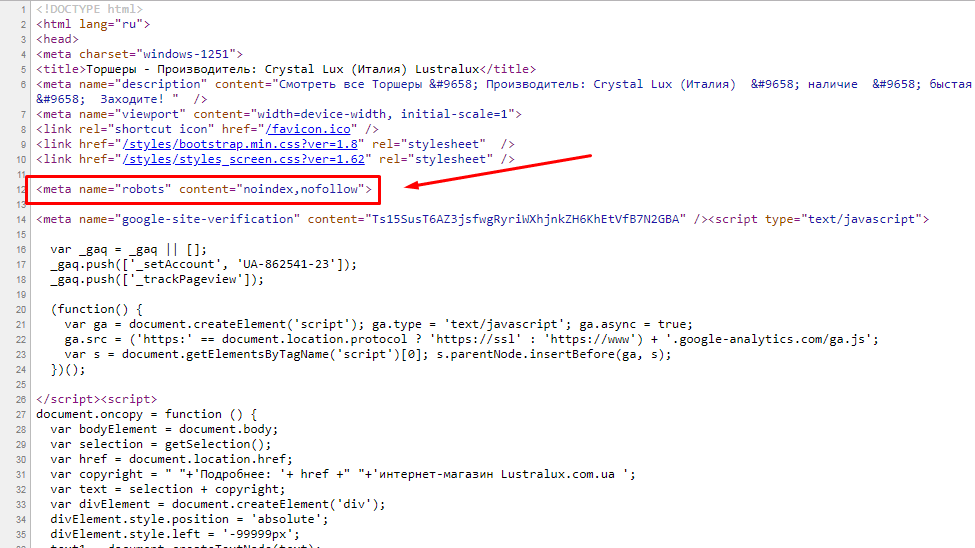

Добавить <meta name="robots" content="nofollow" /> в код этих страниц

Настроить базовую HTTP-авторизацию на эти страницы

Все ответы верны

25 / 30

Влияет ли сортировка товаров в категории интернет-магазина на SEO сайта?

Может влиять через поведенческий фактор.

Может влиять на текстовую релевантность, если есть страницы пагинации.

Оба утверждения верны.

26 / 30

Каким образом в сниппете сайта появился элемент, на который указывает стрелка на скриншоте?

Элемент есть в «хлебных крошках» на сайте.

Это фейк, скриншот подделан.

Можно настроить в Google Search Console.

Элемент есть в микроразметке, которая реализована через синтаксис JSON LD.

27 / 30

На всех страницах пагинации интернет-магазина указан канонический адрес на главную страницу категории. К примеру, на странице «https://site.ru/smartphone/?page=2» указан каноническим адрес «https://site.ru/smartphone/». Как на практике поведет себя Google и Яндекс по отношению к таким страницам пагинации (при условии отсутствия других запретов и разрешений)?

Google исключит из индекса, Яндекс проиндексирует.

Яндекс исключит из индекса, Google проиндексирует.

Яндекс и Google проиндексируют.

Яндекс и Google не проиндексируют.

28 / 30

Можно ли увеличить количество поискового трафика на сайт без изменения позиций в выдаче?

Запустить контекстную рекламу.

Улучшить сниппет за счет более привлекательного заголовка, описания, микроразметки.

Прокачать страницу внешними ссылками.

Нужно помолиться.

29 / 30

Как закрыть часть текста на странице от индексации в Google?

С помощью тегов <!--googleoff: all--> <!--googleon: all-->

Обернуть текст в тег <noindex> … </noindex><

Вывести текст с помощью AJAX, предварительно запретив индексацию этого скрипта в robots.txt.

С помощью директивы Dissalow в Robots.txt

30 / 30

У ключевого слова «Х» показатель IDF равен 11.17, а у слова «Y» 3.86. Какое из них имеет большее значение для текстовой релевантности страницы?

Слово X

Слово Y

Ваша оценка

Средний балл 36%

Может быть полезно:

Работа для SEO-специалиста

Сообщить Google, чтобы он не индексировал определенные части вашей страницы

Есть несколько способов дать указание Google не индексировать различные страницы вашего сайта:

- Директивы robots.

txt

txt - Атрибуты nofollow для ссылок

- Мета-директивы noindex/nofollow

- X-Robots noindex/nofollow директивы

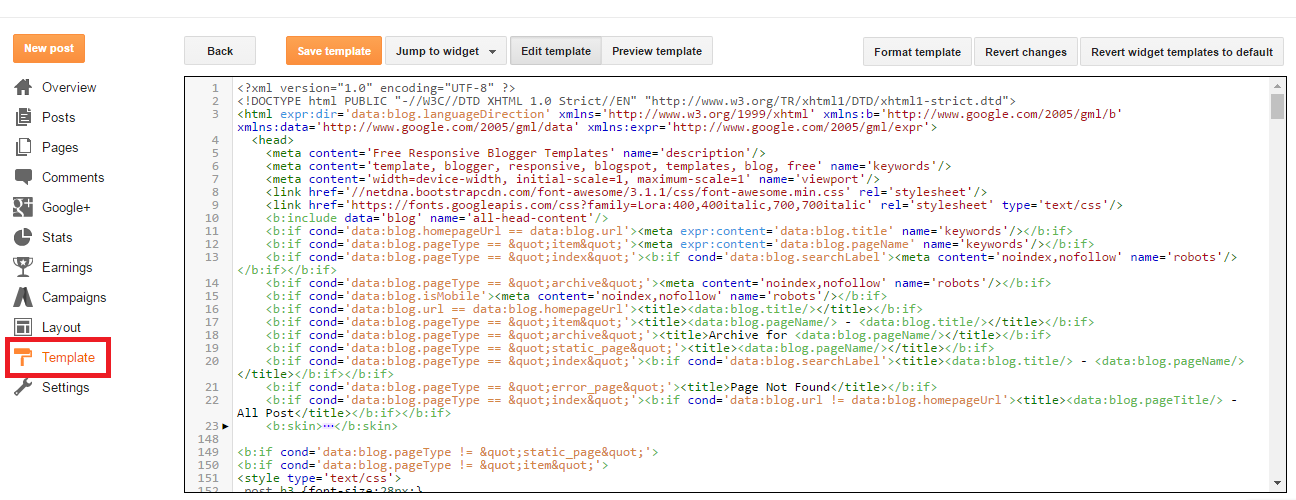

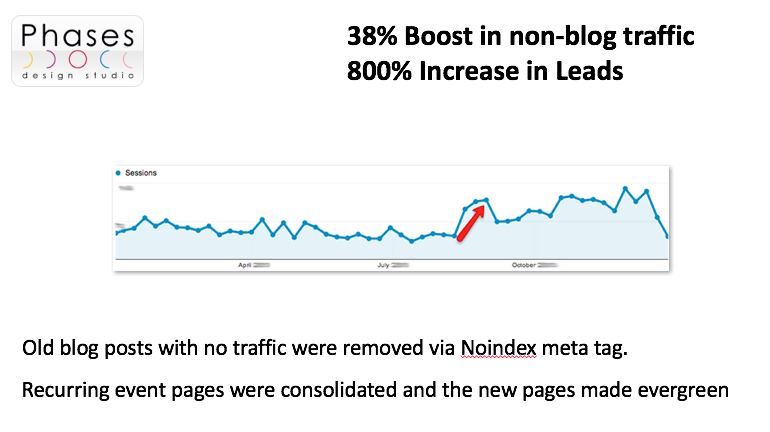

..и так далее. Все эти директивы работают по-разному, но все они служат одной и той же основной цели: управлять тем, как Google сканирует различные страницы вашего сайта. Например, вы можете использовать meta noindex, чтобы запретить Google индексировать вашу карту сайта, RSS-канал или любую другую страницу, которую вы пожелаете. Этот уровень контроля над тем, какие страницы сканируются и индексируются, полезен, но что, если вам нужно контролировать, как Google сканирует содержимое конкретной страницы? Легкий. Google позволяет нам сделать это с набором из googleon / googleoff тегов.

О тегах googleon и googleoff

Проще говоря, теги googleon / googleoff сообщают GoogleBot Google Search Appliance, когда начинать и останавливать индексирование различных частей веб-документа. Рассмотрим следующий пример:

Рассмотрим следующий пример:

Это обычный (X)HTML-контент, который будет проиндексирован Google.

Этот (X)HTML-контент НЕ будет индексироваться Google.

<дел>Ник Мейсон – 2 августа 2009 г.

От Ее Величества королевы. Его ботинки были очень чистыми.

Рик Райт — 3 августа 2009 г.

Каждый год становится короче, кажется, никогда не находить времени.

Дэвид Гилмор – 4 августа 2009 г.

У реки, взявшись за руки, прокатите меня и уложите.

Роджер Уотерс – 5 августа 2009 г.

И через некоторое время вы сможете поработать над очками для стиля.

..

..

е. санкции за клоакинг не должны волновать.

е. санкции за клоакинг не должны волновать. Нужно отдавать роботам ошибку, а юзерам норм сайт. Как это сделать?

Нужно отдавать роботам ошибку, а юзерам норм сайт. Как это сделать? txt

txt

по гуглу

по гуглу Есть 3 основные вещи, которые вы могли бы сделать (которые, вероятно, являются пустой тратой времени, продолжайте читать):

Есть 3 основные вещи, которые вы могли бы сделать (которые, вероятно, являются пустой тратой времени, продолжайте читать): Они знают, как определить, что ваш блог посвящен технологиям, а не RSS. Я очень сомневаюсь, что эти ссылки имеют какое-либо негативное влияние на ваше SEO. Какую проблему вы на самом деле пытаетесь решить?

Они знают, как определить, что ваш блог посвящен технологиям, а не RSS. Я очень сомневаюсь, что эти ссылки имеют какое-либо негативное влияние на ваше SEO. Какую проблему вы на самом деле пытаетесь решить? Просто убедитесь, что RSS и т. д. не находятся в заголовке, жирном или строгом теге.

Просто убедитесь, что RSS и т. д. не находятся в заголовке, жирном или строгом теге. Я не уверен, будут ли боты индексировать слова в атрибутах содержимого в CSS и знать, что содержимое имеет значение по отношению к каждой странице, но это кажется маловероятным. Включение таких слов, как RSS в CSS, в основном говорит о том, что это стиль, а не HTML, поэтому, даже если движки будут его индексировать, они не добавят к нему много/какой-либо ценности. Например, HTML и CSS могут быть:

Я не уверен, будут ли боты индексировать слова в атрибутах содержимого в CSS и знать, что содержимое имеет значение по отношению к каждой странице, но это кажется маловероятным. Включение таких слов, как RSS в CSS, в основном говорит о том, что это стиль, а не HTML, поэтому, даже если движки будут его индексировать, они не добавят к нему много/какой-либо ценности. Например, HTML и CSS могут быть:

( http://www.webmasterworld.com/google/4159807.htm )

( http://www.webmasterworld.com/google/4159807.htm )