Meta Robots Tag Guide for 2023

Meta Robots Tag кратко

Метатеги robots являются важным инструментом для улучшения сканирования и индексирования поисковыми системами, а также для управления вашими сниппетами в поисковой выдаче.

В этой статье мы объясним, как это сделать, как интерпретация и поддержка различаются в зависимости от поисковых систем и как метатег robots связан с X-Robots-Tag и файлом robots.txt.

Содержание

- Что такое метатег robots?

- Почему это важно?

- Объяснение синтаксиса метароботов

- Подробное описание директив метароботов

- Как можно комбинировать директивы метароботов?

- Как поисковые системы интерпретируют конфликтующие директивы?

- X-Robots-Tag — эквивалент HTTP-заголовка

- Рекомендации SEO для директив роботов

- Meta robots vs X-Robots-Tag vs Robots.txt

- Поддержка поисковых систем

- Подведение итогов и переход 900 33

- Весь фрагмент кода называется

метаэлемент. -

и/>— это открывающий и закрывающий теги. - Имеется атрибут с именем

nameсо значениемrobots.robotsприменяется ко всем поисковым роботам, но может быть заменен определенным пользовательским агентом. - А затем есть атрибут с именем

contentсо значениемnoindex, следуйте.noindex,followможно заменить другими директивами. - Предотвратите проблему с дублированием контента, применив директиву мета-роботов

noindexк целевым страницам PPC и страницам результатов поиска на сайте. Обратите внимание, что директивы robots не передают никаких полномочий и релевантности, как канонический URL. - Запретить поисковым системам индексировать контент, который никогда не должен индексироваться, потому что вы предоставляете скидки или какие-либо другие предложения, которые вы не хотите делать доступными для всего мира.

- Удалить проиндексированное конфиденциальное содержимое: если поисковые системы проиндексировали содержимое, которое они вообще не должны были индексировать, примените директиву meta robots

noindex, чтобы удалить содержимое из своих индексов. Вы можете использовать ту же технику при установке ловушек для гусениц. - Выборочно применять директиву мета-роботов

noindexк продуктам, снятым с производства, чтобы продолжать обеспечивать пользователям хороший пользовательский интерфейс.

Что такое метатег robots?

Мета-тег robots дает владельцам сайтов возможность контролировать поведение поисковых систем при сканировании и индексировании, а также то, как их фрагменты отображаются на страницах результатов поисковой системы (SERP).

Мета-тег robots входит в раздел вашего HTML-кода и является лишь одним из метатегов, которые там находятся.

Вероятно, самый известный метатег роботов — это тег, который сообщает поисковым системам не индексировать страницу:

Вы можете предоставить те же инструкции, включив их в HTTP-заголовок , используя X-Robots-Tag. X-Robots-Tag часто используется для предотвращения индексации контента, отличного от HTML, такого как PDF и изображения.

Мета-директивы роботов

Мы предпочитаем говорить о мета-директивах роботов вместо мета-тегов роботов , потому что называть их «мета-тегами роботов» некорректно (см. «Анатомию мета-элемента» ниже).

Совет для профессионалов

Метадирективы robots не следует путать с директивами robots.txt. Это два разных способа общения с поисковыми системами о различных аспектах их поведения при сканировании и индексировании. Но они влияют друг на друга, как мы увидим далее в статье.

Но они влияют друг на друга, как мы увидим далее в статье.

Анатомия мета-элемента

Давайте воспользуемся приведенным выше примером мета-директивы robots, чтобы объяснить, что к чему:

Почему это важно?

Во-первых, директивы мета-роботов дают вам столь необходимый контроль над поведением поисковых систем при сканировании и индексировании. Без какого-либо направления поисковые системы будут пытаться сканировать и индексировать весь контент, который им попадется. Это их поведение по умолчанию.

Это их поведение по умолчанию.

Во-вторых, поисковые системы будут генерировать фрагменты для ваших URL-адресов при их ранжировании. Они принимают ваше мета-описание в качестве входных данных, хотя часто вместо этого они придумывают свой собственный фрагмент, основанный на содержании вашей страницы, если они думают, что он будет работать лучше.

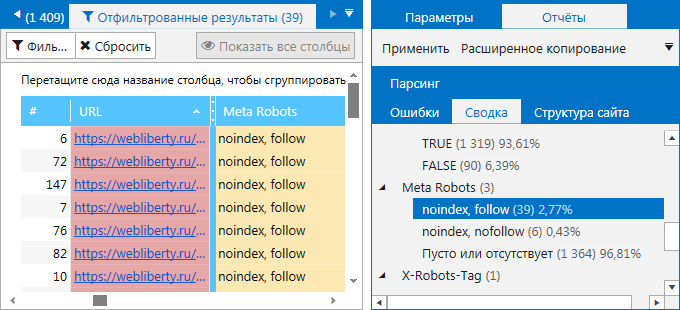

Аудит ваших мета-директив для роботов

Быстро узнайте, правильно ли настроены ваши мета-директивы для роботов!

Теперь давайте рассмотрим несколько применений директив мета-роботов для защиты вашей эффективности SEO:

Совет для профессионалов

Мы намеренно не включили в список возможность использования промежуточных сред, чтобы поисковые системы не индексировали их.

Это связано с тем, что использование HTTP-аутентификации является гораздо лучшим решением, так как оно предотвращает доступ как пользователей, так и поисковых систем и предотвращает перенос директивы мета-роботов noindex на рабочую площадку.

Объяснение синтаксиса мета-роботов

Прежде чем углубляться, давайте рассмотрим некоторые основы.

Синтаксис не чувствителен к регистру

Директивы Meta robots не чувствительны к регистру, что означает, что все приведенные ниже примеры действительны:

Разделение директив запятыми для Google

Для Google необходимо разделять директивы запятой. Пробел не нужен:

Пробелы после запятых не требуются

Пробелы после запятых между директивами не требуются. Таким образом, оба примера ниже действительны:

Теперь давайте переходим к самим директивам!

Подробное описание мета-директив для роботов

В этом разделе мы рассмотрим наиболее распространенные мета-директивы, с которыми вы столкнетесь в дикой природе, и что именно они означают. Мы сосредоточимся в первую очередь на поддержке директив Google, поскольку они являются доминирующей поисковой системой.

Мы сосредоточимся в первую очередь на поддержке директив Google, поскольку они являются доминирующей поисковой системой.

Вот директивы, которые мы рассмотрим:

- all

- index

- index,follow

- noindex

- noindex,follow

- noindex, nofollow

- нет

- нет архива

- nosnippet

- max-snippet

Мета-роботы «все»

По умолчанию поисковые системы будут сканировать и индексировать любой контент, который им попадется, если не указано иное. Если вы хотите явно указать, что это разрешено, вы можете сделать это с помощью следующей директивы:

Meta robots “index”

Пока не обязательно поскольку это поведение по умолчанию, если вы хотите указать поисковым системам, что им разрешено индексировать страницу, вы можете сделать это с помощью приведенной ниже директивы meta robots.

Meta robots "index,follow"

Часто директива index сочетается с директивой follow , что приводит к:

Эти директивы, по сути, означают то же самое, что и вышеприведенная, только указывает index , поскольку Follow также является поведением поисковой системы по умолчанию.

Meta robots «noindex»

Директива meta robots noindex запрещает поисковым системам индексировать страницу. Вот как выглядит мета-директива robots noindex :

Приведенный выше пример говорит поисковым системам, что они не должны индексировать страницу, но они должны чувствовать можно свободно переходить по всем его ссылкам, потому что прямо не указано, что этого делать не следует.

без индекса 9Директива 0040 имеет большой вес, поэтому, когда поисковые системы находят ее, они быстро удаляют контент из своего индекса. Другая сторона медали заключается в том, что трудно переиндексировать этот контент, если, например, вы случайно применили директиву noindex .

Будьте предупреждены о мошеннических директивах noindex

Немедленно получайте оповещения о мошеннических директивах noindex, чтобы предотвратить SEO-катастрофы!

Полезные ресурсы

- Узнайте все об удалении URL из Google

Мета-роботы «noindex,follow»

Часто можно встретить мета-роботов noindex в сочетании с директивой Follow . Он говорит поисковым системам не индексировать страницу, но переходить по ссылкам можно:

Он говорит поисковым системам не индексировать страницу, но переходить по ссылкам можно:

Рискуя показаться заезженной пластинкой , и означает то же самое, поскольку следует за — это поведение поискового робота по умолчанию.

Meta robots «noindex,nofollow»

Вы также можете комбинировать директиву meta robots noindex с метадирективой nofollow (не путать с атрибутом ссылки nofollow):

Комбинация noindex,nofollow указывает поисковым системам не индексировать страницу и не переходить по ссылкам на странице, что означает, что никакие полномочия по ссылкам также не должны передаваться.

Профессиональный совет

«noindex» со временем становится «noindex,nofollow»

Поисковые системы значительно уменьшают повторное сканирование непроиндексированной страницы, что по существу приводит к ситуации noindex, nofollow , потому что ссылки на странице, которые не сканируется, не соблюдаются.

Meta robots «none»

Директива meta robots none на самом деле является сокращением для noindex,nofollow , о котором мы говорили чуть выше. Вот что такое мета роботы none Директива выглядит так:

Она используется не очень часто, и люди часто думают, что это означает прямо противоположное: индекс , следуйте .

Будьте осторожны с этим!

Meta robots «noarchive»

Директива meta robots noarchive запрещает поисковым системам отображать кэшированную версию страницы в поисковой выдаче. Если вы не укажете директиву noarchive , поисковые системы могут просто перейти к кэшированной версии страницы. Итак, опять же, это директива об отказе.

Вот как выглядит директива noarchive :

Однако ее часто комбинируют с другими директивами. Например, вы часто будете видеть его вместе с директивами

Например, вы часто будете видеть его вместе с директивами noindex и nofollow :

не должен индексировать страницу, не должен переходить ни по одной из ее ссылок и не должен кэшировать страницу.

Meta robots «nosnippet»

Директива meta robots nosnippet предписывает поисковым системам не показывать текстовый фрагмент (обычно взятый из метаописания) или предварительный просмотр видео для страницы.

Вот как выглядит директива nosnippet :

Если бы мы применяли директиву meta robots nosnippet к нашей статье о перенаправлениях, тогда фрагмент будет выглядеть так:

Поисковые системы могут по-прежнему показывать миниатюру изображения, если считают, что это улучшит взаимодействие с пользователем. Для Google это относится к обычному поиску в Интернете, изображениям Google и Google Discover. Директива

Директива nosnippet также функционирует как директива noarchive .

Если директива nosnippet не включена, Google самостоятельно создаст фрагмент текста и предварительный просмотр видео.

Pro tip

Предотвращение использования определенного содержимого для фрагмента

В частности, в Google вы можете предотвратить отображение части содержимого вашей страницы во фрагменте с помощью HTML-атрибута data-nosnippet . Хотя это не директива о мета-роботах, она тесно связана с ними, поэтому нам нужно коснуться этого здесь.

HTML-атрибут data-nosnippet можно использовать для элементов span , div и section . Вот пример:

Это может быть показано во фрагменте, а

это не будет отображаться во фрагменте.

Узнайте больше об атрибуте data-nosnippet здесь .

Meta robots «max-snippet»

Директива meta robots max-snippet указывает поисковым системам ограничить фрагмент страницы (обычно взятый из метаописания страницы) до указанного количества символов.

Вот пример, где максимальная длина сниппета составляет 50 символов:

Мета-роботы «max-snippet:0»

Когда вы указываете max-snippet:0 , вы сообщаете поисковые системы не отображать фрагмент — по сути, то же самое, что и директива meta robots nosnippet , которую мы только что описали выше:

Meta robots «max-snippet:-1»

При указании max-snippet:-1 , вы явно указываете поисковым системам, что они могут сами определять длину фрагмента, что является их поведением по умолчанию:

Совет для профессионалов

Влияние Европейской директивы об авторском праве

С октября 2019 года сайты, классифицируемые как «публикации европейской прессы», по умолчанию отображаются в Google без фрагмента..png) Вы можете подписаться на показ своих фрагментов с помощью

Вы можете подписаться на показ своих фрагментов с помощью max-snippet и max-image-preview , или вы можете удалить свой сайт из списка публикаций европейской прессы через Google Search Console . Узнайте больше об этом здесь.

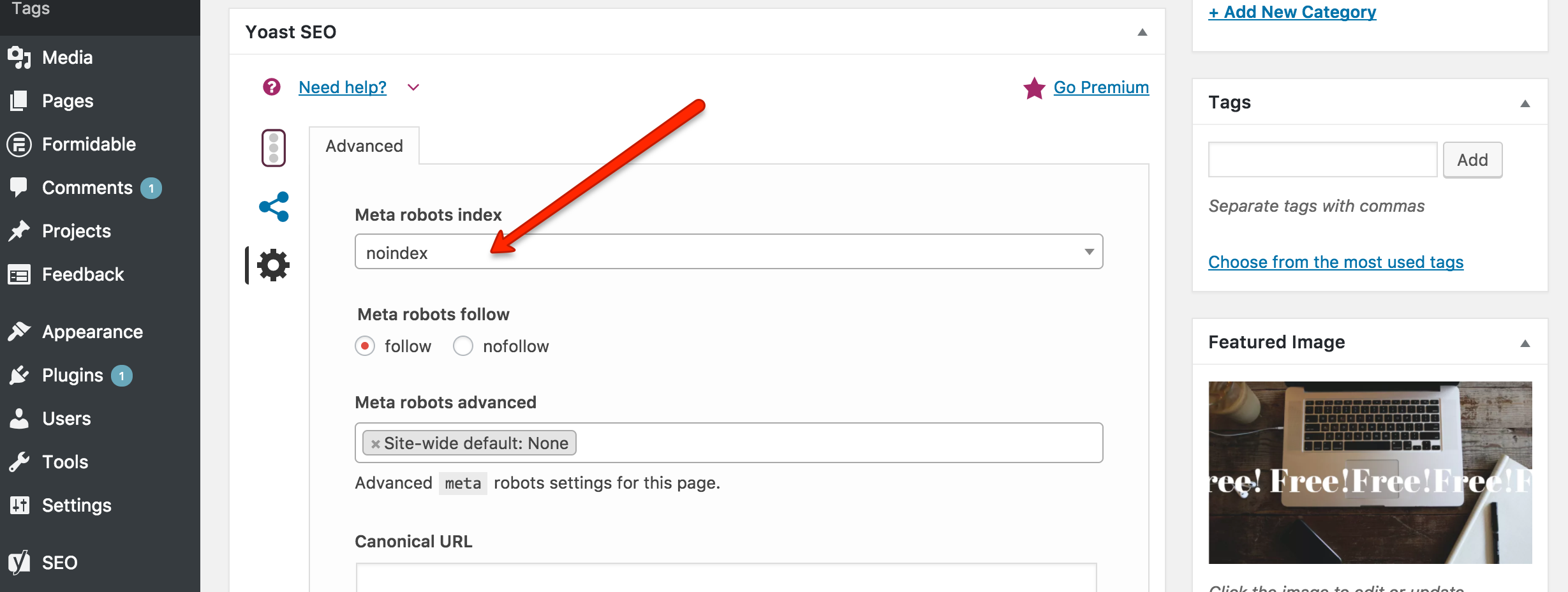

Если вы используете плагин Yoast SEO в WordPress, вы обнаружите, что он автоматически соглашается, когда вы включаете следующий фрагмент:

Менее важные метадирективы роботов

Теперь мы подошли к менее важным директивам мета-роботов, которых коснемся лишь кратко.

То, что касается других директив мета-роботов, относится и к этим: если они не определены, поисковые системы будут делать то, что им заблагорассудится.

Вот что директивы сигнализируют поисковым системам:

-

unavailable_after: "удалить страницу из вашего индекса после определенной даты". Дата должна быть указана в широко распространенном формате, таком как, например, ISO 8601. Директива игнорируется, если не указаны допустимые дата/время. По умолчанию срок действия контента не ограничен. Это в основном таймер

Дата должна быть указана в широко распространенном формате, таком как, например, ISO 8601. Директива игнорируется, если не указаны допустимые дата/время. По умолчанию срок действия контента не ограничен. Это в основном таймер директива noindex, поэтому будьте осторожны при ее использовании. -

noimageindex: «не индексировать изображения на этой странице». -

max-image-preview: «определить максимальный размер предварительного просмотра изображения для страницы с возможными значениями:нет,стандартныйибольшой». -

max-video-preview: «определить максимальную продолжительность предварительного просмотра видео на странице». -

notranslate: "не предлагать переведенную версию страницы в результатах поиска".

Полезные ресурсы

- Документация Google Meta Robots

Как можно комбинировать директивы метароботов?

Помимо возможности комбинировать директивы, вы также можете предоставлять директивы разным поисковым роботам. Каждый сканер будет использовать сумму предоставленных им директив, то есть: они складываются.

Каждый сканер будет использовать сумму предоставленных им директив, то есть: они складываются.

Чтобы проиллюстрировать это, давайте рассмотрим пример:

Эти директивы интерпретируются следующим образом:

- Google:

NoIndex, Nofollow - Другие поисковые системы:

NOFOLLY

Как поисковые агрессии интерпретируют конфликтные директивы?

Как вы понимаете, когда вы начинаете складывать директивы, легко запутаться. Если возникает сценарий, в котором есть конфликтующие директивы, Google по умолчанию использует наиболее ограничительный вариант .

Возьмем, к примеру, следующие директивы:

Вердикт: Google ошибется из-за осторожности и не проиндексирует страницу.![]()

Но то, как интерпретируются конфликтующие директивы, может различаться в разных поисковых системах. Возьмем другой пример:

Google не проиндексирует эту страницу, а Яндекс проиндексирует сделать прямо противоположное и проиндексировать его.

Так что имейте это в виду и убедитесь, что ваши директивы robots работают правильно для важных для вас поисковых систем.

Файлы, отличные от HTML, такие как изображения и PDF-файлы, не имеют источника HTML, в который можно включить метадирективу robots. использовать HTTP-заголовок X-Robots-Tag .

Кратко коснемся заголовков HTTP.

Когда посетитель или поисковая система запрашивает страницу с веб-сервера, и страница существует, веб-сервер обычно отвечает тремя вещами:

- Код состояния HTTP : трехзначный ответ на запрос клиента (например,

200 ОК).

- Заголовки HTTP : заголовки, содержащие, например, тип содержимого

- Тело HTTP : тело (например,

HTML,CSS,JavaScriptи т. д.), которое используется для рендеринга и отображения страницы в браузере.

X-Robots-Tag может быть включен в заголовки HTTP. Вот скриншот заголовков HTTP-ответа страницы, взятый из Chrome Web Inspector, для страницы, содержащей X-Robots-Tag

Итак, как это работает на практике?

Настройка X-Robots-Tag на Apache

Например, если вы используете веб-сервер Apache и хотите добавить noindex,nofollow X-Robots-Tag в ответ HTTP для всех ваших файлов PDF, добавьте следующий фрагмент в файл .htaccess или файл httpd.conf :

Набор заголовков X-Robots-Tag "noindex,nofollow"

Или, возможно, вы хотите сделать изображения типов файлов PNG , JPG , JPEG и GIF неиндексируемыми:

(png|jpe?g |gif)$"> Набор заголовков X-Robots-Tag "noindex"

Ваши мета-теги robots и X-Robots-Tags конфликтуют?

Проведите быструю проверку с помощью ContentKing и узнайте, не загоняете ли вы Google в штопор!

Настройка X-Robots-Tag на nginx

Тем временем на веб-сервере nginx вам необходимо отредактировать файл .conf сайта.Чтобы удалить все файлы PDF из индексов поисковых систем по всему сайту, используйте это:

location ~* \.pdf$ {

add_header X-Robots-Tag "noindex, nofollow";

} А чтобы не индексировать изображения, используйте это:

location ~* \.(png|jpe?g|gif)$ {

add_header X-Robots-Tag "noindex";

} Обратите внимание, что изменение конфигурации вашего веб-сервера может негативно повлиять на эффективность SEO всего вашего сайта. Если вы не хотите вносить изменения в конфигурацию вашего веб-сервера, лучше оставить эти изменения администратору вашего сервера.

В связи с этим мы настоятельно рекомендуем отслеживать ваши сайты с помощью ContentKing. Наша платформа немедленно помечает любые изменения, чтобы вы могли отменить изменения, прежде чем они окажут негативное влияние на вашу эффективность SEO.

Наша платформа немедленно помечает любые изменения, чтобы вы могли отменить изменения, прежде чем они окажут негативное влияние на вашу эффективность SEO.

Полезные ресурсы

- Объяснение кодов состояния HTTP

Рекомендации SEO для директив роботов

Придерживайтесь следующих рекомендаций по директивам роботов:

- Избегайте конфликтов директив роботов 9 0044: избегайте использования как мета-роботов, так и X-роботов. - Директивы тегов, чтобы сигнализировать о ваших предпочтениях сканирования и индексации ваших страниц, так как легко ошибиться и отправить противоречивые инструкции. Однако можно использовать метадирективы роботов на страницах и X-Robots-Tag для изображений и PDF-файлов — просто убедитесь, что вы не используете оба метода доставки инструкций директив роботов в один и тот же файл.

- Не запрещать контент с помощью важных директив для роботов : если вы запретите контент с помощью файла robots.

txt, поисковые системы не смогут определить предпочтительные директивы для роботов этого контента. Скажем, например, вы применяете директиву

txt, поисковые системы не смогут определить предпочтительные директивы для роботов этого контента. Скажем, например, вы применяете директиву noindexк странице и переходите кзапретудоступа к той же странице. Поисковые системы не смогут увидетьnoindexи могут еще долго держать страницу в своем индексе. - Не сочетать директиву noindex с каноническим URL-адресом : страница, имеющая как директиву

noindex, так и каноническую ссылку на другую страницу, сбивает с толку поисковые системы. В редких случаях это приводит к переносуnoindexна каноническую цель. Узнать больше. - Не применяйте директиву noindex к страницам с разбивкой на страницы : поскольку поисковые системы (особенно Google) хорошо понимают страницы с разбивкой на страницы, они относятся к ним по-разному и не будут рассматривать их как дублированный контент. И имейте в виду, что на практике со временем 9Директива 0039 noindex становится директивой

noindex,nofollow, закрывая дверь на пути обнаружения контента, на который ссылаются страницы с разбивкой на страницы. Узнать больше.

Узнать больше. - Нет hreflang для страниц с noindex :

hreflangсообщает поисковым системам, какие варианты контента доступны для разных аудиторий, посылая сигнал о том, что их необходимо проиндексировать. Поэтому избегайте ссылок на страницы с директивойnoindex. - Не включать страницы без индекса в карту сайта XML : страницы, которые не должны быть проиндексированы, также не должны быть включены в вашу XML-карту сайта, поскольку XML-карта сайта используется для того, чтобы сигнализировать поисковым системам, какие страницы они должны сканировать и индексировать.

Meta robots vs X-Robots-Tag vs Robots.txt

Директивы Meta robots, X-Robots-Tag и robots.txt имеют свои уникальные применения. Подводя итог тому, что мы уже рассмотрели, вот для чего их можно использовать:

Мета-роботы | X-Robots-Tag | Robots. | |

|---|---|---|---|

Используется в файлах HTML | Любой файл | Любой файл | |

Объем | На страницу | Без ограничений | Без ограничений |

Сканирование влияний | nofollow | nofollow | |

Индексация влияний | * | ||

Объединяет сигналы 900 44 |

* Контент, запрещенный в файле robots.txt, обычно не индексируется. Но в редких случаях это все же может случиться.

Поддержка в разных поисковых системах

В разных поисковых системах может различаться не только интерпретация конфликтующих директив для роботов. Поддерживаемые директивы и поддержка их метода доставки (HTML или HTTP-заголовок) также могут различаться. Если ячейка в приведенной ниже таблице отмечена зеленой галочкой (✅ ), поддерживаются реализации как HTML, так и HTTP-заголовка. Если есть красный крестик (❌ ), ни один из них не поддерживается. Если поддерживается только один, это объясняется.

Поддерживаемые директивы и поддержка их метода доставки (HTML или HTTP-заголовок) также могут различаться. Если ячейка в приведенной ниже таблице отмечена зеленой галочкой (✅ ), поддерживаются реализации как HTML, так и HTTP-заголовка. Если есть красный крестик (❌ ), ни один из них не поддерживается. Если поддерживается только один, это объясняется.

Директива | Bing/Yahoo | Яндекс | |

|---|---|---|---|

все | Только мета роботы | 90 713||

индекс | Только метароботы | ||

следовать 9 0722 | Только метароботы | ||

noindex | |||

| 9 0002 nofollow | |||

нет | |||

без архива | |||

nosnippet | |||

А теперь к менее важным:

9004 3 Директива | Bing/Yahoo | Яндекс | |

|---|---|---|---|

недоступен_после | 90 775 | ||

индекс индекса изображения | |||

max-image-preview | |||

notranslate | 9 0775 |

Полезные ресурсы

- Документация Google

- Документация Bing

- Документация Yandex

Подведение итогов и переход

Надежное техническое SEO направлено на отправку поисковым системам правильных сигналов. И директива о мета-роботах — лишь один из таких сигналов.

И директива о мета-роботах — лишь один из таких сигналов.

Итак, продолжайте учиться управлять поисковыми системами с помощью нашего руководства по управлению сканированием и индексированием!

Поделиться этой статьей спросил

Изменено 5 лет, 10 месяцев назад

Просмотрено 4к раз

Я получил сообщение в Инструментах Google для веб-мастеров о том, что "бот Googlebot обнаружил чрезвычайно большое количество URL-адресов на вашем сайте" с длинным списком примеров URL-адресов.

Для некоторых из перечисленных страниц ничто не мешало их индексации. Однако для некоторых URL-адресов у меня есть метатегов «noindex, nofollow» следующим образом:

Я читал, что Google иногда индексирует страницы, которые вы заблокировали в robots. txt, если находит другую ссылку, указывающую на страницу, но якобы они соблюдают метатеги?

txt, если находит другую ссылку, указывающую на страницу, но якобы они соблюдают метатеги?

- seo

- google-search-console

- search-engines

- robots.txt

- noindex

индексирование и даже блокировка через роботов не обязательно означает, что контент не будет не сканируются, на самом деле эти страницы все еще могут быть проиндексированы, но скорее скрыты от общедоступных результатов поиска (да, Google капризничает, но это правда). Вы видите, что при использовании noindex на странице Google должен просканировать страницу, чтобы найти этот тег, Googlebot не просто обрабатывает одну строку за раз, а затем останавливается, когда он натыкается на этот тег, он загружает всю страницу, поэтому, скорее всего, сообщается в Инструментах Google для веб-мастеров.

Таким образом, вы можете видеть эти страницы в Инструментах для веб-мастеров, но это не значит, что они включены в фактические результаты поиска, просто введите site:yourdomain. в поиске Google и посмотрите, найдены ли эти страницы, что я подозреваю. это не так, или каким-то образом тег был проигнорирован. com

com

Google фактически рекомендует использовать как метаимя, так и роботов для блокировки контента, доступного в общедоступных результатах поиска. Также вам не нужно использовать botname в мета-имени и простой "роботы" должны помочь.

Ваше метаимя должно выглядеть так:

И вы должны сделать robots.txt вот так

User-agent: * Запретить: /имя папки/2

Сообщение Инструментов для веб-мастеров "Бот Googlebot обнаружил очень большое количество URL-адресов на вашем сайте" означает, что робот Googlebot нашел эти URL-адреса и сканирует их. В Google есть URL-адрес, который немного объясняет это и показывает примеры, такие как «страницы календаря», которые продолжаются вечно.

С помощью своего метатега вы просто говорите Google прочитать страницу и выбросить содержимое перейти по всем ссылкам на этой странице. Если вы не хотите, чтобы Google переходил по этим ссылкам, вы должны вместо этого использовать

Если вы не хотите, чтобы Google переходил по этим ссылкам, вы должны вместо этого использовать nofollow .

Установка запрета в robots.txt предотвратит доступ бота к вашему сайту, но не сохранит ваши (связанные) страницы в поисковом индексе.

Похоже, это должно быть правильно, согласно инструкциям от Google. Несколько предложений:

Убедитесь, что метатеги находятся внутри тега

Убедитесь, что метатеги действительно говорят «noindex, nofollow» (ваш код говорит «noindex, follow» — не уверен, что это просто ошибка копирования)

Используйте стандартный

Подождите, пока Google снова просканирует ваши страницы, если вы только недавно добавили/изменили метатеги, или используйте запрос на удаление URL-адресов, чтобы попытаться ускорить удаление некоторых URL-адресов.

Не добавляйте nofollow в ваш noindex, так как вы хотите, чтобы PageRank нормально проходил через эти страницы к другим; вы просто не хотите, чтобы они индексировались.

Поэтому на страницах, которые вы не хотите индексировать, просто добавьте в раздел .

Обязательно удалите исключения robots.txt , так как при их наличии метаданные не будут видны, а страницы не будут удалены.

Альтернативный, немного более запутанный метод

Дата должна быть указана в широко распространенном формате, таком как, например, ISO 8601. Директива игнорируется, если не указаны допустимые дата/время. По умолчанию срок действия контента не ограничен. Это в основном таймер

Дата должна быть указана в широко распространенном формате, таком как, например, ISO 8601. Директива игнорируется, если не указаны допустимые дата/время. По умолчанию срок действия контента не ограничен. Это в основном таймер

txt, поисковые системы не смогут определить предпочтительные директивы для роботов этого контента. Скажем, например, вы применяете директиву

txt, поисковые системы не смогут определить предпочтительные директивы для роботов этого контента. Скажем, например, вы применяете директиву  Узнать больше.

Узнать больше. txt

txt