UTF-8 — Википедия

Материал из Википедии — свободной энциклопедии

(перенаправлено с «Utf-8»)Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 8 июля 2019; проверки требуют 23 правки. Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 8 июля 2019; проверки требуют 23 правки.

UTF-8 от англ. Unicode Transformation Format, 8-bit — «формат преобразования Юникода, 8-бит») — распространённый стандарт кодирования символов, позволяющий более компактно хранить и передавать символы Юникода, используя переменное количество байт (от 1 до 4), и обеспечивающий полную обратную совместимость с 7-битной кодировкой ASCII. Стандарт UTF-8 официально закреплён в документах RFC 3629 и ISO/IEC 10646 Annex D.

Кодировка UTF-8 сейчас является доминирующей в веб-пространстве. Она также нашла широкое применение в UNIX-подобных операционных системах[1].

Формат UTF-8 был разработан 2 сентября 1992 года Кеном Томпсоном и Робом Пайком, и реализован в Plan 9

UTF-8, по сравнению с UTF-16, наибольший выигрыш в компактности даёт для текстов на латинице, поскольку латинские буквы без диакритических знаков, цифры и наиболее распространённые знаки препинания кодируются в UTF-8 лишь одним байтом, и коды этих символов соответствуют их кодам в ASCII.[4][5]

Алгоритм кодирования в UTF-8 стандартизирован в RFC 3629 и состоит из 3 этапов:

1. Определить количество октетов (байтов), требуемых для кодирования символа. Номер символа берётся из стандарта Юникода.

| Диапазон номеров символов | Требуемое количество октетов |

|---|---|

00000000-0000007F | 1 |

00000080-000007FF | 2 |

00000800-0000FFFF | 3 |

00010000-0010FFFF | 4 |

Для символов Юникода с номерами от U+0000 до U+007F (занимающими один байт c нулём в старшем бите) кодировка UTF-8 полностью соответствует 7-битной кодировке US-ASCII.

2. Установить старшие биты первого октета в соответствии с необходимым количеством октетов, определённом на первом этапе:

- 0xxxxxxx — если для кодирования потребуется один октет;

- 110xxxxx — если для кодирования потребуется два октета;

- 1110xxxx — если для кодирования потребуется три октета;

- 11110xxx — если для кодирования потребуется четыре октета.

Если для кодирования требуется больше одного октета, то в октетах 2-4 два старших бита всегда устанавливаются равными 102 (10xxxxxx). Это позволяет легко отличать первый октет в потоке, потому что его старшие биты никогда не равны 102.

| Количество октетов | Значащих бит | Шаблон |

|---|---|---|

| 1 | 7 | 0xxxxxxx |

| 2 | 11 | 110xxxxx 10xxxxxx |

| 3 | 16 | 1110xxxx 10xxxxxx 10xxxxxx |

| 4 | 21 | 11110xxx 10xxxxxx 10xxxxxx 10xxxxxx |

3. Установить значащие биты октетов в соответствии с номером символа Юникода, выраженном в двоичном виде. Начать заполнение с младших битов номера символа, поставив их в младшие биты последнего октета, продолжить справа налево до первого октета. Свободные биты первого октета, оставшиеся незадействованными, заполнить нулями.

Примеры кодирования[править | править код]

| Символ | Двоичный код символа | UTF-8 в двоичном виде | UTF-8 в шестнадцатеричном виде | |

|---|---|---|---|---|

| $ | U+0024 | 100100 | 00100100 | 24 |

| ¢ | U+00A2 | 10100010 | 11000010 10100010 | C2 A2 |

| € | U+20AC | 100000 10101100 | 11100010 10000010 10101100 | E2 82 AC |

| 𐍈 | U+10348 | 1 00000011 01001000 | 11110000 10010000 10001101 10001000 | F0 90 8D 88 |

Для указания, что файл или поток содержит символы Юникода, в начале файла или потока может быть вставлен маркер последовательности байтов (англ. Byte order mark, BOM), который в случае кодирования в UTF-8 принимает форму трёх байтов: EF BB BF16.

Изначально кодировка UTF-8 допускала использование до шести байтов для кодирования одного символа, однако в ноябре 2003 года стандарт RFC 3629 запретил использование пятого и шестого байтов, а диапазон кодируемых символов был ограничен символом

Кодирование и декодирование / Habr

Причиной разобраться в том, как же работает UTF-8 и что такое Юникод заставил тот факт, что VBScript не имеет встроенных функций работы с UTF-8. А так как ничего рабочего не нашел, то пришлось писть/дописывать самому. Опыт на мой взгляд полезный в любом случае. Для лучшего понимания начну с теории.О Юникоде

До появления Юникода широко использовались 8-битные кодировки, главные минусы которых очевидны:

- Всего 255 символов, да и то часть из них не графические;

- Возможность открыть документ не с той кодировкой, в которой он был создан;

- Шрифты необходимо создавать для каждой кодировки.

Так и было решено создать единый стандарт «широкой» кодировки, которая включала бы все символы (при чем сначала хотели в нее включить только обычные символы, но потом передумали и начали добавлять и экзотические). Юникод использует 1 112 064 кодовых позиций (больше чем 16 бит). Начало дублирует ASCII, а дальше остаток латиницы, кирилица, другие европейские и азиатские символы. Для обозначений символов используют шестнадцатеричную запись вида «U+xxxx» для первых 65k и с большим количеством цифр для остальных.

О UTF-8

Когда-то я думал что есть Юникод, а есть UTF-8. Позже я узнал, что ошибался.

UTF-8 является лишь представлением Юникода в 8-битном виде. Символы с кодами меньше 128 представляются одним байтом, а так как в Юникоде они повторяют ASCII, то текст написанный только этими символами будет являться текстом в ASCII. Символы же с кодами от 128 кодируются 2-мя байтами, с кодами от 2048 — 3-мя, от 65536 — 4-мя. Так можно было бы и до 6-ти байт дойти, но кодировать ими уже ничего.

0x00000000 — 0x0000007F: 0xxxxxxx 0x00000080 — 0x000007FF: 110xxxxx 10xxxxxx 0x00000800 — 0x0000FFFF: 1110xxxx 10xxxxxx 10xxxxxx 0x00010000 — 0x001FFFFF: 11110xxx 10xxxxxx 10xxxxxx 10xxxxxx

Кодируем в UTF-8

Порядок действий примерно такой:

- Каждый символ превращаем в Юникод.

- Проверяем из какого символ диапазона.

- Если код символа меньше 128, то к результату добавляем его в неизменном виде.

- Похожим образом можем продолжить и для больших кодов, но если символ за пределами U+FFFF придется иметь дело с UTF-16 суррогатами.

Function EncodeUTF8(s)

Dim i, c, utfc, b1, b2, b3

For i=1 to Len(s)

c = ToLong(AscW(Mid(s,i,1)))

If c < 128 Then

utfc = chr( c)

ElseIf c < 2048 Then

b1 = c Mod &h50

b2 = (c - b1) / &h50

utfc = chr(&hC0 + b2) & chr(&h80 + b1)

ElseIf c < 65536 And (c < 55296 Or c > 57343) Then

b1 = c Mod &h50

b2 = ((c - b1) / &h50) Mod &h50

b3 = (c - b1 - (&h50 * b2)) / &h2000

utfc = chr(&hE0 + b3) & chr(&h80 + b2) & chr(&h80 + b1)

Else

' Младший или старший суррогат UTF-16

utfc = Chr(&hEF) & Chr(&hBF) & Chr(&hBD)

End If

EncodeUTF8 = EncodeUTF8 + utfc

Next

End Function

Function ToLong(intVal)

If intVal < 0 Then

ToLong = CLng(intVal) + &h20000

Else

ToLong = CLng(intVal)

End If

End Function

Декодируем UTF-8

- Ищем первый символ вида 11xxxxxx

- Считаем все последующие байты вида 10xxxxxx

- Если последовательность из двух байт и первый байт вида 110xxxxx, то отсекаем приставки и складываем, умножив первый байт на 0x40.

- Аналогично для более длинных последовательностей.

- Заменяем всю последовательность на нужный символ Юникода.

Function DecodeUTF8(s) Dim i, c, n, b1, b2, b3 i = 1 Do While i <= len(s) c = asc(mid(s,i,1)) If (c and &hC0) = &hC0 Then n = 1 Do While i + n <= len(s) If (asc(mid(s,i+n,1)) and &hC0) <> &h80 Then Exit Do End If n = n + 1 Loop If n = 2 and ((c and &hE0) = &hC0) Then b1 = asc(mid(s,i+1,1)) and &h4F b2 = c and &h2F c = b1 + b2 * &h50 Elseif n = 3 and ((c and &hF0) = &hE0) Then b1 = asc(mid(s,i+2,1)) and &h4F b2 = asc(mid(s,i+1,1)) and &h4F b3 = c and &h0F c = b3 * &h2000 + b2 * &h50 + b1 Else ' Символ больше U+FFFF или неправильная последовательность c = &hFFFD End if s = left(s,i-1) + chrw( c) + mid(s,i+n) Elseif (c and &hC0) = &h80 then ' Неожидаемый продолжающий байт s = left(s,i-1) + chrw(&hFFFD) + mid(s,i+1) End If i = i + 1 Loop DecodeUTF8 = s End Function

Ссылки

Юникод на Википедии

Исходник для ASP+VBScript

UPD: Обработка ошибочных последовательностей и ошибка с типом Integer, который возвращает AscW.

Как открыть файл UTF8? Расширение файла .UTF8

Что такое файл UTF8?

Полное имя формата файлов, которые используют расширение UTF8: Unicode UTF8-Encoded Text Document. Формат файла UTF8 совместим с программным обеспечением, которое может быть установлено на системной платформе Linux, Mac OS, Windows. UTF8 файл относится к категории Текстовые файлы так же, как #NUMEXTENSIONS # других расширений файлов, перечисленных в нашей базе данных. Пользователям рекомендуется использовать Windows Notepad программное обеспечение для управления UTF8 файлами, хотя 8 другие программы также могут обрабатывать этот тип файлов. Программное обеспечение с именем Windows Notepad было создано Microsoft Corporation. Чтобы найти более подробную информацию о программном обеспечении и UTF8 файлах, посетите официальный сайт разработчика.

Программы, которые поддерживают UTF8 расширение файла

Ниже вы найдете указатель программ, которые можно использовать для открытия файлов UTF8, разделенных на категории 3 в соответствии с поддерживаемой системной платформой. UTF8 файлы можно встретить на всех системных платформах, включая мобильные, но нет гарантии, что каждый из них будет должным образом поддерживать такие файлы.

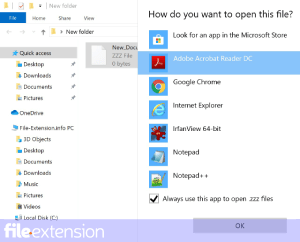

Как открыть файл UTF8?

Проблемы с доступом к UTF8 могут быть вызваны разными причинами. К счастью, наиболее распространенные проблемы с файлами UTF8 могут быть решены без глубоких знаний в области ИТ, а главное, за считанные минуты. Приведенный ниже список проведет вас через процесс решения возникшей проблемы.

Шаг 1. Скачайте и установите Windows Notepad

Основная и наиболее частая причина, препятствующая открытию пользователями файлов UTF8, заключается в том, что в системе пользователя не установлена программа, которая может обрабатывать файлы UTF8. Наиболее очевидным решением является загрузка и установка Windows Notepad или одной из перечисленных программ: TextEdit, Microsoft Word, WordPad. В верхней части страницы находится список всех программ, сгруппированных по поддерживаемым операционным системам. Одним из наиболее безопасных способов загрузки программного обеспечения является использование ссылок официальных дистрибьюторов. Посетите сайт Windows Notepad и загрузите установщик.

Основная и наиболее частая причина, препятствующая открытию пользователями файлов UTF8, заключается в том, что в системе пользователя не установлена программа, которая может обрабатывать файлы UTF8. Наиболее очевидным решением является загрузка и установка Windows Notepad или одной из перечисленных программ: TextEdit, Microsoft Word, WordPad. В верхней части страницы находится список всех программ, сгруппированных по поддерживаемым операционным системам. Одним из наиболее безопасных способов загрузки программного обеспечения является использование ссылок официальных дистрибьюторов. Посетите сайт Windows Notepad и загрузите установщик.

Шаг 2. Обновите Windows Notepad до последней версии

Если проблемы с открытием файлов UTF8 по-прежнему возникают даже после установки Windows Notepad, возможно, у вас устаревшая версия программного обеспечения. Проверьте веб-сайт разработчика, доступна ли более новая версия Windows Notepad. Разработчики программного обеспечения могут реализовать поддержку более современных форматов файлов в обновленных версиях своих продуктов. Причиной того, что Windows Notepad не может обрабатывать файлы с UTF8, может быть то, что программное обеспечение устарело. Последняя версия Windows Notepad должна поддерживать все форматы файлов, которые совместимы со старыми версиями программного обеспечения.

Если проблемы с открытием файлов UTF8 по-прежнему возникают даже после установки Windows Notepad, возможно, у вас устаревшая версия программного обеспечения. Проверьте веб-сайт разработчика, доступна ли более новая версия Windows Notepad. Разработчики программного обеспечения могут реализовать поддержку более современных форматов файлов в обновленных версиях своих продуктов. Причиной того, что Windows Notepad не может обрабатывать файлы с UTF8, может быть то, что программное обеспечение устарело. Последняя версия Windows Notepad должна поддерживать все форматы файлов, которые совместимы со старыми версиями программного обеспечения.

Шаг 3. Назначьте Windows Notepad для UTF8 файлов

После установки Windows Notepad (самой последней версии) убедитесь, что он установлен в качестве приложения по умолчанию для открытия UTF8 файлов. Следующий шаг не должен создавать проблем. Процедура проста и в значительной степени не зависит от системы

Выбор приложения первого выбора в Windows

- Выберите пункт Открыть с помощью в меню «Файл», к которому можно щелкнуть правой кнопкой мыши файл UTF8.

- Нажмите Выбрать другое приложение и затем выберите опцию Еще приложения

- Наконец, выберите Найти другое приложение на этом… , укажите папку, в которой установлен Windows Notepad, установите флажок Всегда использовать это приложение для открытия UTF8 файлы свой выбор, нажав кнопку ОК

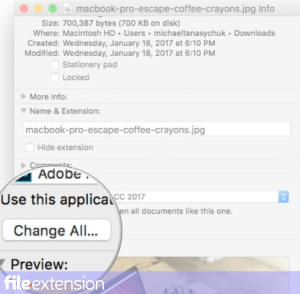

Выбор приложения первого выбора в Mac OS

- Щелкните правой кнопкой мыши на файле UTF8 и выберите Информация.

- Откройте раздел Открыть с помощью, щелкнув его название

- Выберите из списка соответствующую программу и подтвердите, нажав « Изменить для всех» .

- Наконец, это изменение будет применено ко всем файлам с расширением UTF8 должно появиться сообщение. Нажмите кнопку Вперед, чтобы подтвердить свой выбор.

Шаг 4. Проверьте UTF8 на наличие ошибок

Вы внимательно следили за шагами, перечисленными в пунктах 1-3, но проблема все еще присутствует? Вы должны проверить, является ли файл правильным UTF8 файлом. Вероятно, файл поврежден и, следовательно, недоступен.

1. Убедитесь, что UTF8 не заражен компьютерным вирусом

Если случится так, что UTF8 инфицирован вирусом, это может быть причиной, которая мешает вам получить к нему доступ. Сканируйте файл UTF8 и ваш компьютер на наличие вредоносных программ или вирусов. UTF8 файл инфицирован вредоносным ПО? Следуйте инструкциям антивирусного программного обеспечения.

2. Убедитесь, что файл с расширением UTF8 завершен и не содержит ошибок

Если файл UTF8 был отправлен вам кем-то другим, попросите этого человека отправить вам файл. Возможно, файл был ошибочно скопирован, а данные потеряли целостность, что исключает доступ к файлу. При загрузке файла с расширением UTF8 из Интернета может произойти ошибка, приводящая к неполному файлу. Попробуйте загрузить файл еще раз.

3. Убедитесь, что у вас есть соответствующие права доступа

Иногда для доступа к файлам пользователю необходимы права администратора. Войдите в систему, используя учетную запись администратора, и посмотрите, решит ли это проблему.

4. Проверьте, может ли ваша система обрабатывать Windows Notepad

Если система перегружена, она может не справиться с программой, которую вы используете для открытия файлов с расширением UTF8. В этом случае закройте другие приложения.

5. Проверьте, есть ли у вас последние обновления операционной системы и драйверов

Последние версии программ и драйверов могут помочь вам решить проблемы с файлами Unicode UTF8-Encoded Text Document и обеспечить безопасность вашего устройства и операционной системы. Устаревшие драйверы или программное обеспечение могли привести к невозможности использования периферийного устройства, необходимого для обработки файлов UTF8.

8 — это… Что такое UTF-8?

UTF-8 (от англ. Unicode Transformation Format, 8-bit — «формат преобразования Юникода, 8-битный») — распространённая кодировка символов Юникода, совместимая с 8-битными форматами передачи текста. Нашла широкое применение в операционных системах и веб-пространстве[1].

В отличие от UTF-16, UTF-8 является самосинхронизирующейся кодировкой (англ.): при потере одного байта последующие байты будут раскодированы корректно.

Текст, состоящий только из символов Юникода с номерами меньше 128, при записи в UTF-8 превращается в обычный текст ASCII. И наоборот, в тексте UTF-8 любой байт со значением меньше 128 изображает символ ASCII с тем же кодом. Остальные символы Юникода изображаются последовательностями длиной от 2 до 6 байт (реально только до 4 байт, поскольку использование кодов больше 221 не планируется), в которых первый байт всегда имеет вид 11xxxxxx, а остальные — 10xxxxxx.

Проще говоря, в формате UTF-8 символы латинского алфавита, знаки препинания и управляющие символы ASCII записываются кодами US-ASCII, a все остальные символы кодируются при помощи нескольких байтов со старшим битом 1. Это приводит к двум эффектам.

- Даже если программа не распознаёт Юникод, то латинские буквы, арабские цифры и знаки препинания будут отображаться правильно.

- В случае, если латинские буквы и простейшие знаки препинания (включая пробел) занимают существенный объём текста, UTF-8 даёт выигрыш по объёму по сравнению с UTF-16.[2][3]

На первый взгляд может показаться, что UTF-16 удобнее, так как в ней большинство символов кодируется ровно двумя байтами.

Однако это сводится на нет необходимостью поддержки суррогатных пар, о которых часто забывают при использовании UTF-16, реализуя лишь поддержку символов UCS-2.[2]

Формат UTF-8 был изобретён 2 сентября 1992 года Кеном Томпсоном и Робом Пайком и реализован в Plan 9.[4] Сейчас стандарт UTF-8 официально закреплён в документах RFC 3629 и ISO/IEC 10646 Annex D.

Замечание: Символы, закодированные в UTF-8, могут быть длиной до шести байт, однако стандарт Unicode не определяет символов выше 0x10ffff, поэтому символы Unicode могут иметь максимальный размер в 4 байта в UTF-8.

Принцип кодирования

Текстовое описание

В UTF-8 можно кодировать значения кодов символов от 0 до 7FFFFFFF16 включительно (все комбинации 32-битных без установленного старшего бита).

Каждый символ кодируется переменным количеством последовательных 8-битных байт (октетов). Количество же может варьироваться от 1 до 6 байт включительно и определяется самым первым байтом.

Все ASCII-символы (от 0 до 127 (000000002 — 011111112 или 0016 — 7F16) включительно) записываются как есть одним байтом со сброшенным старшим битом.

Все остальные символы кодируются уже особым образом и далее текст этого раздела касается только их. Чтобы лучше понять принцип, лучше представляйте себе блоки бит с их позицией.

У байт не ASCII-символов старший бит всегда установлен в 1. При этом второй с конца бит всегда сброшен у не первых байт (у первых, соответственно, установлен). Поэтому если чтение производится с произвольного байта, то по второму биту можно определять промежуточные байты.

И у не первых байт остальные 6 младших бит содержат фрагмент кода символа (об этом ниже).

Количество байт, которое отводится под символ, всегда равно количеству идущих подряд старших бит со значением 1 в первом байте. Эти биты всегда завершаются битом со значением 0. Оставшиеся младшие биты первого байта составляют код символа. Отсюда обуславливается ограничение в 6 байт на символ — если выше, то в первом байте уже не хватит места под биты данных. Поэтому последовательности бит 111111102 (FE16) и 111111112 (FF16) общепринято считаются не используемыми в UTF-8.

До этого описывалась структура, а теперь про расположение данных.

Как видно из описания выше, каждый байт имеет определённое количество младших бит под данные — переменное у первого и по 6 в последующих. 32-битный код символа последовательно размещается в этих контейнерах. Старшие биты оказываются в первых байтах, а младшие — в последних. Поэтому младшие 6 бит последнего байта всегда содержат биты 0..5 кода символа. Аналогично, предпоследний байт содержат биты 6..11, третий с конца — 12..17, четвёртый — 18..23, пятый — 24..29. Первый байт же содержит оставшиеся старшие биты значения.

Зная структуру и расположение данных внутри байт, теперь рассмотрим взаимосвязь кода символа и количества байт.

Каждое количество байт способно хранить конкретный диапазон значений кода символа. При этом сами диапазоны значений расположены плотно по порядку без всяких просветов. Проиллюстрируем это соответствующей таблицей:

| Коды символов Unicode (HEX) | Размер в UTF-8 | Представленные классы символов |

|---|---|---|

00000000 — 0000007F | 1 байт | ASCII, в том числе латинский алфавит, простейшие знаки препинания и арабские цифры |

00000080 — 000007FF | 2 байта | кириллица, расширенная латиница, арабский, армянский, греческий, еврейский и коптский алфавит; сирийское письмо, тана, нко; МФА; некоторые знаки препинания |

00000800 — 0000FFFF | 3 байта | все другие современные формы письменности, в том числе грузинский алфавит, индийское, китайское, корейское и японское письмо; сложные знаки препинания; математические и другие специальные символы |

00010000 — 001FFFFF | 4 байта | музыкальные символы, редкие китайские иероглифы, вымершие формы письменности |

00200000 — 03FFFFFF | 5 байт | не используется в Unicode |

04000000 — 7FFFFFFF | 6 байт | не используется в Unicode |

Следует отметить, что данная таблица подразумевает плотное кодирование и поэтому она представляет только идеальные комбинации.

Кодировка UTF-8 не является однозначной, так как в ней учитывается размер бит значения без учёта позиции последнего установленного бита. Поэтому возможно написание «грубого» кодировщика, который не отбрасывает лидирующие нули. Например, ASCII-символ «1» (код 001100012 (3116)), может быть представлен следующими двухбайтовыми и трёхбайтовыми последовательностями: 110000002 101100012 (C016 B116) и 111000002 100000002 101100012 (E016 8016 B116). Отсюда выходят следующие бессмыленные битовые комбинации первых байт: 110000002 (C016), 111000002 (E016), 111100002 (F016), 111110002 (F816), 111111002 (FC16), а также последующие за ними комбинации промежуточных байт 100000002 (8016).

Графическое представление

Кодировка UTF-8 использует значения конкретных битов и учитывает расположение битовых блоков. Поэтому она может быть полноценно проиллюстрирована очевидным графическим образом. Если вам требуется быстро реализовать кодирование и раскодирование, то можете воспользоваться следующей схемой:

Максимальный потенциал

До этого рассматривалось кодирование в UTF-8 лишь 32-битных целых без отрицательных значений. Следует отметить, что в стандарте Unicode используются символы лишь до кода 001FFFFF16 включительно. Поэтому даже 32-битных значений может вполне хватить, но этот раздел был включён для полноты изложения в случае использования UTF-8 для кодирования несимвольных данных.

В первом байте количество установленных старших бит определяет количество байт на символ. Оставшиеся младшие биты хранят старшие биты значения кода символа. Мы можем сделать допущение о том, что первый байт не обязан содержать данные. При этом допускаем, что все биты за пределами байта равны нулю. Тогда данные будут содержать только 6 бит в последующих байтах. Получается 36 бит для семибайтового символа и 42 бита — для восьмибайтового.

Неиспользуемые значения байтов

В тексте UTF-8 принципиально не может быть байтов со значениями 254 (FE16) и 255 (FF16). Поскольку в Юникоде не определены символы с кодами выше 221, то в UTF-8 оказываются неиспользуемыми также значения байтов от 248 до 253 (F816 — FD16). Если запрещены искусственно удлинённые (за счёт добавления ведущих нулей) последовательности UTF-8, то не используются также байтовые значения 192 и 193 (C016 и C116).

BOM (сигнатура)

- См. так же полную статью «Byte order mark».

Многие программы Windows (включая Блокнот) добавляют байты EF16, BB16, BF16 в начале любого документа, сохраняемого как UTF-8. Это метка порядка байтов (англ. Byte Order Mark, BOM), также её часто называют сигнатурой (соответственно, UTF-8 и UTF-8 with Signature). По наличию сигнатуры программы могут автоматически определить, является ли файл закодированным в UTF-8, однако файлы с такой сигнатурой могут некорректно обрабатываться старыми программами, в частности xml-анализаторами. Такие редакторы, как Notepad++, Notepad2 и Kate, позволяют явно указывать, следует ли добавлять сигнатуру при сохранении UTF-файлов.

Например: В файле записана одна латинская буква «a».

- Если кодировка этого файла UTF-8 with Signature, то он будет содержать: EF16 BB16 BF16 6116

- Если кодировка этого файла UTF-8 (без сигнатуры), то он будет содержать: 6116

Если считывающая программа не поддерживает BOM, то эти три байта успешно раскодируются в один Unicode-символ FEFF16. Это не разрывающий слова пробел нулевой ширины и поэтому он может не отобразиться. Этот же символ используется в BOM для кодировок UTF-16 и UTF-32.

См. также

Примечания

Ссылки

UTF-8 — Википедия

Материал из Википедии — свободной энциклопедии

UTF-8 (от англ. Unicode Transformation Format, 8-bit — «формат преобразования Юникода, 8-бит») — распространённый стандарт кодирования текста, позволяющий более компактно хранить и передавать символы Юникода, используя переменное количество октетов (байтов) (от 1 до 4), и обеспечивающий полную обратную совместимость с 7-битной кодировкой ASCII. Стандарт UTF-8 официально закреплён в документах RFC 3629 и ISO/IEC 10646 Annex D. Кодировка UTF-8 сейчас является доминирующей в веб-пространстве. Она также нашла широкое применение в UNIX-подобных операционных системах[1]. Формат UTF-8 был разработан 2 сентября 1992 года Кеном Томпсоном и Робом Пайком, и реализован в Plan 9.[2]. Идентификатор кодировки в Windows – 65001[3]

Сравнивая UTF-8 и UTF-16, можно отметить, что наибольший выигрыш в компактности UTF-8 даёт для текстов на латинице, поскольку латинские буквы без диакритических знаков, цифры и наиболее распространённые знаки препинания кодируются в UTF-8 лишь одним октетом, и коды этих латинских букв, цифр и знаков препинания точно соответствуют их кодам в ASCII.[4][5]

Алгоритм кодирования

Алгоритм кодирования в UTF-8 стандартизирован в RFC 3629 и состоит из 3 этапов:

1. Определить количество октетов , требуемых для кодирования символа. Номер символа берётся из стандарта Юникод.

| Диапазон номеров символов | Требуемое количество октетов |

|---|---|

00000000-0000007F | 1 |

00000080-000007FF | 2 |

00000800-0000FFFF | 3 |

00010000-0010FFFF | 4 |

Для символов Юникода с номерами от U+0000 до U+007F (занимающими один октет c нулём в старшем бите) кодировка UTF-8 полностью соответствует 7-битной кодировке US-ASCII.

2. Установить старшие биты первого октета в соответствии с необходимым количеством октетов, определённом на первом этапе:

- 0xxxxxxx — если для кодирования потребуется один октет;

- 110xxxxx — если для кодирования потребуется два октета;

- 1110xxxx — если для кодирования потребуется три октета;

- 11110xxx — если для кодирования потребуется четыре октета.

Если для кодирования требуется больше одного октета, то в октетах 2-4 два старших бита всегда устанавливаются равными 102 (10xxxxxx). Это позволяет легко отличать первый октет в потоке, потому что его старшие биты никогда не равны 102.

| Количество октетов | Значащих бит | Шаблон |

|---|---|---|

| 1 | 7 | 0xxxxxxx |

| 2 | 11 | 110xxxxx 10xxxxxx |

| 3 | 16 | 1110xxxx 10xxxxxx 10xxxxxx |

| 4 | 21 | 11110xxx 10xxxxxx 10xxxxxx 10xxxxxx |

3. Установить значащие биты октетов в соответствии с номером символа Юникода, выраженном в двоичном виде. Начать заполнение с младших битов номера символа, поставив их в младшие биты последнего октета, продолжить справа налево до первого октета. Свободные биты первого октета, оставшиеся незадействованными, заполнить нулями.

Примеры кодирования

utf-8 Википедия

UTF-8 от англ. Unicode Transformation Format, 8-bit — «формат преобразования Юникода, 8-бит») — распространённый стандарт кодирования символов, позволяющий более компактно хранить и передавать символы Юникода, используя переменное количество байт (от 1 до 4), и обеспечивающий полную обратную совместимость с 7-битной кодировкой ASCII. Стандарт UTF-8 официально закреплён в документах RFC 3629 и ISO/IEC 10646 Annex D. Кодировка UTF-8 сейчас является доминирующей в веб-пространстве. Она также нашла широкое применение в UNIX-подобных операционных системах[1]. Формат UTF-8 был разработан 2 сентября 1992 года Кеном Томпсоном и Робом Пайком, и реализован в Plan 9[2]. Идентификатор кодировки в Windows – 65001[3].

UTF-8, по сравнению с UTF-16, наибольший выигрыш в компактности даёт для текстов на латинице, поскольку латинские буквы без диакритических знаков, цифры и наиболее распространённые знаки препинания кодируются в UTF-8 лишь одним байтом, и коды этих символов соответствуют их кодам в ASCII.[4][5]

Алгоритм кодирования

Алгоритм кодирования в UTF-8 стандартизирован в RFC 3629 и состоит из 3 этапов:

1. Определить количество октетов (байтов), требуемых для кодирования символа. Номер символа берётся из стандарта Юникода.

| Диапазон номеров символов | Требуемое количество октетов |

|---|---|

00000000-0000007F | 1 |

00000080-000007FF | 2 |

00000800-0000FFFF | 3 |

00010000-0010FFFF | 4 |

Для символов Юникода с номерами от U+0000 до U+007F (занимающими один байт c нулём в старшем бите) кодировка UTF-8 полностью соответствует 7-битной кодировке US-ASCII.

2. Установить старшие биты первого октета в соответствии с необходимым количеством октетов, определённом на первом этапе:

- 0xxxxxxx — если для кодирования потребуется один октет;

- 110xxxxx — если для кодирования потребуется два октета;

- 1110xxxx — если для кодирования потребуется три октета;

- 11110xxx — если для кодирования потребуется четыре октета.

Если для кодирования требуется больше одного октета, то в октетах 2-4 два старших бита всегда устанавливаются равными 102 (10xxxxxx). Это позволяет легко отличать первый октет в потоке, потому что его старшие биты никогда не равны 102.

| Количество октетов | Значащих бит | Шаблон |

|---|---|---|

| 1 | 7 | 0xxxxxxx |

| 2 | 11 | 110xxxxx 10xxxxxx |

| 3 | 16 | 1110xxxx 10xxxxxx 10xxxxxx |

| 4 | 21 | 11110xxx 10xxxxxx 10xxxxxx 10xxxxxx |

3. Установить значащие биты октетов в соответствии с номером символа Юникода, выраженном в двоичном виде. Начать заполнение с младших битов номера символа, поставив их в младшие биты последнего октета, продолжить справа налево до первого октета. Свободные биты первого октета, оставшиеся незадействованными, заполнить нулями.

Примеры кодирования

| Символ | Двоичный код символа | UTF-8 в двоичном виде | UTF-8 в шестнадцатеричном виде | |

|---|---|---|---|---|

| $ | U+0024 | 100100 | 00100100 | 24 |

| ¢ | U+00A2 | 10100010 | 11000010 10100010 | C2 A2 |

| € | U+20AC | 100000 10101100 | 11100010 10000010 10101100 | E2 82 AC |

| 𐍈 | U+10348 | 1 00000011 01001000 | 11110000 10010000 10001101 10001000 | F0 90 8D 88 |

Маркер UTF-8

Для указания, что файл или поток содержит символы Юникода, в начале файла или потока может быть вставлен маркер последовательности байтов (англ. Byte order mark, BOM), который в случае кодирования в UTF-8 принимает форму трёх байтов: EF BB BF16.

Пятый и шестой байты

Изначально кодировка UTF-8 допускала использование до шести байтов для кодирования одного символа, однако в ноябре 2003 года стандарт RFC 3629 запретил использование пятого и шестого байтов, а диапазон кодируемых символов был ограничен символом U+10FFFF. Это было сделано для обеспечения совместимости с UTF-16.