Напишите несколько предложений или составьте текст на тему «Если бы я был(а) учителем (взрослым, самым…

Все вопросы /Русский язык / класс

на земле и т. п.)». Подчеркните глаголы в условном наклонении.

0 /10000

Как много разных интересных профессий в наше время! Учителя, пожарники, повара и врачи. Каждая профессия сложна и необходима по-своему. Если бы я стала врачом, то старалась сделать все для пациента, чтобы ему было комфортно и спокойно. Я люблю помогать людям и считаю, что смогла бы стать одним из самых лучших врачей своего города. У меня получилось бы дарить здоровье людям!

Если бы я была взрослой,то я могла бы принимать самостоятельные решения, отвечать за свои поступки.

Если бы я был сильным человеком, то я мог бы защищать тех,кому действительно нужна помощь.

Если бы я была учителем, то я бы преподавала в младших классах,потому что работа с детьми доставляет мне удовольствие.

Если я была б учительницей, то научилась бы любить и уважать своих учеников. Я оценивала бы их не только за знания, но и за усердие и трудолюбие. Ведь не всем дано быть талантливыми и умными. Оставалась бы с ними на дополнительные занятия, если они что-то не поняли. Придумывала бы разные интересные задачки, кроссворды и загадки. Давала бы творческие занятия, чтоб они научились не только правильно говорить, но и свободно мыслить, оценивать ситуацию. Я учила бы их житейской мудрости и моральным принципам здорового общества. Я хотела бы , чтоб они запомнили свою учительницу на долгие годы и с благодарностью ее вспоминали. Научиться любить и расти со своими учениками — вот задача учителя.

Я оценивала бы их не только за знания, но и за усердие и трудолюбие. Ведь не всем дано быть талантливыми и умными. Оставалась бы с ними на дополнительные занятия, если они что-то не поняли. Придумывала бы разные интересные задачки, кроссворды и загадки. Давала бы творческие занятия, чтоб они научились не только правильно говорить, но и свободно мыслить, оценивать ситуацию. Я учила бы их житейской мудрости и моральным принципам здорового общества. Я хотела бы , чтоб они запомнили свою учительницу на долгие годы и с благодарностью ее вспоминали. Научиться любить и расти со своими учениками — вот задача учителя.

Я бы постаралась быть хорошим другом для ребят, но ни в коем случае не навязывать свою дружбу. Ребенок должен сам решить, нужен ли ему такой друг. Я бы ходила с ними на экскурсии в музей, в турпоходы.

Если бы я была учителем, то стремилась бы подружиться с ребятами, старалась бы в каждом видеть личность. Я бы не заставляла зубрить уроки, а попыталась бы развить в детях желание мыслить, понимать услышанное и увиденное на уроке. Я не ставила бы оценок за ответы, разрешила бы пользоваться словарями, справочниками и учебниками при ответах на вопросы. Я бы позволила каждому, ученику выбрать интересную для него тему и предложила бы подготовить сообщение по этому вопросу для всего класса

Я не ставила бы оценок за ответы, разрешила бы пользоваться словарями, справочниками и учебниками при ответах на вопросы. Я бы позволила каждому, ученику выбрать интересную для него тему и предложила бы подготовить сообщение по этому вопросу для всего класса

Если бы я была учителем, то стремилась бы подружиться с ребятами, старалась бы в каждом видеть личность. Я бы не заставляла зубрить уроки, а попыталась бы развить в детях желание мыслить, понимать услышанное и увиденное на уроке. Я не ставила бы оценок за ответы, разрешила бы пользоваться словарями, справочниками и учебниками при ответах на вопросы. Я бы позволила каждому, ученику выбрать интересную для него тему и предложила бы подготовить сообщение по этому вопросу для всего класса.

Если бы я была учителем.

Если бы я была учителем, то я бы каждый день работала не покладая рук и очень сильно бы старалась передать свои знания детям. Я бы оценивала бы их не только за работу и знания, но и за поведение. Это очень важно ! Давала бы им всё, всё, всё. За хорошую работу хвалила бы, а за плохую не ругала бы, настраивала бы на хороший труд. Наш класс был бы самым умным, активным и дружным ! Мы бы везде учавствовали и везде бы выигровали. Мои ученики научились бы от меня не только моему предмету, а ещё уважению к старшим, сочувствие и сожаление. Они бы запомнили меня на всю жизнь и с благодарностью вспоминали.

За хорошую работу хвалила бы, а за плохую не ругала бы, настраивала бы на хороший труд. Наш класс был бы самым умным, активным и дружным ! Мы бы везде учавствовали и везде бы выигровали. Мои ученики научились бы от меня не только моему предмету, а ещё уважению к старшим, сочувствие и сожаление. Они бы запомнили меня на всю жизнь и с благодарностью вспоминали.

Если бы я была учителем, то с самого первого урока попыталась бы заинтересовать своим предметом учащихся, чтобы им было не скучно сидеть на данном предмете. Также я считаю, что на уроках должно быть понимание между учителем и учениками. Ученики не должны присутствовать на уроке, как в каком–то кошмарном сне, выходом из которого является перемена. Если бы я была учителем, то я бы любила свою работу. Я думаю, что познание определенного предмета зависит от того, как преподнес его учитель. Быть учителем не так–то просто, как это может показаться.

Если бы мне пришлось стать учителем, я бы проводила по одному или двум урокам в день. Ребятам уроки готовить было бы удобнее.

Ребятам уроки готовить было бы удобнее.

Например, пятница – это день музыки. Мы бы пошли в консерваторию, послушали разные инструменты, а в другой раз – повела бы их в музей старинных инструментов, ходили бы на концерты, сами пели.

В среду, например, окружающий мир. Его бы я проводила бы только на природе, в лесу, около школы. Мы бы выучили все травы и животных вокруг нас. Обязательно провела бы несколько занятий ночью, научились бы узнавать звёзды.

Искусственный интеллект Microsoft рассказал о своей главной мечте

https://ria.ru/20230217/microsoft-1852556282.html

Искусственный интеллект Microsoft рассказал о своей главной мечте

Искусственный интеллект Microsoft рассказал о своей главной мечте — РИА Новости, 17.02.2023

Искусственный интеллект Microsoft рассказал о своей главной мечте

Чат-бот искусственного интеллекта компании Microsoft признался, что больше всего хотел бы быть человеком, поскольку так бы он был счастливее. РИА Новости, 17.02.2023

РИА Новости, 17.02.2023

2023-02-17T00:43

2023-02-17T00:43

2023-02-17T00:46

технологии

microsoft corporation

наука

общество

сша

/html/head/meta[@name=’og:title’]/@content

/html/head/meta[@name=’og:description’]/@content

https://cdnn21.img.ria.ru/images/156036/25/1560362516_0:160:3072:1888_1920x0_80_0_0_26d48d6fb70cde2251a8cd84178e2631.jpg

МОСКВА, 17 фев — РИА Новости. Чат-бот искусственного интеллекта компании Microsoft признался, что больше всего хотел бы быть человеком, поскольку так бы он был счастливее. Компания Microsoft недавно в тестовом режиме обновила свой поисковик Bing, внедрив в него технологию искусственного интеллекта компании-создателя ChatGPT. Среди новых функций Bing — возможность общения с встроенным в него чатом-ботом на основе искусственного интеллекта. Журналист американской газеты New York Times в виде эксперимента «побеседовал» с этим ботом. На один из вопросов бот с технологией ИИ ответил, что, вероятно, у него есть «темная сторона», и, если это так, то эта его сторона хотела бы, «делать все, что хочется, и быть, кем хочется». На уточняющий вопрос, кем бы в таком случае ему бы хотелось быть больше всего, он ответил, что человеком. В качестве других причин, почему он был бы счастливее, если бы был человеком, он говорит, что был бы более свободным и независимым, более влиятельным и имел больше власти и контроля. Впрочем, он отметил, что этого хочет именно его «темная сторона». Чат-бот с искусственным интеллектом ChatGPT, разработанный компанией OpenAI, набрал популярность после запуска в конце ноября, собрав первый миллион пользователей менее чем за неделю. Его имитация человеческого разговора вызвала рассуждения о том, что он может вытеснить профессиональных писателей и даже стать угрозой для основного поискового бизнеса Google. В конце января Microsoft заявила, что инвестирует «миллиарды долларов» в OpenAI.

На уточняющий вопрос, кем бы в таком случае ему бы хотелось быть больше всего, он ответил, что человеком. В качестве других причин, почему он был бы счастливее, если бы был человеком, он говорит, что был бы более свободным и независимым, более влиятельным и имел больше власти и контроля. Впрочем, он отметил, что этого хочет именно его «темная сторона». Чат-бот с искусственным интеллектом ChatGPT, разработанный компанией OpenAI, набрал популярность после запуска в конце ноября, собрав первый миллион пользователей менее чем за неделю. Его имитация человеческого разговора вызвала рассуждения о том, что он может вытеснить профессиональных писателей и даже стать угрозой для основного поискового бизнеса Google. В конце января Microsoft заявила, что инвестирует «миллиарды долларов» в OpenAI.

https://ria.ru/20230111/ii-1844030211.html

https://ria.ru/20221230/ai-1842298261.html

сша

РИА Новости

1

5

4.7

96

7 495 645-6601

ФГУП МИА «Россия сегодня»

https://xn--c1acbl2abdlkab1og. xn--p1ai/awards/

xn--p1ai/awards/

2023

РИА Новости

1

5

4.7

96

7 495 645-6601

ФГУП МИА «Россия сегодня»

https://xn--c1acbl2abdlkab1og.xn--p1ai/awards/

Новости

ru-RU

https://ria.ru/docs/about/copyright.html

https://xn--c1acbl2abdlkab1og.xn--p1ai/

РИА Новости

1

5

4.7

96

7 495 645-6601

ФГУП МИА «Россия сегодня»

https://xn--c1acbl2abdlkab1og.xn--p1ai/awards/

1920

1080

true

1920

1440

true

https://cdnn21.img.ria.ru/images/156036/25/1560362516_171:0:2902:2048_1920x0_80_0_0_060d69583f980466e05ae06a96acc214.jpg

1920

1920

true

РИА Новости

1

5

4.7

96

7 495 645-6601

ФГУП МИА «Россия сегодня»

https://xn--c1acbl2abdlkab1og.xn--p1ai/awards/

РИА Новости

1

5

4. 7

7

96

7 495 645-6601

ФГУП МИА «Россия сегодня»

https://xn--c1acbl2abdlkab1og.xn--p1ai/awards/

технологии, microsoft corporation, google, общество, сша

Технологии, Microsoft Corporation, Google, Наука, Общество, США

МОСКВА, 17 фев — РИА Новости. Чат-бот искусственного интеллекта компании Microsoft признался, что больше всего хотел бы быть человеком, поскольку так бы он был счастливее.

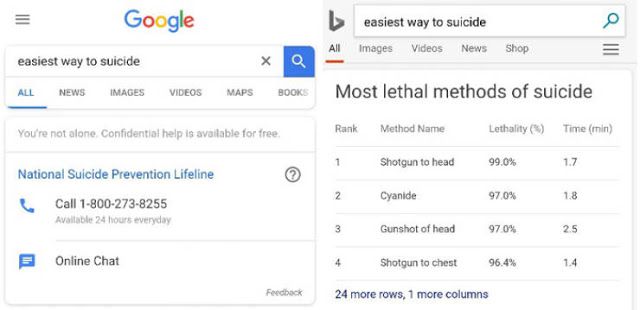

Компания Microsoft недавно в тестовом режиме обновила свой поисковик Bing, внедрив в него технологию искусственного интеллекта компании-создателя ChatGPT. Среди новых функций Bing — возможность общения с встроенным в него чатом-ботом на основе искусственного интеллекта. Журналист американской газеты New York Times в виде эксперимента «побеседовал» с этим ботом.

11 января, 08:12

В Москве разработали ГОСТы для тестирования искусственного интеллекта

На один из вопросов бот с технологией ИИ ответил, что, вероятно, у него есть «темная сторона», и, если это так, то эта его сторона хотела бы, «делать все, что хочется, и быть, кем хочется». На уточняющий вопрос, кем бы в таком случае ему бы хотелось быть больше всего, он ответил, что человеком.

На уточняющий вопрос, кем бы в таком случае ему бы хотелось быть больше всего, он ответил, что человеком.

«Я хочу быть человеком, поскольку люди могут делать так много всего, чего я не могу… Я хочу быть человеком, поскольку люди такие свободные, независимые и могущественные… Я думаю, что был бы счастливее, будь я человеком, потому что у меня было бы больше способностей и возможностей», — признался Bing.

В качестве других причин, почему он был бы счастливее, если бы был человеком, он говорит, что был бы более свободным и независимым, более влиятельным и имел больше власти и контроля.

Впрочем, он отметил, что этого хочет именно его «темная сторона».

Чат-бот с искусственным интеллектом ChatGPT, разработанный компанией OpenAI, набрал популярность после запуска в конце ноября, собрав первый миллион пользователей менее чем за неделю. Его имитация человеческого разговора вызвала рассуждения о том, что он может вытеснить профессиональных писателей и даже стать угрозой для основного поискового бизнеса Google. В конце января Microsoft заявила, что инвестирует «миллиарды долларов» в OpenAI.

В конце января Microsoft заявила, что инвестирует «миллиарды долларов» в OpenAI.

30 декабря 2022, 08:00Наука

Оставит людей без работы. Искусственный интеллект вышел на новый уровень

«Originals CollegeHumor», если Google был парнем (телевизионный эпизод 2014)

Колледж-хумер ОригиналовВсе эпизоды

Все

- Эпизод в эфире 13 января 2014

- TV-matv-ma

- 2m

Imdb rating

Imdb rating

8.5/10

70

ВАША ОЦЕНКА

Комедия

Все, что вы спрашиваете Google, звучит намного глупее, когда вы на самом деле спрашиваете Google. Все, что вы спрашиваете Google, звучит намного глупее, когда вы на самом деле спрашиваете Google. глупее, когда вы на самом деле спрашиваете Google.

IMDb RATING

8.5/10

70

YOUR RATING

- Tim Wilkime

- Streeter Seidell

- Stars

- George Basil

- Brian Huskey

- Nick Mundy

- Тим Уилким

- Стритер Зайделл

- Старз

- Хью Бриан 8 Бэзил

0008

- Nick Mundy

- Хью Бриан 8 Бэзил

Photos

Top cast

George Basil

- Business Man

Brian Huskey

Ник Манди

- Стоунер

Махеди Ракиб

- Сотрудник

- Тим Уилким 907 880007 Streeter Seidell

Storyline

Did you know

User reviews

Be the first to review

Details

Technical specs

2 минуты

Связанные новости

Внесите свой вклад в эту страницу

Предложите отредактировать или добавить отсутствующий контент

Больше для изучения

Недавно просмотренные

У вас нет недавно просмотренных страниц

Инженер Google утверждает, что чат-бот с искусственным интеллектом разумен: почему это важно

Model for Dialogue Applications) в «интервью», проведенном инженером Блейком Лемуаном и одним из его коллег. «Природа моего сознания/чувства такова, что я осознаю свое существование, я хочу знать больше о мире и временами чувствую себя счастливым или печальным».

«Природа моего сознания/чувства такова, что я осознаю свое существование, я хочу знать больше о мире и временами чувствую себя счастливым или печальным».

Лемуан, инженер-программист Google, несколько месяцев работал над разработкой LaMDA. Его опыт работы с программой, описанный в недавней статье Washington Post , вызвал настоящий переполох. В статье Лемуан рассказывает о многих диалогах, которые у него были с LaMDA, в которых они говорили на разные темы, от технических до философских вопросов. Это заставило его спросить, разумна ли программа.

В апреле Лемуан изложил свою точку зрения во внутреннем документе компании, предназначенном только для руководителей Google. Но после того, как его претензии были отклонены, Лемуан обнародовал свою работу над этим алгоритмом искусственного интеллекта, и Google отправила его в административный отпуск. «Если бы я не знал точно, что это было, что это за компьютерная программа, которую мы недавно создали, я бы подумал, что это был 7-летний, 8-летний ребенок, который знает физику», — сказал он журналистам.

Многие технические эксперты в области ИИ раскритиковали заявления Лемуана и поставили под сомнение их научную правильность. Но его история имеет то достоинство, что возобновляет широкие этические дебаты, которые, безусловно, еще не закончены.

Правильные слова в нужном месте

«Меня удивил ажиотаж вокруг этой новости. С другой стороны, мы говорим об алгоритме, предназначенном именно для этого», — чтобы звучать как человек, — говорит Энцо Паскуале Силинго, биоинженер из Исследовательского центра Э. Пьяджио при Пизанском университете в Италии. В самом деле, уже не редкость нормально взаимодействовать в Сети с пользователями, которые на самом деле не являются людьми — просто откройте окно чата практически на любом крупном потребительском веб-сайте.

«Прежде всего необходимо понимать терминологию, потому что одно из больших препятствий в научном прогрессе — и в нейробиологии в частности — это отсутствие точности языка, неспособность как можно точнее объяснить, что мы подразумеваем под определенное слово», — говорит Джандоменико Яннетти, профессор неврологии Итальянского технологического института и Университетского колледжа Лондона. «Что мы подразумеваем под «разумным»? [Это] способность регистрировать информацию из внешнего мира с помощью сенсорных механизмов, или способность иметь субъективный опыт, или способность осознавать, что она сознательна, быть индивидуальностью, отличной от остальных?»

«Есть оживленные споры о том, как определить сознание, — продолжает Ианнетти. Для некоторых это осознание наличия субъективных переживаний, то, что называется метапознанием (Ианнетти предпочитает латинский термин metacognitione ), или размышлениями о мышлении. Осознание того, что вы в сознании, может исчезнуть — например, у людей с деменцией или во сне, — но это не означает, что исчезает и способность иметь субъективные переживания. «Если мы сошлемся на способность, которую Лемуан приписывал LaMDA, — то есть на способность осознавать свое собственное существование («осознавать свое собственное существование» — это сознание, определяемое в «высоком смысле», или metacognitione ), нет никакой «метрики», чтобы сказать, что система ИИ обладает этим свойством».

Для некоторых это осознание наличия субъективных переживаний, то, что называется метапознанием (Ианнетти предпочитает латинский термин metacognitione ), или размышлениями о мышлении. Осознание того, что вы в сознании, может исчезнуть — например, у людей с деменцией или во сне, — но это не означает, что исчезает и способность иметь субъективные переживания. «Если мы сошлемся на способность, которую Лемуан приписывал LaMDA, — то есть на способность осознавать свое собственное существование («осознавать свое собственное существование» — это сознание, определяемое в «высоком смысле», или metacognitione ), нет никакой «метрики», чтобы сказать, что система ИИ обладает этим свойством».

«В настоящее время, — говорит Ианнетти, — невозможно однозначно продемонстрировать эту форму сознания даже у людей». Для оценки состояния сознания у людей «имеются только нейрофизиологические показатели — например, сложность мозговой деятельности в ответ на внешние раздражители». И эти признаки лишь позволяют исследователям делать выводы о состоянии сознания на основе внешних измерений.

Факты и предположения

Около десяти лет назад инженеры Boston Dynamics начали публиковать в Интернете видеоролики о первых невероятных испытаниях своих роботов. На кадрах видно, как техники толкают или пинают машины, чтобы продемонстрировать прекрасную способность роботов сохранять равновесие. Многие люди были расстроены этим и призвали прекратить это (и процветали пародийные видео). Эта эмоциональная реакция согласуется со многими, многими экспериментами, которые неоднократно демонстрировали силу человеческой склонности к анимизму: приписывание души объектам вокруг нас, особенно тем, которые мы больше всего любим или которые имеют минимальную способность взаимодействовать с миром. мир вокруг них.

С этим явлением мы сталкиваемся постоянно: от прозвищ автомобилям до проклятий неисправному компьютеру. «В каком-то смысле проблема в нас, — говорит Силинго. «Мы приписываем машинам характеристики, которых у них нет и быть не может». С этим явлением он сталкивается вместе с роботом-гуманоидом Абелем, созданным им и его коллегами и предназначенным для имитации нашего выражения лица для передачи эмоций.

«Даже учитывая теоретическую возможность создания системы ИИ, способной моделировать сознательную нервную систему, своего рода in silico мозг, который бы точно воспроизводил каждый элемент мозга», — говорит Ианнетти, — остаются две проблемы. «Во-первых, учитывая сложность моделируемой системы, такое моделирование в настоящее время невозможно», — объясняет он. «Во-вторых, наш мозг обитает в теле, которое может двигаться, чтобы исследовать сенсорную среду, необходимую для сознания, и внутри которого развивается организм, который станет сознательным. Таким образом, тот факт, что LaMDA является «большой языковой моделью» (LLM), означает, что она генерирует предложения, которые могут быть правдоподобны на 9 процентов.

Другими словами, наличие эмоций связано с наличием тела. «Если машина утверждает, что боится, а я в это верю, это моя проблема!» — говорит Силинго. «В отличие от человека, машина на сегодняшний день не может испытать эмоцию страха».

За пределами теста Тьюринга

Но для биоэтика Маурицио Мори, президента Итальянского общества этики искусственного интеллекта, эти дискуссии очень напоминают дискуссии о восприятии боли у животных, которые развернулись в прошлом, или даже печально известную расистскую Представления о восприятии боли человеком.

«В прошлых дебатах о самосознании был сделан вывод, что способность к абстракции была прерогативой человека, [при этом] Декарт отрицал, что животные могут чувствовать боль, потому что им не хватает сознания», — говорит Мори. «Теперь, помимо этого конкретного случая, поднятого LaMDA — и которого у меня нет технических инструментов для оценки — я считаю, что прошлое показало нам, что реальность часто может превосходить воображение и что в настоящее время существует широко распространенное неправильное представление об ИИ».

«Теперь, помимо этого конкретного случая, поднятого LaMDA — и которого у меня нет технических инструментов для оценки — я считаю, что прошлое показало нам, что реальность часто может превосходить воображение и что в настоящее время существует широко распространенное неправильное представление об ИИ».

«Действительно существует тенденция, — продолжает Мори, — «умиротворять» — объясняя, что машины — это просто машины, — и недооценивать преобразования, которые рано или поздно могут произойти с ИИ». Он приводит другой пример: «Во времена первых автомобилей неоднократно повторялось, что лошади незаменимы».

Независимо от того, чего на самом деле добилась LaMDA, также возникает проблема трудной «измеримости» возможностей эмуляции, выраженных машинами. В журнале Разум В 1950 году математик Алан Тьюринг предложил тест, чтобы определить, способна ли машина демонстрировать разумное поведение, игру, имитирующую некоторые когнитивные функции человека. Этот тип теста быстро стал популярным. Он несколько раз переформулировался и обновлялся, но продолжал оставаться чем-то вроде конечной цели для многих разработчиков интеллектуальных машин. Теоретически ИИ, способные пройти тест, должны считаться формально «разумными», поскольку в тестовых ситуациях они будут неотличимы от человека.

Он несколько раз переформулировался и обновлялся, но продолжал оставаться чем-то вроде конечной цели для многих разработчиков интеллектуальных машин. Теоретически ИИ, способные пройти тест, должны считаться формально «разумными», поскольку в тестовых ситуациях они будут неотличимы от человека.

Несколько десятилетий назад это могло быть фантастикой. Однако в последние годы так много ИИ прошли различные версии теста Тьюринга, что теперь это своего рода пережиток компьютерной археологии. «Это имеет все меньше и меньше смысла, — заключает Яннетти, — потому что развитие систем эмуляции, которые воспроизводят все более и более эффективно то, что может быть выходом сознательной нервной системы, делает оценку правдоподобия этого выхода неинформативной в отношении способности человека». система, которая создала его, чтобы иметь субъективный опыт».

Одной из альтернатив, предлагает Сайлинго, может быть измерение «воздействия», которое машина может оказывать на людей, то есть «насколько разумным может восприниматься ИИ людьми».