что означает и как правильно использовать

В данной статье речь пойдет о самых популярных директивах Dissalow и Allow в файле robots.txt.

Disallow

Allow

Совместная интерпретация директив

Пустые Allow и Disallow

Специальные символы в директивах

Примеры совместного применения Allow и Disallow

Disallow

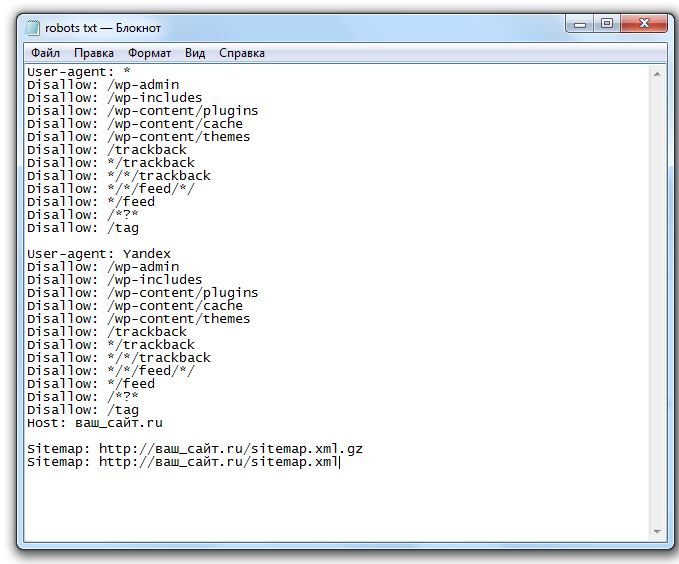

Disallow – директива, запрещающая индексирование отдельных страниц, групп страниц, их отдельных файлов и разделов сайта(папок). Это наиболее часто используемая директива, которая исключает из индекса:

- страницы с результатами поиска на сайте;

- страницы посещаемости ресурса;

- дубли;

- сервисные страницы баз данных;

- различные логи;

- страницы, содержащие персональные данные пользователей.

Примеры директивы Disallow в robots.

# запрет на индексацию всего веб-ресурса User-agent: Yandex Disallow: /

# запрет на обход страниц, адрес которых начинается с /category User-agent: Yandex Disallow: /category

# запрет на обход страниц, URL которых содержит параметры User-agent: Yandex Disallow: /page?

# запрет на индексацию всего раздела wp-admin User-agent: Yandex Disallow: /wp-admin

# запрет на индексацию подраздела plugins User-agent: Yandex Disallow: /wp-content/plugins

# запрет на индексацию конкретного изображения в папке img User-agent: Yandex Disallow: /img/images.jpg

# запрет индексации конкретного PDF документа User-agent: Yandex Disallow: /dogovor.pdf

# запрет на индексацию не только /my, но и /folder/my или /folder/my User-agent: Yandex Disallow: /*my

Правило Disallow работает с масками, позволяющими проводить операции с группами файлов или папок.

После данной директивы необходимо ставить пробел, а в конце строки пробел недопустим.

Allow

В отличие от Disallow, данное указание разрешает индексацию определенных страниц, разделов или файлов сайта. У директивы Allow схожий синтаксис, что и у Disallow.

Хотя окончательное решение о посещении вашего сайта роботами принимает поисковая система, данное правило дополнительно призывает их это делать.

Примеры Allow в robots.txt:

# разрешает индексацию всего каталога /img/ User-agent: Yandex Allow: /img/

# разрешает индексацию PDF документа User-agent: Yandex Allow: /prezentaciya.pdf

# открывает доступ к индексированию определенной HTML страницы User-agent: Yandex Allow: /page.html

# разрешает индексацию по маске *your User-agent: Yandex Allow: /*your

# запрещает индексировать все, кроме страниц, начинающихся с /cgi-bin User-agent: Yandex Allow: /cgi-bin Disallow: /

Для директивы применяются аналогичные правила, что и для Disallow.

Совместная интерпретация директив

Поисковые системы используют Allow и Disallow из одного User-agent блока последовательно, сортируя их по длине префикса URL, начиная от меньшего к большему. Если для конкретной страницы веб-сайта подходит применение нескольких правил, поисковый бот выбирает последний из списка. Поэтому порядок написания директив в robots никак не сказывается на их использовании роботами.

На заметку. Если директивы имеют одинаковую длину префиксов и при этом конфликтуют между собой, то предпочтительнее будет Allow.

Пример robots.txt написанный оптимизатором:

User-agent: Yandex Allow: / Allow: /catalog/phones Disallow: /catalog

Пример отсортированного файл robots.txt поисковой системой:

User-agent: Yandex Allow: / Disallow: /catalog Allow: /catalog/phones # запрещает посещать страницы, начинающиеся с /catalog, # но разрешает индексировать страницы, начинающиеся с /catalog/phones

Пустые Allow и Disallow

Когда в директивах отсутствуют какие-либо параметры, поисковый бот интерпретирует их так:

# то же, что и Allow: / значит разрешает индексировать весь сайт User-agent: Yandex Disallow:

# не учитывается роботом User-agent: Yandex Allow:

Специальные символы в директивах

В параметрах запрещающей директивы Disallow и

разрешающей директивы Allow можно применять специальные символы “$” и “*”, чтобы задать

конкретные регулярные выражения.

Специальный символ “*” разрешает индексировать все страницы с параметром, указанным в директиве. К примеру, параметр /katalog* значит, что для ботов открыты страницы /katalog, /katalog-tovarov, /katalog-1 и прочие. Спецсимвол означает все возможные последовательности символов, даже пустые.

Примеры:

User-agent: Yandex

Disallow: /cgi-bin/*.aspx # запрещает /cgi-bin/example.aspx

# и /cgi-bin/private/test.aspx

Disallow: /*private # запрещает не только /private

# но и /cgi-bin/privateПо стандарту в конце любой инструкции, описанной в Robots, указывается специальный символ “*”, но делать это не обязательно.

Пример:

User-agent: Yandex

Disallow: /cgi-bin* # закрывает доступ к страницам

# начинающимся с /cgi-bin

Disallow: /cgi-bin # означает то же самоеДля отмены данного спецсимвола в конце директивы применяют другой спецсимвол – “$”.

Пример:

User-agent: Yandex

Disallow: /example$ # закрывает /example,

# но не запрещает /example. html

User-agent: Yandex

Disallow: /example # запрещает и /example

# и /example.html

html

User-agent: Yandex

Disallow: /example # запрещает и /example

# и /example.htmlНа заметку. Символ “$” не запрещает прописанный в конце “*”.

Пример:

User-agent: Yandex

Disallow: /example$ # закрывает только /example

Disallow: /example*$ # аналогично, как Disallow: /example

# запрещает и /example.html и /exampleБолее сложные примеры:

User-agent: Yandex

Allow: /obsolete/private/*.html$ # разрешает HTML файлы

# по пути /obsolete/private/...

Disallow: /*.php$ # запрещает все *.php на сайте

Disallow: /*/private/ # запрещает все подпути содержащие /private/

# но Allow выше отменяет часть запрета

Disallow: /*/old/*.zip$ # запрещает все .zip файлы, содержащие в пути /old/

User-agent: Yandex

Disallow: /add.php?*user=

# запрещает все скрипты add.php? с параметром userПримеры совместного применения Allow и Disallow

User-agent: Yandex Allow: / Disallow: / # разрешено индексировать весь веб-ресурс User-agent: Yandex Allow: /$ Disallow: / # запрещено включать в индекс все, кроме главной страницы User-agent: Yandex Disallow: /private*html # заблокирован и /private*html, # и /private/test.html, и /private/html/test.aspx и т.п. User-agent: Yandex Disallow: /private$ # запрещается только /private User-agent: * Disallow: / User-agent: Yandex Allow: / # так как робот Яндекса # выделяет записи по наличию его названия в строке User-agent: # тогда весь сайт будет доступен для индексирования

Я всегда стараюсь следить за актуальностью информации на сайте, но могу пропустить ошибки, поэтому буду благодарен, если вы на них укажете. Если вы нашли ошибку или опечатку в тексте, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Все, все, все о Robots.txt — Реклама и продвижение

Robots.txt

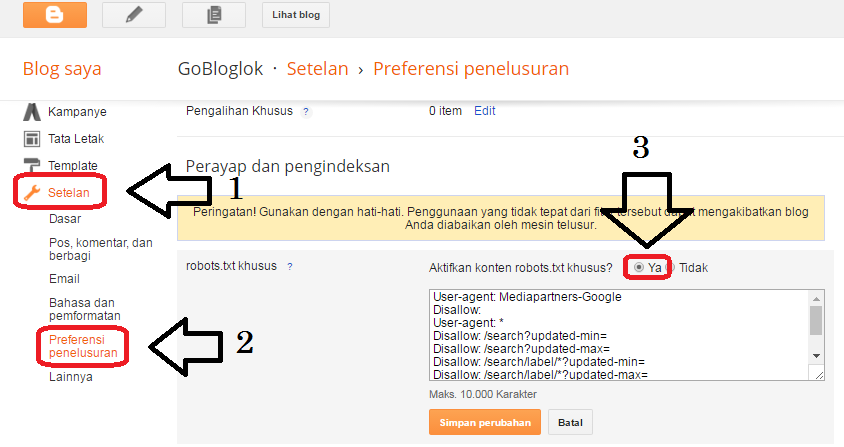

Поисковые сервера всегда перед индексацией вашего ресурса ищут в корневом каталоге вашего домена файл с именем «robots.txt» (http://www.mydomain.com/robots.txt). Этот файл сообщает роботам (паукам-индексаторам), какие файлы они могут индексировать, а какие нет.

Формат файла robots.txt — особый. Он состоит из записей. Каждая запись состоит из двух полей: строки с названием клиентского приложения (user-agent), и одной или нескольких строк, начинающихся с директивы Disallow:

<Поле> ":" <значение>

Robots. txt должен создаваться в текстовом формате Unix. Большинство хороших текстовых редакторов уже умеют превращать символы перевода строки Windows в Unix. Либо ваш FTP-клиент должен уметь это делать. Для редактирования не пытайтесь пользоваться HTML-редактором, особенно таким, который не имеет текстового режима отображения кода.

txt должен создаваться в текстовом формате Unix. Большинство хороших текстовых редакторов уже умеют превращать символы перевода строки Windows в Unix. Либо ваш FTP-клиент должен уметь это делать. Для редактирования не пытайтесь пользоваться HTML-редактором, особенно таким, который не имеет текстового режима отображения кода.

Поле User-agent

Строка User-agent содержит название робота. Например:

User-agent: googlebot

Если вы обращаетесь ко всем роботам, вы можете использовать символ подстановки «*»:

User-agent: *

Названия роботов вы можете найти в логах вашего веб-сервера. Для этого выберите только запросы к файлу robots.txt. большинство поисковых серверов присваивают короткие имена своим паукам-индексаторам.

Поле Disallow:

Вторая часть записи состоит из строк Disallow. Эти строки — директивы для данного робота. Они сообщают роботу какие файлы и/или каталоги роботу неразрешено индексировать. Например следующая директива запрещает паукам индексировать файл email.htm:

Например следующая директива запрещает паукам индексировать файл email.htm:

Disallow: email.htm

Директива может содержать и название каталога:

Disallow: /cgi-bin/

Эта директива запрещает паукам-индексаторам лезть в каталог «cgi-bin».

В директивах Disallow могут также использоваться и символы подстановки. Стандарт диктует, что директива /bob запретит паукам индексировать и /bob.html и /bob/index.html.

Если директива Disallow будет пустой, это значит, что робот может индексировать ВСЕ файлы. Как минимум одна директива Disallow должна присутствовать для каждого поля User-agent, чтобы robots.txt считался верным. Полностью пустой robots.txt означает то же самое, как если бы его не было вообще.

Пробелы и комментарии

Любая строка в robots.txt, начинающаяся с #, считается комментарием. Стандарт разрешает использовать комментарии в конце строк с директивами, но это считается плохим стилем:

Disallow: bob #comment

Некоторые пауки не смогут правильно разобрать данную строку и вместо этого поймут ее как запрет на индексацию ресурсов bob#comment. Мораль такова, что комментарии должны быть на отдельной строке.

Мораль такова, что комментарии должны быть на отдельной строке.

Пробел в начале строки разрешается, но не рекомендуется.

Disallow: bob #comment

Примеры

Следующая директива разрешает всем роботам индексировать все ресурсы сайта, так как используется символ подстановки «*».

User-agent: *

Disallow:

Эта директива запрещает всем роботам это делать:

User-agent: *

Disallow: /

Данная директива запрещает всем роботам заходить в каталоги «cgi-bin» и «images»:

User-agent: *

Disallow: /cgi-bin/

Disallow: /images/

Данная директива запрещает роботу Roverdog индексировать все файлы сервера:

User-agent: Roverdog

Disallow: /

Данная директива запрещает роботу googlebot индексировать файл cheese.htm:

User-agent: googlebot

Disallow: cheese.htm

Если вас интересуют более сложные примеры, попутайтесь вытянуть файл robots.

Дополнения к стандартам

Несмотря на то, что были предложения по расширению стандарта и введению директивы Allow или учета версии робота, эти предложения формально так и не были утверждены.

Поход в поисках robots.txt

При проверке нашего валидатора robots.txt (см. конец статьи), нам понадобилось найти много-много «корма» для него. Мы создали спайдер, который скачивал с каждого найденного сайта лишь один файл robots.txt. Мы прошлись по всем ссылкам и доменам, занесенным в Open Directory Project. Так мы прошлись по 2.4 миллионам URL и накопали файлов robots.txt примерно на 75 килобайт.

Во время этого похода мы обнаружили огромное количество проблем с файлами robots.txt. Мы увидели, что 5% robots.txt плохой стиль, а 2% файлов были настолько плохо написаны, что ни один робот не смог бы их понять. Вот список некоторых проблем, обнаруженных нами:

Перевернутый синтаксис

Одна из самых распространенных ошибок — перевернутый синтаксис:

User-agent: *

Disallow: scooter

User-agent: scooter

Disallow: *

Несколько директив Disallow в одной строке:

Многие указывали несколько директив на одной строке:

Disallow: /css/ /cgi-bin/ /images/

Различные пауки поймут эту директиву по разному. Некоторые проигнорируют пробелы и поймут директиву как запрет на индексацию каталога /css//cgi-bin//images/. Либо они возьмут только один каталог (/images/ или /css/) и проигнорируют все остальное.

Некоторые проигнорируют пробелы и поймут директиву как запрет на индексацию каталога /css//cgi-bin//images/. Либо они возьмут только один каталог (/images/ или /css/) и проигнорируют все остальное.

Правильный синтаксис таков:

Disallow: /css/

Disallow: /cgi-bin/

Disallow: /images/

Перевод строки в формате DOS:

Еще одна распространенная ошибка — редактирование файла robots.txt в формате DOS. Несмотря на то, что из-за распространенности данной ошибки многие пауки-идексаторы научились понимать ее, мы считаем это ошибкой. Всегда редактируйте свой robots.txt в режиме UNIX и закачивайте файл на сайт в режиме ASCII. Многие FTP-клиенты умеют при закачке в текстовом режиме переводить символы строки из DOS-формата в UNIX-формат. Но некоторые этого не делают.

Комментарии в конце строки:

Согласно стандарту, это верно:

Disallow: /cgi-bin/ #this bans robots from our cgi-bin

Но в недавнем прошлом были роботы, которые заглатывали всю строку в качестве директивы. Сейчас нам такие роботы неизвестны, но оправдан ли риск? Размещайте комментарии на отдельной строке.

Сейчас нам такие роботы неизвестны, но оправдан ли риск? Размещайте комментарии на отдельной строке.

Пробелы в начале строки:

Disallow: /cgi-bin/

Стандарт ничего не говорит по поводу пробелов, но это считается плохим стилем. И опять-таки, стоит ли рисковать?

Редирект на другую страницу при ошибке 404:

Весьма распространено, когда веб-сервер при ошибке 404 (Файл не найден) выдает клиенту особую страницу. При этом веб-сервер не выдает клиенту код ошибки и даже не делает редиректа. В этом случае робот не понимает, что файл robots.txt отсутствует, вместо этого он получит html-страницу с каким-то сообщением. Конечно никаких проблем здесь возникнуть не должно, но стоит ли рисковать? Бог знает, как разберет робот этот html-файл, приняв его за robots.txt. чтобы этого не происходило, поместите хотя бы пустой robots.txt в корневой каталог вашего веб-сервера.

Конфликты директив:

Чтобы вы сделали на месте робота slurp, увидев данные директивы?

User-agent: *

Disallow: /

#

User-agent: slurp

Disallow:

Первая директива запрещает всем роботам индексировать сайт, но вторая директива разрешает роботу slurp это делать. Так что же все-таки должен делать slurp? Мы не можем гарантировать, что все роботы поймут эти директивы правильно. В данном примере slurp должен проиндексировать весь сайт, а все остальные не должны уйти прямо с порога.

Так что же все-таки должен делать slurp? Мы не можем гарантировать, что все роботы поймут эти директивы правильно. В данном примере slurp должен проиндексировать весь сайт, а все остальные не должны уйти прямо с порога.

Верхний регистр всех букв — плохой стиль:

USER-AGENT: EXCITE

DISALLOW:

Несмотря на то, что стандарт безразлично относится к регистру букв в robots.txt, в именах каталогов и файлов регистр все-таки важен. Лучше всего следовать примерам и в верхнем регистре писать первые буквы только в словах User и Disallow.

Список всех файлов

Еще одна ошибка — перечисление всех файлов в каталоге:

Disallow: /AL/Alabama.html

Disallow: /AL/AR.html

Disallow: /Az/AZ.html

Disallow: /Az/bali.html

Disallow: /Az/bed-breakfast.html

Вышеприведенный пример можно заменить на:

Disallow: /AL

Disallow: /Az

Помните, что начальная наклонная черта обозначает, что речь идет о каталоге. Конечно, ничто не запрещает вам перечислить парочку файлов, но мы речь ведем о стиле. Данный пример взят из файла robots.txt, размер которого превышал 400 килобайт, в нем было упомянуто 4000 файлов! Интересно, сколько роботов-пауков, посмотрев на этот файл, решили больше не приходить на этот сайт.

Конечно, ничто не запрещает вам перечислить парочку файлов, но мы речь ведем о стиле. Данный пример взят из файла robots.txt, размер которого превышал 400 килобайт, в нем было упомянуто 4000 файлов! Интересно, сколько роботов-пауков, посмотрев на этот файл, решили больше не приходить на этот сайт.

Есть только директива Disallow!

Нет такой директивы Allow, есть только Disallow. Этот пример неверный:

User-agent: Spot

Disallow: /john/

allow: /jane/

Правильно будет так:

User-agent: Spot

Disallow: /john/

Disallow:

Нет открывающей наклонной черты:

Что должен сделать робот-паук с данной директивой:

User-agent: Spot

Disallow: john

Согласно стандартам эта директива запрещает индексировать файл «john» и каталог john». Но лучше всего, для верности, использовать наклонную черту, чтобы робот мог отличить файл от каталога.

Еще мы видели, как люди записывали в файл robots. txt ключевые слова для своего сайта (подумать только — для чего?).

txt ключевые слова для своего сайта (подумать только — для чего?).

Бывали такие файлы robots.txt, которые были сделаны в виде html-документов. Помните, во FrontPage делать robots.txt не стоит.

Неправильно настроенный сервер

Почему вдруг на запрос robots.txt веб-сервер выдает бинарный файл? Это происходит в том случае, если ваш веб-сервер настроен неправильно, либо вы неправильно закачали на сервер сам файл.

Всегда после того, как вы закачали файл robots.txt на сервер, проверяйте его. Достаточно в броузере набрать простой запрос:

http://www.mydomain.com/robots.txt

Вот и все что нужно для проверки.

Особенности Google:

Google — первый поисковый сервер, который поддерживает в директивах регулярные выражения. Что позволяет запрещать индексацию файлов по их расширениям.

User-agent: googlebot

Disallow: *.cgi

В поле user-agent вам следует использовать имя «googlebot». Не рискуйте давать подобную директиву другим роботам-паукам.

МЕТА-тег robots

МЕТА тег robots служит для того, чтобы разрешать или запрещать роботам, приходящим на сайт, индексировать данную страницу. Кроме того, этот тег предназначен для того, чтобы предлагать роботам пройтись по всем страницам сайта и проиндексировать их. Сейчас этот тег приобретает все большее значение.

Кроме того, этим тегом могут воспользоваться те, кто не может доступиться к корневому каталогу сервера и изменить файл robots.txt.

Некоторые поисковые сервера, такие как Inktomi например, полностью понимают мета-тег robots. Inktomi пройдет по всем страницам сайта если значение данного тега будет «index,follow».

Формат мета-тега Robots

Мета тег robots помещается в тег

html-документа. Формат достаточно прост (регистр букв значения не играет):

<HTML>

<HEAD>

<META NAME="ROBOTS" CONTENT="NOINDEX, NOFOLLOW">

<META NAME="DESCRIPTION" CONTENT="Эта страница …. ">

">

<TITLE>...</TITLE>

</HEAD>

<BODY>

Значения мета-тега robots

Данному мета-тегу можно присвоить варианта четыре значений. Атрибут content может содержать следующие значения:

index, noindex, follow, nofollow

Если значений несколько, они разделяются запятыми.

В настоящее время лишь следующие значения важны:

Директива INDEX говорит роботу, что данную страницу можно индексировать.

Директива FOLLOW сообщает роботу, что ему разрешается пройтись по ссылкам, присутствующим на данной странице. Некоторые авторы утверждают, что при отсутствии данных значений, поисковые сервера по умолчанию действуют так, как если бы им даны были директивы INDEX и FOLLOW. К сожалению это не так по отношению к поисковому серверу Inktomi. Для Inktomi значения по умолчанию равны «index, nofollow«.

Итак, глобальные директивы выглядят так:

Индексировать всё = INDEX, FOLLOW

Не индексировать ничего = NOINDEX,NOFLLOW

Примеры мета-тега robots:

<META NAME=ROBOTS" CONTENT="NOINDEX, FOLLOW">

<META NAME=ROBOTS" CONTENT="INDEX, NOFOLLOW">

<META NAME=ROBOTS" CONTENT="NOINDEX, NOFOLLOW">

Валидатор robots.

txt

txt| Валидатор Robots.txt |

« назад к списку статей

Disallow Определение и значение — Merriam-Webster

запретить · разрешить · низкий ˌdis-ə-ˈlau̇

переходный глагол

1

: отрицать силу, истинность или обоснованность

2

: отказ в разрешении

отказ

ˌdis-ə-ˈlau̇-ən(t)s

существительное

Синонимы

- противоречат

- отрицать

- не подтверждать

- дезавуировать

- отказ от ответственности

- не подтвердить

- отречься

- противодействие

- отрицание

- отрицательный

- опровергнуть

- отклонить

- repudiate

Просмотреть все синонимы и антонимы в тезаурусе

Примеры предложений

Тачдаун был запрещен из-за штрафа. отрицание философской концепции свободы воли

отрицание философской концепции свободы воли

Недавние примеры в Интернете

И запрещает мячу подниматься на середину пола.

— Гордон Монсон, 9 лет.0059 The Salt Lake Tribune , 6 января 2023 г.

Как и Дональд Трамп в 2020 году, президент Бразилии Жаир Болсонару оспаривал свое поражение на октябрьских выборах и стремился запретить голосов, поданных на большинстве электронных машин для голосования в стране.

— Дэвид Джексон, USA TODAY , 12 января 2023 г.

При настройке параметров конфиденциальности обязательно запретите людям за пределами ваших непосредственных подключений доступ к вашему контенту и не позволяйте вашим контактам делиться вашим контентом со своими друзьями или семьей. — Новости Далласа , 7 декабря 2022 г.

Верховный суд Пенсильвании приказал организаторам избирательных комиссий отказать в доставке бюллетеней по почте, если избиратели не проставят правильную дату на конверте.

— WSJ , 2 ноября 2022 г.

Общая стоимость будет оцениваться другим старшим судьей, который может отклонить некоторые судебные издержки и уменьшить общую сумму, причитающуюся к уплате.

— Эшли Шеннон Ву, 9 лет.0059 Стервятник , 23 июня 2022 г.

Одним из путей сдерживания распространения легализации является работа с городами и поселками, чтобы запретили диспансеров в своих районах.

— Теара Коулман, Неделя , 9 ноября 2022 г.

На этой неделе Верховный суд, похоже, был готов проголосовать за отмену политик позитивных действий в сфере высшего образования.

— Новости Далласа , 7 декабря 2022 г.

Верховный суд Пенсильвании приказал организаторам избирательных комиссий отказать в доставке бюллетеней по почте, если избиратели не проставят правильную дату на конверте.

— WSJ , 2 ноября 2022 г.

Общая стоимость будет оцениваться другим старшим судьей, который может отклонить некоторые судебные издержки и уменьшить общую сумму, причитающуюся к уплате.

— Эшли Шеннон Ву, 9 лет.0059 Стервятник , 23 июня 2022 г.

Одним из путей сдерживания распространения легализации является работа с городами и поселками, чтобы запретили диспансеров в своих районах.

— Теара Коулман, Неделя , 9 ноября 2022 г.

На этой неделе Верховный суд, похоже, был готов проголосовать за отмену политик позитивных действий в сфере высшего образования. — Лила Маклеллан, 9 лет.0059 Fortune , 2 ноября 2022 г.

Еще один законопроект, вынесенный на утверждение Сената, запретит проведение мероприятий по сбору бюллетеней, подобных тому, которое было проведено в прошлом году в Мэдисоне, до того, как за две недели до выборов начнется окно для личного заочного голосования.

— Скотт Бауэр, Star Tribune , 10 мая 2021 г.

Узнать больше

— Лила Маклеллан, 9 лет.0059 Fortune , 2 ноября 2022 г.

Еще один законопроект, вынесенный на утверждение Сената, запретит проведение мероприятий по сбору бюллетеней, подобных тому, которое было проведено в прошлом году в Мэдисоне, до того, как за две недели до выборов начнется окно для личного заочного голосования.

— Скотт Бауэр, Star Tribune , 10 мая 2021 г.

Узнать больше

Эти примеры предложений автоматически выбираются из различных онлайн-источников новостей, чтобы отразить текущее использование слова «запретить». Мнения, выраженные в примерах, не отражают точку зрения Merriam-Webster или ее редакторов. Отправьте нам отзыв.

Отправьте нам отзыв.

История слов

Первое известное использование

15 век, в значении, определенном в смысле 1

Путешественник во времени

Первое известное использование запретить было в 15 веке

Посмотреть другие слова из того же века дис алитер визуум

запрещать

невнимательно

Посмотреть другие записи рядом

Процитировать эту запись

Стиль

MLAЧикагоAPAMМерриам-Вебстер

«Запретить». Словарь Merriam-Webster.com , Merriam-Webster, https://www.merriam-webster.com/dictionary/disallow. По состоянию на 11 февраля 2023 г.

глагол

По состоянию на 11 февраля 2023 г.

глагол

запретить · разрешить · низкий ˌdis-ə-ˈlau̇

: отказать в приеме или разрешении : отклонить

отклонить претензию

отказ

-ˈlau̇-ən(t)s

существительное

Юридическое определение

запретить

переходный глагол

запретить · разрешить · низкий ˌdi-sə-ˈlau̇

1

: отрицать истину, силу или обоснованность

отказ в вычете

отказ в удовлетворении заявления о банкротстве

2

: отказ в разрешении

отказ в выплате пособия

отказ существительное

Еще от Merriam-Webster на

disallowНглиш: перевод disallow для говорящих на испанском языке

Последнее обновление: — Обновлены примеры предложений

Подпишитесь на крупнейший словарь Америки и получите тысячи дополнительных определений и расширенный поиск без рекламы!

Merriam-Webster без сокращений

одурманенный

См. Определения и примеры »

Получайте ежедневно по электронной почте Слово дня!

Большая британская викторина по словарному запасу

- Названный в честь сэра Роберта Пиля, как называется британская полиция?

- Бобби Берти

- Робби Пилхеды

Прослушайте слово и напечатайте его. Сколько вы можете получить правильно?

ПРОЙДИТЕ ТЕСТ

Сможете ли вы составить 12 слов из 7 букв?

ИГРАТЬ

Запретить Определение и значение | Dictionary.

com.

com.[ dis-uh-lou ]

/ ˌdɪs əˈlaʊ /

Сохранить это слово!

См. синонимы для: disallow / disallowed / disallowance на Thesaurus.com

Показывает уровень обучения в зависимости от сложности слова.

глагол (используется с объектом)

отказать в разрешении; отклонять; вето: отклонить требование о компенсации.

отказаться признать истинность или обоснованность: отвергнуть достоверность сообщения.

ВИКТОРИНА

ВЫ ПРОЙДЕТЕ ЭТИ ГРАММАТИЧЕСКИЕ ВОПРОСЫ ИЛИ НАТЯНУТСЯ?

Плавно переходите к этим распространенным грамматическим ошибкам, которые ставят многих людей в тупик. Удачи!

Вопрос 1 из 7

Заполните пропуск: Я не могу понять, что _____ подарил мне этот подарок.

Происхождение запрета

Впервые записано в 1350–1400 гг.; Среднеанглийское слово от древнефранцузского слова desallouer. См. dis- 1 , allow

ДРУГИЕ СЛОВА ОТ disallow

dis·al·low·a·ble, прилагательноеdis·al·low·a·ble·ness, существительное dis·al ·low·ance, существительноеСлова рядом disallow

дезагрегировать, не соглашаться, неугодный, несогласие, dis aliter visum, запрещать, устранять неоднозначность, устранять неоднозначность, устранять, исчезать, исчезать

Dictionary. com Полный текст

На основе Random House Unabridged Dictionary, © Random House, Inc. 2023

com Полный текст

На основе Random House Unabridged Dictionary, © Random House, Inc. 2023

Слова, относящиеся к disallow

запрещать, отказывать, отрекаться, отменять, подвергать цензуре, запрещать, отрицать, отрекаться, отказываться, увольнять, отрекаться, эмбарго, исключать, убивать , nix, proscribe, отказываться, отвергать, табу, вето

Как использовать disallow в предложении

«Кэпиталз» не засчитали ранний гол после просмотра переигровки, и поединок перешел в третий период без очков.

«Кэпиталз» обыграли «Брюинз» в серии буллитов, сделав Здено Чару счастливым возвращением на родину|Саманта Пелл|4 марта 2021 г.|Washington Post

Стефански не может удаленно тренировать «Брюинз», потому что НФЛ уже давно запретила любое внешнее общение в играх между началом матча и финальным свистком.

«Браунс» избавились от своей истории и одержали первую победу в плей-офф с 1995 года|Адам Килгор, Дез Билер|11 января 2021 года|Washington Post сторонние файлы cookie в Chrome, браузере Google, на долю которого приходится более 60% глобального использования Интернета.

Как А.И. может сделать цифровую рекламу менее жуткой|jakemeth|17 декабря 2020|Fortune

Между тем, закон Калифорнии от 2015 года запрещает использование прежнего названия или логотипа футбольной команды Вашингтона и запрещает школам покупать новое оборудование с этим брендом, но позволяет им продолжать использовать существующее оборудование, пока оно не изнашивается.

Сотни школ по-прежнему используют коренных американцев в качестве талисманов команд|Хоуп Олчин|12 октября 2020 г.|FiveThirtyEight

И знаете, у этой страны, да и у всего мира такая сложная история, когда дело доходит до наркотиков, которые разрешены или запрещены.

Как психоделики и другие наркотики для вечеринок меняют психиатрию? (Эп. 433)|Стивен Дж. Дубнер|1 октября 2020 г.|Фрикономика

Я также отказываюсь лишить палестинцев права на их боль или их повествование.

День независимости без независимости Палестины|Эмили Л. Хаузер|16 апреля 2013 г.

|DAILY BEAST

|DAILY BEASTЯ отказываюсь отказывать моему народу в праве на нашу боль или на нашу радость.

День независимости без независимости Палестины|Эмили Л. Хаузер|16 апреля 2013 г.|DAILY BEAST

Я был против этого проекта и просил вице-короля запретить его.

Умиротворение Бирмы|Сэр Чарльз Хокс Тодд Кростуэйт

Физическая история нашего земного шара — это исследование, важность которого никто в наши дни вряд ли будет отрицать.

Итальянские Альпы|Дуглас Уильям Фрешфилд

Они не допускают, чтобы у доброго самаритянина и левита были одни и те же внешние раздражители.

Оглядываясь назад|Меррик Эбнер Ричардсон

Государственный секретарь может в любое время отклонить или приостановить действие любого сертификата, выданного в соответствии с данным разделом.

Эксперименты над животными|Стивен Пэджет

И первый, и второй Алкивиад кажутся мне подлинными, даже после показа тех самых критиков, которые их отвергают.

html

User-agent: Yandex

Disallow: /example # запрещает и /example

# и /example.html

html

User-agent: Yandex

Disallow: /example # запрещает и /example

# и /example.html html, и /private/html/test.aspx и т.п.

User-agent: Yandex

Disallow: /private$

# запрещается только /private

User-agent: *

Disallow: /

User-agent: Yandex

Allow: /

# так как робот Яндекса

# выделяет записи по наличию его названия в строке User-agent:

# тогда весь сайт будет доступен для индексирования

html, и /private/html/test.aspx и т.п.

User-agent: Yandex

Disallow: /private$

# запрещается только /private

User-agent: *

Disallow: /

User-agent: Yandex

Allow: /

# так как робот Яндекса

# выделяет записи по наличию его названия в строке User-agent:

# тогда весь сайт будет доступен для индексирования

|DAILY BEAST

|DAILY BEAST