Правильный Robots.txt для 1С-Bitrix (2020) — как сделать?

Битрикс является одной из самых распространенных систем администрирования в российском сегменте интернета. С учетом того, что на этой CMS, с одной стороны, нередко делают интернет-магазины и в достаточной степени нагруженные сайты, а с другой стороны, битрикс оказывается не самой быстрой системой, составление правильного файла robots.txt становится еще более актуальной задачей. Если поисковый робот индексирует только то, что нужно для продвижения, это помогает убрать лишнюю нагрузку на сайт. Как и в случае истории с robots для WordPress, в интернете почти в каждой статье присутствуют ошибки. Такие случае я укажу в самом конце статьи, чтобы было понимание, почему такие команды прописывать не нужно.

Более подробно о составлении robots.txt и значении всех его директив я писал здесь. Ниже я не буду подробно останавливаться на значении каждого правила. Ограничусь тем, что кратко прокомментирую что для чего необходимо.

Правильный Robots.txt для Bitrix

User-agent: * # правила для всех роботов Disallow: /cgi-bin # папка на хостинге Disallow: /bitrix/ # папка с системными файлами битрикса Disallow: *bitrix_*= # GET-запросы битрикса Disallow: /local/ # папка с системными файлами битрикса Disallow: /*index.php$ # дубли страниц index.php Disallow: /auth/ # авторизация Disallow: *auth= # авторизация Disallow: /personal/ # личный кабинет Disallow: *register= # регистрация Disallow: *forgot_password= # забыли пароль Disallow: *change_password= # изменить пароль Disallow: *login= # логин Disallow: *logout= # выход Disallow: */search/ # поиск Disallow: *action= # действия Disallow: *print= # печать Disallow: *?new=Y # новая страница Disallow: *?edit= # редактирование Disallow: *?preview= # предпросмотр Disallow: *backurl= # трекбеки Disallow: *back_url= # трекбеки Disallow: *back_url_admin= # трекбеки Disallow: *captcha # каптча Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: *?FILTER*= # здесь и ниже различные популярные параметры фильтров Disallow: *?ei= Disallow: *?p= Disallow: *?q= Disallow: *?tags= Disallow: *B_ORDER= Disallow: *BRAND= Disallow: *CLEAR_CACHE= Disallow: *ELEMENT_ID= Disallow: *price_from= Disallow: *price_to= Disallow: *PROPERTY_TYPE= Disallow: *PROPERTY_WIDTH= Disallow: *PROPERTY_HEIGHT= Disallow: *PROPERTY_DIA= Disallow: *PROPERTY_OPENING_COUNT= Disallow: *PROPERTY_SELL_TYPE= Disallow: *PROPERTY_MAIN_TYPE= Disallow: *PROPERTY_PRICE[*]= Disallow: *S_LAST= Disallow: *SECTION_ID= Disallow: *SECTION[*]= Disallow: *SHOWALL= Disallow: *SHOW_ALL= Disallow: *SHOWBY= Disallow: *SORT= Disallow: *SPHRASE_ID= Disallow: *TYPE= Disallow: *utm*= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Disallow: *from= # ссылки с метками from Allow: */upload/ # открываем папку с файлами uploads Allow: /bitrix/*.js # здесь и далее открываем для индексации скрипты Allow: /bitrix/*.css Allow: /local/*.js Allow: /local/*.css Allow: /local/*.jpg Allow: /local/*.jpeg Allow: /local/*.png Allow: /local/*.gif # Укажите один или несколько файлов Sitemap Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS # то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал # Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают. Host: www.site.ru

В примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает). Подробнее про это читайте в статье Robots.txt.

Ошибочные рекомендации других блогеров для Robots.txt на Bitrix

- Закрывать от индексации страницы пагинации

ПравилоDisallow: *?PAGEN_1= - Закрывать файлы изображений и файлов для скачивания (DOC, DOCX, XLS, XLSX, PDF, PPT, PPTS и др.)

Это делать не нужно. Если у вас есть правилоDisallow: /upload/, удалите его. - Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика. - Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей.

Оцените статью

Загрузка…

Загрузка…Друзья, буду благодарен за ваши вопросы, дополнения и рекомендации по теме статьи. Пишите ниже в комментариях.

Буду благодарен, если поставите оценку статье.

Настройка и создание robots.txt для битрикс

Не секрет, что для правильной seo-оптимизации необходим файл robots.txt, Это тот самый инструмент, который сообщает поисковым системам о параметрах индексирования сайта. В роботе Яндекса используется сессионный принцип работы, на каждую сессию формируется определенный пул страниц, которые планирует загрузить робот. Сессия начинается с загрузки файла robots.txt. Если файл отсутствует, не является текстовым или на запрос робота возвращается HTTP-статус отличный от 200 OK, робот считает, что доступ к документам не ограничен.

В битрикс robots.tx

Оптимальным набором параметров является:

User-agent: Yandex Disallow: /*index.php$ Disallow: /bitrix/ Disallow: /auth/ Disallow: /personal/ Disallow: */*search Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*print Disallow: /*register= Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*?action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*back_url* Disallow: /*COURSE_ID= Disallow: /*?COURSE_ID= Disallow: /*PAGEN_* Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*SHOWALL Disallow: /*show_all= Host: example.com User-agent: * Disallow: /*index.php$ Disallow: /bitrix/ Disallow: /auth/ Disallow: /personal/ Disallow: */*search Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*print Disallow: /*register= Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*?action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*back_url* Disallow: /*COURSE_ID= Disallow: /*?COURSE_ID= Disallow: /*PAGEN_* Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*SHOWALL Disallow: /*show_all= Sitemap: http://example.com/sitemap.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 5960 61 62 63 64 65 66 67 68 69 | User-agent: Yandex Disallow: /*index.php$ Disallow: /bitrix/ Disallow: /auth/ Disallow: /personal/ Disallow: */*search Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*print Disallow: /*register= Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*?action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*back_url* Disallow: /*COURSE_ID= Disallow: /*?COURSE_ID= Disallow: /*PAGEN_* Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*SHOWALL Disallow: /*show_all= Host: example.com User-agent: * Disallow: /*index.php$ Disallow: /bitrix/ Disallow: /auth/ Disallow: /personal/ Disallow: */*search Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*print Disallow: /*register= Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*?action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*back_url* Disallow: /*COURSE_ID= Disallow: /*?COURSE_ID= Disallow: /*PAGEN_* Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*SHOWALL Disallow: /*show_all= Sitemap: http://example.com/sitemap.xml |

Таким образом мы закрываем для индексации форму регистрации так и ряд страниц, т.к. они могут сформировать дубли страниц.

Вообще «robots txt» для битрикс формируется системой весьма корректно, единственно необходимо поправить его в соответствии с проектом, а по сути важные параметры система формирует сама, помимо этого буквально в 2 клика в настройках robots.txt можно удалить или наоборот добавить нужный параметр, а при создании sitemap ссылка в robots.txt формируется сама

Правильный robots.txt 1C Битрикс — Тюнинг-Софт

Пример правильного и оптимального robots.txt для 1С Битрикс, с учетом параметров, css, js, постраничной навигации и т.д.

User-Agent: *

Disallow: /*nav-*

Disallow: /bitrix/

Disallow: /upload/

Disallow: /local/

Disallow: /search/

Disallow: /compare/

Disallow: /personal/

Disallow: /rss/

Disallow: /auth/

Disallow: /login/

Disallow: /webstat/

Disallow: /desktop_app/

Disallow: /ajax/

Disallow: /test/

Disallow: /404.php

Disallow: /*index*.php$

Disallow: */index.php

Disallow: /*?*

Allow: /bitrix/components/

Allow: /bitrix/templates/

Allow: /local/components/

Allow: /local/templates/

Allow: /bitrix/cache/

Allow: /bitrix/css/

Allow: /bitrix/js/

Allow: /bitrix/images/

Allow: /bitrix/panel/

Allow: /upload/iblock/

Allow: /upload/medialibrary/

Allow: /upload/resize_cache/main/

Allow: /upload/resize_cache/iblock/

Allow: /upload/resize_cache/medialibrary/

Allow: /*?question=*

Allow: /*?review_id=*

Allow: /*.css

Allow: /*.js

Host: https://tuning-soft.ruSitemap: https://tuning-soft.ru/sitemap.xml

Подробный разбор правил robots.txt

Это означает, что данные правила применяются ко всем поисковым роботам.

User-Agent: *

Запрещает индексировать новую постраничную навигацию D7.

Disallow: /*nav-*

Данный набор правил запрещает индексировать всякие служебные папки движка, админку, загрузки, модули, результаты поиска, сравнение, персональный раздел, авторизацию, статистику хоста, десктопное приложение, аяксы, тестовые разделы, ошибку 404, т.е. всякий ненужный в результатах поиска мусор.

Disallow: /bitrix/

Disallow: /upload/

Disallow: /local/

Disallow: /search/

Disallow: /compare/

Disallow: /personal/

Disallow: /rss/

Disallow: /auth/

Disallow: /login/

Disallow: /webstat/

Disallow: /desktop_app/

Disallow: /ajax/

Disallow: /test/

Disallow: /404.php

Запрещает индексировать дубли страниц index.php, index1.php, index2.php и т.д.

Disallow: /*index*.php$

Disallow: */index.php

Запрещает индексировать по умолчанию все параметры типа: ?PAGEN_1, ?sort=asc&order=desc

Disallow: /*?*

Разрешаем индексировать в публичной, доступной всем части сайта: компоненты, шаблоны, изображения, кэш, css, js и т.д.

Тут обратите внимание, выше папки /bitrix/ + /local/ полностью запрещено индексировать, но правилами ниже по коду можно переопределять или дополнять разрешения, т.к. в них есть как служебные, так и публичные данные, необходимые и поисковиками и пользователям.

Allow: /bitrix/components/

Allow: /bitrix/templates/

Allow: /local/components/

Allow: /local/templates/

Allow: /bitrix/cache/

Allow: /bitrix/css/

Allow: /bitrix/js/

Allow: /bitrix/images/

Allow: /bitrix/panel/

Здесь аналогично, выше папка /upload/ полностью запрещена для индексации, а ниже по коду открываем для робота отдельные, необходимые папки, это изображения главного модуля, модуля инфоблоки, медиабиблиотека и динамический ресайз превьюшек.

Allow: /upload/iblock/

Allow: /upload/medialibrary/

Allow: /upload/resize_cache/main/

Allow: /upload/resize_cache/iblock/

Allow: /upload/resize_cache/medialibrary/

Данные параметры вопросов и отзывов относятся к моим решениям, они лишь для примера, в каком месте нужно добавлять параметры для индексации своего проекта, их лучше удалить.

Обратите внимание, выше мы закрывали все параметры директивой Disallow: /*?* в этом месте добавляйте только необходимые параметры, которые должны быть разрешены для индексации, все остальные параметры необходимо закрывать, это все мусор, который замедляет индексацию, лишние итерации поисковика и нагрузка на сайт, вплоть до падения сервера.

Allow: /*?question=*

Allow: /*?review_id=*

Это разрешает индексировать все публичные css и js, это важно при проверке проекта на Удобство просмотра на мобильных устройствах или в Google PageSpeed Insights может всплыть закрытый стиль, из-за которого у проекта могут быть проблемы.

Allow: /*.css

Allow: /*.js

Здесь указываем хост проекта, для https именно так, с указанием протокола.

Host: https://tuning-soft.ru

Здесь указываем путь к карте сайта проекта, обратите внимание, нужно отступить одну строку.

Sitemap: https://tuning-soft.ru/sitemap.xml

Постраничная навигация/пагинация

Очень спорный момент, вы часто можете встретить правила типа:

Disallow: /*nav-*

Disallow: /*?PAGEN

Disallow: /*PAGEN_1=Disallow: /*SHOWALL

Данные правила запрещают индексировать постраничку, это правильно, но если у сайта есть карта sitemap.xml, если карты сайта нет, то постраничка должна быть открыта для индексирования, иначе робот может не найти другие страницы, что в постраничке окажутся на 2-й и далее страницах, а при наличии карты сайта все будет проиндексировано.

Порядок в коде

Еще хочу сказать, как например мне удобно ориентироваться в карте и копировать ее из проекта в проект, ежегодно что-то добавлять в нужное место, не копаясь в сотнях строк непонятных правил.

1-й пример, все запрещающие правила для проекта я добавляю выше строки Disallow: /bitrix/

User-Agent: *

Disallow: /shop/*&*

Disallow: /shop/*nav-*

Disallow: /demo/

Disallow: /inc/

Disallow: /yenisite.resizer2/

Disallow: /bitrix/

2-й пример: все разрешающие правила для параметров проекта я добавляю внизу перед Allow: /*.css

Allow: /*?question=*

Allow: /*?review_id=*

Allow: /*.css

Allow: /*.js

Два параметра для вопросов и отзывов у себя можете удалить, две строчки, я пока еще с ними экспериментирую, их и не так много, парочка параметров обычно максимум набирается.

Советы

Все закрытые, системные, административные скрипты и папки закрывайте формой входа на сайт, правила в файле robots.txt все равно не запрещают роботу ходить по сайту и сканировать все что доступно по ссылке, просканирует и загрузит в базу вообще все, хоть всю админку, а в результатах поиска будет показывать что в robots.txt разрешено показывать, но может и всплыть когда-нибудь дамп вашей базы или файл сброса пароля админа ✌😊

Закрывайте от индексации все порты на сервере, все ссылки, которыми мы в Яндекс.Почте обмениваемся, индексируются поисковиком, стоило один раз скинуть клиенту лично на почту ссылку с портом, как через неделю весь сайт на порту был проиндексирован, а исходный сайт был исключен из результатов поиска, как дубль.

SEO-оптимизация, robots txt и плагины

Есть проблемы с ранжированием, проект не растет, хотите проверить работу своих специалистов по продвижению? Закажите профессиональный аудит в Семантике

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

1C Bitrix — самый популярный коммерческий движок. Он широко используется во многих студиях, хотя идеальным его не назовешь. И если говорить о SEO-оптимизации, то здесь надо быть предельно внимательным.

Правильный robots.txt для 1C Bitrix

В новых версиях разработчики CMS изначально заложили robots.txt, который способен решить почти все проблемы с дублями страниц. Если у вас не обновлялась версия, то сравните и залейте новый robots.

Также внимательней нужно подойти к вопросу роботс, если ваш проект в настоящий момент дорабатывается программистами.

</pre> <p>User-agent: * Disallow: /bitrix/ Disallow: /search/ Allow: /search/map.php Disallow: /club/search/ Disallow: /club/group/search/ Disallow: /club/forum/search/ Disallow: /communication/forum/search/ Disallow: /communication/blog/search.php Disallow: /club/gallery/tags/ Disallow: /examples/my-components/ Disallow: /examples/download/download_private/ Disallow: /auth/ Disallow: /auth.php Disallow: /personal/ Disallow: /communication/forum/user/ Disallow: /e-store/paid/detail.php Disallow: /e-store/affiliates/ Disallow: /club/$ Disallow: /club/messages/ Disallow: /club/log/ Disallow: /content/board/my/ Disallow: /content/links/my/ Disallow: /*/search/ Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*?print= Disallow: /*&print= Disallow: /*register=yes Disallow: /*forgot_password=yes Disallow: /*change_password=yes Disallow: /*login=yes Disallow: /*logout=yes Disallow: /*auth=yes Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*print_course=Y Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*BACKURL=* Disallow: /*back_url=* Disallow: /*BACK_URL=* Disallow: /*back_url_admin=* Disallow: /*index.php$</p> Host: www.site.ru Sitemap: http://www.site.ru/sitemap.xml <pre>

Начальная SEO оптимизация сайта на 1С Битрикс

В 1С Битрикс есть SEO модуль, который идет уже в тарифе “Старт”. Данный модуль имеет очень большие возможности, которые удовлетворят все потребности seo специалистов при начальной оптимизации сайта.

Его возможности:

- общее ссылочное ранжирование;

- цитирование;

- количество ссылок;

- поисковые слова;

- индексация поисковиками.

SEO модуль + Веб-аналитика

Инструменты для поисковой оптимизации по страницам:

- представляется вся информация, которая нужна пользователю для модификации страницы;

- в публичной части выводится базовая информация по контенту страницы;

- отображается специальная информация о странице: частота индексации поисковиками, запросы, которые приводят на эту страницу, дополнительная статистическая информация;

- дается наглядная оценка результативности работы страницы;

- возможность тут же вызвать необходимые диалоги и произвести изменения на странице.

Инструмент для поисковой оптимизации по сайту:

- отображается вся информация, необходимая для модификации сайта;

- базовая информация по содержимому сайта выводится в публичной его части;

- применительно ко всему сайту выводится: общее ссылочное ранжирование, цитирование, количество ссылок, поисковые слова, индексация поисковиками;

- наглядная оценка результативности работы сайта;

- возможность тут же вызвать необходимые диалоги и произвести изменения на сайте.

1С-Битрикс: Marketplace

Также в Битрикс имеется свой Маркетплейс, где есть несколько модулей для SEO оптимизации проекта. Они дублируют функции друг друга, так что выбирайте по цене и функциям.

Простое управление мета-тегами для SEO

Бесплатный

Модуль, который позволяет добавить уникальные SEO-данные (title, description, keywords) на любую страницу сайта, включая элементы каталога.

http://marketplace.1c-bitrix.ru/solutions/kaycom.oneplaceseo/

SEO-инструменты

Платный

- Управление ЧПУ сайта на одной странице.

- Возможность переопределения заголовков, и мета-тегов страниц.

- Возможность установки редиректов.

- Тестирование OpenGraph-тегов.

- Последний заход реального бота Гугла или Яндекса (отложенная проверка валидности бота по его IP-адресу).

- Список переходов на ваши страницы, поисковый трафик

- Подсчет количества лайков к вашим страницам, сторонним сервисом

http://marketplace.1c-bitrix.ru/solutions/asd.seo/#tab-action-link

SEO инструменты: Управление мета-тегами PRO

Платный

Инструмент для автоматической генерации мета тэгов title, description, keywords, а также заголовка h2 для ЛЮБЫХ страниц сайта.

- использование правил и шаблонов;

- применение правила с учетом таргетинга;

- возможность настройки проекта на ЛЮБОЕ количество ключей;

- централизованное управление мета-тегами на любых проектах;

- оперативный контроль состояния мета-тегов на любой странице проекта.

http://marketplace.1c-bitrix.ru/solutions/alexkova.megametatags/

Инструменты SEO специалиста

Платный

Модуль позволяет:

- Устанавливать мета-теги (title, keywords, description).

- Принудительно менять h2 (заголовок страницы), устанавливаемый любыми компонентами на странице.

- Устанавливать признак канонического адреса.

- Устанавливать до трех SEO-текстов в любое место страницы с использованием визуального редактора или без него.

- Многосайтовость.

- Редактировать все вышеуказанное как «с лица» сайта, так и из админки.

- Устанавливать и использовать модуль на редакции Битрикса «Первый сайт».

http://marketplace.1c-bitrix.ru/solutions/intervolga.seo/

ASEO редактор-оптимизатор

Платный

Модуль позволяет задать уникальные SEO данные (title, description, keywords) и изменить контент для HTML-блоков на любой странице сайта, имеющей свой URL, либо для определенного шаблона URL на основе GET-параметров.

http://marketplace.1c-bitrix.ru/solutions/ipol.aseo/

SeoONE: комплексная поисковая оптимизация и анализ

Платный

- Настройка «URL без параметров».

- Настройка «META-данные страниц».

- «Статичные» — здесь вы сможете легко задать уникальные meta-данные (keywords и description) для страницы, а также уникальный заголовок браузера и заголовок страницы (обычно h2).

- «Динамические» — эта настройка аналогична предыдущей. Отличие заключается лишь в том, что она создается для динамически генерируемых страниц (например, для каталога товаров).

- Настройка «Подмена адресов» позволяет задать вторичный URL для страницы.

- Настройка «Экспресс-анализ». На этой странице вы сможете добавить неограниченное число сайтов для анализа.

http://marketplace.1c-bitrix.ru/solutions/imyie.seo1/

ЧПУризатор (выставляем символьный код)

Платный

Модуль позволяет выставить на сайте символьные коды для элементов и разделов в автоматическом режиме.

http://marketplace.1c-bitrix.ru/solutions/imyie.chpurizator/

Linemedia: SEO блоки на сайте

Платный

Предоставляет компонент, который позволяет добавить несколько SEO-блоков текста на любую страницу, установить meta-информацию о странице.

http://marketplace.1c-bitrix.ru/solutions/linemedia.seo/

Ссылка на разделы и элементы инфоблоков

Платный

С помощью данного модуля в стандартном визуальном редакторе появляется возможность добавлять и редактировать ссылки на элементы/разделы инфоблоков.

http://marketplace.1c-bitrix.ru/solutions/studio7spb.iblocklink/

Веб-аналитика в 1C Bitrix: Яндекс Метрика и Google Analytics

Существует несколько вариантов размещения счетчиков в cms:

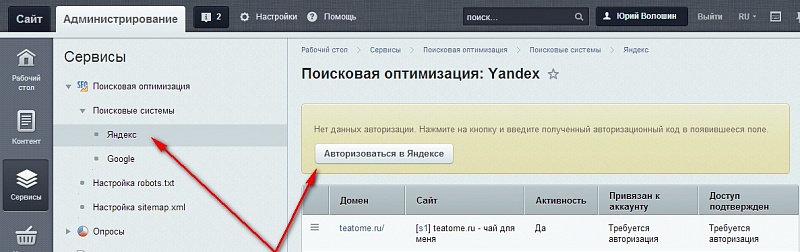

Яндекс Вебмастер и Google webmaster в 1C Bitrix

Да , чтобы добавить сайт в сервис Вебмастер (как в Гугл, так и в Яндекс) существуют встроенные решения, но мы настойчиво рекомендуем напрямую работать с этими сервисами.

Потому, что:

Если вы только создаете сайт и задумались о том, насколько 1C Bitrix подходит для продвижения в поисковых системах и нет ли в нем каких-то проблем, то беспокоиться не нужно. Движок является лидером среди платных cms на рынке и уже очень давно, все seo специалисты (я не только про нашу студию говорю) уже не раз сталкивались с Битриксом и у всех есть опыт.

Продвижение сайта на 1C Bitrix не отличается от продвижения на других cms или самописных движках. Различия можно увидеть лишь в инструментах для оптимизации, о которых мы написали выше.

Но стоит помнить о том, что инструменты сами по себе не продвинут ваш сайт. Здесь нужны специалисты, которые правильно их настроят.

Кстати, у нас полно статей-инструкций, в которых много практических советов с историей многолетней практики. Конечно, мы думали над тем, чтобы наладить тематическую рассылку, но пока не успеваем. Так что удобней всего подписаться на группу нашего блога, куда мы сразу расшариваем новые статьи, как только они появляются в блоге.

Создать и настроить robots.txt в битриксе

Важно передать поисковикам актуальную информацию о страницах, которые закрыты от индексации, о главном зеркале и карте сайта (sitemap.xml). Для этого в корне сайта создается файл robots.tx и заполняется директивами.

Рассмотрим как в самом общем случае в битриксе создать файл robots.txt.

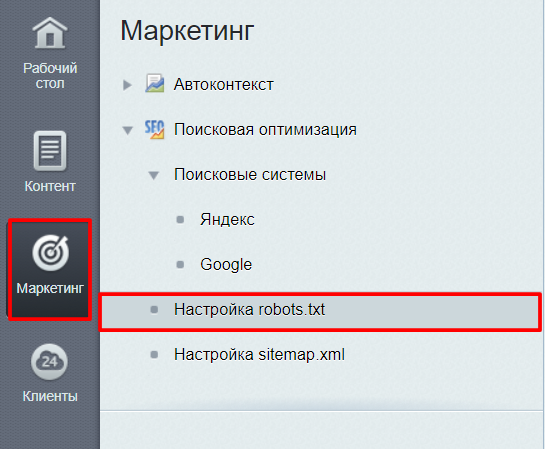

Первое, переходим на страницу Рабочий стол -> Маркетинг -> Поисковая оптимизация -> Настройка robots.txt

Второе, указываем основные правила.

На первой строчке видим User-agent: * , это означает, что директивы указаны для всех роботов всех поисковых систем.

Закрываем от индексации страницу авторизации, личного кабинета и другие директории и страницы, которые не должны попасть в результаты поиска.

Для того, чтобы закрыть директорию пишем правило:

Disallow: /auth/

Третье, указываем главное зеркало сайта с помощью директивы Host. Учтите www, если главным выбран домен с www.

Четвертое, в директиве Sitemap прописываем ссылку к файлк sitemap.xml.

В целом, это все что требуется, для того, чтобы передать файл в вебмастера Яндекса и Google.

В интерфейсе cms битрикс, есть возможность работать с каждым роботом(у поисковиков есть несколько ботов(роботов), которые занимаются отдельными действиями).

Вот роботы Яндекса:

- YandexBot — основной индексирующий

- YandexDirect — скачивает информацию о контенте сайтов-партнеров Рекламной сети, чтобы уточнить их тематику для подбора релевантной рекламы

- YandexMedia — робот, индексирующий мультимедийные данные

- YandexImages — индексатор Яндекс.Картинок

- YandexBlogs поиска по блогам — робот, индексирующий посты и комментарии

- YandexNews — робот Яндекс.Новостей

- YandexMetrika — робот Яндекс.Метрики

- YandexMarket — робот Яндекс.Маркета

Например, вам не нужно индексировать картинки, находящиеся в папке /include/, но вы хотите, чтобы статьи из этого раздела индексировались. Для этого, следует закрыть директивой Disallow папку /include/ для робота YandexImages.

User-agent: YandexImages

Disallow: /include/

Семен Голиков.

Как сделать правильную настройку Robots.txt

Robots.txt — это текстовый файл, который располагается в корне сайта — http://site.ru/robots.txt. Главное его предназначение — это задавать определённые директивы поисковым системам — что и когда делать на сайте.

Самый простой Robots.txt

Самый простой robots.txt, который всем поисковым системам, разрешает всё индексировать, выглядит вот так:

Если у директивы Disallow не стоит наклонный слеш в конце, то разрешены все страницы для индексации.

Такая директива полностью запрещает сайт к индексации:

User-agent — обозначает для кого предназначены директивы, звёздочка обозначает что для всех ПС, для Яндекса указывают User-agent: Yandex.

В справке Яндекса написано, что его поисковые роботы обрабатывают User-agent: *, но если присутствует User-agent: Yandex, User-agent: * игнорируется.

Директивы Disallow и Allow

Существуют две основные директивы:

Disallow – запретить

Allow – разрешить

Пример: На блоге мы запретили индексировать папку /wp-content/ где находятся файлы плагинов, шаблон и.т.п. Но так же там находятся изображения, которые должны быть проиндексированы ПС, для участия в поиске по картинкам. Для этого надо использовать такую схему:

User-agent: *

Allow: /wp-content/uploads/ # Разрешаем индексацию картинок в папке uploads

Disallow: /wp-content/

Порядок использования директив имеет значение для Яндекса, если они распространяются на одни страницы или папки. Если вы укажите вот так:

User-agent: *

Disallow: /wp-content/

Allow: /wp-content/uploads/

Изображения не будут загружаться роботом Яндекса с каталога /uploads/, потому что исполняется первая директива, которая запрещает весь доступ к папке wp-content.

Google относится проще и выполняет все директивы файла robots.txt, вне зависимости от их расположения.

Так же, не стоит забывать, что директивы со слешем и без, выполняют разную роль:

Disallow: /about Запретит доступ ко всему каталогу site.ru/about/, так же не будут индексироваться страницы которые содержат about — site.ru/about.html, site.ru/aboutlive.html и.т.п.

Disallow: /about/ Запретит индексацию роботам страниц в каталоге site.ru/about/, а страницы по типу site.ru/about.html и.т.п. будут доступны к индексации.

Регулярные выражения в robots.txt

Поддерживается два символа, это:

* — подразумевает любой порядок символов.

Пример:

Disallow: /about* запретит доступ ко всем страницам, которые содержат about, в принципе и без звёздочки такая директива будет так же работать. Но в некоторых случаях это выражение не заменимо. Например, в одной категории имеются страницы с .html на конце и без, чтобы закрыть от индексации все страницы которые содержат html, прописываем вот такую директиву:

Теперь страницы site.ru/about/live.html закрыта от индексации, а страница site.ru/about/live открыта.

Ещё пример по аналогии:

User-agent: Yandex

Allow: /about/*.html #разрешаем индексировать

Disallow: /about/

Все страницы будут закрыты, кроме страниц которые заканчиваются на .html

$ — обрезает оставшуюся часть и обозначает конец строки.

Пример:

Disallow: /about — Эта директива robots.txt запрещает индексировать все страницы, которые начинаются с about, так же идёт запрет на страницы в каталоге /about/.

Добавив в конце символ доллара — Disallow: /about$ мы сообщим роботам, что нельзя индексировать только страницу /about, а каталог /about/, страницы /aboutlive и.т.п. можно индексировать.

Директива Sitemap

В этой директиве указывается путь к Карте сайта, в таком виде:

Sitemap: http://site.ru/sitemap.xml

Директива Host

Она предназначена только для Яндекса, потому что он с помощью неё определяет главные зеркала сайта и склеивает их по ней. Про склейку сайтов, в обеих поисковых системах, читайте в моём посте — Как я склеивал сайт в Яндексе и Google.

Указывается в таком виде:

Без http://, наклонных слешей и тому подобных вещей. Если у вас главное зеркало сайта с www, то пишите:

Пример robots.txt для Битрикс

User-agent: *Disallow: /*index.php$

Disallow: /bitrix/

Disallow: /auth/

Disallow: /personal/

Disallow: /upload/

Disallow: /search/

Disallow: /*/search/

Disallow: /*/slide_show/

Disallow: /*/gallery/*order=*

Disallow: /*?*

Disallow: /*&print=

Disallow: /*register=

Disallow: /*forgot_password=

Disallow: /*change_password=

Disallow: /*login=

Disallow: /*logout=

Disallow: /*auth=

Disallow: /*action=*

Disallow: /*bitrix_*=

Disallow: /*backurl=*

Disallow: /*BACKURL=*

Disallow: /*back_url=*

Disallow: /*BACK_URL=*

Disallow: /*back_url_admin=*

Disallow: /*print_course=Y

Disallow: /*COURSE_ID=

Disallow: /*PAGEN_*

Disallow: /*PAGE_*

Disallow: /*SHOWALL

Disallow: /*show_all=

Host: sitename.ru

Sitemap: https://www.sitename.ru/sitemap.xml

Пример robots.txt для WordPress

После того, когда были добавлены все нужные директивы, которые описаны выше. Вы должны получить примерно вот такой файл robots:

Скрытый текст

Это так сказать базовый вариант robots.txt для wordpress. Здесь присутствует два User-agent-a – один для всех и второй для Яндекса, где указывается директива Host.

Существует возможность закрыть от индексации страницу или сайт не только файлом robots.txt, это можно сделать при помощи мета-тега.

<meta name=»robots» content=»noindex,nofollow»>

Прописывать его надо в теге и этот мета тег запретит индексировать сайт. В WordPress существуют плагины, которые позволяют выставлять такие мета теги, например – Platinum Seo Pack. С помощью него можно закрыть от индексации любую страницу, он использует мета-теги.

Директива Crawl-delay

С помощью этой директивы можно задать время, на которое должен прерываться поисковый бот, между скачиванием страниц сайта.

User-agent: *

Crawl-delay: 5

Таймаут между загрузкой двух страниц будет равен 5 секундам. Чтобы уменьшить нагрузку на сервер, обычно выставляют 15-20 секунд. Это директива нужны для больших, часто обновляемых сайтов, на которых поисковые боты просто «живут».

Для обычных сайтов/блогов эта директива не нужна, но можно таким образом ограничить поведение других не актуальных поисковых роботов (Rambler, Yahoo, Bing) и.т.п. Ведь они тоже заходят на сайт и индексируют его, создавая тем самым нагрузку на сервер.

Проверить robots.txt

Чтобы проверить robots.txt для Google, надо зайти в панель вебмастер:

Конфигурация сайта -> Доступ для сканера -> Проверить robots.txt

Тут вы сможете проверять все директивы на работоспособность и экспериментировать с ними.

Проверить robots.txt для Яндекса можно тоже в его Панели Вебмастер, перейдя вот по этой ссылки.

Так же существуют сервисы генераторы robots.txt, которые помогут вас сделать базовые настройки, вот некоторые из них:

1. Seobook

2. 4seo.biz

На этом всё, спасибо за внимание и не забываем подписываться на обновление блога

Управление robots.txt

В этом разделе

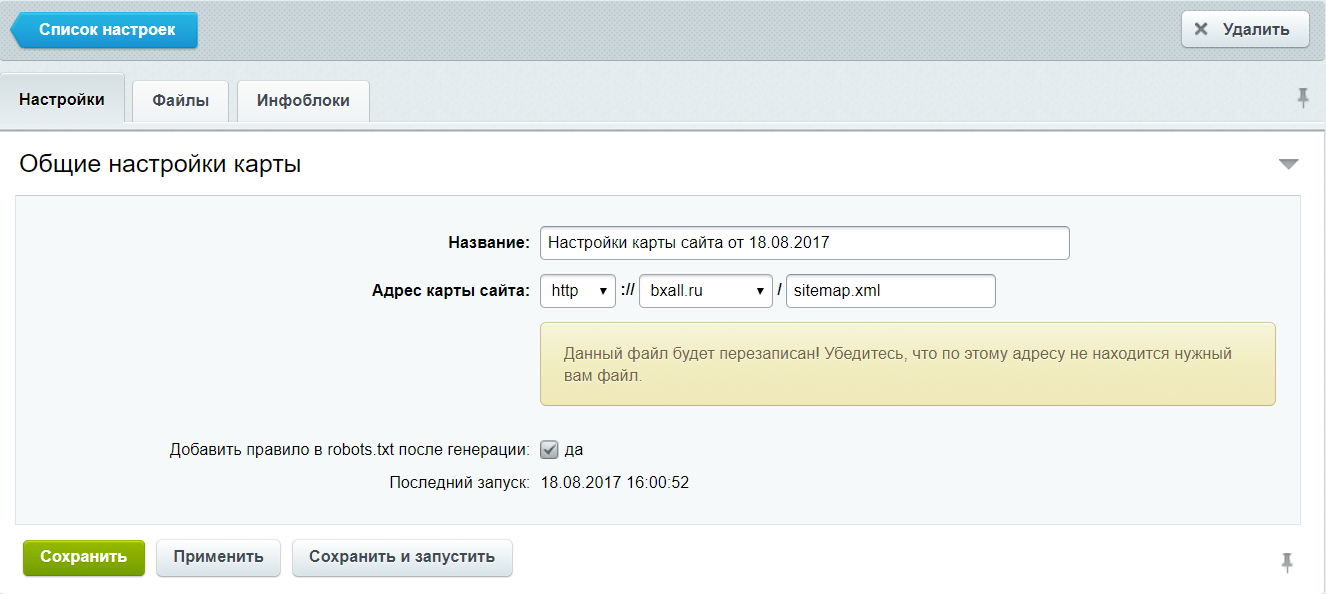

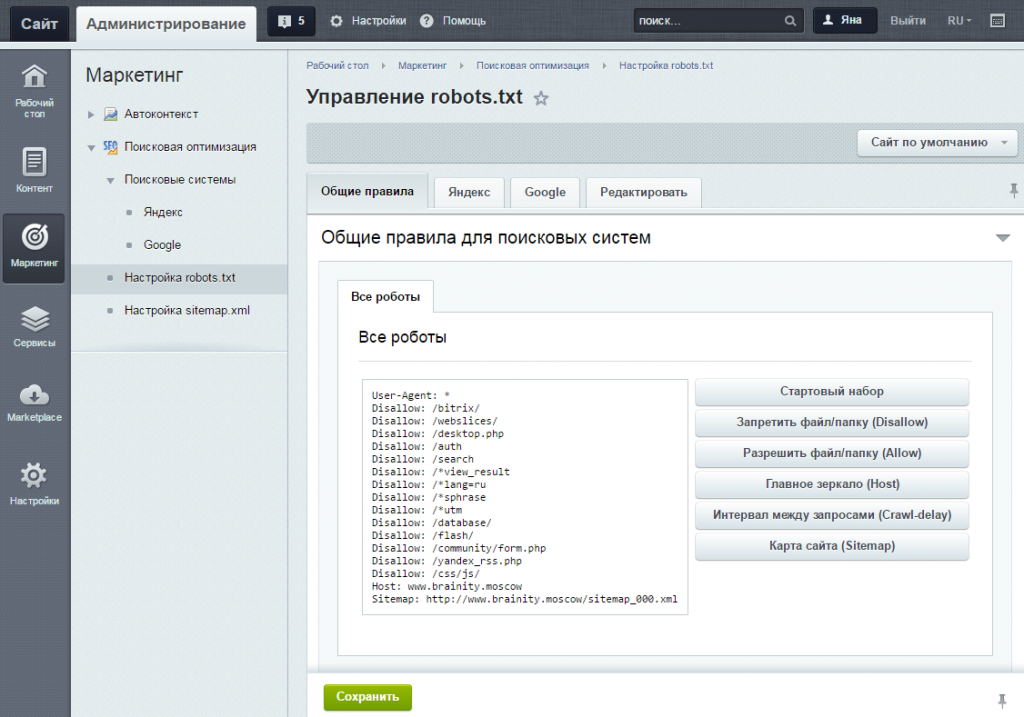

На странице Управление robots.txt (Маркетинг > Поисковая оптимизация > Настройка robots.txt) представлена форма, позволяющая сгенерерировать файл robots.txt.

Контекстная панель

| Кнопка | Описание |

|---|---|

| <название_сайта> | Выбор сайта, для которого должен быть составлен файл robots.txt. |

Поля формы

Закладка «Общие правила»

Данная вкладка служит для указания общих правил для индексирования сайта поисковыми системами. В поле отображается текущий набор инструкций. Любая из инструкций (кроме User-Agent: *) может быть удалена, если навести на нее курсор мыши и нажать на «крестик». Для генерации инструкций необходимо воспользоваться кнопками, расположенными рядом с полем.

| Кнопка | Описание |

|---|---|

| Стартовый набор | Позволяет задать набор стандартных правил и ограничений (закрываются от индексации административные страницы, личные данные пользователя, отладочная информация).

Если часть стандартного набора уже задана, то будут добавлены только необходимые отсутствующие инструкции. |

| Запретить файл/папку (Disallow) | Позволяет составить инструкции, запрещающие индексировать файлы и папки по маске пути.

При нажатии на кнопку открывается форма со списком уже имеющихся инструкций запрета индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые индексировать не нужно. |

| Разрешить файл/папку (Allow) | Позволяет указать файлы и папки, разрешенные для индексации.

При нажатии на кнопку открывается форма со списком путей к файлам и папкам, разрешенных для индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые должны быть проиндексированы. |

| Главное зеркало (Host) | Позволяет задать адрес главного зеркала сайта. Главное зеркало необходимо обязательно указывать, если сайт обладает несколькими зеркалами. |

| Интервал между запросами (Crawl-delay) | Служит для указания минимального временного интервала (в сек.) между запросами поискового робота. |

| Карта сайта | Позволяет задать ссылку к файлу карты сайта sitemap.xml. |

Закладка «Яндекс»

Настройка правил и ограничений для роботов Яндекса. Настройку можно выполнить как сразу для всех роботов Яндекса (вкладка «Yandex»), так и каждого в отдельности (на вкладке с соответствующим названием робота). Внешний вид вкладок одинаков и содержит следующий набор кнопок для генерации инструкций:

| Кнопка | Описание |

|---|---|

| Запретить файл/папку (Disallow) | Позволяет составить инструкции, запрещающие индексировать файлы и папки по маске пути.

При нажатии на кнопку открывается форма со списком уже имеющихся инструкций запрета индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые индексировать не нужно. |

| Разрешить файл/папку (Allow) | Позволяет указать файлы и папки, разрешенные для индексации.

При нажатии на кнопку открывается форма со списком путей к файлам и папкам, разрешенных для индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые должны быть проиндексированы. |

| Главное зеркало (Host) | Позволяет задать адрес главного зеркала сайта. Главное зеркало необходимо обязательно указывать, если сайт обладает несколькими зеркалами.

Важно! Для каждого файла robots.txt обрабатывается только одна директива Host. |

| Интервал между запросами (Crawl-delay) | Служит для указания минимального временного интервала (в сек.) между запросами поискового робота. |

Закладка «Google»

Настройка правил и ограничений для роботов Google. Настройка выполняется для каждого робота в отдельности (на вкладке с соответствующим названием робота). Внешний вид вкладок одинаков и содержит следующий набор кнопок для генерации инструкций:

| Кнопка | Описание |

|---|---|

| Запретить файл/папку (Disallow) | Позволяет составить инструкции, запрещающие индексировать файлы и папки по маске пути.

При нажатии на кнопку открывается форма со списком уже имеющихся инструкций запрета индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые индексировать не нужно. |

| Разрешить файл/папку (Allow) | Позволяет указать файлы и папки, разрешенные для индексации.

При нажатии на кнопку открывается форма со списком путей к файлам и папкам, разрешенных для индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые должны быть проиндексированы. |

| Главное зеркало (Host) | Позволяет задать адрес главного зеркала сайта. Главное зеркало необходимо обязательно указывать, если сайт обладает несколькими зеркалами.

Важно! Для каждого файла robots.txt обрабатывается только одна директива Host. |

Закладка «Редактировать»

На данной вкладке представлено текстовое поле, в котором можно вручную отредактировать содержимое файла robots.txt.

Кнопки управления

| Кнопка | Описание |

|---|---|

| Сохранить | Сохранение внесённых данных в файл robots.txt. |

Смотрите также:

© «Битрикс», 2001-2020, «1С-Битрикс», 2020

Наверх