Обновление алгоритма Google Penguin

Алгоритм Google Penguin – предыстория

Penguin – алгоритм поисковой системы Google, первоначальной ролью которого являлась борьба с неестественными (покупными) ссылками. Дата первого релиза Penguin 1.0 – 24 апреля 2012 года.

Следующие обновления:

Penguin 1.1 – 26 мая 2012 г.

Penguin 1.2 – 5 октября 2012 г.

Penguin 2.0 – 22 мая 2013 г.

Penguin 2.1 – 4 октября 2013 г.

Penguin 3.0 – 17 октября 2014 г.

Запуск обновления Penguin 4.0 неоднократно откладывался. Релиз обновления планировался на конец 2015 года, однако, работа по усовершенствованию алгоритма продлилась до сентября 2016 года.

Представляем вам перевод статьи из официального блога Google: https://webmasters.googleblog.com/2016/09/penguin-is-now-part-of-our-core.html

Пингвин стал частью основного алгоритма Google

Алгоритм Google использует более 200 уникальных сигналов или «подсказок», что позволяет быстро находить то, что ищет пользователь. Эти сигналы включают в себя определенные слова на страницах сайтов, частоту обновления контента, регион сайта и PageRank. Один из таких сигналов Google – это алгоритм Пингвин, который был запущен в 2012 году и 23 сентября 2016 года был обновлен.

После совершенствования и тестирования Google сейчас выкатывает обновление алгоритма Пингвин на всех языках. Представляем вам ключевые изменения, которые вы увидите, они были среди популярных просьб вемастеров:

- Сейчас Пингвин работает в реальном времени. Исторически сложилось так, что список сайтов, «пострадавших» от Пингвина периодически обновлялся. Когда вебмастера улучшали свои сайты, многие алгоритмы Google довольно быстро обновляли информацию о них, но таким алгоритмам, как Пингвин, требовалось время для обновления данных. Теперь данные Пингвина обновляются в реальном времени, а значит, изменения на сайте будут замечены Гуглом гораздо быстрее. Как правило, они вступают в силу сразу после повторного обхода роботом и индексации страниц. Это означает, что Google не собирается больше анонсировать свои обновления.

- Пингвин стал более детальным. Сейчас он понижает страницы, содержащие спам путем изменения рейтинга, основанного на спам-сигналах, а не влияет на ранжирование сайта в целом. Т.е происходит занижение в выдаче одной или нескольких страниц, а не всего сайта.

Интернет (web-паутина) существенно изменился за эти годы, но как Google говорил в своем первоначальном посте, вебмастера должны быть свободны в своих действиях, чтобы сосредоточиться на создании убедительных и полезных сайтов. Также важно помнить, что обновления наподобие Пингвина – это только один из более 200 сигналов, который Google использует для ранжирования сайтов.

Если Вы хотите прочитать о предыдущих обновлениях алгоритма Google Penguin, рекомендуем прошлые наши статьи:

- Продвижение ссылками: защищаем сайт от Пингвина

- Кто виноват – Пингвин или Панда?

- 5 важных изменений в алгоритмах Google

Новый алгоритм Гугла (Google Penguin), как вывести сайт из под фильтра (вебспам и черное SEO)

В начале апреля и мае этого года весь SEO мир Рунета был очень взволнован. Веб-мастера и оптимизаторы начали анализировать последствия введения поисковой системой Гугл новых (обновленных) алгоритмов: Google Panda и Google Penguin.

О том как работает обновлённый алгоритм Гугла (Google Panda) я уже рассказывал в другой статье. Главной задачей алгоритма Гугл Панда было очищение выдачи от сайтов низкого качества. Серьёзно пострадали сайты, которые имели много некачественного и неуникального контента, размещали много назойливой рекламы и были не любимы пользователями (имели плохие поведенческие факторы). Проще говоря, в большинстве своём пострадали сайты, которые, по мнению Гугла, представляют малую пользу для посетителей. Более подробно о Гугл Panda я уже рассказывал здесь.

Ведущие оптимизаторы и СЕО специалисты ещё не успели разобраться с последствиями для сайтов от Google Panda, как на свет появилась новая «птица», в виде алгоритма Google Penguin. После введения Гугл Пингвин выдача заметно преобразилась. Были существенно понижены в результатах поиска или вообще исключены из него сайты, которые злоупотребляли поисковым спамом (webspam) и использовали методы чёрного SEO. Очень заметны последствия от работы нового алгоритма Гугла для сайтов, которые продвигались только за счёт «некачественных» покупных ссылок (к примеру, ссылки, купленные через биржи автоматического размещения).

Итоговый вывод о новом алгоритме Гугла (Google Penguin) я напишу в конце статьи, а сейчас предлагаю ознакомиться с мнениями ведущих СЕО специалистов и оптимизаторов Рунета.

Мнение ведущих экспертов и SEO специалистов о новом алгоритме Гугла (Google Penguin):

За что наказывает сайты алгоритм Google Penguin (мнение ведущих специалистов в области SEO):

Как защитить свой сайт от фильтра Google Penguin (советы от ведущих зарубежных оптимизаторов и экспертов):

Что говорят о Гугл Пингвине на ведущем SEO форуме Рунета (forum.searchengines.ru):

Мнение известных seo специалистов в русскоязычном Интернете:

Что говорят разработчики Google Penguin (Мэтт Каттс) и ведущие зарубежные SEO эксперты:

Также рекомендую посмотреть видео, в котором Мэтт Каттс (Matt Cutts – ведущий специалист по развитию качества поиска Google) рассказывает о том, за что поисковые алгоритмы Гугла (Google Penguin, Google Panda и др.) накладывают фильтры на сайты и как их можно снять. Чем отличаются автоматические и ручные алгоритмы наложения фильтров.

За что на сайт накладываются фильтры Гугла и как можно снять фильтр с сайта?

Чтобы увидеть русский перевод, необходимо запустить видео, и после начала просмотра внизу экрана появится кнопка «CC» (субтитры), после нажатия на эту кнопку появится вариант выбора русского языка. Русский перевод от Mike Shakin.

И в завершение темы, выскажу своё личное мнение (Руслан Савченко, ruslansavchenko.com):

«Стоит отметить два утверждения разработчиков алгоритма Google Penguin, которые противоречат друг другу: Google не учитывает влияние плохих ссылок и игнорирует их, но в тоже время, если на Ваш сайт будут вести спамные ссылки, он потеряет свои позиции в поиске и трафик с Гугла уменьшится.

Из этих противоречий можно предположить следующее: алгоритмы Гугла не станут обращать внимание на ссылки с некачественных сайтов, если их число не превышает количество «хороших ссылок». Но если сайт продвигается исключительно за счёт «спамных» ссылок (webspam), используются так называемые «ссылочные сети», биржи, где размещаются неестественные покупные ссылки, то позиции таких сайтов будут понижаться.

Google Penguin и Google Panda, работая в связке, научились хорошо отличать естественные и качественные методы SEO от «неестественных» и некачественных.»

Также рекомендую Вам посмотреть довольно интересный и понятный видео доклад об алгоритме Гугл Пингвин.

Видео доклад Андрея Буца о новом алгоритме Google Penguin:

Главные тезисы доклада:

- Какие сайты были наказаны новым алгоритмом Google Пингвин?

- Какие методы «продвижения» сайтов больше не будут работать?

- Пример «чёрного» SEO или за какую переоптимизацию наказывает алгоритм Гугла (Google Penguin)?

- Какие ссылки (по мнению алгоритмов Google) считаются естественными, а какие нет?

- Как правильно «разбавлять» анкоры (продвигаемые ключевые слова), чтобы не попасть под пессимизацию и сэкономить бюджет на продвижение?

- В каком соотношении использовать ссылки с повременной оплатой (SAPE и пр.) и вечные ссылки (с разовой оплатой навсегда), к примеру, Gogetlinks?

- Какие ссылки алгоритмы Гугла считают релевантными, а какие нет?

- Чем полезны безанкорные ссылки?

- Как учитываются безанкорные ссылки (без ключевых слов, только урл ссылки)?

Мои выводы (Савченко Руслан) относительно нового алгоритма Google (Гугл Пингвин). Как изменилось продвижение сайтов (SEO) после запуска Google Penguin?

- Продвижение «на автомате» только при помощи ссылочных бирж с автоматическим размещением стало малоэффективным. Такие ссылки можно использовать с пользой для продвижения, они до сих пор работают, но только при их размещении на релевантных страницах (текст на странице должен соответствовать тематике ссылки).

- Безанкорные (естественные) ссылки стали хорошо учитываться в продвижении по запросам, но необходимо правильно их использовать. Важен околоссылочный текст, который учитывается алгоритмами Google. О том, как можно получать бесплатные вечные ссылки и как проводить бесплатный обмен ссылками я уже писал раньше здесь.

- Продвижение сайтов (SEO) стало дольше, дороже, сложнее.

- Продвижение сайта исключительно за счёт приобретения ссылок стало малоэффективным. Очень важна правильная «белая» оптимизация (которую приветствуют разработчики Гугла). О правильной оптимизации отдельных страниц и всего сайта в целом я подробно говорил в своём видеокурсе по SEO оптимизации сайта, и буду ещё рассказывать в следующих статьях и видеоуроках.

Для тех, кто знает английский язык (субтитры идут на английском), предлагаю посмотреть видео-прикол про алгоритм Гугл Пингвин. Задумка автора очень проста: «Гитлер» многие годы создавал сайты, зарабатывал на них, и в один момент всё рухнуло под «натиском» Google Penguin.

На этом мы завершаем обзор нового поискового алгоритма Google Penguin. Буду рад «услышать» Ваши мнения в комментариях. Какое влияние оказал Гугл Пингвин на Ваши сайты?

Если Вас интересует вопрос: как на практике вывести ваш сайт из под современной версии фильтра Google Penguin, рекомендую вам новый уникальный видеокурс «Как вывести сайт из-под «фильтров» (санкций) поисковых систем Яндекс или Google?».

Google Penguin – антиспам алгоритм поисковой системы Google

Гугл Пингвин – это антиспам алгоритм от поисковой системы Google, который впервые вступил в силу 24 апреля 2012 года.

Основная задача алгоритма улучшить результаты поиска, и урезать воздух тем сайтам, которые использует спамные техники обратных ссылок на сайт.

Если Google Панда отвечает за контент на сайте, то алгоритм Google Penguin отвечает за обратные ссылки на сайт.

Как это было после ввода Пингвина

Было затронуто:

— 3.1% поисковых запросов (США — английский)

— 3% поисковых запросов (немецкий, китайский, арабский)

— 5% (русский, польский)

Обычный ход действий сайтов, которые пострадали:

Позиции сайта резко проседают, обычно на 10-20 позиций, если не принимать и каких мер, то они вовсе уходят из зоны видимости, то есть в – 100.

Следствие чего резкое падение трафика на сайте:

За 3-4 недели до того как падает трафик на сайт может прийти письмо в Google Webmaster Tools, в котором будет идти речь про то что используются неестественные ссылки на сайт, которые нарушают правила Google для вебмастеров.

Сайты, которые больше всего пострадали от Google Penguin

— Сайты, на которых были некачественные ссылки с подозрительных ресурсов

— Сайты с большим процентом прямого вхождения анкора

— Сайты, у которых однопрофильная ссылочная масса

В статье про анализ сайтов конкурентов написано, каким образом моно проверить обратные ссылки на сайт, и понять какой ссылочный профиль сейчас на сайт.

Алгоритм Google Пингвин сильно изменил продвижение сайтов, на мой взгляд, в лучшую сторону, где качество и естественность ссылок на сайт будет иметь большое значение.

Как продвигать сайт после Пингвина

Для того что бы понять, каким образом нужно продвигать сайт, после Google Penguin, предлагаю ознакомиться со слайдами доклада, с которым выступил Виктор Карпенко на конференции SeoConference 2012.

Алгоритм постоянно усовершенствуется, и по -прежнему если продвигать сайт прежними техниками продвижения, то есть большая доля вероятности попасть под фильтр, следствие чего – падает трафик, звонки и заявки, продажи.

Оцените статью

Загрузка…

Загрузка…Алгоритм Google Penguin — особенности и эксперимент по возврату посещаемости — Сосновский.ру

Привет, друзья! Большое спасибо за поздравления с трехлетием блога. Было очень приятно. В прошлом посте я упомянул о том, что гугл «помог» мне увеличить посещаемость блога за последние полгода. Как вы уже могли понять по заголовку, относительно новый алгоритм Penguin не обошел и мой дневник. Почему так произошло? Что предпринимать в данной ситуации? Как вернуть посещаемость с этой поисковой системы? Всеми этими вопросами я начинаю новый эксперимент по возврату посещаемости с google.ru.

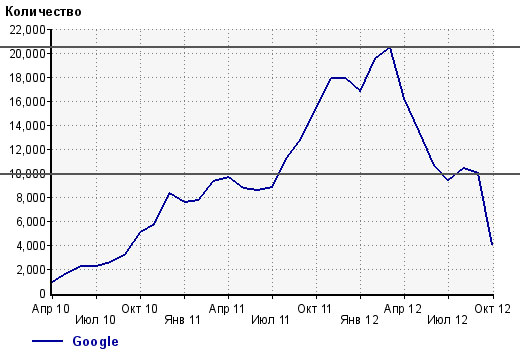

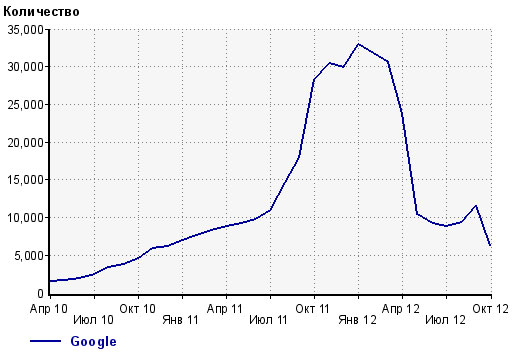

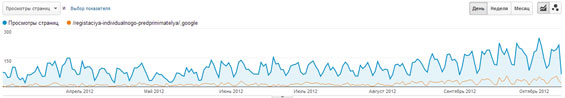

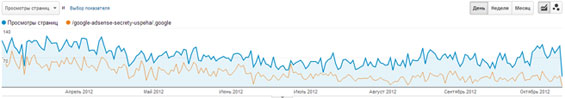

«Прошло практически полгода! Уже не актуально!» — могут сказать некоторые. Во-первых, для меня это актуально (ранее не нашел время, чтобы этим заняться). Во-вторых, это актуально и для многих сайтов, которые мне попадались, и которые до сих пор находятся под влиянием Пингвина от Гугла. В-третьих, данный алгоритм не был одноразовым. Он работает и усовершенствуется до сих пор. В связи с этим, поизучать его никогда не поздно ![]() . Вот мой график посещаемости с этой ПС. Она упала в 2 раза.

. Вот мой график посещаемости с этой ПС. Она упала в 2 раза.

Суть алгоритма

В первую очередь, Google Penguin был направлен на борьбу с веб-спамом: внутренним (на сайте) и внешним (в виде обратных ссылок). Раньше считалось, что гугл любит немного переспамленные тексты и анкор-листы с прямым вхождением продвигаемого ключевого слова. Данный алгоритм перевернул понятие о продвижении в google у вебмастеров и оптимизаторов.

По внутренним факторам в принципе все понятно — не нужно переоптимизировать тексты, внутренние линки. По обратным ссылкам складывается не совсем однозначная ситуация.

Мэтт Катс в интервью на searchengineland говорит о том, что они много работы проделали для того, чтобы один человек не смог негативно подействовать на сайт другого человека. Имеется в виду негативное влияние ссылок. Также он говорит, что плохие ссылки в глаза Пингвина игнорируются, а не негативно сказываются на ранжировании ресурса.

Почему же тогда многие проекты потеряли столько трафика? Если эти сайты по большей части держались в ТОПах из-за покупного ссылочного, то оно для них перестало действовать. По внутренним же факторам они не дотягивали до хороших мест в выдаче. Другими словами, определяющий на тот момент ссылочный фактор, который держал проекты в десятке, потерял свое былое значение. По большей части, действию алгоритма не подверглись старые трастовые сайты с хорошей контентной составляющей и естественными ссылками. C этими выводами, конечно, можно спорить, потому как попадаются частные ситуации, которые выбиваются из общей картины. Это, на мой взгляд, недостаток, присущий любым алгоритмам и фильтрам, которые несправедливо наказывают качественные ресурсы.

Google Penguin анонсировался 24-25 апреля. На самом же деле, по моим наблюдениям, его влияние началось несколько ранее. Это можно увидеть и на моем графике и на некоторых других.

Мэтт Катс говорит, что если на вашем сайте упала посещаемость с ПС google, то это не говорит о том, что постарался Пингвин. Борьба с низкокачественными ссылками происходит давно. Я думаю, что он все-таки лукавит, а действовать данный алгоритм начал немного раньше его официального запуска.

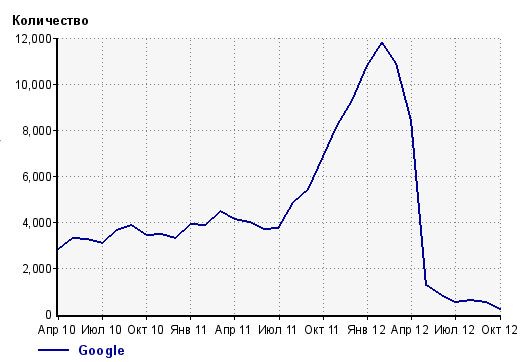

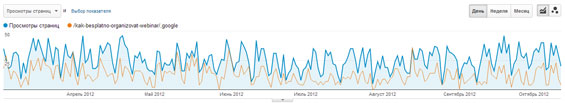

Анализируя посещаемость блога с гугла за последние полгода, я сделал вывод, что алгоритм по большей части затрагивал конкретные страницы, а не сайт целиком или отдельные запросы (поэтому статистику по отдельным ключевым словам я не рассматриваю в этом посте). Например, на некоторые документы трафик с этой поисковой системы не упал.

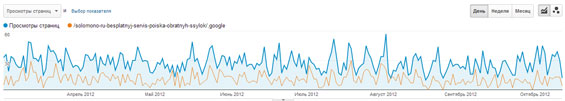

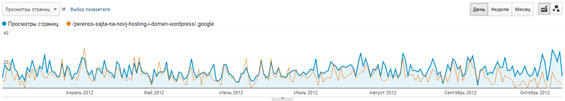

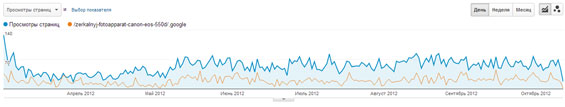

Все графики с google analytics увеличиваются по клику (в новом окне). Синяя линия — это общее число просмотров страницы, оранжевая — переходы с гугла.

А по некоторым увеличился.

На все эти страницы не приобретались ссылки. Текст, соответственно, писался для людей ![]() . Это лишний раз подтверждает, что просто нормальные страницы с нормальным контентом и без внешнего продвижения ведут себя стабильно. Выявить те документы, на которых подросла посещаемость или осталась на том же уровне также полезно. Они станут «примером подражания» для остальных. То есть, анализируя их, можно понять, что нравится поисковой системе, ее алгоритму.

. Это лишний раз подтверждает, что просто нормальные страницы с нормальным контентом и без внешнего продвижения ведут себя стабильно. Выявить те документы, на которых подросла посещаемость или осталась на том же уровне также полезно. Они станут «примером подражания» для остальных. То есть, анализируя их, можно понять, что нравится поисковой системе, ее алгоритму.

Как выявить проблемные страницы?

Способ №1.

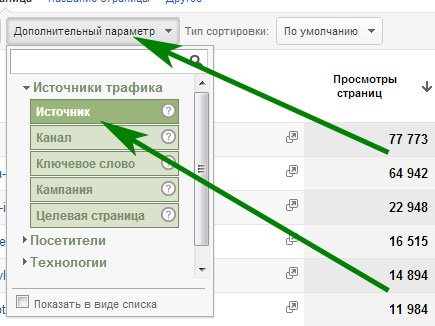

Разберу на примере Google Analytics. Сначала необходимо определить на какие документы шло больше всего посетителей с гугла. Заходим «Содержание» -> «Обзор» -> «Содержание сайта» -> «Все страницы». Далее нужно внести дополнительный параметр по трафику с поисковиков. Для этого нужно нажать «Дополнительный параметр», затем «Источник трафика» -> «Источник».

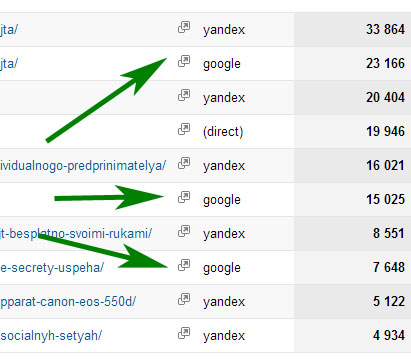

Появится список самых посещаемых документов в разрезе с источниками. Нужно смотреть на те строки, где числится google.

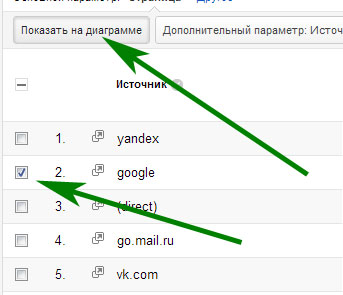

Например, кликаем на первую страницу, на которую за выбранный период приходился максимум посетителей с гугла. Далее также добавляем параметр «Источник». Нажимаем чекбокс на строке, где красуется «google» и кликаем «Показать на диаграмме».

Таким образом, получаются графики, которые я публиковал выше (с общим трафиком на документ и посетителями с гугл). Вот примеры со снижением количества ежесуточных посетителей.

Видите, посещаемость упала, но не пропала. Я проверил некоторые запросы в поисковой выдаче. Они упали на 5-15 позиций. Существенно для снижения количества посетителей, но не совсем критично для видимости сайта в ПС (позиции в пределах ТОП 10-20).

В идеале, так нужно посмотреть все страницы, которые приносили с данной поисковой системы хотя бы какой-то трафик, но не ниже 100-200 в месяц. Если будет меньше, например, 1-2 посещения в сутки, то по данным полученного графика можно сделать неправильные выводы.

Найденные страницы, на которых упал трафик, нужно проверить на:

- Качество контента. Возможно, ваш документ ранее не заслуживал высоких позиций. Гугл просто восстановил справедливость. В таком случае, нужно поднять его качества.

- Переспам в ключевых словах, нечеловеческие словоформы. Тексты для людей становятся более актуальными. В этом пункте нужно «очеловечить» существующие тексты.

- Переспам в анкор-листе, например, прямыми вхождениями. Необходимо разбавить ссылочную массу: изменить старую, либо дополнительно создать «естественную» новую.

В некоторых случаях нужен комплексный подход. Что касается малопосещаемых страниц, низкочастотных запросов и длинного хвоста, то, на мой взгляд, посещаемость на них и по ним может вернуться, когда с основными трафикогенерирующими документами будет все в порядке. Вернется доверие и траст со стороны поисковика (в случае если со страницами будет все нормально, а в алгоритме заложено взаимодействие анкор-листа страницы с анкор-листом всего сайта). «Нормализация» анкор-листов отдельных документов приведет к «нормализации» анкор-листа всего проекта.

Это я разбирал по аналитиксу. В статистике liveinternet тоже можно делать подобное, но необходимо добавить срез по поисковой системе гугл. К сожалению, если ранее он у вас не был установлен, то данные по посещаемости конкретных страниц с конкретных источников получить нельзя. По крайней мере, я не смог найти. Если вы знаете, как это сделать, то напишите в комментариях ![]() . Правда, можно анализировать посещаемость страниц (здесь же можно и запросов) в целом. В таком случае, конечно, могут появиться погрешности, но все равно картина должна быть понятна. Насчет метрики и других сервисов статистики ничего не могу сказать.

. Правда, можно анализировать посещаемость страниц (здесь же можно и запросов) в целом. В таком случае, конечно, могут появиться погрешности, но все равно картина должна быть понятна. Насчет метрики и других сервисов статистики ничего не могу сказать.

Способ №2.

В первом способе анализ шел от полученных изменений. Второй способ попроще, но подольше. Нужно «вручную» проанализировать каждую страницу вашего ресурса на качество контента, а также обратные ссылки на предмет переспама анкор-листа. Довольно-таки не технологический способ, но в некоторых ситуациях не менее эффективный.

Этот пост является началом эксперимента по возврату посещаемости. В нем я рассказал, как можно искать проблемные страницы и немного затронул особенности самого Google Penguin. В следующей части эксперимента, который должен выйти после очередного апдейта этого алгоритма (последний был 5 октября), я расскажу, что делал и что из этого получилось. Надеюсь, что мне удастся вернуть тенденцию развития посещаемости с гугла.

А вас коснулся гугловский пингвин? Получилось найти проблемные документы на сайте? Что-нибудь предпринимали или пускали на самотек? Чего получилось добиться? Жду ваши отзывы и мысли в комментариях ![]() .

.

как защитить свои позиции в выдаче — Netpeak Blog

Известный всем Барри Шварц давно говорил, что Google любит выкатывать обновления своих алгоритмов после обеда в пятницу. Google Penguin официально стал частью основного алгоритма поисковика тоже в пятницу.

Мы решили дать несколько дельных советов тем, для кого это стало потрясением: как обезопасить свой бизнес и встретить апдейт алгоритма Google во всеоружии.

Вначале несколько слов о самом «Пингвине».

Алгоритм выкатили 24 апреля 2012 года, тогда «Пингвин» затронул примерно 3,1% всех поисковых запросов. Были понижены в ранжировании или полностью исключены из поиска сайты, которые злоупотребляли поисковым спамом, продвигались за счет некачественных покупных ссылок и вообще — использовали самые грязные технологии черного, как душа трубочиста, SEO 🙂

Если обобщить, то Penguin реагирует на:

- некачественные бэк-линки;

- большое количество ссылок с оптимизированными анкорами;

- рекламные текстовые ссылки, передающие PageRank;

- запрещенные схемы линкбилдинга — определялись по объемам обмена ссылочной массой и скорости прироста ссылочной массы.

Одним словом, почти каждый сайт в сети рисковал исчезнуть из выдачи во время очередного апдейта алгоритма. Под санкции «Пингвина» попадают как отдельные страницы, так и целые сайты. Вердикт определяется по показателям вашего ссылочного графа.

Если не хотите попасть в глотку прожорливого пингвина, избегайте теневых тактик. Google поставил перед собой чёткую цель: делать всё для улучшения пользовательского опыта. Это значит, что каждый существующий в сети сайт, по мнению Google, должен предоставлять пользователям то, что они хотят видеть, быть качественным и ценным. И только тогда его позиции поползут вверх.

To do list: на что обратить внимание при подготовке к обновлению алгоритма

Изменения трафика: анализируй то, анализируй это.

Первым шагом в подготовке должен быть ретроспективный анализ. Ответьте сами себе на вопрос: как ваш сайт пережил предыдущие обновления алгоритмов, как и когда упал трафик, как долго вы его восстанавливали? Вы должны знать свои сильные и слабые стороны. Постарайтесь реально оценить ситуацию.

Это не пустые слова. Многие сразу побегут скачивать софт для удаления некачественных бэков, а причины-то падения могут таиться совсем в другом. Важно понимать, что многие сайты падают в выдаче из-за ошибок в коде, некачественного контента, проблем с серверами и т.д.

Тщательный анализ необходим для того, чтобы определить истинную болезнь и лечить её соответствующим образом. Всё остальное — просто блуждание в потемках и трата времени.

Чтобы поставить диагноз «Пингвин», нужно проанализировать многие факторы: колебания трафика, разнообразие анкоров, ссылки с follow и nofollow, ссылочный профиль сайта, авторитет и трастовость ресурсов. Это потенциальные «зоны риска» сайта во время нового апдейта алгоритма.

Обязательно пользуйтесь инструментами анализа: если вы не знаете, какой входящий трафик является нормальным, то не сразу сможете определить, попали ли вы под санкции «Пингвина». Кроме стандартной GA, есть сервисы, предоставляющие много полезной информации для анализа входящего трафика.

Американцы, например, используют Compete.com и Quantcast, но нам от них проку мало, так как международный трафик они почти не считают.

Нам же стоит обратить внимание на сервисы:

- Alexa (владелец — Amazon), в отличие от GA, больше направлена на формирование целостной картины входящего трафика. Даёт много полезной информации: уровень трафика, среднее время посещения сайта, список сайтов с ссылками на ваш сайт и многое другое.

- BizInformation. Удобный сервис, также выстраивает красивые линейные графики, предлагает сводную статистику посещений и оценку общей стоимости вашего сайта. Также сервис сообщает о количестве ссылок на ваш сайт с разных соцсетей, включая Digg, Reddit, и StumbleUpon.

Разнообразие анкоров

Google довольно давно раздает санкции за «агрессивный» анкорный текст для ключевиков на бэках. Анализ предыдущих обновлений Penguin выявил критическую важность разнообразия анкорных текстов и релевантности ссылок.

Вот то, что мы знаем наверняка:- В анкорных текстах пострадавших от «Пингвина» сайтов в 65% и более случаев висели проплаченные ключевики.

- У сайтов, которые избежали санкций, проплаченные ключевики встречались в 50% случаев и меньше.

Что это значит для вас? Подумайте о ваших анкорах, как аксессуарах: они нужны там, просто для повышения ценности. Ваша цель — избежать переоптимизации. Перед встречей с «Пингвином» важно, чтобы сайт выглядел как можно естественней.

Анализ бэклинков

Ребята из Search Engine Watch как-то взяли интервью о разнообразии текстов в анкорах и бэклинках у Брюса Клэя (Bruce Clay), ветерана SEO-продвижения. Он порекомендовал регулярно просматривать ваш ссылочный граф — по крайней мере раз в месяц.

За чем необходимо следить:

1. Ищите и удаляйте низкокачественные ссылки. Удалить ссылку в два раза сложнее, чем поставить. В случае, если вы не в состоянии удалить спамные ссылки или добавить достаточно хороших ссылок, стоит составить список ссылок, которые вы пытались удалить и обратиться в Google с просьбой не считать их.

2. Увеличивайте количество бэклинков с сайтов в сходной с вашей нише. Под санкции в предыдущем обновлении Penguin попали сайты с незначительным количеством бэков с ресурсов в той же или аналогичной нише. Ключевыми параметрами становятся качество и релевантность ссылок.

3. Почистите свой сайт и уберите дублирующийся контент. Если какой-нибудь некачественный сайт скопирует вашу страницу, то это может быть прямой угрозой для вас. Хороший сервис для поиска «ворованного контента» — Copyscape. Если вы обнаружили такие страницы — срочно пишите отчет DMCA для Google.

Требуйте удаления дублирующегося контента. Само собой, стоит провести SEO-аудит собственного сайта и убедиться, а не дублируете ли вы сами свой контент.

4. Удалите все бэки из сетей гостевых блогов. Мэтт Каттс уже доказал, что Google будет расправляться со всеми такими случаями. Слишком многие SEO-сайты примкнули к сервисам гостевого блоггинга в погоне за новыми ссылками. Чтобы обезопасить себя, ставьте nofollow к ссылкам с гостевых блогов.

5. Избегайте ссылок из виджетов — это признак покупной ссылки.

6. Удалите точные совпадения анкоров или по крайней мере настройте их, чтобы ваш список анкоров был более разнообразным.

7. Удалите все ссылки со спамных сайтов.

Ссылки follow vs ссылки nofollow

На самом деле нет никакого противопоставления: следует использовать комбинацию двух видов ссылок для качественного SEO-продвижения. Слишком много ссылок follow может быть симптомом спамности, так что ваш сайт может легко попасть под санкции. Что же касается пресыщения ссылками nofollow, то, если верить Мэтту Катсу, его просто не бывает. Впрочем, если вы спамите комменты или как-то иначе раздражаете пользователей, они вполне могут написать о вашем спаме в Google и на сайт наложат ручные санкции.

Инвентаризируйте ваши ссылки. Убедитесь, что среди них нет спамных или искусственных. Уделите внимание созданию качественных ссылок, которые имеют прямое отношение к вашему бренду или бизнесу. В этом случае стоит больше думать не об оптимизации, а о продвижении и качественной самопрезентации.

Скорость прироста ссылочной массы

Спонтанное, искусственное увеличение скорости размещения ссылок может подвести вас под санкции. Распространено заблуждение, что любое увеличение трафика повлечет за собой санкции Google. На самом деле это не так. От источника трафика зависит то, как Penguin посмотрит на ваш случай. Алгоритм учитывает релевантность сайта и существующие тенденции. Новым сайтам тоже нечего бояться. Они часто вызывают шквал в прессе, что приводит к тоннам качественных ссылок. Алгоритм распознаёт, когда медиа-бурю вызвала новость, сезонный трафик или вирусный пост.

Поддержка авторитета и трастовости

Авторитетные ссылки позволяют сохранить лицо компании. «Пингвин» учитывает и авторитет, и уровень трастовости ресурса. Можно сказать, что на трастовости строится авторитет, а авторитет даёт больше трастовости: эти понятия идут вместе. Определить уровень трастовости и авторитетности сайта позволяет, например, бесплатная версия сервиса MozBar. Чем выше будет авторитет и трастовость, тем меньше вероятность, что при обновлении алгоритма у сайта возникнут проблемы.

Постоянный мониторинг

Используйте системы мониторинга. Ahrefs, WMT и Majestic SEO помогут держать руку на пульсе и внимательно следить за бэклинками, а также выявлять проблемы сразу после их появления.

Мы решили узнать у коллег, что они думают про апдейт алгоритма Google.

Алексей Данилин, SEO-специалист Netpeak: cуществует множество разных способов получить качественные тематические ссылки, за которые вас не будут наказывать. Такие ссылки должны приводить на сайт посетителей, которые будут выполнять целевые действия (например, совершать покупки). Подумайте, почему на ваш сайт вообще нужно ставить ссылку? Чем он может быть полезен и чем отличается от других аналогичных? Ответы на эти вопросы помогут вам двигаться в нужном направлении.

Олег Скрып, SEO-специалист: cледует просто ожидать появления естественных ссылок на сайт. А потом эти же естественные ссылки отклонять и писать на них жалобы, так как появляться они могут на «спамных» ресурсах. Например, на форумах и блогах. В свою очередь, хотелось бы отметить, что, по моему мнению, разнообразие ссылочного профиля — вот ключ к успеху. Наращивайте разнообразные анкоры, разнообразные типы ссылок, и вряд ли птица, которая не умеет летать, доберётся до вашего сайта.

Кто виноват – Пингвин или Панда? Статья о двух алгоритмах Google

Если вы заметили снижение трафика на свой сайт из поисковиков (из органической выдачи), то возможно, что ваш сайт попал под действие фильтров поисковых систем, и его позиции в результатах поиска были занижены. Сегодня мы поговорим о поисковике Google и двух его алгоритмах – Гугл Панда и Гугл Пингвин.

Алгоритм Google Panda (Панда) нацелен на повышение качества результатов поиска. Поэтому он занимается оценкой контента сайта – проверяет уникальность текстов, их информативность, наличие добавочной ценности, количество ключевых слов (чтобы не было переспама).

Алгоритм Google Penguin (Пингвин) борется с неестественными внешними ссылками. Такими будут покупные ссылки, ссылки с сайтов-сателлитов и с нерелевантных сайтов.

Шаг первый. Проверяем сообщения от Google

Оказывается, наложить ограничения на сайт могут не только автоматические алгоритмы Гугл, но и самые реальные люди – его сотрудники. Чтобы проверить, нет ли таких ограничений, заходим в Инструменты Google для веб-мастеров, щелкаем по нужному нам сайту и заходим в раздел «Сообщения о сайте» – в этот раздел придет сообщение о наложенных вручную ограничениях. Также посмотреть, приняты ли меры к сайту, можно в разделе «Поисковый трафик» – «Меры, принятые вручную».

Ручные меры могут быть приняты по таким причинам, как искусственные ссылки на ваш сайт (или на вашем сайте), спам, скрытый текст, избыток ключевых слов, неинформативный контент, взломанный сайт.

Устраните причину, указанную в сообщении от Гугл, и отправьте заявку на повторную проверку (с помощью кнопки «Запрос на рассмотрение» в сообщении в разделе «Меры, принятые вручную»).

Если сообщений о ручных мерах нет, переходим к анализу статистики.

Шаг второй. Проверяем трафик из Google

Смотреть статистику посещаемости сайта можно как в Google Analytics, так и в Яндекс.Метрике. Но раз уж сегодня мы говорим об алгоритмах Гугл, то и трафик будем смотреть по статистике Google Analytics. Нас интересует статистика по органическому трафику (переходы из естественных результатов поисковой выдачи, не рекламных).

Заходим в Google Analytics и открываем раздел «Отчеты» для нашего сайта. В меню слева выбираем «Источники трафика» – «Общая информация» – «Источник/Канал». В открывшейся таблице с источниками и каналами трафика отмечаем нужные нам поисковики, именно те, где канал organic (как правило, это «yandex/organic» и «google/organic»).

Далее жмем на кнопку «Показать на диаграмме» и видим график посещаемости, где каждая линия отвечает за трафик из конкретного поисковика (исключением является синяя линия – это общее число посетителей). Проанализируем график:

Если снижение трафика медленное и сразу во всех поисковиках (рис. 1), посмотрите, насколько ваш сайт соответствует продвигаемым запросам. Возможно, пора заняться оптимизацией контента. Наши копирайтеры будут рады вам помочь.

Если трафик упал только из Яндекса (рис. 2), возможно, ваш сайт попал под фильтры Яндекса (например, под АГС-40). В целом, советы по выводу сайта из под фильтра похожи и для Яндекса, и для Гугла, поэтому вы все же можете дочитать эту статью до конца.

Если же резкое падение трафика из органической выдачи вы видите только для Гугла (рис. 3), то это может указывать на сработавший алгоритм Панда или Пингвин. Тогда обратите внимание на дату падения трафика.

Шаг третий. Панда или Пингвин?

Теперь идем на страницу истории обновлений алгоритмов Google (предоставляется сайтом moz.com) и смотрим, когда были обновления алгоритмов. Если дата снижения трафика попадает в интервал 1-2 недели после обновления одного из алгоритмов – возможно, ваш сайт попал под этот алгоритм.

Если дата падения трафика совпадает с датой обновления алгоритма Панда:

Смотрим по статистике посещаемости, для каких страниц сайта наблюдается наибольшее падение трафика. Копируем 1-2 предложения текста с одной из страниц и вставляем в строку поиска в Google, заключив этот текст в кавычки (ищем по точному соответствию).

Смотрим на результаты поисковой выдачи. Если ваш текст найден на других сайтах – смотрим, насколько сильно он совпадает. Если совпадение больше 60%, значит, нужно предпринимать меры.

В первую очередь все же стоит связаться с владельцем сайта, где размещен ваш текст – возможно, он не в курсе, что текст был «украден» с вашего сайта, и добровольно уберет ваш текст. Если убрать ваш текст со своего сайта он отказывается, можно обратиться в суд – но тут потребуются четкие доказательства того, что текст был размещен на вашем сайте раньше. Поэтому такой вариант малоперспективен.

Так что, как правило, самым распространенным действием становится изменение своего текста. И желательно переписать его заново (а не делать рерайт).

После замены текста обязательно защитите его от копирования. Для Яндекса – сохраните текст в разделе «Содержимое сайта» – «Оригинальные тексты» в Яндекс.Вебмастере. Для Гугла – добавьте ссылку на страницу с новым текстом в разделе «Профиль» – «О себе» – «Мои публикации» в Google Plus. И не забудьте добавить ссылку на новую страницу в карту сайта sitemap.xml, это должно помочь ускорить индексацию страницы.

Если дата падения трафика совпадает с датой обновления алгоритма Пингвин:

Заходим снова в Инструменты Google для веб-мастеров и смотрим раздел «Поисковый трафик» – «Ссылки на ваш сайт». Пройдите по нескольким из них. Если это нерелевантные сайты, спам-сайты («линкопомойки») – ссылки с них могут быть причиной снижения позиций вашего сайта.

Необходимо связаться с владельцами данных сайтов, чтобы они убрали ссылки на ваш сайт.

Также верно и то, что чем больше естественных ссылок на ваш сайт, тем меньше будет негативное влияние спамных ссылок (это для тех случаев, если владельцы спам-сайтов не реагируют на требования снять ссылки). Например, хороший вес имеют ссылки с соц. сетей. Что такого интересного можно разместить на сайте, чтобы пользователи соц. сетей желали этим поделиться, ищите в статье «20 вариантов интересного контента для социальных сетей».

В заключение

Чтобы ваш сайт не попал под алгоритмы Панда и Пингвин (равно как и под фильтры Яндекса), не переставайте следить за качеством контента на своем сайте и за качеством внешних ссылок. Не стоит покупать ссылки на биржах или заказывать тексты у сомнительных копирайтеров – такая экономия средств в настоящем может привести к потере позиций сайта в будущем – и, соответственно, к потере клиентов и вашей прибыли.

Проявите уважение к посетителям своего сайта – дайте им полезный и интересный контент. И желательно постоянно обновляемый (статьи, обзоры и прочее).

Не переусердствуйте с оптимизацией под ключевики – менее оптимизированная страница, но более ориентированная на живых людей, будет в поисковой выдаче выше просто за счет поведенческих факторов (из-за большей глубины просмотра и меньшего процента отказов).

На хороший контент будут ссылаться релевантные сайты. Особенно, если им это вовремя предложить )) умелый маркетолог придумает, как это сделать.

Да, поддерживать качество сайта на достойном уровне – задача не из простых. Но в результате вы получите не только прибыль от продаж со своего сайта, но и чувство гордости от хорошо выполненной работы ))

Алгоритм Google Penguin, 2 недели феерии, способы избавления от фильтра и черное SEO

Сегодня представляю вашему вниманию вольный перевод статьи Дэнни Салливана — тут собраны ответы на волнующие многих вопросы.

Прошло две недели с тех пор, как Google выкатил апдейт под кодовым названием Penguin. Новый алгоритм лучше справляется со спамом и уже назван грозой «черному» SEO. Но многие пострадали от этого и задаются вопросом о том, как вернуть позиции. Цель любого обновления алгоритма состоит в улучшении поисковых результатов. Как говорит Мэтт Катц: «Это был успех».

А как насчет тех странных результатов?

Конечно, вскоре после обновления алгоритма многие начали приводить в пример странные результаты из выдачи. К примеру, официальный сайт виагры не попал в топ, зато там были другие, «взломанные» сайты. Пустой сайт попал в выдачу по запросу «make money online». Также и другие пустые сайты попали в выдачу по самым разным запросам.

Как можно считать Google Penguin успешным, если происходят такие вещи?

Каттс говорит, что подобное существовало и до нового алгоритма, и они не были вызваны им. И действительно, что касается сайта Виагры — это правда и ситуация уже исправлена.

Что, на счет тех людей, которые считают, что их сайты несправедливо понизили в ранжировании?

«Мы обнаружили несколько случаев, которые могли бы исследовать, но это изменение не имело тот же эффект, как Panda или Florida», — говорит Каттс.

Panda была серьезным обновлением алгоритма Google в прошлом году — оно было нацелено на низкокачественный спам. Florida — главный апдейт 2003-го года, нацеленный на улучшение качества поиска. Дэнни согласен, что, похоже, оба апдейта задели намного больше сайтов, чем пресловутый Penguin, по крайней мере, если судить по реакции на эти события. Конечно, не все с этим согласятся.

Просто как напоминание: если какой-то сайт понизить в ранжировании, то какой-то повысится. Мы реже слышим о тех сайтах, ранжирование которых улучшилось, не так ли?

В итоге, в Google, кажется, очень уверены, что новый апдейт фильтрует спамеров, как и было задумано. Дэнни отмечает, что спам — действительно причина, по которой многие сайты просели.

Но если это работа Penguin, почему некоторые явно «заспамленные» сайты все-таки попадают в топ?

Не существует безупречного алгоритма. Пока мы стремимся достичь совершенства, наша лакмусовая бумажка — это ответ на вопрос: «Стало ли что-либо лучше, чем было ранее?» Каттс также отмечает, что Penguin был достаточно точно разработан, чтобы действовать против страниц, в заспамленности которых нет сомнений. Спам все-таки может «пройти», но теперь его ощутимо меньше.

Как вернуть позиции?

В связи с текущим апдейтом очень сложно ответить на этот вопрос. Все пострадавшие сайты, видимо, считаются спамом с точки зрения Google. В прошлом, если ваш сайт был заспамлен, вам нужно было подать запрос на повторное рассмотрение. Однако известно, что повторное рассмотрение просьбы не поможет тем, кто пострадал от Penguin. Они будут восстановлены со временем, если спам будет почищен.

Дэнни еще заметил, что некачественные ссылки — одна из причин, почему многие сайты пострадали. Многие использовали платные темы WordPress или пренебрегали тематической перелинковкой, покупали ссылки или участвовали в спам-сетях. Да и как им вырваться из спам-сетей, если их ссылки уже давно неподконтрольны. И все равно Мэтт говорит: «по возможности почистить сайт».

Если вы сделаете все, как следует, как вы узнаете об изменениях?

В идеале вы заметите трафик из Google после следующего обновления апдейта. Это ведет к пониманию другой важной вещи: Penguin (как и Panda) — фильтр, обновляемый раз за разом. Penguin работает не постоянно, а периодически и задача алгоритма в том, чтобы пометить спам в выдаче Google, который пропустили другие спам-фильтры.

Новый алгоритм — это «казнь» всем сайтам без разбора, как Panda, или есть специфика?

Дэнни считает, что стоит ждать от Google Penguin того же, что и от Google Panda — алгоритм затронет очень многие, если не все сайты. Если ваш сайт затронут, вам придется его почистить от спама. Как говорит Каттс, если вы это сделали, но никаких изменений не последовало, в конечном счете вам понадобится новый сайт.

Могут ли навредить конкуренты?

До Google Penguin было много разговоров на эту тему. После него, кажется, все стало местами даже хуже, чем было. Дэнни отмечает, что видел много постов о том, что якобы многие сайты пострадали из-за действий конкурентов. Верно, Google нацелился на некоторые схемы линкбилдинга. И многие получили от Google уведомления о том, что на их сайтах замечены «искусственные» или «неестесственные» ссылки. В итоге сайты потеряли трафик. Это должно привести к понимаю, что плохие ссылки лишь вредят сайтам. Но, как справедливо заметил Дэнни, это не новое веяние, не новости про «плохое» SEO. Эта тенденция наблюдается уже несколько лет и это снова стало большой проблемой.

В Google отмечают, что по факту довольно сложно навредить другим сайтам. В частности, плохие ссылки, которые ведут на хорошие сайты, как и другие подобные действия, могут считаться попыткой инфицировать сайт. Но у хороших сайтов есть антитела — хорошее перевешивает плохое. Каттс утверждает, что «было проделано огромное количество работы, чтобы убедиться, что один человек не может навредить другому». Большая часть тех 700 000 сообщений, отправленных сотрудниками Google веб-мастерам ранее в этом году, оказались вовсе не про «плохие» ссылки. И не были они отправлены внезапно в один день. Скорее всего, многие сайты получили штрафы как вручную, так и алгоритмически за какой-то промежуток времени.

Конечно, новые предупреждения поступают и сегодня. Это напоминает про ситуацию Dan Thies. Ходят слухи, что его сайт кто-то пытался выставить «в плохом свете» — якобы, он практикует «плохое» SEO. Он получил сообщение о том, что замечены искусственные ссылки, которые ведут на его сайт. Его сайт потерял позиции. Не доказывает ли это, что такая тактика работает? Но Thies сообщил Салливану, что сайт потерял позиции вследствие изменений на сайте — а именно: накануне он убрал сквозную ссылку, которая вела на главную страницу. Когда он вернул её, вернулись и позиции. При этом поисковый трафик не ухудшался. Это идет вразрез убеждению, что такие действия могут угрожать чьему-либо сайту. Если бы это работало, то было бы достаточно пометить чужой сайт как спам — и он бы сразу «падал». Так что же про те ссылки? Thies считает, что это была неудачная попытка «черного» SEO. Также он утверждает, что отправил три запроса на пересмотр и каждый раз получал сообщения о том, что спам не замечен. Предупреждение было получено, сайт в итоге пострадал — но вовсе не потому, о чем шла речь в предупреждении. Дэнни попросил Мэтта Каттса прокомментировать эту ситуацию, но он отказался. Он сказал, что предупреждение — в каком-то роде предвестник «падения» сайта. Если веб-мастер быстро отреагирует, он может предотвратить это.

Решение проблемы

Дэнни ожидает и дальше муссирование темы про «черное» SEO, ведь многие и дальше будут уверены, что это — главная проблема. Когда проще всего купить ссылок — легко видеть в этом зло. Конечно, история Thies и масса подобных — например, о том, как внезапно появились 24 000 ссылок, которые ведут на чей-то сайт, вызывают опасения. (Во второй стории предупреждение поступило после падения сайта. Повлияли ли те SEO-ссылки или что-либо другое? В общем, сложно сказать потому, что не сказано, что именно за сайт был). Чтобы еще больше запутать: некоторые сайты из тех, что потеряли трафик после внедрения Penguin, вообще не были жертвами «инквизиции». В то же время Google негативно реагирует на ссылки, которые появились с целью повлиять на ранжирование. Если сайт жестко зависел от этих ссылок, конечно, он в итоге пострадал. Дэнни видел множество людей, которые хотели бы отмежевать ссылки, которые ведут на их сайты. В Google отказались от комментариев о добавлении такой возможности. Конечно, Салливан не советует этого ждать, если сайт уже пострадал из-за нового алгоритма. Лучше сделать все, чтобы почистить сайт.

Одно хорошее предположение гласит, что Google не наказывает за плохие ссылки, которые ведут на сайты. Алгоритм игнорирует ссылки, не позволяя им как-либо повлиять на ранжирование, и не наказывает из-за них сайты. Более того, «черное» SEO — не то, ради чего этот алгоритм был разработан. Наиболее вероятно, что пострадавшие сайты были попросту заспамлены.

И под конец советы от Дэнни Салливана:

— нужно почистить страницы сайта от спама, — удалить «плохие» ссылки

— подождать следующего апдейта и посмотреть, вернутся ли позиции. В случае, если не вернутся, нужно почистить сайт еще тщательнее или создать новый. Если вы уверены, что сайт пострадал несправедливо, напишите письмо в тех. поддержку с подробными объяснениями. Вот тут, кстати, список скрытых ссылок, которые находятся в плагинах WordPress. Если вы используете какой-то из этих плагинов и там есть скрытые ссылки — это вам ничем не грозит. В первую очередь, нужно строго посмотреть на сайт. Плохие ссылки всегда легко найти, если сайт замешан в спам-сетях.

И уж точно обнаружение сайтов, которых не тронул апдейт и жалобы на них — это не решение проблемы, если ваш сайт уже попал под фильтр.

От себя добавим, что довольно странно выглядят два противоречащих друг другу утверждения о том, что Google не учитывает плохие ссылки и игнорирует их, а также что позиции и трафик упадут, если на вас стоят спамные ссылки. Да и запрос о пересмотре сайта практически не работает. У нас есть пример, когда было отправлено 4-5 запросов на пересмотр, были убраны все ссылки, которые только возможно было убрать, было отправлено письмо о том, что «больше ничего убрать не можем» (есть такое условие в письме-предупреждении от Google). И всё безрезультатно. Все так же приходят письма о том, что, мол, мы видим искусственные ссылки на ваш сайт, уберите. Процесс цикличен. Порой кажется, что в Google заблудились в собственных алгоритмах, если даже советуют создавать новый сайт и бросать старый.