Чистим семантическое ядро от мусора в два клика

Все, кто собирает семантику, сталкивается с проблемой – не целевые (мусорные) слова, которые очень муторно вычищать, чтобы получить финальный список ключевых слов, пригодный для работы.

Мы так же сталкиваемся с этим каждый день и надо сказать, что нам это порядком надоело. Мы решили на корню решить эту проблему раз и навсегда.

Мы автоматизировали этот процесс.

Сегодня мы расскажем о нашей новой разработке, которая с прошлой недели вошла в состав Rush Analytics.

Как обычно чистят семантическое ядро от мусора?

На практике обычно это происходит так: оптимизатор/специалист по контекстной рекламе идет в MS Excel, делает фильтр в столбце с ключевыми словами и поочередно вбивает туда стоп-слова: «бесплатно», «ВК», «вконтакте», «онлайн», «реферат» и прочие. Много стоп слов. И так по кругу долгие часы.

Читайте также: Что такое маркерный запрос

Гео-запросы — главная головная боль любого SEO-специалиста

Да-да у многих сейчас, наверное, вспотели ладошки т.к. вы вспомнили долгие часы очистки запросов вида «…спб», «…екб», «… в казани», «…самара». И когда вроде уже все готово – находятся все новые и новые городки, о которых даже не подозреваешь 🙂

Мы нашли решение – сделали готовые списки стоп-слов по гео-запросам.

Как это работает? Вам достаточно выбрать свой целевой город и все запросы, в которых содержится гео-указания (названия городов) отличные от целевого города будут автоматически удалены в отдельный список.

Выглядит это так:

Просто выберите свой целевой город.

Важный нюанс: мы заранее добавили в базу все устоявшиеся сокращения городов вида «екб», «спб», «Питер» и т.д. Все словоформы (склонения) городов так же учитываются автоматически.

Все самые популярные стоп-слова всегда под рукой — в 1 клик

Мы так же составили обширные списки популярных мусорных слов по различным тематикам – практически на все случаи жизни – теперь можно в один клик отсеять, например, все ключевые слова с интентом «бесплатно» или «отзывы» или «фотографии и изображения».

Выглядит это так:

Читайте также: Собираем поисковые подсказки Youtube

Полный список тематик и направлений, стоп-слова по которым мы подготовили:

- Универсальный

Общий список стоп слов подходящий для всех тематик - Халява

Все, что связано со словом «Бесплатно» - Визуализация

Все, что связано с изображениям, видео, фотографии и рисованием - Социальные сети

- Ремонт

Ремонт, инструменты, поломки, запчасти - Софт

Компьютерные игры, софт, драйвера, ключи - БУ

Все связанное с «бу», старым, бывшим - Самодеятельность

Работа на дому, «своими руками», — некоммерческий мусор - Счет-калькуляция

Стоп-слова по расчетам, калькуляторам, коэффициентам - Юмор-приколы

Юмор, приколы, анекдоты - Порно

Русские и английские стоп-слова по теме эротика, порно, секс - Лечение

Стоп-слова по лечению и самолечению, методологиям и болезням - Транзакции

Стоп-слова по продажам, покупкам, бронированию, заказам - Оптовые

Стоп-слова по опту, рознице, закупкам - Отзывы и смежное

Стоп-слова по отзывам, жалобам, мнениям - Вопросы и инфо запросы

Стоп-слова по вопросам: что, кто, какой, где - Аренда

Стоп-слова по аренде, посуточной аренде, прокату - Крупные интернет магазины

Названия интернет магазинов - Авто (Beta)

Названия марок и моделей автомобилей - Животные (Beta)

Список животных - Женские имена

Большой список женских имен - Районы Москвы

Стоп-слова по районам Москвы - Рецепты еды

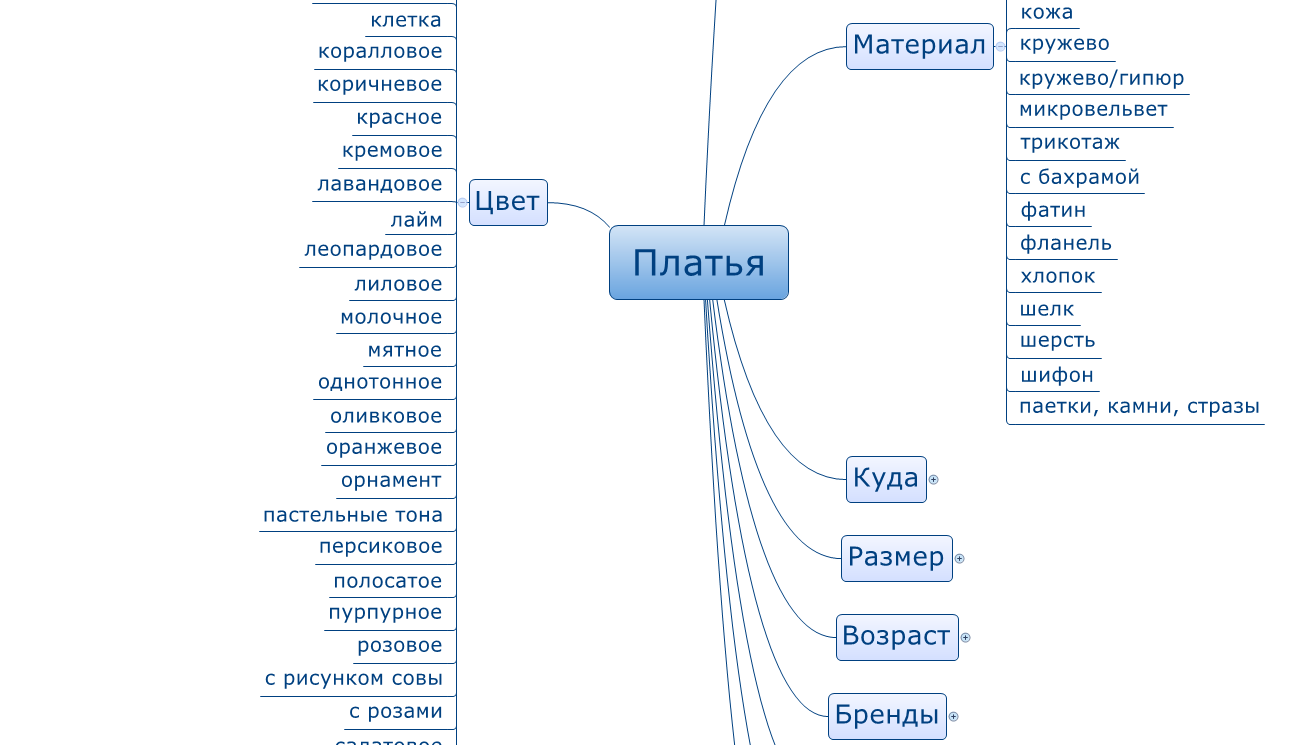

Стоп-слова по названиям блюд и рецептам - Цвета

Большой список названий цветов - Материалы (ткань)

Названия тканей - Характеристики

Характеристики предметов (размер, вес, большой, длина…)

Читайте также: Google Keyword Planner

Работаете с редкими тематиками? Не проблема – заточите все под себя

Конечно же, мы предусмотрели, чтобы вы могли добавить свои списки стоп-слов в сервис, чтобы они всегда были под рукой и не нужно было 1000 раз повторять операцию CTRL+C, CTRL+V.

Просто нажмите «Добавить свой список стоп-слов», введите запросы и пользуйтесь своим списком стоп-слов при сборе подсказок, Wordstat и в кластеризации.

Читайте также: Советы по SEO на WordPress.

Профессиональные опции для опытных специалистов

Теперь в функционале стоп-слов доступны эксперт-опции:

Символьное совпадение

В данном случае если вы введете стоп-слово «бу»

Будут удалены ключевые слова:

- «бу холодильник»

- «холодильник бу»

- «купить бу холодильник»

- «бублик»

- «бумеранг»

- «бумага»

Читайте также: Порядок слов в запросе

Фразовое соответствие

В данном случае если вы введете стоп-слово «бу»

Буду удалены ключевые слова:

- «бу холодильник»

- «холодильник бу»

- «купить бу холодильник»

но не:

- «бублик»

- «бумеранг»

- «бумага»

Если вы используете много стоп-слов – КРАЙНЕ рекомендуем использовать фразовое соответствие.

Читайте также:

Какую частотность ключевых слов использовать для продвижения?Где работает функционал?

- Cбор подсказок Яндекса/Google/Youtube – здесь стоп-слова работают как «фильтр на лету» — как только мы встречаем подсказку, содержащую стоп-слова – мы сразу же отбрасываем ее в отдельный список «удалено по стоп-словам» и дальше не собираем эту ветку подсказок, переходим к следующему слову.

- Сбор ключевых слов из Wordstat – здесь стоп-слова работают как пред-фильтр – мы ищем в веденных вами ключевых словах ненужные ключевые слова и удаляем их еще ДО сбора данных

- Кластеризация запросов – здесь стоп-слова работают аналогично парсеру Wordstat – как пред-фильтр.

Уверены, что теперь, с помощью Rush Analytics, когда вы садитесь составлять семантическое ядро онлайн у вас:

А) Будет позитивный настрой на продуктивную работу без рутины

Б) Будет в 10 раз меньше работы по сбору семантического ядра и его очистке от мусора.

Ждем ваши вопросы и предложения в комментариях. Уже завтра порадуем новым релизом 😉

Читайте также: LSI ключи, Семантическая структура сайта

метод «Муравейника». Читайте на Cossa.ru

Один из первых шагов при продвижении сайта — создание семантического ядра (списка ключевых слов) или доработка существующего.

SEO-специалисты подходят к этому процессу с разных сторон.

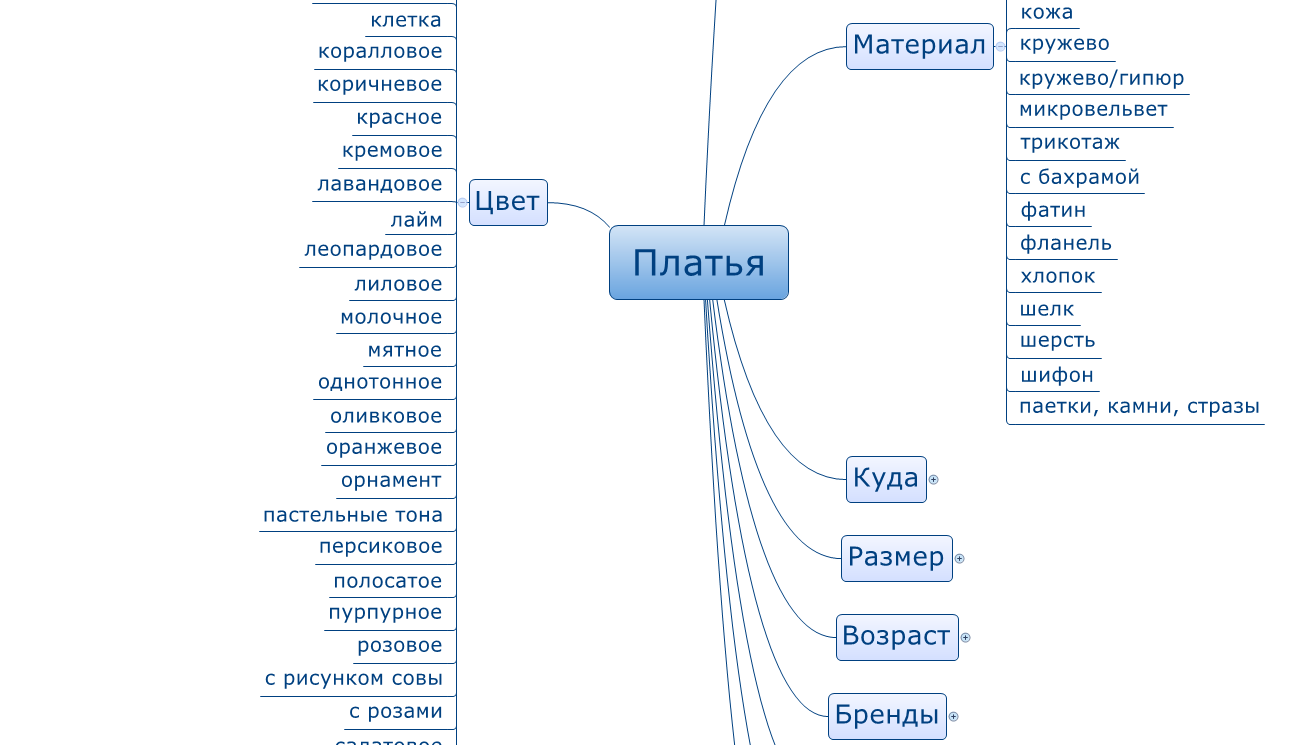

Одни начинают с проработки mindmap-карты со всеми возможными комбинациями ключевых слов. Потом проверяют по частоте все варианты и получившийся список берут в работу.

Другие собирают семантику конкурентов (Serpstat, Spywords), статистику систем контекстной рекламы (Яндекс.Директ, Google AdWords), поисковые подсказки, запросы из счётчиков статистики, базы ключевых слов (Moab, «Букварикс»).

Всё это собирают вместе и начинают многочасовую фильтрацию в ручном режиме с применением некоторой автоматизации.

Мы обычно применяем оба этих способа, но к фильтрации у нас свой подход. О нём в том числе и расскажу в этой статье.

Есть разные метода сбора семантики.

Метод первый. Полностью вручную

Нереально трудоёмкий и неэффективный процесс. Останавливаться на нём не будем. Не надо так.

Метод второй. С использованием инструментов

Часто используется Key Collector.

|

|

Фильтры в Key Collector | Группы в Key Collector | Неявные дубли в Key Collector |

|

|---|---|---|---|---|

|

|

|

|

|

|

В нём же фильтруются запросы с нулевой частотой и проводится фильтрация с помощью подгрузки списка стоп-слов.

Применяется ещё ряд методик облегчающих процесс фильтрации, но после этого всё равно приходится часами проверять оставшиеся запросы вручную.

Наш подход

Мы много лет применяли вышеописанный подход. Но не покидало ощущение, что можно сделать это проще и быстрее.

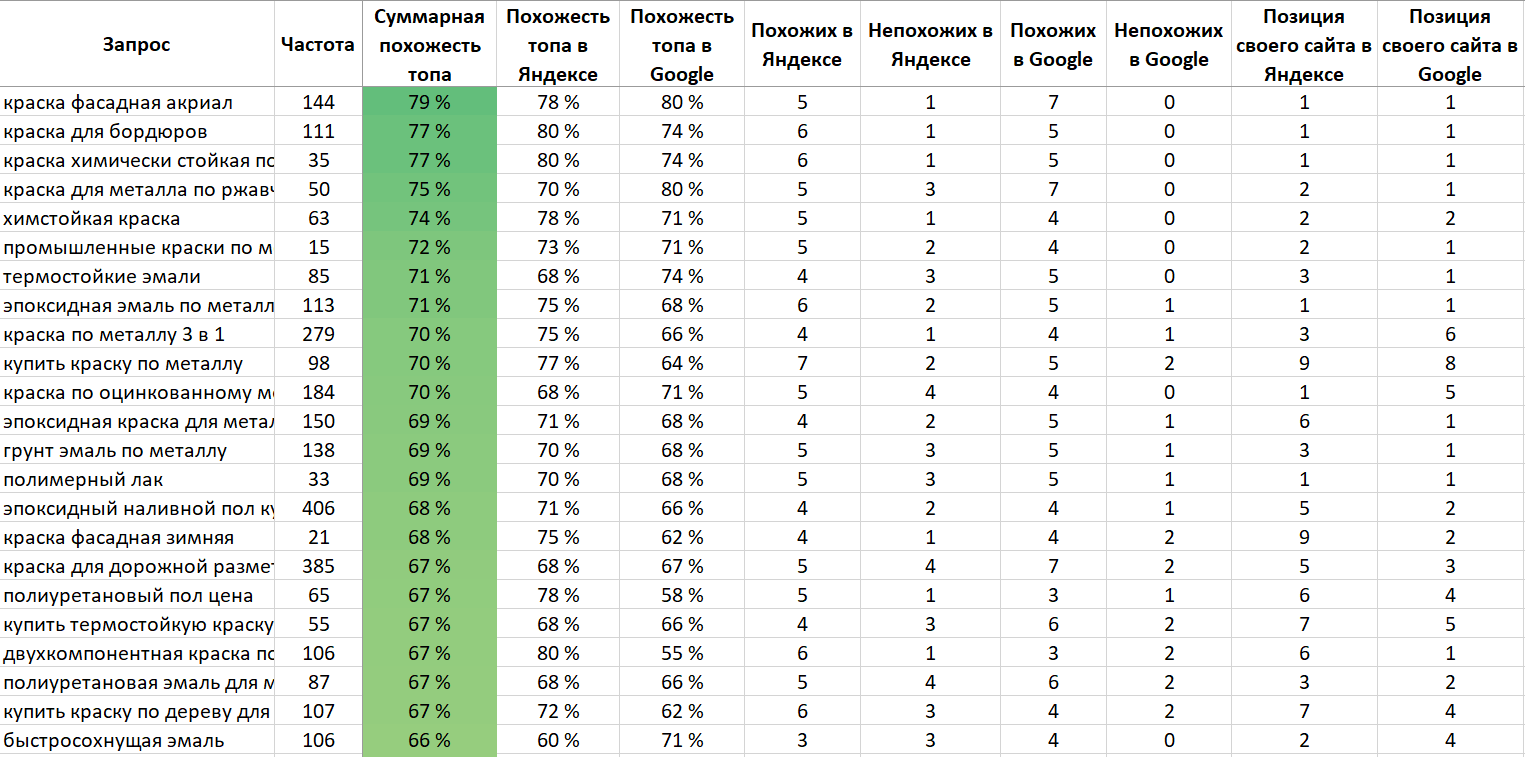

Стали искать варианты. Причём искали не только метод фильтрации, но и выявления вероятности продвижения конкретного сайта по этому запросу. И среди прочих методик выбрали ту, которая давала наибольшее качество и скорость. Это определение «похожести» сайтов из первой десятки на продвигаемый сайт.

Логика простая: если в топе по запросу нет сайтов похожих на нас и много непохожих, то алгоритм поисковой системы и нас туда редко будет пропускать.

Позже к этому мы стали добавлять к оценке параметры конкурирующих сайтов и выводить параметр на их основе (в западных сервисах это часто называется Keyword difficulty), чтобы среди «похожих» выявить более лёгкие и сложные запросы.

Например, если на первой странице только сайты агрегаторы, то сайт конкретной организации по нему будет продвинуть маловероятно. Или если только информационные сайты, то продвинуть по такому запросу коммерческий сайт (даже его информационной страницей) также затруднительно.

Сначала мы применяли этот подход практически в ручном режиме, потом написали скрипт, который автоматизировал этот процесс.

В нём на вход подаётся:

- список запросов;

- целевой поисковик;

- регион;

- несколько похожих сайтов конкурентов.

На выходе:

- похожесть топа;

- среднее значение параметров по топам (возраста конкурентов, число их страниц в индексе, их ссылочные параметры…).

Примеры применения

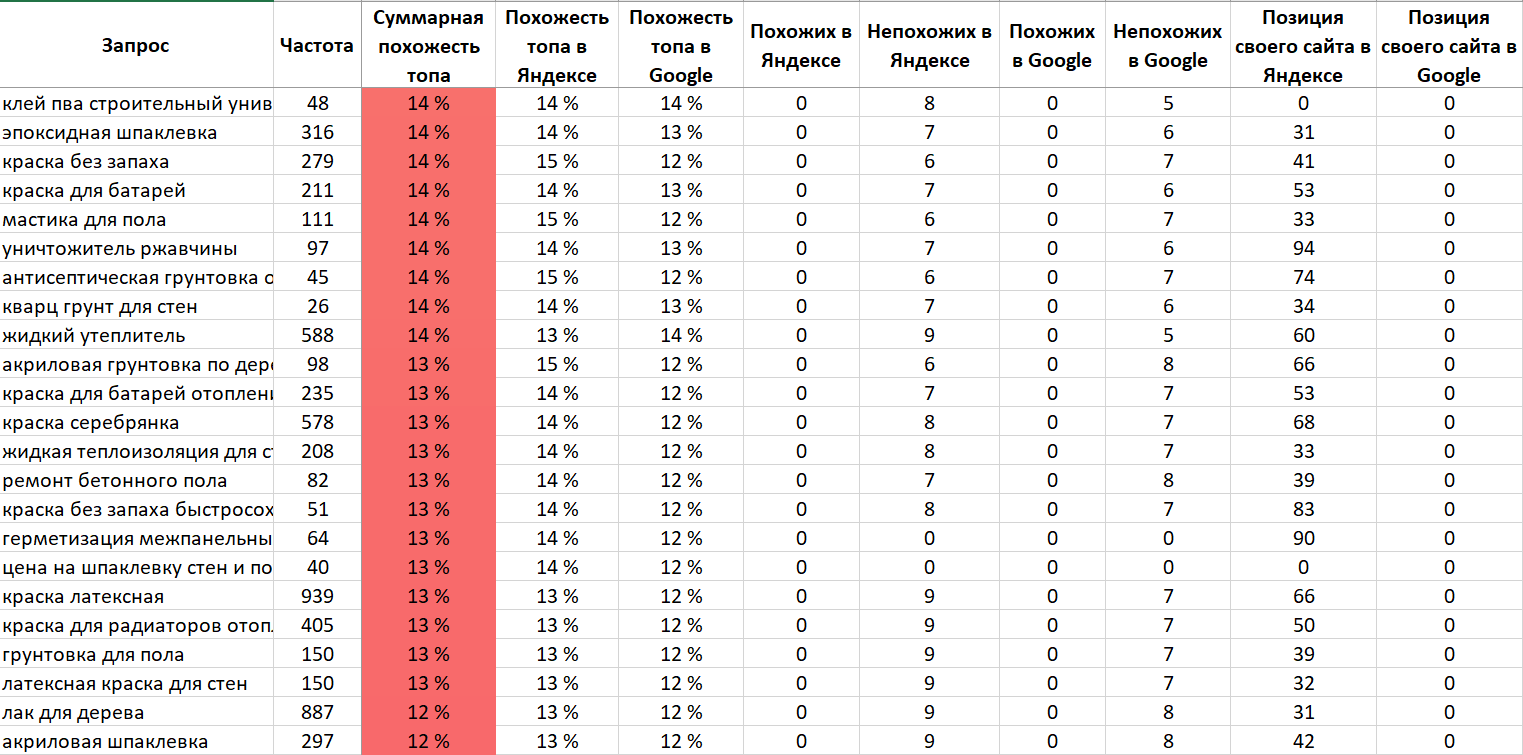

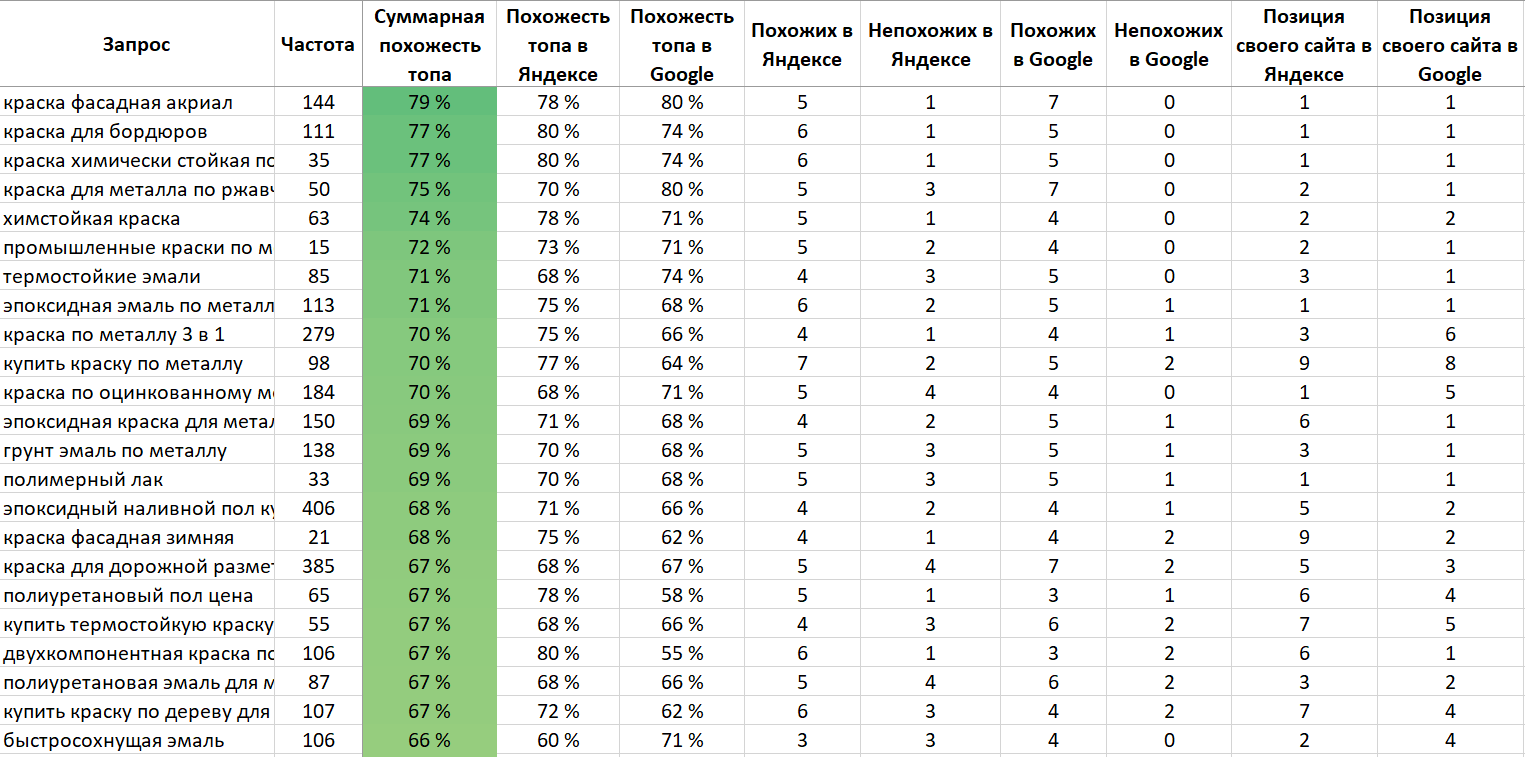

Пришёл клиент — интернет-магазин лакокрасочных материалов. От прошлого подрядчика остались 705 запросов. На первый взгляд, неплохо подобранные. Основная часть инструмента была к тому моменту готова и активно тестировалась. Сразу загрузили в него, и итог отсортировали по убыванию похожести.

В итоге в верху списка оказались сайты, у которых много похожих и мало непохожих.

Внизу — мало похожих, много непохожих.

Видно, что уже сейчас самый верх списка имеет много хороших позиций, а внизу их практически нет.

Что мы сделали дальше? Через 15 минут после получения списка запросов вернули клиенту проанализированный список запросов с прозрачной аргументацией, почему треть запросов из его списка в ближайшем будущем практически не имеют шансов выхода в топ и на них не нужно тратить время и деньги.

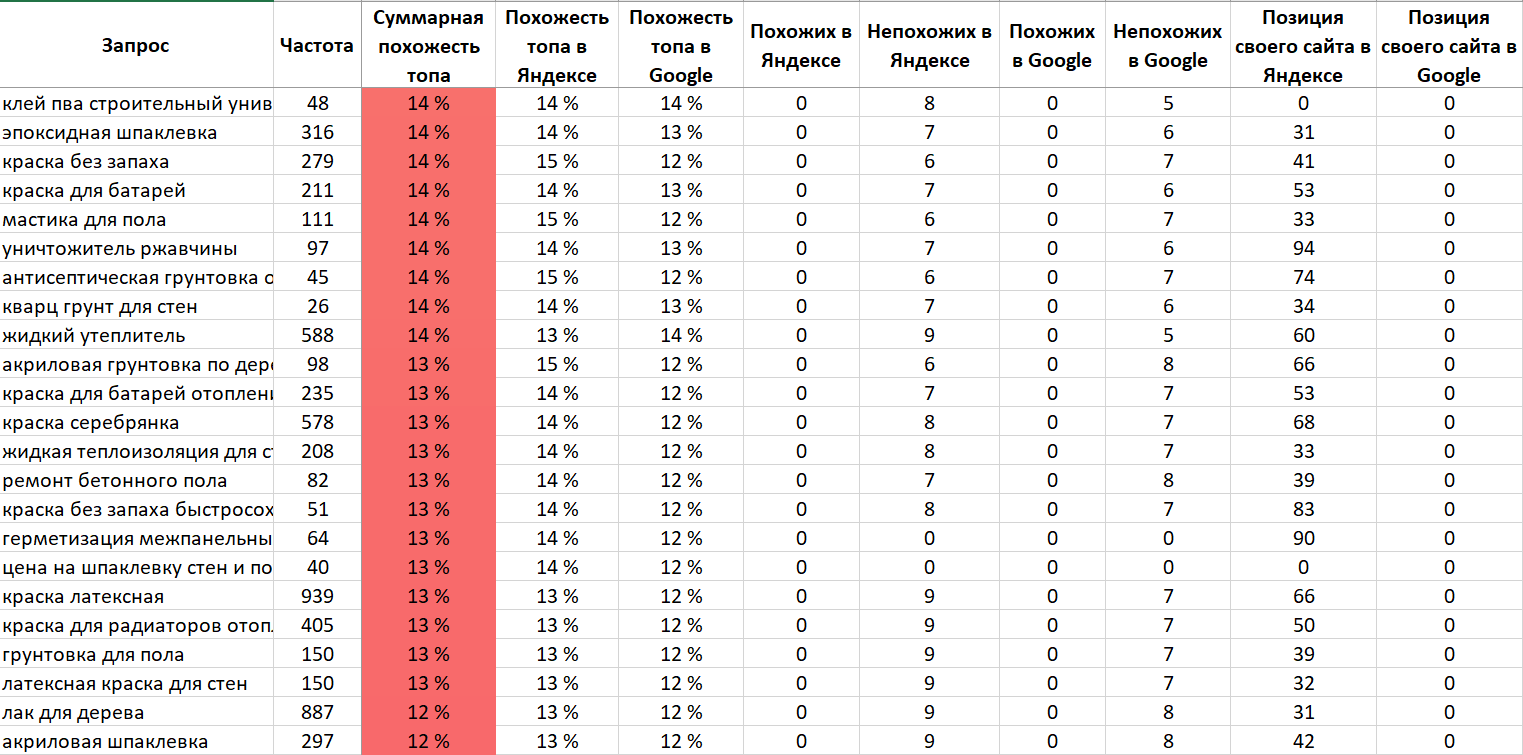

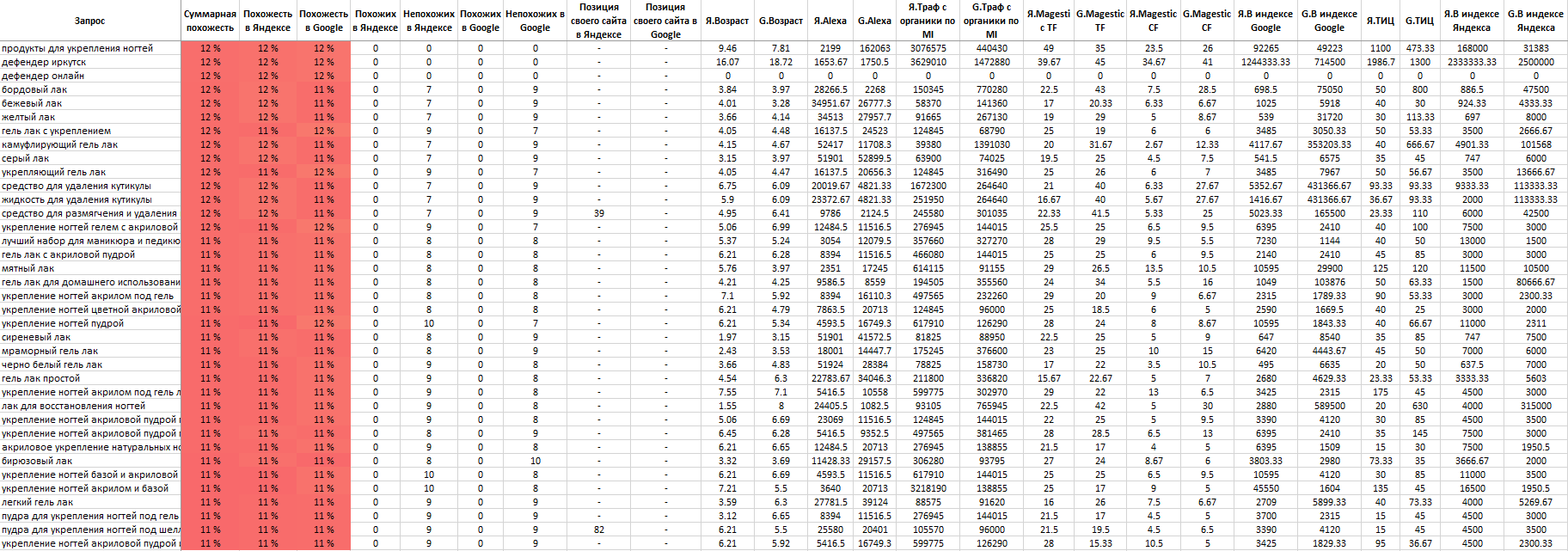

Ещё один пример чистого списка запросов.

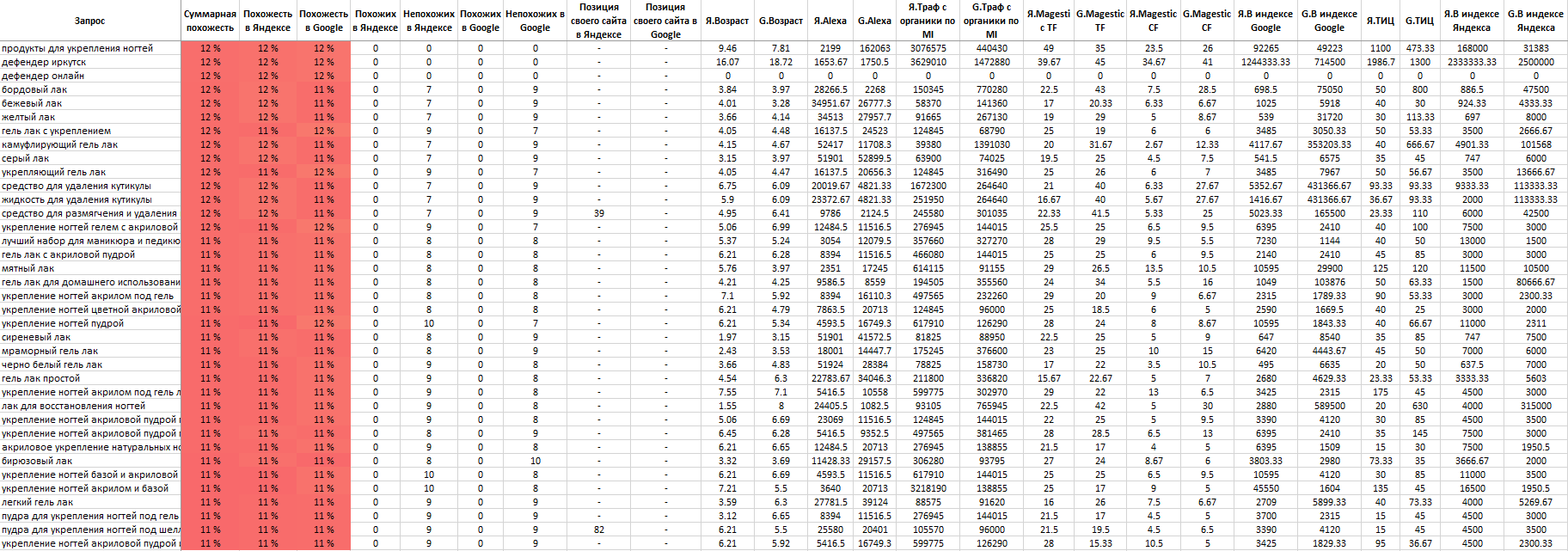

Тематика: маникюрный интернет-магазин.

До внедрения методики мои ребята подобрали 2000 запросов. Как и в прошлом случае проверку «на глазок» запросы проходят.

Здесь мы уже добавили подгрузку дополнительных параметров. Аналогично отсортировали по убыванию суммарной похожести в Яндексе и Google.

Верх списка:

Середина:

Низ:

Мы проверили динамику позиций запросов и опасения подтвердились. Запросы с высокой похожестью за время продвижения заметно выросли. С низкой — даже немного просели.

В результате мы отсеяли треть запросов.

И на этом этапе ввели в работу коэффициент сложности запроса Keyword Difficulty, рассчитанный на основе дополнительных параметров без учёта похожести.

Оставшиеся 2/3 запросов объединили в кластера и отсортировали кластера по сочетанию средней похожести, Keyword Dificulty и частоты и продолжили работу продвигаясь по кластерам, начиная с наиболее полезных.

Как мы это сейчас используем

- Фильтрация грязной семантики.

- Фильтрация чистой семантики.

- Выявление запросов «в зоне риска».

- Приоритизация запросов и кластеров.

- Анализ проседания из-за смены интента запроса/кластера.

Про запросы «в зоне риска» хочется сказать отдельно. Это очень важно в клиентском SEO. Когда запускаем продвижение, часто сайт клиента находится в топе по многим запросам, где он не должен находиться и где он один. Например, когда в топе по запросу только информационные сайты и наш клиент — один коммерческий среди них. Положение по такому запросу довольно шаткое и скорее всего сайт рано или поздно по этому запросу вылетит.

И здесь важно аргументированно предупредить клиента об этом, чтобы клиент имел некоторый прогноз как в целом по продвижению, так и по группам запросов.

Мы выложили этот инструмент на поддомен своего сайта, назвали его «Муравейник Tools».

Для тех, кто дочитал до этого места и хочет обкатать эту методику, есть промокод на 5000 лимитов.

Регистрация

Промо-код: cossa

Читайте также:

Мнение редакции может не совпадать с мнением автора. Ваши статьи присылайте нам на [email protected]. А наши требования к ним — вот тут.

Чистка Семантического Ядра от мусорных запросов

Чистить семантику от мусорных запросов приходится после каждого сбора данных — базисов, запросов, подсказок. Очень важным в этом процессе является формирование списка минус-слов.

Что такое минус-слова

Это такие слова, с которыми поисковая фраза становится нецелевой для сайта.

Опыт показывает, что для каждого сайта желательно формировать свой список. Такой подход позволит сформировать наиболее полную и чистую семантику сайта. А это, в свою очередь, упростит дальнейшую работу над развитием нашего ресурса.

Начальный список минус-слов формируется уже на этапе подбора базовых запросов. Но основной улов будет после первого парсинга запросов по базе Вордстата Яндекса.

Полученный перечень поисковых фраз выгружаем и внимательно просматриваем. Все мусорные слова заносим в отдельный файл.

На первых этапах этот процесс будет самым рутинным и трудоемким, поскольку выполняется вручную. Хотя более правильно было бы сказать вглазную, поскольку напрягаются, в первую очередь, глаза и мозги.

В дальнейшем этот список используется для промежуточных чисток и попутно пополняется новыми словами.

Чем тщательнее Вы будете работать над сбором минус-слов, тем качественнее будет Ваш итоговый результат.

Как правильно чистить

Существует довольно много рекомендаций по этому поводу. У каждого специалиста наработан свой подход. Но цель они преследуют одну – получение наиболее полной и очищенной от мусора Семантики сайта.

В интернете распространяю различные списки стоп-слов. Есть даже сайты, заточенные именно на это. Например – minus-slova.ru. Но к сторонним спискам надо подходить творчески.

Эту информацию необходимо внимательно проанализировать, иначе у Вас могут быть потеряны нужные ключи для работы.

Основные работы по чистке СЯ проделывают после сбора запросов и подсказок – перед этапом по кластеризации.

Вот примерный список операций по чистке полученных запросов:

- Запросы с нулевой частотностью “WC” = 0. Здесь следует обратить внимание на сезонность.

- Запросы, которые устраняют при помощи списка минус-слов или при просмотре:

- Товары и услуги, которых у Вас нет.

- Стоп-слова – бесплатно, реферат.

- Топонимы – слова привязки к местности, городу.

- Запросы для других регионов.

- Ошибки написания.

- Устаревшие данные.

- Очевидный мусор.

- Витальные запросы конкурентов.

- Информационные запросы для коммерческих сайтов. С ними придется работать отдельно. Эти фразы не удаляем бесследно, а переносим в отдельный список для применения на блоге или информационном разделе сайта.

- Слишком широкие запросы. Такие ключи нет смысла использовать для коммерческих сайтов.

- Подозрительные фразы (полнота запроса < 5%).

- Чистка списка в Кей Коллекторе:

- Неявные дубли (перестановка слов, другой падеж).

- Удаление запросов длиннее 7 слов

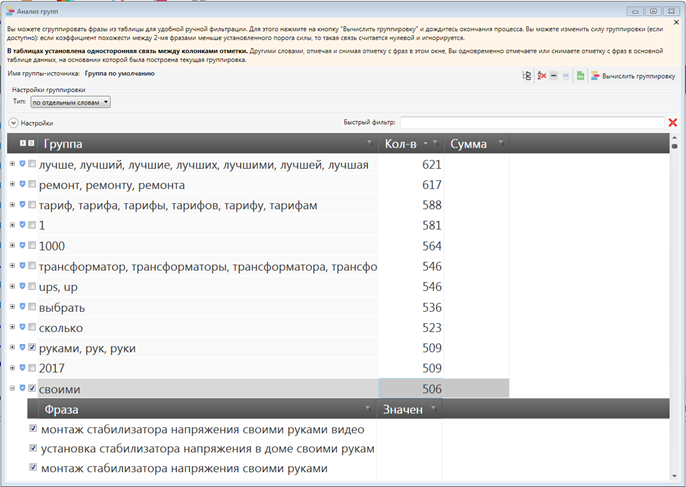

- Удаление по анализу групп

Полнота запросов

Этот показатель определяется по формуле:

Полнота = (“WC” / WC) * 100

Другими словами, фразовую частотность делим на общую и данные получаем в процентах.

Для работы удобно использовать таблицы Excel.

Собрав частотность любым удобным способом, просчитываем столбец «Полнота запроса» и сортируем таблицу по возрастанию этого показателя. Позиции с полнотой < 0.5% можно убирать из списка – это пустышки.

Затем внимательно просматриваем позиции с полнотой до 5%. Там могут встречаться как мусорные фразы, так и рабочие.

Чистка в KeyCollectore

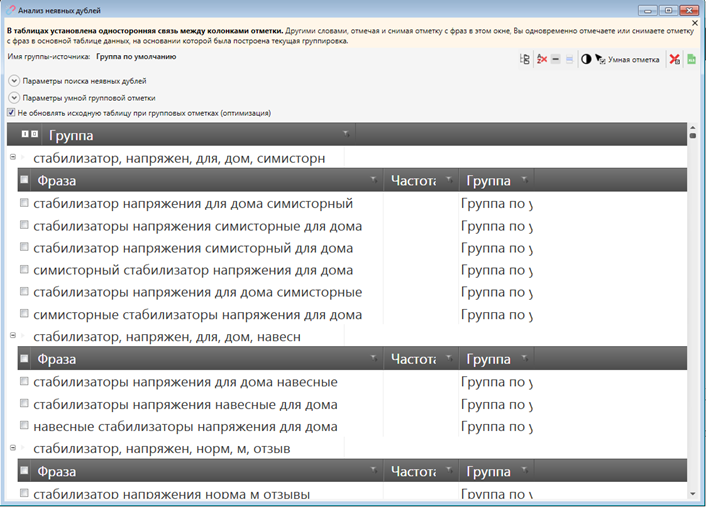

Удалять записи с неявными дублями очень удобно в КейКоллекторе. Там есть такая функция – «Анализ неявных дублей». В видеоролике автор подробно рассказывает как это делается.

Удаление запросов по «Анализу групп», запросов длиннее 7 слов и другие полезные рекомендации Вы можете посмотреть в этом видеоролике.

В этом ролике приводятся основные способы чистки семантики в программе «Кей Коллекстор».

Полученный после очистки список ключевых фраз в дальнейшем используется для кластеризации.

Ключи с ошибками

Что делать с ключами с ошибками. Такие фразы в тексте и в тегах использовать не следует. Для принятия окончательного решения придется заняться проверкой реакции на них поисковых систем. И тут есть два решения.

Если поиск такие запросы исправляет и подставляет правильные слова, то эту фразу исключаем из СЯ.

Если слово не исправляется, то фразу можно оставить, но использовать во внешнем ссылочном – на форумах, в комментариях, в социальных сетях…

P.S. Итак, мы почистили свою семантику от мусора. Еще раз внимательно просматриваем полученный список. Все в норме? Теперь можно переходить к кластеризации, то есть группировке ключевых слов по потребностям пользователей. Или другими словами по интентам, что в переводе с буржуйского тоже означает потребность пользователя.

С этим термином подробнее разберемся во время кластеризации.

Полезные Материалы:

Как почистить ядро от дублей и мусора с помощью инструментов PromoPult

Для максимального охвата целевой аудитории в поиске необходимо собрать емкое семантическое ядро. Это не сотни, а тысячи, десятки и сотни тысяч запросов — в зависимости от конкуренции в тематике.

Мы покажем работу с семантикой на примере чайного магазина.

Сначала составляется базовый перечень фраз, описывающих бизнес. Для этого можно использовать бесплатные рекомендаторы SEO-модуля на шаге «Ключевые слова».

Переключаясь на вкладки, генерируйте запросы и подходящие добавляйте в опорный список для расширения.

Далее базовый список расширяйте в ширину с помощью правой колонки Вордстат (смежные по значению запросы) — кнопка «Wordstat ассоциации». Обязательно ознакомьтесь с рекомендациями по выбору числа страниц для парсинга (в окне настроек расширения семантики).

Найденные слова и фразы, которые отвечают тематике, добавляйте в опорный список к базовым запросам.

Затем опорный список расширяйте в глубину с помощью левой колонки Вордстат (другие фразы с вхождением ключа). Если слов очень много (более тысячи) и система начинает работать медленно, операцию можно проводить поэтапно. Подходящие слова из результатов расширения также добавляйте в опорный список, после чего экспортируйте его и скопируйте в файл Excel.

Для «ширины» есть еще пара профессиональных инструментов PromoPult, для которых мы написали подробные инструкции:

Прогоните через них базовый (начальный) список запросов и добавьте спарсенные слова в общий Excel-файл.

Собрать такой список — полдела.

При автоматическом подборе в ядро могут попадать нерелевантные тематике фразы и мусор в виде дублей запросов, лишних символов, фраз с нулевой частотностью. Список обязательно нужно чистить.

Ручная чистка ядра от нерелевантных запросов

Нерелевантные запросы — это те, что не соответствуют тематике сайта. Например, чайной лавке из Тюмени не подойдут для продвижения такие запросы как [песня зеленый чай], [духи зеленый чай], [чайный гриб], [кафе кофе], [чай википедия] и т.д. В этом списке также могут быть фразы с указанием города, где нет представительства магазина, названия конкурирующих компаний.

Чтобы они заведомо не попали в список, при парсинге нужно указывать возможные минус-слова. В данном случае к ним относятся песня, духи, гриб, кафе, википедия, спб, москва и т.д.

Предусмотреть все минус-слова невозможно, поэтому после каждой операции по расширению ядра нужно визуально проверять список на наличие нерелевантных запросов и удалять их.

Обращайте внимание на фразы с неуточненным интентом и исключайте их из ядра. Например, ключевые слова [золотые брови], [красный халат] (такие сорта чая) применимы также к другим тематикам — продажа косметики, продажа текстиля. Дальнейшее расширение этих фраз спровоцирует появление множества запросов, не имеющих ничего общего с тематикой чая.

Автоматическая чистка ядра от дублей и лишних символов в «Нормализаторе слов»

Кроме нерелевантных фраз в списке неминуемо будут присутствовать повторяющиеся фразы и лишние символы. Это мусор, который провоцирует беспорядок в файле и требует удаления.

Опытные пользователи Excel убирают ненужные строки, символы и пробелы с помощью макросов, автозамен и формул. Наработать для себя набор таких приемов непросто и можно не учесть некоторые моменты, поэтому лучше использовать готовые инструменты. Мы предлагаем попробовать «Нормализатор слов» PromoPult.

Основные возможности инструмента:

- удаление дубликатов в точном вхождении;

- удаление дубликатов с перестановкой слов и учетом морфологии;

- удаление спецсимволов в начале и конце слова;

- удаление лишних пробелов между словами, в начале и конце строки;

- удаление табуляции в начале и конце строки;

- удаление пустых строк;

- преобразование слов в нижний регистр;

- замена ё на е.

Особенности сервиса:

- бесплатное использование;

- неограниченное количество запросов при проверке за один раз;

- работа онлайн — не требует установки софта;

- работа в фоне — не нужно держать страницу открытой;

- не требует разгадывания капчи;

- быстрая скорость обработки данных в облаке;

- результат обработки можно скачать в формате XLSX;

- бессрочное хранение выполненных задач в аккаунте PromoPult.

Инструкция по использованию «Нормализатора слов»

Зарегистрируйтесь или авторизуйтесь в системе PromoPult — так все отчеты сохранятся в вашем личном кабинете.

Нажмите «Добавить задачу» и укажите список запросов, который нужно почистить.

Загрузить запросы можно с помощью файла Excel (собираются данные с первого листа файла) или добавлением списка в окно сервиса (каждый запрос с новой строки).

Обратите внимание, что при загрузке XLSX-файла система считывает данные по принципу «одна ячейка — один запрос», поэтому добавляйте в файл только перечень запросов без другой служебной информации.

Далее необходимо поставить галочки — выбрать действия с ядром.

Удалить дубликаты слов. Система может удалить полностью идентичные строки (дубли словосочетаний) или строки, где слова в словосочетании имеют другой порядок и используются в других словоформах. Например, [виды китайского чая] и [китайский чай виды] будут считаться идентичными — в списке останется только тот запрос, что стоит выше.

Убрать спецсимволы. Иногда запросы для SEO могут мигрировать из контекстных рекламных кампаний и заимствовать спецсимволы. Или же попросту пользователи ставят при наборе запроса знаки препинания, которые вместе с фразами попадают в базы. Парсер поможет убрать их все одним кликом. По умолчанию заданы символы +-?: и при необходимости их можно дополнить.

Убрать лишние пробелы и табуляцию. При наличии лишних пробелов в начале текстовой строки, между словами во фразе и в конце строки система их обнаружит и удалит. Аналогично и с табуляцией — пустое пространство будет удалено в начале и в конце строки.

Удалить пустые строки. Строки без текста будут удалены.

Преобразовать слова в нижний регистр. Опция может быть полезна, когда список содержит спарсенные заголовки — часто слова в них бывают прописаны в верхнем регистре.

Заменить ё на е. На каждой площадке своя редполитика и свои правила написаний слов с буквой ё. Красоты ради собранный файл стоит унифицировать, заменив разом одну букву на другую.

Можно выставить сразу все галочки или только те, которые отвечают конкретной задаче. Ведь парсер полезен не только для чистки семантического ядра — он удобен для наведения порядка в любых списках.

По факту выполнения задачи будет доступен файл для скачивания. Задаче можно дать свое название, чтобы в будущем ее было проще идентифицировать.

В скачанном файле заполнен один лист с финальным списком запросов.

В нашем примере исходный список из 1103 запросов был обработан за 10 секунд. После чистки был удален мусор — дубликаты, занимающие порядка 11% ядра.

Автоматическая чистка ядра от нулевых запросов в парсере Wordstat

Отсеяв мусор и дубли, необходимо также почистить ядро от запросов, частотность которых стремится к нулю. Они не способны генерировать трафик, поэтому нет смысла тратить время и деньги на создание и оптимизацию посадочных страниц.

Собрать частотности Wordstat можно вручную, но это долго и неудобно. Для ускорения работы существуют парсеры — в PromoPult есть и такой инструмент.

Подробный обзор работы с парсером Wordstat вы найдете в статье:

Убирайте мусор вовремя

Если раньше было достаточно оптимизировать сайт под сотню базовых запросов, то сегодня требуются тысячи НЧ и длиннохвостых запросов, которые вручную собрать невозможно. Благодаря парсерам эта задача решается быстро и просто, однако побочным эффектом выступает огромное наличие мусора.

Техническая чистка ядра — необходимая процедура, позволяющая исключить неэффективные для продвижения слова. Сделать проверку быстрой и точной можно с помощью инструментов PromoPult. «Нормализатор слов» доступен бесплатно. Парсер Wordstat — от двух копеек за сбор частотностей для одного запроса. Первые 50 проверок — бесплатно.

Желаете получать дополнительный доход? Поделитесь ссылкой на инструмент с друзьями и получайте 10 % от их оборота.

Методика чистки семантического ядра в Кей Коллекторе

В ходе парсинга через Кей Коллектор неизбежно приезжает большое количество мусорных запросов, которые либо не подходят к нашей тематике, либо содержат различные спец. Символы, частотность которых в итоге окажется равной 0. Кей Коллектор обладает очень универсальным и гибким функционалом для чистки поисковых запросов и может справиться с любым их количеством достаточно быстро. Рассмотрим большинство из них и разберемся как ими управлять.

Чистка с помощью фильтров

В Кей Коллекторе присутствует возможность так называемой “быстрой фильтрации” и более широкой фильтрации, которая подойдет абсолютно любому пользователю КК.

Быстрый фильтр позволяет нам отфильтровать слова, которые содержат заданные параметры. Сам фильтр находится над рабочей областью поисковых фраз.

Фото 1: Вид строки быстрого фильтра в Кей Коллекторе.Рассмотрим на примере: допустим, у нас коммерческий сайт по продаже различной техники и мы собираем семантику для страницы кондиционеров. Собрав поисковые запросы с помощью КК обнаружили, что часть из них содержит слова “бесплатно”, “бесплатный” и другие словоформы этого запроса. Чтобы быстро отсеять ненужные нам запросы можно использовать быстрый фильтр, для этого необходимо вбить в строку “бесплат” и нажать Enter.

Фото 2: Использование значимой части слова для поиска всех морфологических форм.Необходимо использовать именно вариант “бесплат” для того, чтобы охватить все словоформы и чтобы нам не пришлось искать каждое склонение вручную.

После этого система выдаст нам все запросы из группы, которые содержат именно эту последовательность букв в любой части фразы.

Фото 3: Результат фильтрации с разными окончаниями слова. Можно разом очистить все.Остается лишь выделить все фразы.

Фото 4: Кнопка, выделяющая все наши фразы под фильтром.И перенести их в папку “МУСОР”, согласно нашей методике сбора, в которой фразы не удаляются, а остаются для упрощения следующих итераций.

С этим инструментом желательно быть аккуратными, так как он имеет свои недостатки и просто фильтрует по набору и очередности букв (учитывая пробелы). Допустим, если мы работаем с коммерцией и хотим найти какую-либо компанию с названием-аббревиатурой ЕСК, то при использовании быстрого фильтра КК выдаст нам все слова, содержащие этот набор букв, а их будет немало. В тоже время он поддерживает регулярные выражения. Если вы столкнулись с ситуацией, когда быстрый фильтр уже не подходит — переходим к более широкой фильтрации.

Чтобы фильтровать фразы в многоуровневом режиме жмем на данную кнопку.

Фото 5: Кнопка перехода в расширенное меню фильтрации.Перечень возможных фильтров достаточно широк

Фото 6: Варианты фильтрации фраз в Кей Коллекторе.Уже этого набора фильтров будет достаточно даже самому привередливому пользователю.

Увеличивает возможности этого фильтра многоуровневая фильтрация, то есть возможность задать несколько фильтров одновременно. Для этого необходимо нажать на кнопку “…” и добавить “Условие внутрь”. Так же можно сразу добавить несколько групп фильтраций (“Добавить группу внутрь”) и настроить уже в них свои правила.

Фото 7: Включаем дополнительные условия фильтрации.Таким образом мы можем отфильтровать фразы по всем параметрам сразу. При переключении опции “И” на “ИЛИ” система будет рассматривать несколько вариантов фильтрации, а не связывать их. Это позволит задать сразу все фильтры в один проход.

Фото 8: Доступно два условия: «И» и «ИЛИ».Для сброса фильтрации используем эту кнопку

Фото 9: Кнопка сброса всех установленных фильтров группы.Рассмотрим наиболее часто применяемые фильтры.

Прочие символы

Фото 10: Фильтр для чистки от специальных символов.Этот фильтр поможет нам отсеять все фразы, содержащие специальные символы, которые по какой-то причине не отфильтровали на этапе сбора. Под прочими символами КК понимает следующие: \ / ? ( ) ; , ” и другие более специфические (остальные удаляются через настройки, если добавлены в них). Как показывает практика, подобные запросы часто имеют низкую, а в некоторых случаях и нулевую частоту. Если нам надо, чтобы фразы которые содержат , или ? оставались в списке, но не отображались символы — это можно изменить в настройках КК выставив опцию для автоматической замены или удаления этих знаков.

Латинские буквы

Фото 11: Фильтр для чистки от латинских букв в любой части слова.Этот фильтр будет полезен в большей степени для информационных сайтов, не связанных с названием каких-либо продуктов или товаров. Для коммерческих сайтов очень часто используются официальные названия на латинице и данный фильтр может существенно порезать семантическое ядро проекта.

Важно! Рекомендуем его использовать только в проектах, в которых латиница не встречается в “рабочих” фразах. Именно в этом случае этот фильтр оказывается очень удобным и быстрым в использовании.

Запросы с одной буквой в конце

Нередко в ходе парсинга через КК нам приезжают запросы по типу “как сделать прическу из”, “ловля рыбы в”, “купить компьютер за” и подобные выражения, которые либо являются неоконченными, либо имеют повторяющиеся слова. Про повторы поговорим чуть позже, в этом случае фильтр подойдет больше для одиночных букв в конце.

Делаем следующие настройки:

Фото 12: Настройки для чистки запросов от одиночной буквы в конце.Условие оставляем “И”, так как эти параметры должны быть связаны. Фраза “заканчивается на”, перед нужной буквой обязательно ставим пробел. Иначе нам приедут запросы по типу “в Ростов”.

Данный способ очень удобен. Можно сохранить этот шаблон и применять его во всех проектах. Для сохранения шаблона проводим следующую операцию.

Фото 13: Сохранение настроек в шаблон для будущего использования.Вводим название и сохраняем шаблон. Теперь во всех проектах можно использовать этот фильтр, остается только менять букву в конце.

Если менять букву не хочется и хочется всё разом, можно добавить более объемный и жесткий вариант. Будет выглядеть он примерно так:

Фото 14: Вариант формирования универсального шаблона.Этот способ из разряда — все и сразу и подойдет для тех, кто работает с большими ядрами в поточном режиме. Либо для тех, кто ненароком добавил подсказки Mail.ru как источник парсинга. Можно подобным методом пройтись по всему алфавиту и сохранить это в шаблон. Один раз помучившись мы сможем применять его в любом проекте и разом вычищать большой пласт мусора.

Обратите внимание! Вместо одиночной буквы можно поставить любой предлог или слово, которое подходит под ваш случай.

Чистка на повторы слов

Еще одной проблемой при парсинге являются фразы с повторяющимися словами, например такие как “как почистить картошку как”, “чистим историю браузера историю” и другие нелепые фразы, которые приезжают в основном из подсказок. В некоторых случаях они могут доходить до 10% запросов итерации. Чтобы почистить ядро от подобного мусора нам помогут опять же фильтры в связке с еще одним инструментом Кей Коллектора.

Не рекомендуем использовать только фильтрацию “содержит повторы слов”, так как в этом случае мы получим запросы, которые могут содержать повторы предлогов, что не всегда коверкает ключевую фразу. Лучше использовать связку “содержит повторы слов” и маску запросов QUERY. QUERY — метрика вордстата, которая, грубо говоря, определяет последовательность слов в запросе пользователя и отображает информацию, какой из вариантов наиболее часто используется пользователем. К сожалению, точная частота !WS не может похвастаться этим и показывает нормальную частоту несмотря на повторы слов.

Итак, для начала нам необходимо собрать QUERY для наших запросов, эта информация потребуется нам также для чистки дублей.

Фото 15: Нужно собрать порядок слов по маске [QUERY] для анализа повторов.После того, как собрали данные, задаем следующий фильтр:

Фото 16: Настройки для поиска фраз с повторением слов, исключая предлоги.Подобный способ поможет отсечь самых ярких представителей повторов, которые довольно сложно найти другими способами. Чтобы очистить более широко, так как не всегда QUERY может равняться 0, порой это значение может быть в рамках 1-15, в зависимости от точной частоты фразы !WS. Но, чтобы не фильтровать фразы с точной частотой в пределах 5-15, также потребуется добавление параметра. Выглядеть это будет следующим образом.

Фото 17: Вариант с более грубой фильтрацией ключевых слов на повторы.В этом случае мы выделим большинство фраз, в которых есть повторы и при этом не зацепим фразы с повторяющимися предлогами. Добавлять частоту !WS лучше после чистки со значением QUERY = 0. Вы можете настроить оптимальные параметры связки QUERY + WS после пары экспериментов и тестов в своем проекте.

Как видно из всех возможных применений — широкая фильтрация невероятно гибкий инструмент в Кей Коллекторе, который позволяет выстраивать многоуровневую фильтрацию. Еще один плюс — это возможность сохранения всех шаблонов в настройке программы независимо от проекта. Таким образом, один раз создав все необходимые шаблоны, мы можем очистить любое собранное ядро.

Стоп слова

Следующий популярный и достаточно удобный способ чистки фраз в КК — стоп слова.

Стоп слова в данном случае список фраз и слов, которые не подходят нам и мы хотим их вычистить из нашего проекта. По сравнению с фильтрами имеет свои достоинства и ограничения.

Чтобы перейти в раздел стоп слов необходимо нажать на иконку во вкладке “Сбор данных”

Фото 18: Рабочее окно стоп-слов в Кей Коллекторе.Для добавления стоп слов мы можем использовать импорт из готового файла или вписать фразы вручную.

Допустим, у нас коммерческий проект и нас не интересуют информационные направления запросов. В этом случае мы можем добавить слова по типу “бесплатно”, “своими руками”, “в домашних условиях” и прочие в список стоп слов.

Фото 19: Ручное добавление фраз в инструмент стоп-слова.После добавления нужных нам слов жмем “Отметить фразы в таблице”

Фото 20: Настройки словоформ для правильного поиска стоп-слов.Система отметит нам нужные слова и мы можем перенести их в папку “МУСОР”. Минусом именно этой стандартной настройки является то, что фразы не изменяются по словоформе и вариант “бесплатный” уже не будет найден. Чтобы избежать этого необходимо изменить настройку “зависимый от словоформы стоп-слова” на независимый и добавить полную форму слова, а именно “бесплатный”.

Фото 21: Варианты типа вхождений для уточнения поиска.Включение данной опции позволяет КК самому определять и менять словоформу стоп-слов. В большинстве случаев данный способ помогает найти всевозможные варианты. Однако есть одно большое НО! Кей Коллектор “слишком хорошо” меняет словоформы и бывают случаи, когда при добавлении одного слова в итоге могут быть отмечены слова с похожим корнем или набором букв. Например: при добавлении города Зеленоград в список стоп слов, независимая от словоформы фильтрация выделит слова “зеленый” и его производные. Выходом из ситуации может послужить создание двух разных списков минус слов: один, который подходит под изменение словоформы, второй, который требует только зависимой от словоформы отметки.

Важно! Если используете не проверенный и подготовленный список стоп-слов — проверяйте какие слова захватывает инструмент “Стоп-слова” при включенной опции “независимый от словоформы”. Вы можете потерять важные фразы, если система неправильно определит словоформу!

В любом случае, стоп-слова являются оперативным способом чистки, если у нас наготове есть необходимые списки минус слов.

Еще одним удобным способом добавления стоп-слов в список является кнопка в рабочей области фраз

Фото 22: Добавление в стоп-слова из списка основных фраз.Таким образом мы можем добавить слово в стоп слова и сразу же выделить все фразы, которые включают это слово.

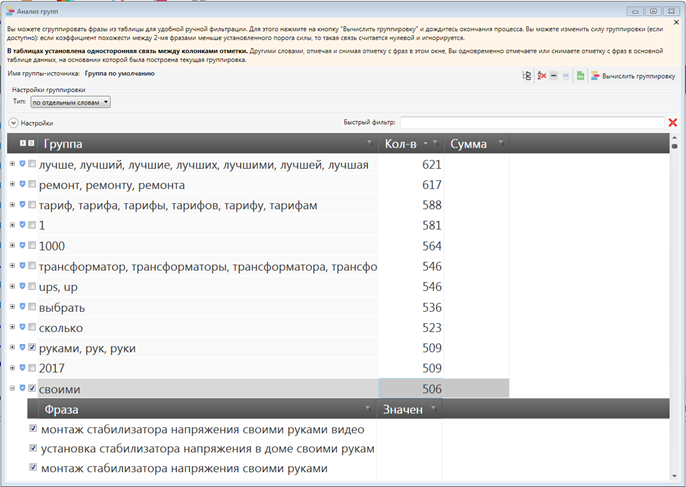

Анализ групп

Анализ групп довольно удобный инструмент для работы с семантическим ядром и для его чистки. Для доступа к этому инструменту необходимо перейти на вкладку “Данные”.

Сам из себя инструмент представляет разбивку всех фраз проекта на слова и совмещенный по группам и словоформам.

При раскрытии группы мы можем посмотреть все фразы, которые в ней содержаться и убрать отметку с тех, которые могут нам пригодиться.

С помощью инструмента мы можем выделить сразу весь блок фраз и словоформ в нем. Способ достаточно быстрый и эффективный. Разве что следует обращать внимание на словоформы в списке, так как порой туда попадают совсем не те слова и с них приходится снимать отметку вручную. После выделения нужных слов переходим в основное окно и переносим фразы в “МУСОР”. Чтобы удалить перенесенные фразы из анализа групп выполняем перерасчет группы.

Здесь же можно использовать быстрый фильтр по фразам, чтобы найти нужную группу.

Данный метод больше подойдет для работы с маленькими ядрами, так как в больших нередки случаи, что список из анализа групп может быть очень большим и при этом разбит по 1 фразе. Либо же для быстрой отметки 100% ненужных направлений, которые мы знаем и можем вбить в быстрый фильтр.

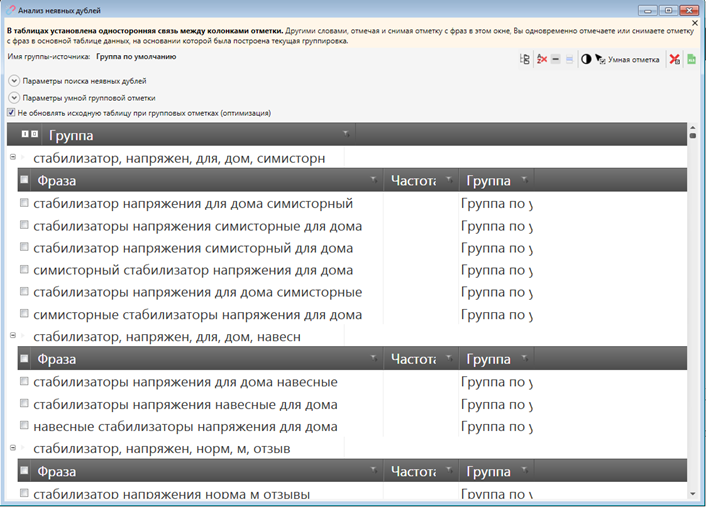

Анализ неявных дублей

Анализ дублей — это один из способов чистки семантического ядра в Кей Коллекторе. Заключается он в том, чтобы отсечь поисковые запросы, которые отличаются только очередностью слов в них и оставить наиболее часто встречающиеся формулировки.

Например, этот инструмент подскажет, какую фразу оставить “как купить квартиру” или “купить квартиру как” и более сложные варианты в автоматическом режиме.

Анализ дублей лучше всего проводить в конце всех итераций сбора перед непосредственным запуском ядра в работу.

Для того, чтобы использовать инструмент необходимо собрать такой показатель как QUERY.

Он наиболее хорошо подходит для данной задачи и определяет частоту определенной маски запроса пользователя. Хотя в самом Кей Коллекторе рекомендуется использование частоты Google Adwords.

Чтобы запустить анализ неявных дублей перейдем на вкладку “Данные”

Устанавливаем следующие настройки

Фото 23: Настройки для анализа неявных дублей.В этом инструменте такая опция как “не учитывать словоформы” работает в другом режиме за счет использования QUERY как критерия отбора. По факту мы можем отключить эту опцию и тогда у нас останутся запросы “какая стиральная машина лучше” и “какие стиральные машины лучше”. Семантического смысла это не меняет, а поисковые системы сами неплохо учитывают словоформы, поэтому нагружать ядро практически одинаковыми фразами с разной частотой нет смысла, достаточно оставить самую частотную из них.

После этого запускаем “Умную отметку”. Инструмент выделит нам фразы, которые сразу можно оценить в этом же окне. В целом, очень редко бывают случаи, когда умная отметка работает плохо либо пропускает какие-то дубли. Переносим получившиеся фразы в папку “ДУБЛИ”. О подготовке папок речь шла в статье о методике сбора в КК.

Анализ дублей позволяет вычистить тот пласт “мусора”, с которым не справятся другие фильтры и инструменты, поэтому стоит всегда использовать его в ходе чистки СЯ.

Чистка фраз по частоте

Еще одним способом чистки поисковых запросов можно назвать фильтр фраз по точной частотности. После сбора частоты !WS необходимо отсеять малочастотные направления. В нашей методике используются запросы с частотой 5 и выше. Эта цифра может быть другой в вашем случае. Стоит отметить, что этот показатель взят не для контекстной рекламы.

Для чистки по частоте подойдут уже рассмотренные фильтры. Для быстрой настройки используем фильтрацию сразу на !WS, а не на фразе.

Фото 24: Фильтруем фразы по точной частоте в Кей Коллекторе.Этот фильтр используется практически всеми и везде, единственное что подлежит изменению — точная частота, которая необходима под каждый проект.

Итоги

Мы постарались рассмотреть наиболее часто встречающиеся методы чистки семантического ядра в Кей Коллекторе. Все эти методы используем мы сами и проверили на множестве проектов. Порядок чистки вы можете выбрать сами, однако наиболее эффективный и быстрый вариант выглядит таким образом:

- Прочие символы.

- Латинские буквы (если позволяет проект).

- Одиночная буква в конце.

- Чистка через стоп-слова.

- Анализ групп.

- Чистка по частоте (можно и раньше, если ядро большое и не жалко денег на антикапчу).

- Повторы слов по QUERY + фильтр “повторы слов”.

- Анализ неявных дублей.

Пройдя по своему семантическому ядру подобным образом в каждой итерации мы сможем получить качественный набор поисковых запросов (при условии, что вручную вычистили ненужные направления через анализ групп).

Правильное семантическое ядро: сбор, чистка, кластеризация

Приветствую вас в очередной статье на моем блоге anton-apraev.ru! С вами как всегда Antay и сегодня давайте ещё раз поговорим о том как составить правильное семантическое ядро для сайта (сбор семантического ядра, чистка, кластеризация семантического ядра). Вопрос стоит о максимально возможной и самое главное качественной сборке под каждый вновь создаваемый вами сайт.

Нужно отметить что сегодня правильное семантическое ядро это основа в сайто-бизнесе, сайто-инвестициях и т.д (своеобразный бизнес-план/финансовый план), так как имея его распечатанную версию, сайт гораздо проще наполнять, а его изначальная стоимость (при возможной продаже сайта) сразу будет гораздо выше. Поэтому данный аспект желательно знать очень хорошо.

Правильное семантическое ядро: работа с Key Collector

Сбор семантического ядра (если мы хотим создать качественное, правильное семантическое ядро) начинается через программу Key Collector (подробней как с ней работать читайте здесь). Здесь жмём создать новый проект и обозначаем его по названию сайта-проекта, жмём сохранить. В правой части программы (управление группами) сначала обозначим новую группы, а затем зададим её базовые слова-маркеры (слова-потребности пользователей для выбранной ниши). Для этого после создания группы просто жмём на большую зеленую кнопку в верхнем меню — «Добавить фразы». В открывшимся поле вбиваем всё что приходит в голову с вашей выбранной нишей. Это нередко могут быть категории товаров если вы составляете семантическое ядро для интернет магазина или различные стороны (аспекты) какой либо деятельности если вы собираетесь вести тематический сайт/блог и т.д. После жмём добавить в таблицу.

Сбор семантического ядра: правая колонка яндекс-вордстат

Далее сбор семантического ядра осуществляется через Яндекс-Wordstat путём добавление наших первоначальных слов в этот сервис для сбора возможных дополнительных запросов из правой колонки этого сервиса. В Key Colletor это делается автоматически через синею верхнюю иконку — «Пакетный сбор слов из правой колонки Yandex.Wordstat» (для этого у вас должен быть подключён хотя бы 1 аккаунт Yandex.Direct, подробнее здесь). Выделяем и копируем все первоначальные фразы (через зажатый shift) и вставляем их в поле для парсинга из правой колонки Wordstat — жмём начать сбор.

Недостатки такого способа — в множестве порой не подходящих слов (но не всегда), поэтому в ряде случаев есть смысл добавлять слова из правой колонки wordstat вручную по очереди вбивая первоначальные запросы.

Пакетный сбор поисковых запросов

Расширение списка ключевых слов — можно дополнительно получить с поисковых подсказок. Для этого в верхнем меню жмём иконку — «Пакетный сбор поисковых подсказок». Обычно ставят галочки напротив поисковых систем Yandex и Google, а также Yandex.Direct, вставляют туда первоначальные слова и собранные с правой колонки и жмут запустить.

Анализ конкурентов

Правильное семантическое ядро в качественном исполнении практически всегда связано и включением в него ключевых слов взятых с сайтов-конкурентов. Так можно его значительно расширить, в ряде случаев если пользоваться специальными платными сервисами (подробнее о них здесь) можно сразу брать за основу самые трастовые сайты даже не вводя изначально свои собственные базовые ключевые слова. Как правило такие сайты получающие по несколько тысяч (десятков тысяч или даже сотен тысяч) просмотров в день уже составлены по очень грамотному и обширному семантическому ядру. Всё что остается сделать это получить данные ключевые слова и затем уже работать с ними (путём чистки, группировки ну и т.д). По данному методу также отлично можно составлять семантические ядра для интернет-магазинов парся ключевые запросы сайтов со сходным вашего интернет-магазина ассортиментом.

Если же вы парсите конкурентов в ручном (бесплатном) режиме — например их категории, их затем дополнительно стоит прогнать также через левую колонку yandex wordstat, что в key collector также можно сделать автоматически нажав на верхнюю оранжевую иконку как показано на рисунке.

Чистка первичного сбора слов

Итак после первичного сбора ключевых слов — самостоятельно или сп******ых с конкурентов через специальные платные сервисы правильное семантическое ядро требует очистки от неподходящих для выбранной ниши слов и просто слов-паразитов. Это делается через-стоп слова — которые можно добавлять заранее или после сбора базы первоначальных ключевых слов (большой разницы это не играет). Заранее указать неподходящие слова для вашего семантического ядра можно в разделе — Сбор данных — большая кнопка — Стоп-слова. Это также хороший способ сразу отсеять ненужные запросы если вы скажем создаете сайт под какой либо отдельный город (региональный портал, магазин и т.д).

Вообще если создаете сайт под региональную тематику — лучше сразу искать запросы из нужного вам региона. Для этого просто в нижних настройках key collector — жмём на иконку регионы и выбираем нужный нам регион и нужный нам город.

Если у вас узкотематический (узконишевый) сайт — по какому то 1 виду автомобилей или медицинских диагнозов или скажем по какой то определенной вещи/явлению — которые имеют множество разновидностей — стоит зайти на любой каталог посвещённый этой теме, спарсить оттуда все эти виды — внести их(кроме вашего выбранного вида) в стоп-слова.

Другой способ сделать чистку стоп-словами (уже после первичного парсинга) перейти во вкладку — Данные — Анализ групп. Здесь просматриваем в открывшимся блоке список и если видим автоматически собранную группу слов которую как мы считаем не подходит для нашей тематики просто выделяем её — и через правую кнопку мыши — «Отправить все слова из определений целиком отмеченных групп в окно стоп-слов». В открывшимся следом блоке — ещё раз бегло просматриваем все выделенные галочками слова этой группы и жмём — Добавить в стоп-слова.

Анализ и удаление неявных дублей

В нашей первичной сборке может оказаться много фраз с одинаковыми словами, но просто переставленными между собой (т.е у них будет разный порядок одних и тех же слов). Здесь как и в математике от перемены мест слагаемых сумма не меняется. Несмотря на то что в ряде случаев (как например с гуглом) у таких дублей может быть разная частотность — классическая практика составления семантического ядра показывает что должен быть лишь 1 вариант фразы с большей частотностью.

Чтобы избавиться от неявных дублей (оставить лишь 1 вариант с большей частотностью) в самом простом варианте — перейдем в верхний раздел — Данные — Анализ неявных дублей (перед нами откроется окно где будут сгруппированы все дубликаты) — жмём отметить все. Теперь все неявные дубли отметятся — и вернувшись на блок с ключевыми фразами нужно кликнуть на стоящий над этими фразами фильтр-иконку — Фильтрация фраз — выбрать напротив IsChesked = истина. Теперь в правом блоке (управления группами) — ключевые слова заметно поредеют, так как был включен режим отображение только неявных дублей.

Так как яндекс не чувствителен (не определяет частотность) от перемены слов между собой, а нам нужно отобрать из неявных дублей варианты с большей частотностью — подключаем Гугл.Адвордс (как и в случае с яндекс.директ здесь нужно будет подключить хотя бы 1 аккаунт но теперь уже от google — в настройках — google.adwords — нужно будет вбить логин:пароль (без @gmail.com).

Жмём на иконку «Сбор статистики с Google.Adword» — получить данные. После сбора статистики с Google.Adwords можно вернуть отображение всех остальных слов — для этого опять заходим в Анализ неявных дублей и жмём «Снять отметку со всех». После этого здесь же (в анализе неявных дублей) жмём выполнить умную группировку.

Настройки умной группировки лучше задавать с такими параметрами:

Будут отмечены фразы-дубли имеющие меньшую частоту (и которые нам не нужны) — жмём удалить отмеченную.

Правильное семантическое ядро: сбор частотности ключевиков

Теперь приступаем к основной функции программы Key Collector — собираем частотность ключевых фраз которая у нас загружена (оставлена после чисток) в этой программе. Жмём иконку — Yandex.Direct — в открывшимся окне:

- 1. Указываем регион сбора (если проект заточен под рунет выбираем Россия + СНГ), если это региональный проект дополнительно указываем федеральный округ — регион — в ряде случаев город.

- 2. Выбираем параметры поиска — в исходном виде, в кавычках, с восклицательным знаком (можно включить все сразу, можно парсить по очереди).

После парсинга в графах частотность появиться частотность (сколько данную фразу искали люди), если вы парсили по 3 направлениям — исходном, с кавычками, с восклицательным знаком — в каждом из этих блоках будет отражён свой результат.

- Оператор «» — учитывает только ключевой запрос + все его словоформы (-окончания). А сочетание этого слова с другими словами не учитывает.

- Оператор «!» — учитывает только точный ключевой запрос самостоятельно или вместе с другими словами. А словоформы (-окончания) этого запроса не учитывает.

Чистка по частотности

Перед второй чисткой (при большом объёме ключевых слов) желательно прогнать парсинг частотности хотя бы на 2 раза, потому что с 1 раза Key collector — может просто не осилить этот объем и вы случайно удалите не просканированные хорошие ключи. После же этого стоит удалить запросы у которых частотность = о (т.е эту фразу пользователи не искали за месяц вообще) или меньше 10.

Некоторые удаляют частотность = 0 или меньше 10 только у базовой частоты, а у частоты в кавычках, такие ключевые слова перемещают в отдельную группу (на будущее). Это делается через раздел — Управление группами — выбирается группа — через ПКМ — из открывшегося блока выбирается — создать новую группу внутри. Потом также через фильтр выявляют и выделяют эти фразы (ЛКМ+shift) — и мышкой просто переносят в отдельно выделенную группу.

Но в любом случае, в основном списке фразы с нулевой или низкой частотностью должны быть убраны.

Правильное семантическое ядро: сбор конкурентности ключевиков

После сбора частотности (сколько людей вбивают конкретные ключевые фразы в конкретный временной отрезок) необходимо собрать по ним их конкурентность (сколько статей уже находится в топе-поисковиков по данным ключевым фразам). Это делается через верхнюю вкладку — Сбор данных — иконку Key. Жмём на неё — если вы работаете под рунет — выбираем — Получить данные для ПС Яндекс (также можно сразу нажать на — Получить все данные (яндекс,гугл,майл,ютуб). Учитываем что без proxy — это будет делаться долго, поэтому лучше собирать данные о конкурентности по очереди.

Знания точной частоты запросов и конкуренции по данным запросом бывает достаточно для информационных сайтов.

После сбора данных о конкуренции запросов по top-выдачи поисковых систем — в этой же разделе — жмём «Рассчитать KEY по имеющимся данным». По специальной формуле — будет рассчитана конкуренция и отображена в специальном столбце основного окна программы.

Это формулу можно задать и самому в настройках программы. Я в последнее время использую формулу близкую к формуле сервиса мутаген (также определяющий конкурентность ключевых запросов). Стираем все стандартные формулы — заменяем их :

В key1 прописывается:

- ( KEI_YandexMainPagesCount * 6 ) + ( KEI_YandexTitlesCount + KEI_GoogleTitlesCount ) + ( KEI_YandexDocCount / 73000 )

В результате в колонке key1 получаем конкурентность по яндексу и гуглу. Чем больше будет число тем более конкурентный считается запрос (в топе по данной ключевой фразе присутствуют уже большое количество сайтов) и наоборот при 5-8 или 0 этот запрос считается малоконкурентным или конкуренции нет вообще и можно легко продвинуться по данному запросу.

Экспорт

После сбора ключевиков, чистки, анализа частотности и конкурентности (первой части семантического ядра)- перед экспортом проекта стоит скрыть ненужные (не использованные;пустые) колонки для удобства восприятия. Для этого переходим во вкладку — Вид — Автонастройка видимости колонок (можно также затем нажать на — «Сохранить настройки вида» — задать имя шаблону и сохранить как отдельный шаблон)

Формат экспорта лучше ставить в .xmls для удобства дальнейшей работы в Exel (при ручной работе) или же для совместимости с рядом программ-кластеризаторов (например Key Assort).

Чтобы его поставить переходим в Настройки — вкладку Интерфейс — Формат экспорта (ставим радиокнопку на .xmls)- сохранить изменение. Там же в самом низу можно заранее установить что должно по умолчанию, каждый раз, отображаться в столбцах главного меню программы (обычно оставляют фразу, 3 вида частотности и key1).

После установки экспорта в .xmls экспортировать файл можно просто нажав на соответствующую иконку экспорта (в виде таблицы Exel).

Кластеризация семантического ядра по Key Assort

Правильное семантическое ядро неизбежно включает в себя группировку (кластеризацию) семантического ядра которую наиболее быстро можно сделать через специальные программы или платные сервисы (типа Rush-Analytics.ru, Topvisor.ru, Zapros.binet.pro, Just-magic.org), я пользуюсь программой Key Assort (с ценой оплаты только 1 раз) и настроенной на силу группировки 4, вид кластеризации — Soft для информационных сайтов и Hard для коммерческих. В данной програме в настройках также следует указать URL-для запросов (через который будет осуществляться кластеризация на основе топ-выдачи), от вашего яндекс-аккаунта (+нужно иметь в вебмастере-яндекс хотя бы 1 сайт за каждый из которых яндекс будет выдавать вам определенное количество лимитов в день).. Если у вас пока нет сайтов (их мало или просто не хотите заморачиваться) вместо своего аккаунта можно вставить url — купленный через http://xmlproxy.ru/. Этот сервис по продаже и покупке лимитов (при большом объеме сайтов у вас вы можете и сами продавать лимиты там в автоматическом порядке и иметь от этого небольшой пассивный доход).

Кластеризация семантического ядра: импорт в Key Assort

Для того чтобы импортировать в программу собранные и прочищенные ключевые запросы — жмём файл создать новый проект. После его обозначения — жмём Импорт — выбираем один из вариантов:

- 1. Ручное добавление фраз (из key collector — через выделить всё -копировать — вставить)

- 2. Список фраз в txt-файле.

- 3. Список фраз с данными о поисковой выдаче xlsx-файла (фразы+url)

- 4. Список фраз в обычном xlsx-файле.

Обычно если проект экспортируется из key collector выбирается вариант — Список фраз в обычном xlsx-файле. Перед тем как файл начнет импортироваться следует ответить на ряд вопросов-настроек связанных с импортируемым файлом. Если вы указывали в настройках key collector вышеназванные параметры (оставление строк — фраза, частотности, key1) всё происходит очень легко и быстро.

После загрузки ключевых фраз в верхнем меню программы жмём — Собрать данные, ждём пока программа не сообщит о том что — данные загружены. После этого жмём верхнюю кнопку — Кластеризовать — ждём оповещения о том что кластеризация завершена.

Ряд фраз может не попасть ни в какую категорию (не сгруппировано) — вы можете самостоятельно просмотреть эти фразы, выделить подходящие вам и создать из них новую группу, неподходящие вам можете полностью удалить. Через перетаскивания мыши можно также перетаскивать любые фразы в любые группы.

Кластеризация семантического ядра: экспорт из Key Assort

Для экспорта сгруппированных ключевых запросов — выделяем все нужные нам группы (через зажатый shift) и перетаскиваем их в правую колонку. После жмём экспорт — обозначаем и экспортируем готовый файл (xlsl).

Собственно на этом правильное семантическое ядро в виде 2 основных частей семантического ядра (сборка и группировка (или кластеризация семантического ядра)) созданы. При больших объёмах и уже профессиональной работе с сайтами написание статей по грамотно составленному семантическому ядру делегируют копирайтерам. Однако и для них нужно давать грамотно составленное техническое задание по написанию статей, но это уже тема отдельной статьи..

Резюме

В заключении хочется сказать о действительно нужных и полезных инструментов для seo-оптимизации. Софт можно назвать главным видом инвестиций в работе веб-мастера. Поэтому эти программы (или их аналоги) желательно иметь в своём распоряжении. Они очень сильно экономят время и приносят (при систематической работе) деньги и позволяют легко создать правильное семантическое ядро. Я желаю вам успехов, удачи и твёрдых намерений в реализации ваших задач на пути к вашим целям. До встречи!

метод «Муравейника». Читайте на Cossa.ru

Один из первых шагов при продвижении сайта — создание семантического ядра (списка ключевых слов) или доработка существующего.

SEO-специалисты подходят к этому процессу с разных сторон.

Одни начинают с проработки mindmap-карты со всеми возможными комбинациями ключевых слов. Потом проверяют по частоте все варианты и получившийся список берут в работу.

Другие собирают семантику конкурентов (Serpstat, Spywords), статистику систем контекстной рекламы (Яндекс.Директ, Google AdWords), поисковые подсказки, запросы из счётчиков статистики, базы ключевых слов (Moab, «Букварикс»).

Всё это собирают вместе и начинают многочасовую фильтрацию в ручном режиме с применением некоторой автоматизации.

Мы обычно применяем оба этих способа, но к фильтрации у нас свой подход. О нём в том числе и расскажу в этой статье.

Есть разные метода сбора семантики.

Метод первый. Полностью вручную

Нереально трудоёмкий и неэффективный процесс. Останавливаться на нём не будем. Не надо так.

Метод второй. С использованием инструментов

Часто используется Key Collector.

|

|

Фильтры в Key Collector | Группы в Key Collector | Неявные дубли в Key Collector |

|

|---|---|---|---|---|

|

|

|

|

|

|

В нём же фильтруются запросы с нулевой частотой и проводится фильтрация с помощью подгрузки списка стоп-слов.

Применяется ещё ряд методик облегчающих процесс фильтрации, но после этого всё равно приходится часами проверять оставшиеся запросы вручную.

Наш подход

Мы много лет применяли вышеописанный подход. Но не покидало ощущение, что можно сделать это проще и быстрее.

Стали искать варианты. Причём искали не только метод фильтрации, но и выявления вероятности продвижения конкретного сайта по этому запросу. И среди прочих методик выбрали ту, которая давала наибольшее качество и скорость. Это определение «похожести» сайтов из первой десятки на продвигаемый сайт.

Логика простая: если в топе по запросу нет сайтов похожих на нас и много непохожих, то алгоритм поисковой системы и нас туда редко будет пропускать.

Позже к этому мы стали добавлять к оценке параметры конкурирующих сайтов и выводить параметр на их основе (в западных сервисах это часто называется Keyword difficulty), чтобы среди «похожих» выявить более лёгкие и сложные запросы.

Например, если на первой странице только сайты агрегаторы, то сайт конкретной организации по нему будет продвинуть маловероятно. Или если только информационные сайты, то продвинуть по такому запросу коммерческий сайт (даже его информационной страницей) также затруднительно.

Сначала мы применяли этот подход практически в ручном режиме, потом написали скрипт, который автоматизировал этот процесс.

В нём на вход подаётся:

- список запросов;

- целевой поисковик;

- регион;

- несколько похожих сайтов конкурентов.

На выходе:

- похожесть топа;

- среднее значение параметров по топам (возраста конкурентов, число их страниц в индексе, их ссылочные параметры…).

Примеры применения

Пришёл клиент — интернет-магазин лакокрасочных материалов. От прошлого подрядчика остались 705 запросов. На первый взгляд, неплохо подобранные. Основная часть инструмента была к тому моменту готова и активно тестировалась. Сразу загрузили в него, и итог отсортировали по убыванию похожести.

В итоге в верху списка оказались сайты, у которых много похожих и мало непохожих.

Внизу — мало похожих, много непохожих.

Видно, что уже сейчас самый верх списка имеет много хороших позиций, а внизу их практически нет.

Что мы сделали дальше? Через 15 минут после получения списка запросов вернули клиенту проанализированный список запросов с прозрачной аргументацией, почему треть запросов из его списка в ближайшем будущем практически не имеют шансов выхода в топ и на них не нужно тратить время и деньги.

Ещё один пример чистого списка запросов.

Тематика: маникюрный интернет-магазин.

До внедрения методики мои ребята подобрали 2000 запросов. Как и в прошлом случае проверку «на глазок» запросы проходят.

Здесь мы уже добавили подгрузку дополнительных параметров. Аналогично отсортировали по убыванию суммарной похожести в Яндексе и Google.

Верх списка:

Середина:

Низ:

Мы проверили динамику позиций запросов и опасения подтвердились. Запросы с высокой похожестью за время продвижения заметно выросли. С низкой — даже немного просели.

В результате мы отсеяли треть запросов.

И на этом этапе ввели в работу коэффициент сложности запроса Keyword Difficulty, рассчитанный на основе дополнительных параметров без учёта похожести.

Оставшиеся 2/3 запросов объединили в кластера и отсортировали кластера по сочетанию средней похожести, Keyword Dificulty и частоты и продолжили работу продвигаясь по кластерам, начиная с наиболее полезных.

Как мы это сейчас используем

- Фильтрация грязной семантики.

- Фильтрация чистой семантики.

- Выявление запросов «в зоне риска».

- Приоритизация запросов и кластеров.

- Анализ проседания из-за смены интента запроса/кластера.

Про запросы «в зоне риска» хочется сказать отдельно. Это очень важно в клиентском SEO. Когда запускаем продвижение, часто сайт клиента находится в топе по многим запросам, где он не должен находиться и где он один. Например, когда в топе по запросу только информационные сайты и наш клиент — один коммерческий среди них. Положение по такому запросу довольно шаткое и скорее всего сайт рано или поздно по этому запросу вылетит.

И здесь важно аргументированно предупредить клиента об этом, чтобы клиент имел некоторый прогноз как в целом по продвижению, так и по группам запросов.

Мы выложили этот инструмент на поддомен своего сайта, назвали его «Муравейник Tools».

Для тех, кто дочитал до этого места и хочет обкатать эту методику, есть промокод на 5000 лимитов.

Регистрация

Промо-код: cossa

Читайте также:

Мнение редакции может не совпадать с мнением автора. Ваши статьи присылайте нам на [email protected]. А наши требования к ним — вот тут.