Кластеризация семантического ядра + excel + автоматизация

Оглавление:

- Кластеризация и чистка семантического ядра в Excel

- Зачем все это нужно и почему все так сложно?

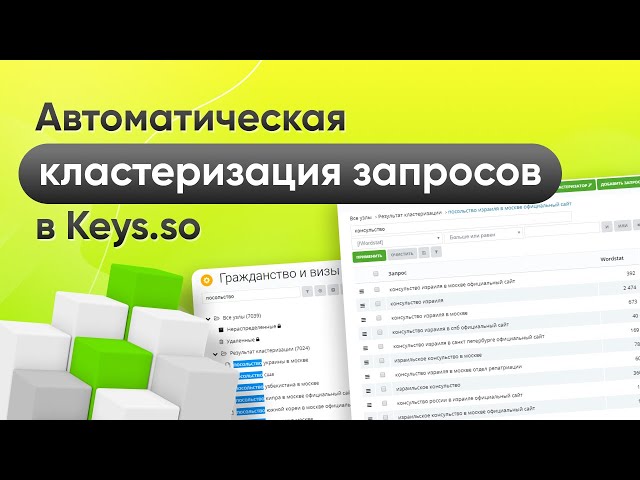

- Автоматизация кластеризации семантического ядра

Здравствуйте, уважаемые читатели сайта Uspei.com. В этом уроке мы рассмотрим такие вещи как группировка запросов в рамках семантического ядра или кластеризация. Начнем мы с группировки поисковых запросов и чистки ядра. В прошлой статье мы посмотрели, как собирать статистику, какие инструменты для этого можно использовать, и все это почистили, удалив дубликаты. А также мы рассмотрели виды запросов.

У нас есть большой список запросов, из которого мы должны удалить оставшийся мусор и провести группировку. То есть у нас есть здоровенный список запросов. В некоторых тематиках он может доходить до 10 000. Наша задача сейчас разбить его на группы, каждая из которых будет содержать в себе только синонимы.

К примеру, если у нас есть запрос «купить ноутбук», то мы должны сделать группу, в которой будут только синонимы к запросу «купить ноутбук».

Под синонимом в SEO имеется в виду то, что в запросы, по которым люди ищут, вкладывается один и тот же смысл. К примеру, запросы «купить ноутбук» и «купить ноутбук apple» это НЕ синонимы и они будут входить в разные группы, потому что у них разное понятие. В первом случае человек ищет просто ноутбук и это может быть даже samsung, а совсем не apple. Во втором же случае человек ищет конкретно apple. Ну, еще один пример. Человек ищет «такси» и «междугороднее такси» — тут думаю тоже очевидно и понятно.

Таких групп в рамках большого семантического ядра может быть огромное количество, их может быть более нескольких сотен в редких случаях более тысячи.

И потом я вам дам ссылки на набор инструментов, который может существенно автоматизировать или ускорить эту группировку или кластеризацию, как это сейчас модно называть.

К оглавлению ↑

Кластеризация и чистка семантического ядра в Excel

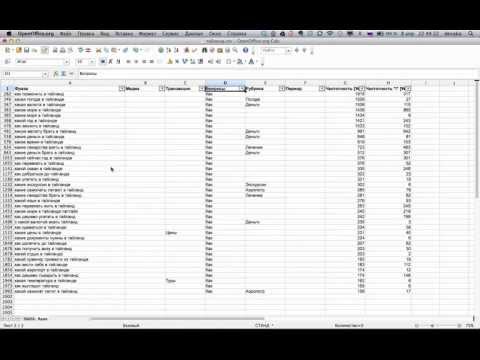

Возвращаемся к нашему списку запросов и у нас достаточно простой алгоритм. У нас уже отсортированы все запросы по убыванию частотности, то есть от самых популярных до наименее популярных. Дубликаты мы удалили.

Мы берем каждый запрос и смотрим подходит он нам или нет. Например, у нас есть запрос «интернет-магазин», но если мы занимаемся только ноутбуками, то этот запрос без слова ноутбук нам не подходит. Значит запрос «интернет-магазин» мы удаляем — это не тематический запрос.

Дальше запрос «ноутбук». Да, в принципе это информационный запрос, но не совсем понятно, что человек вкладывает в этот запрос, когда вбивает его в поисковую строку. Ищет ли он информацию, картинку или он ищет товары или возможно что-то еще.

Если мы сомневаемся в смысле поискового запроса, логично его проверить. Как это делается? Мы копируем запрос и вбиваем его в новой вкладке в ту поисковую систему, с которой мы работаем. Например, Google.

Мы видим, что Google показывает нам набор интернет-магазинов. Мы видим точно, что это запрос коммерческий и если у нас интернет-магазин, мы его оставляем.

И мы добрались до первого подходящего нам запроса. Давайте выделим нашу первую группу запросов, в которую будут входить все слова с упоминанием слова «ноутбук». Для этого нужно включить фильтр и отфильтровать по текстовому условию «содержит». Но там могут быть словоформы запроса «ноутбук» поэтому мы просто напишем «ноут» и получаем список строк только с поисковыми запросами, в которых упоминается «ноут».

Каждую вкладку мы будем называть соответственно по тому слову, по которому мы произвели фильтрацию. В первой же вкладке мы вручную (!) выделяем все отфильтрованные ключи и удаляем. После чего очищаем фильтр.

Итак, в первой вкладке у нас остались все ключи, которые НЕ содержат «ноутбук», а мы переходим во вторую («ноутбук») и продолжаем работать теперь уже там.

Итак, следующее слово «ноутбук». Мы уже разобрались, что это коммерческий запрос и по нему также как и по запросу «купить ноутбук» показываются интернет-магазины, то есть это синонимы и мы оставляем их в одной группе.

«DNS ноутбуки» — как раз это тот самый навигационный запрос и можно предположить, что приставка «DNS» как популярный интернет-магазин будет часто встречаться в списке запросов про ноутбуки. Поэтому давайте сразу удалим все чужие навигационные запросы «DNS». Фильтр — выделяем вручную и удалить.

«Ноутбуки бу» — аналогично как с «dns» — удаляем, если только мы не продаем б/у ноубуки.

«Купить ноутбук Москва» — тут уже добавляется регион, а мы далеко не в Москве. По сути, запрос повторяет смысловую нагрузку запроса «купить ноутбук» или просто «ноутбук». Но поскольку добавляется регион, стоит проверить считает ли google эти поисковые запросы синонимами.

Мы берем запрос «купить ноутбук» вбиваем его в google и в другой вкладке вбиваем запрос «купить ноутбук Москва». И сравниваем результаты поиска на предмет повторения результатов, то есть именно конкретных страничек. Если хотя бы 4-5 страничек одинаковых, то мы можем считать, что это запросы синонимы и Google показывает по ним одинаковый смысл. Если же по этим запросам выдача разная, то «купить ноутбук Москва» навигационный запрос и он нам не нужен.

Идем дальше и таким образом проделываем ту же процедуру — удаляем мусор и создаем новые группы отличные по смыслу.

Очень рекомендую чистить семантику, используя фильтры, если чистить ручками, то есть большой шанс что-то пропустить.

Но когда мы фильтруем, надо быть аккуратным, чтобы не удалить какие-то важные слова случайно отфильтровав их. Например, если в фильтр вбить просто «бу» то он отфильтрует ВООБЩЕ ВСЕ слова, содержащие «бу» — например, сам запрос «ноутБУк» — а это уже крах))). Поэтому лучше вбить по очереди два варианта с пробелом вначале и вконце » бу» и «бу «, а также через слэш «б/у». Помните это и будьте внимательны))))).

Например, если в фильтр вбить просто «бу» то он отфильтрует ВООБЩЕ ВСЕ слова, содержащие «бу» — например, сам запрос «ноутБУк» — а это уже крах))). Поэтому лучше вбить по очереди два варианта с пробелом вначале и вконце » бу» и «бу «, а также через слэш «б/у». Помните это и будьте внимательны))))).

И вот у нас запрос «ноутбук hp». Это уже не просто «ноутбук» — это уже более узкая тема, значит мы должны выделить ноутбуки hp в отдельную группу.

Производим фильтрацию «текст содержит» получаем набор запросов и переносим их в новую вкладку «ноутбуки hp». Из второй вкладки «ноутбук» перенесенные в 3 вкладку результаты удаляем.

Так мы будем повторять эту процедуру, пока в каждой вкладке не останутся только синонимы. То есть дальше мы должны перейти в 3 вкладку «ноутбуки hp» и здесь их разделить еще на более подробные группы. Мы видим, что здесь есть «ноутбук hp pavilion», » ноутбук hp compaq» и «ноутбук hp игровой». Таким образом, эта группа будет разбита еще на 3 группы.

Во вторую вкладку мы вернёмся, когда во всех следующих группах все слова будут синонимами и продолжим этот разбор. Продолжим до тех моментов, пока самая первая наша вкладка не будет разложена на группы, а в ней самой не останутся только нецелевые запросы или запросы, которые тоже будут синонимами.

В итоге наша задача создать файл, в котором у нас будет огромное количество вкладок. В разных темах по-разному — возможно в некоторых темах будет всего 5-6 вкладок, если тема очень маленькая, но основная задача, чтобы в рамках одной вкладки были только запросы синонимы.

Причем не просто слова синонимы в классическом понимании, а синонимы с точки зрения поисковой системы. Вот как из примера «купить ноутбук» и «ноутбук» это синонимы с точки зрения поисковой системы, поэтому они у нас остались в одной группе.

Если во вкладке 20 синонимов и один НЕ СИНОНИМ — выносим его одного в отельную вкладку. Это очень важный момент, так как каждая группа это отдельная страница, на которой эти запросы будут продвигаться, и чем больше будет ошибок и недоработок, тем менее чистой по смыслу станет страница, что скажется результатах поиска.

Повторю еще раз основную мысль — в каждой вкладке должны быть запросы подходящие по смыслу. Пример, если в текущей вкладке 5 запросов:

- «заработать в интернете»

- «как можно заработать в интернете»

- «где заработать через интернет»

- «как заработать деньги в интернете»

- «как заработать в интернете без обмана»

Первые три запроса останутся в текущей вкладке, так смысл у них один, а последние два уйдут каждый в свою группу-вкладку, так как они не совпадают по смыслу ни с первыми тремя, ни между собой — они более детализированы. В одном случае речь идет о деньгах ( а заработать в наши дни можно все что угодно — биткоины, баллы в играх и т.д.), а во-втором, речь идет о заработке без обмана.

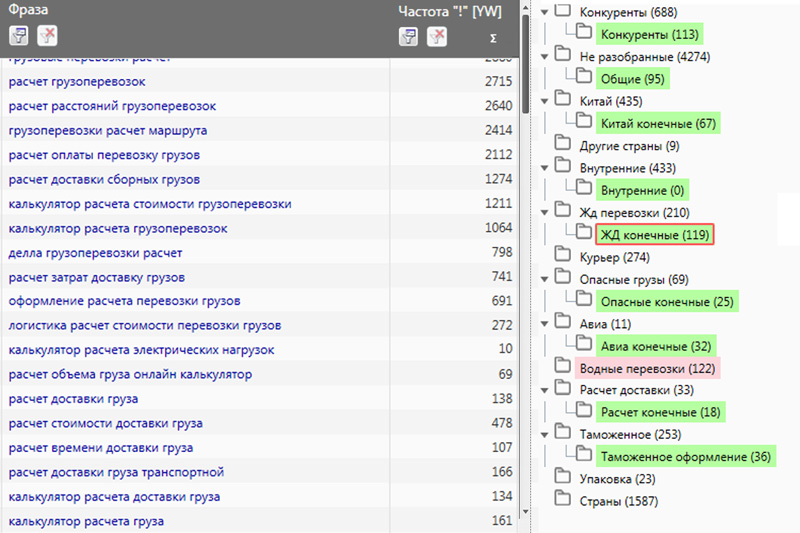

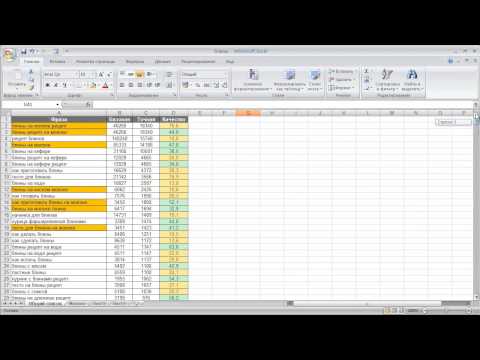

Для понимания я в течение часа сварганил (правда не до конца) семантику по запросам, «заработок в интернете» «заработок в сети» «заработок онлайн». Первая вкладка — вся семантика, а далее по группам. Красные вкладки это основные, из которых идет разбор. Повторюсь, это полусырая заготовка, которую еще нужно дорабатывать.

Красные вкладки это основные, из которых идет разбор. Повторюсь, это полусырая заготовка, которую еще нужно дорабатывать.

Скачать пример семантического ядра в excele.

К оглавлению ↑

Зачем все это нужно и почему все так сложно?

Вы уже, наверное, поняли, как много времени вам придется уделить на сбор и кластеризацию семантического ядра, и часто люди спрашивают — зачем это все нужно? Какую практическую пользу это несет?

На самом деле, сейчас это не очевидно, но буквально через два-три этапа вы увидите, что вся поисковая оптимизация, абсолютно все seo, построено на основе правильно собранного семантического ядра. SEO — это не просто любительский способ сделать свой сайт лучше. Это, можно сказать наука, в которой все начинается с «атомов» и именно это приводит к результату.

SEO можно сравнить с большим спортом — боксом или сноубордом или любым другим. Если вы не освоите технику ПРОФЕССИОНАЛЬНЫХ ударов или элементов езды, то это скажется на скорости и выносливости и вы проиграете сопернику, кто этим не пренебрег. Если вы не хотите делать этого, тогда это уже не SEO, а что-то другое — не такое эффективное. И в SEO, как и в спорте, нет 15 или 20 места — есть только первая страница и все.

Если вы не хотите делать этого, тогда это уже не SEO, а что-то другое — не такое эффективное. И в SEO, как и в спорте, нет 15 или 20 места — есть только первая страница и все.

Мы не можем начинать оптимизацию сайта, если мы не сделали семантику, не разбили ее на группы, не обработали и не почистили. И все что мы будем делать дальше, будет основано на семантике.

Приведу конкретный пример. Мы же понимаем, что по каждому запросу поисковик дает свой результат выдачи. Возьмем какую-то небольшую тематику по которой в семантике всего 100 запросов. И вот у одного владельца 100 страниц на сайте, в которых содержимое часто пересекается, структура сайта от этого расплывчатая, поисковик не понимает до конца, какие страницы релевантны запросу больше, а какие меньше. В итоге, кроме путаницы, эти 100 страниц содержат в своем «винегрете» ответы только на 30-40 запросов.

А у второго владельца сайта, благодаря полному собранному кластеризованному семантическому ядру, на каждый запрос есть соответствующая страница, строго релевантная только этому запросу. Поисковик и пользователи четко понимают структуру сайта, а также не страдают «дежавю», что уже где-то несколько раз читали об этом на сайте. Внутренняя перелинковка четко структурирована, так как у владельца сайта не возникает вопросов на какую из 10 страниц поставить внутреннюю ссылку. Этот сайт поисковик покажет по ВСЕМ 100 запросам и соберет весь трафик.

Поисковик и пользователи четко понимают структуру сайта, а также не страдают «дежавю», что уже где-то несколько раз читали об этом на сайте. Внутренняя перелинковка четко структурирована, так как у владельца сайта не возникает вопросов на какую из 10 страниц поставить внутреннюю ссылку. Этот сайт поисковик покажет по ВСЕМ 100 запросам и соберет весь трафик.

К оглавлению ↑

Автоматизация кластеризации семантического ядра

Такая работа по группировке запросов по обработке всей этой статистики вручную занимает достаточно много времени. Особенно если человек делает это первый раз. Но я вам рекомендую, если вы хотите научиться работать запросами, работать с семантикой, хотя бы один раз проведите все это вручную в электронных таблицах. Тогда вы сможете прочувствовать и понять, как это работает.

Если же вы работаете в очень больших объемах, крайне рекомендую использовать профессиональные инструменты. Чаще всего они платные.

Один из самых популярных инструментов по работе с семантикой это инструмент «Key Collector», которая позволяет автоматизировать большинство процессов по сбору и обработке семантики. Как минимум, она умеет автоматически собирать ключевые слова из yandex wordstat, а также данные о частотности по запросам и другие рекомендации.

Если же у вас есть уже готовое отфильтрованное от мусора семантическое ядро, то вы можете прибегнуть к помощи дополнительных сервисов, которые производят автоматическую кластеризацию. Лидером сейчас на рынке является онлайн-сервис, который называется Rush analytics.

Расценки не очень высокие и в принципе, если у вас один сайт, вы владелец или вебмастер, то вы можете собрать семантику, почистить ее, после чего просто отдать на кластеризацию такому сервису.

Теги: AppleGoogleHPSamsungseoавтомобиливнутренние факторыинструментыинтернетконтентноутбукиопросочкисемантикассылкиструктура сайта

Мы в соцсетях:

Кластеризация поисковых запросов.

Что это вообще такое и как правильно её сделать для SEO? / Хабр

Что это вообще такое и как правильно её сделать для SEO? / ХабрВсем привет! 🙋♀️ Когда-то я написала эту статью и опубликовала её на своем сайте, но решила уйти из SEO и сайт, соответственно, больше не нужен. Дабы не пропадать моей статье, решила перенести её на Хабр. Данная статья — туториал, который поможет разобраться как делать правильно кластеризацию или, простыми словами, группировать запросы для SEO-продвижения.

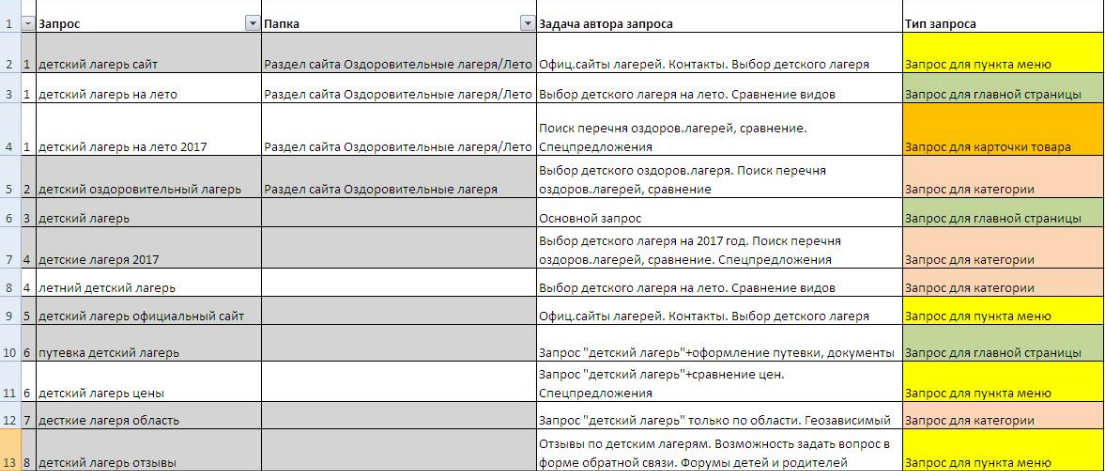

Кластеризация семантического ядра – это распределение ключевых запросов на группы, которые будут использоваться для оптимизации определенных страниц на сайте или добавления новых страниц.

Приступают к кластеризации после очищенного семантического ядра от неподходящих и «мусорных» запросов. Если этого не делать, могут быть проблемы со структурой сайта, особенно это касается интернет-магазинов и крупных сайтов (например, агрегаторы).\

Основная цель кластеризации – сделать удобный для пользователя сайт и дать релевантный ответ на запрос пользователя, показывая нужную страницу сайта.

Разбивка ключевых запросов необходима:

Для проработки будущей структуры сайта. Например, необходимо понять структуру будущего сайта компании, которая занимается полным циклом работ по котельным и котлам. Если семантическое ядро собрано с вхождениями «котельная» и «котел», то ядро будет состоять из множества кластеров, состоящих из коммерческих запросов по поиску товару («купить котел» и услуги («установка котельной цена»), информационных запросов («какой котел выбрать», «как установить котельную»), полукоммерческих или общих запросов («котел», «котельная»).

Для составления эффективной перелинковки между страницами. Например, необходимо добавить блок «Вам может быть интересно» на категорию товаров «Подгузники Huggies» в интернет-магазине. Но чтобы потенциальный покупатель не уходил сразу же с сайта, так как не нашел то, что нужно, в блок «Вам может быть интересно» добавляются те товары, которые также спрашивают в поиске и потенциально могут задержать пользователя на сайте и даже сделать покупку.

Для добавления новых страниц на сайт, которые будут приводить целевой трафик. Например, компания продает клеи для мебели, но, чтобы охватить больше трафика, необходимо создавать страницы под среднечастотные и низкочастотные запросы или более узкие запросы («клеи для мебельных щитов», «клеи для кромки»), при условии, что имеется ассортимент в этих категориях.

Что такое интент и почему он важен при кластеризации?

Интент или поисковый интент – это намерение или потребность человека, которая заключена в запросе. Интент важен в кластеризации, чтоб в кластерах не было лишних ключей, по которым страницы будут продвигаться.

Когда нужно понять интент, просто задайте вопрос: что именно ищет человек?

Пример:

Если ищут «ноутбук купить», логично предположить, что ищут ноутбуки с целью купить сейчас или в дальнейшем.

Если ищут «какой ноутбук купить», то вероятно ищут обзоры, рейтинг или инструкции по выбору ноутбука.

Если ищут просто «ноутбуки», то здесь уже не совсем ясно что нужно пользователю и необходимо анализировать выдачу.

Если ищут «ноутбуки москва», то здесь логично предположить, что ищут каталог ноутбуков с целью выбрать и приобрести сейчас или в дальнейшем.

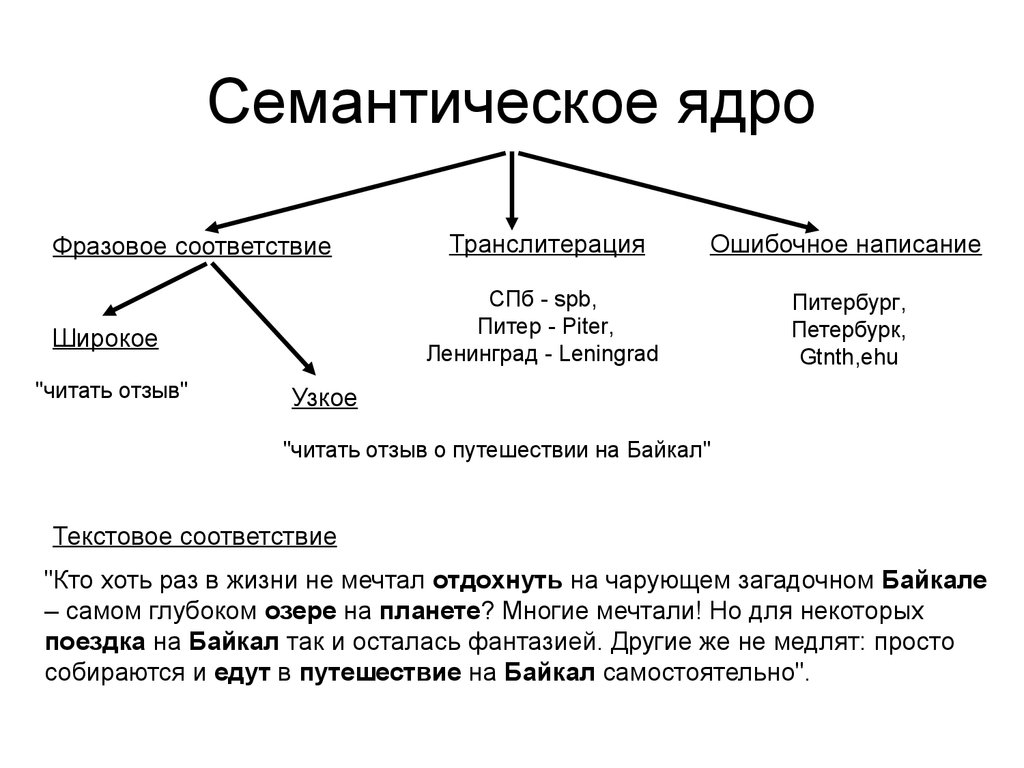

Методы разбивки запросов по кластерам

Существуют несколько методов:

По интенту запросов

Кластеризация по интенту запросов проводиться на основе того, что собственно нужно пользователю. Это можно сказать точная кластеризация, так как группировка запросов по такому методу помогает грамотно распределять запросы по существующим или будущим страницам сайта.

Нельзя продвигать информационный ключ «какой корм для собак выбрать» на странице категории кормов для собак и логично, что «корм для собак купить» не пойдет в статью, которая продвигается по ключам «как выбрать корм для собак» или «какой выбрать корм для собак». Это грубая ошибка. Поэтому важно обращать внимание при группировке на поисковый интент.

Это грубая ошибка. Поэтому важно обращать внимание при группировке на поисковый интент.

Семантическая близость (схожесть) – это тоже про интент, но сюда подключается и морфология. Например, мы собрали семантическое ядро по теме «кастрация/стерилизация собаки» и в нем находятся такие запросы:

кастрация собаки;

стерилизация собаки;

кастрировать собаку;

стерилизовать собачку.

Все они имеют один и тот же интент (собственно, это самый главный критерий, по которому нужно ориентироваться при разбивке запросов), но морфологически немного отличаются:

Если не обращать внимание на интент, то схожие морфологически фразы из списка выше будут поделены на 2 группы:

Кастрация собаки: кастрация собаки, кастрировать собаку.

Стерилизация собаки: стерилизация собаки, стерилизовать собачку.

Но если мы обратим внимание на интент, то все запросы придется отнести в одну группу. По факту это вообще 2 разные процедуры, но люди привыкли под «стерилизацией» подразумевать «кастрацию». Поэтому важно не только морфологическую связь между словами и фразами учитывать, но и интент.

По факту это вообще 2 разные процедуры, но люди привыкли под «стерилизацией» подразумевать «кастрацию». Поэтому важно не только морфологическую связь между словами и фразами учитывать, но и интент.

По выдаче ТОП-10

Кластеризация запросов проводиться на основе выдачи топ-10 и под регион, в котором собираетесь продвигать сайт. Программа или сам оптимизатор анализирует выдачу по определенным запросам и при пересечении определенного количества страниц создает для таких запросов группу (кластер).

Существуют 2 типа кластеризации по выдаче топ-10:

Soft. Все запросы сравниваются с самым высокочастотным ключом. Это не очень хорошо, так как одна группа может содержать слишком большое количество запросов, по которым нужно продвигать страницу. Подойдет для информационных проектов (сайты, содержащие только статьи), но и здесь спорно, так как многим таким проектам важно придерживаться SILO-структуры, чтоб продвигаться в поиске эффективно, а не так – зашел, прочитал статью и ушёл.

Также может подойти для коммерческих сайтов в небольших регионах, где конкуренции меньше.

Также может подойти для коммерческих сайтов в небольших регионах, где конкуренции меньше.Hard. Все запросы сравниваются с высокочастотный ключом и между собой. Хорошо тем, что на выходе получается много групп с определенным интентом. Вероятность того, что человек попадет на нужную страницу по определенной группе запросов или по одному запросу из этой группы, гораздо выше, чем при кластеризации методом Soft. Подходит для всех сайтов, особенно для сайтов с высокой конкуренцией.

Способы группировки ключевых фраз

Ручная

Ручная кластеризация – это кластеризация без помощи специальных сервисов и программ. Медленно, но качественно. Подходит для семантических ядер, которые содержат менее 100 запросов. Бесплатно. Если запросов от 500, а то и от 1000, на кластеризацию вручную уйдет неделя с лишним.

Автоматическая

Автоматическая кластеризация — это кластеризация с помощью сервисов или программ. Быстро, но приходится доделывать вручную. Подходит для семантических ядер от 100 и выше. Этот способ гораздо эффективней, чем разбирать ключи при ручном способе. Большинство сервисов и программ – платные.

Быстро, но приходится доделывать вручную. Подходит для семантических ядер от 100 и выше. Этот способ гораздо эффективней, чем разбирать ключи при ручном способе. Большинство сервисов и программ – платные.

Эффективный способ кластеризации – совмещение автоматической и ручной кластеризации. Обязательно сначала кластеризовать автоматически, а потом уже доделать кластеризацию вручную. Наоборот – нет, это пустая трата времени.

Как разбить семантическое ядро по группам?

Ручная кластеризация (с сохранением частотности)

Возьмем тему — красные фиксаторы резьбы. Нужно разделить группы, под которые будут созданы новые подразделы и страницы.

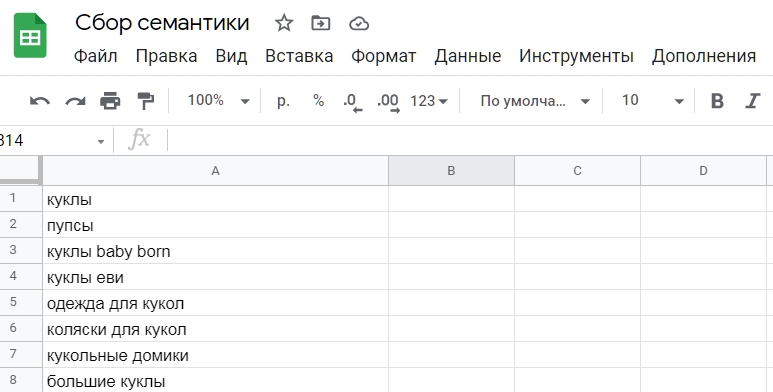

Переходите по ссылке, чтоб скачать семантическое ядро по «красным фиксаторам резьбы». Если предпочитаете работать в Google Excel, создайте копию файла и начните работать с семантическим ядром.

1. Откройте список ключевых слов в Excel. Обязательно должно быть 2 столбца – Запрос и Частотность. Остальные – по желанию и при необходимости.

Остальные – по желанию и при необходимости.

2. Начните распределять по группам. Обратите внимание на интент запроса.

Если во фразах содержится слова «купить», «цена» и не указан конкретный бренд фиксатора, значит это общие коммерческие ключевые фразы. Выносим их в отдельную группу под названием «Купить красные фиксаторы». Для этой группы будет создана страница со всеми красными фиксаторами резьбы независимо от бренда.

Если во фразах содержатся слова «купить», «цена» и указан конкретный бренд, например, «abro», значит это коммерческие ключевые фразы по определенному бренду красного фиксатора. Выносим их в отдельную группу под названием «Купить красные фиксаторы Abro». Аналогично поступаем и с другими брендами.

Если во фразах содержаться вопросительные слова «сколько сохнет», «какой выбрать», «как использовать», а также фразы или слова, которые подразумевают поиск информации, например, «инструкция по применению» (может быть также коммерческим запросом), «виды», «состав», «время высыхания», значит они попадают в группу информационных запросов, по которым пишутся статья или несколько статей.

3. Посмотрите какие запросы остались некластеризованными. Если по интенту все ясно, определяете в свою группу. Если нет, необходимо посмотреть выдачу ТОП-10 по таким запросам по определенному региону, где будет продвигаться сайт. Другой вариант – проверка коммерциализации (показывает коммерциализацию в процентах).

Если вы видите, что чаще по запросу показываются статьи, значит запрос определенно стоит отнести к информационным запросам. Если примерно 50/50, то здесь вероятно тоже стоит отнести к информационным, если запрос совсем не похож на коммерческий. Например, такая ситуация может быть с общими фразами – «красные фиксаторы», «красные резьбовые фиксаторы».

Важно! Яндекс и Google имеют разную выдачу. Google, к примеру, по запросу «красные фиксаторы резьбы» показывает в основном коммерческие страницы, а вот Яндекс – часто статьи. Ориентируйтесь по той поисковой системе, которая для вас более приоритетна в продвижении.

4. Кластеризация закончена. Приступайте к добавлению новых страниц и их оптимизации или к оптимизации уже существующих страниц.

Приступайте к добавлению новых страниц и их оптимизации или к оптимизации уже существующих страниц.

Важно! По информационным запросам требуется дополнительный сбор семантики по всей стране, если вы реально хотите написать классную подробную статью на эту тему.

Инструкция – Автоматическая кластеризация

Возьмем эту же тему — красные фиксаторы резьбы. Нужно разделить группы, под которые будут созданы новые подразделы и страницы.

Переходите по ссылке, чтоб скачать семантическое ядро по «красным фиксаторам резьбы». Если предпочитаете работать в Google Excel, создайте копию файла и начните работать с семантическим ядром.

1. Откройте список ключевых слов в Excel. Обязательно должно быть 2 столбца – Запрос и Частотность. Остальные – по желанию и при необходимости.

2. Скопируйте список запросов (без частотности) и добавьте в любой сервис автоматической кластеризации. Большинство сервисов предлагают метод Soft или Hard.

3. Выберите метод Hard и запустите проверку.

4. По завершению выгрузите в Excel и откройте файл.

5. Перенесите частотность по формуле ВПР, проверьте группы и приведите таблицу в порядок, чтоб лучше видеть структуру.

6. Посмотрите какие запросы сервис не смог кластеризовать и распределите их по группам самостоятельно. Посмотрите выдачу ТОП-10 по нужному региону или процент коммерциализации, если есть сомнения куда отнести запрос.

7. Кластеризация закончена. Приступайте к добавлению новых страниц и их оптимизации или доработки существующих.

Резюме

Кластеризация – важный этап в поисковом продвижении.

Доступна ручная, автоматическая и комбинированная кластеризация запросов.(автоматическая + ручная).

Группировать запросы можно по выдаче ТОП-10, по интенту и семантической близости. По выдаче ТОП-10 доступны Soft- и Hard-метод.

Кластеризовать запросы может кто угодно: SEO-специалист, владелец сайта, интернет-маркетолог, специалист по контекстной рекламе и другие.

Главное, понимать принципы.

Главное, понимать принципы.Доверять кластеризацию лучше SEO-специалисту, так как именно этому человеку продумывать структуру сайта и продвигать ваш сайт в поиске.

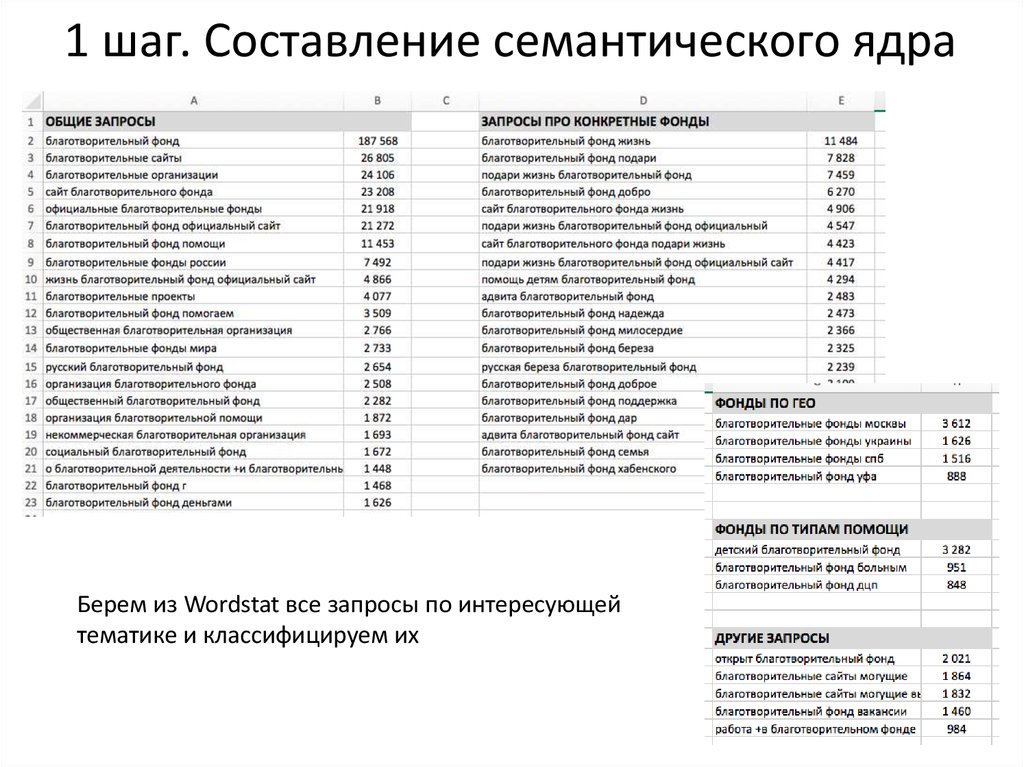

✅ Семантическое ядро ЗДЕСЬ!

Этот сайт посвящен составлению семантических ядер и ниже написано что это такое. Здесь вы можете заказать семантическое ядро, а здесь задать интересующий вопрос.

Содержание:

- Как выглядит семантическое ядро?

- Ключевые слова – основа для продвижения

- Что дает семантическое ядро заказчику?

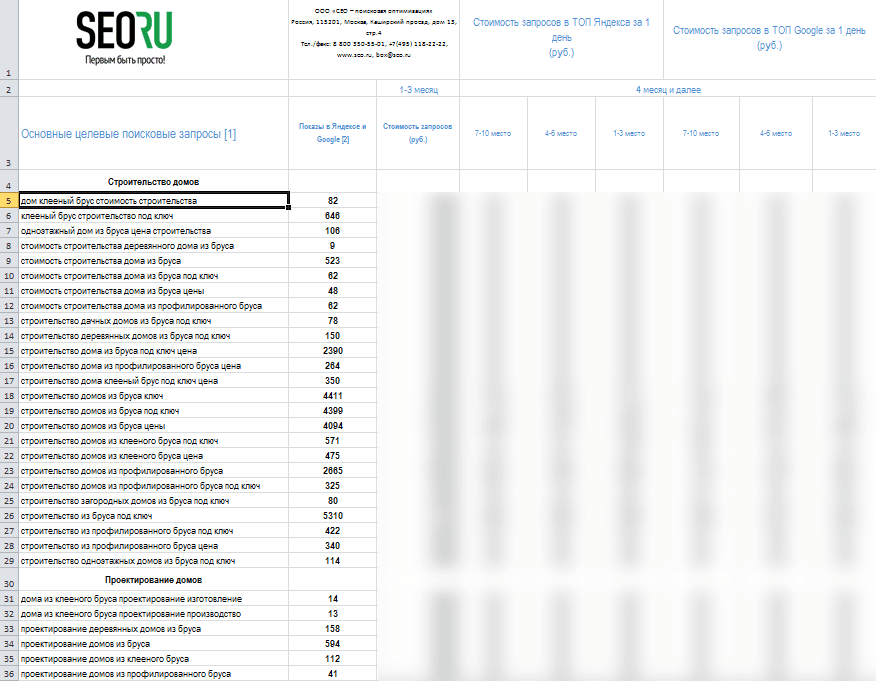

- Пример готового семантического ядра

- Как использовать собранное семантическое ядро?

- Применение ключевых слов конкурентов в своей контекстной рекламе

Семантическое ядро – набор ключевых слов и словосочетаний, которые наиболее релевантны тематике сайта или статье, в которых они используются. По своей сути — это запросы людей в поисковых системах, которые правильно сгруппированы в кластеры семантического ядра, которое, в свою очередь является базой для построения структуры сайта.

Семантическое ядро состоит из высокочастотных ключевых слов, среднечастотных и низкочастотных, иногда включают микронизкочастотные запросы.

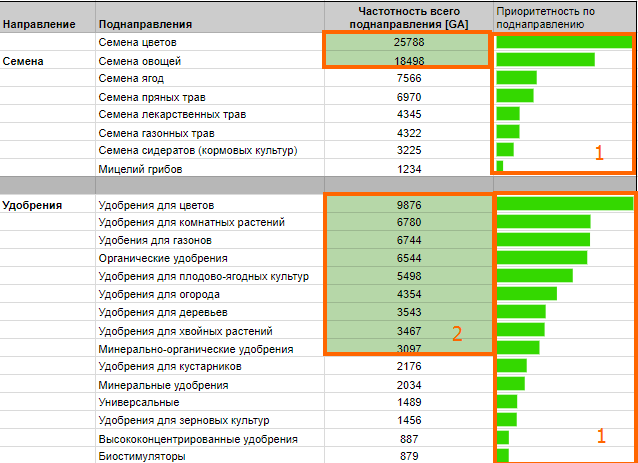

Как выглядит семантическое ядро?

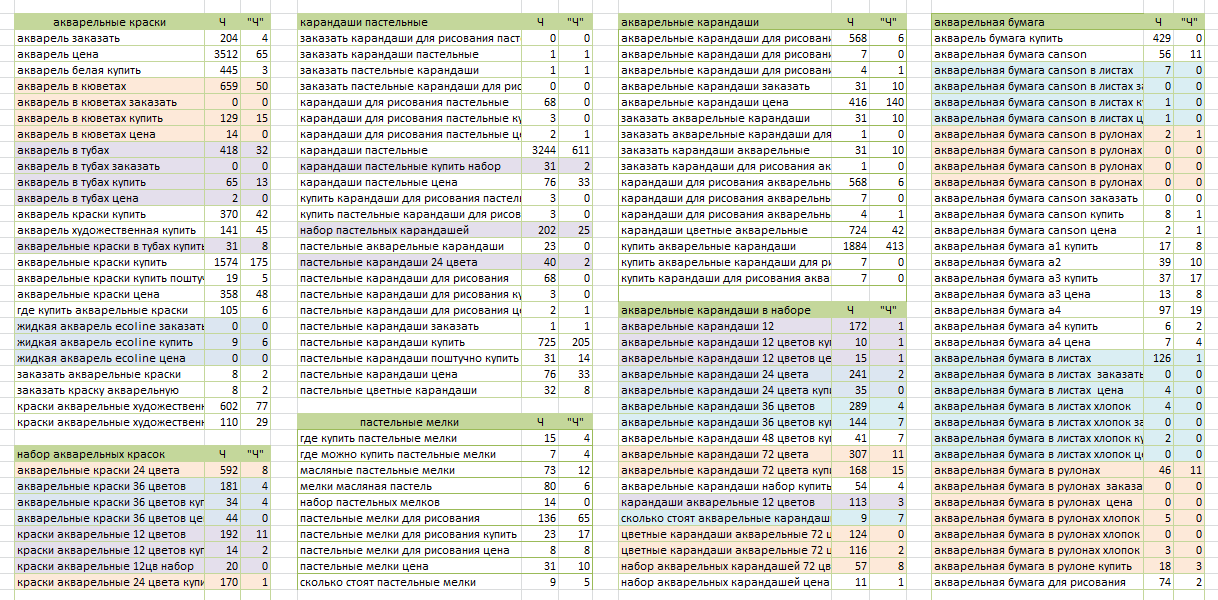

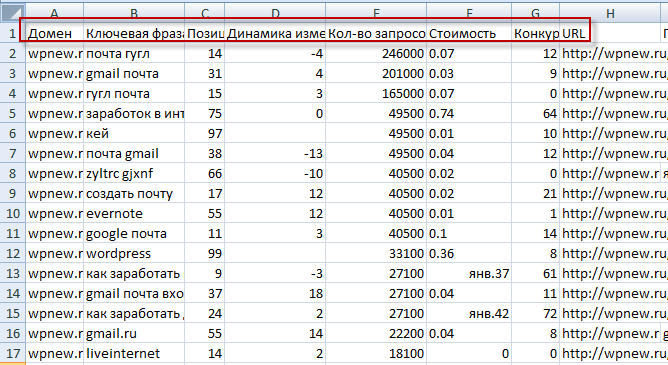

Выглядит оно как как файл Excel (обычно), в этом файле собраны ваши ключевые слова, которые сгруппированы (кластеризованы), у каждого слова есть своя частотность (базовая, фразовая, точная), + добавлены различные значения из Яндекс Директа, Google ADW, показатели KEI (конкуренция), другие показатели.

★ Примеры изображений семантического ядра ЗДЕСЬ

★ Скачать XLS файл пример

Ключевые слова — основа для продвижения

Сейчас наблюдаем следующие тенденции:

- основные механизмы поискового продвижения всем известны и практически исчерпаны,

- множество молодых сео оптимизаторов – специалисты с небольшим опытом,

- грамотных SEO специалистов надо целенаправленно искать, ведь кто из знакомых даст вам золотой номер телефона? А вдруг этот специалист будет меньше уделять времени ЕГО сайту?

Вывод: с каждым годом остается все меньше уникальных инструментов для продвижения сайтов и маркетинга. Только большие компании, с огромными бюджетами могут позволить себе огромные расходы на рекламу и качественное продвижение.

Только большие компании, с огромными бюджетами могут позволить себе огромные расходы на рекламу и качественное продвижение.

НО, все-таки, – семантика держится особняком, вопрос качественного сбора семантического ядра сайта полностью не закрыт и являет собой одну из немногих ниш, в которой есть не так уж много специалистов . Особенно в вопросе качества. А если и есть заявления о включении семантического ядра в структуру работ, то зачастую – это всего лишь сбор нескольких десятков слов и фраз вручную из Яндекс.Вордстат – не более.

Что дает семантическое ядро заказчику?

Само по себе семантическое ядро – лишь Excel файл с информацией. А вот содержащаяся в нем информация дает понимание – что делать и как делать. Не умозрительное понимание, а подтвержденное исследованием, каждый шаг которого можно отследить и проверить.

Для чего нужно СЯ по пунктам:

- Доработка сайтов уже существующего бизнеса,

- Анализ ниши, в которую вы предполагаете зайти,

- Планирование бюджета на рекламу, оптимизация рекламы.

Семантическое ядро по своей сути является картой, на которой видны пути развития вашего бизнеса или пути его создания. Главное – уделить ей время и изучить, я думаю, что те, кому важно развитие своего бизнеса сделают это во всей внимательностью. Особенное внимание надо уделять показателям частотности и конкуренции, но об этом написано несколько далее, а пока про использование и внедрение семантических ядер.

Правильно внедренное в проект семантическое ядро дает: гарантированный ТОП 10. Внедренное в рекламную кампанию это же ядро дает экономию рекламного бюджета: min от 10% и max до 70%.

*Небольшая ремарка – экономия 70% на контекстной рекламе это не предел, бывают и более поразительные результаты.

Пример готового семантического ядра

В данном примере показаны изображения семантического ядра,

собранного для адвоката, работающего в Москве, частотность собрана за месяц,

выгружены данные из Яндекс.Директа, собраны данные о конкуренции (KEI), рассчитаны уровни

конкуренции по формулам KEI.

Файл XLS Семантическое ядро (Пример)

В собранном семантическом ядре выявлены ключевые фразы с минимальной конкуренцией в РСЯ. Ключевые фразы были внедрены в РСЯ. По имеющейся информации сейчас заказчик семантического ядра – не справляется с объемами поступающих заявок и вынужден передавать заказы коллегам.

Заявка на сбор семантического ядра

Качество семантического ядра – это залог успеха

Исходя из написанного выше – остро стоит вопрос качественного сбора ядра и его проработки для каждого бизнеса. Именно от качества семантического ядра сайта зависит релевантная структура сайта, релевантность текстов, эффективность рекламы… А если в целом — перспективы бизнеса, которые вытекают из дальнейшей проработки и продвижения сайта.

И не только для продвижения – актуален так же вопрос составления качественной, таргетированой и экономной рекламной кампании, которая не жрет деньги с отдачей в 1%.

Поэтому заказать сбор ядра сайта нужно у специалистов. Заказать семантическое ядро можно и у нас. Качество и соответствие срокам исполнения гарантируем.

Размер семантического ядра

Размер семантического ядра зависит от ниши, для которой формируется. Чем больше и обширнее ниша или ассортимент оказываемых услуг / продаваемых товаров – тем больше и семантическое ядро.

Чем правильнее и полнее сформировано ядро сайта — тем больше работы у копирайтеров и разработчиков тем лучше перспективы развития сайта, больший охват аудитории и, следовательно – больше целевого трафика из органической выдачи.

Например, для крупных порталов, таких как Wildberries, DNS и других подобных крупных площадок СЯ может состоять из нескольких сотен тысяч или даже нескольких миллионов ключевых слов, а для среднего интернет-магазина обычно достаточно нескольких тысяч или десятков тысяч фраз. Тут все зависит от самой тематики и масштаба поиска.

Считаю, что важно упомянуть так же и уникальные узкоспециализированные ниши.

Случай из нашей работы: Поступил заказ от небольшой компании на составление семантического ядра по их тематике, она не часто встречается, настолько не часто, что мы первый раз об этом слышали за всю свою жизнь! Начали собирать ядро, парсить слова, искать по сервисам (естественно платным)… а слов нет! Ну нет и все, никто таких слов в поиске не набирает! Что мы делаем – генерируем в Excel порядка 100.000 тематических и околотематических слов и словоформ на основании ТЗ заказчика и смотрим частотность этих ключей. Получаем около 200 тематических фраз с частотностью более 10, уже есть успех!)) В итоге заказ был выполнен – большими стараниями удалось найти целевых 1000 слов (примерно столько и оговаривалось) с приемлемой частотностью. В таких случаях мы берем в расчет и информационные запросы тоже.

Как использовать собранное семантическое ядро?

Теперь подробнее о применении СЯ. Семантическое ядро показывает ПЕРСПЕКТИВНОСТЬ ПУТЕЙ РАЗВИТИЯ и ПРОДВИЖЕНИЯ сайта, ВЫГОДНОСТЬ рекламной кампании. По большому счету от этих данных зависит эффективность и прибыльность вашего сайта или рекламы.

Семантическое ядро показывает ПЕРСПЕКТИВНОСТЬ ПУТЕЙ РАЗВИТИЯ и ПРОДВИЖЕНИЯ сайта, ВЫГОДНОСТЬ рекламной кампании. По большому счету от этих данных зависит эффективность и прибыльность вашего сайта или рекламы.

Далее будут рассмотрены варианты использования семантического ядра:

- Использование для оптимизации и продвижения сайта,

- Использование для контекстной рекламы,

- Комбинированное использование.

Использование семантического ядра для продвижения и оптимизации сайта

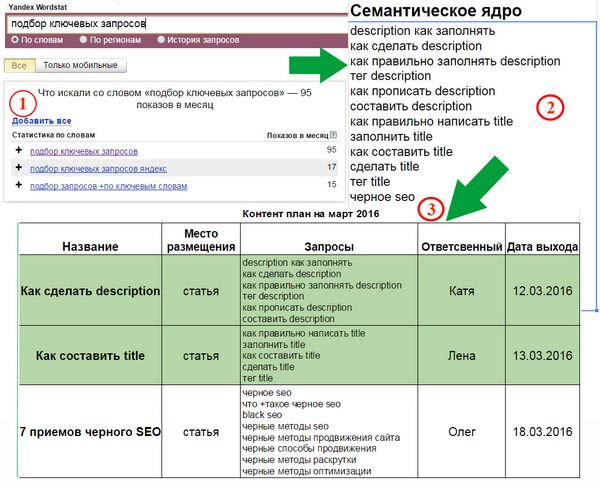

Семантическое ядро для продвиженияПравильно составленное ядро сайта – это кластеризованные (*сгруппированные) по определенным методикам целевые слова и фразы людей, эти ключевые слова, по сути, — должны быть основой для формирования или доработки структуры сайта, для создания релевантного контента сайта, для понимания интента (интент это запрос людей – т.е. чего они хотят на самом деле).

На основе сем. ядра готовятся исходные данные (ТЗ) для

подготовки материала (статей) или формирования рекламных кампаний.

Анализ ключевых слов:

- по частотности,

- по гео зависимости,

- по сезонности запросов,

- по релевантности,

- уровню конкуренции (показатели и формулы KEI),

- более детальное разделение на коммерческие запросы и информационные,

- выясняется конкуренция ключевых слов,

- позиции сайта по запросам.

Внедрение семантического ядра для продвижения:

- пишутся статьи, проспекты, презентации,

- или наоборот – не пишутся (либо пишутся, но чисто символически), это в случае огромной конкуренции (на основе анализа), когда просто не выгодно тратить ресурсы,

- соответствующим образом оформляются карточки товаров,

- дорабатывается структура сайта,

- удаляются или дорабатываются нерелевантные тексты,

- другие работы.

Преимущества и недостатки продвижения сайта на основе семантического ядра

+ Преимущества: в результате получаете бесплатный трафик из

поисковых систем, все затраты полностью окупаются, количество заявок растет в

разы.

— Недостатки: долго, дорого, требуется взаимодействие со специалистами, которые будут проводить работы.

Использование семантического ядра в рекламной кампании

Cемантическое ядро в рекламной кампанииВ какой именно рекламной системе – не важно. В Яндекс.Директ, GoogleADS или других – не имеет большого значения т.к. правильное СЯ имеет собранные ключевые слова из всех основных поисковых систем. Итак, на основе анализа семантического ядра вы выбираете по каким словам рекламироваться, по каким не рекламироваться, где установить ставки побольше, где поменьше.

Анализ ключевых слов для контекста (Яндекс.Директ)

- оцениваем количество объявлений конкурентов по каждой фразе,

- оцениваем Среднюю стоимость клика (CPC), прогнозный бюджет,

- оцениваем кликабельность (CTR) количество показов и переходов.

Все эти данные будут выгружены в отчете.

Настройка РСЯ на основе полученных ключевых слов:

- добавляются в кампанию ключевые слова, которые ранее не были охвачены,

- удаляются не выгодные слова – на основании большой конкуренции,

- добавляются информационные ключевые запросы по минимальным ставкам,

- другие работы по настройке рекламы.

Преимущества и недостатки создания рекламной кампании на основе семантического ядра

+ Преимущества: сразу получаете целевой трафик из поисковых систем и соответственно выручку.

— Недостатки: 1) за рекламу, хоть и меньше, но все-таки надо платить, 2) ваш портал не развивается или развивается вслепую наощупь.

Комбинированное использование семантического ядра для рекламной кампании и для продвижения

На наш взгляд это наиболее правильная стратегия для работающего сайта, пока одни сотрудники приводят сайт в порядок – ваша реклама уже работает, требует и помогает окупать оплату услуг оптимизаторов и копирайтеров.

Применение ключевых слов конкурентов в своей контекстной рекламе

Запросы конкурентов как источник ключейМногие владельцы сайтов выбирают короткий путь получения ключевых слов для своего бизнеса. Вместо сбора полноценного семантического ядра – просто ищут ключевые слова конкурентов и не глядя, без анализа добавляют их в свою рекламную кампанию.

Во-первых – всех его слов, полностью, вы не получите, максимум – его же слова из контекстной рекламы. Возможно (есть минимальный шанс), что там будут низко конкурентные слова, где только вы и он будут конкурентами, но как показывает практика – такой подход приносит минимальную выгоду и, в принципе, с большой натяжкой сгодится на начальном этапе. При этом не забывайте – никакой речи об экономной рекламной кампании здесь не идет вообще.

Во-вторых – вы не развиваете свой сайт, просто получаете список его слов, без анализа, без данных о конкуренции, без структуры.

Вы скажете: «А что, если я выгружу слова у 10 или 20 конкурентов?» Теоретически идея имеет право на существование, но при одном условии: вы соберете частотность слов, получите аналитические данные об этих словах из поисковой системы, тогда, анализируя это самостоятельно вы, возможно, сможете выявить несколько относительно выгодных слов. И не забывайте, что другие могут делать тоже самое.

Заказать семантическое ядро

Как собрать семантическое ядро сайта в excel

Как составить семантическое ядро сайта

Часть 2 (практика)

В первой части нашей статьи мы рассказали, что такое семантическое ядро и дали общие рекомендации о том, как его составить.

Пришло время разобрать этот процесс в деталях, шаг за шагом создавая семантическое ядро для вашего сайта. Запаситесь карандашами и бумагой, а главное временем. И присоединяйтесь …

Составляем семантическое ядро для сайта

Сфера деятельности компании: складские услуги в Москве.

Сайт был разработан специалистами нашего сервиса 1PS.RU, и семантическое ядро сайта разрабатывалось поэтапно в 6 шагов:

Шаг 1. Составляем первичный список ключевых слов.

Проведя опрос нескольких потенциальных клиентов, изучив три сайта, близких нам по тематике и пораскинув собственными мозгами, мы составили несложный список ключевых слов, которые на наш взгляд отображают содержание нашего сайта: складской комплекс, аренда склада, услуги по хранению, логистика, аренда складских помещений, тёплые и холодные склады.

Задание 1: Просмотрите сайты конкурентов, посоветуйтесь с коллегами, проведите «мозговой штурм» и запишите все слова, которые, по вашему мнению, описывают ВАШ сайт.

Шаг 2. Расширение списка.

Воспользуемся сервисом http://wordstat.yandex.ru/. В строку поиска вписываем поочерёдно каждое из слов первичного списка:

Копируем уточнённые запросы из левого столбца в таблицу Excel, просматриваем ассоциативные запросы из правого столбца, выбираем среди них релевантные нашему сайту, так же заносим в таблицу.

Проведя анализ фразы «Аренда склада», мы получили список из 474 уточнённых и 2 ассоциативных запросов.

Проведя аналогичный анализ остальных слов из первичного списка, мы получили в общей сложности 4 698 уточнённых и ассоциативных запросов, которые вводили реальные пользователи в прошедшем месяце.

Задание 2: Соберите полный список запросов своего сайта, прогнав каждое из слов своего первичного списка через статистику запросов Яндекс. Вордстат.

Вордстат.

Шаг 3. Зачистка

Во-первых, убираем все фразы с частотой показов ниже 50: «сколько стоит аренда склада» — 45 показов, «Аренда склада 200 м» — 35 показов и т.д.

Во-вторых, удаляем фразы, не имеющие отношения к нашему сайту, например, «Аренда склада в Санкт-Петербурге» или «Аренда склада в Екатеринбурге», так как наш склад находится в Москве.

Так же лишней будет фраза «договор аренды склада скачать» – данный образец может присутствовать на нашем сайте, но активно продвигаться по данному запросу нет смысла, так как, человек, который ищет образец договора, вряд ли станет клиентом. Скорее всего, он уже нашёл склад или сам является владельцем склада.

После того, как вы уберетё все лишние запросы, список значительно сократится. В нашем случае с «арендой склада» из 474 уточнённых запросов осталось 46 релевантных сайту.

А когда мы почистили полный список уточнённых запросов (4 698 фраз), то получили Семантическое Ядро сайта, состоящее из 174 ключевых запросов.

Задание 3: Почистите созданный ранее список уточнённых запросов, исключив из него низкочастоники с количеством показов меньше 50 и фразы, не относящиеся к вашему сайту.

Шаг 4. Доработка

Поскольку на каждой странице можно использовать 3-5 различных ключевиков, то все 174 запроса нам не понадобятся.

Учитывая, что сам сайт небольшой (максимум 4 страницы), то из полного списка выбираем 20, которые на наш взгляд наиболее точно описывают услуги компании.

Вот они: аренда склада в Москве, аренда складских помещений, склад и логистика, таможенные услуги, склад ответственного хранения, логистика складская, логистические услуги, офис и склад аренда, ответственное хранение грузов и так далее….

Среди этих ключевых фраз есть низкочастотные, среднечастотные и высокочастотные запросы.

Заметьте, данный список существенно отличается от первичного, взятого из головы. И он однозначно более точен и эффективен.

Задание 4: Сократите список оставшихся слов до 50, оставив только те, которые по вашему опыту и мнению, наиболее оптимальны для вашего сайта. Не забудьте, что финальный список должен содержать запросы различной частоты.

Не забудьте, что финальный список должен содержать запросы различной частоты.

Заключение

Ваше семантическое ядро готово, теперь самое время применить его на практике:

- пересмотрите тексты вашего сайта, быть может, их стоит переписать.

- напишите несколько статей по вашей тематике, используя выбранные ключевые фразы, разместите статьи на сайте, а после того, как поисковики проиндексируют их, проведите регистрацию в каталогах статей. Читайте «Один необычный подход к статейному продвижению».

- обратите внимание на поисковую рекламу. Теперь, когда у вас есть семантическое ядро, эффект от рекламы будет значительно выше.

Как собрать семантическое ядро сайта в excel

Данный метод сбора семантического ядра актуален для небольших и средних интернет-магазинов. Он позволяет сократить время на подбор ключевых фраз и получить достаточно качественное семантическое ядро. Разберем суть метода на примере.

Допустим, ваш магазин продает три группы товаров: матрасы, подушки и одеяла. Необходимо подобрать список запросов для продвижения раздела каталога с каждой группой товаров. Для этого нам нужно сгенерировать семантическое ядро, состоящее из запросов вида:

Необходимо подобрать список запросов для продвижения раздела каталога с каждой группой товаров. Для этого нам нужно сгенерировать семантическое ядро, состоящее из запросов вида:

[ товарная категория ] + [ дополнительное продающее слово ]

Примеры продающих слов: купить, продажа, недорого, дешево, цена, стоимость, прайс. Соответственно, запросы для продвижения товарной категории «матрасы» будет выглядеть следующим образом:

матрасы купить

матрасы продажа

матрасы недорого

матрасы дешево

матрасы цена

матрасы стоимость

матрасы прайс

Что делать, если товарных категорий и товаров много, и вручную набивать все запросы будет долго? Воспользуемся файлом Excel, чтобы сгенерировать семантическое ядро в полуавтоматическом режиме.

Как пользоваться генератором

Файл состоит из листов. На листе «Вся семантика» автоматически собирается информация с других листов. Листы с номерами (от 1 до 5 в примере) обозначают отдельные страницы на сайте. Чтобы сгенерировать семантическое ядро для конкретной страницы, необходимо открыть пустой лист и в столбце А добавить название товара или товарной категории. В примере ниже таким словом является «одеяло»:

Чтобы сгенерировать семантическое ядро для конкретной страницы, необходимо открыть пустой лист и в столбце А добавить название товара или товарной категории. В примере ниже таким словом является «одеяло»:

В столбце С автоматически сформировалось семантическое ядро для страницы, а на листе «Вся семантика» скопировались данные из листа с примером:

Таким образом, вводя на страницах с номерами название товаров или товарных категорий, вы сможете сгенерировать семантику для всех страниц интернет-магазина.

Далее вам останется скопировать список запросов, который автоматически соберется на странице «Вся семантика», и при помощи специализированных программ или инструментов в https://direct.yandex.ru проверить список запросов на наличие «пустых» – после чего сформировать финальное семантическое ядро для продвижения интернет-магазина.

В файлике в примере есть 5 страниц для генерации семантики для конкретных страниц. При желании можно сделать файл на любое количество страниц, формулы в примере все открыты.

Как собрать семантическое ядро в Вордстат Яндекса

Без применения специализированных программ

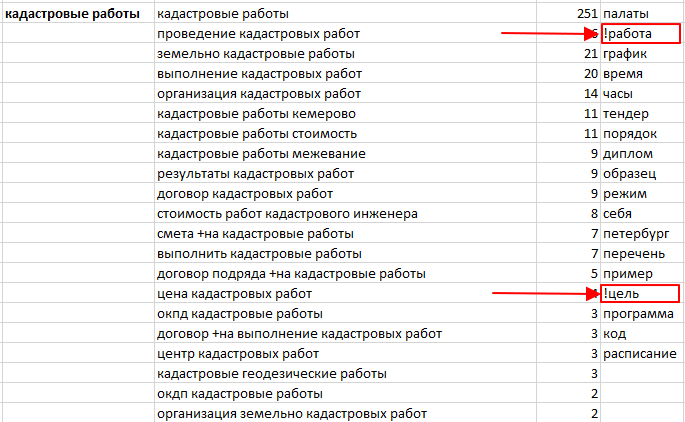

Рассмотрим этапы формирования семантического ядра на основе сервиса Яндекс Вордстат (как им пользоваться). Будем использовать ручной метод сбора, который трудозатратен, при постоянной работе с семантикой целесообразно пользоваться профессиональными программами. Для понимания процессов разберем вариант сбора и обработки фраз без специлизированного софта и сервисов.

Возьмем направление «рольставни» для компании, которая занимается установкой защитных конструкций и их обслуживанием по Москве и области. В первую очередь актуальны запросы, которые формулируют люди, заинтересованные в покупке таких изделий или у которых возникли проблемы с эксплуатацией. Вводим маску в строку подбора, выбираем регион, например, Москва и область:

В колонке слева Wordstat показывает запросы пользователей, которые набирали со словом «рольставни». В правой колонке дополнительные запросы. Ориентируйтесь на левую колонку, скопируйте фразы и частоту в таблицу. Переходите по пагинации снизу на следующие странице и скопируйте предлагаемые варианты фраз.

Ориентируйтесь на левую колонку, скопируйте фразы и частоту в таблицу. Переходите по пагинации снизу на следующие странице и скопируйте предлагаемые варианты фраз.

Вордстат даёт 2000 запросов по одному направлению. На одной странице показывается 50 фраз, получается 20 страниц нужно пролистать. Для примера я собрал первые 350 фраз, получилась таблица:

Скачать файл Эксель-исходник

Группировка (кластеризация) запросов в семантическом ядре

После сбора запросов, группируем (кластеризируем). Для этого используют 3 вида кластеризации:

- по смыслу;

- по SERP;

- смешанный.

Разбивка «По смыслу» предполагает, что из запросов выделяется основной посыл, что хочет получить человек. В собранном перечне запросы делятся так:

- рольставни +в туалет

- рольставни +на окна

- сантехнические рольставни

- рольставни +в туалет купить

- рольставни +в санузел

- рольставни наружные

- рольставни +в туалет москва

- сантехнические рольставни +в туалет

- рольставни +на окна наружные

- рольставни +в туалет купить москва

- прозрачные рольставни

- рольставни сантехнические купить

- рольставни +в туалет цена

- рольставни +на окна цена

- рольставни +в санузел москва

- прозрачные рольставни +для веранды

Туалет: 1, 3, 4, 5, 7, 8, 10, 12, 13, 15. Так как санузел, туалет и сантехнический предполагает один вид помещения для установки.

Так как санузел, туалет и сантехнический предполагает один вид помещения для установки.

Окна: 2, 6, 9, 14. Установка на окна предполагает, что рольставни буду наружными (запрос №6).

Прозрачные: 11, 16.

Кластеризация по «SERP» предполагает использование специализированной программы или сервиса (например, keyassort.ru). Получается, что это автоматизированный процесс. SERP – это результат поисковой выдачи, проще говоря ТОП-10. Алгоритм действий здесь такой:

- Выбранные фразы добавляются в программу.

- По каждому запросу программа проверяет ТОП-10 или ТОП-20 в Яндекс (Гугл) и сохраняет результат в таблице.

- Далее программа анализирует сохраненные данные и соотносит страницы в выдаче и фразы. И запросы, по которым встречаются одни и те же страницы сайтов в выдаче, объединяет в одну группу.

Такой способ кластеризации подходит для многотысячной семантики и экономит время. По опыту студии, в результате разбивки качество получаемых ядер низкое и требует корректировок.

Смешанный метод – «SERP» и здравый смысл. Применение двух способов одновременно. Случается, что разбив ядро по смыслу, остаются фразы, назначение которых спорно и их сложно объединить в группы. В этом случае снимается СЕРП и на основе анализа разбиваются фразы.

Популярный вопрос «сколько фраз должно быть в одном кластере?». Ограничений нет, от одного запроса до нескольких сотен. Студия DIUS ведет проекты, где одна страница ранжируется по 200-300 запросам. Бывает наоборот, что первоначально добавили в кластер 100 запросов, но при оптимизации зашли только 50. Тогда детально и подробно изучаем оставшиеся фразы, делим по дополнительным признакам и создаем под них новые разделы или оптимизируем другие страницы.

Но такой подход требует опыта, т.к. поисковики негативно относятся, когда под похожие запросы создаются две страницы. В этом случае понижаются позиции по обеим страницам. В этом случае, внимательно изучайте конкурентов в выдаче, возможно на одну страницу следует добавить вхождений.

Для группировки ядра по направлению «Рольставни» воспользуемся методом «По смыслу», т.к. фраз всего 350 и группировка не займет много времени.

Делим фразы по: типу продукции, назначению, параметрам (цвет, материал) и т.д. И также нужно будет отбросить ненужные фразы, назовем эту группу «мусор». В неё попадают нецелевые фразы, которые содержат слова:

- леруа мерлен;

- своими руками;

- фото и видео;

- города не из Московской области;

- бу, схемы, инструкции.

Просмотрев и задав кластер для каждого запроса, получаются следующие группы:

Из 350 подобранных фраз получилось 85 мусорных, остальные распределились на 36 групп по типам и назначению изделия. В первой колонке группа, во второй сколько содержит слов из 350 подобранных:

| Группа | Количество фраз |

| основная | 63 |

| туалет | 61 |

| область | 35 |

| на окна | 28 |

| гараж | 7 |

| прозрачные | 6 |

| монтаж | 5 |

| электропривод | 5 |

| ремонт | 4 |

| шкаф | 4 |

| фотопечать | 4 |

| ванная | 3 |

| дача | 3 |

| комната | 3 |

| дверь | 3 |

| терраса | 2 |

| алютех | 2 |

| балкон | 2 |

| дорхан | 2 |

| перфорированные | 2 |

| торговые | 2 |

| встроенные | 2 |

| веранда | 2 |

| беседка | 2 |

| двери | 1 |

| проем | 1 |

| внутренние | 1 |

| управление | 1 |

| поликарбонат | 1 |

| защитные | 1 |

| мебельные | 1 |

| антивандальные | 1 |

| паркинг | 1 |

| противопожарные | 1 |

| стеклянные | 1 |

| квартира | 1 |

| утепленные | 1 |

| мусор | 85 |

Полученные кластеры в свою очередь группируем по смыслу и получаем структуру сайта для оптимизации:

- Рольставни:

- Вид: прозрачные, поликарбонат, перфорированные, противопожарные, и т.

д.

д. - Назначение: окна, двери, квартира, проем, торговые, мебельные, туалет, гараж, паркинг и т.д.

- Профиль: алютех, дорхан.

- Опции: с электроприводом, с фотопечатью.

- Вид: прозрачные, поликарбонат, перфорированные, противопожарные, и т.

- Сервис

- Ремонт

- Монтаж

Из 2000 фраз, которые выдает Вордстат по заданному слову, получится составить структуру сайт гораздо шире, чем приведенная в примере. Естественно ориентируйтесь на ключевики, которые характеризуют продукцию или услуги компании. Если какой-то тип продукции или услуг компания не производит отправляйте их в раздел «мусор».

Расширение семантического ядра в Wordstat

Как подсказывает вордстат на скрине выше, некоторые называют рольставни другим словом – «роллеты». Поэтому для расширения ядра получения дополнительных фраз по ним также собираются фразы:

И:

Эти фразы добавляются в созданные группы или по ним создаются новые. Поисковики понимают, что «рольставни» и «роллеты» — это одно и тоже, поэтому совмещайте их в одних целевых кластерах.

Расширение ядра при помощи поисковых подсказок Yandex.ru

Дополнительным способом расширения семантики используют такой метод как «поисковые подсказки». Когда пользователь Яндекса вводит запрос в строку, поисковик предлагает варианты, исходя из статистики популярных запросов, дополняющие слова:

Видно, что на запрос «рольставни» поисковик предлагает запросы, которые уже были отобраны из сервиса Вордстат. Ориентируйтесь на фразы из 3-4 слов:

Тогда получится дополнить ядро. Вручную собирать подсказки трудозатратно, для этого целесообразно использовать профессиональные программы по сбору семантики или сервисы. РашАналитикс помогает собирать подсказки. На сервисе предусмотрена бесплатная регистрация, и сразу даётся 200 баллов.

Для сбора добавьте фразы из 3-4 слов из семантического ядра. Задайте популярные мусорные слова, чтобы сервис автоматически из убрал из результатов: своими руками, бу, леруа мерлен. В результате получаем такие дополнительные слова из подсказок:

Полученные фразы чистим от мусорных и проверяем частоту через Вордстат:

Сколько запросов собирать в ядро

По сути ограничений нет, чем больше фраз подобрано в семантическое ядро, тем лучше будет проработан сайт с точки зрения структуры и содержания. Отталкиваясь от групп запросов оптимизатор формирует не только разделы, но и планирует контент. Посмотрим на 28 запросов в группе «Рольставни на окна»:

Отталкиваясь от групп запросов оптимизатор формирует не только разделы, но и планирует контент. Посмотрим на 28 запросов в группе «Рольставни на окна»:

Ясно, что посетителей интересует:

- Цена такой конструкции.

- Варианты исполнения: с электроприводом или механические.

- Материалы изготовления: тканевые, металлические.

- Как устанавливают изделие.

- Для каких окон: квартиры, дачи, частный дом.

- Дополнительные функциональные свойства: защитные, антивандальные и т.д.

Каждый запрос в группе – это единица смысла, которую нужно отразить на созданной странице. Во-первых, это позволит употребить ключевые слова, что сделает сайт релевантным этому кластеру. Во-вторых, на странице будет опубликована полезная для посетителя информация.

Очистка семантики от мусора

При сборе многотысячного семантического ядра в список попадёт много нецелевых фраз:

- Тип продукции или схожий вид услуг, которыми компания не занимается.

В случае с рольставнями, это материалы, из которых компания не производит изделия, либо дополнительные услуги – обслуживание, доставка, установка.

В случае с рольставнями, это материалы, из которых компания не производит изделия, либо дополнительные услуги – обслуживание, доставка, установка. - В запросах часто появляются названия фирм конкурентов, когда пользователь пишет товар или услугу, и указывает название компании.

- У людей, проживающих в Москве и имеющих коттедж в другом регионе, например, Твери, отразится это в запросах, когда они будут заказывать рольставни, ворота и т.д. Указывая город в сервисе, вы задаете географию пользователей, интересы которых могут лежать за пределами этого региона.

- Также убирайте из ядра ошибочные написания и опечатки. Если раньше под такие запросы создавались страницы, то сейчас поисковые алгоритмы обнаружив опечатку исправляют её и выдача формируется по корректной словоформе. И если появятся новые ошибки в названиях, это значит, что в ближайшее время алгоритм это учтет.

От нецелевых запросов следует избавляться по следующим причинам:

- Если пользователь зайдет на сайт и обнаружит, что компания из другого региона – он закроет страницу.

Это сказывается на поведенческих характеристиках сайта, в результате поисковик понизит в выдаче и по другим запросам, которые будут целевыми.

Это сказывается на поведенческих характеристиках сайта, в результате поисковик понизит в выдаче и по другим запросам, которые будут целевыми. - Также это расценивается алгоритмами как поисковый спам, когда компания привлекает посетителей по запросам, задачи по которым она не решает.

- По некоторым запросам, типа «рейтинг компаний по рольставням», поисковики показывают сайты справочники, бизнес-каталоги, агрегаторы. По таким фразам не добраться до ТОП-10, если только не делать каталог организаций. Убрав их из ядра оптимизатор экономит время и ресурсы.

Как разбить семантическое ядро по типу запросов

Также стоит учесть разделение запросов по интенту пользователя:

- информационные;

- коммерческие.

Подробнее об этом в материале блога.

Для коммерческих запросов создаются разделы услуг, на которых предлагаются к продаже услуги и товары. Они называются коммерческими, т.к. предполагают, что у пользователя, при запросе прямое намерение купить или заказать продукцию, представленную на сайте. В таких запросах непосредственное название продукции или бренда, а также слова: купить, цена, заказать и т.п.

В таких запросах непосредственное название продукции или бренда, а также слова: купить, цена, заказать и т.п.

Информационные запросы подразумевают, что пользователь хочет получить сведения о пользовании продукцией, инструкций и т.п. В таких запросах часто фигурируют вопросы: как, какой, зачем, что лучше, почему и т.д. Для таких групп создается раздел статей на сайте, который отвечают на популярные вопросы людей перед покупкой, например, по рольставняим: как выбрать, какой профиль лучше и т.д. Формируется дополнительное ядро запросов для написания полезных материалов. Его собирают из Вордстат, добавив к фразе конструкцию «+как»:

Также с «+где», «+когда» и т.д.

При этом информационные запросы геонезависимые, поэтому регион ставьте Россия. Грамотное использование инфозапросов даёт целевые переходы из поисковиков, которые также конвертятся в обращения и покупки. Для этого используйте «Лестницу Бена Ханта» — подробней в статье.

Предлагаем создание

семантического ядра для сайта

Узнать стоимость

Что делать с семантическим ядром после составления

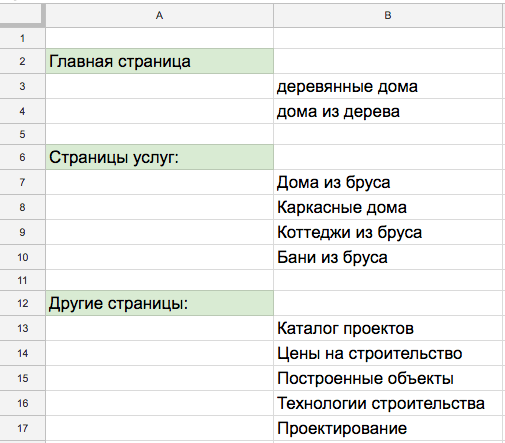

Итак, семантика собрана, разбита на группы. Приступаем к завершающему и целевому действию – разработка структуры сайта и планирование содержания страниц.

Приступаем к завершающему и целевому действию – разработка структуры сайта и планирование содержания страниц.

Сначала еще раз посмотрите каждую группу, проверьте на соответствие ассортименту компании. На сколько формулировки соответствуют предлагаемым видам продукции или услуг.

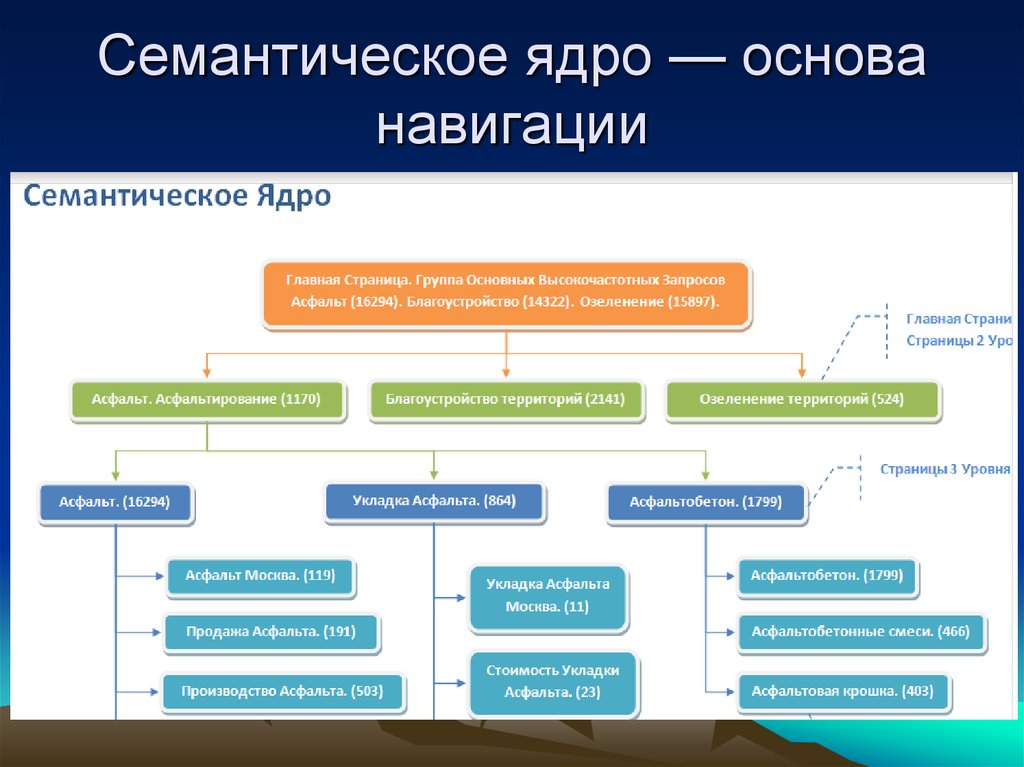

Структура сайта на основе семантики

На основе семантического ядра разрабатываем структуру сайта:

- Главная страница под высокочастотные и прямые фразы. В случае с «Рольставни» — это: рольставни, рольставни купить / цена / заказать и т.д.

- Планируем разделы, в которые включаются виды продукции (услуг) и вспомогательные страницы (гарантии, отзывы, доставка, контактная информация, о компании) цель которых убедить посетителя в надежности представленной компании.

- Подразделы – группы запросов распределенные по видам, типам и т.д. В представленном примере «Рольставни» в разделе Профиль, будут 2 подраздела: Алютех и Дорхан, из которых производят изделия.

Содержание страниц

Как говорилось выше, семантика для маркетолога – это источник креатива и полезного контента. В запросах пользователя он видит какие проблемы хочет решить клиент и формирует содержание, которое вовлекает посетителя, цепляет и вызывает доверие, а также мотивирует оставить заявку, позвонить или заказать товар.

В запросах пользователя он видит какие проблемы хочет решить клиент и формирует содержание, которое вовлекает посетителя, цепляет и вызывает доверие, а также мотивирует оставить заявку, позвонить или заказать товар.

Превратитесь на время в маркетолога, изучите каждую фразу под микроскопом. Что подразумевает человек в запросе. Какие у него опасения и как их развеять. В какой формате человек хочет получить решение проблемы и как показать, что компания выполнит желаемое. Какие факторы принятия решения влияют на него и как их усилить на странице? Таким образом составится уникальный контент, полезный для посетителя с коммерческим эффектом.

Вывод

Ручное составление семантического ядра при помощи Яндекс Вордстат трудозатратное мероприятие. Оно подходит для разовой работы и для небольших сайтов. При профессиональном продвижении сайтов целесообразно приобрести программу Кей Коллектор, которая упрощает работы и сокращает время по формирование семантики в разы. При этом она позволяет детально работать с группой и каждым словом. Пример сбора ядра в Key Collector можете посмотреть здесь.

Пример сбора ядра в Key Collector можете посмотреть здесь.

Сбор семантическое ядро: инструкция для начинающих

Алексей Шульгин

Старший специалист отдела продвижения компании SEO Интеллект

Основой успешного продвижения сайта в поисковых системах или запуска контекстной рекламы всегда являлось правильно собранное семантическое ядро. В данной статье показан весь процесс сбора и группировки запросов.

Мы разделили работу на три основных этапа:

- Сбор вариаций написания продукта и маркеров.

- Сбор и чистка семантического ядра в Key Collector.

- Кластеризация (группировка) семантического ядра.

Каждый этап мы разберем на примере группы товаров «Шлемы для мотоцикла», для которой и соберем семантическое ядро.

Чтение статьи займет у вас чуть больше 10 минут. Но если вы не очень любите читать, то можете потратить примерно то же время на просмотр ролика.

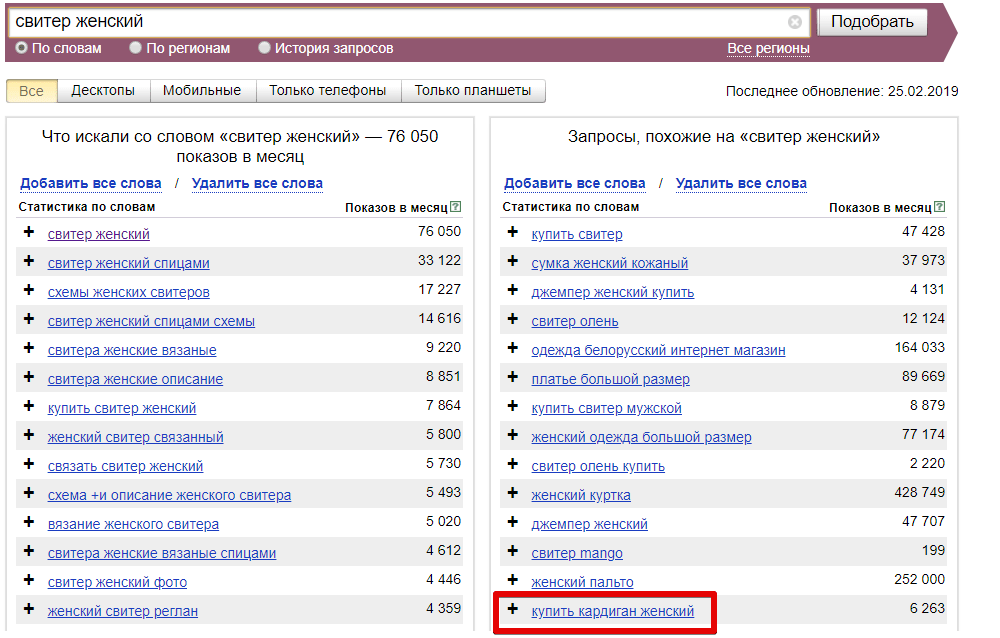

Этап 1. Сбор вариаций написания продукта и маркеров

Перед сбором запросов необходимо выявить все возможные варианты написания продвигаемого продукта, а также маркеры (свойства). Для этого мы используем сервис подбора слов Яндекса.

Методика

- Вписываем название нашего продукта в поисковую строку и нажимаем кнопку «Подобрать».

- Детально просматриваем запросы из правой колонки полученных результатов и выявляем синонимы или иные варианты нашего запроса.

- Переносим все найденные варианты названия продукта в отдельный файл.

- На следующем шаге следует собрать маркеры, то есть свойства, определяющие продукт. Данные маркеры можно объединить по типам схожих свойств, например, Цвет, Бренд, Тип и иных.

Для выявления маркеров есть два пути:

1. Сбор и последующая чистка всей семантики по названию продукта, например, «Мотошлем».

1.1. Плюс: Сбор всех существующих в спросе маркеров;

1.2. Минус: Долгий и трудозатратный процесс.

2. Поиск и анализ страниц конкурентов в ТОП 10, которые уже имеют страницы с нашим продуктом.

2.1. Плюс: Быстрый процесс;

2.2. Минус: Неполный сбор свойств, если они отсутствуют у конкурентов.

- Используя второй вариант, находим сайты конкурентов по запросам названия продукта, взяв страницы из ТОП 10. Это возможно сделать вводом основного запроса прямо в поисковую систему или же воспользоваться инструментом полноценного поиска конкурентов по видимости их сайтов, как было рассказано в 4 пункте первого этапа данной статьи.

- На странице конкурента, нужно обратить внимание на структуру категории, то есть существуют ли подкатегории, или посмотреть функционал фильтрации товаров.

В нем уже присутствуют группы свойств, внутри которых мы можем увидеть маркеры.

В нем уже присутствуют группы свойств, внутри которых мы можем увидеть маркеры.

- Копируем подкатегории и/или маркеры, которые нас интересуют, то есть то, что действительно есть у продвигаемого сайта в ассортименте, и выносим в наш файл:

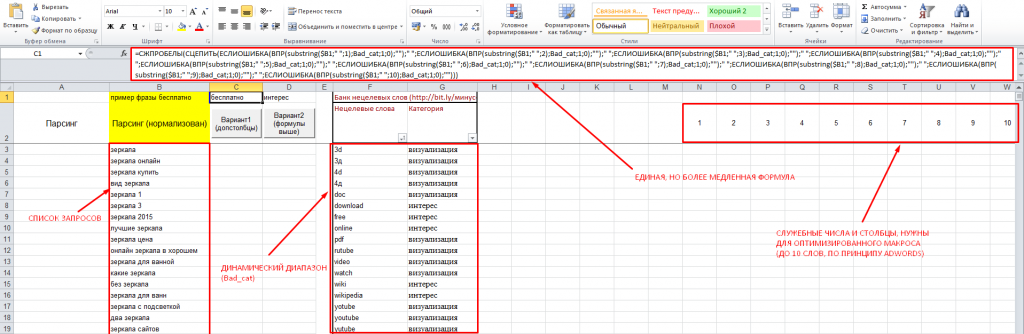

- Следующим шагом сцепляем все варианты написания нашего продукта с маркерами, чтобы получить различные запросы для последующего сбора семантического ядра уже по ним. Рекомендуем использовать функцию «СЦЕПИТЬ» в Microsoft Excel. В результате получим таблицу, аналогичную представленной ниже:

- Для пакетной (разовой) загрузки всех ключевых слов в KeyCollector следует опять воспользоваться функцией «СЦЕПИТЬ» (формируем запросы в формате «Группа:Ключ»). Таким образом мы сможем разом добавить все запросы в единое поле программы, которая в свою очередь создаст необходимые группы и добавит в них соответствующие запросы для расширения ядра.

Итоговый список запросов в необходимом формате:

Итоговый список запросов в необходимом формате:

Этап 2. Сбор и чистка семантического ядра в Key Collector

Перед началом сбора семантического ядра необходимо указать регион, по которому следует собирать запросы и их частотность. Регион напрямую связан с магазином, для которого собирается семантика, то есть если ваш магазин находится в Москве, то и запросы с их частотностью нужно собирать по данному региону. Для этого в нижней части окна мы выбираем регион для сервисов Yandex.Wordstat и Яндекс Директ:

После выбора региона можно приступать к сбору семантики.

Методика

- В основном меню нажимаем кнопку «Пакетный сбор слов из левой колонки Yandex.Wordstat»:

- В открывшимся окне мы увидим поле, куда необходимо добавить запросы прямо из нашего файла. После их добавления в нижней правой части окна следует нажать на иконку разделения фраз по группам:

- После нажатия на кнопку в правой колонке групп мы увидим, что наши группы добавлены, и во всплывающем окне появилось поле с названиями наших групп, внутри которых находятся соответствующие запросы.

Далее мы можем нажимать кнопку «Начать сбор»:

Далее мы можем нажимать кнопку «Начать сбор»:

Запустив парсинг левой колонки Yandex.Wordstat, мы автоматически получаем все расширения наших запросов из сервиса, и теперь не будем собирать их вручную.

- Следующим шагом является сбор корректной частоты запросов. Для этого следует очистить данные общей частотности, собранной вместе с запросами из сервиса Yandex.Wordstat, нажав на заголовок столбца правой кнопкой мыши и выбрав пункт «Очистить данные в колонке»:

Для сбора частотности мы используем функционал «Сбор статистики Yandex.Direct»:

- Во всплывающем окне выбираем период сбора равный году. Это необходимо потому, что спрос на товары зачастую является сезонным, и без годовой частотности мы не сможем выявить самые популярные запросы. Целью сбора выбираем «Базовую» и «Уточненную» частотность, после чего нажимаем кнопку «Получить данные»:

- Когда частотность собралась, можно переходить к чистке семантики от мусорных фраз.

Мы рекомендуем удалять запросы с «Уточненной» частотностью менее 10, так как это означает, что подобные запросы приносят меньше 1 посетителя в месяц.

Мы рекомендуем удалять запросы с «Уточненной» частотностью менее 10, так как это означает, что подобные запросы приносят меньше 1 посетителя в месяц.

Выделяем такие запросы и нажимаем кнопку «Удалить фразы»:

- Теперь можно приступить к чистке запросов по фразам.

Для этого есть несколько инструментов:

1. Инструмент фильтрации позволяет быстро отсечь часть ненужных запросов. Используя его, можно оставить в основной таблице только те фразы, которые включают в себя английские символы, цифры или состоят из 4 и более слов и т.п. для пакетного удаления.

2. Инструмент «Стоп-слова» позволяет отмечать фразы на удаление или последующий перенос в другую/новую группу по заранее загруженным в поле словам. Можно сразу выделить запросы с вхождениями городов (отличных от выбранного региона), названий компаний конкурентов, а также информационные запросы со словами «как», «почему», «отзывы», «реферат» и пр.

3. Инструмент «Анализ групп» позволяет собрать запросы в группы по различным вариантам группировки и отмечать названия групп, выделяя сразу несколько запросов для удаления или последующего переноса в другую/новую группу.

- Рекомендуем пользоваться всеми инструментами, основным из которых должен стать «Анализ групп». Данный инструмент находится во вкладке «Данные»:

Во всплывающим окне можно увидеть несколько вариантов группировки, из которых мы советуем использовать метод «по отдельным словам».

В данном методе все запросы будут присутствовать в таблице и не случится того, что запрос, не попавший ни в одну группу, будет исключен из таблицы и его придется искать позже вручную в общем списке запросов.

- Просматривая группы одну за другой, отмечаем их или фразы внутри них, которые явно нам не подходят. В процессе мы будем наблюдать, что, выбирая пять групп, мы уже отметили в общей таблице 9 фраз:

- После того как отметим все группы и запросы в них, мы можем закрыть данное окно и нажать на кнопку «Удалить фразы».

После чего следует перейти к выгрузке запросов в Excel для последующей ручной чистки запросов и группировки семантики.

- Чтобы совершить пакетную выгрузку всех запросов из разных групп, необходимо в правой колонке программы отметить все наши группы и нажать кнопку «Режим просмотра мульти-группы». После этого можно выгрузить наше семантическое ядро в Microsoft Excel:

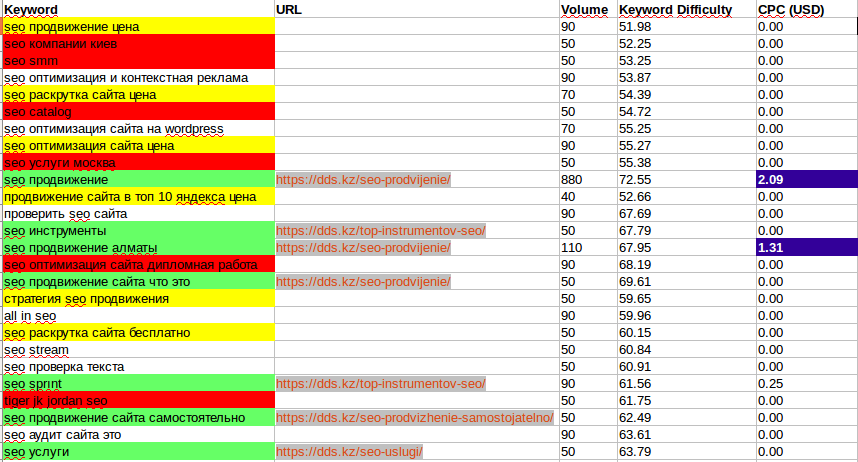

Этап 3. Кластеризация (группировка) семантического ядра

Полученный список запросов нам нужно разбить на кластеры для последующей проработки посадочных страниц. Чтобы корректно выполнить эту задачу, нужно использовать сервисы кластеризации запросов, работающие на основе выдачи поисковых систем. Именно такой формат анализа, возможности продвижения тех или иных запросов на одной или разных страницах дает 70% успеха при дальнейшем продвижении сайта.

Популярные программные продукты:

1. KeyAssort – программа для кластеризации и структуризации семантического ядра.

2. Key Collector – функционал «Анализ групп» с типом группировки «По поисковой выдаче»).

Популярные онлайн-сервисы:

1. Engine Seointellect

2. Tools PixelPlus

3. Rush Analytics

Рассмотрим методику группировки запросов с помощью сервиса Engine Seointellect.

Методика

- Полученный список запросов, который мы выгрузили из программы Key Collector, содержит столбец с названием «Группа». Нам необходимо по очереди добавлять все запросы из каждой группы в кластеризатор.

- Заходим в сервис и выбираем в меню слева пункт «Кластеризация запросов». В открывшемся блоке мы видим кнопку «Новая группировка».

- Нажимаем на данную кнопку. На экране появятся следующие поля для заполнения:

1. Добавить запросы – в данный блок мы добавляем все запросы из первой анализируемой группы.

2. Вид группировки включает в себя три вида жесткости кластеризации:

2. 1.«Hard» – жесткая группировка.

1.«Hard» – жесткая группировка.

2.2.«Balance» – группировка средней жесткости.

2.3.«Soft» – группировка низкой жесткости.

Подробнее про различие работы методов группировки можно посмотреть в данном видео:

При группировке коммерческих запросов, как в нашем случае, следует изначально выбирать метод группировки «Hard», если запросы информационные, то рекомендуем пользоваться только методом «Soft».

3. Регион выбираем соответствующий регион продвижения.

4. Мой сайт не нужно указывать, так как эта функция нужна для определения запросов по уже существующим посадочным страницам указанного сайта.

- Нажав «Запустить группировку», необходимо дождаться окончания процесса сбора данных. При завершении анализа в правой части созданного задания вместо отображения процесса появится иконка «Глаз», на которую необходимо нажать.

- Мы попадаем на страницу результата группировки и можем проанализировать данные:

1. Мы видим, что все наши запросы, кроме одного, попали в одну группу (отмечено зеленым), а значит их можно продвигать вместе на одной посадочной странице.

2. Также присутствует нераспределенный запрос (отмечено синим), это значит, что по данному запросу результаты выдачи сильно отличаются от результатов других запросов. В таком случае следует сделать вывод, что под этот запрос нужно создавать отдельную посадочную страницу бренда Ataki.

3. Справа от группы есть функционал «Показать список URL», нажав на который откроется блок со ссылками на страницы из ТОП 10, по которым была проведена кластеризация.

- Если бы мы добавили большее количество запросов в кластеризатор, то в нераспределенных могли оказаться фразы, которые можно продвигать в готовых группах. Можно просто увидеть эти запросы и перенести в нужную группу, но если фраз много, то их следует отправить на группировку по методу «Soft».

Полученные группы по методу группировки «Soft» соединить с группами, полученными ранее по методу «Hard».

Полученные группы по методу группировки «Soft» соединить с группами, полученными ранее по методу «Hard». - Проведя данные действия с каждой группой из нашего файла, мы получим готовый список разделенных запросов, для последующей проработки страниц.

Финальная версия файла семантического ядра

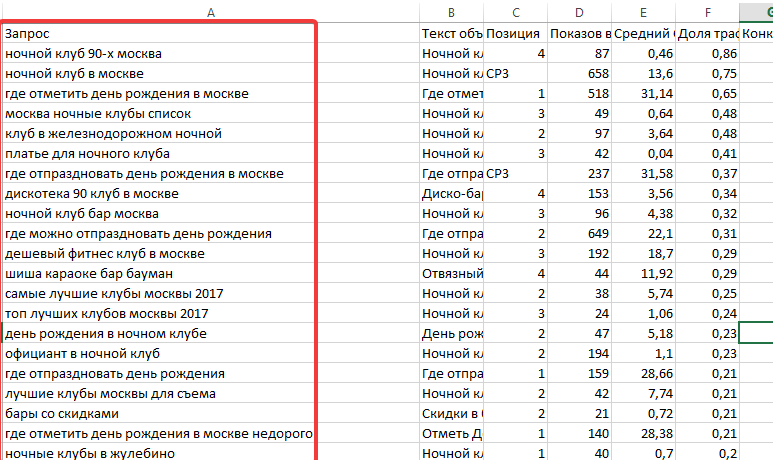

Итоговый файл с семантическим ядром должен представлять собой таблицу, включающую следующие столбцы с данными:

1. Запрос

2. Группа

3. Базовая частотность

4. Уточненная частотность

5. Посадочная страница

Все группы мы рекомендуем отделять чертой друг от друга, чтобы впоследствии с таким файлом было легче работать:

Выводы

Теперь вы знаете, насколько трудозатратным является процесс сбора и группировки семантического ядра для продвижения сайта или настройки контекстной рекламы.

Это лишь базовая инструкция, которая не охватывает многих нюансов, возникающих в процессе, но именно эта работа является основой успешного достижения целей продвижения, а значит выполнять ее некачественно равносильно бездействию, так как вы не добьетесь никаких результатов без «построенного фундамента».

Семантическая кластеризация ключевых слов для более чем 10 000 ключевых слов [со сценарием]

Семантическая кластеризация ключевых слов может помочь вывести исследование ключевых слов на новый уровень.

В этой статье вы узнаете, как использовать лист Google Colaboratory, доступный исключительно для читателей журнала Search Engine.

Эта статья расскажет вам об использовании листа Google Colab, подробном обзоре того, как он работает внутри, и о том, как внести коррективы в соответствии с вашими потребностями.

Но, во-первых, зачем вообще группировать ключевые слова?

Распространенные варианты использования кластеризации ключевых слов

Вот несколько вариантов использования кластеризации ключевых слов.

Faster Keyword Research:

- Отфильтруйте фирменные ключевые слова или ключевые слова, не имеющие коммерческой ценности.

- Сгруппируйте связанные ключевые слова вместе, чтобы создать более подробные статьи.

- Сгруппируйте связанные вопросы и ответы для создания часто задаваемых вопросов.

Платные поисковые кампании:

- Быстрее создавайте списки минус-слов для объявлений с использованием больших наборов данных — перестаньте тратить деньги на ненужные ключевые слова!

- Сгруппируйте похожие ключевые слова в варианты рекламных кампаний.

Вот пример скрипта, объединяющего похожие вопросы вместе, идеально подходит для подробной статьи!

Скриншот из Microsoft Excel, февраль 2022 г.

Проблемы с более ранними версиями этого инструмента

Если вы следите за моей работой в Твиттере, то знаете, что я уже некоторое время экспериментирую с кластеризацией ключевых слов.

Более ранние версии этого скрипта были основаны на превосходной библиотеке PolyFuzz, использующей сопоставление TF-IDF.

В то время как это делало работу, всегда были некоторые головокружительные кластеры, которые я чувствовал, что первоначальный результат мог быть улучшен.

Слова с одинаковым набором букв будут сгруппированы, даже если они не связаны семантически.

Например, не удалось сгруппировать такие слова, как «Велосипед» с «Велосипед».

В более ранних версиях скрипта также были другие проблемы:

- Он плохо работал на других языках, кроме английского.

- Было создано большое количество групп, которые невозможно было сгруппировать.

- Не было большого контроля над тем, как создавались кластеры.

- Сценарий был ограничен примерно 10 000 строк, прежде чем истекло время ожидания из-за нехватки ресурсов.

Семантическая кластеризация ключевых слов с использованием глубокого обучения обработки естественного языка (NLP)

Перенесемся на четыре месяца вперед к последнему выпуску, который был полностью переписан для использования самых современных встроенных предложений глубокого обучения.

Взгляните на некоторые из этих удивительных семантических кластеров!

Заметили, что «горячий», «термический» и «теплый» содержатся в одном и том же кластере ключевых слов?

Скриншот из Microsoft Excel, февраль 2022 г.

Или как насчет оптом и оптом?

Скриншот из Microsoft Excel, февраль 2022 г.

Собака и такса, Рождество и Рождество?

Скриншот из Microsoft Excel, февраль 2022 г.

Он даже может объединять ключевые слова на более чем ста разных языках!

Снимок экрана из Microsoft Excel, февраль 2022 г.

Особенности нового скрипта по сравнению с более ранними версиями

В дополнение к семантической группировке ключевых слов в последнюю версию этого скрипта были добавлены следующие улучшения.

- Поддержка кластеризации более 10 000 ключевых слов одновременно.

- Уменьшено число кластерных групп.