Настройка robots.txt | 2DOMAINS.RU ✔️

Помощь 0 Регистрация Вход

- Домены

- Хостинг

- Выбор и заказ хостинга

Продвинутым пользователям

Продвинутым пользователям- Настройка переадресации (редиректа)

- Почта

- Проблемы в работе сайта

- Часто задаваемые вопросы

- Сайты

- Личный кабинет

- VPS и серверы

- SSL-сертификаты

- Общие вопросы

- Как настроить robots.

txt

txt - Указать временной интервал посещения сайта поисковыми роботами

- Закрыть индексацию для конкретных папок или URL

- Закрыть весь сайт от индексации

Чтобы выставить для сайта настройки индексирования поисковыми роботами, используйте файл «robots.txt». Обратите внимание: если файла «robots.txt» ещё нет в каталоге вашего сайта, просто создайте его.

Какие настройки можно указать с помощью robots.txt:

- интервал, с которым поисковые роботы будут посещать ваш сайт;

- запретить индексацию конкретными работами и скрыть от индексации конкретные страницы сайта;

- скрыть от индексации весь сайт.

Как настроить robots.txt

Обратите внимание! Для некоторых браузеров настройки индексации нужно выставлять индивидуально. Например:

- в Google: не все поисковые роботы браузера следуют правилам в «robots.txt». Так робот «Googlebot» следует запрещающим правилам («Disallow»), но не следует директиве «Crawl-delay».

Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google;

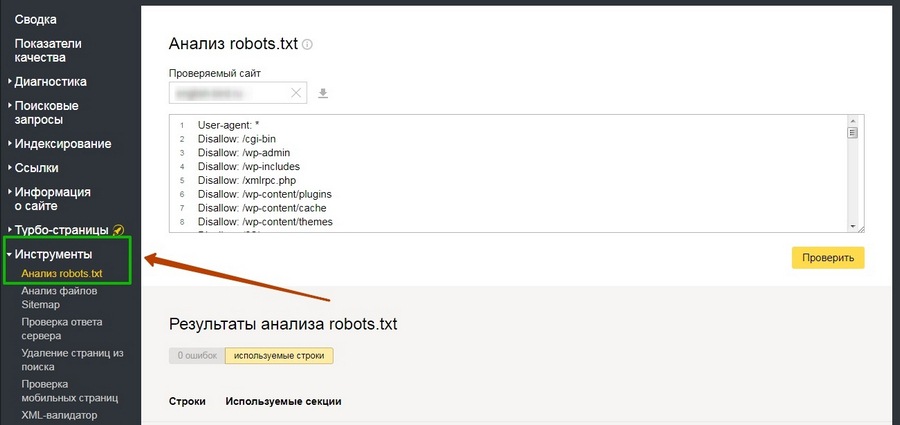

Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google; - в Yandex: для робота «Yandex Bot» максимально возможное ограничение через «robots.txt» составляет 2 секунды. Чтобы указать нужную частоту, с которой робот будет индексировать ваш сайт, используйте Яндекс.Вебмастер. Подробнее в справке Яндекс.

Указать временной интервал посещения сайта поисковыми роботами

Чтобы задать временной интервал обращения, авторизуйтесь в Яндекс.Вебмастер. Подробнее в справке Яндекса.

Обратите внимание:

— снижение скорости обхода сайта нужно, только если создается избыточная нагрузка на сервер;

— снижение скорости обхода сайта не влияет на позиции в поисковой выдаче браузера Яндекс.

Закрыть индексацию для конкретных папок или URL

За это отвечает директива User-agent — она определяет, для каких роботов будут применяться правила. С её помощью можно как задать отдельные правила для конкретных роботов, так и указать общие правила для всех роботов сразу.

# закрываем индексацию страницы vip.html для Googlebot:

User-agent: Googlebot

Disallow: /vip.html # закрываем индексацию папки private всеми роботами:

User-agent: *

Disallow: /private/# разрешаем доступ только к страницам, начинающимся с ‘/shared’ для Yandexbot

User-agent: Yandex

Disallow: /

Allow: /sharedЗакрыть весь сайт от индексации

Чтобы запретить индексацию сайта для всех поисковых роботов, добавьте в «robots.txt» следующие строки:

User-agent: *

Disallow: /

Популярные статьи

- Как указать (изменить) DNS-серверы для домена

- Я зарегистрировал домен, что дальше

- Как добавить запись типа A, AAAA, CNAME, MX, TXT, SRV для своего домена

- Что такое редирект: виды и возможности настройки

- Как создать почту со своим доменом

Домены

- Регистрация доменов

- Освободившиеся домены

- Промоакции

- Перенос домена

- Переадресация

- Магазин доменов

Сайты

- Конструктор сайтов

- Сайты на WordPress

Хостинг сайтов

- Хостинг

- Windows хостинг

VPS и серверы

- VPS хостинг

- Windows VPS

- Аренда серверов

Дополнения

- SSL-сертификаты //=url(‘/free-mail’)?>

Сервисы

- Бесплатный хостинг

- Whois

- Связь с администратором домена

- Определить свой IP-адрес

- Проверка порта на доступность

- Узнать местоположение по IP

- Проверить доступность сайта

Поддержка

- Справка

- Стоимость услуг

- Способы оплаты

- Связаться с нами

Компания

- О компании

- Документы

- Офис

- Дата-центр

- Блог

- Акции и скидки

© 2DOMAINS — регистрация доменов

- Домены оптом

- Географические домены

- Кириллические домены

- Административные домены

- Национальные домены

- Новые домены первого уровня

- Где купить домен дешево

- Дешевый хостинг

- CloudVPS

- Хостинг для сайта-визитки

- Хостинг с PHP и MySQL

- Надежный хостинг

- Самые дешевые домены

- Хостинг WordPress

- Хостинг для 1С-Битрикс

- Хостинг для Drupal

- Хостинг для Joomla

- Хостинг для MODX

- Хостинг для OpenCart

- Антивирус для хостинга

- Бэкап сайта

- Защита от DDoS-атак

- Хостинг с ISPmanager

- SSL бесплатно

- AlphaSSL

- AlphaSSL WildCard

- ExtendedSSL

- GlobalSign-сертификаты

- Comodo / Sectigo — сертификаты

- GeoTrust-сертификаты

- Symantec-сертификаты

- Thawte-сертификаты

- TrustWave-сертификаты

- Wildcard-сертификаты

Политика обработки

персональных данных

Тех. поддержка: [email protected]

поддержка: [email protected]

Указанные на сайте цены могут не включать стоимость применимых комиссий.

При заказе услуги стоимость может быть уточнена исполнителем.

Как закрыть сайт от индексации? 7 рабочих способов

Евгений (Админ VsetyRabota) Продвижение сайта Просмотров: 844

Существует ряд причин, по которым может потребоваться закрыть сайт от индексации в поисковых системах. Например, он находится в разработке, выбранный домен является копией основного или что-то еще. В этой статье будут разобраны основные методики, позволяющие скрыть отдельную страницу или весь сайт от индексации поисковыми системами.

Способы запрета индексации сайта

Итак, основные варианты запретить поисковым системам индексировать ваш сайт или определенные страницы это:

- Прописать запрещающие директивы в файле robots.

txt.

txt. - Прописать на страницах сайта запрещающий к индексации мета-тег robots.

- Через заголовок X-Robots-Tag.

- Использовать авторизацию на сайте.

- Изменить настройки сервера.

- Изменить ответ сервера.

- Закрыть сайт через настройки CMS.

Разберем каждый метод более подробно.

Файл robots.txt

С помощью этого файла можно указать поисковым роботам отдельные инструкции по индексации. Чтобы скрыть весь сайт от индексации для всех поисковых систем файл должен иметь следующее содержимое:

User-agent: *

Disallow: /

Когда нужно скрыть сайт от индексации в Яндекс, следует прописать следующее:

User-agent: Yandex

Disallow: /

Для скрытия от индексации в Google пропишите следующее:

User-agent: Google

Disallow: /

Также с помощью этого файла можно закрыть от индексации отдельную страницу сайта, прописав:

Disallow: /sotsialnye-seti$

Где sotsialnye-seti – это адрес страницы вашего сайта без указания домена. Указанная в примере директива закроет от индексации страницу https://vsetyrabota.ru/sotsialnye-seti. Если необходимо закрыть не только саму страницу, но и все URL, которые входят в указанный раздел, в файле robots.txt необходима следующая строчка:

Указанная в примере директива закроет от индексации страницу https://vsetyrabota.ru/sotsialnye-seti. Если необходимо закрыть не только саму страницу, но и все URL, которые входят в указанный раздел, в файле robots.txt необходима следующая строчка:

Disallow: /sotsialnye-seti

В результате будет закрыта от индексации страница https://vsetyrabota.ru/sotsialnye-seti и все страницы внутри нее, например:

https://vsetyrabota.ru/sotsialnye-seti/218-kupit-akkaunt-vkontakte

Данный способ является одним из самых простых и рекомендуется к использованию поисковыми системами. Директива Disallow позволяет запретить индексацию как конкретной страницы, так и целого раздела, группы файлов или всего сайта.

Использование мета-тега robots

Не стоит путать тег robots и файл robots.txt. Тег прописывается в коде страницы, а файл располагается в корневой папке домена.

Для запрета индексации страницы, в коде между блоками <head> и </head> следует прописать значение noindex или none. Выглядеть такой код будет следующим образом:

Выглядеть такой код будет следующим образом:

<meta name=”robots” content=”noindex”/>

Или

<meta name=”robots” content=”none”/>

Указанные выше теги срабатывают на обе поисковые системы. Если нужно запретить индексацию страницы в одной поисковой системе, следует прописать следующее:

Для Google:

<meta name="googlebot" content="noindex">

Для Яндекса:

<meta name="yandex" content="none" />

- Директива noindex – запрещает индексацию страницы, и она не будет участвовать в результатах поиска;

- Директива none – соответствует директивам noindex, nofollow – страница запрещена от индексации, и она не участвует в результатах поиска, а также поисковому роботу дано указание не переходить по ссылкам на странице.

Использование заголовка X-Robots-Tag

Принцип работы заголовка X-Robots-Tag, аналогичен мета-тегу robots. Однако его действие распространяется на все виды контента, которые расположены на сайте, поэтому можно считать его более надежным (хотя и мета-тег robots прекрасно справляется со своей задачей).

Для запрета индексации страницы сайта, следует использовать те же директивы, что и для тега robots: noindex или none. Пример использования заголовка:

X-Robots-Tag: noindex, nofollow

Авторизация на сайте

Указанные выше способы не всегда позволяют скрыть все страницы сайта от индексации. Особенно это актуально для главной страницы. В официальном руководстве Яндекса говорится, что при наличии ссылок на главную страницу – есть вероятность сохранения ее в индексе поисковых систем. Чтобы решить проблему, дополнительно настраивают авторизацию при переходе на эту страницу.

Смена настроек сервера

Радикальный метод, который позволяет изменить настройки обращения к серверу для роботов поисковых систем. Для внесения правок потребуется изменить данные в файле .htaccess. Обычно к такой проблеме прибегают в том случае, когда поисковые боты продолжают индексировать сайт не смотря на все проведенные действия. Чтобы запретить им это делать в файле прописывают следующие строчки:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yandex" search_bot

Первая строчка запретит доступ поисковому боту Google, а вторая Яндексу. В результате страницы должны вылететь из индекса.

В результате страницы должны вылететь из индекса.

Смена ответа сервера страницы

Как известно, для индексации страницы она должна иметь 200-й ответ сервера. Соответственно при изменении ответа на 30Х или 40Х – страница со временем выпадет из индекса поисковых систем. Назвать это способом запрета страницы от индексации довольно сложно, да и поисковики могут длительное время сохранять страницу с отличным от 200-го ответом сервера в выдаче. Однако чаще всего такие странички выпадают из индекса в течении одного или нескольких обходов. Не рекомендуется использовать этот метод для скрытия страниц от индексации.

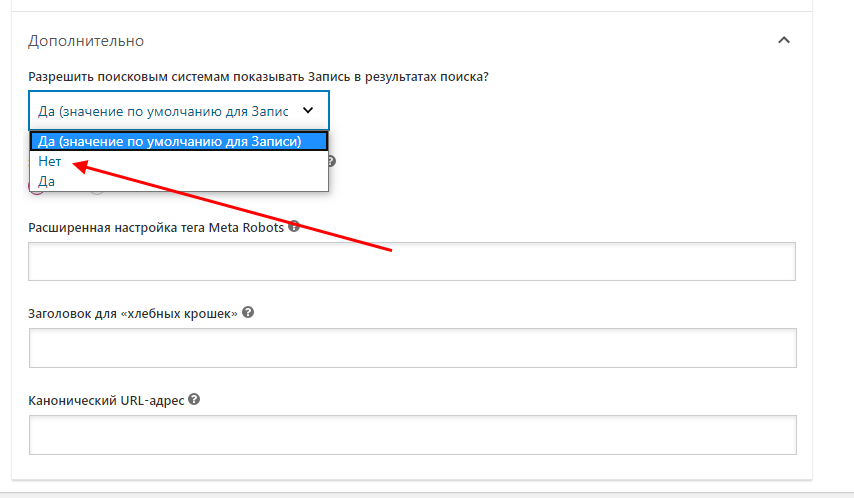

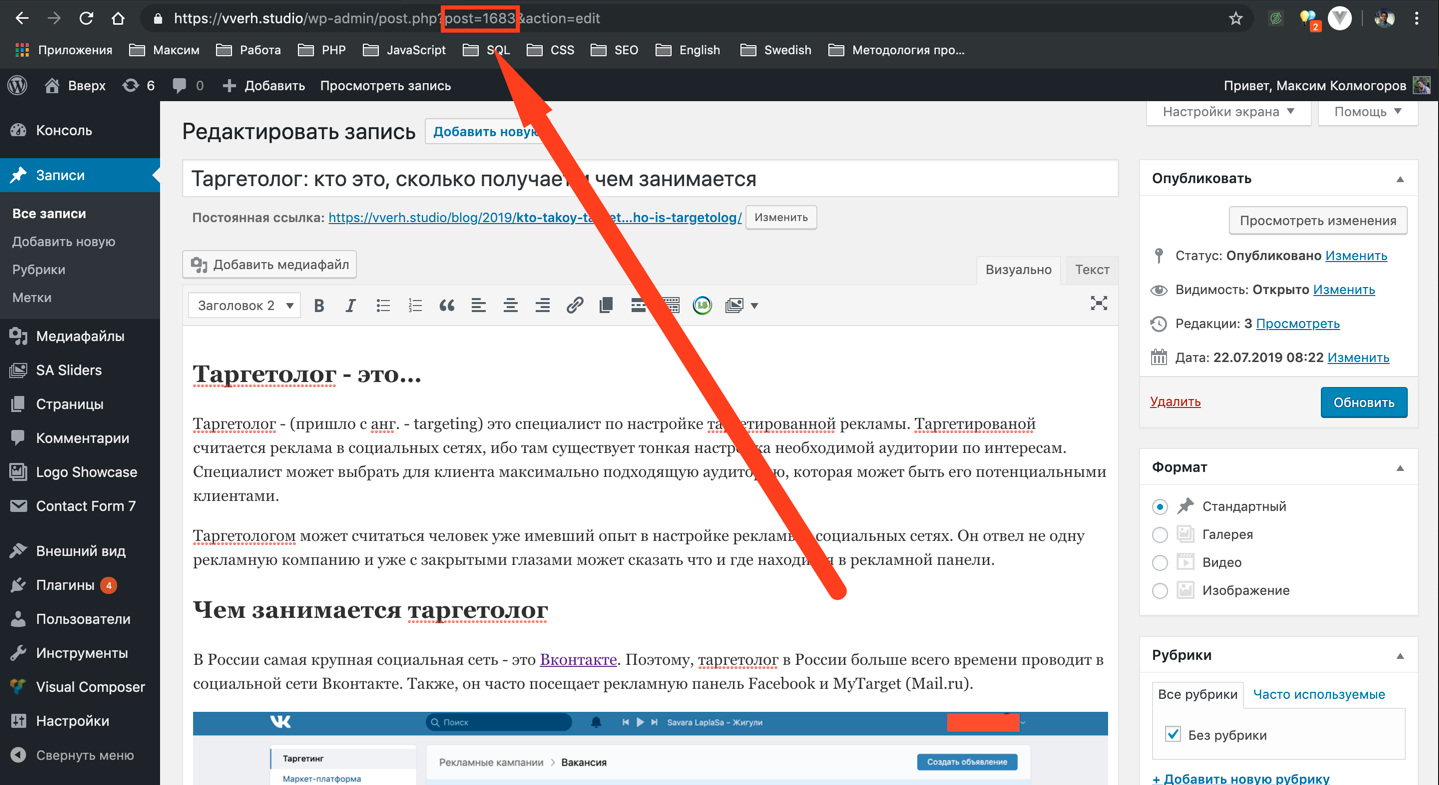

Использование настроек CMS

Любая популярная CMS имеет в «коробке» возможность скрыть сайт от индексации для поисковых систем. Достаточно лишь установить галочку или задать соответствующую настройку, а система все сделает за вас.

На WordPress сделать это можно через панель администратора. Заходим в раздел «Настройки» => «Чтение» и устанавливаем галочку напротив соответствующего блока. Не забудьте сохранить изменения.

Не забудьте сохранить изменения.

На Joomla вы это можете сделать в разделе «Общие настройки» => «Сайт». Нас интересует вкладка «Параметры метаданных» и у блока Мета-тег Robots устанавливаем значение «No index, No follow». Стоит обратить внимание, что если у отдельного материала в настройках будет прописан отличный от этого мета-тег, то работать будет именно он.

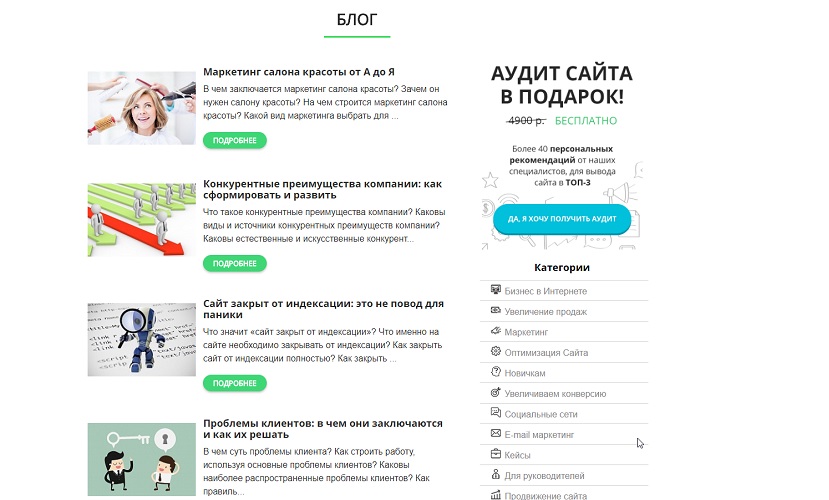

Дополнительно на многие сайты распространяются плагины для SEO-оптимизации. Некоторые из них предусматривают возможность устанавливать настройки по индексации страниц.

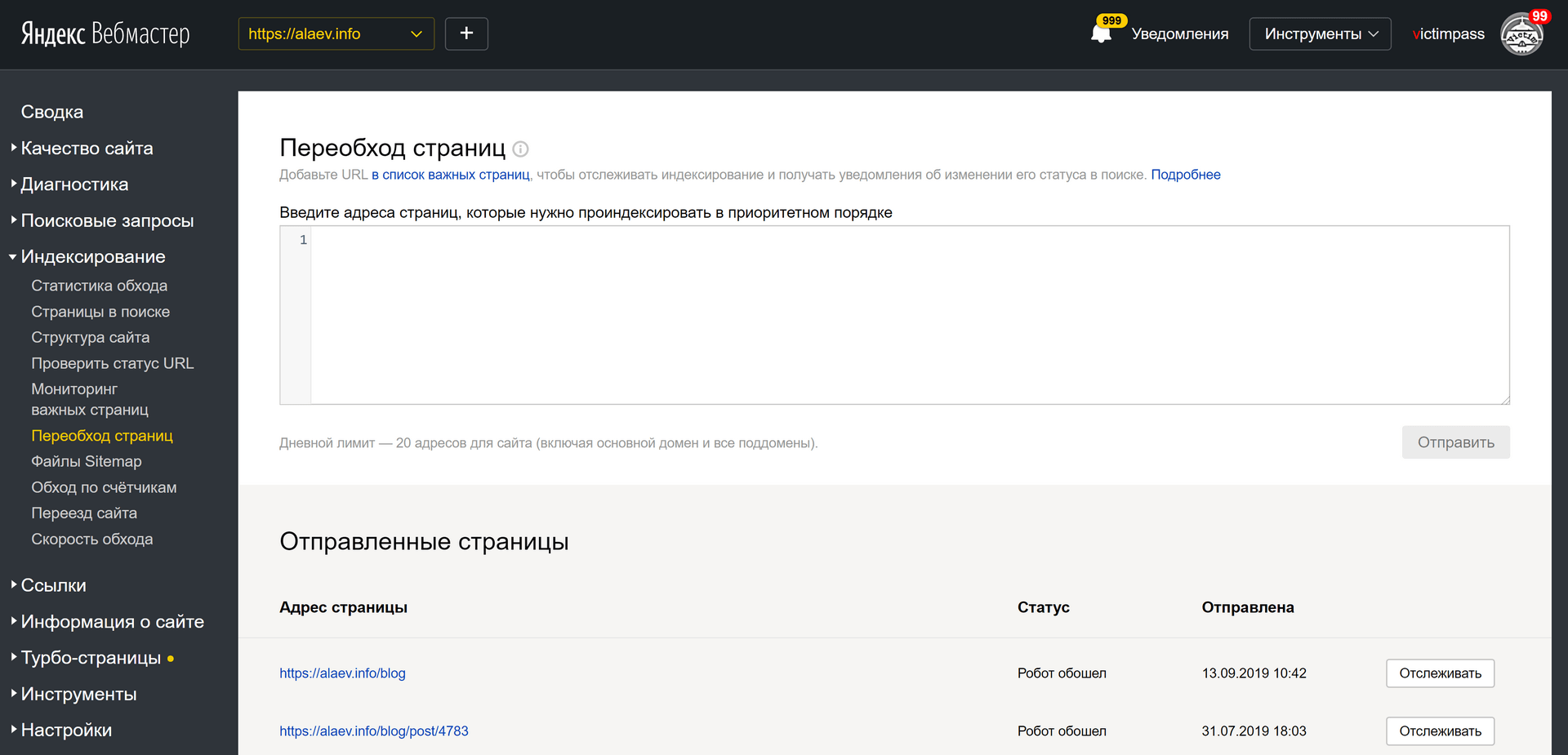

Как проверить, что страница запрещена к индексации?

Выбрав указанный способ и запретив индексацию сайта или его страницы, необходимо проверить, правильность выполненных действий. Узнать находится ли сейчас страница в индексе можно вручную, используя поисковый оператор url для Яндекса. Например:

url: https://vsetyrabota.ru/sotsialnye-seti/218-kupit-akkaunt-vkontakte

Вбив этот оператор в поисковую строку, вы увидите присутствует ли страница в индексе:

В Google раньше использовался оператор info, аналогичный оператору url для Яндекса, но в 2019 году было официально объявлено о том, что это оператор отключат.

Можно выполнить проверку с помощью специальных инструментов поисковых систем. В Яндексе это инструмент для проверки ответа сервера: https://webmaster.yandex.ru/tools/server-response/

Вбив в строку «Опрашиваемый URL» проверяемый адрес, вы получите результат о том, можно ли его проиндексировать.

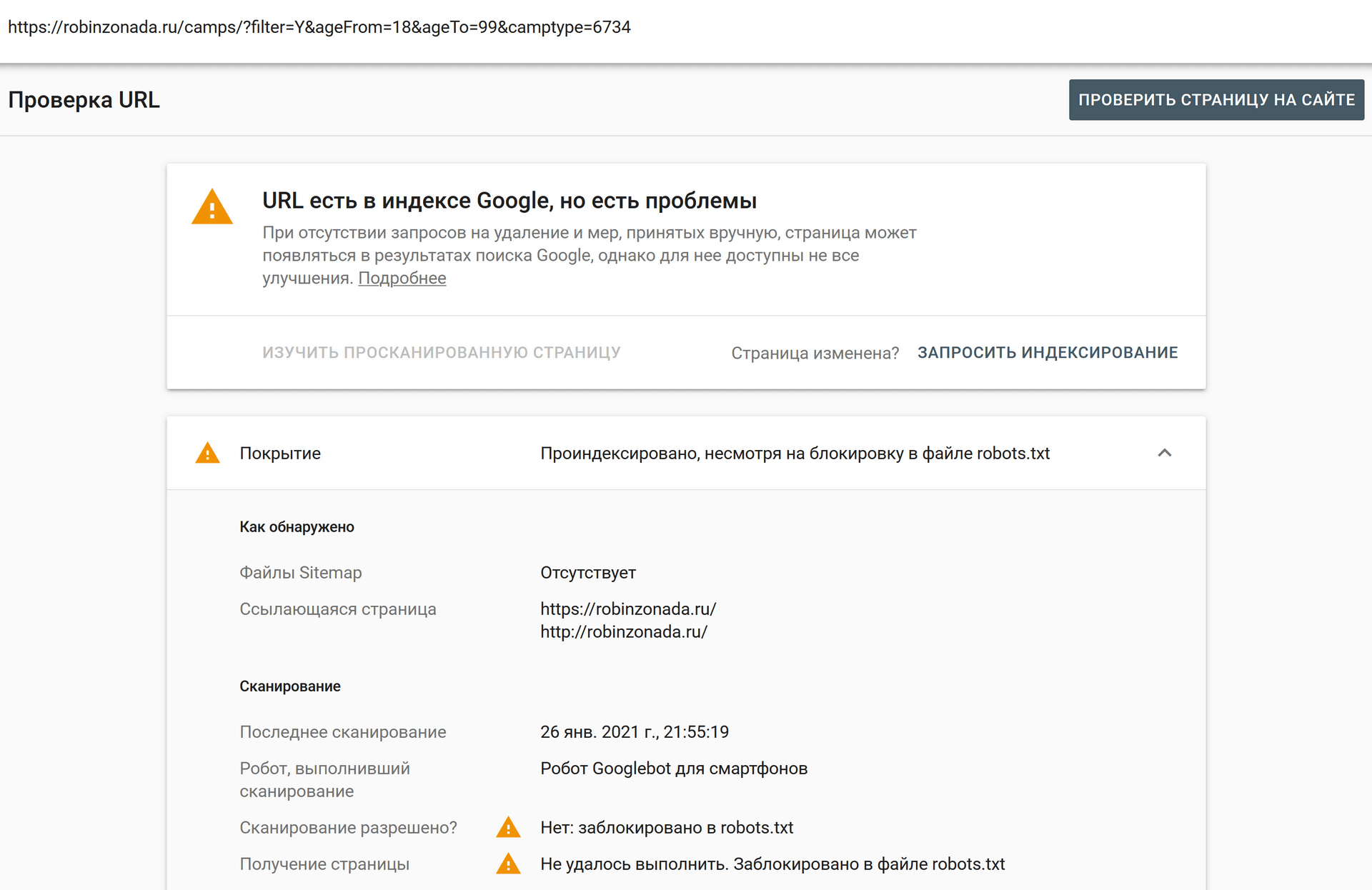

Google дает возможность проверять страницы в Search Console. Для этого достаточно вбить нужный адрес в строку «Проверка URL» и дождаться обработки результата.

На скриншоте видно, что страница отсутствует в индексе Google и ей запрещено сканирование по средствам файла robots.txt.

Основные тезисы

Есть два основных момента, которые следует помнить при запрете индексации:

- Большинство из указанных способов поисковые системы рассматривают как рекомендации и могут их игнорировать (особенно Google). По этой причине страницы могут присутствовать в индексе поисковой системы, даже если вы все сделали правильно.

- Если страница уже попала в индекс поисковой системы – потребуется определенное время (несколько дней, редко – недель) чтобы поисковые системы переиндексировали саму страницу и нашли на ней запрещающий тег.

В результате страница должна пропасть из поисковой выдачи.

В результате страница должна пропасть из поисковой выдачи.

Запретить поисковым системам индексировать ваш сайт

Если вы запретите поисковым системам индексировать ваш сайт WordPress, он не будет сканироваться, индексироваться и отображаться где-либо в результатах поиска. Вы разработали веб-сайт и оптимизировали его, чтобы повысить шансы на ранжирование в результатах поиска. Итак, почему вы хотите заблокировать поисковые роботы и индексаторы?

К концу поста вы узнаете 5 самых важных причин, по которым ваш сайт не индексируется, а также способы отключения индексации поисковыми системами.

- Зачем отговаривать поисковые системы от индексации вашего сайта WordPress

- Запретить поисковым системам индексировать сайты WordPress

- Защита паролем веб-сайтов с помощью cPanel

- Использовать плагин для защиты паролем WordPress Pro

- Использовать функцию видимости поисковой системы WordPress

- 3 распространенных мифа о robots.

txt

txt- Ограничения файла robots.txt

- Запретить Google индексировать страницы и сообщения WordPress

- Использовать метатег robots

- Использовать HTTP-заголовок x-robots-tag

- Используйте плагин защиты страниц и сообщений WordPress

- Запрет поисковым системам индексировать файлы WordPress

- Редактировать robots.txt

- Запретить Google индексировать страницы вложений

- Использовать плагин Yoast SEO

- Используйте плагин Prevent Direct Access Gold

Почему не рекомендуется поисковым системам индексировать ваш сайт WordPress

Существует 5 распространенных случаев, когда вы можете потребовать, чтобы поисковые системы прекратили сканирование и индексирование вашего сайта WordPress и его контента:

1. Обслуживание и скоро будут страницы Страница обслуживания сообщает пользователям, что ваш сайт все еще находится в разработке. Эта страница не должна быть проиндексирована и отображаться в результатах поиска, потому что она не будет предоставлять никаких значений после того, как сайт будет запущен.

Эта страница не должна быть проиндексирована и отображаться в результатах поиска, потому что она не будет предоставлять никаких значений после того, как сайт будет запущен.

Вы создаете клон веб-сайта в целях разработки. Однако вы не хотите, чтобы этот сайт конкурировал с существующим. Само собой разумеется, что Google может рассматривать их как повторяющиеся веб-сайты и отображать один из этих двух в результатах поиска. Что, если он ранжирует ваш тестовый сайт вместо основного? Хранение дублирующего сайта вдали от Google оказывается полезным для более высокого рейтинга более важного веб-сайта.

3. Ценный контентПосетители могут искать URL-адреса страницы заказа и благодарности, которые включают ценные предложения, чтобы украсть ваши продукты. Если это так, эти страницы не должны индексироваться и показываться в результатах поиска публично.

4. Личный контент Когда вы пишете журналы или дневники и размещаете их на своем веб-сайте блога, у вас есть веская причина сделать его недоступным для поиска. В результате никто даже не узнает о существовании вашего блога.

В результате никто даже не узнает о существовании вашего блога.

Пока ваша команда работает над проектом, вы можете создать неиндексируемый сайт для обмена внутренней информацией с членами команды. Этот веб-сайт будет скрыт от поисковых роботов Google. Только члены команды могут искать и получать доступ к сайту.

Теперь мы покажем вам конкретные решения для отключения индексации поиска в зависимости от областей сайта, которые вы хотите защитить.

Запретить поисковым системам индексировать сайты WordPress

Существует 3 распространенных способа запретить поисковым системам индексировать сайты WordPress:

- Пароль, защищающий каталог с помощью cPanel

- Использование плагина для защиты паролем всего сайта

- Включение функции видимости поисковой системы WordPress

Прежде чем углубляться во встроенную функцию WordPress, давайте начнем с метода защиты паролем. Вы можете либо указать пароль для инструмента панели управления вашего сайта, либо установить пароль через плагин. Каждый метод защищает ваш сайт по-своему.

Вы можете либо указать пароль для инструмента панели управления вашего сайта, либо установить пароль через плагин. Каждый метод защищает ваш сайт по-своему.

cPanel предлагает один из самых популярных и удобных инструментов веб-хостинга для управления всеми веб-сайтами. Чтобы защитить паролем свой сайт, выполните следующие 5 шагов:

- Войдите в панель управления cPanel и откройте Защитить паролем каталоги

- Выберите каталог, в котором размещен ваш сайт WordPress на

- Выберите Пароль Защитить этот каталог опция

- Создайте учетную запись пользователя с именем пользователя и паролем

- Сохраните изменения

Если веб-сайт защищен паролем через cPanel, пользователи должны вводить имя пользователя и пароль при доступе к веб-сайту. Вот почему вы можете рассмотреть возможность использования плагина защиты паролем.

Password Protect WordPress Pro защищает ваш сайт WordPress с помощью одного пароля, защищая его от поисковых роботов и индексаторов. Этот метод дает вам больший контроль над инструментом защищенных паролем каталогов cPanel, поскольку он не требует имени пользователя.

После активации вам необходимо:

- Перейти на страницу настроек

- Убедитесь, что расширенная функция Block Search Indexing включена

- Перейдите на вкладку Весь сайт и введите пароль для защиты вашего сайта

- Сохраните изменения

После защиты паролем ваш сайт становится невидимым для поисковых роботов и нигде не отображается в результатах поиска. Только те, у кого есть правильные пароли, могут разблокировать частный сайт.

Кроме того, плагин позволяет исключить некоторые страницы из общей защиты сайта. Другими словами, эти страницы будут доступны для поиска, в то время как остальная часть веб-сайта скрыта от поисковых систем.

Другими словами, эти страницы будут доступны для поиска, в то время как остальная часть веб-сайта скрыта от поисковых систем.

- Найти Настройки в панели управления WordPress

- Нажмите на опцию Чтение под

- Включить параметр « Запретить поисковым системам индексировать этот сайт »

Как только вы установите флажок Запретить поисковым системам индексировать этот сайт , WordPress использует файл robots.txt и метатег, чтобы защитить ваш сайт от поисковых роботов и индексаторов.

WordPress редактирует файл robots.txt, используя следующий синтаксис:

Агент пользователя: * Запретить: /

В то же время он добавляет эту строку в заголовок вашего веб-сайта:

Вы можете задаться вопросом, является ли это хорошим решением, чтобы отговорить поисковые системы от индексация вашего сайта. Это влияет на SEO-рейтинг вашего сайта. Вашему контенту сложно подняться в рейтинге.

Это влияет на SEO-рейтинг вашего сайта. Вашему контенту сложно подняться в рейтинге.

3 распространенных мифа о Robots.txt

Robots.txt — это текстовый файл, созданный веб-мастерами, чтобы запретить поисковым системам сканировать страницы вашего веб-сайта. Многие люди, в том числе WordPress, рекомендуют использовать его для ограничения индексации веб-сайтов, контента и файлов.

Однако не все из нас знают, как правильно использовать файлы robots.txt. Ниже приведены 3 распространенных мифа о robots.txt, которые большинство пользователей неправильно понимают.

1. Robots.txt помогает блокировать поисковое индексирование Владельцы сайтов WordPress считают, что правила запрета robots.txt широко используются для предотвращения индексации вашего сайта поисковыми системами. Однако это не предназначено для блокировки поисковых индексаторов, а для управления сканирующим трафиком на ваш сайт. Например, вы используете robots.txt, чтобы избежать сканирования неважных или похожих страниц. Более того, вы можете использовать robots.txt, когда к вашему серверу поступает много запросов от поисковых роботов Google.

Более того, вы можете использовать robots.txt, когда к вашему серверу поступает много запросов от поисковых роботов Google.

Чтобы запретить поисковым системам индексировать ваш сайт, вам следует рассмотреть возможность использования метатега robots и HTTP-заголовка x-robots-tag.

2. Контент не будет проиндексирован без сканированияGoogle выполняет 3 основных шага для получения результатов от веб-страниц, а именно сканирование, индексирование и обслуживание.

- Во-первых, сканирование — это когда Google обнаруживает все страницы, существующие на вашем сайте. Он использует множество методов для поиска страницы, таких как чтение карты сайта или переход по ссылкам с других сайтов и страниц.

- Затем Google индексирует ваши страницы, анализируя и понимая, о чем страница. Эта информация будет храниться в огромной базе данных под названием Google index.

- Наконец, Google начинает ранжировать ваш контент.

Всякий раз, когда кто-то вводит ключевое слово в строку поиска, Google находит и предоставляет результаты с наиболее релевантным содержанием из своего индекса. Эти результаты будут основаны на более чем 200 факторах, включая качество контента страницы, местоположение пользователя, язык, устройство и т. д.

Всякий раз, когда кто-то вводит ключевое слово в строку поиска, Google находит и предоставляет результаты с наиболее релевантным содержанием из своего индекса. Эти результаты будут основаны на более чем 200 факторах, включая качество контента страницы, местоположение пользователя, язык, устройство и т. д.

Таким образом, вы можете подумать, что если ваш контент не просканирован, он не будет проиндексирован. Поскольку файл robots.txt блокирует поисковые роботы Google, он также предотвратит индексацию поиска?

На самом деле страницы, заблокированные robots.txt, не будут сканироваться, но все равно будут проиндексированы, если на них ссылаются с других сайтов. Скорее всего, ваши страницы все еще появляются в результатах поиска.

3. Robots.txt используется для сокрытия контента Люди часто используют файл robots.txt, чтобы контент не отображался в результатах поиска. Однако файл robots.txt указывает Google не читать, анализировать и понимать содержание. Таким образом, поисковые системы не будут знать, должны ли они индексировать ваши страницы или нет. В результате Google не предоставляет метаописание для страницы. Вместо этого пользователи увидят строку «Для этой страницы нет доступной информации. Узнайте, почему».

Таким образом, поисковые системы не будут знать, должны ли они индексировать ваши страницы или нет. В результате Google не предоставляет метаописание для страницы. Вместо этого пользователи увидят строку «Для этой страницы нет доступной информации. Узнайте, почему».

Robots.txt НЕ используется для сокрытия контента. На самом деле robots.txt затрудняет для Google анализ и защиту вашего личного контента. Чтобы эффективно скрыть контент, вы должны использовать другие методы, такие как защита паролем или метатег «noindex».

Как уже упоминалось, функция WordPress Search Engine Visibility работает на основе файла robots.txt. Вот почему это не мешает поисковым системам индексировать ваш контент.

Ограничения файла robots.txtСуществуют некоторые ограничения, которые следует учитывать при использовании robots.txt.

1. Файл robots.txt общедоступен

Файл robots. txt доступен всем. На самом деле файлы robots.txt всех сайтов находятся в корневом домене, а /robots.txt, например. www.example.com/robots.txt . Помещая URL-адреса страниц и файлов в файл robots.txt, вы случайно открываете непреднамеренный доступ. Боты и пользователи будут знать, какие страницы следует скрыть. Затем они могут получить URL-адреса и легко получить доступ к этим страницам 9.0003

txt доступен всем. На самом деле файлы robots.txt всех сайтов находятся в корневом домене, а /robots.txt, например. www.example.com/robots.txt . Помещая URL-адреса страниц и файлов в файл robots.txt, вы случайно открываете непреднамеренный доступ. Боты и пользователи будут знать, какие страницы следует скрыть. Затем они могут получить URL-адреса и легко получить доступ к этим страницам 9.0003

Чтобы преодолеть этот недостаток, вам нужно сгруппировать все файлы, для которых вы хотите отключить поисковое индексирование, в отдельной папке. Затем поместите свои файлы в эту папку и сделайте ее невидимой в Интернете. После этого укажите только имя папки в /robots.txt.

2. Другие роботы поисковых систем могут игнорировать ваш файл robots.txt

Хотя большинство роботов следуют вашему файлу robots.txt, вредоносные программы и сборщики адресов электронной почты, используемые спамерами, могут игнорировать его. Эти вредоносные роботы могут посещать ваш сайт и сканировать его на наличие такой информации, как электронные письма и формы для рассылки спама.

Вы должны использовать брандмауэры, блокировщики IP-адресов и плагины безопасности для повышения безопасности вашего сайта WordPress.

3. Каждый поисковый робот может читать синтаксис по-разному

Синтаксис в файле robots.txt применяется для большинства веб-сканеров. Тем не менее, каждый из них может читать и следовать правилам файла по-разному. Это объясняет, почему некоторые поисковые роботы не соблюдают правила запрета файлов и продолжают сканировать ваш сайт.

Не следует слишком полагаться на файл robots.txt для управления сканирующим трафиком.

Важность robots.txt Файл robots.txt оказывается полезным, когда вы четко понимаете, как он работает. Это не мешает контенту индексироваться. Файл robots.txt используется для управления сканирующим трафиком и предотвращения отображения загрузок в результатах поиска Google. Эта функция будет обсуждаться в разделе «Запретить поисковым системам индексировать файлы » ниже.

Запретить Google индексировать страницы и сообщения WordPress

Вместо того, чтобы защищать весь сайт от поисковых роботов и индексаторов, вы можете деиндексировать только некоторые определенные страницы, например страницы с конфиденциальной информацией или страницы с благодарностью.

Чтобы запретить Google индексировать ваш контент, выберите один из этих 3 отдельных путей: редактирование метатега robots, использование HTTP-заголовка X-Robots-Tag или использование плагина Protect WordPress Pages and Posts.

1. Используйте метатег robotsДобавление метатега noindex к страницам (X)HTML запрещает Google индексировать и делать ваш контент доступным в результатах поиска.

Поместите метатег robots в раздел

выбранной страницы, например:<заголовок> (…) (…)

Значение « robots » после мета-имени указывает, что страница или запись применимы ко всем поисковым роботам. Замените « robots » на имя конкретного бота, индексацию которого вы собираетесь заблокировать, например Googlebot — поисковый робот Google. Посетители смогут найти ваш контент не в результатах поиска Google, а через другие поисковые системы, такие как Bing или Ask.com.

Замените « robots » на имя конкретного бота, индексацию которого вы собираетесь заблокировать, например Googlebot — поисковый робот Google. Посетители смогут найти ваш контент не в результатах поиска Google, а через другие поисковые системы, такие как Bing или Ask.com.

Более того, вы можете использовать несколько метатегов robots одновременно, если вы хотите указать разные поисковые роботы по отдельности. Например:

Подобно метатегу robots, вы также можете использовать HTTP-заголовок X-Robots-Tag, чтобы запретить поисковым системам индексировать контент на уровне страницы. Поместите следующий синтаксис в заголовок HTTP:

HTTP/1.1 200 ОК Дата: вторник, 25 мая 2010 г., 21:42:43 по Гринвичу (…) X-Robots-Tag: noindex (…)

Методы метатегов robots и x-robots-tag HTTP-заголовков кажутся слишком сложными для тех, у кого нет хороших навыков программирования. К счастью, Protect Pages and Posts WordPress упрощает использование метатега robots и HTTP-заголовка x-robots-tag.

К счастью, Protect Pages and Posts WordPress упрощает использование метатега robots и HTTP-заголовка x-robots-tag.

«Защита страниц и сообщений WordPress» скрывает ваш контент от индексаторов на основе того, как работают метатеги robots и HTTP-заголовки x-robots-tag.

Пользователи не могут найти ваши исходные URL-адреса контента. Вместо этого плагин автоматически генерирует уникальные частные ссылки, которые позволяют вам делиться защищенными страницами и сообщениями с другими. Вы можете настроить эти ссылки, чтобы сделать их значимыми, запоминающимися и законными.

Чтобы контент не был широко распространен среди других, срок действия частных ссылок может истечь в течение нескольких дней или кликов. Например, вы можете установить использование ссылки на один раз. Пользователи будут видеть страницу 404 после загрузки каждой страницы.

Запретить поисковым системам индексировать файлы WordPress

Существует ряд способов сделать ваши файлы невидимыми для поисковых роботов, например, редактирование файлов robots. txt, защита страниц вложений или использование плагина Prevent Direct Access.

txt, защита страниц вложений или использование плагина Prevent Direct Access.

Как упоминалось выше, файл robots.txt не препятствует индексации отдельных веб-страниц поисковыми системами. Он удерживает только медиафайлы, кроме PDF и HTML, подальше от глаз Google. Поместите следующий синтаксис в данный файл, который вы хотите исключить поисковые системы:

Агент пользователя: Googlebot-Image Disallow: /[slug]/

Обновите ярлык с конкретными URL-адресами файлов, которые вы хотите заблокировать при поиске. Вы также можете добавить символ доллара ($), чтобы заблокировать все файлы, заканчивающиеся определенной строкой URL. Например:

Агент пользователя: Googlebot Disallow: /*.xls$

Все файлы, заканчивающиеся на .xls, теперь заблокированы для индексации Google.

2. Запретить Google индексировать страницы вложений Другой способ запретить поисковым системам индексировать файлы — использовать страницы вложений.

Вложения относятся к любым типам загрузки веб-сайта, таким как изображения, видео и аудио. Как только файл загружается, WordPress создает страницу вложения, которая включает файл, а также соответствующие подписи и описания.

Вы должны запретить поисковым системам находить и ранжировать эти страницы, поскольку они содержат очень мало контента или вообще не содержат его. Эти страницы могут разочаровать посетителей, желающих найти информативные статьи.

Существуют различные способы сделать так, чтобы Google не смог проиндексировать ваши страницы вложений WordPress, либо вручную отредактировав метатег robots и HTTP-заголовок x-robots-tag, либо используя плагин Yoast SEO.

Редактирование метатега robots и HTTP-заголовка x-robots-tag для страниц вложений выполняется так же, как и редактирование метатега и HTTP-заголовка x-robots-tag для стандартных страниц. Однако этот метод кажется слишком сложным и трудоемким, если вы хотите предотвратить одновременную индексацию нескольких файлов.

Вы также можете использовать Yoast SEO, чтобы защитить ваши файлы от поисковых роботов и индексаторов Google. Активируйте плагин и выполните следующие 5 шагов:

- Перейдите к Настройки SEO в раскрывающемся списке Yoast

- Выбрать Внешний вид поиска

- Головка на Носитель Вкладка

- Включить параметр « Перенаправить URL-адреса вложений на само вложение »

- Сохраните изменения

Prevent Direct Access Gold блокирует поисковые системы от индексации ваших файлов. В отличие от метатегов robots и HTTP-заголовков x-robots-tag, плагин не требует никакого технического кодирования.

После активации плагин автоматически поместит метатег noindex в

каждой страницы вложений, чтобы отключить поисковое индексирование.

Более наглядное руководство можно найти в этом обучающем видео.

Готовы заблокировать поисковую систему от индексации вашего сайта?

Вручную запретить поисковым системам индексировать сайты, контент и файлы WordPress непросто. Нужно искать решения для упрощения процесса.

Вы можете установить Password Protect WordPress Pro, чтобы защитить весь ваш сайт от поисковых роботов. Это связано с тем, что встроенная функция чтения по-прежнему позволяет поисковым роботам заходить и индексировать ваш сайт, если на него есть ссылки с других сайтов и страниц.

Считаете редактирование метатега и HTTP-заголовка X-Robots-Tag слишком сложным? Плагин Protect WordPress Pages and Posts автоматически делает страницы и сообщения невидимыми для поисковых систем.

Плагин Prevent Direct Access Gold экономит вам много времени, отключая поисковые системы от индексации файлов WordPress и страниц вложений. Это быстрее, чем блокировать отдельные файлы с помощью метатега robots или HTTP-заголовка X-Robots-Tag.

Пожалуйста, оставьте комментарий ниже, если у вас есть какие-либо вопросы о том, как предотвратить сканирование и индексацию вашего сайта WordPress.

Удаление полного сайта из индекса Google

Задавать вопрос

спросил

Изменено 5 лет, 2 месяца назад

Просмотрено 3к раз

Я хочу удалить содержимое из индекса Google. Индекс Google включает мои веб-сайты, огромное количество страниц, проиндексированных в индексе Google около 5 000 000 страниц ранее, но теперь осталось 3 025 000 страниц. .*Googlebot/2.1.*$

переписать .* — [F,L]

.*Googlebot/2.1.*$

переписать .* — [F,L]

Контент возвращается роботу Googlebot при попытке его сканирования:

HTTP/1.1 410 Удалено

Дата: суббота, 05 января 2013 г., 12:39:23 по Гринвичу

Сервер: Apache/2.2.23 (Unix) mod_ssl/2.2.23 OpenSSL/0.9.8e-fips-rhel5

mod_fastcgi/2.4.6 mod_jk/1.2.37 mod_auth_passthrough/2.1 mod_bwlimited/

1.4 FrontPage/5.0.2.2635 PHP/5.3.19

Длина контента: 661

Подключение: близко

Тип содержимого: текст/html; кодировка = iso-8859-1

Я также использовал метатег HTML noindex , без подписки, но без эффекта:

Я также подал заявку на удаление веб-сайта, но скорость удаления содержимого очень низкая. За последние 35 дней удалено всего несколько страниц. Мой веб-сайт также удален из поискового индекса Google, но Инструменты Google для веб-мастеров — Здоровье -> Состояние индекса по-прежнему показывает 3 025 000 страниц, и если я повторно отправлю сайт, они покажут уже проиндексированные страницы. Как увеличить скорость удаления страниц?

Как увеличить скорость удаления страниц?

- Google-поисковая консоль

- google-индекс

- удаление URL

.htaccess

Я только что провел последнюю минуту, просматривая ваш сайт с моим

User-Agent, настроенным на Googlebot 2.1, и я не нажал ни одного 410. Я не эксперт по .htaccess, но вы уверены, что ваше правило .htaccess работает правильно для всего сайта?Fдолжен выдавать ошибку 403 (Запрещено), а не 410, которую выдает ваш Fetch as Googlebot.Зачем только сообщать Google, что страница запрещена, удалена или что-то в этом роде? Ваш мета-

noindexпредполагает, что вы хотите проинструктировать поисковые системы, кроме Google.

Meta Noindex

Похоже, вы указываете определенным роботам noindex , а затем отменяете это, сообщая всем роботам index :

country" content="IN">

Robots.txt

Ваш файл robots.txt на самом деле не содержит

User-Agent: * Запретить: /

как вы говорите. Он содержит

User-agent: * Запретить: /judgment_view Запретить: /платеж Запретить: /include Запретить: /search.php* Запретить: /admin

Хотя это не так уж важно, так как это только предотвратит сканирование и не удалит содержимое из индекса.

Раствор

Вы не указали точно, какова ваша цель, и это не ясно из шагов, которые вы предприняли на своем сайте, но вышеизложенное должно служить отправной точкой.

Google не удаляет страницы так быстро отчасти потому, что страницы ранжируются, и если бы они удаляли их быстро, люди бы жаловались на то, что они теряют свои рейтинги страниц из-за незамеченной ошибки. Так что это своего рода льготный период, чтобы сократить расходы.

Проблема с перенаправлениями .htaccess заключается в том, что Google может предположить, что это ошибка в HTACCESS, поэтому периодически он возвращается и проверяет снова, и если у вас много страниц, то это занимает много времени.

Кроме того, вы должны делать это на каждой странице, потому что robots.txt не всегда проверяется при сканировании, лично я бы вообще не использовал .htaccess, потому что они будут просто возвращаться и предполагать, что это ошибка. NOINDEX работает быстрее, чем robots и htaccess, но попробуйте инструмент для удаления, ссылку на который я дал выше.

Еще одним фактором является то, как Google относится к вашему сайту с точки зрения ранжирования и что он считает его скоростью. Поэтому, если вы используете VPS, увеличьте его скорость, это должно увеличить количество страниц, которые Google будет сканировать из-за того, что бот Google будет сканировать X отведенного времени, а затем уйдет независимо, и вам нужно столько сока, сколько возможный.

Продвинутым пользователям

Продвинутым пользователям txt

txt Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google;

Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google; txt.

txt. В результате страница должна пропасть из поисковой выдачи.

В результате страница должна пропасть из поисковой выдачи. txt

txt Всякий раз, когда кто-то вводит ключевое слово в строку поиска, Google находит и предоставляет результаты с наиболее релевантным содержанием из своего индекса. Эти результаты будут основаны на более чем 200 факторах, включая качество контента страницы, местоположение пользователя, язык, устройство и т. д.

Всякий раз, когда кто-то вводит ключевое слово в строку поиска, Google находит и предоставляет результаты с наиболее релевантным содержанием из своего индекса. Эти результаты будут основаны на более чем 200 факторах, включая качество контента страницы, местоположение пользователя, язык, устройство и т. д.