Как закрыть ссылки и страницы сайта от индексации? — Seo Master на vc.ru

105 просмотров

С какой целью порой может использоваться закрытие веб-сайта или каких-то его разделов, страниц от индексации поисковыми системами? Вариантов с ответами имеются несколько:

- Следует убрать от всеобщего обзора ту или иную информацию, в которой могут находиться секретные данные.

- Если нужно сформировать подходящий релевантный контент: случаются варианты, если очень сильно возникает желание сообщить пользователям Интернете больший поток информации, однако которая делает туманной релевантность по тексту.

- Закрыть от роботов дублирующий контекст.

- Спрятать информацию, которая не представляет интереса для пользователей, и которую так не любят поисковые роботы, считая ее спамом в медиа-контенте.

Например, это могут быть портфолио, материалы сайта с устаревшим смыслом, какие-то расписания в справочниках.

Способ второй

Для страницы, которую необходимо закрыть, можно в файле .htaccess прописать любой из следующих ответов сервера:

1 403 «Доступ к ресурсу запрещен», т.е. код 403 Forbidden

2 410 «Ресурс недоступен», т.е. окончательно удален

Способ третий

Можно закрыть индексацию к сайту с помощью доступа только по паролю:

В этом случае, в файле .htaccess, вставляем следующий код:

1 AuthType Basic

2 AuthName «Password Protected Area»

3 AuthUserFile /home/user/www-pass/.htpasswd

4 Require valid-user

Значит в корне сайта создаем — home/user/www-pass/.htpasswd

где .htpasswd — файл с паролем, который создаем сами в файле.

Но затем следует добавить пользователя в файл паролей htpasswd — /home/user/www-pass/.htpasswd USERNAME

где USERNAME — это имя пользователя для авторизации.

Здесь можно прописать свой вариант.

Как закрыть отдельный блог от индексации?

Зачастую бывает, что необходимо закрыть от поисковой индексации не весь сайт целиком, а только конкретный источник: список, счетчик, запись, страницу либо какой-нибудь код.

В одно время, достаточно было использовать тег «noindex», но это больше подходило для роботов Яндекса, а для Google были достаточны обычные действия.

Здесь может быть любой текст, ссылки или код

Но затем роботы Яндекс стали меньше обращать внимания на такую техническую «уловку», а роботы Google вообще перестали понимать данную комбинацию. В результате, технические специалисты сайтов, стали применять иной вариант с целью закрытия индексации части текста на какой-либо странице, используя скрипты javascript, либо соответствующие плагины или модули.

Часть текста шифруется с помощью javascript. Но следует помнить, что затем непосредственно сам скрипт нужно будет закрыть от индексации в robots.txt.

Универсальный способ закрытия изображений (медиафайлов) от индексации

Многие сайты используют картинки, которые в основном берутся из Интернета, я значит никак не могу считаться уникальными. В результате таких действий, появляется боязнь, то, что роботы поисковиков отнесутся к таким сайтам негативно, а именно будут блокировать продвижение и повышение в рейтингах.

В этом случае следует на странице сделать следующую запись в коде:

<span data-link=»https://goo.gl»><img src=»…»></span>

Скрипт, который будет обрабатывать элемент:

<script>$(‘.hidden-link’).replaceWith(function(){return'<a href=»‘+$(this).data(‘link’)+'»>’+$(this).html()+'</a>’;})</script>

Как закрыть от индексации внешние либо внутренние ссылки?

Такие действия нужно только в том случае, если нужно закрыть от индексации входящие ссылки от сайтов находящиеся под санкциями поисковых систем, а так же скрыть исходящие ссылки на сторонние ресурсы, чтобы предотвратить уменьшение веса сайта, а именно ТИЦ сайта донора.

Для этого нужно создать файл transfers.js

После этого нижеуказанную часть кода вставляем в файл transfers.js:

function goPage(sPage) {

window.location.href = sPage;

}

После этого данный файл уже размещаем в соответствующей папке сайта и на странице в head добавляем код:

<script type=»text/javascript» src=»/js/transfers. js»></script>

js»></script>

И теперь прописываем необходимую ссылку, которую нужно скрыть от индексации поисковых систем:

<a href=»javascript:goPage(‘http://указываем URL/’)»></a>

Как закрыть от индексации роботов отдельную страницу на сайте?

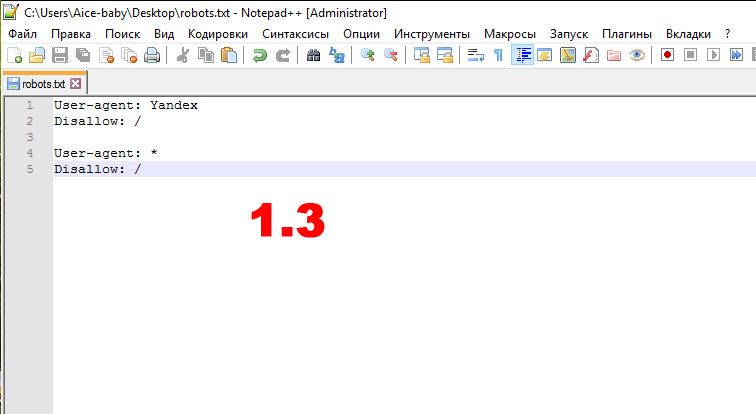

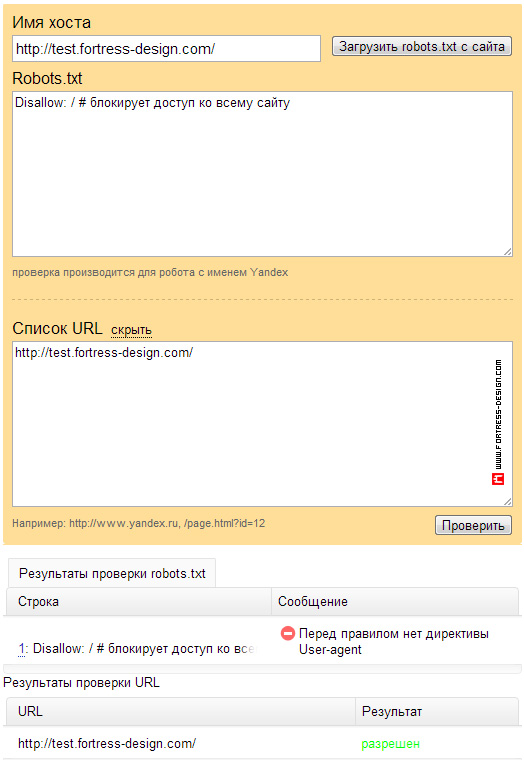

Первый метод — через файл robots.txt

</pre>

Disallow: /URL-страницы сайта

<pre>

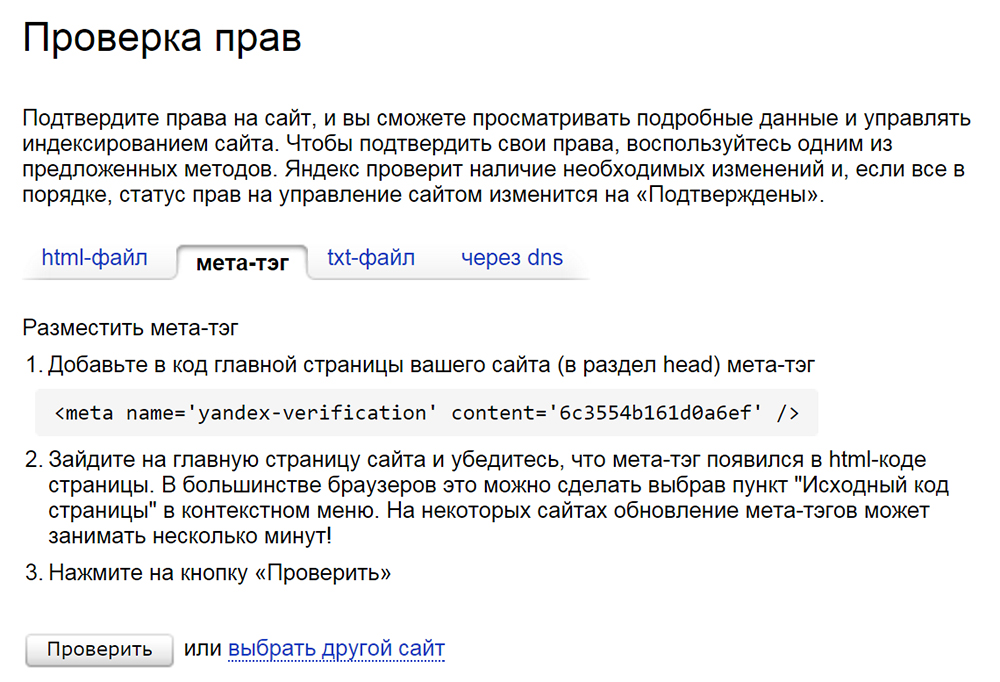

Второй метод — закрытие с помощью метатегов

<meta name=»robots» content=»noindex, nofollow» />

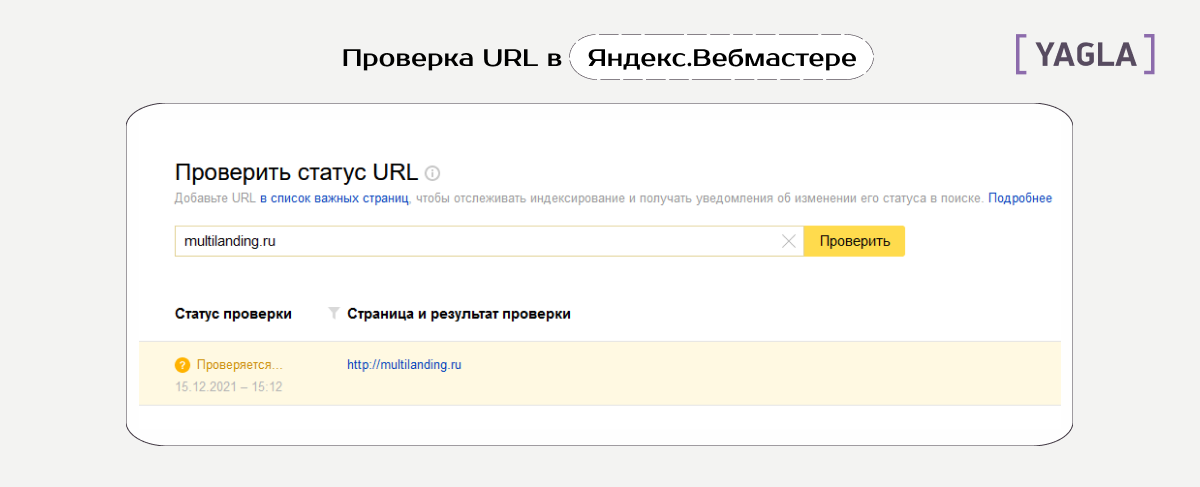

Третий метод — в Вебмастере Яндекса, в разделе «Инструменты» с помощью «Удалить URL» можно отдельно по каждой ссылке сделать запрет на индексацию от роботов Яндекса.

Четвертый метод — сделать запрет на индексацию через ответ сервера:

404 — ошибка страницы

410 — страница удалена

И сделать добавление в файле .htaccess:

ErrorDocument 404 https://URL-сайта/404

Однако, данным метод используется весьма редко.

Как закрыть от индексации сразу весь раздел или категорию на сайте?

Лучший способ — реализовать это с помощью файла robots. txt, где внутри прописать:

txt, где внутри прописать:

User-agent: *

Disallow: /название раздела или категории

Дополнительные варианты:

Кроме указанных выше способов, также могут подойти способы, которые применяются для сокрытия страницы сайта целиком, либо какого-то раздела, — правда, если подобные действия могут быть сделаны автоматически:

- соответствующий ответ сервера для определенных страниц раздела сайта

- применение мета-тегов к определенным страницам

Все эти без исключения методы, возможно, осуществить программно, а никак не в «ручном» режиме назначать к любой страничке или части текста запрет на индексацию – весьма дороги трудовые затраты.

Конечно, ведь легче в целом сделать соответствующее запрещение в файле robots.txt, однако практика показывает, то что это не может гарантировать на 100% запрет на индексацию.

Как закрыть от индексации целиком папку?

В этом случае на закрытие пойдет непосредственно папка, а не раздел.

User-agent: *

Disallow: /folder/

Как правильно закрыть сайт от индексации Google и Яндекс

Добро пожаловать на вебсайт Sitexpert (далее — «Вебсайт»). Выражения «мы», «нам», «наше», и Sitexpert относятся к Sitexpert и его собственникам. Выражение «Вы» относится к пользователю, который использует Вебсайт для получения информации о рейтинге своего сайта в Интернете.

Используя этот Вебсайт в любой форме Вы подтверждаете, что обязуетесь соблюдать данные Правила. Если Вы не принимаете данные Правила — не используйте Вебсайт. Мы оставляем за собой право в любое время, на наше усмотрение, менять или дополнять Правила без предварительного предупреждения, а Ваше последующее использование Вебсайта означает Ваше принятие Правил.

Данный Вебсайт позволяет Вам получить информацию о том на каком месте находится Ваш сайт в той или иной поисковой системе по тем запросам, которые Вы укажите.

1. Использование Вебсайта

1.1. Используя данный Вебсайт, Вы подтверждаете что:

1.2. Вы достигли 18-летнего возраста.

1.3. У вас есть юридические полномочия давать и принимать правовые обязательства.

1.4. Вы будете использовать этот Вебсайт согласно Правил.

1.5. Пользователь Вебсайта, размещая на Вебсайте информацию, добровольно предоставляет нам, а также третьим лицам, которые имеют доступ к этому Вебсайту, свое безусловное согласие на обработку своих персональных данных (которые содержатся в информации, собранной и/или размещаемой на Вебсайте и/или отправляемой другим Пользователям Вебайта).

1.6. Вы соглашаетесь с тем, что мы имеем право присылать на указанный Вами при регистрации e-mail и/или мобильный телефон информационные сообщения в т.ч. и рекламного характера.

1.7. Вы соглашаетесь с тем, что мы предоставляем данные услуги на безоплатной основе и в любое время без Вашего согласия можем установить оплату.

1. 8. Вы соглашаетесь с тем, что мы неограничены во времени по обработке и предоставлению отчета по Вашему запросу.

8. Вы соглашаетесь с тем, что мы неограничены во времени по обработке и предоставлению отчета по Вашему запросу.

1.9. Вы соглашаетесь с тем, что данные полученные по Вашему запросу могут быть неточными в связи с сбоями в работе поисковых систем на которых тестировался Ваш сайт.

2. Отказ от гарантий

Вы понимаете, следующее (за исключением случаев, которые запрещены законом):

2.1. Использование вами вебсайта и/или услуг осуществляется исключительно на ваш риск. Сайт и услуги предоставляются на условиях «как есть» и «как доступно». Мы отрицаем любого вида гарантии, включая, но не ограничиваясь, гарантиями товарности, пригодности для конкретной цели и неиспользования.

2.2. Мы не даем никаких гарантий, что:

a) вебсайт или услуги будут соответствовать вашим требованиям;

b) вебсайт или услуги будут предоставляться непрерывно, своевременно, безопасно, или без ошибок;

c) результаты, которые могут быть получены посредством использования вебсайта или услуг, будут точными и надежными;

d) качество любых продуктов, служб, информации или других материалов, полученных вами через вебсайт или услуги, будет соответствовать вашим ожиданиям, и

e) ошибки в программном обеспечении будут исправлены, или, что любая часть сайта будет без вирусов, червей, троянских коней и.

т.д. ;

f) любой материал, загруженный или иным образом полученный посредством использования вебсайта или обслуживания, осуществляется на ваше собственное усмотрение и, что только вы будете нести ответственность за любой ущерб, нанесенный вашему компьютеру, или утерю данных в результате загрузки любых таких пользований;

g) никакая консультация или информация, письменная или устная, полученная вами от нас не предусматривает никаких гарантий, прямо не указанных в правилах.

3. Ограничение ответственности

3.1. Вы понимаете и согласны с тем, что sitexpert, ее должностные лица, директора, сотрудники, агенты, юристы, спонсоры, рекламодатели, филиалы, правопреемники («мы»), не являются ответственными за любые штрафные убытки, включая, но не ограничиваясь, убытками от потери прибыли, репутации, использования данных и других нематериальных убытков, в результате:

a) использования или невозможности использования вебсайта;

b) несанкционированного доступа или изменения ваших сообщений или данных;

c) заявлений любого третьего лица на вебсайте или услугах;

d) любых других вопросов, относящихся к вебсайту.

3.2. Если вы недовольны вебсайтом или нормами правил или у вас возникают еще какие-либо споры или разногласия с sitexpert, то вашим единственным и исключительным правом правовой защиты будет прекращение использование вебсайта.

4. Общая информация

4.1. Настоящие Правила являются соглашением между Вами и собственниками Sitexpert и регламентирует использование Вами Вебсайта, заменяя собой любые предыдущие соглашения между Вами и Sitexpert. На вас также могут распространяться дополнительные положения и условия, которые могут применяться при использовании сопутствующих услуг, содержания третьей стороны или программного обеспечения других производителей. Данные правила, а также взаимоотношения между вами и Sitexpert регулируются законодательством Украины. Вы и Sitexpert соглашаетесь подчиняться личной и исключительной юрисдикции судов, расположенных по месту нахождения ответчика, если иное не предусмотрено законодательством Украины. Вы признаете, что Sitexpert вправе принимать правовые меры против Вас, если ваши действия нарушают данные Правила или идут в ущерб Sitexpert.

Вы признаете, что Sitexpert вправе принимать правовые меры против Вас, если ваши действия нарушают данные Правила или идут в ущерб Sitexpert.

4.2. Вы подтверждаете, что Вы прочитали, поняли и соглашаетесь с данными Правилами.

5. Нарушения

Пожалуйста, сообщайте о любых нарушениях настоящих Правил нашей службе поддержки или по электронной почте.

Как запретить поисковым системам индексировать ваш сайт в 2021 году

Для многих веб-сайтов поисковые системы являются крупнейшим источником трафика. Из-за этого, когда кто-то спрашивает, «как запретить поисковым системам индексировать этот сайт», вы, вероятно, задаетесь вопросом, зачем им это делать. Давайте рассмотрим некоторые из этих причин сегодня.

Распространенные причины блокировки контента от поисковых систем

Многие люди думают, что если другие веб-сайты не ссылаются на ваш домен, поисковые системы не смогут найти ваш сайт. Даже если это так, вот несколько способов найти ваш сайт:

- Кто-то ранее владел вашим доменом и все еще имеет ссылки, указывающие на сайт.

- Результаты поиска по домену могут быть проиндексированы с вашей ссылкой на них.

- Веб-страницы, содержащие список имен сайтов, включая ваше.

И вот несколько причин, по которым вы можете подумать о том, как запретить поисковым системам индексировать этот ваш сайт:

- (Намеренно) дублировать контент. Важность отсутствия дублированного контента невозможно переоценить; это штраф Google, из-за которого ваш сайт может быть деиндексирован поисковым гигантом. Если есть необходимость опубликовать дублированный контент (например, рекламный лендинг), рассмотрите возможность добавления канонической ссылки на рассматриваемую страницу. Если вы оказались в ситуации, когда вам нужно опубликовать весь веб-сайт с дублирующимся контентом, лучше всего определить, как запретить поисковым системам индексировать этот сайт (все это).

- Создание веб-сайта для разработки или тестирования. Перед запуском новой темы WordPress лучше всего создать копию текущего веб-сайта для работы в целях разработки.

Никакого ковбойского кодирования!. Вы же не хотите, чтобы дубликат вашего веб-сайта конкурировал с вами за ранжирование или полностью разрушал ваши шансы на ранжирование.

Никакого ковбойского кодирования!. Вы же не хотите, чтобы дубликат вашего веб-сайта конкурировал с вами за ранжирование или полностью разрушал ваши шансы на ранжирование. - Частный контент. Если у вас есть членский сайт, вы не хотите, чтобы платный контент индексировался поиском — он предназначен только для платных участников!

- Динамический контент . Если у вас есть контент, который часто меняется, вы хотите запретить поисковым системам индексировать контент, который может скоро устареть. Поисковым системам требуется некоторое время для индексации обновленного контента, поэтому, если ваш сайт меняется слишком быстро, чтобы поисковая система успевала за ним, лучше запретить поисковым системам индексировать уже устаревший контент.

Наша команда WP Buffs помогает владельцам веб-сайтов, агентствам-партнерам и партнерам-фрилансерам управлять индексацией своих сайтов. Если вам нужно, чтобы мы управляли 1 веб-сайтом или поддерживали 1000 клиентских сайтов, мы вас поддержим.

Как запретить поисковым системам индексировать ваш сайт

Есть несколько способов предотвратить индексацию вашего сайта, но сначала давайте проясним, что на самом деле означает .

Многие люди не понимают, чем веб-сайты, «включенные в список», отличаются от веб-сайтов, которые «индексируются» в Google. Вот как это выглядит:

- Индексирование : описывает процесс загрузки содержимого сайта на сервер поисковой системы для добавления в его индекс. Проверьте, проиндексирован ли ваш сайт, набрав site: url (где «url» — адрес вашего веб-сайта). Вы увидите, сколько ваших страниц проиндексировано. Если вы обнаружите, что ваш сайт проиндексирован, это, как правило, считается хорошей новостью. Это означает, что поисковые системы могут сканировать ваш сайт, чтобы найти контент. Поисковым системам требуется от недели до четырех недель, чтобы обновить результаты поиска, поэтому есть вероятность, что ваш веб-сайт еще не отображается/не ранжируется.

- Рейтинг/Листинг/Показ : Ваш веб-сайт появляется на страницах результатов поисковой системы. Поскольку ваш сайт отображается в поисковой выдаче (страницы результатов поисковой системы), это означает, что ваш сайт есть.

В двух словах, рейтинг означает, что ваш сайт проиндексирован , но индексация вашего сайта не означает автоматически, что он будет ранжироваться/показываться в поисковой выдаче.

Обратите внимание, что сайт не обязательно должен находиться в списке для индексации.

Теперь ответ на вопрос «Как запретить поисковым системам индексировать этот сайт»?

Есть несколько способов добиться успеха, если вы не хотите, чтобы Google индексировал ваш сайт:

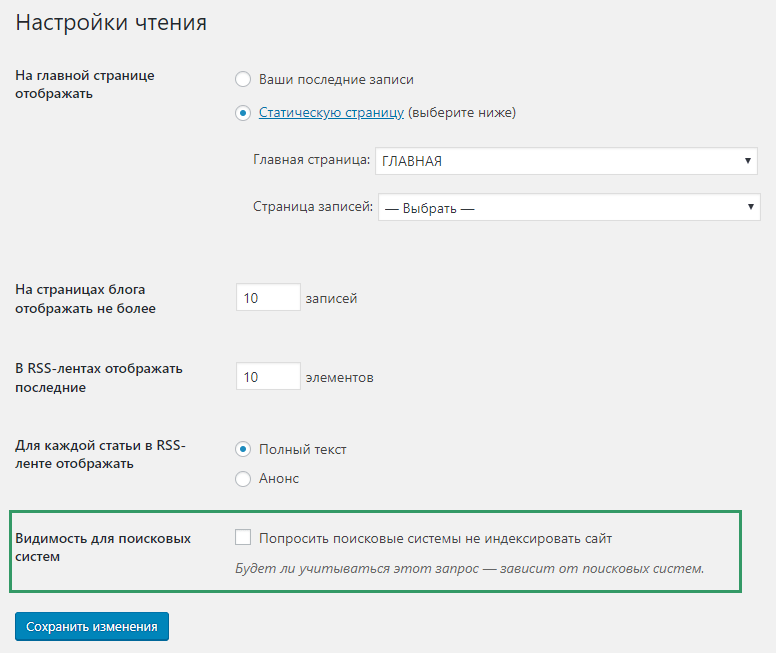

1. Флажок видимости поисковой системы WordPress

Вы можете запретить поисковым системам индексировать ваш веб-сайт с помощью панели управления WordPress.

Перейдите в админку WordPress. Выберите Настройки > Чтение:

Выберите Настройки > Чтение:

Перейдите к опции Видимость в поисковых системах и там вы увидите флажок Видимость в поисковых системах WP. Идите вперед и установите флажок Запретить поисковым системам индексировать этот сайт . Обязательно нажмите Сохранить изменения .

Вот как это работает:

WordPress редактирует файл robots.txt и добавляет в заголовок вашего веб-сайта строку, запрещающую поисковым системам индексировать ваш веб-сайт, например:

Обратите внимание, что хотя большинство поисковых систем учитывают этот запрос, некоторые поисковые системы могут игнорировать его. Даже после этого может быть несколько страниц и особенно изображений с вашего веб-сайта, которые все еще могут отображаться как проиндексированные.

2. Редактирование файла Robots.

txt

txtРеализуя первый вариант запрета поисковым системам индексировать этот сайт, WordPress позаботится об редактировании файла robots.txt за вас.

Другой вариант? Отредактируйте файл robots.txt вручную!

Вот как:

Получите доступ к файлам вашего веб-сайта через файловый менеджер или FTP-клиент и найдите robots.txt 9файл 0025. Обычно он находится в той же папке, что и WordPress, в файле public_html . Если файла robots.txt нет, создайте новый пустой.

Затем введите следующий синтаксис, который предотвратит сканирование вашего сайта поисковыми системами:

Агент пользователя: *

Disallow: /

индексация вашего сайта заключается в защите его паролем, так как поисковые системы и поисковые роботы

не имеют доступа к защищенным паролем веб-сайтам.Для этого вы можете использовать cPanel или плагин защиты паролем.

Использование cPanel

Большинство веб-хостов используют cPanel для управления вашей учетной записью хостинга.

Чтобы защитить паролем свой веб-сайт через cPanel, сначала войдите в панель инструментов cPanel и перейдите к Защитить паролем каталоги .

Затем выберите каталог, который вы хотите защитить. Для WordPress он обычно находится в папка public_html или каталог www .

Выберите параметр P asword Защитить этот каталог , выберите имя каталога, который хотите защитить, и сохраните его.

После этого создайте учетную запись пользователя, которая сможет получить доступ к защищенному каталогу. Укажите имя пользователя и пароль, затем сохраните.

Использование плагина для защиты паролем

Существует также несколько плагинов для WordPress, которые позволяют защитить ваш сайт паролем.

Как скажет вам любой хороший разработчик WordPress, добавление плагинов для исправления мелких проблем может принести больше вреда, чем пользы. Каждый новый плагин может негативно повлиять на скорость загрузки страницы и создать новые уязвимости в системе безопасности. Когда это возможно, рассмотрите один из предыдущих вариантов, чтобы запретить поисковым системам индексировать этот сайт.

Каждый новый плагин может негативно повлиять на скорость загрузки страницы и создать новые уязвимости в системе безопасности. Когда это возможно, рассмотрите один из предыдущих вариантов, чтобы запретить поисковым системам индексировать этот сайт.

Если вы не очень хорошо разбираетесь в бэкенде вашего сайта WordPress, рассмотрите следующие плагины:

Вот некоторые из лучших вариантов.

- Защищено паролем . Простой плагин, позволяющий защитить ваш сайт WordPress одним паролем. Обратите внимание, что этот плагин защищает только контент вашего сайта WordPress, а не ваши изображения и загруженные файлы . Если кто-то введет точный URL-адрес файла изображения, он все равно будет доступен для них при использовании этого плагина.

- iThemes. iThemes Security — это надежный плагин безопасности, который делает гораздо больше, чем защищает ваши пароли. Мы знаем из первых рук, учитывая, что мы сотрудничаем с ними! Воспользуйтесь преимуществами таких функций, как принудительный безопасный пароль, защита от грубой силы, обнаружение изменений файлов, резервное копирование базы данных и многое другое.

- Скрыть мой сайт . Этот плагин позволяет вам использовать один пароль для защиты вашего сайта WordPress и блокирует пользователей, пытающихся войти в систему несколько раз.

Удаление проиндексированного веб-сайта из Google

Если ваш веб-сайт уже был проиндексирован и вы хотите удалить его из поисковых систем, не беспокойтесь. Еще не поздно.

Чтобы удалить проиндексированный веб-сайт из Google, вам необходимо сначала настроить Google Search Console.

После настройки перейдите на недавно добавленный веб-сайт и нажмите Индекс Google > Удалить URL-адреса .

Введите URL веб-страницы, которую вы хотите удалить, и нажмите Продолжить .

Выберите Временно скрыть страницу из результатов поиска и удалить из кеша и нажмите Отправить запрос .

Это временно удаляет URL-адрес из результатов поиска (около 90 дней). Если вы планируете препятствовать индексации этого сайта поисковыми системами, лучше всего и применяют любой из более постоянных методов, описанных выше.

Если вы планируете препятствовать индексации этого сайта поисковыми системами, лучше всего и применяют любой из более постоянных методов, описанных выше.

Полное разрешение Google индексировать ваш сайт

Хотя могут быть причины, по которым вы не хотите, чтобы Google сканировал и индексировал страницы и сообщения вашего веб-сайта, может наступить момент, когда вы передумаете.

Чтобы убедиться, что Google разрешено индексировать ваши веб-сайты, вам не нужно вносить никаких серьезных изменений после публикации контента на вашем веб-сайте. Google автоматически просканирует эти страницы и проиндексирует их.

Однако, если у вас возникли проблемы с индексацией ваших страниц в Google, вы можете выполнить все шаги, которые мы только что прошли, чтобы деиндексировать ваш веб-сайт и убедиться, что ни один из них не активен. Если это так, возможно, вы мешаете Google индексировать ваш сайт, даже если вы этого не хотите.

Заключительные мысли: как запретить поисковым системам индексировать этот сайт

В то время как большинство людей приветствует трафик поисковых систем на свои веб-сайты WordPress, есть и другие, которым может потребоваться скрыть весь свой веб-сайт. Конечно, есть много разных причин, по которым нужно запретить индексацию контента поисковыми системами, такими как Google.

Конечно, есть много разных причин, по которым нужно запретить индексацию контента поисковыми системами, такими как Google.

К счастью, существует множество различных тактик, которые вы можете использовать, чтобы найти ответ на вопрос: «Как помешать поисковым системам индексировать этот сайт?» От работы с внутренними файлами вашего веб-сайта до простого нажатия кнопки или использования плагина — вам, честно говоря, не нужно быть веб-разработчиком, чтобы решить эту проблему самостоятельно.

Хотите оставить отзыв или присоединиться к беседе? Добавляйте свои комментарии 🐦 в Twitter.

СохранитьСохранить

СохранитьСохранить

Если вам понравилась эта статья, то вам действительно понравится круглосуточное управление веб-сайтом WordPress и услуги поддержки, которые может предложить WP Buffs! Станьте партнером команды, которая предлагает все аспекты премиальных услуг поддержки WordPress.

От услуг по оптимизации скорости до неограниченного редактирования веб-сайтов, безопасности, круглосуточной поддержки и даже управления сайтами по принципу «белой этикетки» для агентств и фрилансеров — наши опытные инженеры окажут вам поддержку. Пригласите нас в свою команду, чтобы сделать ваш сайт Bufftastic! Ознакомьтесь с нашими планами

Пригласите нас в свою команду, чтобы сделать ваш сайт Bufftastic! Ознакомьтесь с нашими планами

Как не допустить индексации промежуточного сайта или сайта разработки

Одной из наиболее распространенных технических проблем SEO, с которыми я сталкиваюсь, является непреднамеренное индексирование серверов разработки, промежуточных сайтов, рабочих серверов или любого другого имени, которое вы используете.

Это происходит по ряду причин: от людей, которые думают, что никто никогда не будет связываться с этими областями, до технических недоразумений. Эти части веб-сайта обычно носят конфиденциальный характер, и их включение в индекс поисковой системы может привести к раскрытию запланированных кампаний, бизнес-аналитики или личных данных.

Как определить, индексируется ли ваш сервер разработки

Вы можете использовать поиск Google, чтобы определить, индексируется ли ваш промежуточный сайт. Например, чтобы найти промежуточный сайт, вы можете выполнить поиск в Google по запросу site:domain. com и просмотреть результаты или добавить такие операторы, как -inurl:www, чтобы удалить все URL-адреса www.domain.com. Вы также можете использовать сторонние инструменты, такие как SimilarWeb или SEMrush, для поиска субдоменов.

com и просмотреть результаты или добавить такие операторы, как -inurl:www, чтобы удалить все URL-адреса www.domain.com. Вы также можете использовать сторонние инструменты, такие как SimilarWeb или SEMrush, для поиска субдоменов.

Могут быть и другие конфиденциальные области, содержащие порталы входа или информацию, не предназначенную для публичного использования. В дополнение к различным операторам поиска Google (также известным как Google Dorking), веб-сайты, как правило, блокируют эти области в своих файлах robots.txt, сообщая вам, где именно вам не следует искать. Что может быть не так, если вы сообщите людям, где найти информацию, которую вы не хотите, чтобы они видели?

Есть много действий, которые вы можете предпринять, чтобы не допустить посетителей и поисковых систем к серверам разработки и другим конфиденциальным областям сайта. Вот варианты:

Хорошо: HTTP-аутентификация

Все, что вы хотите убрать из индекса, должно включать аутентификацию на стороне сервера. Требование аутентификации для доступа является предпочтительным методом защиты от пользователей и поисковых систем.

Требование аутентификации для доступа является предпочтительным методом защиты от пользователей и поисковых систем.

Хорошо: белый список IP-адресов

Разрешение только известных IP-адресов, например принадлежащих вашей сети, клиентов и т. д., — это еще один важный шаг в обеспечении безопасности вашего веб-сайта и гарантии того, что только те пользователи, которым необходимо видеть область веб-сайта, будут вижу это.

Возможно: Noindex в robots.txt

Noindex в robots.txt официально не поддерживается, но может сработать для удаления страниц из индекса. Моя проблема с этим методом заключается в том, что он по-прежнему указывает людям, куда им не следует смотреть, и может не работать вечно или не со всеми поисковыми системами.

Причина, по которой я говорю «может быть», заключается в том, что это может работать и на самом деле может быть объединено с запретом в robots.txt, в отличие от некоторых других методов, которые не работают, если вы запрещаете сканирование (о чем я расскажу позже). в этой статье).

в этой статье).

Возможно: Теги Noindex

Тег noindex либо в метатеге robots, либо X-Robots-Tag в заголовке HTTP может помочь предотвратить попадание ваших страниц в результаты поиска.

Одна проблема, которую я вижу в этом, заключается в том, что это означает, что поисковые системы будут сканировать больше страниц, что съедает ваш краулинговый бюджет. Я обычно вижу, что этот тег используется, когда в файле robots.txt также есть запрет. Если вы просите Google не сканировать страницу, они не смогут соблюдать тег noindex, потому что не видят его.

Другая распространенная проблема заключается в том, что эти теги могут быть применены к промежуточному сайту, а затем оставлены на странице, когда она будет запущена, фактически удаляя эту страницу из индекса.

Возможно: Canonical

Если у вас есть канонический набор на промежуточном сервере, который указывает на ваш основной веб-сайт, практически все сигналы должны быть правильно объединены. В содержании могут быть несоответствия, которые могут вызвать некоторые проблемы, и, как и в случае с тегами noindex, Google придется сканировать дополнительные страницы. Веб-мастера также имеют тенденцию добавлять запрет в файл robots.txt, поэтому Google лишний раз не может просканировать страницу и не может соблюдать каноничность, потому что не может ее видеть.

Веб-мастера также имеют тенденцию добавлять запрет в файл robots.txt, поэтому Google лишний раз не может просканировать страницу и не может соблюдать каноничность, потому что не может ее видеть.

Вы также рискуете, что эти теги не изменятся при переходе с рабочего сервера на рабочий, что может привести к тому, что тот, который вы не хотите показывать, будет канонической версией.

Плохо: ничего не делать

Ничего не делать для предотвращения индексации промежуточных сайтов, как правило, потому, что кто-то предполагает, что никто никогда не будет ссылаться на эту область, поэтому ничего делать не нужно. Я также слышал, что Google просто «выяснит это», но обычно я не доверяю им свои проблемы с дублирующимся контентом. Не могли бы вы?

Плохо: Запретить в robots.txt

Вероятно, это самый распространенный способ, которым люди пытаются предотвратить индексацию промежуточного сайта. Директивой disallow в robots.txt вы говорите поисковым системам не сканировать страницу, но это не мешает им индексировать страницу. Они знают, что в этом месте существует страница, и все равно будут показывать ее в результатах поиска, даже не зная точно, что там находится. У них есть подсказки из ссылок, например, о типе информации на странице.

Они знают, что в этом месте существует страница, и все равно будут показывать ее в результатах поиска, даже не зная точно, что там находится. У них есть подсказки из ссылок, например, о типе информации на странице.

Когда Google индексирует заблокированную для сканирования страницу, в результатах поиска обычно отображается следующее сообщение: «Описание этого результата недоступно из-за файла robots.txt этого сайта».

Если вы помните, эта директива также запрещает Google видеть другие теги на странице, такие как теги noindex и canonical, потому что она вообще не позволяет им видеть что-либо на странице. Вы также рискуете не забыть удалить этот запрет при запуске веб-сайта, что может помешать сканированию при запуске.

Что делать, если вы случайно проиндексировали что-то?

Сканирование может занять некоторое время в зависимости от важности URL-адреса (вероятно, низкой в случае промежуточного сайта). Повторное сканирование URL-адреса может занять несколько месяцев, поэтому любая блокировка или проблема могут не обрабатываться в течение длительного времени.

т.д. ;

т.д. ;

Никакого ковбойского кодирования!. Вы же не хотите, чтобы дубликат вашего веб-сайта конкурировал с вами за ранжирование или полностью разрушал ваши шансы на ранжирование.

Никакого ковбойского кодирования!. Вы же не хотите, чтобы дубликат вашего веб-сайта конкурировал с вами за ранжирование или полностью разрушал ваши шансы на ранжирование.