Для чего нужен поддомен сайта и как его создать?

Содержание

- Когда появляется необходимость в создании поддоменов?

- Создавать поддомены или нет?

- Секреты успешного поискового продвижения поддоменов

- Как создают поддомены

- Как закрыть поддомены от индексации

- Как найти все поддомены сайта

Вы, наверное, замечали, что страницы некоторых сайтов имеют необычные УРЛы. Стандартную конструкцию по типу «название сайта.ru» может предварять дополнительный набор символов. Именно здесь — перед указанием доменной зоны (в нашем примере это .ru) и домена второго уровня (название сайта) — указывается имя поддомена. Зачем создают поддомены? Когда можно без них обойтись? Как их успешно продвигать? Отвечаем на эти и другие вопросы в данной статье.

Если говорить коротко, то поддомен — это домен, представляющий собой часть домена более высокого уровня. Обычно при размещении сайта папка субдомена находится в папке самого домена. Однако, если есть такая необходимость, домен и поддомен возможно привязать к разным папкам.

Обычно при размещении сайта папка субдомена находится в папке самого домена. Однако, если есть такая необходимость, домен и поддомен возможно привязать к разным папкам.

Поддомены понадобятся:

- Если сайт продвигается в высоконкурентных нишах, SEO-специалисту приходится иметь дело с огромным списком ключевых запросов, которые никак не умещаются на одной главной странице. Тогда на выручку приходят поддомены — с их помощью можно создать несколько вариантов главных страниц. А затем продвигать каждую отдельно. В связи с тем, что каждый субдомен продвигается по своим ключевым словам, с помощью данного инструмента удаётся расширить представление ресурса в поисковиках и рассказать о вашем бизнесе максимальному количеству пользователей. Кроме того, вы сможете вывести товары или услуги на локальные рынки.

- Через сайт могут продавать товары из совершенно разных категорий и сфер. Чтобы как-то разделить их, используют поддомены.

Например, Wildberries для подборки своих цифровых товаров создал поддомен https://digital.wildberries.ru/.

В данном случае наличие поддоменов делает навигацию более четкой и удобной для пользователей. - Поддомены — отличное решение для сайтов со сложной структурой, ориентированной на разные группы пользователей. Это доказывает Ozon. У сайта компании есть поддомены специально для тех,

- кого интересует, как открыть Ozon Счёт и получать дополнительные скидки на маркетплейсе — https://finance.ozon.ru/?perehod=headernew;

- кто хочет «зарабатывать с Ozon» — https://business.ozon.ru/?perehod=header;

- кто хочет «продавать с Ozon» — https://seller.ozon.ru.

-

Если компания работает сразу в нескольких регионах страны, то для неё могут создать так называемые региональные поддомены. Для каждого представительства — свой. Так удается избежать проблем с ранжированием в Яндексе.

Мы часто предлагаем подобное решение своим клиентам. Например, крупному поставщику товаров для шитья — компании СТАРТЕКС. Компания работает с покупателями со всей страны. Смотрите, сколько поддоменов у её сайта.

Например, поддомен для Омска имеет вид https://omsk.star-tex.ru, для Сургута — https://surgut.star-tex.ru/ и т.д.

А вот другой клиент Студии ЯЛ, который также решил, учтя наш совет, обзавестись поддоменами.

Компания «Сибсвет» имеет представительства в 25 городах. Именно столько поддоменов отображаются в навигации по основному сайту.

С основного сайта пользователь может легко выбрать интересующий его город и перейти на соответствующий региональный поддомен.

Поддомен может выступать в роли площадки, на которой будет размещён дополнительный контент, лишь косвенно относящийся к основному сайту. Сюда помещают блоги, форумы, различные каталоги и личные кабинеты.

Например, компания Ingate под свой блог об интернет-маркетинге создала поддомен https://blog.ingate.ru.

Переходя с сайта банка ВТБ в раздел ВТБ онлайн, вы попадаете на страницу https://online.vtb.ru/login.

Также поддомены могут служить для размещения мобильной версии сайта.

Скажем честно, поддомены — это не универсальный инструмент. Они нужны далеко не всем. Например, компании, сайт которой имеет много однообразных разделов, тематически связанных друг с другом, разумнее задействовать традиционную структуру. То есть работать над увеличением числа разделов. В данном случае бессмысленно заниматься созданием поддоменов.

Кроме того, учтите, что в случае работы с субдоменами вам придётся столкнутся со следующими трудностями:

- На каждый поддомен нужно подтверждать права Вебмастера в Google и Яндексе.

В случае с разделами это не требуется. Кроме того, создавать разделы проще, чем поддомены. Ведь, грубо говоря, это просто папки, расположенные на сервере;

В случае с разделами это не требуется. Кроме того, создавать разделы проще, чем поддомены. Ведь, грубо говоря, это просто папки, расположенные на сервере; - Помните, что количество поддоменов лимитировано — это зависит от возможностей сервера;

- Если вы решились на создание субдоменов, вам понадобятся знания в области перелинковки. Это необходимо, чтобы передать вес от основного домена к поддоменам.

- Есть небольшая доля риска, что поисковые системы признают основной сайт и поддомены аффилиатами и наложат на них соответствующие санкции. Чтобы избежать этого, нужно каждому субдомену прописать регион в Яндекс.Вебмастере.

Нужно всегда помнить, что основной сайт или сайты, созданные на поддоменах, являются разными ресурсами. Поэтому и продвигать их нужно отдельно.

И еще один значимый факт: имена поддоменов не должны содержать более 63 символов. А уровней поддоменов не должно быть больше 127.

- В панели Вебмастеров каждый поддомен лучше добавлять отдельно. Так вы в будущем будете иметь доступ к данным каждого сайта и сможете для каждого проводить персональный мониторинг.

- Если вы собираетесь работать с субдоменами, учтите, что для каждого из них придётся выстраивать свой ссылочный профиль. Ведь поддомены не берут на себя ссылочный профиль основного домена.

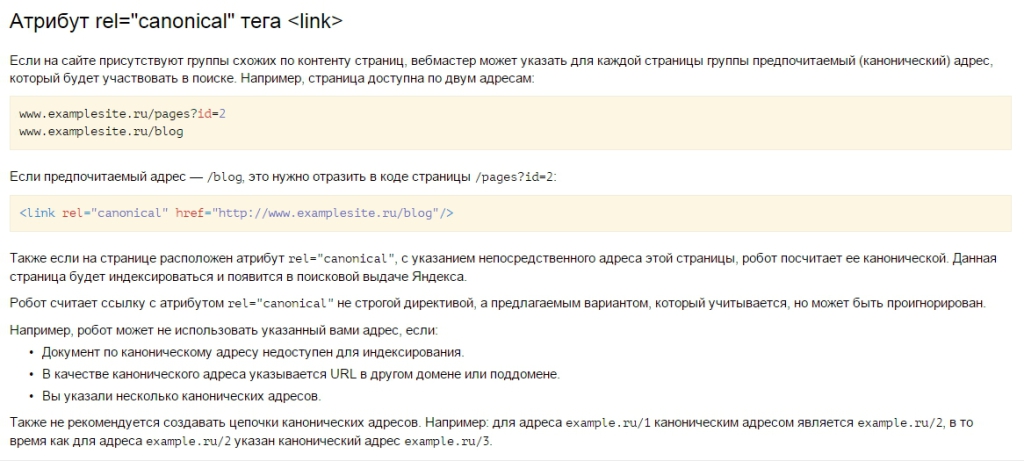

- Контент на основном сайте и на поддоменах должен отличаться. Иначе поисковики примут страницы с одинаковым контентом за дубли. Однако бывает так, что текстовая часть должна быть одинаковой на нескольких субдоменах. В таком случае не поленитесь прописать метатег rel=»canonical», который поможет вам обозначить каноническую страницу.

Не допускайте того, чтобы сайты домена и субдоменов продвигались по одному и тому же семантическому ядру. Это чревато возникновением между ними конкуренции и даже наложением на сайт фильтра от поисковых систем.

При этом визуально поддомены и основной сайт должны быть похожи (пусть и не всегда идентичны), связаны общим дизайном.

Контент карточек товаров в интернет-магазине можно сделать уникальным следующим образом:

- Прописать в названии товара регион или город;

- В блоке о доставке или на специальной странице уточнить условия работы в конкретном регионе;

- В блоке, где должны быть прописаны контакты, или на отдельной странице публикуем региональные номера телефона, адреса;

- Цены на товары могут различаться в зависимости от региона;

- Расположенный в карточке товаров блок с отзывами можно наполнить комментариями покупателей, заказавших товар в конкретном регионе.

Чтобы посмотреть, как это реализуется в реальной жизни, давайте сравним, как выглядят главные страницы на двух разных поддоменах СТАРТЕКС — для Нижнего Новгорода и для Барнаула.

Для каждого поддомена написан свой уникальный контент с включением названия города. Вот так выглядит текст на главной странице нижегородского поддомена.

А это уже барнаульский вариант.

На каждом поддомене размещены свои контактные данные в футере.

- Настройте с основного домена ссылки на субдомены.

- Анкоры ссылок, которые переводят пользователей с сайта домена на поддомены, должны содержать ключевые слова из семантики субдомена.

- Также нужно продумать логику интерфейса внутри сайта поддомена. Например, кликая на логотип, посетитель должен переходить на главную страницу сайта поддомена, а не домена.

- Подключить для каждого сайта субдомена отдельный файл robots.

txt. Для всех интересующихся мы подготовили полезную статью о том, что представляет собой файл robots.txt, из чего состоит и как его проверить.

txt. Для всех интересующихся мы подготовили полезную статью о том, что представляет собой файл robots.txt, из чего состоит и как его проверить. - Создать для каждого сайта файлы XML-карты, а в будущем их регулярно обновлять.

- Настроить линковку между сайтом домена и сайтами поддоменов. Это эффективно с точки зрения повышения скорости индексации. Кроме того, обеспечивает сбалансированное разделение веса между страницами.

- Возможно, для каждого сайта на поддомене нужно будет в индивидуальном порядке настраивать сервисы электронной коммерции и коллтрекинг.

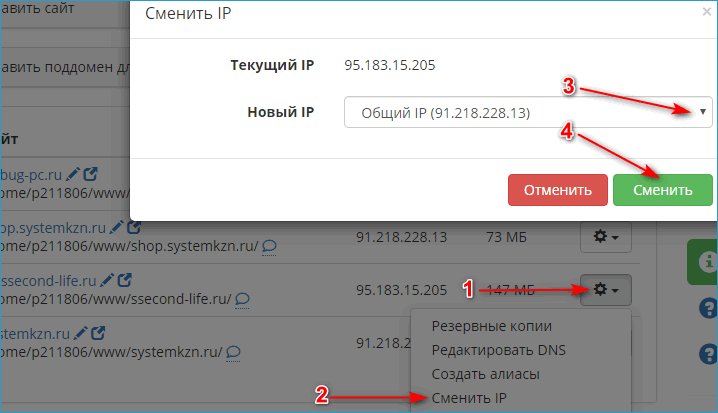

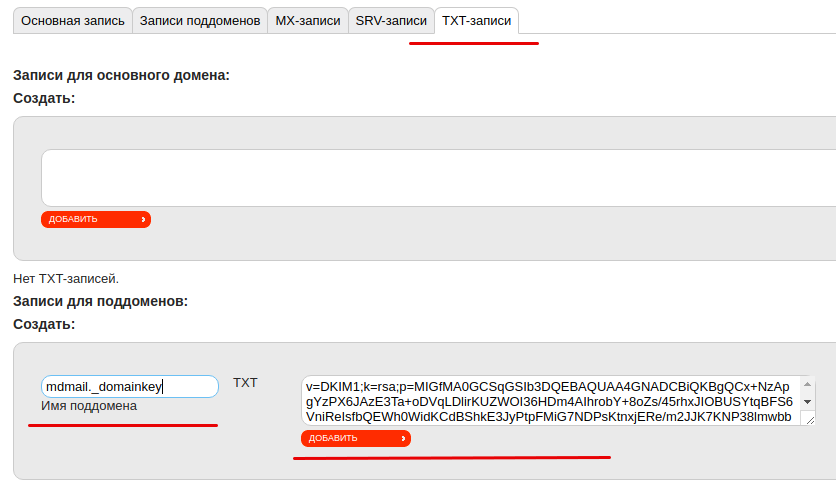

Этот процесс подразумевает выполнение двух основных шагов:

- Сначала нужно зарегистрировать субдомен.

Для этого создают поддомен на стороне того сервиса, чьи NS-серверы прописаны для основного домена. Если после приобретения домена вы не изменяли NS-серверы, то для создания поддомена нужно будет использовать личный кабинет регистратора. А если изменения всё-таки были внесены, то на стороне компании-держателя NS-серверов.

Для этого создают поддомен на стороне того сервиса, чьи NS-серверы прописаны для основного домена. Если после приобретения домена вы не изменяли NS-серверы, то для создания поддомена нужно будет использовать личный кабинет регистратора. А если изменения всё-таки были внесены, то на стороне компании-держателя NS-серверов. - Следующий этап подразумевает размещение поддомена. Для поддомена нужно будет уточнить А-запись — то есть IP-адрес сервера, где будет размещён ресурс на поддомене. Затем включите поддомен в панель управления хостинга.

Моментального начала работы субдомена ждать не стоит. Это произойдёт лишь после того, как обновится информация на DNS-серверах. На это, как правило, уходит от четверти часа до трёх часов.

Если вы хотите, чтобы поддомены не появлялись в результатах поисковой выдачи, возьмите на вооружение один из нижеперечисленных способов:

- Через файл robots.txt пропишите для сайта поддомена директиву Disallow.

- Через html-код пропишите метатег robots, указав директиву noindex.

- Закройте доступ к сайту или ограничьте его, сделав поддомен доступным для пользователей только после авторизации.

Поисковики уже проиндексировали субдомен? Чтобы убрать его из выдачи, действуйте следующим образом.

- Для начала «спрячьте» сайт субдомена от индексации, используя один из вышеперечисленных способов.

- В панели Яндекс.Вебмастера найдите раздел «Инструменты-Удаление страниц из поиска».

- Выберите параметр «По URL».

- Укажите URL сайта, который хотите удалить из индекса, или URL определённой страницы. Нажмите на кнопку «Удалить».

Учтите! В последующем вы можете мониторить статус удалённой страницы. За сутки нельзя удалить больше 500 урлов. Возникновение статуса «Отклонено» говорит о том, что статус страницы отличается от 404 и 403.

Если сравнивать Гугл и Яндекс, то первый удаляет из выдачи закрытые от индексирования страницы быстрее. Однако порой его боты не действуют согласно общим предписаниям файла robots.txt. Выход — указывайте персональные ограничения для краулеров Google. В выдаче Яндекса закрытые от индексирования поддомены могут застрять на несколько месяцев.

Однако порой его боты не действуют согласно общим предписаниям файла robots.txt. Выход — указывайте персональные ограничения для краулеров Google. В выдаче Яндекса закрытые от индексирования поддомены могут застрять на несколько месяцев.

Необходимость в поиске всех поддоменов сайта обычно появляется тогда, когда, несмотря на все вложенные в продвижения усилия, сайт на основном домене по какой-то причине плохо ранжируется. Возникает подозрение, что причина кроется в дублировании контента. Тогда поисковики признают ресурсы аффилированными и понижают их в выдаче.

Выявление поддоменов пригождается при проведении общего технического анализа сайта, изучения структуры компании-конкурента (чтобы понять, как и в каких регионах работает бизнес), тестировании и редизайне главного зеркала сайта.

Существуют 2 метода поиска поддоменов сайта:

- через операторы поисковых систем. Например, для Гугла это могут быть «site:» (ограничивают результаты поиска основным доменом) и «–inurl» (исключаем основной домен).

- при помощи сервисов. Есть как платные, так и бесплатные инструменты. К последним относится, например, Be1.ru. Пользоваться им очень просто — нужно лишь ввести в специальную строку URL интересующего сайта.

Еще один удобный сервис — Pentest-Tools. Базовая версия сканирования — бесплатная. Результаты можно посмотреть на сайте или скачать. Полная версия открывает доступ к дополнительным методам идентификации поддоменов.

Возможно, вам понравится функционал ещё одного бесплатного сервиса — Nmmapper.

Как видите, создание поддоменов может приносить бизнесу ощутимую пользу: способствовать успешному поисковому продвижению, увеличивать число потенциальных клиентов. Однако важно понимать, нужны ли они конкретно в вашем случае. Дать чёткий и обоснованный ответ на этот вопрос способны лишь специалисты. Так, сотрудники Студии ЯЛ рекомендуют создавать поддомены только тем компаниям, которые, по их мнению, получат максимум пользы от этого инструмента. Вы можете обратиться к нам за профессиональной помощью, оставив свою заявку через сайт или позвонив по указанному номеру телефона.

Вы можете обратиться к нам за профессиональной помощью, оставив свою заявку через сайт или позвонив по указанному номеру телефона.

Наша статья оказалась для вас полезной? Ищите ещё больше интересных материалов о SEO оптимизации, интернет-маркетинге, SERM, веб-разработке на сайте Студии ЯЛ. Мы стараемся регулярно радовать вас свежим контентом на самые актуальные темы.

Другие материалы на тему:

- Как битые ссылки вредят SEO-продвижению и что сделать, чтобы минимизировать этот ущерб

- Как посмотреть исходный код страницы: выбирайте подходящий для вас способ

- Как создать идеальный чекаут в интернет-магазине

Как запретить индексацию сайта или отдельных страниц, разделов или изображений

В процессе индексации поисковые роботы Google и Яндекс сохраняют в свои базы содержимое сайта: картинки, видео, текст, код.

Правильно когда в индекс поисковых систем попадают только полезные и нужные пользователям материалы. Часто повторяющаяся ошибка среди веб-мастеров — не исключать из индекса страницы, которые не следует показывать в результатах поиска.

Часто повторяющаяся ошибка среди веб-мастеров — не исключать из индекса страницы, которые не следует показывать в результатах поиска.

Почему нельзя индексировать весь сайт

- Пользователям, которые ищут в сети полезную информацию, ни к чему видеть «лишний» для них контент. Он мешает поиску нужной информации. Поисковые системы это заметят и также не оставят без внимания.

- Поисковые роботы любят, чтобы контент на страницах был уникальным. Поэтому без запрета индексации не обойтись если сайт тестируют на другом домене (поисковые системы также могут принять это за копирование).

- Поисковые системы отводят определенное время (мощности своего поискового бота) на индексирование каждого сайта. Если это время будет уходить на ненужную и не полезную информацию (на редиректы, спам и т.д.) это может замедлить индексацию важных страниц.

- При смене дизайна сайта или его структуры, когда он находится в разработке.

Что нужно закрывать от индексации

- Страницы сайта в разработке.

Если сайт находится в разработке, лучшим решением будет закрыть его от индекса на время. Ограничить доступ к сайту или его страницам нужно через файл robots.txt.

Если сайт находится в разработке, лучшим решением будет закрыть его от индекса на время. Ограничить доступ к сайту или его страницам нужно через файл robots.txt. - Копии сайта. Чтобы верно указать копию сайта, необходимо корректное зеркало (с помощью 301 редиректа или атрибута rel=»canonical»), чтобы рейтинг главного ресурса не падал. К тому же, поисковые системы так будут лучше понимать — где главный сайт, а где его копия. Рабочий ресурс не должен быть скрыт от индексации! Так можно потерять репутация ресурса, наработанную годами.

- Печатные страницы. Печатные страницы могут быть полезны посетителю. Необходимая информация может быть распечатана в адаптированном текстовом формате: статья, информация о продукте, схема расположения компании. По сути, печатная страница является копией своей основной версии. Если эта страница открыта для индексации, поисковый робот может выбрать ее в качестве приоритетной и посчитать более релевантной.

- Ненужные документы.

Кроме страниц, полезных для пользователей, на сайте могут также присутствовать документы для скачивания (PDF, DOC, XLS). И когда пользователь ищет информацию, он может видеть в выдаче не только нужные страницы, но и заголовки pdf-файлов. Эти файлы не несут практической ценности для пользователей. Либо документы появляются в результатах поиска над html страницами сайта. В этом случае индексация документов нежелательна, и их лучше закрыть от индекса в файле robots.txt.

Кроме страниц, полезных для пользователей, на сайте могут также присутствовать документы для скачивания (PDF, DOC, XLS). И когда пользователь ищет информацию, он может видеть в выдаче не только нужные страницы, но и заголовки pdf-файлов. Эти файлы не несут практической ценности для пользователей. Либо документы появляются в результатах поиска над html страницами сайта. В этом случае индексация документов нежелательна, и их лучше закрыть от индекса в файле robots.txt. - Пользовательские формы и элементы. Эти элементы могут быть полезны для пользователей сайта, но при этом не нести никакой информационной пользы в поисковой выдаче. Соответственно, оттуда их нужно убирать. Такие элементы, как форма регистрации и заявки, корзина, личный кабинет и прочее.

- Технические данные сайта. Только владелец ресурса должен иметь доступ к техническим страницам (это может быть форма входа в панель управления). В поисковой выдаче эти страницы — ни к чему.

- Личная информация о клиенте.

Это информация должна быть конфиденциальной и, ни в коем случае, не индексироваться. Это могут быть данные пользователя, его банковская информация и так далее.

Это информация должна быть конфиденциальной и, ни в коем случае, не индексироваться. Это могут быть данные пользователя, его банковская информация и так далее.

Запретить индексирование сайта, раздела или страницы

Как запретить индексирование в robots txt всего сайта

Иногда необходимо запретить весь сайт к индексу роботами Яндекса и Google. Так, для Яндекса стоит ввести следующий текст в robots.txt:

User-agent: Yandex

Disallow: /

Чтобы закрыть сайт от всех поисковых систем, стоит прописать:

User-agent: *

Disallow: /

Как закрыть папку от индексации

Иногда требуется закрыть определенную папку (например, служебную). Для этого нужно:

- Открыть файл robots.txt.

- Указать на каких поисковых роботов будет распространятся запрет: на все (User-agent: *) или только на Яндекс (User-agent: Yandex).

- Создать правило Disallow с названием папки/раздела, который хотите запретить: Disallow: /catalog/ (вместо «catalog» — название папки, которую необходимо запретить к индексу).

Как закрыть поддомен

Иногда появляется необходимость закрыть поддомены от индекса (например, при мультирегиональных или мультиязычных сайтах поддомены не всегда должны попадать в выдачу).

Для этого необходимо добавить инструкцию

User-agent: *

Disallow: /

На каждом поддомене, который требуется закрыть.

Как запретить индексацию страницы в robots txt и метатегах

Отдельную страницу можно закрыть при помощи следующих способов:

- Использования метатега «noindex». Добавление метатега «noindex» — метод управления индексацией отдельно взятой страницы. Необходимо вставить следующий тег в раздел <head> HTML-разметки страницы: <meta name=»robots» content=»noindex»>. Это необходимо сделать для каждой страницы, которую вы не хотите индексировать.

- Использования HTTP-заголовка X-ROBOTS-TAG. Тег X-Robots-Tag нужно добавлять в заголовок ответа HTTP для данного URL-адреса. Он имеет тот же эффект, что и тег «noindex», но с дополнительными параметрами для указания условий для разных поисковых систем.

Чтобы деиндексировать страницу, нужно добавить тег «X-Robots-Tag: noindex».

Чтобы деиндексировать страницу, нужно добавить тег «X-Robots-Tag: noindex». - В robots.txt в Disallow: прописать полный адрес страницы.

Как запретить индексацию контента

Можно также скрыть от индекса поисковыми системами отдельные виды контента: картинки, часть текса и ссылки.

Как закрыть все картинки от индексации

Чтобы скрыть все картинки на сайте от индекса в Яндекс, нужно в файл robots.txt добавить следующее:

User-Agent: Yandex

Disallow: *.jpg

Disallow: *.gif

Disallow: *.png

Для Google стоит прописать:

User-Agent: Googlebot

Disallow: *.jpg

Disallow: *.gif

Disallow: *.png

Для скрытия конкретной картинки:

User-Agent: *

Disallow: /img/pixelplus.gif

Дополнительно можно закрывать от индексации папку, где эти картинки расположены.

Как скрыть от индексации часть текста

Часть текста стоит закрывать от индекса в том случае, если он не должен попадать в выдачу, но все же несет информационную ценность для посетителей. Для Яндекса стоит использовать тег <noindex>. Он показывает поисковой системе, что часть текста, находящуюся между тегами <noindex></noindex> индексировать не нужно.

Для Яндекса стоит использовать тег <noindex>. Он показывает поисковой системе, что часть текста, находящуюся между тегами <noindex></noindex> индексировать не нужно.

Для Google есть возможность закодировать нужную часть текста с помощью асинхронного JavaScript.

Как скрыть от индекса ссылки на странице

В HTML-коде страницы необходимо указать метатег «robots» с директивой nofollow. В таком случае поисковые роботы не станут переходить по ссылкам на данной странице. Или же использовать в атрибутах ссылки <noindex><a href=»http://адрес_сайта/» rel=»nofollow»>Текст ссылки</a></noindex>.

Как закрыть от индексации страницы пагинации

Добавить на страницы пагинации теги:

<meta name=»robots» content=»noindex» />

Закрыть их в robots.txt или внедрить rel = «canonical». Это лучший вариант.

Как проверить, корректно ли работает запрет индексации

Есть несколько способов чтобы узнать, корректно ли работает ваш запрет на индексацию сайта или отдельной страницы:

- Яндекс.

Вебмастер. Кликнуть на кнопку «Инструменты» и далее «Проверка ответа сервера». Вставить адрес нужной вам страницы. Если она запрещена к индексу, то вы увидите соответствующее сообщение.

Вебмастер. Кликнуть на кнопку «Инструменты» и далее «Проверка ответа сервера». Вставить адрес нужной вам страницы. Если она запрещена к индексу, то вы увидите соответствующее сообщение. - Google Search Console. Нажать на «Проверка URL» и вписать адрес нужной вам страницы.

- Ввести в строку поиска (в Google или Яндекс) site:https:// + URL интересующего сайта/страницы. Так вы увидите выдает ли поисковик вашу страницу.

Индексирует ли Google субдомены? | Victorious

В ЭТОЙ СТАТЬЕ:

- https://www.example.com

- https://blog.example.com

- https://news.example1.com

- https://randomly-made-up-site.example.com

- Вы отправляете XML-карту сайта для своего поддомена в Google через Google Search Console.

- Индекс XML-карты сайта включает URL-адреса вашего поддомена. По сути, они будут функционировать как внешние ссылки на ваши субдомены.

- Были предыдущие ссылки на ваш субдомен, которые позволили его обнаружить, однако с тех пор эти ссылки были удалены. В такой ситуации поддомен, скорее всего, останется «застрявшим» в индексе.

- Дом

- SEO-тактика

- Оптимизация страницы

- Блокировка субдомена от сканирования и индексирования Google

- org/Comment»>

Всем привет, как дела?

У меня простой вопрос, на который мне нужно ответить.

У меня есть основной домен, назовем его domain.com. Недавно наша компания запустит серию рекламных акций, в которых мы будем использовать поддомены cname, например, try.domain.com или buy.domain.com. Они будут служить коммерческой цели, не более того.

Как лучше всего заблокировать такие домены от индексации в Google, а также от учета поддоменов от domain.com. Robots.txt, No-follow и т. д.?

Надеюсь услышать от вас,

С уважением,

-

Привет, Джордж! Спасибо за быстрый ответ! Я прочитал эту статью, и есть некоторые проблемы с этим. если вы можете увидеть на это, я был бы очень признателен.

Итак, проблема в том, что если я сделаю это прямо из Tumblr, он также заблокирует это от пользователей Tumblr. Вот примечание прямо под этой опцией «Разрешить этот блог появляться в результатах поиска»:

Итак, проблема в том, что если я сделаю это прямо из Tumblr, он также заблокирует это от пользователей Tumblr. Вот примечание прямо под этой опцией «Разрешить этот блог появляться в результатах поиска»:

«Это относится к поиску в Tumblr, а также во внешних поисковых системах, таких как Google или Yahoo».Кроме того, если я сделаю это из GWT, я очень беспокоюсь об удалении URL-адресов с моим поддоменом, потому что я боюсь, что это удалит весь мой домен. Например, мой домен — abc.com, а блог Tumblr настроен на tumblr.abc.com. Поэтому я боюсь, что если я удалю tumblr.abc.com из индекса, он также удалит мой abc.com. Пожалуйста, дай мне знать, что ты думаешь.

Спасибо!

-

Здравствуйте, Марина,

Если я правильно понял ваш вопрос, вы просто не хотите, чтобы Google проиндексировал ваш блог Tumblr.

В этом случае помогут следующие действия: http://yourbusiness.azcentral.com/keep-tumblr-off-google-3061.html

В этом случае помогут следующие действия: http://yourbusiness.azcentral.com/keep-tumblr-off-google-3061.htmlС уважением,

Джордж

-

Привет, ребята, я прочитал ваш разговор. У меня похожая проблема, но у меня немного другая ситуация. Я буду очень признателен, если вы поможете с этим. Итак, у меня также есть поддомен, который я не хочу индексировать в Google. Однако этот субдомен не находится под моим контролем. Я имею в виду, я создал поддомен на своем хостинге, но он указывает на мой блог Tumblr. Так что у меня нет доступа к его txt робота. Так может ли кто-нибудь посоветовать, что я могу сделать в этой ситуации, чтобы не индексировать этот субдомен?

Спасибо

- org/Comment»>

Лично я бы не стал полагаться только на robots.txt, так как одна случайная общедоступная ссылка на любую из страниц (проще, чем вы думаете!) приведет к тому, что Google проиндексирует эту страницу поддомена (она просто не будет отслеживаться) . Это означает, что страница может «застрять» в индексе Google, и для решения этой проблемы вам потребуется удалить ее с помощью WMT (инструкции здесь). Если бы случайно проиндексировано много страниц, вам нужно было бы снять ограничение robots.txt , чтобы Google мог его просканировать, и поместить на страницу теги noindex/nofollow, чтобы Google исключил ее из своего индекса.

Короче говоря, я бы выполнил шаги 1 и 2, описанные Федерико, если вы хотите спокойно спать по ночам :).

Джордж

- org/Comment»>

Также было бы разумно добавить поддомены в Инструменты для веб-мастеров на тот случай, если один из них будет проиндексирован и вам потребуется его удалить.

Robots.txt — самый простой и быстрый способ. В качестве резерва можно использовать метатег Noindex на страницах в поддомене

.-

2 способа сделать это с разными эффектами:

robots.txt в каждом поддомене. Это полностью заблокирует любую поисковую систему даже для доступа к этим страницам, поэтому они не будут знать, что у них внутри.

Агент пользователя:*

Запретить: /

тега noindex на этих страницах. Этот метод позволяет поисковым роботам читать страницу и, возможно, индексировать (если вы установили «follow») страницы, на которые вы ссылаетесь, или «nofollow», если вы не хотите, чтобы связанные страницы также индексировались.

Надеюсь, это поможет!

- Выпуск для индексации страниц AMP

Привет В поисковой консоли Google у меня есть около 500 страниц, проиндексированных для моих сайтов https://horaire-priere.be/ и https://horarios-oracion.es/, но только 20 страниц проиндексированы как AMP. Butmy сайт только усилитель. Я не могу понять, почему google проиндексировал страницу, но не в режиме amp? Заранее благодарю

Оптимизация страницы | | Закиро

0

- org/ListItem»> Как Google обрабатывает теги read more в WordPress

Привет всем Мне интересно, как Google обрабатывает тег «подробнее» в WordPress. Я вставил ссылку на сообщение в блоге в Google и ничего не нашел (domain.com/post#readmore). Затем я вставил версию без #readmore (domain.com/post) и обнаружил, что Google проиндексировал страницу, но с возможностью нажать «подробнее», чтобы прочитать ее. Полного сообщения в блоге нет в их указателе, только версия, в которой вас просят прочитать больше. Это потому, что Google не дошел до этого или Google игнорирует это. Я не уверен, но в идеале я предпочитаю индексировать полную запись в блоге, а не версию для чтения. Мне любопытно, вызовет ли это проблемы с дублированием контента. Каков ваш опыт в этом и целесообразно ли использовать альтернативный метод, чтобы узнать больше.

Возможно, с помощью плагина WordPress. Заранее спасибо.

Возможно, с помощью плагина WordPress. Заранее спасибо.Оптимизация страницы | | Габен

0

- Как перенаправить поддомен в новый каталог блога

Я переместил свой блог WordPress из поддомена в подкаталог /blog/ на моем сайте. Как лучше всего настроить перенаправление с субдомена на новый каталог /blog/? Или я должен просто удалить блог поддомена и подождать, пока Google проиндексирует его в /blog/. Мне нужно сделать одно или другое, чтобы не столкнуться с проблемами дублирования контента.

Оптимизация страницы | | СамКУК

0

- org/ListItem»> Новый дизайн страницы google serps

привет я знаю, что отображаемая длина заголовка теперь основана на пикселях, а не на символах, но по-прежнему считается безопасным иметь заголовки до 70 символов задолго до того, как они будут усечены я вижу, что на страницах с новым дизайном G serps заголовки, которые полностью отображались в старом дизайне (без усечения), теперь усекаются. Как и в том же заголовке, отображается нормально (отображается полностью) на старой поисковой выдаче дизайна, но усекается на странице нового дизайна. Кто-нибудь еще это замечает? Ваше здоровье Дэн

Оптимизация страницы | | Дэн-Лоуренс

1

- org/ListItem»> Почему Google не проиндексировал именно эти 2 страницы? Есть идеи?

Уважаемое сообщество, 27 июля я перезапустил свой собственный веб-сайт и отправил карту сайта, а также отправил индексную страницу для сканирования, включая все связанные страницы. Уже на следующий день новые страницы были проиндексированы. Сегодня я проверил их вручную, были ли они проиндексированы. В результате 2 из 13 страниц не проиндексированы, здесь они выделены жирным шрифтом: http://inlinear.com/

http://inlinear.com/suchmaschinenoptimierung-online-marketing.php

http://inlinear.com/design/

http://inlinear.com/design/printmedien-gestaltung.php

http:/ /inlinear.com/design/corporate-design-und-corporate-identity.php

http://inlinear.com/design/corporate-raum-design. php

php

http://inlinear.com/webentwicklung/

http ://inlinear.com/virtueller-rundgang-360grad-fotografie.php

http://inlinear.com/business-atlas-online-verzeichnis.php

http://inlinear.com/baudokumentation-bauueberwachung.php

http://inlinear.com/ueber-uns.php

http://inlinear.com/blog/

http://inlinear.com/kontakt/ Страница «/design/» (которая является index.php этой папки) должна быть главной страницей, потому что она посвящена веб-дизайну.

Должен ли я создать копию и назвать ее /design/ web-design.php ? быть Google предпочитает осмысленный URL-адрес, чем index.php?Поэтому я добавил rel=canonical к web-design.php в моем index.php? design/corporate-design-und-corporate-identity.php

URL-адрес немного длинный, но это не должно быть причиной? Или это может быть причиной того, что другая страница, которая все еще находится в индексе, но больше не в сети (даже с перенаправлением на /дизайн/), все еще доминирует? Странно…. или мне просто немного подождать или попробовать отправить эти сайты вручную в google? При проверке инструментов Google для веб-мастеров Google сообщает мне, что проиндексированы только 3 страницы.

Когда я проверял, проиндексирована ли страница или нет, я проверял каждый URL-адрес с помощью опции поиска по сайту:

site:inlinear.com/pageX.php … когда Google показывает эту страницу, это означает, что она была проиндексирована, но почему инструменты для веб-мастеров показывают только 3 страницы? (см. скриншот) Есть ли у вас какие-либо идеи?

Спасибо 🙂 индексированный.pngОптимизация страницы | | линейный

0

- Отправка URL-адресов в Bing и Google

Делает ли отправка URL-адресов в Bing и Google что-нибудь? Стоит ли? Я имею в виду периодическую отправку отдельных URL-адресов после отправки карты сайта.

Оптимизация страницы | | FCAbroad

0

- Google Maps API в качестве основного источника навигации

Можно ли для SEO использовать Google Maps API в качестве основного источника навигации? Например, пусть люди находят местоположения на карте, а не ссылки на них. Мне интересно, как/если Google рассматривает этот метод, вроде того, как Google не может читать изображения. Поймет ли Google, что эти страницы связаны с API gmaps главной страницы?

Оптимизация страницы | | терран

0

«Субдомен» относится к части архитектуры сайта, которая находится на любом уровне ниже имени домена верхнего уровня.

Итак, все следующие:

будет «поддоменами» « example.com ». Каждый из них имеет протокол (HTTP) и поддомен перед основным доменным именем « example.com ».

Субдомены позволяют веб-мастерам упорядочивать свой контент. Например, они могут поддерживать магазин электронной коммерции в одном домене и блог в другом. Однако Google рассматривает поддомены как отдельные сайты. Хотя «blog.example.com» и «example.com» могут иметь общий корневой домен, робот Googlebot будет рассматривать их как разные домены и соответственно сканировать и индексировать. Это вызвало массу путаницы и привело нас к большому вопросу:

Индексирует ли Google субдомены?

Короткий ответ: да, Google может и будет индексировать и ранжировать поддомены, если вы явно не предпримете шаги, чтобы исключить их из индекса.

Вся бизнес-модель Google основана на поиске контента. То же самое касается всех поисковых систем. Если страница имеет уникальный контент и может быть просканирована/индексирована, скорее всего, так и будет, поскольку она поддерживает цель поисковой системы.

На самом деле, если бы Google не поддоменов индекса, во всем их индексе не будет веб-сайтов с «www». Это, вероятно, кажется удивительным, поскольку сайты с «www» обычно рассматриваются как сайты по умолчанию, но сайты с «www» на самом деле являются наиболее распространенными поддоменами.

Несмотря на видимую индексацию миллионов субдоменов в результатах поиска Google, продолжают оставаться нерешенными вопросы относительно сканирования и индексации субдоменов Google. Это связано с тем, что использование поддоменов может создать проблемы и повлиять на усилия по SEO.

Мы подробно рассматриваем эти соображения в нашем блоге о поддоменах и подкаталогах. Хотя вы должны учитывать эти факторы при принятии решений относительно архитектуры вашего сайта и того, как она может повлиять на эффективность SEO вашего сайта, они не влияют на фундаментальный вопрос о том, могут ли субдомены ранжироваться в Google.

Когда поддомен не будет проиндексирован?

Хотя Google по умолчанию индексирует субдомены, безусловно, бывают ситуации, когда субдомены будут , а не индексироваться.

К ним относятся:

Нет ссылок, указывающих на ваш субдомен

Google обнаруживает и определяет приоритет индексации URL-адресов на основе ссылок, указывающих на эти URL-адреса. Эти ссылки могут быть из внешних доменов или из других доступных поддоменов в том же корневом домене.

Если Google не обнаружит ссылки на ваш субдомен при сканировании вашего сайта или другого сайта, то он не сможет найти ваш субдомен и, следовательно, не проиндексирует его.

Единственными исключениями из этого правила могут быть следующие случаи:

Субдомен использует теги Noindex

Вы можете явно заблокировать индексацию определенных URL-адресов на своем веб-сайте, используя теги noindex. Вы можете убедиться, что субдомен не включен в индекс Google, используя теги noindex или заголовки ответа noindex HTTP. Тег noindex позволяет Google и другим поисковым системам сканировать страницу и переходить по ссылкам, но по существу просит их воздержаться от ее индексации.

Имейте в виду, что если вы хотите успешно использовать этот метод, все страницы вашего субдомена должны иметь тег noindex в соответствующих файлах кода HTML. Простое применение тега noindex к домашней странице субдомена не будет индексировать только вашу домашнюю страницу.

Поддомен заблокирован через Robots.txt

Вы также можете заблокировать индексацию всего поддомена, обновив файл robots. txt для этого конкретного поддомена. Например, на сайте Victorious мы используем субдомен «start» для целевой страницы бесплатной консультации: https://start.victoriousseo.com/seo/.

txt для этого конкретного поддомена. Например, на сайте Victorious мы используем субдомен «start» для целевой страницы бесплатной консультации: https://start.victoriousseo.com/seo/.

Если мы хотим, чтобы эта целевая страница (и все другие целевые страницы, размещенные в поддомене «start») никогда не сканировались и не включались в индекс Google, мы могли бы реализовать запрет в файле robots.txt.

Это будет выглядеть так:

Этот метод работает только для исключения субдомена из индекса Google , если субдомен еще не был проиндексирован Google.

Если поддомен был проиндексирован, его блокировка с помощью файла robots.txt просто сохранит версию URL-адресов поддоменов, уже включенных в индекс Google. Чтобы удалить субдомен, который уже проиндексирован, установите теги noindex или используйте инструмент запроса на удаление URL в Google Search Console после обновления файла robots.txt.

Примечание: этот метод может не работать для поддоменов, на которые ведут многочисленные внутренние и внешние ссылки. Несмотря на то, что блокировка robots.txt является сильным предложением для Google, чтобы избежать индексации страниц, если этому сигналу противоречат многочисленные ссылки на URL-адрес, Google может принять решение о включении URL-адреса в свой индекс независимо от директивы robots.txt. Если Google индексирует ваш поддомен, несмотря на вашу директиву robots.txt, рассмотрите возможность снятия блокировки и использования мета-тегов noindex на всех страницах поддоменов.

Несмотря на то, что блокировка robots.txt является сильным предложением для Google, чтобы избежать индексации страниц, если этому сигналу противоречат многочисленные ссылки на URL-адрес, Google может принять решение о включении URL-адреса в свой индекс независимо от директивы robots.txt. Если Google индексирует ваш поддомен, несмотря на вашу директиву robots.txt, рассмотрите возможность снятия блокировки и использования мета-тегов noindex на всех страницах поддоменов.

Нужна помощь по архитектуре сайта? Victorious Has Your Back

Если вы не использовали поддомен на своем сайте, потому что не были уверены, проиндексирует ли его Google, будьте спокойны. Создав SEO-стратегию для каждого из ваших субдоменов, вы сможете хорошо ранжироваться по нужным ключевым словам и привлечь трафик на свои субдомены.

И вам не обязательно делать это в одиночку. Архитектура веб-сайта SEO может быть невероятно запутанной, если у вас нет опыта в поисковой оптимизации. Упростите процесс с опытным SEO-агентством и покорите Google SEO для субдоменов. Свяжитесь с нами сегодня для бесплатной консультации по SEO, чтобы наша команда оценила лучшие варианты для вашего сайта.

Свяжитесь с нами сегодня для бесплатной консультации по SEO, чтобы наша команда оценила лучшие варианты для вашего сайта.

НАЧНИТЕ РЕЙТИНГ СЕГОДНЯ

Получите бесплатную консультацию по SEO

Заполните форму для бесплатного анализа сайта.

Имя *

Фамилия *

Электронная почта компании *

Сколько вы хотите инвестировать в SEO? *

— Пожалуйста, выберите — Я еще не уверен / Мне нужна помощь с этим $2 999 — 5 000 / месяц $ 5 000 — 10 000 / месяц $ 10 000 — 20 000 / месяц $ 20 000 + / месяц

Блокировка субдомена от Google Crawl and Index | SEO Форум

Ваш браузер не поддерживает JavaScript. В результате ваши впечатления от просмотра будут уменьшены, и вы будете переведены в режим только для чтения .

Загрузите браузер, поддерживающий JavaScript, или включите его, если он отключен (например, NoScript).

Эта тема была удалена. Его могут видеть только пользователи с правами управления вопросами.

У вас есть животрепещущий вопрос по SEO?

Подпишитесь на Moz Pro, чтобы получить полный доступ к вопросам и ответам, отвечать на вопросы и задавать свои.

Начать бесплатную пробную версию

Есть вопрос?

Просмотр вопросов

Посмотреть Все вопросыНовые (нет ответов)ОбсуждениеОтветыПоддержка продуктаБез ответа

От Все времяПоследние 30 днейПоследние 7 днейПоследние 24 часа

Сортировка по Последние вопросыНедавняя активностьБольше всего лайковБольшинство ответовМеньше всего ответовСамые старые вопросы

С категорией Все категорииПартнерский маркетингОбновления алгоритмовAPIBрендингСообществоКонкурентные исследованияРазработка контентаОптимизация коэффициента конверсииЦифровой маркетингЗапросы функцийНачало работыОптимизация изображений и видеоОтраслевые событияНовости отраслиПромежуточное и продвинутое SEOМеждународное SEOВакансии и возможностиИсследование ключевых словИсследование ключевых словСоздание ссылокЛокальные спискиЛокальное SEOЛокальная оптимизация веб-сайтаMoz BarMoz LocalMoz NewsReport Marketing Analytics & Product Analytics ToolsOn-Page Analytics Search поиск и тенденцииОтзывы и рейтингиПоисковое поведениеSEO ТактикаТренды поисковой выдачиСоциальные сетиТехническое SEOВеб-дизайнБелое/черное SEO

Связанные вопросы

- schema.org/ItemList» data-nextstart=»» data-set=»»>

В случае с разделами это не требуется. Кроме того, создавать разделы проще, чем поддомены. Ведь, грубо говоря, это просто папки, расположенные на сервере;

В случае с разделами это не требуется. Кроме того, создавать разделы проще, чем поддомены. Ведь, грубо говоря, это просто папки, расположенные на сервере; txt. Для всех интересующихся мы подготовили полезную статью о том, что представляет собой файл robots.txt, из чего состоит и как его проверить.

txt. Для всех интересующихся мы подготовили полезную статью о том, что представляет собой файл robots.txt, из чего состоит и как его проверить. Для этого создают поддомен на стороне того сервиса, чьи NS-серверы прописаны для основного домена. Если после приобретения домена вы не изменяли NS-серверы, то для создания поддомена нужно будет использовать личный кабинет регистратора. А если изменения всё-таки были внесены, то на стороне компании-держателя NS-серверов.

Для этого создают поддомен на стороне того сервиса, чьи NS-серверы прописаны для основного домена. Если после приобретения домена вы не изменяли NS-серверы, то для создания поддомена нужно будет использовать личный кабинет регистратора. А если изменения всё-таки были внесены, то на стороне компании-держателя NS-серверов.

Если сайт находится в разработке, лучшим решением будет закрыть его от индекса на время. Ограничить доступ к сайту или его страницам нужно через файл robots.txt.

Если сайт находится в разработке, лучшим решением будет закрыть его от индекса на время. Ограничить доступ к сайту или его страницам нужно через файл robots.txt. Кроме страниц, полезных для пользователей, на сайте могут также присутствовать документы для скачивания (PDF, DOC, XLS). И когда пользователь ищет информацию, он может видеть в выдаче не только нужные страницы, но и заголовки pdf-файлов. Эти файлы не несут практической ценности для пользователей. Либо документы появляются в результатах поиска над html страницами сайта. В этом случае индексация документов нежелательна, и их лучше закрыть от индекса в файле robots.txt.

Кроме страниц, полезных для пользователей, на сайте могут также присутствовать документы для скачивания (PDF, DOC, XLS). И когда пользователь ищет информацию, он может видеть в выдаче не только нужные страницы, но и заголовки pdf-файлов. Эти файлы не несут практической ценности для пользователей. Либо документы появляются в результатах поиска над html страницами сайта. В этом случае индексация документов нежелательна, и их лучше закрыть от индекса в файле robots.txt. Это информация должна быть конфиденциальной и, ни в коем случае, не индексироваться. Это могут быть данные пользователя, его банковская информация и так далее.

Это информация должна быть конфиденциальной и, ни в коем случае, не индексироваться. Это могут быть данные пользователя, его банковская информация и так далее.

Чтобы деиндексировать страницу, нужно добавить тег «X-Robots-Tag: noindex».

Чтобы деиндексировать страницу, нужно добавить тег «X-Robots-Tag: noindex». Вебмастер. Кликнуть на кнопку «Инструменты» и далее «Проверка ответа сервера». Вставить адрес нужной вам страницы. Если она запрещена к индексу, то вы увидите соответствующее сообщение.

Вебмастер. Кликнуть на кнопку «Инструменты» и далее «Проверка ответа сервера». Вставить адрес нужной вам страницы. Если она запрещена к индексу, то вы увидите соответствующее сообщение.

Итак, проблема в том, что если я сделаю это прямо из Tumblr, он также заблокирует это от пользователей Tumblr. Вот примечание прямо под этой опцией «Разрешить этот блог появляться в результатах поиска»:

Итак, проблема в том, что если я сделаю это прямо из Tumblr, он также заблокирует это от пользователей Tumblr. Вот примечание прямо под этой опцией «Разрешить этот блог появляться в результатах поиска»:  В этом случае помогут следующие действия: http://yourbusiness.azcentral.com/keep-tumblr-off-google-3061.html

В этом случае помогут следующие действия: http://yourbusiness.azcentral.com/keep-tumblr-off-google-3061.html

Возможно, с помощью плагина WordPress. Заранее спасибо.

Возможно, с помощью плагина WordPress. Заранее спасибо. php

php