Индексация сайта в Яндекс и Гугл, как ускорить, проверить

Под индексированием понимается процесс сканирования страниц сайта роботом поисковой системы (ПС) и их дальнейшее добавление в базу данных, которая называется Индексом. Индекс необходим для поиска страниц сайтов с корректным ответом на запросы пользователей поисковика. Он происходит не в интернете, а в заранее сформированной базе.

К примеру, в Яндексе веб-документы, успешно прошедшие индексирование, разделяют на отдельные смысловые кластеры. Получается, что в момент, когда посетитель набирает поисковый запрос, система моментально ищет нужную информацию в конкретном кластере. далее она ранжируется (сортируется по важности) согласно заданным алгоритмам и формируются страницы выдачи, первая из которых – ТОП-10. На то какое место занимает конкретный сайт в выдаче, влияет то, насколько грамотно проведена внешняя и внутренняя оптимизация страницы под ключевые слова.

Для попадания на верхние строчки в выдаче необходимо, чтобы сайт присутствовал в индексе у целевых поисковиков. А попасть туда действительно важно, так как первые 10 ссылок собирают 95% поискового трафика.

А попасть туда действительно важно, так как первые 10 ссылок собирают 95% поискового трафика.

Как выполняется индексация

Процесс выполняется автоматически при помощи специально разработанных роботов, которых называют пауками либо краулерами. Создано несколько десятков подобных программ для разных целей, подробный перечень представлен в Яндекс. Проанализировав этот список, можно классифицировать всех роботов по назначению:

- Общие. Программы, необходимые для сканирования веб-пространства в поиске новых интернет-ресурсов.

- Специализированные. Их основная задача состоит в индексации графических изображений, видеороликов, фавиконок и т.д.

- Роботы-проверяльщики. Эти пауки определяют, адаптирован ли ресурс под мобильные устройства (смартфоны, планшеты), подтверждены ли права на владение конкретным доменным именем, имеется ли валидатор микроразметки, наличие RSS для турбо-страниц. Наличие этих элементов сказывается на месте веб-сайта на страницах выдачи.

- Пауки от конкретных сервисов. В Yandex есть несколько десятков сервисов, отдельный робот предусмотрен для некоторых из них. Например, разработаны краулеры для «Яндекс.Справочника», «Яндекс.Маркета», «Яндекс.Трекера», «Яндекс.Вебмастер» и т.д.

Работа пауков происходит по следующему алгоритму:

- Роботы переходят по определенному адресу и проверяют, появились ли новые веб-страницы.

- Если в ходе поиска обнаружены новые разделы, они сканируют следующие ключевые показатели:

- Соответствие требованиям поисковика. При обнаружении нарушений сайт или страница не добавляется в индекс.

- Содержательная сторона. Выполняется проверка оригинальности опубликованных материалов (статей, графических изображений, видеороликов). Тексты и фотографии, скопированные со сторонних источников, которые уже есть в базе поисковика – не добавляются.

- Система считывает сигналы релевантности страницы и определяет, в какие смысловые кластеры её добавить.

- Страница попадает в базу данных и начинает участвовать в формировании выдачи ПС.

Сколько времени занимает попадание в Индекс

Время, за которое конкретный URL-адрес появляется в Индексе, зависит от ряда факторов. Ключевое значение имеет периодичность добавления изменений на нем. Индексация новостных порталов, форумов проводится за несколько минут, для них предназначены специальные быстроботы, которые реагируют на ежеминутные изменения. Если информация редко обновляется, а новые материалы практически не публикуются, то частота просмотра ботами снижается. Отсюда рекомендация оптимизаторов регулярно добавлять новые статьи и новости на продвигаемые сайты.

Как ускорить индексацию сайта в Яндекс и Google

Любой веб-сайт рано или поздно попадает в базу данных, но без грамотного подхода на это уходит достаточно длительное время. Избежать этого получится, если следовать этим правилам.

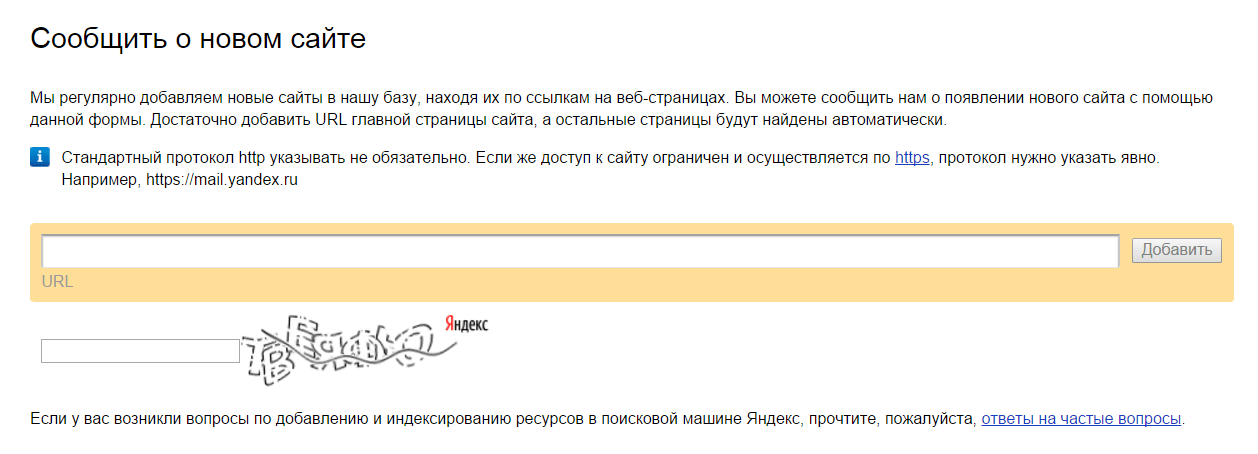

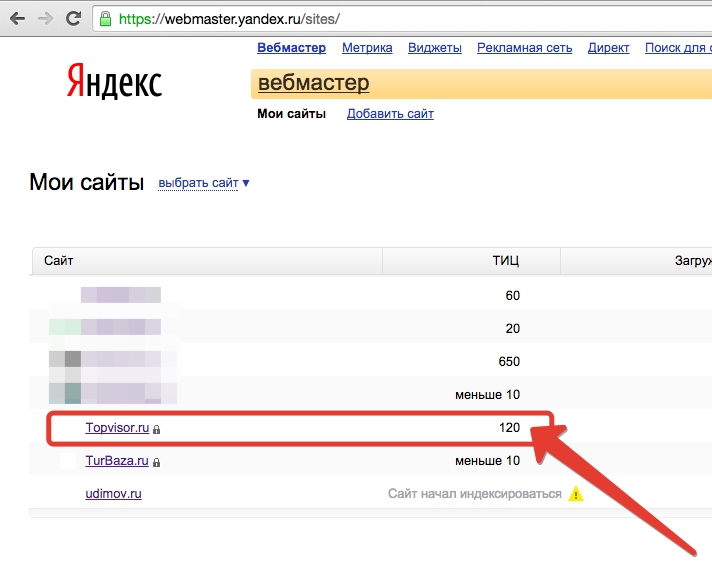

Добавить сайт в панели вебмастеров: «Яндекс.Вебмастер» и Google Search Console

Регистрация в сервисе от Yandex занимает несколько минут. Действуйте согласно инструкции:

Действуйте согласно инструкции:

- Зарегистрируйте новый аккаунт (почтовый ящик) на Yandex или войдите в существующий.

- Перейдите по ссылке: https://webmaster.yandex.ru/sites/add/, укажите URL главной страницы своего ресурса в поле и нажмите кнопку «Добавить».

- Подтвердите права, что вы являетесь владельцем сайта. Скопируйте предложенный сервисом мета-тег и добавьте его в код страницы в раздел <head></head>.

- После проверки сервисом мета-тег, сайт будет добавлен и отобразится информация о нем.

Чтобы повысить точность данных, установите «Яндекс.Метрику» и привяжите её аккаунту Вебмастера. Данные, оказавшиеся в метрике, используются поисковым пауком.

Через Вебмастер получится проверить индексацию отдельных разделов. Перейдите на вкладку «Индексирование» и найдите пункт «Проверить статус URL».

Добавление веб-страниц в Google Search Console также занимает всего несколько минут и происходит по следующей схеме:

- Перейти по ссылке: https://search.

google.com/search-console/welcome.

google.com/search-console/welcome. - Завести почтовый ящик в Гугл или воспользоваться существующим аккаунтом.

- Выбрать тип ресурса. Это может быть:

- Доменный ресурс;

- Ресурс с префиксом в URL.

Программы от этих поисковиков схожи по многим параметрам. Оба сервиса предоставляют пользователям доступ к отчетам о текущем состоянии индексирования. С их помощью легко отследить, какие разделы добавлены поисковиком, увидеть обнаруженные на сайте ошибке, получить рекомендации по доработкам.

Создать файл robots.txt

Этот файл предназначен для того, чтобы указывать роботам ПС, какие разделы доступны для проверки, а какие — нет. Любой веб-ресурс состоит из содержательных и технических разделов. К последним относятся результаты поиска, системные файлы, личный кабинет, корзина и другие сведения, не представляющие пользы для посетителей или поисковика.

Чтобы ограничить индексирование подобных разделов, в корневой папке сайта создают файл robots.txt и добавляют туда ссылки на них. Главное — проверить перед запуском сам файл и его синтаксис, иначе он будет действовать некорректно. Например, запрещено использовать кириллицу. Если домен прописан русскими буквами, нужно воспользоваться конвертерами.

Рекомендации Яндекса по файлам robots.txt.

Поисковик даёт рекомендации:

- По наполнению файла, какие директивы использовать.

- Как добавлять информацию о доменах на кириллице – сайт.рф.

- Как создать файл robots.txt.

С помощью robots.txt можно закрыть сайт от индексирования Google и открыть его только для Яндекса. Это выполняется двумя способами. Добавьте следующие правила:

- User-agent: Google

- Disallow:/

- User-agent: Yandex

- Allow:/

Если надо распространить для всех ПС, в «User-agent» вместо поисковика, добавляют символ «*». Подробнее про настройку файла robots. txt.

txt.

Также запрет на индексацию страниц сайта реализуется с помощью мета-тегов. На странице, которую нельзя индексировать требуется прописать тег:

<meta name=«robots» content=«noindex, nofollow»/>.

Создать файл sitemap.xml

Sitemap — отдельный xml-документ, где собраны все URL-адреса сайта. Такой файл становится своеобразным путеводителем для поисковиков. Используя предоставленные данные, они узнают, какие материалы доступны и как их найти. Благодаря карте XML ускоряется работа краулеров, так как им не надо переходить на сайт, есть отдельный URL на каждый новый документ.

Создание карты XML предусматривают все популярные CMS. Если сайт работает без движка, сделайте карту при помощи сервисов Gensitemap и XML-Sitemaps, но бесплатно можно добавить не более 1000 страниц.

Чтобы sitemap.xml действительно ускорил проверку, нужно следовать следующим правилам:

- Добавить путь до карты в документ robots.txt. Так робот быстрее сможет перейти в этот раздел.

- Добавить ссылку в сервисы для вебмастеров. Там также выполняется его проверка. Есть различия у «Яндекс.Вебмастера» и Google Search Console. Вебмастер автоматически обнаруживает файлы Sitemap в robots.txt. В Google Search Console с этим возникают проблемы. Иногда сервис не находит карту сайта, поэтому приходится указывать путь к нему вручную.

- Настроить динамический sitemap.xml. Файл будет автоматически обновляться при добавлении новых страниц на сайт или корректировке старых. Нередко владельцы веб-ресурсов забывают об этом и непреднамеренно оставляют на карте устаревшие сведения.

Создать HTML-карту

Ссылки на карту встречаются в подвале сайта, то есть в самом нижнем блоке, расположенным под основным контентом. Грамотно разработанная HTML-карта способствует повышению скорости сканирования ресурса поисковыми роботами и помогает им ориентироваться.

Создать понятную многоуровневую структуру

Продуманная структура также способствует повышению скорости индексирования. Чтобы она действительно помогла снизить время проверки, нужно при разработке учитывать требования ПС:

Чтобы она действительно помогла снизить время проверки, нужно при разработке учитывать требования ПС:

- структура должна быть понятной;

- не стоит придумывать длинные URL, в них отражается суть раздела или страницы;

- URL должны быть понятны не только паукам, но и посетителям.

При этом стоит учитывать, что ее разработка во многом зависит от формата веб-ресурса: структуры лендинга или сайта-визитки отличаются от интернет-магазина или тематического форума.

Оптимизировать скорость загрузки

Чтобы ускорить загрузку, надо:

- уменьшить размер страниц;

- упростить код — вынести стили и скрипты в отдельные файлы;

- уменьшить размер изображений до актуальных, оптимизировать их вес.

Определить скорость загрузки получится при помощи бесплатных сервисов. Для этих целей разработаны tools.pingdom.com и gtmetrix.com.

Создать внутреннюю перелинковку

Желательно, чтобы в отдельных разделах присутствовали ссылки на другие страницы. Если ведется перелинковка в интернет-магазине, добавьте ссылки на аналогичные и сопутствующие товары. Например, при публикации содержательных статей можно ссылаться на дополняющие материалы, опубликованные ранее, а также сделать рубрику с ссылками «Также полезно знать».

Если ведется перелинковка в интернет-магазине, добавьте ссылки на аналогичные и сопутствующие товары. Например, при публикации содержательных статей можно ссылаться на дополняющие материалы, опубликованные ранее, а также сделать рубрику с ссылками «Также полезно знать».

Как подобрать материал, в который может добавить ссылку на новый? Для этого используется поисковик и особый тип запроса «ключевое слово site:domen.ru», например, для это статьи можно подобрать следующие страницы для перелинковки:

Внешние сигналы

Сделайте репост опубликованного материала в социальные сети (например, личные страницы или сообщества в Facebook и ВКонтакте), добавьте ссылки на тематические форумы, доски объявлений и другие сторонние ресурсы (партнерские или спонсорские). Это позволяет поисковым краулерам быстрее обнаружить страницу. Видя, что ей поделились, он считает информацию, размещенную там полезной для пользователей, что ускоряет анализ содержимого.

Проверка индексации сайта в поисковых системах

Проверить, проиндексирован ли веб-адрес, можно несколькими способами, как через поисковики, так и с помощью сторонних сервисов.

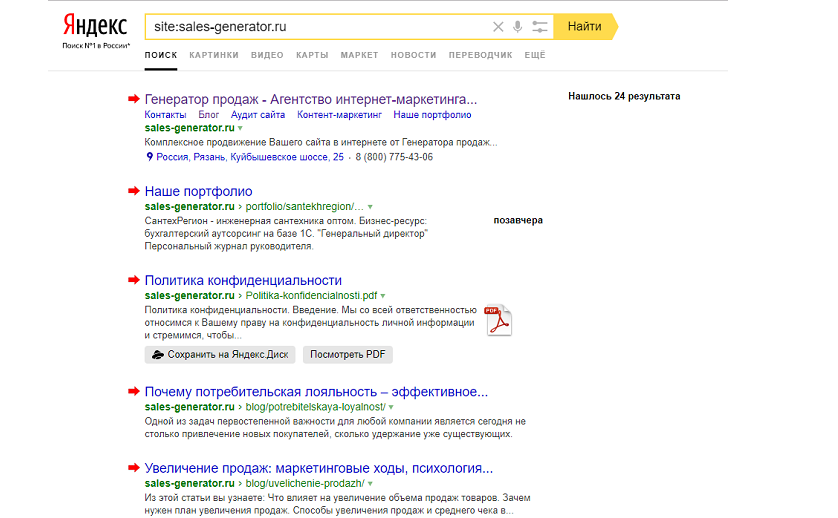

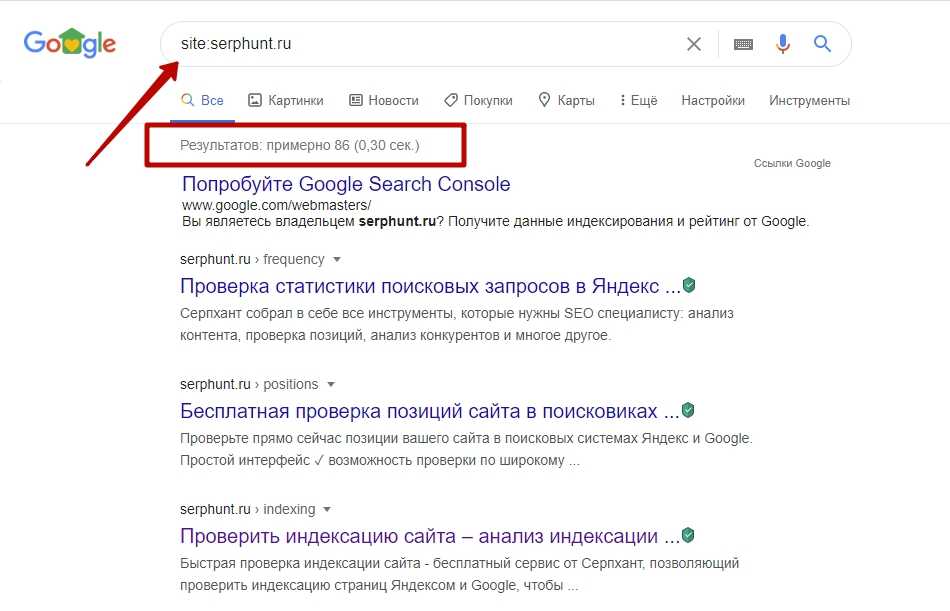

Специальные операторы

Число проиндексированных разделов через ПС получится проверить с помощью специального оператора «site:domen.ru». Для этого нужно после него в строке добавить адрес веб-ресурса. Примерное количество указано в верхней части поисковой выдачи.

Пример для Яндекс:

«Нашлось 640 результатов», говорит о том, что в индексе поисковика 640 страниц с этого сайта.

Пример с Google:

Фраза «Результатов: примерно 603» указывает на 603 проиндексированные страницы сайта студии.

Если результаты в разных ПС сильно отличаются, это говорит, о том, что есть проблемы в обнаружении страниц роботами сайтам или других проблемах. Посмотрите на ошибки, которые указаны в сервисах для Вебмастеров.

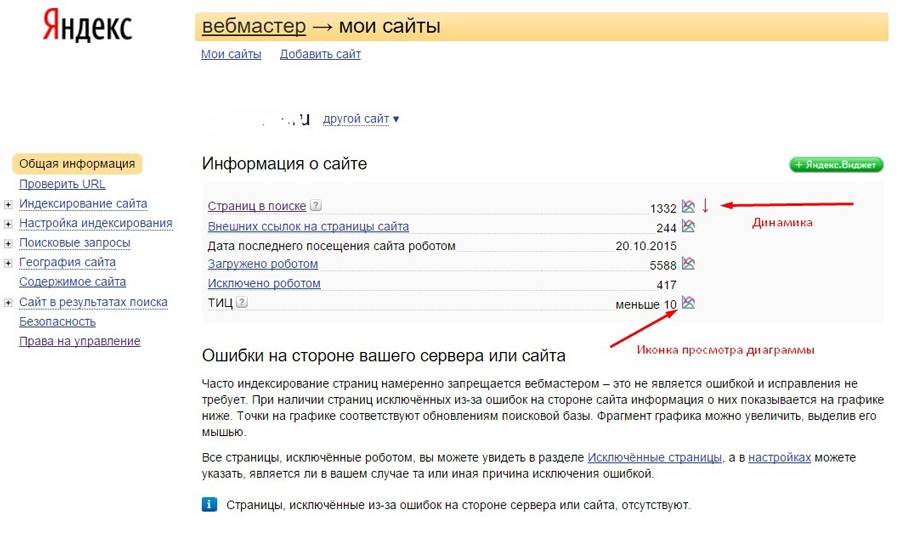

Сервисы для вебмастеров

Если вы пользуетесь Google Search Console, выберите ресурс, информацию о котором хотите посмотреть, и в блоке «Индекс», кликните на «Покрытие». Так вы увидите, какие страницы попали в индекс Гугла, а на каких страницах обнаружены проблемы.

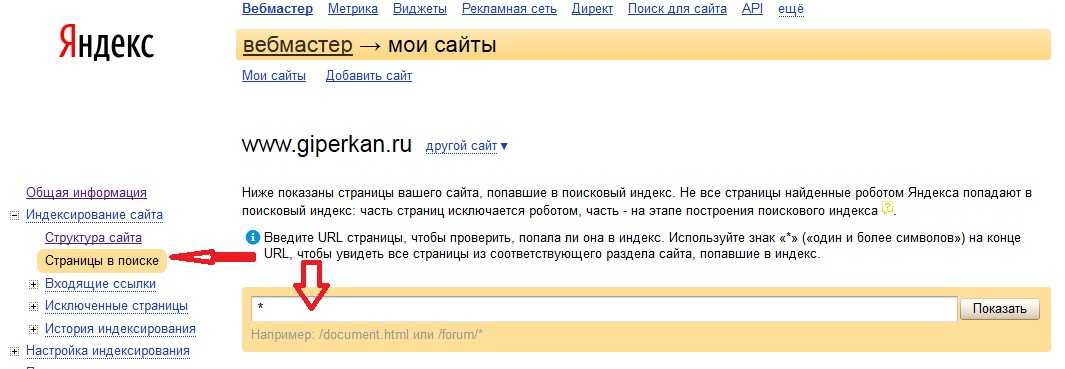

При работе с панелью для вебмастеров от Yandex надо открыть меню «Индексирование сайта» и перейти во вкладку «Страницы в поиске».

Такой метод позволяет увидеть, сколько URL-адресов попало в индекс, и отследить динамику.

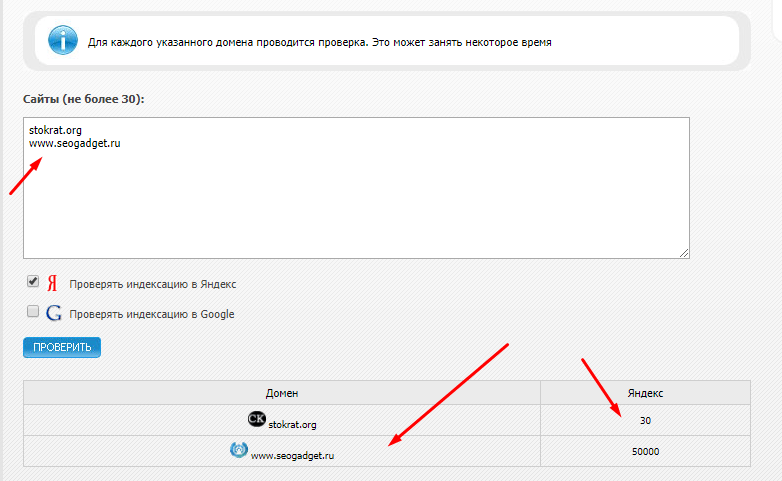

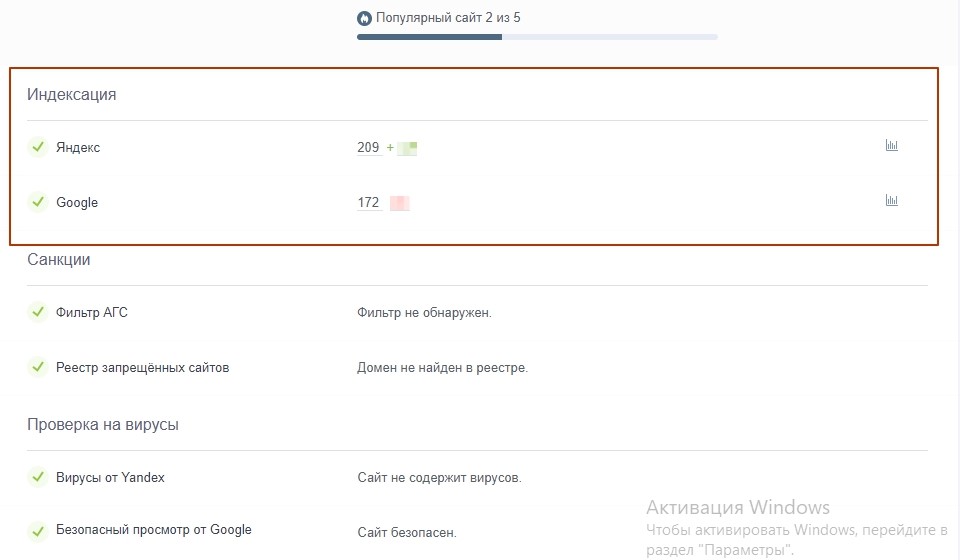

Сторонние сервисы

Выполнить проверку получится бесплатно с помощью сторонних сервисов. Для этого подходят инструменты от pr-cy.ru. Чтобы просмотреть данные об индексации, нужно указать ссылку в свободную строку и нажать «Проверить». После этого на экране появится информация о попадании в индекс, трафике, последних событиях. Ресурс показывает количество ошибок и успешных текстов.

Аналогично работают инструменты от be1.ru. Указав адрес и нажав на кнопку «Анализировать», пользователь переходит к ключевым показателям. Здесь также легко просмотреть, адаптирован ли сервис под использование на мобильных устройствах, какова скорость загрузки и динамика посещаемости.

Видеоролик про проверку и ускорению индексации

В обучающем видеоролике, который специалисты студии подготовили для SEO-марафона, идет речь про поисковую индексацию. В нем мы рассказываем, что это такое, почему она важна для SEO, а также как и где проверять индексацию сайта. Даем рекомендации по ускорению индексации страниц поисковиками.

В нем мы рассказываем, что это такое, почему она важна для SEO, а также как и где проверять индексацию сайта. Даем рекомендации по ускорению индексации страниц поисковиками.

Резюме

Исходя из этой информации, становится понятно, что индексация важна при продвижении в интернете. Если результаты Гугл и Яндекс отличаются в десятки раз, это говорит об ошибке. Из-за них роботам труднее выполнять проверку, частота которых снижается. Если в базу данных не внесена ни одна из страниц или только несколько из них, это также сигнализирует о возможных санкциях со стороны ПС. Эффективное продвижение возможно только при постоянном контроле индексации сайта и исправлении ошибок, которые усложняют доступ роботов к страницам и содержанию.

Обсудим сотрудничество?

Какие задачи нужно решить:

Разработка сайта / интернет-магазина

Продвижение (SEO, Директ и т.п.)

Контент-маркетинг

Поддержка сайта (информационная, техническая)

Аудит сайта / интернет-магазина

Консультация

Настройка индексирования сайта в Яндексе: от теории к практике

- Eye 5 076

- Chatbubbles 1

- CategoriesSEO, Яндекс

В данной статье рассматриваются вопросы индексации нового сайта и разбирается несколько вопросов касательно переезда сайтов на HTTPS.

Содержание

Настройка индексирования нового сайта

При работе над новым сайтом у вас возникает огромное количество вопросов:

- Как организовать каталог?

- Куда разместить информационные статьи?

- Что делать с фильтрами?

Но один вопрос возникает практически у каждого вебмастера:Что делать со страницей пагинации, фильтрами и сортировкой?

Пагинация

Для страниц пагинации рекомендуется использовать атрибут rel=»canonical» тега link с указанием на главную страницу каталога, где будут собраны все Ваши товары из определенного раздела или это будет первая страница пагинации в зависимости от того, как организован ваш каталог.

Тег rel=»canonical» вы можете использовать для исключения страниц пагинации из результатов поиска. Теги rel=»next» и rel=»prev» робот Яндекса игнорирует

Рис. 1. Практический пример: несколько страниц пагинации. Для их исключения достаточно «canonical». В этом случае в поиске будет участвовать первая страница вашего каталога или первая страница пагинации.

Подробнее об использовании атрибута Rel canonical для указания канонического адреса страниц и предотвращения дублирования контента

Сортировки, фильтры, UTM-метки

Что делать со страницами фильтров и сортировки? Для них нужно использовать файл robots.txt, чтобы индексирующий робот не посещал подобные страницы, не загружал и не добавлял информацию о них в свою базу, а также страницы не появлялись в поисковой выдаче.

Рассмотрим страницы сортировки, выбор по размеру и фильтры. Такие страницы лучше запретить от индексации с помощью следующих правил в файле robots.txt:

- User-agent: *

- Disallow: *size=*

- Disallow: *sort=*

- Disallow: */filter/*

Что делать с UTM-метками? Содержащими параметр, по которому можно отследить, откуда к Вам пришел посетитель, из какой рекламной компании. Для таких меток есть прекрасная директива clean-param.

Для таких меток есть прекрасная директива clean-param.

Файл robots.txt будет выглядеть следующим образом:

- User-agent: Yandex

- Сlean-param: utm_sourse&utm_medium&utm_campaign

Перечисленные метки не будут учитываться роботом. Робот не будет загружать и включать подобные страницы в поисковую выдачу.

Важно: поисковые факторы ранжирования с неканонической страницы учитываются для канонической страницы.

Дубли: Как устранить, что с ними делать?

В зависимости от того, с какими дублями вы столкнулись, можно использовать несколько способов и методов борьбы с ними.

- Используйте 301 редирект в случае, если дубли – это страница со слешем или без слеша в конце адреса страницы.

- Если это служебные страницы, то используем запрет в файле robots.txt.

- Можно использовать rel=»canonical» для дублей одного и того же товара в нескольких категориях и для указания только одного товара, который нужно включать в поисковую выдачу.

Важное правило: Если страницы не были доступны для посетителей Вашего сайта, они не могли взять эту ссылку и разместить на тематическом форуме, не пересылали ее друг другу, то такие страницы лучше запрещать в файле robots.txt. Если страницы были доступны для пользователей, то можно использовать rel=»canonical» или 301 перенаправление на канонические адреса.

Файл robots.txt для нового сайта

Рассмотрим небольшой чек-лист robots.txt для нового сайта.

- Запрещайте к индексации страницы сортировки фильтров, подбора товаров, различные UTM-метки, идентификаторы сессий.

- Обязательно запрещайте страницы действий: добавление в сравнение, добавление в корзину, поиск по сайту.

- Нужно запрещать данные пользователей: личный кабинет, различные данные по доставке, адреса, телефоны.

- Указываем директиву Host с адресом главного зеркала, по которому ваш сайт будет участвовать в поиске.

- Указываем директиву Sitemap с адресом соответствующего файла.

Проверить составленный файл robots.txt можно в сервисе Яндекс.Вебмастер с помощью соответствующего инструмента. Посмотрите, какие правила робот использует при обходе Вашего сайта.

Дополнительно: Если проанализировать загруженные роботом страницы, то можно увидеть, что на них содержатся адреса страниц с действиями: голосовалки, экшены, лайки и дизлайки. Такие страницы лучше запрещать в файле robots.txt, поскольку обращения от роботов могут быть восприняты как обращения от обычных посетителей.

Работа с проиндексированным сайтом

Все пользователи поисковой системы хотят, чтобы в результатах поиска участвовала наиболее актуальная и свежая информация. Поэтому перед каждым из Вас встает вопрос: Как устроить индексирование вашего сайта?

Существует три пункта, следуя которым можно повлиять на скорость индексирования вашего ресурса.

1. Запрет индексирования ненужных страниц

Первый – это самый главный пункт: не разрешайте роботу индексировать то, что не нужно.

Рис. 2. Разбор на практике. Существует сайт, где большая разница между числом загруженных страниц и страниц в поиске.

Почему так много загруженных страниц? Список всех загруженных страниц можно скачать из Яндекс.Вебмастера.

Как еще можно получить загруженные страницы? Каким образом их можно увидеть? В данном случае страниц в поиске всего 270. Где остальные 300 тысяч?

Берем архив из Яндекс.Вебмастера и видим, что по данному сайту существует огромное количество адресов следующего вида:

- http://dsplit.ru/?part=110 — HTTP-200

- http://dsplit.ru/?part=114 — Разрешены в robots.txt

- http://dsplit.ru/?part=119 — Содержит контент главной страницы

Это случайный параметр, который ничего не меняет на странице: ничего не происходит, контент не меняется. Такие страницы разрешены в robots.txt, отвечают кодам 200. Робот загружает и добавляет их в свою базу.

Если проанализировать архив, можно увидеть огромное количество загруженных страниц, из них процентов 80–90 % – это страницы действий (в данном случае – это страницы покупки).

Все подобные страницы лучше запрещать в файле robots.txt. Со временем данные о них будут удалены из базы робота и они пропадут из сервиса Яндекс.Вебмастер. Количество загруженных страниц уменьшится.

Индексирование и участие загруженных страниц в поиске

Почему так мало страниц в поиске? Если проанализировать исходный код страниц сайта с товарами, то можно увидеть стандартные метатеги для всего каталога и текстовое описание внизу страницы.

Рис. 3. Стандартные метатеги для всего каталога и текстовое описание внизу страницы

Если Вы хотите, чтобы такие страницы с товарами индексировались и участвовали в поиске, над страницами нужно поработать:

- Уникализировать метатеги, которые установлены на странице.

- Добавить больше текстового описания, рекомендации, отзывы от покупателей и так далее.

- Нужно хотя бы добавить фотографию, чтобы узнать об отсутствии ошибки с выбором ножки.

Нужно работать над такими страницами, и они смогут появиться в поисковой выдаче.

2. Анализ логов сервера

Страницы, к которым обращается индексирующий роботПовлиять на индексирование Вашего сайта можно с помощью анализа логов сервера.

Что можно понять с помощью логов сервера?

Во-первых, можете увидеть, к каким именно страницам обращается индексирующий робот.

Рис. 4. Пример логов сервера. Четыре запроса от робота

Если посмотреть повнимательнее, можно увидеть, какие параметры в них содержатся: параметры подбора, фильтров, кастинг-подбор и так далее.

Сразу видно, по каким служебным адресам идут запросы.

Из четырех запросов четыре были сделаны роботом к служебным страницам.

Вывод: Запрещайте индексацию служебных страниц в файле robots.txt.

Частота обращений от индексирующего роботаВторое, что можем увидеть в логах сервера, – это частоту обращений от индексирующего робота.

Как правило, к большому сайту робот совершает 1–2 обращения в секунду в зависимости от того, сколько страниц он знает на этом сайте. Если Вы видите, что в логах робот обращается реже, проверьте, установлена ли у Вас директива Crawl-delay. Очень часто она мешает индексировать большие ресурсы.

Также бывают ограничения со стороны хостинг-провайдера. Например, Вы добавили новый раздел на Ваш сайт, робот узнал о его наличии из файла Sitemap, начал обращаться, совершать 3–4 запроса в секунду. Хостер видит запросы робота и начинает отвечать медленнее, так как считает, что сайт подвергся DDOS-атаке.

Как реагирует робот? Робот видит, что сайт работает плохо: отвечал быстро, теперь – медленно. Робот уменьшает количество запросов, так как «думает», что он влияет на работу сайта. При уменьшении количества запросов, частота и скорость обновления информации в поиске падают.

Проверьте, нет ли у Вашего хостера аналогичных ограничений.

HTTP-коды ответовТретье, что можно увидеть в логах сервера, – это HTTP-коды ответов. Каким образом это работает?

Каким образом это работает?

Известно, что доступная страница отвечает кодам 200. Но если, при большом количестве запросов, Ваш сайт начинает отвечать кодам 500, 503, 502 – то робот также снижает количество обращений к Вашему сайту, так как «думает» о проведении работ, о занятости сайта и о том, что лучше к нему реже обращаться. Обязательно смотрите на коды ответа.

Также можно посмотреть скорость ответа сервера – возврат первого и последнего байта. При этом Ваш сервер должен отвечать быстро не только на запрос одной страницы в несколько секунд, но и на запрос нескольких страниц в секунду. Готовьтесь к тому, что при добавлении нового раздела робот может увеличить частоту обращений. Если сервер отвечает медленно, индексирующий робот будет реже к нему обращаться.

3. Файл Sitemap

Вопрос: Добавляем новый раздел на сайт. Что же указывать в файле Sitemap: все адреса страниц или только новые страницы сайта?

Ответ: Здесь можно выбрать любой из вариантов: индексирующий робот, при получении Вашего файла Sitemap со списком всех страниц, проверяет известные ранее страницы и те страницы, которые только что появились на сайте.

При получении новых страниц робот начнет индексировать любые файлы: большой файл по всему сайту или отдельный файл с новым разделом. Новый раздел на сайте может появляться не только при постепенном добавлении информации на сайт, но и при редизайне, смене структуры.

Чек-лист при смене дизайна сайта и структуры

- Обязательно используйте 301 редирект, если меняются адреса страниц на Вашем сайте.

- Новые страницы указывайте в файле Sitemap.

- Если Вы ранее готовили новую версию сайта на техническом поддомене, а теперь заливаете ее на Ваш работающий сайт, то проверьте файл robots.txt. Очень часто возникает ситуация, когда вместе с техническим доменом и новым дизайном попадает запрещающий файл robots.txt. Сайт пропадает из поиска, и Вы теряете посетителей.

- Следите за тем, чтобы все метатеги на нужных страницах были прописаны.

- Текст должен быть доступен для робота.

- Важная информация не должна загружаться с помощью JavaScript. Робот не использует скрипты при обходе сайта и не увидит тот полезный контент, который Вы хотите ему отдать.

- Проверьте <noindex>.

- Проверьте, что rel=»canonical» ведет на нужные канонические страницы.

- Следите за появлением битых ссылок, которые потом могут попасть в базу индексирующего робота.

Переезд сайта на HTTPS

Как переехать на https, чтобы проблемы не возникали?

До начала переезда следует проверить:

- Во-первых, корректен ли сертификат, который Вы получили. Не будут ли посетители сайта видеть предупреждения в браузере о невалидности сертификата и его принадлежности другому сайту, или существует проблема в цепочке сертификатов. Проверить можно с помощью популярного сервиса www.ssllabs.com.

- Во-вторых, если Вы используете партнерский контент, например, загружаете видео с других сайтов, убедитесь, что они умеют работать по протоколу https. Очень часто партнеры не могут отдать тот или иной контент по защищенному протоколу.

- В-третьих, проверьте, что внутренние ссылки на https-версии ведут на https-страницы и они же указаны в файле Sitemap.

Поэтапный план переезда:

- Добавляем сайт https в Яндекс.Вебмастер.

- Устанавливаем директиву Host с указанием защищенного протокола в robots.txt.

- Используем инструмент «Переезд сайта».

- Ждем окончания переезда. В большинстве случаев это занимает 3–4 недели.

После того, как данные в Вебмастере обновятся, Вы можете установить перенаправление с http-версии на HTTPS.

Источник (видео): Мастер-класс — настраиваем индексирование: от теории к практике — Александр Смирнов.

Магомед Чербижев

Поделиться:

Об авторе

Никита Пасечник

Эксперт в области продвижения и интернет-маркетинга. Специалист по бизнес-решениям. Опыт работы более 10 лет. Более 5 000 часов активных тренингов и практик.

ПодробнееMass Ping Tool для SEO — Список пинга WordPress для более быстрой индексации в Google, Яндексе,… — Плагин WordPress

- Детали

- отзывов

- Монтаж

- Развитие

Опора

100% АВТОМАТИЧЕСКИЙ ПЛАГИН ИНСТРУМЕНТА PING ДЛЯ WORDPRESS ДЛЯ ПОВЫШЕНИЯ ВАШЕГО SEO. НЕ НУЖНО БЫТЬ ЭКСПЕРТОМ, 2 ЩЕЛКА И ГОТОВО!

НЕ НУЖНО БЫТЬ ЭКСПЕРТОМ, 2 ЩЕЛКА И ГОТОВО!

★★★★★

Инструмент массового пинга для плагина SEO — один из самых быстрых способов проиндексировать Google. После проверки связи роботы Google посетят ваш веб-сайт и инициируют процесс индексации вашего веб-сайта.

Пинг — это механизм push-уведомлений, который уведомляет поисковые системы, новостные ленты и каталоги веб-сайтов, когда ваш веб-сайт WordPress публикует новый или обновленный контент. Ваш пинг-лист указывает поисковым системам сканировать и индексировать ваш сайт, чтобы ваш свежий контент быстрее попадал на страницы результатов поиска.

Когда вы пингуете службу, вы даете ей указание просканировать ваш сайт с помощью бота. Бот обнаруживает новые и обновленные страницы на вашем сайте. Затем страницы индексируются поисковой системой.

Пингование отправки — один из самых полезных и лучших способов ускорить индексацию вашего нового поста в блоге или обновленного контента. Если вы используете его без необходимости, это может привести к наказанию Google или любой другой поисковой системы. Так что не используйте его без необходимости .

Так что не используйте его без необходимости .

О стандартном сервисе проверки связи WordPress

В WordPress есть отличный вариант службы проверки связи для более быстрой индексации постов и блогов. Когда вы публикуете новый пост, WordPress автоматически уведомляет перечисленные службы обновления сайта (в настоящее время одна — http://rpc.pingomatic.com/).

Основное отличие службы проверки связи WordPress по умолчанию заключается в том, что этот плагин будет пинговать ВСЕ, используя несколько служб проверки связи вместо одной! В то время как служба пинга WordPress строго ограничена сообщениями, плагин Mass Ping Tool для SEO будет пинговать все ваши страницы продуктов, ваши страницы и пользовательские типы сообщений, позволяя вашему веб-сайту получить максимальную видимость из поисковых систем!

Преимущества инструмента массовой проверки связи для плагина SEO

- Помогает увеличить индексацию сайта.

- Это помогает улучшить рейтинг на страницах результатов поисковой системы (SERP).

- Это безопасный и надежный метод SEO.

- Помогает повысить авторитет домена сайта.

Как это работает

Этот плагин прост. Он будет пинговаться или не пинговаться в зависимости от установленных условий.

- Включить Ping : эта опция полностью включает/отключает службу Ping. По умолчанию для этого будет установлено значение ON.

- Службы проверки связи : Наш список проверки связи (предоставляемый API) регулярно обновляется для повышения производительности. Обязательно обновите свой режим (Free или PRO). Также обратите внимание, что НАШ список Ping (БЕСПЛАТНЫЙ или PRO) намеренно не отображается, чтобы избежать ненадлежащего чрезмерного использования и защитить наши источники.

- Ограничение пинга : хотя список пинга полезен для более быстрой индексации, он также может привести к тому, что поисковые системы накажут ваш сайт за слишком сильный пинг.

Каждый раз, когда вы добавляете или изменяете контент на своем веб-сайте, WordPress отправляет пинг в ваш список. Итак, если вы обновляете свой сайт несколько раз в течение дня или недели, WordPress отправляет несколько пингов. Решение состоит в том, чтобы контролировать, сколько раз вы отправляете пинг. Эта функция поможет вам автоматически контролировать пинг. Таким образом, ваш сайт не будет помечен поисковыми системами как спамер.

Каждый раз, когда вы добавляете или изменяете контент на своем веб-сайте, WordPress отправляет пинг в ваш список. Итак, если вы обновляете свой сайт несколько раз в течение дня или недели, WordPress отправляет несколько пингов. Решение состоит в том, чтобы контролировать, сколько раз вы отправляете пинг. Эта функция поможет вам автоматически контролировать пинг. Таким образом, ваш сайт не будет помечен поисковыми системами как спамер. - Список проверки связи по умолчанию : этот список предоставляется службами проверки связи WordPress по умолчанию и является дополнением к нашей собственной службе списка проверки связи. Вы также можете добавить свои собственные службы (другие URL-адреса для проверки связи).

- Кнопка Ping Now (Forced): Эта функция просто пропингует все сообщения, которые требуют PING после обновления. Однако мы рекомендуем использовать эту функцию очень осторожно. По умолчанию служба PING блокируется при редактировании сообщения.

Но каждое «редактирование» автоматически создает постмету (подразумевается, что для этого сообщения требуется проверка связи) (поведение WordPress по умолчанию). Это означает, что если несколько сообщений были изменены 30 раз, использование этой опции пропингует все эти 30 сообщений. Ограничение не будет работать с этой опцией. И это может привести к чрезмерному количеству пингов сразу, что приведет к тому, что ваш сайт не будет помечен как пинг-спамер.

Но каждое «редактирование» автоматически создает постмету (подразумевается, что для этого сообщения требуется проверка связи) (поведение WordPress по умолчанию). Это означает, что если несколько сообщений были изменены 30 раз, использование этой опции пропингует все эти 30 сообщений. Ограничение не будет работать с этой опцией. И это может привести к чрезмерному количеству пингов сразу, что приведет к тому, что ваш сайт не будет помечен как пинг-спамер.

- Mass Ping Tool для SEO

Установка вручную

- Распакуйте все файлы в каталог

/wp-content/plugins/mass-ping-tool-for-seo - Войдите в систему администратора WordPress и активируйте плагин «Mass Ping Tool for SEO» через меню «Плагины»

- Перейдите к «Mass Ping Tool» в левом меню, чтобы начать работу над ним.

У меня не было с ним проблем, и он работает как положено.

Прочитать все 1 отзыв «Mass Ping Tool for SEO — WordPress ping list для более быстрой индексации в Google, Yandex, …» — это программное обеспечение с открытым исходным кодом.

google.com/search-console/welcome.

google.com/search-console/welcome.

Каждый раз, когда вы добавляете или изменяете контент на своем веб-сайте, WordPress отправляет пинг в ваш список. Итак, если вы обновляете свой сайт несколько раз в течение дня или недели, WordPress отправляет несколько пингов. Решение состоит в том, чтобы контролировать, сколько раз вы отправляете пинг. Эта функция поможет вам автоматически контролировать пинг. Таким образом, ваш сайт не будет помечен поисковыми системами как спамер.

Каждый раз, когда вы добавляете или изменяете контент на своем веб-сайте, WordPress отправляет пинг в ваш список. Итак, если вы обновляете свой сайт несколько раз в течение дня или недели, WordPress отправляет несколько пингов. Решение состоит в том, чтобы контролировать, сколько раз вы отправляете пинг. Эта функция поможет вам автоматически контролировать пинг. Таким образом, ваш сайт не будет помечен поисковыми системами как спамер.