Удаление сайта. Руководство разработчика

Удаляет сайт из списка сайтов пользователя.

- Формат запроса

- Формат ответа

- Коды ответа

DELETE https://api.webmaster.yandex.net/v4/user/{ Тип: int64. ID пользователя. Необходим для вызова любых ресурсов API Яндекс Вебмастера. Чтобы получить его, используйте метод GET /v4/user."}}">}/hosts/{Тип: host id (string). ID сайта. Чтобы получить его, используйте метод GET /v4/user/{user-id}/hosts."}}">}user-id | Тип: int64. ID пользователя. Необходим для вызова любых ресурсов API Яндекс Вебмастера. Чтобы получить его, используйте метод GET /v4/user. |

host-id | Тип: host id (string). ID сайта. Чтобы получить его, используйте метод GET /v4/user/{user-id}/hosts. |

Тело ответа не передается.

Чтобы посмотреть структуру ответа подробнее, нажмите на причину.

| Код | Причина | Описание |

|---|---|---|

| 204 | NO_CONTENT | Сайт удален из списка пользователя. |

| 403 | INVALID_USER_ID | ID пользователя, выдавшего токен, отличается от указанного в запросе. В примерах ниже {

"error_code": "INVALID_USER_ID",

"available_user_id": 1,

"error_message": "Invalid user id. {user_id} should be used."

}<Data>

<Описание |

| 404 | HOST_NOT_FOUND | Сайт отсутствует в списке сайтов пользователя. {

"error_code": "HOST_NOT_FOUND",

"host_id": "http:ya.ru:80",

"error_message": "explicit error message"

}<Data>

<Описание |

Была ли статья полезна?

4 способа удалить страницу из поискового индекса Яндекс и Google

Практически каждый вебмастер, особенно на начальном этапе создания проекта, сталкивался с необходимостью удаления страниц веб-сайта из индекса поисковиков. Даже не взирая на то, что процедура, на первый взгляд, довольно простая, у многих все же возникают трудности.

Даже не взирая на то, что процедура, на первый взгляд, довольно простая, у многих все же возникают трудности.

Зачем нужно убирать страницы из индекса?

Как закрыть страницу от поисковиков с помощью панели вебмастера?

Yandex

Ошибка 404 на сервере

Изменение файла robots.txt

Мета-тег Robots

Заключение

Зачем нужно убирать страницы из индекса?

Порой владельцу веб-ресурса приходиться скрывать документ от поисковиков по следующим причинам:

- сайт находится в стадии разработки и попал в выдачу совершенно случайно;

- контент на странице больше неактуален;

- документ дублирует другую страницу, которая уже есть на сайте;

- в индекс попали служебные страницы, где размещены личные данные клиентов.

Во избежание таких случаев, сегодня мы поговорим о 4 эффективных способах удаления страницы из индекса поисковых систем.

Как закрыть страницу от поисковиков с помощью панели вебмастера?

Данный метод закрытия доступа к страницам вашего сайта для поисковых роботов считается одним из самых легких. Причем этот инструмент идеально подходит для тех случаев, когда определенные URL нужно удалить срочно.

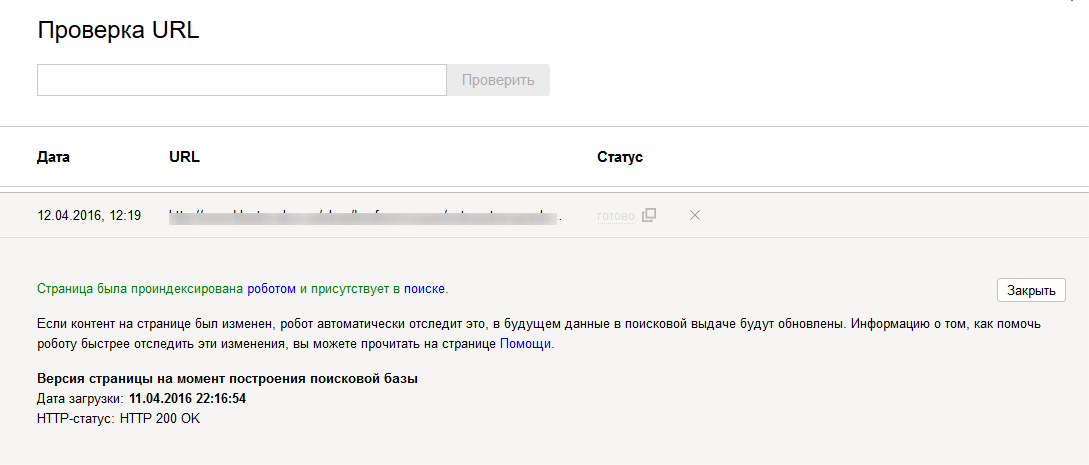

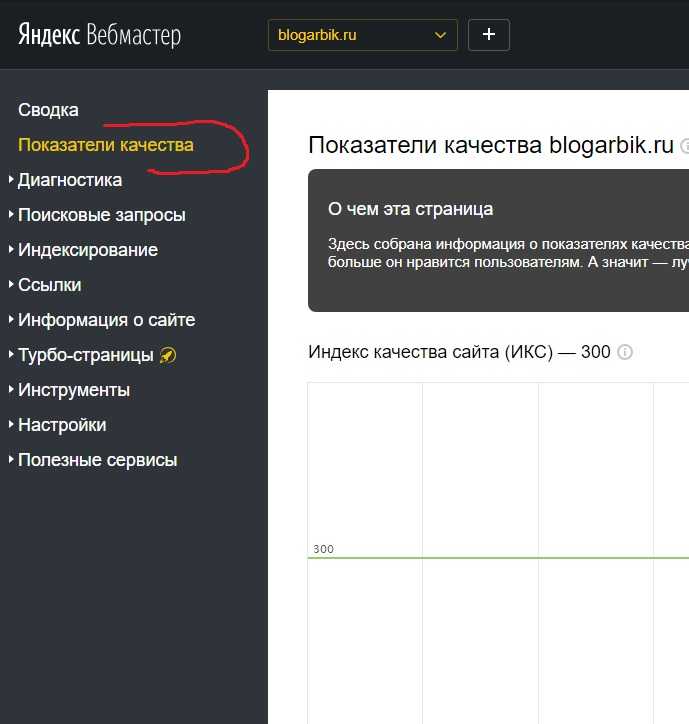

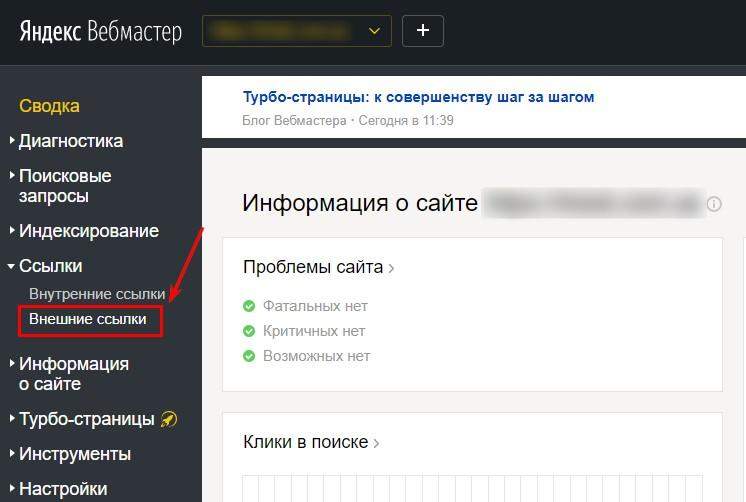

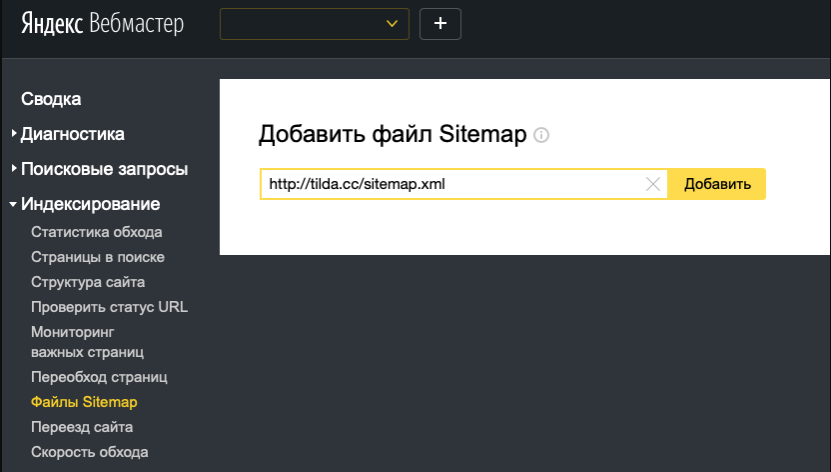

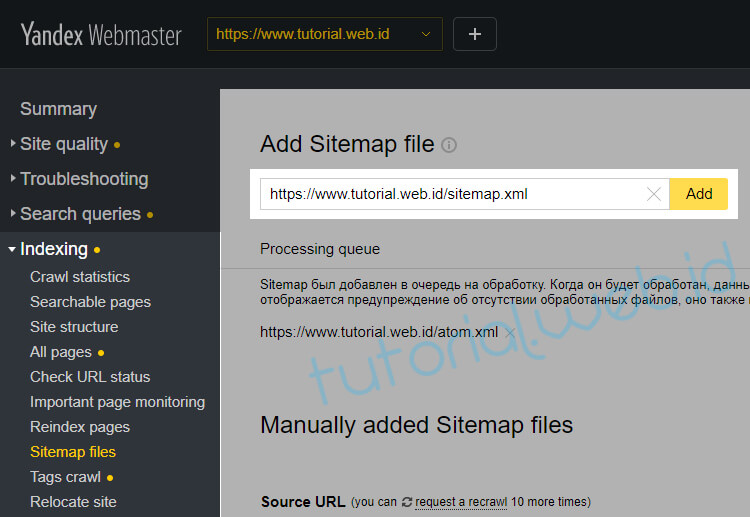

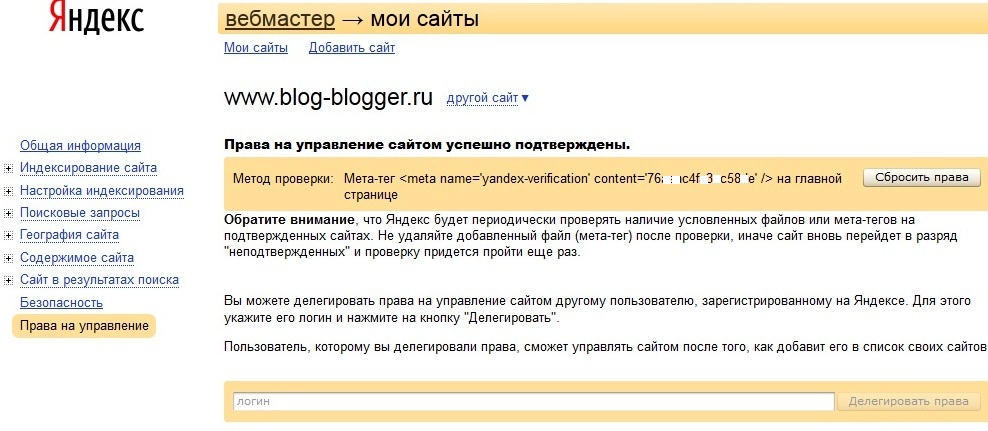

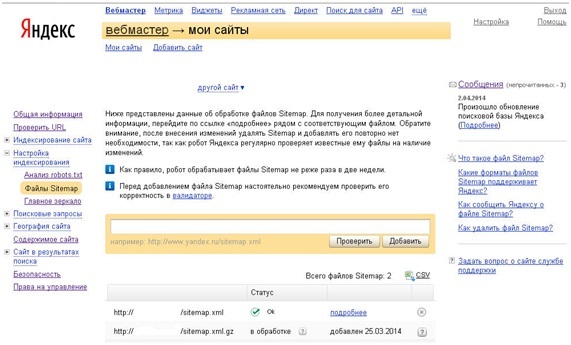

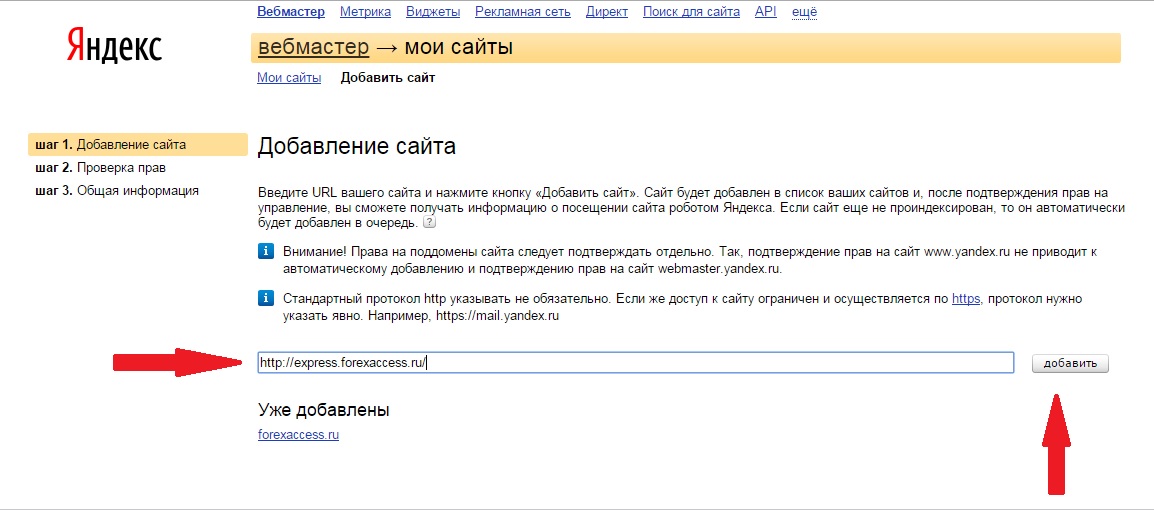

Yandex

Для этого вам понадобится сервис Яндекс.Вебмастер. Как добавлять сайт на эту площадку для ускорения индексации, мы рассказывали здесь. Перейдите по ссылке https://webmaster.yandex.ru/tools/del-url/ и добавьте в соответствующее поле адрес конкретной страницы, затем нажмите «Удалить».

С большой долей вероятности Yandex попросит вас ускорить процесс удаления страницы из базы данных системы. Для этого вам нужно предварительно закрыть ее от ботов через файл либо мета-тег robots, или сделать так, чтобы сервер выдавал ошибку 404. Про то, как это сделать, мы поговорим чуть позже.

Понадобится несколько часов или даже дней, прежде чем боты удалят документ из базы. Это связано с тем, что системе нужно будет отслеживать его статус и убедиться, что он уже не изменится.

Авторизируйтесь на площадке Google Webmaster Tools. Предварительно добавьте свой сайт в индекс, если вы еще этого не сделали. Затем найдите там вкладку «Индекс Google», и под ним «Удалить URL адреса». В появившемся окне выберите опцию создания запроса на удаление, и укажите в поле адрес удаляемого документа. Затем отправьте запрос.

Дальше сверху экрана появится сообщение о том, что указанный URL был добавлен в список удаляемых. Вам остается только ждать. Как правило, документ из индекса Google удаляется в течение 2-24 часов.

Ошибка 404 на сервере

Наверняка каждый пользователь, ища нужную информацию в Интернете, попадал на страницу, где выдавало ошибку 404 – «Страница не найдена». Это значит, что искомый по вашему запросу документ был удален с ресурса.

Сделать это вебмастер может в панели управления сайтом, например, WordPress. Для поисковиков это означает, что вы настраиваете ответ сервер этой страницы так, чтобы на определенном адресе появился код 404 not found. И когда робот снова посетит данный URL, сервер сообщит ему, что страницы больше нет. Это дает понять поисковикам, что документ удален с сайта, и они уберут его из поисковой выдачи, чтобы посетители не заходили на него и не читали ошибку 404.

И когда робот снова посетит данный URL, сервер сообщит ему, что страницы больше нет. Это дает понять поисковикам, что документ удален с сайта, и они уберут его из поисковой выдачи, чтобы посетители не заходили на него и не читали ошибку 404.

К характерным особенностям данного способа можно отнести:

- Простую настройку всего за несколько кликов.

- Полное исчезновение документа из веб-ресурса. Из-за этого не рекомендуется использовать данный метод в случае, когда из индекса нужно убрать служебную страницу (конфиденциальную информацию клиентов и пр.).

- Также стоит прибегнуть к другому варианту скрытия страницы, например, 301 редирект, если на нее ведут входящие ссылки.

Важно! Страница выпадает из поискового индекса не за счет ее удаления с ресурса, а за счет дальнейшей переиндексации. Поэтому для ее удаления вам придется ждать около 2ух недель, пока бот вновь не посетит ресурс.

Для вебмастеров такой метод является одним из самых удобных, а вот посетителю ошибка 404 может не понравиться, и есть риск того, что пользователь, увидев ее, перестанет заходить на сайт. Но выход есть и из этой ситуации.

Но выход есть и из этой ситуации.

На заметку. Очень часто сайтостроители занимаются интересным оформлением страницы, на которой вылетает ошибка 404 not found. Они выкладывают туда полезную информацию и предлагают посетить другие страницы ресурса, которые непременно привлекут внимание посетителя. Так вы сделаете эту страницу более привлекательной для пользователя, что непременно положительно скажется на его рейтинге и узнаваемости.

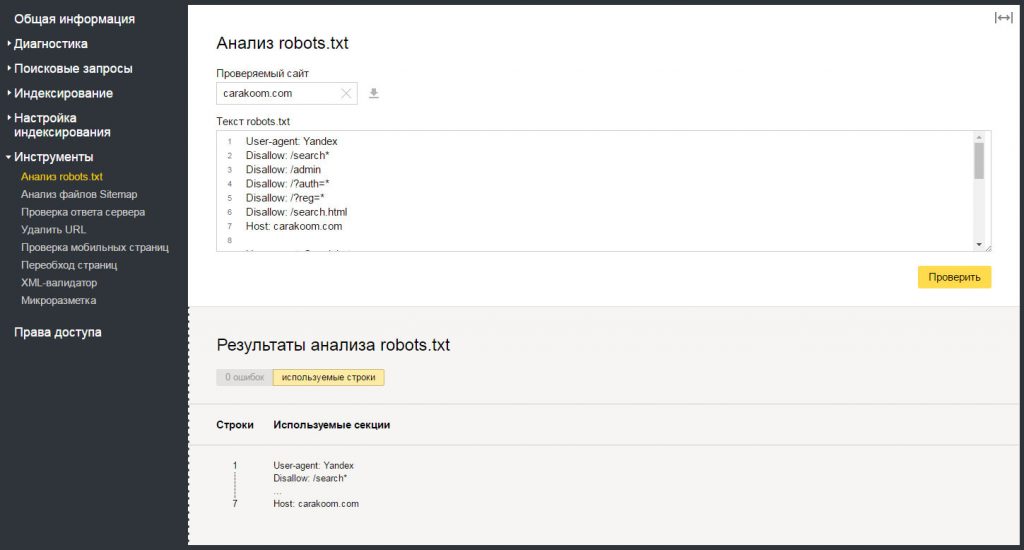

Изменение файла robots.txt

Еще один распространенный метод, к которому прибегают вебмастера. Он позволяет скрыть отдельные документы и целые разделы. В файле robots вы можете не только запретить, но и разрешить поисковым ботам индексировать сайт или определенные страницы. Подобные команды обеспечиваются применением директивы Disallow.

Для скрытия страницы от поисковых машин, вам нужно получить доступ к корневой папке сайта. В документе robots.txt в основном содержатся 2 строки:

- User-agent.

Здесь указывается имя робота определенного поисковика, которому вы запрещаете сканировать страницу, или же прописывается код User-agent: *, применимый сразу для всех ботов.

Здесь указывается имя робота определенного поисковика, которому вы запрещаете сканировать страницу, или же прописывается код User-agent: *, применимый сразу для всех ботов. - Disallow. Тут прописывается URL удаляемой страницы.

Вместе они создают команду для поисковых машин, касающуюся указанного URL. Если требуется, вы можете в одном файле скрыть сразу несколько документов на одном ресурсе, и они никак не будут влиять друг на друга.

Например, вот так мы укажем всем поисковым роботам, чтобы они не индексировали страницы index и password на нашем сайте

User-agent: * Disallow: /index Disallow: /password

Когда вы пропишите данную команду, нужно будет ждать следующей индексации. Вам стоит знать, что все изменения в файле robots несут для поисковиков рекомендательный характер, поэтому не удивляйтесь, если объект по-прежнему останется в индексе, но с пометкой о скрытии через robots.txt. Но если через определенный промежуток времени статус документа не изменится, он все же будет удален из базы данных поисковых систем.

Важно! Если на удаленных страницах есть внешние ссылки, то они останутся доступными для перехода именно по ним. Это связано с тем, что команды в файле robots не удаляют объект из поисковой выдачи фактически, а лишь скрывают его из результатов.

Мета-тег Robots

Если не вдаваться в подробности, то этот способ аналогичен вышеуказанному, вот только все команды прописываются в html-коде сайта внутри тегов head:

<meta name =“robots” content=”noindex,nofollow” />

Все изменения также будут произведены после индексации. Преимущество использования мета-тега robots заключается в том, что посредством него из поиска можно удалить множество URL без необходимости изменения самого файла robots. Данный способ идеально подходит для начинающих сайтостроителей, которые постепенно создают новые страницы.

Также это отличный вариант тогда, когда вам нужно закрыть страницу от индекса Яндекса, но при этом оставить ее доступной в Google. Или же когда вы хотите удалить объект из поиска, но оставить информацию доступной на самом сайте.

Пример закрытия URL только для Яндекса:

<meta name=”yandex” content=”noindex,nofollow”>

Важно! Прописывание мета-тегов отличается от изменения robots.txt тем, что с их помощью вы сможете удалить объект из поиска, даже если на него ведут внешние ссылки. Этому способствует мета-тег noindex. Однако если ваш сайт создан не на базе WordPress, то процедура будет более сложной. Дело в том, что в WP есть специальный плагин Yoast SEO, который и позволяет удалять страницы мета-тегами.

Заключение

Если у вас вдруг появилась необходимость удалить отдельную страницу своего сайта из поискового индекса, вы с легкостью можете воспользоваться всеми указанными в данной статье методами. Выбирайте тот, который для вас более удобный, но при этом учитывайте характерные особенности каждого из них. Вообще, если вы хотите закрыть документ в максимально кратчайшие сроки, используйте сразу несколько вариантов.

Как удалить предупреждения из черного списка Google

Каждый день Google добавляет в черный список около 10 000 веб-сайтов. Ты один из них? Для большинства владельцев веб-сайтов предупреждения безопасности, индикаторы взлома и диагностические страницы могут быть пугающими. Это руководство поможет владельцам веб-сайтов понять, что такое черный список, как удалить взлом веб-сайта и разрешить предупреждения системы безопасности Google. Это поможет вам быстро восстановить свой веб-сайт и вернуть посетителей, доход и SEO-рейтинг.

Ты один из них? Для большинства владельцев веб-сайтов предупреждения безопасности, индикаторы взлома и диагностические страницы могут быть пугающими. Это руководство поможет владельцам веб-сайтов понять, что такое черный список, как удалить взлом веб-сайта и разрешить предупреждения системы безопасности Google. Это поможет вам быстро восстановить свой веб-сайт и вернуть посетителей, доход и SEO-рейтинг.

Общие индикаторы сайта, занесенного в черный список

- Антивирус блокирует часть или весь сайт при его посещении

- Результаты поисковой системы говорят: «Этот сайт может быть взломан»

- При посещении сайта вас блокируют на странице с предупреждением

- Хост уведомляет вас и отключает ваш сайт

- SEO-спам ссылки и перенаправления в SERP (страницы результатов поисковой системы)

- Неожиданные изменения файлов или появление незнакомых файлов

- Страница с предупреждением о безопасном просмотре отображается до перехода на сайт

Защитите свой сайт

Что такое черный список Google?

Понимание черного списка Google

Google является наиболее используемой поисковой системой в мире и стремится обеспечить своим пользователям безопасную работу в Интернете.

Когда поисковая система заносит веб-сайт в черный список, это относится к процессу удаления веб-сайта из их индекса. Когда веб-сайт попадает в черный список, он обычно теряет почти 95% органического трафика, что быстро сказывается на продажах и доходах.

Как проверить, не занесен ли ваш сайт в черный список

Вы хотите узнать, есть ли у вашего сайта вредоносное ПО или статус в черном списке? Наш сканер Sucuri SiteCheck проверит статус занесения в черный список и видимые проникновения вредоносного ПО. Нажмите здесь, чтобы запустить отчет, или, если вы используете сайт WordPress, установите наш бесплатный плагин безопасности WordPress, чтобы автоматизировать проверку безопасности.

Почему сайты попадают в черный список

Сайты попадают в черный список, когда органы, такие как Google, Bing, Norton Safe Web, McAfee SiteAdvisor и т. д., обнаруживают нарушения на веб-сайте, который они считают вредоносным. Вредоносное ПО может проявляться во многих формах: троянские кони, фишинговые схемы, взломы фармацевтических компаний, электронная почта или сбор информации. Чаще всего владелец сайта даже не подозревает, что его взломали. Однако в интересах поисковой системы не показывать зараженные результаты, поскольку они не хотят, чтобы это нарушило их целостность. Существует несколько различных категорий для занесения в черный список, в зависимости от того, почему веб-сайт был заблокирован. Например, некоторые веб-сайты занесены в черный список за спам, другие — за фишинговые ссылки или, в более общем смысле, за наличие вредоносных программ. Ниже мы углубимся в типы причин внесения в черный список.

Как выглядит черный список вредоносных программ?

Большинство современных браузеров предоставляют пользователю собственный уникальный вариант сайта, занесенного в черный список из-за вредоносных программ.

Ниже приведены некоторые предупреждающие сообщения, зарезервированные для черных списков вредоносных программ:

- На следующем сайте содержится вредоносное ПО!

- Подозрительный сайт

- Сайт содержит вредоносные программы

- Эта страница пытается загрузить скрипты из источников, не прошедших проверку подлинности

- Сайт впереди содержит вредоносное ПО!

- Вы имели в виду [имя сайта]?

- Это правильный сайт?

- Этот веб-сайт признан небезопасным

- Впереди обманчивый сайт

Не все указанные выше сообщения исходят от Google, и не все браузеры используют Google SafeBrowsing API для проверки безопасности сайта. Каждое предупреждение предназначено для информирования вас о необходимости проявлять осторожность, если вы продолжите посещать веб-сайт, который, вероятно, был взломан и занесен в черный список, поскольку он распространял вредоносное ПО.

Каждое предупреждение предназначено для информирования вас о необходимости проявлять осторожность, если вы продолжите посещать веб-сайт, который, вероятно, был взломан и занесен в черный список, поскольку он распространял вредоносное ПО.

Понимание предупреждений безопасности Google

«Этот сайт может быть взломан»

Это сообщение используется, чтобы сообщить пользователю, что Google считает, что злоумышленник внес изменения в сайт, добавив новые страницы в виде спама. Посещение сайта может перенаправить посетителя на страницу с различными формами спам-ссылок или спам-страниц.

Это предупреждение не создает красный экран и отображается исключительно на страницах результатов поисковой системы Google (SERP). Для получения дополнительной информации о том, что делать, если вы видите это предупреждение, посетите страницы справки Google.

Для получения дополнительной информации о том, что делать, если вы видите это предупреждение, посетите страницы справки Google.

Официальное объяснение Google: «Вы увидите сообщение «Этот сайт может быть взломан», когда мы полагаем, что хакер мог изменить некоторые из существующих страниц на сайте или добавить новые спам-страницы. Если вы посетите этот сайт, вы можете быть перенаправлены на спам или вредоносное ПО».

«Этот сайт может нанести вред вашему компьютеру»

Это сообщение используется, чтобы сообщить пользователю, что Google считает, что злоумышленники внесли изменения в сайт, который распространяет и устанавливает вредоносное программное обеспечение на компьютер посетителя. Посещение сайта может привести к непоправимому повреждению вашего устройства, которое может включать в себя ряд атак с загрузкой с диска или обманным путем заставить посетителя загрузить вредоносное ПО, например программу-вымогатель.

Google довольно точен, когда подозревает, что веб-сайт распространяет вредоносное ПО среди своих пользователей. Классификация создает большое красное изображение при посещении сайта в нескольких браузерах, использующих Google SafeBrowsing API. Для получения дополнительной информации о том, что делать, если вы видите это уведомление, посетите страницы справки Google.

Классификация создает большое красное изображение при посещении сайта в нескольких браузерах, использующих Google SafeBrowsing API. Для получения дополнительной информации о том, что делать, если вы видите это уведомление, посетите страницы справки Google.

Официальное объяснение Google: «Вы увидите сообщение «Этот сайт может нанести вред вашему компьютеру», когда мы думаем, что сайт, который вы собираетесь посетить, может позволить программам установить вредоносное программное обеспечение на ваш компьютер. компьютер».

Пример предупреждающих сообщений и предупреждений в черном списке

Каждый браузер использует свои собственные сообщения, когда помечает сайт как внесенный в черный список. Если вы видите следующие сообщения на своем сайте в поиске, он был занесен в черный список:

- Этот сайт может нанести вред вашему компьютеру

- Этот сайт может быть взломан

- Впереди обманчивый сайт

- Сообщается, что этот веб-сайт небезопасен

- Сайт впереди содержит вредоносное ПО

- Сайт впереди содержит вредоносные программы

- Предстоит фишинговая атака

- Подозрительный сайт

- Эта страница пытается загрузить скрипты из источников, не прошедших проверку подлинности

- Предупреждение: посещение этого сайта может нанести вред вашему компьютеру

- Предупреждение о вводящем в заблуждение веб-сайте

- Предупреждение: впереди потенциальная угроза безопасности

- Программное обеспечение препятствует безопасному подключению Firefox к этому сайту

Проверить статус предупреждения

Работа с инструментами Google для веб-мастеров для просмотра предупреждений безопасности

Ваш веб-сайт занесен в черный список, поскольку Google просканировал ваш сайт и обнаружил вредоносное поведение. Google необходимо защитить своих пользователей от опасных веб-сайтов, которые появляются в результатах поиска . Фактически, веб-сайты, которые неоднократно попадают в черный список за вредоносное поведение, ограничены только одним просмотром каждые 30 дней . Эта красная заставка (промежуточная) страница (и предупреждения рядом с вашим сайтом в результатах поиска Google) предназначены для того, чтобы посетители не заходили на ваш сайт, и это тоже работает. Веб-сайты теряют около 95% своего трафика, когда Google заносит их в черный список .

Google необходимо защитить своих пользователей от опасных веб-сайтов, которые появляются в результатах поиска . Фактически, веб-сайты, которые неоднократно попадают в черный список за вредоносное поведение, ограничены только одним просмотром каждые 30 дней . Эта красная заставка (промежуточная) страница (и предупреждения рядом с вашим сайтом в результатах поиска Google) предназначены для того, чтобы посетители не заходили на ваш сайт, и это тоже работает. Веб-сайты теряют около 95% своего трафика, когда Google заносит их в черный список .

Мы должны упомянуть страницу Google Safe Browsing, когда говорим о черном списке Google и предупреждениях системы безопасности. Это ключевая страница, о которой должны знать и использовать все владельцы веб-сайтов. Это также быстрый способ определить, занесен ли ваш веб-сайт в черный список Google из-за вредоносного ПО или фишингового контента.

Инструменты Google для веб-мастеров будут содержать более подробную информацию о предупреждениях безопасности вашего веб-сайта.

Узнайте, что занесено в черный список

Вы должны определить, что именно занесено в черный список Google. На странице инструментов Google для веб-мастеров для вашего веб-сайта нажмите «Проблемы безопасности», и вы найдете обнаруженные URL-адреса. Если URL-адрес является каталогом, каждая страница под ним должна быть проверена на наличие вредоносных программ.

Вот несколько примеров или списков блокировки URL:

- blog.example.com/pages/page1.html — только эта страница

- blog.example.com/pages/ — все ниже /pages

- blog.example.com — весь блог

- example.com — весь домен и его поддомены

Эта информация может помочь вам сузить область поиска до определенных разделов вашего сайта.

Определите, когда и почему появился черный список

Затем найдите, когда Google обнаружил подозрительное содержимое в последний раз (дата обнаружения). Вы можете найти эти даты рядом с URL-адресами, указанными в разделе «Обнаруженные проблемы».

Если вы хотите, чтобы Google принял ваши последние изменения, вам следует запросить проверку вредоносного ПО в Инструментах Google для веб-мастеров. Это заставит Google повторно просканировать ваш сайт в течение нескольких дней. Для этого щелкните раздел «Проблемы безопасности», а затем нажмите кнопку «Запросить проверку», чтобы отправить свой сайт.

К сожалению, ссылки на вредоносные сайты обычно сложны, и Google не всегда предоставляет конкретные сведения о черном списке. Стоит отметить, что хакеры довольно часто меняют доменные имена своих вредоносных сайтов, поэтому их невозможно заблокировать. Скомпрометированный законный веб-сайт часто регулярно обновляется, чтобы убедиться, что теперь он ссылается на эти новые вредоносные сайты.

Если ничего не помогает, вы можете нанять профессионалов для очистки вашего сайта.

Предупреждения о вредоносных программах Google SERP

Когда ваш сайт появляется в Google, предупреждения на страницах результатов поисковой системы (SERP) показывают, обнаружены ли на вашем сайте спам или перенаправления . Они также могут быть вызваны, если ваш взломанный сайт используется для заражения посетителей вредоносным программным обеспечением посредством загрузок с диска . Если на вашем сайте еще не отображается красная страница с предупреждением, но эти предупреждения появляются в результатах поиска, это может указывать на загрузку вредоносных скриптов и фреймов со сторонних сайтов. Иногда это также может быть вызвано сторонней рекламой, которая загружается на ваш веб-сайт и может пытаться распространять вредоносное ПО посредством вредоносной рекламы.

Они также могут быть вызваны, если ваш взломанный сайт используется для заражения посетителей вредоносным программным обеспечением посредством загрузок с диска . Если на вашем сайте еще не отображается красная страница с предупреждением, но эти предупреждения появляются в результатах поиска, это может указывать на загрузку вредоносных скриптов и фреймов со сторонних сайтов. Иногда это также может быть вызвано сторонней рекламой, которая загружается на ваш веб-сайт и может пытаться распространять вредоносное ПО посредством вредоносной рекламы.

Большинство черных списков браузера используют API черных списков Google. Для получения дополнительной информации посетите страницы справки Google.

Сканирование вашего сайта на наличие вредоносных программ

Вы можете использовать наш бесплатный инструмент Sucuri SiteCheck для сканирования вашего сайта и обнаружения вредоносных полезных нагрузок, местоположений вредоносных программ, проблем безопасности и статуса в черном списке основных органов власти.

Чтобы просканировать свой веб-сайт на наличие взломов и предупреждений о черном списке с помощью Sucuri SiteCheck:

- Посетите веб-сайт Sucuri SiteCheck и введите URL-адрес своего веб-сайта.

- Щелкните Сканировать веб-сайт .

- Если сайт заражен, обратите внимание на все полезные нагрузки и расположение файлов, обнаруженные SiteCheck.

- Просмотрите статус в черном списке веб-сайтов , чтобы узнать, занесены ли вы в черный список другими органами.

Примечание по хостингу серверов: Если у вас есть несколько веб-сайтов на одном сервере, мы рекомендуем сканировать их все на наличие вредоносного содержимого. Перекрестное заражение является одной из основных причин повторного заражения. Мы рекомендуем каждому владельцу веб-сайта изолировать свои веб-сайты на отдельных учетных записях хостинга.

Если SiteCheck сможет найти полезную нагрузку, это поможет сузить область поиска. Следующий раздел этого руководства поможет вам вручную просмотреть свой сайт на наличие подозрительных элементов, чтобы удалить свой черный список.

Следующий раздел этого руководства поможет вам вручную просмотреть свой сайт на наличие подозрительных элементов, чтобы удалить свой черный список.

Исправление симптомов черного списка

Удаление зараженных файлов

Чтобы выполнить полное удаление вредоносных программ, вы должны иметь возможность редактировать файлы на своем сервере. Если вас это не устраивает, попросите профессионалов очистить ваш сайт.

Замена файла

Если вы используете CMS, такую как WordPress или Joomla, вы можете перестроить сайт, используя свежие копии основных файлов и плагинов непосредственно из официальных репозиториев. Пользовательские файлы можно заменить последней резервной копией, если она не заражена.

Вредоносные домены и полезные нагрузки

Если SiteCheck или Инструменты Google для веб-мастеров обнаружат какие-либо вредоносные домены или полезные нагрузки, вы можете начать поиск этих файлов на своем сервере. Дата обнаружения также может сузить ваш поиск до файлов, измененных в этот период времени.

Чтобы вручную удалить заражение вредоносным ПО из файлов вашего веб-сайта (НЕ из базы данных):

- Войдите на свой сервер через SFTP или SSH.

- Перед внесением изменений создайте резервную копию сайта.

- Найдите в своих файлах любые ссылки на вредоносные домены или полезные нагрузки, которые вы заметили.

- Идентифицировать незнакомые или недавно измененные файлы.

- Восстановление подозрительных файлов копиями из официального репозитория или чистой резервной копии.

- Копируйте любые изменения, внесенные в ваши файлы.

- Проверка работоспособности сайта после этих изменений.

Вы также можете вручную искать распространенные вредоносные функции PHP, такие как eval, base64_decode, gzinflate, preg_replace, str_replace и т. д. Обратите внимание, что эти функции также используются плагинами по законным причинам, поэтому обязательно тестируйте изменения или обращайтесь за помощью, чтобы вы избежите поломки вашего сайта.

Хакеры довольно часто меняют вредоносные сайты, чтобы избежать обнаружения. В результате на странице «Проблемы безопасности» Google могут быть упомянуты вредоносные или промежуточные домены, которых больше нет на вашем сайте, поскольку они уже заменены новыми доменами.

Если вы не можете найти «плохой» контент, попробуйте поискать в Интернете доменные имена, указанные на странице диагностики. Скорее всего, кто-то уже выяснил, как эти доменные имена связаны с вредоносным ПО для веб-сайтов.

Внимание: Ручное удаление «вредоносного» кода из файлов веб-сайта может быть чрезвычайно опасным. Никогда не выполняйте никаких действий без резервной копии. Если вы не уверены, обратитесь за помощью к профессионалу. Не перезаписывайте файлы конфигурации CMS. В WordPress это включает файл wp-config.php или wp-content. В Joomla это включает в себя файл configuration.php и настройки.

Очистить взломанные таблицы базы данных

Чтобы удалить заражение вредоносным ПО из базы данных вашего веб-сайта, используйте панель администратора базы данных для подключения к базе данных. В cPanel большинство хостинговых компаний предлагают phpMyAdmin. Вы также можете использовать такие инструменты, как Search-Replace-DB или Adminer.

В cPanel большинство хостинговых компаний предлагают phpMyAdmin. Вы также можете использовать такие инструменты, как Search-Replace-DB или Adminer.

Чтобы вручную удалить вредоносное ПО из таблиц базы данных:

- Войдите в панель администратора базы данных.

- Перед внесением изменений сделайте резервную копию базы данных.

- Поиск подозрительного контента (например, спам-ключевых слов, ссылок).

- Откройте таблицу с подозрительным содержимым.

- Вручную удалите все подозрительное содержимое.

- Проверка работоспособности сайта после изменений.

- Удалите все инструменты доступа к базе данных, которые вы могли загрузить.

Предотвращение повторного заражения

Хакеры всегда оставляют возможность вернуться на ваш сайт. Чаще всего мы находим несколько бэкдоров, таких как злонамеренные пользователи-администраторы или веб-шеллы PHP, а также пропущенные уязвимости, из-за которых ваш сайт снова попадает в черный список.

Просмотр учетных записей пользователей

Не забывайте об учетных записях пользователей! Украденные пароли могут позволить хакерам вернуться на ваш сайт.

Чтобы очистить ваши учетные записи пользователей:

- Подтвердите, что все учетные записи пользователей веб-сайта действительны, включая пользователей CMS, пользователей FTP/SFTP/SSH, панели администрирования баз данных (PHPMyAdmin и т. д.), учетные записи cPanel и логины хостинговой компании.

- Изменить все пароли для всех пользователей.

- Включить двухфакторную аутентификацию (2FA), если она доступна.

Предупреждение: Эти функции также могут использоваться плагинами на законных основаниях, поэтому обязательно проверяйте любые изменения, потому что вы можете сломать свой сайт, удалив безопасные функции. Большинство вредоносного кода, который мы видим, использует ту или иную форму кодирования для предотвращения обнаружения. Помимо премиальных компонентов, которые используют кодировку для защиты своего механизма аутентификации, очень редко можно увидеть кодировку в официальных файлах CMS.

Идентификация бэкдоров

Часто бэкдоры встраиваются в файлы с именами, похожими на файлы ядра CMS, но расположенными в неверном каталоге. Злоумышленники также могут внедрять бэкдоры в законные файлы.

Бэкдоры обычно включают следующие функции PHP:

- base64

- ул_рот13

- gzuncompress

- оценка

- исполнитель

- функция_создания

- система

- утверждать

- полосы косая черта

- preg_replace (с /e/)

- move_uploaded_file

Крайне важно, чтобы все бэкдоры были удалены для успешного устранения взлома веб-сайта, в противном случае ваш сайт будет быстро повторно заражен и добавлен в черный список.

Secure Computing

Инфекция может перейти с компьютера на ваш сайт с помощью CMS или приложений для передачи файлов. Все компьютеры, используемые для доступа к вашему сайту, должны быть защищены. Попросите всех пользователей просканировать свои компьютеры с помощью антивирусной программы, чтобы обнаружить любые инфекции.

Вот некоторые антивирусные программы, которые мы рекомендуем:

Платные

- BitDefender

- Касперский

- Софос

- F-безопасный

Бесплатно

- Malwarebytes

- Аваст

- Основы безопасности Майкрософт

- Авира

Примечание: Большинство черных списков браузера используют API черных списков Google. Для получения дополнительной информации посетите страницы справки Google.

Удалить ваш веб-сайт из черных списков

Получить Google Search Console

Чтобы удалить предупреждение из черного списка, вам нужно сообщить Google, что вы полностью вылечили инфекцию. Для этого у вас должна быть учетная запись Google Search Console (ранее — Инструменты для веб-мастеров).

Чтобы подтвердить право собственности на свой веб-сайт в Google Search Console:

- Откройте Google Webmaster Central.

- Нажмите Search Console и войдите в свою учетную запись Google.

- Щелкните Добавить сайт.

- Введите URL своего сайта и нажмите «Продолжить».

- Подтвердите свой сайт с помощью параметров Рекомендуемый метод или Альтернативные методы.

- Щелкните Добавить сайт.

- Щелкните Подтвердить.

- Проверьте раздел «Безопасность и ручные действия», чтобы просмотреть все предупреждения.

Другие черные списки веб-сайтов

Google Safebrowsing — не единственный черный список веб-сайтов. Однако многие другие органы власти используют API Google для добавления вредоносных веб-сайтов в свои черные списки.

Антивирусные программы и другие поисковые системы также хотят предупредить своих пользователей, когда веб-сайт опасен. У каждого своя консоль и процесс обзора. Чтобы удалить ваш сайт из их черных списков, вам необходимо выполнить шаги, чтобы сообщить им, что ваш сайт чист.

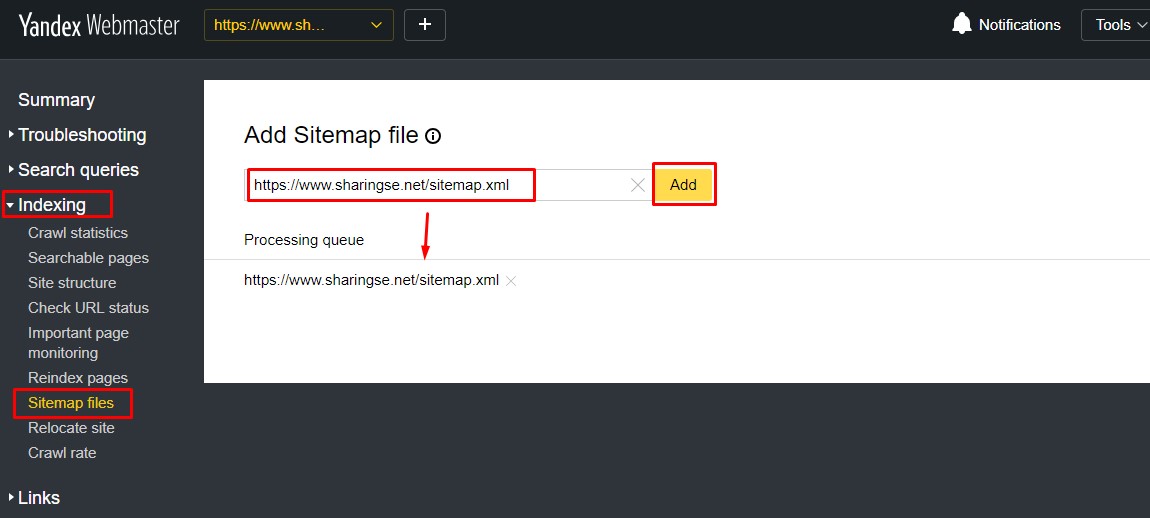

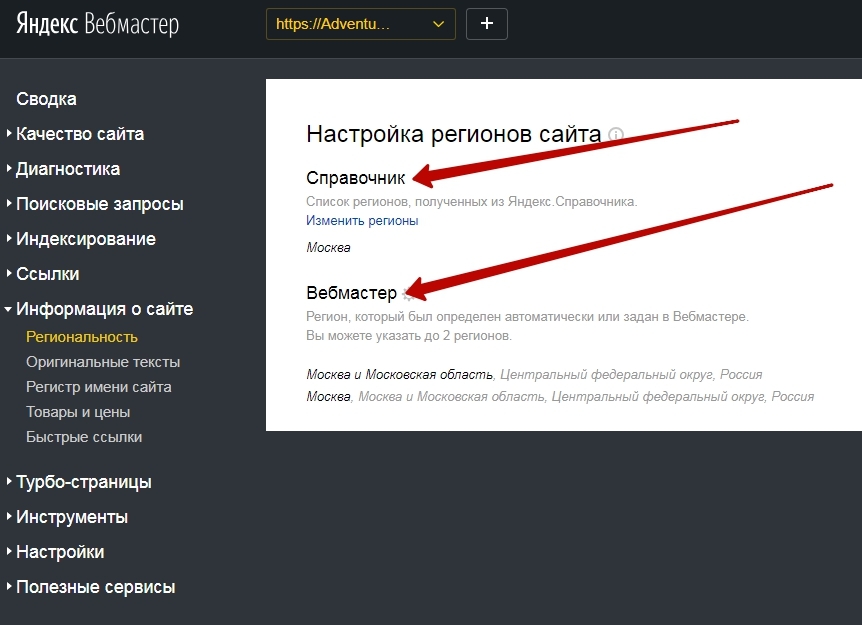

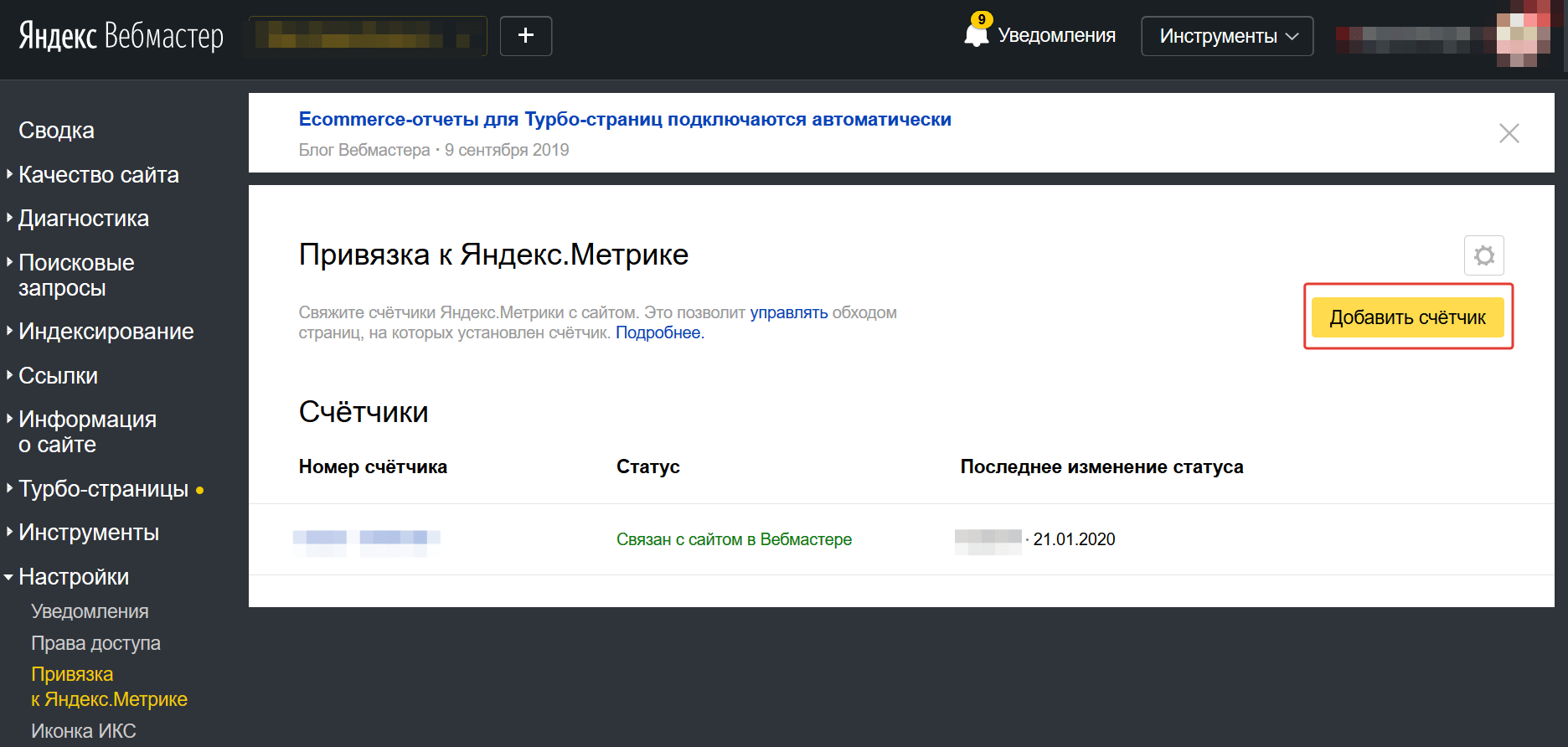

Если вы использовали SiteCheck для сканирования вашего сайта на наличие вредоносных программ на первом этапе, результаты укажут, был ли ваш сайт внесен в черный список некоторыми из высших органов власти. Процесс проверки должен быть аналогичен Google Search Console. Например, в черном списке McAfee есть форма отправки отзыва, а у Bing и Яндекса есть свои собственные инструменты для веб-мастеров, на которые вы должны подписаться.

Процесс проверки должен быть аналогичен Google Search Console. Например, в черном списке McAfee есть форма отправки отзыва, а у Bing и Яндекса есть свои собственные инструменты для веб-мастеров, на которые вы должны подписаться.

Другие авторитетные источники черного списка:

- McAfee SiteAdvisor

- Черный список Bing

- Черный список Яндекса

- Нортон СейфВеб

- Фиштанк

- Спамхаус

- BitDefender

- ESET

Запрос проверки безопасности

Если вы не запросите проверку, Google может решить, что вы не завершили очистку сайта. Запрашивая проверку, вы сообщаете Google, что готовы к повторному сканированию вашего сайта. В настоящее время Google ограничивает правонарушителей, повторно занесенных в черный список, одним запросом на проверку каждые 30 дней. Не пытайтесь обмануть Google, так как он может не пройти процесс проверки. Например, если сайт пуст, он не пройдет проверку. Прежде чем продолжить, убедитесь, что ваш сайт чист!

Чтобы запросить проверку безопасности в Google:

- Перейдите на вкладку «Проблемы безопасности» в Search Console.

- Просмотрите проблемы, чтобы убедиться, что все они устранены.

- Установите флажок, чтобы подтвердить, что эти проблемы устранены.

- Щелкните Запросить проверку.

- Заполните как можно более подробно информацию о том, что было очищено.

Чтобы запросить проверку на спам в Google:

- Перейдите на вкладку «Поисковый трафик» в Search Console.

- Щелкните раздел Действия вручную.

- Просмотрите проблемы, чтобы убедиться, что все они устранены.

- Щелкните Запросить проверку.

- Заполните как можно более подробно информацию о том, что было очищено.

Этот процесс будет аналогичен для других черных списков, таких как McAfee, Bing, Yandex и Norton.

Подождите и защитите свой бренд

После того, как вы отправили запрос на удаление черного списка, Google может пройти несколько дней, чтобы проверить ваш сайт, и Google переиндексирует ваш сайт.

Если заголовок и описание ваших веб-страниц были заражены спамом, для очистки результатов поиска может потребоваться некоторое время. Это связано с тем, что Google сканирует ваш сайт очень часто. К счастью, в Search Console вы можете попросить Google обновить определенные страницы и ссылки на этих страницах.

Это связано с тем, что Google сканирует ваш сайт очень часто. К счастью, в Search Console вы можете попросить Google обновить определенные страницы и ссылки на этих страницах.

Чтобы Google повторно просканировал ваш сайт:

- Используйте поле поиска «Проверить любой URL» в верхней части Search Console для поиска вашего URL.

- Нажмите кнопку «Запросить индексирование» справа.

Затем он обеспечит просмотр вашего веб-сайта без каких-либо ошибок и отправит его на переиндексацию в случае успеха. Если он обнаружит какие-либо ошибки, вам нужно будет просмотреть ошибки и убедиться, что ваш сайт доступен для робота Google.

В случае успеха вы получите следующее сообщение: «URL-адрес добавлен в приоритетную очередь сканирования. Отправка страницы несколько раз не изменит ее положение в очереди или приоритет».

Google просканирует вашу домашнюю страницу и любые ссылки на этой странице. Если у вас есть другие страницы, которые отображаются в результатах поиска Google со спамом в заголовке и описании, вы также можете сканировать эти страницы отдельно.

Примечание: Google Search Console позволяет сканировать 500 отдельных URL-адресов в месяц и только 10 с прямыми ссылками в месяц. Эти 10 лучше всего использовать для сканирования страниц с большим количеством внутренних ссылок, таких как общедоступная карта сайта или ваша домашняя страница.

Удалить спам-URL

Если спам-страницы были удалены с вашего сайта, возможно, они уже были проиндексированы Google. Страницы со спамом могут создавать ошибки 404 (не найдено) при удалении с вашего сайта. Вы можете использовать инструмент удаления URL, чтобы сообщить Google, что эти спам-страницы должны быть удалены из их индекса.

Чтобы удалить URL-адреса спама, вызывающие ошибку 404:

- Перейдите на вкладку Index в Search Console.

- Щелкните раздел Удаление .

- Нажмите кнопку Новый запрос .

- Введите URL-адреса спам-страниц, которые были удалены.

- Нажмите Продолжить .

Внимание! Этот инструмент удаляет страницы из поиска Google. Эта опция помогает после того, как вы удалили спам-страницы, чтобы Google знал, что они на самом деле не являются частью вашего сайта.

Как предотвратить будущие взломы и занесение в черный список

Сосредоточьтесь на защите веб-сайта

Вам также следует подумать о том, чтобы принять дополнительные меры по укреплению и защите вашего сайта, чтобы предотвратить попадание в черный список в будущем. Это включает в себя применение обновлений, поддержание хорошей стратегии резервного копирования веб-сайта, управление привилегиями пользователей и внедрение элементов управления безопасностью веб-сайта.

Количество уязвимостей, используемых злоумышленниками, растет с каждым днем. Попытка не отставать является сложной задачей для администраторов. Брандмауэры веб-сайтов были изобретены для обеспечения системы защиты периметра, окружающего ваш веб-сайт.

Преимущества использования брандмауэра веб-сайта:

- Предотвращение взлома в будущем: Обнаружив и остановив известные методы и поведение взлома, брандмауэр веб-сайта в первую очередь защищает ваш сайт от заражения.

- Virtual Security Updates: хакеры быстро используют уязвимости в плагинах и темах, и всегда появляются неизвестные (так называемые нулевые дни). Хороший брандмауэр веб-сайта залатает дыры в программном обеспечении вашего веб-сайта, даже если вы не применяли обновления безопасности.

- Блокировка атак методом грубой силы: брандмауэр веб-сайта должен блокировать доступ к вашей странице wp-admin или wp-login для всех, кого там не должно быть, чтобы они не могли использовать автоматизацию грубой силы для подбора вашего пароля.

- Смягчение DDoS-атак: распределенные атаки типа «отказ в обслуживании» пытаются перегрузить ваш сервер или ресурсы приложения. Обнаружив и заблокировав все типы DDoS-атак, брандмауэр веб-сайта гарантирует доступность вашего сайта, если вы подвергаетесь атакам с большим количеством поддельных посещений.

- Оптимизация производительности: большинство WAF предлагают кэширование для более высокой глобальной скорости страницы. Это делает ваших посетителей счастливыми и, как доказано, снижает показатель отказов, улучшая взаимодействие с сайтом, конверсию и рейтинг в поисковых системах.

Дополнительные ресурсы

Узнайте, как определить проблемы, если вы подозреваете, что ваш сайт WordPress был взломан.

Смотреть сейчас

Присоединяйтесь к нашей серии электронных писем, поскольку мы предлагаем практические шаги и основные методы обеспечения безопасности для владельцев сайтов WordPress.

Зарегистрироваться

По нашим данным, тремя наиболее часто заражаемыми платформами CMS были WordPress, Joomla! и Мадженто.

Прочитать

Изучите передовые методы обеспечения безопасности для веб-сайтов WordPress, чтобы улучшить состояние веб-сайта и снизить риск компрометации.

См. сейчас

Ошибки сканирования в Google Search Console (Инструменты для веб-мастеров)

Случалось ли это с вами? Вы проверяете отчет «Ошибки сканирования» в консоли поиска Google (ранее известной как «Инструменты для веб-мастеров») и видите так много ошибок сканирования, что не знаете, с чего начать. Множество 404, 500, «мягкие 404», 400 и многие другие… Вот как я справляюсь с большим количеством ошибок сканирования.

Множество 404, 500, «мягкие 404», 400 и многие другие… Вот как я справляюсь с большим количеством ошибок сканирования.

Важное примечание: Эта статья устарела, поскольку в ней рассматриваются отчеты об ошибках старой консоли поиска Google, которых больше не существует. Комментарии закрыты.

Впервые это руководство было опубликовано на сайте retailics.com в 2015 году, с тех пор оно несколько раз обновлялось и перемещалось в этот блог.

Содержание

Вот обзор того, что вы найдете в этой статье:

- Не паникуйте!

- Сначала пометить все ошибки сканирования как исправленные

- Проверяйте отчет об ошибках сканирования раз в неделю

- Классическая ошибка сканирования 404

- 404 ошибки, вызванные ошибочными ссылками с других веб-сайтов

- 404 ошибки, вызванные ошибочными внутренними ссылками или записями карты сайта

- 404 ошибки, вызванные тем, что Google просканировал JavaScript и испортил его 😉

- Тайна 404 ошибки

- Что такое ошибки «Soft 404»?

- Что делать с 500 ошибками сервера?

- Другие ошибки сканирования: 400, 503 и т.

д.

д. - Список всех ошибок сканирования, с которыми я столкнулся в «реальной жизни»

- Пик ошибок сканирования после миграции веб-сайта

- Резюме

Итак, приступим. Прежде всего:

Без паники!

Ошибки сканирования — это то, чего вы обычно не можете избежать, и они не обязательно оказывают немедленное негативное влияние на вашу SEO-эффективность. Тем не менее, это проблема, которую вы должны решить. Низкое количество ошибок сканирования в Search Console является положительным сигналом для Google, поскольку отражает хорошее общее состояние сайта. Кроме того, если бот Google обнаруживает меньше ошибок сканирования на вашей странице, пользователи с меньшей вероятностью увидят ошибки веб-сайта и сервера.

Во-первых, отметьте все ошибки сканирования как исправленные

Поначалу этот совет может показаться глупым, но на самом деле он поможет вам структурировать ошибки сканирования. Когда вы впервые просматриваете свой отчет об ошибках сканирования, вы можете увидеть сотни и тысячи ошибок сканирования из далекого прошлого. Вам будет очень трудно разобраться в этих длинных списках ошибок.

Вам будет очень трудно разобраться в этих длинных списках ошибок.

От этого снимка экрана вам становится легче? Держу пари, тебе лучше, чем этому веб-мастеру 😉

Мой подход заключается в том, чтобы пометить все как исправленное, а затем начать с брака: нерелевантные ошибки сканирования больше не появятся, а те, которые действительно нуждаются в исправлении, скоро вернутся в ваш отчет. Итак, после того как вы очистили свой отчет, выполните следующие действия:

Проверяйте отчет об ошибках сканирования раз в неделю

Выберите фиксированный день каждую неделю и перейдите к отчету об ошибках сканирования. Теперь вы найдете управляемое количество ошибок сканирования. Поскольку их не было за неделю до этого, вы будете знать, что недавно они были обнаружены ботом Google. Вот как справиться с тем, что вы находите в своем отчете об ошибках сканирования раз в неделю:

Классическая ошибка сканирования 404

Это, вероятно, самая распространенная ошибка сканирования на веб-сайтах, а также ее легче всего исправить. Для каждой ошибки 404, с которой сталкивается бот Google, Google сообщает вам, откуда он связан: с другого веб-сайта, другого URL-адреса на вашем веб-сайте или ваших карт сайта. Просто нажмите на ошибку сканирования в отчете, и откроется лайтбокс, подобный этому:

Для каждой ошибки 404, с которой сталкивается бот Google, Google сообщает вам, откуда он связан: с другого веб-сайта, другого URL-адреса на вашем веб-сайте или ваших карт сайта. Просто нажмите на ошибку сканирования в отчете, и откроется лайтбокс, подобный этому:

Обратите внимание, что информация на вкладке «Связано с» не всегда актуальна. Он может содержать URL-адреса, которых больше не существует или которые больше не ссылаются на URL-адрес ошибки. Это связано с тем, что на этой вкладке Google сообщает нам, где он нашел URL-адрес ошибки, а не где он находится.0553 в настоящее время подключено (как следует из названия).

Знаете ли вы, что вы можете загрузить отчет со всеми ошибками сканирования и их ссылками? Таким образом, вам не нужно вручную проверять каждую ошибку сканирования. Перейдите по этой ссылке на проводник Google API. Большинство полей уже предварительно заполнены, поэтому все, что вам нужно сделать, это добавить URL-адрес вашего веб-сайта (точный URL-адрес свойства Search Console, с которым вы имеете дело) и нажать «Авторизовать и выполнить».

Дайте мне знать, если у вас есть какие-либо вопросы по этому поводу!

Теперь давайте посмотрим, что вы можете сделать с различными типами ошибок 404.

Если ложный URL-адрес связан с другим веб-сайтом, вам следует просто реализовать перенаправление 301 с ложного URL-адреса на правильную цель. Возможно, вы сможете обратиться к веб-мастеру ссылающейся страницы с просьбой внести коррективы, но в большинстве случаев это не стоит затраченных усилий.

Если ложный URL-адрес, вызвавший ошибку 404 для бота Google, связан с одной из ваших собственных страниц или с карты сайта, вы должны исправить ссылку или запись в карте сайта. В этом случае также рекомендуется перенаправить 301 URL-адрес 404 в правильное место назначения, чтобы он исчез из индекса Google и передал силу ссылки, которую он мог иметь.

Ошибки 404, вызванные тем, что Google сканирует JavaScript и искажает его 😉

Иногда вы сталкиваетесь со странными ошибками 404, на которые, согласно Google Search Console, ссылаются несколько или все ваши страницы. Когда вы ищете ссылки в исходном коде, вы обнаружите, что на самом деле это относительные URL-адреса, которые включены в скрипты, подобные этому (просто случайный пример, который я видел в одном из моих свойств Google Search Console):

Когда вы ищете ссылки в исходном коде, вы обнаружите, что на самом деле это относительные URL-адреса, которые включены в скрипты, подобные этому (просто случайный пример, который я видел в одном из моих свойств Google Search Console):

По словам Google, это вообще не проблема, и этот тип ошибки 404 можно просто игнорировать. Прочтите параграф 3) этого поста Джона Мюллера из Google для получения дополнительной информации (а также остальной части, поскольку она очень полезна):

Загадка 404 ошибки

В некоторых случаях источник ссылки остается загадкой. Данные, которые Google предоставляет в отчетах об ошибках сканирования, не всегда надежны на 100%. Например, информация на вкладке «Связано с» не всегда актуальна и может содержать URL-адреса, которые не существуют уже много лет или больше не ссылаются на URL-адреса ошибок. В таких случаях вы все равно можете настроить перенаправление 301 для ложного URL.

Не забывайте всегда отмечать все ошибки сканирования 404, которые вы устранили, как исправленные в своем отчете об ошибках сканирования. Если есть ошибки сканирования 404, с которыми вы не знаете, что делать, вы все равно можете пометить их как исправленные и собрать в «список тайн». Если они продолжат появляться снова, вы знаете, что вам придется копнуть глубже в проблему. Если они больше не появятся, тем лучше.

Если есть ошибки сканирования 404, с которыми вы не знаете, что делать, вы все равно можете пометить их как исправленные и собрать в «список тайн». Если они продолжат появляться снова, вы знаете, что вам придется копнуть глубже в проблему. Если они больше не появятся, тем лучше.

Если вы столкнулись с загадочной ошибкой 404, не стесняйтесь оставить мне комментарий в конце этой статьи. Я буду рад проверить вашу проблему.

Давайте теперь посмотрим на странный вид «мягких ошибок 404».

Что такое ошибки «Soft 404»?

Это изобретение Google, не так ли? По крайней мере, я больше нигде не слышал об ошибках «Soft 404». Ошибка «Soft 404» — это пустая страница, обнаруженная ботом Google, которая вернула код состояния 200.

Таким образом, Google считает, что это страница, которая, по мнению Google, должна быть страницей 404, но это не так. В 2014 году веб-мастера начали получать ошибки «Soft 404» для некоторых своих страниц с реальным контентом. Это способ Google сообщить нам, что на наших страницах есть «неконтент».

Работа с ошибками «Soft 404» так же проста, как и с обычными ошибками 404:

- Если URL-адрес ошибки «Soft 404» не должен существовать, 301 перенаправит его на существующую страницу. Также убедитесь, что вы решили проблему с несуществующими URL-адресами, которые не возвращают правильный код ошибки 404.

- Если URL-адрес страницы «Soft 404» является одной из ваших страниц фактического содержания, это означает, что Google рассматривает ее как «неполное содержание». В этом случае убедитесь, что вы добавили ценный контент на свой сайт.

После устранения ошибок «Soft 404» не забудьте пометить их как исправленные. Далее, давайте посмотрим на жестокие виды 500 ошибок сервера.

Что делать с 500 ошибками сервера?

500 ошибок сервера, вероятно, единственный тип ошибок обхода, о которых вам следует немного беспокоиться. Если бот Google регулярно обнаруживает ошибки сервера на вашей странице, это очень сильный сигнал для Google о том, что с вашей страницей что-то не так, и это в конечном итоге приведет к ухудшению рейтинга.

Этот тип ошибки сканирования может появляться по разным причинам. Иногда это может быть определенный поддомен, каталог или расширение файла, из-за которых ваш сервер возвращает код состояния 500 вместо страницы. Разработчик вашего веб-сайта сможет исправить это, если вы отправите ему или ей список последних 500 ошибок сервера из инструментов Google для веб-мастеров.

Иногда в консоли поиска Google появляется 500 ошибок сервера из-за временной проблемы. Возможно, сервер некоторое время был недоступен из-за технического обслуживания, перегрузки или форс-мажорных обстоятельств. Обычно это то, что вы сможете узнать, проверив свои файлы журналов и поговорив с вашим разработчиком и хостом веб-сайта. В таком случае вы должны попытаться убедиться, что такая проблема не повторится в будущем.

Обратите внимание на ошибки сервера, которые отображаются в инструментах Google для веб-мастеров, и постарайтесь максимально ограничить их появление. Бот Google всегда должен иметь доступ к вашим страницам без каких-либо технических барьеров.

Давайте посмотрим на некоторые другие ошибки сканирования, с которыми вы можете столкнуться в своих инструментах Google для веб-мастеров.

Другие ошибки сканирования: 400, 503 и т. д.

В этой статье мы рассмотрели наиболее важные и распространенные ошибки сканирования: 404, «Soft 404» и 500. Время от времени вы можете встретить другие типы сканирования ошибки, вроде 400, 503, «Отказано в доступе», «Неверные редиректы» (для смартфонов) и так далее.

Во многих случаях Google предоставляет некоторые пояснения и идеи о том, как справляться с различными типами ошибок.

В общем, рекомендуется устранять все обнаруженные ошибки сканирования и стараться избегать их повторного появления в будущем. Чем меньше ошибок сканирования обнаруживает бот Google, тем больше Google доверяет вашему сайту. Страницы, которые постоянно вызывают ошибки сканирования, также будут считаться неудобными для пользователей и будут иметь более низкий рейтинг, чем здоровые веб-сайты.

Дополнительную информацию о различных типах ошибок сканирования вы найдете в следующей части этой статьи:

Список всех ошибок сканирования, с которыми я столкнулся в «реальной жизни»

Я подумал, что было бы интересно включить список всех типы ошибок сканирования, которые я действительно видел в свойствах Google Search Console, над которыми я работал. У меня не так много информации обо всех них (кроме рассмотренных выше), но вот:

Ошибка сервера (500)

В этом отчете Google перечисляет URL-адреса, которые вернули ошибку 500, когда Google бот попытался просканировать страницу. Подробнее см. выше.

Soft 404

Это URL-адреса, которые вернули код состояния 200, но, согласно Google, должны возвращать ошибку 400. Я предложил некоторые решения для этого выше.

Доступ запрещен (403)

Здесь Google перечисляет все URL-адреса, которые вернули ошибку 403, когда бот Google попытался их просканировать. Убедитесь, что вы не ссылаетесь на URL-адреса, требующие аутентификации. Вы можете игнорировать ошибки «Отказано в доступе» для страниц, которые вы включили в свой файл robots.txt, потому что вы не хотите, чтобы Google получал к ним доступ. Тем не менее, может быть хорошей идеей использовать ссылки nofollow при переходе на эти страницы, чтобы Google не пытался сканировать их снова и снова.

Убедитесь, что вы не ссылаетесь на URL-адреса, требующие аутентификации. Вы можете игнорировать ошибки «Отказано в доступе» для страниц, которые вы включили в свой файл robots.txt, потому что вы не хотите, чтобы Google получал к ним доступ. Тем не менее, может быть хорошей идеей использовать ссылки nofollow при переходе на эти страницы, чтобы Google не пытался сканировать их снова и снова.

Не найдено (404 / 410)

«Не найдено» — это классическая ошибка 404, о которой говорилось выше. Прочтите комментарии, чтобы узнать интересную информацию об ошибках 404 и 410.

Не отслеживается (301)

Ошибка «не отслеживается» относится к URL-адресам, которые перенаправляют на другой URL-адрес, но перенаправление не работает. Исправьте эти перенаправления! » по неустановленной причине». Я предлагаю вам обрабатывать эти ошибки так же, как и обычные ошибки 404.

Flash-контент (смартфон)

В этом отчете просто перечислены страницы с большим количеством flash-контента, который не будет работать на большинстве смартфонов. Избавьтесь от вспышки!

Избавьтесь от вспышки!

Заблокировано (смартфон)

Эта ошибка относится к страницам, к которым мог получить доступ робот Google, но которые были заблокированы для мобильного робота Google в вашем файле robots.txt. Убедитесь, что вы разрешили всем ботам Google доступ к контенту, который вы хотите проиндексировать!

Если у вас есть какие-либо вопросы или дополнительная информация об ошибках сканирования, перечисленных выше, или других типах ошибок сканирования, сообщите мне.

Пик ошибок сканирования после миграции веб-сайта

После миграции веб-сайта можно ожидать пик ошибок сканирования. Даже если вы сделали все, что в ваших силах, чтобы подготовить миграцию с точки зрения SEO, очень вероятно, что бот Google столкнется с большим количеством ошибок 404 после перезапуска.

Если количество ошибок сканирования в Инструментах Google для веб-мастеров возрастает после миграции, не нужно паниковать. Просто следуйте инструкциям, описанным выше, и постарайтесь исправить как можно больше ошибок сканирования в течение нескольких недель после миграции.

Здесь указывается имя робота определенного поисковика, которому вы запрещаете сканировать страницу, или же прописывается код User-agent: *, применимый сразу для всех ботов.

Здесь указывается имя робота определенного поисковика, которому вы запрещаете сканировать страницу, или же прописывается код User-agent: *, применимый сразу для всех ботов.

д.

д. Дайте мне знать, если у вас есть какие-либо вопросы по этому поводу!

Дайте мне знать, если у вас есть какие-либо вопросы по этому поводу!