Как избавиться от дублей страниц

Статьи по теме

Всем привет! В прошлой статье мы затронули важную тему — поиск дублей страниц сайта. Как показали комментарии и несколько пришедших мне на почту писем, эта тема актуальна. Дублированный контент на наших блогах, технические огрехи CMS и различные косяки шаблонов не дают нашим ресурсам полной свободы в поисковых системах. Поэтому нам приходится с ними серьезно бороться. В этой статье мы узнаем как можно убрать дубли страниц любого сайта, примеры этого руководства покажут как от них можно избавиться простым способом. От нас просто требуется использовать полученные знания и следить за последующими изменениями в индексах поисковиков.

Всем привет! В прошлой статье мы затронули важную тему — поиск дублей страниц сайта. Как показали комментарии и несколько пришедших мне на почту писем, эта тема актуальна. Дублированный контент на наших блогах, технические огрехи CMS и различные косяки шаблонов не дают нашим ресурсам полной свободы в поисковых системах. Поэтому нам приходится с ними серьезно бороться. В этой статье мы узнаем как можно убрать дубли страниц любого сайта, примеры этого руководства покажут как от них можно избавиться простым способом. От нас просто требуется использовать полученные знания и следить за последующими изменениями в индексах поисковиков.

Моя история борьбы с дублями

Перед тем, как мы займемся рассмотрением способов устранения дубликатов, я расскажу свою историю борьбы с дублями.

Два года назад (25 мая 2012 года) я получил в свое распоряжение учебный блог на курсах se0-специалиста. Он мне был дан для того, чтобы во время учебы практиковать полученные знания. В итоге за два месяца практики я успел наплодить пару страниц, десяток постов, кучу меток и вагон дублей. К этому составу в индекс Google в последующие полгода, когда учебный блог стал моим личным сайтом, прибавились и другие дубликаты. Это получилось по вине replytocom из-за растущего число комментариев. А вот в базе данных Яндекса количество проиндексированных страниц росло постепенно.

В начале 2013 года я заметил конкретное проседание позиций моего блога в Гугле. Тогда то я и задумался, почему так происходит. В итоге докопался до того, что обнаружил большое число дублей в этом поисковике. Конечно, я стал искать варианты их устранения. Но мои поиски информации ни к чему не привели — толковых мануалов в сети по удалению дублей страниц я не обнаружил. Но зато смог увидеть одну заметку на одном блоге о том, как можно с помощью файла robots.txt удалить дубликаты из индекса.

Первым делом я написал кучу запрещающих директив для Яндекса и Гугла по запрету сканирования определенных дублированных страниц. Потом, в середине лета 2013 года использовал один метод удаления дублей из индекса Goоgle (о нем Вы узнаете в этой статье). К тому времени в индексе этой поисковой системы накопилось более 6 000 дублей! И это имея на своем блоге всего пятерку страниц и более 120-ти постов…

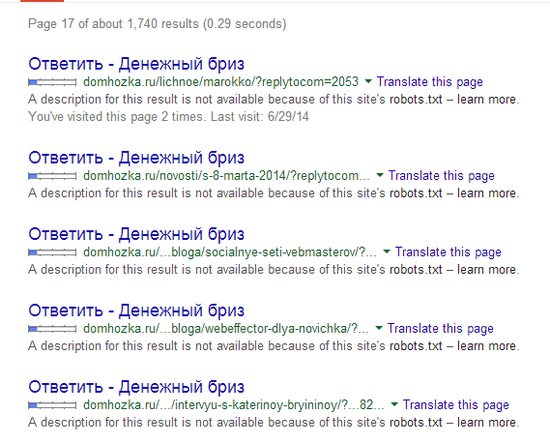

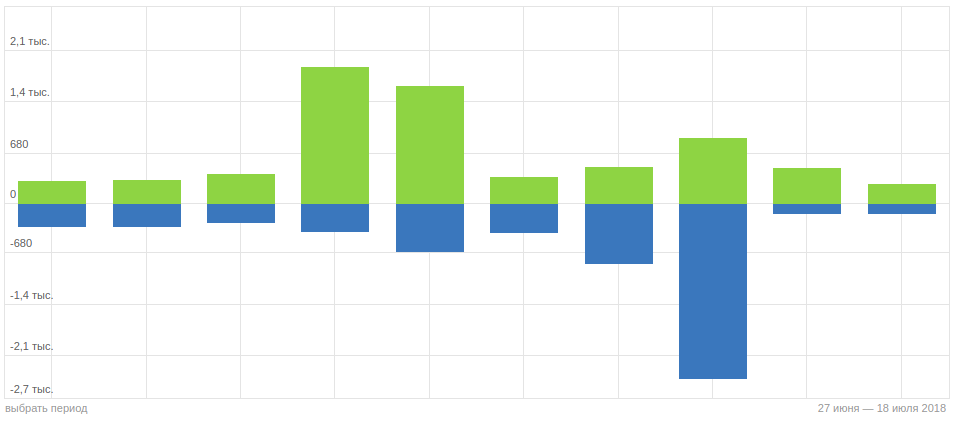

После того, как я реализовал свой метод удаления дублей, число их стало стремительно уменьшаться. В начале этого года я использовал еще один вариант удаления дубликатов для ускорения процесса (о нем Вы тоже узнаете). И сейчас на моем блоге число страниц в индексе Гугла приближается к идеальному — на сегодняшний день в базе данных находится около 600 страниц. Это в 10 раз меньше, чем было раньше!

Как убрать дубли страниц — основные методы

Существует несколько различных способов борьбы с дублями. Одни варианты позволяют запретить появление новых дубликатов, другие могут избавиться от старых. Конечно, самый лучший вариант — это ручной. Но для его реализации нужно отлично разбираться в CMS своего сайта и знать работу алгоритмов поисковой системы. Но и другие методы тоже хороши и не требуют специализированных знаний. О них мы сейчас и поговорим.

301 редирект

Данный способ считается самым эффективным, но и самым требовательным к знанию программирования. Дело в том, что здесь прописываются нужные правила в файле .htaccess (находиться в корне директории сайта). И если они прописываются с ошибкой, то можно не только не решить поставленную задачу удаления дублей, но и вообще убрать весь сайт из Интернета.

Как же решается задачка удаления дублей с помощью 301-го редиректа? В основу его лежит понятие переадресации поисковых роботов с одной страницы (с дубля) на другую (оригинальную). То есть робот приходит на дубликат какой-то страницы и и с помощью редиректа появляется на нужном нам оригинальном документе сайта. Его то он и начинает изучать, пропуская дубль вне поля своего зрения.

Со временем после прописки всех вариантов этого редиректа, склеиваются одинаковые страницы и дубли со временем выпадает с индекса. Поэтому этот вариант отлично чистит уже проиндексированные ранее дубли страниц. Если Вы решите воспользоваться этим методом, то обязательно перед пропиской правил в файле .htaccess, изучите синтаксис создания редиректов. Например, рекомендую для изучения руководство по 301-му редиректу от Саши Алаева.

Создание канонической страницы

Данный способ используется для указания поисковой системе того документа из всего множества его дублей, который должен быть в основном индексе. То есть такая страница считается оригинальной и участвует в поисковой выдаче.

Для ее создания необходимо на всех страницах дублей прописать код с урлом оригинального документа:

<link rel= «canonical» href= «http://www.site.ru/original-page.html»>

Конечно, прописывать все это вручную тяжковато. Для этого существуют различные плагины. Например, для своего блога, который работает на движке ВордПресс, я указал этот код с помощью плагина «All in One SEO Pack». Делается это очень просто — ставиться соответствующая галочка в настройках плагина:

К сожалению, вариант с канонической страницей не удаляет дубли страниц, а только предотвращает их дальнейшее появление. Для того, чтобы избавиться от уже проиндексированных дубликатов, можно использовать следующий способ.

Директива Disallow в robots.txt

Файл robots.txt является инструкцией для поисковых систем, в которой им даются указания, как нужно индексировать наш сайт. Без этого файла поисковый робот может дотянуться практически до всех документов нашего ресурса. Но такая вольность поискового паука нам не нужна — не все страницы мы желаем видеть в индексе. Особенно это кассается дублей, которые появляются благодаря не соврешнеству шаблона сайта или наших ошибок.

Вот поэтому то и создан такой файл, в котором прописываются различные директивы запрета и допуска индексации поисковым системам. Запретить сканирование дублей страниц можно с помощью директивы Disallow:

При создании директивы тоже нужно правильно составлять запрет. Ведь если ошибиться при заполнении правил, то на выходе может получиться совсем не та блокировка страниц. Тем самым мы можем ограничить доступ к нужным страницам и дать просочиться другим дублям. Но все же здесь ошибки не так страшны, как при составлении правил редиректа в .htaccess.

Запрет на индексацию с помощью Disallow действует для всех роботов. Но не для всех эти запреты позволяют поисковой системе убирать из индекса запрещенные страницы. Например, Яндекс со временем удаляет блокированные в robots.txt дубли страниц.

А вот Google не будет очищать свой индекс от ненужного хлама, который указал веб-мастер. К тому же директива Disallow не является гарантом этой блокировки. Если на запрещенные в инструкции страницы идут внешние ссылки, то они со временем появятся в базе данных Гугла.

Избавляемся от дублей, проиндексированных в Яндексе и Google

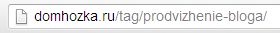

Итак, с различными методами разобрались, пришло время узнать пошаговый план удаления дубликатов в Яндексе и Гугле. Перед тем, как проводить зачистку, необходимо найти все дубли страниц — об этом я писал в прошлой статье. Нужно перед глазами видеть, какие элементы адресов страниц отражены в дублях. Например, если это страницы с древовидными комментариями или с пагинацией, то мы фиксируем содержащие в их адресах слова «replytocom» и «page»:

Замечу, что для случая с replytocom можно взять не это словосочетание, а просто вопросительный знак. Ведь он всегда присутствует в адресе страниц древовидных комментариев. Но тогда нужно помнить о том, что уже в урлах оригинальных новых страниц не должно быть символа «?», иначе и эти станицы уйдут под запрет.

Чистим Яндекс

Для удаления дублей в Яндексе создаем правила блокировки дубликатов с помощью директивы Disallow. Для этого совершаем следующие действия:

- Открываем в Яндекс Вебмастере специальный инструмент «Анализ robot.txt».

- Вносим в поле директив новые правила блокировки дублей страниц.

- В поле «список URL» вносим примеры адресов дубликатов по новым директивам.

- Нажимаем кнопку «Проверить» и анализируем полученные результаты.

Если мы все верно сделали, то данный инструмент покажет о наличии блокировки по новым правилам. В специальном поле «Результаты проверки URL» мы должны увидеть красную надпись о запрете:

После проверки мы должны отправить созданные директивы по дублям в настоящий файл robots.txt и переписать его в директории нашего сайта. А далее нам просто нужно подождать, пока Яндекс автоматически не выгребет из своего индекса наши дубли.

Чистим Google

С Гуглом не все так просто. Запретные директивы в robots.txt не удаляют дубли в индексе этой поисковой системы. Поэтому нам придется все делать своими силами. Благо для этого есть отличный сервис Google вебмастер. А конкретно нас интересует его инструмент «Параметры URL».

С Гуглом не все так просто. Запретные директивы в robots.txt не удаляют дубли в индексе этой поисковой системы. Поэтому нам придется все делать своими силами. Благо для этого есть отличный сервис Google вебмастер. А конкретно нас интересует его инструмент «Параметры URL».

Именно благодаря этому инструменту, Google позволяет владельцу сайта сообщить поисковику сведения о том, как ему нужно обрабатывать те или иные параметры в урле. Нас интересует возможность показать Гуглу те параметры адресов, страницы которых являются дублями. И именно их мы хотим удалить из индекса. Вот что нам нужно для этого сделать (для примера добавим параметр на удаление дублей с replytocom):

- Открываем в сервисе Гугла инструмент «Параметры URL» из раздела меню «Сканирование».

- Нажимаем кнопку «Добавление параметра», заполняем форму и сохраняем новый параметр:

В итоге у нас получается прописанное правило для пересмотра Гуглом своего индекса на наличие дублированных страниц. Таким образом дальше мы прописываем следующие параметры для других дубликатов, от которых хотим избавиться. Например, вот так выглядит часть моего списка с прописанными правилами для Гугла, чтобы он подкорректировал свой индекс:

На этом наша работа по чистке Гугла завершена, а мой пост подошел к концу. Надеюсь, эта статья принесет Вам практическую пользу и позволит Вам избавиться от дублей страниц Ваших ресурсов.

С уважением, Ваш Максим Довженко

P.S. Друзья, если нужно сделать видео по этой теме, то напишите мне в комментарии к этой статье.

как избавится от них раз и навсегда

Добрый день, уважаемые читатели! Сегодня мы поговорим об очень важном моменте в настройке блога: а именно удалении дублированного контента или дублей страниц и о правильной настройке блога, чтобы эти дубли больше не появлялись.

Добрый день, уважаемые читатели! Сегодня мы поговорим об очень важном моменте в настройке блога: а именно удалении дублированного контента или дублей страниц и о правильной настройке блога, чтобы эти дубли больше не появлялись.

Я давно пыталась найти решение этой проблемы. Информации в Интернете много, но она однотипна и по большей части ошибочна.

Это я проверила на себе, так как использовала способы описанные в различных статьях, но от этого дублей меньше не становилось. Но благодаря одному блоггеру решение было найдено. Итак, обо всем по порядку.

Вы узнаете:

- что такое дубли страниц;

- как проверить блог на наличие дублей;

- как от них избавиться.

Что такое дубли страниц

Дублированный контент создается, когда одна и та же страница доступна по нескольким адресам.

Дубли могут создаваться за счет внешних и внутренних факторов.

- К внешним фактором относится — воровство контента. Когда кто-то скопировал Вашу статью, а она еще не успела проиндексироваться, то она становится дублем. Выход здесь один защищать свои статьи от копирования всеми возможными способами и ускорять их индексацию.

- Но дубли создает и Ваш движок WordPress. Это классная платформа для ведения блога, но и у нее есть недостатки.

Если вы перейдете в рубрику, где находится нужная вам статья, то увидите следующую ссылку:

А если будете искать статью с помощью меток или тегов, то увидите следующее:

А анонс на главной странице будет иметь следующий адрес:

Все эти ссылки создают дубли страниц. И это еще не все проблемы с дубликатами страниц.

Как найти дубли страниц

В этом вам помогут инструменты для Вебмастеров от Яндекса и Гугл. О них я уже упоминала в этой статье. И если вы еще не зарегистрировали в них свой блог, то очень советую это сделать.

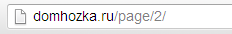

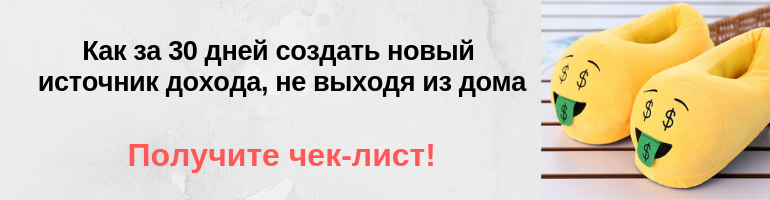

В Яндексе выбираете раздел «Индексирование сайта» →»Страницы в поиске»:

И смотрите, какие ссылки находятся в индексе и нет ли дублей. У меня было около 50 дублирующих ссылок. О том, что с ними делать, вы узнаете чуть позже.

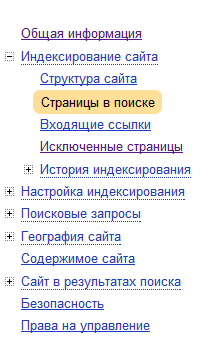

Также не забудьте проверить ссылки и в инструментах для вебмастеров Google:

Но если тут все в порядке, то это не значит, что дублей нет. Особенно это качается Гугл. У него кроме основного индекса есть еще и дополнительный (Supplemental Index или Сопли). И вот туда он отправляет очень много ссылок. Они не появляются в основной выдаче, но очень сильно мешают продвижению, так как Google может наложить фильтр за дублированный контент.

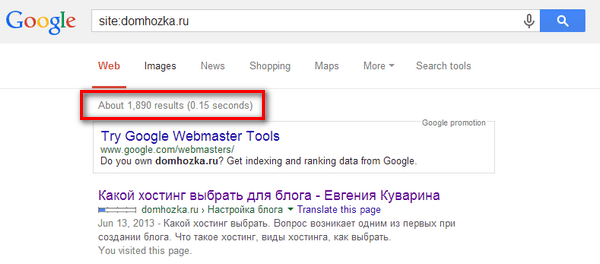

Чтобы проверить, есть ли у Вас дубли наберите в поисковой строке: site:domhozka.ru

Разумеется Вы указываете домен Вашего блога.

Смотрите, что получается у меня:

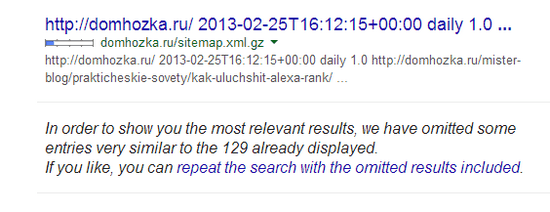

Найдено 1890 ссылок, хотя должно быть всего 130 не более. Это значит, что на блоге полно дублей. Перейдите на последнюю страницу и нажмите «Отобразить скрытые данные»:

Снова перейдите ближе к концу и Вы увидите эти дубли:

На скриншоте Вы видите дубли, которые создаются, когда пользователи отвечают на чей-то комментарий. И если у Вас на блоге происходит активное общение, то дубли могут разрастаться, как снежный ком.

О том, как удалить дубли replytocom я расскажу отдельно чуть дальше.

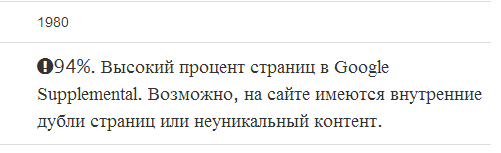

Также Вы можете проанализировать Ваш сайт с помощью сервиса seolib.ru (экспресс-анализ). Он покажет сколько процентов ссылок находится в дополнительном индексе. И если Вы увидите такую картину:

То это опять же говорит, о наличии дублей.

Если в ссылке присутствуют переменные: replytocom, feed, trackback, attachement, attachement, page, category, то знайте, что это дубли. Чтобы проверить сколько ссылок с определенной переменной есть у Вас, добавьте после названия сайта переменную, например, site:domhozka.ru replytocom и нажмите на показать скрытые результаты. И так с каждой переменной.

Как удалить дублированный контент

В блогосфере было принято закрывать дубли с помощью файла robots.txt. Этим способом пользуются 99% блоггеров и пользовалась и я.

Но это не решает проблему, а наоборот создает ее. Так как Google не реагирует на команды в роботсе, вернее реагирует не так, как нам надо. Он видит, что страница закрыта от индексации и так как не знает, что это за страница на всякий случай отправляет ее в дополнительный индекс. Теперь Вы поняли откуда берутся дубли? Все из-за неправильного robots.txt.

Нельзя закрывать дубли с помощью robots.txt. Конечно, это не означает, что теперь этот файл стал не нужным.

Нет для того, чтобы Ваш блог индексировался, он необходим, но в нем должно быть как можно меньше информации. Мой robots.txt вы можете посмотреть здесь. А дубли стоит закрывать с помощью других инструментов.

О которых я сейчас и расскажу.

Главное зеркало сайта

Определите главное зеркало сайта. Зеркала — это сайты, которые являются полными или частичными копиями, например domhozka.ru и www.domhozka.ru.

Поисковые системы определяют данные зеркала, а затем склеивают их и выбирают главное на свое усмотрение, если Вы не подсказали им, какой сайт Вы хотите сделать главным.

Для этого в файле robots прописывается директива: Host: domhozka.ru

Вы можете указать домен с www, если хотите сделать его главным зеркалом.

Далее Вы идете в инструменты Вебмастеров и указывает главное зеркало там. В Инструментах от Яндекса Вы выбираете:

Настройка индексирования → Главное зеркало:

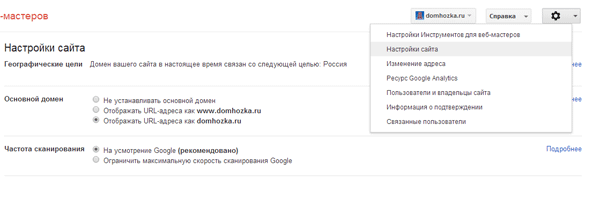

В инструментах Гугл Вы нажимаете на шестеренку в правом верхнем углу и выбираете Настройки сайта:

Имейте в виду, что в роботсе и в инструментах должно быть указано одно и то же главное зеркало.

Кроме этого можно настроить редирект 301 в файле htaccess

Я использую следующий вариант редиректа с www. domhozka.ru на домен без www:

RewriteCond %{HTTP_HOST} ^www\.(.*) [NC]

RewriteRule ^(.*)$ http://%1/$1 [R=301,L]301 редирект

Наиболее эффективный способ, но он требует специальных знаний. Если Вы ими не обладаете, то лучше всего будет обратиться к специалисту. Этот способ хорош еще и тем, что он помогает избавиться уже от существующих дублей.

Суть редиректа в том, что с помощью него происходит переадресация со страницы дубля на оригинальную.

Я настроила редиректы с помощью информации, полученной из курса А. Борисова «Блоггер Тысячник 3.0«

Канонический URL

Еще один вариант предупредить дубли, это указать ПС каноническую страницу, то есть страницу которая будет основной и которую нужно отправить в основной индекс

Для этого на странице следует прописать тег link с атрибутом rel=»canonical»

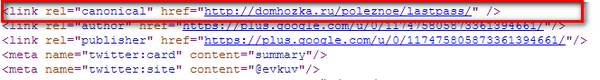

У меня это реализовано с помощью плагина Yoast WordPress Seo. Если Вы откроете код любой статьи, то увидите этот тег:

Каноническая страница предотвращает появление дублей, но не приводит к удалению уже существующих.

Каноническая страница предотвращает появление дублей, но не приводит к удалению уже существующих.

Дубли для рубрик и тегов Вы также можете удалить с помощью seo плагина. Заходите в Заголовки и метаданные → Таксономии и ставите галочку в строке Мета Robots в разделах Рубрики, Метки, Формат. Сохраняете изменения. Затем переходите во вкладку Остальное и отключаете Архивы автора и даты.

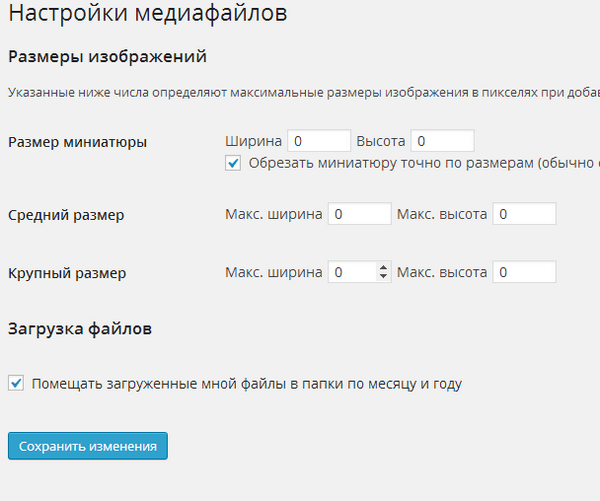

Дубли картинок

Теперь надо поработать над картинками. В Админ-панели WordPress зайдите в Настройки → Медиафайлы и везде поставьте 0. Это избавит Вас от дублей и сэкономит место на хостинге.

Этот способ подойдет не для всех. Сначала изучите, какие размеры картинок Вы используете на блоге. Например, если Вы выводите похожие записи с помощью миниатюр, то этот способ Вам не подойдет.

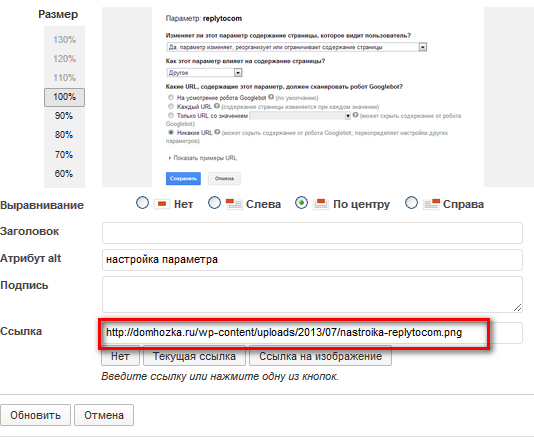

После вставки изображения в статью, удалите ссылку на нее здесь:

Эта ссылка позволяет открыть картинку в новом окне, но в большинстве случаев это необязательно. У меня на блоге я оставила ссылки только для фотографий о Марокко, чтобы их было удобнее смотреть при желании.

У остальных изображений я эту ссылку удалила, так как нет необходимости открывать на отдельной странице, тем самым создавая дублирование контента.

В новой версии WordPress эту ссылку можно удалить сразу после загрузки изображения. Просто проследите, чтобы в Настройках изображения в графе Ссылка стояло: нет.

Кроме этого стоит удалить ненужные картинки, которые накопились у Вас на хостинге. Сделать это очень легко с помощью плагина DNUI.

Но главную проблему представляют древовидные комментарии, так их больше всего.

Дубли Replytocom

Данные дубли создаются из-за кнопочки Ответить в комментариях. Как же от них избавиться?

- Отключить древовидные комментарии. Самый простой способ, но это затруднит общение с читателями. И возможно приведет к уменьшению их активности на блоге, а значит ухудшит поведенческие факторы. О ПФ читайте тут. Кстати, еще один важный момент в настройках комментариев никогда не ставьте галочку в графе Разбивать комментарии на страницы. Это опять же создаст дублированный контент.

- Удалить переменные replytocom с помощью плагина Seo by Yoast ( раздел Постоянные ссылки), но если у пользователя отключен Java-script, он не сможет ответить на комментарий.

- Но есть способ лучше и о нем рассказал Александр Борисов, кстати это и есть тот блоггер, который первым нашел решение для борьбы с дублями. Поэтому очень рекомендую прочитать его статью по борьбе с [link]replytocom[/link].

Надеюсь, статья была для Вас полезной и данная информация поможет улучшить позиции Вашего блога. У меня после применения этих знаний трафик на блоге вырос в 2 раза!

Как найти и удалить дубли страниц на сайте

Многих людей на каком-то этапе начинает беспокоить вопрос поиска дублей страниц на их сайте. Данной проблеме особенно подвержены интернет-магазины, особенно старые и на самописных движках (да, такие ещё встречаются). В принципе это не удивительно, поскольку любая работа над сайтом в итоге сопровождается появлением дублей.

В этой статье я не буду пичкать вас бесполезной теорией. В этом нет нужды ибо именно теории посвящены тысячи статей. Сейчас я вам расскажу о том, как определить наличие или отсутствие проблем и их характер. Полное отсутствие проблем конечно же может констатировать только SEO-специалист. Вы же сможете только понять есть ли серьезные проблемы у сайта или нет. В этой статье мы определим есть ли проблемы у сайта с дублями страниц и со страницами низкого качества.

Беглый осмотр

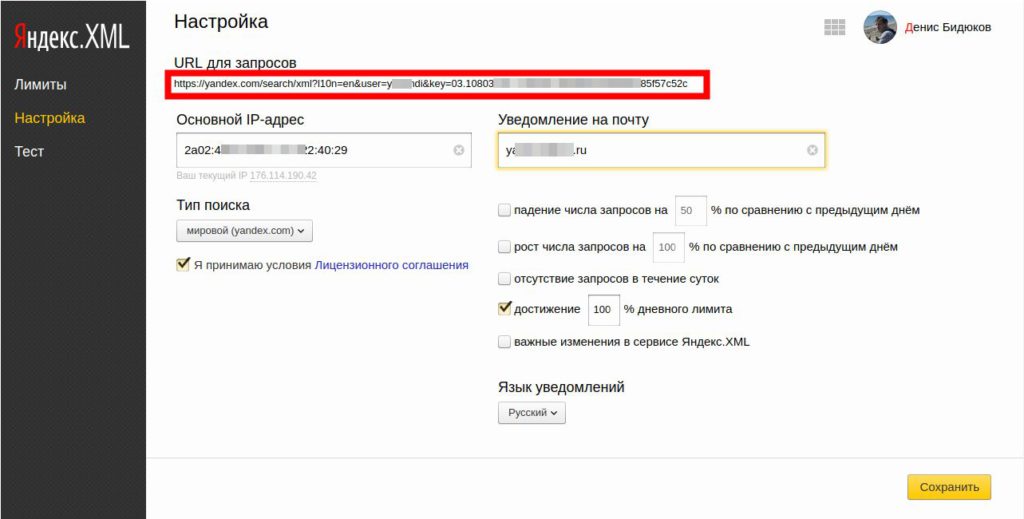

Чтобы понять каково текущее состояние сайта, достаточно зайти в Яндекс.Вебмастер в раздел «Страницы в индексе».

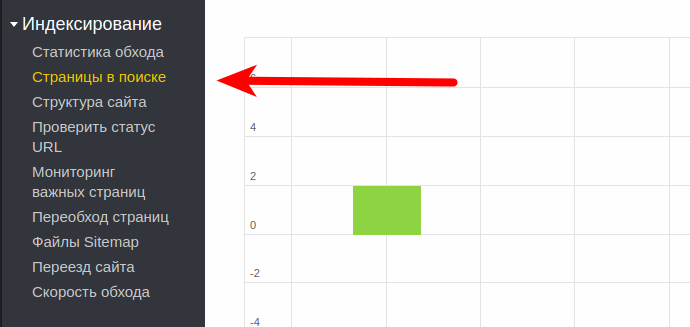

После этого мы попадем на страницу, где собрана вся информация касаемо процесса индексации нашего сайта. Первым делом смотрим на график, если видим примерно вот такую картину:

Зеленые столбики без синих означают что серьезных проблем у сайта нет. Но если же мы видим примерно вот такую картину:

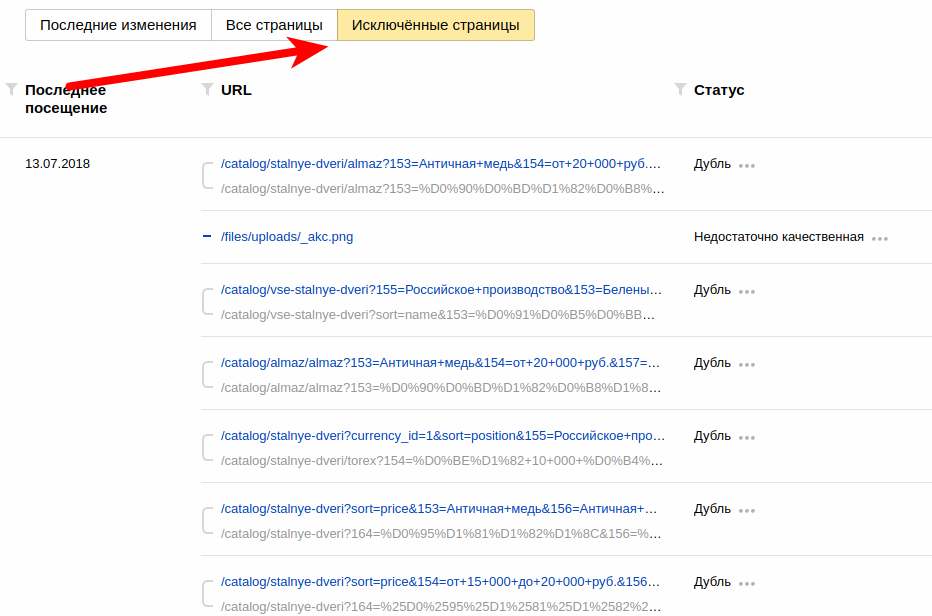

То начинаем ерзать на стуле, поскольку это говорит о явных проблемах. Чуть ниже под графиком кликаем кнопку «Исключенные страницы» и смотрим с каким комментарием удаляются страницы.

Как видите в поле «Статус» финурируют понятия «Дубль», «Недостаточно качественная». Это очень плохо. Если же в колонке «Статус» фигурируют «Редирект», «Ошибка 404», «Запрешщено тем-то», то можете спать спокойно, у вашего сайта нет серьезных проблем. Спускаемся в конец страницы и смотрим количество страниц с исключенными страницами.

Значение в 2500 максимальное и говорит о том, что как минимум на вашем сайте 50 000 проблемных страниц. На самом деле это число может быть в десятки раз выше. На одном сайте с 800 товарами Яндекс загрузил свыше 4 миллионов страниц. Это было самым большим количеством загруженных страниц, которое попадалось мне за мою практику. Из этого количества только 1 000 страниц является уникальными, все остальное дубли. Зато, со слов владельца сайта, этот самописный сайт очень удобный. Честно говоря в одно место такое удобство. Разработчикам таких, с позволения сказать, CMS хочется оторвать руки. Две недели я буду просто удалять ссылки.

Но это ерунда, перед этим ко мне обратились одни товарищи с интернет-магазином на ViartShop, вот где полный атас. Там карточка товара может иметь до трех дублей без возможности установить хотя бы rel canonical. тут только на удаление мусорных ссылок мне потребовалось бы от 40 до 50 дней, при том, что договор заключался всего на 60 календартный дней и за это время я должен был показать результаты в виде увеличения продаж. Само собой пришлось с товарищами расстаться. Загадят сайт, а потом жесткие условия ставят.

Первый шаг: определяем характерные особенности «мусорных» ссылок\

Для этого нам потребуется изучить ссылки исключенных страниц. Поскольку частая причина возникновения дублей – это фильтрация, то как правило общим признаком таких страниц является наличие знака вопроса «?» в URL. По идее мы можем закрыть их все всего лишь одной директивой «DisallowL *?*», но эта директива закроет вообще все страницы где есть знак «?». Если на сайте нет важных страниц с параметрами, то можно использовать эту директиву. Но не всегда есть возможность разобраться с сайтом, а действовать надо прямо сейчас, то проще сначала закрыть от индексации страницы с конкретными параметрами.

Второй, по популярности, причиной появления дублей является пагинация. Эти страницы также необходимо закрывать от индексации. Хорошо если в URL этих страниц имеются явные признаки в виде «?page=6» или «/page/6», но бывают случаи когда такие признаки отсутствуют, например пагинация имеет в URL просто цифру «blog/5», такие страницы будет сложно закрыть от индексации без «хирургического» вмешательства в движок.

Но в случае с моим подопытным таких проблем не было. Все ссылки с параметрами являются бесполезными и их можно смело закрывать от индексации. Остается только определить их ключевые признаки:

- /catalog/dveri-iz-massiva?158=***

- /mezhkomnatnye-dveri?sort=price&162=***

- /catalog/stalnye-dveri/torex?156=***

- /catalog/mezhkomnatnye-dveri?162=***&161=***

- /products?page=23

- /catalog/mezhkomnatnye-dveri/sibir-profil?162=***&sort=name

- /catalog/dveri-s-plenkoj-pvh/?162=***

Если бы разработчики движка, на котором работает подопытный сайт, хоть чуть-чуть разбирались в SEO, то сделали бы параметры в виде массива:

- /catalog/mezhkomnatnye-dveri/sibir-profil?filter[162]=***&filter[sort]=name

Или каждый параметр снабжали бы префиксом:

- /catalog/mezhkomnatnye-dveri/sibir-profil?filter_162=***&filter_sort=name

В обоих случаях можно было бы прикрыть все страницы фильтрации всего лишь одной директивой «Disalow: *filter*». Но увы, криворукие программисты в данном случае забили на все что связано в SEO и иными «бесполезными» вещами, которые так или иначе связаны с SEO, и не оставили мне другого выхода кроме как закрывать от индексации страницы фильтрации путем указания параметров. Конечно же я мог внести изменения и устранить этот недостаток, но самописный движок всегда ящик Пандоры, стоит начать его ковырять и ошибки начинают выскакивать пачками. По этой причине я решил избежать действий, которые могли привести к непредвиденным последствиям..

В итоге у меня получился примерно вот такой список директив:

- Disallow: *sort=*

- Disallow: *page=*

- Disallow: *153=*

- Disallow: *154=*

- Disallow: *155=*

- Disallow: *156=*

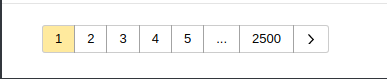

Правильность директив можно проверить на странице «Инструменты -> Анализ robots.txt». Там в самом низу есть поле, копируем туда ссылку и жмем кнопку «Проверить».

Если под надписью «Результат» мы видим параметр одной из диркектив, выделенный красным, значит ссылка запрещена, если же там зеленая галка, значит ссылка не запрещена к индексации. Необходимо корректировать параметр директивы, отвечающий за запрет к индексации подобных страниц.

Самое главное – это соблюдать осторожность в формировании параметров директив. Можно таких дров наломать, что мама дорогая. Я однажды в погоне за «хвостами» от переноса сайта с Wix закрыл от индексации весь сайт клиента. Приятным бонусом было таки исчезновение этих «хвостов» из индекса.

Второй шаг: удаление «мусора»

Тут у нас с вами два пути:

- Забить и ждать пока Яндекс сам все удалит из индекса.

- Ускорить этот процесс путем использования инструмента «Удаление страниц из поиска».

Первый вариант может затянуться на месяцы и если вы никуда не спешите, то можно в принципе не заморачиваться. Второй вариант тоже не самый быстрый, но побыстрее чем первый. Единственный его минус – это возможность удаления страниц из поиска до 500 в сутки.

Когда с этой проблемой я столкнулся на своем сайте, то там я не стал заморачиваться автоматизацией, поскольку надо было удалить всего 400 с лишним URL. Но даже на это у меня ушло два дня. Сидеть и вручную копипастом перебивать ссылки то ещё занятие. Но для удаления нескольких тысяч я решил все-таки написать скрипт на PHP, который выворачивает весь индекс сайта и выбирает из него страницы, которые необходимо удалить. Эти страницы он складывает в файлик. После этого нам остается «вырезать» из этого файла ссылки и вставлять в поле на странице «Удаление страниц из поиска».

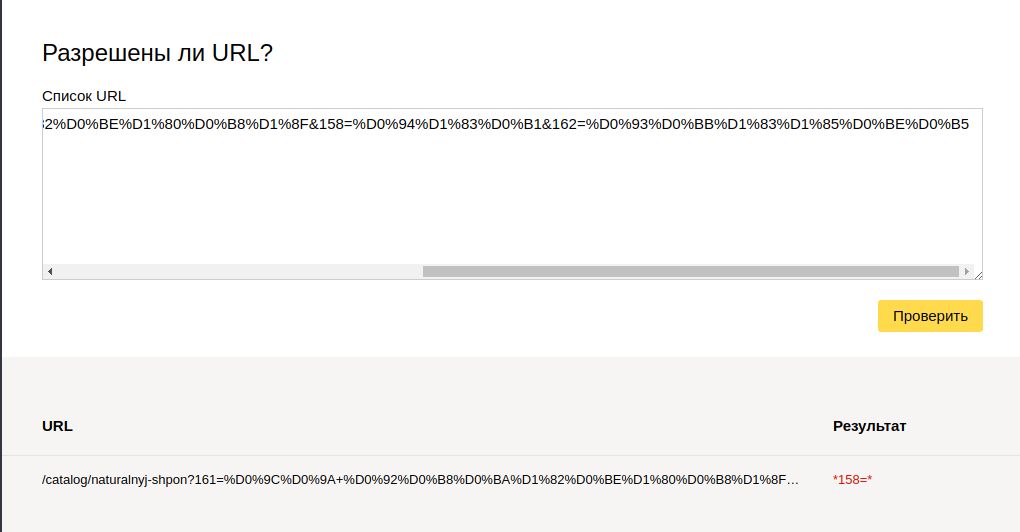

К сожалению и в случае со скриптом есть одно «но», для работы со скриптом необходима регистрация и настройка Яндекс XML, поскольку скрипт работает на основе этого сервиса. Перед использованием необходимо со своего аккаунта в Яндекс получить ключ и вставить его в скрипт. После этого скрипт будет готов к работе. Ключ необходимо скопировать из ссылки , которая указана в верхней части страницы с настройками(см. фото).

Обратите внимание на лимиты, прежде чем приступать к работе со скриптом. Необходимо убедиться что лимит запросов к сервису достаточно велик. Ни в коем случае не запускайте скрипт на хостинге, ничего хорошего это не даст.

Получив файл со списком ссылок, нам остается только раз в день открывать Яндекс.Вебмастер и Google Console, и в разделах «Удаление URL» копипастить ссылки пачками.

Скрипт тут: https://yadi.sk/d/d3IRM_vv3ZQkww

P.S. Больше всего повезло обладателям сайтов (интернет-магазинам) на Битриксе, поскольку там разработчики отличаются большей сообразительностью и там уже искаропки идет robots.txt заполненный как надо. Как пример сайт buldoors.ru, из 17к страниц в индексе, мусорных у него всего 60+. Казалось бы можно расслабиться, но увы, большое количество страниц говорит явно о каких-то проблемах, выяснение которых требует более глубокого анализа.

Как убрать дубли страниц на сайте

Что такое дубли страниц — это страницы с абсолютно одинаковым содержанием и разными URL адресами.

Причин возникновения дублей страниц на сайте может быть несколько, однако почти все они так или иначе связаны с системой управления содержимым сайта. Лучше всего принять меры, предотвращающие появление страниц-дублей еще на стадии создания сайта. Если Ваш сайт уже функционирует — обязательно проверьте наличие на нем повторяющихся страниц, иначе серьёзных проблем с индексацией и SEO не избежать.

Существует несколько способов избавления от дублей страниц сайта. Одни могут помочь в борьбе с уже появившимися копиями страниц, другие помогут избежать их появления в будущем.

Как найти дубли страниц на сайте?

Но для начала необходимо проверить — есть ли вообще повторяющиеся страницы на Вашем ресурсе и, если да, то какого типа эти страницы. Как это сделать?

- Способ 1. Запрос в поиске «site:»

Можно воспользоваться командой «site:». Эта команда выдает результаты поиска по определенному сайту. Введя site:www.yoursite.com/page1, Вы увидите, есть ли в поиске дубли этой страницы.

- Способ 2. Поиск по отрывку из статьи

Выделяем небольшой отрывок текста со страницы, для которой мы ищем дубли, и вставляем в поиск. Результаты поиска сразу покажут все проиндексированные дубли нужной страницы.

Как бороться с дублями страниц?

301 редирект

Одним из самых эффективных, но в то же время и самых непростых методов борьбы с дублями является 301-редирект, он склеивает указанные страницы и дубли со временем исчезают из индекса поисковых систем.

При попадании поискового робота на дубликат страницы, на которой прописан 301 редирект, веб-сервер автоматически перенаправит его на страницу-оригинал. Прописываются все перенаправления в файле .htaccess, который находится в корневом каталоге сайта. Не стоит использовать 301 перенаправление (постоянный редирект), если вы планируете в дальнейшем как-то использовать страницу-копию. Для этого можно использовать 302 перенаправление (временное). Тогда склеивания страниц не произойдет.

При использовании 301 редиректа для удаления дублей страниц из индекса прежде всего надо определиться с главным зеркалом сайта. Для примера в качестве главного зеркала укажем http://site.ru Вам останется только поменять на адрес своего сайта

- 301 Редирект с www.site.ru на site.ru

Для этого надо в файле .htaccess (файл находится в корне сайта) добавить следующие строки сразу после RewriteEngine On:

RewriteCond %{HTTP_HOST} ^www.site.ru$ [NC]RewriteRule ^(.*)$ http://site.ru/$1 [R=301,L]

- 301 редирект с site.ru/index.php на site.ru

RewriteCond %{THE_REQUEST} ^[A-Z]{3,9}\ /index\.php\ HTTP/

RewriteRule ^index\.php$ http://site.ru/ [R=301,L]

Аналогичным образом можно избавиться от дублей типа:

http://site.ru/index

http://site.ru/index.html

http://site.ru/index.htm

Если Вы, к примеру, хотите склеить страницы http://site.ru и http://site.ru/page123, то в файле .htaccess следует прописать следующее:

Redirect 301 /page123 http://site.ru

Теперь при попытке зайти на страницу http://site.ru/page123 будет срабатывать перенаправление на главную.

Канонические ссылки

Другой способ указать оригинал — прописывать на страницах-дублях т.н. канонические ссылки. Это ссылки с атрибутом rel=canonical, иными словами в блоке head такой страницы прописано:

<link rel=»canonical» href=»http://site.ru/load» />

Если поисковые системы сталкиваются с такой ссылкой, то понимают какая из многочисленных копий страниц является оригиналом и индексируют её.

Например, в примере выше на сайте были 2 страницы-дубля:

http://site.ru/load

http://site.ru/load/

Указав на странице http://site.ru/load атрибут rel=canonical мы покажем поисковым системам, что эта страница является главной и именно ее надо индексировать.

Некоторые CMS (например, Joomla!) могут автоматически создавать такие ссылки, на других эта операция выполняется различными плагинами. Однако, даже если все новосозданные дубли страниц Вашего сайта будут с каноническими ссылками, это не поможет решить проблему уже существующих дублей.

robots.txt

Частично проблему дублей страниц решает файл robots.txt в котором содержатся рекомендации поисковым системам с перечнем файлов и папок, которые не должны быть проиндексированы. Почему частично? Потому что этот файл содержит именно рекомендации, а не правила и некоторые поисковые системы игнорируют эти рекомендации.

Например, чтобы Яндекс удалил из индекса старые дубли страниц, достаточно прописать соответствующие запрещающие их индексацию правила в robots.txt. С Google ситуация немного сложнее. Те же правила придется вносить в особый инструментарий от Google, разработанный специально для веб-мастеров. В Google вебмастер понадобится задать необходимые нам параметры ссылок в разделе «Сканирование».

При создании же robots.txt нам понадобится воспользоваться запрещающей директивой Disallow.

- Правильный robots.txt для Joomla

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Sitemap: http://site.ru/sitemap.xml

User-agent: Yandex

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: /xmlrpc/

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

- Правильный robots.txt для WordPress

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Sitemap: http://site.ru/sitemap.xml

User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Что означают эти строки:

- User-agent: * — правила описанные в ниже этой строки будут действовать для всех поисковых роботов

- User-agent: Yandex — правила действуют только для робота Яндекса

- Allow: — разрешить индексирование (обычно не пишут)

- Disallow: запрещено индексировать страницы в адресе котроых есть то что описано в строке.

- Host: site.ru — Основное зеркало сайта

- Sitemap: — ссылка на XML-карту сайта

- «*» — любая последовательность символов в адресе страницы

Борьба с дублями страниц в WordPress

Каким должен быть файл robots.txt для WordPress мы уже рассмотрели выше. А теперь поговорим о плагинах, которые позволяют бороться с дублями и вообще незаменимы для оптимизатора сайтов на этом движке.

Yoast SEO — Один из самых популярных плагинов для WordPress, позволяющим бороться с проблемой дублей. С его помощью можно заставить WordPress прописывать канонические ссылки, запретить индексацию страниц с постраничным разбиением (рубрики), скрыть архивы автора, удалить /category/ из URL и многое другое.

All in One Seo Pack — Аналогичный плагин, не менее популярный и выполняющий похожие функции. Какой из них использовать — решать вам.

Как убрать дубли страниц в Joomla

Несмотря на то, что Joomla! поддерживает автоматическое создание канонических ссылок, некоторые дубли все равно могут попадать в индекс поисковых машин. Для борьбы с дублями в Joomla! можно использовать robots.txt и 301редирект. Правильный файл rorbots.txt описан выше.

Ну, а чтобы включить ЧПУ (человеко понятные урлы) в Joomla достаточно переименовать htaccess.txt в .htaccess и добавить туда сразу после RewriteEngine On:

RewriteCond %{HTTP_HOST} ^www.site.ru$ [NC]

RewriteRule ^(.*)$ http://site.ru/$1 [R=301,L]

RewriteCond %{THE_REQUEST} ^[A-Z]{3,9}\ /index\.php\ HTTP/

RewriteRule ^index\.php$ http://site.ru/ [R=301,L]

А также в настройках сайта поставить галочки следующим образом:

Таким образом мы избавимся от дублей типа www.site.ru и site.ru/index.php, потому что в этой CMS возникает такая проблема с дублями. И поисковики часто индескируют страницы типа site.ru/index.php. Теперь после всех манипуляций при попытке зайти на страницу, например, www.site.ru посетителя перекинет на главную, т.е. site.ru.

Из плагинов для Джумлы могу посоветовать JL No Doubles — плагин убирает дубли страниц в компоненте com_content. Возможен 301 редирект на правильную страницу, либо вывод 404 ошибки.

Специальные сервисы для создания robots.txt и .htaccess

Если Вы только начинаете осваивать сайтостроение — попробуйте воспользоваться услугами специализированных сервисов, которые помогут Вам сгенерировать валидные файлы robots.txt и .htaccess:

seolib.ru — На нем можно не только создать, но и протестировать Ваш robots.txt

htaccess.ru — один из наиболее популярных сервисов, на котором можно создать и выбрать различные параметры генерируемого файла .htaccess

Как удалить дубли страниц

Здравствуйте уважаемые читатели и подписчики. Как проходит лето? Надеюсь, более чем насыщенно. В сегодняшнем посте мы опять поговорим о продвижении сайта, а если быть более точным, то уделим внимание поиску и устранению дублей страниц.

Прежде чем начать, хотелось бы рассказать новичкам, что вообще такое дубли и как они могут препятствовать продвижению. Дубли страниц возникают из-за того, что один тот же контент доступен по разным адресам. Например: sayt.ru/statja и www.sayt.ru/statja. Это приводит к тому, что контент на сайте становится неуникальным и позиции в поисковых системах падают. Чаще всего дубли возникают из-за особенности той или иной CMS (движка блога), а также из-за неопытности и невнимательности вебмастера.

Дубли можно разделить на 2 категории: полные и не полные. В перовом случае дублируется вся страница, во втором, только ее часть, например, после анонса в RSS.

Если на своем сайте Вы обнаружили дубли контента, то вот с какими проблемами Вы можете столкнуться при продвижении:

- Потеря внутреннего ссылочного веса. Это может произойти из-за того, что ссылки ведут на дублированные страницы, вместо того чтобы увеличивать вес продвигаемой. Простой пример: при внутренней перелинковке, Вы можете случайно ошибиться и сослаться на дублированную страницу, в таком случае вес страницы пропадает в пустую.

- Подмена основной страницы в индексе. Дублированная страница может быть расценена поисковиками как оригинальная и свободно попасть в основной индекс. Если такое произойдет, то все усилия по ее продвижению будут напрасны и соответственно позиции по нужным запросам просядут.

- Если дублей очень много, то есть риск попадания под фильтр Яндекса АГС.

Теперь, когда мы узнали определение и последствия дублей, можно приступать к их поиску и устранению. Устранение сводиться к тому, чтобы запретить дублям индексироваться

Устранение самых распространенных дублей

Сайт доступен с www и без www

Откройте главную страницу сайта. У меня это life-webmaster.ru (без www, но у Вас может быть наоборот). Теперь уберите или допишите к адресу www. Если дубля нет, то Вас будет автоматически перебрасывать на основное зеркало. Если сайт доступен и с www и без него – это дубль и от него нужно избавляться.

Делается это очень просто. Если вы хотите сделать сайт доступным без www, то в конец файла .htaccess пишем этот код:

Options +FollowSymLinks

RewriteEngine On

RewriteCond %{HTTP_HOST} ^www.domain\.com$ [NC]

RewriteRule ^(.*)$ http://domain.com/$1 [R=301,L] |

Options +FollowSymLinks RewriteEngine On RewriteCond %{HTTP_HOST} ^www.domain\.com$ [NC] RewriteRule ^(.*)$ http://domain.com/$1 [R=301,L]

Если с www, этот:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^www\.(.*) [NC]

RewriteRule ^(.*)$ http://www.%1/$1 [R=301,L] |

RewriteEngine On RewriteCond %{HTTP_HOST} !^www\.(.*) [NC] RewriteRule ^(.*)$ http://www.%1/$1 [R=301,L]

В индексе присутствуют страницы с параметрами page=1; .php и т.д.

Эта проблема наблюдается в основном у тех, кто использовал движок WordPress для создания своего сайта. Дело в том, что URL, который использует данный движок для записей, выглядит следующим образом: sayt.ru/?p=1. Это не очень хорошо, но решается тегом rel=”canonical”, который есть в любом seo плагине. Если у Вас другая CMS, то зайдите в файл index.php и добавьте этот тег вручную. Если тег rel=”canonical” уже прописан на Вашем сайте, this is хорошо.

Дубли со слешами на конце

Суть в том, что страница доступна по ссылке со слешем (/) и без него. Проверяется следующим образом:

- Открываем статью сайта

- Например, у меня открылась sayt.ru/statja/ (т.е. со слешем)

- Теперь убираем слеш, получиться sayt.ru/statja

Если одни и те же страницы будут открываться со слешем и без него, то это дубль:

- sayt.ru/statja

- sayt.ru/statja/

Устранить эту проблему можно прописав в конец файла .htaccess следующее правило:

RewriteBase /

RewriteCond %{HTTP_HOST} (.*)

RewriteCond %{REQUEST_URI} /$ [NC]

RewriteRule ^(.*)(/)$ $1 [L,R=301] |

RewriteBase / RewriteCond %{HTTP_HOST} (.*) RewriteCond %{REQUEST_URI} /$ [NC] RewriteRule ^(.*)(/)$ $1 [L,R=301]

Оно уберет слеш на конце ссылки и будет перенаправлять пользователя на правильную страницу. Например, человек ввел в адресную строку адрес sayt.ru/statja/ и его тут же перебросит на sayt.ru/statja

Этими действиями мы предотвратили появление в индексе дублированного контента, но что делать, если таковой уже имеется в выдаче? В таком случае нужно отыскать, и избавится от него вручную.

Поиск дублированного контента в индексе

Есть множество способов найти дублированный контент, давайте рассмотрим самые основные:

Расширенный поиск Яндекса. Заходим в этот поисковик и жмем “расширенный поиск”:

Берем кусок текста из старого поста, заключаем его в кавычки и вставляем в строку поиска. Далее вводим адрес блога и жмем “Найти”:

Если по таким запросам показывается несколько страниц, то это дубли. Заметьте, что нужно брать текст из середины или конца поста, потому как первые предложения могут встречаться на главной странице или в рубриках блога.

Если найдены дубли, то удалите их с помощью инструмента из Яндекс Вебмастера.

Конечно, если на Вашем сайте тысячи страниц то проверять его ручками можно вечно, поэтому для упрощения работы придумана программа XENU.

Проверка с помощью программы Xenu. Эта программа проанализирует все ссылки Вашей площадки и укажет на возможные ошибки. Программка на английском, но разобраться в ней несложно.

Итак, скачиваем ее отсюда (жмем кнопку Download) и устанавливаем на компьютер. После установки запустите программу, перейдите в раздел “file” и выберите подраздел “check URL”:

Здесь введите адрес нужного сайта и нажмите ok. Начнется процесс проверки ссылок. Прошу заметить, что полная проверка может длиться достаточно долго, поэтому не переживаем.

Все ошибки будут подсвечены красным цветом, поэтому распознать проблемные страницы будет несложно. После анализа, программа предложить сделать карту сайта, но этого делать не нужно.

Еще одним удобным способом проверки дублированных страниц является инструмент в Google Webmaster. Если Ваш сайт добавлен туда, то перейдите в раздел “оптимизация”, а затем в “оптимизация html”. Здесь будут показаны одинаковые тайтлы и description, что говорит о дублированном контенте. Если все good, то ы увидите следующие:

После нахождения дублей анализируйте их появление, и устраняйте вышеперечисленными способами. Если найдены дубли с непонятными адресами, то закрывайте их от индексации через robots.txt. Также если на Вашем сайте есть архив записей, то его тоже лучше закрыть от индексации в robots.txt либо через All in One Seo Pack.

На этом все, надеюсь, Вы выявили все проблемные страницы Вашего сайта и с успехом удалили их. Если возникли вопросы по поводу дублей, не стесняйтесь, я всегда открыт для общения.

Песенка на закуску

Буду благодарен за подписку и за репост в социальных сетях. Удачного лета друзья.

p.s. Стал писать реже, потому что уехал в Крым :3

Загрузка…

Загрузка…Подпишитесь на обновления блога Life-Webmaster.ru и получайте в числе первых новые статьи про создание блога, раскрутку и заработок на нем!

Как найти и удалить дубли страниц на сайте

Дубли – это страницы сайта с одинаковым содержимым, они могут полностью повторять контент друг друга или частично. Часто они становятся причиной низких позиций ресурса. Мы хотим рассказать, почему могут возникать дубли и как от них избавится.

Полные дубликаты могут возникать, когда страница доступна под несколькими адресами, то есть не выбрано главное зеркало или не настроен 404 редирект. Часто их автоматически создает CMS в процессе разработки.

Частичные дубли часто получаются в результате ошибки разработчика или из-за особенностей CMS. Это могут быть страницы пагинации и сортировок с разными URL или ошибочно открытые для индексации служебные страницы.

В чем опасность

По сути, страницы одного сайта начинают соперничать друг с другом. Google и Яндекс не хранят в собственной базе несколько идентичных страниц, а выбирают только одну, наиболее релевантную. Они могут выбрать копию нужной вам страницы, в результате чего, позиции резко проседают. Из-за дубликатов страдают поведенческие факторы и естественный ссылочный вес, становится труднее собирать статистические данные.

Если дубликатов много, то поисковик может попросту не успеть проиндексировать их полностью. При этом следующей индексации придется ждать дольше, так как поисковые боты реже переходят на ресурс, где контент повторяется. А это также значительно замедляет продвижение.

Как найти дубли страниц

Сервисы для вебмастеров

Существует несколько способов. Наиболее простой – воспользоваться сервисами Google Search Console или «Яндекс.Вебмастер». Распознать дубликаты проще всего по повторяющимся метатегам title и description.

Для этого в панели инструментов Search Console перейдите в раздел «Оптимизация HTML» пункт «Повторяющееся метаописание», где будет указано количество таких страниц, а также их URL.

В вебмастере Яндекса, страницы с одинаковым метаописанием можно найти в разделе «Индексирование», а именно «Вид в поиске», где необходимо выделить исключенные страницы и выбрать категорию «Дубли».

Существует также много других сервисов для подобных задач, например Netpeak Spider или Screaming Frog. С их помощью можно получить полный список адресов страниц и автоматически выделить среди них те, у которых совпадают метатеги.

При помощи операторов ПС

При помощи оператора site: для Google или host: для Яндекса, можно вручную искать повторяющийся контент на страницах поисковой выдачи. Для этого введите в поисковую строку оператор перед адресом вашего сайта, а дальше нужный отрывок текста в кавычках (site:address.com”…”). Таким образом вы сможете отыскать не только полные, но и частичные дубли.

Если использовать оператор с адресом без текста, в выдаче вы увидите все проиндексированные страницы собственного ресурса. По одинаковым заголовком можно легко определить копии.

Как исправить

Удалить вручную. Подходит для борьбы с полными копиями, которые возникли в результате ошибок. Для этого достаточно найти их URL и удалить при помощи CMS.

Закрыть от индексации. Для этого в файле robot.txt следует использовать директиву disallow. Таким образом вы сможете закрыть индексацию указанных типов страниц.

При помощи тега rel=canonical. Позволяет решить проблему с разными адресами страниц пагинации и др.

Настроить редирект 301. Редирект перенаправляет со всех похожих URL на один основной.

Как борются с дубликатами в Elit-Web

Когда к нам на продвижение приходят сайты, разработанные не у нас, технические ошибки, в том числе дубли, – один из первых пунктов проверки.

Многим не удается найти все копии страниц. Автоматический поиск осуществляется исключительно по метатегам. А чтобы искать при помощи контента, необходимо знать, какой именно текст может повторятся. Потому даже после работ по внутренней оптимизации, могут остаться ошибки.

Мы устраняем ошибки, используя все доступные методы проверки. Также наши специалисты ориентируются на саму специфику CMS и работ, проведенных на сайте, чтобы удостоверится, что на сайте не осталось дублей. А потому если у вас возникли проблемы с продвижением, мы уверены, что сможем помочь.

Как убрать дубли страниц с сайта: руководство и советы

С позиции SEO-продвижения дубликаты страниц несут опасность для сайта. Их негативно воспринимают поисковые системы, а в худшем случае дубликаты могут стать причиной значительного падения трафика и проседания позиций сайта в целом. Для того, чтобы предотвратить возможные последствия, необходимо своевременно избавляться от дублей. Как? Об этом мы расскажем в нашей статье.

Чем опасны дубли страниц?

Показать опасность дубля можно на простом примере: представьте две полностью аналогичных страницы сайта с одинаковым содержимым. Содержимое — статья на тематику “Отдых в Таиланде”. Какая из этих двух статей будет более релевантной для поисковой выдачи? Обе страницы абсолютно одинаковы, но нужно выбрать только одну.

В аналогичной ситуации оказывается и краулер поисковой системы, который оценивает содержимое вашего сайта — из двух аналогичных страниц Яндекс или Гугл должны выбрать только одну страницу. В результате необходимости такого выбора могут возникнуть следующие проблемы:

Снижение позиций ключевиков и проседание посадочной страницы.

Постоянные скачки в позициях ключевых слов за счет того, что релевантная страница постоянно меняется.

Когда проблема распространяется на весь сайт, возможно значительное понижение ранжирования всего ресурса.

Кроме того, в таком случае пропадает возможность правильной и точной проверки позиций ключевых слов в поисковых системах.

Резюмируя, все эти проблемы могут быть устранены еще до момента возникновения при условии своевременного устранения дублей страниц на сайте.

Как найти дубликаты страниц?

Рекомендуется использовать несколько (или один из нескольких) инструментов для поиска дублей. Разберем самые популярные:

Поиск с помощью оператора site:/example.com. Что это дает: вы увидите все проиндексированные страницы сайта и сможете визуально определить наличие повторяющихся страниц. Целесообразно использовать в том случае, когда проиндексированных страниц не несколько тысяч.

Парсеры и специальные сервисы. Есть специальные парсеры с разработанными поисковыми краулерами, которые после запуска программы сканируют ваш сайт. После этого вам будет доступна выкладка всех URL-адресов, которые затем можно отсортировать с помощью совпадений по метатегам title или description. Примером таких программ может быть Screaming Frog или Xenu.

Google Search Console. Крайне удобный инструмент — вкладка “Оптимизация HTML” дает подробные данные по страницам, в том числе описание страниц с повторяющимися мета-тегами.

Проведение ручного поиска на сайте. Целесообразно использовать, если сайт молодой и имеет небольшое количество страниц, или же вы достаточно опытный SEO-специалист и способны обнаружить дубли через ручной поиск.

После того, как дубли страниц были найдены, их необходимо устранить — далее мы рассмотрим способы, как удалить дубликаты с сайта.

Избавляемся от дублей страниц сайта

Устранить дубли можно 4 различными способами:

Непосредственное удаление дублированной страницы.

Выставление запрета на индексацию через файл robots.txt. Хорошо подходят для удаления дублей служебных страниц, которые часто повторяют контент посадочных.

Настройка редиректов — в зависимости от ситуации, можно использовать 301, 302 или 307 редирект.

Использование rel=canonical для страниц с сортировками, фильтрами или пагинации.

Достаточно часто дубли возникают не по вине SEO-специалиста или других сотрудников, а ввиду особенностей работы CMS сайта. Поэтому в случае появления дублей необходимо не только устранить их, но и определить причину их возникновения, и если она кроется в движке сайта — настроить его должным образом.