Основные Ошибки в СЕО На Сайте

Автор: Анатолий Улитовский

SEO (Search Engine Optimization) – это оптимизация и продвижение в выдаче поисковых систем. Принято рассматривать внешние и внутренние факторы оптимизации.

К внешним факторам продвижения относятся действия на сторонних ресурсах. Например:

- платное и бесплатное наращивание ссылочной массы;

- регистрация на трастовых сайтах и каталогах;

- гостевые и партнерские статьи в блогах;

- группы в соцсетях, призванные продвигать сайт;

- публикации на форумах и «партизанский маркетинг».

Подробно о продвижении сайта и изменении алгоритмов поисковиков можно прочитать в отдельной статье.

Внешнее СЕО – это ежедневная, кропотливая работа контент-менеджера, маркетолога и копирайтера, она сравнима с наращиванием мышечной массы в спорте. Но прежде чем дело дойдет до мышц, необходим прочный костяк, на котором эти мышцы крепятся. В этом смысле техническое SEO – скелет вашего сайта. Качество и количество мяса, которое растет на его костях, будет зависеть от того, насколько правильно они формируются.

Проблема в том, что, когда дело доходит до технической SEO-оптимизации, сложно определить с чего начать и на что нужно обращать внимание в первую очередь.

Чтобы разобраться в этом, компания SEMrush, специализирующаяся на продвижении, провела серию исследований наиболее частых и значимых ошибок оптимизации. Сеошники выявили факторы, которые отрицательно влияют на ранжирование и производительность веб-ресурса.

Чтобы определить наиболее распространенные технические ошибки, специалисты фирмы собирали данные на 100 000 веб-сайтов и 450 миллионах страниц. А потом структурировали все недочеты и проблемы по уровню серьезности.

В первую очередь внимание уделялось факторам, которые связаны с удобством (юзабилити) сайта. А также показателям общей производительности. Это же мы рекомендуем и вам. Удостоверьтесь, что исправлены критические ошибки на самых важных страницах сайта. Недочеты, ухудшающие продвижение, должны быть учтены и устранены.

Чтобы разобраться, что и как влияет на здоровье вашего ресурса, внимательно ознакомьтесь с этой статьей. Важно усвоить принципы и ключевые моменты. По итогу вы сможете самостоятельно оценить состояние ресурса, а также подготовить техническое задание для специалиста, который будет заниматься программной частью.

Наиболее распространенные технические проблемы SEO

Есть три слоя технической SEO-оптимизации, которые должен учитывать каждый владелец сайта или оптимизатор:

- структура сайта;

- SEO посадочных страниц;

- технические аспекты работы и продвижения.

Каждый из этих слоев подобен ящику Пандоры – когда мы его открываем, освобождаются силы зла, с которыми потом придется иметь дело. Но давайте рассмотрим все шаг за шагом.

Область 1: Структура сайта и индексируемость

Усилия по оптимизации эффективны только когда поисковые системы имеют свободный доступ к страницам. Googlebot должен просканировать и индексировать весь сайт, чтобы он появится в SERP (поисковой выдаче). Ошибка на этом этапе сведет к нулю все действия по оптимизации; сайт, который не виден посетителям, денег не принесет.

Чтобы ресурс успешно индексировался ботом поисковика, необходимо уделить этому вопросу некоторое время.

Есть три простых приема чтобы ускорить появление ресурса в выдаче:

- Зарегистрировать сайт в Search Console Гугла.

- Добавить главную посадочную страницу в addurl Google.

- Получить качественные ссылки на прокаченных порталах.

Но что делать, если что-то пошло не так? Самый простой и действенный вариант – посмотреть, как бот Гугла сканирует сайт, и на каком этапе возникает проблема. Это можно сделать через Search Console, во вкладке «Сканирование».

Если Гугл «съест» главную страницу, то оттуда, по ссылкам, сможет обойти весь сайт (естественно, при условии, что ссылки сделаны правильно). При наличии ошибок, ссылка может вести «на деревню к дедушке», соответственно, какая-то часть сайта останется скрытой для робота, а значит не будет принимать участия в ранжировании. Далее мы подробнее рассмотрим проблемы с «битыми» ссылками.

Ссылки и переадресации

Специалисты SEMrush обнаружили, что на каждом четвертом веб-сайте есть проблемы с ссылками. Они встречаются гораздо чаще, чем неправильная конфигурация домена или ошибки в цепочках перенаправления.

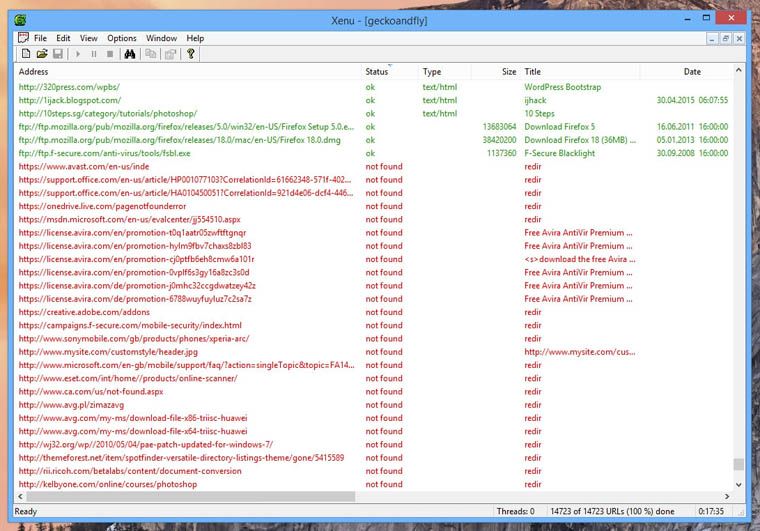

Чаще всего, недочеты связаны с «кривыми» внутренними ссылками – они встречаются у 30 процентов сайтов. Если захотите самостоятельно почистить сайт от некачественных ссылок можно воспользоваться бесплатным чекером.

Это удобный и полезный инструмент, вводите адрес своего сайта и получаете подробную информацию по каждой.

А если захотите подробнее разобраться в этом вопросе, у нас есть отдельная статья.

Также обратите особое внимание на ошибки редиректа 4XX, они присутствуют у 26,5 процентов веб-сайтов.

Более подробная информация представлена на иллюстрации ниже:

Ссылки, перенаправления и «хлебные крошки» ведут пользователя через весь ресурс, и это важно. Подробнее о ссылках можно посмотреть в статье, или в видео на нашем канале.

А еще нельзя забывать о правильно настроенных sitemap и robots.txt, которые также связаны со структурой сайта и возможностью его индексирования.Карта сайта и Robots.txt

Хотя большинство веб-сайтов внешне выглядят достаточно привлекательно, когда дело доходит до sitemaps и robots.txt, часто возникают проблемы. По статистике у 13 процентов сайтов есть ошибки в файле sitemap.xml и robot.txt. Конечно, это менее распространенная проблема чем «битые» ссылки, но все же данные говорят сами за себя. «Сайтмап» и «робот» рекомендуем приводить в порядок в первую очередь.

Проанализировать robots.txt можно через бесплатные инструменты Google Webmaster Tools или Яндекс Вебмастер. Тут нужно знать, что Гугл требует подтверждения прав на владение сайтом, а Яндекс нет.

Для проверки sitemap есть схожие инструменты – анализатор Яндекса

И требующий авторизации Google Sitemaps Status Checker:

Ошибки в SEO страниц

Теперь пришло время посмотреть на отдельные веб-страницы. Посадочные страницы – это то, куда попадает посетитель сайта по конкретному запросу. Если вместо товара или услуги человек видит что-то иное, он уходит, не выполнив целевое действие. Поэтому эта область имеет первостепенное значение.

Правильно оптимизированные страницы гораздо лучше ранжируются и быстрее растут в поисковике. Их рейтинг и видимость обусловлены качеством оптимизации. Посмотрим, какие ошибки чаще всего здесь встречаются.

Основные ошибки SEO на посадочной странице

Контент – это капитал, и он приносит прибыль. О том, как создавать ориентированный на клиента контент есть отдельная статья. Но сейчас мы говорим о том, что относится не к качеству текстов и видео, а к техническим аспектам вопроса.

На самом деле большинство технических проблем SEO связаны с контентом:

- У 65,88% сайтов есть серьезные проблемы с дублированием текста. Конечно, в некоторых случаях невозможно избежать повторений, но вы всегда можете добавить тег rel = «canonical» на вторичные страницы. Однако старайтесь не злоупотреблять полномочиями по скрытию страницы, поскольку уникальный текст всегда лучше, чем хорошо оптимизированный дублированный контент.

- Впечатляющие 93,72 процента веб-страниц имеют низкое соотношение текста и HTML-кода. Хотя эта проблема действительно широко распространена, ее уровень серьезности довольно низок, потому что некоторые страницы (например, страница «Связаться с нами»), естественно, содержат меньше текста, чем кода. Однако, это все равно будет восприниматься поисковиком как ошибка.

- 73,47% страниц имеют малое количество слов, что не всегда является ошибкой с вашей стороны, так как некоторые веб-страницы просто не требуют большого количества текста. Можно свести эту проблему к нулю, если поместить не менее 250 слов на каждую страницу, там, где это уместно и выглядит естественно.

Тем не менее, SEO не заканчивается на оптимизации текстов. Еще нужно прокачать страницу, предоставляющую этот контент для веб-поиска. И тут на сцену выходят метатеги, заголовки и изображения.

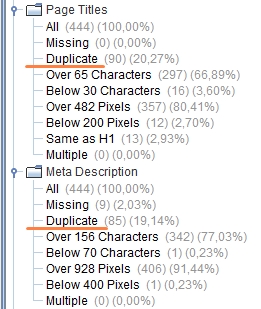

Метатеги

Как показано в исследовании, метаописания часто исключаются из процесса оптимизации. Примерно 63% владельцев веб-сайтов полностью отказываются от каких-либо попыток создать метатеги. При этом почти 54% веб-сайтов имеют дублированные, не уникальные тайтл и дескрипшн.

Повторяющиеся метаописания – очень серьезный недочет. Даже недостаток тегов не настолько вреден для продвижения, потому что поисковые системы будут создавать свои варианты, даже если вы не потрудились затратить время на это самостоятельно. Но пускать дело на самотек – плохая идея.

В конце концов, метатег – окно дисплея, который смотрит на ваш сайт. Это то, что заставляет людей «щелкать». Поэтому, если хотите получить более высокий рейтинг кликов (CTR) для своих веб-страниц, обратите внимание на теги.

Заголовки h2 и теги изображений

Другая область оптимизации контента, которая влияет на SEO, связана с заголовками и названиями картинок.

Более 60 процентов веб-сайтов пропускают теги alt для картинок и имеют слишком длинные заголовки h2. Иногда они вообще отсутствуют.

Хотя эти проблемы не считаются столь же серьезными, как приведенные выше, но все равно негативно влияют на UX веб-сайта, что, в свою очередь, оказывает влияние на рейтинг.

Технические аспекты SEO

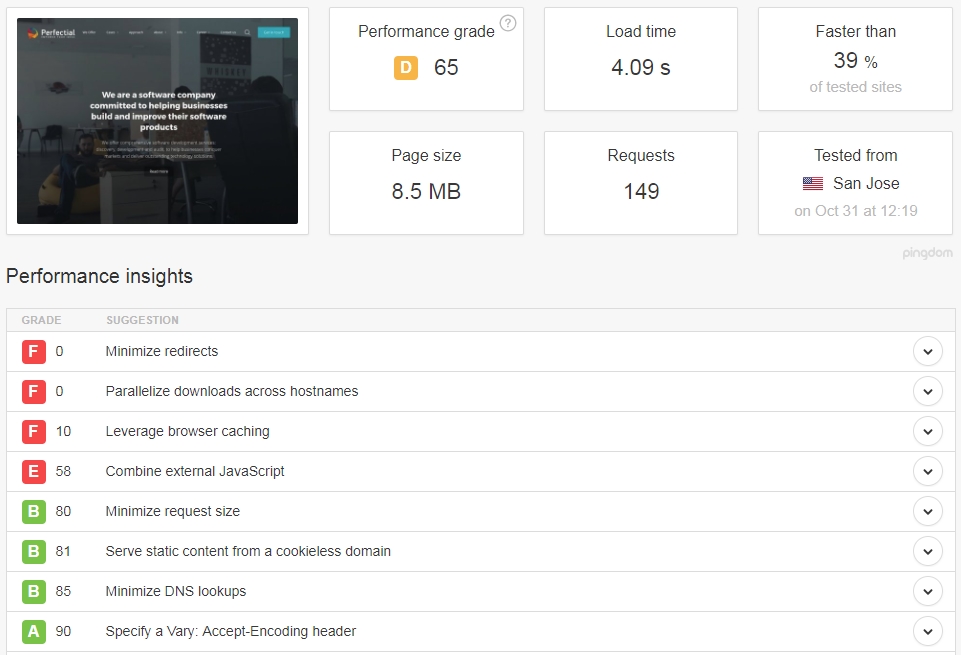

Вам должно быть интересно, почему мы оставили «на потом» такие важные моменты SEO, как скорость загрузки сайта и оптимизация под мобильных пользователей. Это потому, что производительность относится к третьему, техническому разделу SEO, а мы договорились рассматривать все по порядку.

Цена ошибки в любом из технических компонентов может быть невероятно высокой. Исследование Amazon показало, что 100 миллисекунд дополнительного времени потраченного на загрузку страницы может привести к 1-процентному снижению продаж. Много это или мало? Ответить сложно, но есть сайты, которые грузятся по 4-5 секунд, и это уже критичные показатели.

Трафик сайта сильно обусловлен техническими аспектами СЕО, ведь никто не будет ждать, 10 секунд чтобы посмотреть товар в интернет-магазине, если есть тысячи подобных ресурсов. Время – деньги, и часто доход компании определяется временем, которое пользователь тратит на ожидание.

Скорость страницы

Скорость страницы является одним из самых значимых факторов рейтинга Google , влияющим на пользовательский интерфейс и, следовательно, на число отказов.

Более 20% веб-сайтов имеют медленную скорость загрузки страницы, и это заслуживает самого пристального внимания. К счастью, большинство проблем современных сайтов решаемы на уровне кода.

Сайты, созданные по новым технологиям, поправить несложно. Другое дело, если программная часть безнадежно устарела.

Старые технологии

Большинство из нас не умеет высчитывать математические уравнения при помощи римских цифр. Попробуйте на письме решить простейший пример, и скорее всего, вы убедитесь в этом сами.

Поэтому предполагать, что поисковые системы хотят читать старый код, и анализировать такие вещи, как iframes и Flash, ошибочно. А ведь эти программы и части их кода появляются и на новых веб-сайтах. Интернет никогда не перестает развиваться, при этом многие технические аспекты устаревают. Следовательно, задача – не отставать от важных изменений.

Одна из распространенных проблем, связанных с устаревшими технологиями – сайт, который не оптимизирован под мобильных пользователей.

Мобильная отзывчивость

Хотя большинство веб-сайтов уже приспособились под Mobilegeddon, это вызвало некоторую путаницу в технической сфере.

Самое худшее, что вы можете сделать, это забыть добавить тег «canonical» в ускоренные мобильные страницы. Это проблема имеет высокий приоритет важности и присутствует у 0,08 процентов пользователей, сайты которых работают с AMP.

Подробнее о оптимизации сайта под мобильных пользователей можно узнать из этой статьи.

Вывод

Невозможно переоценить важность технического аспекта SEO-продвижения. Однако не нужно вести войну по каждой незначительной проблеме, которая возникает на страницах. Устраните критические недочеты, прежде чем заниматься мелочами.

Осознание наиболее распространенных технических ошибок SEO поможет выбрать правильную стратегию. Удостоверьтесь, что уделяете достаточно внимания самым важным страницам и понимаете уровень серьезности каждой ошибки. Знание проблем – уже половина победы, а кто предупрежден – тот вооружен.

Поделитесь с друзьями

Техническая оптимизация (доработки) сайта

Энциклопедия поискового продвижения Ingate

Ваш запрос успешно отправлен

Ваш запрос успешно отправленВаш запрос не отправлен

Выполнение технических доработок – самый первый и наиболее важный этап поисковой оптимизации сайта. Обычно эта процедура проводится только один раз, перед стартом продвижения. В дальнейшем возможна корректировка некоторых технических составляющих сайта.

Техническая оптимизация сайта (технические доработки) – это комплекс мер, направленных на корректировку технических аспектов сайта, с целью улучшить его взаимодействие с роботами поисковых систем.

Основная задача технической оптимизации – обеспечить максимально полную и быструю индексацию страниц сайта. Без проведения технических доработок эффективное продвижение сайта значительно усложняется или вовсе становится невозможным.

Обратите внимание, что в «Энциклопедии поискового продвижения» мы не даем инструкций по технической доработке сайта, а рассказываем о наиболее распространенных проблемах и способах их решения. Эта информация поможет вам правильно поставить задачу веб-разработчикам. Вносить технические изменения в сайт должны специалисты, обладающие необходимыми знаниями и умениями. Неквалифицированное вмешательство в код сайта способно привести к его полной неработоспособности.

Здесь и далее мы рассматриваем решения для сайтов, которые обслуживаются HTTP-сервером Apache, поскольку, по данным исследовательской компании Netcraft, этим типом сервера обслуживается более 60% всех сайтов в мире.

Технические доработки сайта делятся на следующие группы:

- Устранение проблем хостинга и оптимизация кода. Чем ненадежнее хостинг и чем больше мусора в коде, тем дольше грузится страница. Это отрицательно влияет на поведенческие факторы. Именно по этой причине следует оптимизировать код и устранить проблемы с хостингом, дополнительно исправив ошибки, возникающие в разных браузерах.

- Настройка редиректов и статус-кодов. Данные процедуры следует провести для настройки зеркал, склейки дублей страниц, настройки корректной обработки 404 ошибки. В случае стандартного PHP-хостинга перенаправления (редиректы) настраиваются в файле .htaccess. Обработка 404 ошибки поможет избежать дублей на сайте.

- Сопутствующие настройки сайта. Корректно составленный файл robots.txt поможет запретить или разрешить индексацию страниц, дублей и разделов сайта, указать основное зеркало. Файл sitemap.xml поможет поисковику проиндексировать все страницы быстро и качественно.

- Внутренние корректировки страниц сайта. Если навигация сайта или страницы целиком построена на технологии Flash, это значительно усложнит индексацию содержимого сайта или даже сделает её невозможной. Внутренние корректировки страниц сайта направлены на то, чтобы продублировать Flash, Frame, JavaScript элементы на HTML.

- Настройка URL страниц. Из двух видов адресов страниц, псевдостатических и динамических, оптимальными в поисковой оптимизации считаются псевдостатические адреса. Их настройка производится в файле .htaccess. При этом очень важным моментом является корректная настройка редиректов со старых URL на новые.

- Устранение дублей страниц и аффилиатов. Этот процесс требует особого внимания, так как наличие копий на сайте, как внутренних, так и внешних, может привести к наложению санкций со стороны поисковых систем. Работа с аффилиатами – это долгий и трудоемкий процесс, особенно если продвигаемый сайт уступает аффилиату.

- Прочие технические доработки. Помимо перечисленного и в зависимости от сайта также приходится работать с удалением входной неинформативной страницы, устранением страниц с идентификаторами сессий, исправлением битых ссылок и другими техническими доработками.

Пренебрежительное отношение к технической оптимизации не дает многим хорошим сайтам достичь ТОПа.

Правильное и полное выполнение всех необходимых технических доработок является залогом корректной и быстрой индексации страниц сайта популярными поисковыми системами.

Вернуться назад: Этапы оптимизации Читать далее: Устранение проблем с хостингом и оптимизация кода сайта

Технические ошибки оптимизации сайтов — Devaka SEO Блог

Сайт дня: Интересный SEO blog SHAMAN’a о поисковой оптимизации и не только.

В данной статье затронут технический аспект оптимизации сайтов и основные недочеты, требующие исправления в первую очередь (см. также статью Основные ошибки поисковой оптимизации сайтов, где описаны общие ошибки оптимизации).

Результаты аудита большинства сайтов показывают, что многие вебмастера допускают одни и те же ошибки в техническом плане. Эти недочеты влияют на продвижение сайта по-разному, одни виды ошибок не позволяют поисковым роботам быстро индексировать страницы сайта, другие дают потенциальную уязвимость для конкурентов использовать эту техническую особенность для своих коварных целей, третьи же ошибки могут в последствии сыграть негативную роль в плане продвижения и позиций. Ниже описаны наиболее часто встречаемые технические недоработки и методы их исправления.

Доступность домена по разным адресам

Когда один и тот же ресурс доступен по разным URL-адресам, например, с префиксом www и без этого префикса, и при этом они не склеены между собой, возникает проблема дублированного контента. Поисковые роботы в данном случае могут посчитать, что по одному из адресов контент не уникален и поместить его в дополнительные результаты поиска. Не всегда выбранный поисковиком адрес дубля устраивает владельца сайта, поэтому следует избегать этой ошибки, склеивая между собой основной домен с неосновным зеркалом или со всеми алиасами домена.

Как проверить наличие ошибки?

Введите в адресную строку браузера адрес сайта с www. и без www. Если сайт доступен и в первом и во втором случае и при этом в файле robots.txt не прописана директива Host, тогда вы не выбрали основной домен для продвижения.

Как исправить ошибку?

Необходимо в файле robots.txt всех зеркал добавить директиву Host с указанием основного домена, например.

User-Agent: Yandex

Host: www.maindomain.ru

Где домен www.maindomain.ru (без http) является выбранным вами основным доменом. См. также статью о продвижении сайтов с помощью зеркал.

К тому же следует поставить 301 редирект с неосновного домена на основной. Таким образом, при вводе, например, адреса http://maindomain.ru/articles/ в браузер, пользователя должно редиректить на основной домен http://www.maindomain.ru/articles/.

Доступность главной страницы по разным адресам

Главная страница сайта должна быть доступна лишь по основному адресу http://www.maindomain.ru/. Если она доступна также и по другим адресам, например, http://www.maindomain.ru/index.php, то возникает ошибка дублированного контента, из-за которой возможно падение позиций сайта при удобном стечении обстоятельств (сочетании других факторов).

Как проверить наличие ошибки оптимизации?

Необходимо ввести в браузер адрес с index.php или index.html, например,

http://www.maindomain.ru/index.php

Если страница доступна и нет редиректа на основной домен, то ошибка существует. Также найти дубли главной страницы можно, введя в кавычках её TITLE в поиске Яндекса или Google, анализируя результаты выдачи.

Как исправить ошибку дублирования главной страницы?

Для исправления этой ошибки следует также использовать 301-ый редирект с дублей на основной домен, либо отдавать 404-ую ошибку (страницы не существуют). До этого следует из результатов поиска удалить все дубли (например, это делается с помощью панели для вебмастеров в Google). Редирект, при использовании apache и mod_rewrite, можно сделать следующими строками:

RewriteEngine On

RewriteCond %{REQUEST_URI} ^/index\.(.+)$

RewriteRule ^.*$ http://%{HTTP_HOST}/ [R=301,L]

Большой уровень вложенности страниц

Не совсем технический аспект, но часто эта ошибка оптимизации возникает из-за неправильной работы CMS (нехватки каких-либо модулей).

При индексации контента сайта, поисковый робот ходит по внутренним ссылкам со страницы на страницу по определенному алгоритму и своему расписанию. Документ с большим уровнем вложенности (более 3-4, то есть те страницы, которые доступны в минимум 3-4 и более кликах по ссылкам от главной) поисковики дают минимальный приоритет, что означает, что до этих страниц очередь переиндексации может дойти не скоро и старый контент может оставаться в индексе поисковых систем месяцами или даже годами. Это логично, так как страницы с большим уровнем вложенности обычно менее приоритетны для пользователей и имеют низкую вероятность посещений, а соответственно, и малый статический вес (ничтожный по сравнению со страницами 2-3 уровня вложенности).

Как найти страницы на сайте с большим уровнем вложенности?

Для поиска таких страниц можно использовать бесплатный инструмент Xenu Link Sleuth, который также позволит найти и другие ошибки.

Как исправить ошибку больших уровней вложенности?

Следует не допускать на сайте наличие подобных страниц и разделов. Если их возникновение неизбежно, тогда используйте стандартные средства перелинковки: html карту сайта, облака ключевых слов, древовидное меню, разделы “похожие статьи” для статей и новостей и другие методы перелинковки.

Наличие несуществующих страниц

Известная ошибка, когда для несуществующих документов выдается главная (или другая) страница сайта с 200-ым кодом ошибки, а не с 404-ым. В данном случае, опять же, может возникнуть проблема дублированного контента.

Как определить наличие ошибки?

Ввести в адресную строку браузера любую несуществующую страницу анализируемого сайта, например,

http://yandex.ru/not/exists

Если в HTTP заголовках выдается HTTP/1.1 404 Not Found, то все нормально, сайт отдает 404-ую ошибку. Если же в заголовках присутствует 200 ошибка или 304-ая (Not Modified), то следует исправить этот недочет.

Как исправить ошибку?

Необходимо для несуществующих страниц выдавать соответствующий код, чтобы поисковый робот не добавлял их в индекс. Обычно это настраивается в используемой CMS. Если у вас нет таких настроек, тогда проверьте .htaccess файл или обратитесь к разработчикам вашей сисетмы управления контентом.

Другие технические ошибки оптимизации

Также существуют некоторые другие, менее популярные технические аспекты, которые не учитываются оптимизаторами или вебмастерами при продвижении сайтов. К ним относятся:

— Ошибки в движке сайта

Формирование дублей, добавление параметров сессий в URL-адреса, неверные коды ответов страниц, ошибки в .htaccess-файле.

— Открытые серверные логи

Увеличивают количество неинформативных страниц в индексе поисковой системы, уменьшая доверие к сайту и скорость индексации важного контента.

— Низкая скорость отдачи страниц

Скорость отдачи страниц пользователю является одним из факторов ранжирования с недавнего времени. Чем больше вы заботитесь о пользователях, тем больше доверия получаете и от поисковых систем.

Анализируйте свои сайты самостоятельно или заказывайте аудит, выявляйте технические ошибки и устраняйте их. Успехов в оптимизации!

Типовые технические проблемы региональных сайтов медицинских клиник

Конкуренция в региональной поисковой выдаче гораздо ниже, чем в Москве, и для выхода на первые места интернет-ресурсам не нужно прикладывать сверхусилий. Достаточно просто иметь нормальный сайт и выполнить базовые типовые работы по поисковой оптимизации. Однако до сих пор они делаются не на всех сайтах, а особенно плачевно все выглядит в нише медицинских услуг в регионах.

Мы понимаем, что для медицинских клиник и врачей поисковая оптимизация, сайты, да и интернет в целом, не всегда приоритетное направление для продвижения своих услуг. Максимум они отображают услуги, цены, но редко когда изучают возражения/боли клиентов, чтобы закрыть их еще на этапе изучения и выбора медицинского центра.

Сейчас 2018 год и все пациенты даже при малейшей головной боли лезут в сеть. По данным wordstat.yandex.ru, спрос на медицинские услуги растёт год от года. И этот пласт пациентов необходимо “осваивать”. Если не заниматься SEO-оптимизацией, то можно просто потерять большое количество потенциальных клиентов, которые уйдут к конкурентам с более функциональными сайтами.

Оптимизированный сайт сегодня также важен для клиники, как наличие бахил или вежливость администратора.

Илья Русаков и команда агентства impulse.guru проанализировали сайты популярных региональных медицинских клиник Нижнего Новгорода и Владимира по техническим и маркетинговым параметрам.

На основе полученных данных можно смело говорить о типовых ошибках, большинство которых решаются быстро и просто. В этом материале вы узнаете о том, как их исправить, а ещё лучше — вообще не допускать.

Для удобства, предлагаем разделить оптимизацию на множество небольших работ. Важно убедиться, что сайт не отстаёт от конкурентов по каждому из перечисленных параметров. Если сайт уже занимает первые места, то рекомендуем ориентироваться на сайты из более крупных регионов, чтобы сравнивать себя с лучшими представителями рынка.

Релевантность сайта запросам

Влияние на позиции: Высокое

Влияние на конверсию: Высокое

Сложность работы: Высокая

Мы собрали несколько кластеров с запросами, которые связаны с популярными услугами многофункциональных медицинских центров (гинекология, неврология, терапия, кардиология, косметология). 164 запроса по Нижнему Новгороду и 106 запросов по Владимиру. Из общего списка убрали брендовые и информационные запросы. Также не учитывали запросы, где есть имена конкретных врачей. Остались самые целевые и универсальные фразы.

Пример запросов, по которым мы оценивали видимость медицинских центров в поисковой выдаче Яндекса: [гинеколог во владимире], [платная клиника в нижнем новгороде] и т.п.

Пример кластеров с запросами, по которым оценивалась видимость сайтов

Данные кластеры могут считаться основой для создания семантического ядра сайта.

Чем больше запросов из семантического ядра есть в ТОПе выдачи поисковых систем, тем выше видимость сайта, и, соответственно, посещаемость. Как же повысить видимость сайта в поисковой выдаче?

Цель поисковой системы – дать своим пользователям лучшие ответы на их запросы.

Цель поисковой оптимизации сайта – сделать так, чтобы именно ваш сайт давал ответы на запросы пользователей поисковых систем лучше конкурентов.

Сайт должен быть самым удобным и информативным, сами услуги и их описание должны быть самыми привлекательными, технические проблемы отсутствовать.

Чтобы сайт получил хорошую видимость в поисковой выдаче, у него должно быть множество оптимизированных посадочных страниц, которые дают полноценные ответы на запросы. Без хорошей структуры сайта и полного семантического ядра это невозможно сделать.

Оптимизация мета-тега Title

Влияние на позиции: Высокое

Влияние на конверсию: Нет

Сложность работы: Средняя

Title – это основной мета-тег, который учитывают поисковые системы при ранжировании сайтов в выдаче. Он обязательно должен быть прописан на всех страницах сайта.

Все Title должны быть уникальными, соответствующими содержанию страницы. Title — это не перечисление ключевых слов, а понятный заголовок, который полноценно описывает содержание страницы. На большинстве исследуемых сайтов мета-теги не оптимизированы.

“Невролог во Владимире, платный прием, отзывы — Название клиники” – хороший Title.

“Невролог” – плохой Title.

Мы смотрели мета-тэги именно на посадочных коммерческих страницах, которые должны собирать большую часть трафика из поисковых систем.

Отметим, что даже у сайтов с отличным дизайном, уникальными качественными фотографиями и видео нет оптимизированных мета-тэгов.

Оптимизация мета-тегов — одна из базовых работ по продвижению сайта, которая проводится в первые месяцы продвижения. Сложность оптимизации мета-тегов основных посадочных страницах не такая высокая. Составление мета-тегов для 100 страниц занимает около недели.

Дубли и отсутствие мета-тегов Title и Description

Влияние на позиции: Высокое

Влияние на конверсию: Нет

Сложность работы: Средняя

Мета-теги Title должны быть не только оптимизированы, но и уникализированы. Каждая страница сайта должна иметь уникальное содержание. Логично, что мета-тэги, описывающие контент страницы, также не должны повторяться.

Пример дублей мета-тэга Title на сайте babyboom33.ru

Дубли мета-тэгов негативно влияют на ранжирование сайта в поиске. Проблема с дублями встречается у подавляющего большинства исследуемых сайтов.

Техническая оптимизация сайта. Что это?

Мы уже рассматривали такие важные параметры подготовки к продвижению сайта, как оптимизация изображений и текстовая оптимизация. Однако есть еще один существенный момент, с которого следует начинать работу, – это техническая оптимизация сайта.

Можно сказать, что это первый и наиболее важный этап. В основном подобная операция проводится один раз перед началом продвижения ресурса, а в дальнейшем она лишь корректируется и подправляется. Иными словами, это комплекс действий, которые направлены на корректировку технических нюансов сайта для улучшения взаимодействия его с поисковым роботом.

Главная задача технической оптимизации – обеспечивать максимальную индексацию страниц сайта. Если же упустить из виду какие-либо технические моменты, то это станет значительной преградой на вашем пути к ТОПу в выдаче, а, возможно, и сделает продвижение невозможным.

Безусловно, все технические доработки должны выполняться специалистами-разработчиками сайта. Пользователю или даже владельцу ресурса не стоит «лезть» в HTML-код, так как это может привести к непоправимым последствиям, а в большинстве случаев компании не несут ответственность за нарушения по вине иных лиц.

Рассмотрим основные технические проблемы и пути их решения. Однако еще раз напомним: любые изменения должны вносить специалисты.

При правильной технической оптимизации у поискового робота нет никаких претензий к отображению страниц и сайта в целом, ресурс не выдаёт ошибки и сбои, а – следовательно — индексируется быстро и хорошо.

Пять основных моментов технической оптимизации

Этот текстовый файл должен быть в корневой категории вашего сайта. Он содержит определенные инструкции для поискового робота, который обращается к нему в первую очередь. В этом файле можно указать те страницы, которые нельзя индексировать (допустим, системные или дублированные). Также в нём указывается адрес зеркала сайта, адрес карты сайта, а также иная информация для правильной индексации, предназначенная для поисковых роботов.

- Адреса всех страниц ресурса

Все адреса должны формироваться по следующей схеме (проверьте это):

- использование слешей.

Например, http://mysite.ru/katalog/ и http://mysite.ru/cost/ — правильно.

http://mysite.ru/katalog и http://mysite.ru/cost/ — неправильно;

- все адреса должны быть написаны латинскими буквами, не смешивайте русский язык и латиницу в одном адресе. Этот пункт особенно касается сайтов доменной зоны .рф.

Например, http://mysite.ru/katalog/dress/ — правильно,

http://mysite.ru/katalog/платья/ — неправильно;

- не советуем использовать в адресах различные символы, они могут некорректно обрабатываться и отображаться. Речь идёт о «?», «@», «#» и т.д.

Для проверки адресов будет удобно воспользоваться картой сайта.

- Sitemap или карта сайта

Помимо того, что картой сайта пользуются роботы, она полезна и удобна для пользователей. С её помощью легко искать информацию на сайте. Для робота на карте видна структура, а посетителю удобно ориентироваться на сайте. В файле Sitemap вы также можете прописать инструкции для Яндекса, какие страницы следует индексировать в первую очередь, как часто вы делаете обновления на сайте. Не забывайте, что карта может содержать не более 50000 страниц, иначе вам необходимо создавать второй экземпляр.

В тот момент, когда пользователь открывает страницу или робот начинает её проверку, сервер с расположения сайта даёт ответ, то есть информацию о состоянии вашего ресурса и необходимой страницы.

Основные коды таковы:

- 200 – со страницей все в порядке,

- 404 –страница не существует,

- 503 – сервер временно недоступен.

Правда, иногда даётся и неверный код. Предположим, страница может быть рабочая, а код ошибки 404 (либо другие комбинации). Этот момент нужно заранее проверить и отследить, чтобы сделать правильную настройку кодов в файле .htaccess.

Пристальное внимание уделите настройке ошибки 404. Если какая-то страница существует, а сервер сообщает код 404, то индексироваться она не будет. Сделать проверку кодов статусов можно при помощи известного вам Яндекс.Вебмастера.

- Настройка редиректа

Наиболее часто встречающаяся ошибка – не настроен редирект с домена www на домен без www (или же обратная ситуация). Выберите, какое доменное имя будет главным и укажите это в файле .htaccess для поисковых систем. Иначе один и тот же сайт будет восприниматься как дубль, что приведёт к проблемам в ранжировании. Это касается и иных редиректов с других зеркал – страницы вида «index.htm», «index.html» и т.д.

- Теги Title и Description также относятся частично к технической оптимизации. Они должны быть уникальны на каждой странице, отображать её суть и содержимое.

- Проверьте время загрузки сайта. Рекомендованные показатели таковы: до 0.7 сек (700 мс) должно уходить на скачку исходного кода документа и до 0.2 сек (200 мс) для получения ответа сервера.

- На каждой странице должно быть не более одного заголовка уровня h2. Проверьте также, чтобы заголовки всех уровней от h2 до H6 не использовались в оформлении страниц.

- Иконка favicon. Мелочь, на которую тоже стоит обратить внимание.

- Обязательно протестируйте отображение вашего сайта в основных браузерах – Сhrome, Android Browser, FireFox, Mobile Safari, Opera. Особое внимание уделите различным заполняемым формам (если такие есть на сайте).

- Закройте от индексации страницу доступа в административную панель CMS — /wp-login, /administrator, /bitrix, /admin.

- Необходимо проверить вёрстку на наличие незакрытых парных тегов. Если тег Td открыт, он должен быть обязательно закрыт /Td.

- В файле Robots также следует закрыть от индексации служебные папки (cache, wp-includes) и документы разрешения .pdf и .doc, если они не несут никакой информации.

- Если у вас интернет-магазин, то вам следует закрыть страницы авторизации, фильтрации, поиска, страницу оформления заказа и логина пользователя.

Альтернативой файлу robots.txt считается мета-тег name=“robots” со значениями полей «content=“noindex, follow“». Он требует немного более сложной настройки, но при этом более внимательно соблюдается поисковыми системами.

Даже после окончательного формирования списка страниц, закрытых от индексации, всё равно стоит периодически проводить мониторинг сайта на момент возможного появления дублей каких-либо страниц.

Любая ошибка в технической оптимизации, которая будет пропущена изначально, так или иначе будет вам вредить и мешать на пути к ТОПу в выдаче. Постарайтесь убрать каждую из них. В нашем списке мы собрали наиболее распространённые ошибки, которые допускаются создателями сайтов или просто упускаются из вида.

предыдущие записи

-

Анализ неявных предпочтений пользователей.

17:31 10/03/2015Анализ неявных предпочтений пользователей — важнейший фактор в ранжировании документов в результатах поиска или, например, показе рекламы и рекомендации новостей.

-

Landing Page по ремонту квартир

00:58 27/11/2014Хотите сделать Landing Page по ремонту квартир? Мы подобрали для Вас примеры лучших лендингов, которые нашли в поисковых системах.

-

Как проверить скорость сайта

23:25 30/03/2015Скорость загрузки сайта — это, конечно, прежде всего показатель, который заметен пользователю сайта. Но в результате он влияет и на позицию Вашего сайта

-

Landing Page для услуги наращивания волос

20:07 06/05/2015Хотите сделать Landing Page для услуги наращивания волос? Мы подобрали для Вас примеры лучших лендингов, которые нашли в поисковых системах.

Техническая оптимизация сайта: устраняем проблемы с хостингом

Оптимизация любого ресурса – это кропотливый процесс, занимающий продолжительное время. Он требует к себе внимания и временных затрат. Есть несколько основных этапов, грамотное выполнение которых сможет в значительной степени повлиять на успех продвижения сайта:

технические действия по оптимизации работы ресурса;

оптимизация и создание контента;

оптимизация графических объектов и изображений.

Первым делом нужно провести все работы с техническим состоянием ресурса, устранить ошибки и нормализовать его работу. Когда техническая составляющая работает корректно, можно приступить к наполнению текстом и графическими объектами. Можно выполнять эти этапы не последовательно, а параллельно.

Начнем подробно рассматривать техническую оптимизацию ресурса.

Техническая оптимизация

По-другому техническая оптимизация называется доработкой, в понятие включается полный комплекс действий, которые направлены на корректирование технических параметров сайта. Направлены такие действия на правильную работу и взаимодействие с поисковыми системами. Главная цель – это обеспечить максимально быструю и полную, а главное, правильную индексацию всех страниц вашего ресурса.

Индексацией страниц называется включение в базу данных поисковых сервисов сведений о ресурсах, ссылках, ключевых словах графических и текстовых материалах для того, чтобы провести максимально эффективно ранжирование сайта в результате выдачи.

Для эффективного проведения технической оптимизации важно уделить внимание работе над многими элементами, от которых зависит наличие или отсутствие помех на пути к оптимальному ранжированию сайта.

Самыми распространенными элементами технической оптимизации являются:

код страницы не оптимизирован должным образом;

проблемы связанные с работой хостинга;

некорректная обработка ошибки 404;

возможные неточности и ошибки при настраивании зеркал;

некорректно работает статус – код;

дублирование составляющих ресурса или отдельного фрагмента контента;

неработоспособные ссылки;

ошибки в файле rоbots.txt;

ссылочная масса, ведущая на внешние сайты, открытые для оптимизации;

sitemap.xml – составлен с ошибкой.

Рассмотрим каждый элемент, чтобы выяснить главные проблемы, которые могут быть связаны с ними, и начнем с обсуждения в этой статье проблем с хостингом.

Проблемы с хостингом

Хостингом называется площадка, на которой размещается информация на подключенном к сети сервере. Это одна из самых главных составляющих хорошего сайта. Если хостинг будет работать корректно, на нем не будет ошибок или сбоев, то индексация роботами поисковых систем будет происходить без проблем.

Если же хостинг часто выдает сбои, то поисковой робот, который несколько раз попытается найти ваш сайт и наткнется на его отсутствие или заметит, что он не работает, – может исключить ресурс из индексации, решив, что его больше не существует. В этом случае можете считать, что время и средства на создание такого ресурса были потрачены просто так.

Какие еще могут быть проблемы с хостингом.

Ожидание отклика

Одной из самых распространенных ошибок сервера является длительное ожидание отклика. Поисковые роботы оценивают, насколько быстро посетители попадают на сайт. Если длительность отклика слишком большая, то поисковые роботы могут некорректно индексировать сайт, а посетители покидать, не дождавшись загрузки. Поэтому лучше снизить значение этого показателя до минимума.

Нормальное и ошибочное время ожидания в миллисекундах выглядит так:

Чтобы проанализировать насколько быстро пользователи и ПС могут попадать на сайт можно воспользоваться инструментом «Проверка ответа сервера», который доступен в Яндекс. Вебмастере. Для того чтобы выполнить проверку нужно ввести адрес вашего сайта (URL) в строку и нажать «проверить».

Будьте внимательны, такой сервис будет возможно использовать, только если сайт подтвержден.

В строке под названием «время ответа сервиса» будет формироваться вся информация, полученная с помощью проверки:

Низкий аптайм

Это время, в течение которого сервис был полностью работоспособен. Отличными такие показатели считаются, если они приближены к 100%, к примеру, 99, 98%. Ресурсам на таких площадках легко занять первые строчки в поисковой выдаче. А вот если показатель в значительной степени, ниже этого значения – это проблема, которая будет серьезной помехой на пути к ТОПу поисковых систем. Чтобы не упустить момент, когда ресурс может просто исключить из индексации, необходимо регулярно отслеживать значение, которое имеет аптайм на вашем хостинге.

Отследить аптайм можно следующими способами:

с помощью хостинга-провайдера, где размещен сайт. Крупные хостинговые компании предлагают информацию по анализу работы аптайма серверов. Если случаются перебои в работе, оповещают об этом пользователей по телефону или другим заявленным каналам связи;

специальными серверами: есть много автоматизированных систем, которые предлагают оценить работу хостингов. Это бесплатные и платные сервисы. Hоst-traker, Pingdom, Ping-Admin относятся к самым востребованным сервисам, среди пользователей хостинговых услуг;

с помощью Яндекс. Вебмастера и «Инструменов для веб-мастеров» от Google. О степени корректности функционирования ресурса с помощью Яндекс.Вебмастера можно судить, пройдя в «индексирование сайта», где есть специальная вкладка «история», в ней выбрать «количество запросов».

Автоматически система выстроит график, где будет видно, были ли прерывания или ошибки в работе сайта в течение выбранного периода. Если ошибки были, то график будет выглядеть таким образом:

Если сбоев не наблюдалось, то вы увидите:

Если нужно проверить ошибки через сервис «Инструментов для веб-мастеров», то вам нужно выбрать «сканирование», кнопка находится в меню системы. Далее нажимаем «ошибки сканирования»:

Если наблюдались сбои в работе, то график будет выглядеть так:

Для ознакомления с подробными данными нужно перейти во вкладку «подключение к серверу», где можно нажать на значок пиктограммы, в виде вопросительного знака и перейти по ссылке «подробнее». Вы перейдете на страницу, где будет содержаться полная информация:

IP-сервер хостинга присутствует в спам листе любых почтовых служб, поисковых системах

Если есть такие ограничения, то их нужно срочно исправлять, так как пользователь не сможет написать письмо владельцу сайта, оно будет заблокировано системами. Поисковики крайне негативно относятся к спаму, что будет серьезной причиной не попадания в ТОП выдачи.

Если после сбора информации о хостинге вы выявили какую-либо проблему, то нужно срочно решать их, перед тем, как перейти к наполнению сайта контентом и графической информацией, чтобы сразу повысить свои шансы попасть в ТОП поисковой выдачи.

Решить эти проблемы можно несколькими способами:

оптимизация кода сайта: Замедление отображения страниц может возникать из-за некорректного кода, что влияет на скорость загрузки и работоспособность некоторых функций, увеличивая нагрузку на сам хостинг. Если у вас есть навыки в веб-разработке сайтов, то нужно будет только время не перепроверку кода. Если нет, то потребуются услуги разработчиков;

обратиться в службу вашего хостинга и попросить их исправить неполадки. Это могут быть не только проблемы сервера, но и вашего тарифного пакета. В данном случае лучше приобрести дорогостоящий, чтобы не потерять большего. В тарифном плане с большей ставкой чаще всего предлагаются большие объемы дискового пространства, трафика, почтовых служб и другого ресурса, что может помочь организовать корректную работу сайта. В результате этих действия работоспособность ресурса повысится в несколько раз, становясь привлекательным для ПС и пользователей;

отказаться от услуг провайдера и сменить хостинг службу. Радикальный вариант, который может потребоваться, если устранение проблем невозможно. Качественная поддержка другого хостинг-провайдера поможет вам получить привлекательный работоспособный сайт.

Неочевидные проблемы на сайте, которые мешают SEO

Эффективное продвижение сайта требует проработки множества мелких деталей. Продуманная структура, качественный контент и его регулярное обновление, обратные ссылки – все это влияет на видимость ресурса в поиске.

Эффективное продвижение сайта требует проработки множества мелких деталей. Продуманная структура, качественный контент и его регулярное обновление, обратные ссылки – все это влияет на видимость ресурса в поиске.

Тем не менее, любой сайт может содержать множество неочевидных ошибок, которые на первый взгляд совершенно не видны. Чаще всего это касается технической части, но иногда неправильным является сам подход к решению определенной задачи. И все это работает против вас, постепенно сводя на нет все усилия, направленные на продвижение проекта.

Визуально все может выглядеть просто замечательно. Проблемы кроются внутри. Определить их несложно и сделать это можно при помощи ряда инструментов, изначально созданных для такой диагностики.

И вот список наиболее распространенных проблем, на предмет которых мы рекомендуем вам проверить и свой сайт.

Низкая скорость загрузки

Даже красивый внешне сайт будет бесполезным, если он работает медленно. Иногда используемые дизайнерами «красивости» и являются основной причиной медленной загрузки страниц. Или чрезмерно большое количество подключенных модулей. Или просто ошибки в коде, которые влияют на производительность.

Причин может быть много. Если у вас быстрый интернет, это может быть не заметно. Но не значит, что проблемы не существует. Поэтому всегда лучше убедиться, что все «ОК», и у людей, которые используют мобильный интернет или просто медленное соединение, тоже все хорошо.

Как проверить:

Воспользуйтесь сервисами GTmetrix или Pingdom Website Speed Test. Они позволяют не только протестировать скорость загрузки, но и выдают рекомендации каким образом это значение можно улучшить.

Дубли страниц

Страницы с полностью идентичным или частично заимствованным контентом, чаще всего являются результатом особенностей работы движка. Причем, это характерно как для open-source, так и для бесплатных CMS. Страницы пагинации и фильтров – наиболее частый их пример.

Чем плохи дубли? Дело в том, что наличие на сайте нескольких URL с идентичным или очень похожими метатегами и прочим дублированным содержимым, усложняет поисковым роботам оценку их релевантности и ранжирование. В итоге, если дублей много, это сказывается на видимости сайта в целом. Решается проблема путем уникализации таких страниц и применения атрибутов rel=»canonical» или meta name=»robots».

Как проверить:

Проще всего просканировать сайт специальным краулером типа Screaming Frog SEO Spider или NetPeak Spider, а затем сверить результаты по списку Title и Description. Их совпадение чаще всего и является признаком дублей.

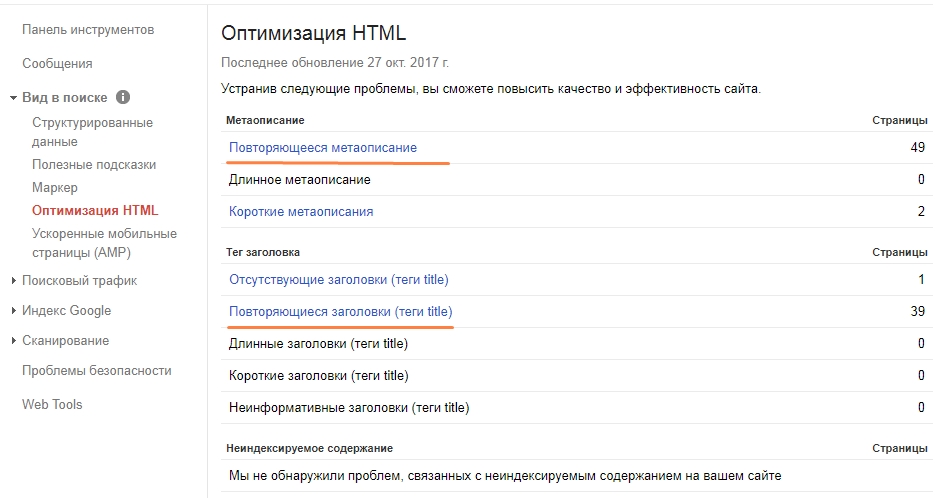

Также можно посмотреть отчет в Google Search Console -> Вид в поиске -> Оптимизация HTML. Здесь нам интересны пункты «Повторяющееся метаописание» и «Повторяющиеся заголовки (теги title)», которые содержат аналогичную информацию о дублях.

Неуникальные тексты

К 100% технической уникальности стремится смысла особого нет, тем более что в некоторых тематиках это и невозможно. Но за текст, скопированный с чужих сайтов чуть менее чем полностью, поисковики тоже по голове не погладят. А продвигать такие страницы и вовсе нет смысла. Хорошо если из-за такой практики весь сайт под фильтр не улетит.

Это одна сторона проблемы. Вторая – статьи с вашего сайта тоже могут растянуть на десятки других ресурсов. Или копирайтер, который занимается его наполнением, решит упростить себе жизнь и вместо уникальной статьи опубликует скомпилированный из нескольких источников микс. В любом случае, действует правило «доверяй, но проверяй».

Как проверить:

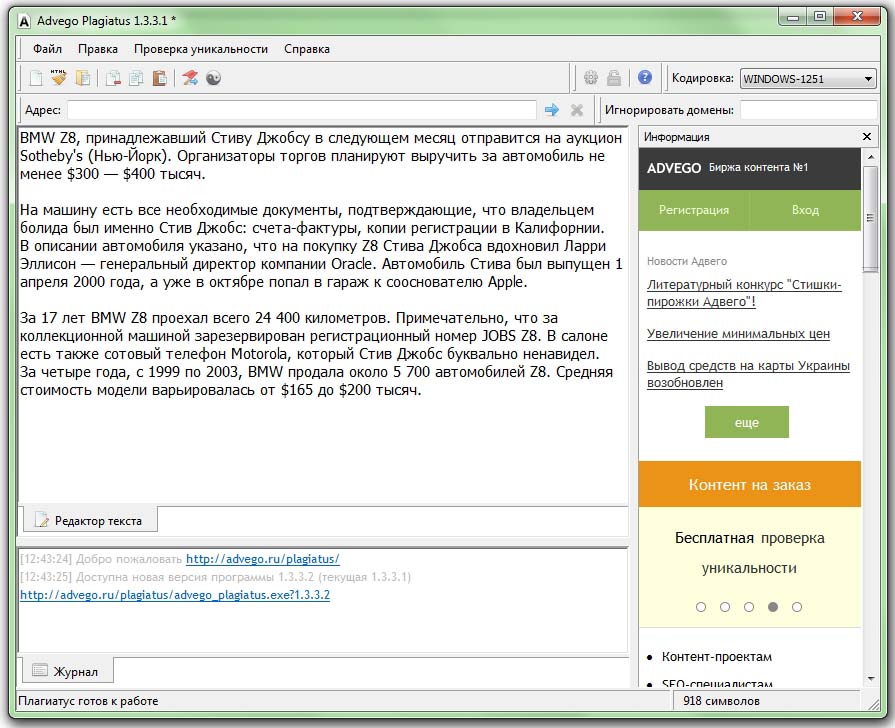

Отдельные тексты можно вручную, при помощи программ eTXT Антиплагиат или Advego Plagiatus:

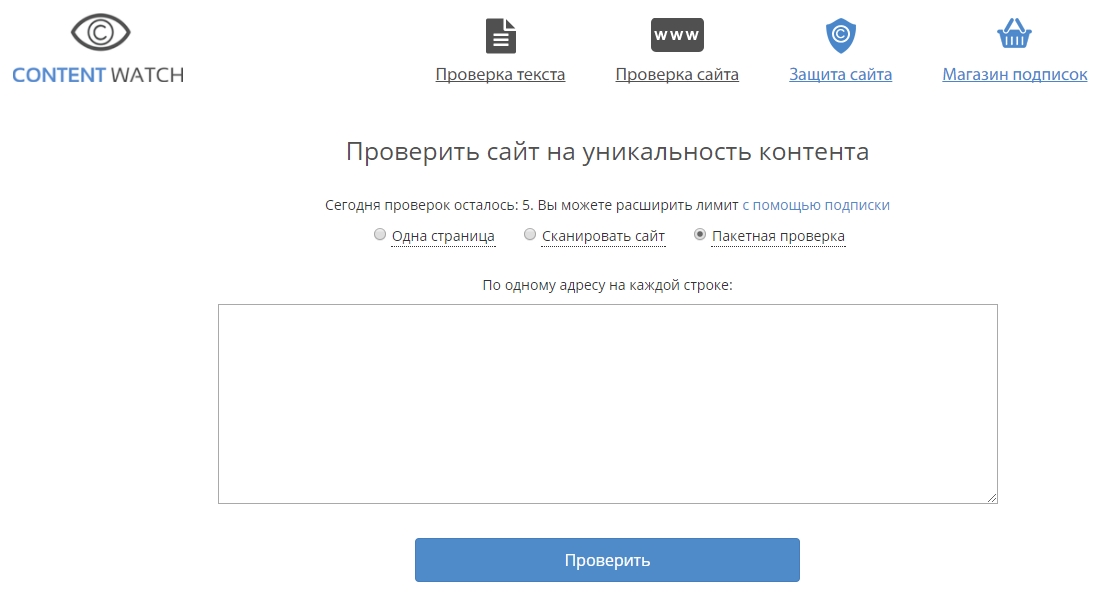

Проверка списка URL-страниц в пакетном режиме возможна через сервис Content-watch.ru:

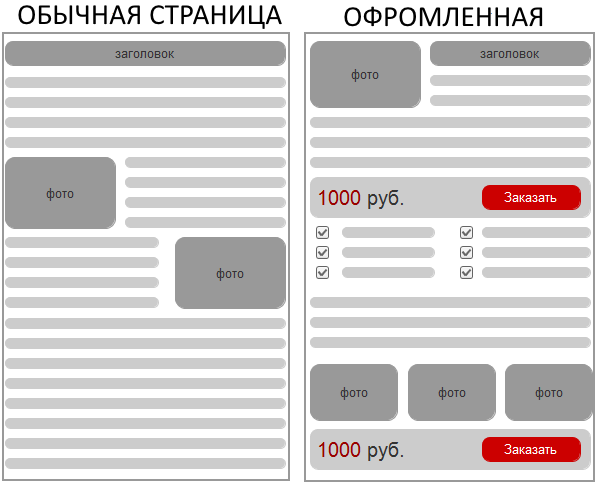

Недостаточная проработка посадочных

Страницы услуг для коммерческого сайта, карточки товаров для интернет-магазинов и прочие важные посадочные, нуждаются в особо тщательной проработке. Ведь от того, насколько хорошо они выглядят и отвечают потенциальным запросам ЦА, зависит коэффициент конверсии посетителей в клиентов для бизнеса.

Распространенная проблема – нужные страницы вроде и есть, вот только конверсия по ним оставляет желать лучшего. Анализ конкурентов, точечная аналитика и мозговой штурм позволяют понять, что именно улучшить, чтобы повысить отдачу от них. А улучшить можно следующие моменты:

- расширить семантику, под которую оптимизируется страница;

- добавить больше текста, сделать его более информативным;

- добавить фото и видеоконтент;

- добавить блоки внимания и призывы к действию;

- структурировать контент, сделав его более читабельным.

Вроде и не такой уж и большой перечень задач получается, но эффект от их внедрения может быть очень хорошим. Простой, но наглядный пример:

Как проверить:

Если у вас настроено отслеживание целей в веб-аналитике, проверьте показатель конверсии и отказов по каждой важной странице. Если на части из них эти показатели существенно хуже, чем на остальных, значит они требуют доработки в первую очередь.

Пройдитесь по аналогичным страницам конкурентов из Топа, посмотрите как они выглядят. Исходите из позиции покупателя, если бы вам был нужен конкретный товар или услуга, где бы вы сделали покупку – на вашем сайте или каком-нибудь другом, который вызывает больше доверия?

Неправильное использование ключевых слов

У этой медали две стороны – недостаточная интеграция ключей в тело страницы или же чрезмерное насыщение ими (переоптимизация). И в первом и во втором случае у вас будут проблемы. Причем, не всегда вы сможете понять быстро, что что-то не так.

Качественное семантическое ядро – основа любой работы по оптимизации сайта. Но работать с этими ключами тоже нужно уметь, используя запросы аккуратно. Здесь нет готовых рецептов, просто стремитесь к балансу, чтобы текст и метатеги страницы содержали нужные запросы, оставаясь при этом читабельными и естественными для восприятия.

Как проверить:

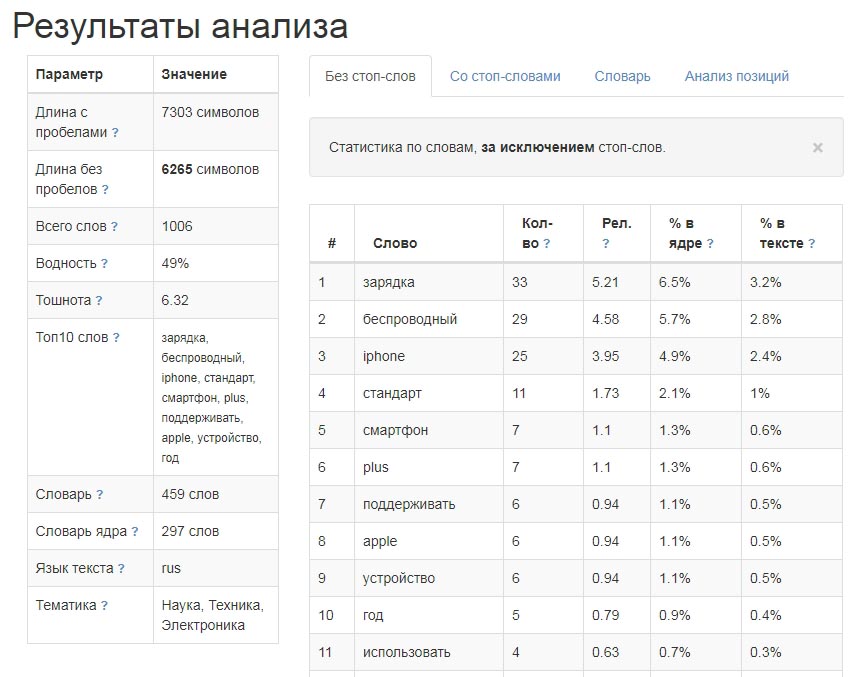

Плотность и вхождения ключевых слов на странице можно проверить при помощи любого текстового анализатора. К примеру, хорошо подходит бесплатный сервис Istio.com, который умеет анализировать как текст, так и URL-адрес. Пример результата:

Неадаптивный дизайн

Адаптивность верстки – это свойство дизайна сайта подстраиваться под параметры экрана устройства, с которого осуществляется просмотр. Главная задача, которая решается таким образом, состоит в обеспечении комфортного использования сайта как на PC так и на мобильных. А мобильные пользователи в некоторых нишах уже превысили показатель 50% от общего трафика!

Если сайтом неудобно пользоваться на мобильных, это влияет на продажи, поведенческие факторы, и в итоге сказывается на его видимости в поиске в целом. Вы теряете и прибыль, и рейтинг в поиске.

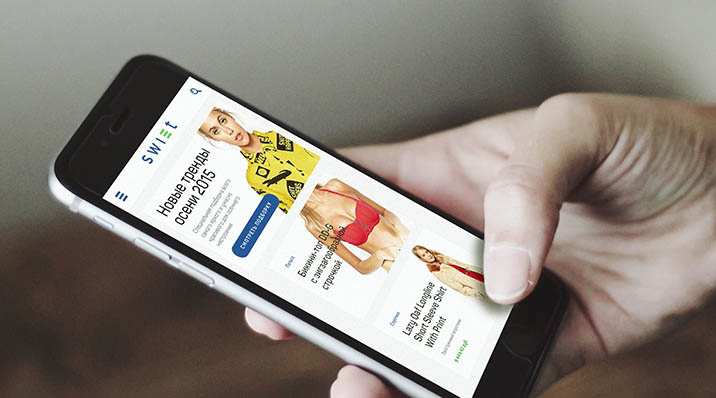

Покажем на примере. Хорошо если ваш сайт выглядит на мобильном вот так (адаптивный дизайн):

И плохо если вот так (неадаптивная верстка):

Как проверить:

Самый простой способ – зайдите на свой сайт с мобильника и попробуйте им попользоваться. Просмотрите страницы, запустите поиск, попробуйте сделать заказ.

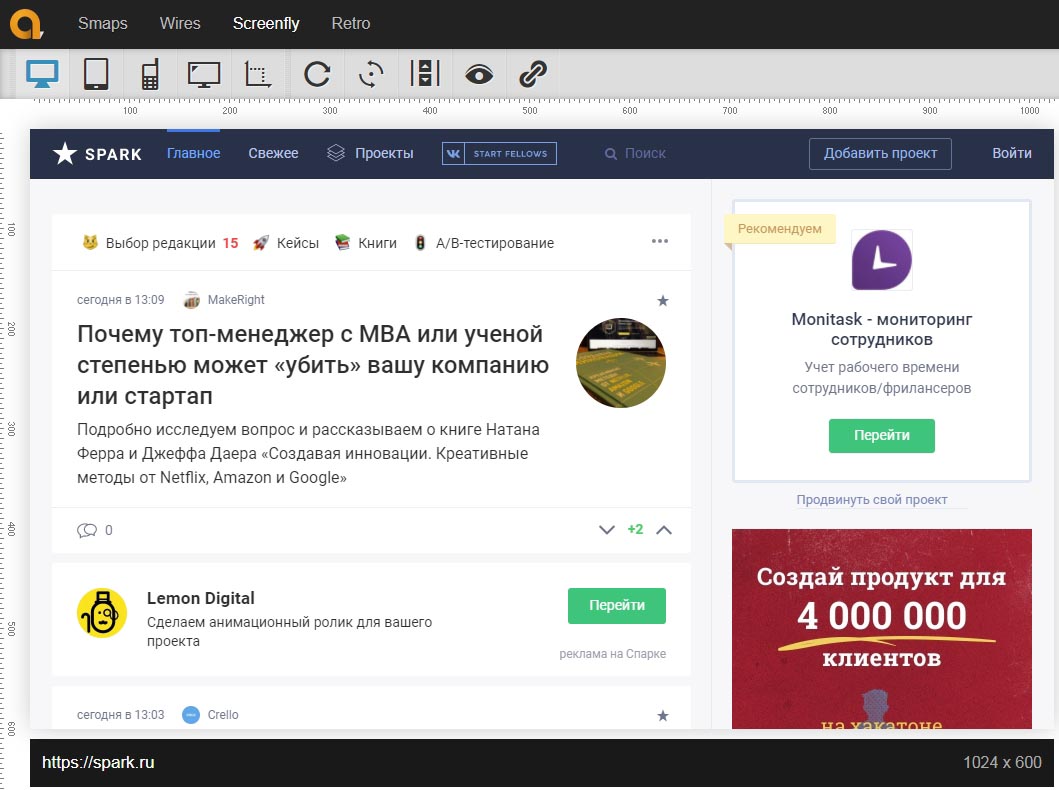

Еще один вариант – воспользуйтесь специальным сервисом, который позволяет протестировать отображение сайта на устройствах с различной диагональю экрана. К пример, Screenfly:

Вирусы или взлом

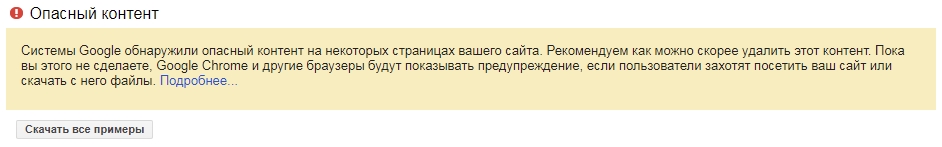

Нечасто, но такое бывает. Естественно, что это ставит под вопрос все продвижение. Внешне с сайтом все может быть совершенно нормально, даже спад трафика и заказов пойдет не сразу. Обнаруживают проблемы с безопасностью чаще всего после того как приходит уведомление от хостера или от самой поисковой системы в панели вебмастера:

Проблему необходимо решать незамедлительно, ведь неизвестно как злоумышленник начнет действовать в будущем. Уязвимости устранить и, по возможности, подключить какой-нибудь модуль для защиты. Ну и как минимум, своевременно обновлять версию движка, так как над вопросами безопасности регулярно работают сами разработчики.

Как проверить:

Следить за уведомлениями в панелях вебмастеров, раздел «Проблемы безопасности» (Google Search Console) и «Диагностика» (Яндекс.Вебмастер).

Битые, исходящие и скрытые ссылки

Не только внешние, но и внутренние ссылки влияют на ранжирование сайта. Если на нем есть ссылки, которые ведут на несуществующие страницы, выдавая ошибки «404», ссылки на ресурсы сомнительного качества и «невидимые ссылки» (того же цвета, что и фон), поисковые системы вполне могут посчитать это подозрительным.

Да и пользователи будут не в особом восторге от того, что вместо того материала, который им «обещал» переход по определенной ссылке, они видят сообщение об ошибке. На поведенческих факторах это тоже скажется.

Цель проста: найти проблему и устранить её. Битые ссылки заменить на актуальные, а нежелательные беклинки убрать или закрыть в «nofollow».

Как проверить:

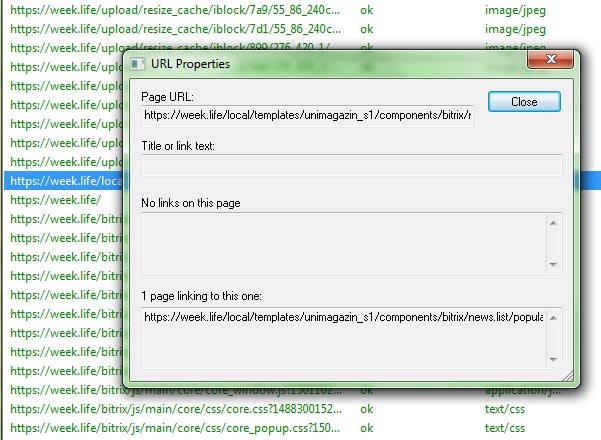

Скачиваем бесплатную программу Xenu Link Sleuth и запускаем сканирование своего сайта. После окончания процесса проблемные/битые ссылки в отчете будут выделены красным цветом. Сортируем по колонке «Status»:

Затем, кликаем правой кнопкой мыши по любой из них, и выбираем в меню пункт «URL properties»:

Внизу окошка отображается список страниц на которых проставлена данная ссылка, теперь вы можете убрать её или исправить.

Выводы

Перечисленные проблемы встречаются на многих сайтах и часто являются основной причиной, почему приложенные усилия по SEO не дают достаточного результата. Не все из них влияют на ситуацию достаточно сильно, но, в совокупности, способны принести немало проблем.

Сложности с поисковым продвижением не всегда являются следствием применения неправильных методов или нарушения правил поисковых систем. Иногда нужно просто лучше заботиться о состоянии самого сайта. И в любом случае ориентироваться на его удобство для пользователей.

Предупрежден – значит вооружен. Так что не лишним будет проверить и свой сайт по этому списку, чтобы обилие мелких ошибок не превратилось однажды в снежный ком, остановить который будет уже куда сложнее.

А у вас есть чем дополнить наш список? Поделитесь своим мнением в комментариях!

Подпишитесь на обновления, чтобы быть в курсе!