типичные ошибки и их устранение 🚀

В основе работы любого поисковика заложен простой принцип: в строке поиска вводится запрос, система анализирует его и выдаёт релевантные результаты. Далее отобранные сайты ранжируются (сортируются) и отображаются списком по убыванию релевантности. Лидеры, стоящие на самой верхушке — топы поисковой выдачи.

Большинство пользователей находят необходимую информацию уже на первой странице выдачи. Это объясняется тем, что в топ-10 стоят платформы с высоким рейтингом доверия поисковой системы. Многие люди даже не переходят на вторую страницу выдачи, поскольку нашли, что искали, на первой. Следовательно, чем ближе сайт к топу, тем больше посетителей на него переходит.

SEO: что это и почему так важно грамотно оптимизировать свой сайт

SEO расшифровывается как «Search Engine Optimization», что в переводе с английского означает «поисковая оптимизация». Это заранее проработанный план действий, который улучшит показатели сайта и поспособствует продвижению его в поисковой выдаче за счёт адаптации под требования поисковой системы.

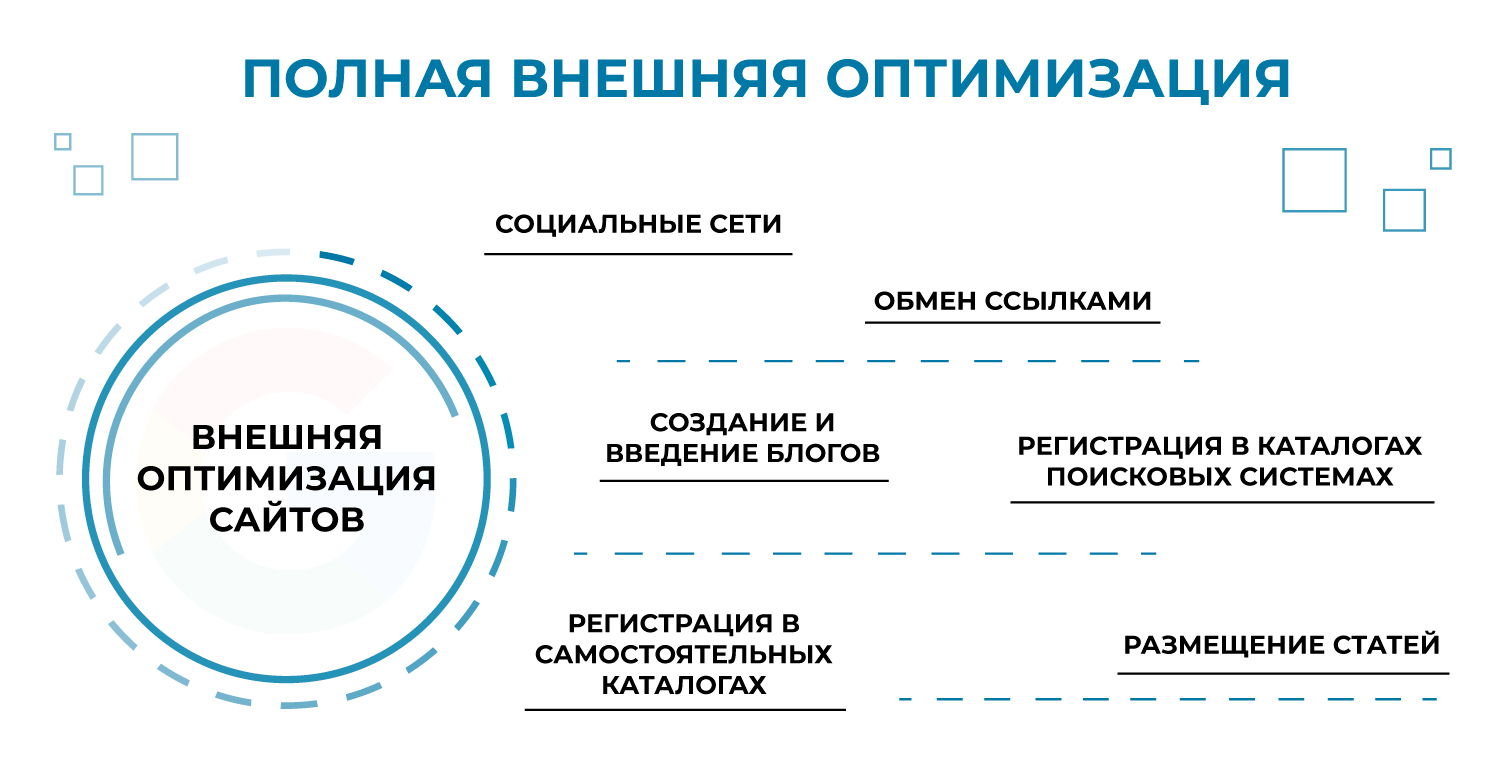

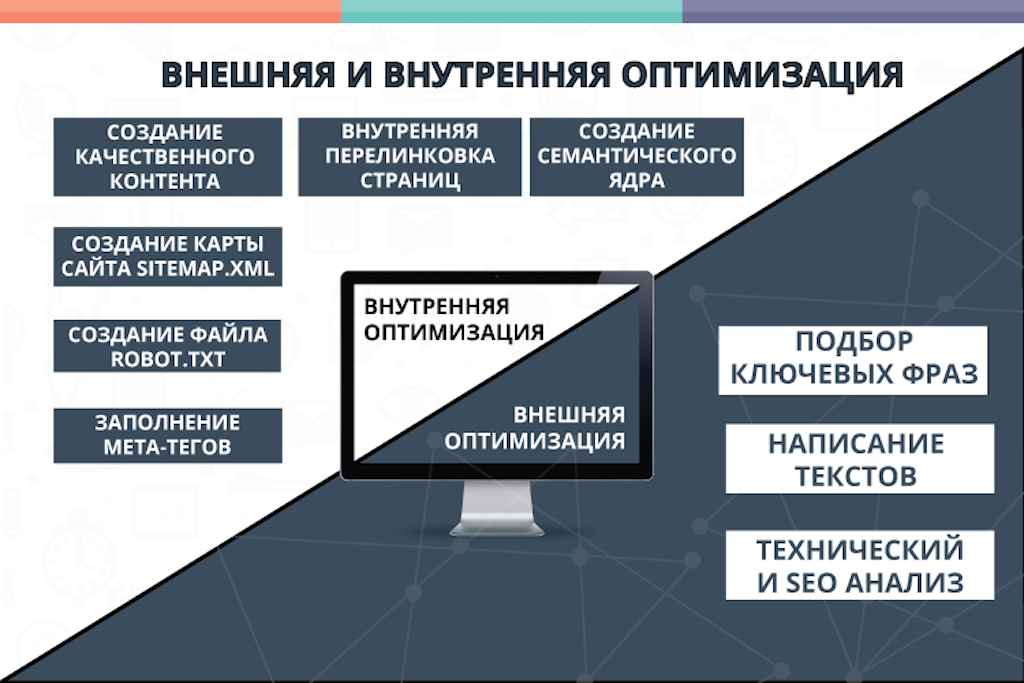

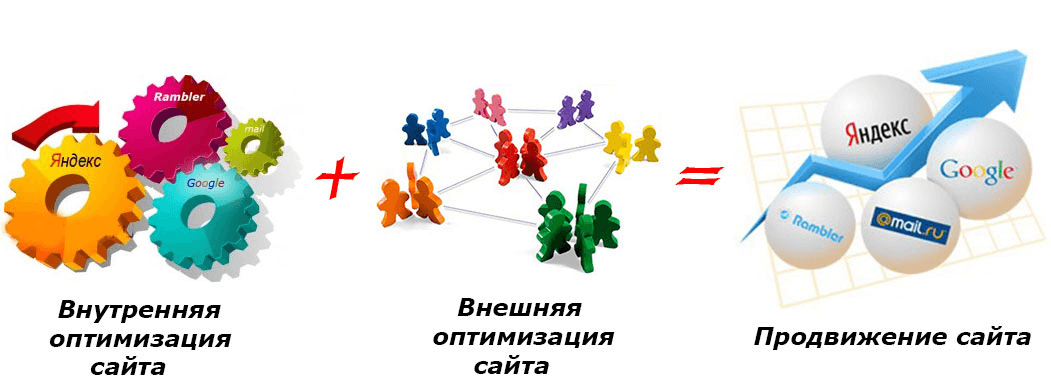

Если нужно увеличить органический трафик, ускорить индексацию в поисковике, поднять позиции страниц вверх при ранжировании, без грамотного SEO не обойтись. Оптимизация сайта делится на два вида: внешнюю и внутреннюю.

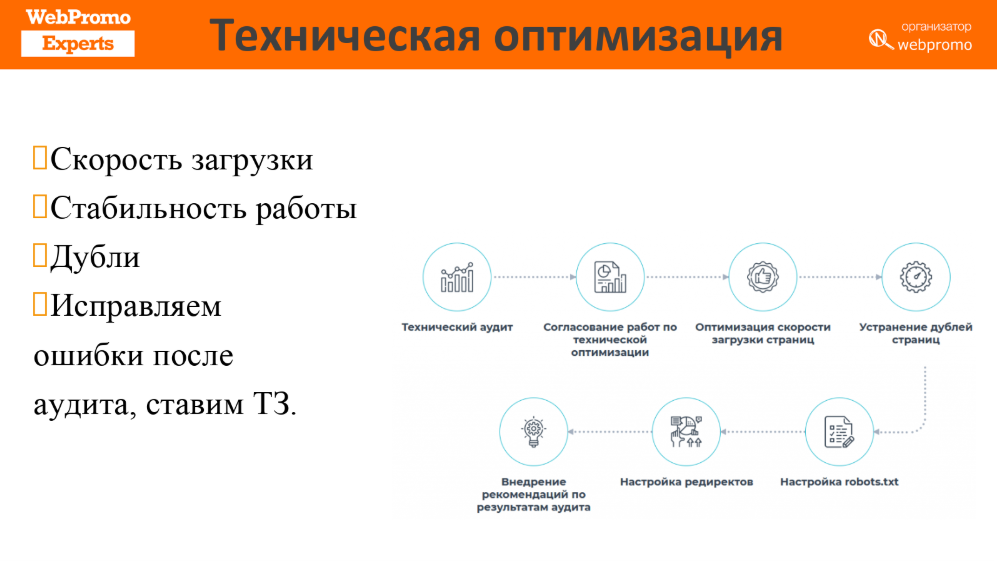

Первый вид — это работы, проводимые для наращивания качественной ссылочной массы. Внутренняя (техническая) оптимизация сайта подразумевает более обширные работы. Они выполняются, скорее, для поисковых роботов, чем для пользователей.

Помимо внешних работ, SEO необходимо для анализа, выявления и устранения технических проблем ресурса. Это даст возможность вывести площадку на первую страницу поисковой выдачи, улучшить ранжирование, обогнать лидеров, повысить посещаемость и увеличить доход от сайта.

Проблемы в технической оптимизации сайта: как обнаружить

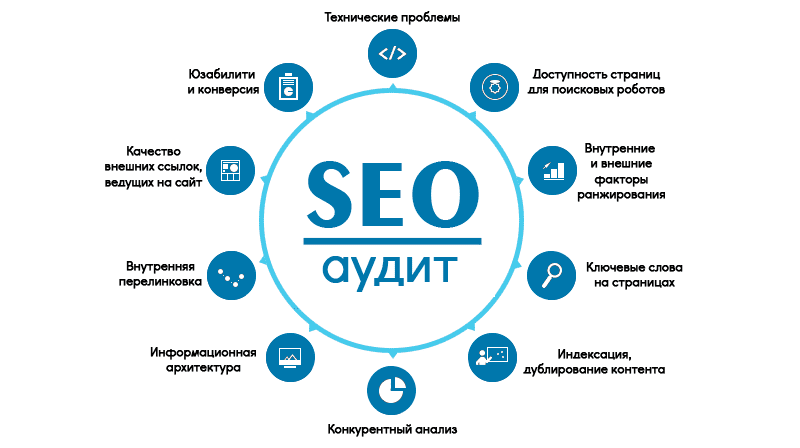

Перед началом работ обязательно нужно провести SEO-аудит. Это комплексный анализ всех показателей и параметров ресурса. Таких критериев достаточно много и проверить нужно каждый, чтобы точно знать, какие проблемы есть на сайте. Для этого существуют инструменты, позволяющие оценить все основные и второстепенные показатели:

Для этого существуют инструменты, позволяющие оценить все основные и второстепенные показатели:

- скорость загрузки страниц сайта;

- работа в разных браузерах;

- удобство для пользователей;

- количество неработающих или неиндексированных страниц и т. д.

Также можно обратиться за помощью к специальным сервисам, предлагающим проведение комплексного SEO-аудита для веб-специалистов. Отличным примером такого сервиса является SE Ranking — платформа с широким арсеналом инструментов и многофункциональных модулей. SE Ranking предоставляет технический аудит сайтов с детальным отчётом и анализом всевозможных параметров по окончании работ.

Чтобы провести аудит, необходимо зарегистрироваться на сервисе. Для всех SEO-специалистов, использующих инструментарий платформы SE Ranking впервые, предусмотрен бесплатный пробный аккаунт на 14 дней. Это означает, что после простой регистрации, вы получаете весь арсенал услуг без платы за тариф на две недели.

После того как регистрация завершена, создайте новый проект с указанием домена и нажмите «Аудит сайта». По завершению аудита перейдите в раздел «Отчёт об ошибках» и изучите найденные технические ошибки.

По завершению аудита перейдите в раздел «Отчёт об ошибках» и изучите найденные технические ошибки.

Полученный отчёт будет разделён на несколько блоков, отображаемых слева в столбик:

- «Код ответа сервера»;

- «Title»;

- «Description»;

- «Скорость загрузки»;

- «Текстовый контент» и т. д.

При переходе на определённый блок из списка, нажимаем на проблему и получаем информацию, как её решить.

Чтобы закрепить результат, после проведения технической оптимизации и устранения выявленных проблем, стоит повторно провести SEO-аудит. Это даст возможность отследить, устранена та или иная проблема, или нет. Для удобства есть колонка «Исправленное», в которой можно увидеть решённые проблемы.

Ошибки в технической оптимизации: классификация и методы устранения

Существуют технические проблемы в оптимизации, решать которые необходимо грамотно и оперативно, постоянно отслеживая результат при помощи аудитов. Рассмотрим самые распространённые из них и расскажем, как их исправить.

1. Проблемы с файлом robots.txt или его отсутствие

Чтобы самостоятельно узнать, есть ли документ robots.txt, необходимо добраться до корневой папки ресурса. Проще всего это сделать через адресную строку: введите домен вашего сайта и добавьте название документа (site.com/robots.txt).

Этот файл важен — он служит инструкцией (или проводником) для поисковых роботов. В нём описывается необходимость сканирования того или иного содержимого сайта. Прежде чем начать обход площадки, поисковые роботы обращаются к файлу robots.txt, а уже потом сканируют указанные в нём страницы.

Не стоит забывать про краулинговый бюджет — количество страниц сайта, которое может проиндексировать робот за определённый промежуток времени. Это квоту рекомендуют экономить. Для этого нужно настроить файл robots, где указываются ограничения на сканирование группы страниц, категорий или папок. Если краулинговая инструкция прописана неверно или её нет, могут возникнуть проблемы с индексацией сайта.

Решение проблемы

Если документ robots.txt отсутствует, перейдите в корневое хранилище сайта и создайте его там. После этого внимательно пропишите инструкции сканирования и индексации. Поисковых роботов много, поэтому можно прописать инструкции для каждого отдельно. Не забудьте указать путь к карте сайта (sitemap).

2. Файл Sitemap.xml

Не менее важный документ — карта сайта или «sitemap». Это файл со всеми URL вашего ресурса. Список ссылок в карте сайта прописывается для обхода их поисковыми роботами. Если такого документа нет, это не повлияет на то, проиндексируется та или иная ссылка, или нет. Однако, sitemap может помочь поисковым роботам обнаружить URL, если он долго не попадает в индекс.

Если у вас крупный ресурс с приличным списком URL-адресов (около 50 тысяч), документ sitemap может весить более 50 МБ, а это недопустимо. В таком случае обработка адресов для поискового робота затрудняется. Также в файле могут оказаться ссылки, которые закрыты от индекса при помощи метатега noindex, что тоже является ошибкой. Составляя документ карты сайта, нужно прописывать только приоритетные для сканирования и индексации адреса.

Составляя документ карты сайта, нужно прописывать только приоритетные для сканирования и индексации адреса.

Решение проблемы

Первым делом разделите sitemap на несколько разных файлов, если лимит по количеству адресов превышен. Можно создать отдельные карты сайта на адреса страниц, видео и картинки. Главное, после разделения указать в файле robots.txt путь к каждому созданному XML sitemap.

SEO-аудит может показать закрытые от индексации адреса в файле карты сайта. Эту проблему также стоит устранить: удалить эти URL из sitemap или убрать метатеги, запрещающие индексацию.

3. Дублирование контента

Уникальные тексты на сайте — это мощная база для продвижения в топы выдачи. Но если по какой-либо причине вы копируете тексты у конкурентов и вставляете их на своей площадке, поисковый робот плохо к этому отнесётся. Также он негативно оценит дубли страниц, текстов, видео- и аудиоматериала. Создавайте уникальный контент и будет вам счастье.

С проблемой дублей чаще всего сталкиваются крупные ресурсы. К примеру, интернет-магазины с множеством похожих товарных позиций. Описания таких продуктов различаются минимально и восприниматься роботом как дублирование контента. Также дубли страниц попадают в индекс из-за неправильно настроенного редиректа (зеркала сайта) в доменном имени. Индексироваться будут одинаковые страницы — www.site.com и site.com.

К примеру, интернет-магазины с множеством похожих товарных позиций. Описания таких продуктов различаются минимально и восприниматься роботом как дублирование контента. Также дубли страниц попадают в индекс из-за неправильно настроенного редиректа (зеркала сайта) в доменном имени. Индексироваться будут одинаковые страницы — www.site.com и site.com.

Решение проблемы

Проблема дублей решается настройкой редиректов. После чего необходимо провести повторный аудит, чтобы найти оставшиеся дубли страниц или убедиться, что их не осталось. Если вам всё же требуется похожий контент на страницах, используйте канонические ссылки. С их помощью можно указывать роботам, что конкретно индексировать. Для этого на неканонической странице прописывается тег rel=”canonical” для одного URL-адреса.

4. Неправильно настроенные редиректы

Редирект — это настройка переадресации с одного URL на другой. Необходимость редиректов ощущается во время удаления страниц и смены их адресов. То есть страница удаляется, на неё настраивают переадресацию, и пользователь попадает уже на актуальную версию страницы.

Этот метод переноса даёт немалое преимущество, ведь настройка редиректа позволяет сохранить авторитет старой страницы у поисковой системы и передать его новой. В технической оптимизации переадресация также важна. Благодаря редиректу, новая страница сразу доступна посетителям.

Редирект удобен тем, что пользователь автоматически переходит на новую страницу без задержек. Однако при настройке переадресации могут возникнуть проблемы:

- Замедление переадресации из-за длинных цепочек редиректов. Чем больше адресов, тем медленнее процесс перехода.

- Некорректный редирект страницы на саму себя, что приводит к зацикливанию и «вечной загрузке» страниц.

- Уменьшение краулингового бюджета из-за слишком длинных списков URL-адресов.

- Наличие в длинной цепочке неработающего адреса.

Решение проблемы

Первый этап исправления ошибок — SEO-аудит, который покажет статусы страниц (цепочки, зацикленные страницы, 3ХХ, 4ХХ, 5ХХ). Если проверка покажет цепочки переадресаций, в которые входят 3 и более адреса, нужно сократить их до двух. Тогда робот будет видеть, что выполнено корректное перенаправление со старой страницы на актуальную.

Тогда робот будет видеть, что выполнено корректное перенаправление со старой страницы на актуальную.

Если были найдены зацикленные редиректы, их стоит отредактировать, убрав битые ссылки. Статус страниц 4ХХ и 5ХХ означает, что их стоит либо удалить, либо сделать доступными.

5. Снижение скорости загрузки страниц

Многие пользователи не будут дожидаться, пока страница загружает контент. Посетитель скорее покинет страницу и перейдёт на другой сайт, чем будет долго ждать её загрузку. Скорость загрузки — это важный критерий для поисковых систем, на который они обращают внимание при ранжировании.

Чтобы выявить длительную загрузку страницы, обратите внимание на такие моменты:

- картинки в высоком разрешении;

- несжатые тексты;

- «тяжёлый» HTML-код и файлы.

Решение проблемы

Совсем необязательно загружать на свой ресурс изображения в оригинальном формате и размере. Пользуйтесь специальными инструментами, которые сжимают картинку без потери качества. Выбирайте корректные расширения картинок и файлов, уменьшите размеры изображений. Также следите за тем, чтобы вес HTML-страниц не превышал 2 МБ.

Выбирайте корректные расширения картинок и файлов, уменьшите размеры изображений. Также следите за тем, чтобы вес HTML-страниц не превышал 2 МБ.

Установите сжатие и на текстовый контент. Это позволит дополнительно увеличить скорость загрузки страницы. Применяя архивацию GZIP, можно оптимизировать объёмы страниц. Все эти меры ускорят загрузку страниц и улучшат позиции сайта при ранжировании.

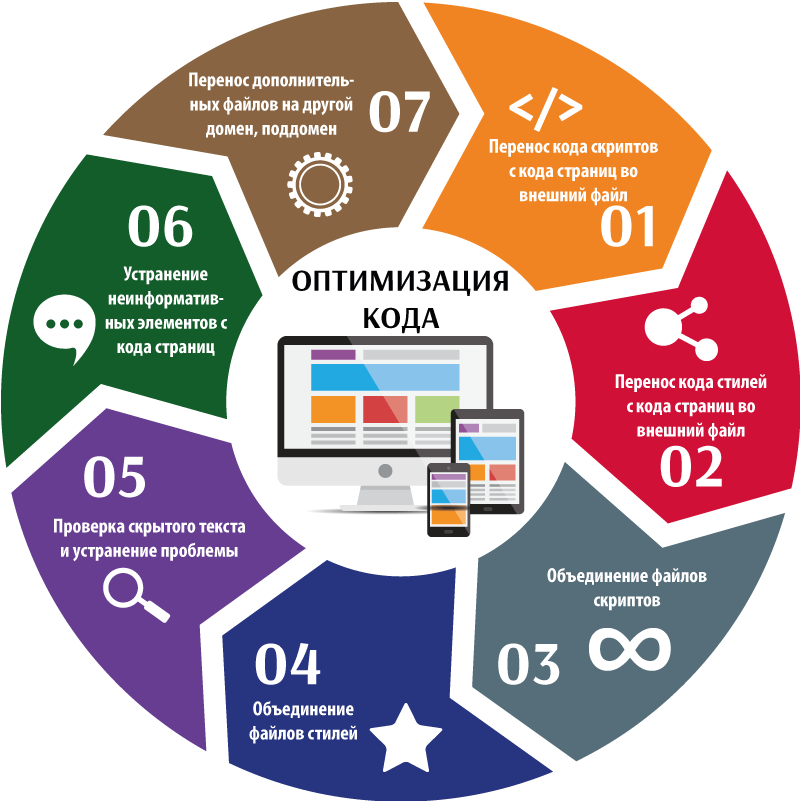

6. JavaScript и CSS: отсутствие оптимизации кодов

Раз затронули тему скорости загрузки страниц сайта, стоит также упомянуть влияние на этот параметр кодов JavaScript и CSS, которые создают внешний вид ресурса. Благодаря каскадным таблицам CSS, мы можем создавать фон сайта, менять размер шрифтов, расположение текста, графических элементов, управлять положением и размером изображений. JavaScript, в свою очередь, придаёт динамичности дизайну.

Без JavaScript и CSS невозможно создать современный сайт. Однако, у их файлов также есть ограничения по весу: CSS файлы не должны весить больше 150 КВ, а скрипты — не больше 2 МВ. Иначе замедлится загрузка страниц.

Иначе замедлится загрузка страниц.

Решение проблемы

Всё довольно просто — необходима настройка кэширования и сжатия файлов CSS/JavaScript. Пользуясь результатами SEO-аудита, вы можете узнать количество страниц, на которых необходимо уменьшить размер кода.

Кэширование снижает нагрузку на сервер, так как браузер не будет загружать страницу с нуля, а подгрузит копии данных из кэша. Минификация кода подразумевает его чистку от мусора: комментариев, лишних символов и т. д. Благодаря этому уменьшается его исходный размер.

Один из актуальных методов ускорения загрузки страниц — объединение файлов CSS/JS.

7. Адаптивность на разных устройствах

Большинство пользователей работают на мобильных устройствах: планшетах, смартфонах. Поэтому необходимо настроить корректный показ страниц своего сайта на подобных девайсах. Если сайт не адаптирован под смартфоны, пользователю будет неудобно его использовать, и он уйдёт к конкурентам.

Отсутствие адаптивности не означает, что ваш сайт вообще не будет отображаться у пользователей мобильных устройств. Просто им потребуется постоянно увеличивать каждый элемент, чтобы с ним ознакомиться. Также страницы могут выходить за границы экрана устройства, из-за чего понадобится прокрутка.

Просто им потребуется постоянно увеличивать каждый элемент, чтобы с ним ознакомиться. Также страницы могут выходить за границы экрана устройства, из-за чего понадобится прокрутка.

Решение проблемы

Помимо основного дизайна сайта, стоит также разработать дополнительный адаптивный под разные типы устройств. Это позволит настроить корректное отображение, к примеру, на смартфонах. На небольшом экране будут удобно расположены все блоки, хорошо виден текст, границы не будут нарушены и прочее.

Отдельного внимания заслуживают метатеги viewport в HTML-коде. Они должны обязательно прописываться без фиксации в параметре device-width, чтобы автоматически адаптировать под смартфон, планшет и ПК ширину страниц сайта.

8. Не прописан атрибут alt у изображений

Тег img в HTML-коде отвечает за отображение картинок. Но вместе с тегом необходимо прописывать альтернативный текст. Он включает в себя описание (обязательно с ключами) того, что изображено на картинке. Текст помещается в атрибут alt и показывается пользователю, когда тот наводит мышкой на изображение, за которым атрибут закреплён.

Поисковикам гораздо проще определять тематику картинок, если к нему прописывается альтернативный текст. Если alt пустой, можно потерять трафик, ведь из раздела «Картинки» в Google миллионы пользователей переходят на страницы сайтов, нажимая на подходящее изображение.

Решение проблемы

Чтобы разобраться с этим вопросом, достаточно прописать alt ко всем изображениям на сайте. Вручную делать это долго, поэтому можно воспользоваться различными SEO-плагинами. Инструменты позволяют выводить специальное поле alt-текста при редактировании страницы в панели администратора сайта.

Достаточно только прописать в поле альтернативный текст и выложить пост с изображениями, где автоматически пропишутся атрибуты alt. Заполняя эти поля, не переусердствуйте с ключевыми словами, чтобы не заспамить страницу. Также не пишите слишком короткий текст — он должен быть не меньше 5–6 слов. Старайтесь, чтобы атрибут не состоял только из ключевых фраз.

9. Отсутствие защищённого протокола HTTPS

HTTPS — альтернативный вариант протокола соединения HTTP. Он обеспечивает более надёжное соединение и шифрование пользовательских данных. Браузеры часто блокируют на переход по URL-адресу с протоколом HTTP, выдавая на экране предупреждение о том, что это небезопасно.

Он обеспечивает более надёжное соединение и шифрование пользовательских данных. Браузеры часто блокируют на переход по URL-адресу с протоколом HTTP, выдавая на экране предупреждение о том, что это небезопасно.

Важно, что при ранжировании поисковая система будет снижать рейтинг доверия к сайту, протокол соединения которого не настроен на HTTPS. Следовательно, позиции ресурса в выдаче снизятся.

Решение проблемы

Чтобы в адресной строке возле доменного имени стояла пометка HTTPS-протокола, необходимо купить сертификат и использовать безопасное соединение. Главное, не забывать его продлевать, иначе страницы перестанут отображаться.

Также полезен SEO-аудита и после перехода на HTTPS-протокол, чтобы удостовериться, что всё работает нормально. Дополнительно проверка позволит выявить URL-адреса на HTTP. Необходимо будет настроить протокол на каждой такой странице, чтобы она корректно отображалась в поисковой выдаче.

10. Коды ошибок на страницах

Чтобы содержимое страницы было видно при переходе по её URL-адресу, браузер предварительно запрашивает информацию у сервера. Если после запроса в ответе указывается, что URL доступен, страница отображается без ошибок. Если сервер сообщает, что адрес недоступен, на странице выдаётся соответствующая ошибка 4ХХ и 5ХХ.

Если после запроса в ответе указывается, что URL доступен, страница отображается без ошибок. Если сервер сообщает, что адрес недоступен, на странице выдаётся соответствующая ошибка 4ХХ и 5ХХ.

Такие ошибки приводят к нежелательным последствиям:

- Поведенческие факторы ухудшаются — вместо необходимой информации, пользователь видит сообщение, что страница недоступна или не найдена.

- Удаление страницы из индекса из-за того, что робот не может её просканировать.

- Краулинговый бюджет расходуется впустую — сканирование повторяется вне зависимости от статуса страницы.

Решение проблемы

Проведите SEO-аудит и выясните, по какой причине появляются такие ошибки. Чтобы решить вопрос, необходимо удалить проблемные URL-адреса из индекса (можно сделать вручную самостоятельно) или восстановить к ним доступ.

Выводы

Техническая оптимизация важна для роста позиций сайта в поисковой выдаче, а также для удобства посетителей ресурса. Чтобы оптимизировать работу сайта, сначала проводится SEO-аудит. С его помощью вы сможете обнаружить существующие проблемы и узнать методы их решения. Также не забывайте запускать проверку, чтобы отследить правильность выполняемых работ.

С его помощью вы сможете обнаружить существующие проблемы и узнать методы их решения. Также не забывайте запускать проверку, чтобы отследить правильность выполняемых работ.

Из основных проблем в технической оптимизации выделяют:

- снижение скорости загрузки страниц;

- «тяжёлый» код CSS, JavaScript, HTML;

- отсутствие протокола соединения HTTPS;

- некорректная настройка файлов robots.txt и sitemap.xml;

- дубли;

- неадаптивный дизайн;

- отсутствие alt-атрибутов;

- некачественная переадресация, ошибки 4ХХ, 5ХХ.

Чтобы сохранить и улучшить позиции платформы при ранжировании, займитесь технической оптимизацией сайта. Не упускайте из виду даже мелкие проблемы, вовремя устраняя их. Только так можно выйти в топ!

Обзор основных ошибок при технической оптимизации сайта

- 19 августа 2022

- Продвижение

- 4.3K

- 7 мин.

- Понравилось? Поделись! Прочесть позже

Для продвижения сайта в поисковых системах и привлечения пользователей недостаточно создать сайт с красивым дизайном и качественным контентом. Помимо этого, сайт должен соответствовать определенным критериям с технической точки зрения.

Технические ошибки можно найти на любом сайте – даже те ресурсы, что находятся на первых местах в топе поисковых систем, могут иметь свои недочеты, и это нормально. Самое важное – постоянно следить за работоспособностью сайта и отлавливать ошибки, пока они не стали носить критический характер и влиять на ранжирование.

Любые сайты регулярно обновляются, меняют структуру, добавляют новые фишки или недостающий функционал – на этом фоне могут возникать различные ошибки. Не исключено, что ошибки могут быть заложены ещё на этапе проектирования, ведь не всегда можно предусмотреть абсолютно все, а некоторые вещи могут показаться незначительными, и впоследствии про них попросту забывают.

В этой статье мы рассмотрим 9 наиболее популярных технических ошибок при оптимизации сайта. Не исключено, что один (или несколько) из перечисленных недочетов встречается и на вашем ресурсе.

Технический SEO-аудит: 9 ошибок, которые встречаются регулярно

Неправильно настроенные редиректы

Распространённой проблемой является доступность страниц или домена по разным адресам, что порождает другую проблему – дублирование контента. Например, один и тот же сайт может открываться по адресу с www и без. Если эти адреса не склеены между собой, поисковик посчитает, что это два разных сайта, и на одном из них контент не является уникальным – в результате понизит его позиции в выдаче.

Также дубли могут возникать по другим причинам: из-за особенностей CMS, работы некоторых плагинов, после изменения структуры сайта и проведения других технических работ.

Решение: обе эти проблемы решаются 301-м редиректом, он предупреждает поисковые системы, что страница находится по другому адресу.

Подробнее рассказывали в этой статье.

Подробнее рассказывали в этой статье.-

Отсутствие файла robots.txt

Файл robots.txt используется для указания параметров индексации сайта. Он дополняет карту сайта и должен находиться в корне ресурса.

Чтобы проверить, есть ли данный файл на вашем сайт, достаточно к домену дописать название файла (пример — site.com/robots.txt). В первую очередь, зайдя на сайт, роботы проверяют наличие и содержание этого файла, после чего начинают исследовать сайт.

При отсутствии этого файла поисковые роботы будут проверять абсолютно все страницы сайта, в том числе служебные или мусорные страницы. При неправильной настройке файла сайт может оказаться закрытым от индексации, и поисковые системы просто не смогут его проиндексировать, в результате чего ваш сайт не будет показан в поисковой выдаче.

Решение: корректно настроить robots.txt – полная инструкция здесь.

-

Неоформленная страница 404

Если пользователь случайно забрел на удаленную или несуществующую страницу важно сохранить его внимание.

В данном случае сайт должен возвращать 404 код ответа и перенаправлять пользователя на страницу ошибки. При отсутствии правильно оформленной страницы можно легко ввести пользователя в заблуждение, что скорее всего вынудит его покинуть сайт.

Многие компании последние несколько лет стараются творчески и с юмором подходить к оформлению этой страницы. Если у вас небольшая компания, и нет возможности и средств для креативного оформления страницы, будет достаточно уведомить пользователя, что он попал на несуществующую страницу и предложить перейти на главную страницу или, например, продолжить просмотр каталога.

Ниже представлены примеры качественно оформленных страниц:

Вот интересный вариант дизайна от Лабиринта:

Решение: если планируете красиво оформить 404 страницу, но нет идей – загляните в нашу статью. Собрали 50 примеров, которые точно оценят пользователи.

-

Отсутствие микроразметки

Еще одним необязательным, но важным элементом является микроразметка.

Напрямую наличие или отсутствие микроразметки не влияет на SEO, но правильно настроенная разметка на сайте дает следующие преимущества:

Напрямую наличие или отсутствие микроразметки не влияет на SEO, но правильно настроенная разметка на сайте дает следующие преимущества:- Помогает поисковым роботам считывать информацию, что вызывает у них больше доверия к сайту;

- Позволяет оформить сниппеты в социальных сетях и делает их привлекательнее для пользователей;

- Помогает выделяться сайту в выдаче.

Существуют различные словари и синтаксисы микроразметки. Словарь содержит набор атрибутов, с помощью которых можно описать содержимое страницы, а синтаксис отвечает за то, как словарь будет применяться.

На выбор словаря и синтаксиса влияет цель, для которой используется разметка. Для корректного отображение сниппета страницы в социальных сетях используют Open Graph, а при разметке страницы контактов или карточек товаров предпочтение отдается Schema.org. Кроме этого, можно разметить любую нужную информацию: статьи, инструкции, рецепты, услуги и т.

д.

Например, при разметке рецептов, Яндекс может поместить страницу в отдельный блок, что привлечет большое внимание пользователей.

Решение: не пренебрегайте микроразметкой и четко следуйте нашим советам.

-

Низкая скорость загрузки сайта

В наше время у пользователей каждая минутка на счету, поэтому для них важно, насколько быстро можно получить необходимую информацию. Даже если у вас очень выгодные предложения для клиентов и куча преимуществ, никто не станет ждать, пока загрузится ваш сайт, если это будет занимать больше 2-3 секунд.

На скорость загрузки влияет большое количество факторов, начиная от загружаемых изображений до выбора CMS. Наиболее популярным сервисом для проверки является Google Pagespeed Insights. Он не всегда показывает наиболее точные результаты, но тем не менее на него можно ориентироваться.

Решение: если же ваш сайт очень долго грузится, и вы не знаете, как это исправить, наши специалисты всегда готовы вам в этом помочь.

Самостоятельно изучить способы улучшения скорости можно в статье.

Самостоятельно изучить способы улучшения скорости можно в статье. -

Отсутствие счетчиков статистики

Для развития сайта так же важно понимать, как пользователя ведут себя на сайте, какие страницы чаще всего посещают, а что, наоборот, их отталкивает. Для получения всеобъемлющей информации о пользователе и отслеживания его действий существуют бесплатные инструменты, такие как Яндекс. Метрика и Гугл. Аналитика.

Решение: достаточно зарегистрироваться на сервисах и разместить на своем сайте их счетчики. Вы легко это сможете сделать самостоятельно, следуя инструкциям из наших статей (здесь про Яндекс, а тут – про Google).

-

ЧПУ

Пользователю сайта даже небольшого сайта важно понимать, на какой странице он находится, поэтому принято считать, что страницы сайта должны быть написаны на латинице и иметь осмысленное название, то есть быть человеко-понятными.

При нахождении пользователя на сайте, имеющего большой уровень вложенности, ЧПУ будет выступать в роли дополнительной навигации. Это поможет сориентироваться и понять, как пользователь дошел до данной страницы.

На примере Вайлдберриса мы видим правильно настроенные ЧПУ – такая ссылка помогает понять, в каком разделе пользователь находится и как он туда дошел.

Таким образом, человекопонятные урлы как прямо (через индексирование), так и косвенно (через поведенческие факторы) определяет качество поисковой оптимизации.

Решение: несколько советов по созданию человеко-понятного URL вы найдете в этой статье (пункт №44)

-

Отсутствует атрибут alt

Множество пользователей переходят на страницы сайта из раздела «Картинки» в поисковых системах. Поисковики не всегда легко могут определить назначение и тематику картинки – за это отвечает атрибут alt, содержащий описание изображения.

Из-за его отсутствия можно потерять часть трафика.

Вот как это должно выглядит в коде страницы:

Решение: всегда прописывайте тег alt к каждому изображению. Даже если сайт полностью не загрузится, по описанию пользователь поймет, что изображено на картинке. Более подробно об атрибутах alt и title для изображений можно узнать из статьи.

-

Отсутствие протокола HTTPS

HTTPS – это расширение протокола HTTP, которое используется для повышения безопасности передачи данных. Сайты, использующие HTTPS-соединение в браузерной строке помечены замочком.

На данный момент наличие этого протокола вызывает большое доверие как у пользователей, так и у поисковых систем. Очень многие браузеры блокируют доступ к сайтам, не использующих протокол HTTPS и выводят сообщение, что соединение небезопасно и лучше покинуть этот сайт.

Кроме того, это сказывается на ранжировании – сайты без hTTPS занимают более низкие позиции в выдаче.

Решение: обязательно переезжайте на HTTPS, если вы еще этого не сделали. Подробно о переезде сайта на безопасный протокол можно прочитать в нашей статье.

Вывод

Вышеперечисленные ошибки не являются полным перечнем технических проблем, и по мере изменения алгоритмов поисковых систем требования к сайтам периодически меняются. Мы постарались собрать наиболее часто встречающиеся ошибки, устранив которые вы сможете улучшить свой трафик.

Для проверки сайта на наличие ошибок и соответствие требованиям поисковых систем наши специалисты могут сделать вам SEO-аудит, в котором будут подробно расписаны недостатки сайта.

А если вы точно знаете, какие грешки водятся за вашим сайтам, обратитесь к нашим техническим специалистам – они точно помогут устранить недочеты.

#аудит сайта #оптимизация сайта #техническая оптимизация

12 2 2 0 3© 1PS.RU, при полном или частичном копировании материала ссылка на первоисточник обязательна

Чек-лист «Готов ли ваш сайт к продвижению»

Казалось бы, базовые вещи. .. Однако у многих сайтов наличие технических проблем, мешающих продвижению, не редкость. Проверьте нет ли у вашего сайта таких элементарных ошибок.

.. Однако у многих сайтов наличие технических проблем, мешающих продвижению, не редкость. Проверьте нет ли у вашего сайта таких элементарных ошибок.

Популярные статьи

- 13.9K

- 6 мин.

- 7.7K

- 11 мин.

В данной статье расскажем, как раскрутить блог, дадим актуальные советы по эффективной оптимизации блога и не только.

В данной статье расскажем, как раскрутить блог, дадим актуальные советы по эффективной оптимизации блога и не только.- 40.1K

- 6 мин.

Все популярные статьи »

8 Технические проблемы SEO для больших веб-сайтов

Большие веб-сайты — это бегемот, которым нужно управлять. Один веб-сайт может принадлежать многим заинтересованным сторонам. Чем крупнее предприятие, тем сложнее чувство собственности.

К сожалению, иногда сотрудники, способные принимать революционные решения по технической оптимизации предприятия, в первую очередь не понимают своих проблем.

У вашего предприятия не должно быть проблем с техническим SEO.

Большие сайты были активны дольше. У вас больше бюджет и больше людей. Существует значительный авторитет домена; многие крупные сайты имеют отношения с Google (в конце концов, Google предпочитает бренды) и имеют большое влияние.

Когда дело доходит до органического поиска, крупные известные бренды имеют несправедливое преимущество, верно?

В некотором смысле это правда.

Так в чем проблема?

Многие признанные бренды не достигают того уровня популярности, который им необходим, чтобы оставаться конкурентоспособными в поиске в долгосрочной перспективе. У них есть устаревшие технологии, которые отягощают их.

Слишком часто крупные сайты сталкиваются с похожими проблемами, и мы собираемся решить их сегодня:

Давайте рассмотрим некоторые из основных технических проблем SEO, с которыми сталкиваются эти крупные сайты.

Неправильное использование краулингового бюджета

Прежде чем мы углубимся в это, нам нужно определить наши термины. Чтобы решить проблему краулингового бюджета, мы должны убедиться, что нам нужно правильно объяснить ее.

Чтобы решить проблему краулингового бюджета, мы должны убедиться, что нам нужно правильно объяснить ее.

Ваш краулинговый бюджет – это количество страниц, которые робот Googlebot должен сканировать за определенный период времени.

Согласно Google, «Googlebot — это общее название для двух различных типов сканеров: сканер для настольных компьютеров, который имитирует пользователя на рабочем столе, и сканер для мобильных устройств, который имитирует пользователя на мобильном устройстве».

Робот Googlebot перестает сканировать ваши веб-страницы, упаковывается и переходит на другой домен, когда ваш краулинговый бюджет израсходован. Google — единственный, кто знает о конкретных ресурсах, которые они выделили вашему сайту. Однако Google опирается на определенные критерии при распределении краулингового бюджета для вашего сайта.

- Состояние сканирования: В уравнении учитываются такие факторы, как скорость страницы, время отклика сервера, сжатие и т.

д. Google объясняет, почему качество сканирования является таким важным критерием: «Если сайт какое-то время отвечает очень быстро, лимит увеличивается, а это означает, что для сканирования можно использовать больше подключений. Если сайт тормозит или отвечает ошибками сервера, лимит снижается, и робот Googlebot сканирует меньше».

д. Google объясняет, почему качество сканирования является таким важным критерием: «Если сайт какое-то время отвечает очень быстро, лимит увеличивается, а это означает, что для сканирования можно использовать больше подключений. Если сайт тормозит или отвечает ошибками сервера, лимит снижается, и робот Googlebot сканирует меньше». - Популярность: По данным Google, популярные URL-адреса сканируются чаще, чтобы поддерживать актуальность индекса Google. Google имеет тенденцию чаще возвращаться к обновленным страницам, особенно если они популярны.

- Устаревание: Это больше о частоте ваших обновлений. Страницы и контент, которые регулярно обновляются, регулярно посещаются роботом Googlebot. Google пытается предотвратить устаревание URL-адресов в своем индексе.

- Ссылки: Сюда входят такие факторы, как ваша внутренняя структура ссылок (включая входящие и исходящие ссылки), мертвые ссылки, перенаправления и т. д.

Вот в чем дело; установка более высоких лимитов не означает автоматически, что вы получите больший краулинговый бюджет.

Вот в чем дело; установка более высоких лимитов не означает автоматически, что вы получите больший краулинговый бюджет.

Так почему это вызов?

Google считает, что слишком много URL-адресов с низкой добавленной стоимостью отрицательно влияют на сканирование и индексирование вашего сайта. Они отсортировали эти малозначительные URL-адреса по нескольким конкретным категориям:

- Идентификаторы фасетной навигации и сеанса: Пример фасетной навигации может включать фильтрацию по цене, размеру или параметрам цвета. Примером идентификаторов сеанса может быть информация об отслеживании пользователей, хранящаяся в параметрах URL. Это проблематично, потому что он создает разные комбинации URL-адресов, создавая проблему с дублирующимся контентом.

- Взломанные страницы: Google определяет эти страницы как «любой контент, размещенный на вашем сайте без вашего разрешения в результате уязвимостей в системе безопасности вашего сайта».

Google работает над тем, чтобы эти страницы не попадали в результаты поиска, потому что это снижает качество поисковой выдачи Google (очевидно).

Google работает над тем, чтобы эти страницы не попадали в результаты поиска, потому что это снижает качество поисковой выдачи Google (очевидно).

Вот подробная разбивка из Google Search Central.

Google уделяет большое внимание внедрению URL-адресов, контента или кода.

- Бесконечные пространства и прокси: Согласно Google, бесконечные пространства — это страницы с очень большим количеством ссылок (например, ссылки «Следующая страница», которые продолжаются вечно). Эти ссылки практически не содержат нового контента. Сканирование этих URL-адресов означает, что робот Googlebot использует ненужную полосу пропускания, что увеличивает вероятность того, что Google не сможет полностью проиндексировать содержимое вашего сайта.

Динамические URL-адреса, идентификаторы сеансов, аддитивная фильтрация (см. выше), динамическое создание документов и неработающие ссылки — все это усугубляет эту проблему. Робот Google не хочет индексировать один и тот же контент вечно. Он хочет найти новый контент один раз, проиндексировать его, а затем проверить наличие обновлений. Бесконечные пространства мешают.

Существует несколько способов борьбы с этой проблемой. Вы можете добавить атрибут no-follow к ссылкам, которые создаются динамически. Используйте robots.txt , чтобы заблокировать доступ Googlebot к проблемным URL-адресам; обязательно «укажите порядок параметров в разрешающей директиве) или используйте hreflang для определения языковых вариантов контента.

- Контент низкого качества и спам: Вам не о чем беспокоиться, если вы создаете контент, соответствующий рекомендациям Google E-A-T.

Если это не так, есть большая вероятность, что у вас может быть проблема с низким качеством или спамом. Контент низкого качества не соответствует стандарту Google E-A-T; примеры включают незащищенный сайт электронной коммерции, контент из неавторитетного источника (например, рекомендации по налогам с веб-сайта по уходу за собаками) 9.0038

Если это не так, есть большая вероятность, что у вас может быть проблема с низким качеством или спамом. Контент низкого качества не соответствует стандарту Google E-A-T; примеры включают незащищенный сайт электронной коммерции, контент из неавторитетного источника (например, рекомендации по налогам с веб-сайта по уходу за собаками) 9.0038

Трата ресурсов сервера на страницах (или проблемах), подобных этим, отвлечет активность сканирования от страниц с ценностью, что может привести к значительной задержке в поиске интересного контента на сайте роботом Googlebot.

Последствия дублирования контента

Дублирование контента – это каннибализм .

Ваши веб-страницы конкурируют друг с другом за одинаковый рейтинг и видимость, поглощая ценность, которую вы получили бы от уникального контента. Каждый дубликат привлекает очень небольшую часть трафика и конверсий, которые должен получать один авторитетный источник. Контент никогда не достигает своего полного потенциала.

Почему это проблема?

Немного трафика лучше, чем ничего, я прав?

На самом деле нет.

Если одна веб-страница будет иметь посещений 1800 в день (657 000 в год), но ваши дубликаты (вместе) получают только 500 в день (180 000 в год), это разница в 114%!

Предположим, у вас коэффициент конверсии 5% на обеих страницах.

- 657 тыс. посещений = 32 850 конверсий

- 180 тыс. посещений = 9000 конверсий

Видите проблему?

Указывает на утечку доходов; здесь теряется огромное количество дохода, в зависимости от средней стоимости вашего заказа. Только от дублированного контента!

Нехорошо.

Вот гнусная часть о дублирующемся контенте; это происходит все время. Давайте рассмотрим несколько причин дублирования контента.

Плохое управление CMS

Крупные организации часто используют более одной CMS. Вы можете работать с CMS с собственной поддержкой SEO (или без нее). Вы также можете иметь дело с CMS, которая создает дублированный контент. Например, некоторые современные CMS присваивают каждой статье уникальный идентификатор базы данных, который действует как ее уникальный идентификатор (вместо URL-адреса).

Вы можете работать с CMS с собственной поддержкой SEO (или без нее). Вы также можете иметь дело с CMS, которая создает дублированный контент. Например, некоторые современные CMS присваивают каждой статье уникальный идентификатор базы данных, который действует как ее уникальный идентификатор (вместо URL-адреса).

Это означает, что одна статья может иметь несколько URL-адресов, что создает проблему для поисковых систем, которые полагаются на URL-адреса.

Варианты URL

Несогласованные внутренние ссылки часто создают проблемы с дублированием контента. Это означает такие страницы, как…

- example.com/page

- www.example.com/page

- www.example.com/page/index.php

… Направлять людей и поисковые системы на одно и то же содержание .

По данным Google, дублированный контент обычно не является вредоносным и может возникать в результате безобидных событий, таких как:

- Версии веб-страниц только для печати

- Одни и те же продукты в вашем магазине электронной коммерции отображаются или на них ссылаются через несколько уникальных URL-адресов

- Форумы, которые имеют общие и урезанные страницы (оптимизированные для мобильных устройств)

Это можно исправить, создав переадресацию 301 », убедившись, что вы направляете посетителей и поисковые системы на исходную страницу. Кроме того, вы можете использовать атрибут rel=canonical , чтобы обозначить страницы, которые являются копиями, и источник, который вы обозначили как оригинал.

Кроме того, вы можете использовать атрибут rel=canonical , чтобы обозначить страницы, которые являются копиями, и источник, который вы обозначили как оригинал.

Использование правильного префикса: HTTP или HTTPS

Возможно, вы:

- Переключение с HTTP на HTTPS

- Перемещение с субдомена (например, с blog.example.com на example.com/blog)

- Изменение домены полностью

- Работа с несколькими версиями сайта (например, www.example.com против example.com).

- Переключение со среды разработки и реальной среды (т. е. dev.example.com, example.com и www.example.com).

Какими бы ни были ваши обстоятельства, вы захотите решить эти проблемы надлежащим образом.

Во-первых, укажите исходную или авторитетную исходную страницу; объединить весь контент из вашего дубликата здесь. Затем создайте перенаправление 301 на свой «дубликат», указывающий на вашу авторитетную исходную страницу.![]() Это предотвращает каннибализацию контента и устраняет внутреннюю конкуренцию.

Это предотвращает каннибализацию контента и устраняет внутреннюю конкуренцию.

Что делать, если вам нужно сохранить дубликаты?

Используйте атрибут rel=canonical для идентификации ваших веб-страниц; это позволяет вам определить оригинал и копии, давая Google четкое указание о том, как ранжировать ваши веб-страницы.

Очистка содержимого

Если вы работаете с сайтом электронной коммерции или занимаетесь розничной торговлей, это распространенная проблема. Допустим, вы продаете зеркальные камеры; если производитель, оптовики, дистрибьюторы и ваш магазин электронной коммерции имеют одинаковое описание продукта, это (вне сайта) дублированный контент.

Решение простое. Вы просто стисните зубы и создадите уникальные описания для каждого продукта. Если у вас есть дублированный контент на сайте, работайте над объединением своего контента с помощью переадресации 301 или rel=канонический атрибут .

Неорганизованная архитектура сайта

Хорошая архитектура сайта является обязательным условием для крупных веб-сайтов. Это важно по двум причинам.

Это важно по двум причинам.

- Архитектура сайта распределяет ссылочный вес (через плоскую структуру) по всему сайту.

- Хорошая архитектура сайта помогает роботу Googlebot находить и индексировать все страницы вашего сайта.

Как выглядит «хорошая» архитектура сайта?

Пример хорошо организованной архитектуры сайта.Ваш сайт…

- Имеет плоскую структуру, благодаря которой люди и поисковые системы могут получить доступ к любой странице вашего сайта за четыре или менее кликов

- Эффективно использует страницы категорий для создания центров

- Имеет структуру URL, соответствующую структуре вашей категории (например, example.com/category/subcategory/keyword)

- Использует внутренние ссылки для связывания страниц и типов страниц вместе (например, страницы навигации > страницы категорий > отдельные страницы)

- Используйте HTML для навигации и внутренних ссылок (с анкорным текстом на основе ключевых слов) для распределения ссылочного капитала

- Добавьте обновленные карты сайта, чтобы улучшить «сканируемость» сайта

Вот где это становится трудным.

Ваша команда должна будет откровенно взглянуть на архитектуру вашего сайта и принять некоторые решения. Хорошо ли организована архитектура или ее нужно полностью перестроить? Если его нужно перестроить, вам нужно определить, как все должно быть реорганизовано и кто будет нести ответственность за это.

Плохая внутренняя перелинковка

Большие сайты имеют явное преимущество.

У них есть ссылочный вес.

Благодаря внутренним ссылкам определенная ценность и авторитет перетекают с одной страницы на другую. Внутренние ссылки позволяют вам распространять рейтинг с одной страницы на другую.

https://ipullrank.wistia.com/medias/u2a2ydgpfp

Вот несколько факторов, которые определяют, будут ли ссылки проходить по справедливости.

- Полномочия

- Сканируемость

- Соблюдение или отказ от выполнения

- Статус HTTP

- Местоположение ссылки

- Релевантность

Почему важны внутренние ссылки?

Хорошая внутренняя перелинковка устанавливает информационную иерархию для вашего сайта; это помогает Google сканировать, индексировать, понимать и ранжировать ваш веб-сайт. Когда вы передаете Googlebot ссылки и описательный анкорный текст, вы показываете Google, какие страницы вашего сайта наиболее важны. Вы даете Google ясность по темам и подтемам, которые вы освещаете.

Когда вы передаете Googlebot ссылки и описательный анкорный текст, вы показываете Google, какие страницы вашего сайта наиболее важны. Вы даете Google ясность по темам и подтемам, которые вы освещаете.

Внутренние ссылки также важны для пользователей.

Они позволяют пользователям перемещаться по вашему веб-сайту, улучшая взаимодействие с пользователем и увеличивая время пребывания на сайте.

Что делает внутренние ссылки сложными для крупных веб-сайтов?

- Ссылки, спрятанные внутри плагинов или апплетов

- Ссылки внутри неразборчивого JavaScript

- Заблокированные ссылки (из-за метатега robots и robots.txt)

- Ссылки, скрытые внутри форм

- Ссылки, спрятанные за внутренними окнами поиска 9 0038

- Слишком много ссылок на одной странице

- Ссылки на I-кадры (или фреймы)

Какие передовые методы внутренних ссылок следует соблюдать?

- Использовать анкорный текст, богатый ключевыми словами или более) страниц

- Использовать описательный якорный текст

- Размещать ссылки выше на странице

- Сохранять однородную структуру ссылок (т.

е. трехуровневую)

е. трехуровневую) - Используйте обычные ссылки DoFollow для распространения ссылочного веса с одной страницы на другую

- Используйте внутренние ссылки для интеграции потерянных страниц

- Используйте ссылки на главную страницу (стратегически), чтобы разделить ссылочный вес с другими страницами

- Избегайте использования инструментов для автоматизации создания внутренних ссылок

- Создание ссылок на категории страниц

- Добавление внутренних ссылок на старые страницы

- Использование проверок четности для создания единого аудита

- Отслеживание внутренних ссылок для поиска и исправления неработающих ссылок

Следуйте этим рекомендациям по внутренним ссылкам, чтобы повысить эффективность SEO.

JavaScript Ошибки рендеринга SEO

Веб-страницы, которые сильно зависят от JavaScript, индексируются медленно и частично.

Серж Безбородов в своем недавнем посте о JavaScript SEO обозначил проблему. «При наличии большого количества динамического контента (например, отложенной загрузки изображений, обзоров продуктов, живого чата и т. д.), раздутого кода темы и дополнительных запросов к серверу рендеринг JS может добавить секунды ко времени, необходимому для преобразования страницы. интерактивный для посетителей, что вредит UX и Core Web Vitals».

«При наличии большого количества динамического контента (например, отложенной загрузки изображений, обзоров продуктов, живого чата и т. д.), раздутого кода темы и дополнительных запросов к серверу рендеринг JS может добавить секунды ко времени, необходимому для преобразования страницы. интерактивный для посетителей, что вредит UX и Core Web Vitals».

Становится хуже.

Компания Google значительно улучшила свой поисковый робот, но это не гарантирует, что контент с большим количеством JavaScript будет просканирован. Часто это происходит из-за проблем, не зависящих от Google (например, блокировка контента в файле robots.txt, тайм-ауты, ошибки и т. д.).

Если контент сильно зависит от JavaScript, но не обрабатывается роботом Googlebot, у вас проблема.

Какие проблемы с JavaScript создают проблемы для SEO?

- Генерация URL с хешем

- Плохая внутренняя структура ссылок (из-за обработчиков событий JS)

- Неминимизированный JavaScript и CSS

Как решить эти проблемы с JavaScript?

- Начните с Google Page Speed Insights: Используйте инструмент Google, чтобы оценить, что испытывают реальные пользователи, когда они посещают ваш сайт.

- Поддерживайте дисциплину SEO на странице: Обеспечьте хорошее управление определенными факторами на странице (например, уникальными заголовками и мета-описаниями, альтернативными атрибутами изображений, хорошими внутренними ссылками и контентом, оптимизированным под ключевые слова).

- Предоставьте роботу Googlebot доступ к вашему JavaScript: Убедитесь, что вы не блокируете Googlebot доступ к своему содержимому JavaScript. Вам больше не нужно скрывать свой JavaScript-контент от Google (т. е. экономить краулинговый бюджет).

- Оптимизировать ленивую загрузку: Googlebot не прокручивается, как мы; он изменяет размер страницы для просмотра вашего контента. Если вы полагаетесь на отложенную загрузку, ваш контент не будет отображаться и просматриваться роботом Googlebot. Убедитесь, что вы оптимизировали код отложенной загрузки, чтобы предотвратить ошибки рендеринга.

- Правильно используйте robots.

txt + JavaScript: Вы не хотите, чтобы Google случайно проиндексировал ваш контент. Если вы собираетесь использовать JavaScript для добавления метатегов robots, действуйте осторожно. Убедитесь, что файл robots.txt позволяет роботу Googlebot сканировать страницы JS и CSS.

txt + JavaScript: Вы не хотите, чтобы Google случайно проиндексировал ваш контент. Если вы собираетесь использовать JavaScript для добавления метатегов robots, действуйте осторожно. Убедитесь, что файл robots.txt позволяет роботу Googlebot сканировать страницы JS и CSS. - Используйте кэширование для повышения скорости загрузки: «Используйте управление версиями файлов или снятие отпечатков содержимого (например, main.2ba87581f.js) для создания новых имен файлов при каждом изменении кода, чтобы робот Googlebot загружал обновленную версию ресурса для рендеринга. ”

- Следуйте рекомендациям по работе с веб-компонентами: Веб-компоненты — это набор API-интерфейсов, который позволяет создавать повторно используемые настраиваемые элементы с инкапсулированной функциональностью, которые можно использовать на веб-сайтах и в приложениях. Робот Googlebot поддерживает веб-компоненты, но видит видимый контент только в отображаемом HTML.

Используйте удобный для мобильных устройств инструмент Google, чтобы оценить соответствие рекомендациям.

Используйте удобный для мобильных устройств инструмент Google, чтобы оценить соответствие рекомендациям. - Создавайте доступные веб-страницы: Ваши веб-страницы должны быть видны пользователям устаревших браузеров, программ чтения с экрана и тем, кто не поддерживает JS. Протестируйте свои веб-страницы с помощью текстового редактора или просмотрите свои веб-страницы с отключенным JS, чтобы проверить доступность.

- Используйте инструменты анализа JavaScript: Технические инструменты SEO, такие как JetOctopus, предоставляют исчерпывающую информацию о различных деталях (например, о выполнении JavaScript, запросах, производительности и т. д.).

Эти передовые методы позволяют Google легко сканировать, отображать и индексировать страницы с большим количеством JavaScript без дополнительных проблем, связанных с ошибками.

Отсутствие паритета контекста

Видят ли поисковые системы то, что видят ваши искатели?

В предыдущем посте основатель iPullRank Майк Кинг рассказал о проблемах с паритетом контента.

«Выявление проблем с паритетом контента отражает подход, который вы можете использовать, чтобы определить, есть ли у вас проблемы с JavaScript SEO. По сути, вы пытаетесь выяснить, что данная веб-страница показывает пользователю, чего не может увидеть сканер поисковой системы, потому что страница может показывать ее только в контексте, который отличается от того, в котором поисковая система сканирует или индексирует. ”

Это вопрос, на который вы пытаетесь ответить.

Но большинство сайтов не могут ответить на этот вопрос. В ходе нашего исследования мы проанализировали 5,3 миллиона URL-адресов и сделали несколько удивительных открытий.

- Только 16,29% сайтов, которые мы проанализировали, имели одинаковое количество слов как на настольных, так и на мобильных устройствах

- 30,31% URL-адресов обслуживали различное количество внутренних ссылок для настольных устройств, чем для мобильных устройств

- 9 0036 2,98% URL-адресов , которые являются самоканоничными на рабочем столе, не являются таковыми на мобильных устройствах

Вы ищете, есть ли несколько версий одной и той же страницы по одному и тому же URL-адресу.

Почему это важно?

Если на мобильных устройствах меньше контента, чем на ПК, робот Googlebot увидит меньше вашего контента. Если Google видит меньше, вы получаете меньше видимости.

Это нехорошо.

Единый интерфейс лучше всего подходит для пользователей и поисковых систем, поскольку он обеспечивает единообразие для всех (пользователей, поисковых систем и вас). Так как же убедиться, что вы предоставляете уникальный опыт?

Вы проводите проверку паритета.

Вы проверяете свои веб-страницы, используя различные пользовательские контексты (ракурсы), чтобы получить четкое представление о том, насколько похожи настольная и мобильная версии вашего сайта.

Вот эти контексты:

- HTML для рабочего стола — Необработанная HTML-версия веб-страницы, доставленная с вашего сервера в браузер

- JavaScript для рабочего стола — Полностью визуализированная версия веб-страницы, как она видна. в браузере до состояния Document Ready

- Мобильный HTML — Необработанная HTML-версия веб-страницы доставляется с вашего сервера на мобильное устройство

- Мобильный JavaScript — Полностью визуализированная версия веб-страницы, как обычно он просматривается в мобильном браузере до состояния готовности документа

Google также рассматривает их с точки зрения Googlebot, поэтому вам потребуется версия, отличная от Googlebot, для каждого из четырех контекстов, перечисленных выше. Вы можете сделать это вручную, используя такие инструменты, как Screaming Frog, или вы можете использовать Parito, созданный нами инструмент, для проведения аудита четности.

Вы можете сделать это вручную, используя такие инструменты, как Screaming Frog, или вы можете использовать Parito, созданный нами инструмент, для проведения аудита четности.

Неправильное использование или отсутствие структурированных данных

Структурированные данные являются разметкой на странице.

Эта разметка помогает поисковым системам понимать информацию, указанную на ваших веб-страницах, предоставляя пользователям богатые визуальные результаты поиска. Схема — это общий словарь разметки, который помогает поисковым системам сопоставлять людей с релевантной информацией, которую они хотят.

Google использует эти структурированные данные для создания расширенных фрагментов, которые они определяют как «визуально улучшенный результат поиска, теперь известный как «расширенный результат».

Существует более 30 разновидностей Rich Snippets.

Вот несколько распространенных проблем при работе со структурированными данными и Schema.org.

- Использование более чем одного языка для управления структурированными данными (например, JSON-LD, Microdata или RDF).

Вот общий сценарий; разработчики решают использовать JSON-LD, оптимизаторы решают использовать микроданные или RDF на той же веб-странице, что не очень хорошо. Лучше всего, чтобы все, кто работает с одним и тем же сайтом, придерживались одного и того же языка.

Вот общий сценарий; разработчики решают использовать JSON-LD, оптимизаторы решают использовать микроданные или RDF на той же веб-странице, что не очень хорошо. Лучше всего, чтобы все, кто работает с одним и тем же сайтом, придерживались одного и того же языка. - HTTP или HTTPS? Какой вариант лучше? Согласно Schema.org, любой вариант подходит, если вы избегаете использования «www» в качестве поддомена.

- Мы внедрили NAP, но не видим результатов поиска. Ваша страница должна будет установить авторитет с помощью внешних ссылок, местных ссылок и обзоров.

- Разметка текста, невидимая для пользователя, но видимая для робота Googlebot. Google говорит, что это не так. «Не размечайте контент, который не виден читателям страницы. Например, если разметка JSON-LD описывает исполнителя, тело HTML должно описывать того же исполнителя».

- Ваш веб-сайт содержит неподдерживаемый тип контента. Есть ли обходной путь для решения этой проблемы? Вы можете просто ничего не делать, выбрать менее конкретный тип контента или использовать систему расширения schema.

org для определения нового типа.

org для определения нового типа. - Верна ли ваша разметка schema.org? Как это проверить? Вы можете использовать инструменты Google для проверки расширенных результатов. Используйте средство проверки разметки схемы для общей проверки схемы, чтобы протестировать все типы разметки schema.org без специальной проверки Google.

Более распространенные проблемы можно найти в FAQ на Schema.org.

Катастрофа из-за неумелого управления технической миграцией веб-сайта

Как легко потерять рейтинг, видимость и трафик?

Миграция большого сайта.

Если вы сталкиваетесь с различными проблемами SEO, перенос вашего веб-сайта в новую среду может стать отличным способом начать все заново. Но это также отличный способ потерять рейтинг, если с ним неправильно обращаются.

Вот несколько причин, по которым предприятия испытывают падение трафика при переносе своего сайта.

- Отсутствующие метаданные

- Заблокированный контент (через метаданные robots.

txt)

txt) - Канонизация изменений тегов

- Проблемы со скоростью/производительностью страниц

- Проблемы с внутренними ссылками (т. е. со ссылками на старый сайт) 90 035 Проблемы с внешними ссылками (т.е. , потерянные входящие ссылки)

- Проблемы с доступностью консоли поиска Google

- Проблемы с переадресацией

- Проблемы с хостингом (например, ограничения по стране, брандмауэры, низкая производительность)

- Проблемы со ссылками на изображения (изображения ссылаются на старый сайт)

Вот как вы решаете эти технические проблемы миграции.

- Используйте такие инструменты, как Screaming Frog, для сканирования вашего сайта на наличие ошибок, неработающих ссылок, robot.txt, дублированного контента и т. д.

- Используйте такие инструменты, как ExactScience, Google Search Console и Google Analytics, для сравнения существующего рейтинга, трафика и конверсий

- Создайте (или обновите) XML-карту сайта вашего текущего сайта

- Подтвердите свою XML-карту сайта с помощью Map Broker

- Создайте список необходимых исправлений (например, 301 редиректы, неработающие ссылки)

- Проведите аудит паритета контекста с помощью Parito

- Запретите роботу Googlebot индексировать содержимое сайта разработки

- Создайте карту сайта в формате XML и добавьте ее в файл robots.

txt

txt - Настройка/обновление инструментов Bing для веб-мастеров и Google Search Console

- Добавьте коды отслеживания на каждую страницу (например, Adobe Analytics, Marketo, Facebook Pixel и т. д.), проверьте установку

- Обновите цели конверсии аналитики

- Обновите платную рекламу (поисковую, социальную, медийную и т. д.) URL-адреса обновлены

- Обновите локальные ссылки, профили социальных сетей и обзоров, а также контент

- Используйте такие инструменты, как Screaming Frog, для сканирования вашего нового сайта на наличие ошибок, неработающих ссылок, robot.txt, дублированного контента и т. д.

- Отклонение неверных ссылок

- Журнал в Google Search Console и убедитесь, что все ваши URL-адреса (и новый контент) были проиндексированы и конверсии

- Создавайте новые внутренние ссылки на свои страницы.

- Отслеживайте рекламные и маркетинговые каналы для снижения трафика. При тщательном подходе у вас будет все необходимое для безопасного перехода без необходимости ранжирования или потери трафика.

У крупных веб-сайтов возникают следующие проблемы с техническим SEO для предприятий

Это распространенные проблемы SEO для предприятий, но большинство из этих технических проблем можно решить.

Многие признанные бренды не достигают того уровня популярности, который им необходим, чтобы оставаться конкурентоспособными в поиске в долгосрочной перспективе. Этих технических проблем SEO можно избежать. Ваша организация может свести к минимуму проблемы с техническим SEO.

Google отдает предпочтение брендам; такие крупные сайты, как ваш, были активны дольше. У вас больше бюджет, больше ссылок и команда, которая вам нужна для решения этих технических задач.

Это несправедливое преимущество.

Чтобы решить эти технические проблемы, нужно правильно понять основы. Эти проблемы сводятся к масштабу; уделяйте этим проблемам то внимание, которого они заслуживают, и вы обнаружите, что можете получить значительную пользу, просто избегая этих проблем.

- Автор

- Последние сообщения

Эндрю Макдермотт

Эндрю Макдермотт является соучредителем HooktoWin.

Он показывает предпринимателям, как привлечь и завоевать новых клиентов.

Он показывает предпринимателям, как привлечь и завоевать новых клиентов.Последние сообщения Эндрю МакДермотта (см. все)

Топ-9 технических проблем SEO и способы их устранения знание своего пути в маркетинге в социальных сетях.

Чтобы поддерживать свой прогресс, вам также необходимо твердое понимание технического SEO.

В то время как классическое SEO фокусируется на ключевых словах, контент-маркетинге и других хорошо известных аспектах SEO на странице, техническое SEO направлено на улучшение вашего сайта на практическом уровне для повышения удобства пользователей.

Речь идет о том, чтобы убедиться, что он быстрый, эффективный, удобный для навигации и функциональный во всех отношениях, поскольку Google ожидает, что сайт будет соответствовать этим вещам, прежде чем он будет хорошо ранжироваться.

Понимание лучших технических методов поисковой оптимизации и старательное их применение — эффективный способ достичь и поддерживать высокие позиции в поисковой выдаче.

Но очень важно знать, какие потенциальные технические проблемы SEO вам следует искать, а также как их исправить.

Но очень важно знать, какие потенциальные технические проблемы SEO вам следует искать, а также как их исправить.Вот несколько примеров.

Загрузите этот пост, введя свой адрес электронной почты ниже

Не волнуйтесь, мы не спамим.1. Плохая мобильная доступность

Дни, когда люди просматривали веб-страницы и совершали покупки в основном через стандартные настольные системы, прошли.

Конечно, люди по-прежнему используют настольные компьютеры и ноутбуки , но почти 53 процента интернет-пользователей теперь выходят в Интернет через мобильные устройства.

Другими словами, мобильных пользователей сейчас составляют большинство ваших посетителей , и в будущем их будет только больше.

Так что, если ваш веб-сайт недоступен для мобильных устройств, это виртуальная гарантия того, что вы теряете посетителей и продажи, особенно в свете подхода Google к индексации, ориентированного на мобильные устройства.

Протестируйте свой сайт, чтобы убедиться, что он хорошо загружается на различных экранах.

Также часто проверяйте Google Search Console на наличие ошибок удобства использования и исправьте их до того, как они смогут повлиять на ваш рейтинг.

Также часто проверяйте Google Search Console на наличие ошибок удобства использования и исправьте их до того, как они смогут повлиять на ваш рейтинг.2. Дублированный контент

Дублирующийся контент представляет большую проблему для большего количества различных веб-сайтов, чем вы думаете, особенно в тех случаях, когда владельцы веб-сайтов полагаются на автоматизированные системы для управления своим контентом.

Иногда одни и те же элементы или контент представлены на нескольких страницах. В других случаях это может быть проблема с URL-адресом или контент, который был непреднамеренно дважды опубликован.

Причина, по которой дублирование контента является проблемой SEO, заключается в том, что поисковые роботы имеют ограниченное количество времени, которое они могут посвятить оценке вашего сайта. Дублированный контент может запутать их и помешать правильно индексировать соответствующий контент.

Вы можете решить эти проблемы, добавив проверку дублирующегося контента к своим регулярным проверкам веб-сайта.

Попробуйте такой инструмент, как Siteliner от Copyscape, чтобы упростить и ускорить процесс поиска проблемных страниц. И избегайте соблазна намеренно копировать и вставлять информацию, например описания продуктов, на несколько страниц.

3. Безопасность HTTPS отсутствует

Помните, что миссия Google — предоставлять своим пользователям самые лучшие и точные результаты поиска.

Он не рекомендует сайты с плохим или отсутствующим пользовательским интерфейсом, и он не будет рекомендовать сайты, которые могут представлять угрозу безопасности.

Тем не менее, если на вашем сайте не используется протокол безопасности HTTPS, Google будет рассматривать его как потенциальную опасность для своих посетителей.

Посетителей отпугнет сообщение «небезопасно», которое они получат, если они все равно посетят вашу страницу, и у них останется плохое впечатление о вашем бизнесе.

Ни одна из этих вещей не улучшит ваш рейтинг в поисковой выдаче.

Если ваш сайт не поддерживает этот протокол, вы можете исправить это, купив действующий сертификат SSL. Как только это будет сделано, URL-адрес вашего сайта будет отображать знакомое изображение висячего замка прямо перед тем местом, где он должен быть.

4. Низкая скорость загрузки

Вспомните, когда вы в последний раз пытались посетить многообещающий веб-сайт и обнаружили, что он загружается с черепашьей скоростью.

Скорее всего, вы не хотели просто сидеть и терпеливо ждать столько времени, сколько потребуется.

На самом деле, если загрузка этой страницы заняла больше пары секунд, вы, вероятно, расстроились и в конце концов удалились.

Если у вашего сайта есть собственные проблемы со временем загрузки, ваши посетители чувствуют то же самое. И вы можете быть уверены, что Google тоже, поскольку низкая скорость является одной из самых распространенных и неприятных технических проблем SEO. (По данным Google идеальное время загрузки меньше секунды и не должно превышать 3-4 секунды.

)

) Будьте в курсе скорости загрузки с помощью надежного инструмента, такого как Google PageSpeed Insights, для проверки настроек как для ПК, так и для мобильных устройств.

Поддерживайте высокую скорость загрузки, минимизируя JavaScript, оптимизируя изображения и графику и сохраняя веб-дизайн как можно более чистым и простым.

5. Отсутствующие альтернативные теги

Отсутствующие альтернативные теги — еще одна из наиболее распространенных технических проблем SEO, поскольку даже профессиональные специалисты по оптимизации часто не могут правильно пометить свои изображения.

Имейте в виду, что поисковые системы (а также пользователи с ограниченным доступом) рассчитывают на теги alt, чтобы сообщить им, что представляет собой изображение.

Тем не менее, оставляя их без внимания, вы теряете огромные возможности SEO.

Альтернативные теги позволяют роботам-сканерам индексировать и каталогизировать ваши изображения , а также посетителям с нарушениями зрения понимать изображение с помощью программного обеспечения для чтения.

Отсутствие этого может определенно повредить вашему рейтингу.

Отсутствие этого может определенно повредить вашему рейтингу.Исправьте эту проблему, методично просматривая все изображения на своем веб-сайте и добавляя описательные теги alt с ключевыми словами к тем, у которых их еще нет. (Одновременно проверьте наличие поврежденных изображений.)

Затем не забывайте использовать теги alt при каждой загрузке новых изображений в будущем.

6. Неработающие ссылки

Неработающие ссылки — это технические проблемы SEO, которые по понятным причинам прерывают положительное впечатление пользователя от веб-сайта.

Это не только лишает их удовольствия от контента, который они читают, но и оставляет у пользователя плохое впечатление о бренде, стоящем за этим сайтом.

И да, Google также замечает эти проблемы и может соответствующим образом оштрафовать ваш контент.

Дело в том, что время идет, контент стареет, и могут возникать такие проблемы, как неработающие ссылки, поэтому важно быть в курсе событий.

Регулярно проводите анализ внутренних ссылок, чтобы найти страницы со ссылками, которые необходимо исправить.

Также следите за своим каталогом внешних обратных ссылок, чтобы вы могли обращаться к владельцам веб-сайтов с обновленной информацией при обнаружении неработающих ссылок.

7. Неправильный файл robots.txt

Если ваш файл robots.txt неправильно сконфигурирован или иным образом неверен, поисковые роботы Google не смогут получить доступ или правильно проиндексировать ваш сайт.

Это означает, что органический трафик либо полностью останавливается, либо вообще отсутствует , так что это определенно одна из тех технических проблем SEO, которые вы не можете позволить себе игнорировать.

Если у вас нет конкретных разделов вашего сайта, которые вы хотите полностью исключить из процесса индексации, скорее всего, вам вообще не нужен пользовательский файл robots.txt. Но если вы до используйте один, очень важно убедиться, что вы делаете это правильно.

Оцените наличие проблемы, введя «/robots.txt» после URL-адреса.

Если вы видите команду «запретить», у вас есть потенциальная проблема, и следует поговорить с вашим веб-разработчиком.

Иногда есть причина, по которой он там есть, но иногда это означает, что пришло время для построчного обзора, чтобы найти дополнительные технические проблемы SEO.

8. Отсутствующие или неэффективные мета-описания

Твердые теги заголовков и метаописания — это не просто хорошая идея, когда дело доходит до SEO.

Когда эти элементы отсутствуют, у Google нет всех данных, которые необходимы для правильного отображения ваших страниц в результатах поиска и возврата их нужным пользователям. (Мета-описания — это короткие дескрипторы, отображаемые рядом со ссылкой на веб-сайт в поисковой выдаче.)

Максимизируйте SEO-потенциал вашего контента, всегда включая хорошо написанное мета-описание.

Google обычно урезает метаописания примерно до 160 символов , поэтому для достижения наилучших результатов оставьте их такой же длины или меньше.

Не забудьте также включить релевантные ключевые слова естественным образом.

Не забудьте также включить релевантные ключевые слова естественным образом.9. Использование сомнительных ссылок

Создание ссылок является одним из столпов хорошей SEO-стратегии, но неправильный подход к нему может открыть дверь для проблемных технических вопросов SEO.

Например, вы наткнетесь на множество советов по созданию ссылок в Интернете, в которых рекомендуются такие стратегии, как обмен ссылками — стратегии, которые могут привести к большому количеству обратных ссылок, но в лучшем случае сомнительному качеству.

Важно понимать, что не все обратные ссылки одинаковы.

Вам нужны органические ссылки из авторитетных авторитетных источников , но любой ценой следует избегать токсичных обратных ссылок с некачественных сайтов или сайтов, не связанных с вашей нишей.

Решите эту проблему, избегая автоматических служб построения ссылок, независимо от того, что они вам обещают.

Не покупайте и не продавайте обратные ссылки.

Подробнее рассказывали в этой статье.

Подробнее рассказывали в этой статье.

Напрямую наличие или отсутствие микроразметки не влияет на SEO, но правильно настроенная разметка на сайте дает следующие преимущества:

Напрямую наличие или отсутствие микроразметки не влияет на SEO, но правильно настроенная разметка на сайте дает следующие преимущества:

Самостоятельно изучить способы улучшения скорости можно в статье.

Самостоятельно изучить способы улучшения скорости можно в статье.

д. Google объясняет, почему качество сканирования является таким важным критерием: «Если сайт какое-то время отвечает очень быстро, лимит увеличивается, а это означает, что для сканирования можно использовать больше подключений. Если сайт тормозит или отвечает ошибками сервера, лимит снижается, и робот Googlebot сканирует меньше».

д. Google объясняет, почему качество сканирования является таким важным критерием: «Если сайт какое-то время отвечает очень быстро, лимит увеличивается, а это означает, что для сканирования можно использовать больше подключений. Если сайт тормозит или отвечает ошибками сервера, лимит снижается, и робот Googlebot сканирует меньше». Вот в чем дело; установка более высоких лимитов не означает автоматически, что вы получите больший краулинговый бюджет.

Вот в чем дело; установка более высоких лимитов не означает автоматически, что вы получите больший краулинговый бюджет. Google работает над тем, чтобы эти страницы не попадали в результаты поиска, потому что это снижает качество поисковой выдачи Google (очевидно).

Google работает над тем, чтобы эти страницы не попадали в результаты поиска, потому что это снижает качество поисковой выдачи Google (очевидно).

Если это не так, есть большая вероятность, что у вас может быть проблема с низким качеством или спамом. Контент низкого качества не соответствует стандарту Google E-A-T; примеры включают незащищенный сайт электронной коммерции, контент из неавторитетного источника (например, рекомендации по налогам с веб-сайта по уходу за собаками) 9.0038

Если это не так, есть большая вероятность, что у вас может быть проблема с низким качеством или спамом. Контент низкого качества не соответствует стандарту Google E-A-T; примеры включают незащищенный сайт электронной коммерции, контент из неавторитетного источника (например, рекомендации по налогам с веб-сайта по уходу за собаками) 9.0038 е. трехуровневую)

е. трехуровневую)

txt + JavaScript: Вы не хотите, чтобы Google случайно проиндексировал ваш контент. Если вы собираетесь использовать JavaScript для добавления метатегов robots, действуйте осторожно. Убедитесь, что файл robots.txt позволяет роботу Googlebot сканировать страницы JS и CSS.

txt + JavaScript: Вы не хотите, чтобы Google случайно проиндексировал ваш контент. Если вы собираетесь использовать JavaScript для добавления метатегов robots, действуйте осторожно. Убедитесь, что файл robots.txt позволяет роботу Googlebot сканировать страницы JS и CSS. Используйте удобный для мобильных устройств инструмент Google, чтобы оценить соответствие рекомендациям.

Используйте удобный для мобильных устройств инструмент Google, чтобы оценить соответствие рекомендациям. Вот общий сценарий; разработчики решают использовать JSON-LD, оптимизаторы решают использовать микроданные или RDF на той же веб-странице, что не очень хорошо. Лучше всего, чтобы все, кто работает с одним и тем же сайтом, придерживались одного и того же языка.

Вот общий сценарий; разработчики решают использовать JSON-LD, оптимизаторы решают использовать микроданные или RDF на той же веб-странице, что не очень хорошо. Лучше всего, чтобы все, кто работает с одним и тем же сайтом, придерживались одного и того же языка. org для определения нового типа.

org для определения нового типа. txt)

txt) txt

txt

Он показывает предпринимателям, как привлечь и завоевать новых клиентов.

Он показывает предпринимателям, как привлечь и завоевать новых клиентов. Но очень важно знать, какие потенциальные технические проблемы SEO вам следует искать, а также как их исправить.

Но очень важно знать, какие потенциальные технические проблемы SEO вам следует искать, а также как их исправить. Также часто проверяйте Google Search Console на наличие ошибок удобства использования и исправьте их до того, как они смогут повлиять на ваш рейтинг.

Также часто проверяйте Google Search Console на наличие ошибок удобства использования и исправьте их до того, как они смогут повлиять на ваш рейтинг.

)

)  Отсутствие этого может определенно повредить вашему рейтингу.

Отсутствие этого может определенно повредить вашему рейтингу.

Не забудьте также включить релевантные ключевые слова естественным образом.

Не забудьте также включить релевантные ключевые слова естественным образом.