seo — Как закрыть от индексации страницы

Задать вопрос

Вопрос задан

Изменён 11 месяцев назад

Просмотрен 40 раз

Нужно закрыть от индексации след. страницы:

/catalog/?q=Стулья+офисные&s=Найти

/catalog/?q=сонома&s=Найти

/catalog/?section_id=1314&q=Подушка+&how=r

/catalog/divany-i-kresla/vse-divany/filter/dlina-to-1.88/apply/

/catalog/?section_id=1428&q=Гостиная+3&s=Найти

/form/?name=toorder&form_id=TOORDER&data-trigger={"class":"btn-lg to-order btn btn-default animate-load has-ripple","data-event":"jqm","data-param-form_id":"TOORDER","data-name":"toorder","data-autoload-product_name":"Диван угловой ЛЕО (Amigo (green))","data-autoload-product_id":"206121"}

/catalog/?section_id=1420&q=Комоды&how=r

Попробовала добавить след. строки в

строки в robots.txt, но не помогло.

Disallow: /*?q= Disallow: /*?section_id= Disallow: /*?name= Disallow: /catalog/divany-i-kresla/vse-divany/filter/

Подскажите, пожалуйста, как можно решить проблему?

- seo

- индексация

- robots.txt

Используйте директиву Clean-param для исключения параметров q, s и how:

Clean-param: q&s&how /catalog*

А url подобные /catalog/divany-i-kresla/vse-divany/filter/dlina-to-1.88/apply/ закройте при помощи

Disallow: /catalog/*/filter/*2

Зарегистрируйтесь или войдите

Регистрация через Google Регистрация через Facebook Регистрация через почтуОтправить без регистрации

ПочтаНеобходима, но никому не показывается

Отправить без регистрации

ПочтаНеобходима, но никому не показывается

By clicking “Отправить ответ”, you agree to our terms of service and acknowledge that you have read and understand our privacy policy and code of conduct.

Как закрыть сайт или страницу от индексации в поисковых системах?

На стадии разработки и/или редизайна проекта бывают ситуации, когда лучше не допускать поисковых роботов на сайт или его копию. В этом случае рекомендуется закрыть сайт от индексации поисковых систем. Сделать это можно следующим образом:

Закрыть сайт от индексации очень просто, достаточно в настройках сайта в блоке «Содержимое файла robots.txt» прописать в нём следующие строки:

User-agent: Yandex

Disallow: /

Такие строки закроют сайт от поискового робота Яндекса.

User-agent: *

Disallow: /

А таким образом можно закрыть сайт от всех поисковых систем (Яндекса, Google и других).

Как закрыть от индексации отдельную папку? #

Отдельную папку можно закрыть от поисковых систем в том же поле с её явным указанием (будут скрыты все файлы внутри этой папки).

User-agent: *

Disallow: /folder/

Если какой-то отдельный файл в закрытой папке хочется отдельно разрешить к индексации, то используйте два правила Allow и Disallow совместно:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Как закрыть отдельный файл в Яндексе? #

Всё по аналогии.

User-agent: Yandex

Disallow: /folder/file.php

Как закрыть конкретную страницу в Яндексе? #

Всё по аналогии.

User-agent: Yandex

Disallow: /pagename

Как скрыть от индексации картинки? #

Картинки форматов jpg, png и gif могут быть запрещены к индексации следующими строчками в поле robots:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Как обращаться к другим поисковым роботам (список) #

У каждой поисковой системы есть свой список поисковых роботов (их несколько), к которым можно обращаться по имени в поле «Содержимое файла robots. txt». Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

txt». Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

- Yandex — основной робот-индексатор Яндекса.

- Googlebot — основной робот-индексатор от Google.

- Slurp — поисковый робот от Yahoo!.

- MSNBot — поисковый робот от MSN (поисковая система Bing от Майкрософт).

- SputnikBot — имя робота российского поисковика Спутник от Ростелекома.

Прочие директивы в robots.txt #

Поисковая система Яндекс также поддерживает следующие дополнительные директивы в файле:

-

«Crawl-delay:» — задает минимальный период времени в секундах для последовательного скачивания двух файлов с сервера. Также поддерживается и большинством других поисковых систем. Пример записи: Crawl-delay: 0.5

-

«Clean-param:» — указывает GET-параметры, которые не влияют на отображение контента сайта (скажем UTM-метки или ref-ссылки). Пример записи: Clean-param: utm /pagename

-

«Sitemap:» — указывает путь к XML-карте сайта, при этом, карт может быть несколько.

Также директива поддерживается большинством поисковых систем (в том числе Google). Пример записи: Sitemap: https://energy-bm.ru/sitemap.xml

Закрыть страницу и сайт с помощью meta-тега name=»robots» #

Также, можно закрыть сайт или заданную страницу от индексации с помощь мета-тега robots. Данный способ является даже предпочтительным и с большим приоритетом выполняется пауками поисковых систем. Для скрытия от индексации в настройках сайта/страницы в поле <head> </head> документа устанавливается следующий код:

<meta name=»robots» content=»noindex, nofollow»/>

Или (полная альтернатива):

<meta name=»robots» content=»none»/>

С помощью meta-тега можно обращаться и к одному из роботов, используя вместо name=»robots» имя робота, а именно:

Для паука Google:

<meta name=»googlebot» content=»noindex, nofollow»/>Или для Яндекса:

<meta name=»yandex» content=»none»/>

Как скрыть страницу WordPress от Google (3 метода)

Вы ищете способ скрыть страницу WordPress от Google?

Иногда вам может потребоваться исключить страницу из результатов поиска Google, поскольку она не имеет отношения к содержанию вашего сайта, чтобы защитить вашу конфиденциальность или отпугнуть нежелательных пользователей.

В этой статье мы покажем вам, как скрыть страницу WordPress от Google, не влияя на общую поисковую оптимизацию вашего сайта (SEO).

Зачем скрывать сообщение или страницу WordPress от Google

Поисковые системы, такие как Google, позволяют владельцам веб-сайтов исключать контент из результатов поиска.

Например, вы можете захотеть скрыть сообщения и страницы блога WordPress, которые не имеют никакого отношения к широкой публике, например страницу, которую вы создали для подтверждения права собственности на веб-сайт.

Вы также можете исключить страницы с личной или конфиденциальной информацией, чтобы защитить вашу конфиденциальность и предотвратить попадание конфиденциальной информации в чужие руки.

Например, если у вас есть членский веб-сайт, вы можете скрыть страницы профилей ваших участников от показа в поисковых системах.

Скрытие контента от Google также полезно, если ваш веб-сайт находится в разработке и вы хотите поделиться предварительным просмотром со своей аудиторией. Таким образом, Google не будет индексировать незавершенный сайт в результатах поиска.

Таким образом, Google не будет индексировать незавершенный сайт в результатах поиска.

В этой статье мы рассмотрим различные способы скрытия страниц WordPress от Google, включая использование метатега HTML, использование файла robots.txt, защиту страниц паролем и перевод вашего сайта в режим обслуживания.

- Скрытие страницы WordPress от поисковых систем с помощью AIOSEO

- Скрытие страницы WordPress от поисковых систем с помощью файла robots.txt

- Защита паролем публикации или страницы в WordPress

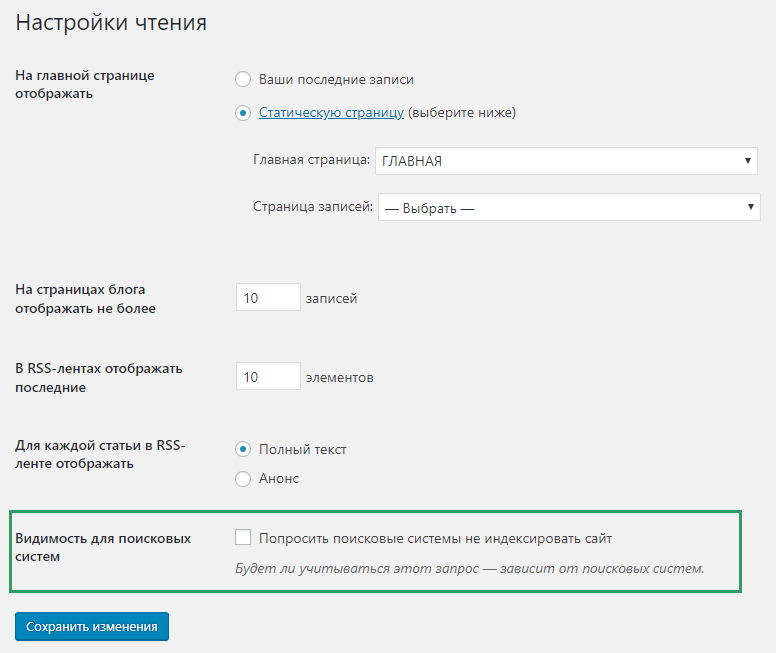

- Скрытие сайта WordPress до тех пор, пока он не будет готов

Способ 1 : скрыть страницу WordPress от поисковых систем с помощью AIOSEO

Вы можете скрыть страницу WordPress от Google с помощью плагина WordPress, такого как All in One SEO (AIOSEO). Это один из самых популярных SEO-плагинов, которым пользуются более 3 миллионов веб-сайтов. Этот метод самый простой и рекомендуется для начинающих.

Во-первых, вам нужно установить и активировать плагин AIOSEO. Для получения более подробной информации см. наше пошаговое руководство по установке плагина WordPress. В бесплатной версии AIOSEO также есть возможность скрывать страницы от Google.

Для получения более подробной информации см. наше пошаговое руководство по установке плагина WordPress. В бесплатной версии AIOSEO также есть возможность скрывать страницы от Google.

После установки и активации плагина на вашем сайте WordPress вам необходимо отредактировать страницу или публикацию, которую вы хотите скрыть от Google.

В редакторе контента WordPress просто прокрутите вниз до настроек AIOSEO и нажмите на вкладку «Дополнительно».

Теперь вы увидите параметр «Настройка роботов» и переключатель «Использовать настройки по умолчанию». Вам нужно нажать на переключатель, чтобы отключить настройку robots.

Как только вы это сделаете, в разделе «Мета роботов» появятся дополнительные параметры.

Чтобы страница не отображалась в результатах поиска Google, необходимо установить флажок «Без индекса».

После этого вы можете сохранить или опубликовать свою страницу. AIOSEO добавит строку кода, которая сообщает поисковым системам, таким как Google, не индексировать эту страницу.

Автоматический код будет выглядеть так:

Помимо исключения определенных страниц, AIOSEO также позволяет скрывать различные разделы контента от показа в Google.

Для этого перейдите на страницу

Вы увидите разные вкладки для разных разделов контента, включая типы контента, таксономии, мультимедиа и архивы.

Теперь щелкните любую из этих вкладок и установите для параметра «Показывать в результатах поиска» значение «Нет».

Если вы хотите скрыть медиафайлы от Google, вам понадобится версия AIOSEO Pro для просмотра параметров на вкладке «Медиа».

После этого нажмите кнопку «Сохранить изменения».

AIOSEO добавит HTML-метатег noindex, чтобы поисковые системы не индексировали контент, и он не отображался в результатах поиска. Это также исключит контент из ваших карт сайта XML.

Способ 2: скрыть страницу WordPress от поисковых систем с помощью файла robots.txt

Этот метод требует редактирования файла robots.txt, который представляет собой файл конфигурации, содержащий инструкции для роботов поисковых систем. Для получения дополнительной информации ознакомьтесь с нашим руководством по оптимизации файла robots.txt WordPress для SEO.

Добавление неправильных инструкций в этот файл может негативно сказаться на SEO вашего сайта, поэтому мы не рекомендуем этот метод новичкам.

Вы можете отредактировать файл robots.txt, подключившись к своему веб-сайту с помощью FTP-клиента или файлового менеджера в cPanel хостинга WordPress и перейдя в корневой каталог вашего веб-сайта.

Вам нужно будет добавить следующие строки в файл robots.txt:

Пользовательский агент: * Запретить: /ваша-страница/

Строка агента пользователя позволяет нацеливаться на определенных ботов. Мы используем знак звездочки, чтобы включить все поисковые системы. Следующая строка определяет часть URL-адреса, которая следует за вашим доменным именем.

Следующая строка определяет часть URL-адреса, которая следует за вашим доменным именем.

Теперь предположим, что вы хотите скрыть сообщение в блоге с таким URL-адресом:

http://example.com/2016/12/мой-блог-пост/

Вот как вы добавите этот URL в свой файл robots.txt:

Пользовательский агент: * Запретить: /2016/12/мой-блог-пост/

Не забудьте сохранить изменения и загрузить файл robots.txt обратно на сервер.

Использование файла robots.txt для скрытия содержимого имеет некоторые недостатки. Во-первых, имейте в виду, что файл robots.txt общедоступен. Это означает, что любой может получить к нему прямой доступ, чтобы увидеть, есть ли какие-либо страницы, которые вы пытаетесь скрыть.

Во-вторых, хотя большинство поисковых систем следуют инструкциям в файле robots.txt, другие сканеры и боты могут просто игнорировать его и все равно индексировать эти страницы. Эти боты сканируют Интернет, чтобы распространять вредоносное ПО, нацеливаться на веб-сайты и собирать информацию, такую как учетные записи электронной почты и номера телефонов.

Способ 3: Защита паролем публикации или страницы в WordPress

Этот метод использует другой подход. Вместо того, чтобы просить поисковые системы не индексировать страницу, вы можете просто защитить ее паролем, чтобы она была видна только пользователям с паролем.

WordPress поставляется со встроенной функцией защиты паролем сообщений и страниц. Просто отредактируйте запись или страницу, которую хотите защитить. В разделе «Документ» в редакторе WordPress нажмите ссылку рядом с параметром «Видимость».

Это покажет параметры видимости, доступные в WordPress, где вы можете сделать запись или страницу общедоступной, частной или защищенной паролем.

Частные сообщения доступны только зарегистрированным пользователям, которые имеют по крайней мере роль редактора на вашем веб-сайте. Посты, защищенные паролем, может увидеть любой посетитель, у которого есть пароль.

Вам нужно выбрать опцию «Защищено паролем», а затем ввести надежный пароль.

После того, как вы опубликуете или обновите сообщение или страницу, посетителям, которые попытаются получить к ним доступ, будет предложено ввести пароль для просмотра содержимого.

Они увидят такую страницу.

Более подробные инструкции см. в нашем руководстве о том, как защитить паролем записи и страницы в WordPress.

Если вы хотите создавать и продавать онлайн-курсы, мы рекомендуем использовать подходящую платформу, такую как MemberPress, которая поставляется с расширенными функциями защиты контента.

Способ 4. Скрытие сайта WordPress до тех пор, пока он не будет готов

Возможно, вы захотите скрыть свой сайт WordPress от Google и других пользователей, когда будете его создавать, переделывать или обновлять основные темы и плагины.

Самый простой способ сделать это — перевести свой веб-сайт в режим обслуживания с помощью плагина, такого как SeedProd.

Во-первых, вам необходимо установить и активировать плагин SeedProd. Для получения более подробной информации см. наше пошаговое руководство по установке плагина WordPress.

Примечание: Существует также бесплатная версия SeedProd, которую вы можете использовать. Но в этом уроке мы покажем версию Pro, так как в ней больше возможностей.

Но в этом уроке мы покажем версию Pro, так как в ней больше возможностей.

После активации перейдите на 9Страница 0057 SeedProd » Settings для ввода лицензионного ключа. Вы можете найти эту информацию в своей учетной записи на веб-сайте SeedProd.

Далее вам нужно перейти к SeedProd » Pages .

Здесь вы должны найти страницу «Режим обслуживания» и переключить переключатель с «Неактивно» на «Активно».

После этого вам нужно будет нажать кнопку «Настроить страницу режима обслуживания». Это позволяет вам создать временную страницу, которую ваши посетители могут видеть, пока ваш сайт скрыт.

Во-первых, вам нужно выбрать шаблон для страницы. При наведении указателя мыши на шаблон вы увидите два значка. Вы можете предварительно просмотреть шаблон, щелкнув значок увеличительного стекла, и выбрать его, щелкнув значок с красной галочкой.

После выбора шаблона вы попадете в конструктор страниц SeedProd с функцией перетаскивания, чтобы настроить страницу режима обслуживания.

Здесь вы можете отредактировать текст и загрузить собственное фоновое изображение, соответствующее вашему брендингу.

Вы также можете добавлять новые блоки из левого столбца. Например, вы можете добавить таймер, который отсчитывает время до запуска вашего веб-сайта.

Если вы довольны дизайном страницы, вам необходимо опубликовать ее. Просто нажмите кнопку раскрывающегося меню рядом с «Сохранить», а затем нажмите «Опубликовать».

Вам будет показано сообщение о том, что ваша страница опубликована.

Ваш веб-сайт теперь скрыт от Google и общественности, и видна только страница обслуживания.

Вы можете нажать кнопку «Просмотреть страницу в реальном времени», чтобы просмотреть страницу обслуживания.

Так это выглядит на нашем демонстрационном сайте.

Когда вы будете готовы показать свой веб-сайт всему миру, просто посетите SeedProd » Страницы еще раз и переключите переключатель режима обслуживания с «Активно» на «Неактивно».

Мы надеемся, что это руководство помогло вам узнать, как скрыть страницу WordPress от Google. Вы также можете ознакомиться с нашим руководством по установке Google Analytics в WordPress, чтобы просматривать статистику пользователей, или нашими экспертами, которые выбирают лучшие конструкторы страниц с перетаскиванием для WordPress.

Если вам понравилась эта статья, подпишитесь на наш YouTube канал для видеоуроков по WordPress. Вы также можете найти нас в Твиттере и Facebook.

html — Как запретить поисковым системам индексировать одну страницу моего сайта?

спросил

Изменено 2 года, 11 месяцев назад

Просмотрено 18 тысяч раз

Я не хочу, чтобы поисковые системы индексировали мою страницу выходных данных. Как я мог это сделать?

Как я мог это сделать?

- HTML

- SEO

Также вы можете добавить следующий метатег в HEAD этой страницы

2

Вам нужен простой файл robots.txt . По сути, это текстовый файл, который указывает поисковым системам не индексировать определенные страницы.

Вам не нужно включать его в заголовок вашей страницы; пока он находится в корневом каталоге вашего веб-сайта, он будет обнаружен поисковыми роботами.

Создайте его в корневой папке вашего сайта и введите следующий текст:

User-Agent: * Запретить: /imprint-page.htm

Обратите внимание, что в этом примере вы замените imprint-page.html фактическим названием страницы (или каталога), индексацию которой вы хотите предотвратить.

Вот оно! Если вы хотите стать более продвинутым, вы можете проверить здесь, здесь или здесь для получения дополнительной информации. Кроме того, в Интернете можно найти бесплатные инструменты, которые сгенерируют файл

Кроме того, в Интернете можно найти бесплатные инструменты, которые сгенерируют файл robots.txt 9.0196 для вас (например, здесь).

Вы можете настроить файл robots.txt, чтобы попытаться заставить поисковые системы игнорировать определенные каталоги.

Подробнее см. здесь.

В основном:

User-agent: * Запретить: /[директория или файл здесь]

Просто включите эту строку в свой 9Тег 0196. Почему я говорю вам это, потому что, если вы используете файл robots.txt, чтобы скрыть свои URL-адреса, которые могут быть страницами входа или другими защищенными URL-адресами, которые вы не будете показывать кому-либо еще или поисковым системам.

Что я могу сделать, так это получить доступ к файлу robots.txt непосредственно с вашего веб-сайта и увидеть, какие URL-адреса у вас являются секретными. Тогда в чем логика этого файла robots. txt?

txt?

Хороший способ - включить метатег сверху и обезопасить себя от кого-либо.

В настоящее время лучший способ — использовать метатег robots и установить для него значение 9.0195 noindex, следуйте :

0

Создайте файл robots.txt и установите в нем элементы управления.

Вот документы для Google: http://code.google.com/web/controlcrawlindex/docs/robots_txt.html

Робот хочет посетить URL-адрес веб-сайта, например http://www.example.com/welcome.html. Перед этим он сначала проверяет http://www.example.com/robots.txt и находит: вы можете явно запретить:

Агент пользователя: * Запретить: /~joe/junk.html

, пожалуйста, перейдите по ссылке ниже для получения подробной информации robots.txt

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google Зарегистрироваться через Facebook Зарегистрируйтесь, используя электронную почту и парольОпубликовать как гость

Электронная почтаТребуется, но не отображается

Опубликовать как гость

Электронная почтаТребуется, но не отображается

Нажимая «Опубликовать свой ответ», вы соглашаетесь с нашими условиями обслуживания и подтверждаете, что прочитали и поняли нашу политику конфиденциальности и кодекс поведения.