Создать robots.txt онлайн

Чтобы активировать

PRO версию программы достаточно только нажать и поделиться страницей через социальные сети выше.

Настройки

|

Ссылка на сайт |

Домен сайта, если на сайт заходите с WWW укажите сайт с www. |

|

Ссылка на карту сайт [ Создать карту сайта онлайн ] |

Обычно это sitemap.xml файл который содержит древо сайта Только файл (без http:// и домена) Добавить еще |

|

|

Добавить еще |

|

Ссылка на карту сайт (2) |

Добавить еще |

|

Ссылка на карту сайт (3) |

Добавить еще |

|

Ссылка на карту сайт (4) |

Добавить еще |

|

Ссылка на карту сайт (5) |

Добавить еще |

| Все роботы могут заходить на сайт |

Рекомендовано разрешить. разрешитьзапретить

разрешитьзапретить |

|

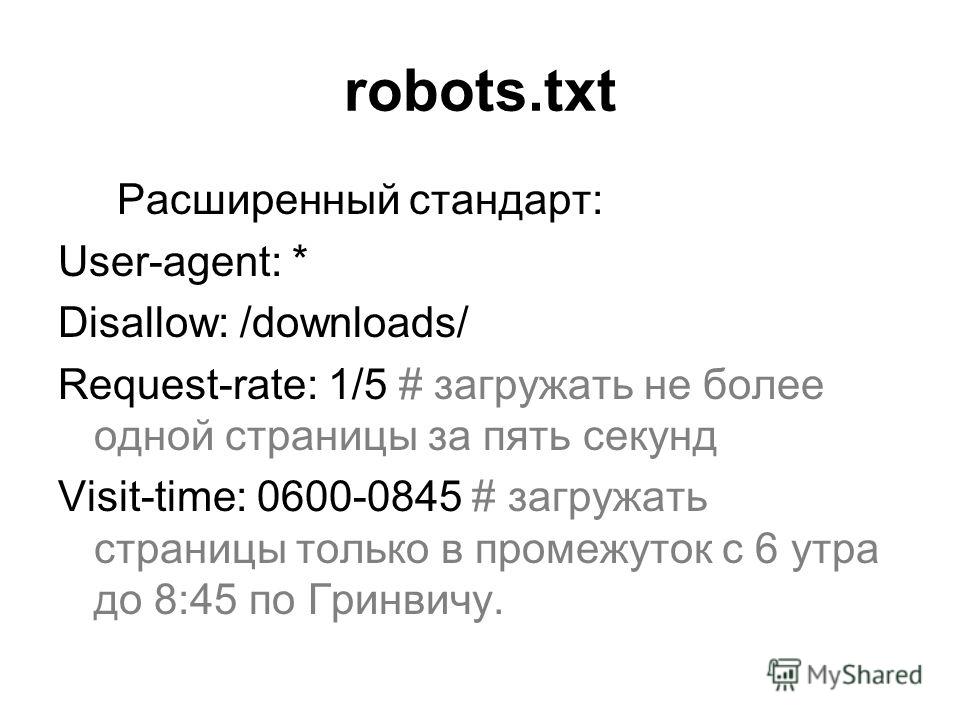

Задержка индексации |

Скорость перехода (в секундах) на другу страницу На усмотрение поисковика5 сек.10 сек.20 сек.60 сек.120 сек. |

Запретить этим роботам индексировать сайт:

| Яндекс | Mail.Ru | Google Картинки | ||

| Google Мобильный | Aport | MSN Поиск | MSN Картинки | Yahoo |

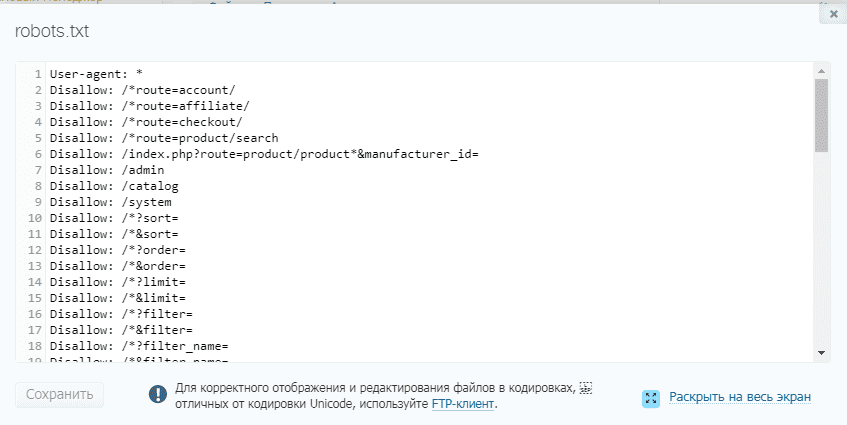

Запретить индексировать пути

Robots.

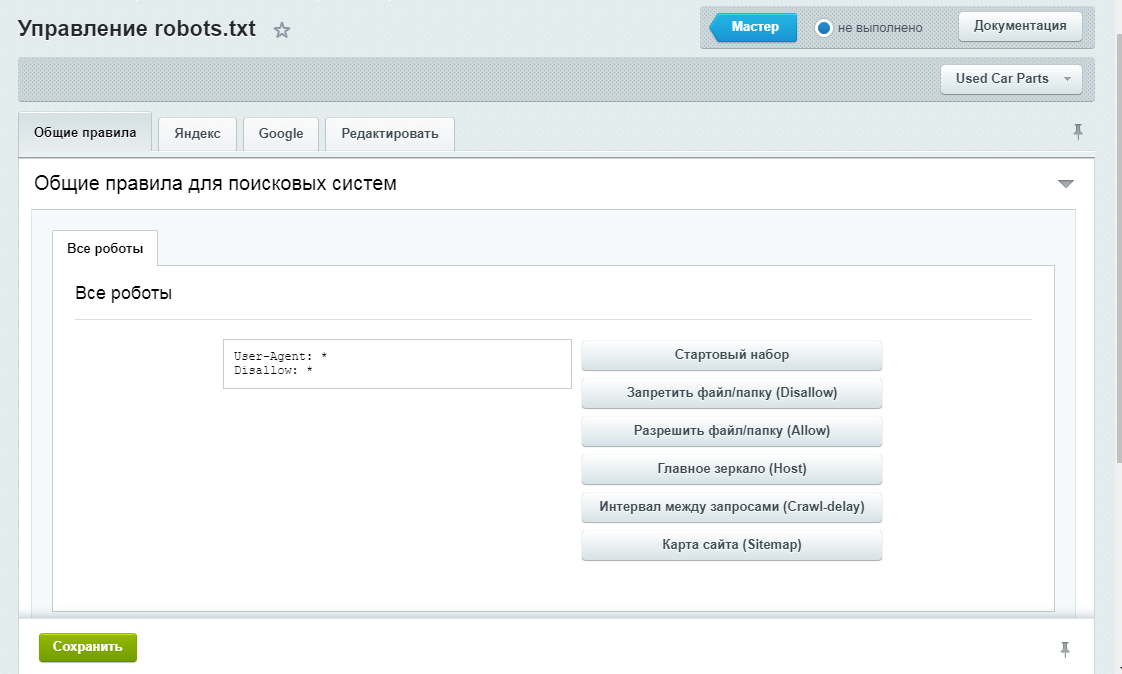

Конечно же вы можете самостоятельно написать данный файл, к тому же примеров в сети очень много. Но, намного правильнее и быстрее будет воспользоваться нашим инструментом создания robots.txt – это самый эффективный способ. Все что от Вас требуется это заполнить форму на нашем сайте и все. В результате вы получите уже готовый текст, который нужно просто вставить в документ и сохранить в корне вашего сайта под именем Robots.txt. При этом у вас есть возможность полностью запретить индексирование своего сайта, хотя вряд ли это кому-то понадобится. Здесь вам нужно будет указать местонахождение карты вашего сайта, а если у вас ее нету, то можно просто не заполнять данное поле. Далее вы можете выбрать поисковые системы, которым дадите право проводить индексирование страниц вашего ресурса. Рекомендуется выбирать все, это даст наиболее положительный эффект в плане посещаемости сайта. В перечне присутствуют все основные поисковые машины. Далее вам предлагается указать те страницы, которые вы бы не хотели видеть в индексе поисковиков. На этом все, ваш файлик готов, можете выкладывать его к себе на сайт.

Все что от Вас требуется это заполнить форму на нашем сайте и все. В результате вы получите уже готовый текст, который нужно просто вставить в документ и сохранить в корне вашего сайта под именем Robots.txt. При этом у вас есть возможность полностью запретить индексирование своего сайта, хотя вряд ли это кому-то понадобится. Здесь вам нужно будет указать местонахождение карты вашего сайта, а если у вас ее нету, то можно просто не заполнять данное поле. Далее вы можете выбрать поисковые системы, которым дадите право проводить индексирование страниц вашего ресурса. Рекомендуется выбирать все, это даст наиболее положительный эффект в плане посещаемости сайта. В перечне присутствуют все основные поисковые машины. Далее вам предлагается указать те страницы, которые вы бы не хотели видеть в индексе поисковиков. На этом все, ваш файлик готов, можете выкладывать его к себе на сайт.

Есть ли какие-то отличия Robots.txt для Яндекса в сравнении с файлами для других роботов?

На самом деле каждая поисковая машина использует разные методы индексирования, и вообще работают они по-разному. Каждый поисковик имеет свои методики ранжирования, присвоения сайтам определенного места в своем списке. Однако, практически все они одинаково индексируют и понимают файл Robots.txt. Практика свидетельствует, что один файл Robots.txt подходит абсолютно ко всем поисковым системам и с ним не возникает никаких проблем.

Каждый поисковик имеет свои методики ранжирования, присвоения сайтам определенного места в своем списке. Однако, практически все они одинаково индексируют и понимают файл Robots.txt. Практика свидетельствует, что один файл Robots.txt подходит абсолютно ко всем поисковым системам и с ним не возникает никаких проблем.

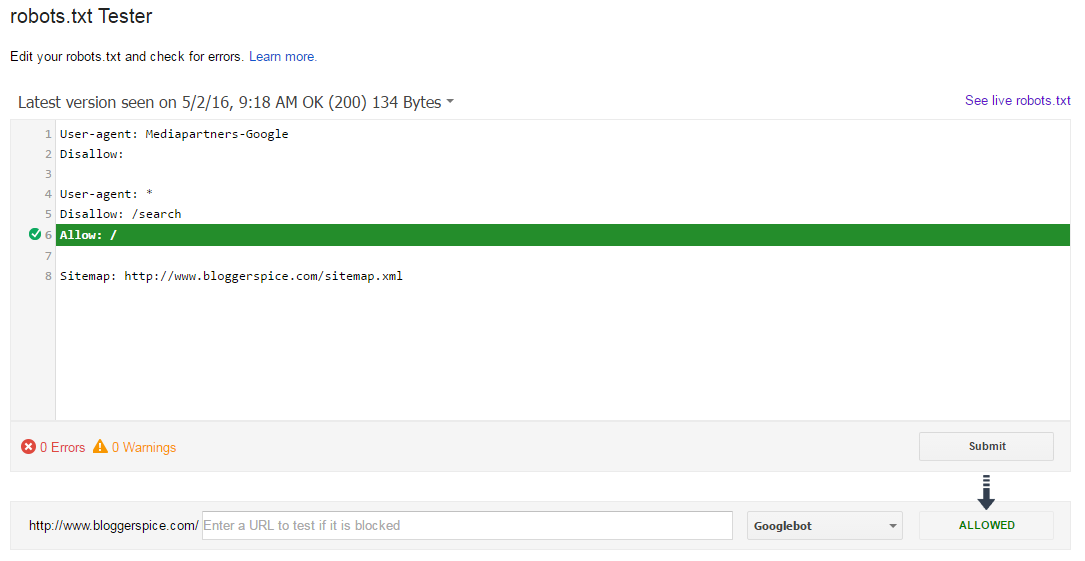

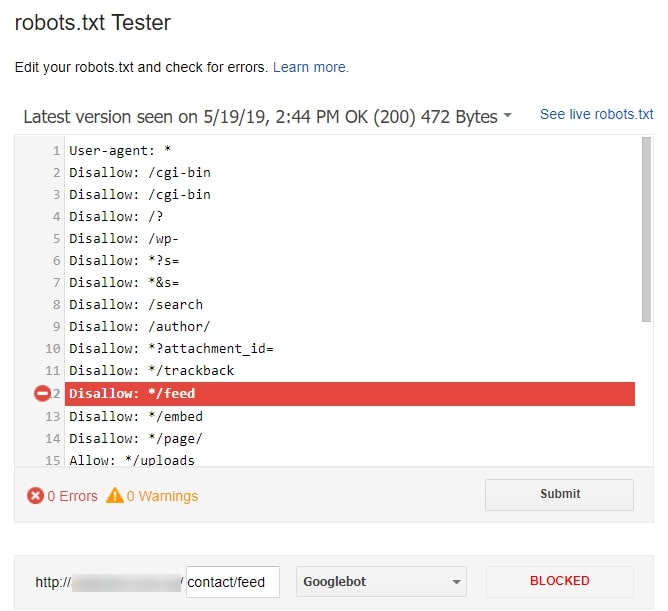

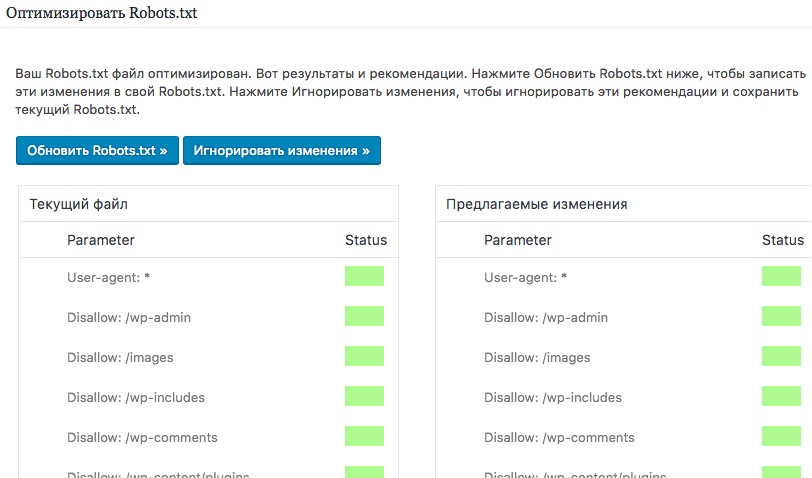

Есть ли возможность проверить существующий файл Robots.txt?

Если вы сами писали данный файл, или использовали другой генератор, и сомневаетесь в его работоспособности, то можете проверить его с помощью специального сервиса на нашем сайте. Если в ходе такой проверки обнаружатся те или иные проблемы, то вы с легкостью сможете сгенерировать новый файлик воспользовавшись нашим инструментом. Специалисты всегда рекомендуют проверять самодельные файлы Robots.txt с помощью уже проверенных генераторов, чтобы избежать возможных проблем в будущем.

Генератор Robots.txt — Создать robots.

txt для сайта и настроить бесплатно – Онлайн сервис

txt для сайта и настроить бесплатно – Онлайн сервис | По умолчанию — All Robots are: | AllowedRefused | |

| Crawl-Delay: | По умолчанию — No Delay5 Seconds10 Seconds20 Seconds60 seconds120 Seconds | |

| Карта сайта (Sitemap): (оставить чистым, если нет) | ||

| Поисковые роботы: | Как по умолчаниюAllowedRefused | |

| Google Image | Как по умолчаниюAllowedRefused | |

| Google Mobile | Как по умолчаниюAllowedRefused | |

| Yandex | Как по умолчаниюAllowedRefused | |

| MSN Search | Как по умолчаниюAllowedRefused | |

| Yahoo | Как по умолчаниюAllowedRefused | |

| Yahoo MM | Как по умолчаниюAllowedRefused | |

| Yahoo Blogs | Как по умолчаниюAllowedRefused | |

| Ask/Teoma | Как по умолчаниюAllowedRefused | |

| GigaBlast | Как по умолчаниюAllowedRefused | |

| DMOZ Checker | Как по умолчаниюAllowedRefused | |

| Nutch | Как по умолчаниюAllowedRefused | |

| Alexa/Wayback | Как по умолчаниюAllowedRefused | |

| Baidu | Как по умолчаниюAllowedRefused | |

| MSN PicSearch | Как по умолчаниюAllowedRefused | |

| Закрыть каталоги от индексирования: | Путь относится к корню и должен содержать в конце слеш (/). «/» «/» | |

Далее: Создайте файл ‘robots.txt’ в корне Вашего сайта. Скопируйте полученное и вставьте в файл.

Robots.txt — специальный текстовый файл, размещаемый в корне каждого сайта. Данный документ содержит подробные инструкции для поисковых роботов относительно того, что им надо индексировать, а что — нет. Правильная настройка Robots.txt обязательна, если Вам необходима корректная индексация Вашего сайта.

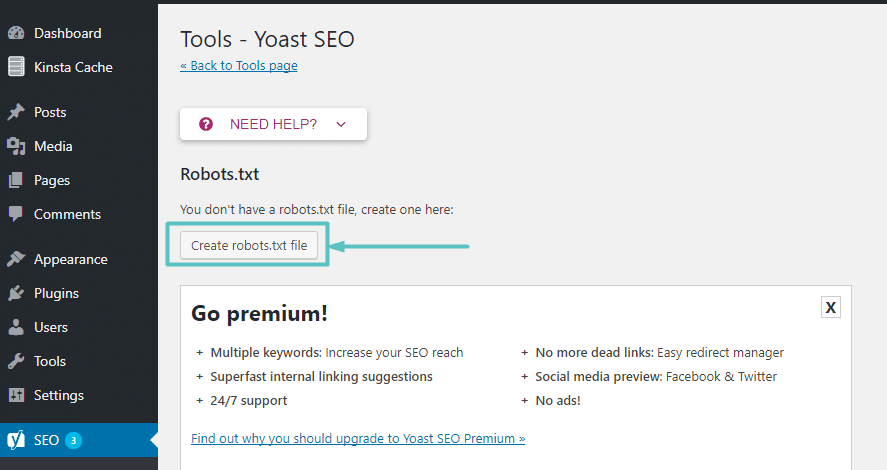

Как создать правильный Robots.txt? Эффективное и быстрое решение для создания и настройки Robots. txt – воспользоваться онлайн сервисом на нашем сайте. В результате работы генератора Robots.txt Вы получите текст, который необходимо сохранить в файл под названием robots.txt и загрузить в корневой каталог Вашего сайта.

txt – воспользоваться онлайн сервисом на нашем сайте. В результате работы генератора Robots.txt Вы получите текст, который необходимо сохранить в файл под названием robots.txt и загрузить в корневой каталог Вашего сайта.

Robots.txt Generator — Создать файл Robot.txt онлайн бесплатно

Опишите, какие области вашего веб-сайта должны и не должны посещаться поисковым роботом в файле robots.txt. Предоставьте нашему инструменту всю необходимую информацию и позвольте ему создать нужный файл, нажав кнопку «Создать Robots.txt».

Robots.txt — это краткая форма, используемая SEO-специалистами и технически подкованными веб-мастерами для описания стандарта исключения роботов. Это означает, что robots.txt инструктирует роботов поисковых систем, какие области веб-сайта им не следует посещать. Для размещения этих инструкций на веб-сайте можно использовать простой и удобный в использовании текстовый генератор robots.

Этот стандарт был предложен в 1994 году Мартином Костером после того, как поисковый робот, написанный Чарльзом Строссом, нанес ущерб сайту Мартейна. Robots.txt стал стандартом де-факто, которому следуют современные поисковые роботы. Однако ложные веб-сканеры, которые нацелены на веб-сайты для распространения вирусов и вредоносных программ, игнорируют файл robots.txt и посещают каталоги веб-сайтов, которые роботы.txt запрещает посещать сканерам. Эти вредоносные роботы будут не только игнорировать инструкции robots.txt, но и посещать страницы и каталоги, посещение которых запрещено. Именно так они распространяют вредоносное ПО и портят сайты.

Robots.txt стал стандартом де-факто, которому следуют современные поисковые роботы. Однако ложные веб-сканеры, которые нацелены на веб-сайты для распространения вирусов и вредоносных программ, игнорируют файл robots.txt и посещают каталоги веб-сайтов, которые роботы.txt запрещает посещать сканерам. Эти вредоносные роботы будут не только игнорировать инструкции robots.txt, но и посещать страницы и каталоги, посещение которых запрещено. Именно так они распространяют вредоносное ПО и портят сайты.

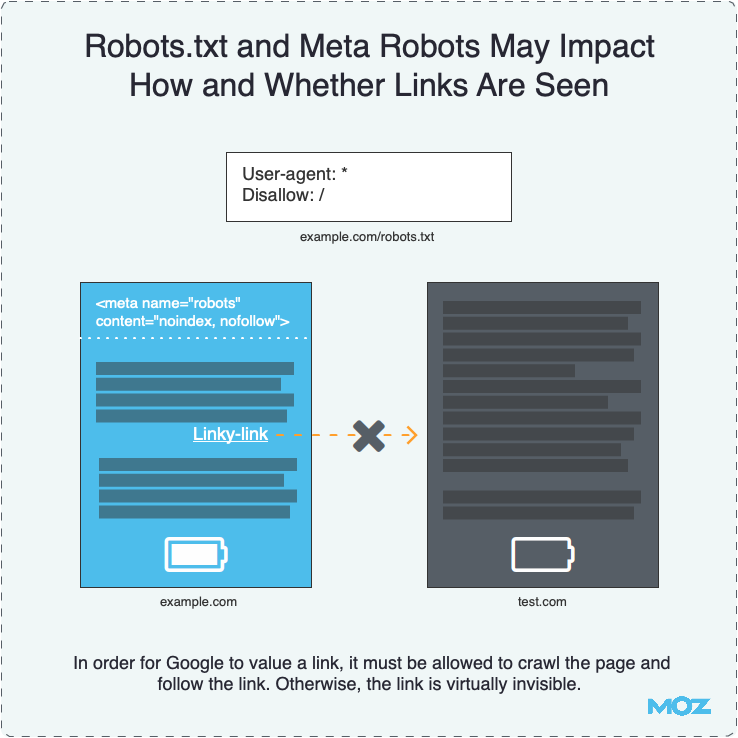

Когда робот поисковой системы хочет посетить веб-сайт, например, предположим, что URL-адрес веб-сайта http://www.examples.com/Greetings.html/, но прежде чем поисковая система начнет оценивать сайт, она проверяет, http: //www.examples.com/robots.txt существует. Он существует и находит эти две строки:

User-agent: *

Disallow: /

Сайт не проверяется и не индексируется. В первой строке файла robots.txt «User-agent: *» содержится указание всем поисковым системам следовать его инструкциям, а во второй строке «Disallow: /» — указание им не посещать какие-либо каталоги сайта.

ВАЖНЫЕ СООБРАЖЕНИЯ

Есть два важных фактора, о которых вы должны знать, а именно:

- Помните, что если вы щелкните правой кнопкой мыши на любом веб-сайте, вы сможете просмотреть его исходный код. Поэтому помните, что ваш файл robots.txt будет виден всем, и любой сможет его увидеть и увидеть, какие каталоги вы запретили поисковому роботу посещать.

- Веб-роботы могут игнорировать файл robots.txt, особенно вредоносные роботы и сборщики адресов электронной почты. Они будут искать уязвимости на сайте и игнорировать инструкции robots.txt.

Типичный robots.txt, предписывающий поисковым роботам не посещать определенные каталоги на веб-сайте, будет выглядеть так:

User-agent: *

Disallow: /aaa-bin/

Disallow: /tmp/

Disallow: / ~mike/

Этот текст указывает роботам поисковых систем не посещать сайт. Вы не можете поместить две функции запрета в одну строку, например, вы не можете написать: Disallow: /aaa-bin/tmp/. Вы должны явно указать, какие каталоги вы хотите игнорировать. Вы не можете использовать общие имена, такие как Disallow: *.gif.

Вы должны явно указать, какие каталоги вы хотите игнорировать. Вы не можете использовать общие имена, такие как Disallow: *.gif.

Не забудьте использовать строчные буквы для имени файла robots.txt, а не «ROBOTS.TXT».

ГДЕ РАЗМЕСТИТЬ ROBOTS.TXT НА ВИРТУАЛЬНОМ ХОСТИ

Виртуальный хост имеет разные значения для разных вещей. Виртуальный веб-хост различает с помощью доменного имени разные сайты, использующие один и тот же IP-адрес. Файл robots.txt можно поместить в код вашего домена, он будет прочитан и выполнен поисковым роботом.

Если вы делите хост с другими пользователями, вам придется попросить администратора хоста помочь вам.

КАК СОЗДАТЬ ROBOTS.TXT

Если вы являетесь SEO-специалистом или технически подкованным веб-мастером, вы можете создать файл robots.txt на компьютере Microsoft, используя notepad.exe или textpad.exe и даже Microsoft Word. Только не забудьте сохранить его как обычный текст.

На Apple Macintosh вы можете использовать TextEdit, используя формат «сделать обычный текст» и сохранить как западный.

В Linux можно использовать vi или emacs.

Создав файл robots.txt, вы можете скопировать/вставить его в раздел заголовка кода заголовка вашего веб-сайта.

ИСПОЛЬЗОВАНИЕ ГЕНЕРАТОРА ROBOTS.TXT ДЛЯ СОЗДАНИЯ ФАЙЛА

Если вы оптимизатор, веб-мастер или разработчик, вы можете получить помощь на сайте searchenginereports.net. Посетите веб-сайт и нажмите «Бесплатные инструменты SEO». Прокрутите список инструментов SEO, пока не нажмете генератор Robots.txt.

Нажмите на значок этого инструмента, и он откроет страницу, отображающую: Генератор Robots.txt.

- По умолчанию — все роботы: по умолчанию «Разрешено».

- Crawl-Delay: по умолчанию — «Без задержки».

- Карта сайта: (оставьте пустым, если у вас ее нет)

- Поисковые роботы: здесь все роботы будут перечислены в отдельных строках, и значение по умолчанию будет таким же, как и значение по умолчанию, то есть «Разрешено».

- Запрещенные каталоги: Здесь вы укажете каталоги, которые вы хотите запретить поисковым роботам.

Не забудьте указать один каталог в каждом поле.

Не забудьте указать один каталог в каждом поле.

После того, как вы ввели свои ограничения; вы можете нажать «Создать Robots.txt» или выбрать «Очистить». Если вы допустили ошибку при вводе требований, нажмите «Очистить» и повторно заполните поля.

Если выбрать параметр «Создать Robots.txt», система создаст файл robots.txt. Затем вы можете скопировать и вставить его в заголовок HTML-кода вашего сайта.

Нет никаких ограничений на количество раз, когда вы можете использовать этот отличный бесплатный инструмент. Если вы забыли добавить каталог для ограничения или хотите добавить новый каталог. Вы можете использовать инструмент генератора txt Robots, чтобы создать новый файл.

Помните, что если вы хотите добавить новый каталог, просто укажите его в списке ограниченных каталогов инструмента генератора txt для роботов. После создания файла скопируйте/вставьте только строку каталога с ограничениями в существующий файл robots.txt в формате HTML.

Вы можете войти во все каталоги с ограниченным доступом, включая старые и новые, и создать новый файл robots. txt, который можно вырезать и вставить после удаления предыдущего файла robots.txt из источника HTML.

txt, который можно вырезать и вставить после удаления предыдущего файла robots.txt из источника HTML.

ЗАКЛЮЧЕНИЕ

Поскольку вы собираетесь вмешиваться в исходный код своего веб-сайта, будьте очень осторожны. Не пытайтесь экспериментировать с созданием robots.txt, вы можете непреднамеренно сломать свой сайт.

Если вы разработали свой веб-сайт в WordPress, вы можете обратиться за помощью к плагину WordPress robots.txt, как создать robots.txt в WordPress и на нескольких других сайтах, включая WordPress.

В HTML вы также можете получить справку из примера robot.txt.

Помните, что robots.txt — это часть, в которой вы даете роботам поисковых систем инструкции, какие каталоги им не следует посещать. Также в файле robots.txt вы можете указать им не переходить по внешним ссылкам вашего сайта. Но вы не можете сгенерировать это с помощью searchenginereports.exe, если только они не помещены в отдельный каталог.

Бесплатный онлайн-генератор robots.

txt — Быстрое создание robots.txt

txt — Быстрое создание robots.txt| Разрешить или запретить всех роботов: Дефолталловрефузе | |

| Задержка сканирования (в секундах): | |

| Карта сайта: | |

| Выберите роботов для разрешения или отказа: | |

| Google Image: Дефолталловрефузе | Google для мобильных устройств: Дефолталловрефузе |

| MSN-поиск: Дефолталловрефузе | Яху: Дефолталловрефузе |

| Яху ММ: Дефолталловрефузе | Блоги Yahoo: Дефолталловрефузе |

| Спросите/Тема: Дефолталловрефузе | Гигавзрыв: Дефолталловрефузе |

| Проверка ДМОЗ: Дефолталловрефузе | Алекса/Обратный путь: Дефолталловрефузе |

| Байду: Дефолталловрефузе | Навер: Дефолталловрефузе |

| MSN PicSearch: Дефолталловрефузе | |

| Запрещенные каталоги: | |

Файл robots. txt: txt: | |

Что такое файл robots.txt

Файл robots.txt — это текстовый файл, который используется для связи с поисковыми роботами и другими автоматизированными агентами, например поисковыми роботами, которые посещают веб-сайт. Файл размещается в корневом каталоге веб-сайта и содержит инструкции для этих агентов, какие страницы или разделы веб-сайта следует сканировать или индексировать.

Формат файла robots.txt прост и понятен. Он состоит из ряда строк «User-agent», за которыми следует одна или несколько строк «Disallow». Строка «User-agent» указывает, к какой поисковой системе или боту применяются инструкции, а строка «Disallow» указывает, какие страницы или каталоги веб-сайта не следует сканировать.

Например, файл robots.txt может содержать следующую строку: User-agent: * Disallow: /private-page/

Это сообщает всем поисковым роботам, что им не следует сканировать или индексировать страницу, расположенную по адресу «http: //www. example.com/private-page/».

example.com/private-page/».

Важно отметить, что, хотя файл robots.txt можно использовать для предотвращения сканирования определенных страниц поисковыми системами, на самом деле он не препятствует доступу пользователей к этим страницам.

Почему файл robots.txt важен

Файл robots.txt сообщает поисковым системам, какие страницы или разделы веб-сайта не следует сканировать или индексировать. Robots.txt важен по нескольким причинам:

- Поисковая оптимизация (SEO): Файл robots.txt не позволяет поисковым системам индексировать дублированный или двигатели фокусируются на самых важных страницах веб-сайта.

- Защита конфиденциальной информации: Файл robots.txt блокирует сканирование поисковыми системами определенных страниц или разделов веб-сайта, что помогает владельцам веб-сайтов защитить конфиденциальную информацию от индексации и публикации.

- Экономия ресурсов сервера: Владельцы веб-сайтов могут запретить поисковым системам сканирование ненужных страниц или разделов веб-сайта с помощью файла robots.

txt, что помогает экономить ресурсы сервера и избегать потенциальной перегрузки сервера.

txt, что помогает экономить ресурсы сервера и избегать потенциальной перегрузки сервера. - Защита конфиденциальности: Владельцы веб-сайтов могут защитить конфиденциальность своих пользователей, заблокировав поисковым системам сканирование страниц, не предназначенных для общего пользования.

- Соответствие требованиям законодательства: файл Robots.txt можно использовать, чтобы запретить поисковым системам сканировать определенные страницы или разделы веб-сайта, чтобы убедиться, что веб-сайт соответствует правовым требованиям, таким как Общий регламент по защите данных (GDPR) или Закон о защите конфиденциальности детей в Интернете (COPPA).

Важно помнить, что хотя файл robots.txt может быть полезным инструментом для улучшения SEO веб-сайта и защиты конфиденциальной информации, он не дает 100% гарантии того, что страница не будет проиндексирована или кэширована поисковыми системами, и не является безопасный способ блокировки страниц.

директивы robotx.txt

В основном файл robots.txt состоит из 4 директив: «User-agent» и «Disallow».

Директива «User-agent»: Используется для указания, к какой поисковой системе или боту относятся инструкции в файле. Например, «User-agent: Googlebot» применит правила из файла к пауку поисковой системы Google. Подстановочный знак «*» можно использовать для применения правил ко всем поисковым роботам.

Директива «Запретить»: Используется для указания того, какие страницы или каталоги веб-сайта не должны сканироваться. Например, «Запретить: /private-page/» не позволит поисковым роботам сканировать страницу, расположенную по адресу «http://www.example.com/private-page/».

Директива «Разрешить»: разрешает индексацию определенных страниц или каталогов. «Разрешить: /public-page/», это позволит поисковым роботам сканировать страницу, расположенную по адресу «http://www.

example.com/public-page/».

example.com/public-page/».Директива «Карта сайта»: Используется для указания местоположения карты сайта на веб-сайте. Например, «Карта сайта: https://www.example.com/sitemap.xml».

Как создать robotx.txt

- Создайте новый текстовый файл с помощью текстового редактора.

- Добавьте в файл следующую строку кода:

User-agent: * (это сообщает всем поисковым системам, что следующие правила применяются ко всем ботам поисковых систем) - Чтобы заблокировать определенную страницу или раздел вашего веб-сайта, добавьте следующую строку кода, заменив «page-path» фактическим путем к странице, которую вы хотите заблокировать:

Запретить: /путь-страницы/ - Чтобы запретить индексацию всех страниц вашего сайта, добавьте следующую строку кода:

Запретить: / - Сохраните файл как robots.txt и загрузите его в корневой каталог вашего веб-сайта.

- После загрузки вы можете проверить, работает ли он, посетив «http://www.

example.com/robots.txt» в браузере.

example.com/robots.txt» в браузере.

Примечание: Будьте очень осторожны при редактировании файла robots.txt, так как ошибка может привести к тому, что поисковые системы перестанут сканировать весь ваш сайт.

Что такое robots.txt Generator

A robots.txt Generator — это инструмент, который помогает владельцам веб-сайтов создавать файл robots.txt для своего веб-сайта. Инструмент предоставляет удобный интерфейс, который позволяет пользователям легко указывать, какие страницы или разделы их веб-сайта должны быть заблокированы для поисковых систем.

Процесс использования генератора robotstxt обычно довольно прост и понятен. Вам будет предложено выбрать, какие страницы или разделы вашего сайта вы хотите заблокировать, после чего генератор создаст соответствующий код для файла robots.txt. Генератор текстовых файлов Somerobots также имеет функцию добавления карты сайта веб-сайта в файл robots.txt.

После создания файла robots. txt его необходимо загрузить в корневую директорию вашего веб-сайта. Обычно это можно сделать с помощью FTP-клиента или через панель управления вашего сайта.

txt его необходимо загрузить в корневую директорию вашего веб-сайта. Обычно это можно сделать с помощью FTP-клиента или через панель управления вашего сайта.

Важно помнить, что хотя генератор robots.txt может быть полезным инструментом, важно понимать основы работы robots.txt и проверять правильность работы файла после его загрузки на веб-сайт.

Зачем использовать онлайн-генератор robots.txt

- Удобство: Создание файла robots.txt с нуля может занять много времени и утомительно, особенно для владельцев веб-сайтов, которые не знакомы с синтаксисом и форматом файла. Генератор текста робота упрощает создание файла, предоставляя простой и удобный интерфейс, который помогает пользователям в процессе.

- Предотвращение ошибок: Создание файла robots.txt вручную может привести к ошибкам, особенно если владелец веб-сайта не знаком с синтаксисом и форматом. Бесплатный генератор robots.txt может помочь предотвратить ошибки, предоставляя предварительно отформатированный файл, который легко понять и настроить.

- Экономия времени: Генератор файлов роботов может сэкономить владельцам веб-сайтов значительное количество времени за счет автоматизации процесса создания файла robots.txt.

- Знание программирования не требуется: Одним из основных преимуществ использования генератора robots.txt является то, что он позволяет владельцам веб-сайтов создавать файл robots.txt без каких-либо навыков программирования.

Как использовать бесплатный генератор robots.txt

- Выберите разрешить/запретить всех роботов сайта.

- Введите задержку сканирования в секундах.

- Добавить карту сайта веб-сайта.

- Выберите разрешение или запрет для роботов различных поисковых систем.

- Вход в каталоги с ограниченным доступом.

- Нажмите кнопку «Создать robots.txt», чтобы сгенерировать текстовый файл robots для Google, и генератор автоматически загрузит файл robots.txt с соответствующим кодом.

Не забудьте указать один каталог в каждом поле.

Не забудьте указать один каталог в каждом поле. txt, что помогает экономить ресурсы сервера и избегать потенциальной перегрузки сервера.

txt, что помогает экономить ресурсы сервера и избегать потенциальной перегрузки сервера. example.com/public-page/».

example.com/public-page/». example.com/robots.txt» в браузере.

example.com/robots.txt» в браузере.