Как правильно создать файл Robots.txt?

Привет, начинающим вебмастерам!

После двух подготовительных уроков (Что такое SEO-продвижение? и Основные понятия SEO) можем переходить к практической части, а вернее к подготовке сайта к продвижению. Сегодня мы разберем вопрос: как создать robots.txt?

robots.txt – это файл в котором содержатся параметры индексирования для поисковых систем.

Создание этого файла является одним из первых шагов к SEO-продвижению. И вот почему.

Для чего нужен robots.txt?

После того, как вы добавите свой сайт в Яндекс и Google (мы пока это не проходили), ПС начнут индексировать все, абсолютно все, что находится в вашей папке с сайтом на сервере. Это не очень хорошо с точки зрения продвижения, ведь в папке содержится очень много не нужного для ПС “мусора”, что негативно скажется на позициях в поисковой выдаче.

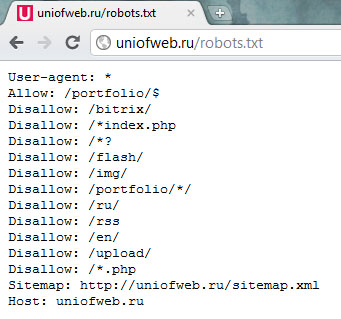

Именно файл robots.txt запрещает индексирование документов, папок и ненужных страниц. Кроме всего прочего, здесь указывается путь к карте сайта (тема следующего урока) и главный адрес, об чуть подробнее.

О карте сайта я говорить много не буду, скажу лишь одно: карта сайта улучшает индексацию сайта. А вот про главный адрес стоит поговорить подробнее. Дело в том, что каждый сайт изначально имеет несколько зеркал (копий сайта) и доступны по различным адресам:

- www.context-up.ru

- context-up.ru

- context-up.ru/

- www.context-up.ru/

При наличии всех этих зеркал сайт становится не уникальным. Естественно, ПС не любят не уникальный контент, не давая таким сайтам подниматься в поисковой выдаче.

Как заполнить файл robots.txt?

Любой файл, предназначенный для работы с различными внешними сервисами, в нашем случае поисковыми системами, должен иметь правила заполнения (синтаксис). Вот правила для robots:

- Название файла robots.txt должно начинаться именно с маленькой буквы. Не нужно называть его ни Robots.txt, ни ROBOTS.TXT. Правильно: robots.txt;

- Текстовый формат “Unix”. Формат свойственен обычному блокноту в Windows, поэтому создать robots.txt достаточно просто;

Операторы robots

А сейчас поговорим, собственно, о самих операторах robots. Всего их около 6 по-моему, но необходимыми являются только 4:

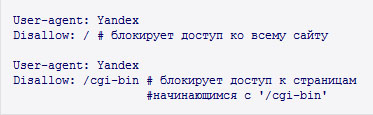

- User-agent. Данный оператор используется для указания поисковой системы, к которой адресуются правила индексации. С его помощью можно указывать разные правила разным ПС. Пример заполнения: User-agent: Yandex;

- Disallow. Оператор, запрещающий индексацию той или папки, страницы, файла. Пример заполнения: Disallow: /page.html;

- Host. Этим оператором указывается главный адрес (домен) сайта. Пример заполнения: Host: context-up.ru;

Таким образом я запретил Яндексу индексировать страницу “page.html”, указал главный домен сайта (context-up.ru) и адрес карты сайта. Теперь поисковый робот Яндекса учтет эти правила и страницы “page.html” никогда не будет в индексе.

User-agent

Как уже было сказано выше, в User-agent указывается поисковая система, к которой будут использованы правила индексации. Вот небольшая табличка:

| Поисковая система | Параметр User-agent |

| Яндекс | Yandex |

| Mail.ru | Mail.ru |

| Rambler | StackRambler |

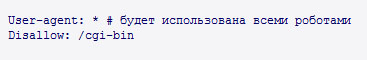

Если вы хотите, чтобы правила индексации применялись для всех ПС, то нужно сделать такую запись:

User-agent: *

То есть, использовать, как параметр, обычную звездочку.

Disallow

С этим оператором чуть посложнее, поэтому нужно быть осторожным с его заполнением. Прописывается после оператора “User-agent”. Любая ошибка может привести к очень плачевным последствиям.| Что запрещаем? | Параметр | Пример |

| Индексацию сайта | / | Disallow: / |

| Файл в корневом каталоге | /имя файла | Disallow: /page.html |

| Файл по определенному адресу | /путь/имя файла | Disallow: /dir/page.html |

| Индексация папки | /имя папки/ | Disallow: /papka/ |

| Индексация папки по определенному адресу | /путь/имя папки/ | Disallow: /dir/papka/ |

| Документы, начинающиеся с определенного набора символов | /символы | /symbols |

| Документы, начинающиеся с определенного набора символов по адресу | /путь/символы | /dir/symbols |

Еще раз говорю: будьте крайне внимательны при работе с данным оператором. Случается и такое, что чисто случайно человек запрещает индексацию своего сайта, а потом удивляется тому, что его нет в поиске.

Про остальные операторы говорить смысла нет. Того, что написано выше вполне достаточно.

Вам, наверное, хотелось бы получить пример robots.txt? Ловите:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /tag Host: site.ru Sitemap:site.ru/sitemap.xml

Кстати, этот пример могут использовать, как настоящий файл robots.txt, люди, чьи сайты работают на WordPress. Ну а те, у кого обычные сайты, пишите сами, ха-ха-ха. К сожалению, одного единственного для всех не существует, у каждого он свой. Но с той информацией, которую я вам дал, создать robots.txt не составит большого труда.

До свидания, друзья!

Robots.txt: Как создать и Проверить файл Роботс

Файл robot.txt – необходим для большинства сайтов.Каждый SEO-оптимизатор должен понимать смысл этого файла, а также уметь прописывать самые востребованные директивы.

Правильно составленный robots улучшает положение сайта в поисковой выдаче и, среди прочих методов продвижения, является эффективным инструментом SEO.

Чтобы разобраться в том, что такое robot.txt и как он действует, вспомним, как работают поисковики.

Алгоритмы Google Яндекса и других систем выполняют два основных задания:

- обход интернета для поиска новой информации;

- индексирование контента, чтобы его могли находить пользователи.

Чтобы посетить все сайты, поисковые системы используют доменные имена, переходят с одного ресурса на другой, изучают миллиарды ссылок.

Такое поведение напоминает паука в паутине: он обходит территорию и смотрит, что нового попало в сеть.

После прибытия на веб-сайт, но перед его индексацией, алгоритм поисковика (робот, бот, сканнер) смотрит файл robots.txt.

Если он существует, бот сначала читает его, а потом, в соответствии с инструкциями, продолжает исследовать сайт.

Robots.txt содержит информацию о том, как поисковая система должна сканировать найденные страницы и что с ними делать.

Если файл не содержит директив, запрещающих действие агента (или его нет совсем), бот продолжит индексировать все данные на сайте.

ГЛАВА 1:

Первое знакомство с Robots.Txt

Что такое Robots.txt и с чем его едят?Некоторые пользовательские агенты могут игнорировать robots.txt.

В какой кодировке создают Robots.txt?

Robots.txt — это текстовый файл, созданный веб-мастером для инструктирования поисковых роботов.

В нем прописаны рекомендации касательно того, как сканировать страницы на данном сайте.

Говоря простым языком – в этом файле указано, куда не надо заходить поисковому роботу, что индексировать для поиска, а что нет.

По сути, это простой текстовый файл, который создают в корневом каталоге сайта.

Всякий раз, когда поисковые агенты приходят на сайт, они ищут робота в одном конкретном месте: основной каталог (обычно корневой домен).

Если пользовательский агент посещает www.nashsite.com/robots.txt и не находит там его, он предполагает, что на сайте этого файла нет вообще и продолжает сканирование всего, что там расположено.

Файл чувствителен к регистру, он должен иметь название «robots.txt» (а не Robots.txt, robots.TXT или иначе).

Некоторые пользовательские агенты могут игнорировать robots.txt.

Это особенно характерно для пиратских сканеров или парсеров адресов электронной почты.

Это общедоступный файл, его может увидеть любой пользователь, поэтому не используйте его, чтобы скрыть особо важную информацию.

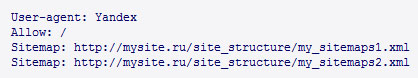

В нижней части файла чаще всего указывают, где лежит карта сайта.

Если у Вас сайт (домен) с поддоменами, то в каждом из них в корне должны быть отдельные robots.txt.

Это означает, что и blog.nashsite.com, и nashsite.com должны иметь свои файлы: blog. nashsite.com/robots.txt и nashsite.com/robots.txt.

Памятка: если robots.txt был создан и существует по адресу: nashsite.com/index/robots.txt, www.nashsite.com/homepage/robots.txt, или в иных, не корневых папках, он не будет принят во внимание.

Robots.txt создают в стандартной кодировке UTF-8.

Это важно, потому что другие кодировки поисковые системы могут воспринимать некорректно.

Все, что записано в нем, работает для интернет-протоколов FTP, HTTP и HTTPS.

А если вдаваться в технические подробности, файл robots.txt – это документ в форме Бекса-Наура, которая востребована в различных языках программирования для описания синтаксиса.

Памятка: размер файла Robots.txt для Google ограничен 500Kb

В файле robots есть инструкции как поисковые системы должны обращаться со страницами сайта.

Зачем это нужно?

Для SEO, если на страницах есть ссылки на сторонние ресурсы, не уникальный контент или информация, которую не нужно индексировать.

Ответы на частые вопросы по ссылкам можно получить из нашего видео:

Также в robots.txt можно прописать отдельные правила для различных поисковиков, далее мы подробно рассмотрим, как это делается.

Как создать правильный файл Robots.txt?

Привет всем, как настроение дорогие друзья? У меня все отлично, пытаюсь с первых дней нового года задать оптимальный импульс работы, что бы все успеть в новом 2014 году. И вот она новая статья, в которой я решил поговорить про раскрутку сайта, а если быть точнее, то сегодня мы попытаемся приучить такие поисковые системы как Yandex и Google с помощью файла robots txt.

Мы начали с вами писать статьи, так же писать статьи оптимизированные под поисковые системы, создали собственную RSS ленту, теперь настало время создать robots.txt для WordPress. Для чего он нужен? Также в конце статьи вы сможете скачать правильный robots.txt для WordPress.

Для чего нужен файл robots.txt ?

Файл robots.txt был придуман для запрета индексации определенных страниц или разделов сайта. Чуть ниже объясню на примерах, а сейчас представьте. Вы создали сайт, но так получилось, что некоторые страницы не должны показываться в поисковых системах, тому могут быть разные причины, именно для этого и существует robots txt.

Зачем нужен файл robots.txt? Пример №1:

Посмотрите на моем примере: раньше на мой сайт можно было зайти по 2 адресам — wpmen.ru и www.wpmen.ru. Теоретически это один и тот же адрес, если вы припишете к любому сайту www, то вы а любом случае попадете на основной сайт, если даже главный домен прописан без www. Это старая приставка, которая тихо-мирно вымирает из интернет-сегмента.

Но не смотря на это, для поисковых систем wpmen.ru и www.wpmen.ru это 2 совершенно разных сайта. И представьте, что о вас подумает например Yandex, если увидит 2 абсолютно идентичных сайта, прям все точь — в точь…

Запрет страниц в robots.txt Пример №2:

Раньше, большой проблемой для вебмастеров был нумератор страниц с статьями внизу страницы, причем главная страница полностью совпадала с номером 1. Думаю вы догадались о чем идет речь, а поисковые системы определяют эти 2 страницы разными, и на них собственно полностью одинаковый контент.

В свою очередь поисковые системы сильно занижали главную страницу в выдаче, регламентируя это дублированием контента. Иногда даже попадались фильтры, если веб-мастер долго не реагировал на эту ошибку. К счастью сейчас эта проблема встречается редко, потому что современные шаблоны самостоятельно исправляют эту проблему.

Правильный robots.txt, пример:

И так, ловите пример правильного robots.txt:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tagUser-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: wpnew.ru

Sitemap: http://wpmen.ru/sitemap.xml.gz

Sitemap: http://wpmen.ru/sitemap.xml

Давайте немного разберем что к чему: User-agent — это критерий для ввода поисковой системы. Если вы хотите ввести данные абсолютно для всех поисковых систем, то нужно ввести: User-agent: * Звездочка в свою очередь снимает все ограничения и само собой вводит эти правила для всех поисковых систем.

Если вы хотите указать данные для какой-то конкретной поисковой системы, то за место звездочки нужно написать название поисковой системы. Например: User-agent: Yandex . Не все так просто, каждый поисковик имеет своего бота, который также называется по разному, вот основные из них:

Google (google.com) — Googlebot;

Yandex (yandex.ru) — Yandex;

Рамблер (rambler.ru) — StackRambler;

Mail (mail.ru) — Mail.Ru;

Yahoo! и AOL (yahoo.com и aol.com) — Slurp;

Bing (bing.com) — MSNBot;

Alexa (alexa.com) — ia_archiver;

Ask (ask.com) — Teoma;

К сожалению это еще не весь список поисковых ботов. Многие поисковые системы имеют несколько поисковых ботов, с несколькими именами. Например у Яндекса есть обычный поисковый бот, бот по зеркалам, бот по картинкам, видеозаписям и так далее. Полный список ботов вы сможете найти на специализированном сайте о Robots.txt.

Примеры с разбором правильного файла robots.txt:

Давайте рассмотрим несколько примеров, после чего вы научитесь самостоятельно создавать файл Robots.txt:

- «Allow: » — разрешает индексацию файлов или страниц указанных после двоеточия.

- «Disallow: » — запрещающий индексацию директив, но, если после двоеточия оставить пустое место, то он разрешает индексацию всего сайта.

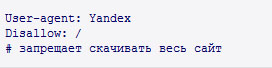

- «Disallow: / » — полностью запрещает поисковым системам добавлять в индекс страницы сайта.

- «Disallow: /picture/ » — Запрещает добавлять в индекс, а так же просматривать папку /picture/ и все последующие каталоги, которые входят в него.

- «Disallow: /picture » — Заперт просмотра каталога /picture, а так же всех файлов, папок и так далее, которые имеют в своем названии слово picture ( /pictures, /picture11, /picture.jpg, /picture.htm и т.д).

- «Disallow: *.php » — запрет просмотра всех файлов формата PHP.

Скачать готовый файл robots.txt для WordPress:

Ну и наконец то самое главное, для ленивых и ищущих самые легкие пути. Предоставляю вам готовый, правильный файл robots.txt для WordPress. Единственное что вам придется сделать — это: В разделе Host вписать главное зеркало своего сайта. Это делается для того, что бы избавится от ошибки, которую я описывал выше и вписать ссылки которые ведут на карты сайта, в разделе Sitemap.

Скачать Robots.txt для WordPress Бесплатно.

Проверка Robots.txt с помощью Яндекса:

После того как вы закачали файл в главную папку вашего сайта, его необходимо проверить. Для этого мы будем использовать сервис Яндекс.Вебмастер. Вы должны войти в него со своей учетной записи, где уже подтверждены права на ваш сайт. И перейти на страницы: Настойка индексирования -> Анализ robots.txt

После чего нажимаем «Загрузить robots.txt с сайта» и проверить. Если не появилось никаких красных текстов и файл отображается в точности таким же, каким вы его создавали, то он учитывается Яндексом правильно, а следовательно и другими поисковыми системами тоже.

Также специально для поисковых систем предлагаю вам прочитать статью о том, как создать карту сайта для поисковых систем. Данный урок так же поможет вам в развитии вашего сайта среди поисковых систем *cool*

На этом все дорогие друзья, не пропустите следующие, еще более интересные и полезные уроки, подписывайтесь на бесплатную рассылку уроков 😉 Всего вам наилучшего, до скорых встреч

Robots.txt. Создать правильный robots.txt – для продвижения сайтов. Анализатор robots.txt, основные директивы.

В ходе работ по продвижению сайта появляется необходимость закрытие от поисковых систем ряда страниц, которые не несут полезной информации для пользователей, мешают корректной индексации и ранжированию сайта или могут содержать данные, попадание которых в открытый доступ необходимо избежать. Появляется необходимость самостоятельно показать поисковым системам, какие части сайта не следует индексировать и размещать поиске. Подобные инструкции прописываются в специальном файле на сайте – robots.txt.

Robots.txt – специальный текстовый файл, расположенный в корневом каталоге сайта и содержащий инструкции для поисковых систем. В файле robots.txt можно указать информацию как для каждой поисковой системы в отдельности, так и для всех поисковиков сразу.

Как создать robots.txt?

Файл robots.txt легко создать при помощи любого текстового редактора, например Блокнот. Для этого достаточно создать новый файл с именем «robots.txt», и заполнить его всеми необходимыми директивами. После того, как файл создан, его необходимо поместить в корневой каталог вашего сайта.

Основные директивы robots.txt

User-agent – директива, где указываются наименования поисковых роботов, к которым будут применяться написанные ниже правила. Для того чтобы написанные инструкции использовали все роботы, поддерживающие robots.txt , достаточно указать в директиве User-agent значение «*»:

Если написанные директивы предназначаются определенным поисковым роботам, то в User-agent пишут их названия:

Информацию по поисковым роботам Google можно получить тут, по поисковым роботам Яндекса тут.

Disallow – директива, позволяющая запретить доступ роботов поисковых систем к конкретным страницам и разделам сайта. Директиву Disallow используют для того, чтобы скрыть страницы или разделы, которые не имеют информационной значимости для пользователей (технический разделы сайта, дублирующийся контент и т.п.). Также данная директива позволяет закрыть информацию, которая не должна попасть в общий доступ (личные данный пользователей и т.д.):

При помощи директивы Disallow можно запретить доступ поисковых роботов ко всему сайту целиком:

При запрете индексации всего сайта – она полностью пропадает из поиска.

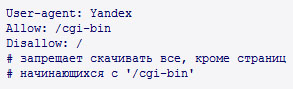

Allow – директива, которая позволяет разрешить доступ поискового робота к странице или разделам сайта. Часто данная директива используется, когда надо открыть для роботов небольшое количество страниц раздела, который планируется закрыть при помощи директивы Disallow:

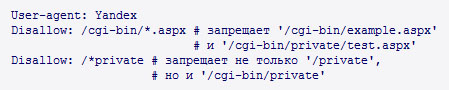

Спецсимвол «*» – обозначает любую последовательность символов. Применяется, если необходимо закрыть (открыть) большое количество страниц с общим набором некоторых символов:

По умолчанию любое правило в robots.txt заканчивается «*».

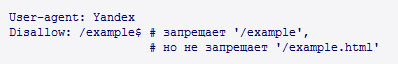

Спецсимвол «$» – используется для того, чтобы отменить использование спецсимвола «*» в конце правила:

Sitemap – директива необходимая, если для улучшения индексации сайта используется файл sitemap.xml. При помощи директивы Sitemap можно указать путь к месту расположения одной или нескольких xml-карт сайта:

В дальнейшем, данные из sitemap.xml будут использоваться для индексации сайта.

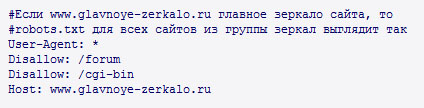

Host – директива, используемая для указания главного зеркала сайта. Если у сайта есть несколько зеркал, то они будут объединены в специальную группу. В таком случае в поиске будет выдаваться только адрес главного зеркала. Для того чтобы у робота-зеркальщика Яндекса не было проблем с определением главного сайта, необходимо указать его в директиве Host файла robots.txt каждого сайта-зеркала:

Директива Host в файле robots.txt указывается после директив Allow и Disallow

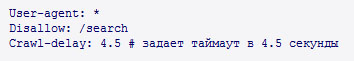

Crawl-delay – директива, которая позволяет указать поисковым роботам минимальное время (в секундах) между скачиванием страниц. Данную директиву следует использовать в случае сильной нагрузки на сервер:

Директива Crawl-delay в файле robots.txt пишется после директив Allow и Disallow.

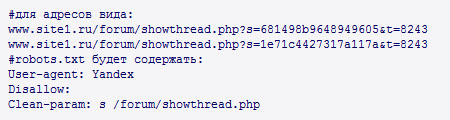

Clean-param – директива позволяющая избежать многократной закачки дублирующихся страниц, возникших из-за не изменяющих содержание динамических параметров. Использование директивы Clean-param снижает нагрузку на сервер, а также позволяет избавиться от одной из основных технических проблем, мешающих успешному продвижению сайтов в Яндексе – внутренних дублей страниц:

Наиболее частое применение данная директива получила при наличии на сайте идентификаторов сессий.

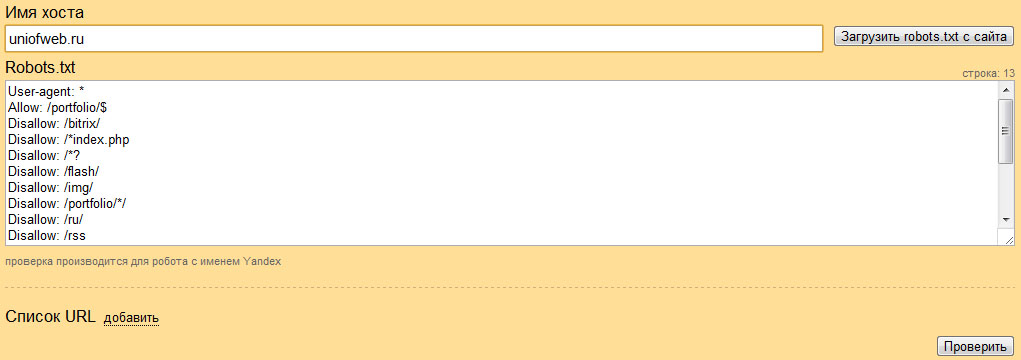

Анализатор файла robots.txt

Небольшая опечатка в файле robots.txt может привезти к исчезновению из индекса поисковых систем важных для пользователя разделов. Для того чтобы избежать этого рекомендуется использовать специальный сервис, позволяющий убедится, что robots.txt создан правильно.Воспользоваться анализатором robots.txt можно здесь.

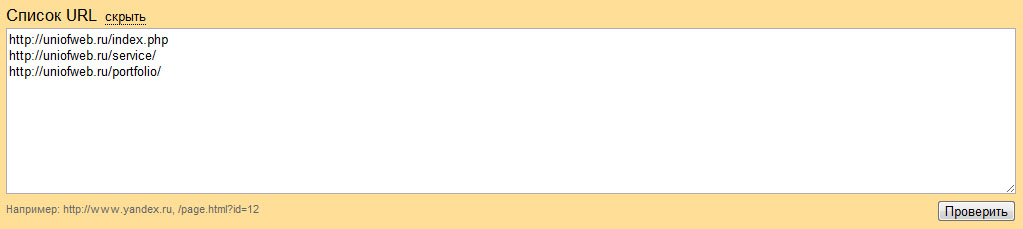

Для того чтобы проанализировать правильность составление файла robots.txt, необходимо в поле «Имя хоста» написать домен сайта, а в поле «Robots.txt» перенести данные из созданного файла. Если файл robots.txt уже загружен на хостинг, то достаточно нажать кнопку «Загрузить robots.txt с сайта» и данные появятся автоматически:

Теперь, чтобы проверить правильность составления файла robots.txt, необходимо сделать проверку наиболее важных страниц (разделов) сайта, которые должны быть открыты, а также добавить для проверки страницы, которые необходимо закрыть. Нажимаем кнопку «добавить» и копируем список проверяемых адресов (допускается использовать как абсолютные, так и относительные адреса страниц):

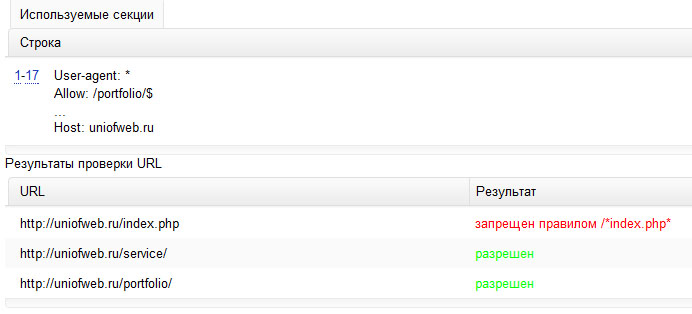

Как только все необходимые адреса внесены в поле ввода, жмем кнопку «Проверить»:

Если все предназначенные для закрытия адреса запрещены к индексации, а полезные разделы и страницы – разрешены, то файл robots.txt составлен без ошибок. Если разделы сайта оказались некорректно закрыты (открыты), то необходимо просмотреть файл robots.txt на наличие ошибок, либо добавить соответствующие директивы Disallow (Allow).

Файл robots.txt можно загружать на сайт (или обновлять информацию в существующем) только после того, как анализатор подтвердил правильность его составления: что должно быть закрыто – запрещено, что должно быть открыто – разрешено.