Для чего нужен и как правильно составить файл robots.txt?

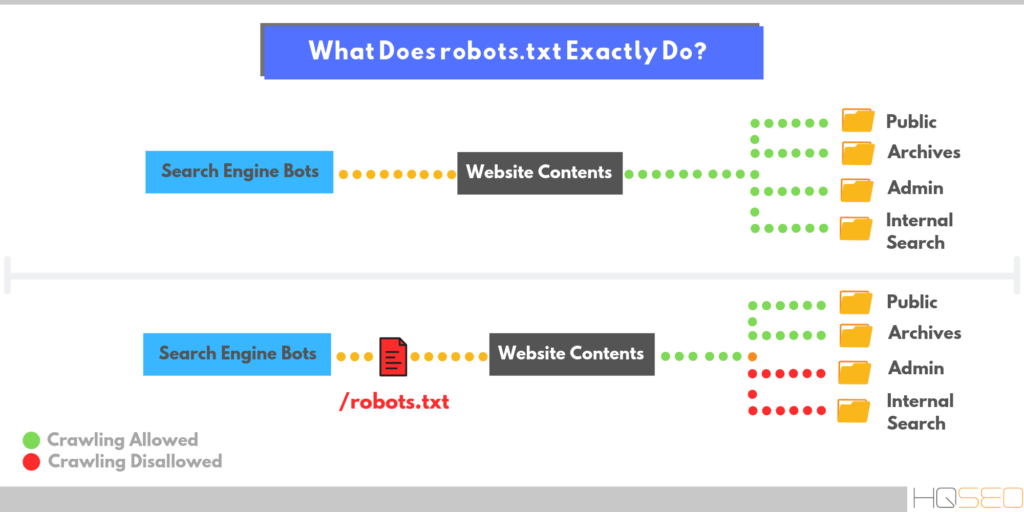

Файл robots.txt — это документ состоящий из латинских символов, хранящийся на сервере и предназначенный для рекомендации поисковым системам, какие страницы стоит сканировать.

Для чего нужен файл robots.txt?

- определение страниц для индексации

- снижение нагрузки на сервер за счет запрета доступа к сайту для поисковых систем

- определение пути к карте сайта и основного зеркала

- указание правил для обхода определенного ресурса

Как выглядит файл robots.txt?

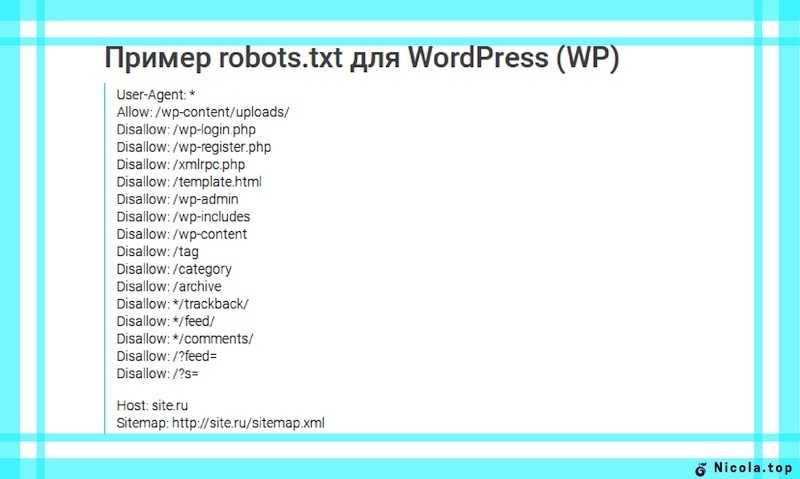

Представим пример базового файла robots.txt:

Sitemap: http://www.mysite.ru

User-agent:*

Allow: /admin/

Allow: /home/

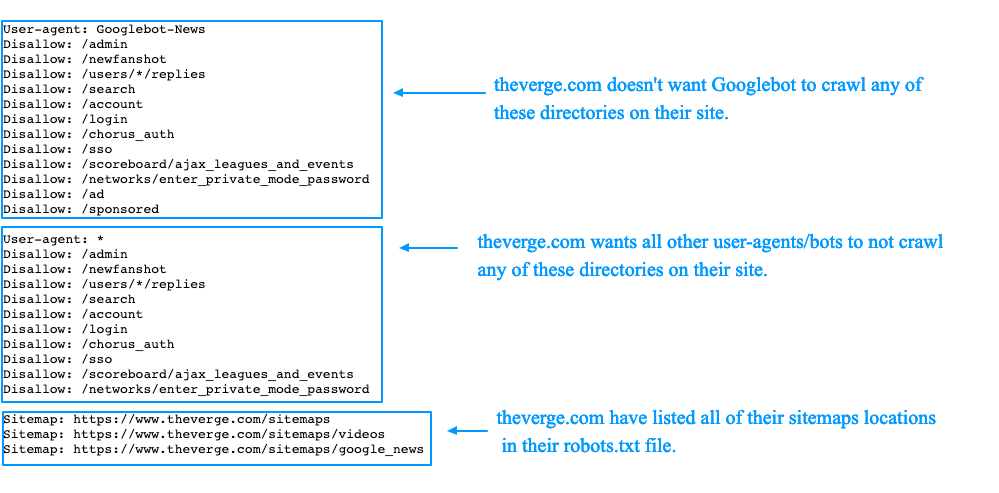

1. Sitemap — это URL карты сайта. Для всех User-agent действует один адрес. В файле robots.txt можно указать количество карт сайтов, которое Вам требуется.

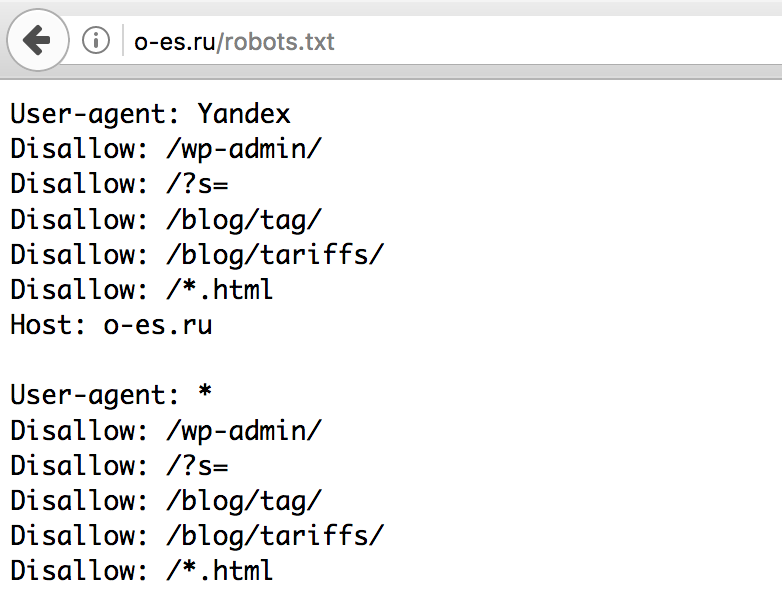

2. User-agent — обращение к поисковым ботам. Указывается список ботов, к которым применяются следующие правила, например:

- «*» — обозначает инструкции ко всем поисковым ботам

- «Googlebot» — обозначает инструкции только к Google

- «Yandex» — обозначает инструкции только к Яндексу.

3. Директивы — инструкции, прописанные для User-agent, которым он должен следовать. Перечислим некоторые директивы:

- Disallow — используется для того, чтобы ограничить доступ к ресурсу по какому-либо пути

- Allow — используется для того, чтобы открыть доступ к ресурсу

- Crawl-delay — используется для задержки сканирования. Не поддерживается для Google

- Noindex — запрещает индексацию ресурса и исключает его из поисковых систем

- Nofollow — запрещает переходить по всем ссылкам на странице

- Host — указывает основное зеркало

- Clean-param — запрещает индексировать параметры адреса страницы.

Работает исключительно для Яндекса.

Работает исключительно для Яндекса.

Как создать файл robots.txt ?

Файл robots.txt — это тестовый файл txt с названием robots.txt. Его можно написать, например в блокноте. Знак «$» используется для того, чтобы сохранить окончание URL. Отдельная директива должна начинаться с новой строки. В файл можно вписать комментарий для веб-мастеров, он должен начинаться с новой строки, со знака «#».

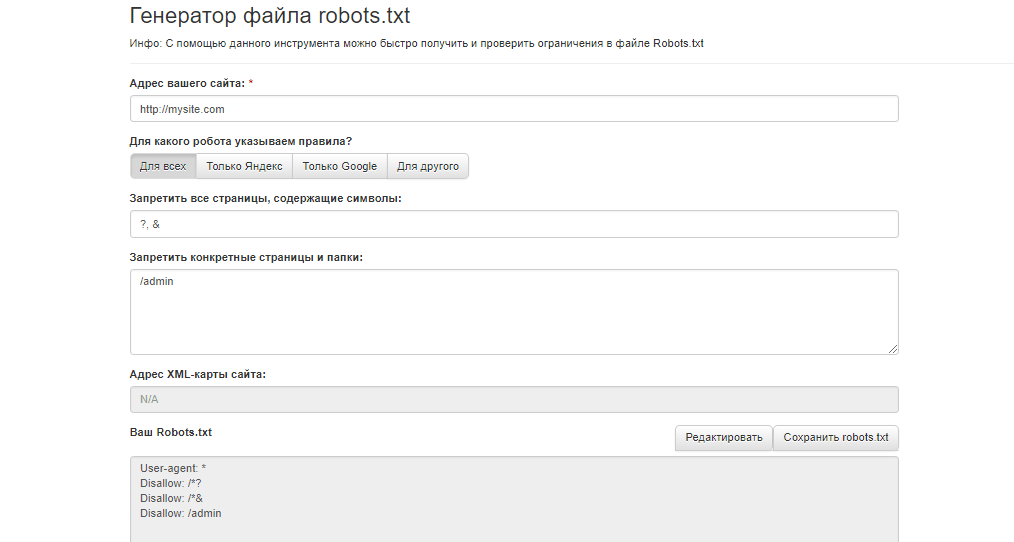

Также существуют онлайн сервисы, которые генерируют robots.txt по заданным параметрам. Например SEOlib (

Файл robots.txt должен быть размещен в корневом каталоге субдомена, в рамках которого он должен действовать и должен открываться по адресу сайта. Допустим сайт имеет адрес: https://handyhost.ru/, то файл должен открываться по адресу https://handyhost.ru/robots. txt.

txt.

Как закрыть сайт для индексации от поисковых ботов Вы можете узнать на нашем сайте.

В файле robots использование кириллицы запрещено. Поэтому нужно преобразовывать кириллицу в PunyCode, а адреса страниц указывать в кодировке, которая соответствует структуре ресурса.

Существует сервис по преобразованию URL на кириллице — Simple Seo Solutions (https://www.design-sites.ru/utility/url-encoding.php

).Неверно:User-agent: Yandex

Disallow: /магазин

Sitemap: http://первыйсайт.рф/sitemap.xml

Верно:User-agent: Yandex

Disallow: /xn—80aairftm

Sitemap:http://%D0%BF%D0%B5%D1%80%D0%B2%D1%8B%D0%B9%D1%81%D0%B0%D0%B9%D1%82.%D1%80%D1%84/sitemap.xml

Файл robots.txt при создании сайтов

Я полагаю, что те из Вас, кто решил создать собственный сайт своими силами, уже знают о многих тонкостях web-строительства. Но многие начинающие разработчики часто пренебрегают одним элементом, а именно файлом «robots.txt».

Но многие начинающие разработчики часто пренебрегают одним элементом, а именно файлом «robots.txt».

Между тем, создание сайтов требует к себе трепетного отношения, в котором нет места мелочам. Успех проекта напрямую зависит от грамотного построения всех составляющих, включая мелочи и детали. Итак, файл «robots.txt». Он используется для того, чтобы дать указания поисковым роботам, какие страницы Вашего сайта им можно индексировать, а какие нельзя.

Запрет роботам поисковых систем индексировать страницы может понадобиться, если, например, страницы содержат приватную информацию, или же эта страница заполнена ссылками, и вы не хотите делать их видимыми, то есть «обратными».

Файл «robots.txt» – это обычный текстовый документ, который может быть только один и размещается в корневом каталоге сайта (то есть иметь путь относительно имени сайта /robots.txt). Перед обращением к страницам Вашего сайта поисковые роботы сначала ищут файл «robots.txt», который запрещает им доступ к указанным Вами разделам ресурса. Форма записи в этом атрибуте чрезвычайно простая. Файл состоит из записей, разделенных пустыми строками.

Форма записи в этом атрибуте чрезвычайно простая. Файл состоит из записей, разделенных пустыми строками.

Первая строка правила содержит информацию о сетевом роботе User-agent: и имя этого робота (если правило распространяется на всех роботов, то ставится звездочка *). Следующие строки содержат информацию об запрещенных или разрешенных для индексации файлов (Disallow:). Если имя файла отсутствует, то индексация разрешена. Каждой инструкции Disallow соответствует одна директория. Если нужно закрыть несколько директорий, то для каждой необходимо писать свою инструкцию Disallow.

Запрет индексации всего сервера

Для того, чтобы запретить индексацию всего сервера необходимо создать файл robots.txt., содержащий следующее:

User-agent: *

Disallow: /

В первой стоке определяется правило для всех роботов *, а во второй задается запрет на доступ от корневой директории и выше.

Запрет индексации для одного робота

User-agent: Googlebot

Disallow: /

Разрешение индексации всего сервера

Для того, чтобы разрешить индексацию всего сервера пишем:

User-agent: *

Disallow:

Аналогичного эффекта можно добиться, создав пустой файл robots. txt.

txt.

Разрешение индексации только для одного робота

User-agent: WebCrawler

Disallow:

User-agent: *

Disallow: /

Запрет индексации отдельных директорий

Для запрета индексации отдельных директорий они записываются по одной после директивы Disallow:

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /private/

Запрет индексации отдельных файлов

Одним из способов является размещение всех необходимых для запрета файлов в отдельную директорию и установки на нее запрета индексации. Или же просто перечислить все запрещаемые файлы:

User-agent: *

Disallow: /~user/private.html

Disallow: /~user/emails.html

Disallow: /~user/contacts.html

Следует дополнить, что в запрете на индексацию нет ничего запретного, просто иногда на сайте содержится информация, не имеющая для поисковика никакой ценности. Поэтому, ограничив доступ к определенным файлам и папкам, мы тем самым уменьшаем время индексации сайта, оптимизируем работу поискового робота. Создание сайтов помогает зарабатывать деньги, А файл «robots.txt» помогает сайту. Этот элемент может показаться неважным и малозначимым, однако на деле он вносит очень существенный вклад в индексацию и продвижение сайта.

Создание сайтов помогает зарабатывать деньги, А файл «robots.txt» помогает сайту. Этот элемент может показаться неважным и малозначимым, однако на деле он вносит очень существенный вклад в индексацию и продвижение сайта.

Файловый редактор robots.txt — Функции Yoast SEO • Yoast

Управляйте возможностью сканирования прямо из Yoast SEO

Yoast SEO содержит сложные настройки мета-тегов robots, которые позволяют вам решать, куда поисковые системы будут перемещаться на вашем веб-сайте. В большинстве случаев этих настроек достаточно, чтобы получить контроль над просматриваемостью вашего сайта. Но у нас также есть решение для конкретных технических задач, требующих доступа к файлу robots.txt или .htaccess.

Yoast SEO дает вам полный контроль с помощью файлового редактора

- Контролируйте возможности сканирования

- Устранение конкретных технических проблем

- Мощный, но простой в использовании

Yoast SEO настроен так, чтобы упростить сканирование. Но что, если у вас есть определенные технические проблемы, которые необходимо исправить с помощью файла robots.txt или .htaccess? Мы покрываем и эти случаи! С помощью инструментов Yoast SEO вы можете редактировать файлы robots.txt и .htaccess. Делая это, вы можете получить еще больший контроль над тем, как ваш сайт сканируется!

Но что, если у вас есть определенные технические проблемы, которые необходимо исправить с помощью файла robots.txt или .htaccess? Мы покрываем и эти случаи! С помощью инструментов Yoast SEO вы можете редактировать файлы robots.txt и .htaccess. Делая это, вы можете получить еще больший контроль над тем, как ваш сайт сканируется!

Зачем мне редактировать файлы robots.txt или .htaccess?

Хотя мы предоставляем эту опцию в плагине Yoast SEO, мы рекомендуем вам использовать ее, только если вы знаете, что делаете. В большинстве случаев достаточно заблокировать доступ поисковых систем к определенным страницам, добавив метатеги robots или HTTP-заголовки robots. Однако мы понимаем, что в некоторых случаях могут возникать сложные технические проблемы, требующие редактирования файла robots.txt. Для таких случаев мы сделали возможным редактирование файлов robots.txt и .htaccess.

Ранг с вашими высококачественными страницами

На больших или сложных сайтах поисковые системы могут иногда ограничивать количество URL-адресов, которые они готовы сканировать и потреблять. Этот предел иногда называют «краулинговым бюджетом». В зависимости от размера и репутации вашего веб-сайта они могут решить выделить больше (или меньше) ресурсов для сканирования ваших страниц. Если на вашем сайте есть страницы, которые нуждаются в SEO-оптимизации, вы можете заблокировать доступ к ним сканеров. Таким образом, вы даете поисковым роботам больше возможностей для доступа к страницам, которые вы хотите ранжировать.

Этот предел иногда называют «краулинговым бюджетом». В зависимости от размера и репутации вашего веб-сайта они могут решить выделить больше (или меньше) ресурсов для сканирования ваших страниц. Если на вашем сайте есть страницы, которые нуждаются в SEO-оптимизации, вы можете заблокировать доступ к ним сканеров. Таким образом, вы даете поисковым роботам больше возможностей для доступа к страницам, которые вы хотите ранжировать.

Заблокируйте доступ к страницам, к которым вы не хотите, чтобы поисковые роботы имели доступ

На вашем веб-сайте также есть страницы, которые не влияют на ваш рейтинг, но они необходимы для функционирования вашего веб-сайта. Например, у вас могут быть внутренние результаты поиска, страницы администрирования, страницы учетных записей, корзины покупок и т. д. Вы можете заблокировать доступ сканеров к этим страницам с помощью файла robots.txt. Это может улучшить техническое SEO вашего сайта и способствовать повышению рейтинга!

Управление настройками сервера

Возможность редактировать файл . htaccess позволяет контролировать некоторые аспекты того, как ваш сервер отвечает на запросы. Вы можете управлять перенаправлениями, параметрами обработки файлов и многим другим. Это может быть полезно при предварительной настройке или там, где сложно внести изменения на самом сервере.

htaccess позволяет контролировать некоторые аспекты того, как ваш сервер отвечает на запросы. Вы можете управлять перенаправлениями, параметрами обработки файлов и многим другим. Это может быть полезно при предварительной настройке или там, где сложно внести изменения на самом сервере.

Как это работает?

В зависимости от используемого сервера вы можете редактировать файлы robots.txt или .htaccess в Yoast SEO > Инструменты > Редактор файлов.

Для получения дополнительной информации см.:

Как редактировать файлы .htaccess с помощью Yoast SEO

Как редактировать файлы robots.txt с помощью Yoast SEO

Позвольте Yoast SEO помочь вам занять высокие позиции в поиске

Откройте для себя все возможности плагина Yoast SEO для WordPress.

ГенераторRobots.txt | Ryte — Twaino

Используйте генератор robots.txt для создания файла robots.txt с вашей картой сайта за несколько кликов.

Robots.txt Generator

Поисковые системы выделяют веб-сайтам краулинговый бюджет, который представляет собой количество URL-адресов, которые пауки должны просканировать на сайте за заданный период времени. Но есть некоторые факторы, которые съедают этот бюджет, например страницы с ошибками. Кроме того, поисковым роботам не нужно сканировать каждую страницу вашего сайта. В этом случае файл robots.txt содержит инструкции о том, как поисковые роботы должны просматривать ваш сайт. С другой стороны, создание этого файла может стать настоящей головной болью, так как малейшая ошибка может негативно сказаться на вашем сайте. Чтобы помочь веб-мастерам, RYTE предлагает инструмент Robots.txt Generator для простого создания файлов robots.txt. Благодаря этому описанию мы узнаем, как сгенерировать этот файл из инструмента, и проверим правильность ваших инструкций.

Но есть некоторые факторы, которые съедают этот бюджет, например страницы с ошибками. Кроме того, поисковым роботам не нужно сканировать каждую страницу вашего сайта. В этом случае файл robots.txt содержит инструкции о том, как поисковые роботы должны просматривать ваш сайт. С другой стороны, создание этого файла может стать настоящей головной болью, так как малейшая ошибка может негативно сказаться на вашем сайте. Чтобы помочь веб-мастерам, RYTE предлагает инструмент Robots.txt Generator для простого создания файлов robots.txt. Благодаря этому описанию мы узнаем, как сгенерировать этот файл из инструмента, и проверим правильность ваших инструкций.

Что такое генератор Robots.txt от RYTE?

Генератор Robots.txt от RYTE — очень простой в использовании генератор robots.txt для начинающих. Вы можете собрать файл robots.txt всего за несколько шагов. Действительно, файл robots.txt представляет собой форму инструкции для роботов и поисковых роботов (например, Googlebot), которая определяет, какие каталоги веб-сайта можно читать, а какие нет. Например, дубликаты страниц можно исключить из индексации. При отсутствии такого файла поисковая система или поисковый робот просматривает весь веб-сайт и, возможно, каждый файл. Таким образом, все файлы могут отображаться в поиске Google, например, даже если их там быть не должно (например, в приватной области администрирования веб-сайта). Это явление также может оказать негативное влияние на вашу поисковую оптимизацию, поскольку сканируемые подстраницы не оптимизированы для поисковых систем. Генератор Ryte Robots.txt может помочь вам быстро создать файлы robots.txt с выбором из 11 пауков. После того, как вы все настроите, одним щелчком мыши вы сможете создать и загрузить файл. Все, что вам нужно сделать, это загрузить его в корневой каталог вашего сайта.

Например, дубликаты страниц можно исключить из индексации. При отсутствии такого файла поисковая система или поисковый робот просматривает весь веб-сайт и, возможно, каждый файл. Таким образом, все файлы могут отображаться в поиске Google, например, даже если их там быть не должно (например, в приватной области администрирования веб-сайта). Это явление также может оказать негативное влияние на вашу поисковую оптимизацию, поскольку сканируемые подстраницы не оптимизированы для поисковых систем. Генератор Ryte Robots.txt может помочь вам быстро создать файлы robots.txt с выбором из 11 пауков. После того, как вы все настроите, одним щелчком мыши вы сможете создать и загрузить файл. Все, что вам нужно сделать, это загрузить его в корневой каталог вашего сайта.

Кому подходит генератор RYTE Robots.txt?

Этот генератор файлов robots.txt предназначен для веб-мастеров, которые хотят запретить поисковым системам доступ к определенным ресурсам на своих сайтах, которые не должны отображаться в результатах поиска. Тем самым вы оптимизируете краулинговый бюджет своего сайта, чтобы пауки сканировали только важные страницы. Это также бесплатно и позволяет добавить карту сайта в файл robots.txt.

Тем самым вы оптимизируете краулинговый бюджет своего сайта, чтобы пауки сканировали только важные страницы. Это также бесплатно и позволяет добавить карту сайта в файл robots.txt.

Параметры генератора Ryte Robots.txt для создания файла

Прежде чем изучать параметры этого инструмента, давайте сначала посмотрим на синтаксис файла robots.txt. Файл робота включает в себя один или несколько блоков директив для отправки поисковым системам. В первой строке указывается пользовательский агент, т. е. имя сканирования, которому вы даете инструкции по сканированию. Тем не менее, каждый начинает с указания пользовательского агента, к которому должен применяться оператор, а затем следует команда, которая является не чем иным, как оператором.

Разрешить все или принять все

Эта опция дает доступ всем роботам для сканирования всех страниц вашего сайта. Вы понимаете, что это не идеальный вариант, когда вы не хотите, чтобы все страницы вашего сайта были просканированы. Однако вы можете настроить его и указать, каких ботов вы хотите проинструктировать и какие страницы они должны сканировать.

Однако вы можете настроить его и указать, каких ботов вы хотите проинструктировать и какие страницы они должны сканировать.

Запретить все или Отклонить все.

Этот параметр не позволяет поисковым роботам сканировать страницы вашего сайта. Однако, если пауки не могут сканировать ваш сайт, то, очевидно, страницы вашего сайта не будут проиндексированы. И когда ваши веб-страницы не проиндексированы, они также не могут отображаться в результатах поиска. Вот почему вам нужно быть осторожным при создании файла robot.

Вариант настройки или настройки

Это самая интересная часть инструмента Ryte Robots.txt Generator, поскольку у вас есть возможность настроить файл robot.txt и дать инструкции по своему желанию. Слева в Select Bot вы можете определить, каким поисковым роботам вы хотите дать указания. Справа вы определите как URL-адреса (или каталоги), которые боты не должны сканировать, так и те, которые им разрешено посещать. Короче говоря, вот шаги для создания файла с помощью инструмента.

Короче говоря, вот шаги для создания файла с помощью инструмента.

- 1. Введите свой корень. Просто введите ( ⁄ ) и добавьте разрешенные или запрещенные URL-адреса относительно корневой папки вашего сервера;

- 2. Выберите роботов, которым вы хотите разрешить просматривать ваш сайт;

- 3. Введите пути, которые вы хотите разрешить или запретить для доступа к вашему сайту;

- 4. Добавьте свою карту сайта, чтобы поисковым роботам было легче увидеть вашу карту сайта, когда они попадут на нее;

- 4. Каждый раз, когда вы заканчиваете утверждение, нажимайте «Добавить», чтобы сохранить правило и начать писать другую директиву;

- 5. Загрузите файл robots.txt.

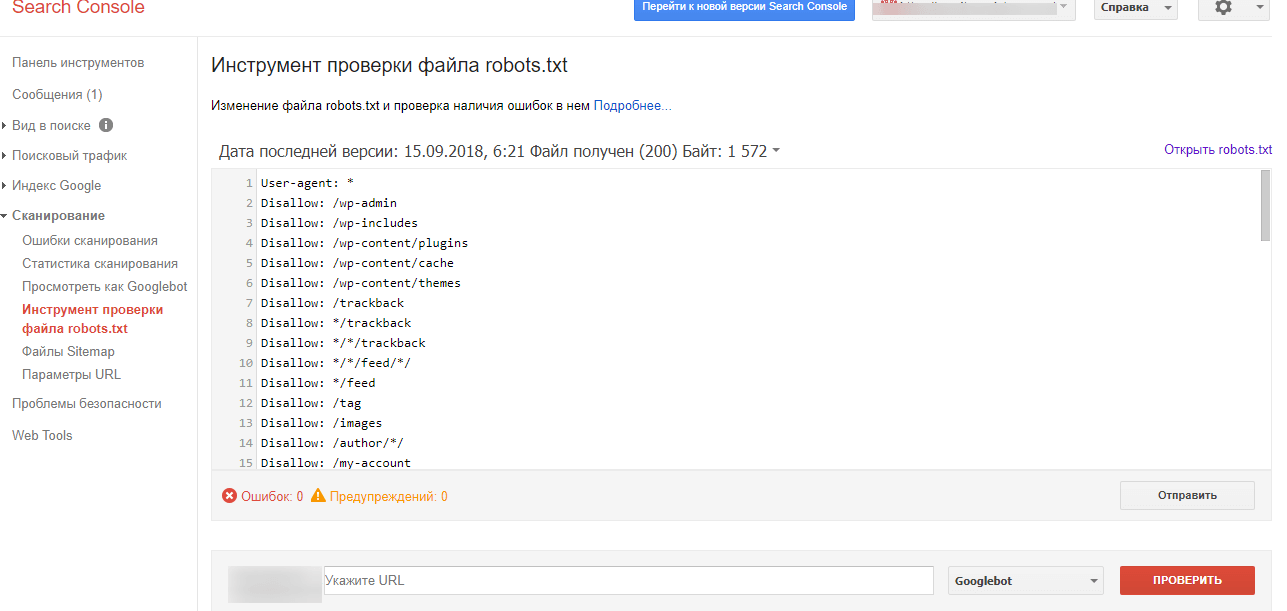

Проверьте файл robots.txt перед публикацией

Всегда проверяйте правильность файла robots.txt, прежде чем размещать его в корневом каталоге веб-сайта. Малейшая ошибка может привести к тому, что робот проигнорирует спецификации и, возможно, интегрирует страницы, которые не должны быть в индексе Google. Ryte также предлагает инструмент для тестирования Robots.txt, который позволяет вам протестировать файл robots.txt. Все, что вам нужно сделать, это ввести соответствующий URL-адрес и выбрать соответствующий пользовательский агент. После нажатия «Начать тест» инструмент проверяет, разрешено ли сканирование по данному URL-адресу. Короче говоря, инструмент тестирования Robots.txt от Ryte позволит вам создать файл robots.txt для вашего сайта без каких-либо технических знаний.

Ryte также предлагает инструмент для тестирования Robots.txt, который позволяет вам протестировать файл robots.txt. Все, что вам нужно сделать, это ввести соответствующий URL-адрес и выбрать соответствующий пользовательский агент. После нажатия «Начать тест» инструмент проверяет, разрешено ли сканирование по данному URL-адресу. Короче говоря, инструмент тестирования Robots.txt от Ryte позволит вам создать файл robots.txt для вашего сайта без каких-либо технических знаний.

Работает исключительно для Яндекса.

Работает исключительно для Яндекса.