как правильно составить и для чего он нужен

Поисковые роботы индексируют всё, что находят. Даже админпанель с личной информацией. Robots.txt — это специальный файл для ботов с правилами, по которым они начинают работать с вашим сайтом. В этом файле вы и прописываете всё, что разрешаете или запрещаете им делать.

Важный файл robots.txt

Для чего нужен

Для того, чтобы ваш сайт быстрее индексировался, в поиск не попадали ненужные страницы или приватная информация. «Ненужные страницы» — это дубликаты товарных категорий, личная информация, формы отправки данных, страницы с результатами поиска и т.п. Robots.txt устанавливает строгие правила для поисковиков, если же эти правила не указать, то вся ваша информация окажется в сети и удалить её из архивов интернета будет практически нереально.

Где писать этот файл и где его располагать

Писать можно в любом удобном для вас редакторе — в обычном встроенном блокноте для Windows, NotePad или Word — не суть. Главное, чтобы этот файл был сохранён в текстовом формате, то есть с расширением .txt.

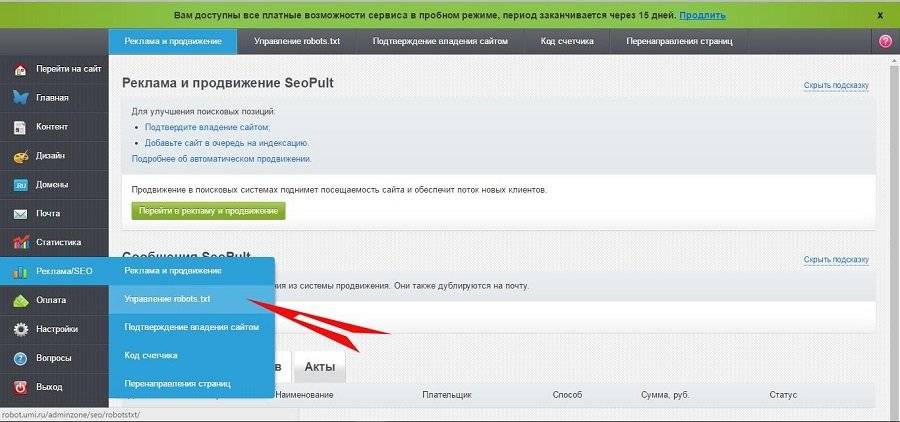

В нашей системе вставить инструкцию для поисковых ботов на сайт очень просто: выберите в левой панели управления сайтом раздел «Реклама/SEO → Управление robots.txt».

Управление robots.txt находится в разделе «Реклама/SEO»

И в открывшееся поле вы просто вставляете готовую инструкцию (с помощью функции «копировать — вставить»).

На нашем сервисе файл robots.txt автоматически генерируется системой. В большинстве случаев он полностью отвечает всем требованиям поисковых роботов и закрывает от индексации те страницы, которые не должны быть на виду. Но вы можете создать свою инструкцию или внести любые изменения в готовый файл. В случае необходимости всегда можно восстановить первоначальный вариант.

Правила синтаксиса robots.txt

Поисковый робот учитывает только определённые выражения и алгоритмы. Поэтому инструкция составляется на понятном ему «языке». Вот основные команды, которые «понимает» робот:

- User-Agent: Имя бота поисковой системы. Для Яндекса это Yandex, для Google — Google-bot, для Mail.ru — Mail.ru. Весь список названий роботов-поисковиков перечислен на этой странице.

- Allow — команда «разрешить».

- Disallow — команда «запретить».

- Host — имя вашего хостера (на 1C-UMI это robot.umi.ru).

Директива Allow не является обязательной, а вот Disallow нужно указывать. По умолчанию файл robots.txt разрешает всё, поэтому прописывать нужно только запрещающие команды.

Правильный синтаксис написания: команда → двоеточие → пробел → слеш (/) → точное наименование страницы.

Точное наименование страницы — это весь путь, который ведёт на указанную страницу, начиная с главной: мойсайт.рф — мода — женская мода — верхняя одежда — пальто — чёрное пальто в горошек.

Пример:

- Вы разрешаете поисковому боту Яндекс индексировать всё, кроме страницы «Контакты»:

- User-Agent: Yandex

- Allow:

- Disallow: /contacts

- Если вы разрешаете индексировать сайт всем поисковым системам, то после User-Agent нужно поставить знак *:

- Если вы ничего не запрещаете к индексации, то после disallow ничего не ставите:

- Если вы запрещаете какому-то определённому боту индексировать свой сайт, то ставите его имя и запрещающую команду disallow вместе со слешем:

- User-Agent: googlebot-image (робот-поисковик по картинкам в Гугл)

- Disallow: /

Disallow относится только к тому боту, который указан перед командой. Для каждого робота нужно прописывать команды индивидуально.

Как не запутаться в названиях ботов и командах

Есть удобная функция «комментарий», которую вы можете использовать при составлении robots.txt. Всё, что вы хотите прокомментировать, оставить какое-либо уточнение, отмечайте символом #. Всё, что будет написано после этого знака, роботом не учитывается.

User-Agent: Yandex

Disallow: /Price/ #Не индексировать каталог с ценами.

Как установить период захода на сайт робота-поисковика

Чтобы уменьшить нагрузку на сервер, нужно использовать директиву (команду для робота-поисковика) Crawl-delay. Она устанавливает период, за который робот-поисковик должен обойти сайт, или время, за которое робот просмотрит все страницы сайта и внесёт их в индекс. Другими словами, эта директива позволяет ускорить обход сайта роботом. Обычно устанавливается на сайт-многостраничник. Если у вас страниц ещё немного, не больше двухсот, то этот параметр можно не указывать.

Прописывается это так:

- User-Agent: Yandex

- Disallow: /contacts

- Craw-delay: 2 #Тайм-аут обхода 2 секунды

Тайм-аут обхода вы можете указать любой. Это не гарантирует, что на ваш сайт робот будет заходить каждые 2 (3, 4, 5…) секунд, вы просто даёте ему приблизительное время обхода. Если ваш сайт уже хорошо ранжируется, то роботы будут заходить на него чаще, если сайт ещё молод, то реже. В справке Яндекс об этом параметре написано подробней.

Ошибки при составлении robots.txt

Рассмотрим самые популярные ошибки, которые совершают пользователи при создании файла.

|

Ошибки |

Правильно |

|

Путаница в инструкциях User-Agent: / Disallow: Googlebot |

User-Agent: Googlebot Disallow: / |

|

Несколько каталогов в одной строке Disallow Disallow: /moda/ hat/ images |

Disallow: /moda/ Disallow: /hat/ Disallow: /images/ |

|

Пустая строка в указании имени поискового робота User-Agent: Disallow: |

User-Agent: * Disallow: |

|

Заглавные буквы USER-AGENT: YANDEX ALLOW: |

User-Agent: Yandex Allow: |

|

Перечисление каждого файла в категории User-Agent: Googlebot Disallow: /moda/ sinee-palto.html Disallow: /moda/ zelenoe-palto.html Disallow: /moda/ seroe-palto.html Disallow: /price/ women.html Disallow: /price/ men.html |

User-Agent: Googlebot Disallow: / moda/ Disallow: /price/ |

Не забывайте про знак слеш (/). Если его не будет, то робот запретит к индексации все файлы и категории с таким же названием. Например, если вы не укажете слеш в директиве: “Disallow: moda”, то из индекса выпадут все страницы, рубрики и категории, где встречается это название.

Правила написания robots.txt

- Каждую команду надо писать с новой строки.

- В одной строке — одна директива.

- В начале строки не должно быть пробела.

- Команды не берут в кавычки.

- В конце директивы не ставится точка с запятой, запятая или точка.

- Disallow: равнозначно Allow: / (всё разрешено).

- Поисковые роботы чувствительны к регистру букв — прописывайте имена файлов и категорий точно так же, как они указаны на вашем сайте.

- Если у вас нет robots.txt, это сигнал для поисковиков, что запрещений нет, индексировать можно всё.

- В robots.txt используется только английский язык. Все другие языки игнорируются.

Как проверить robots.txt на правильность написания

Есть специальные сервисы, которые проверяют, правильно ли составлен разрешающий файл. Проверьте свой robots.txt на сайте Яндекс или в Гугл.

Автоматическое создание robots.txt

Если для вас сложно самостоятельно написать инструкцию для ботов, то создайте её автоматически. На сайте pr-cy файл будет сгенерирован за 10 секунд, просто укажите нужные вам параметры, потом скопируйте текст и вставьте его в поле для robots.txt на нашем сервисе.Директивы — базовая информация

Директивы – это своеобразный свод правил поведения на страничках сайта для robots.txt. Считывая их, поисковый агент и понимает, какой контент можно использовать для индексации сайта, а какой нельзя.Ниже перечислим разные типы директив, с пояснениями.

User-agent

Если перевести на простой язык, то «User-agent» — это призыв к некоему действию. После этого директива обычно прописывается наименование robots.txt, которому сообщается информация, а далее — уже сама информация. Иными словами, User-agent — самая важная директива для robots.txt.

Вот так выглядят директивы User-agent для разных поисковых машин:

- User-agent: *; — для всех видов роботов.

- User-agent: Yandex; — для роботов поисковика Яндекс.

- User-agent: Googlebot. — для роботов поисковика Google.

- User-agent: Mail.Ru. — для роботов Mail.ru

- User-agent: Slurp – для роботов Yahoo!

- User-agent: MSNBot – для роботов MSN

- User-agent: StackRambler – для роботов Рамблера.

Disallow

Директива, запрещающая индексировать те или иные странички веб-сайта. Веб-мастера советуют прописывать ее для следующих типов страниц:

- Корзине и всем сопутствующим оформлению заказа страничкам.

- Поисковым формам.

- Административной панели сайта.

- Ajax, Json — эти скрипты выводят всплывающие формы для заполнения, рекламные баннеры и так далее.

Allow

Это директива, наоборот, открывает страничку сайта для чтения роботом.

Sitemap

Простыми словами — директива, отображающая карту вашего сайта. Сообщая роботу структуру вашего сайта, вы ускоряете его индексацию.

Host

Указывает поисковому роботу на зеркало вашего сайта, куда будут попадать пользователи.

Crawl-delay

Помогает снижать нагрузку на сервер, задавая минимальный временной интервал между обращениями к сервису.

Общие рекомендации любых директив:

- Не прописывайте в одной строчке больше одной директивы.

- Убирайте пробелы в начале строк.

- Только полная директива без лишних символов будет работать.

- Код файла robots.txt немыслим без Disallow.

Robots.txt напрямую влияет на индексацию сайта, поэтому обязательно установите свои правила для поисковых ботов. Успешного вам продвижения!

Как составить robots.txt: Практическое руководство

Файл robots.txt – посредник между Вашим сайтом и веб-пауками (или поисковыми роботами), которые регулярно посещают Ваш ресурс, чтобы проиндексировать новые и обновленные страницы.

На любом (или почти на любом) сайте есть такие страницы, которые вебмастер не хотел бы показывать поисковой системе. Это могут быть страницы с неуникальным контентом, который Вы вынуждены добавить на сайт (например, отрывок из закона, условия дисконтной программы и т.д.) или страницы админпанели, которые системе видеть совсем ни к чему.

Именно при помощи robots.txt можно сделать эти нежелательные для индексации страницы невидимыми для поисковика. Robots.txt дает возможность запретить индексацию страниц, целых разделов и подразделов сайта, или же весь сайт полностью.

Составляем файл robots.txt корректно

Файл robots.txt хранится в корневой папке (директории) сайта. Создать файл можно двумя способами: самостоятельно (вручную) и с помощью автоматической генерации.Сегодня разберем только “ручной” способ составления файла robots, т.к. способы автоматической его генерации — тема отдельная.

На самом деле, в составлении файла вручную нет ничего сложного – для этого лишь нужно знать об основных директивах, которые Вам может понадобиться использовать.

Директива User-agent

С этой директивы ОБЯЗАТЕЛЬНО начинается файл robots. Она – приветствие Вашим сайтом роботов поисковых систем.

Т.к. в robots.txt есть возможность ограничить или открыть для индексации страницы сайта отдельно для Google или Яндекс, User-agent как раз содержит информацию о том, для какого из роботов предназначены инструкции.

Например:

Если директива User-agent в файле отсутствует или находится не в начале файла, поисковые роботы будут думать, что для индексации открыты абсолютно все страницы сайта, включая даже страницы админпанели.

Директивы Allow и Disallow

Директива Allow разрешает страницу/раздел/сайт для индексации, директива Disallow, напротив, ограничивает доступ к старницам, которые Вы не хотите показывать поисковикам.

Роботам Яндекса разрешено индексировать все страницы в директории “catalog”, но запрещено индексировать все остальные страницы сайта.

Роботам Яндекса разрешено индексировать все страницы в директории “catalog”, но запрещено индексировать все остальные страницы сайта. Роботам всех поисковых систем запрещено индексировать сайт полностью.

Роботам всех поисковых систем запрещено индексировать сайт полностью. Основному роботу Google запрещено индексировать отдельную страницу

Основному роботу Google запрещено индексировать отдельную страницуС помощью файла robots.txt можно закрыть от индексации определенную директорию сайта, при этом оставив открытой отдельные подразделы и страницы, в нее входящие.

Например:

Мы закрыли от индексации основной каталог сайта, при этом оставив открытым подкаталог “Платья”

Мы закрыли от индексации основной каталог сайта, при этом оставив открытым подкаталог “Платья”Однако, если Вы не укажете, какие именно элементы должны остаться открытыми внутри запрещенной для индексации директории, ни один ее элемент не будет виден поисковому роботу.

Некоторые фишки файла robots.txt:

- Новая директива — новая строка. Строго придерживайтесь этог оправила.

- При написании директив допустимо использовать только

- Для одного бота достаточно одной директивы User-agent, а все инструкции могут быть прописаны подряд.

- Символ * (звездочка) может запретить индексацию всего сайта, всех объектов, принадлежащих определенной директории или всех объектов, содержащих определенное слово.

- Если Вы закрываете от индексации директорию, символ / (слеш) должен быть и в начале, и в конце ее названия.

- Если директива Disallow не имеет инструкций, робот воспринимает это как знак того, что весь сайт открыт для индексации.

- Директивы для одного робота в robots.txt не должны повторяться.

Директива Sitemap

Позаботьтесь о том, чтобы в файле robots была прописана строка, указывающая, где находится карта сайта (sitemap). Это значительно ускорит индексацию сайта, а также не даст поисковому роботу пропустить отдельные страницы.

Директива Host

При наличии у сайта зеркала (или зеркал), в robots.txt прописывается директива Host, которая указывает, какое зеркало является главным. Это не дает гарантий, что поисковая система также посчитает главным зеркалом именно его, однако значительно увеличит шансы.

Важно помнить, что директива Host должна следовать после директив Allow и Disallow.

Как видите, написание файла robots.txt – не такая уж и сложная наука. Тем не менее, ошибки в этом файле встречаются достаточно часто, поэтому перед тем, как добавлять его в корневую папку сайта, воспользуйтесь анализатором robots.txt Яндекс.

Ну а если у Вас большой сайт с большим количеством директорий и составление robots.txt вручную кажется совсем уж рискованным мероприятием, можно воспользоваться автоматическими генераторами, о которых мы поговорим в другой нашей статье.

Автор: Анастасия Анненкова, SEO-специалист MSA-IT

- Теги: внутренняя оптимизация

Как составить минимальный robots.txt – Андрей Шарапов

Файл robots.txt — специальный текстовый файл, расположенный в корневом каталоге сайта и содержащий инструкции для поисковых систем. Он является одним из самых важных при оптимизации любого сайта. Его отсутствие может привести к высокой нагрузке на сайт со стороны поисковых роботов и медленной индексации, а неправильная настройка к тому, что сайт полностью пропадет из поиска или просто не будет проиндексирован.

Как создать robots.txt?

Файл robots.txt легко создать при помощи любого текстового редактора, например Блокнот. Для этого достаточно создать новый файл с именем «robots.txt», и заполнить его всеми необходимыми директивами. После того, как файл создан, его необходимо поместить в корневой каталог вашего сайта.

Как влияет robots.txt на индексацию сайта

Поисковые роботы будут индексировать ваш сайт независимо от наличия файла robots.txt. Если же такой файл существует, то роботы могут руководствоваться правилами, которые в этом файле прописываются. При этом некоторые роботы могут игнорировать те или иные правила, либо некоторые правила могут быть специфичными только для некоторых ботов.

Максимальную нагрузку на сайт создают роботы, которые скачивают контент с вашего сайта. Следовательно, указывая, что именно индексировать, а что игнорировать, а также с какими временны́ми промежутками производить скачивание, вы можете, с одной стороны, значительно снизить нагрузку на сайт со стороны роботов, а с другой стороны, ускорить процесс скачивания, запретив обход ненужных страниц.

Давайте начнем по порядку и будем рассматривать директивы в том порядке, в котором предпочтительнее их разложить.

Директивы robots.txt

Директивы — это набор правил для роботов.

User-agent

Это самая главная директива, определяющая для каких роботов далее следуют правила. Для того чтобы написанные инструкции использовали все роботы, поддерживающие robots.txt , достаточно указать в директиве User-agent: *. Если написанные директивы предназначаются определенным поисковым роботам, то в User-agent пишут их названия, например User-agent: Googlebot или User-agent: YandexBot.

Внимание! В robots.txt не важен регистр символов. Вы можете записывать правила как Googlebot, так и googlebot.

Allow

Директива Allow позволяет разрешить доступ поискового робота к странице или разделам сайта. Часто данная директива используется, когда надо открыть для роботов небольшое количество страниц раздела, который планируется закрыть при помощи директивы Disallow.

Disallow

Директива Disallow позволяет запретить доступ роботов поисковых систем к конкретным страницам и разделам сайта. Также её используют для того, чтобы скрыть страницы или разделы, которые не имеют информационной значимости для пользователей, например админку в cms, технический разделы сайта, дублирующийся контент в SERP и пр..

Прежде чем приступать к установке директив, нужно знать дополнительные операторы *, $ и # и понимать, как они используются.

-

*— это любое количество символов, в том числе и их отсутствие. При этом в конце строки звездочку можно не ставить, подразумевается, что она там находится по умолчанию. -

$— показывает, что символ перед ним должен быть последним. -

#— используется для того, чтобы отменить использование спецсимвола*в конце правила.

Пример 1:

Allow: *.css Disallow: /template/

говорят нам о том, что /style.css — открыт от индексирования, а /template/style.css — закрыт.

Если нужно, чтобы все .css файлы сайта были открыты для индексирования придется это дополнительно прописать для каждой из закрытых папок.

Allow: *.css Allow: /template/*.css Disallow: /template/

Пример 2

User-agent: * Disallow: /template$

Здесь мы запретили адреса /template, но не запретили /template/page/ или /template.html.

Помните, что порядок записи директив Allow и Disallow не важен.

Следующие директивы указывается в файле robots.txt после директив Allow и Disallow.

Sitemap

Директива Sitemap необходима при использовании файл sitemap.xml. При помощи этой директивы можно указать путь к месту расположения одной или нескольких карт сайта.

Например, если у нас помимо основного сайта есть еще и форум, то в файле robots.txt мы укажем две карты:

Sitemap: /sitemap.xml Sitemap: /sitemap-forum.xml

Host

Директива Host необходима для указания главного зеркала сайта. В большинстве случаев для перехода с www.site.ru на site.ru. Если у сайта есть несколько зеркал, то они будут объединены в специальную группу. В таком случае в поиске будет выдаваться только адрес главного зеркала. Для того чтобы у робота-зеркальщика не было проблем с определением главного сайта, необходимо указать директиву Host для каждого сайта-зеркала.

Host: website.ru или www.website.ru или https://website.ru

Crawl-delay

Директива Crawl-delay позволяет указать поисковым роботам минимальное время (в секундах) между скачиванием страниц. Данную директиву следует использовать в случае сильной нагрузки на сервер. Значение может устанавливаться в целых или дробных единицах (разделитель — точка), время в секундах.

Crawl-delay: 5 или 4.5

Чем больше значение, тем меньше страниц робот загрузит за одну сессию. Оптимальное значение определяется индивидуально для каждого сайта. Лучше начинать с не очень больших значений — 0.1, 0.2, 0.5 — и постепенно их увеличивать. Если сайт имеет небольшую нагрузку, то необходимости устанавливать такое правило нет. Однако если индексация страниц роботом приводит к тому, что сайт превышает лимиты или испытывает значительные нагрузки вплоть до перебоев работы сервера, то эта директива поможет снизить нагрузку.

Clean-param

Директива, позволяющая избежать многократной закачки дублирующихся страниц, возникших из-за не изменяющих содержание динамических параметров. Использование директивы Clean-param снижает нагрузку на сервер, а также позволяет избавиться от внутренних дублей страниц.

Как запретить индексирование сайта?

Если вы хотите, чтобы ваш сайт НЕ индексировался поисковыми роботами, то вам нужно прописать в robots.txt следующие директивы:

User-agent: * Disallow: /

Как составить минимальный robots.txt?

Исходя из вышесказанного, вы наверное уже поняли как должен выглядеть минимальный файл robots.txt. Для тех кто еще не совсем разобрался, вот минимальный код:

Для того, чтобы избежать исчезновения из поисковых систем важных для разделов вашего сайта, рекомендуется использовать специальный сервис, позволяющий убедится в правильности заполнения вашего robots.txt.

Автор: Андрей Шарапов

Возможно Вас также заинтересует…

Файл robots txt для сайта

Robots.txt – это служебный файл, инструкция для поисковых роботов для индексации сайта. В файле указываются каталоги, которые не требуется индексировать. Обычно это администраторская панель, кеш, служебные файлы. Размещается в корневой папке веб-ресурса. Его использование необходимо для лучшей индексации страниц, защиты приватной информации и повышения безопасности сайта.

Часто используется веб-мастерами вместе с другим служебным файлом, предусмотренным протоколом sitemap ( написанном на языке XML), который действует наоборот, предоставляя карту сайта с разрешенными к чтению роботами страницами.

Robots.txt и его влияние на индексацию сайта.

После создания сайта его корневая папка на хосте становится доступной для поисковых систем. Роботы читают все, что найдут, без разбора.

В каталогах динамических сайтов, находящихся под управлением CMS, они не найдут никакой информации, ведь она хранится в базах данных MYSQL. Роботы, если им этого не запретить, беспрепятственно перебирают файлы в директориях, которые закрыты для посещения всем, кроме администратора. Это опасно для сайта и отнимает время у поисковиков, снижая скорость индексации веб-ресурса.

Для хакеров и прочих компьютерных злоумышленников доступные к чтению служебные файлы – это еще не дверь, но замочная скважина, в которую они обязательно залезут с электронной отмычкой для получения контроля над всем сайтом. Если в файле robots.txt указать, что читать надо только индексные файлы, то знакомство поисковой системы с динамическим сайтом произойдет быстрее, а его безопасность повысится.

Виртуальный хостинг сайтов для популярных CMS:

Для статических веб-ресурсов этот файл станет небольшой гарантией, что хранящиеся конфиденциальные данные (телефоны, адреса электронной почты и другие) не окажутся в открытом доступе.

Веб-мастер, создавая файл robots.txt, может запретить роботам поисковых систем посещение всего сайта или дать доступ к его индексации только одной из категорий или страниц сайта.

Какие страницы стоит запретить и закрыть в robots.txt?

Если на хосте, где размещен сайт, есть панель управления, то этот файл можно создать, открыв корневую папку и нажав кнопку «новый файл» (бывают варианты в названиях). Но лучше создать файл на домашнем компьютере, а для загрузки воспользоваться каналом FTP.

Самой удобной программой для создания файла robots.txt является Notepad++. Но не возбраняется использовать обычный блокнот из набора Windows или текстовый редактор Word. Сохранять файл надо с расширением .txt.

Даже если он написан неправильно, это не приведет к потере работоспособности сайта, как это происходит с неправильным файлом .htaccess.

— Если не хочется ни изучать синтаксис файла, ни создавать его самостоятельно, то можно обратиться, например на http://pr-cy.ru/robots/, где его сгенерируют автоматически.Директивы файла — user agent, host и т.д.

Директивы (команды) файла пишутся на латинице, после каждой из них ставится двоеточие и указывается объект управления.

Директивы бывают стандартные:

- User-agent – имя поискового робота;

- Allow – разрешить;

- Disallow – запретить;

- Sitemap – адрес, где находится sitemap.xml;

- * – для всех.

И расширенные:

- Craw-delay– промежуток времени между чтением директорий;

- Request-rate – количество страниц, просмотренных за одну секунду;

- Visit-time – желаемое время посещения сайта роботом.

Расширенные директивы снижают нагрузку на сервер и защищают сайт от слишком назойливых парсеров.

Google, Яндекс и настройка роботс.

Поисковые системы Гугл и Яндекс одинаково хорошо читают этот файл, но рассчитывать, что его наличие послужит установлению каких-либо особенных отношений поисковых систем с сайтом – это ненужный романтизм, лишенный оснований. Есть некоторые отличия в том как можно обратиться к поисковому роботу, ведь у каждой системы их целый набор:

- YandexBot и Googlebot – это обращение к основным поисковым роботам;

- YandexNews и Googlebot-news – роботы, специализирующиеся на новостном контенте;

- YandexImages и Googlebot-image – индексаторы картинок.

У Яндекса поисковых роботов девять, а у Google восемь. Если требуется общая индексация, то после директивы User-agent пишется Yandex или Googlebot.

У Яндекса есть еще одна особенность: его роботы читают директиву Host, указывающую на «зеркало» сайта. Гугл ее не понимает.

Как составить robots.txt для Joomla.

Вот как может выглядеть этот файл для новостного сайта на CMS Joomla.

User-agent: YandexNews

Disallow: /administrator

Disallow: /components

Disallow: /libraries

Allow: /index1.php

Allow: /index2.php

Request-rate: 1/20

Visit-time: 0200-0600

В нем для индексации «приглашен» новостной бот Яндекса, которому запрещено читать директории administrator, components и libraries (папка, где собственно и содержится «движок»). Индексировать можно 1 страницу за 20 секунд, а посещать сайт с двух ночи до шести утра по Гринвичу.

Проверить правильность написания файла robots.txt можно обратившись в Яндексе к сервису «Вебмастеру». Такой же Центр Веб-мастеров есть и у Google.

Не нужно использовать этот файл как основу – в нем просто показано использование директив.

Пример правильного файла robots.txt для WordPress — как запретить все лишнее.

А это – рабочий файл robots.txt для CMS WordPress.

User-agent: *

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /archives/

Disallow: /*?*

Disallow: *?replytocom

Disallow: /wp-*

Disallow: /comments/feed/

User-agent: Yandex

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /archives/

Disallow: /*?*

Disallow: *?replytocom

Disallow: /wp-*

Disallow: /comments/feed/

Host: http://вашсайт.ру

Sitemap: http://вашсайт.ру/sitemap.xml

В первом блоке написаны директивы для всех поисковых роботов, они же дублируются для Яндекса, только с уточнением основной версии сайта. Как видно, из индекса исключена пагинация, служебные файлы и каталоги.

Как правильно составить файл robots.txt для WordPress

Приветствую Вас на своем блоге. Сегодня я расскажу, как правильно составить файл robots.txt для WordPress. Файл robots.txt — простой текстовый файл, который можно написать в простым текстовым редактором, например «Блокнот» от Windows. Файл robots.txt нужно разместить в корневой папке Вашего блога.

Приветствую Вас на своем блоге. Сегодня я расскажу, как правильно составить файл robots.txt для WordPress. Файл robots.txt — простой текстовый файл, который можно написать в простым текстовым редактором, например «Блокнот» от Windows. Файл robots.txt нужно разместить в корневой папке Вашего блога.

Этот файл должен состоять из символов нижнего ригистра — robots.txt. Поисковикам нужно указывать, что можно индексировать, а что нет. Чтобы лучше поисковики индексировали Ваш блог, надо закрыть от индексации ненужные папки, рубрики, страницы и прочее. Роботы должны индексировать только то, что Вам необходимо.

Вот что нам на это отвечает Яндекс:

Запретите в robots.txt индексирование страниц, неинтересных пользователям. Например, формы ответа на форуме, статистику посещений, страницы с результатами поиска, сайты-зеркала, документы на нераспространенных в рунете языках.

Как правильно составить файл robots.txt для WordPress

В файле нужно задать параметры для каждого поисковика. Давайте рассмотрим следующий вариант этого файла для wordpress:

User-agent: *

Allow: /wp-content/uploads/

Crawl-delay: 4

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: */comment*

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /?s=

Disallow: /o-sebe/*

Disallow: /2011/*

Disallow: /2012/*

Disallow: /category/novosti/*

Disallow: /archives/tag/*

Disallow: /*?* этот параметр не добавляем. Если уже присутствует в файле — удалите его

Host: dvpress.ruSitemap: https://dvpress.ru/sitemap.xml.gz

Sitemap: https://dvpress.ru/sitemap.xml

Теперь разберем по полочкам этот файл:

Первая строка означает, что все параметры относятся ко всем поисковым роботам. Чтобы указать для поискового робота Yandex, нужно указать следующее: User-agent: Yandex. Здесь мы не будем рассматривать параметры всех поисковых роботов, а только общие. Директивы Google и Yandex немного отличаются.

User-agent: *

В следующей директиве мы разрешили индексировать папку uploads, в которой находятся картинки блога.

Allow: /wp-content/uploads/

Задали тайм аут в 4 секунды. Бывает, что сервер перегружен и поэтому не успевает обрабатывать запросы на закачку, тогда можно указать эту директиву. Эта директива не учитывается в Google.

Crawl-delay: 4

Заблокировали доступ к страницам, начинающимся с ‘/cgi-bin’

Disallow: /cgi-bin

Следующие директивы указывают, какие папки не следует индексировать

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Если указать Disallow: /wp-*, тогда будет запрещена индексация всех файлов, которые начинаются с wp-

Следующие параметры запрещают индексирование комментариев, трекбыков и фида. (Трекбеки — это обратные ссылки. Размещают их под комментариями к посту на тот блог, который ссылается на данную статью).

Disallow: */comment*

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Запрет на индексацию результатов поиска:

Disallow: /?s=

Следующие строки запрещают индексацию архивов, за 2011 год и 2012:

Disallow: /2011/*

Disallow: /2012/*

На Вашем блоге страницы архивом могут отличаться. Чтобы проверить, какой адрес у Вас имеют страницы архивов, зайдите в архив и посмотрите в адресной строке. У меня это выглядит так: https://dvpress.ru/2012/02, что означает: 2012 год архива, а 02 месяц архива, т.е. февраль. У Вас это может выглядеть примерно так:

Потом я закрыл от индексации страницу «О себе» и «Книги«.

Disallow: /o-sebe/*

Disallow: /knigi/*

Так же закрыл от индексации рубрику «Новости«.

Disallow: /category/novosti/*

Следующие директивы запрещают индексацию тегов архивов.

Disallow: /archives/tag/

Архивы тегов рекомендуют закрывать, пока у Вас молодой сайт. Когда Ваш сайт хорошо проиндексируется, можно будет убрать запрет на индексацию, это примерно через полгода.

Так же рекомендуют закрыть индексацию всех главных страниц, кроме первой. Для этого перейдите на следующую страницу и посмотрите в адресной строке, как они у Вас выглядят. У меня на блоге они выглядят так: https://dvpress.ru/page/2, поэтому я вписал в робот следующую директиву:

Disallow: /page/* , где звездочка указывает, что следующие страницы индексировать так же запрещено.

Далее указываем путь к следующим файлам sitemap.xml.gz и sitemaps.xml:

Sitemap: https://dvpress.ru/sitemap.xml.gz

Sitemap:

Примечание: Звездочка «*» в конце директивы означает, что все, что идет после, так же не должно быть индексировано, например: Disallow: /2012/* — означает, что архив 2012 не должен индексироваться и все его вложения.

Проверить работоспособность файла, после его настройки можно в Яндексе по следующему адресу: http://webmaster.yandex.ru/robots.xml#results и в Google https://www.google.com/webmasters/tools/crawl-access?hl=ru&siteUrl=http://site.ru/

Читайте также:

почему Яндекс не всегда работать с файлом robots.txtкак удалить сопли Google

___________________________

К Уроку 34. Кнопки социальных сетей wordpress, несколько способов настройки